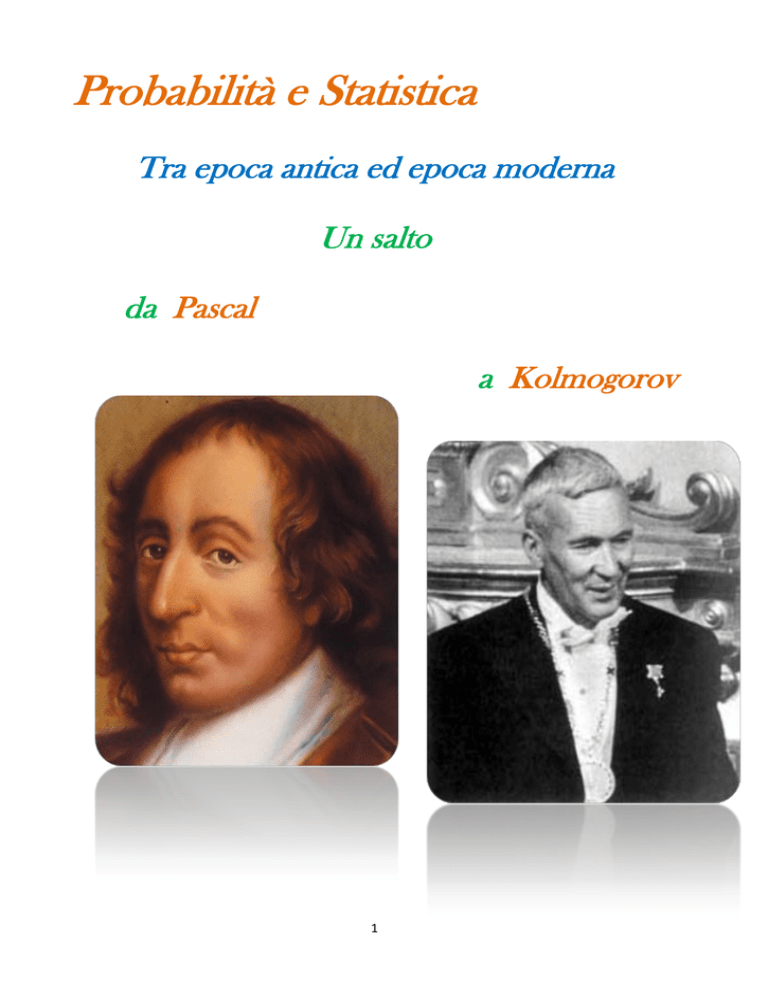

Probabilità e Statistica

Tra epoca antica ed epoca moderna

Un salto

da Pascal

a Kolmogorov

1

PREMESSA

Nel corso del nostro studio abbiamo

notato come molti argomenti siano

stati trattati esaurientemente già

prima dell’era cristiana. Gli Elementi

di Euclide, infatti, danno conferma di

ciò non solo per quanto riguarda la

geometria elementare, ma anche per

molte questioni di aritmetica. Il

grado di perfezione raggiunto dai

greci in geometria è stato superato

soltanto dopo più di duemila anni, e

cioè nel XIX secolo, con la scoperta

delle geometrie non euclidee.

Lo sviluppo dell’algebra è stato

molto più lento. Bisogna arrivare, infatti, al XVI secolo per avvertire un vero e

proprio salto di qualità rispetto agli studi precedenti, i quali consideravano le

equazioni di 2° grado come le colonne d’Ercole dell’algebra. Gli algebristi del ‘500,

a dispetto di tutte le radicate convinzioni, riuscirono a spingersi fino alla

risoluzione delle equazioni di 4° grado. Nel giro di pochi anni l’algebra diventa lo

strumento più efficace per la risoluzione di molti problemi geometrici. Comincia

così ad acquistare le caratteristiche di una vera e propria scienza che non aveva

nulla da invidiare alla consolidata e affermata geometria.

Si fa strada in tal modo l’idea di una certa autonomia dalla cultura classica.

L’uomo del ‘500 acquista piena consapevolezza delle

proprie capacità creative che lo liberano dalla

sudditanza del passato.

In tutti i campi del sapere le questioni vengono

affrontate con mezzi e prospettive nuovi.

La grande autorità esercita da Aristotele per decine

di secoli viene messa in discussione e rigettata,

specie nel campo della fisica.

Tuttavia, soltanto in matematica furono raggiunti

risultati molto espressivi e pregnanti, il cui influsso

fu avvertito oltre lo stretto ambito della

disciplina.(In figura Gerolamo Cardano 1501-1576).

A questo punto la cultura classica acquista una

dimensione nuova e, comunque, assolutamente non

totalizzante.

Le conquiste realizzate in algebra diedero un grande

impulso alla ricerca scientifica. Infatti, con l’algebra

presero l’avvio altri rami della matematica come la

2

geometria analitica e il calcolo

infinitesimale, la cui importanza è

testimoniata dai grandi progressi realizzati

nella meccanica, struttura portante di tutta

la scienza moderna.

Con la geometria analitica e il calcolo

infinitesimale prende l’avvio anche un nuovo

ramo della matematica: il calcolo delle

probabilità, che si pone come obiettivo la

ricerca di una certa regolarità anche per quei

fenomeni che regolari non lo sono per

niente.

Si tratta di un progetto ambizioso

e, in un certo senso, velleitario,

che poteva essere perseguito

soltanto da chi nutriva grande

fiducia nel progresso scientifico.

I fenomeni astronomici attrassero

l’attenzione

dell’uomo

sin

dall’antichità a causa della

periodicità regolare con cui si

verificavano. Ciò ha permesso la

scoperta di molte leggi che

regolano il moto degli astri.

L’uomo dell’era moderna comincia

ad interessarsi di questioni che

nell’antichità

non

avrebbero

sicuramente trovato posto nel campo della ricerca scientifica. Difatti, il calcolo

delle probabilità prese le mosse dal gioco d’azzardo. Le sue origini perciò sono

poco nobili. Il primo ad interessarsi della ricerca di una legge che regolasse il gioco

con i dadi fu Blaise Pascal. Si distinsero in questo campo anche Fermat, Eulero e

Bernoulli. Tuttavia soltanto ai primi del XIX secolo, con Laplace, il calcolo delle

probabilità acquista pieno diritto di cittadinanza nel mondo matematico.

Nel calcolo delle probabilità Laplace riconobbe un vero e proprio strumento di

ricerca scientifica. Le sue idee trovarono la più ampia conferma nel XX secolo con i

grandi progressi realizzati in fisica quantistica.

3

INTRODUZIONE

Il calcolo della probabilità

è lo strumento che fa sì

che l’uomo assuma un

comportamento

razionale

di

fronte

all’incertezza.

L’esperienza quotidiana

mostra che i fatti

osservabili non sono

generalmente prevedibili,

eppure si presenta spesso

la necessità di prendere

decisioni che riguardano

eventi futuri.

Il

calcolo

della

probabilità permette di assumere atteggiamenti coerenti e giustificabili nel caso

di eventi futuri non ripetibili e di effettuare previsioni quantitative attendibili nel

caso di eventi ripetibili uniformemente e per i quali è quindi possibile effettuare

una serie sufficientemente lunga di osservazioni.

Il calcolo delle probabilità nasce dagli studi dei matematici sui giochi d’azzardo. Da

questi studi, nei primi dell’800, ha origine la prima definizione di probabilità, detta

classica. Successivamente si ebbero le definizioni frequentista e soggettiva e, per

ultimo la definizione assiomatica, dovuta principalmente a Komolgorov.

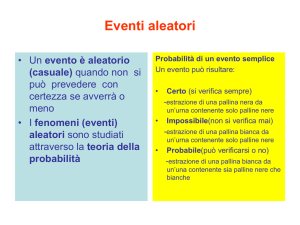

Tutte le definizioni necessitano, però, di un concetto basilare su cui tutte si

fondano: il concetto di evento.

Per gli eventi vale quanto detto per le proposizioni(il concetto di proposizione

riguarda un enunciato per il quale è possibile esprimere immediatamente una

valutazione sulla sua verità o falsità. Vero o falso sono detti valori di verità della

proposizione).

Per cui dati due eventi semplici, due eventi cioè espressi da enunciati non

scomponibili in enunciati più semplici aventi senso compiuto, E1 ed E2, si può

ottenere un evento composto mediante i connettivi logici e (^) ed o (v), oppure

dato un evento E, è possibile considerare la sua negazione (connettivo logico non)

come evento che si verifica se non si verifica E.

4

Le operazioni tra eventi,

medianti i connettivi e ed o,

sono commutativi, associative

e godono della proprietà di

idempotenza.

Per esempio, sono eventi

semplici

E1 : uscita di testa nel lancio di

una moneta

E2 : uscita del 3 nel lancio di

un dado

E3 : uscita di un numero pari

nel lancio di un dado;

mentre sono eventi composti,

ottenuti dai precedenti,

E2 V E3 : uscita del 3 o di un

numero pari nel lancio di un

dado

DEFINIZIONE: due eventi, E1 ed E2, si dicono incompatibili, se il verificarsi dell’uno

esclude il verificarsi dell’altro. In caso contrario, i due eventi si diranno

compatibili.

Esempio: supponiamo di estrarre, da un mazzo di carte da gioco, una carta. Gli

eventi

E1 :estrazione di una carta rossa

E2: estrazione di una figura,

sono compatibili, perché è possibile estrarre una figura rossa.

DEFINIZIONE: due eventi, E1 ed E2 ,si dicono indipendenti, se il verificarsi di uno

dei due non influenza il verificarsi dell’altro. In caso contrario, i due eventi si

dicono dipendenti.

Esempio: consideriamo il gioco della Roulette. Gli eventi

E1 uscita di un numero rosso

E2 uscita di un numero pari

5

sono indipendenti; infatti il verificarsi dell’uno non influisce sul verificarsi

dell’altro. In caso contrario i due eventi si dicono dipendenti.

6

DEFINIZIONE CLASSICA DI PROBABILITÀ

7

Nel mondo che ci circonda

troviamo una quantità

innumerevole di situazioni

probabilistiche.

La probabilità nasce per

rispondere

ad alcune

domande.

Infatti

nel

lontano 1654 un giocatore

d'azzardo, il cavaliere di

Merè, chiese consiglio ad

un matematico francese,

Blaise Pascal (1601-1665),

sul modo di ripartire le

sue puntate in denaro in

un gioco di dadi. Pascal

discusse il problema con un

altro eminente matematico ,

di nome Pierre Fermat (16231662), e la soluzione di questo

problema diede origine alla

teoria della probabilità.

Una delle questioni proposte,

considerata un paradosso, è la

seguente: secondo il giocatore

d'azzardo, la probabilità di

avere almeno un 6 su quattro

lanci di un dado è almeno un doppio 6 su ventiquattro lanci di due dadi doveva

essere la stessa; questa sua convinzione,però non era confermata dall'esperienza.

Aveva ragione l'esperienza. I due matematici francesi avevano quindi discusso su

un fenomeno che in matematica era completamente nuovo. Fino ad allora,

infatti,ad opera principalmente di Galileo Galilei (1564-1642) e Isaac

Newton(1642-1727), dominava un modo di vedere la realtà, detto determinismo

meccanicistico secondo il quale, ogni fenomeno fisico nel mondo reale doveva

seguire leggi matematiche e che non ci si poteva fermare alla descrizione di come

era fatto il mondo, ma si doveva capire anche come funzionava. Nasceva così la

convinzione che poche leggi governavano i fenomeni del mondo fisico e

permettevano di prevedere ogni evoluzione futura dell'universo.

8

Possiamo schematizzare il successo del determinismo meccanicistico con la

seguente affermazione:

(Dati) + (Leggi) = (Conoscenza)

Ciò significa essere in grado ,per esempio,di prevedere in quale istante e in quale

luogo un corpo lanciato toccherà terra. Ma per Pascal e Fermat il meccanicismo

deterministico non riusciva a risolvere tutti i problemi che la ricerca poneva: certi

fenomeni non si verificavano con certezza ma avevano una evoluzione casuale

non univocamente prevedibile. Per essi quindi vale la seguente affermazione:

(Dati)+(Leggi)=(Conoscenza non completa)

In molti esperimenti, è possibile calcolare a priori quali e quanti sono i casi che

possono realizzarsi e quali e quanti tra questi sono quelli da considerarsi

favorevoli all’esito dell’esperimento. In questi casi, quando è cioè possibile

conoscere a priori il numero dei casi favorevoli m e quello dei casi possibili n, si

può considerare come misura della probabilità dell’evento considerato, secondo

la definizione di La Place, il rapporto tra il numero dei casi favorevoli e quello dei

casi possibili a condizione che però tutti i casi abbiano la stessa possibilità di

realizzarsi:

Dalla definizione si deduce facilmente che p può assumere valori compresi tra 0 e

1, estremi inclusi. Nel primo caso l’evento considerato è detto impossibile, nel

secondo è detto certo. Per tutti i valori compresi tra 0 e 1 l’evento è detto

aleatorio o casuale. Per questo motivo, la probabilità così calcolata è detta a

priori.

Osservazioni

La definizione classica presenta vari punti deboli. Intanto, dal punto di vista

pratico, si può osservare che la sua applicazione è legata all’effettiva possibilità di

conoscere a priori m ed n e ciò è effettivamente possibile solo in alcuni casi.

Inoltre, la definizione prevede un ambiente ideale nel quale tutti gli eventi sono

ugualmente possibili, cosa non sempre realizzabile nella realtà e non tiene,

quindi, conto di tutti quei fattori che potrebbero influire sul verificarsi o meno di

un evento. Nella definizione viene indicata la condizione che i casi possibili siano

tutti ugualmente possibili e ciò potrebbe essere espresso dicendo che i casi

9

devono essere equiprobabili. Delle osservazioni critiche ora fatte si tenne conto

negli studi che portarono alle altre definizioni già citate che permisero di ovviare,

almeno in parte a questi difetti.

Eventi ed insiemi

Le considerazione che seguono permettono di visualizzare un esperimento ed i

suoi possibili esiti utilizzando un modello insiemistico.

Consideriamo l’evento E: uscita di una faccia contrassegnata da un numero pari,

nel lancio di un dado. Si possono considerare possibili esiti come elemento di un

insieme, che chiameremo U, insieme universo.

U

1

2

6

3

5

4

La probabilità dell’evento E, secondo la definizione classica sarà

In generale, ad ogni esperimento è possibile associare l’insieme universo U dei

risultati possibili e un sott’insieme proprio di U, i cui elementi sono risultati

favorevoli all’evento e che possiamo considerare coincidente con l’evento stesso.

10

PROBABILITÀ FREQUENTISTA

11

LA DEFINIZIONE FREQUENTISTA

DI PROBABILITA’

In molti dei problemi della realtà

è

possibile

effettuare

praticamente un certo numero

di prove e rilevare gli esiti di

queste. Se su n prove un certo

evento E si è presentato m volte,

il rapporto m/n esprime la

frequenza con cui l’evento E si è

verificato

relativamente

al

numero n di prove effettuate.

Tale rapporto che indicheremo con f è detto quindi frequenza relativa mentre m è

detta frequenza assoluta dell’evento considerato.

I valori che la frequenza può assumere sono compresi bell’intervallo chiuso *0;1+,

avendosi il valore 0 quando m=0, cioè quando E non si è mai realizzato, e il valore

1 quando m=n, cioè quando l’evento E si è realizzato in ogni prova.

Malgrado ciò però la frequenza e la probabilità sono concetti molto diversi,

essendo la prima una quantità calcolata a posteriori, cioè dopo aver effettuato

l’esperimento e la seconda una quantità, come già detto, a priori.

La legge empirica del caso

P ed f non sono indipendenti tra loro, anzi esiste uno strettissimo legame,

espresso dalla legge ricavata empiricamente, detta appunto legge empirica del

caso o legge dei grandi numeri:

eseguendo un grande numero di prove, effettuate tutte nelle medesime

condizioni, il valore della frequenza approssima il valore della probabilità e tale

approssimazione è tanto maggiore quanto più alto è il numero di prove effettuate.

Grazie alle legge empirica del caso, è possibile utilizzare la frequenza come valore

approssimato della probabilità a priori, quando non sussistono le condizioni

perché questa sia calcolata.

Da ciò ha origine la definizione frequentista:

la frequenza di un evento, calcolata effettuando un gran numero di prove, può

essere considerata come il valore approssimato della probabilità.

12

La legge permette, inoltre di effettuare previsioni sull’esito di un esperimento, se

è possibile calcolare la probabilità a priori dell’evento in esame.

LAPLACE E LA PROBABILITÀ

Nel 1779 Laplace indicò il

metodo per stimare il

rapporto del numero dei

casi favorevoli rispetto al

numero totale dei casi

possibili. Esso consiste nel

considerare

i

valori

successivi di una qualsiasi

funzione come i coefficienti

dello sviluppo di un'altra

funzione con riferimento ad

una

diversa

variabile.

Questa seconda funzione

viene dunque chiamata la

funzione generatrice della

precedente. Laplace mostrò

come, per mezzo dell'interpolazione, questi

coefficienti possano essere determinati a

partire dalla funzione generatrice. In seguito

egli affrontò il problema inverso, trovando dai

coefficienti la funzione generatrice mediante la

soluzione di un'equazione alle differenze finite.

Il metodo è scomodo e, dati i successivi sviluppi

dell'analisi, oggi viene usato raramente. Il suo

trattato Théorie analytique des probabilités

include un'esposizione del metodo dei minimi

quadrati, una notevole testimonianza della

padronanza di Laplace sui procedimenti

13

dell'analisi. Il metodo dei minimi quadrati, tramite numerose osservazioni, era

stato spiegato empiricamente da Carl Friedrich Gauss e Legendre, ma il quarto

capitolo di questo lavoro contiene una dimostrazione formale di esso, su cui da

allora si è basata l'intera teoria degli errori. Questo fu dimostrato solo grazie a

un'analisi più complessa, inventata appositamente per lo scopo, ma la forma in

cui viene presentato è così incompleta che, nonostante la costante accuratezza

dei risultati, ci si chiese se Laplace aveva effettivamente esaminato con attenzione

il difficile lavoro che egli stesso aveva così brevemente e spesso erroneamente

mostrato.

14

PROBABILITÀ SOGGETTIVA

15

DEFINIZIONE PROBABILITA’ SOGGETTIVA

Esistono, però, eventi per i quali non è applicabile nessuna delle due definizioni

precedenti, esistono cioè eventi, per i quali è impossibile il calcolo di p, non

potendosi conoscere m ed n, per i quali non è possibile calcolare f trattandosi di

un evento unico non verificatosi precedentemente e che non si verificherà più in

futuro. Si tratta di eventi tutt’altro che rari anzi, nella maggior parte dei casi, sono

di questo tipo gli eventi aleatori sui quali ci si trova a dover prendere decisioni. Un

esempio classico è la scommessa sul risultato di un avvenimento sportivo, come

una corsa di cavalli o una partita di calcio. Per quanto soggettiva la valutazione

non è però arbitraria, ma deve rispondere a un principio di coerenza. Per la scuola

che segue il principio di coerenza e che fa capo al matematico B. De Finetti, la

probabilità di un evento può essere definita come la misura della fiducia del

verificarsi di un evento che ha

un individuo coerente. Per

“coerenza”, sarà p(E)=0 se

l’evento

è

considerato

impossibile in base alle proprie

informazioni

e

opinioni,

mentre sarà p(E)=1 se l’evento

è considerato certo. Sarà

0<p(E)<1

se

l’evento

è

aleatorio: il valore sarà tanto

più prossimo ad 1 quanto

maggiore è la fiducia che

l’individuo coerente ha del verificarsi dell’evento, sarà tanto più prossimo a 0

quanto minore è questa fiducia. Poiché molte scelte comportano l’investimento di

un capitale s nella speranza di ricavarne uno S, con s<S, per coerenza la

probabilità p dell’evento E al verificarsi del quale, avendo avuto una spesa s, si

introita la somma S, deve essere tale che

Sp=s

da cui

Poichè il rapporto s/S rappresenta la somma che si è disposti a sborsare per

esigere un capitale unitario, si può dare la seguente definizione:

16

la probabilità di un evento, secondo un individuo coerente, è la somma ch’egli

considera equo sborsare per avere la possibilità di incassare un importo unitario

al verificarsi dell’evento considerato.

BRUNO DE FINETTI E LA PROBABILITÀ

De Finetti è stato un matematico e statistico

italiano, noto soprattutto per la formulazione della

concezione

soggettiva

operazionale

della

probabilità. La probabilità è l'argomento di cui De

Finetti si è occupato in modo più specifico e

continuativo. Egli sostiene il significato soggettivo

della probabilità. Egli inoltre rivolge critiche radicali

ad alcune correnti concezioni e definizioni

(o pseudo definizioni) della probabilità. "La

probabilità non è nient'altro che il grado di fiducia

(speranza, timore, ..) nel fatto che qualcosa di

atteso (temuto, o sperato, o indifferente) si

verifichi e risulti vero". Lo statistico italiano è

inoltre noto per aver ideato il Diagramma di De

Finetti, il quale permette di individuare la

posizione di una popolazione in un grafico basato su coordinate triangolari,

rispetto all'equilibrio di Hardy-Weinberg.

De Finetti e Savage hanno proposto una definizione di probabilità applicabile ad

esperimenti casuali i cui eventi elementari non siano ritenuti ugualmente possibili

e che non siano necessariamente ripetibili più volte sotto le stesse condizioni: la

probabilità di un evento è il prezzo che un individuo ritiene equo pagare per

ricevere 1 se l'evento si verifica, 0 se l'evento non si verifica.

Al fine di rendere concretamente applicabile la definizione, si aggiunge un criterio

di coerenza: le probabilità degli eventi devono essere attribuite in modo tale che

non sia possibile ottenere una vincita o una perdita certa.

In tal modo è possibile ricavare dalla definizione soggettiva le stesse tre regole già

viste.

1. P(A) è compresa tra 0 e 1; se infatti fosse negativa si avrebbe un guadagno

certo, se fosse maggiore di 1 si avrebbe una perdita certa;

2. P(Ω) = 1; se l'evento è certo, si riceverà sicuramente 1, ma se fosse P(Ω) < 1

si avrebbe un guadagno certo, pari a 1 - P(Ω), se invece fosse P(Ω) > 1 si

avrebbe una perdita certa;

17

3. se A∩B = ∅, P(A∪B) = P(A)+P(B). Si osserva preliminarmente che se

gli n eventi A1, A2, ..., An sono incompatibili (non possono presentarsi

insieme) e necessari (uno di loro deve necessariamente verificarsi), la

somma delle probabilità P(Ai), con i che va da 1 a n, è uguale a 1; infatti, se

si paga P(Ai) per ciascun evento,

se la somma fosse inferiore a 1 si

avrebbe un guadagno certo, se

fosse superiore si avrebbe una

perdita certa. Si considerano poi

gli eventi incompatibili A e B e

l'evento complemento della loro

unione; i tre eventi sono

incompatibili e necessari e si ha:

Sono però incompatibili anche

l'unione di A e B ed il suo

complemento:

Dalle due uguaglianze segue:

se

, allora

La definizione soggettiva consente quindi di calcolare la probabilità di eventi

anche quando gli eventi elementari non sono equiprobabili e quando

l'esperimento non può

essere ripetuto. Rimane

fondata,

tuttavia,

sull'opinione di singoli

individui, che potrebbero

presentare

diverse

propensioni al rischio.

Basta pensare che molti

sarebbero

disposti

a

giocare 1 euro per

vincerne 1000, ma pochi

giocherebbero un milione

di euro per vincerne un

miliardo.

18

PROBABILITÀ ASSIOMATICA

19

DEFINIZIONE PROBABILITA’ ASSIOMATICA

Negli anni centrali del XX secolo, tuttavia, prima Bruno de Finetti e poi Leonard

Jimmie Savage hanno elaborato una

concezione soggettiva della probabilità,

secondo cui essa è il grado di fiducia che

una persona ha nel verificarsi dell'evento.

Nello stesso periodo, Andrey Nikolaevich

Kolmogorov ha dato inizio alla moderna

teoria assiomatica (Grundbegriffe der

Wahrscheinlichkeitsrechnung,

1933),

ispirandosi alla teoria della misura.

Si è così affermata una teoria della

probabilità puramente matematica, che

generalizza il patrimonio matematico

comune alle diverse impostazioni.

Seguendo l'impostazione di Kolmogorov

(1950), si può introdurre la teoria della probabilità seguendo un modo di

procedere detto "assiomatizzazione", che consiste nei seguenti momenti:

a) si introducono i concetti primitivi (prova, evento e probabilità), cioè delle

nozioni originarie e intuitive;

b) mediante tali concetti si stabiliscono delle affermazioni, detti postulati o

assiomi, che non si dimostrano; c) dai postulati, e solo tramite essi, si

deducono tutte le possibili conseguenze, sia logiche che matematiche,

pervenendo alla dimostrazione dei teoremi del calcolo delle probabilità. Nel

corso di questo secolo i matematici usando i metodi della logica formale e

della teoria degli hanno formulato una nuova definizione di probabilità,

detta assiomatica.

20

Lo spazio degli eventi

Alla base di questa

impostazione sta il

concetto di spazio

degli eventi. Abbiamo

già accennato al fatto

che ad ogni evento E è

possibile associare un

insieme, logicamente

coincidente

con

l’evento

stesso,

avente come elementi

tutti gli esiti favorevoli

al realizzarsi di E. Per

esempio nel lancio di

un

dado

si

ha

U=,1,2,3,4,5,6-. Consideriamo per l’insieme delle parti di U p(U), cioè l’insieme

avente come elementi tutti i possibili sottoinsiemi di U compresi l’insieme ∅ e

l’insieme U stesso. Nell’esempio si ha

P(U)={E0, E1, E2, E3, E4, E5, E6, E7, E8, E9, E10, E11, E12,…}

con E1=1, E2=2, E3=3, E4=4, E5=5, E6=6, E7=1,2, E8=1,3, E9=1,4, …

questo insieme è detto spazio degli eventi s.

in generale, dato un insieme U i cui elementi diremo eventi elementari, si chiama

spazio degli eventi l’insieme p(U) di tutti i sottoinsiemi di U.

21

Gli assiomi

I seguenti assiomi permettono di attribuire

alla funzione p(E) le caratteristiche che la

rendono utilizzabile nel calcolo delle

probabilità.

Assioma 1. Ad ogni elemento E nello spazio

degli eventi è associabile un numero reale

p(E) non negativo detto probabilità di E.

Assioma 2. Dati tre elementi E1, E2, E3 dello

stesso spazio degli eventi disgiunti tra loro si

ha che:

p(E1 U E2 U E3)= p(E1)+ p(E2)+ p(E3);

si dice che la funzione p(E) è una funzione

additiva d’insieme.

Assioma 3. Essendo S lo spazio degli eventi si ha p(S)=1. Si può osservare che,

poiché S U ∅ = S, per il secondo assioma si ha

p(S)= p(S)+ p(∅)

1=1+p(∅)

E quindi p(∅)=0, cioè la probabilità di un evento impossibile vale 0.

22

TEOREMI SULLA PROBABILITÀ

23

Teorema sulla probabilità contraria

Facendo riferimento alla teoria assiomatica, consideriamo due elementi dello

spazio degli eventi S, l’evento E e il suo complementare rispetto ad S, E’= E’’. Sarà

naturalmente

S = E U E’’

E per il secondo assioma

P(S)= p(E)+ p(E’’).

Poiché il terzo assioma è

P(S)=1,

si ha

p(E)+ p(E’’)=1

tale teorema della probabilità contraria si esprime dicendo che

la somma delle probabilità di un evento E e del suo contrario E’’ è uguale ad 1.

Teorema della probabilità totale

Il secondo assioma della teoria assiomatica è conosciuto come il teorema della

probabilità totale e si esprime dicendo che: dati due o più eventi incompatibili E1,

E2, E3, la probabilità dell’evento U p(E1 U E2 U E3) è data dalla somma delle

probabilità dei singoli eventi cioè, in formula

p(E1 U E2 U E3)= p(E1)+ p(E2)+ p(E3)

si può, però, presentare il caso di dover calcolare la probabilità dell’evento unione

di eventi compatibili.

Consideriamo il caso di due eventi E1 e E2 compatibili.

U

E1

24

E2

L’evento composto E2 – (E1 ∩ E2) è incompatibile con E1 e, come si può osservare

dalla figura, l’unione tra questo evento ed E1 è uguale all’unione tra E1 ed E2,

cioè

E1 U E2 = E1 U(E2 – (E1 ∩ E2 ))

Da cui

P(E1 U E2)= p(E1) + p(E2) – p(E1 ∩ E2 )

Il teorema della probabilità totale nel caso di eventi compatibili si esprime

dicendo che

dati due eventi E1 ,E2 compatibili, la probabilità dell’evento (E1 U E2 )è data

dalla somma delle probabilità dei singoli eventi diminuita della probabilità

dell’evento intersezione.

Probabilità condizionata

Sia E1 l’evento estrazione di una pallina avente il colore verde, E2 l’evento

estrazione di una pallina avente il colore rosso. L’evento estrazione di una pallina

avente il colori verde e rosso sarà E1 ∩ E2.

Si ha che

p(E1)= n1 +n3 /n , poiché n1 + n3 è il totale delle palline aventi una parte verde;

p(E2)= n1 + n2/n , poiché n1+n2 è il totale delle palline aventi una parte rossa;

p(E1 ∩ E2)= n1/n2

si consideri adesso l’evento “estrazione di una pallina con una metà verde,

supposto che l’altra metà sia rossa, cioè il verificarsi dell’evento E1 subordinato (o

condizionato) al realizzarsi di E2 ; indichiamo un tale evento con il simbolo E1/E2.

Nota: il fatto che l’evento E1 sia subordinato all’evento E2 non vuol dire che E1

deve realizzarsi “dopo” E2; E1 può realizzarsi in concomitanza ad E2.

Poiché si sta considerando il realizzarsi di E1 essendosi realizzato anche E2

dovranno essere considerati possibili tutti e solo i casi che danno ad E2 la

possibilità di realizzarsi: essi sono tanti quanti il numero delle palline contenenti il

colore rosso e cioè le n1 palline rosse o verdi più le palline n2 rosso o bianche. Si

avrà allora

P(E1/E2)= n1/ n1 + n2

Da cui, dividendo numeratore e numeratore per n, si ha

P(E1/E2)= n1/ n/ n1 + n2 /n

25

-10E cioè, in termini di probabilità

P(E1/E2)= p(E1 ∩ E2)/ p(E2)

La probabilità di un evento E1 subordinato al realizzarsi di un evento E2, detto

probabilità condizionata è data dal rapporto tra la probabilità che E1 ed E2 si

realizzino contemporaneamente e la probabilità di realizzarsi di E2.

Teorema della probabilità composta

La formula

p(E1 ∩ E2)- p(E1)x P(E1/E2)

permette di calcolare la probabilità dell’evento intersezione E1 ∩ E2, detta

probabilità composta che si esprime dicendo

dati due eventi dipendenti E1 ed E2, la probabilità dell’evento E1 ∩ E2 è uguale

al prodotto della probabilità dell’evento E1 per la probabilità dell’evento E2

subordinato all’evento E1 (evento E2/ E1).

Se gli eventi E1 ed E2 sono indipendenti, la probabilità di E2 è indipendente dal

verificarsi di E1 e quindi è p(E2/ E1) = p(E2) e perciò avremo

p(E1 ∩ E2)= p(E1)x p(E2)

si può quindi enunciare tale teorema come:

dati due eventi E1 ed E2 indipendenti, la probabilità dell’evento E1 ∩ E2 è data

dal prodotto della probabilità dell’evento E1 per la probabilità dell’evento E2.

26

LA STATISTICA

27

LA STATISTICA

Studia fenomeni collettivi (demografici, economici, scientifici..) mediante

l’osservazione dei fatti e degli eventi, con lo scopo di interpretarli attraverso l’uso

di opportuni modelli.in tutti i problemi di statistica si devono analizzare grandi

mane di dati che sono raccolti e classificati ed elaborati allo scopo di ottenere

certi risultati o di formulare e verificare delle ipotesi. La statistica opera su

popolazioni di dati che possiedono determinate caratteristiche alla quali viene

dato il nome di caratteri o attributi. Se la popolazione è troppo estesa per essere

analizzata completamente allora si estrae un campione appropriatamente scelto.

Soluzione problemi

Ragionamento deduttivo:

Ragionamento induttivo:

E’ utilizzato quando si

per conoscono i caratteri di una

popolazione e si possono ricavare

le proprietà dei doveri con più

possibilità di estrarli.

Procede da ipotesi vere e

conduce a risultati veri.

Procede da casi particolari

giungere a considerazioni generali

28

CLASSIFICAZIONE DELLA STATISTICA

Descrittiva

Inferenziale

ha come scopo quello di raccogliere

informazioni relative alle caratteristiche

di uno stato (da cui il nome). Opera su

grandezze certe e non utilizza grandezze

probabilistiche.

Opera su un campione e su

grandezze di tipo probabilistico.

Adotta il metodo induttivo. I

risultati sono incerti.

POPOLAZIONE

CAMPIONE

Estrazione

campione

Processo di inferenza

del campione

Esempio: per determinare l’efficacia di un farmaco si conducono analisi di tipo

statistico inferenziale analizzando differenti campioni di popolazione e

confrontando i risultati. Dai comportamenti registrati si inducono comportamenti

validi per tutta la popolazione.

29

Si occupa della descrizione delle distribuzioni statistiche di una sola variabile.

I dati raccolti vengono organizzati in tabelle e poi analizzate e descritte per mezzo

di alcuni indici.

Se alcuni dati si verificano più volte si ottiene la frequenza assoluta.

Se i dati raccolti sono numeri interi si diranno discreti; se i dati sono approssimati

si diranno continui.

30

Esempio: lancio di un dado 40 volte.

Punteggio.

1

2

3

4

5

6

Frequenza.

4

8

9

7

4

8

Totale

40

f%

DATI DISCRETI

1

2

3

diagramma ad aste

DATI DISCRETI

f%

punteggio

1

2

3

4

31

non sono classi

Esempio: Serie di 30 misure di peso in grammi arrotondati all’unità.

60,48,73,79,86,90,61,64,67,57,95,87,93,78,91…..

30

I dati raccolti si possono organizzare in tabelle di frequenze. A fianco di ciascun

intervallo, detto classe di frequenza, si riporta la frequenza assoluta con cui

compare il dato.

CLASSE

FREQUENZA

ASSOLUTA

FREQUENZA

RELATIVA

FREQUENZA

PERCENTUALE

FREQUENZA

CUMULATA

40 – 49

2

7%

2

50 – 59

4

13%

4+2=6

60 – 69

5

2 0, 07

30

4 0, 13

3

5 0, 17

30

17 %

5 + 6 = 11

70 – 79

12

40 %

12 +11 = 23

80 – 89

4

13 %

4 + 23 = 27

90 – 99

3

10 %

3 + 27 = 31

TOTALI

30

1,0

32

100 %

RAPPRESENTAZIONE GRAFICA

33

Per rappresentare una distribuzione frequenza si associa ai dati raccolti nelle

tabelle di frequenza un grafico detto diagramma di frequenza. Uno dei più noti è

l’istogramma, detto anche grafico a colonne, in cui sull’asse delle ascisse si

riportano i dati suddivisi in classi di frequenza e sull’asse delle ordinate la

frequenza. Gli estremi delle classi di frequenza, detti limiti e confini delle classi, si

trovano nel punto medio tra la fine di una classe e l’inizio della classe successiva.

Estremi della classe 50 – 59.

49 50 49, 5 e. i.

2

59 60 59, 5 e. s.

2

Si disegna per ciascuna classe una colonna avente base costante e altezza

proporzionale alla frequenza.

f

In alternativa si possono utilizzare i poligoni di frequenza, che si ottengono

congiungendo i punti medi del lato superiore di ciascuna sbarra dell’istogramma.

L’ordinata del punto medio è il valore della frequenza, l’ascissa si ricava

sommando i punti xi e xi+1 della classe 2.

Xmi i i 1

centro o valore centrale della i- esima classe

2

34

Es :

mi 49, 5 59, 5 54, 5

2

f

misure pesi

Poiché a ogni distribuzione di frequenza è associabile una distribuzione

cumulativa di frequenza è associabile una distribuzione cumulativa di frequenza,

oltre a questi diagrammi possiamo disegnare grafici detti poligoni delle frequenze

cumulate od ogive. Le frequenze cumulate sull’asse delle ordinate e sull’asse delle

ascisse gli estremi di ogni classe, l’ordite dell’esterno sinistro della prima classe è

0 mentre l’ordite di ciascun estremo destro coincide col valore della frequenza

cumulata.

35

LE DISTRIBUZIONI CONTINUE

Per le distribuzioni continue l’istogramma è un’approssimazione della

distribuzione delle probabilità.

36

Distribuzione continua normale o gaussiana

Presenta le seguenti caratteristiche:

1) ha un unico picco centrale, per cui esiste una sola moda.

2) è simmetrica e quindi la moda coincide con la media

3) le probabilità di valori sempre più lontani dalla media sono via via più piccole.

La distribuzione gaussiana assume notevole importanza per l’esecuzione di

misure di laboratorio di grandezze fisiche. I valori si distribuiscono attorno al

valore medio secondo una curva ‘campana’ in modo che i valori meno probabili

sono quelli più lontani dal valore atteso.

Questa distribuzione è rappresentata dalla funzione densità di probabilità:

S(x)= |c e (elevato a –h(x- ) al quadrato

Dove

= valore medio della variabile aleatoria x

|C= costante arbitraria il cui valore influenza lo sviluppo verticale della campana:

al crescere di k cresce l’altezza della curva e viceversa, da k dipende anche l’area

totale sottesa. In generale, si utilizza una distribuzione gaussiana normalizzata in

modo che l’area sottesa sia unitaria.

in questo caso il valore di k è fissato e dipende dalla deviazione standard δ

h è una costante il cui valore influenza lo sviluppo orizzontale della campana: al

crescere di h la curva assume una forma più larga.

Il valore h dipende da δ:

h = 1/2 δ2

Sostituendo h e k si ha

δ (x) =

e –(x-

2

2 δ2

37

La distribuzione gaussiana dipende da due valori:

1) la media ;

2) la deviazione standard δ.

La funzione di distribuzione per una distribuzione normale è data da:

–(x-

F(x) =

)2 dx

2

2

f(x)

1 - - - - -2 - - - - - - - - - - - - 1- - - - - -

In una distribuzione gaussiana:

1) tra i valori - e + cade il 68,3% dei valori della distribuzione;

2) tra i valori - e + cade il 95,5% dei valori della distribuzione;

3) tra i valori - e + cade il 99,7% dei valori della distribuzione

38

LICEO SCIENTIFICO “E. SICILIANO” Bisignano (CS) a.s. 2011/2012

CLASSE IVB:

Polverazzi Valentina - Prezioso Ilenia - Giovinco Valentina - Spera M. N. Jacqueline

- Ritacco Pamela

DOCENTE REFERENTE: Tortorella Franca

39