Probabilità

Da Wikipedia, l'enciclopedia libera.

Il concetto di probabilità, utilizzato a partire dal '600, è diventato con il passare del tempo la base

di diverse discipline scientifiche. In particolare su di esso si basa una branca della statistica (la

statistica inferenziale), cui fanno ricorso numerose scienze sia naturali che sociali.

Cenni storici

La nascita del concetto moderno di probabilità viene attribuita a Blaise Pascal (1623-1662) e Pierre

de Fermat (1601-1665). Il Cavalier de Méré (un accanito giocatore passato alla storia per questo)

aveva calcolato che ottenere almeno un 6 in 4 lanci di un dado non truccato era equivalente ad

ottenere almeno un doppio 6 in 24 lanci, sempre di un dado non truccato. Tuttavia, giocando

secondo tale convinzione, invece di vincere perdeva e scrisse a Pascal lamentando che la

matematica falliva di fronte all'evidenza empirica. Da ciò scaturì una corrispondenza tra Pascal e

Fermat in cui iniziò a delinearsi il concetto di probabilità nell'accezione frequentista.

Definizioni

In probabilità si considera un fenomeno osservabile esclusivamente dal punto di vista della

possibilità o meno del suo verificarsi, prescindendo dalla sua natura. Tra due estremi, detti evento

certo (ad esempio: lanciando un dado si ottiene un numero compreso tra 1 e 6) ed evento

impossibile (ottenere 1 come somma dal lancio di due dadi), si collocano eventi più o meno

probabili.

Si dice spazio degli eventi l’insieme non vuoto Ω che ha come elementi tutti i risultati possibili di

un esperimento Gli eventi vengono normalmente indicati con lettere maiuscole. Dati due eventi A e

B, si indica con AUB la loro unione, ovvero l'evento costituito dal verificarsi dell'evento A oppure

dell'evento B. Si indica con A∩B la loro intersezione, ovvero l'evento costituito dal verificarsi sia

dell'evento A che dell'evento B. Se A∩B = ∅ i due eventi A e B vengono detti incompatibili (non

possono verificarsi simultaneamente). Il complemento di un evento A rispetto a Ω, Ω\A, è detto

negazione di A e indica il suo non verificarsi (ovvero il verificarsi dell'evento complementare).

Definizione classica

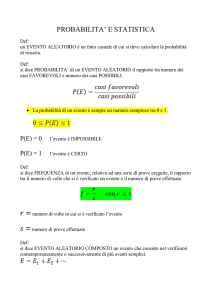

Secondo la prima definizione di probabilità, per questo detta classica, la probabilità di un evento è il

rapporto tra il numero dei casi favorevoli all'evento e il numero dei casi possibili, purché questi

ultimi siano tutti equiprobabili. Questa definizione è spesso attribuita a Pierre Simon Laplace e

quindi anche identificata definizione classica di Laplace.

Indicando con Ω l'insieme di casi possibili e con |Ω|=n la sua cardinalità, con A un evento e con nA

il numero dei casi favorevoli ad A.

Ad esempio, nel lancio di un dado Ω={1,2,3,4,5,6}, n = 6, A = "numero pari", nA = 3), la probabilità

di A, indicata con P(A), è pari a:

Dalla definizione seguono tre regole:

1. la probabilità di un evento è un numero compreso tra 0 e 1;

2. la probabilità dell'evento certo è pari a 1; se A = "numero compreso tra 1 e 6", nA = 6 e nA/n

= 1;

3. la probabilità del verificarsi di uno di due eventi incompatibili, ovvero di due eventi che non

possono verificarsi simultaneamente, è pari alla somma delle probabilità dei due eventi;

se A = "numero pari", con P(A) = 1/2, e B= "esce il 3", con P(B) = 1/6, la probabilità che

tirando un dado si ottenga un numero pari oppure un 3 è:

La definizione classica consente di calcolare effettivamente la probabilità in molte situazioni.

Inoltre, è una definizione operativa e fornisce quindi un metodo per il calcolo. Presenta tuttavia

diversi aspetti negativi non irrilevanti:

dal punto di vista formale, è una definizione circolare: richiede che i casi possiedano tutti la

medesima probabilità, che è però ciò che si vuole definire;

non definisce la probabilità in caso di eventi non equiprobabili;

presuppone un numero finito di risultati possibili e di conseguenza non è utilizzabile nel

continuo.

Definizione frequentista

Per superare tali difficoltà, Richard von Mises (1883-1953) propose di definire la probabilità di un

evento come il limite cui tende la frequenza relativa dell'evento al crescere del numero degli

esperimenti:

La definizione frequentista si applica ad esperimenti casuali i cui eventi elementari non siano

ritenuti ugualmente possibili, ma assume che l'esperimento sia ripetibile più volte, idealmente

infinite, sotto le stesse condizioni.

Anche tale definizione consente di calcolare la probabilità di molti eventi e da essa si ricavano le

stesse tre regole che seguono dalla definizione classica. È sufficiente, infatti, sostituire il rapporto

tra numero dei casi favorevoli nA e numero dei casi possibili n con il limite del rapporto per n

tendente all'infinito.

Tuttavia:

il "limite" delle frequenze relative non è sempre calcolabile;

non tutti gli esperimenti sono ripetibili; ad esempio, ha sicuramente senso chiedersi quale sia

la probabilità che vi sia vita su Marte o che tra 50 anni il tasso di natalità in Africa diventi la

metà di quello attuale, ma in casi simili non è possibile immaginare esperimenti ripetibili

all'infinito.

Definizione soggettiva

De Finetti e Savage hanno proposto una definizione di probabilità applicabile ad esperimenti casuali

i cui eventi elementari non siano ritenuti ugualmente possibili e che non siano necessariamente

ripetibili più volte sotto le stesse condizioni: la probabilità di un evento è il prezzo che un individuo

ritiene equo pagare per ricevere 1 se l'evento si verifica, 0 se l'evento non si verifica.

Al fine di rendere concretamente applicabile la definizione, si aggiunge un criterio di coerenza: le

probabilità degli eventi devono essere attribuite in modo tale che non sia possibile ottenere una

vincita o una perdita certa.

In tal modo è possibile ricavare dalla definizione soggettiva le stesse tre regole già viste.

1. P(A) è compresa tra 0 e 1; se infatti fosse negativa si avrebbe un guadagno certo, se fosse

maggiore di 1 si avrebbe una perdita certa;

2. P(Ω) = 1; se l'evento è certo, si riceverà sicuramente 1, ma se fosse P(Ω) < 1 si avrebbe un

guadagno certo, pari a 1 - P(Ω), se invece fosse P(Ω) > 1 si avrebbe una perdita certa;

3. se A∩B = ∅, P(AUB) = P(A)+P(B).

La definizione soggettiva consente quindi di calcolare la probabilità di eventi anche quando gli

eventi elementari non sono equiprobabili e quando l'esperimento non può essere ripetuto. Rimane

fondata, tuttavia, sull'opinione di singoli individui, che potrebbero presentare diverse propensioni al

rischio. Basta pensare che molti sarebbero disposti a giocare 1 euro per vincerne 1000, ma pochi

giocherebbero un milione di euro per vincerne un miliardo.

Elenchiamo alcune proprietà elementari della probabilità:

Se P(A) è la probabilità di un evento A, la probabilità dell'evento complementare è 1-P(A).

Infatti, poiché l'intersezione di A e del suo complemento è vuota e la loro unione è Ω, dagli

assiomi 3 e 4 si ricava:

La probabilità dell'evento impossibile è pari a zero. Infatti l'insieme vuoto è il complemento

di Ω e si ha:

La probabilità di un evento è minore o uguale a 1. Infatti, dovendo la probabilità essere non

negativa per il secondo assioma, si ha:

Se un evento A è incluso in un evento B, allora la sua probabilità è minore o uguale a quella

di B. Infatti, se B include A può essere espresso come unione di insiemi disgiunti e si ha:

Teoremi di base

Dai suddetti assiomi derivano alcuni teoremi e concetti fondamentali.

Il teorema della probabilità totale consente di calcolare la probabilità dell'unione di due o più

eventi, ovvero la probabilità che si verifichi almeno uno di essi. Essa è la somma delle probabilità

dei singoli eventi se sono a due a due incompatibili; in caso contrario, alla somma va sottratta la

somma delle probabilità delle intersezioni due a due, poi aggiunta la somma delle probabilità delle

intersezioni a tre a tre e così via. Ad esempio, nel caso di tre eventi:

Si dice probabilità condizionata di A dato B, e si scrive P(A|B), la probabilità che l'evento A ha di

verificarsi quando si sappia che B si è verificato:

Attraverso tale concetto si perviene al teorema della probabilità composta, che consente di

calcolare la probabilità dell'intersezione di due o più eventi, ovvero la probabilità che essi si

verifichino tutti. Nel caso di due eventi (che può essere generalizzato), si ha:

Nel caso che la probabilità di A dato B, P(A|B), sia uguale a P(A), i due eventi vengono definiti

indipendenti stocasticamente (o probabilisticamente) e dalla stessa definizione segue una diversa

formulazione della probabilità composta, caso particolare del precedente: P(A∩B)=P(A)P(B).

Il teorema di Bayes consente di calcolare la probabilità a posteriori di un evento Ai, quando si

sappia che si è verificato un evento E. Se Ai appartiene ad un insieme finito o numerabile di eventi a

due a due incompatibili, e se E si verifica allora si verifica necessariamente uno degli eventi di tale

insieme (ed uno solo, dato che sono incompatibili), allora, conoscendo le probabilità a priori degli

eventi Ai e le probabilità condizionate P(E|Ai) e sapendo che si è verificato E, si può calcolare la

probabilità a posteriori di un particolare Ai:

Più discorsivamente: se si conoscono sia le probabilità a priori delle diverse possibili "cause" di E

(ma non si sa per effetto di quale di esse E si è verificato), sia le probabilità condizionate di E data

ciascuna delle cause, è possibile calcolare la probabilità che E si sia verificato per effetto di una

particolare causa.