La probabilità

Concetti di base

Probabilità

Grado di incertezza connesso al

risultato scaturito da una prova

Esempio

Numero che appare sulla faccia superiore

del dado dopo averlo lanciato

Concetti primitivi di probabilità

La prova

La prova è un esperimento

Che ha due o più possibili

risultati

L’evento

Per evento si intende uno

dei possibili risultati della

prova

La probabilità

La probabilità è un numero

compreso tra 0 ed 1 che

misura il grado di incertezza

sul verificarsi di un evento

Prova, evento e probabilità

In una data prova, l’evento E

si verifica con probabilità P(E)

Esempio:

Nel lancio di un dado (ben bilanciato)

La faccia contrassegnata dal numero 5

(E=5) si presenta con probabilità

P(E=5)=1/6

Eventi e Algebra di Eventi

Postulato 1

Gli eventi formano una

algebra di Boole

Dato il postulato 1 sono definite le seguenti

operazioni:

1.

La negazione di un evento A, ossia A

2.

L’intersezione tra due eventi A e B, ossia A B

3.

L’unione tra due eventi A e B, ossia A B

6

Eventi

Definizione due eventi rilevanti:

Evento impossibile: è l’evento che non può mai verificarsi e può

essere definito come

Al lancio di un dado esce la faccia 0

Evento certo, ossia l’evento che si verifica sempre in quanto

comprende tutti i possibili risultati dell’esperimento. Può essere

definito

A A B B

Al lancio di una moneta esce T o C

Due eventi A e B, si dicono incompatibili (o

mutualmente esclusivi o disgiunti) se

A B

A A

A

A

A

B

A B

A

A B

B

A B

A B

A A

Proprietà assiomatiche della

probabilità

La probabilità è una funzione di insieme che

associa a ogni evento EiE un numero reale.

La probabilità sarà indicata con P(Ei)

Postulato 2

P(A)0

Postulato 3

P()=1

Postulato 4

[A B = ø]

[P(A U B)=P(A)+P(B)]

Esperimento casuale

E’ ogni processo la cui singola esecuzione (prova) dà luogo a un

risultato non prevedibile.

Esempio: Lancio di una moneta 3 volte

S= Spazio campionario=

Evento è un sottinsieme di S

E1 TTT

E TTC

2

E3 TCT

E4 CTT

E5 TCC

E6 CTC

E7 CCT

E CCC

8

Eventi

elementari

Spazio campionario

F

A

E1

E2

E4

E3

E8

E5

E6

E7

L’evento è un sottinsieme delle spazio campionario.

A almeno 2T E1 , E2 , E3 , E4

F esce T al 1 lancio E1 , E2 , E3 , E5

A almeno 2T E1 , E2 , E3 , E4

F esce T al 1 lancio E1 , E2 , E3 , E5

A F E1 , E2 , E3

A F E1 , E2 , E3 , E4 , E5

A F

E1

E3

E2

E4

E8

E5

E6

A F

E7

La probabilità dell’intersezione è

sommata due volte!

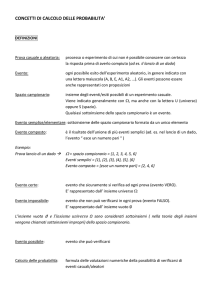

DEFINIZIONI DI PROBABILITA’

1. Classica: è il rapporto tra il numero di casi favorevoli e il

numero di casi possibili, supposto che questi siano

equiprobabili (di Laplace)

2. Frequentista: è la frequenza relativa con cui l’evento si

verifica in una lunga serie di prove ripetute sotto

condizioni simili (di Von Mises)

3. Soggettivista: è il grado di fiducia che un individuo

coerente attribuisce, secondo le sue informazioni e

opinioni al verificarsi dell’evento

Probabilità condizionate e

indipendenza

P(AB)=

ossia

n. dei casi favorevoli ad (A B)

n. dei casi favorevoli a B

P(A B)

P(AB)=

P(B)

Si definisce probabilità condizionata di A dato B

il rapporto tra la probabilità dell’evento (A B) e la

probabilità dell’evento B

Probabilità condizionata

Si vuol calcolare la probabilità dell’evento e4 rispetto

allo spazio campionario S’

E è il nuovo spazio campionario S’

e1

e3

e2

e8

e5

e6

e4

e7

PCTT

Pr obC al I lancio almeno 2T

PTTC , PTCT , PCTT , PTTT

16

Principio delle probabilità

composte

Dati 2 eventi A e B tali che P(A)>0 e P(B)>0 :

P (A B) =P(A) P(B|A)= P(B)P(A|B)

Due eventi si dicono indipendenti se il

verificarsi di B non influenza la probabilità di A e

il verificarsi di A non influenza la probabilità di B

P (A|B) =P(A)

P(B|A) = P(B)

da cui si ricava

PA B PA PB

Teorema di Bayes

Probabilità a posteriori:

P Ai B

P Ai | B

,

P B

Teorema di Bayes

P Ai | B

P Ai P B | Ai

P A1 P B | A1 ... P Ak P B | Ak

P Ai , probabilità a priori.

P B | Ai , probabilità condizionate o verosimiglianze

P Ai | B , probabilità a posteriori, in quanto si riferiscono

agli eventi Ai , dopo aver osservato l’evento B.

18

Esempio

P(A1) = 0,1

prob. di estrarre un individuo malato

P(A2) = 0,9

prob. di estrarre un individuo sano

P(B1|A2) = 0,2 prob. che il test dia un falso-positivo

P(B2|A1) = 0,1 prob. che il test dia un falso-negativo

Determinare:

P(A1|B1) = probabilità che un individuo positivo al test sia

effettivamente malato

P( A1 | B1 )

P( A1 )P( B1 | A1 )

P( A1 )P( B1 | A1 ) P( A2 )P( B1 | A2 )

poichè P(B1|A1) = 1 – P(B2|A1) = 0,9

P ( A1 | B1 )

0,1 0,9

0,33

0,1 0,9 0,9 0,2

19

Esempio (continua)

tivo

i

,2

s

=0

po

)

|A 2

2

B

(

P

o

san

)

P(A 2

,9

=0

P A2 B2 0,9 0,2 0,18

P(B

1 |A

2)

neg

ativ

o

=0

,8

P A2 B1 0,9 0,8 0,72

Popolazione

ma

lat

o

P(A

1)

=0

,1

po

o

sitiv

P

,

0,9

=

)

A

(B 2| 1

P A1 B2 0,1 0,9 0,09

P(B

neg

ativ

o

1 |A

1)

=0

,1

P A1 B1 0,1 0,1 0,01

20/100=0.2

Tipo A

60/100=0.6

adulto

Tipo non A

100

40/100=0.4

14/100=0.14

Tipo A

giovane

40/100=0.4

Tipo non A

26/100=0.26

P giovane tipoA 0.14

PtipoA / giovane

0.35

P giovane

0.4

Esercizio Excel

Campioni

E1: sano

E2: malato

Test +

250

120

370

P(Ei)

P(H/Ei) P(Ei)P(H/Ei)

20 0.6757

0.080

0.05

25 0.3243

0.208

0.07

45

0.12

Definiamo H l'evento Test +

P(E1)

P(E2)

P(H)

P(H/E1)

P(H/E2)

P(H)

0.68

0.32

0.12

0.08

0.208333333

=P(E1)*P(H/E1)+P(E2)*P(H/E2)=

P(E1/H)=P(E1)*P(H/E1)/P(H)=

P(E2/H)=P(E2)*P(H/E2)/P(H)=

0.12

0.444444

0.555556

Possiamo affermare che, se la probabilità a priori di essere malato è pari al

32%, dopo che si verifica un test positivo tale probabilità aumenta al 56%

La distribuzione di probabilità

S=

e1 TTT

e TTC

2

e3 TCT

e4 CTT

e5 TCC

e6 CTC

e7 CCT

e CCC

8

X è la variabile casuale “numero di T in tre

lanci di una moneta”

Valori di x

0

1

2

3

Totale

Probabilità

1/8

3/8

3/8

1/8

1

Variabili casuali discrete: Distribuzioni di

probabilità

Distribuzione di probabilità della v.c. N°

teste in tre lanci di una moneta

0.4

pi

0.35

0.3

0.25

0.2

0.15

0.1

0.05

0

0

1

2

3

Variabili casuali continue: Funzione di densità

Immaginiamo di avere un carattere statistico continuo

e di rappresentarlo tramite istogramma con 8 classi di

ampiezza finita

Variabili casuali continue: Funzione di densità

Man mano che

aumentiamo il numero

delle classi, si riduce

l’ampiezza della classe. Al

limite, l’ampiezza della

classe diviene infinitesima

e il poligono di frequenza

si approssima con una

linea continua. Tale linea

si chiama funzione di

densità di frequenza in

quanto l’ordinata non è

altro che l’altezza dei

rettangoli che compongo

l’istogramma

Alcune distribuzioni

teoriche

La

distribuzione binomiale

(discreta)

La curva di Gauss o Normale

(continua)

Distribuzione binomiale

Esperimento bernulliano: esperimento casuale che ammette due

soli esiti possibili, successo e insuccesso.

Esempio: lancio di una moneta, condizione di malattia

p è la probabilità di successo. q=1-p è la probabilità di insuccesso

Hanno distribuzione binomiale:

La variabile casuale X definita come “numero di successi su n prove” ha

distribuzione binomiale

La variabile casuale F definita come “frequenza relativa di successo su n

prove”

Esempio: La probabilità che un paziente guarisca da una

determinata malattia è p=0.60.

Determinare la probabilità che su 5 pazienti ne

guariscano esattamente 3

G=guarito

NG= non guarito

Si tratta di un esperimento bernulliano con p=0.60 e

q=0.40

Considerando gruppi di 5 pazienti, possiamo avere

le seguenti combinazioni

1. (G,G,G,NG,NG)

2. (G,NG,NG,G,G)

3. …

Ogni combinazione è il prodotto di eventi

indipendenti.

In tutto le combinazioni sono:

n 5

5!

5 * 4 * 3!

10

3!*2

x 3 3!2!

La prima combinazione ha probabilità:

La seconda combinazione ha probabilità:

0.6 * 0.6 * 0.6 * 0.4 * 0.4

0.6 * 0.4 * 0.4 * 0.6 * 0.6

Tutte e 10 le combinazioni possibili hanno probabilità

0.63 * 0.4 2 p x * 1 p

Quindi, la probabilità di x successi su n prove è:

n x

n x

Px * p * 1 p

x

Tornando all’esempio:

5

Px 3 * 0.63 * 0.4 2

3

n x

Statistiche della distribuzione binomiale

E F p

E X np

var X np(1 p)

p(1 p)

var F

n

Simmetria della distribuzione binomiale

0.4

0.4

0.35

0.35

0.3

0.3

0.25

0.25

0.2

0.2

0.15

0.15

0.1

0.1

0.05

0.05

0

0

1

2

3

4

5

6

7

p<0.50 Asimmetrica a destra o positiva

8

9

1

2

3

4

5

6

7

p>0.50 Asimmetrica a sinistra o negativa

All’aumentare di n e a prescindere da p, la distribuzione binomiale

tende ad essere simmetrica e si può approssimare con la curva

Normale N(np,np(1-p)) per X e N(p, p(1-p)/n) per F

8

9

Esempio: con p=0.15

Prob(almeno 2 successi su 5 prove)= Prob(x≥2)=

P(X=2)+P(X=3)+P(X=4)+P(X=5)

Prob(meno di 2 successi su 7 prove)=

Prob(x<2)=P(X=0)+P(X=1)

Prob(fra 3 e 5 successi su 7 prove)=

Prob(3≤x ≤ 5)=P(X=3)+P(X=4)+P(X=5)