La probabilità

Definizione - Esperimento aleatorio

Ogni fenomeno del mondo reale al quale associare una situazione di incertezza.

Es: Lancio di un dado, estrazioni numeri della tombola, ecc.

Definizione – Spazio campionario

Insieme dei possibili risultati di un esperimento aleatorio. Simbolo

Es: Nel lancio di un dado, Ω = {1,2,3,4,5,6}

Ω.

Definizione - Evento aleatorio

Ogni proposizione, relativa ad un esperimento aleatorio, di cui non si conosce il valore di verità.

Ω

.

Esso definisce un sottoinsieme dello spazio campionario

Es: Nel lancio di un dado, un evento aleatorio è la proposizione «esce 3», oppure «esce un numero

pari», ecc.

Definizione - Evento elementare

Ω

Evento aleatorio che coincide con un elemento dello spazio campionario

.

Es: Nel lancio di un dado, un evento elementare è la proposizione «esce 3», oppure «esce 5»,

mentre non sono eventi elementari le proposizioni «esce un numero pari», «esce un numero pari»,

ecc.

Definizione - Evento certo

Ω

Evento certo è l’evento aleatorio che definisce l’intero spazio campionario

.

Es: Nel lancio di un dado, l’evento certo è la proposizione «esce un numero minore di 7»

Definizione - Evento impossibile

Φ

Evento impossibile è l’evento aleatorio che definisce l’insieme vuoto

.

Es: Nel lancio di un dado, l’evento impossibile è la proposizione «esce 7».

Definizione - Evento contrario

Dato un evento A, l’evento contrario, A , si verifica quando A non si è verificato, e viceversa.

Es: Nel lancio di un dado, se A è l’evento «esce 5», l’evento contrario A è « non esce 5»,.

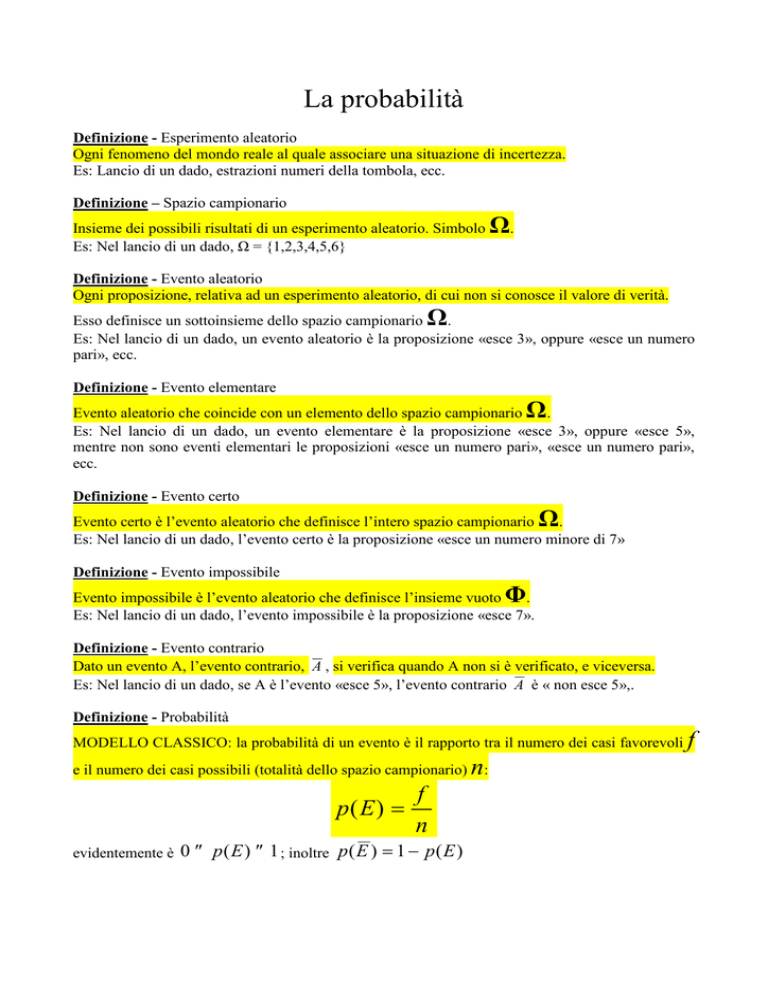

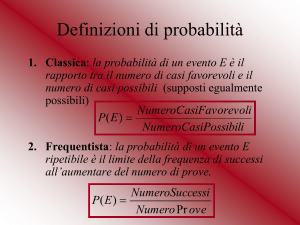

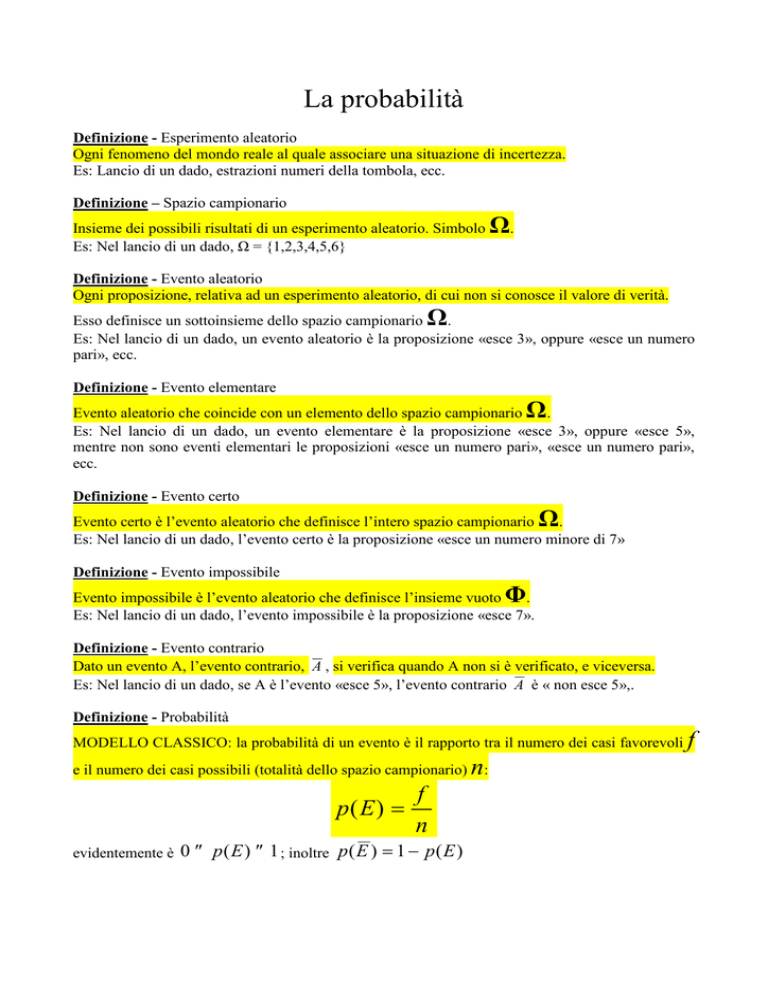

Definizione - Probabilità

MODELLO CLASSICO: la probabilità di un evento è il rapporto tra il numero dei casi favorevoli

e il numero dei casi possibili (totalità dello spazio campionario)

p( E ) =

evidentemente è

f

n

0 ≤ p ( E ) ≤ 1 ; inoltre p ( E ) = 1 − p ( E )

n:

f

MODELLO STATISTICO o FREQUENTISTA: relativamente ad un esperimento aleatorio A, che

può essere ripetuto molte volte, la probabilità di un evento E è il valore a cui tende il rapporto tra il

numero di prove che hanno avuto esito favorevole e il numero totale di prove fatte.

Nel lancio di una moneta, ripetuto 100 volte, potrebbe essersi verificato: 48 volte testa, 52 volte

croce. Pertanto, volendo valutare la probabilità (secondo il modello statistico) dell’evento «esce

croce», il rapporto tra il numero di prove con esito favorevole e il numero totale di prove è uguale a

52

= 0,52 . Ripetendo l’esperimento 1000 volte, si verificherà, ad esempio 495 volte testa, 505

100

505

volte croce: il rapporto diventa

= 0,505 . Ripetendo l’esperimento un numero di volte sempre

1000

maggiore, il rapporto in questione tenderà ad assumere il valore 0,5. Constatazione:

Legge empirica del caso: in un grande numero di prove, ripetute alle stesse condizioni, la

probabilità “frequentista” tende ad essere uguale alla sua probabilità teorica.

Probabilità totale e composta

Definizione - Eventi incompatibili

Due eventi si dicono incompatibili se il verificarsi dell’uno esclude il verificarsi dell’altro; cioè se è

impossibile che si verifichino entrambi.

Definizione - Eventi indipendenti

Due eventi si dicono indipendenti quando il verificarsi del primo non modifica la probabilità di

verificarsi del secondo; cioè quando la probabilità di verificarsi del secondo evento è la stessa sia

che il primo evento si sia verificato sia che non si sia verificato.

Definizione – Evento totale

Dati due o più eventi (parziali), si dice evento totale l’evento che consiste nel verificarsi dell’uno o

dell’altro degli eventi parziali.

Es: Nel lancio di un dado, siano A = «esce 5» e B «esce 6». L’evento C = «esce un numero maggior

di 4» è verificato quando si verifica A oppure B. C è, quindi, l’evento totale degli eventi parziali A e

B. In simboli C = A ∪ B .

Definizione – Evento composto

Dati due o più eventi (componenti), si dice evento composto l’evento che consiste nel verificarsi di

tutti gli eventi parziali.

Es: Dati due mazzi di carte, si estrae una carta da ciascun mazzo. L’evento C = «la prima carta è un

asso e la seconda è una figura» è verificato quando sono verificati entrambi gli eventi A = «esce un

asso» e B «esce una figura». C è, quindi, l’evento composto degli eventi componenti A e B. In

simboli C = A ∩ B .

Principio della probabilità totale (sintesi):

Se A e B sono incompatibili p ( A ∪ B ) = p ( A) + p ( B )

Principio della probabilità composta (sintesi):

Se A e B sono indipendenti p ( A ∩ B ) = p ( A) ⋅ p ( B )

Se A e B non sono indipendenti p ( A ∩ B ) = p ( A) ⋅ p ( B / A) (*)

(*)

p ( B \ A)

è la probabilità che si verifichi B, essendosi verificato A.

Principio della probabilità totale generalizzato (sintesi):

Se A e B non sono incompatibili p ( A ∪ B ) = p ( A) + p ( B ) − p ( A ∩ B )

Probabilità composta e diagrammi ad albero

Esempio di applicazione

Si hanno tre urne:

U1 contiene 10 palline rosse e 6 bianche;

U2 contiene 8 palline rosse e 12 bianche;

U3 contiene 6 palline rosse e 9 bianche.

Inoltre, si lancia un dado e se esce un numero n pari a 1 o a 2, si estrae una pallina dalla prima urna,

se esce un numero n superiore a 3, si estrae una pallina dalla seconda urna, se esce 3, si estrae una

pallina dalla terza urna.

Domanda: Qual è la probabilità che la pallina sia rossa?

Schematizziamo il tutto introducendo i seguenti simboli:

A «estrazione pallina rossa»

H1 «nel lancio del dado esce n pari a 1 o a 2»

H2 «nel lancio del dado esce n superiore a 3»

H3 «nel lancio del dado esce 3»

Si può realizzare il seguente diagramma:

10

p( A \ H 1 ) =

16

U1

3

6

8

p( A \ H 2 ) =

20

U2

1

p( H 3 ) =

6

2 10 5

⋅ =

6 16 24

R

p( H 2 ∩ A) =

3 8 1

⋅

=

6 20 5

p ( H 3 ∩ A) =

1 6

1

⋅ =

6 15 15

B

6

p( A \ H 3 ) =

15

U3

p( H 1 ∩ A) =

B

2

p( H 1 ) =

6

p( H 2 ) =

R

R

B

Sui tre rami di sinistra sono indicate la probabilità di accedere alle varie urne. Su tre dei sei rami

centrali sono indicate le probabilità di estrarre una pallina rossa da ciascuna urna. A destra le

probabilità di estrarre la pallina rossa da ciascuna urna subordinata all’uscita favorevole, per

quell’urna, nel lancio del dado.

Cerchiamo di dare la risposta:

Il diagramma ad albero ha consentito di individuare gli eventi favorevoli all’estrazione della pallina

rossa, individuandone anche le probabilità. Ora occorre chiedersi, come “combinare” insieme le tre

probabilità

2 10 5

3 8 1

1 6

1

⋅ =

p( H 2 ∩ A) = ⋅

=

p ( H 3 ∩ A) = ⋅ =

6 16 24

6 20 5

6 15 15

Basterà pensare che l’estrazione della pallina rossa come l’evento totale di

A = ( H 1 ∩ A) ∪ ( H 2 ∩ A) ∪ ( H 3 ∩ A) ,

ora, essendo

H 1 ∩ A, H 2 ∩ A) e ( H 3 ∩ A)

incompatibili tra loro, si ha (vedi probabilità composta)

p ( A) = p ( H 1 ∩ A) + p ( H 2 ∩ A) + p ( H 3 ∩ A) , ossia,

5 1 1 19

p ( A) =

+ +

=

24 5 15 40

p( H 1 ∩ A) =

Il teorema di Bayes (o teorema delle cause)

Il principio della probabilità composta abbiamo

p( A ∩ H ) = p ( A) ⋅ p ( H \ A) , e anche p( H ∩ A) = p ( H ) ⋅ p ( A \ H )

inoltre la proprietà commutativa dell’intersezione ( A ∩ H = H ∩ A ) consente di scrivere

p ( A) ⋅ p ( H \ A) = p ( H ) ⋅ p ( A \ H ) . Da questa formula ricaviamo

p( H ) ⋅ p( A \ H )

(*)

p( H \ A) =

p ( A)

Questa formula è un caso particolare del più generale teorema di Bayes;

Vediamone il significato con riferimento all’esempio affrontato con il diagramma ad albero:

se A è l’estrazione della pallina rossa e H l’esito del lancio del dado, la formula (*) consente,

sapendo che è stata estratta una pallina rossa, di valutare la probabilità che essa provenga da una

certa urna. In termini più generali Bayes consente la valutazione della probabilità del verificarsi

delle cause che hanno determinato un certo evento. Pertanto, ora possiamo rispondere sia alla

domanda “qual è la probabilità di estrarre una pallina rossa?” (probabilità dell’evento finale), sia

alla domanda “qual è la probabilità che la pallina rossa estratta provenga da una certa urna?”.

Specificamente, con riferimento all’esempio affrontato con il diagramma ad albero, si può

rispondere alla domanda “qual è la probabilità che la pallina rossa estratta provenga dalla prima

p( H 1 ) ⋅ p( A \ H 1 )

urna?”. Essendo p( H 1 \ A) =

, basterà riprendere i valori riportati nel

p ( A)

diagramma:

2

10

19

p ( H 1 ) = , p ( A \ H 1 ) = , p ( A) =

6

40

16

(quest’ultimo valore è la probabilità che venga estratta una pallina rossa, affrontata con il

precedente diagramma ad albero), quindi si ha che la probabilità che la pallina rossa estratta

provenga dalla prima urna è:

2 10

⋅

p ( H 1 ) ⋅ p ( A \ H 1 ) 6 16 25

.

p ( H 1 \ A) =

=

=

19

p ( A)

57

40

Esercizio: Una certa produzione industriale è legata a tre macchine, che chiameremo M1, M2, e

M3. Di ognuna di esse è stata valutata una certa probabilità di produrre prezzi difettosi. In

particolare p( D \ M 1 ) = 0,05 , p( D \ M 2 ) = 0,02 , p ( D \ M 3 ) = 0,07 . Per produrre un certo lotto

di 1000 pezzi si sono utilizzate tutte e tre le macchine; in particolare, M1 ha prodotto 350 pezzi,

M2 ne ha prodotti 520, M3 gli altri 130.

Calcolare la probabilità che, scegliendo un pezzo a caso fra i 1000 e vedendo che è difettoso,

questo sia stato prodotto (a) dalla macchina M1, (b) dalla macchina M2, (c) dalla macchina M3.

Calcolare la probabilità che, scegliendo un pezzo a caso fra i 1000 e vedendo che è un pezzo

buono, questo sia stato prodotto (d) dalla macchina M1, (e) dalla macchina M2, (f) dalla

macchina M3.

Soluzione del caso (a) (è un caso dove si chiede di valutare la probabilità della causa che ha

determinato l’evento, quindi, bisogna impiegare il diagramma ad albero e, successivamente,

Bayes):

E’ evidente l’analogia al problema del dado e delle urne risolto con il diagramma ad albero.

Occorre valutare innanzitutto qual è la probabilità che il pezzo (buono o difettoso che sia)

provenga dalla macchina M1, dalla macchina M2 o dalla macchina M3.

p( M 1 ) = 350/1000; p( M 2 ) = 520/1000, p ( M 3 ) = 130/1000 (nel diagramma, rami a sinistra).

Poi, occorrerà precisare la probabilità che M1 (nonché M2 e M3) produca un pezzo difettoso

prodotto. Tali dati sono forniti nella traccia.

D = pezzo difettoso

p( D \ M 1 ) = 0,05 ; p( D \ M 2 ) = 0,02 ; p ( D \ M 3 ) = 0,07

(nel diagramma, rami centrali).

Quindi, occorrerà calcolare la probabilità che scegliendo un pezzo tra quelli prodotti, esso sia

difettoso (D) e sia stato prodotto da M1 (nonché da M2 e M3).

Si tratta di eventi composti:

350

p( D ∩ M 1 ) = p( M 1 ) ⋅ p( D \ M 1 ) =

⋅ 0,05 = 0,0175

1000

520

p( D ∩ M 2 ) = p(M 2 ) ⋅ p( D \ M 2 ) =

⋅ 0,02 = 0,0104 (nel diagramma, rami di destra)

1000

130

p( D ∩ M 3 ) = p (M 3 ) ⋅ p( D \ M 3 ) =

⋅ 0,07 = 0,0091

1000

Quindi, ora, si può calcolare la probabilità che il pezzo sia difettoso (a prescindere dalla

macchina) p ( D ) = 0,0175 + 0,0104 + 0,0091 = 0,037

Ora, sfruttando il teorema di Bayes, si può stabilire che la probabilità che il pezzo difettoso

provenga dalla macchina M1 è:

350

⋅ 0,05

p ( M 1 ) ⋅ p ( D \ M 1 ) 1000

p(M 1 \ D) =

=

= 0,47297

p( D)

0,037

Il gioco equo

Un giocatore A punta una somma S (es: 10 euro) ed ha la probabilità p di vincere contro un

giocatore B che punta una somma S ' ed ha la probabilità p ' di vincere. Il gioco di dice equo se

S

p'

= , ossia, se le somme puntate dai giocatori sono direttamente proporzionali alle loro

S ' p'

probabilità di vincere.

Le variabili casuali

Si chiama variabile casuale una funzione che associa ad ogni evento elementare E uno e un solo

numero reale.

Una variabile casuale si dice discreta quando può assumere solo particolari valori di un intervallo.

Esempio: nel lancio di tre monete, la variabile X, numero di volte che si ottiene croce, può assumere

i valori 0, 1, 2 , 3.

Una variabile casuale si dice continua quando può variare con continuità in un intervallo.

Esempio: misurando l’altezza di un gruppo di persone, la variabile X, altezza della persona, è una

variabile di tipo continuo.

Quando ad ogni valore della variabile casuale X si attribuisce la probabilità di verificarsi, si ottiene

la distribuzione di probabilità.

Esempio: distribuzione di probabilità della variabile “punteggio” nel lancio di due dadi.

2

3

4

5

6

7

8

9

10

11

12

Valori di X

1/36

2/36

3/36

4/36

5/36

6/36

5/36

4/36

3/36

2/36

1/36

Probabilità

0,0278

0,0555

0,0833

0,1111

0,1389

0,1667

0,1389

0,1111

0,0833

0,0555

0,0278

“ (decimale)

Gli eventi possibili sono 36. Per esempio, il valore X = 4 può verificarsi con le uscite:

(1,3), (2,2), (3,1), pertanto la sua probabilità è 3/36.

Funzione di probabilità: essa descrive la distribuzione di probabilità ed è definita come

p( x) = P( X = x)

con p ( x) ≥ 0 e ∑ x p ( x) = 1

Più intuitivamente si tratta di associare ad ogni valore di ascissa (= al valore della variabile discreta

X) un valore di probabilità. Si veda il grafico seguente

0,16

0,0555

0,1

0,04

0,0278

0,06

0,0278

0,08

0,0555

0,0833

0,12

0,0833

0,1111

0,14

0,1111

0,1389

0,18

0,1389

0,1667

0,2

0,02

0

2

3

4

5

6

7

8

9

10

11

12

Per una variabile di tipo continuo non ha senso chiedersi qual è la probabilità che essa assuma un

determinato valore. Ha, invece, senso chiedersi qual è la probabilità che il suo valore cada in un

certo intervallo.

Le distribuzioni: binomiale e di Poisson

Consideriamo una serie di n prove, ripetute nelle medesime condizioni, considerando un evento A o

il suo contrario B (ad esempio il lancio di due dadi, considerando l’evento A «realizzare 10 punti» e

l’evento contrario B «non realizzare 10 punti»).

In una singola prova A ha una probabilità p di verificarsi e q=1 - p di non verificarsi.

Dopo n prove, A può essersi verificato un numero di volte x = 0, 1, 2, 3,… n volte, e, in

corrispondenza B può essersi verificato n, …3, 2, 1, 0 volte.

La variabile x è detta variabile casuale binomiale e i suoi possibili valori vanno da 0 a n. Ci si può

chiedere qual è la probabilità che x assuma un certo valore k volte, con 0 ≤ k ≤ n . Ad esempio, qual

è la probabilità che lanciando due dadi 20 volte (n = 20) si ottenga il punteggio 10 (x = 10) per 6

volte (k = 6)?.

Il calcolo di tale probabilità si effettua con la formula seguente

n ⋅ (n − 1)... ⋅ (n − k + 1) k n − k

p q =

k!

n

n!

=

p k q n − k = ⋅ p k q n − k .

k!⋅(n − k )!

k

p k = C n .k p k q n − k =

Esempio: qual è la probabilità, gettando una moneta 10 volte, di fare testa zero volte, una volta,

….dieci volte?

n = 10, p = probabilità di fare testa in un lancio, 1/2, q = probabilità di non fare testa in un lancio,

½.

0

10

10

10 1 1

1

p0 = ⋅ ⋅ = 1 ⋅

Fare testa 0 volte: k = 0

2

0 2 2

1

9

10

10 1 1

1

Fare testa 1 volta: k = 1

p1 = ⋅ ⋅ = 10 ⋅

2

1 2 2

2

Fare testa 2 volte: k = 2

Fare testa 3 volte: k = 3

Fare testa 4 volte: k = 4

Fare testa 5 volte: k = 5

Fare testa 6 volte: k = 6

Fare testa 7 volte: k = 7

8

10 1 1

1

p 2 = ⋅ ⋅ = 45 ⋅

2

2 2 2

10

10

10 1

1

p3 = ⋅ = 120 ⋅

2

3 2

10

10

10

10

10 1

1

p 4 = ⋅ = 210 ⋅

2

4 2

10

10

10 1

1

p5 = ⋅ = 252 ⋅

2

5 2

10 1

1

p6 = ⋅ = 210 ⋅

2

6 2

10

10

10 1

1

p7 = ⋅ = 120 ⋅

2

7 2

10

Fare testa 8 volte: k = 8

Fare testa 9 volte: k = 9

10

Fare testa 10 volte: k = 10

10

10 1

1

p8 = ⋅ = 45 ⋅

2

8 2

10

10

10 1

1

p9 = ⋅ = 10 ⋅

2

9 2

10 1

1

p10 = ⋅ = 1 ⋅

2

10 2

10

10

0,25

0,20507813

0,24609375

0,20507813

0,3

0,00097656

0,00976563

0,04394531

0,1171875

0,00097656

0,00976563

0,1

0,04394531

0,15

0,05

0,1171875

0,2

0

1

2

3

4

5

6

7

8

9

10

11

La distribuzione binomiale è simmetrica; questo accade ogni volta che p = 1/2.

Si può dimostrare che il valore medio di una variabile casuale è dato dalla formula

x = n⋅ p.

Per comprendere il significato di x , si recuperi la dispensa di statistica da

www.desarlolagonegro.it. Tuttavia, qui è riportato un esempio. Si osservi la seguente tabella, nella

quale sono riportati quanti oggetti difettosi prodotti da una ditta sono stati trovati esaminando 50

campioni (confezioni) ciascuno costituito di 10 articoli, con relative frequenze:

Numero di articoli difettosi in

ciascun campione di 10 art.

Frequenza dei campioni con x

art. difettosi

Frequenza relativa

x

0

1

2

3

4

5

6

7

8

9

10

Totale

Dalla tabella si deduce che x =

5

14

15

10

4

1

1

0

0

0

0

50

0 ⋅ 5 + 1 ⋅ 14 + 2 ⋅ 15 + ... + 10 ⋅ 0

≅2

50

Ossia, gli articoli difettosi sono mediamente 2 su 10.

0,1000

0,2800

0,3000

0,2000

0,0800

0,0200

0,0200

0,0000

0,0000

0,0000

0,0000

1,000

Quando il numero di prove n è molto grande, i calcoli sono molto laboriosi con la distribuzione

binomiale. In questo caso diventa utile la formula di Poisson,

pk =

λk

k!

e −λ

essa consente di stabilire la probabilità che, su un numero enorme di prove, l’evento A si manifesti

k volte. Occorre però conoscere λ, che rappresenta il valore medio della variabile casuale binomiale

ossia x .

Per esempio se in un centralino pervengono in media 10 telefonate al minuto, le probabilità che in

un minuto pervengano 6 telefonate è

10 6 −10

p6 =

e ≅ 6,3% ,

6!

mentre la probabilità che ne pervengano 9 è

10 9 −10

p9 =

e ≅ 12,5%

9!

La distribuzione normale o gaussiana

Questa distribuzione è molto utilizzata in statistica, perché molti fenomeni fisici e biologici, ma non

solo, hanno una andamento che si può rappresentare, con buona approssimazione, mediante una

curva di Gauss. La funzione è espressa dalla formula

y=

1

e

σ 2π

(

x − x )2

−

2σ 2

con − ∞ < x < +∞ , x il valore medio della variabile casuale, σ lo scarto quadratico medio, definito

n

come σ =

∑(x

i =1

1

− x)2

n

.

1. Il fattore e

−

( x − x )2

2σ 2

, variabile al variare di x, determina la forma della gaussiana;

1

2. Il valore massimo assunto dalla funzione è

assunto in corrispondenza del valore

σ 2π

medio x ;

3. ha come asintoto orizzontale l’asse x;

4. l’area sottesa dalla curva e delimitata dall’asse x vale 1.

La sua forma è detta a campana.

Sono interessanti i seguenti dati:

− la probabilità che x assuma un valore compreso tra x − σ e x + σ è del 68% circa.

− la probabilità che x assuma un valore compreso tra x − 2σ e x + 2σ è del 95% circa.

− la probabilità che x assuma un valore compreso tra x − 3σ e x + 3σ è quasi del 100%.