Calcolo delle probabilità

Il calcolo delle probabilità ha avuto origine nel Seicento in riferimento a questioni legate al gioco

d’azzardo e alle scommesse. Oggi trova tante applicazioni in ambiti anche molto lontani da quello

appena citato, ad esempio il Google Rank (l’algoritmo di ricerca di Google ideato da Sergey Brin e

Larry Page, i fondatori di Google) si basa sulle catene di Markov alla cui base vi è la probabilità.

Il calcolo delle probabilità è uno strumento che rende “razionale” il comportamento umano in

condizioni di incertezza.

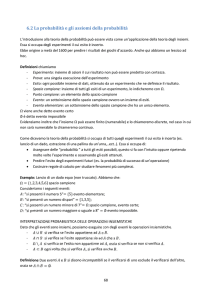

Un evento è un qualsiasi fatto o avvenimento che può essere osservato. Un evento è descritto da

un enunciato, che può essere vero o falso. E’ necessario che, quando sono note tutte le modalità

dello svolgimento dell’osservazione o dell’esperimento casuale in questione, sia possibile solo una

delle conclusioni: vero, se l’evento si è verificato, falso, se l’evento non si è verificato.

Un evento si dice casuale o aleatorio se può verificarsi oppure no: le cause che lo producono non

sono oggettivamente controllabili. Un esperimento che dà luogo a differenti esiti se ripetuto sotto

le stesse condizioni viene chiamato esperimento casuale. Pur conoscendone i dati iniziali e le leggi

che lo governano non possiamo prevederne il risultato, ma possiamo conoscere l’insieme di tutti i

possibili risultati. Essi sono chiamati eventi elementari.

Un evento si dice composto se può essere scomposto in più eventi elementari.

Esempi di esperimenti casuali: estrazione di una carta da un mazzo, lancio di un dado o di una

moneta.

Esempi di eventi elementari nel lancio di un dado: “esce il numero 1”, …, “esce il numero 6”.

Invece l’evento “esce un numero dispari” non è elementare essendo l’unione degli eventi

(incompatibili) “esce il numero 1”, “esce il numero 3”, “esce il numero 5”.

Lo spazio campionario è l’insieme dei risultati possibili di un esperimento casuale e solitamente si

indica con la lettera Ω. Quindi nel lancio del dado Ω = {1,2,3,4,5,6}, nel lancio di una moneta

Ω = {𝑇, 𝐶}.

Un evento si dice certo se in seguito ad un esperimento deve necessariamente verificarsi, ad

esempio l’uscita di un numero naturale tra 1 e 6 nel lancio di un dado a sei facce; si dice

impossibile se non può accadere in un certo esperimento, ad esempio l’uscita del numero 7 nel

dado; aleatorio in tutti gli altri casi. E’ di questi eventi che si occupa la probabilità.

Dato un evento E si definisce evento complementare di E l’evento corrispondente al non verificarsi

di E. Si indica con 𝐸̅ o con 1 − 𝐸.

Un medesimo evento può essere certo, impossibile o aleatorio a seconda del contesto. Ad

esempio l’evento “Mario supera l’esame di probabilità” è certo se Mario ha corrotto la

commissione esaminatrice, possibile se ha studiato, impossibile se il giorno dell’esame non si

presenta.

Due eventi si dicono incompatibili (o disgiunti) se il verificarsi dell’uno esclude il verificarsi

dell’altro, ossia se essi non si verificano contemporaneamente, cioè se 𝐸1 ∩ 𝐸2 = ∅.

Ad esempio nel lancio di una moneta l’evento “esce testa” e l’evento “esce croce” sono

incompatibili, così come nel lancio di un dado l’evento “esce il numero 2” e l’evento “esce un

numero maggiore di 3” sono incompatibili.

Due eventi elementari sono sempre incompatibili.

Due eventi si dicono compatibili se non sono incompatibili, cioè se 𝐸1 ∩ 𝐸2 ≠ ∅.

Esempio: l’evento “esce il numero 3” è compatibile con l’evento “esce un numero dispari”.

Due eventi si dicono esaustivi se la loro unione genera tutto lo spazio campionario, cioè se

𝐸1 ∪ 𝐸2 = Ω.

Esempio: l’evento “esce un numero pari” e l’evento “esce un numero dispari” sono esaustivi nel

lancio di un dado perché la loro unione dà tutto lo spazio degli eventi Ω = {1,2,3,4,5,6}.

Un certo numero di eventi costituisce una partizione se tali eventi sono esaustivi e incompatibili a

due a due.

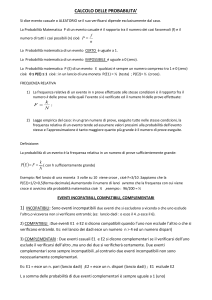

Definizioni di probabilità

1. Probabilità classica o laplaciana o a priori

La probabilità di un evento E è il rapporto tra i casi favorevoli al verificarsi dell’evento e quelli

possibili (o totali), a condizione che i casi possibili siano finiti ed equiprobabili (cioè distribuiti

uniformemente):

𝑃(𝐸) =

𝑐𝑎𝑠𝑖 𝑓𝑎𝑣𝑜𝑟𝑒𝑣𝑜𝑙𝑖

𝑐𝑎𝑠𝑖 𝑝𝑜𝑠𝑠𝑖𝑏𝑖𝑙𝑖

Esempio: lancio di una moneta: P(T)=1/2; P(C)=1/2; lancio di un dado: P(pescare un numero

pari)=1/2 e così via.

La definizione classica di probabilità è inutilizzabile quando non si conosce a priori il numero dei

casi possibili, come nella quasi totalità degli eventi reali. Gli sviluppi del calcolo delle probabilità e

le sue applicazioni in ambito commerciale fecero vacillare la definizione classica.

Essa non si può applicare quando gli esiti sono infiniti.

Esempio: nell’insieme dei naturali qual è la probabilità di scegliere a caso un numero pari?

L’intuizione dice ½, ma la definizione classica non è applicabile perché sia gli esiti favorevoli che

quelli possibili sono infiniti (NB Tra le altre cose l’insieme ℕ è infinito perché può essere messo in

corrispondenza biunivoca con il suo sottoinsieme proprio dei numeri pari, e sono entrambi insiemi

infiniti con cardinalità numerabile).

Esempio: al Luna Park una ruota di legno, divisa in settori colorati di ampiezze diverse, gira molto

velocemente mentre un giocatore lancia una freccetta colpendo a caso uno dei settori. Qual è la

probabilità di colpire il settore giallo, il cui angolo al centro misura 9°?

La probabilità di colpire un settore è data dal rapporto tra la superficie considerata e quella di

tutto lo spazio campione. Un settore di 9° rappresenta 9/360 dell’intera ruota e dunque la

probabilità vale 9/360 ossia 1/40.

Esempio: calcolare la probabilità che lanciando successivamente 3 monete escano 2 croci (con

grafo ad albero). Il diagramma ad albero permette di avere un’elencazione grafica di tutti gli

elementi dello spazio campione. Se scriviamo su ciascun ramo la probabilità dell’evento scritto nel

nodo seguente, la probabilità di un evento su un ramo terminale è il prodotto delle probabilità

scritte sull’intero percorso (applicazione della formula della probabilità composta, che vedremo).

2. Probabilità frequentista o statistica o a posteriori

A causa delle critiche mosse alla concezione classica agli inizi del 900 si assiste alla nascita della

concezione frequentista, dovuta soprattutto all’applicazione della probabilità alle scienze

sperimentali. Intuitivamente al crescere del numero delle prove effettuate tutte nelle stesse

condizioni iniziali, la frequenza relativa, pur variando, tende a stabilizzarsi attorno ad un valore, e

tale valore corrisponde a quello della probabilità dell’evento.

Dunque la probabilità di un evento E è la frequenza relativa con cui tende a presentarsi un certo

evento, qualora fosse possibile effettuare un gran numero di prove tutte nelle stesse condizioni.

Ossia:

𝑚

𝑃(𝐸) =

𝑛

dove m rappresenta il numero di prove che hanno verificato E, n rappresenta il numero totale

delle prove. E’ la “probabilità empirica”, che dà un significato preciso al concetto di probabilità.

Questa definizione si applica in quei casi in cui non è applicabile la definizione classica in quanto

viene a mancare la condizione di equiprobabilità degli eventi elementari sulla quale essa si basa.

Ad esempio se abbiamo motivo di ritenere che un dado sia truccato, non essendo magari costruito

con materiale omogeneo, non potremo assegnare alla probabilità di uscita di un certo numero il

valore 1/6. Possiamo ripetere il lancio del dado molte volte, calcolare la frequenza relativa

dell’uscita di ciascun numero ed assumere quel valore come probabilità dell’evento.

La definizione si applica a fenomeni passati dei quali si posseggano dati statistici che si sono

verificati in condizioni analoghe, per esempio per una data popolazione la probabilità di

sopravvivenza, o delle nascite di maschi e femmine. Si applica in fisica, biologia, medicina,

economia e in tutte le scienze che utilizzano metodi statistici. E’ molto utile in campo assicurativo

e nel controllo di qualità. Ha il pregio di aver collegato concetti molto diversi come probabilità e

frequenza, essendo la prima definita a priori, la seconda calcolata a posteriori. Dunque nella

concezione frequentista la probabilità è ricavata a posteriori, dall’esame dei dati.

Esempio: calcolare la probabilità che un neonato sia maschio, sapendo che su 100.000 nascite

52.300 sono maschi.

P(M)=52.300/100.000=0,523 e P(F)=1-0.523=0.477.

Esempio: la probabilità dell’evento “nel week-end pioverà” non si può calcolare con tale

definizione, perché è un evento non ripetibile, e nemmeno quella dell’evento “nasce un bambino

con 2 teste, la coda e tre paia di occhi” perché non si è mai realizzato (speriamo).

3. Probabilità soggettiva (di Bruno De Finetti, 1930)

Cosa accade se un fenomeno casuale non si presenta con un elenco “chiaro” di esiti possibili,

equiprobabili, tra i quali scegliere quelli favorevoli ad un certo evento? Per esempio l’esito di una

battaglia il giorno prima di combatterla, il fatto che domani piova o sia sereno, o che una certa

squadra di un certo sport vinca un trofeo sono esempi di fenomeni che richiedono una concezione

soggettiva della probabilità. Non si richiede la conoscenza del meccanismo che regola il fenomeno

e la ripetibilità del fenomeno stesso. Tale concezione sottolinea l’impossibilità di accertare

l’obiettività della probabilità. Il modello soggettivo esprime il grado di fiducia che si ha nella

realizzazione di un certo evento e in esso diventa dunque fondamentale il fattore personale. E’

relativo alle scommesse ma anche alla gestione aziendale, ad esempio.

E’ il numero reale P(E) tale che 0 ≤ 𝑃(𝐸) ≤ 1 che rappresenta la quantificazione del grado di

fiducia che un evento E si verifichi. E’ dunque il rapporto:

𝑃(𝐸) =

𝑆

𝑉

dove S è la somma che siamo disposti a pagare (cioè a scommettere) e V è la vincita che

otterremmo se l’evento si verificasse.

Condizione di coerenza: chi scommette deve essere anche disposto a perdere la vincita V se

l’evento non si verifica.

Esempio: il risultato della finale di Champions League, o eventi simili sono governati da un

altissimo numero di fattori imprevedibili.

La “stima” personale che diamo al verificarsi di un evento dipende pesantemente dalle quantità di

informazioni che conosciamo, dal loro grado di attendibilità e da come sappiamo valutarle.

4. Probabilità assiomatica (di Kolmogorov, 1933) (teoria unificata di probabilità)

La probabilità di un evento E è un numero reale p tale che:

1. 𝑝(𝐸) ≥ 0 (positività);

2. 𝑝(𝐸) = 1 se l’evento E è certo (certezza);

3. 𝑝(𝐸1 ∪ 𝐸2 ) = 𝑝(𝐸1 ) + 𝑝(𝐸2 ) se gli eventi sono incompatibili (unione).

Dai primi due assiomi si deduce che 0 ≤ 𝑝(𝐸) ≤ 1.

Primi teoremi sulla probabilità

1. Teorema della probabilità contraria:

𝑝(𝐸̅ ) = 1 − 𝑝(𝐸),

dove 𝐸̅ indica l’evento complementare di E.

2. Teorema della somma per eventi incompatibili:

𝑝(𝐸1 ∪ 𝐸2 ) = 𝑝(𝐸1 ) + 𝑝(𝐸2 ),

se gli eventi 𝐸1 , 𝐸2 sono incompatibili, cioè se 𝐸1 ∩ 𝐸2 = ∅.

3. Teorema della somma per eventi compatibili:

𝑝(𝐸1 ∪ 𝐸2 ) = 𝑝(𝐸1 ) + 𝑝(𝐸2 ) − 𝑝(𝐸1 ∩ 𝐸2 ).

Generalizzando: se gli eventi 𝐸1 , 𝐸2 , … , 𝐸𝑛 sono a due a due incompatibili allora:

𝑝(𝐸1 ∪ … ∪ 𝐸𝑛 ) = 𝑝(𝐸1 ) + ⋯ + 𝑝(𝐸𝑛 ).

Se oltre ad essere incompatibili sono anche esaustivi, ossia costituiscono una partizione dello

spazio campionario, allora: 𝑝(𝐸1 ∪ … ∪ 𝐸𝑛 ) = 𝑝(𝐸1 ) + ⋯ + 𝑝(𝐸𝑛 ) = 1.

Esempi: 1. Da un’urna contenente palline numerate da 1 a 10 si estraggono contemporaneamente

4 numeri. Calcolare la probabilità dell’evento “almeno uno dei numeri estratti è pari”.

Basta calcolare 𝑝(𝐸̅ )=p(nessuno dei numeri estratti è pari) e poi usare il teorema della probabilità

contraria.

5

(4 )

𝑝(𝐸̅ )=(10

=1/42, quindi p(E)=1-1/42=41/42.

)

4

2. Si lanciano due dadi successivamente. Calcolare la probabilità dell’evento E=”la somma delle

facce è un numero maggiore di 7 o multiplo di 3”.

p(somma maggiore di 7)=15/36; p(multiplo di 3)=12/36, p(s>7 and s=3k)=p(s=9 o s=12)=5/36,

quindi: p(E)=15/36+12/36-5/36=22/36=11/18.

3. In un mazzo di carte romagnole (da briscola) calcolare la probabilità di pescare una figura

oppure una carta di bastoni.

p(figura)=12/40; p(bastoni)=10/40; p(figura di bastoni)=3/40 quindi:

p(figura vel carta di bastoni)=12/40+10/40-3/40=19/40.

4. Calcolare la probabilità che esca una sola testa lanciando due volte una moneta equilibrata.

I casi possibili sono TT, TC, CT e CC dunque p(una testa)=p(CT)+p(TC)=2/4=1/2.

5. Si hanno 8 palline bianche. Quante palline azzurre dovremmo aggiungere affinché la probabilità

di estrarre una pallina bianca sia 2/3?

8/N=2/3 quindi N=12 quindi dovremmo aggiungere 12-8=4 palline azzurre.