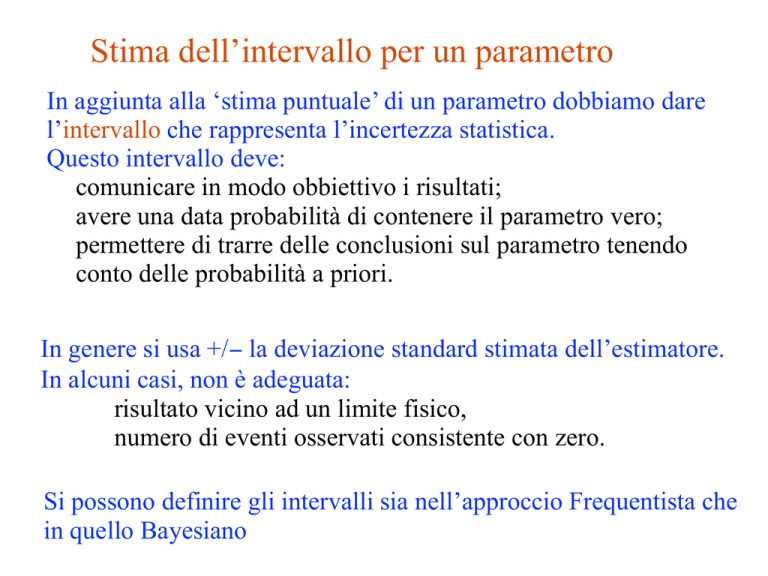

Stima dell’intervallo per un parametro

In aggiunta alla ‘stima puntuale’ di un parametro dobbiamo dare

l’intervallo che rappresenta l’incertezza statistica.

Questo intervallo deve:

comunicare in modo obbiettivo i risultati;

avere una data probabilità di contenere il parametro vero;

permettere di trarre delle conclusioni sul parametro tenendo

conto delle probabilità a priori.

In genere si usa +/− la deviazione standard stimata dell’estimatore.

In alcuni casi, non è adeguata:

risultato vicino ad un limite fisico,

numero di eventi osservati consistente con zero.

Si possono definire gli intervalli sia nell’approccio Frequentista che

in quello Bayesiano

Intervalli di confidenza: approccio frequentista

Dato un estimatore

per il parametro θ e la stima

Sia data per tutti i possibili θ la distribuzione del campione

Si fissa i valori per le code di probabilità superiore e inferiore, per

esempio α = 0.05, β = 0.05, quindi si trovano le funzioni uα(θ) e

vβ(θ) tali che:

Intervallo di confidenza dalla fascia di confidenza

La regione tra uα(θ) e vβ(θ) è la fascia di confidenza.

Determiniamo i punti dove il valore

osservato interseca la fascia di

confidenza

Questo è l’intervallo di confidenza [a, b]

Livello di confidenza = 1 − α − β = probabilità che

l’intervallo “copra” il vero valore del parametro (questo vale

per ogni valore possibile del parametro θ)

Intervalli di confidenza in pratica

La ricetta per trovare [a, b] si riduce a risolvere

→ a è il valore ipotetico di θ tale che

→ b è il valore ipotetico di θ tale che

Significato di un intervallo di confidenza

Intervalli di confidenza centrali o unilaterali

Intervalli di confidenza dalla likelihood

Nel limite di campione infinito vale per l’estimatore ML dei

parametri

:

(Gaussiana n-dimensionale con covarianza V)

definisce una regione di confidenza iper-ellissoidale

Se

allora

Si noti che n è il numero di parametri

Regioni di confidenza approssimative da L(θ )

Per determinare la regione di confidenza con CL = 1−γ si prende:

Per campioni finiti approssimano le regioni di confidenza

La probabilità di copertura non è garantita essere 1−γ ;

non ci sono teoremi per stimare di quanto si sbaglia (usare un MC).

Esempio di intervallo dal ln L(θ )

Per n=1 parametri, CL = 0.683, Qγ = 1.

Limite sui parametri di una distribuzione di Poisson

Consideriamo di nuovo il caso di n = ns + nb eventi dove

nb eventi da processi noti (fondo)

ns eventi da processi nuovi (segnale)

sono variabili di Poisson con medie s e b e perciò anche n = ns + nb

è una variabile di Poisson con media = s + b. Supponiamo b sia noto.

Stiamo cercando l’evidenza per il processo di segnale,

ma il numero di evnti trovati è circa uguale al numero di

eventi aspettati per il solo fondo, per esempio b = 4.6 e noi

troviamo nobs = 5 eventi.

L’evidenza per il segnale s non è statisticamente rilevante

→ vogliamo mettere un limite superiore su s.

Limite superiore per una Poissoniana

Troviamo il parametro s tale che la probabilità di osservare gli

eventi che abbiamo visto o meno è uguale a un valore fissato,

piccolo, per esempio γ = 0.05:

Risolviamo per s = sup, e troviamo il limite superiore per s con un

livello di confidenza di 1−γ.

Esempio: supponiamo b = 0 e troviamo nobs = 0. Per 1−γ = 0.95,

→

In generale è utile ricordare che:

m

!

ν n e−ν

= 1 − Fχ2 (2ν; 2(m + 1))

n!

n=0

Calcoliamo il limite per la Poissoniana

Per determinare slo, sup, possiamo usare la relazione con la

distribuzione del χ2:

Quantile della distribuzione del χ2

Per fluttuazioni verso il basso di n il

risultato per sup ; cioè l’intervallo di

confidenza è vuoto.

Limiti vicino ad un contorno fisico

Supponiamo che sia b = 2.5 e che si osservi n = 0.

Se scegliamo CL = 0.9, dalla formula per sup troviamo

Punto di vista fisico:

Sapevamo già che s ≥ 0; non possiamo riportare come risultato

di un esperimento complesso un limite superiore negativo!

Punto di vista statistico:

L’intervallo copre il valore vero del parametro nel 90% dei casi;

chiaramente questo non è uno di quelli.

Questo è un dilemma piuttosto comune quando il limite del

parametro è vicino ad un contorno fisico, per esempio nel caso di

mν stimato con E2 − p2 .

Limite aspettato per s = 0

Fisico: avrei dovuto usare CL = 0.95 — quindi sup = 0.496

Anche meglio: per CL = 0.917923 otteniamo sup = 10−4 !

Un momento... con b = 2.5 le fluttuazioni di Poisson in n sono circa

√2.5 = 1.6. Come faccio ad ottenere un limite così basso?

Guardiamo il valore medio del limite

nell’ipotesi di fondo soltanto (s = 0):

questo valore è la sensibilità.

Distribuzione del limite per un CL

del 95% con b = 2.5, s = 0.

Limite superiore medio = 4.44

Approccio Bayesiano

Nella statistica Bayesiana dobbiamo iniziare con ‘pdf a priori’ π(θ),

che rappresenta la nostra conoscenza di θ prima dell’esperimento.

Il teorema di Bayes ci dice come modificare la pdf in seguito ai

risultati dell’esperimento

Possiamo integrare la pdf a posteriori p(θ | x) per ottenere un

intervallo con qualsivoglia copertura

.

Per esempio per una Poissoniana il limite superirore al 95% di CL si

otterrà da

Probabilità a priori per una Possioniana

Poichè sappiamo che s ≥0, poniamo π(s) = 0 per s<0.

Spesso si traduce la nostra ‘ignoranza a priori’ con

- Non è normalizzata:

va bene se L(s) decresce rapidamente per s grande.

- Non è invariante rispetto ad un cambio dei parametri.

una probabilità piatta per la massa del bosone di Higgs implica

una probabilità non piatta per il numero di eventi con un Higgs.

- Non rappresenta veramente il nostro grado di conoscenza ma

possiamo usarla come punto di riferimento:

ci permette di costruire degli intervalli dei quali possiamo

studiare le proprietà dal punto di vista frequentista (la copertura

dipenderà dal vero valore di s).

Intervallo Bayesiano con priori piatta per s

Bisogna risolvere per sup la seguente equazione

1−β

=

=

⇒β=

! sup

L(n|s)ds

0

!∞

L(n|s)ds

0

! sup

n −(s+b)

(s

+

b)

e

ds

0

!∞

n e−(s+b) ds

(s

+

b)

0

e

!n

(sup +b)i

i=0

i!

!

n

bi

−b

e

i=0 i!

−(sup +b)

Per b = 0, il limite superiore Bayesiano è identico a quello

classico (per pura coincidenza)

Intervallo Bayesiano con priori piatta per s (2)

Altrimenti il limite Bayesiano è sempre maggiore

(‘conservativo’) di quello classico

Non è mai negativo; non dipende da b se n = 0.

N.B.: questo metodo può essere usato anche con la likelihood

estesa:

Intervalli di confidenza e test statistici

Un interavallo di confidenza per il parametro θ può essere trovato

definendo un test per l’ipotesi con il valore θ (ripetuto per tutti i

possibili θ):

Specifichiamo i valori osservati che sono sfavoriti per un dato

θ (regione critica) in modo che P(regione critica) ≤ γ

per un γ specificato, per esempio 0.05 or 0.1.

Se i valori osservati cadono nella regione critica rigettiamo θ

Ora invertiamo il test per definire un intervallo di confidenza come:

l’insieme dei valori θ che non sarebbero rigettati dal test (il

livello di confidenza corrispondente è 1 − γ ).

L’intervallo copre il vero valore θ con una probabilità ≥ 1 − γ.

È equivalente alla costruzione della fascia di confidenza; la fascia

di confidenza è la regione di accettanza di un test

Limite con il likelihood ratio (Feldman-Cousins)

Definiamo il rapporto della likelihood per un ipotetico valore s del

parametro:

Qui

è l’estimatore con la ML, quindi

La regione critica è definita dai valori inferiori del likelihood ratio.

Gli intervalli che si ottengono possono essere uni- o bi-laterali

(dipende da n).

(Ri)scoperta per HEP da Feldman and Cousins,

Phys. Rev. D 57 (1998) 3873.

Intervalli con LR test (Feldman-Cousins)

Caveat sulla copertura: supponiamo di trovare n >> b.

Di solito il risultato viene dato come:

Se, invece, n non è abbastanza grande per dichiarare una scoperta si

mette un limite su s..

FC fanno notare che se la decisione viene presa in base al risultato

ottenuto, la probabilità di copertura dell’intevallo può essere minore

del livello di confidenza (‘flip-flopping’).

L’intervallo definito con il test LR rimuove questo problema:

la transizione da 1 a 2 estremi infatti dipende da n.

Però, supponiamo che il test LR dia 0.1 < s < 5 al 90% CL.

Questo non significa che certamente il segnale è diverso da zero

(il p-valore per s=0 è ancora sostanziale). Il risultato è che il limite

superiore diventa meno stringente...

Proprietà dei limiti superiori

Esempio: prendiamo b = 5.0, 1 − γ = 0.95

Limite superiore sup vs. n

Limite superiore medio vs. s

Limite superiore vs b

Feldman & Cousins, PRD 57 (1998) 3873

Se n = 0, il limite superiore dipende da b?

Classico: sì

Bayesiano: no

FC: sì

Il test CLs

Un altro test statistico che è stato usato per definire l’intervallo di

confidenza per un segnale (ad es. Higgs a LEP) è:

p-valore dell’ipotesi segnale + fondo

CLs =

1 − p-valore dell’ipotesi fondo soltanto

a volte scritta più semplicemente

CLb+s

CLs =

CLb

ma nei due casi si inverte il test di

compatibilità con l’ipotesi di

fondo soltanto!

Il test CLs (2)

Anche in questo caso si può trattare CLs come una variabile

statistica e calcolare il suo p-valore e quindi costruire gli intervalli

di confidenza

Oppure, come si fa più spesso usare il valore di CLs come p-valore

per costruire gli intervalli di confidenza

Si noti che in quest’ultimo caso CLs < CLs+b ovvero si ottiene

sempre un limite conservativo rispetto all’uso di CLs+b

È una situazione molto simile a quella già incontrata nel confronto

tra metodo classico e Bayesiano per il limite nel caso n = s+b

Ed infatti CLs applicato a questo caso dà esattamente il risultato

Bayesiano!

Bibliografia aggiuntiva

Per quest’ultima parte oltre a Data Analysis di G. Cowan è utile

leggere la review di statistica del PDG

C. Amsler et al. (Particle Data Group), Physics Letters B667, 1

(2008) and 2009 partial update for the 2010 edition

anche disponibile online su http://pdg.lbl.gov

Ovviamente vi invito anche a leggere il già citato

Feldman and Cousins, Phys. Rev. D 57 (1998) 3873