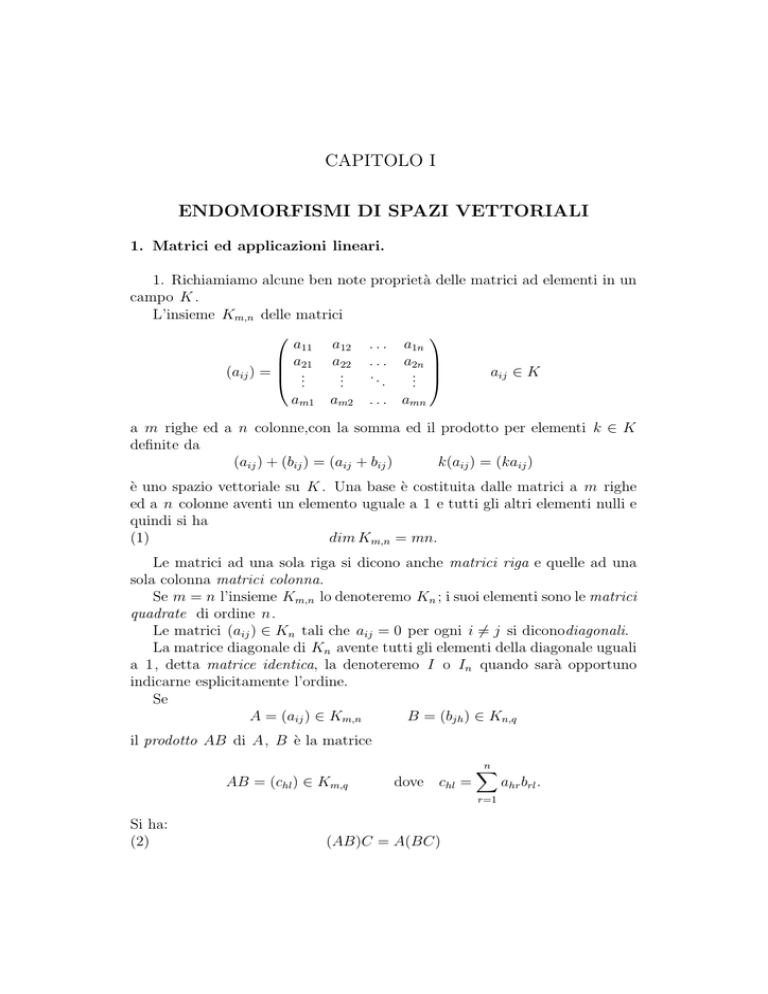

CAPITOLO I

ENDOMORFISMI DI SPAZI VETTORIALI

1. Matrici ed applicazioni lineari.

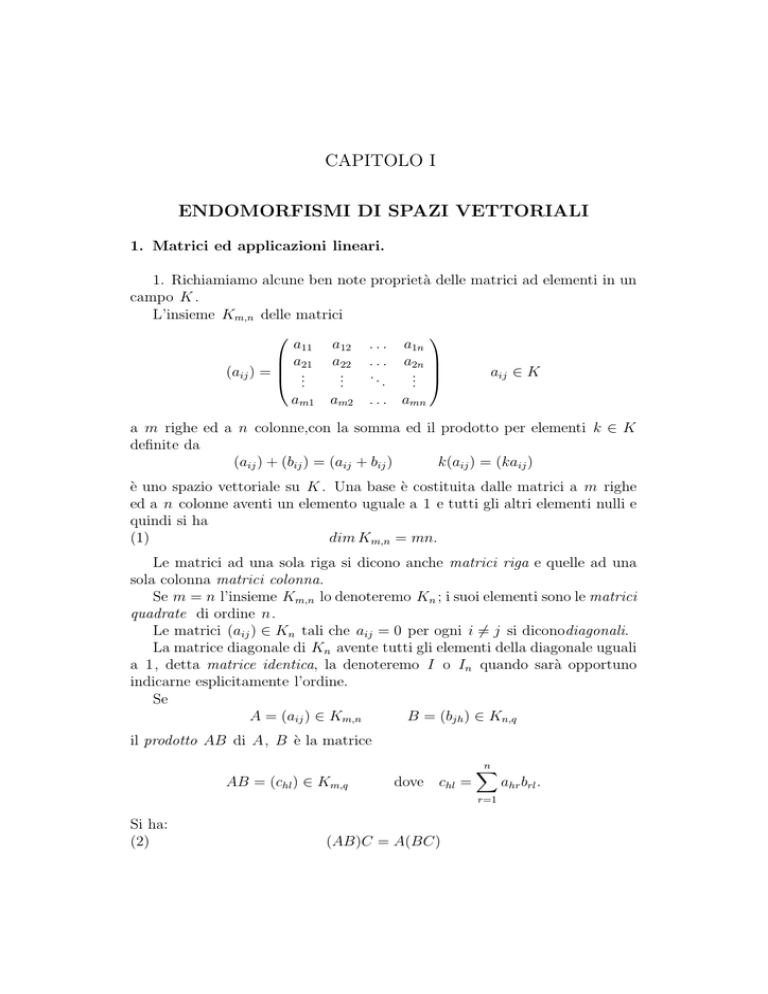

1. Richiamiamo alcune ben note proprietà delle matrici ad elementi in un

campo K .

L’insieme Km,n delle matrici

a11 a12 . . . a1n

a21 a22 . . . a2n

aij ∈ K

(aij ) =

..

..

..

...

.

.

.

am1

am2

. . . amn

a m righe ed a n colonne,con la somma ed il prodotto per elementi k ∈ K

definite da

(aij ) + (bij ) = (aij + bij )

k(aij ) = (kaij )

è uno spazio vettoriale su K . Una base è costituita dalle matrici a m righe

ed a n colonne aventi un elemento uguale a 1 e tutti gli altri elementi nulli e

quindi si ha

(1)

dim Km,n = mn.

Le matrici ad una sola riga si dicono anche matrici riga e quelle ad una

sola colonna matrici colonna.

Se m = n l’insieme Km,n lo denoteremo Kn ; i suoi elementi sono le matrici

quadrate di ordine n.

Le matrici (aij ) ∈ Kn tali che aij = 0 per ogni i 6= j si diconodiagonali.

La matrice diagonale di Kn avente tutti gli elementi della diagonale uguali

a 1, detta matrice identica, la denoteremo I o In quando sarà opportuno

indicarne esplicitamente l’ordine.

Se

A = (aij ) ∈ Km,n

B = (bjh ) ∈ Kn,q

il prodotto AB di A, B è la matrice

AB = (chl ) ∈ Km,q

Si ha:

(2)

dove chl =

(AB)C = A(BC)

n

X

r=1

ahr brl .

2

1 MATRICI ED APPLICAZIONI LINEARI

(3)

AI = IA = A

per ogni A ∈ Kn .

Una matrice A ∈ Kn è invertibile se esiste una matrice B ∈ Kn tale che

AB = BA = I ; una tale matrice B , che quando esiste è unica, è l’inversa di

A e la denoteremo A−1 .

Se A e B sono invertibili tale è AB e si ha

(AB)−1 = B −1 A−1

(4)

Se A = (aij ) ∈ Kn il suo determinante lo denoteremo

detA = |aij | .

La matrice A ∈ Kn è non singolare se detA 6= 0.

Si ha:

(5)

(6)

(7)

A ∈ Kn

det(AB)

è invertibile

detA−1

=

⇐⇒

=

detA detB;

A è non singolare;

(detA)−1 .

Se A ∈ Km,n , la matrice At ∈ Kn,m che ha come righe le colonne di A è la

matrice trasposta di A. Si ha:

(8)

(9)

(10)

(11)

(12)

(A + B)t

(AB)t

(At )t

detAt

(A−1 )t

=

=

=

=

=

At + B t ;

B t At ;

A;

detA;

(At )−1 .

Le matrici A tali che At = A sono le matrici simmetriche.

2. Siano V, V′ spazi vettoriali

1

sul campo K e

T : V −→ V′

un’applicazione lineare.

′

Se B = (v1 , ..., vn ) è una base di V e B′ = (v1′ , ..., vm

) è una base di V′

si ha

′

,

T (vi ) = a1i v1′ + a2i v2′ + · · · + ami vm

1

aji ∈ K,

1 ≤ i ≤ n.

Gli spazi vettoriali da noi considerati saranno da ritenere sempre di dimensione finita.

3

1 MATRICI ED APPLICAZIONI LINEARI

Definizione 1.1 La matrice

a11

a

21

MBB′ (T ) =

...

am1

a12

a22

..

.

am2

. . . a1n

. . . a2n

..

..

.

.

. . . amn

si dice matrice di T rispetto alle basi B e B′ .

Se V = V′ e B = B′ diremo che MBB (T ) è la matrice di T rispetto alla

base B .

Osservazione 1.2 Se X = (x1 , ..., xn )t è la matrice colonna delle componenti

di x ∈ V rispetto a B , allora la matrice colonna delle componenti di T (x)

rispetto a B′ è X ′ = (MBB′ (T ))X .

Infatti, sia

′

T (x) = x′1 v1′ + x′2 v2′ + · · · + x′m vm

,

xi ∈ K.

Poiché

x = x1 v1 + x2 v2 + · · · + xn vn ,

si ha

T (x) = x1 T (v1 ) + x2 T (v2 ) + · · · + xn T (vn )

′

′

= x1 (a11 v1′ + · · · + am1 vm

) + · · · + xn (a1n v1′ + · · · + amn vm

)

′

= (a11 x1 + · · · + a1n xn )v1′ + · · · + (am1 x1 + · · · + amn xn )vm

e quindi

x′i = ai1 x1 + ai2 x2 + · · · + ain xn ,

1 ≤ i ≤ m.

Sia Hom(V, V′) l’insieme delle applicazioni lineari di V in V′ .

Con la somma S +T di S, T ∈ Hom(V, V′) ed il prodotto kT , con k ∈ K ,

definiti ponendo per ogni v ∈ V

(S + T )(v) = S(v) + T (v)

(kT )(v) = kT (v),

Hom(V, V′) diviene uno spazio vettoriale su K . Il suo elemento nullo lo

denoteremo 0.

Teorema 1.3 Siano V, V′ spazi vettoriali su K e siano B = (v1 , ..., vn ) una

′

base di V e B′ = (v1′ , ..., vm

) una base di V′ . L’applicazione

f : Hom(V, V′) −→ Km,n

definita ponendo per ogni T ∈ Hom(V, V′)

f (T ) = MBB′ (T )

è un isomorfismo.

4

1 MATRICI ED APPLICAZIONI LINEARI

DIMOSTRAZIONE. L’applicazione f è lineare.

Infatti, sia S, T ∈ Hom(V, V′) e h, k ∈ K . Se

f (S) = (bij )

f (T ) = (aij )

f (hS + kT ) = (cij ),

per ogni 1 ≤ i ≤ n si ha

′

S(vi ) = b1i v1′ + b2i v2′ + · · · + bmi vm

,

′

′

′

T (vi ) = a1i v1 + a2i v2 + · · · + ami vm ,

′

(hS + kT )(vi ) = c1i v1′ + c2i v2′ + · · · + cmi vm

.

Ma

(hS + kT )(vi ) = hS(vi ) + kT (vi )

′

′

= h(b1i v1′ + · · · + bmi vm

) + k(a1i v1′ + · · · + ami vm

)

′

′

= (hb1i + ka1i )v1 + · · · + (hbmi + kami )vm ,

quindi

cji = hbji + kaji

e perciò

per 1 ≤ i ≤ n, 1 ≤ j ≤ m

f (hS + kT ) = hf (S) + kf (T ).

L’applicazione f è iniettiva.

Infatti, se f (T ) = MBB′ (T ) è la matrice nulla si ha

T (vi ) = 0,

1 ≤ i ≤ n,

e quindi T (x) = 0 per ogni x ∈ V , ossia T = 0.

L’applicazione f è suriettiva.

Infatti, sia A = (aij ) ∈ Km,n ; se T : V −→ V′ è l’applicazione lineare

definita da

(13)

′

,

T (vi ) = a1i v1′ + a2i v2′ + · · · + ami vm

1 ≤ i ≤ n,

risulta A = MBB′ (T ) = f (T ).

L’applicazione lineare T e la matrice MBB′ (T ) le diremo associate l’una

all’altra rispetto alle basi B e B′ .

Se B e B′ sono basi dello stesso spazio vettoriale V e I è l’applicazione

identica di V, la matrice MBB′ (I) è la matrice di passaggio dalla base B′ alla

base B .

Corollario 1.4 Se V, V′ sono spazi vettoriali su K di dimensione n, m

risulta

dim Hom(V, V′) = mn.

1 MATRICI ED APPLICAZIONI LINEARI

5

DIMOSTRAZIONE. Segue subito dal teorema 1.3 e dalla (1).

Corollario 1.5 Se T ∈ Hom(V, V) e B è una base di V si ha MBB (T ) = I

se e solo se T = I .

Corollario 1.6 Se V, V′ sono spazi vettoriali di uguale dimensione n e B =

(v1 , ..., vn ), B′ = (v1′ , ..., vn′ ) sono loro rispettive basi, esiste uno ed un solo

isomorfismo T : V −→ V′ tale che

T (vi ) = vi′ ,

1 ≤ i ≤ n.

DIMOSTRAZIONE. L’isomorfismo T è quello che rispetto alle basi B , B′ è

associato alla matrice identica I ∈ Kn .

Osservazione 1.7 Sia T ∈ Hom(V, V′) e sia

a11 . . . a1n

.

..

..

A = ..

.

.

am1 . . . amn

′

la matrice di T rispetto alle basi B = (v1 , . . . , vn ) di V e B′ = (v1′ , . . . , vm

)

′

di V . Se r è la caratteristica di A si ha:

1) dim Im T = r ,

2) dim Ker T = dim V − r .

3) Se m = n, allora T è isomorfismo se e solo se A è invertibile.

1) Le colonne di A sono le componenti dei vettori T (v1 ), . . . , T (vn ) rispetto alla base B′ . Se, come è possibile supporre previo un eventuale

scambio di indici, sono linearmente indipendenti le prime r colonne di

A, i vettori T (v1 ), . . . , T (vr ) sono linearmente indipendenti. Essi generano Im T perché, per ogni r + 1 ≤ j ≤ n, la j−ma colonna di A è

combinazione lineare delle prime r .

2) Segue dal fatto che dim V = dim Im (T ) + dim Ker T .

3) Segue immediatamente dalle 1) e 2).

Teorema 1.8 Siano V, V′ , V′′ spazi vettoriali su K e T ∈ Hom(V, V′),

S ∈ Hom(V′, V′′ ). Se B , B′ , B′′ sono basi rispettive di V, V′ , V′′ , risulta

′

MBB′′ (ST ) = MBB′′ (S)MBB′ (T ).

6

1 MATRICI ED APPLICAZIONI LINEARI

DIMOSTRAZIONE. Sia

a11 . . . a1n

.

..

..

MBB′ (T ) = ..

.

.

am1 . . . amn

b11

..

B′

MB′′ (S) =

.

br1

c11 . . . c1n

..

.

.

MBB′′ (ST ) = .. . . .

.

cr1 . . . crn

Allora, se

B = (v1 , ..., vn ),

′

B′ = (v1′ , ..., vm

),

. . . b1m

..

..

.

.

. . . brm

B′′ = (v′′1 , ..., v′′r ),

si ha

′

T (vj ) = a1j v1′ + · · · + amj vm

, 1 ≤ j ≤ n,

′

′′

′′

S(vi ) = b1i v 1 + · · · + bri v r , 1 ≤ i ≤ m,

(ST )(vj ) = c1j v′′1 + · · · + crj v′′r , 1 ≤ j ≤ n.

Ma

(ST )(vj ) =

=

=

=

′

S(a1j v1′ + · · · + amj vm

)

′

′

a1j S(v1 ) + · · · + amj S(vm

)

a1j (b11 v′′1 + · · · + br1 v′′r ) + · · · + amj (b1m v′′1 + · · · + brm v′′r )

(b11 a1j + · · · + b1m amj )v′′1 + · · · + (br1 a1j + · · · + brm amj )v′′r ,

quindi

ossia

chj = bh1 a1j + · · · + bhm amj ,

1 ≤ h ≤ r, 1 ≤ j ≤ n,

′

MBB′′ (ST ) = MBB′′ (S)MBB′ (T ).

Corollario 1.9 Siano V,V′ spazi vettoriali di uguale dimensione su K e B ,

B′ loro rispettive basi e sia T : V → V′ un isomorfismo. Allora

′

MBB (T −1 ) = (MBB′ (T ))−1 .

DIMOSTRAZIONE. Per il teorema 1.8 ed il corollario 1.5, si ha

′

MBB (T −1 T ) = MBB (T −1 )MBB′ (T ) = I,

′

′

MBB′ (T T −1 ) = MBB′ (T )MBB (T −1 ) = I,

e quindi

′

MBB (T −1 ) = (MBB′ (T ))−1 .

7

2 AUTOVALORI ED AUTOVETTORI

Corollario 1.10 Sia T ∈ Hom(V, V). Se B e B′ sono basi di V e N =

′

MBB (I) è la matrice di passaggio dalla base B alla base B′ si ha

′

MBB′ (T ) = N −1 MBB (T )N.

DIMOSTRAZIONE. Per il teorema 1.8 ed il corollario 1.9 si ha

′

′

′

MBB′ (T ) = MBB′ (IT ) = MBB′ (I)MBB (T )

′

′

= MBB′ (I)MBB (T I) = MBB′ (I)MBB (T )MBB (I)

= N −1 MBB (T )N.

Corollario 1.11 Se A, B ∈ Kn sono tali che AB = I si ha anche BA = I .

DIMOSTRAZIONE. Siano S , T le applicazioni lineari di K n che rispetto alla

base canonica E sono associate rispettivamente a B ed A. Allora, rispetto a

E , sono associate T S con AB e ST con BA (teorema 1.8). Da AB = I segue

che T S = I (corollario 1.5) e quindi l’iniettività di S . Infatti, se u ∈ KerS

si ha u = (T S)(u) = T (S(u)) = T (0) = 0. Poiché

n = dimK n = dim(ImS) + dim(KerS) = dim(ImS),

S è anche suriettiva e perciò è isomorfismo. Si ha

ST = (ST )(SS −1) = S(T S)S −1 = SS −1 = I

e quindi (corollario 1.5) BA = I .

2. Autovalori. Autovettori. Polinomio caratteristico.

1. Sia V uno spazio vettoriale sul campo K .

Gli endomorfismi di V sono gli elementi di Hom(V, V); gli automorfismi

di V sono gli elementi di Hom(V, V) che sono isomorfismi.

Definizione 2.1 Sia T un endomorfismo di V; un elemento λ ∈ K si dice

autovalore di T se esiste un vettore non nullo v ∈ V tale che T (v) = λv.

Se λ è un autovalore di T i vettori non nulli v ∈ V tali che T (v) = λv, si

dicono autovettori di T relativi o associati a λ ed il sottospazio

V(λ) = {v ∈ V | T (v) = λv}

si dice autospazio relativo a λ.

2 AUTOVALORI ED AUTOVETTORI

8

Osserviamo che λ è un autovalore di T se e solo se l’endomorfismo λI −T ,

dove I è l’endomorfismo identico, non è invertibile, cioè se e solo se Ker(λI −

T ) 6= {0}.

Se M è una matrice di Kn , si chiamano autovalori ed autovettori di

M gli autovalori e gli autovettori dell’endomorfismo T di K n che rispetto

ad una base comunque fissata è associato a M . Quindi, un autovettore di

M associato all’autovalore λ è una matrice colonna non nulla X tale che

MX = λX .

Lemma 2.2 Se M è la matrice dell’endomorfismo T di V rispetto ad una

base B ed I è la matrice identica, il polinomio

∆(x) = ∆T (x) = det(xI − M)

nell’indeterminata x non dipende da B .

DIMOSTRAZIONE. Se B′ è un’altra base di V e M ′ è la matrice di T

rispetto a B′ , esiste (corollario 1.10) una matrice invertibile N tale che M ′ =

N −1 MN e quindi si ha

det(xI − M ′ ) =

=

=

=

det(N −1 xIN − N −1 MN)

det(N −1 (xI − M)N)

det N −1 det(xI − M)det N

det(xI − M).

Definizione 2.3 Il polinomio ∆T (x) si dice polinomio caratteristico di T .

Se M ∈ Kn , si dice polinomio caratteristico di M quello dell’endomorfismo di K n che rispetto ad una base comunque fissata è associato a M ; esso

è det(xI − M).

Lemma 2.4 Sia T un endomorfismo dello spazio vettoriale V. Un elemento

λ ∈ K è autovalore di T se e solo se è radice del polinomio caratteristico

∆(x) di T .

DIMOSTRAZIONE. Un elemento λ ∈ K è autovalore di T se e solo se

λI − T è non invertibile. Se M è la matrice di T rispetto ad una base B di

V, la matrice di λI − T rispetto a B è λI − M . Ed allora (corollario 1.9 e

(6)) λI − T è non invertibile se e solo se det(λI − M) = ∆(λ) = 0.

Corollario 2.5 Un endomorfismo dello spazio vettoriale V ha al più n =

dimV autovalori distinti.

9

2 AUTOVALORI ED AUTOVETTORI

Corollario 2.6 Se V è uno spazio vettoriale di dimensione positiva su un

campo algebricamente chiuso K , ogni endomorfismo di V possiede autovettori.

Definizione 2.7 Se λ è un autovalore di T , la molteplicità mT (λ) di λ come

radice del polinomio caratteristico ∆T (x) di T si dice molteplicità algebrica di

λ. La dimensione gT (λ) dell’autospazio V(λ) si dice molteplicità geometrica

di λ.

Teorema 2.8 Per ogni endomorfismo T dello spazio vettoriale V e per ogni

autovalore λ di T risulta gT (λ) ≤ mT (λ).

DIMOSTRAZIONE. Sia r = gT (λ) e sia (v1 , ..., vr ) una base di V(λ). Scelti

in V n − r elementi vr+1 , ..., vn in modo che B = (v1 , ..., vr , vr+1 , ..., vn ) sia

una base di V, si ha

λvi

se 1 ≤ i ≤ r,

T (vi ) =

a1i v1 + a2i v2 + · · · + ani vn

se r + 1 ≤ i ≤ n.

Quindi la matrice di T rispetto alla

λ 0 ...

0 λ ...

. .

. . ...

. .

M =

0 0 ...

. . .

..

.. ..

0 0 ...

base B è

0

0

..

.

a1 r+1

a2 r+1

..

.

λ

..

.

ar r+1

..

.

0

an r+1

Ne segue che

x− λ

0

0

x−λ

.

..

.

.

.

∆(x) = det(xI − M) = 0

0

.

..

..

.

0

0

. . . a1n

. . . a2n

..

..

.

.

.

. . . arn

..

..

.

.

. . . ann

...

0

−a1 r+1

...

0

−a2 r+1

..

..

..

.

.

.

. . . x − λ −ar r+1

..

..

..

.

.

.

...

0

−an r+1

è divisibile per (x − λ)r e perciò r = gT (λ) ≤ mT (λ).

...

−a1n ...

−a2n ..

..

.

.

...

−arn ..

..

.

.

. . . x − ann Teorema 2.9 Sia T un endomorfismo dello spazio vettoriale V. Autovettori

di T relativi ad autovalori distinti sono linearmente indipendenti.

10

3 DIAGONALIZZAZIONE DI MATRICI

DIMOSTRAZIONE. Siano v1 , ..., vm autovettori relativi rispettivamente agli

autovalori distinti λ1 , ..., λm . Se m = 1 la cosa è banalmente vera. Sia m ≥ 2

e procediamo per induzione su m, assumendo che l’asserto sia vero per m − 1

autovettori. Sia

(1)

a1 v1 + a2 v2 + · · · + am vm = 0,

ai ∈ K;

allora

(2) T (a1 v1 + a2 v2 + · · · + am vm ) = a1 λ1 v1 + a2 λ2 v2 + · · · + am λm vm = 0.

D’altra parte, moltiplicando ambo i membri della (1) per λ1 e sottraendo

dalla (2) si ha

a2 (λ2 − λ1 )v2 + · · · + am (λm − λ1 )vm = 0.

Poiché λi − λ1 6= 0 per 2 ≤ i ≤ m e, per ipotesi, v2 , ..., vm sono linearmente

indipendenti, deve essere a2 = · · · = am = 0. Dalla (1) segue allora che

a1 v1 = 0 e perciò anche a1 = 0.

3. Diagonalizzazione di endomorfismi e di matrici

1. Sia T un endomorfismo dello spazio vettoriale V.

Definizione 3.1 Se esiste una base B rispetto alla quale le matrice di T è

diagonale si dice che T è diagonalizzabile e che B diagonalizza T .

Se M è una matrice di Kn , diagonalizzare M significa diagonalizzare l’endomorfismo T di K n che rispetto ad una base comunque fissata è associato

a M . In virtù del corollario 1.10, ciò vuol dire trovare una matrice invertibile

N tale che N −1 MN è diagonale.

Teorema 3.2 Un endomorfismo T dello spazio vettoriale V è diagonalizzabile se e solo se V possiede una base di autovettori di T .

DIMOSTRAZIONE. Se (v1 , ..., vn ) è una base di autovettori di T si ha

T (vi ) = λi vi ,

λi ∈ K,

1 ≤ i ≤ n,

e la matrice di T rispetto a tale base è diagonale.

Viceversa, se la matrice M di T rispetto alla base B = (v1 , ..., vn ) è

diagonale ed è

λ1 0 . . . 0

0 λ2 . . . 0

M =

.. . .

.

...

. ..

.

0 0 . . . λn

11

3 DIAGONALIZZAZIONE DI MATRICI

si ha

T (vi ) = λi vi ,

1 ≤ i ≤ n,

e perciò B è una base di autovettori.

Corollario 3.3 Se il polinomio caratteristico di un endomorfismo T di uno

spazio vettoriale V su K ha n = dimV radici distinte in K , T è diagonalizzabile.

DIMOSTRAZIONE. Per teorema 3.2, V possiede una base di autovettori di

T.

Teorema 3.4 Un endomorfismo T dello spazio vettoriale V è diagonalizzabile se e solo se si ha

(1)

V = V(λ1 ) ⊕ · · · ⊕ V(λr )

dove λ1 , ..., λr sono gli autovalori distinti di T .

DIMOSTRAZIONE. Se è vera la (1), con λi autovalori distinti di T e Bi è

una base di V(λi), allora B = ∪Bi è una base di V che diagonalizza T .

Viceversa, sia T diagonalizzabile e sia B una base (di autovettori) che

lo diagonalizza. Se λ1 , ..., λr sono gli autovalori distinti di T , B ha una

ripartizione in sottoinsiemi B1 ,...,Br , dove Bi è il sottoinsieme degli elementi

di B associati a λi . Se Vi è il sottospazio generato da Bi , risulta V =

V1 ⊕ · · · ⊕ Vr . Si ha Vi = V(λi ) e quindi la (1). Infatti, è ovvio che

Vi ⊆ V(λi ). D’altra parte

V = V1 ⊕ · · · ⊕ Vr ⊆ V(λ1 ) ⊕ . . . ⊕ V(λr ) ⊆ V

P

P

e quindi

dim Vi =

dim V(λi) da cui segue dim Vi = dim V(λi ). Si ha

allora Vi = V(λi) e il teorema è dimostrato.

Teorema 3.5 Un endomorfismo T dello spazio vettoriale V su K è diagonalizzabile se e solo se sono soddisfatte le condizioni:

1) Il polinomio caratteristico di T si decompone in fattori lineari in K[x];

2) Per ogni autovalore λ di T si ha gT (λ) = mT (λ).

DIMOSTRAZIONE. Se valgono le 1) e 2) si ha

r

Y

∆T (x) =

(x − λi )mi

i=1

12

3 DIAGONALIZZAZIONE DI MATRICI

Pr

con λ1 , ..., λr distinti e mi = dimV(λi ). Poiché dimV =

i=1 mi si ha

V = ⊕V(λi ), con λ1 ,...,λr autovalori distinti e quindi T è diagonalizzabile

(teorema 3.4).

Viceversa, sia T diagonalizzabile e siano λ1 , . . . , λr gli autovalori distinti di

T . Per il lemma 2.4 si ha

∆T (x) = h(x)

r

Y

i=1

(x − λi )mi ,

h(λi ) 6= 0

e per il teorema 2.8 si ha dimV(λi ) ≤ mi . Per il teorema 3.4 si ha V =

⊕ri=1 V(λi), quindi

dimV =

r

X

i=1

e perciò

dimV(λi ) ≤

r

X

r

X

i=1

mi ≤ dimV

mi = dimV.

i=1

Allora h(x) = 1 e quindi vale la 1). Inoltre dimV(λi ) = mi per ogni i, cioè

vale la 2).

CAPITOLO II

PRODOTTI SCALARI

1. Forme bilineari. Prodotti scalari.

1. Sia V uno spazio vettoriale sul campo K .

Definizione 1.1 Si chiama forma bilineare su V un’applicazione

f : V × V −→ K

lineare in ogni variabile, cioè tale che per ogni x, y, z ∈ V e a, b ∈ K soddisfa

le

1) f (ax + bz, y) = af (x, y) + bf (z, y);

2) f (x, ay + bz) = af (x, y) + bf (x, z).

Lemma 1.2 Siano A ∈ Kn e B una base di V. L’applicazione

f :V×V →K

definita mediante la

f (x, y) = X t AY,

(1)

dove X e Y sono le matrici colonna delle componenti di x e y rispetto a B ,

è bilineare.

DIMOSTRAZIONE. Se a, b ∈ K e x, y, z ∈ V si ha

f (ax + bz, y) = (aX + bZ)t AY = aX t AY + bZ t AY = af (x, y) + bf (z, y),

f (x, ay + bz) = X t A(aY + bZ) = aX t AY + bX t AZ = af (x, y) + bf (x, z).

Ogni forma bilineare f su V si può esprimere nella forma (1). Infatti, se

B = (v1 , ..., vn ) è una base di V e

x=

n

X

xi vi ,

y=

i=1

n

X

yi vi

i=1

sono elementi di V, si ha

(2)

f (x, y) = f

n

X

i=1

xi vi ,

n

X

i=1

yi vi

!

=

n

X

i,j=1

xi yj f (vi , vj ).

1 FORME BILINEARI E PRODOTTI SCALARI

14

Se X e Y sono le matrici colonna delle componenti di x e y rispetto a B e

f (v1 , v1 ) f (v1 , v2 ) . . . f (v1 , vn )

f (v2 , v1 ) f (v2 , v2 ) . . . f (v2 , vn )

MB (f ) =

..

..

..

..

.

.

.

.

f (vn , v1 ) f (vn , v2 ) . . . f (vn , vn )

la (2) si può scrivere

f (x, y) = X t MB (f )Y.

(3)

Definizione 1.3 La matrice MB (f ) si dice matrice di f rispetto a B .

Sia Bl(V) l’insieme delle forme bilineari su V. Con la somma f + g di f, g ∈

Bl(V) ed il prodotto kf , con k ∈ K , definiti ponendo per ogni (x, y) ∈ V×V

(f + g)(x, y) = f (x, y) + g(x, y),

(kf )(x, y) = kf (x, y),

Bl(V) è uno spazio vettoriale su K ; il suo elemento nullo, denotato 0, è

l’applicazione che ad ogni (x, y) ∈ V × V associa l’elemento nullo.

Teorema 1.4 Siano n la dimensione e B una base di V. L’applicazione

ϕ : Bl(V) −→ Kn

definita ponendo

ϕ(f ) = MB (f )

è un isomorfismo.

DIMOSTRAZIONE. L’applicazione ϕ è lineare. Infatti, siano f, g ∈ Bl(V),

c, d ∈ K e siano

ϕ(f ) = MB (f ) = (aij ),

ϕ(g) = MB (g) = (bij ),

ϕ(cf + dg) = MB (cf + dg) = (cij ).

Se B = (v1 , ..., vn ), si ha

cij = (cf + dg)(vi, vj ) = cf (vi , vj ) + df (vi , vj ) = caij + dbij ,

quindi

MB (cf + dg) = cMB (f ) + dMB (g).

L’applicazione ϕ è iniettiva. Infatti, se ϕ(f ) è la matrice nulla, cioè

f (vi , vj ) = 0 per ogni i, j , risulta f = 0.

1 FORME BILINEARI E PRODOTTI SCALARI

15

L’applicazione ϕ è suriettiva. Infatti, se A = (aij ) ∈ Kn , sia f : V × V →

K l’applicazione bilineare definita mediante la (1). Se Xi è la matrice colonna

delle componenti di vi rispetto a B si ha

f (vi , vj ) = Xit AXj = aij

e quindi ϕ(f ) = A.

Cambiando la base di V la matrice di f ∈ Bl(V) cambia nel modo espresso

dal seguente teorema.

Teorema 1.5 Sia f una forma bilineare sullo spazio vettoriale V e siano A

′

e A′ le matrici di f rispetto alle basi B e B′ . Se N = MBB (I) è la matrice

di passaggio dalla base B alla base B′ , si ha

A′ = N t AN.

DIMOSTRAZIONE. Se x, y ∈ V , siano X, Y le matrici colonna delle loro

componenti rispetto a B e X ′ , Y ′ le matrici colonna delle loro componenti

rispetto a B′ . Si ha

f (x, y) = X t AY = X ′t A′ Y.′

Poiché (capitolo I, osservazione 1.2) X = NX ′ e Y = NY ′ risulta

X ′t A′ Y ′ = X t AY = (NX ′ )t A(NY ′ ) = X ′t (N t AN)Y ′

e quindi, per il teorema 1.4, si ha A′ = N t AN.

2. Sia sempre V uno spazio vettoriale su K .

Definizione 1.6 Una forma bilineare f su V si dice simmetrica se e solo se

soddisfa la condizione

f (x, y) = f (y, x) per ogni x, y ∈ V.

Una forma bilineare simmetrica su V si dice anche prodotto scalare o

prodotto interno su V o in V.

Teorema 1.7 Una forma bilineare f sullo spazio vettoriale V è simmetrica

se e solo se la sua matrice rispetto ad una qualsiasi base di V è simmetrica.

DIMOSTRAZIONE. Sia B = (v1 , ..., vn ) una base di Ve sia A = (aij ) la

matrice di f rispetto a B . Se

x=

n

X

i=1

xi vi ,

y=

n

X

i=1

yivi

16

1 FORME BILINEARI E PRODOTTI SCALARI

sono vettori di V si ha

f (x, y) =

n

X

aij xi yj ,

f (y, x) =

i,j=1

n

X

aji yj xi .

i,j=1

Se A è simmetrica risulta aij = aji per ogni i, j e quindi f (x, y) = f (y, x),

cioè f è simmetrica.

Viceversa, se f è simmetrica si ha aij = f (vi , vj ) = f (vj , vi ) = aji per

ogni i, j e quindi A è simmetrica.

Nel seguito, una forma bilineare simmetrica la chiameremo prodotto scalare; generalmente un prodotto scalare lo denoteremo con il simbolo ◦ e denoteremo x ◦ y il valore assunto da ◦ nella coppia di vettori x, y di V e diremo

x ◦ y prodotto scalare di x, y.

Esempio 1.8 Se V = K n , l’applicazione K n × K n → K definita ponendo

per ogni coppia di elementi x = (x1 , ..., xn ), y = (y1, ..., yn ) di K n

x◦y =

n

X

xi yi

i=1

è un prodotto scalare che si dice prodotto scalare canonico su K n .

Osservazione 1.9 Se il campo K ha caratteristica 6= 2 e f, g sono due

prodotti scalari su V tali che f (v, v) = g(v, v) per ogni v ∈ V, allora f = g .

Infatti, se x,y ∈ V si ha

f (x + y, x + y) = f (x, x) + 2f (x, y) + f (y, y),

g(x + y, x + y) = g(x, x) + 2g(x, y) + g(y, y)

e quindi

2(f (x, y) − g(x, y)) = 0.

Poiché la caratteristica di K è 6= 2, da ciò segue che

f (x, y) = g(x, y) per ogni x, y ∈ V,

cioè f = g .

Osservazione 1.10 Se il campo K ha caratteristica 6= 2 ed il prodotto

scalare è non nullo esiste un vettore 0 6= v ∈ V tale che v ◦ v 6= 0. Infatti, se

v◦v = 0 per ogni v ∈ V dall’osservazione 1.9 segue che il prodotto scalare è

nullo.

17

2 ORTOGONALITÀ

2. Ortogonalità.

1. Sia V uno spazio vettoriale su K su cui sia definito un prodotto scalare

◦.

Definizione 2.1 Due vettori x, y ∈ V si dicono ortogonali o perpendicolari

(rispetto al prodotto scalare assegnato su V) se e solo se x ◦ y = 0.

Due sottoinsiemi M, N di V si dicono ortogonali o perpendicolari se e

solo se ogni vettore di uno di essi è ortogonale a tutti i vettori dell’altro. Per

denotare che due vettori x e y sono ortogonali scriveremo x ⊥ y.

Osservazione 2.2 Se M, N sono due sottoinsiemi di V tra loro ortogonali,

allora sono ortogonali tra loro i sottospazi [M ], [N ] da essi generati.

Infatti, se x ∈ [M ], y ∈ [N ] si ha

x=

r

X

i=1

xi ui ,

y=

s

X

yj vj ,

ui , ∈ M,

j=1

e quindi

x◦y =

X

i,j

vj ∈ N,

xi , yj ∈ K

xi yj ui ◦ vj = 0.

Definizione 2.3 Per ogni sottoinsieme M di V il sottospazio

M⊥ = {x ∈ V : x ⊥ v per ogni v ∈ M}

si dice complemento ortogonale di M .

Definizione 2.4 Un prodotto scalare su V si dice non singolare o non degenere se V⊥ = (0), singolare o degenere in caso contrario.

Teorema 2.5 Un prodotto scalare su uno spazio vettoriale V è non singolare

se e solo se la sua matrice rispetto ad una qualunque base di V è non singolare.

DIMOSTRAZIONE. Sia B = (v1 , . . . , vn ) una base di V e sia A = (aij ) la

matrice del prodotto scalare rispetto a B . Il sottospazio V⊥ è costituito dai

vettori v ∈ V tali che vi ◦ v = 0 per i = 1, 2, . . . , n. Se X = (x1 , ..., xn )t e Xi

= (0, ..., 1, ..., 0)t sono le matrici colonna delle componenti di v, vi rispetto a

B , risulta

vi ◦ v = Xit AX = ai1 x1 + ai2 x2 + · · · + ain xn

18

2 ORTOGONALITÀ

e perciò v ∈ V⊥ se e solo se

a11 x1 + a12 x2

...

an1 x1 + an2 x2

+ ··· +

a1n xn

= 0

+ · · · + ann xn

= 0

Quindi V⊥ = (0) se e solo se det A 6= 0.

Corollario 2.6 Se su uno spazio vettoriale V è definito un prodotto scalare

non singolare ◦, per ogni sottospazio U di V si ha

1) dimU⊥ = dimV − dimU;

2) U⊥⊥ = U.

DIMOSTRAZIONE. 1) Sia B = (v1 , . . . , vn ) una base di V in modo che

(v1 , . . . , vr ) sia una base di U. Il complemento ortogonale U⊥ di U è costituito dai vettori v ∈ V tali che vi ◦v = 0 per 1 ≤ i ≤ r e quindi, se A = (aij )

è la matrice del prodotto scalare rispetto a B , dai vettori v le cui componenti

rispetto a B sono soluzione del sistema

a11 x1 + a12 x2 + · · · + a1n xn = 0

...

ar1 x1 + ar2 x2 + · · · + arn xn = 0

La matrice M dei coefficienti di tale sistema è costituita dalle prime r righe

della matrice A, che sono linearmente indipendenti perché A è non singolare

(teorema 2.5); quindi la caratteristica di M è r e perciò

dimU⊥ = n − r = dimV − dimU.

2) Se u ∈ U risulta u ◦ v = 0 per ogni v ∈ U⊥ e perciò u ∈ U⊥⊥ , cioè

U ⊂ U⊥⊥ . Per la 1) si ha

dimU⊥⊥ = dimV − dimU⊥ = dimV − (dimV − dimU) = dimU

e perciò U⊥⊥ = U.

Definizione 2.7 Se U è un sottospazio di V, un prodotto scalare f su V si

dice non degenere o non singolare su U se tale è quello indotto da f su U

(cioè la restrizione di f a U × U).

Teorema 2.8 Sia V uno spazio vettoriale su cui sia definito un prodotto

scalare ◦. Il prodotto scalare è non singolare sul sottospazio U di V se e solo

se risulta

V = U ⊕ U⊥ .

19

2 ORTOGONALITÀ

DIMOSTRAZIONE. Se V = U⊕U⊥ si ha U∩U⊥ = (0) e quindi il prodotto

scalare è non singolare su U.

Viceversa, sia il prodotto scalare non singolare su U. Se B = (u1 , ..., um )

è una base di U ed aij = ui ◦ uj , per il teorema 2.5 si ha det(aij ) 6= 0 e quindi

per ogni v ∈ V il sistema lineare

a11 x1 + a21 x2 + · · · + am1 xm = v ◦ u1

...

a1m x1 + a2m x2 + · · · + amm xm = v ◦ um

ha una soluzione (b1 , . . . , bm ) ∈ K m . Posto

u = b1 u1 + b2 u2 + · · · + bm um ,

w = v − u,

risulta

w ◦ ui =

=

=

=

v ◦ ui − u ◦ ui

(a1i b1 + a2i b2 + · · · + ami bm ) − (b1 u1 + b2 u2 + · · · + bm um ) ◦ ui

(a1i b1 + a2i bi + · · · + ami bm ) − (b1 a1i + b2 a2i + · · · + bm ami )

0

(1 ≤ i ≤ m)

e quindi w ∈ U⊥ . Poiché v = u + w si ha V = U + U⊥ . Essendo il prodotto

scalare non singolare su U si ha U ∩ U⊥ = (0) e quindi V = U ⊕ U⊥ .

Corollario 2.9 Sia ◦ un prodotto scalare definito su uno spazio vettoriale V, non singolare sul sottospazio U di V. Allora ◦ è non singolare sul

complemento ortogonale U⊥ di U se e solo se è non singolare su V.

DIMOSTRAZIONE. Se ◦ è non singolare su V si ha (corollario 2.6) U =

U⊥⊥ , quindi V = U⊥⊥ ⊕ U⊥ e perciò (teorema 2.8) ◦ è non singolare su

U⊥ .

D’altra parte, sia ◦ non singolare su U⊥ . Se A e B sono le matrici dei

prodotti scalari indotti rispetto alle basi B1 di U e B2 di U⊥ , la matrice di

◦ rispetto alla base B1 ∪ B2 di V è

A 0

M=

.

0 B

Si ha (teorema 2.5) det A 6= 0, det B 6= 0, quindi det M = det A det B 6= 0 e

perciò (teorema 2.5) ◦ è non singolare su V.

2. Sia V uno spazio vettoriale su cui sia definito un prodotto scalare ◦.

20

2 ORTOGONALITÀ

Definizione 2.10 Una base (v1 , ..., vn ) di V si dice ortogonale (rispetto al

prodotto scalare assegnato) se

vi ◦ vj = 0 per ogni i 6= j

e si dice ortonormale se è ortogonale ed inoltre

vi ◦ vi = 1 per 1 ≤ i ≤ n.

Esempio 2.11 La base canonica dello spazio vettoriale K n è ortonormale

rispetto al prodotto scalare canonico.

Osservazione 2.12 Se B = (v1 , ..., vn ) è una base ortonormale di V e

x=

n

X

xi vi ,

y=

i=1

sono vettori di V risulta

x◦y=

n

X

i=1

xi vi

n

X

yi vi

i=1

!

◦

n

X

i=1

yi vi

!

=

n

X

xi yi ;

i=1

cioè rispetto ad una base ortonormale la matrice del prodotto scalare è quella

identica.

Teorema 2.13 Sia V uno spazio vettoriale di dimensione positiva n su K

su cui sia definito un prodotto scalare ◦. Se K ha caratteristica 6= 2 esistono

in V basi ortogonali.

DIMOSTRAZIONE. Se n = 1 oppure il prodotto scalare è nullo il teorema è

banalmente vero perché ogni base di V è ortogonale. Supponiamo, allora, che

sia n ≥ 2, che il prodotto scalare sia non nullo e procediamo per induzione

su n, supponendo che il teorema sia vero per spazi di dimensione n − 1.

Essendo il prodotto scalare non nullo esiste un vettore v1 ∈ V tale che v1 ◦

v1 6= 0 (osservazione 1.10). Il prodotto scalare è non singolare sul sottospazio

V1 = [v1 ] generato da v1 , in quanto v1 ◦ v1 6= 0 e quindi, per il teorema 2.8,

si ha

V = V1 ⊕ V1⊥ .

Poiché dimV1⊥ = n − 1, V1⊥ ha una base (v2 , ..., vn ) ortogonale rispetto al

prodotto scalare indotto e (v1 , v2 , ..., vn ) è una base ortogonale di V.

Corollario 2.14 Se il campo K ha caratteristica 6= 2 e la matrice A ∈ Kn

è simmetrica, esiste una matrice non singolare N ∈ Kn tale che N t AN è

diagonale.

21

2 ORTOGONALITÀ

DIMOSTRAZIONE. Sia B una base di K n e sia ◦ il prodotto scalare su K n la

cui matrice rispetto a B sia A. Per il teorema 2.13 esiste una base ortogonale

di K n e rispetto ad essa la matrice A′ del prodotto scalare è diagonale. Dal

teorema 1.5 segue il corollario.

Il teorema 2.13 assicura l’esistenza di basi ortogonali. Il seguente teorema

2.15 fornisce un procedimento, detto di Gram-Schmidt, per costruire una base

ortogonale a partire da una base qualsiasi di V.

Teorema 2.15 Sia V uno spazio vettoriale su cui sia definito un prodotto

scalare ◦ tale che v ◦ v 6= 0 per ogni 0 6= v ∈ V . Se (u1 , ..., un ) è una base

di V, allora una base ortogonale di V è (v1 , ..., vn ) con

v1 = u1 ,

ui ◦ v1

ui ◦ vi−1

vi−1 − · · · −

v1 ,

vi = ui −

vi−1 ◦ vi−1

v1 ◦ v1

2 ≤ i ≤ n.

DIMOSTRAZIONE. Sia Vi = [u1 , ..., ui ], 1 ≤ i ≤ n, il sottospazio di V

generato da u1 , ..., ui , con il prodotto scalare indotto da quello di V e dimostriamo che (v1 , ..., vi ) è una base ortogonale di Vi . Ciò è manifestamente

vero per i = 1. Supponiamo allora che sia i ≥ 2 e procediamo per induzione, ammettendo che (v1 , ..., vi−1 ) sia una base ortogonale di Vi−1 . Per ogni

1 ≤ j ≤ i − 1 si ha

ui ◦ vi−1

ui ◦ v1

vi ◦ vj =

ui −

vi−1 − · · · −

v1 ◦ vj

vi−1 ◦ vi−1

v1 ◦ v1

ui ◦ vj

vj ◦ vj = 0.

= ui ◦ vj −

vj ◦ vj

Inoltre i vettori v1 , ..., vi sono linearmente indipendenti perché, se

i

X

h=1

ah vh = 0,

ah ∈ K,

per ogni 1 ≤ j ≤ i si ha

i

X

h=1

ah vh ◦ vj = aj vj ◦ vj = 0

e quindi aj = 0 per 1 ≤ j ≤ i. Dunque (v1 , ..., vi ) è una base ortogonale di

Vi . Per i = n si ha il teorema.

Assegnato un prodotto scalare su uno spazio vettoriale V mediante la sua

matrice rispetto ad una base B , un metodo, detto di Jacobi, per determinare

una matrice diagonale del prodotto scalare è quello descritto nel seguente

teorema.

22

2 ORTOGONALITÀ

Teorema 2.16 Sia V uno spazio vettoriale con un prodotto scalare ◦ la cui

matrice rispetto alla base B = (v1 , ..., vn ) sia A = (aij ). Posto

a11 . . . a1r .

.. ..

(1 ≤ r ≤ n),

dr = ..

.

. a

. . . arr

r1

se

dr 6= 0 per 1 ≤ r ≤ n − 1,

esiste in V una base B′ ortogonale rispetto alla quale la matrice del prodotto

scalare è

c1 0 . . . 0

0 c2 . . . 0

.

.

.. . .

..

. ..

.

0 0 . . . cn

con

dr

c1 = d 1 , cr =

(2 ≤ r ≤ n).

dr−1

DIMOSTRAZIONE. Se 1 ≤ i ≤ n − 1, essendo di 6= 0, il sistema lineare

a11 t1 + · · · + ai1 ti + ai+1 1 = 0

...

a1i t1 + · · · + aii ti + ai+1 i = 0

nelle indeterminate t1 , ..., ti ha una soluzione (b1 i+1 , ..., bi i+1 ) in K i . I vettori

v1′ = v1 ,

vi′ = b1i v1 + b2i v2 + · · · + bi−1 i vi−1 + vi ,

2 ≤ i ≤ n,

costituiscono la base B′ richiesta. Infatti, avendo la matrice

1 b12 . . . b1i

0 1 . . . b2i

.

.. . .

..

.

Ni =

.

.

.

.

0 0 ... b

i−1 i

0 0 ...

1

determinante 1, i vettori v1′ , ..., vi′ sono linearmente indipendenti e quindi

Vi = [v1 , ..., vi ] = [v1′ , ..., vi′ ].

′

Il vettore vi+1

è ortogonale a v1 , ..., vi in quanto, per ogni 1 ≤ h ≤ i, si ha

′

vi+1

◦ vh =

i

X

j=1

bj i+1 (vj ◦ vh ) + vi+1 ◦ vh =

i

X

j=1

ajh bj i+1 + ai+1 h = 0.

23

2 ORTOGONALITÀ

′

Allora vi+1

è anche ortogonale a v1′ , ..., vi′ e quindi (v1′ , ..., vr′ ) è una base

ortogonale di Vr per ogni 1 ≤ r ≤ n. Il prodotto scalare indotto su Vr ,

rispetto alla base Br = (v1 , ..., vr ) ha come matrice

a11 . . . a1r

..

.

..

Ar = ..

.

.

ar1 . . . arr

mentre rispetto alla base Br′ = (v1′ , ..., vr′ ) ha una matrice diagonale

c1 . . . 0

.

.

A′r = .. . . . ..

0 . . . cr

e, per il teorema 1.5, si ha A′r = Nrt Ar Nr . Poiché det Nrt = det Nr = 1 si ha

c1 c2 ...cr = det A′r = dr .

Da ciò segue che

c1 = d 1 ,

cr =

dr

dr

=

(2 ≤ r ≤ n).

c1 ...cr−1

dr−1

3. Se il campo K ha caratteristica 6= 2 ed un prodotto scalare ◦ non nullo

su V è assegnato mediante la sua matrice A = (aij ) rispetto ad una data base

B , una matrice diagonale del prodotto scalare può essere determinata con un

procedimento elementare, detto del completamento dei quadrati.

Per illustrare tale procedimento ci occorre il

Lemma 2.17 Sia B = (v1 , ..., vn ) una base dello spazio vettoriale V. Se

x1 , ..., xn sono le componenti di v ∈ V rispetto a B e

xi =

n

X

cij x′j ,

j=1

cij ∈ K,

1 ≤ i ≤ n,

det(cij ) 6= 0,

allora x′1 , ..., x′n sono le componenti di v rispetto alla base

vj′

=

n

X

i=1

cij vi ,

1 ≤ j ≤ n.

24

2 ORTOGONALITÀ

DIMOSTRAZIONE. Si ha

v=

n

X

xi vi =

n

n

X

X

i=1

i=1

cij x′j

j=1

!

vi =

n

X

j=1

x′j

n

X

cij vi =

n

X

x′j vj′ .

j=1

i=1

Se x1 , ..., xn sono le componenti di v ∈ V rispetto alla base B = (v1 , ..., vn ),

allora

(1)

v◦v =

n

X

aij xi xj =

i,j=1

n

X

aii x2i + 2

i=1

X

aij xi xj .

i<j

Supponiamo che nella (1) vi sia uno dei coefficienti aii non nullo e, salvo

uno scambio di indici, possiamo supporre a11 6= 0. I termini della (1) che

contengono x1 sono

X

a11 x21 + 2

a1j x1 xj =

=

=

1<j

1 X

2 X

a11 x21 +

a1j x1 xj + 2

a1j xj

a11 1<j

a11 1<j

!2

!2

X a1j

1 X

xj −

a1j xj

a11 x1 +

a

a

11

11

1<j

1<j

e quindi

v ◦ v = a11

X a1j

x1 +

1<j

a11

xj

!2

!2

− 1

a11

X

1<j

a1j xj

!2

+ h(x2 , ..., xn ),

con h(x2 , ..., xn ) polinomio omogeneo di grado 2 non contenente x1 . Posto

X a1j

xj ,

x′i = xi (2 ≤ i ≤ n),

x′1 = x1 +

a

1<j 11

ossia

x1 = x′1 −

poiché

X a1j

1<j

a11

x′j ,

1 − a12

a11

0

1

.

..

..

.

0

0

xi = x′i (2 ≤ i ≤ n),

... −

...

..

.

...

a1n

a11

0

..

.

1

= 1,

25

2 ORTOGONALITÀ

per il lemma 2.17, x′1 , x2 , ..., xn sono le componenti di v rispetto alla base

v1′ = v1 ,

vi′ = −

a1i

v1 + vi

a11

(2 ≤ i ≤ n).

Rispetto a tale base risulta

2

v ◦ v = a11 x′ 1 + h(x2 , ..., xn ),

la matrice del prodotto scalare è del tipo

a11 0 . . . 0

0 b22 . . . b2n

.

..

..

..

..

.

.

.

0 bn2 . . . bnn

e B = (bij ) è la matrice del prodotto scalare indotto sul sottospazio [v2′ , ..., vn′ ]

generato da v2′ , ..., vn′ rispetto alla base (v2′ , ..., vn′ ).

Se nella (1) tutti i coefficienti aii delle x2i sono nulli, essendo il prodotto

scalare non nullo, uno dei coefficienti aij è non nullo e, salvo uno scambio di

indici, possiamo supporre che sia a12 6= 0. Posto

x1 = y1 + y2 ,

x2 = y1 − y2 ,

xi = yi (3 ≤ i ≤ n)

poiché

1

1

0

.

.

.

0

1 −1 0 . . . 0 0

0 1 . . . 0 = −2

.

.. .. . .

..

. 0 . .

0

0 0 ... 1

e la caratteristica di K è 6= 2, per il lemma 2.17, y1 , . . . , yn sono le componenti

di v rispetto alla base

u1 = v1 + v2 ,

u2 = v1 − v2 ,

ui = vi (3 ≤ i ≤ n).

L’espressione di v ◦ v rispetto alla base (u1 , . . . , un ) è ottenuta dalla (1)

mediante la (2) ed in essa compare 2a12 y12 − 2a12 y22 , trasformato di 2a12 x1 x2

ed il termine 2a12 y12 non si cancella con altri termini. Adesso si prosegue

come nel caso precedente. Ripetendo il procedimento per il prodotto scalare

indotto sul sottospazio [v2′ , . . . , vn′ ] e proseguendo successivamente in modo

analogo otteniamo una matrice diagonale del prodotto scalare.

4. Se il campo K ha caratteristica 6= 2 il numero di indici i per i quali in

una base ortogonale B = (v1 , ..., vn ) di V si ha vi ◦ vi = 0 non dipende dalla

base B , come risulta dal seguente teorema.

3 PRODOTTI SCALARI SU SPAZI VETTORIALI REALI

26

Teorema 2.18 Se il campo K ha caratteristica 6= 2 e B = (v1 , ..., vn ) è una

base ortogonale dello spazio vettoriale V con un prodotto scalare ◦, il numero

di indici i per i quali vi ◦ vi = 0 è uguale alla dimensione di V⊥ .

DIMOSTRAZIONE. Se vi ◦ vi = 0 per ogni 1 ≤ i ≤ n, allora V = V⊥ ed il

teorema è vero. Supponiamo che vi sia un indice i tale che vi ◦ vi 6= 0. Gli

elementi di B possono essere ordinati in modo che sia

6= 0

se 1 ≤ i ≤ s,

vi ◦ vi

=0

se s + 1 ≤ i ≤ n.

Allora

vj ◦ vi = 0

per 1 ≤ j ≤ n, s + 1 ≤ i ≤ n

P

e quindi vs+1 , ..., vn ∈ V . Se v = ni=1 ai vi ∈ V⊥ , risulta

!

n

X

v ◦ vi =

ai vi ◦ vi = ai vi ◦ vi = 0

per 1 ≤ i ≤ n

⊥

i=1

ed allora, essendo vi ◦ vi 6= 0 per 1 ≤ i ≤ s, deve essere a1 = · · · = as = 0.

Quindi V⊥ è generato da vs+1 , ..., vn . Poiché vs+1 , ..., vn sono linearmente

indipendenti, in quanto elementi di una base, costituiscono una base di V⊥ ,

da cui il teorema.

3. Prodotti scalari su spazi vettoriali reali.

1. Gli spazi vettoriali reali sono gli spazi vettoriali sul campo reale R.

Definizione 3.1 Un prodotto scalare ◦ su uno spazio vettoriale reale V si

dice positivo se e solo se x ◦ x > 0 per ogni 0 6= x ∈ V e si dice negativo se e

solo se x ◦ x < 0 per ogni 0 6= x ∈ V .

Esempio 3.2 Il prodotto scalare canonico di Rn P

è positivo.

Infatti, se x = (x1 , ..., xn ) ∈ Rn , si ha x ◦ x = ni=1 x2i .

Osservazione 3.3 Un prodotto scalare positivo o negativo su V è non degenere.

Infatti, se un prodotto scalare ◦ su V è degenere, esiste un elemento

0 6= v ∈ V⊥ e quindi tale che v ◦ v = 0.

Osservazione 3.4 Se B = (v1 , ..., vn ) è una base ortogonale di V e x1 , ..., xn

sono le componenti di v ∈ V rispetto a B si ha

v◦v=

n

X

i=1

x2i (vi ◦ vi )

27

3 PRODOTTI SCALARI SU SPAZI VETTORIALI REALI

e quindi il prodotto scalare è positivo se e solo se vi ◦vi > 0 per ogni 1 ≤ i ≤ n

ed è negativo se e solo se vi ◦ vi < 0 per ogni 1 ≤ i ≤ n.

Il numero di indici i per i quali in una base ortogonale B = (v1 , ..., vn ) di V

risulta vi ◦ vi > 0 non dipende dalla base, come risulta dal seguente teorema.

Teorema 3.5 (di Sylvester) Sia V uno spazio vettoriale reale su cui sia

definito un prodotto scalare ◦. Esiste un intero r ≥ 0 con la proprietà: per

ogni base ortogonale B = (v1 , ..., vn ) di V vi sono esattamente r indici i tali

che vi ◦ vi > 0.

DIMOSTRAZIONE. Siano B = (v1 , ..., vn ) e B′ = (v1′ , ..., vn′ ) basi ortogonali

di V e sia

ai = vi ◦ vi ,

a′i = vi′ ◦ vi′ ,

1 ≤ i ≤ n.

Siano r il numero di indici i per i quali ai > 0 e s il numero di indici i per i

quali a′i > 0. Se r = 0 anche s = 0. Infatti, se vi fosse un elemento a′h > 0,

poiché

n

X

′

vh =

cj vj ,

cj ∈ K,

j=1

si avrebbe l’assurdo

0 < a′h = vh′ ◦ vh′ =

n

X

cj vj

j=1

!

◦

n

X

cj vj

j=1

!

=

n

X

j=1

c2j aj ≤ 0.

Se r = n il prodotto scalare è positivo (osservazione 3.4), quindi a′j > 0

per ogni j e perciò s = n = r . Sia 1 ≤ r < n; allora 1 ≤ s < n. Le basi B ,

B′ si possono pensare ordinate in modo che sia

> 0 se 1 ≤ i ≤ r,

> 0 se 1 ≤ i ≤ s,

′

ai

ai

≤ 0 se r + 1 ≤ i ≤ n,

≤ 0 se s + 1 ≤ i ≤ n.

′

, ..., vn′ sono linearmente indipendenti. Infatti, sia

I vettori v1 , ..., vr , vs+1

r

X

(1)

bi vi +

i=1

n

X

b′j vj′ = 0,

j=s+1

bi , b′j ∈ R.

Allora

r

X

i=1

bi vi

!

◦

r

X

i=1

bi vi

!

=

n

X

j=s+1

b′j vj′

!

◦

n

X

j=s+1

b′j vj′

!

3 PRODOTTI SCALARI SU SPAZI VETTORIALI REALI

e quindi

r

X

ai b2i =

i=1

n

X

28

2

a′j b′j .

j=s+1

Il primo membro di questa uguaglianza è ≥ 0 mentre il secondo membro è

≤ 0, quindi entrambi i membri debbono essere nulli. Poiché a1 , ..., ar sono

positivi, deve essere b1 = · · · = br = 0; la (1) diviene allora

n

X

b′j vj′ = 0

j=s+1

′

e poiché vs+1

, ..., vn′ sono linearmente indipendenti deve essere b′s+1 = · · · =

b′n = 0. Ne segue, allora, che r + (n − s) ≤ n e quindi r ≤ s. Analogamente

s ≤ r e perciò r = s.

Osservazione 3.6 Dal teorema 3.5 e dal teorema 2.18 segue che non dipende

dalla base ortogonale B = (v1 , ..., vn ) il numero di indici j per cui vj ◦vj < 0.

2. Si ha il

Teorema 3.7 Un prodotto scalare ◦ su uno spazio vettoriale reale V è positivo se e solo se la sua matrice A = (aij ) rispetto ad una qualunque base

B = (v1 , ..., vn ) di V è tale che

a11 . . . a1r .

.. ..

dr = ..

.

. > 0 per ogni 1 ≤ r ≤ n.

a

. . . arr r1

DIMOSTRAZIONE. Se dr > 0 per 1 ≤ r ≤ n, per il teorema 2.16, esiste in

V una base B′ ortogonale tale che, se x1 , ..., xn sono le componenti di v ∈ V

rispetto a B′ , si ha

v◦v=

n

X

i=1

ci x2i ,

c1 = d 1 ,

cr =

dr

(2 ≤ r ≤ n)

dr−1

e quindi il prodotto scalare è positivo (osservazione 3.4).

Viceversa, sia il prodotto scalare positivo. Sia Vr = [v1 , ..., vr ]; allora

a11 . . . a1r

.

..

..

Ar = ..

.

.

ar1 . . . arr

3 PRODOTTI SCALARI SU SPAZI VETTORIALI REALI

29

è la matrice del prodotto scalare indotto su Vr rispetto alla base Br =

(v1 , ..., vr ). Esiste in Vr una base ortogonale Br′ (teorema 2.13) e rispetto ad

essa la matrice del prodotto scalare è del tipo

b1 . . . 0

.

.

A′r = .. . . . ..

0 . . . br

con bi > 0 per 1 ≤ i ≤ r (osservazione 3.6). Se Nr è la matrice di passaggio

dalla base Br alla base Br′ si ha (teorema 1.5)

A′r = Nrt Ar Nr

e quindi

b1 b2 ...br = (det Nr )2 dr ,

da cui segue che dr > 0 per 1 ≤ r ≤ n. 3. Sia V uno spazio vettoriale reale

con un prodotto scalare positivo ◦.

Definizione 3.8 Se x ∈ V , il numero reale

√

kxk = x ◦ x

si dice norma o lunghezza di x. Un vettore u ∈ V di lunghezza 1 si dice

unitario.

Se x ∈ V e x 6= 0, il vettore

u=

è unitario.

x

kxk

Teorema 3.9 In uno spazio vettoriale reale V, di dimensione positiva, su

cui è definito un prodotto scalare ◦, esistono basi ortonormali se e solo se il

prodotto scalare è positivo.

DIMOSTRAZIONE. Se il prodotto scalare è positivo, è non degenere (osservazione 3.3) e, per il teorema 2.13, V possiede una base ortogonale B =

(v1 , ..., vn ). Poiché il prodotto scalare è positivo si ha vi ◦vi > 0 per 1 ≤ i ≤ n

ed allora, posto

vi

,

1 ≤ i ≤ n,

ui =

kvi k

(u1 , ..., un ) è una base ortonormale di V.

D’altra parte, se il prodotto scalare non è positivo e (v1 , . . . , vn ) è una base

ortogonale di V vi è almeno un elemento vi tale che vi ◦ vi ≤ 0 (osservazione

3.4) e quindi in V non esistono basi ortonormali.

3 PRODOTTI SCALARI SU SPAZI VETTORIALI REALI

30

Teorema 3.10 Sia V uno spazio vettoriale reale su cui sia definito un prodotto scalare positivo ◦. Per ogni coppia di vettori x, y ∈ V si ha:

1) |x ◦ y| ≤ kxk kyk (Disuguaglianza di Schwarz);

2) kx + yk ≤ kxk + kyk;

3) |kxk − kyk| ≤ kx − yk.

DIMOSTRAZIONE. 1) Se x = 0 la 1) è banalmente vera. Sia x 6= 0; allora

0 ≤ (kx − y) ◦ (kx − y) = kxk2 k 2 − 2(x ◦ y)k + kyk2

e quindi deve essere

da cui la 1).

2) Segue da

(x ◦ y)2 ≤ kxk2 kyk2 ,

kx + yk2 = (x + y) ◦ (x + y) = kxk2 + 2x ◦ y + kyk2

≤ kxk2 + 2kxk kyk + kyk2 = (kxk + kyk)2 .

3) Da

segue che

Anlogamente

e perciò si ha la 3).

kxk = kx − y + yk ≤ kx − yk + kyk

kxk − kyk ≤ kx − yk.

kyk − kxk ≤ kx − yk

Osservazione 3.11 Se i vettori x, y sono entrambi non nulli, nella disuguaglianza di Schwartz vale l’uguaglianza se e solo se essi sono linearmente

dipendenti. Infatti, se sono linearmente dipendenti esiste un elemento k0 ∈ K

tale che y = k0 x ed allora k0 è radice reale dell’equazione in k

(2)

quindi

kxk2 k 2 − 2(x ◦ y)k + kyk2 = 0,

(x ◦ y)2 ≥ kxk2 kyk2 ,

da cui l’uguaglianza.

Viceversa, se vale l’uguaglianza, l’equazione (2) ha una radice reale k0 ,

quindi

(k0 x − y) ◦ (k0 x − y) = 0

e perciò y = k0 x.

31

4 FORME QUADRATICHE

Dalla disuguaglianza di Schwartz segue che, se x 6= 0 e y 6= 0, si ha

−1 ≤

x◦y

≤ 1.

kxk kyk

Poiché la funzione coseno è un’applicazione strettamente decrescente dell’intervallo chiuso [0, π] sull’intervallo chiuso [−1, 1], esiste un ben determinato

numero reale θ tale che

x◦y

cos θ =

, 0 ≤ θ ≤ π.

kxk kyk

Il numero reale θ è l’angolo dei vettori x, y. I vettori x, y sono ortogonali se

e solo se il loro angolo è π2 .

4. Forme quadratiche.

1. Sia V uno spazio vettoriale su un campo K di caratteristica 6= 2.

Definizione 4.1 Si chiama forma quadratica su V un’applicazione

q : V −→ K

tale che esiste un prodotto scalare ◦ su V in modo che

q(v) = v ◦ v per ogni v ∈ V

e si dice che q è determinata o definita dal prodotto scalare ◦.

Dall’osservazione 1.9 segue che una forma quadratica q su V è determinata

da un unico prodotto scalare su V.

Sia q una forma quadratica su V e sia B = (v1 , ..., vn ) una base di V.

La matrice A = (aij ) rispetto a B del prodotto scalare che definisce q si dice

anche matrice di q rispetto a B . Se

v=

n

X

xi vi ,

X = (x1 , ..., xn )t ,

i=1

risulta

(1)

q(v) = X t AX =

X

aij xi xj .

i,j

D’altra parte, assegnata una matrice simmetrica A = (aij ) ∈ Kn di ordine

n = dimV , A definisce una forma bilineare su V avente A come matrice

32

4 FORME QUADRATICHE

rispetto a B (teorema 1.4), che è simmetrica (teorema 1.7) e quindi definisce

una forma quadratica q su V per la quale si ha la (1).

Se x1 , ..., xn sono le componenti di v ∈ V rispetto alla base B , scriveremo

anche

q(v) = q(x1 , ..., xn ).

Una base che diagonalizza q è una base (u1 , ..., un ) di V rispetto alla quale

la matrice di q è diagonale, cioè rispetto alla quale q si esprime mediante la

(2)

q(x1 , ..., xn ) =

n

X

i=1

ai x2i ,

ai = ui ◦ ui .

Dal teorema 2.13 segue che esistono in V basi che diagonalizzano q .

Una matrice diagonale di q si ottiene col completamento dei quadrati (§2,

n.3) o col metodo di Jacobi (teorema 2.16).

Definizione 4.2 Il numero di indici i per i quali nella (2) è ai = 0, che per

il teorema 2.18 non dipende dalla base B che diagonalizza q , si dice indice di

nullità di q .

Definizione 4.3 La forma quadratica q si dice non degenere se e solo se è

non degenere il prodotto scalare che la definisce.

Dal teorema 2.5 segue il

Corollario 4.4 Una forma quadratica è non degenere se e solo se ha indice

di nullità 0.

2. Una forma quadratica reale è una forma quadratica su uno spazio vettoriale

reale.

Definizione 4.5 Una forma quadratica reale q si dice:

definita positiva se e solo se q(v) > 0 per ogni 0 6= v ∈ V , cioè se e solo

se è positivo il prodotto scalare che la definisce,

definita negativa se e solo se q(v) < 0 per ogni 0 6= v ∈ V ,

semidefinita positiva se e solo se q(v) ≥ 0 per ogni v ∈ V ,

semidefinita negativa se e solo se q(v) ≤ 0 per ogni v ∈ V .

Se A = (aij ) è la matrice di q rispetto ad una base B di V, una condizione

necessaria e sufficiente perché q sia definita positiva è data dal teorema 3.7.

33

5 ENDOMORFISMI SIMMETRICI

Definizione 4.6 Se B = (u1 , ..., un ) è una base che diagonalizza q e rispetto

ad essa q si esprime mediante la (2), il numero dei coefficienti ai che sono

positivi, che non dipende da B (teorema 3.5), si dice indice di positività di

q . Il numero dei coefficienti ai che sono negativi, che non dipende da B in

conseguenza del teorema 2.18, si dice indice di negatività di q .

Corollario 4.7 Una forma quadratica reale su V è definita positiva (negativa) se e solo se il suo indice di positività (negatività) è uguale alla dimensione

di V.

5. Endomorfismi simmetrici.

1. Sia V uno spazio vettoriale su K . Lo spazio vettoriale duale di V è

V∗ = Hom(V, K).

Se (v1 , ..., vn ) è una base di V, gli elementi v1∗ , ..., vn∗ di V∗ tali che

0, se i =

6 j;

∗

vi (vj ) =

1, se i = j;

costituiscono una base di V∗ , la duale di (v1 , ..., vn ).

Teorema 5.1 Sia V uno spazio vettoriale su K su cui sia definito un prodotto

scalare ◦ non singolare e per ogni v ∈ V sia λv l’elemento di V∗ tale che

λv (x) = v ◦ x

per ogni x ∈ V.

L’applicazione

definita da

Ψ : V −→ V∗

Ψ(v) = λv

è un isomorfismo.

DIMOSTRAZIONE. L’applicazione Ψ è lineare in quanto, se u, v ∈ V e

a, b ∈ K , per ogni x ∈ V si ha

λau+bv (x) = (au + bv) ◦ x = au ◦ x + bv ◦ x = aλu (x) + bλv (x)

= (aλu + bλv )(x)

e perciò

Ψ(au + bv) = aΨ(u) + bΨ(v).

34

5 ENDOMORFISMI SIMMETRICI

Inoltre Ψ è iniettiva. Infatti, se Ψ(v) = 0 si ha λv (x) = v ◦ x = 0 per ogni

x ∈ V ed essendo il prodotto scalare non singolare deve essere v = 0. Ed

allora, avendo V e V∗ la stessa dimensione, Ψ è isomorfismo.

Teorema 5.2 Sia V uno spazio vettoriale su K su cui sia definito un prodotto scalare ◦ non singolare. Per ogni endomorfismo S di V esiste un ben

determinato endomorfismo T di V tale che

(1)

x ◦ S(y) = T (x) ◦ y

per ogni x, y ∈ V.

DIMOSTRAZIONE. Per ogni x ∈ V , sia

fx : V → K

l’applicazione definita da

fx (y) = x ◦ S(y).

Si verifica subito che fx ∈ V∗ e quindi, per il teorema 5.1, esiste un ben

determinato elemento v ∈ V tale che se λv : V −→ K è l’applicazione lineare

definita da λv (y) = v ◦ y, risulta fx = λv . L’applicazione T : V −→ V

definita da x → v soddisfa la (1); infatti,

x ◦ S(y) = fx (y) = λT (x) (y) = T (x) ◦ y.

E T è un endomorfismo di V perché se x, y, z ∈ V e a, b ∈ K si ha

T (ax + bz) ◦ y = (ax + bz) ◦ S(y) = ax ◦ S(y) + bz ◦ S(y)

= aT (x) ◦ y + bT (z) ◦ y

= (aT (x) + bT (z)) ◦ y

e quindi

(T (ax + bz) − aT (x) − bT (z)) ◦ y = 0.

Poiché ciò vale per ogni y ∈ V ed il prodotto scalare è non singolare, deve

essere

T (ax + bz) = aT (x) + bT (z).

L’endomorfismo T è l’unico che soddisfa la (1). Infatti, se T ′ è un altro

endomorfismo che la soddisfa, per ogni y ∈ V si ha

(T ′ (x) − T (x)) ◦ y = 0

e poiché il prodotto scalare è non singolare, deve essere T ′ (x) = T (x) per

ogni x ∈ V , cioè T ′ = T.

35

5 ENDOMORFISMI SIMMETRICI

Definizione 5.3 L’endomorfismo T del teorema 5.2, si dice trasposto di S e

lo denoteremo S t .

Definizione 5.4 L’endomorfismo S di V si dice simmetrico se e solo se S =

S t , cioè

x ◦ S(y) = S(x) ◦ y per ogni x, y ∈ V.

Corollario 5.5 Sia S un endomorfismo di uno spazio vettoriale V su cui sia

definito un prodotto scalare ◦ non singolare e sia B una base ortonormale di

V. Allora, la matrice rispetto a B del trasposto S t di S è la trasposta della

matrice di S rispetto a B . In particolare S è simmetrico se e solo se la sua

matrice rispetto a B è simmetrica.

DIMOSTRAZIONE. Siano A, B le matrici rispetto a B di S, S t rispettivamente. Se X, Y sono le matrici colonna delle componenti di x, y rispetto a

B si ha (osservazione 2.12 e capitolo I osservazione 1.2)

x ◦ S(y) = X t (AY ) = X t AY

S t (x) ◦ y = (BX)t Y = X t B t Y.

Deve essere

X t AY = X t B t Y

per ogni X, Y

cioè

X t (A − B t )Y = 0 per ogni X, Y .

In particolare, se B = (v1 , . . . , vn ) e Xi = (0, . . . , 1, . . . , 0)t è la matrice

colonna delle componenti di vi rispetto a B , deve essere

Xit (A − B t )Xj = 0,

per ogni 1 ≤ i, j ≤ n,

da cui segue che A − B t = 0 e perciò At = B .

Teorema 5.6 Sia V uno spazio vettoriale reale di dimensione n > 0 su

cui sia definito un prodotto scalare positivo ◦ e sia T un endomorfismo

simmetrico di V. Allora:

1) Il polinomio caratteristico di T si decompone in fattori lineari in R[x];

2) T possiede autovettori.

DIMOSTRAZIONE. 1) Sia B una base ortonormale di V (che esiste, per il

teorema 3.9) e sia M la matrice di T rispetto a B . Il polinomio caratteristico

di T è ∆(x) = det(xI −M). Se S è l’endomorfismo dello spazio vettoriale Cn

36

5 ENDOMORFISMI SIMMETRICI

sul campo complesso C la cui matrice rispetto alla base canonica è M , ∆(x)

è anche il polinomio caratteristico di S e quindi le sue radici in C sono gli

autovalori di S . Si deve dimostrare che ogni radice di ∆(x) in C appartiene

a R.

Se B = (bij ) è una matrice ad elementi in C, sia B = (bij ) la matrice

i cui elementi sono i coniugati degli elementi di B . Essendo M simmetrica

(corollario 5.5) e reale, si ha

t

Mt = M = M = M .

(2)

Sia

h : Cn × Cn −→ C

l’applicazione definita nel modo seguente: se z, y ∈ Cn e Z = (z1 , ..., zn )t ,

Y = (y1 , ..., yn )t sono le matrici colonna delle componenti di z, y rispetto alla

base canonica, allora

n

X

h(z, y) =

zj y j = Z t Y .

j=1

Sono immediate le

(3)

h(az, y) = ah(z, y) per ogni a ∈ C;

(4)

h(z, ay) = ah(z, y) per ogni a ∈ C;

(5)

h(z, z) ∈ R;

(6)

h(z, z) > 0 se z 6= 0.

Se z è un autovettore dell’endomorfismo S associato all’autovalore λ, si ha

S(z) = λz e quindi

λh(z, z) = h(λz, z) = h(S(z), z) = (MZ)t Z = Z t M t Z = Z t M Z

= h(z, S(z)) = h(z, λz) = λh(z, z).

Allora

(λ − λ)h(z, z) = 0

e, per la (6), si ha λ = λ, ossia λ ∈ R.

2) Segue immediatamente dalla 1).

37

5 ENDOMORFISMI SIMMETRICI

Teorema 5.7 (Teorema spettrale) Sia V uno spazio vettoriale reale di

dimensione positiva n su cui sia definito un prodotto scalare positivo ◦. Se

T è un endomorfismo simmetrico di V, esiste in V una base ortonormale

costituita da autovettori di T .

DIMOSTRAZIONE. Per n = 1 il teorema è vero perché, se 0 6= v ∈ V , allora

u = v/kvk è un autovettore di T e costituisce una base ortonormale di V.

Procediamo per induzione su n. Sia n > 1 e supponiamo che il teorema sia

vero per spazi vettoriali di dimensione n−1. Per il teorema 5.6, T possiede un

autovettore v1 ; sia u1 = v1 /kv1 k e sia U = [u1 ]⊥ il complemento ortogonale

di u1 . La restrizione T ′ di T a U è un endomorfismo di U; infatti, se

T (u1 ) = λu1 , per ogni u ∈ U si ha

T (u) ◦ u1 = u ◦ T (u1 ) = u ◦ λu1 = λu ◦ u1 = 0

e perciò T (u) ∈ U. Ovviamente T ′ è un endomorfismo simmetrico rispetto al

prodotto scalare indotto. Poiché dimU = n − 1 (osservazione 3.3 e corollario

2.6), per ipotesi esiste una base ortonormale (u2 , ..., un ) di U costituita da

autovettori di T ′ . Ed allora (u1 , u2 , ..., un ) è una base ortonormale di U

costituita da autovettori di T .

Se K è un campo, una matrice M ∈ Kn è ortogonale se e solo se

M t M = MM t = I.

Per il corollario 1.11 del capitolo I, perché M sia ortogonale basta che risulti

MM t = I oppure M t M = I .

Lemma 5.8 Se su uno spazio vettoriale V su K è definito un prodotto scalare ◦ ed E , B sono basi ortonormali di V, la matrice di passaggio dall’una

all’altra è ortogonale.

DIMOSTRAZIONE. Sia E = (e1 , . . . , en ), B = (u1 , . . . , un ) e sia

ui = b1i e1 + b2i e2 + · · · + bni en ,

Allora

b11

.

B

M = ME (I) = ..

bn1

Sia M t M = (cij ). Si ha

1 ≤ i ≤ n.

. . . b1n

..

..

.

.

.

. . . bnn

cij = b1i b1j + b2i b2j + · · · + bni bnj = ui ◦ uj =

e quindi M t M = I .

0, se i 6= j,

1, se i = j,

38

5 ENDOMORFISMI SIMMETRICI

Corollario 5.9 Sia A una matrice reale simmetrica di ordine n. Allora:

1) il polinomio caratteristico ∆(x) di A si decompone in fattori lineari in

R[x];

2) se

λ1 . . .

.

′

∆(x) =

(x − λi ),

A = .. . . .

i=1

0 ...

esiste una matrice ortogonale M ∈ Rn tale che

n

Y

0

..

,

.

λn

A′ = M −1 AM = M t AM.

DIMOSTRAZIONE. Sia T l’endomorfismo di Rn avente A come matrice

rispetto alla base canonica E = (e1 , ..., en ). Poiché, rispetto al prodotto

scalare canonico ◦ di Rn , E è ortonormale, T è simmetrico rispetto a tale

prodotto scalare (corollario 5.5). Il polinomio caratteristico di A coincide con

quello di T e quindi la 1) segue dal teorema 5.6.

Per il teorema 5.7, esiste in Rn una base B = (u1 , ..., un ) ortonormale

rispetto al prodotto scalare canonico costituita da autovettori di T . Se

T (ui ) = λi ui ,

1 ≤ i ≤ n,

la matrice rispetto a B di T è A′ . Se M è la matrice di passaggio dalla base

E alla base B si ha (capitolo I, corollario 1.10) A′ = M −1 AM . Per il lemma

5.8 la matrice M è ortogonale, cioè M t = M −1 e quindi

A′ = M −1 AM = M t AM.

Corollario 5.10 Siano f, g due prodotti scalari su uno spazio vettoriale reale V. Se f è positivo, esiste in V una base ortonormale rispetto a f ed

ortogonale rispetto a g .

DIMOSTRAZIONE. Per il teorema 3.9 esiste in V una base E ortonormale

rispetto a f . Sia A la matrice di g rispetto a E e sia T l’endomorfismo di V

che rispetto a E è associato ad A. Poiché E è ortonormale rispetto a f ed A

è simmetrica, T è simmetrico rispetto a f (corollario 5.5) e quindi in V esiste

una base B = (u1 , ..., un ) ortonormale rispetto a f costituita da autovettori

di T (teorema 5.7). Se T (ui ) = λi ui , 1 ≤ i ≤ n, la matrice di T rispetto a

B è la matrice diagonale

λ1 . . . 0

.

.

(7)

A′ = .. . . . .. .

0 . . . λn

39

5 ENDOMORFISMI SIMMETRICI

Se M = MEB (I) è la matrice di passaggio dalla base E alla base B , si ha

(capitolo I corollario 1.10) A′ = M −1 AM . Per il lemma 5.8, M è ortogonale

e quindi

A′ = M −1 AM = M t AM.

Allora A′ è la matrice di g rispetto a B (teorema 1.5) e quindi B è ortogonale

rispetto a g .

Corollario 5.11 Sia g un prodotto scalare su uno spazio vettoriale reale V

di dimensione positiva n e sia A la sua matrice rispetto ad una base E di V.

Se il polinomio caratteristico di A è

n

Y

∆(x) =

(x − λi ),

i=1

λi ∈ R,

esiste in V una base ortogonale B rispetto alla quale la matrice di g è la

matrice diagonale (7).

DIMOSTRAZIONE. Sia f il prodotto scalare su V la cui matrice rispetto a

E sia la matrice identica I ; f è positivo e rispetto ad esso E è ortonormale.

Il corollario segue, allora, dalla dimostrazione del corollario 5.10.

Osservazione 5.12 Il prodotto scalare g del corollario 5.11 è positivo se e

solo se gli autovalori della sua matrice A sono tutti positivi.

CAPITOLO III

SPAZI AFFINI

GEOMETRIA LINEARE AFFINE

1. Spazi affini.

1. Sia A un insieme non vuoto e sia V uno spazio vettoriale su K .

Definizione 1.1 Si dice che su A è definita una struttura di spazio affine

con spazio vettoriale associato V se è assegnata un’applicazione

(1)

A × A −→ V

−−→

tale che ad ogni (P, Q) ∈ A × A associa un vettore di V, denotato P Q , in

modo che:

−−→

a1 ) P Q = 0 ⇐⇒ P = Q;

−−→

a2 ) Per ogni P ∈ A ed ogni v ∈ V , esiste Q ∈ A tale che P Q = v;

−−→ −−→ −−→

a3 ) Se P, Q, R ∈ A si ha P Q + QR = P R .

Un insieme A con una struttura di spazio affine e spazio vettoriale associato

V si dice anche spazio affine su V; i suoi elementi si dicono punti e per ogni

−−→

(P, Q) ∈ A × A, P si dice punto di applicazione del vettore P Q .

La dimensione di V si dice anche dimensione dello spazio affine A e la

denoteremo dim A. Per indicare che lo spazio affine A ha dimensione n

scriveremo anche An . Gli spazi affini A1 si dicono rette e gli spazi affini A2

piani.

Osservazione 1.2 1) Dalle a1 ), a3 ) segue che

(2)

−−→

−−→

QP = − P Q.

2) Per ogni P ∈ A ed ogni v ∈ V vi è un solo punto Q ∈ A tale che

−−→

P Q = v.

−−→

−−→

−−→ −−→ −−→

−−→

Infatti, sia P Q = v = P R ; da P Q + QR = P R segue che v + QR = v,

−−→

quindi QR =0 e perciò Q = R.

41

1 SPAZI AFFINI

−−−→ −−−→

3) Sussiste la legge del parallelogramma: se P1 Q1 = P2 Q2 risulta anche

−−−→ −−−→

P1 P2 = Q1 Q2 .

Infatti, si ha

−−−→ −−−→ −−−→ −−−→ −−−→

P1 Q1 + Q1 Q2 = P1 Q2 = P1 P2 + P2 Q2

−−−→ −−−→

e perciò P1 P2 = Q1 Q2 .

Esempio 1.3 L’applicazione V × V → V che alla coppia (u,v) ∈ V × V

associa

−→

(3)

uv = v − u

per ogni u, v ∈ V definisce su V una struttura di spazio affine con spazio

vettoriale associato V stesso.

Nel caso particolare che V=K n esso si dice spazio affine di dimensione n

su K e lo denoteremo AnK o An (K).

2. Sia A uno spazio affine su V.

Definizione 1.4 Si chiama sistema di riferimento di origine il punto O di

A il dato (O; e1, . . . , en ) del punto O di A e di una base (e1 , ..., en ) di V.

Nel caso dello spazio affine An (K), se O = (0, . . . , 0) ed (e1 , . . . , en ) è la

base canonica di K n , il sistema di riferimento (O; e1, . . . , en ) si dice canonico.

−−→

Se (O; e1 , ..., en ) è un sistema di riferimento di A e P ∈ A, il vettore OP

si dice vettore associato a P nel sistema di riferimento e le sue componenti

rispetto alla base (e1 , ..., en ) si dicono coordinate di P nel sistema di riferimento. Per indicare che x1 , ..., xn sono coordinate di P scriveremo anche

P (x1 , ..., xn ).

Se P (x1 , ..., xn ) e Q(y1 , ..., yn ) sono punti di A, le componenti del vettore

−−→

P Q rispetto alla base (e1 , ..., en ) sono (y1 − x1 , ..., yn − xn ).

Teorema 1.5 Siano (O; e1 , ..., en ) e (O ′ ; e′1 , ..., e′n ) due sistemi di riferimento dello spazio affine A. Se X, Y sono le matrici colonna delle coordinate di

un punto P nei due sistemi di riferimento, si ha la trasformazione (affine)

di coordinate

(4)

Y = AX + B,

dove A è la matrice di passaggio dalla base (e′1 , ..., e′n ) alla base (e1 , ..., en )

e B è la matrice colonna delle coordinate di O nel sistema di riferimento

(O ′; e′1 , ..., e′n ).

2 VARIETÀ LINEARI AFFINI

42

DIMOSTRAZIONE. Si ha

−−→ −−→ −−→

O ′ P = O ′ O + OP .

−−→

La matrice colonna delle componenti di OP rispetto alla base (e′1 , ..., e′n ) è

AX (capitolo I, osservazione 1.2), da cui la (4).

2. Varietà lineari affini.

1. Sia A uno spazio affine sullo spazio vettoriale V.

Definizione 2.1 Un sottoinsieme non vuoto S di A si dice varietà lineare

(affine) o sottospazio lineare di A se e solo se esiste un sottospazio vettoriale

M di V tale che:

−−→

s1 ) se P, Q ∈ S , allora P Q ∈ M;

−−→

s2 ) se P ∈ S e v ∈ M, il punto Q di A tale che P Q = v appartiene a S .

Il sottospazio M è univocamente determinato da S . Infatti, sia N un altro

sottospazio di V per cui siano soddisfatte le s1 ), s2 ). Se v ∈ M e P ∈ S ,

−−→

in virtù della s2 ) esiste Q ∈ S tale che v= P Q e, in virtù della s1 ), si ha

−−→

P Q = v ∈ N. Dunque M ⊂ N. Analogamente N ⊂ M e perciò M=N.

Definizione 2.2 Il sottospazio vettoriale M determinato dalla varietà lineare

S si dice associato a S o anche giacitura di S . La dimensione di M si dice

dimensione di S e la denoteremo dim S .

Le varietà lineari affini di dimensione 0 di A sono i punti, quelle di dimensione 1, 2 si dicono rispettivamente rette, piani e, se dim A = n > 3, quelle

di dimensione n − 1 si dicono iperpiani.

La giacitura M di una retta S di A si dice anche direzione di S ; ogni

0 6= v ∈ M si dice vettore di direzione di S .

In A si adopera il linguaggio geometrico usuale: se S è una sottovarietà di

T , cioè S ⊂ T , si dice che T passa per S ; punti appartenenti ad una stessa

retta si dicono allineati; punti e rette contenuti in uno stesso piano si dicono

complanari; rette passanti per uno stesso punto si dicono concorrenti; ecc.

Osservazione 2.3 Se S è sottovarietà di una varietà lineare T , allora risulta

dim S ≤ dim T e l’uguaglianza vale se e solo se S = T .

Infatti, se M, N sono le giaciture di S, T rispettivamente si ha M ⊂ N e

M=N se e solo se S = T .

2 VARIETÀ LINEARI AFFINI

43

Esempio 2.4 1) Se P0 ∈ A e M è un sottospazio di V, il sottoinsieme di A

−−→

(P0 ; M) = {P ∈ A : P0 P ∈ M}

è una varietà lineare che passa per P0 ed ha giacitura M.

Infatti, (P0 ; M) è non vuoto perché contiene P0 . Se P, Q ∈ (P0 ; M) si

−−→ −−→

−−→ −−→ −−→

ha P0 P , P0 Q ∈ M e quindi P Q = P P0 + P0 Q ∈ M, cioè è soddisfatta la

−−→

−−→

s1 ). Se v ∈ M, P ∈ (P0 ; M) e Q ∈ A è tale che P Q =v, si ha P0 Q =

−−→ −−→ −−→

P0 P + P Q = P0 P + v ∈ M; perciò Q ∈ (P0 ; M) e quindi è soddisfatta la

s2 ).

Se S è una varietà lineare di A di giacitura M, allora per ogni punto

P0 ∈ S si ha S = (P0 ; M).

−−→

Infatti, se P ∈ S risulta P0 P ∈ M e quindi P ∈ (P0 ; M); d’altra parte,

−−→

se P ∈ (P0 ; M) si ha P0 P ∈ M e quindi, per la s2 ), P ∈ S .

2) Sia V uno spazio vettoriale con la struttura di spazio affine definita

dalla (3). Se M è un sottospazio di V e u è un punto dello spazio affine V,

la varietà lineare passante per u e di giacitura M è l’insieme

u + M = {u + v : v ∈ M}.

In particolare, se u ∈ M si ha u+M=M e quindi le varietà lineari dello

spazio affine V sono i sottospazi vettoriali M di V ed i loro traslati u+M.

Lemma 2.5 L’intersezione di una famiglia di varietà lineari di A, se non è

vuota, è una varietà lineare.

DIMOSTRAZIONE. Sia {Si } una famiglia di varietà lineari di A tale che

∩i Si sia non vuota e sia Mi la giacitura di Si . Se P0 ∈ ∩Si si può scrivere

Si = (P0 ; Mi ) e risulta ∩i Si = (P0 ; ∩Mi ).

Lemma 2.6 Siano S1 = (P1 ; M1 ), S2 = (P2 ; M2 ) varietà lineari di A.

−−−→

Risulta S1 ∩ S2 6= Ø se e solo se P1 P2 ∈ M1 + M2 .

−−→

−−→

DIMOSTRAZIONE. Se Q ∈ S1 ∩S2 , per la s1 ) si ha P1 Q = m1 ∈ M1 , P2 Q =

−−−→

−−→ −−→

m2 ∈ M2 e quindi P1 P2 = P1 Q + QP2 = m1 − m2 ∈ M1 + M2 . D’altra

−−−→

parte, se P1 P2 = m1 + m2 , m1 ∈ M1 , m2 ∈ M2 , per la s2 ) esiste Q ∈ S2

−−→

−−−→

−−−→ −−→

−−→

tale che P2 Q = m1 − P1 P2 = −m2 e quindi P1 P2 + P2 Q = P1 Q = m1 .

Allora Q ∈ S1 e quindi S1 ∩ S2 6= Ø.

2 VARIETÀ LINEARI AFFINI

44

Definizione 2.7 Sia {Si } una famiglia di varietà lineari di A. La varietà

lineare intersezione delle varietà lineari che contengono tutte le Si si dice

varietà lineare congiungente le varietà Si . Essa è la minima varietà lineare di

A che contiene tutte le Si . La varietà lineare congiungente le varietà lineari

della famiglia Si la denoteremo ∨i Si o anche S1 ∨ S2 ∨ ... ∨ Sm se la famiglia

è finita e costituita da m elementi.

Lemma 2.8 La varietà lineare congiungente S1 = (P1 ; M1 ) e S2 = (P2 ; M2 )

è

−−−→

S1 ∨ S2 = (P1 ; [ P1 P2 ] + M1 + M2 ).

DIMOSTRAZIONE. Poiché S1 ∨ S2 contiene S1 e S2 , la sua giacitura M

−−−→

−−−→

contiene P1 P2 , M1 , M2 e quindi S1 ∨ S2 ⊃ (P1 ; [ P1 P2 ] + M1 + M2 ). D’altra

−−−→

parte, la varietà lineare (P1 ; [ P1 P2 ] + M1 + M2 ) contiene S1 e S2 , quindi

−−−→

contiene S1 ∨ S2 e perciò S1 ∨ S2 = (P1 ; [ P1 P2 ] + M1 + M2 ).

Corollario 2.9 La varietà lineare congiungente i punti P1 , P2 , ..., Pr è

−−−→ −−−→

−−−→

P1 ∨ P2 ∨ ... ∨ Pr = (P1 ; [ P1 P2 , P1 P3 , ..., P1 Pr ]).

DIMOSTRAZIONE. Ciò è vero per r ≤ 2, come segue dal lemma 2.8. Sia

r > 2 e procediamo per induzione su r , supponendo che l’asserto sia vero per

r − 1 punti. Tenendo conto del lemma 2.8, risulta

P1 ∨ ... ∨ Pr = (P1 ∨ ... ∨ Pr−1 ) ∨ Pr

−−→

−−−−→

= (P1 ; [P1 P2 , ..., P1 Pr−1 ]) ∨ (Pr ; [0])

−−→

−−→

= (P1 ; [P1 P2 , ..., P1 Pr ]).

Definizione 2.10 Se P1 , . . . , Pr sono punti di A, la varietà lineare P1 ∨...∨Pr

si dice varietà lineare individuata dai punti P1 , ..., Pr ; e si dice che P1 , ..., Pr

sono linearmente indipendenti se e solo se dim(P1 ∨ ... ∨ Pr ) = r − 1.

Lemma 2.11 Se S1 = (P1 ; M1 ) e S2 = (P2 ; M2 ) sono varietà lineari di A,

si ha:

dim S1 + dim S2 − dim S1 ∩ S2 , se S1 ∩ S2 6= Ø,

dim S1 ∨ S2 =

dim(M1 + M2 ) + 1,

se S1 ∩ S2 = Ø.

DIMOSTRAZIONE. Per il lemma 2.8 si ha

−−−→

S1 ∨ S2 = (P1 ; [ P1 P2 ] + M1 + M2 ).

45

2 VARIETÀ LINEARI AFFINI

−−−→

Se S1 ∩ S2 6= Ø, per il lemma 2.6 si ha P1 P2 ∈ M1 + M2 e quindi

dim S1 ∨ S2 = dim(M1 + M2 )

= dim M1 + dim M2 − dim(M1 ∩ M2 )

= dim S1 + dim S2 − dim S1 ∩ S2 .

−−−→

Se S1 ∩ S2 = Ø, per il lemma 2.6 risulta P1 P2 6∈ M1 + M2 e quindi

dim S1 ∨ S2 = dim(M1 + M2 ) + 1.

2. Sia (O; e1, . . . , en ) un sistema di riferimento di A.

Sia S una varietà lineare di dimensione r di A di giacitura M. Se P0 è

un suo punto si ha S = (P0 ; M) ed esistono r punti P1 , ..., Pr ∈ S tali che

−−−→

−−−→

P0 P1 , ..., P0 Pr costituiscono una base di M. Quindi

n

o

−−→

−−−→

−−−→

S = (P0 ; M) = P ∈ A : P0 P = λ1 P0 P1 + · · · + λr P0 Pr , λi ∈ K .

Se

−−→

OP = x,

−−→

OPi = ai

per la a3 ) si ha

(0 ≤ i ≤ r),

−−→

−−→ −→

P0 P = P0 O + OP = x − a0 ,

−−→

−−→ −−→

P0 Pi = P0 O + OPi = ai − a0 ,

1 ≤ i ≤ r,

e quindi S è l’insieme dei punti P ∈ A tali che

(1)

x = a0 +

r

X

i=1

od anche, ponendo µ0 = 1 −

(2)

x=

r

X