ANALISI STATISTICA DEI DATI

STATISTICA E PROBABILITA'

Misura di una grandezza fisica

Errori

dovuti a:

Strumenti di misura

Parametri non controllabili da sperimentatore

= da valore vero grandezza

varia da misura a misura

La misura è fenomeno casuale e la singola misura sarà evento

casuale.

Evento casuale (o aleatorio): evento ripetibile (infinite volte) che

si manifesta in modo non prevedibile singolarmente

(es. lancio dado/moneta, estrazione carta ...)

AS-1

S: insieme di tutti i modi possibili del

fenomeno casuale

E: generica modalità dell'evento casuale

(generico evento casuale)

S

E

x(E) (numero reale)

in modo univoco

x(E):

variabile casuale definita nell'insieme S.

discrete o continue

Variabili casuali

numero finito o infinito di valori

La misura di una grandezza fisica può essere considerata come

un evento casuale e il numero (che si ottiene) la variabile

casuale associata all'evento.

PROBLEMA DELLA MISURA

insieme di misure della

stessa grandezza fisica

?

valore

vero

Analisi statistica delle misure

che utilizza teoria della probabilità

Definire intervallo di valori della variabile casuale "misura" con

assegnata probabilità di contenere valorevero della grandezza

AS-2

La STATISTICA è un ramo della matematica che studia i

fenomeni casuali utilizzando la TEORIA della PROBABILITA`

PROBABILITA`

1) Definizione "classica"

Probabilità P(E) di un evento casuale E: rapporto fra numero

dei casi "favorevoli" (casi in cui si presenta E) e numero totale

casi possibili, purché tutti i casi possibili sianoequiprobabili

COROLLARIO:

0=P=1

numero reale

PROBLEMA:

Es. 1.

Tautologia (per definire probabilità è

necessario valutare equiprobabilità)

Lotto

P(n) =

Es. 2.

1

90

P(pari) =

45

1

=

90

2

3 figli non dello stesso sesso

MMM MMF MFM FMM MFF FMF FFM FFF

Tot casi possibili = 8

3

P(non stesso sesso)= 6 =

8

4

AS-3

2) Definizione "empirica"

(Frequenzistica)

Frequenza relativa di E : f (E)

f (E) =

n

N

N: numero totale prove

n: numero volte in cui si è presentato E su N prove

Si definisce:

P(E) = lim f (E) = lim

N→8

N→8

n

N

postula che lim f (E) sia numero definito

PROBLEMA:

non è def. operativa

f (E)

1

.5

0

0

1

1

2

2

3

3

4

5

3

5

N

3

6

3

7

4

8

4

9

E: testa su lancio moneta

5 6

10 11

AS-4

2) Definizione "assiomatica"

s

A

S: Insieme di tutti i possibili E

A: Sottoinsieme di S

A tale che:

P(A) E' un numero associato univocamente ad

Unione

P(A) = 0 per ogni A

Intersezione

Contenuto

P(S) = 1

P(A+B) = P(A) + P(B)

se A B = 0

A B

PROBLEMA:

Non ci dice quanto vale P

L'asseganzione di P ad A è un modello matematico

A partire da definizione assiomatica di P si può dimostrare che:

f(E)

P(E)

per N

8

LEGGE DEI GRANDI NUMERI

AS-5

LEGGE DEI GRANDI NUMERI

Dato evento casuale E a cui è associata P(E),

n

se f(E) =

(su N prove), scelti due numeri positivi a piacere

N

ε', ε" è possibile definire un N tale che, per ogni M > N:

P (|f(E) - (E)|>ε’)<ε”

(In analisi: |f(E) - P(E)|<ε)

Si dimostra a partire dalla diseguaglianza

v

v

di BIENAYME' - CEBICEV

AS-6

PROPRIETA` DELLA PROBABILITA`

1) Evento complementare di E : E

N-n = 1 N

f (E) =

n

N

= 1 - f(E)

P(E) = 1 - P(E)

P(E) + P(E) = 1

Se E1... E m : insieme di tutti gli eventi possibili in S, mutuamente

esclusivi:

m

Σ1 i

P(Ei) = 1

Evento complesso = prodotto logico di due eventi casuali

E, F (es.: moneta/carta)

F

F

E

n11 n12

E

n21

Su N prove

n22

4 possibili casi:

EF

EF

EF

EF

AS-7

f (EF) =

n 11 ;

N

f(EF) = n 21 ; f(EF) = n 12 ; f(EF) = n 22 ;

N

N

N

f (E) = n11 + n12 = f (EF) + f (EF)

N

f (F) = n11 + n21 = f (EF) + f (EF)

N

P(E) = P(EF) + P(EF)

P(F) = P(EF) + P(EF)

PROBABILITA` CONDIZIONATA:

Probabilità che si verifichi E se si è verificato F (o viceversa)

P(E|F)

f (E|F) =

n11 =

n11 + n 21

n11 =

f (F|E) =

n11 + n 12

P(F|E)

n11

N

f (EF)

N

.

= f (F)

n11 + n 21

f (EF)

f (E)

P(E|F) =

P(EF)

P(F)

P(EF) = P(F) .P(E|F)

P(F|E) =

P(EF)

P(E)

P(EF) = P(E) .P(F|E)

AS-8

2) LEGGE DELLE PROBABILITA` COMPOSTE

Se E ed F sono statisticamente indipendenti

P(E|F) = P(E)

P(F|E) = P(F)

P(EF) = P(E). P(F)

m

P(E1 . E 2 ... . E m ) =

Π

1 i

P(E i )

La probabilità che avvengano contemporaneamente E ed F

(prodotto logico) è uguale al prodotto delle probabilità

dell'evento E e dell'evento F

se E ed F sono statisticamente indipendenti

Es. 2 dadi - Probabilità che escano due 4

P(4,4) = P(4) . P(4) = 1 . 1 = 1

6 6

36

Se E ed F sono mutuamente esclusivi:

P(E|F) = P(F|E) = 0

P(EF) = 0

AS-9

3) LEGGE DELLE PROBABILITA` TOTALI

f (E + F) : evento

f (E + F) =

E

n 11 + n12 + n 21

N

o evento

F

o ambedue

(n11+ n 12 )+(n 21 + n 11)-n11

=

N

f (E + F) = f (E) + f (F) - f (EF)

P(E + F) = P(E) + P(F) - P(EF)

Se E ed F sono mutuamente esclusivi

P(EF) = 0

P(E + F) = P(E) + P(F)

m

P(E1 ... E m ) =

Σ1 i P(E i )

Dimostrabile anche usando la definizione assiomatica di

probabilità:

C

A = (A - C) + C

A

B

B = (B - C) + C

(A - C),(B - C), C: disgiunti

AS-10

Da III assioma: (P(A + B) = P (A) + (P(B)) se A,B disgiunti;

P(A) = P(A - C) + P(C)

P(A - C) = P(A) - P(C)

P(B) = P(B - C) + P(C)

P(B - C) = P(B) - P(C)

Se ora consideriamo insieme somma A+B :

A + B = (A - C) + (B - C) + C

P(A + B) = P(A - C) + P(B - C) + P(C)

P(A + B) = P(A) - P(C) + P(B) - P(C) + P(C)

P(A + B) = P(A) + P(B) - P(C)

P(A . B)

P(A + B) = P(A) + P(B) - P(A .B)

Se considero 3 eventi casuali :

P(A1 + A2 + A 3) = P(A 1) + P(A 2) + P(A 3) - P(A 1A 2) - P(A 1A 3)

- P(A2.A3 ) + ( P(A1. A 2 . A 3)

A1

A2

1-2

1-3 1-2-3

2-3

A3

AS-11

STATISTICAMENTE INDIPENDENTI

P(E|F) = P(E)

P(F|E) = P(F)

P(EF) = P(E) . P(F)

STATISTICAMENTE DIPENDENTI

MAZZO CON 42 CARTE (solo KQJ fiori)

E estrazione FIORI

F estrazione RE

P(E) = 3

42

P(F) = 4

42

P(E|F) = 1

4

P(F|E) = 1

3

P(E . F) =

3 . 1

42

3

=

P(E) P(F|E)

1

42

# P(E) . P(F)

1 . 4 = 1

126

12

42

3

AS-12

SO M M AR IO

s tatis ticam ente

indipendenti

P(A . B)

P(A) . P(B)

s tatis ticam ente

dipendenti

P(A) . P(B|A)

s tatis ticam ente

e s clu s ivi

=0

P(B) . P(A|B)

P(A+ B) P(A) + P(B) - P(A . B) P(A) + P(B) -P(A.B) P(A) + P(B) -P(A.B)

AS-13

Es.: efficienza di scanning nella ricerca di eventi rari

N : N. di eventi rari presenti nel campione (incognito)

N12 + N1 : N. di eventi trovati nella 1 a ricerca

N + N : N. di eventi trovati nella 2 a ricerca

12

2

N12 : N. di eventi trovati in ambedue

P(1) =

P(2) =

P(1, 2) =

N12 + N1

N

(1) e (2) statisticamente indipendenti

N12 + N2

N

N12

P(1) =

N

= P(1) . P(2)

N12

N12 + N2

N=

P(2) =

(N12 + N1 ). (N12 + N2 )

N12

N12

(N12 + N1 )

Probabilità di trovare un evento nelle due ricerche:

P(1 +2) = P(1) + P(2) - P(1) . P(2) =

(N12 + N1 ) (N12 + N2 ) N12

=

+

N

N

N

N12

. (N1 + N2 + N12 )

=

.

(N12 + N1 ) (N12 + N2 )

AS-14

DISTRIBUZIONE DI PROBABILITA`

E

DENSITA` DI PROBABILITA`

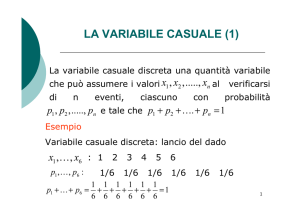

1) Variabile casuale discreta

xi

xi

Pi (xi ) = lim

N "

i = 1, ...

n (xi )

N

Σi Pi (xi ) = 1

S

L'insieme di Pi costituisce la

distribuzione di probabilità della variabile casuale

2) Variabile casuale continuax

∆x

2

∆x

2

x

f (x - ∆x , x + ∆x ) : frequenza in x ± ∆x

2

2

2

n(x ± ∆x 2)

N

Frequenza limite per unità di ∆x:

f (x - ∆x , x + ∆x )

2

2

lim

= f(x)

∆x 0

∆x

N

"

f(x) : DENSITA` DI PROBABILITA` o

FUNZIONE DI DISTRIBUZIONE

AS-15

dP(x, x + dx)

=

dx

dP =

f(x)

f(x) dx

P(a, b) =

∫

a

∫

s

b

probabilità che la

variabile casuale

cada in (a,b)

=

f(x) dx =

+"

∫-"

∫

a

=

b

f(x) dx

f(x) dx = 1

11

12

21

Es.

P(x)

1

P(x)

un dado

6

2 dadi (somma)

13

22

31

.

.

.

36

6

1

1 2 3 4 5 6

36

2

x

7

12

2

3

4

x

Es.

f(x)

f(x)

1

b-a

a

b

x

µ

x

Densità uniforme di probabilità

f(x) = C

∫

a

b

C . dx = C . (b - a) = 1

1

C= b-a

AS-16

CUMULATIVA DI UNA FUNZIONE DI DISTRIBUZIONE

Funzione cumulativa:

F(x) =

x

∫-"

f(x') dx'

PROPRIETA':

F(x) = P (-" < x' < x)

b

P(a < x < b) =

∫ f(x) dx = -"∫

a

b

a

f(x) dx -

∫-" f(x) dx = F(b) - F(a)

f(x)dx = F(x + dx) - F(x) = dF(x)

dF(x)

dx

F(x) è monotona crescente

dato che f(x) " 0 sempre

= f(x)

Se x è definito fra a e b:

F(a) = 0

F(b) = 1

(F(-" ) = 0; F(+" ) = 1)

Es.

f(x)

1

b-a

a

b

x

F(x)

1

1

F(x) =

b-a

0

a

b

x

∫a

x

dx' =

x-a

b-a

AS-17

PARAMETRI CARATTERISTICI

DISTRIBUZIONI DI PROBABILITA`

1) La "posizione" della distribuzione

I

La moda: x per cui la distribuzione ha il massimo

(unimodali, multimodali )

II

La mediana: xM che divide a metà la distribuzione

xM

∫-"

III

+"

f(x) dx =

∫xM f(x) dx =

1

2

La media (o valore aspettato) : (= µ)

+"

E[x] = µ =

∫-" x . f(x) dx

continuo

n

E[x] = µ =

Σ i x i .P i (x i )

discreto

1

In generale si definisce il valore aspettato di una funzione di x, g(x)

(se x variabile casuale g(x) è anche variabile casuale):

+"

E[g(x)] =

∫-"

g(x) . f(x) dx

AS-18

f(x)

0.15

0.1

0.05

5

10

20 x

15

Media (valore aspettato)

Mediana

Moda

f(x)

xo

x

Moda

Mediana

Media (valore aspettato)

AS-19

Proprietà del valore aspettato:

E[Σk ak. gk (x)] = Σk ak .E[gk (x)]

Casi notevoli:

∫ a. f(x) dx = a . ∫ f(x) dx = a

E[a] = a

E[a . g(x)] = a . E[g(x)]

=1

Notare:

E[(x - µ)] = E[x] - µ = 0

2)

La "larghezza" della distribuzione = varianza

= valore aspettato di (x - µ)2

Varianza = σ2

E[(x - µ)2]

σ2 =

+"

∫-"

(x - µ)2 .f(x) dx continuo

n

σ2 = Σi (xi - µ)2 .Pi (xi)

1

discreto

E[(x - µ)2] = E[(x2 + µ2 - 2µx)] =

=µ

E[x2] + µ2 - 2µE[x] = E[x2] - µ2

= E[x2] - (E[x])2

σ = σ2 = deviazione standard

AS-19A

3) La "asimmetria" della distribuzione

(valore aspettato di (x - µ)3)

+"

SKEWNESS

SK =

∫-"

(x- µ)3 f(x) dx

σ3

= 0 per distribuzioni

> 0: coda a destra

< 0: coda a sinistra

rispetto a µ

f(x) simmetriche

E [(x - µ)4 ]

-3

4

σ

> 0 più piccata

= 0 per gaussiana

< 0 meno piccata

In generale la funzione di distribuzione è completamente definita

dall'insieme dei suoi momenti:

+"

Momento k-esimo di f(x) rispetto a xo =

(x - xo)k . f(x) dx

∫

-"

= µk(xo) = E[(x - xo)k]

CURTOSIS

µo(0) = 1

µo(µ) = 1

Σ i (xi - xo)k

Pi(xi)

Si può dimostrare che:

k

µk(xo) =

k . x r . µ (0)

r

.

(-1)

o k -r

Σo r

r

coefficiente binomiale

Funzione simmetrica

momenti dispari rispetto µ = 0

rispetto a µ

VALORE ASPETTATO : µ1(0)= µ = momento primo rispetto a xo = 0

VARIANZA :

µ (µ) = σ2 = momento secondo rispetto a xo = µ

2

SKEWNESS :

µ3(µ/σ3) = momento terzo rispetto a µ σ3

CURTOSIS :

momento quarto rispetto a µ

σ4

AS-20

VALORE ASPETTATO

di f(x) simmetrica rispetto a xo

µ = xo

xo

Infatti:

µ=

x

+8

∫-8

x f(x) dx =

+8

∫-8

(x' + xo ) f(x' + x o) dx' =

x' = x - xo

+8

=

∫-8

x = x' + xo

x'. f(x' + xo) dx' + xo

+8

∫-8

f(x' + xo) dx' = xo

= 0 (f dispari . f pari)

VARIANZA

=1

di una distribuzione uniforme

0

∆

a

µ=

σ

2=

=

∫a

b

∫a

µ

x f(x) dx =

b

f(x) =

b

b

∫a

2

-

(b + a)2

4

σ =

=

1

b-a

∫a

-8

a

b

+8

c= 1

x

(x - µ) f(x) dx =

b3 - a3

3(b-a)

dx = dx'

b-a

x dx =

1

b2 - a2

b-a

2

=

a,b

b+a

2

b

x2 f(x) dx - µ2 =

(b - a) 2

12

(b - a)

12

=

(b - a)

2

1

3

=

D

3

AS-21

FUNZIONE GENERATRICE DEI MOMENTI

Funzione della variabile casuale x :

Gx (t) = E [ext]

Sviluppano in serie ext :

Gx (t) = E [1 + xt +

x2 t2

2

+...

xk tk

k!

+ . . .] =

2

k

= 1 + µ 1 (0)t + µ2 (0) t2 . . . µk (0) t

k!

+...

I coefficienti dello sviluppo della Gx (t) in serie di potenze di t

sono i momenti intorno all'origine.

dk Gx(t)

dtk

dk ext

=E

= E xk . ext

k

dt

dk Gx(0)

= E xk = µ k (0)

k

dt

AS-22

PROPRIETA` NOTEVOLI :

.

I Gcx (t) = E [e c.x. t] = E [e x ct]

= Gx (ct)

.

II Gc+x (t) = E [e (c+x) t] = ect E [ext] = ect .Gx (t)

III Gx (0) = 1

La II ci permette di calcolare i momenti centrali:

Es. σ 2 : momento secondo di (x - µ)

Gx-µ (t) = e-µt Gx (t)

d

dt

Gx-µ (t) = -µ .e-µt .Gx(t) + e-µt .

d

dt

d2

dt2

. x(t) -µ e.-µt

Gx-µ (t) = µ 2e-µt G

. d Gx (t) +

dt

Gx (t)

d

d2

µt

µt

.

.

-µ e

Gx (t) + e . 2 Gx (t)

dt

dt

d

dt

Gx-µ (0) = -µ Gx (0)

+

Gx (0) = 0

=µ

=1

d2

dt2

d

dt

d

dt

Gx (0) = µ

d2

d

2

Gx (0)

G

(0)

+

Gx-µ (0) = µ - µ - µ .

x

2

dt

dt

2

=µ

σ2

σ2=

d2

dt2

Gx (0) - µ 2

AS-23

FUNZIONE DI DISTRIBUZIONE PER FUNZIONE

DELLA VARIABILE CASUALE

x

y = y(x)

f(x)

f(y) ?

corr. biunivoca

dP(x, x + dx) = dP(y, y + dy)

y(x)

f(x) dx = f(y) dy

f(y) =

dx (y)

dy

. f(x(y))

dato che f deve

essere sempre • 0

AS-24

NOTARE :

g(x) . f(x) . dx

E[g(x)] =

g(x) = y

E[y] =

y . f(x) . dx = y . f(y) . dy

Infatti:

f(y) =

dx

dy

. f(x)

E[y] = y f(y) dy =

= y.

dx

f(x) . dy =

dy

= y(x) f(x) . dx

AS-25

Es.

SORGENTE DI PARTICELLE ISOTROPA

r

z

θ

φ

x

y

Isotropa: flusso di particelle emesso (per unità di tempo )

proporzionale ad angolo solido e costante

dS

. dϕ

dSsfera= r2 sinθdθdϕ

dΩ = sfera

=

d(cos

)

θ

r2

Quindi la funzione di distribuzione di cosθ sarà costante

fra -1, +1; f(cosθ) = 1

2

Funzione di distribuzione di θ ?

-1 < x < 1

θ = arcos (cos θ)

p>y>0

y

x

1 sin

dx

1 dcos θ

f(y) = f(x) .

=

θ

=

dy

2

2

dθ

p

0

Es.

1 sin θ d θ = - 1 cos θ

2

2

p

=1

0

F(x) è variabile casuale funzione di x

CUMULATIVA

x

dy

= f(x)

dx

-8

f(x)

dx

Funzione di distribuzione di y : f(y) = f(x)

=1

=

f(x)

dy

uniforme fra 0 e 1

1

AS-26

f(x)

y = F(x) =

f(x') dx'

Dato che F(x) è distribuita uniforme (0, 1) posso ottenere

variabili casuali con funzione di distribuzione qualsiasi a

partire da variabile casuale con distribuzione uniforme fra

0 e 1 (utile nei calcolatori).

Es.

DISTRIBUZIONE ESPONENZIALE

x

1

x

f(x) =

e o

xo

x

x

y = F(x) =

0

x

1 e - xx' dx' = 1 - e- x

o

o

xo

∞

f(x) dx = 1

0

Se y è la cumulativa di f(x), generato y uniforme, x = g(y) sarà

distribuito secondo f(x)

x

y = 1 - e - xo

lge (1 - y) = -

x

xo

x = - xo lge (1 - y)

Per generare gaussiana(µ = 0, σ = 1) :

x = sin (2py1) . - 2 lgey2

y1, y2 : 2 numeri casuali con distribuzione uniforme

AS-27

VALORE ASPETTATO E VARIANZA DI y

y = g(x)

Siano µx e σ 2x valore aspettato e varianza di x.

Sviluppo y(x) in serie di Taylor intorno a µx:

y(x) = y(µx) +

dy .

dx µ (x - µx) +

x

d2y

(x - µx)2 + . . .

2

dx µx

1

2

A

µy = E[y] = y(µx) +

dy .

dx µE [(x - µx)] +

x

=0

1

2

d2y .

E (x - µx)2 + . . .

dx2 µx

Trascurando i termini di ordine più alto:

µy = E [y] ~ y(µx)

E y - y(µx)

2

=

dy 2 .

dalla ~

dy 2

2

E (x - µx)2

E dx (x - µx) = dx

A

µx

µx

σ 2x

µ(y)

σ 2y = E

y - y(µx)

2

=

dy 2 . σ 2

x

dx µ

x

approssimata

AS-28

Se y è funzione lineare di x :

y = g (x)

y = ax + b

µy = aµx + b

σy2 = a2 σ2x

ESATTA

AS-29

DISTRIBUZIONE BINOMIALE

Processo casuale generico

una certa modalità E di presentarsi nel

"successo" :

processo casuale con probabilità p

(evento complementare E, probabilità (1 - p))

Se facciamo n prove, quale è la probabilità che il successo si

presenti k volte?

Pn,p (k)

Da teorema delle probabilità composte (le prove sono

statisticamente indipendenti) :

k successi, n-k insuccessi

pk ( 1 - p )n-k

k volte (SI), (n-k) volte (NO)

p (1 - p)n-k pk-1

SI, (n-k) volte NO, (k-1) SI

.

.

.

Sommare su tutte le possibili combinazioni:

n!

n =

n. di combinazioni n oggetti k a k = k

k! (n - k)!

AS-30

P

PERMUTAZIONI

Dati n oggetti distinti, in quanti modi se ne possono selezionare r?

nPr = n . (n - 1) . . . (n - r + 1)

nPn = n . (n - 1) . . . (n - n + 1) = n!

RICORDARE:

nPr =

COMBINAZIONI

n!

(n - r)!

0! = 1

C

Se non siamo interessati all'ordine in cui compaiono gli r oggetti:

n.(n - 1)...(n - r + 1)

n!

n

nCr = (n - r)! r! = r =

r!

nCr . r! = nPr

nCr =

n!

(n - r)! r!

AS-31

Pn , p (k) = n . pk . (1 - p)n-k

k

k=0→n

DISTRIBUZIONE

BINOMIALE

Distribuzione di probabilità nella variabile casuale k

(n. finito di valori: 0 . . . n)

n

n

n

n

k

n-k

. .

Pn , p (k) =

k p (1 - p) = p + (1 - p) = 1

k

k

0

0

Σ

Σ

Ricordare che:

n

(a+b)n =

Σ0 k

n k n-k

a b

k

Es.

Probabilità di un 2 su 10 lanci di un dado:

1

p=

6

probabilità

evento

favorevole

10! . 1

P10, 1 (1) =

1! (10 - 1)! 6

6

n = 10

1

. 1- 1

6

numero

prove

9

= 0.32

Probabilità di nessun 2 :

1 0. 5

10!

.

P10, 1 (0) =

0! 10! 6

6

6

10

= 0.16

Probabilità di tutti 2:

1

P10, 1 (6) = 10! .

10! 0! 6

6

10

5

6

0

= 1.7 .10-8

AS-32

Probabilità di avere almeno un 2:

10

Σ1

(k) = 1 - P10,1/6 (0) = 1 - 0.16 = 0.84

P

k 10,1/6

Proprietà notevoli della binomiale:

1 Valore aspettato e varianza

n

µ = E[k] =

Σ

n!

. pk . (1 - p)n-k =

k

k! (n - k)!

0

1 dato che k = 0 annulla primo termine

k.

n

= n.p

k' = k - 1

n' = n - 1

Σ

(n -1)!

pk-1 .(1 - p)n-k

k (k -1)! (n - k)!

1

n'

= n.p

Σ

n'!

pk'. (1 - p)n'-k'

k' k'! (n' - k')!

0

=1

µ=n.p

σ2 = E (k - np)2 = E[k2] - (np)2

AS-33

n

E[k2] =

Σ

0

k

n!

pk (1 - p)n-k

k! (n - k)!

k2

n

=np

Σ

1

k' = k - 1

n' = n - 1

k

k

=

(n -1)!

pk-1(1 - p)n-k =

(k -1)! (n - k)!

Σ (k' + 1) P

n'

=np

n',p

(k') =

0

su n-1 prove

= np .E[(k' + 1)] = np . (E[k'] + 1) =

(n - 1) . p

= np . {(n - 1) . p + 1} = n (n - 1) . p2 + n . p

σ2 = n (n - 1) . p2 + n . p -(n . p)2 = np(1 - p)

σ2 = np . (1 - p)

σ = np (1 - p)

Distribuzione binomiale:

pn,p (k) =

µ = np

n k n-k

p q

k

q = (1 - p)

σ = npq

AS-34

µ e σ2 della distribuzione binomiale

usando funzione generatrice dei momenti

µ = µ1 (0)

PN,p (k) = N .pk qN-k

k

σ2 = µ2 (µ)

N

Gk (t) = E [etk] =

N

=

Σ

0

k

Σ

0

k

etk N pk qN-k =

k

N . ( p)k . qN-k =

k

sviluppo di

un binomio

= (et . p + q)N

d G (t) = N .(et . p + q)N-1 . p .et

k

dt

d2 G (t) = N. (et . p + q)N-1 . p .et +

k

dt 2

+ N . (N - 1) . (et . p + q)N-2 p2 . e2t

d G (0)

µ1 (0) = dt

k

2

µ2 (µ) = σ2 = d 2 Ge (0) - µ2

dt

AS-35

d

µ = dt

Gk (0) = N .(p + q)N-1. p = N . p

=1

d2 G (0) = N .(p + q)N-1 . p +

k

dt2

=1

+ N (N - 1) . (p + q)N-2 . p2 =

=1

= N . p + N . (N - 1) . p2

2

σ2 = d 2 Gk (0) - µ2 = Np + N2p2 - Np2 +

dt

-(Np)2 = Np .(1 - p) =

= N . p .q

AS-36

1

Massimo della distribuzione

Massimo in corrispondenza a k ~ np

se np >> 1

N!

PN,p(k + 1)

PN,p(k)

(k + 1)! (N -k -1)! .

=

N!

k! (N - k)!

pk+1 qN-k-1

=

k

N-k

.

p q

p

= N-k . q

k+1

Distribuzione crescente per :

N-k . p

q

k+1

=1

k = Np - q

AS-37

2

Massimo della distribuzione

Massimo in corrispondenza a k ~ np

3

se np >> 1

se p = 0.5

pn,1/2 (k) =

1

2

k

n!

(n - k)! k!

1

2

n!

k! (n - k)!

pn,1/2 (n - k) =

. 1- 1

2

n-k

n-k

. 1- 1

2

k

p(k) = p (n - k)

Se p = 0.5 distribuzione simmetrica intorno a np (intero)

4

n 8 , p = costante

Tende alla distribuzione "normale" (gaussiana) con:

µ = np

5

σ=

np . (1 - p)

n 8 , np = costante

Tende alla distribuzione di Poisson

AS-38

n=5

p=0.2

n=2

p=0.2

0.5

0

0 1 2

n=10

p=0.2

0 1 2 3 4

n=20

p=0.2

0 1 2 3 4 5 6 7 8 9

0 1 2 3 4 5

P1 (k)

Poisson (m = 1)

Binomiale

n=2

p=0.5

np=1.0

0.1

n=5

p=0.2

np=1.0

n=10

p=0.1

np=1.0

n=20

p=0.05

np=1.0

0.2

0

0

1

2

3

4

0

1

2

3

4

0

1

2

3

4

0

1

2

3

4

AS-39

Es.

Frequenza su n prove

(Evento favorevole con probabilità p)

1

µ = E[ν] = n

k

ν= n

k -p

n

σν2 = E[(ν - µ ν)2] = E

=E

k

n

2

np

=p

n

E[k] =

2

=

vedi

AS-34

- p2 = 12 n(n - 1) p2 + np - p2

n

p . (1 - p)

= 12 . np . (1 - p) =

n

n

σν

0

per n

•

ν

p

per n

•

Vedi anche

Teorema di Bernoulli

Es. Fluttuazioni di densità in un gas

ideale

A

B

V

Date N molecole in V, sia p la probabilità per generica

molecola di essere in A e (1 - p) la probabilità di essere in B.

(Nessuna interazione fra molecole, a parte urti → posizione

molecola indipendente da posizione altre molecole).

AS-40

Probabilità ad un certo istante di avere nA molecole in A?

Ogni molecola è una prova indipendente

e "evento favorevole" = essere in A.

N . pnA . (1 - p )N-n

A

A

nA

A

PN,p (nA) =

A

1 (dato che i volumi sono uguali)

2

se p = (1 - pA) =

A

N!

.

nA! (N -nA)!

PN, 1 (nA) =

2

µ (nA) = N

2

1

2

N

1

σ(nA) = 2 . N

Applicando la formula di Stirling alla variabile x:

x=

nA

N

2

N

2

scarto relativo di

nA dal suo

valore aspettato

2

2 . e-(N-1) . x2

P(x) =

p .N

N . x2

Dato che nell'esponente compare con N molto grande,

2

appena x si scosta da 0, P → 0 (x = 10-8, P ~ 0).

UN GAS HA SEMPRE DENSITA` UNIFORME

AS-41

DISTRIBUZIONI SPERIMENTALI

Variabile casuale discreta

Es. Somma di due dadi

x

2

3

4

. . . 12

P(x)

P2

P3

P4 . . . P12

N Esperimenti ripetuti (lancio dadi)

Risultato: n2

n3

. . . n12

Σn = N

n12

n

n

F2 = N2 F3 = N3 . . . F12 = N

Per il Teorema

N→8

di Bernoulli

...

P2

P3

P12

AS-42

Consideriamo un particolare valore della variabile

casuale (Es. 2):

n2 → NP2

N→8

N finito:

F2 ? P2

n2 ? NP2

Quale è la distribuzione di probabilità di n2?

P N, P2(k) = N P2 k (1 - P2)N-k

k

(binomiale)

Se P2 è probabilità della variabile 2, la probabilità di

k(=n2) successi su N prove si ottiene dalla distribuzione

binomiale

Ripetendo M volte la serie di N lanci (N cost) i valori di n2

che si ottengono saranno distribuiti secondo la P N, P (n2)

2

(0 < n2 < N). [Se N grande e P2 piccolo la distribuzione

tenderà alla poissoniana con m = NP2. Vedi dopo.

V alore aspettato e varianza d in 2 :

µ(n 2)= NP 2

σ2(n2) = N . P2 . (1 - P2)

AS-43

Variabile casuale continua

N prove : x1 . . . . . xN

n1 n2 n3

.

.

.

.

.

.

ni

1

4

5

.

.

.

.

i

2

3

∆x

ni

N

x

ni valori di x in intervallo i

N→8

∆Pi =

xi+∆x

xi

f(x) dx ~ f(xi) .∆x

Per N finito ni ? N∆P.

Ripetendo M volte la serie di N misure il

contenuto ni del generico ∆x avrà distribuzione

binomiale P N,f(x ) ∆.x (ni) [tenderà alla poissoniana

i

con µ(ni) = N .f(xi) . ∆x per N grande e ∆P

piccolo].

Valore aspettato di ni :

µ(ni) = N f(xi) . ∆x

σ2(ni) = N . f(xi) . ∆x . (1 - f(xi) . ∆x)

AS-44

Rappresentazione grafica

(istogrammi )

caso discreto

N prove

*

N eventi

*

10

*

*

aspettato = NPi

* valore

: eventi osservati

*

*

*

5

*

*

*

2

*

4

6

8

10

12

x

caso continuo

N eventi

15

ni valori di x in intervallo i

N . f(xi) .∆x

N prove

10

5

xi

∆x

Area = Σi ni ∆x = ∆x Σi ni = ∆x .N

x

Valore aspettato in intervallo i:

µi = N f(xi) . ∆x

Area = Σi µi ∆x = N . ∆x Σi f(xi) ∆x = ∆x. N

s

f(x) dx = 1

AS-45

QUINCONCE DI GALTON

N : file di perni

∆x : spaziatura perni

N

p : probabilità di deviazione

a destra

1 )

(in genere p =

2

∆x

0

1

2

k

N

3

0

xi

x

Ad ogni urto la pallina subirà spostamento ∆x

2

Coordinata xi finale della pallina :

xi = nD -

N ∆x

2

Infatti:

nD : n. urti con deviazione a destra

nS = (N - nD): n. urti con deviazione a sinistra

x = nD . ∆x - (N - nD) ∆x =

2

2

= (2nD - N) ∆x = (nD - N ) ∆x

2

2

nD = 0, . . . , N

x=- N ,..., N

2

2

Vogliamo valutare la

probabilità che la pallina

abbia alla fine xi

N + 1 valori

(∆x = 1)

P (xi) = P (nD)

AS-46

Evento favorevole : deviazione a destra

Un singolo urto : una prova ogni fila di perni

Dopo N prove (= N di file di perni), la probabilità che evento

favorevole si sia presentato nD volte (essendo p la probabilità di deviazione a destra) :

PN,p (nD) =

N . p nD . (1 - p)N-n D

nD

µ (nD) = N . p

σ2(nD) = N .p . (1 - p)

Se considero ora la variabile x = f(nD):

P(y) = P(z = 1a {y - b})

y = az + b

µ(y) = a . µz + b

µz , σ z2

σ2(y) = a2 . σ 2z

x = (nD - N

2 ) ∆x

N

nD = x + 2

∆x

P(x) = P (nD calcolato in x) =

µ(x) = (N . p -

N

2

N . p nD .(1 - p)N-nD

nD

) . ∆x

σ2(x) = N . p . (1 - p) . ∆x2

La probabilità che la pallina abbia coord. finale x è una

n. prove = n. file chiodi

BINOMIALE con

p = prob. urto a destra

AS-47

LANCI RIPETUTI

Numeriamo caselle di arrivo della pallina da 0 a N

(k (numero della casella) = nD)

xk = (coordinata centro cella) =

k-

N

2

avendo posto:

∆x = 1

P(k) = P(nD) = P(xk)

Se faccio N lanci di palline, quale è la probabilità di trovare

mk palline in cella k?

Se eseguiamo N lanci (N prove) e se P(k) è la probabilità

che la pallina vada nella cella k (evento favorevole), la

distribuzione di probabilità per la variabile casuale mk

(= numero di successi su N prove, cioè numero di palline in

cella k) è una binomiale:

P N ,p(k) (mk) =

N

mk

. P(k)

mk

. Q(k)

N-mk

Q=1-P

0 = mk =

N

con

P(k) = PN,p(k) = N pk . (1 - p)N-k

k

N: numero di file di chiodi

p: probabilità di deviazione a destra

AS-48

La variabile casuale mk avrà valore aspettato e varianza:

µ(mk) = N . P(k)

σ 2 (mk) = N . P(k) .(1 - P (k))

Dove µ(mk) rappresenta il numero aspettato di palline nella

cella k se si eseguono N lanci e σ (= varianza = deviazione

standard) è la larghezza della distribuzione intorno al valore

aspettato. Notare che:

σ (mk)

µ(mk)

=

N . P(k) . 1 - P(k)

N . P(k)

=

1 . 1

-1

P(k)

N

Larghezza relativa distribuzione =

intervallo fluttuazione valori

osservati intorno a valore

aspettato/valore aspettato

Quindi σ

µ decresce come

1

N

per un dato P(k)

NOTARE:

se P(k) << 1, 1 - P(k) & 1

σ2 (mk) ~ µ (mk)

σ =

µ

1

µ

AS-49

TRACCIA SUGGERITA ESPERIENZA

(P = 0.5; X∆ = 1)

1

Verifica valore aspettato e varianza

variabile x

N determinazioni di x con N lanci

Miglior stima di µ e σ :

x=

Σ i xi

N

Σ i xi2 - x2

N

Σ i (xi - x)2 ~

s=

~

( N - 1)

( N - 1) ~ N

Nella generica cella k, mk palline;

osservato mk volte xk = k - N2

N

N

N

N

Σ1 i x i = Σ0 k x k . mk

Σ1

i

x2i =

Σ0

k

(xk . mk ) 2

AS-50

Confronto valori misurati

valori aspettati

(Stime)

µ(x), σ(x)

x, s(x)

Per buon accordo alto numero N di lanci

(N = 30, N = 10. 000)

2

Confronto distribuzione aspettata e

distribuzione osservata variabile mk

Valore aspettato di mk in cella k avendo effettuato N lanci:

µk = µ(mk) = N . P(k)

Confrontare, per ogni cella k, µk con valore osservato mk.

Verificare, utilizzando il test del χ2 (vedi dopo),l'accordo fra

distribuzione aspettata e distribuzione osservata.

Accordo (visivo)migliora con

N

σ ∝

µ

1

N

AS-51

Con stesso valore di N fare due serie

con N piccolo e N grande

N 1 = 100

= 30

N

N 2 = 10000

Confronto distribuzione osservata e

distribuzione aspettata per un

determinato mk

3

Fisso una cella k

M serie di N lanci

jm

k = numero di palline in cella k nella serie

j(j = 1, M)

Distribuzione aspettata per ni,

i

ni = numero di volte che si osserva mk in cella k

ni (mki ) = M. P (mki )

con

P (mik) =

N .

mik .

Q(k)

mik P(k)

N -mik

n

nii(mk)

0

mki

mk

AS-52

DISTRIBUZIONE DI POISSON

Evento casuale E cui è associata variabile casuale t con le

seguenti caratteristiche :

1) Densità di probabilità uniforme f(t) = λ

dP = λ dt

2) Eventi statisticamente indipendenti

3) Probabilità trascurabile di avere più di un evento in dt

Distribuzione di probabilità che in un intervallo (0, t) si

verifichino k eventi:

P (k, t)

dP (1, dt) = λ dt

dP(0, dt) = 1 - λ dt

P(k, t + dt) = P(k -1, t) . dP(1, dt) + P(k,t) dP (0, dt)

= P(k -1, t) . λ dt + P(k, t) . (1 - λ dt)

P(k, t + dt) - P(k, t) = λ . P(k - 1, t) - λ . P(k, t)

dt

dP(k, t)

+ λ . P(k, t) - λ . P(k - 1, t) = 0

dt

AS-53

k=0

P(k - 1, t) = 0

dP(0, t)

= - λ P(0, t)

dt

P(0, t) = e-λt

P(0, 0) = 1

k=1

dP(1, t) + . P(1, t) - e-λt = 0

λ

λ

dt

Sol. : P(1, t) = λt .e-λt

infatti:

λ e-λt - λ2 te-λt + λ2 te-λt - λ e-λt

=0

dP(2, t)

+ λ . P(2, t) - λ2 t . e-λt = 0

dt

k=2

..

.

(λ t)k e-λt

P(k, t) =

k!

k

t : costante; m = λ t costante

mk -m

Pm(k) = k! e

Distribuzione

di

Poisson

(dipende da un solo

parametro: m)

k: variabile casuale discreta fra 0 → + 8

Normalizzazione :

8

Σ

0k

mk e-m = e-m . 8Σ mk = e-m . e+m = 1

0 k k!

k!

sviluppo in serie di em

AS-54

Valore aspettato : 0 = k = 8

8

8

mk-1

mke-m = m .e-m .

Σ1 k (k -1)!

k!

µ = E[k] = Σk k

0

1

k' = k - 1

8

= m . e-m

Σ0 k'

mk' = m .e-m .em

k'!

em

Notare:

m

Pm (k) = Pm (k -1) .

k

crescente fino a

k=m

µ=m

Pm (m) = Pm (m - 1)

Varianza :

σ2 = E (k - m)2 = E k2 - m2

E k2

8

=

Σ0 k

k2

mk e-m = m

k!

8

Σk k

1

mk-1 e-m =

(k - 1)!

1

k' = k - 1

8

mk' e-m =

(k'

+

1)

Σ0 k'

k'!

= m E [k' + 1] = m (m + 1)

=m

σ2 = m(m + 1) - m2

σ2 = m

σ = m

AS-55

La distribuzione di Poisson si può anche ottenere da

distribuzione binomiale per n molto grande, p molto piccolo

(n . p limitato).

Infatti (esempio decadimento radioattivo): per ogni intervallo

di tempo t:

p : probabilità di decadere

1) Si fanno n prove (n nuclei che possono decadere)

2) Si ottengono k "successi" (= k decadimenti)

p : molto piccolo

n : molto grande

n

k

Pn,p(k) = lim

n→8

np=cost.

np : limitato

pk(1 - p)n-k =

1-p~1 se p piccolo

σ 2(k) ~ n p.

µ(k) = n .p

in Poisson

p= m

n

n . (n - 1) . . . (n - k +1) m

= lim

n

k!

n→8

m

k

1 -m

n

n-k

1 -m

n

n

n . (n - 1) . . . (n - k +1) m k

.

= lim

nk

k! 1 - m

n→8

n

= 1 dato che k finito

mk

.

.

= lim 1 1 - 1n 1 - 2n . . . 1 - k-1

n

k!

n→8

k

=

1 -m

n

1 -m

n

n

k

k

= m e-m

k!

c.v.d.

Ricordare che:

lim 1 + ax

x→8

=

x

= ea

lim 1 - m

n

n→8

n

= e-m

AS-56

DIMOSTRAZIONE ALTERNATIVA:

n!

. pk (1 - p)n-k =

n→8 k! (n - k)!

lim

p= m

n

FORMULA DI STIRLING :

n! ~ 2pn . nn . e-n

n>>1

n-k

k

2pn

nn . e-n

.

. m . 1 -m

n

2p (n - k) (n - k)n-k .e-(n-k) n

= lim 1

n→8 k!

n-k

=

=1

= lim 1

n→8 k!

1

1-k

n

n-k

.

ek

mk 1 - m

n

n-k

=

e-m

e-k

Ricordare:

lim 1 + ax

x→8

x

= ea

= 1 mk . e-m

k!

AS-57

Es.

Decadimento nuclei radioattivi :

Se m è numero medio di decadimenti per unità di tempo

(m = media), la probabilità di osservare k dec. nell'unità

di tempo è data dalla :

k

Pm (k) = m e-m

k!

10 dec./U.T. ;

Probabilità di 0 dec.?

100 -10

P10 (0) =

e = 4.5 10-5

0!

1010 -10

P10 (10) =

e = 0.13

10!

µ=m

σ= m

P(m - m = k = m + m )

?

P10 (7 = k = 13) = F10 (13) - F10 (7) = 0.865 - 0.220 = 0.645

Se m = 4:

P4 (2 = k = 6) = F4 (6) - F4 (2) = 0.889 - 0.238 = 0.651

AS-58

Es.

(Esperimento di Rutherford)

Sorgente α su bersaglio

conteggio numero di particelle con angolo di "scattering" θ

2608 conteggi da 7.5 s; 10. 094 particelle in totale.

.

10 094 = in media 3.87 particelle/conteggio = m

2608

Verifica della distribuzione Poisson del numero di particelle

osservate in un conteggio:

Prove fatte: 2608 = N

Probabilità di osservare k particelle in un conteggio :

k

m

Pm (k) =

e-m

k!

Numero aspettato di conteggi in cui osservo k particelle,

avendo fatto N prove (da binomiale) :

nk = N .Pm(k)

k

nk

0

1

2

3

4

5

6

7

8

9

=10

57

203 383 525

532 408 273 139

45

27

11

(aspettato)

54

210 407 526

508 393 254 140

68

29

17

σn k

7

8

5

4

(osservato)

nk

14

20

23

22

20

16

12

AS-59

Es.

Conteggi da rivelatore con ε < 1

numero medio per unità di tempo di particelle nel

rivelatore : ν

(con distribuzione di Poisson)

r: numero di particelle osservate nell'unità di tempo

quale è: P (r) ?

Per avere r conteggi, = r particelle nel rivelatore con

p = probabilità del rivelatore di osservare particella

8

P(r) = Σr n Pν(n) .Bn,p(r) =

8

1

= Σr n n!

.

νn . e-ν

1 .(p )r .e-ν

= r!

ν

.

8

n r.

n-r

r p (1 - p) =

Σr n

1

(n - r)!

.

ν . (1 - p)

n-r

=

sviluppo in serie di ek con

k = ν (1 - p)

1 .(p )r . e-ν . e(1-p)ν =

= r!

ν

= 1 .(pν)r . e-pν = Ppν (r)

r!

Poisson con m = pν

AS-60

DISTRIBUZIONE UNIFORME

F(x) = b - x

b-a

f(x) = 1

b-a

µ = E[x] =?

b

a

x 1 dx = 1

b-a

b-a

x2 b

2 a=

2

2

= 12 bb -- aa = 12 (b + a)

σ 2 = E (x - µ)2 = E x2 - µ2

E

x2

b

=?

x2

a

σ

2=

1 dx = 1

b-a

b-a

b3 - a3

3

b3 - a3 - (b + a)2 = 1 = (b - a)3 = 1 (b - a)2

12

12

b-a

3(b - a)

4

1

µ = 2 (b + a)

(b - a) = 2 .∆x

σ=

σ2 =

1 (b - a)2

12

σ=

1 (b - a)

12

1

∆x

3

P(µ - σ = x = µ + σ) =

2

∆x

3

2 ∆x

= 0.58

AS-61

DISTRIBUZIONE ESPONENZIALE

fβ(x) = 1 e-x/ β

β

∫

8

0

f(x) dx = 1

β

1

µ(x) =

β

∫

0

∫x . e

8

e-x/β dx

-x/ β

0

= - e-x/β

=0

8

8

0

=1

∫e

8

8

dx = - x . e-x/β +

0

-x/ β

dx =

0

integrando per parti :

u=x

v = e-x/ β

dv = − 1 e-x/β dx

β

=β

1

σ2 = β

0=x=8

β>0

∫

0

8

x2 e-x/β dx - β 2 = 1 .2 β 3 - β 2 = β 2

β

∫x

2 eax

dx =

ax

2

2x

= ea x2 - a + a2

fµ(x) = 1 e-x/µ

µ

µ(x) = µ

σ 2 (x) = µ2

AS-62

CUMULATIVA DELLA DISTRIBUZIONE ESPONENZIALE

∫

F(x) =

0

x

1 e-x'/ µ dx' = 1 - e-x/ µ

µ

P(µ - σ = x = µ + σ) = F(2µ) = 1 - e-2 = 0.86

2µ

0

AS-63

Esempio

Distribuzione del ∆t fra due particelle consecutive in

un fascio con distribuzione temporale uniforme.

Ntot particelle

∆t

t1

t

t0

t2

f(t) = cost

f(t)

1

t2 - t1

t1

t2

t

Fissato arbitrariamente t0 :

0 particella in ∆t

1

" dt

"

dP(∆t ) = e-λ∆t .λ dt

dP(1, dt)

P(0, t) (vedi pag. AS-54)

f(∆t ) =

λ=

Ntot

t2 - t1

dP(∆t ) = . e-λ∆t

λ

dt

µ(∆t ) = 1 =

λ

t2 - t1

Ntot

AS-64

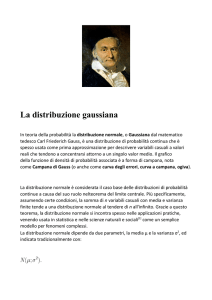

DISTRIBUZIONE DI GAUSS

(NORMALE)

∫

(x - xo)2

1

. e- 2a2

f(x) =

;

2π.a

+8

f(x)dx = 1

-8

1 Simmetria intorno a: x = xo

2

3

2f

d

xo - a, xo + a sono i punti di flesso

=0

dx2

a misura la larghezza della distribuzione

1

2π.a

massimo: f(x = xo) =

df

dx = 0

Valore aspettato

1

µ = E[x] =

2 π .a

∫ xe+8

(x - xo)2

-8

cambiando variabile:

x-x

t= a o

dt = a1 dx

1

=

2π

∫

∫

+8

t2

xo

1

. =

a t e 2 dt +

2 π -8

2π

=0

+8

-8

+8

t2

.

(a t + xo) e 2

-8

∫

dx =

2a2

Gauss con

xo = 0

a =1

=1

dt =

∫

+8

-8

t2 dt

e 2

= xo

AS-65

f(x)

xo = - 1

a = 0.5

t2

xo = 3.5

a = 1.5

0.5

t

-2

-1

0

xo = 1.5

a=2

1

2

3

4

5

x

AS-66

Varianza

= xo

1

2π a

σ2 = E (x - µ)2 =

∫

(x - µ)2

(x - µ)2 e 2a2

dx =

-8

t= x-µ

a

∫

+8

+8

dt = 1 dx

a

2

t

a2

2

.

e

2 dt = integrando per parti

=

t

-8

2π

u=t

du = dt

2

t

v = e- 2

t2

2

dt

∫ u . dv = u . v - ∫

+8

=

dv = t . e-

-8

+8

-8

-8

+8

t2

2t

a

. e- 2

=-8

2π

=0

+

+8

vdu =

a2

2π

∫

+8

-8

=1

2

t

e- 2

dt

=

Gauss x = 0

a=1

= a2

(x - µ)2

1

.

f(x)=

e 2 2

σ

2π σ

Distribuzione

di

Gauss

AS-67

F(x) =

∫

(x' - µ)2

1

e 2σ2 dx'

.

2π σ

x

-8

Cumulativa

Variabile ridotta

t=

x-µ

σ

dx

dt = σ

Se x ha funzione di distribuzione f(x) ,

g(t) = dx . f(x = t)

dt

t = t(x)

Funzione universale

g(t) = σ .

t2

1

. e 2

2π σ

Cumulativa

∫

G(t) =

Gaussiana

µ=0

σ=1

t

-8

g(t') dt'

g(t) e G(t) tabulate.

AS-68

~0.4

g(t)

0.3

0.2

0.1

-3

-2

-1

0

1

2

3

t

1.0

G(t)

0.5

-3

-2

-1

0

1

2

t

3

AS-69

Il contenuto probabilistico di un intervallo ∆x per la

funzione di Gauss si ottiene usando G(t):

∫-t

to

Pµ,σ (µ-∆, µ+∆) = P(-to, to) =

to =

g(t) dt = 2

∫

to

g(t) dt =

0

o

xo - µ

σ

Se si ha G(t)

=

tabulata

fra 0 e t

∫

2

to

∫ g(t) dt =

0

g(t) dt -

-8

-8

= 2 G(to) - G(0) = 2G(to) - 1

1

2

g(t)

G(0) = 0.5

G(1) = 0.841345

G(2) = 0.977250

G(3) = 0.998650

G(4) = 0.999968

G(to)

G(0) =

-2

-1

0

to

1

2

1

2

t

P(µ ± 1σ) = 2 . G(1) - 1 = 0.6827

P(µ ± 3σ) = 2 . G(3) - 1 = 0.9973

P(µ ± 2σ) = 2 . G(2) - 1 = 0.9545

P(µ ± 4σ) = 2 . G(4) - 1 = 0.99994

AS-70

P(a = x = b) = G

b- µ

σ

-G

a-µ

σ

Se, fissato P = Po, voglio ricavare (a, b) ?

Po = G

b- µ

σ

a-µ

σ

-G

infinite soluzioni

Se richiedo intervallo simmetrico: (intorno a µ)

Po = 2G

G

Es:

b- µ

σ

b- µ

σ

-1

Po + 1

2

=

Po = 0.9

b-µ

σ

G

= 1.645

b-µ

σ

= 0.95

b - µ = 1.645 . σ

P(x > µ + nσ) = 1 - G(n)

P(µ - nσ = x = µ + nσ) = 2(1 - G(n))

AS-71

Funzione di distribuzione di più variabili casuali

Dato un fenomeno causale che dipende da più variabili casuali

x = (x1, x2, ... xn)

Si può definire una densità di probabilità congiunta

f(x) = f(x1, ... xn)

cn

f(x) dx = 1

E G(x) =

E xi =

G(x) f(x) dx

cn

xi

n

c

f(x) dx = µi

E (xi - µi)2 =

(xi - µi)2 f(x) dx

cn

E (xi - µi) . (xj - µj) =

(xi - µi) (xj - µj) f(x) dx

cn

AS-72

= (xixj + µiµj - xiµj - xjµi) f(x) dx =

cn

= E xixj + µiµj - 2µiµj

= E xixj -E xi .E xj = Vij

Vij : matrice di covarianza

I

è una matrice simmetrica Vij = Vji

II

elementi diagonali Vii = σ2 (xi)

III

i ? j Vij : covarianza (xi, xj)

>0

<0

Coefficiente di correlazione ρ (xi, xj) :

ρ (xi, xj) =

Vij

cov(xi, xj)

=

.

σi . σj

Vii V

jj

-1 = ρ(xi, xj) = 1

ρ = 0 scorrelate

ρ = ± 1 completamente correlate

Infatti : (es)

σ2(x1 +ax2) = σ2(x1) + a2σ2(x2) + 2a. cov(x1x2)

[Vedi dopo combinazioni lineari di variabili casuali]

AS-73

Dato che σ2(x1 +ax2) è per definizione = 0 :

σ2(x1) + a2σ2(x2) + 2a cov(x1x2) = 0

Dividendo per σ2(x1) :

1+

a2

σ2(x2)

σ(x2) . cov(x1x2)

+

2a

=0

σ(x1) σ(x1) . σ(x2)

σ2(x1)

α2

α

1 + α2 + 2αρ = 0

ρ2 = 1

ρ(x1x2)

per ogni α

-1 = ρ = 1

Se le xi sono mutuamente indipendenti:

. 2) ... f(xn)

f(x1 ... xn) = f(x1) f(x

E{xi xj} =

(vedi pag. prec.)

xi xj f(xi) ... f(x n) dx1 ... dxn =

=

xi xj f(xi) . f(x j) dxi dxj =

=

xi f(xi) dxi . xj f(xj) dxj = E{xi} .E{x j}

cov(xixj) = 0 per j ? i

AS-74

x1 e x2 indipendenti

Es.

0 < x1 < 1

0 < x2 < 1

F. di distribuzione

uniforme entro C2

x2

1

C2

f(x1, x2) = 1

0

1

Infatti:

x1

1 1

0 0

µ x1 =

µ x2 =

σ2x = V11 =

1

1 2

x12

1

x22

1

x1f(x1,x2) dx1 dx2 = 2

2

1 2

x2

"

= 2

x12

1

= 2

0

1

= 2

0

)2 . f(x

.

.

1,x2) dx1 dx2 =

(x1-µ x1

=E

V12 =

1

f(x1,x2) dx1 dx2 = 1

1

0

(x1-µ x1)2 dx1 =

x13 1

1

- µ x21 = 13 - 14 = 12

x1 = 3

0

-µ 2

(x1 - µ x1) (x2 - µ x2) f(x 1x2) dx1 dx2 =

= (x1 - µ1) dx1 (x2 - µ2) dx2 = 0

AS-75

x1 e x2 correlati

0 < x1 < 1

0 < x2 < 1

x2

1

x12 + x22 = 1

F. di distribuzione uniforme entro C2

C2

0

0

x1

1

f(x1,x2) = cost.

C2

1

µ x1 = 4p

4

x1 = V11 = p

0

σ2

dx2 = 4p

1-x12

2.

(x1 - µ x1) dx1 .

0

V12 = 4p

0

0

1

0

x1. 1 - x12 . dx1 = 0.42

1

2

4

(x

µ

)

dx2 = p

x1 .

1

0

1-x12

dx1 = 0.07

1-x12

1

0

2

area = pR

4

f(x1,x2) = 4p

1-x12

x1 dx1.

1

f(x1,x2) dx1 dx2 = 1

(x1 - µ x1) dx1

ρ12 =

0

(x2 - µ x2) dx2 = - 0.022

- 0.022

= - 0.31

0.07 . 0.07

AS-76

DISTRIBUZIONE GAUSSIANA MULTIVARIATA

La funzione di distribuzione di n variabili casuali gaussiane

correlate:

T. .

-1/2(x

a)

B (x - a)

.

φ(x) = k e

k=

1

(2p)n/2 . (DET B-1)1/2

Con:

a = (µ1, µ2 . . . µn)

B-1 = C

Matrice delle covarianze di x1, . . . xn

∫ φ(x) . dx = 1

B11 . . . . . B1n

(x1 - µ1, . . . xn - µn) .

.

.

.

.

.

.

.

.

Bn1 . . . . . Bnn

x1 - µ1

.

.

.

.

.

xn - µn

AS-77

DISTRIBUZIONE GAUSSIANA BIDIMENSIONALE

Distribuzione binormale

2

C=

cov (x1 x2)

σ1

2

σ2

cov (x1 x2)

B=

2

1

2

σ1

2

σ2

= B-1

σ2

.

- cov (x1 x2)2

- cov (x1 x2)

2

σ1

- cov (x1 x2)

se (x1 x2) sono scorrelate (cov (x1 x2) = 0):

B=

1/ σ12

0

0

1/ σ 22

(x1 - µ1, x2 - µ2)

1/ σ12

0

0

1/ σ 22

x1 - µ1

.

=

x2 - µ2

x1 - µ1

2

= (x1, µ1, x2 - µ2)

σ1

x2 - µ2

=

(x1 - µ1 )2

2

σ1

2

σ2

1

. e(x

,

x

)

=

φ 1 2

.

2p σ1σ2

2

1 (x1 - µ 1 )

2

2

σ1

. e-

+

1

2

(x2 - µ2 )2

2

σ2

(x2 - µ2 )2

2

σ2

Prodotto di 2 gaussiane

AS-78

Nel caso in cui x1 e x2 sono correlate:

ρ=

moltiplico e

divido per

σ1σ2

cov (x1 x2)

σ1σ2

B può essere scritta:

1

B=

1 - ρ2

f(x1 x2) =

G=

1

1 - ρ2

1

σ1σ2

1

2π σ1σ2

ρ

ρ

σ2

σ1

-ρ

2

σ1

-ρ

C = σ1σ2

σ1 σ

2

1 - ρ2

σ1σ2

1 2

σ2

. e -1/2 G

(x2 - µ2 )2

(x1 - µ 1 )2

+

-2 ρ

2

2

σ1

σ2

x1 - µ 1

σ1

x2 - µ2

σ2

f(x 1, x2)

x2

x1

Probability density of a bivariate Gaussian distribution

AS-79

FUNZIONI LINEARI DI VARIABILI CASUALI

n

y(x1, ... xn) =

i ai xi

1

Valore aspettato:

E[y] = E[Σi ai xi ] = Σi ai E[xi] = Σi ai µi

Dato che E è un operatore lineare

Varianza:

E[(y - µy)2] =

= E Σi ai xi - Σi ai µi

2

=

= E Σi ai (xi - µi) 2 =

= E Σi a2i (xi - µi) 2 + i?j

Σ aiaj (xi - µi) (xj - µj) =

= Σi a2i σi2 + i?j

Σ a iaj . cov (xi , xj)

AS-80

Se le variabili xi sono indipendenti:

N

µy = ? ai . µx i

N

i=1

? ai . xi

y = i=1

σ2y

N

2

2

?

a

=

i . σ xi

i=1

Ma: forma della ƒy, date le ƒx i ?

Difficile in generale ma:

Alcuni casi particolari

a) Distribuzioni gaussiane

b) "Tante" f(xi) qualsiasi

(sotto particolari condizioni)

AS-81

FUNZIONI LINEARI DI VARIABILI CASUALI

CON DISTRIBUZIONE "NORMALE" (GAUSSIANA)

Date n variabili casuali xi con funzione di distribuzione

gaussiana ("normale") f(µi, σi) la funzione :

n

y = ?1 i ai . xi

avrà ancora una funzione di distribuzione "normale"

f(µy, σy)

(si può dimostrare)

con :

µy = ? i ai . µi

σ2y = ? i a2i . σ2i

xi

N

Ne segue che la media x = ?

1

i

N

di un campione di

dimensione N di una variabile "normale" (σx, µx) è ancora

σx

una variabile "normale" con: µx = µx e σx =

N

[Ogni xi può essere considerata una variabile casuale con f.

di distribuzione normale]

AS-82

TEOREMA DEL LIMITE CENTRALE

Date n variabili casuali indipendenti xi con funzioni di

distribuzione qualsiasi (µi, σi finita), la funzione:

n

y = ? i ai . xi

1

nel limite n → 8

avrà distribuzione "normale" con :

µy = ? i ai µi

2

2

σ2y = ? ai σi

Condizioni di validità molto ampie, ma :

è importante che le σ2i siano tutte finite e

paragonabili, cioè nessuna domina le altre.

N.B.

Se le ƒi sono concentrate attorno al valore aspettato

(σi piccole), il teorema è valido già per valori piccoli di

N.

AS-83

Es.:

T

µ=T

µ= 2

T

0

y = x1 + x2 + x3

y = x1 + x2

y = x1

1

T

2T2

σ2 = 12

T2

σ2 = 12

1

T

3

p

T2

σ2 = 4

3 T

2

T

T

2

e-3(x-T) /T

1

T

2

Gaussiana con stessa µ, σ

ES.

µ = 23 T

2

p

2

e-2(x-1.5 T) /T

2

Gaussiana con stessa µ, σ

Generatore di numeri a caso con distribuzione Gauss

G (0, σ): ottenuto con la somma di n numeri a caso

con distribuzione uniforme in (0, 1).

n

y = ? xi

i=1

- n

2

1 - n =0

2

2

1

σ2 = n .

12

µ=n.

Buon accordo con gaussiana per n > 5÷10. Per n = 12 si ottiene

G (0, 1)

N.B.

Il teorema del L.C. ha validità più generale.

AS-84

Il modello di Laplace degli errori di misura

Sia x* il valore vero di una grandezza fisica, x il risultato di una

generica misura.

x = x*

a causa degli errori di misura che assumeremo

puramente casuali

Modello di Laplace : errore di misura = insieme estremamente

grande (→ 8 ) di disturbi contemporanei molto piccoli

(→ infinitesimi)

Ogni disturbo = ± ε (50% + ε, 50% - ε )

Ogni disturbo è statisticamente indipendente

Se N sono i disturbi e k i disturbi +ε :

x = x* + kε -(N -k) ε = x* + (2k - N) ε

PN,p(k) =

con :

N!

pk . qN-k

k! (N - k)!

p = probabilità di disturbo + ε =

1

2

AS-85

σ2 (k) = Npq

µ(k) = N . p

λ : scarto di k dal suo valore aspettato

k - Np = λ

k = Np + λ

N - k = N. q - λ

PN,p(λ) =

0=k=N

-Np = λ = N . q

N!

. pNp + λ . qNq - λ

(Np + λ)! (Nq - λ)!

µ(λ) = E[λ] = E[k] - N . p = 0

σ2(λ) = E[(λ - E(λ))2] =

=0

= E[(k - Np)2] = Npq

Al crescere di N si può utilizzare per N! la formula di Stirling :

N! =~ 2p .NN+1/2 .e-N

I

(Np + λ)! = 2p (Np + λ)Np+λ+1/2 . e-Np-λ =

= 2p (1 + Npλ )Np+λ+1/2 . e-Np-λ .(Np)Np+λ+1/2

AS-86

II

(Nq - λ) =

1

λ Nq - λ + 2

Nq

1-

2p

e-Nq + λ (Nq)Nq - λ +

- Np

I e II valide per λ lontano dai suoi limiti

2p

PN,p(λ) =

λ

1 + Nq

2p

Np+λ+1/2

Nq

1

Nq + 2

N

e-N

.

Np-λ+1/2

N+1

-Nq -Nq . N1/2

2p 1 - λ

e

Nq

=N

pNp + λ

.

. qNq - λ

1

2

pNp + λ +

. qNq - λ +

=

1

2

1

=

1

2p

.

.

1

2

1+

Npq

λ

Nq

-Np-λ- 2

.

1-

λ

1

-Np+λ- 2

Nq

NOTE:

I

PN,p(0) =

1

2p

.

Npq

Valore massimo

Σk P(k) = 1

P(0) → 0 come N ; quindi il numero di valori di λ per cui P(λ) non è

trascurabile rispetto a P(0) deve divergere come N , anche se il numero

totale di valori di λ diverge come N+1.

II La formula approssimata per P(λ) non è valida per λ ~ -Np e λ~ Nq; ma in

questi intorni P(λ) è trascurabile rispetto a P(0).

AS-87

Consideriamo ora:

1

lg =

1+

λ Np - λ - 2

Np

λ

Nq

e

lg (1 + x) = x -

= Np + λ + 1

2

1-

lg 1 + λ

Np

= Np + λ + 1

2

λ

Np

λ

Nq

=

1

lg 1 - Nq − λ +

2

λ

Nq

=

sono << 1 lontano dagli estremi.

3

x2

+ x

2

3

....

2

λ

- λ2 2 + ...

Np

2N p

2

λ

=- λ

2Npq

2N

Np + λ - 12

1

1

p

q

+

λ3

6N2

Np - λ + 1

2

1

1

p2 q2

2

- λ - λ

+ ... =

Nq 2N2q2

+ ...

Per λ ~ N (unici valori non trascurabili) solo I termine

1

1

finito (secondo → 0

, terzo → 0 1 , altri come N ).

N

N

AS-88

lg k ~ -

λ2

k = e 2Npq

λ2

2Npq

1

λ2

e 2

Npq

1

P(λ) ~

2p

Npq

P( λ) ∼

1

2p σλ

.e -

1

2

λ2

σ 2λ

Ma nel modello di Laplace:

p=

1

2

x = λ* + (2k - N) . ε =

Np + λ

= x* + 2 λε

2Np + 2λ - N =

2 . N . 1/2 + 2λ - N

= 2λ

(x - x*) = 2λε

E[x] = E[x* + 2λε] = x* + 2ε E[λ]

=0

E[(x - x*)2 ] = E [(2λε)2] = 4ε2 E[λ2] = 4ε2σ2 λ

AS-89

Per ε → 0 (x da discreta a continua) :

P(x) =

?λ

?x

. P(λ)

λ = λ (x)

1

2ε

1

P(x) =

2ε

1

. e2p σλ

1

2

λ2

σ2λ

x = x* + 2λε

σx = 2εσλ

1

eP(x) =

2p σx

1

2

(x - x*)2

σ2

x

c.v.d

In questo caso P(x) rappresenta una densità di probabilità

La misura di una grandezza fisica è una variabile casuale

con f. di distribuzione gaussiana (normale). Il valore

aspettato di tale variabile casuale è proprio il valore vero

della grandezza.

AS-90

MISURA DI UNA GRANDEZZA FISICA

(Caso generale)

1) Ammettiamo che esista un valore "vero" x* della grandezza.

2) Ammettiamo che esistano molte sorgenti (N) di disturbo

della misura. Queste sorgenti generano degli errori casuali

εi che hanno le seguenti proprietà:

µ(εi) = εi f(εi) d εi = 0

2

σ2(εi) = εi f(εi) d εi

finito

(Nessuna ipotesi sul tipo delle f( εi))

Potremo quindi scrivere per la generica misura di x, xM :

N

xM = x* + ? i εi

xM = x* + ε

1

N

ε = ? i εi

1

Per il teorema del limite centrale la variabile casuale ε, somma

di N variabili casuali a varianza finita, per N → 8 avrà

distribuzione normale con valore aspettato e varianza:

N

µ(ε) = ? i µ(ε i) = 0

1

f(ε) =

1

2p σε

N

σε = ? i σ2(εi)

2

1

e-

ε2

2 σε2

AS-91

Per il teorema della addizione di variabili normali, xM sarà

ancora una variabile normale con :

µx M= x* + µε = x*

2

y = ax + b

2

σx M= σε

µy = aµx + b

σy2 = a2σ 2x

f(xM) =

1

2p σx M

. e-

(xM - x*)2

2 2

σxM

Dimostreremo (vedi prossime lezioni) anche che:

h

se si eseguono N misure xi della grandezza, cioè se si estrae

un campione di dimensione N dalla popolazione (infinita)

della variabile xM (che ha funzione di distribuzione

normale), la miglior stima di µx M (cioè del valore x* della

grandezza fisica) sarà dato da:

N

x=

? i xi

1

N

(media aritmetica delle xi)

AS-92

e che la miglior stima di σx2M :

s2

=

1

N-1

N

?i

1

(xi - x )2

(scarto quadratico medio)

La media x , essendo combinazione di variabili casuali normali,

avrà a sua volta distribuzione normale con :

µ (x) = x*

σ (x) =

2

σx2

N

Indicheremo il risultato di N misure ripetute (con stesso metodo

nelle stesse condizioni) di una grandezza fisica con la notazione:

x = x ± sx = x ±

sx

N

N

x=

sx =

1 ?

i

N 1

xi

? (xi - x)2

N-1

Con questa notazione si intende :

P( x - x* = sx) = 68%

Cioè la probabilità che l'intervallo: x - sx = x* = x + sx

contenga x* è il 68%

Risultato di una singola misura x i (assumendo noto sx) :

x = xi ± sx

AS-93

-8

?

f(x)

f(x) dx = 1

+8

GAUSS σ = 1

0,399

∆

WP

WP

⇓

σ=

0

-3

-2

-1

σ=1

uniforme

0

68,27%

1

1,73 2

2∆

= ∆

12 1,73

3

GAUSS

95,45%

99,73%

57,8%

uniforme

AS-93

bis

PROPAGAZIONE DEGLI ERRORI (STATISTICI)

Misura indiretta di una grandezza fisica:

y = f(x1, . . . xn)

Dove xi sono grandezze fisiche misurate direttamente (xi ± si);

dato che le xi sono variabili casuali, anche la y sarà variabile

casuale.

Se sviluppiamo y in serie di Taylor in un intorno di (µ1, . . . µn)

[valori aspettati delle xi]:

1

?y

y = y(µ1, . . . µn) + ?n i ?x

i

µi

(xi - µi) + . . .

Se trascuriamo i termini di ordine superiore (cioè

assumiamo che le xi siano in un intorno dei loro valori veri

µi)

y è combi nazione lineare di variabili casuali con

distribuzione normale

(quindi)

y ha funzione di distribuzione normale con :

µy = y(µ1, . . . µn)

(dato che (xi - µi) ha valore aspettato = 0)

AS-94

Per la varianza:

2

σy =

)2]

E[(y - µy

n

=E ?i

1

?y

(x ?xi µi i

µi)

2

=

n

n

?y

?y

?

= E 1 i ?1 j ?x µ. ?xj µ . (xi - µi) . (xj - µj) =

i

j

i

n

?y

?y

= ?1 i ? j ?x µ. ?xj µ. E (xi - µi) . (xj - µj) =

i

j

i

Vij

Vij = E (xi - µi) (xj - µj) = E xi xj + µi µj - xi µj - xj µi =

(Vij = Vji )

= E [xi xj] + µi µj - 2 µi µj = E [xi xj] - µi µj

LEGGE

?y .DI PROPAGAZIONE

?y

σy2 = ? i ? j ?x

V

ij

?xj ERRORI

STATISTICI

i

σy2 =

n

?i

1

?y

?xi

2

2

σ xi + ? i ? j ?y

?xi

?y

?xj

. Vij

i?j

Se le xi sono statisticamente indipendenti : (Vij = 0

σy2 =

n

?i

1

?y

?xi

2

i ? j)

LEGGE D IPROPAGAZ IONE

2

σxi

ERROR I STAT IST IC I

(x iscorrelate)

Questa legge di propagazione degli errori è esatta solo se y

è funzione lineare della xi .

AS-95

Nel caso in cui y sia un monomio : y = ? ixαi i

LEGGE D IPROPAGAZ IONE ERROR IRELAT IV I

xi correlate:

σy 2

y =

? i α2i . σx i

n

1

2

i

σ

σj

+ ? i ? j αi . αj . ρij . x i . x

i

j

i=j

xi scorrelate:

σy 2

y =

? i α2i . σx i

n

1

2

i

AS-96

STIMA DEI PARAMETRI DELLE DISTRIBUZIONI

Se distribuzione di probabilità o funzione di distribuzione

non note a priori :

Numero infinito di prove per determinarla

Esperimento con N. finito di prove :

"campione" di dimensione n della popolazione

Analisi statistica dei dati (risultato delle prove) permette una

stima delle proprietà (delle grandezze caratteristiche) della

distribuzione e permette di valutare bontà della stima.

BONTA' : probabilità statistica che il valore vero del

parametro cada in un certo intervallo intorno alla

stima ottenuta (intervallo di confidenza)

Stime con campioni di egual n hanno bontà equivalenti.

Stime con n maggiore hanno intervalli di confidenza più

stretti.

AS-97

CAMPIONAMENTO

Estrazione di n valori della variabile casuale → campione

.

di dimensione n

(1)

.......

x1

m CAMPIONI

(m)

x1

(1)

. . . . . . . . . . xn

..........

x(m)

n

Se considero :

(j)

(j)

x (j) = (x1 . . . xn )

_

x sarà ancora una variabile casuale con

_

f(x) = f(x1 . . . xn)

Il campione sarà casuale se :

I

xi indipendenti

f(x1 . . . xn) = f(x 1) . . . f(xn)

II

xi tutte con la stessa formula di distribuzione:

f(x1) = . . . = f(xn) = f(x)

Una generica funzione di un campione: "statistica"

AS-98

Una "statistica" si usa per stimare i parametri di una

funzione di distribuzione

se a sono i parametri

incogniti:

S(x1 . . . xn)

Estimatore

S è una variabile casuale

^astima

=

a

=S

Un estimatore gode delle seguenti proprietà:

1) ASSENZA DI DISTORSIONE

Per un campione finito, un estimatore è non distorto

se:

^ = a* (per ogni n)

E[S(x1, ... xn)] = E[a]

Se la distorsione tende solo asintoticamente a 0 lo

estimatore si dice asintoticamente non distorto.

2)

CONSISTENZA

Al crescere delle dimensioni del campione l'estimatore

converge al valore vero del parametro :

per n

3)

8

2

σ^a

0

EFFICIENZA

La stima ottenuta da un estimatore avrà una certa

varianza; è più efficiente un estimatore con varianza

minore. (A parità di dimensioni n del campione).

4) INVARIANZA SOTTO TRASFORMAZIONE DEI

PARAMETRI

Se a^ è la stima del parametro a, allora la stima per una

^

generica f(a), è proprio f(a).

AS-99

Estimatore del valore aspettato : media aritmetica

x=

PROPRIETA':

_

E[x] = n1

1

1

n (x1 + . . . xn)

E[x] + . . . E[xn] =

1

n

. nµ = µ(x)

non distorto

2

Per le proprietà di funzioni lineari di variabili casuali: a =

_

σ2 (x) =

1 . . 2

n σ (x) =

n2

è consistente

3

1

n

σ2 (x)

n

σ2 → 0

n→8

Si può dimostrare che la media aritmetica è la stima del

valore aspettato che ha la minima varianza, cioè è la

più efficiente

AS-100

Proprietà della media:

I

_

Somma degli scarti da x = 0

? ixi

_

_

? i (xi - x) = ? ixi - x .n = n .

n

1

n

II

_

_

_

- nx = nx - nx = 0

_

Somma dei quadrati degli scarti da x minima

Infatti, scelto un generico x:

n

? i (xi 1

x)2

_

_

2

= ? i (xi - x) + (x - x) =

n

1

n

_

_

_ _

= ? i (xi - x)2 + (x - x) 2 + 2(xi - x) (x - x) =

1

_

_ 2 . _ 2

_

= ? i (xi - x) + n (x - x) + 2(x - x) ? i(xi - x) =

n

1

_

_ 2

_2

2

= ? i (xi - x) + n(x - x) > ? i(xi - x)

=0

n

1

Estimatore della varianza (scarto quadratico medio)

s2

=

1

n -1

_

? i(xi - x)2

AS-101

Consideriamo inizialmente:

s'2 =

1

n

(x1 - x)2 + . . . (xn - x)2

E[s' 2] =

1

n

_

E ? i (xi - x)2 =

=

1

n

_

2

? i E (xi - µ) - (x - µ)

=

1

n

_

? i E (xi - µ)2 - E (x - µ) 2 =

=

1

n

=

n -1

n

nσ2 - n

1

n

σ2 =

σ2 = (1 -

1

n

=

σ2(x)

) . σ2

E' distorto (solo "asintoticamente non distorto")

s2

=

1

n -1

_

? i(xi - x)2

Sarà invece non distorto

AS-102

LA LEGGE DEI GRANDI NUMERI

(Applicata al caso della media aritmetica)

Data una popolazione di varianza finita σ2, e dati 2 numeri

positivi ε' e ε" , esisterà sempre un numero N tale che, per

ogni campione della popolazione di dimensione M = N, si

avrà:

P( x- µx = ε') = ε"

v

v

DISEGUAGLIANZA DI BIENAYME' - CEBICEV

Data una variabile casuale x con funzione di distribuzione

f(x) e varianza finita σ2 :

P( x - µ = λσ) =

1

2

λ

per λ positivo qualunque.

Infatti:

P( x - µ = λσ) =

dove C* = dominio in cui

x- µ

λσ

f(x) dx

C*

= 1.

AS-103

Graficamente:

± 2σ

± 1σ

λ=2

f(x)

x

µ

σ

Voglio dimostrare che:

= f(x) dx = 1 =

C*

λ2

1

4

f(x)

x

C*

AS-104

In C* sarà anche vero :

(x - µ)2

2

2 =1

λ σ

Quindi:

(x - µ)2

P( x - µ = λσ ) =

2

2 f(x) dx =

C* λ σ

=

C

(x - µ)2

2 2 f(x) dx

λ σ

Dove C è tutto il campo di definizione di x.

P( x - µ = λσ ) =

1

E[(x - µ)2] =

2

2

λ σ

1

2

λ

varianza di x = σ2

c.v.d.

2

Ricordando che x ha varianza =

v

σ , potremo riscrivere

N

la diseguaglianza di B.C. :

P( x - µ = λ σ ) = 1 2

N

λ

ε"

ε'

ε' = λσ

N

ε" = 2 = σ2

ε' N

λ

1

2

AS-105

Fissato ε' ed ε" (quindi λ), si sceglie N tale che :

2

σ

N=

ε' 2 . ε"

Per ogni M = N la diseguaglianza iniziale sarà soddisfatta.

*

Valore di N per cui la probabilità che la media x disti

Es.:

da µ più di 1 σ = 20%.

ε' = 1 . σ

ε " = 0.2

Infatti se ε' = σ, ne segue che

λ =1 ;

N

σ2

N=

0.2 * σ 2

1

N

=

=5

In generale, fissato N, la P(|x - µ| > 1σ) =

N= 1

1

λ2

P( x - µ > 1σ) = 1

1 :

N

0.32

2

1/2

0.20

5

1/5

0.04

10

1/10

0.001

100

1/100

f(x)

qualsiasi

f(x)

gaussiana

σx = σ

N

AS-106

*

Significato dell'argomento :

Data una variabile casuale con distribuzione qualsiasi, fissato

un livello di confidenza richiesto (cioè una probabilità), è

possibile determinare la grandezza minima del campione (cioè

il valore di N) per cui la media è (con probabilità assegnata)

prossima al valore "vero" più di un dato valore (in unità di σ)

σ

popolazione

µ

campione

x

AS-107

TEOREMA DI BERNOULLI

Data distribuzione binomiale: PN,p(k) consideriamo la

variabile casuale :

k

φ= N

PN,p(φ) = PN,p(k = Nφ)

1

E[φ] = N E[k] = Np = p

N

σ2[φ] =

1

N

E[k2] = Npq

=

2

2

N

pq

N

v

Dalla diseguaglianza di B.C. :

P( x - µ = λσ) =

λσ = ε

λ

2

=

ε

λ

2

2

2

σ

P( x - µ = ε) =

P( φ - p = ε) =

Per N → 8

1

P( k - p > ε)

N

frequenza

σ2

ε2

p. q

Nε 2

tende a 0.

AS-108

In altre parole, per N → 8 la probabilità che la

frequenza relativa differisca dalla probabilità per più di

una quantità ε assegnata, tende a 0.

Il teorema di Bernoulli è una giustificazione della

definizione di probabilità in termini della frequenza

relativa.

AS-109

METODO DELLA MASSIMA VEROSIMIGLIANZA

Stima dei parametri di distribuzioni :

data una funzione di distribuzione di una variabile

casuale, con forma funzionale nota, dipendente da

un certo numero di parametri incogniti, si vuole

stimare il valore dei parametri a partire da un

campione limitato della popolazione.

f(x, a)

a : parametri incogniti (a1 . . . an)

x1, x2, x3, . . . xN : misure della variabile casuale

(campione)

Se f è la funzione di distribuzione di x, la probabilità di

osservare l'insieme x1 . . . xN di valori :

N

dP = f(x1, a) dx f(x2, a) dx . . . f(xN , a) dx = ? i f(xi, a) dx

1

AS-110