1.INTRODUZIONE STORICA ALLA PSICOLOGIA DEI PROCESSI

COGNITIVI

1. ORIGINI E SVILUPPO DELLA PSICOLOGIA SCIENTIFICA

Per affrontare il tema della nascita della Psicologia Scientifica bisogna partire

dal problema della definizione

della disciplina. Nella cultura occidentale le problematiche psicologiche hanno

attraversato tutta la riflessione

filosofica (a partire dai filosofi greci) e in parte quella scientifica. Il pensiero

filosofico ha affrontato i problemi

connessi alla “mente” partendo da due approcci distinti (problema ancora oggi in

parte irrisolto):

A. l’innatismo: esistono aspetti della mente umana che prescindono

dall’esperienza e sono patrimonio innato

dell’uomo. La punta estrema di questa concezione e’ il dualismo cartesiano (res

cogitans e res extensa). La

mente e’ intesa come una qualità innata e specifica dell’uomo e l’esperienza serve

solo a renderlo

consapevole di una conoscenza già presente nella mente a livello implicito

(dottrina delle idee innate).

B. l’empirismo: la mente umana può essere compresa solo attraverso le relazioni

che si instaurano con

l’ambiente e quindi con l’esperienza.

Un ruolo fondamentale per la nascita della Psicologia Scientifica ha avuto anche

la ricerca scientifica. In particolare il metodo scientifico formulato da Galileo e la

teoria dell’evoluzione di Darwin. Attraverso la ricerca scientifica si e’ esplicitato

il problema della forte influenza, nella cultura occidentale, della tradizione

cristiana che, ponendo l’uomo in una dimensione distinta dagli altri esseri

viventi, nega ogni possibilità di studiarlo come parte della natura. Solo con

l’avvento dell’età moderna (XVII sec.), si accantona la visione metafisica dell’uomo,

permettendo che diventi oggetto di studio per le scienze naturali. Si pongono così

le basi culturali per lo sviluppo della Psicologia Scientifica così come la

intendiamo oggi: disciplina scientifica che supera la dicotomia tra una visione

metafisica

dell’uomo

e

una

visione

che

lo

riduce

ad

un

meccanismo

neurofisiologico, e approda a una visione integrata mente-corpo per spiegare i

processi mentali.

1

Convenzionalmente la data e il luogo di nascita della psicologia come scienza

autonoma coincidono con la creazione del primo laboratorio di psicologia

sperimentale a Lipsia nel 1879, da parte di Wilhelm Wundt. Wundt ha sancito

l’autonomia teorica del sapere psicologico e ha definito un metodo di indagine

rigoroso: il metodo sperimentale di laboratorio – l’oggetto di studio deve essere

l’esperienza mentale cosciente attraverso l’analisi dei suoi contenuti elementari

(elementismo) che, nelle loro associazioni complesse, formano i contenuti di

pensiero (associazionismo).

In seguito si sviluppano altri laboratori e nascono istituti di psicologia in tutta

europa e nel nordamerica. Nel corso del ‘900, si delineano anche orientamenti

differenti:

lo

fenomenologia,

strutturalismo,

la

psicoanalisi,

il

la

funzionalismo,

psicologia

il

comportamentismo,

cognitiva,

il

cognitivismo,

la

la

psicobiologia.

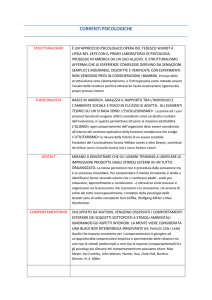

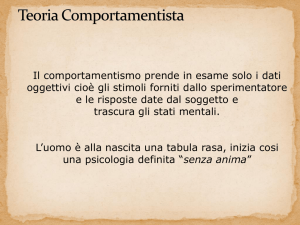

2. L’ORIENTAMENTO COMPORTAMENTISTA

Il comportamentismo può essere diviso in due periodi principali:

A. il comportamentismo classico (1913-1930) – il suo esponente principale è

Watson, psicologo

nordamericano che nel 1913 pubblica l’articolo Psychologist as the Behaviorist

Views it.

I fondamenti teorici generali di questa scuola psicologica sono:

necessità di abbandonare il terreno filosofico: la psicologia è una disciplina

scientifica, il cui obiettivo è la previsione e il controllo del comportamento e

procede attraverso il metodo sperimentale (ipotetico-deduttivo) senza fare

distinzione tra l’uomo e l’animale.

rifiuto di qualsiasi riferimento ai processi mentali che determinano il

comportamento: i comportamentisti usano la metafora della mente come “black

box”- non essendo possibile indagare direttamente i processi mentali che

determinano il comportamento, la mente può essere concepita solo come una

scatola nera, che riceve stimoli dall’esterno e produce risposte comportamentali.

L’oggetto di studio dello psicologo e’ la relazione tra gli stimoli ambientali e le

risposte (modello stimolo-risposta), in quanto la spiegazione scientifica deve

limitarsi ai fenomeni che è possibile spiegare sulla base dei dati e della

verifica sperimentale. La psicologia diviene così la scienza che studia il

comportamento. I comportamenti umani hanno diversi livelli di complessità,

ma secondo i comportamentisti un comportamento complesso altro non è che la

somma o la combinazione di comportamenti più semplici.

Sviluppo

dell’uomo

spiegato

interamente

sulla

base

delle

modificazioni

prodotte dall’interazione con l’ambiente: la mente non e’ considerata dotata di

2

fattori ereditari innati, ma una tabula rasa , lo sviluppo cognitivo e’ il

risultato della modulazione che l’esperienza produce nei comportamenti. Il

comportamento viene letto come apprendimento, cioè come una catena di

associazioni stimolo-risposta, che valgono sia per gli apprendimenti semplici

che per quelli complessi (es. linguaggio).

Possibilità di spiegare il comportamento umano attraverso la sperimentazione

sugli animali: se i comportamenti complessi sono la somma di comportamenti

semplici è possibile indagare alcune forme di apprendimento studiando gli

animali.

È evidente la matrice fortemente riduzionista di questo modello: la mente viene

vista come una struttura passiva che riceve segnali dall’esterno e produce risposte

comportamentali in funzione dell’adattamento dell’organismo all’ambiente.

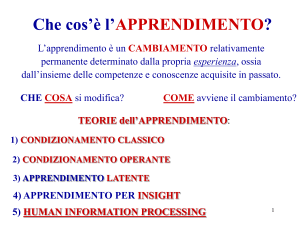

Il principale ambito di studio del comportamentismo è l’apprendimento (principio

del condizionamento).

B. il neocomportamentismo – si sviluppa a partire dagli studi di Skinner e

Tolman che introducono un’evoluzione del modello S-R, restituendo importanza

alla dimensione dell’organismo (modello S-O-R).

Il comportamentismo

ha

fornito contributi

rilevanti

anche

alla

psicologia

applicata in ambito pedagogico e sociale. Particolarmente rilevanti sono le

ricerche di

modelli,

che

Bandura (1969) sull’apprendimento mediante l’osservazione di

dimostrano

la

possibilità

di

acquisire

comportamenti

sociali

complessi sulla base di schemi imitativi e di rinforzi. Nell’affermare la possibilità

di

apprendimento

attraverso

l’osservazione

di

modelli

sociali, Bandura

fa

riferimento al concetto di imitazione, che a sua volta rimanda a processi cognitivi

quali la percezione, l’attenzione, la memoria, il pensiero: introducendo nella

variabile organismo anche i processi cognitivi.., pone le basi del passaggio dal

comportamentismo al cognitivismo.

3.L’ORIENTAMENTO FENOMENOLOGICO

Prendendo le distanze dalla psicologia elementista di Wundt nasce la Scuola di

Berlino, i cui principali esponenti sono Max Wertheimer (1880-1943), Wolfgang

Koehler (1887-1967) e Kurt Kofka (1886-1941) che si occupano prevalentemente

dello studio della percezione. Dal punto di vista teorico i principali riferimenti

sono Franz Brentano (1838-1917) e William James (1842-1910). Secondo questi

studiosi il fondamento della conoscenza psicologica deve essere l’analisi dei

processi psichici assunti nella loro immediatezza qualitativa e fenomenologia.

L’unitarietà dell’esperienza fenomenica (il modo in cui il mondo degli oggetti

percepiti si presenta alla coscienza) non può essere spiegata però come pura somma

3

di elementi, ma facendo riferimento alla relazione tra i singoli elementi e al

modo in cui interagiscono coi dati dell’esperienza. Nasce la psicologia della

Gestalt (forma) che parte dagli studi di Wertheimer sul movimento stroboscopio e

in particolare sul fenomeno del moto apparente. L’assunto di partenza è che la

realtà percettiva non equivale a quella fisica (es. melodia e accompagnamento). La

realtà fenomenica è considerata una configurazione globale (forma), dotata di

proprietà specifiche (qualità formali) a prescindere dalle caratteristiche dei

singoli costituenti. La psicologia, il cui oggetto di studio è la realtà fenomenica,

deve dunque analizzare i principi che regolano l’organizzazione secondo la quale

gli elementi formano un “tutto”, dando luogo ai percetti: l’oggetto della psicologia

è la relazione che intercorre tra i singoli elementi all’interno del campo percettivo

(parallelismo col campo magnetico). L’organizzazione del campo percettivo e’

regolata

da

precisi

principi:

vicinanza,

somiglianza,

chiusura,

buona

continuazione, buona forma, pregnanza, destino comune, esperienza passata. Le

percezioni, non derivano quindi da aggregazioni arbitrarie di singoli elementi,

ma sono frutto di un’organizzazione regolata da vincoli precisi, che determinano

proprietà globali del percetto non riconducibili alla somma degli elementi

costitutivi. Per i gestaltisti, tra le leggi che regolano i processi percettivi e quelle

dei

processi

neurofisiologici

esistono

dei

principi comuni. Comprendere

le

caratteristiche strutturali e funzionali dei processi percettivi consentirebbe quindi

di comprendere, dal punto di vista dinamico e funzionale, i processi cerebrali. I

gestaltisti hanno dato un importante contributo anche allo studio del pensiero e

dell’intelligenza: nella soluzione dei problemi si deve partire dall’analisi delle

relazioni intercorrenti tra gli elementi disponibili all’interno del campo costituito

dal problema.

La teoria della Gestalt possiede tuttora aspetti di grande rilievo: a. ha individuato

alcuni principi percettivi strutturali; b. ha posto l’attenzione sulla relazione tra

processi cerebrali e processi mentali.

4. LO STUDIO DEI PROCESSI COGNITIVI

Lo sviluppo della ricerca sui processi cognitivi si deve a due fattori: a. l’emergere

dei

limiti

memoria,

del

comportamentismo

percezione,

ecc.,

non

nell’affrontare

indagabili

temi

tramite

il

come

ragionamento,

solo

comportamento

manifesto; b. nuove acquisizioni in altri ambiti disciplinari, in particolare le

neuroscienze, l’informatica e la linguistica.

Lo

studio

scientifico

dell’attività

mentale

deve

comunque

partire

da

comportamenti espliciti per proporre costrutti ipotetici sui meccanismi mentali

che li hanno generati.

4

Lo sviluppo del cognitivismo si articola in due periodi: la prima fase va dalla

fine degli anni ’50 alla metà degli anni ’80 e la seconda è costituita dalla ricerca

sperimentale e dalla riflessione teorica contemporanee.

Non esiste una “data di nascita” del cognitivismo, ma una concomitanza di eventi

importanti per la definizione di questo nuovo orientamento. Uno di questi è il

congresso al Massachusetts Institute of Technology di Boston (1956), in cui il

confluire di conoscenze provenienti da ambiti disciplinari differenti pone le basi

per una ridefinizione del sapere psicologico – in particolare sono

cruciali i

lavori di G. Miller, sulla memoria a breve termine, A. Neswell e H. A. Simon, col

modello General Problem Solving, N. Chomsky, con la nuova teoria sullo sviluppo

del linguaggio. Solo nel 1967 si ha però una sintesi organica delle ricerche sui

processi cognitivi: Cognitive Psychology di Ulrich Neisser. In quest’opera il termine

cognitivo indica tutti quei processi che comportano elaborazioni, riduzioni,

immagazzinamenti, recuperi ed altri impieghi dell’imput sensoriale, anche

quando

hanno

luogo

in

assenza

di

una

stimolazione

appropriata

(vedi

immaginazione o allucinazioni).

4.1. Primo cognitivismo o teoria dell’elaborazione dell’informazione

Il

cognitivismo

dall’ambiente

punta

vengano

alla

comprensione

selezionati,

di

elaborati

come

e

i

segnali

restituiti

in

provenienti

termini

di

comportamento. Le informazioni vengono elaborate e integrate con quelle già

acquisite attraverso meccanismi di retroazione (feedback) che consentono il

monitoraggio continuo e flessibile del proprio comportamento in base alle

richieste dell’ambiente. Il cognitivista indaga gli stadi dell’elaborazione nei

processi di riconoscimento percettivo, memoria, uso del linguaggio, ragionamento,

ecc., (HIP=Human Information Processing), procedendo attraverso l’uso di modelli,

semplificazioni,

quasi

sempre

traducibili

graficamente,

delle

ipotesi

di

funzionamento dei singoli processi. In questi modelli il flusso d’informazione

viene descritto come un processo lineare, in cui i passaggi avvengono in modo

seriale (stretta analogia tra il funzionamento della mente e quello del computer).

In Piani e strutture del comportamento (Miller, Galanter e Pribram–1960) il

comportamento è descritto come il prodotto dell’elaborazione di un determinato

pattern di informazioni utili alla soluzione di un problema: TOTE (Test: verifica

degli elementi disponibili nell’ambiente e valutazione della loro congruenza

rispetto allo scopo – Operate: se sono adatti passare al compimento dell’azione –

Test: altrimenti ritestare la situazione - Exit: concludere l’azione). In questo modo

si può costruire un modello per ogni specifico processo cognitivo.

5

4.2. Neocognitivismo.

È lo stesso Neisser, nel ’76, in Cognition and Reality a proporre una revisione

dell’HIP (limitato nel fornire una spiegazione completa dei comportamenti

umani)

partendo

dalle

ricerche

di

Gibson

sulla

percezione.

Gibson

da

un’interpretazione diversa del termine informazione: non più la risultante

dell’elaborazione che il sistema cognitivo opera sui dati provenienti dall’esterno,

ma qualcosa che e’ già presente nell’ambiente e che non ha bisogno di alcuna

interpretazione

per

essere

colta

(teoria

della

percezione

visiva

diretta).

L’attenzione si sposta dai processi all’interazione tra l’individuo e l’ambiente

(approccio ecologico) e il comportamento umano viene considerato nei suoi aspetti

più globali, tenendo conto dell’interazione fra variabili cognitive e non (fattori

emozionali, motivazione, caratteristiche dell’ambiente, feedback). L’approccio

ecologico afferma il carattere adattivo della mente in un organismo in continua

interazione con l’ambiente e mette in evidenza i limiti della metafora della

mente come calcolatore.

Un’altra critica, mossa al primo cognitivismo, e’ quella di essere una forma più

sofisticata di comportamentismo: un sistema che accetta informazioni in entrata e

produce una risposta comportamentale; non è abbastanza considerato l’effetto di

retroazione dell’ambiente, che obbliga a modulare la risposta.

Su queste basi, nel 1979, nasce la scienza cognitiva che si fonda sui contributi di

tutte le discipline che si occupano della mente umana: psicologia, intelligenza

artificiale, antropologia, filosofia, linguistica, neuroscienza (esagono cognitivo). In

ambito psicologico la metodologia privilegiata è quella della simulazione al

computer dei processi mentali.

4.3. Gli orientamenti attuali

Negli ultimi anni si e’ affermata un’ ottica più generale e unificatrice per lo

studio dei processi mentali e si e’ avviato un acceso dibattito su questioni

epistemologiche: la definizione di mente, il suo sviluppo e la sua natura, il

rapporto mente-cervello, il problema della coscienza.

In studi recenti, la mente viene intesa come qualità del cervello che emerge

quando l’organismo raggiunge livelli particolarmente complessi. Questa prospettiva

deriva da una teoria neodarwiniana del cervello: lo sviluppo del sistema nervoso

centrale e’ inteso, sia da un punto di vista ontogenetico che filogenetico, come un

processo di selezione di

gruppi di neuroni, strettamente legato alla necessità del

cervello di modificarsi in base alle richieste ambientali. La comprensione dei

processi

mentali

non

può,

dunque,

prescindere

dalla

conoscenza

del

funzionamento del sistema nervoso, a partire dalla sua evoluzione. La dimensione

6

evolutiva e dinamica delle strutture nervose fa cadere definitivamente l’analogia

cervello-computer. Le principali caratteristiche del sistema nervoso sono infatti la

sua estrema variabilità e flessibilità.

Nel tentativo di capire come lo sviluppo delle nostre competenze cognitive, sono

stati elaborati due modelli:

1.

ad architettura verticale: gli stimoli sensoriali vengono elaborati da moduli,

strutture con elevata competenza e funzioni altamente specifiche, che lavorano in

autonomia, senza scambio di informazioni. Le informazioni vengono integrate in

un sistema centrale con caratteristiche diverse dai moduli.

2.

ad architettura orizzontale: un unico meccanismo generale di apprendimento

opera a prescindere dal tipo di informazione. A favore di questa concezione vi

sono molti dati sperimentali che evidenziano la grande plasticità del cervello,

che rende possibile un continuo

rimodellamento di reti e di circuiti neuronali

nuovi (es. recupero nei pazienti con lesioni neuropsicologiche).

La sempre maggiore conoscenza dei fondamenti biologici dei processi mentali

ripropone

in

modo

più

complesso

le

due

questioni

cardine

del

dibattito

scientifico-psicologico: la relazione fra mente e cervello e l’emergere della

coscienza. Il problema cruciale resta definire il rapporto tra processi mentali e

realtà.

2.FARE RICERCA IN PSICOLOGIA:I METODI

La psicologia e’ la scienza che studia il comportamento, le azioni osservabili

compiute da un individuo e i processi mentali che se ne possono inferire. In

quanto scienza, è empirica, obiettiva (si basa su osservazioni oggettive), dispone di

meccanismi di autoregolazione (nuovi dati possono mettere in discussione i

precedenti) ed e’ guidata dal principio della parsimonia (privilegia la spiegazione

più semplice). La ricerca psicologica è fondata su regole precise che permettono la

generalizzazione dei risultati: lo psicologo cerca di risalire a una legge generale e

di stabilire in quali condizioni sia valida. La ricerca sperimentale parte sempre

da un’ipotesi, che può essere confermativa o esplorativa (a sec. che si preveda o

meno la direzione che prenderà la ricerca). Un’ipotesi può scaturire da studi

precedenti o da un’intuizione (es. effetto Zeigarnik: tendenza a ricordare meglio i

compiti non portati a termine – la psicologa Bluma Zeigarnik ebbe un’intuizione

osservando un cameriere con una memoria prodigiosa, che le spiegò che per

ricordare a memoria tutte le ordinazioni le rimuoveva non appena le avesse

eseguite, tenendo a mente solo quelle ancora da eseguire). L’ipotesi va poi

verificata attraverso una serie di studi di laboratorio, seguendo le regole del

7

metodo sperimentale. Esistono anche altri metodi d’indagine: l’osservazione, il

metodo dell’inchiesta e quello dei test. La scelta del metodo dipende dal fenomeno

che si analizza e dalla natura del campione d’indagine.

1. CONCETTO DI VARIABILE

La variabile è un aspetto del comportamento o la caratteristica di una persona o

di un evento che ha la prerogativa di essere misurabile, in base ai valori che

quella variabile può assumere (es. la v. “sesso” ha solo due valori: maschio e

femmina).

Le variabili si distinguono in base al tipo di misurabilità: le v. quantitative

variano in grandezza (es. tempi di reazione), le v. qualitative variano in genere

(es. la professione), le v. continue possono assumere qualsiasi valore in un insieme

continuo (es. intensità di uno stimolo acustico), le v. discrete o discontinue non

prevedono valori intermedi (es. il colore dei capelli).

Per quanto riguarda il ruolo delle variabili all’interno di un piano di ricerca,

bisogna distinguere tra v. indipendente (quella che lo sperimentatore controlla e

manipola direttamente) e v. dipendente (la misura del comportamento che e’

oggetto di studio).

Le variabili rimandano spesso a costrutti astratti (intelligenza, ansia, aggressività,

ecc.)

che

non

sono

direttamente

osservabili

ma

che

vengono

inferiti

dal

comportamento. La teoria di riferimento del ricercatore e le strategie che userà per

misurare i costrutti determineranno le modalità di operazionalizzazione delle

variabili (es. in uno studio sull’ansia da esame: se il ricercatore vuole dimostrare

che sostenere un esame provoca un aumento dell’ansia, l’operazione consiste nel

misurare il costrutto; se intende dimostrare che l’ansia influisce negativamente

sul risultato dell’esame, l’operazione consiste nel produrre il costrutto). La v.

indipendente può essere manipolata dal ricercatore. Ad es. se si studia il

comportamento a seguito dell’assunzione di un farmaco, si può dosare il farmaco

o decidere di somministrarlo solo ad alcuni soggetti. Vi sono però anche v.

indipendenti che non si possono manipolare, ma solo controllare (sesso, età, status

socio-economico, ecc.). In sintesi, la v. indipendente è un fattore di cui si vogliono

calcolare gli effetti.

2. LA MISURAZIONE

Le variabili si misurano in maniera diversa a seconda delle loro caratteristiche.

Le misurazioni possono essere più o meno accurate (se misuro l’ansia da esame e

divido gli studenti in due categorie, ad es. ansiosi e non ansiosi, ottengo

accorpamenti abbastanza grossolani, se invece li classifico in base al punteggio di

8

un test ottengo una quantità maggiore di informazioni; nel primo caso mi limito

a classificare, nel secondo effettuo una reale misurazione).

2.1. Le scale di misurazione

La quantità di informazioni che si può ottenere da una variabile dipende dal

tipo di scala di misurazione a cui appartiene. Stevens ha proposto di utilizzare 4

livelli di misurazione (scale):

1. scala nominale – classifica eventi e oggetti in categorie (es. settentrionalimeridionali). Alle categorie si

possono anche assegnare valori numerici, ma il

valore è nominale, non numerale.

2. scala ordinale – dispone gli oggetti e gli eventi in base alla loro grandezza, si

stila una graduatoria (es. una classifica del grado di simpatia dei colleghi). Gli

intervalli tra valori non sono regolari

3. scala a intervalli – gli intervalli tra i valori sono regolari, si stabilisce

convenzionalmente un punto zero da cui partire (es. la misuraz. del quoziente

intellettivo). Poiché lo zero non è assoluto non si può affermare però che un QI

140 sia il doppio di un QI 70.

4. scala a rapporti – e’ caratterizzata da un punto zero reale e da differenze

significative tra i valori numerici (es. il peso, la lunghezza, il tempo). Le

informazioni che si possono raccogliere con questa misurazione sono estremamente

dettagliate inoltre si può affermare che un individuo che ha un tempo di

reazione di 500 ms (millisecondi) impiega effettivamente il doppio del tempo di

un individuo che risponde in 250 ms.

3. OSSERVAZIONE E METODI OSSERVATIVI

La metodologia di ricerca si distingue in metodi sperimentali e metodi descrittivi.

Tra gli uni e gli altri cambia il controllo che il ricercatore esercita sulle variabili

e sui soggetti. L’ esperimento di laboratorio offre il grado più elevato di controllo,

ma non è sempre utilizzabile: a volte è fondamentale che i soggetti vengano

studiati in una situazione naturale (es. gli stili di conversazione dei giovani in

discoteca). L’osservazione è obiettiva nella misura in cui viene condotta secondo

procedure sistematiche, ripetibili e comunicabili. In quanto metodo di ricerca

implica la selezione di un fenomeno e la raccolta di informazioni più accurata

possibile.

Esistono

diversi

tipi

di

osservazione:

sul

campo,

ma

anche

in

laboratorio (si può scegliere di osservare un fenomeno in un ambiente artificiale);

può riguardare un’ampia gamma di fenomeni o aspetti specifici di un fenomeno.

La

caratteristica

fondamentale

è

la

rinuncia

al

controllo

delle

variabili

indipendenti attraverso la manipolazione sperimentale. L’osservazione può essere

naturalistica o partecipante a seconda che l’osservatore sia o meno presente nel

9

contesto osservativo. Nel primo caso è essenziale che l’osservatore non sia visibile

agli oggetti della sua osservazione (es. scimpanzé nel loro habitat naturale).

Numerosi esempi di osservazione naturalistica ci vengono dalla psicologia sociale

(vd. studi sul comportamento delle persone per strada) in cui è fondamentale la

non intrusività dell’osservatore e addirittura la sua capacità di “mimetizzarsi”

tra coloro che vuole osservare. Il metodo osservativo non si esaurisce comunque

nell’osservazione

raccolta

e

di

informale:

registrazione

il

ricercatore

dei

dati.

impiega

tecniche

Un’osservazione

sistematiche

accurata

richiede

di

la

definizione dell’oggetto di osservazione, ma anche l’individuazione di categorie di

comportamento che diventeranno focali nell’osservazione. Queste categorie devono

essere

il

più

possibile

specifiche

ed

esaustive

e

rispettare

il

principio

dell’esclusività (non devono sovrapporsi). Per es. per analizzare il comportamento

di un bimbo problematico a scuola, Thomas, Nielsen, Kypers e Becker hanno

utilizzato 9 categorie di comportamento (atteggiamenti scomposti, aggressività,

parlare, ecc.). L’aggressività è stata a sua volta definita come: colpire, spingere,

spintonare, pizzicare, schiaffeggiare, battere,ecc.

Il ricercatore deve poi stabilire il luogo, il numero, la durata delle sedute e la

frequenza con cui rilevare i comportamenti.

L’obiettività deve essere garantita dalla presenza di più osservatori indipendenti,

dall’uso

di

scale

di

valutazione

o

di

schede

di

osservazione

predefinite,

dall’utilizzo di strumenti tecnologici di rilevazione.

Il metodo osservativo presenta diversi limiti. Vasta ha analizzato le principali

fonti di errore, indicandone i correttivi: 1. la reattività dei soggetti (la tendenza a

comportarsi in maniera innaturale sapendo di essere osservati) si può risolvere

usando

metodi

di

osservazione

non

invasivi

(es.

telecamere

nascoste);

2.

l’osservatore e’ influenzato dal suo stile cognitivo, dalle sue caratteristiche

personali e dalle sue aspettative (che possono portarlo a dare maggiore rilievo agli

elementi che le confermano). Per risolvere questo problema colui che osserva non

deve essere al corrente delle ipotesi di ricerca (osservazione cieca). Inoltre e’ sempre

preferibile utilizzare più osservatori indipendenti e ritenere attendibili solo le

osservazioni per le quali vi sia un alto grado di concordanza (indice di

agreement).

4. L’ESPERIMENTO DI LABORATORIO

10

Il livello più accurato di osservazione è l’osservazione controllata, principio

cardine

del

metodo

scientifico.

La

migliore

applicazione

dell’osservazione

controllata si ottiene con l’esperimento di laboratorio in cui vi è la diretta

manipolazione della v. indipendente da parte del ricercatore (il ricercatore deve

dimostrare che la v. indipendente A è l’unica causa della v. dipendente B). In un

esperimento di laboratorio ciascun valore delle v. indipendenti si definisce

condizione sperimentale. Un es. di questo tipo di relazione tra le variabili è

l’esperimento di Schachter sulla relazione tra ansia e affiliazione. L’ipotesi di

partenza

era

che

gli

stati

d’ansia

favorissero

l’incremento

delle

tendenze

affiliative. Schachter indusse la variabile indipendente “ansia” nei soggetti

preannunciando la somministrazione di scosse elettriche e usò due condizioni

sperimentali, “alta ansia” e “bassa ansia”, dando ai due gruppi sottoposti

all’esperimento informazioni più o meno allarmanti. Poi informò i soggetti che

avrebbero potuto attendere l’inizio dell’esperimento in sale d’attesa separate o in

una sala comune e chiese loro di esprimere le loro preferenze su una scala a 5

punti, misurando in questo modo la tendenza affiliativa (v. dipendente).

Un altro esempio: un ricercatore vuole dimostrare che una determinata sostanza

chimica facilita l’apprendimento nei topi. Potrebbe individuare due condizioni

sperimentali come “basso dosaggio” e “alto dosaggio”. Più frequentemente però si

preferisce utilizzare un gruppo di controllo, somministrando il trattamento solo a

un gruppo (trattamento si/trattamento no). Perché l’esperimento riesca i due

gruppi devono avere le stesse caratteristiche, è necessario quindi fare molta

attenzione alla scelta dei soggetti.

4.1.

Il campione

Nella descrizione di una ricerca una sezione è sempre dedicata al campione sul

quale si è svolto lo studio: un insieme di elementi di un certo tipo selezionati da

un insieme più ampio, da una popolazione o universo (es. piloti d’aereo, studenti,

casalinghe, ecc.). L’esperimento di laboratorio richiede che vi sia un’assegnazione

casuale dei soggetti alle diverse condizioni sperimentali, per limitare gli errori (es.

nell’esperimento sull’apprendimento dei topi, se gli animali fossero prelevati da

due diversi recinti e assegnati rispettivamente alla prima e alla seconda

condizione sperimentale, il risultato potrebbe essere influenzato dalle diverse

condizioni di vita degli animali nei due recinti). Quindi per estrarre un

campione da una popolazione si selezionano casualmente alcuni suoi elementi.

4.2.

L’errore sperimentale

11

Si ha un errore sperimentale quando il mutamento della variabile dipendente è

causato da una qualsiasi altra variabile, diversa dalla v. indipendente (l’effetto si

ottiene, ma vi è confusione sulla causa). L’errore minaccia la validità interna

dell’esperimento, la certezza della relazione funzionale (di causa ed effetto) tra la

v. indipendente e la v. dipendente (es.: esperimento per valutare se le abilità di

calcolo di due gruppi di bambini di terza elementare possono essere incrementate

con un apposito training, in cui la variabile “giorno della settimana” si confonde

con la variabile indipendente – p. 47).

Esistono due strategie di controllo dell’errore: 1. il controllo – consiste nel tenere

costante la variabile parassita (es. sottoporre i due gruppi ai test di abilità nello

stesso giorno della settimana e orario); 2. la randomizzazione - assegnare

casualmente i soggetti alle diverse condizioni sperimentali, in questo modo

qualsiasi altra variabile verrà distribuita.

Tornando al controllo, bisogna considerare il controllo dell’errore dovuto alle

condizioni sperimentali. Se, per esempio, si deve testare l’efficacia di un

antidepressivo col metodo trattamento si/trattamento no, per evitare che il gruppo

sottoposto al trattamento sia soggetto all’autosuggestione bisogna dare a uno dei due

gruppi, a loro insaputa, un placebo. In questo modo l’autosuggestione interviene su

tutti e due i gruppi e abbiamo annullato il peso di questa variabile. Si tratta di

rendere ciechi i soggetti, non far sapere loro a quale condizione sperimentale sono

stati assegnati. Vi è però un'altra fonte di errore. Se il medico che assegna i

farmaci sa a chi somministra il farmaco e a chi il placebo, potrebbe avere un

atteggiamento diverso nei confronti degli uni e degli altri pazienti, suggestionando

a sua volta i pazienti. Ricorriamo allora al doppio cieco: nemmeno il medico deve

sapere se sta somministrando il farmaco vero o il placebo.

Con questi accorgimenti si annullano le fonti di errore nel caso in cui si lavori

con gruppi di soggetti indipendenti. Le cose si complicano se dobbiamo sottoporre

gli stessi soggetti a due compiti diversi: l’ordine di presentazione delle prove

potrebbe inquinare l’esperimento (es. pubblicità in cui si testano due prodotti).

Per evitare questo inconveniente si ricorre al bilanciamento del campione, si

varia cioè la successione dei compiti. Così si evitano, tra l’altro, le modificazioni

dell’attenzione dovute all’affaticamento.

Neutralizzando le variabili parassite, si assicura la validità interna di un

esperimento. Va considerata però anche la sua validità esterna, la possibilità cioè

di generalizzare i dati di una ricerca, di estendere i risultati ottenuti a contesti

più ampi (es. se si accerta che in un campione di studenti universitari esiste una

relazione causale tra ansia e affiliazione, ripetendo l’esperimento con altri gruppi

di soggetti – operai, casalinghe, ecc. – si deve riscontrare la stessa associazione

12

causale tra le variabili indipendenti e le variabili dipendenti considerate).

Accanto alla validità esterna, vanno segnalate la validità di costrutto, coerenza

tra il modello teorico di riferimento e l’interpretazione che il ricercatore da delle

relazioni causali osservate, e la validità statistica, che serve a stimare se e quanta

parte della relazione tra le due variabili sia causale o casuale (solitamente si

considera verificata un’ipotesi quando la probabilità di errore è inferiore al 5%).

4.3.

I quasi-esperimenti

Certe volte non è possibile manipolare la variabile indipendente o controllare

l’assegnazione casuale dei soggetti alle condizioni sperimentali. In questi casi si

parla di quasi-esperimenti: essi si richiamano al metodo sperimentale senza

soddisfarne tutte le esigenze di controllo. Per estensione rientrano in questa

categoria tutti gli esperimenti in cui non sia possibile controllare tutti gli aspetti

dell’esperimento stesso. Se, per esempio, si deve verificare l’efficacia di un certo

metodo di apprendimento sul ricordo della storia, si dovrà per forza utilizzare la

classe in cui è stato applicato e non si potrà scegliere un campione a caso. Negli

esperimenti sul campo spesso non si possono assegnare casualmente i soggetti alle

condizioni sperimentali e si svolgono dei quasi-esperimenti. Queste limitazioni

ricadono in genere sull’estendibilità dei risultati.

5. IL METODO DELL’INCHIESTA

Nell’ambito della ricerca non sperimentale occupa un posto a sé il metodo

dell’inchiesta. Questo metodo include varie tecniche di raccolta dei dati, in

particolare le interviste e i questionari. Rispetto all’osservazione o al metodo

sperimentale, l’inchiesta appare un percorso d’indagine meno tortuoso, anch’esso

però presenta vantaggi e svantaggi. Il ricercatore può raccogliere una grande

quantità di informazioni su campioni anche molto estesi in tempi relativamente

brevi. Tuttavia dovrà affrontare problematiche come il fattore di desiderabilità

sociale (tendenza dei soggetti a dichiarare ciò che è socialmente accettabile invece

del loro reale pensiero). Il ricercatore esperto è in grado di neutralizzare questa

insidia ricorrendo a una serie di accorgimenti a partire dalla costruzione degli

strumenti che utilizzerà.

5.1.

L’intervista

Le interviste possono essere classificate come strutturate (o standardizzate), semistrutturate e non strutturate. Nel primo caso, l’’intervistatore deve porre le

domande così come sono formulate nel modulo e rispettarne la successione. Nel

secondo, l’intervistatore è tenuto a fare un certo numero di domande specifiche,

13

ma può anche porne delle altre se questo è funzionale ad una migliore

comprensione delle dichiarazioni dell’intervistato. Nell’intervista non strutturata

il ricercatore dispone di uno schema guida, ma può introdurre tutte le variazioni

che ritiene opportune.

L’intervista strutturata consente di ottenere risultati più omogenei e comparabili,

anche a distanza di tempo. Al polo opposto si colloca l’intervista non strutturata

che rappresenta però un utile strumento nelle mani di un ricercatore esperto, le

risposte del soggetto possono infatti costituire degli spunti per indirizzare la

ricerca in una direzione più interessante o per approfondire determinati aspetti.

Una

particolare

modalità

di

intervista

è

il

metodo

clinico.

Si

tratta

di

un’interazione verbale “a catena” tra lo sperimentatore e il soggetto: il primo

inizia ponendo una domanda e ciò che chiederà successivamente dipenderà dalla

risposta del soggetto (metodo ampiamente utilizzato da Piaget coi bambini). Questa

procedura

mira

non

comprendere il come,

tanto

a

registrare

la

prestazione

del

soggetto,

ma a

quali sono i processi mentali che lo inducono a scegliere

un percorso solutorio e non un altro.

La scelta di un tipo di intervista rispetto ad un altro dipende da diversi fattori:

gli obiettivi che il ricercatore si pone, la complessità del fenomeno analizzato, il

gusto personale del ricercatore.

In ogni caso, è di fondamentale importanza valutare e minimizzare gli effetti che

la situazione o l’intervistatore possono esercitare sul soggetto. La “desiderabilità

sociale” non è l’unico fattore che può compromettere l’autenticità dei risultati di

un’intervista. Un altro problema può essere la relazione che si stabilisce tra

l’intervistato e l’intervistatore: il primo tenderà a cogliere ogni segnale di

approvazione o disapprovazione dell’intervistatore e a porre a sua volta domande.

L’intervistatore dovrà quindi evitare di essere eccessivamente espressivo, ma non

dovrà nemmeno tenere un atteggiamento troppo riservato, che potrebbe demotivare

l’intervistato. È bene inoltre che l’intervistatore tenga celato il suo punto di vista

personale. Pur nel rispetto di queste norme di base, l’intervistatore deve apparire

abbastanza spigliato.

Un altro aspetto importante è la modalità di registrazione dei dati: in alcuni casi

si trascrivono semplicemente i dati salienti delle risposte; in altri si può

utilizzare un registratore o una telecamera. L’uso di questi dispositivi non sempre

è ben accetto da parte degli intervistati. Laddove sia possibile farvi ricorso, questi

strumenti

si

rivelano

preziosi

perché

permettono

di

cogliere

intonazioni,

sfumature e enfasi (ma anche espressioni e posture nel caso della telecamera), e di

stimare pause e incertezze dei soggetti.

14

5.2.

Il questionario

Il questionario è un elenco di domande scritte che possono essere divise in due

grandi categorie: domande aperte (non hanno risposte prefissate) e domande

chiuse (si deve scegliere tra un certo numero di domande prefissate). Spesso i

questionari contengono entrambi i tipi di domanda.

La selezione delle domande da inserire in questionario deve rispettare una serie

di requisiti:

1. evitare le domande doppie - ogni domanda deve contenere un solo quesito

(chiedere di rispondere con un “si” o con un “no” alla domanda “Lei

ritiene che i suoi professori siano competenti e disponibili?” sarebbe un

errore, i quesiti andrebbero distribuiti su due domande).

2. non inserire domande che possano influenzare il soggetto ed evitare i

termini che non tutti conoscono.

3. per quanto riguarda le domande chiuse, le varie alternative devono essere

diverse

l’una

dall’altra

e

coprire

tutte

le

possibilità

(es.

studente-

lavoratore).

Per la formulazione delle domande chiuse si possono usare, oltre alle scale

nominali, le scale ordinali. Spesso infatti i questionari contengono affermazioni

rispetto alle quali il soggetto deve esprimere la sua posizione. A seconda che il

ricercatore voglia sondare abitudini, atteggiamenti o opinioni userà modalità di

risposta riguardanti, ad esempio, la frequenza (“spesso”, “qualche volta”, “quasi

mai”) oppure l’accordo/disaccordo.

Uno dei metodi più usati per la misurazione degli atteggiamenti è la scala Likert,

che consente di misurare non solo la direzione di un’opinione e di un

atteggiamento (es. favorevole o contrario), ma anche la sua intensità (usando una

scala a 5 o a 7 punti che preveda le posizioni intermedie tra i due poli

“favorevole”/”contrario” e tenga conto anche delle posizioni neutrali: -3 -2 -1

0 +1 +2 +3).

Affinché un questionario sia ben fatto, non solo le domande che lo compongono

devono essere formulate in maniera univoca

e precisa, ma devono essere ben

esplicitate le istruzioni per la sua compilazione.

6. IL METODO DEI TEST

Il test psicologico è uno strumento di misura che comprende prove di diversa

natura che consentono di ottenere una misura o almeno delle indicazioni su una

o più caratteristiche del soggetto. A. Anastasi lo definisce una “misurazione

obiettiva e standardizzata di un campione di comportamento”. Un test risponde al

requisito

dell’obiettività

se

la

sua

somministrazione,

la

determinazione

15

e

l’interpretazione dei punteggi prescindono dal giudizio soggettivo di chi lo

somministra. La standardizzazione si riferisce all’uniformità delle prove, delle

condizioni

di

somministrazione

e

delle

procedure

di

determinazione

del

punteggio. I test devono inoltre essere sensibili, ossia possedere la capacità di

differenziare i soggetti in base a quello che stanno misurando (così come un

termometro deve essere in grado di distinguere i soggetti che hanno la febbre da

quelli che hanno una temperatura nella norma). Un test deve essere fedele (se

ripetuto nelle stesse condizioni e con gli stessi soggetti deve dare risultati molto

simili. Un ultimo requisito di un test deve essere la validità. La validità può

essere di diversi tipi: a. la validità di contenuto, garantita da una corretta

campionatura del contenuto (es. un professore che voglia testare la preparazione

degli alunni alla fine del corso deve dare lo stesso spazio a tutti gli argomenti

trattati); b. la validità in rapporto al criterio o validità predittiva: per valutare la

capacità di un test di predire il comportamento di un individuo in determinate

situazioni, si assume come termine di paragone un criterio, una misura diretta e

indipendente di ciò che si vuole testare (es. in un test sul rendimento scolastico si

possono adottare come criterio le votazioni che gli studenti riporteranno alla fine

dell’anno), maggiore sarà la corrispondenza tra il risultato del test

e il criterio,

più elevata risulterà la capacità predittiva del test; c. la validità concorrente: in

questo caso si mettono in relazione i risultati del test con quelli riportati dai

soggetti in altre prove che misurino lo stesso attributo (es. test sulla cecità per i

colori confrontato coi risultati di esami oculistici).

Per quanto riguarda i tipi di test, bisogna innanzitutto distinguere tra i test

individuali e quelli collettivi. Esistono poi test che servono a misurare abilità

specifiche: test di profitto scolastico, di personalità, ecc.

Oltre che per le finalità i test si differenziano per il formato, molti sono del tipo

“carta e matita”, ma ci sono anche quelli che richiedono l’impiego e/o la

manipolazione di materiali particolari (disegni, fotografie, cubi colorati, ecc.) o

l’uso di apparecchiature specifiche.

Uno stesso test può comportare prove di vario genere e l’impiego di differenti

materiali. Analogamente uno stesso attributo può essere valutato ricorrendo a

tecniche differenti.

3.LA PERCEZIONE

16

Quale fiducia dare agli organi di senso e alla percezione, che si fonda sui dati da

essi rilevati?

Si tratta di un problema presente dal '600 (dalla nascita della scienza moderna

con Galileo). Sappiamo che i dati sensoriali non sono sempre veridici, ci sono

infedeltà percettive, distorsioni, mancate corrispondenze. Questa constatazione può

condurre ad una svalutazione dell'attività percettiva a causa di una falsa

impostazione del problema: ritenere cioè che lo scopo della percezione sia la

registrazione accurata di ciò che è presente nel mondo. Il problema si risolve a

favore della fiducia nella percezione se la si considera come un complesso

meccanismo, preposto alla raccolta ed elaborazione, in tempi molto brevi, di una

grande quantità di informazioni utili e/o necessarie al sistema cognitivo e a

quello motorio per raggiungere i loro obiettivi, prima di tutto quello della

sopravvivenza.

La percezione è costituita da un insieme concatenato di processi di raccolta,

elaborazione, trasformazione e organizzazione delle informazioni disponibili

nell’ambiente. L’interazione

col mondo

è

possibile

solo

attraverso l’attività

percettiva e questa può aver luogo solo se vi è la presenza contemporanea di 3

condizioni:

1. un pezzo di mondo che emetta e/o rifletta qualche tipo di energia: stimolo

distale

2. un tipo di energia che sia in grado di modificare gli organi sensoriali di un

essere vivente: stimolo

prossimale (stimolazione dei recettori sensoriali periferici)

3.un sistema di elaborazione che sia in grado di decodificare e interpretare le

modificazioni che l’energia ha

prodotto

negli

organi

di

registrazione

sensoriale:

percetto

(frutto

dell’elaborazione finale);

L’insieme dei percetti costituisce il nostro mondo fenomenico, che si distingue da

quello fisico (es. nel modo fisico il sole sta fermo e la terra si muove, nel mondo

fenomenico è il sole che sorge e tramonta).

3. ENERGIA E SENSAZIONE: LA PSICOFISICA

Il mediatore fra gli stati del mondo esterno e la nostra conoscenza di esso è

l’energia a cui il sistema percettivo è sensibile. Uno dei primi argomenti affrontati

dalla psicologia sperimentale fu lo studio delle relazioni che si instaurano tra

l’intensità dell’energia che colpisce gli organi di senso e l’intensità dell’esperienza

sensoriale del percipiente. Theodor Fechner definì “psicofisica” la disciplina che

studia il rapporto fra il mondo degli stimoli fisici e quello delle esperienze

17

psicologiche da essi prodotte. Prima di Fechner, era stato Weber a rendersi conto

che il modificarsi della quantità di energia che colpisce gli organi di senso non

produce una modificazione equivalente della sensazione e che quest’ultima non

dipende

solo

dal

modificarsi

dell’intensità

dello

stimolo,

ma

dal

livello

complessivo di energia che colpisce l’organo di senso in un dato momento (es.

lampadina da 10w in una stanza molto scura). La relazione tra intensità dello

stimolo e intensità della relazione non è lineare.

Per misurare le sensazioni, la psicofisica utilizza due criteri di misura: la soglia

assoluta - quantità minima di energia necessaria per produrre una sensazione - e

la soglia differenziale o differenza appena percepibile - variazione che deve

subire l’intensità di uno stimolo perché un soggetto ne colga il cambiamento.

Visto che la valutazione delle soglie è soggetta a oscillazioni e interferenze, in

entrambi i casi si è stabilito che la misura sia data dal valore che viene

riconosciuto mediamente 50 volte su 100.

La differenza appena percepibile è una costante, che ha un valore specifico per

ogni modalità sensoriale (Costante di Weber), e che misura l'intensità di uno

stimolo dicendoci di quanto esso deve variare per essere percepito come diverso da

un altro (ad esempio per la pesantezza è 0.02).

La Costante di Weber non ci dice nulla però sulla variazione della sensazione.

Fechner scoprì che tra l'intensità dello stimolo e quella della sensazione vi è una

relazione per cui dall'una si può ricavare l'altra. Questa relazione è espressa

dalla formula: S = C log I (S= sensazione; C= costante relativa alla modalità

sensoriale considerata; log, logaritmo;

I= misura fisica dell’intensità dello

stimolo).

Stevens ha poi dimostrato che è possibile far valutare direttamente l’intensità

delle sensazioni alle persone chiedendo loro di associare una sensazione con un

numero.

Il

metodo

della

Magnitudo

Estimation

consiste

nell’assegnare

convenzionalmente un valore numerico ad uno stimolo e, aumentando lo stimolo,

chiedere al soggetto di valutare la nuova intensità in rapporto alla prima.

4. INFORMAZIONE E ATTIVITA’ PERCETTIVA

Gli studi di psicofisica indagano i rapporti tra il mediatore energetico che riflette

lo stato del mondo osservato e gli organi di senso attivati da quel mediatore.

L’atto percettivo è il primo livello di interazione fra individuo e ambiente e ci

rende consapevoli non solo delle caratteristiche strutturali delle cose (forma,

dimensione, volume, posizione, ecc.), ma anche di aspetti del loro modo di essere

rispetto a noi (pericolosità, aggressività, disponibilità, attrazione, ripugnanza,

ecc.).

18

Nel caso della visione, il mediatore è la luce. Ad oggi sul problema di come la

luce riesca a dar conto di aspetti della realtà così numerosi e diversi sono state

avanzate solo delle risposte limitate e parziali.

Sappiamo che il mediatore energetico, attraverso le sue modulazioni ordinate e

mai casuali, veicola informazione (ogni aumento di conoscenza con relativa

diminuzione

dell’incertezza).

L’attività

percettiva

raccoglie,

da

una

stessa

porzione di realtà, informazioni diverse, spesso indipendenti tra loro, al servizio

di due processi fondamentali della nostra vita: l’attività cognitiva e l’attività

motoria.

4.1. Quale informazione: dieci casi

Il nostro sistema percettivo procede in modo veloce e automatico, il più delle volte

senza che ne diventiamo consapevoli, alla selezione dell’informazione. Questo

modo di procedere rende impossibile stabilire a priori che cosa sia informativo e

in che misura lo sia. È quindi necessario predisporre delle condizioni osservative

controllate per capire quali elementi informativi il sistema percettivo estragga di

volta in volta. Stabilendo per convenzione che un cerchietto bianco su una

superficie nera sia il primo livello dell’attività percettiva da cui si intende

partire, si apportano modifiche progressive per verificare in che modo il nostro

vissuto percettivo muti dopo ogni intervento:

1. presenza di un punto: su una superficie di colore uniforme si inserisce un

pallino di colore diverso. Il rendimento percettivo è un pallino chiaro su una

superficie scura;

2. aggregazione di base: aggiungendo a caso un altro pallino, i due cerchietti

tendono a non essere visti come entità del tutto separate, ma come una coppia;

3. movimento apparente: se invece dei due pallini ci sono due punti luminosi,

uno acceso e l’altro spento, spegnendo il primo e accendendo il secondo in un

brevissimo intervallo di tempo, il rendimento percettivo sarà il movimento del

primo pallino, non lo spegnersi del primo e l’accendersi successivo dell’altro

(informazione percettiva di movimento);

4. distanza percepita in funzione della grandezza: modificando il diametro di

uno dei 2 cerchi, si percepiranno 2 cerchi di misura diversa o 2 cerchi posti a

distanze diverse (informazione di distanza);

5. posizione non ordinata di punti e 1° livello di organizzazione: se su piano

nero si dispongono 4 pallini in ordine sparso, vedremo 4 pallini disposti

casualmente. Se però i pallini vengono allineati a 2 a 2 ed equidistanti sia

verticalmente che orizzontalmente, si vedranno i 4 punti collegati tra loro in

una forma (informazione di forma);

19

6. vincolo della vicinanza ordinata: aggiungendo alla figura precedente altri

dodici pallini, allineati in 4 righe e 4 colonne, la forma quadrata appare più

strutturata e unitaria (informazione di forma);

7. vicinanza, coesione e segregazione: se raddoppio la distanza tra le colonne

della figura precedente e dimezzo quella fra le righe, si percepiranno 4

colonne indipendenti in luogo del quadrato (la vicinanza degli elementi

veicola

un’informazione

di

appartenenza

di

un

elemento

ad

una

configurazione unitaria);

8. dalla superficie fronto-parallela alla profondità spaziale: partendo dalla

figura del punto 6 e riducendo in stadi progressivi la lunghezza di ogni riga di

un valore costante, la distanza tra le righe in modo progressivo dal basso verso

l’alto e nello stesso modo la misura dei pallini, otterrò la percezione di una

superficie di pallini bianchi sempre più inclinata in profondità (il “gradiente

di

tessitura”

informa

sull’inclinazione

di

una

superficie

nella

terza

dimensione);

9. eguaglianza fisica ed eguaglianza fenomenica: in una griglia costituita

dall’alternanza di fasce orizzontali bianche e nere dello stesso spessore

dispongo 4 serie di cerchietti della stessa tonalità di grigio, disposti a sinistra

sulle fasce nere e a destra su quelle bianche. Pur essendo dello stesso colore, i

cerchietti di sinistra appaiono di un grigio meno intenso (l’informazione in

base alla quale viene percepito un colore dipende dalla scena);

10. percezione della quantità in funzione dello spazio occupato: se dispongo 16

segmenti, fra loro paralleli ed equidistanti, in colonna su una superficie

accanto ad altri sedici segmenti uguali, ma disposti lungo una linea inclinata

di 45°, quelli inclinati appariranno più numerosi di quelli incolonnati

(l’informazione sul numero degli elementi di una collettività dipende dalla

loro distribuzione nello spazio).

Nella maggior parte dei casi descritti il rendimento percettivo fa riferimento a

delle caratteristiche della figura che non emergono dalla sua descrizione fisicogeometrica e perciò si deve ritenere che sia frutto del lavoro di elaborazione e

organizzazione dell’attività percettiva. In ognuno degli esempi riportati si è

instaurato

qualche

tipo

di

legame

tra

gli

elementi

della

configurazione:

l’informazione non risiede negli elementi di una scena, ma nelle relazioni che si

istituiscono fra gli elementi e fra le loro caratteristiche.

4.2. Altre informazioni, altre relazioni

Chiusura: se in uno spazio rettangolare traccio 4 segmenti indipendenti questi

non provocheranno un mutamento della percezione di quello spazio. Se unisco i

20

quattro segmenti formando un quadrilatero, lo spazio verrà percepito in modo

diverso: da una parte dei segmenti la superficie appartiene al rettangolo

includente, dall’altra al poligono incluso che appare sopra al rettangolo. Il

“chiudersi” del contorno del quadrilatero ha prodotto una separazione e una

duplicazione dello spazio da esso racchiuso che copre quello del rettangolo

sottostante. Il quadrilatero si separa dal rettangolo sfondo e il margine appartiene

sempre

e solo alla figura, non delimita un foro nel rettangolo. Affinché il

contorno del poligono definisca un buco nel rettangolo bisogna far riferimento a

un alto fenomeno percettivo: il completamento amodale. Se aggiungo alle due

figure due trapezi (fig. 13 p. 77) uno all’esterno del rettangolo ed uno all’interno

del quadrilatero, allineati in posizione tale da dare l’impressione di “continuare

sotto”, in base al principio della “buona continuazione”, il rendimento percettivo

sarà una figura che si unisce sotto alla superficie rettangolare originaria che a

questo punto risulterà bucata.

Un altro esempio di completamento amodale, associato alla buona continuazione,

è costituito dalle linee di un intreccio (fig. 16 p. 81)

La

buona

continuazione

o

“continuità

direzionale

è

uno

dei

fattori

di

organizzazione figurale individuati nell’ambito della psicologia della Gestalt da

Max Wertheimer, che da lui prendono il nome di “fattori di Wertheimer (altri

sono la vicinanza e la chiusura).

5. INDETERMINAZIONE GEOMETRICA E DETERMINATEZZA VISIVA

La figura 17a veicola, da un punto di vista geometrico, una figura ambigua:

potrebbe essere costituita da una losanga posta su un rettangolo oppure da due

poligoni concavi accostati. Per il sistema percettivo vi è invece solo la prima

possibilità. Si tratta di un caso di indeterminazione geometrica, ma non

percettiva.

Il rendimento geometrico di una qualsiasi porzione di realtà osservata potrebbe

essere, dal punto di vista geometrico, il risultato di molteplici aggregazioni diverse

degli elementi presenti. Il più delle volte però il nostro vissuto è unico. Parliamo

invece di figure ambigue quando il sistema percettivo non riesce a decidere quale

delle due o più soluzioni possibili accettare in modo definitivo (gli esempi di

figure ambigue sono molti: forme bianche su sfondo nero – fig. 19; il cubo di

Necker – fig. 20; coppa e profili – fig. 21; ballerini e ballerine – fig. 22;

ambiguità di figure non significative – fig. 23; moglie e suocera – fig. 24; papero

e coniglio – fig. 25). Le figure ambigue costituiscono una dimostrazione che

l’attività percettiva è un processo attivo, in cui l’elaborazione delle informazioni

continua anche dopo il raggiungimento di un primo rendimento accettabile. A

21

fronte di una stessa condizione stimolatoria, si generano sul versante percettivo

due o più rendimenti fra loro alternativi e sempre ben strutturati. È lecito pensare

che il modo di presentarsi dei dati osservati attivi più di un’elaborazione

percettiva.

6. LA FIGURA IN RAPPORTO CON L’AMBIENTE CIRCOSTANTE

Ogni oggetto nell’ambiente naturale è di solito inserito in un contesto di

riferimento che ne definisce posizione, orientamento e dimensioni. La fig. 26 è un

chiaro esempio di come l’attività percettiva tenga conto innanzitutto delle

relazioni intercorrenti fra ogni oggetto presente in una scena e la scena nel suo

insieme.

7. FATTORI FORMALI E TESTO SCRITTO

Nei testi scritti le lettere si susseguono da sinistra a destra raggruppandosi e

separandosi per formare le parole, ma anche per facilitare e accelerare la lettura.

Qualsiasi affaticamento percettivo sottrae risorse al processo di comprensione. È

per questo che i caratteri devono essere chiari, simili tra loro, ben allineati ed

opportunamente distanziati. La scrittura rispetta le proprietà formali che sono

alla base dell’organizzazione visiva, primi fra tutti i fattori di vicinanza,

somiglianza e continuità di direzione (un es. del ruolo dei fattori formali nella

lettura di un testo è dato nella figura 27).

8. NASCONDERE, MOSTRARSI

I processi di unificazione-separazione su cui si basa l’organizzazione del nostro

mondo visivo, che rendono individuabili gli oggetti separandoli dallo sfondo,

possono anche funzionare al contrario, rendendo impossibile o difficoltoso il loro

riconoscimento. Ne abbiamo svariati esempi nel mondo animale, dove la vita di

un animale nel proprio ambiente può dipendere, a seconda delle circostanze, dal

suo essere chiaramente visibile (accoppiamento) o completamente invisibile

(ricerca del cibo). Entrambi gli obiettivi si ottengono grazie al funzionamento

degli stessi processi percettivi, innanzitutto in base alla relazione della figura con

lo sfondo.

In ambito psicologico i primi esperimenti sul mascheramento vennero fatti da

Gottschaldt e successivamente da Kanizsa e da Vicario (fig. 29, 30 e 31). Tali

esperimenti mettono in evidenza che affinché si produca un mascheramento è

necessario che alcune delle caratteristiche figurali salienti entrino a far parte di

un’altra figura diversamente organizzata.

22

Il mimetismo animale obbedisce agli stessi principi che rendono possibile il

mascheramento

di

figure

astratte:

i

fattori

di

organizzazione

figurale

e

l’articolazione figura-sfondo.

9. PERCEPIRE LA PROFONDITA’ E LA TRIDIMENSIONALITA’

Noi vediamo il distribuirsi di persone e cose nello spazio a distanze diverse

(ampio repertorio di metafore spaziali) e siamo certi di riuscire a valutare

distanze, posizioni, direzioni e orientamenti. L’ambiente naturale ci appare

abbastanza stabile e ben strutturato. Tuttavia il funzionamento della percezione

della

profondità

spaziale

ha

sempre

posto

notevoli

problemi,

a

partire

dall’individuazione delle informazioni utilizzate.

Il primo scoglio è quello della registrazione degli stimoli. I recettori retinici sono i

bastoncelli

e

i

coni.

I

primi

funzionano

bene

anche

a

bassi

livelli

di

illuminazione, ma sono poco sensibili ai colori. I secondi funzionano bene solo in

condizioni di buona illuminazione e sono sensibili ai mutamenti cromatici.

Questi fotorecettori vengono attivati nello stesso modo dalla luce riflessa da oggetti

vicini o lontani. Si pone quindi il problema di come venga recuperata, nel

rendimento percettivo, la profondità spaziale. Le soluzioni emerse si rifanno a

due distinti ambiti teorici, quello definito “percezione indiretta” e quello

definito “percezione diretta”.

9.1. Percezione diretta e percezione indiretta

Berkeley, primo sostenitore della percezione indiretta, riteneva che la percezione

della

profondità

spaziale

dipendesse

dall’integrazione

dei

dati

visivi

bidimensionali con le conoscenze acquisite attraverso altre modalità quali il tatto

e il movimento.

Herman von Helmholtz definì inferenza inconscia quel processo che, sulla base

dell’esperienza passata e delle conoscenze acquisite, supplisce i dati incompleti

raccolti dagli organi di senso.

I fautori della percezione diretta si rifanno all’orientamento ecologico di Gibson

secondo il quale l’occhio raccoglie tutta l’informazione necessaria per raggiungere

una percezione esauriente dell’ambiente. Questa concezione si basa sull’idea che

la

luce

deve

essere

considerata un

veicolo strutturato

e

ben

ordinato di

informazione. La luce riflessa dagli oggetti e dalle superfici converge negli occhi

dell’osservatore in un fascio di raggi che formano angoli la cui ampiezza varia in

funzione della distanza e della posizione delle superfici da cui provengono.

L’insieme di questi angoli è definito assetto ottico (una fotografia in prospettiva è

un esempio del fatto che anche su un piano bidimensionale possono essere

23

presenti

informazioni

di

profondità

spaziale).

Quando

all’assetto

ottico

si

accompagna il movimento si parla di flusso ottico (gli angoli ce si formano tra i

raggi riflessi dalla scena e convergono nell’occhio di chi guarda si modificano in

continuazione in maniera ordinata e coerente e quindi informativa).

Un altro approccio allo studio della percezione visiva diretta è il modello

computazionale di David Marr. Egli riteneva che la visione fosse un processo

attivato attraverso diversi stadi di processamento dell’informazione luminosa.

Fondamentale in questa sequenza è l’identificazione dell’oggetto osservato che

inizia col riconoscimento dei suoi margini. I margini però, nel processo visivo,

cambiano e si spostano continuamente, a causa del mutare dell’illuminazione e

della posizione di chi sta guardando. Per determinare la forma reale di un oggetto

il sistema visivo deve essere in grado di ignorare i margini creati dalle ombre o

dalle variazioni di illuminazione e considerare solo i margini “veri”. Per far ciò

deve analizzare in tempo reale i cambiamenti attraverso processi computazionali

complessi. Il metodo di Marr si basa quindi su un modello di analisi matematica

delle variazioni di luce e ombra all’interno della scena visiva.

L’estrazione delle caratteristiche “margini” da un oggetto avviene anche servendosi

di proprietà visive dell’oggetto racchiuse dentro ai margini (zone chiare o scure,

tessitura della superficie, convessità, ecc.)

9.2. Gli indici della profondità

Gli indici della profondità sono tutti i dati che contribuiscono a determinare il

rendimento percettivo di profondità spaziale nella terza dimensione. Questi dati

possono dipendere dal funzionamento degli organi visivi, dalla struttura della

scena o dell’oggetto osservato, dalle condizioni di osservazione.

Gli indici di profondità che dipendono dagli organi visivi sono: accomodazione,

convergenza e disparità binoculare. L’accomodazione è il processo attraverso cui

viene modificata la curvatura del cristallino per consentire la messa a fuoco di

oggetti che si trovano a distanze diverse dall’osservatore. Durante questo processo

avviene anche la convergenza, ossia la rotazione degli occhi nella loro orbita, in

modo da puntare entrambi sull’oggetto osservato. Gli sforzi muscolari per regolare

la curvatura del cristallino e la convergenza costituiscono l’informazione sulla

distanza dell’oggetto osservato.

La disparità binoculare da luogo, a livello cerebrale, alla fusione in un’unica

immagine (stereopsi) delle due immagini, leggermente diverse, registrate da

ciascun occhio producendo una dislocazione in profondità.

24

9.3. Gli indici pittorici della profondità

Le informazioni sulla profondità spaziale si trovano anche nella struttura

dell’oggetto osservato. Si tratta degli indici pittorici di profondità (usati dagli

artisti per produrre effetti di tridimensionalità e profondità):

1. interposizione, anche detta sovrapposizione o occlusione, si ottiene frapponendo

un oggetto tra

l’osservatore e un altro oggetto più lontano, di cui

nasconde una parte del contorno;

2. altezza nel campo visivo: ciò che si trova nella parte superiore del campo visivo

sembra più lontano;

3. orientamento delle ombre (oltre alle ombre proprie di un oggetto vi sono anche

le ombre portate, le ombre di un oggetto che la luce proietta su un altro oggetto);

4. prospettiva lineare e prospettiva aerea: si tratta, più che di un singolo indice,

di un sistema organico di accorgimenti e di regole geometriche che utilizza le

informazioni determinanti per la rappresentazione della profondità spaziale

(fig. 35: le linee parallele in profondità convergono verso un unico punto, l

grandezza relativa di archi e colonne decresce progressivamente, il gradiente di

tessitura del pavimento s’infittisce verso il fondo, così come si riduce la

distanza tra le colonne, gli archi più lontani sono disegnati con tratto leggero e

non ben definito);

5. grandezza relativa: gli oggetti più piccoli vengono considerati più lontani;

6. gradiente di tessitura: la microstruttura di ogni superficie riflette la luce in

modo diverso (sistematicamente e progressivamente più densa quanto più

lontana da chi guarda) a seconda del suo orientamento in profondità (fig. 36)

10. LE COSTANZE PERCETTIVE

Meccanismi di costanza sono stati chiamati quei processi che contribuiscono a

mantenere fenomenicamente immutate le caratteristiche degli oggetti (dimensioni,

forma, colore) nonostante le continue variazioni delle loro registrazioni ottiche. Ci

sono solo delle ipotesi sul loro funzionamento, ma è sempre più diffusa l’idea che

siano meccanismi iscritti nel nostro patrimonio genetico e non appresi.

Costanza di grandezza: quando ci avviciniamo o ci allontaniamo dalle cose le

dimensioni delle loro percezioni retiniche variano (fig. 37), noi però percepiamo

immutata la dimensione degli oggetti. Questo grazie ad un processo per effetto del

quale le variazioni registrate di grandezza sono viste come variazioni di distanza,

mentre la grandezza percepita rimane la stessa.

Per studiare quali siano le informazioni utilizzate dai meccanismi di costanza,

Holway e Boring condussero un esperimento: l’osservatore era posto all’intersezione

di due lunghi corridoi; un disco modificabile era posto a circa tre metri

25

dall’osservatore in uno dei due corridoi, mentre nell’altro corridoio venivano

disposti dei dischi standard a distanze comprese fra i 3 e i 36 metri; i dischi

standard a maggior distanza erano più grandi, in modo da proiettare sempre la

stessa immagine retinica; il compito del soggetto era di aggiustare le dimensioni

del disco di confronto fino a farlo diventare delle stesse dimensioni di quello

standard.

Le valutazioni erano state fatte in diverse condizioni ambientali (disponibilità di

informazioni ambientali più o meno ampia) e i risultati misero in evidenza che

una drastica perdita di informazione ambientale riduce l’efficacia dei processi di

costanza e obbliga l’osservatore a dare maggior credito alla grandezza retinica.

Il risultato dell’esperimento mette quindi in evidenza la stretta relazione tra i

processi di costanza e la disponibilità di informazione ambientale.

Gli oggetti non verrebbero quindi visti come indipendenti gli uni dagli altri: il

sistema percettivo tiene conto,più che dei dati assoluti, delle relazioni che si

determinano fra le parti di una scena (fig. 38).

Costanza di forma: riguarda quei processi in cui i mutamenti di forma non

vengono visti come tali, ma come cambiamenti di orientamento dell’oggetto.

I processi di costanza sono collegati tra loro e funzionano nello stesso modo, resta

da indagare dove risieda l’informazione utilizzata dal sistema percettivo. Un

modo per ricavarla è l’analisi dell’indeterminazione ottica: la stessa proiezione

retinica può essere prodotta da un numero praticamente infinito di forme diverse

sottese allo stesso angolo visivo (fig. 39). Quasi sempre però il rendimento percettivo

è uno solo: viene vista la forma più semplice e lineare.

11. PERCEPIRE PER AGIRE E CONOSCERE

Gli occhi si muovono continuamente anche indipendentemente dal nostro volere.

Ciò che avviene sulla nostra retina è un susseguirsi di modificazioni instabili.

Nonostante ciò gli oggetti e gli ambienti ci appaiono stabili.

Oltre ai movimenti del nostro corpo, la retina registra anche il movimento degli

oggetti. Bisogna allora determinare quali i processi ci consentono di discriminare

le trasformazioni che avvengono sulla retina per effetto degli spostamenti

dell’osservatore e quelli dovuti alla dinamica degli oggetti. L’ipotesi è che esista un

centro che controlla la corrispondenza fra le variazioni della stimolazione

retinica che ci si deve aspettare in seguito ai movimenti del nostro corpo e quella

che effettivamente si sta verificando. Nel caso in cui vi sia corrispondenza, il

centro di controllo annulla le informazioni di movimento e la scena appare

statica.

26

Recentemente ci si è resi conto che lo scopo dell’attività percettiva non è solo

quello di raccogliere informazioni cognitivamente utili. La percezione deve

assolvere a due funzioni diverse e complementari: raccogliere ed elaborare

informazioni necessarie sia al sistema cognitivo che al sistema motorio.

L’idea di una differente elaborazione dell’informazione visiva in funzione dello

scopo è stata confermata da alcune ricerche neuropsicologiche che hanno scoperto

l’esistenza

di

due

sistemi

funzionalmente

distinti

per

la

trasformazione

dell’informazione spaziale.

12-13. VEDERE IL MOVIMENTO: IL MOVIMENTO APPARENTE E IL MOVIMENTO

INDOTTO

La capacità di percepire il movimento è fondamentale per la sopravvivenza ed è

una delle competenze più precoci sia nei bambini che nei cuccioli di molte specie

animali. Resta tuttavia da spiegare che cosa vediamo del movimento. Sappiamo

che per la percezione gioca un ruolo fondamentale la relazione tra l’oggetto

osservato e l’ambiente. Quest’idea dovrebbe valere in modo particolare per il

movimento, dal momento che non esiste il movimento in sé, ma sempre in

relazione a qualcosa che rimane fermo.

Movimento apparente o stroboscopio: una serie di accadimenti vengono visti come

movimento quando l’accensione e l’estinzione di due punti luminosi avviene in

un ambito di precisi rapporti di spazio, di tempo e di energia. Gli esperimenti di

Ternus (fig. 40 e 41) mettono in luce come l’attività percettiva tenda a conservare

il più possibile la

stabilità

di un

ambiente in

cui

avvengono continue

trasformazioni e spostamenti.

Il movimento indotto si verifica quando il movimento di un elemento della scena

osservata viene attribuito ad un altro elemento (fig. 42). Ciò accade, secondo

Duncker, perché l’attività percettiva opera una separazione dei sistemi. Il

movimento percepito dipenderà dalla relazione che ogni oggetto intrattiene con

quella parte di scena che assume il ruolo di schema di riferimento. Lo schema di

riferimento è sempre la regione più grande e includente e automaticamente viene

assunto come maggiormente stabile (es. il sorgere e tramontare del sole).

14. LA LUCE, IL COLORE: POCHI ACCENNI

Alcuni aspetti della percezione di luce e colore (colore acromatico):

1.

la luce: una piccola porzione del vasto spettro delle onde elettromagnetiche è

visibile e noi la chiamiamo

luce. Per la fisica l’energia elettromagnetica

costituisce un fenomeno unitario che va considerato nel suo insieme, il fatto che

27

una sua parte giochi un ruolo così importante per gli esseri viventi, non la rende

diversa. La luce è quindi ritenuta un problema prettamente psicologico;

2.

che cos’è il colore: allo stesso modo della luce il colore è un problema

psicologico. Solo un numero limitato di esseri viventi è sensibile al colore. Il

colore esiste perché fra i fotorecettori ce ne sono alcuni che si attivano in maniera

differenziata per alcune lunghezze d’onda dello spettro visibile.

3.

le parole della luce: l’essere umano in alcuni casi vede come diverse superfici

che riflettono quantità uguali di energia e viceversa, e in altri casi vede uguali

superfici che riflettono quantità uguali di energia (es. cartoncini grigi). Bisogna

allora determinare che cosa misura l’essere umano all’atto di percepire il colore.

Le dimensioni fisiche della luce sono la luminanza (quantità di colore che

colpisce una superficie) e la riflettanza (proprietà di una superficie di riflettere