A.1.2. TRASFORMAZIONI NONLINEARI DI VARIABILI ALEATORIE (MONODIMENSIONALI)

A.1.2

441

Trasformazioni Nonlineari di Variabili Aleatorie (monodimensionali)

Consideriamo una trasformazione nonlineare monodimensionale g(·) che definisce la variabile aleatoria x a partire dalla variabile

aleatoria u, i.e.:

x = g(u)

Per semplicità, limitiamoci inizialmente a considerare il caso di trasformazione invertibile, i.e. esiste la trasformazione inversa

u = γ(x)

con γ(·) tale che

γ g(u) = u

Considerato, allora, un generico intervallo Iu sull’asse della variabile aleatoria u, e il corrispondente intervallo Ix = {x : x =

g(u), u ∈ Iu } sull’asse della variabile aleatoria u, gli eventi Eu = {u ∈ Iu } e Ex = {x ∈ Ix } hanno medesima probabilità di

verificarsi, i.e.

pX (x) dx =

Ix

pU (u) du

Iu

Poichè l’equilibrio delle probabilità deve mantenersi comunque scelto l’intervallo Iu , possiamo scrivere

pX (x) |dx| = pU (u) du (A.1.3)

u=γ(x)

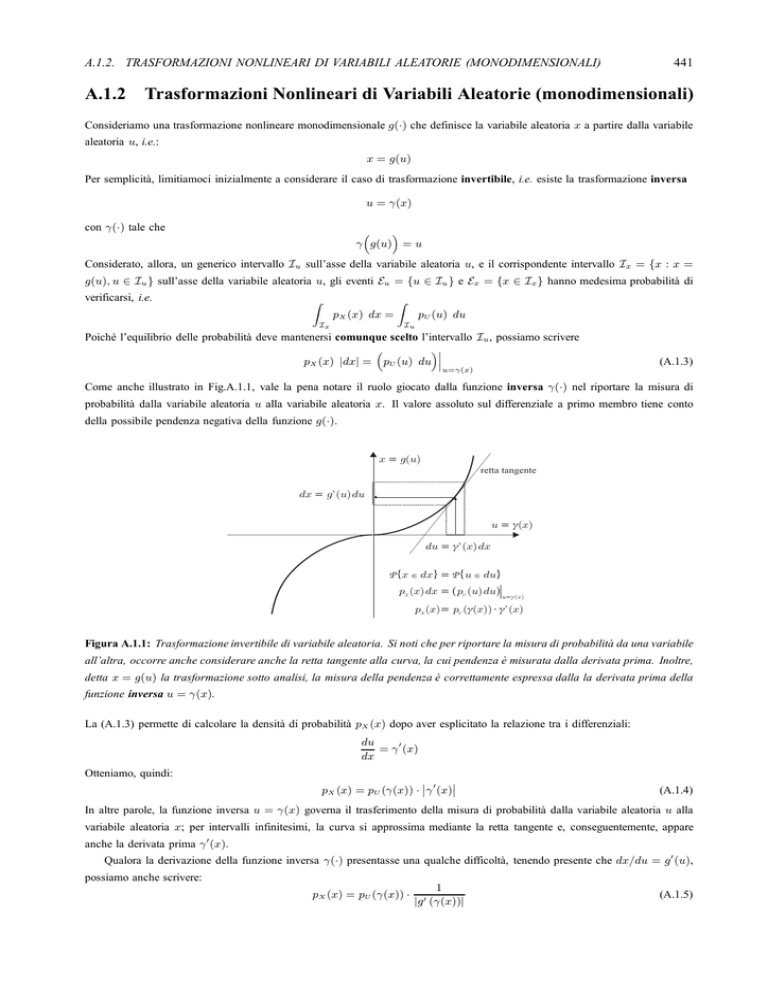

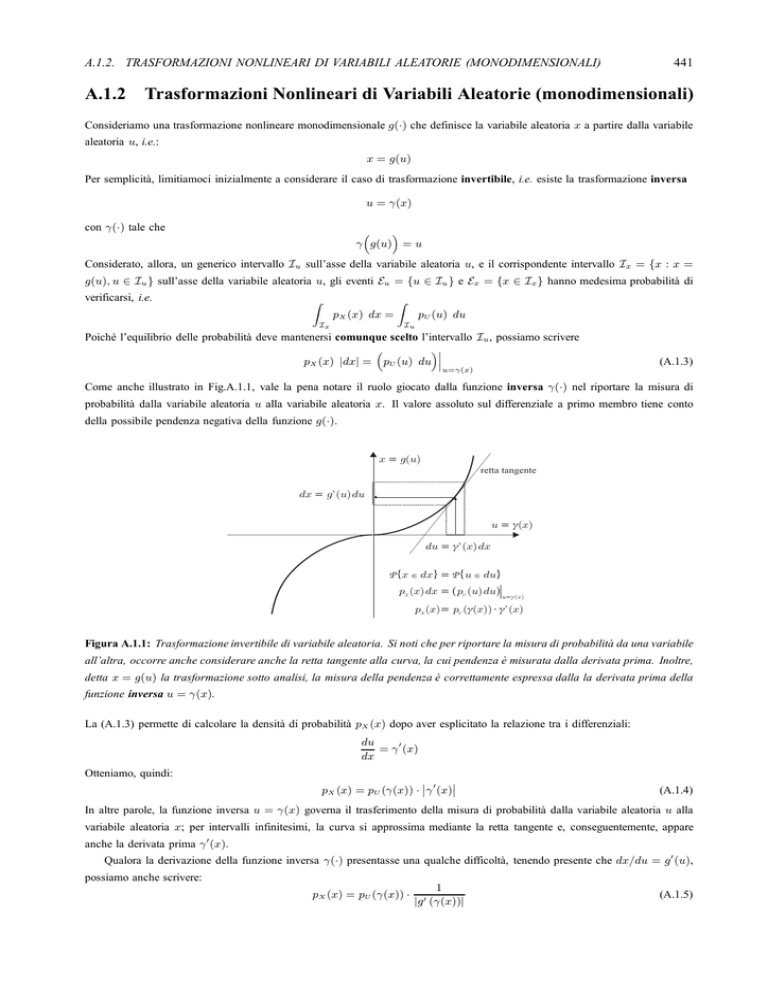

Come anche illustrato in Fig.A.1.1, vale la pena notare il ruolo giocato dalla funzione inversa γ(·) nel riportare la misura di

probabilità dalla variabile aleatoria u alla variabile aleatoria x. Il valore assoluto sul differenziale a primo membro tiene conto

della possibile pendenza negativa della funzione g(·).

x = g(u)

retta tangente

dx = g'(u) du

u = g(x)

du = g'(x) dx

P {x Î dx} = P {u Î du}

a

pX (x) dx = pU (u) du

f

u=g( x )

pX (x)= pU ( g(x))× g'(x)

Figura A.1.1: Trasformazione invertibile di variabile aleatoria. Si noti che per riportare la misura di probabilità da una variabile

all’altra, occorre anche considerare anche la retta tangente alla curva, la cui pendenza è misurata dalla derivata prima. Inoltre,

detta x = g(u) la trasformazione sotto analisi, la misura della pendenza è correttamente espressa dalla la derivata prima della

funzione inversa u = γ(x).

La (A.1.3) permette di calcolare la densità di probabilità pX (x) dopo aver esplicitato la relazione tra i differenziali:

du

= γ (x)

dx

Otteniamo, quindi:

pX (x) = pU (γ(x)) · γ (x)

(A.1.4)

In altre parole, la funzione inversa u = γ(x) governa il trasferimento della misura di probabilità dalla variabile aleatoria u alla

variabile aleatoria x; per intervalli infinitesimi, la curva si approssima mediante la retta tangente e, conseguentemente, appare

anche la derivata prima γ (x).

Qualora la derivazione della funzione inversa γ(·) presentasse una qualche difficoltà, tenendo presente che dx/du = g (u),

possiamo anche scrivere:

pX (x) = pU (γ(x)) ·

1

|g (γ(x))|

(A.1.5)

442

APPENDICE A.1. ELEMENTI DI TEORIA DELLA PROBABILITÀ

Trasformazioni nonlineari del tipo “molti a uno”

Se la funzione g(·) non è iniettiva, i.e. più valori di u corrispondono allo stesso valore di x, possiamo considerare separatamente

gli intervalli di iniettività (monotonia) della funzione g(·), applicando a ciascun intervallo quanto sopra esposto. Allora, detto L

il numero di intervalli di monotonia della funzione g(·), osserviamo che solo L(x) ≤ L intervalli di monotonia contribuiscono a

determinare un particolare assegnato valore x, i.e. fissato x, l’equazione

g(u) = x

ammette L(x) radici distinte che chiamiamo ul = γl (x) per l = 1, · · · , L(x).

La densità di probabilità si ottiene sommando sugli L(x) intervalli di monotonia:

L(x)

pX (x) =

pU (γl (x)) · γl (x)

l=1

oppure, se si preferisce,

L(x)

pX (x) =

pU (γl (x)) ·

l=1

1

|g (γl (x))|

Esempio: trasformazione parabolica (quadratore)

Il dispositivo che opera una trasformazione parabolica è spesso riferito come “quadratore”. Con riferimento alla Fig.A.1.2, la trasformazione

d’interesse è

x = u2

(A.1.6)

con u variabile aleatoria che può assumere, in generale, sia valori positivi che negativi.

g(u) = u2

g1(x) = x

g2(x) = - x

x = u2

u

u2 = - x

0

u1 = x

Figura A.1.2: Trasformazione parabolica (quadratore).

In questo caso, la (A.1.6) risulta non iniettiva per x ≥ 0, con L = 2 intervalli di monotonia, u < 0, e u ≥ 0. Per x ≥ 0 l’equazione

u2 = x

√

√

√

(x) = ±1/2 x.

ammette sempre L(x) = 2, i.e. u1,2 = ± x. Le due funzioni inverse sono quindi γ1,2 (x) = ± x, con derivate prime γ1,2

La densità di probabilità della variabile aleatoria x prende la forma seguente, valida solo per x ≥ 0:

1

1

1

pX (x) = √ · pU √

+ pU − √

2 x

x

x

Nel caso in cui la variabile aleatoria u assume solo valori non negativi, allora la (A.1.6) è invertibile, e abbiamo, per x ≥ 0:

1

1

pX (x) = √ · pU √

, quando risulta pU (u) = 0 per u < 0

2 x

x

Se invece la variabile aleatoria u assume solo valori non positivi, abbiamo, sempre solo per x ≥ 0:

1

1

pX (x) = √ · pU − √

, quando risulta pU (u) = 0 per u > 0

2 x

x

A.1.3. TRASFORMAZIONI NONLINEARI DI VARIABILI ALEATORIE (N -DIMENSIONALI)

A.1.3

443

Trasformazioni Nonlineari di Variabili Aleatorie (N -dimensionali)

Consideriamo N variabili aleatorie (x1 , x2 , · · · , xN ) ottenute per trasformazione nonlineare invertibile da altre N variabili

aleatorie (u1 , u2 , · · · , uN ):

x1 = g1 (u1 , u2 , · · · , uN ) ;

x2 = g2 (u1 , u2 , · · · , uN ) ;

xN = gN (u1 , u2 , · · · , uN )

Essendo la trasformazione invertibile, dalle N funzioni g1 (· · ·), · · · , gN (· · ·) possiamo determinare le N trasformazioni inverse:

u1 = γ1 (x1 , x2 , · · · , xN )

;

u2 = γ2 (x1 , x2 , · · · , xN ) ;

uN = γN (x1 , x2 , · · · , xN );

e calcolare lo Jacobiano della trasformazione:

⎡

∂γ1 (· · · )

⎢

⎢ ∂u1

⎢

⎢

⎢ ∂γ2 (· · · )

⎢

⎢ ∂u1

def J (x1, x2 , · · · , xN ) = det ⎢

⎢

⎢

..

⎢

.

⎢

⎢

⎢

⎣ ∂γN (· · · )

∂u1

∂γ1 (· · · )

∂u2

···

∂γ2 (· · · )

∂u2

···

..

.

..

.

∂γN (· · · )

∂u2

···

(A.1.7)

⎤

∂γ1 (· · · ) ⎥

∂uN ⎥

⎥

⎥

∂γ2 (· · · ) ⎥

⎥

∂uN ⎥

⎥

⎥

⎥

..

⎥

.

⎥

⎥

⎥

∂γN (· · · ) ⎦

∂uN

Lo Jacobiano permette di scrivere riportare la trasformazione nonlineare nelle densità di probabilità:1.1

pX1 ,X2 ,···,XN (x1 , x2 , · · · , xN ) = pU1,U2 ,···,UN γ1 (x1 , x2 , · · · , xN ), · · · , γN (x1 , x2 , · · · , xN ) · J (x1 , x2 , · · · , xN )

(A.1.8)

Nel caso di trasformazioni nonlineari suriettive ma non iniettive si procede sostanzialmente come descritto per il caso monodimensionale.

1.1 Nella

(A.1.8), il lettore attento avrà riconosciuto il passaggio fondamentale della tecnica cosiddetta “d’integrazione per sostituzione”, impiegata

nell’integrazione di funzioni di più variabili. L’unica differenza, sostanziale, consiste nel fatto che la probabilità di eventi associati a intervalli

definiti sullo spazio delle variabili aleatorie (γ1 (x1 , x2 , · · · , xN ) si ottiene mediante integrazione della densità di probabilità, i.e.

P {(x1 , x2 , · · · , xN ) ∈ I} def

=

···

pX1 ,X2 ,···,XN (x1 , x2 , · · · , xN ) dx1 dx2 , · · · , dxN

(x1 ,x2 ,···,xN )∈I

per cui lo Jacobiano deve far parte integrante della densità di probabilità dopo la trasformazione, come indicato nella (A.1.8).

Nel caso di un integrale di più variabili, invece, lo Jacobiano determina come si modifica l’elemento di ipervolume misurato dal prodotto dei

differenziali, i.e.

du1 du2 , · · · , duN = J(x1 , x2 , · · · , xN ) · dx1 dx2 , · · · , dxN

Allora, la (A.1.8) esprime il fatto che, dopo aver trasformato l’elemento di ipervolume, per ottenere la densità di probabilità delle variabili aleatorie

(x1 , x2 , · · · , xN ) dopo la trasformazione, occorre avere l’accortezza di considerare il prodotto dello Jacobiano con la densità di probabilità

delle variabili aleatorie (u1 , u2 , · · · , uN ), avendo effettuato in quest’ultima il necessario cambio di variabile definito dalle trasformazioni inverse

(A.1.7).

444

APPENDICE A.1. ELEMENTI DI TEORIA DELLA PROBABILITÀ

A.1.4

Variabili Aleatorie Gaussiane

def

La densità di probabilità di N variabili aleatorie x = [x1 , · · · , xN ]T congiuntamente gaussiane si scrive come segue:

1

(x − η x )T · K−1

x · (x − η x )

pX (x) = exp −

2

(2π)N · det Kx

(A.1.9)

def

def

dove η x = E {x} = [η1 , · · · , ηN ]T è il vettore dei valori medi, e Kx = E (x − η x ) · (x − η x )T e la matrice di covarianza.

Notiamo che la matrice di covarianza è simmetrica per costruzione, i.e. KT

x = Kx. Sulla diagonale di Kx troviamo le varianze

delle singole variabili aleatorie, mentre sugli elementi fuori diagonale troviamo le covarianze mutue, i.e.

(Kx)ii = Var{xi } = σi2

(Kx )ik = ρi,k · σi σk

essendo

def

ρi,k = per i = 1, · · · , N

per i, k = 1, · · · , N ; i = k

Cov{xi , xk }

Var{xi } · Var{xk }

il coefficiente di correlazione tra le variabili xi e xk .

La funzione caratteristica assume la forma seguente

T T

1

def

PX (ν) = E ejν x =

pX (x) · ejν x dx = exp jν T · η x · exp − ν T · Kx · ν

2

X

La variabili aleatorie marginali xi sono a distribuziona gaussiana. Infatti

1

PXi (νi ) = PX (0, · · · , 0, νi , 0, · · · , 0) = exp (jνi · ηi ) · exp − νi · σi2 · νi

2

In particolare, nel caso bivariato (N = 2) abbiamo

⎡

⎤

⎢

Kx ⎢

⎣

ρ · σ1 σ2 ⎥

⎥

⎦

σ22

σ12

ρ · σ1 σ2

⎡

;

=

K−1

x

σ12 σ22

⎢

1

⎢

2

(1 − ρ ) ⎣

⎤

σ22

−ρ · σ1 σ2

−ρ · σ1 σ2 ⎥

⎥

⎦

σ12

e quindi

pX1 X2 (x1 , x2 ) =

1

2π · σ1 σ2

1 − ρ2

exp −

1

·

2 (1 − ρ2 )

x1 − η1 x2 − η2

(x2 − η2 )2

(x1 − η1 )2

− 2ρ

+

σ12

σ1

σ2

σ22

A.1.4. VARIABILI ALEATORIE GAUSSIANE

A.1.4.1

445

Caso di Due Variabili Aleatorie Centrate e Normalizzate

Per scrivere la funzione densità di probabilità di due variabili aleatorie congiuntamente gaussiane conviene riferirsi a variabili

centrate e normalizzate (media nulla e varianza unitaria)

def

ζ1 =

x1 − η1

σ1

def

;

ζ2 =

x2 − η2

σ2

e al coefficiente di correlazione

def

ρ = E {ζ1 ζ2 }

Per scopi di compattezza di notazione, introduciamo anche il vettore aleatorio, a media nulla,

def

ζ T = [ζ1 ζ2 ]

avente come matrice di covarianza (diretta e inversa)

⎡

⎤

⎢1

def

Kζ = E ζ ζ T = ⎢

⎣

ρ

ρ⎥

⎥

⎦

1

⎡

K−1

ζ

;

⎤

1

1 ⎢

⎢

=

1 − ρ2 ⎣

−ρ

−ρ⎥

⎥

⎦

1

(A.1.10)

Possiamo allora utilizzare l’espressione della funzione densità di probabilità nel caso generale di N variabili aleatorie congiuntamente gaussiane, collezionate nel vettore ζ T = [ζ1 · · · ζN ], i.e.

pZ (ζ) = 1

(2π)N · det Kζ

exp

ζ T · K−1

ζ ·ζ

−

2

(A.1.11)

Sostituendo le (A.1.10) nella (A.1.11) otteniamo la funzione densità di probabilità di una coppia di variabili aleatorie congiuntamente gaussiane, centrate e normalizzate:

pZ1 ,Z2 (ζ1 , ζ2 ) =

2π

2

1

ζ − 2ρ ζ1 ζ2 + ζ22

exp − 1

2(1 − ρ2 )

1 − ρ2

(A.1.12)

Nelle Figg. A.1.3 e A.1.4 è riportato l’andamento delle densità di probabilità (A.1.12), rispettivamente per ρ = 0 e ρ = 0.85. Per

ρ = 0, le curve di livello sono delle ellissi con assi principali ruotati di π/4 o −π/4, rispettivamente per ρ > 0 e ρ < 0. Infatti,

fissato un livello K, e al variare di ζ1 e ζ2 , la condizione

pZ1 ,Z2 (ζ1 , ζ2 ) = K

individua la stessa curva ottenuta dalla condizione

ζ12 − 2ρ ζ1 ζ2 + ζ22 = −2 1 − ρ2 · ln 2πK 1 − ρ2

che è proprio un ellisse come detto sopra.

Nel caso ρ = 0 le curve di livello degenerano in circonferenze. In questo caso, infatti, le due variabili aleatorie diventano

incorrelate e, in quanto gaussiane, anche statisticamente indipendenti, i.e. la densità di probabilità congiunta si fattorizza nel

prodotto delle densità di probabilità marginali

2

2

2

1

1

ζ1 + ζ22

1

pZ1 ,Z2 (ζ1 , ζ2 ) =

exp −

= √ e−ζ1 /2 · √ e−ζ2 /2

2π

2

2π

2π

p

Z1 (ζ1 )

p

Z2 (ζ2 )

Notiamo che, in questo caso, la pZ1 ,Z2 (ζ1 , ζ2 ) è una funzione a simmetria circolare, in quanto dipende solo dalla somma ζ12 + ζ22 .

Nelle stesse figure é riportato anche il diagramma di scatteramento, ottenuto considerando 5000 realizzazioni ottenute effettuando sorteggi statisticamente indipendenti in accordo alla (A.1.12). Tali diagrammi confermano che, nel caso gaussiano, il

legame statistico che sussiste tra le due variabili aleatorie è completamente spiegato dalla seguente relazione lineare:

ζ2 = ρ · ζ1 +

1 − ρ2 · w

(A.1.13)

446

APPENDICE A.1. ELEMENTI DI TEORIA DELLA PROBABILITÀ

dove w è una variabile aleatoria gaussiana, anch’essa centrata e normalizzata, statisticamente indipendente da ζ1 . Dalla (A.1.13)

osserviamo che ζ2 é una variabile aleatoria gaussiana a media nulla, in quanto somma di variabili aleatorie gaussiane a media

nulla. La varianza si calcola facilmente. Infatti, poichè ζ1 è statisticamente indipendente da w, possiamo scrivere

Var{ζ2 } = ρ2 · Var{ζ1 } + 1 − ρ2 · Var{w} = 1

1

1

Per quanto riguardo il coefficiente di correlazione, poiché le variabili sono anche centrate e normalizzate, possiamo scrivere

= ρ · E {ζ1 · ζ1 } + 1 − ρ2 · E {ζ1 · w} = ρ

E {ζ1 · ζ2 } = E ζ1 · ρ · ζ1 + 1 − ρ2 · w

Var{ζ1 }=1

E{ζ1 }·E{w}=0

Osservando la (A.1.13), possiamo concludere che, per ρ → 1 e considerando diversi sorteggi, per ciascun sorteggio le realizzazioni

della variabile aleatoria ζ2 tendono a coincidere con quelle di ζ1 . Il diagramma di scatteramento tenderà a formare una nuvola di

punti intorno alla retta con pendenza π/4 (cfr. Fig.A.1.4). Per ρ → −1 succede lo stesso a parte un cambiamento di segno, per

cui la nuvola di punti si addenserà intorno alla retta con pendenza −π/4.

Per ρ = 0 le variabili aleatorie sono statisticamente indipendenti, e la nuvola di punti assume una forma circolare (cfr.

Fig.A.1.3).

In conclusione, come potevamo aspettare, i diagrammi di scatteramento presentano nuvole di punti che si addensano intorno

alle stesse figure geometriche presenti nel diagramma delle curve di livello della densità di probabilità.

A.1.4. VARIABILI ALEATORIE GAUSSIANE

447

Figura A.1.3: Densità di probabilità (superficie e curve di livello) e diagramma di scatteramento pertinente a due variabili

aleatorie gaussiane a media nulla, varianza unitaria e coefficiente di correlazione ρ = 0.

448

APPENDICE A.1. ELEMENTI DI TEORIA DELLA PROBABILITÀ

Figura A.1.4: Densità di probabilità (superficie e curve di livello) e diagramma di scatteramento pertinente a due variabili

aleatorie gaussiane a media nulla, varianza unitaria e coefficiente di correlazione ρ = 0.85.

A.1.4. VARIABILI ALEATORIE GAUSSIANE

A.1.4.2

449

Caso Generale di Due Variabili Aleatorie

def

Consideriamo ora il caso generale di variabili aleatorie x = [x1 x2 ]T, con medie non nulle e varianze non unitarie. Definendo il

def

vettore dei valori medi η x = [η1 η2 ]T e la matrice di covarianza

⎡

⎢

def

Kx = E (x − η x ) · (x − η x )T = ⎢

⎣

⎤

σ12

ρ · σ1 σ2

ρ · σ1 σ2 ⎥

⎥

⎦

2

σ2

possiamo scrivere la densità di probabilità congiunta come segue

1

(x − η x )T · K−1

· (x − η x )

x

exp −

px (x) =

2

2πσ1 σ2 · 1 − ρ2

(A.1.14)

Dobbiamo quindi analizzare le ellissi descritte dall’equazione

(x − η x )T · K−1

x · (x − η x ) = C

(A.1.15)

che si ottengono da quelle descritte dall’equazione

xT · K−1

x ·x = C

centrandole nel punto di coordinate (η1 , η2 ).

⎡

Poichè abbiamo

=

K−1

x

⎢

1

⎢

σ12 σ22 (1 − ρ2 ) ⎣

⎤

−ρ · σ1 σ2 ⎥

⎥

⎦

2

σ1

σ22

−ρ · σ1 σ2

le ellissi che interessano sono descritte dall’equazione

x1 x2

x2

x21

+ 22 = C 2 − 2ρ

σ1

σ1 σ2

σ2

(A.1.16)

con C = 1 − ρ2 · C.

Per scrivere l’ellisse in forma canonica, i.e.

dobbiamo determinare la matrice di rotazione1.2

ξ2

ξ12

+ 22 = C 2

a

b

Q che porta il sistema di riferimento cartesiano (x1 , x2 ) nel sistema di riferimento

cartesiano (ξ1 , ξ2 ). Sostituendo x = QT · ξ nella (A.1.15) otteniamo

T

ξ T · Q · K−1

x Q ξ = C

Quindi, l’equazione canonica si ottiene quando risulta

⎡

1

⎢ 2

T

⎢

a

Q · K−1

·

Q

=

x

⎣

0

⎤

0⎥

⎥

⎦

1

b2

o, equivalentemente, essendo Q una matrice di rotazione,

⎤

⎡

⎢a

Q · Kx · QT = ⎢

⎣

2

0

1.2 Una

0⎥

⎥

⎦

2

b

matrice di rotazione gode delle due seguenti proprietà:

Q · QT = QT · Q = I

det Q = 1

450

APPENDICE A.1. ELEMENTI DI TEORIA DELLA PROBABILITÀ

Per inciso, la matrice Q · Kx · QT è proprio la matrice di covarianza del vettore aleatorio ξ = QT · x. Infatti, poichè risulta

def

η ξ = E {ξ} = E QT · x = QT · E {x} = QT · η x

abbiamo:

Kξ = E

T = QT · E (x − η x ) · (x − η x )T · Q = QT · Kx · Q

ξ − ηξ · ξ − ηξ

La matrice Q si determina osservando la scomposizione in autovalori e autovettori1.3 della matrice di covarianza Kx, i.e.

K x = U · Λ · UT

dove la matrice U di rotazione che colleziona gli autovettori nelle colonne, i.e.

def

U = [u1 u2 ]

mentre Λ è la matrice diagonale degli autovalori, i.e.

⎡

def ⎢ λ1

Λ = ⎢

⎣

0

⎤

0⎥

⎥

⎦

λ2

Il nostro problema è risolto ponendo Q = U. Infatti, poichè U é una matrice di rotazione, risulta

T

Kξ = UT· U · Λ · UU

= Λ

I

2

I

2

Conseguentemente, abbiamo anche a = λ1 e b = λ2 .

Calcoliamo ora gli autovalori e gli autovettori di Kx . Gli autovalori s ottengono dalla equazione di secondo grado

det (Kx − λ · I) = 0

Valutando il determinante otteniamo

⎡

⎤

⎢ σ12 − λ

det ⎢

⎣

ρ · σ1 σ2

ρ · σ1 σ2 ⎥ 2

⎥ = σ1 − λ · σ22 − λ − ρ2 · σ12 σ22 = λ2 − σ12 + σ22 · λ + σ12 σ22 1 − ρ2 = 0

⎦

σ22 − λ

Le radici sono

λ1,2 =

1 2

σ1 + σ22 ± (σ12 + σ22 ) − 4σ12 σ22 (1 − ρ2 )

2

⎡

⎤

2

2

2σ1 σ2 ρ

1 ⎣ 2

2

2

⎦

σ1 + σ2 ± σ1 − σ2

1+

=

2

σ12 − σ22

Gli autovettori si ottengono dalle equazione omogenea

(Kx − λi · I) · ui = 0

1.3 Per

una matrice quadrata A, la coppia autovalore λi e autovettore ui è determinata dalla autoequazione

A · ui = λi · ui

che scriviamo anche

(A − λi · I) · ui = 0

Questa equazione omogenea ammette soluzione se e solo se

det (A − λi · I) = 0

condizione che permette di calcolare gli autovalori.

Quando A è simmetrica, i.e. AT = A, gli autovettori corrispondenti ad autovalori distinti risultano mutuamente ortogonali, e la matrice U é

una matrice di rotazione, risultando U · UT = UT · U = I.

A.1.4. VARIABILI ALEATORIE GAUSSIANE

per i = 1, 2. Per i = 1 abbiamo

451

⎤ ⎡

⎡

⎢σ12

⎢

⎣

− λ1

ρ · σ1 σ2

Risolvendo la prima equazione otteniamo

ρ · σ1 σ2 ⎥ ⎢u1,1 ⎥

⎥·⎢

⎥=0

⎦ ⎣

⎦

2

σ2 − λ1

u1,2

⎤

⎡

⎤

⎤

⎡

⎢u1,1 ⎥

⎢−ρ · σ1 σ2 ⎥

⎥ = α1 · ⎢

⎥

u1 = ⎢

⎦

⎦

⎣

⎣

2

u1,2

σ1 − λ1

dove la costante α1 va determinata in modo da avere l’autovettore con norma unitaria, i.e. tale che risulti uT

1 · u1 = 1, quindi

2 2 2

2

2

α1 · σ1 σ1 ρ + (σ1 − λ1 ) = 1.

Possiamo già deteminare la direzione di u1 , ossia l’angolo θ1 formato da u1 con l’asse x1 :

tan θ1 =

Poichè risulta

σ12

− λ1 =

σ12

ρ · σ1 σ2

σ12 − λ1

⎤

⎤

⎡

⎡

2

2

2

2

1 ⎣ 2

2ρ · σ1 σ2 ⎦

2ρ · σ1 σ2 ⎦

1 ⎣ 2

2

2

2

2

−

1+

1+

=

σ1 + σ2 − σ1 − σ2

σ1 − σ2 − σ1 − σ2

2

σ12 − σ22

2

σ12 − σ22

⎛

⎞

2

2ρ · σ1 σ2 ⎠

σ12 − σ22 ⎝

1− 1+

=

2

σ12 − σ22

Posto

A=

2ρ · σ1 σ2

σ12 − σ22

abbiamo quindi

A

√

1 − 1 + A2

Poichè l’angolo θ1 può determinarsi solo nell’intervallo [−π/2, π/2], conviene riferirsi alla tan 2θ1 per la quale si ottiene

tan θ1 =

un’espressione abbastanza semplice. Abbiamo

−1

√

2

1 − 1 + A2

2 tan θ1

2A

A2

2A

√

√

=

·

1

−

=

·

tan 2θ1 =

√

√

2

2

1 − tan2 θ1

1 − 1 + A2

1 − 1 + A2

1 − 1 + A2

1 − 1 + A2 − A2

= 2A ·

=

√

√

1 − 1 + A2

1 − 1 + A2

√

√

=A

= 2A · 1 − 2 1 + A2 + 1 + A2 − A2

2 1 − 1 + A2

(A.1.17)

2ρ · σ1 σ2

σ12 − σ22

L’angolo θ1 misura la rotazione che porta il sistema di riferimento (x1 , x2 ) nel sistema di riferimento (ξ1 , ξ2 ), ossia la rotazione

subita dagli assi principali dell’ellisse.

Per completezza, calcoliamo anche u2 .

⎤ ⎡

⎡

⎢σ12

⎢

⎣

− λ2

ρ · σ1 σ2

⎤

ρ · σ1 σ2 ⎥ ⎢u2,1 ⎥

⎥·⎢

⎥=0

⎦ ⎣

⎦

2

σ2 − λ2

u2,2

Risolvendo la seconda equazione otteniamo

⎡

⎤

⎡

⎤

⎢u2,1 ⎥

⎢ σ2 − λ2 ⎥

⎥ = α2 · ⎢ 2

⎥

u2 = ⎢

⎣

⎣

⎦

⎦

u2,2

−ρ · σ1 σ2

dove la costante α2 va determinata in modo da avere l’autovettore con norma unitaria, i.e. tale che risulti uT

2 · u2 = 1, quindi

2

2

2

2

2

α2 · σ1 σ1 ρ + (σ2 − λ2 ) = 1.

452

APPENDICE A.1. ELEMENTI DI TEORIA DELLA PROBABILITÀ

Per finire:

σ22

− λ2 =

σ22

⎡

⎡

⎤

⎤

2

2

2

2

1 ⎣ 2

2ρ · σ1 σ2 ⎦

2ρ · σ1 σ2 ⎦

1 ⎣ 2

2

2

2

2

σ1 + σ2 − σ2 − σ1

σ2 − σ1 − σ2 − σ1

−

1+

1+

=

2

σ22 − σ12

2

σ22 − σ12

⎞

⎛

2

2ρ · σ1 σ2 ⎠

σ22 − σ12 ⎝

= − σ12 − λ1

1− 1+

=

2

σ22 − σ12

e quindi

σ22 − λ2

σ2 − λ1

1

=− 1

=−

ρ · σ1 σ2

ρ · σ1 σ2

tan θ1

Come doveva risultare, la direzione di u2 risulta ortogonale a quella di u1 .

tan θ2 =

Nelle Figg. A.1.5 e A.1.6 è riportato un esempio per η1 = 1 e η2 = 0.5, σ12 = 1.25 e σ2 = 0.75, rispettivamente per ρ = 0

e ρ = 0.85. Riportiamo anche il calcolo dell’orientazione dell’ellisse nella Fig. A.1.6:

√

√

1

1

2 · 0.85 · 1.25 · 0.75

1

θ1 = arctan

= arctan(3.4 · 0.968) · 73.36 deg 36.68 deg

2

1.25 − 0.75

2

2

A.1.4. VARIABILI ALEATORIE GAUSSIANE

453

Figura A.1.5: Densità di probabilità (superficie e curve di livello) e diagramma di scatteramento pertinente a due variabili

aleatorie gaussiane con valori medi η1 = 1 e η2 = 0.5, varianze σ12 = 1.25 e σ2 = 0.75, e coefficiente di correlazione ρ = 0.

454

APPENDICE A.1. ELEMENTI DI TEORIA DELLA PROBABILITÀ

Figura A.1.6: Densità di probabilità (superficie e curve di livello) e diagramma di scatteramento pertinente a due variabili

aleatorie gaussiane con valori medi η1 = 1 e η2 = 0.5, varianze σ12 = 1.25 e σ2 = 0.75, e coefficiente di correlazione ρ = 0.85.

A.1.4. VARIABILI ALEATORIE GAUSSIANE

A.1.4.3

455

Trasformazioni Lineari di Variabili Aleatorie Gaussiane

def

Sia A una matrice N × N non singolare che trasforma le N variabili aleatorie v = [v1 , · · · , vN ]T nelle N variabili aleatorie

def

x = [x1 , · · · , xN ] , i.e.

T

x=A·v

Non è difficile mostrare che se v colleziona variabili aleatorie congiuntamente gaussiane, anche le variabili aleatorie in x risultano

congiuntamente gaussiane. Ricorrendo alle funzioni caratteristiche possiamo scrivere

T T 1 T

def

jν x

jν Av

T

T

T

PX (ν) = EX e

= EV e

= PV (A ·ν) = exp jν · Aη v · exp − ν · A·KV ·A · ν

2

ηx

Kx

1

= exp jν T · η x · exp − ν T · Kx · ν

2

riconoscendo in PX (ν) la forma di una funzione caratteristica relativa a una distribuzione gaussiana con vettore dei valori medi

η x = A · η v e matrice di covarianza Kx = A · KV · AT .

A.1.4.3.1

Colorazione di N variabili aleatorie gaussiane

Supponiamo di voler “colorare” le N variabili aleatorie v “bianche”, i.e. con η v = 0 e KV = I, nelle variabili aleatorie x con

assegnati vettore dei valori medi η x e matrice di covarianza Kx . Da quanto detto in precedenza, è possibile ottenere questo

risultato mediante un’opportuna trasformazione lineare

x = A · v + ηx

Infatti

E {x} = E {A · v} + E {η x } = A · E {v} + η x = η x

E (x − η x )·(x − η x )

T

= A · E v·v

0

T

· AT = A·AT

Per il valor medio occorre soltanto aggiungere il valore desiderato η x .

Per la covarianza, è necessario che risulti A·AT = Kx . Una matrice A che goda di questa proprietà è una “radice quadrata”

della matrice di covarianza Kx . Notiamo che le radici quadrate sono legate da matrici ortogonali, i.e. per ogni matrice ortogonale

def

Q, la matrice B = A·Q è radice quadrata. Infatti

B·BT = A · Q·QT · AT = A·AT = Kx

I

Dalla scomposizione in autovalori e autovettori di Kx , i.e.

Kx = U·Λ·UT

√

√

def

posto Λ1/2 = diag{ λ1 , · · · , λN }, riconosciamo che le matrici U · Λ1/2 e U · Λ1/2 · UT sono radici quadrate di Kx . In

particolare, notiamo che la matrice U·Λ1/2 ·UT è anche simmetrica.

456

APPENDICE A.1. ELEMENTI DI TEORIA DELLA PROBABILITÀ

A.1.4.3.2

Determinazione di una radice quadrata triangolare mediante scomposizione di Cholensky

Illustriamo il procedimento costruttivo supponendo per comodità, ma senza perdere di generalità, variabili aleatorie ζ centrate

e normalizzate, i.e. ζi = (xi − ηi )/σi2 , per i = 1, · · · , N .1.4 Gli elementi della matrice di covarianza di ζ coincidono con i

coefficienti di correlazione delle variabil x, i.e. (Kζ )i,k = ρi,k .

def

Indichiamo con ai,k = (A)i,k gli elementi della matrice A. Quando gli elementi sono nulli nella parte triangolare superiore,

i.e. ai,k = 0 per k > i, la matrice si dice triangolare in basso.1.5 In questo caso, le equazioni della trasformazione ζ = A·v si

scrivono come segue:

ζ1 = a1,1 ·v1

⎞

⎛

⎟

⎜

2

⎟

ζ2 = ⎜

⎝ a2,1 ·v1 + 1 − a2,1 · v2 ⎠

a2,2

⎞

⎛

⎜

ζ3 = ⎜

⎝ a3,1 ·v1 + a3,2 ·v2 +

⎟

1 − a23,1 − a23,2 · v3 ⎟

⎠

(A.1.18)

a3,3

·········

⎞

&

⎟

⎜

'

i−1

i−1

⎟

⎜

'

⎟

⎜

(

2

ai,k ·vk + 1 −

ai,k · vi ⎟

ζi = ⎜

⎟

⎜

k=1

⎠

⎝ k=1

⎛

ai,i

·········

La trasformazione colora le variabili aleatorie bianche v nelle variabili aleatorie ζ, centrate, normalizzate, e con matrice di

covarianza (Kζ )i,k = ρi,k , quando risulta

1 = a1,1

ρ2,1 = a2,1 ·a1,1

ρ3,1 = a3,1 ·a1,1 ,

ρi,1 = ai,1 ·a1,1 ,

ρi,j

ρ3,2 = a3,1 ·a2,1 + a3,2 ·

·········

&

'

j−1

j−1

'

=

ai,k ·aj,k + ai,j · ( 1 −

a2j,k

k=1

1 − a22,1

(A.1.19)

per j = 2, · · · , i − 1

k=1

·········

Noti i coefficienti di correlazione ρi,j , sfruttando la natura triangolare del sistema di equazioni (A.1.19), i coefficienti ai,k si

determinano mediante il seguente algoritmo di Cholensky.

1.4 Le

variabili aleatorie x si ottengono dalle ζ molto semplicemente:

xi = σi · ζi + ηi ,

1.5 Infatti,

i = 1, · · · , N

una matrice triangolare in basso ha elementi diversi da zero nella parte triangolare in basso, compresa la diagonale, i.e. per i <= k.

A.1.4. VARIABILI ALEATORIE GAUSSIANE

457

Algoritmo di Cholensky

Consideriamo in sequenza i = 1, · · ·, N e per ogni i procediamo in sequenza j = 1, · · · , i. Così facendo, in ciascuna equazione

ρi,j = · · · della (A.1.19) occorre determinare soltanto l’incognita ai,j (le altre sono state già tutte determinate precedentemente).

Abbiamo:

a1,1 = 1

a2,1 = ρ2,1 ,

a3,1 = ρ3,1 ,

a3,2 =

a2,2 =

1 − a22,1

ρ3,2 − a3,1 ·a2,1

,

a2,2

a3,3 =

1 − a23,1 − a23,2

·········

ρi,j −

ai,1 = ρi,1 ,

j−1

ai,k ·aj,k

k=1

ai,j =

per j = 2, · · · , i − 1 ,

aj,j

ai,i

&

'

i−1

'

= (1 −

a2

i,k

k=1

·········

Il numero delle operazioni (moltiplicazioni) necessario per calcolare gli elementi della riga i è O(i2 ), infatti:

i−1

# mul

=

riga i

j=2

j

+

(i − 1)

(i−1) quadrati per ai,i

j mul per ai,j , j=2,··· ,i−1

i−1

=

j=1

− 1 + (i − 1) =

j

i2

i

i · (i + 1)

− +i−2 =

−2

2

2

2

i·(i−1)/2

Quindi, poichè

# mul =

N i · (i + 1)

i=1

2

−2

3

il numero complessivo di moltiplicazioni è O(N ).

Osserviamo una forta criticità di carattere numerico quando, per qualche indice i, risulta ai,i 0.

Per concludere, osserviamo che la (A.1.18) generalizza al caso di N variabili il legame lineare esistente tra due variabili

aleatorie gaussiane mutuamente correlate, già discusso nella (A.1.13).

458

A.1.4.3.3

APPENDICE A.1. ELEMENTI DI TEORIA DELLA PROBABILITÀ

Sbiancamento di N variabili aleatorie gaussiane

Consideriamo, per semplicità ma senza perdere di generalità, N variabili aleatorie x a media nulla, i.e. η x = 0, e matrice di

covarianza Kx. Mediante un’opportuna trasformazione lineare è possibile “sbiancare” x, ossia ottenere N variabili aleatorie v

incorrelate, aventi cioè matrice di covarianza diagonale, diciamo KV = D con D qualsiasi. La trasformazione

v = W T ·x

sbianca quando risulta

KV = E v·vT = W T · E x·xT · W = W T · Kx · W = D

Dalla scomposizione in autovalori e autovettori di Kx , i.e.

Kx = U·Λ·UT

riconosciamo che W = U è una trasformazione sbiancante con D = Λ. Infatti

UT · Kx · U = UT·U · Λ · UT·U = Λ

I

In generale poichè possiamo scrivere

abbiamo

I

−1

T

= D−1

W · Kx · W

W T · Kx · W

−1

−T

= W −1 · K−1

x ·W

e quindi

K−1

= W·D−1 ·W T

x

Le trasformazioni sbiancanti sono quelle che diagonalizzano l’inversa della matrice di covarianza. Quelle che ottengono D = I

differiscono per una matrice ortogonale. Infatti, se risulta W T · Kx · W = I, allora, per Q generica matrice ortogonale, anche

QT W T sbianca. Infatti

QT · W T ·Kx ·W · Q = QT ·Q = I

I

A.1.4.3.4

Determinazione di una trasformazione sbiancante mediante ortogonalizzazione di Gram-Schmidt

Al solito, conviene riferisi a variabili aleatorie centrate e normalizzate ζi = (xi − ηi )/σi per i = 1, · · · , N . Il metodo della

ortogonalizzazione di Gram-Schmidt consiste nel costruire iterativamente le variabili aleatorie mutuamente incorrelate vi , per

i = 1, · · ·, N , utilizzando esclusivamente la variabile aleatoria ζi e le variabili aleatorie vi−1 , vi−2 , · · ·, v1 già determinate, i.e.

v 1 = ζ1

v2 = ζ2 + a2,1 ·v1

v3 = ζ3 + a3,2 ·v2

···

···

···

(A.1.20)

vi+1 = ζi+1 + ai+1,i ·vi

···

···

···

Affinché v2 risulti incorrelata con v1 , deve risultare a2,1 = −ρζ2 ,v1 = −ρ2,1 . Proseguendo, affinché v3 risulti incorrelata con

v2 , deve risultare a3,2 = −ρζ3 ,v2 = −(ρ3,2 + a2,1 · ρ3,1 ). In generale, affinché vi+1 risulti incorrelata con vi , deve risultare

ai+1,i = −ρζi+1 ,vi .

A.1.4. VARIABILI ALEATORIE GAUSSIANE

459

Ortogonalizzazione di Gram-Schimdt

v 1 = ζ1

;

a1,1 = 1

v2 = ζ2 + a2,1 ·v1

= ζ2 + a2,1 ·ζ1

;

a2,2 = 1

a2,1 = −ρζ3 ,v2 = −ρ2,1

v3 = ζ3 + a3,2 ·v2

= ζ3 + a3,2 ·(ζ2 + a2,1 ·ζ1 )

= ζ3 + a3,2 ·ζ2 + a3,1 ·ζ1

;

a3,3 = 1

a3,2 = −ρζ3 ,v2 = − (ρ3,2 + a2,1 ·ρ3,1 )

a3,1 = a3,2 · a2,1

v4 = ζ4 + a4,3 ·v3

= ζ4 + a4,3 ·(ζ3 + a3,2 ·ζ2 + a3,1 ·ζ1 )

= ζ4 + a4,3 ·ζ3 + a4,2 ·ζ2 + a4,1 ·ζ1

;

a4,4 = 1

(A.1.21)

a4,3 = −ρζ4 ,v3 = − (ρ4,3 + a3,2 ·ρ4,2 + +a3,1 ·ρ4,1 )

a4,2 = a4,3 · a3,2

a4,1 = a4,3 · a3,1

···

vi+1 = ζi+1 + ai+1,i ·vi

= ζi+1 + ai+1,i · xi +

i−1

···

···

ai,k ·ζk

k=1

= ζi+1 +

i

ai+1,k ·ζk

;

ai+1,i+1 = 1

k=1

ai+1,i = −ρζi+1 ,vi = − ρi+1,i +

i−1

ai,k ·ρi+1,k

k=1

ai+1,k = ai+1,i · ai,k per k = 1, · · ·, i − 1

···

···

···

Osservazione

Le tecniche di colorazione e sbiancamento mediante trasformazione lineare si applicano per qualsiasi distribuzione di probabilità.

Solo, però, nel caso gaussiano si controlla la distribuzione di probabilità, che in questo caso rimane invariata sotto una trasformazione lineare. Ad esempio, per variabili aleatorie vi statisticamente indipendenti ma non-gaussiane, nel caso della colorazione

)N

i=1 ak,i ·vi risulta

riusciamo a ottenere la matrice di covarianza desiderata, ma la distribuzione di probabilità della singola xk =

essere la convoluzione delle densità di probabilità delle singole variabili aleatorie ak,i ·vi.

460

APPENDICE A.1. ELEMENTI DI TEORIA DELLA PROBABILITÀ

A.1.5

Tabelle

A.1.5.1

Integrale di Gauss

L’integrale di Gauss è usualmente definito come funzione d’errore:

A

def 2

exp(−ξ 2) dξ

erf(A) = √

π 0

e anche come funzione d’errore complementata:

2

erfc(A) = 1 − erf(A) = √

π

def

+∞

exp(−ξ 2 ) dξ

A

La Tab.A.1.1 riporta i valori numerici più significativi delle funzioni d’errore.

Valgono le seguenti espressioni asintotiche, spesso utili per semplificare i calcoli:

1

erfc (A) √

exp −A2

πA

2

*

p

p

2 1

· exp −

erfc √

π p

2

2

In luogo della erfc(·), si incontra spesso anche la funzione Q(·), definita come

p

def 1

Q(p) = erfc √

2

2

Per comodità, si riportano due probabilità per la variabile aleatoria gaussiana x; tali probabilità sono spesso incontrate nei calcoli

riguardanti prestazioni di collegamenti di telecomunicazione.

p

P {|x − ηx | ≥ p · σx } = erfc √ = 2Q(p)

2

p

P {|x − ηx | < p · σx } = erf √ = 1 − 2Q(p)

2

Equivalentemente, posto ε = p · σx , abbiamo

ε

σx

σx 2

ε

ε

√

= 1 − 2Q

P {|x − ηx | < ε} = erf

σx

σx 2

P {|x − ηx | ≥ ε} = erfc

ε

√

= 2Q

Approssimazione Polinomiale

Poiché risulta erf(x) = − erf(−x), è sufficiente considerare valori x ≥ 0. Posto

def

t =

abbiamo

1

1 + 0.47047 · x

2

erf(x) = 1 − 0.3480242 · t − 0.0958798 · t2 + 0.7478556 · t3 · e−x

per x ≥ 0

A.1.5. TABELLE

461

A

erf(A)

erfc(A)

A

erf(A)

erfc(A)

A

erf(A)

erfc(A)

0.00

0.0000e+000

1.0000e+000

2.50

9.9959e-001

4.0695e-004

5.00

1.0000e+000

1.5375e-012

0.05

5.6372e-002

9.4363e-001

2.55

9.9969e-001

3.1066e-004

5.05

1.0000e+000

9.2131e-013

0.10

1.1246e-001

8.8754e-001

2.60

9.9976e-001

2.3603e-004

5.10

1.0000e+000

5.4938e-013

0.15

1.6800e-001

8.3200e-001

2.65

9.9982e-001

1.7849e-004

5.15

1.0000e+000

3.2599e-013

0.20

2.2270e-001

7.7730e-001

2.70

9.9987e-001

1.3433e-004

5.20

1.0000e+000

1.9249e-013

0.25

2.7633e-001

7.2367e-001

2.75

9.9990e-001

1.0062e-004

5.25

1.0000e+000

1.1310e-013

0.30

3.2863e-001

6.7137e-001

2.80

9.9992e-001

7.5013e-005

5.30

1.0000e+000

6.6131e-014

0.35

3.7938e-001

6.2062e-001

2.85

9.9994e-001

5.5656e-005

5.35

1.0000e+000

3.8477e-014

0.40

4.2839e-001

5.7161e-001

2.90

9.9996e-001

4.1098e-005

5.40

1.0000e+000

2.2277e-014

0.45

4.7548e-001

5.2452e-001

2.95

9.9997e-001

3.0203e-005

5.45

1.0000e+000

1.2834e-014

0.50

5.2050e-001

4.7950e-001

3.00

9.9998e-001

2.2090e-005

5.50

1.0000e+000

7.3578e-015

0.55

5.6332e-001

4.3668e-001

3.05

9.9998e-001

1.6080e-005

5.55

1.0000e+000

4.1975e-015

0.60

6.0386e-001

3.9614e-001

3.10

9.9999e-001

1.1649e-005

5.60

1.0000e+000

2.3828e-015

0.65

6.4203e-001

3.5797e-001

3.15

9.9999e-001

8.3982e-006

5.65

1.0000e+000

1.3460e-015

0.70

6.7780e-001

3.2220e-001

3.20

9.9999e-001

6.0258e-006

5.70

1.0000e+000

7.5662e-016

0.75

7.1116e-001

2.8884e-001

3.25

1.0000e+000

4.3028e-006

5.75

1.0000e+000

4.2321e-016

0.80

7.4210e-001

2.5790e-001

3.30

1.0000e+000

3.0577e-006

5.80

1.0000e+000

2.3556e-016

0.85

7.7067e-001

2.2933e-001

3.35

1.0000e+000

2.1625e-006

5.85

1.0000e+000

1.3047e-016

0.90

7.9691e-001

2.0309e-001

3.40

1.0000e+000

1.5220e-006

5.90

1.0000e+000

7.1904e-017

0.95

8.2089e-001

1.7911e-001

3.45

1.0000e+000

1.0661e-006

5.95

1.0000e+000

3.9434e-017

1.00

8.4270e-001

1.5730e-001

3.50

1.0000e+000

7.4310e-007

6.00

1.0000e+000

2.1520e-017

1.05

8.6244e-001

1.3756e-001

3.55

1.0000e+000

5.1548e-007

6.05

1.0000e+000

1.1686e-017

1.10

8.8021e-001

1.1979e-001

3.60

1.0000e+000

3.5586e-007

6.10

1.0000e+000

6.3146e-018

1.15

8.9612e-001

1.0388e-001

3.65

1.0000e+000

2.4448e-007

6.15

1.0000e+000

3.3953e-018

1.20

9.1031e-001

8.9686e-002

3.70

1.0000e+000

1.6715e-007

6.20

1.0000e+000

1.8167e-018

1.25

9.2290e-001

7.7100e-002

3.75

1.0000e+000

1.1373e-007

6.25

1.0000e+000

9.6722e-019

1.30

9.3401e-001

6.5992e-002

3.80

1.0000e+000

7.7004e-008

6.30

1.0000e+000

5.1242e-019

1.35

9.4376e-001

5.6238e-002

3.85

1.0000e+000

5.1886e-008

6.35

1.0000e+000

2.7014e-019

1.40

9.5229e-001

4.7715e-002

3.90

1.0000e+000

3.4792e-008

6.40

1.0000e+000

1.4171e-019

1.45

9.5970e-001

4.0305e-002

3.95

1.0000e+000

2.3217e-008

6.45

1.0000e+000

7.3970e-020

1.50

9.6611e-001

3.3895e-002

4.00

1.0000e+000

1.5417e-008

6.50

1.0000e+000

3.8421e-020

1.55

9.7162e-001

2.8377e-002

4.05

1.0000e+000

1.0188e-008

6.55

1.0000e+000

1.9858e-020

1.60

9.7635e-001

2.3652e-002

4.10

1.0000e+000

6.7000e-009

6.60

1.0000e+000

1.0213e-020

1.65

9.8038e-001

1.9624e-002

4.15

1.0000e+000

4.3847e-009

6.65

1.0000e+000

5.2268e-021

1.70

9.8379e-001

1.6210e-002

4.20

1.0000e+000

2.8555e-009

6.70

1.0000e+000

2.6617e-021

1.75

9.8667e-001

1.3328e-002

4.25

1.0000e+000

1.8506e-009

6.75

1.0000e+000

1.3488e-021

1.80

9.8909e-001

1.0909e-002

4.30

1.0000e+000

1.1935e-009

6.80

1.0000e+000

6.8009e-022

1.85

9.9111e-001

8.8890e-003

4.35

1.0000e+000

7.6594e-010

6.85

1.0000e+000

3.4123e-022

1.90

9.9279e-001

7.2096e-003

4.40

1.0000e+000

4.8917e-010

6.90

1.0000e+000

1.7036e-022

1.95

9.9418e-001

5.8207e-003

4.45

1.0000e+000

3.1089e-010

6.95

1.0000e+000

8.4634e-023

2.00

9.9532e-001

4.6777e-003

4.50

1.0000e+000

1.9662e-010

7.00

1.0000e+000

4.1838e-023

2.05

9.9626e-001

3.7419e-003

4.55

1.0000e+000

1.2374e-010

7.05

1.0000e+000

2.0580e-023

2.10

9.9702e-001

2.9795e-003

4.60

1.0000e+000

7.7496e-011

7.10

1.0000e+000

1.0073e-023

2.15

9.9764e-001

2.3614e-003

4.65

1.0000e+000

4.8297e-011

7.15

1.0000e+000

4.9063e-024

2.20

9.9814e-001

1.8628e-003

4.70

1.0000e+000

2.9953e-011

7.20

1.0000e+000

2.3778e-024

2.25

9.9854e-001

1.4627e-003

4.75

1.0000e+000

1.8485e-011

7.25

1.0000e+000

1.1467e-024

2.30

9.9886e-001

1.1432e-003

4.80

1.0000e+000

1.1352e-011

7.30

1.0000e+000

5.5026e-025

2.35

9.9911e-001

8.8927e-004

4.85

1.0000e+000

6.9375e-012

7.35

1.0000e+000

2.6274e-025

2.40

9.9931e-001

6.8851e-004

4.90

1.0000e+000

4.2189e-012

7.40

1.0000e+000

1.2484e-025

2.45

9.9947e-001

5.3058e-004

4.95

1.0000e+000

2.5531e-012

7.45

1.0000e+000

5.9022e-026

2.50

9.9959e-001

4.0695e-004

5.00

1.0000e+000

1.5375e-012

7.50

1.0000e+000

2.7766e-026

Tabella A.1.1: Tavola dei valori di erf(·) e erfc(·).