Università degli Studi della Basilicata

C.d.L. Economia Aziendale

Statistica a.a. 2014/2015

Docente: E. Di Nardo

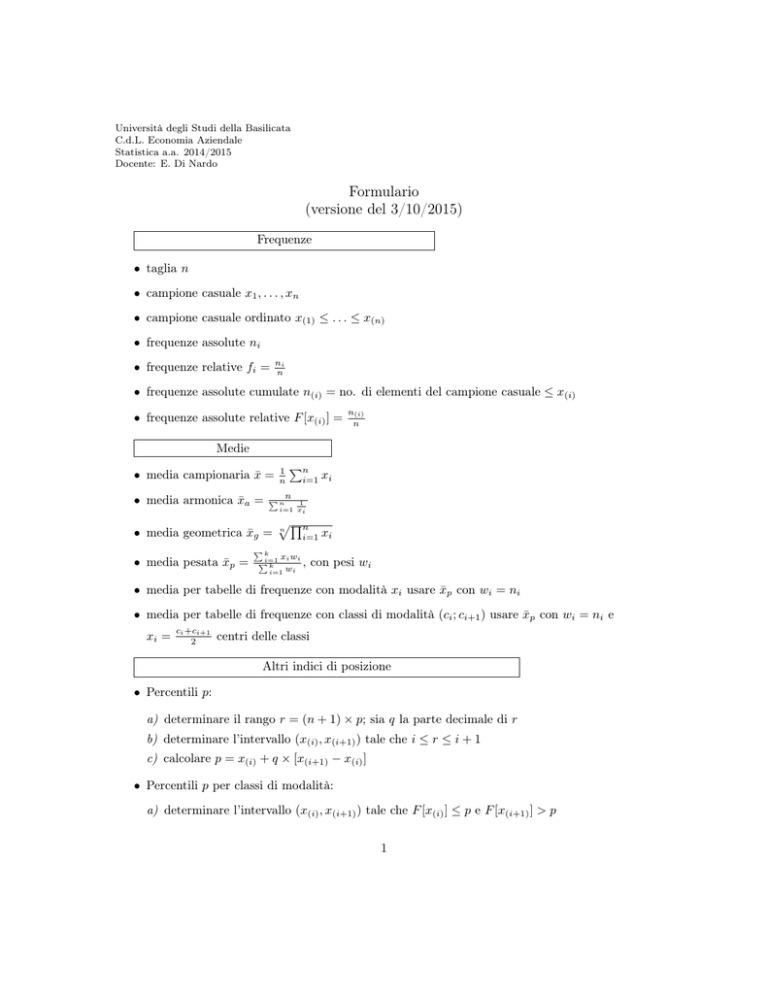

Formulario

(versione del 3/10/2015)

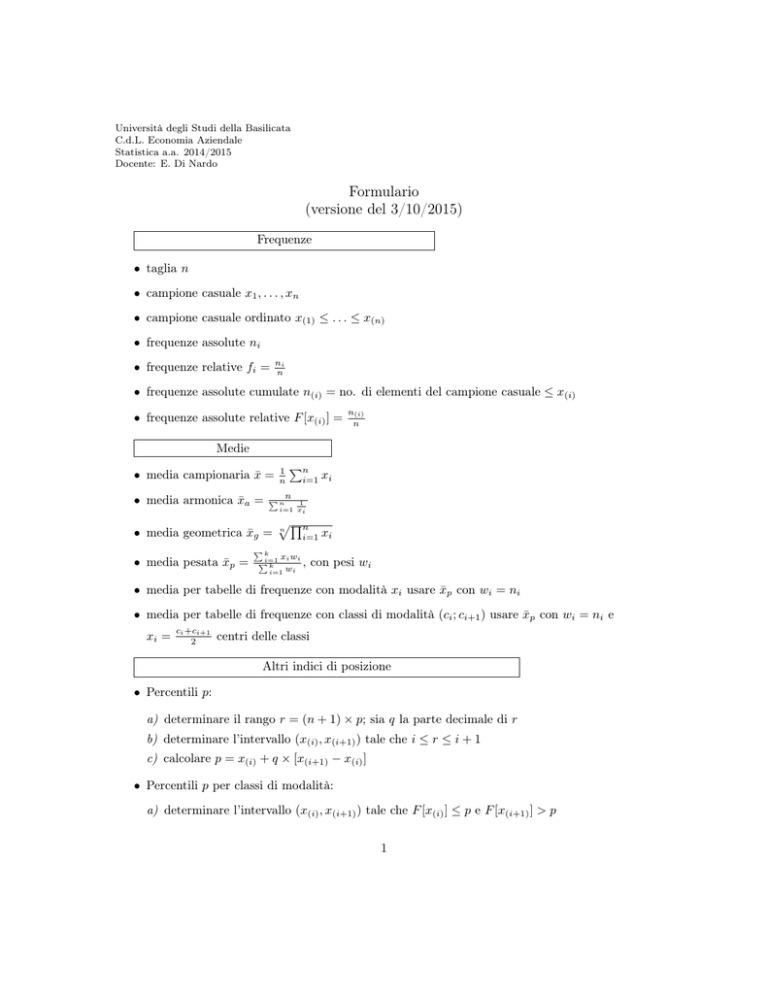

Frequenze

• taglia n

• campione casuale x1 , . . . , xn

• campione casuale ordinato x(1) ≤ . . . ≤ x(n)

• frequenze assolute ni

• frequenze relative fi =

ni

n

• frequenze assolute cumulate n(i) = no. di elementi del campione casuale ≤ x(i)

• frequenze assolute relative F [x(i) ] =

n(i)

n

Medie

• media campionaria x̄ =

• media armonica x̄a =

Pn

i=1

xi

Pn n

• media geometrica x̄g =

• media pesata x̄p =

1

n

1

i=1 xi

p

Qn

n

i=1

Pk

i=1 xi wi

P

,

k

i=1 wi

xi

con pesi wi

• media per tabelle di frequenze con modalità xi usare x̄p con wi = ni

• media per tabelle di frequenze con classi di modalità (ci ; ci+1 ) usare x̄p con wi = ni e

xi =

ci +ci+1

2

centri delle classi

Altri indici di posizione

• Percentili p:

a) determinare il rango r = (n + 1) × p; sia q la parte decimale di r

b) determinare l’intervallo (x(i) , x(i+1) ) tale che i ≤ r ≤ i + 1

c) calcolare p = x(i) + q × [x(i+1) − x(i) ]

• Percentili p per classi di modalità:

a) determinare l’intervallo (x(i) , x(i+1) ) tale che F [x(i) ] ≤ p e F [x(i+1) ] > p

1

p−F [x(i) ]

F [x(i+1) ]−F [x(i) ]

b) p = x(i) + a × [x(i+1) − x(i) ] dove a =

Indici di dispersione

• range ∆C = x(max) − x(min)

• intervallo interquartile IQR = Q3 − Q1 , dove Q1 , Q3 sono rispettivamente il primo e il terzo

quartile

Pn

1

2

• varianza S 2 = V ar(X) = n−1

i=1 (xi − x̄)

2

• varianza pesata Sw

=

Pk

(x −x̄)2 wi

i=1

Pk i

i=1 wi

, con pesi wi

2

• varianza per tabelle di frequenze con modalità xi usare Sw

con wi = ni

2

• varianza per tabelle di frequenze con classi di modalità (ci ; ci+1 ) usare Sw

con wi = ni e

ci +ci+1

xi =

centri

delle

classi

2

√

• scarto quadratico medio/Deviazione standard S = S 2

S

x̄

• coefficiente di variazione CV =

× 100

√

• precisione della media campionaria S/ n

• rapporto di concentrazione di Gini

2

(Pi − Qi )

n−1

x(1) + x(2) + · · · + x(i)

i

con Pi = , Qi =

n

x(1) + x(2) + · · · + x(n)

G=

• rapporto di concentrazione di Gini per modalità

con Pi =

x(1) × n(1) + x(2) × n(2) + · · · + x(i) × n(i)

i

, Qi =

n

x(1) × n(1) + x(2) × n(2) + · · · + x(k) × n(k)

R=

n−1

X

[(Pi−1 − Qi−1 ) + (Pi − Qi )]

i=1

• indice di eterogeneità di Gini e1 = 1 −

Pk

i=1

fi2

Indici di forma

• Asimmetria: = (x(max) − Q2 ) − (Q2 − x(min) )

Rapporti statistici

• rapporto di composizione

Pkai

i=1

ai

× 100

2

ni

n

• rapporto di coesistenza P1 /P2 , se P1 e P2 rappresentano il numero di elementi di due insiemi,

rispettivamente

• rapporto di derivazione (bi /ai ) × 100, se A è un fenomeno di stato e B é un fenomeno di

movimento

• numeri indici semplici a base fissa b It =

xt

xb

× 100

1/s

• variazione percentuale media v = (b1 It × b2 It × · · · × bs It )

1/s

x

• crescita percentuale media c = xfi − 1

× 100

• numeri indici semplici a base mobile

• cambiamento di base c It =

b It

b Ic

t−1 It

=

xt

xt−1

× 100

× 100

Ps

p q

Psi=1 it ib ,

i=1 pib qib

• indice di Laspeyres IL =

con pit prezzo tempo corrente, qit quantità tempo corrente, pib prezzo tempo di base, qib quantità tempo base.

Ps

p q

it it

• indice di Paasche IP = Psi=1 pib

qit

i=1

√

• indice di Fisher IF = IL IP

Indici di dipendenza

• Distribuzioni doppie:

ni0 =

T

X

nih , per ogni i = 1, . . . , S marginali sulle righe

h=1

n0j =

S

X

nhj , per ogni j = 1, . . . , T marginali sulle colonne

h=1

n=

S

X

ni0 =

PN

SXY =

i=1 (Xi

n0j totali

j=1

i=1

• Covarianza:

T

X

N

− µX )(Yi − µY )

1 X

=

Xi Yi − µX µY

N

N i=1

• Indice di connessione di Cramer e statistica test chi-quadrato per tavole di contingenza (Cr ):

Cr =

s X

t

X

c2ij n̂ij ,

cij = nij − n̂ij , n̂ij =

i=1 j=1

s

Cr∗ =

Cr

n min{s − 1, t − 1}

3

ni0 n0j

N

• Coefficiente di correlazione lineare:

rX,Y =

SXY

SX SY

• Coefficiente di determinazione:

2

R2 = rX,Y

• Coefficiente di Spearman:

Pn

2

i=1 (RXi − RYi )

n(n2 − 1)

ρX = 1 − 6

Regressione

• retta dei minimi quadrati: se X rappresenta la variabile indipendente e Y la variabile dipendente, Y = a X + b con

a = rX,Y

SY

SX

e b = ȳ − ax̄

Probabilità

• Probabilità dell’unione:

P (A ∪ B) = P (A) + P (B) − P (A ∩ B)

• Probabilità condizionata:

P (A|B) =

P (A ∩ B)

P (B)

• Legge del prodotto:

P (A ∩ B) = P (A|B)P (B) = P (B|A)P (A)

P (A1 ∩ A2 ∩ . . . ∩ An ) = P (A1 )P (A2 |A1 )P (A3 |A1 ∩ A2 ) · · · P (An |A1 ∩ · · · ∩ An−1 )

• Eventi indipendenti: P (A ∩ B) = P (A)P (B)

• Probabilità composte:

P (B) =

n

X

P (Ai )P (B|Ai )

i=1

• Teorema di Bayes:

P (Ai )P (B|Ai )

P (Ai |B) = Pn

i=1 P (Ai )P (B|Ai )

Distribuzioni di probabilità

4

• Media di una v.a.

( P

R k ∈ I xk P (X = xk ),

E(X) =

xfX (x)dx,

R

se X è discreta

se X è assolutamente continua

– Proprietà: se Y = aX + b allora E(Y ) = aE(X) + b

• Varianza di una v.a.

Sia m = E(X) il valore atteso di X

( P

m)2 P (X = xk ),

R k ∈ I (xk −

V ar(X) =

2

(x − m) fX (x)dx,

R

se X è discreta

se X è assolutamente continua

– Proprietà: se Y = aX + b allora V ar(Y ) = a2 E(X)

– Formula operativa: V ar(X) = E(X 2 ) − [E(X)]2

• Funzione di ripartizione:

( P

R xxk ≤x P (X = xk ),

FX (x) = P (X ≤ x) =

f (x)dx,

−∞ X

se X è discreta

se X è assolutamente continua

Si ha: P (a ≤ X ≤ b) = P (X ≤ b) − P (X ≤ a)

• Distribuzione binomiale (estrazioni con reimmissione): X ∼ Bin(n, p)

E(X) = np

V ar(X) = np(1 − p)

Se n = 1 allora X bernoulliana con P (X = 0) = q e P (X = 1) = p

• Distribuzione ipergeometrica (estrazioni senza reimmissione): X ∼ Hp(N, K, n)

K

N

K

K N −n

V ar(X) = n

1−

N

N N −1

E(X) = n

• Distribuzione di Poisson: X ∼ P o(λ)

E(X) = λ

V ar(X) = λ

• Distribuzione gaussiana: X ∼ N (µ, σ 2 )

E(X) = µ

V ar(X) = σ 2

5

– se µ = 0, σ 2 = 1, allora Z ∼ N (0, 1)

∗

∗

∗

∗

FZ (−z) = 1 − F − Z(z)

P (Z ≤ z) = F( z)

P (Z ≥ z) = 1 − Fz (z)

P (|Z| ≤ z) = 2 FZ (z) − 1

– se X ∼ N (µ, σ 2 ) allora Y = aX + b ∼ N (aµ + b, a2 σ 2 )

– se X1 , X2 indipendenti, allora X1 ± X2 ∼ N (µ1 ± µ2 , σ12 + σ22 )

• Distribuzione chi-quadrato: X ∼ χ2n

E(X) = n

V ar(X) = 2n

• Distribuzione T-Student: X ∼ tn

E(X) = 0

V ar(X) =

n

n−2

• Distribuzione uniforme: X ∼ U(a, b)

1

, a≤x≤b

b−a

a+b

E(X) =

2

(b − a)2

V ar(X) =

12

fX (x) =

Distribuzioni campionarie

• media campionaria X̄ =

1

n

Pn

k=1

Xk

– campionamento con ripetizione su pop. infinita oppure pop. normale

E(X̄) = E(Xi ) e V ar(X̄) =

V ar(Xi )

n

– campionamento senza ripetizione su pop. finita

E(X̄) = E(Xi ) e V ar(X̄) =

– per n > 15,

X̄ − E(X̄)

∼ Z ∼ N (0, 1)

D(X̄)

– per popolazioni gaussiane,

X̄ − E(X̄)

p

∼ Tn−1

S/n

6

V ar(Xi ) N − n

n

N −1

2

2

• varianza campionaria per popolazioni gaussiane: (n−1)

σ 2 S ' χn−1

Pn

• frequenza campionaria p̂ = n1 k=1 Xk , E(p̂) = p, V ar(p̂) = p(1−p)

n

Proprietà degli stimatori

• Correttezza E(T ) = θ

• Efficienza σ 2 (T1 ) ≤ σ 2 (T2 )

Intervalli di confidenza

• Intervalli di confidenza per la media:

– varianza nota, pop. gaussiana

σ

σ X̄ − z1−α/2 √ ; X̄ + z1−α/2 √

n

n

– varianza ignota, pop. gaussiana

h

S i

S

X̄ − tn−1;1−α/2 √ ; X̄ + tn−1;1−α/2 √

n

n

– pop. non gaussiana (n > 15)

h

S i

S

X̄ − z1−α/2 √ ; X̄ + z1−α/2 √

n

n

• Intervalli di confidenza per la varianza:

h (n − 1)S 2 (n − 1)S 2 i

;

χ21−α/2

χ2α/2

• Intervalli di confidenza per percentuali:

r

r

h

p̂(1 − p̂)

p̂(1 − p̂) i

; p̂ + z1−α/2

p̂ − z1−α/2

n

n

n0 =

0.5 z1−α/2

E

2

pop.infinita

n=

n0

pop.finita taglia N

+1

n0

N

• Intervalli di confidenza per la differenza tra medie:

– varianze note, pop. gaussiana o non gaussiana n > 15

s

s

2

2

2

2

σ

σ

σ

σ

1

1

(X̄1 − X̄2 ) − z1−α/2

+ 2 ; (X̄1 − X̄2 ) + z1−α/2

+ 2

n1

n2

n1

n2

7

– varianze ignote ma uguali, pop. gaussiana Sp2 =

(n1 −1)S12 +(n2 −1)S22

,m

n1 +n2 −2

= n1 + n2 − 2

r

r

1

1

1

1

+

; (X̄1 − X̄2 ) + t1−α/2;m Sp

+

(X̄1 − X̄2 ) − t1−α/2;m Sp

n1

n2

n1

n2

– pop. non gaussiana (n > 15)

s

(X̄1 − X̄2 ) − z1−α/2

S12

S2

+ 2 ; (X̄1 − X̄2 ) + z1−α/2

n1

n2

s

S12

S22

+

n1

n2

• Intervalli di confidenza per la differenza tra percentuali: p̂1 , p̂2 frequenze relative stimate

s

(p̂1 − p̂2 ) − z1−α/2

p̂1 (1 − p̂1 ) p̂2 (1 − p̂2 )

+

; (p̂1 − p̂2 ) + z1−α/2

n1

n2

s

p̂1 (1 − p̂1 ) p̂2 (1 − p̂2 )

+

n1

n2

Test di ipotesi

• potenza del test: 1 − β = P ( “rigettare H0 ” | “H0 è vera ”)

2 P (Stat.Test > valore osservato|“H0 è vera ”)

• p-value (test a due code):

2 P (Stat.Test < valore osservato|“H0 è vera ”)

• verifica di ipotesi sulla media

– varianza nota

H0

H1

µ = µ0

µ 6= µ0

µ < µ0

µ ≥ µ0

µ > µ0

µ ≤ µ0

regione accettazione

σ

σ

µ0 − z1−α/2 √ ; µ0 + z1−α/2 √

n

n

σ

−∞; µ0 + z1−α √

n

σ

µ0 − z1−α √ ; ∞

n

– varianza incognita

8

se valore osservato > θ0

se valore osservato < θ0

H0

H1

µ = µ0

µ 6= µ0

µ < µ0

µ ≥ µ0

µ > µ0

µ ≤ µ0

regione accettazione

S

S

µ0 − t1−α/2;n−1 √ ; µ0 + t1−α/2;n−1 √

n

n

S

−∞; µ0 + t1−α;n−1 √

n

S

µ0 − t1−α;n−1 √ ; ∞

n

– varianza incognita (n > 15)

H0

H1

µ = µ0

µ 6= µ0

µ < µ0

µ ≥ µ0

µ > µ0

µ ≤ µ0

regione accettazione

S

S

µ0 − z1−α/2 √ ; µ0 + z1−α/2 √

n

n

S

−∞; µ0 + z1−α √

n

S

µ0 − z1−α √ ; ∞

n

• verifica di ipotesi per una popolazione bernoulliana

H0

H1

regione accettazione

r

p = p0

p 6= p0

p0 − z1−α/2

p0 (1 − p0 )

; p0 + z1−α/2

n

r

p < p0

p ≥ p0

−∞; p0 + z1−α

r

p > p0

p ≤ p0

p0 − z1−α

• verifica di ipotesi per la varianza

9

r

p0 (1 − p0 )

n

p0 (1 − p0 )

n

!

!

p0 (1 − p0 )

;∞

n

!

H0

H1

σ = σ0

σ 6= σ0

σ < σ0

σ ≥ σ0

σ > σ0

σ ≤ σ0

regione accettazione

σ02

σ2

; χ21−α/2;n−1 0

n−1

n−1

χ2α/2;n−1

0; χ2α;n−1

χ21−α;n−1

σ02

n−1

σ02

;∞

n−1

• verifica di ipotesi sulla differenza tra le medie di popolazioni gaussiane

– varianze note

H0

H1

regione accettazione

s

s

2

2

2

2

∆0 − z1−α/2 σ1 + σ2 ; ∆0 + z1−α/2 σ1 + σ2

n1

n2

n1

n2

s

2

2

−∞; ∆0 + z1−α σ1 + σ2

n1

n2

s

2

2

∆0 − z1−α σ1 + σ2 ; ∞

n1

n2

µ1 − µ2 = ∆0

µ1 − µ2 6= ∆0

µ1 − µ2 < ∆0

µ1 − µ2 ≥ ∆0

µ1 − µ2 > ∆0

µ1 − µ2 ≤ ∆0

– varianze incognite ma uguali: statistica test X̄1 −X̄2 ; varianza pesata Sp2 =

gradi di libertà m = n1 + n2 − 2

H0

H1

µ1 − µ2 = ∆0

µ1 − µ2 6= ∆0

µ1 − µ2 < ∆0

µ1 − µ2 ≥ ∆0

µ1 − µ2 > ∆0

µ1 − µ2 ≤ ∆0

(n1 −1)S12 +(n2 −1)S22

;

n1 +n2 −2

rregione accettazione

r

1

1

1

1

∆0 − t1−α/2;m Sp

+

; ∆0 + t1−α/2;m Sp

+

n1

n2

n2

r

n1

1

1

−∞; ∆0 + t1−α;m Sp

+

n1

n2

r

1

1

∆0 − t1−α;m Sp

+

;∞

n1

n2

– varianze incognite, dati accoppiati: T-test per un campione ottenuto effettuando le differenze tra i dati.

m2

1

• verifica di ipotesi sulla differenza tra due probabilità: statistica test m

n1 + n2 , dove m1 è il

numero di successi nel primo campione di taglia n1 e m2 è il numero di successi nel secondo

2

campione di taglia n2 ; percentuale pesata p̂ = mn11 +m

+n2

10

H0

H1

s

p1 = p2

p1 6= p2

p1 < p2

p1 ≥ p2

p1 > p2

p1 ≤ p2

−z1−α/2

regione accettazione

s

!

1

1

1

1

p̂(1 − p̂)

+

; z1−α/2 p̂(1 − p̂)

+

n1

n

n1

n2

s 2

!

1

1

−∞; z1−α p̂(1 − p̂)

+

n1

n2

s

!

1

1

−z1−α p̂(1 − p̂)

+

;∞

n1

n2

• verifica di ipotesi sul rapporto tra varianze: statistica test S12 /S22

H0

H1

σ12 = σ22

σ12 6= σ22

σ12 < σ22

σ12 > σ22

σ12 ≥ σ22

σ12 ≤ σ22

regione accettazione 2

2

fα/2;n

; f1−α/2;n

1 ;n2

1 ;n2

2

0; f1−α;n

1 ;n2

(fα;n1 ;n2 ; ∞)

• Analisi di dati di frequenza

– Test chi-quadrato per distribuzioni:

statistica test

k

Oi

Ei

regione di accettazione

p

2

Pk

i)

,

χ2 = i=1 (Oi −E

Ei

numero delle classi

frequenze osservate

frequenze attese

(0, χ2α,k−p−1 )

numero dei parametri stimati

– Test di Kolmogorov-Smirnov:

statistica test

x(i)

F (x)

F̂ (x)

regione di accettazione

D = maxi |F̂ (x(i) ) − F (x(i) )|

i-esimo dato osservato nel campione casuale

funzione di ripartizione teorica

funzione di ripartizione empirica F̂ (x) = numero ndi dati≤x .

(0, Dn,α )

11