TEORIA DELLA PROBABILITÀ

1

1.1. CENNI STORICI

I primi contributi all’elaborazione della teoria della probabilità risalgono alla fine del XV secolo. Luca Pacioli, amico di Leonardo da Vinci, si occupa del problema della ripartizione della posta tra giocatori nel caso di interruzione di un popolare gioco in uno dei volumi della Summa de arithmetica, geometria, proportioni et proportionalita pubblicata nel 1494. Il problema,

successivamente studiato da Tartaglia, è infine risolto da Pascal e Fermat.

Girolamo Cardano analizza il gioco dei dadi nel Liber de ludo aleae – scritto

nel 1526, ma pubblicato dopo un secolo e mezzo, nel 1663 – e da Galileo Galilei (Sulla scoperta dei dadi, 1656). Da notare che i due autori ricorrono al calcolo combinatorio per ottenere il numero di sequenze risultanti dal lancio

di un dado n volte.

L'individuazione di un preciso riferimento cronologico per la nascita

della definizione di probabilità è una questione ancora aperta. Una delle

tappe fondamentali sembra essere il 1654. Antoine Gombaud, cavaliere di

Méré, un nobile francese appassionato di giochi d'azzardo, richiama l'attenzione di Pascal sull'apparente contraddizione emersa in un popolare

gioco d’azzardo, consistente nel lancio ripetuto di una coppia di dadi. Il

problema che Gombaud sottopone a Pascal è calcolare la probabilità di ottenere almeno un "doppio 6" nell'arco di 24 lanci. Una regola operativa diffusa tra i giocatori dell’epoca suggeriva che scommettere sull’evento “il

doppio 6 si verifica almeno una volta su 24 lanci” sarebbe stato vantaggioso, ma i calcoli di Gombaud portavano a conclusioni opposte.

Questo ed altri problemi sollevati da Gombaud portarono Pascal e Fermat ad uno scambio epistolare, nel quale furono formulati per la prima volta alcuni principi fondamentali della teoria della probabilità. Infatti, sebbene alcuni problemi specifici concernenti i giochi aleatori fossero stati risolti

da matematici italiani già nel XV e XVI secolo, come si è detto in precedenza, nessuna formulazione teorica generale era stata sviluppata prima del

carteggio Pascal‒Fermat.

2

Lo scienziato olandese Christian Huygens, un insegnante di Leibnitz,

venuto a conoscenza di questa corrispondenza, pubblica nel 1657 il primo

trattato di teoria della probabilità, dal titolo De ratiociniis in ludo aleae. Poiché il libro si occupava di giochi aleatori, la cui “febbre” stava dilagando in

quel periodo, la teoria della probabilità divenne presto famosa e si sviluppò

rapidamente durante il XVIII secolo. Tra gli studiosi ai quali si devono fondamentali contributi alla teoria della probabilità in questo periodo, ricordiamo Jacob Bernoulli (1654-1705) e Abraham De Moivre (1667-1754).

Nel 1812 Pierre Simon de Laplace (1749-1827) introduce nuove idee e

tecniche matematiche nel suo testo Théorie Analytique des Probabilités. Se

prima di Laplace la teoria della probabilità si occupava per lo più dello sviluppo di una matematica dei giochi aleatori, allo studioso francese si deve

l’applicazione di un approccio probabilistico in molti problemi scientifici e

pratici. La teoria degli errori, la matematica attuariale e la meccanica statistica sono esempi di alcune delle applicazioni della teoria della probabilità

sviluppate nel XIX secolo.

In quegli stessi anni, Gauss, con il contributo dello stesso Laplace, presentava una prima formulazione della distribuzione normale, conosciuta

anche come distribuzione di Gauss-Laplace, che costituisce uno dei cardini

su cui si fonda la statistica moderna.

Dai tempi di Laplace, molti studiosi hanno contribuito alla sviluppo

formale della teoria della probabilità. Tra i più importanti Chebychev,

Markov, von Mises, De Finetti e Kolmogorov.

Una delle difficoltà nello sviluppo di una teoria matematica della probabilità è stata il raggiungimento di una definizione di probabilità sufficientemente rigorosa e precisa per l'utilizzo all’interno di un modello matematico ma, al tempo stesso, flessibile al fine di essere utilizzata per

l’analisi di un’ampia gamma di fenomeni. La ricerca di una definizione accettabile ha richiesto quasi tre secoli ed è stata segnata da innumerevoli dispute. Il problema è stato definitivamente risolto nel XX secolo, quando la

teoria della probabilità è stata riformulata su basi completamente assiomatiche. Nel 1933, nella monografia Grundbegriffe der Wahrscheinlichkeitsrechnung (Fondamenti di teoria della probabilità), Kolmogorov delinea l’approccio

assiomatico che è alla base della moderna teoria della probabilità. Da allora,

queste idee sono state alquanto sviluppate e la teoria della probabilità ora è

parte di una più generale disciplina matematica, la teoria della misura.

3

1.2. L’EVOLUZIONE DELLE DEFINIZIONI

La teoria della probabilità è una branca delle discipline matematiche che

studia i problemi di definizione e misurazione dell’incertezza.

La realtà che ci circonda è la sintesi – il prodotto – di infiniti fatti le cui

cause si intrecciano e si sovrappongono. Nonostante l’estrema complessità

della realtà fenomenica e la difficoltà di individuare leggi generali,

l’osservazione e l’esperienza pongono in evidenza ripetizioni e regolarità –

è il cosiddetto problema sull’induzione di Hume – che possono essere condensate in affermazioni del tipo: “Ogni volta che si realizza un certo insieme di condizioni B, si verifica l’evento E”. In questo caso, l’evento E è detto

evento certo, in quanto definito in maniera univoca dall’insieme delle condizioni B. In notazione logica sarà

E B

Se il set informativo a disposizione dell’agente non è B, ma un sottoinsieme parziale di condizioni C, non si avrà come conseguenza necessaria il

verificarsi di E. Si parlerà in questo caso di evento incerto, o casuale.

Il concetto di probabilità si presenta con due significati: quello di chance,

quando l’osservazione sul risultato di un esperimento e la sua valutazione

dipendono dal caso – nel senso chiarito in precedenza – e l’esperimento è

suscettibile di essere ripetuto un gran numero di volte; e quello di probabilità in senso stretto, attinente ad un esperimento difficilmente ripetibile.

Introduciamo tre concetti, che risulteranno utili nel seguito della trattazione:

Esperimento casuale. Operazione (o sequenza di operazioni) il cui

esito non può essere previsto con certezza.

Evento elementare. Qualunque risultato a cui può dare luogo un

esperimento. Gli eventi elementari possono essere considerati

come elementi di un più generale spazio degli eventi.

Spazio campione. È l’insieme di tutti gli eventi elementari o evento certo. In generale gli eventi elementari costituiranno sottoinsiemi

in .

Occupiamoci adesso della definizione della misura di probabilità e della

sua evoluzione storica.

4

Definizione classica. Originariamente dovuta a Laplace, afferma che

dato uno spazio finito di eventi , la probabilità è il rapporto tra il numero n

dei casi favorevoli al verificarsi di un qualunque evento e il numero n dei casi

possibili, posto che gli eventi siano tutti equiprobabili.

Pr( )

n

n

La definizione classica è una definizione a priori. Per esempio, con riferimento all’esperimento consistente nel lancio di una moneta ben bilanciata, l’agente conosce ex ante gli eventi elementari (testa, croce) cui

l’esperimento può dare luogo. Gli eventi hanno la caratteristica fondamentale di essere necessari, in quanto nel corso dell’esperimento o l’uno o l’altro

degli eventi elementari deve necessariamente verificarsi; mutuamente esclusivi (o incompatibili), tali cioè che il verificarsi dell’uno esclude il verificarsi

dell’altro; ed equiprobabili, in quanto si assume che nessuno dei due eventi

elementari abbia maggiori chance di manifestarsi rispetto all’altro.

Per quanto di immediata comprensibilità e di pronta applicazione a

semplici problemi pratici, la definizione classica è insoddisfacente da un

punto di vista logico. Infatti, il riferimento nella definizione alla nozione di

equiprobabilità dei risultati configura una tautologia1. Inoltre, a prescindere

dalle sue lacune logiche, l’applicabilità della definizione classica è confinata

a quei contesti in cui l’osservatore sia in grado di rappresentare ex ante lo

spazio degli eventi elementari e che questi, come detto, siano equiprobabili,

condizioni che difficilmente si presentano nella realtà.

Definizione frequentista. Formulata da Venn (1834-1923), emerge da

un ragionamento a posteriori fondato sull’osservazione dei risultati di un

esperimento.

Consideriamo un esperimento articolato in n prove, nel corso del quale

si verifichino k eventi elementari 1 ...k tra loro incompatibili, ma non

equiprobabili. Ipotizziamo che in n prove l’evento elementare i si sia manifestato ni volte. Definendo la frequenza relativa dell’evento i il rapporto

ni n , la misura di probabilità del generico evento elementare è il limite della sua

frequenza relativa al divergere del numero di prove.

È appena il caso di ricordare che in logica la tautologia è un’affermazione vera per definizione e, in quanto tale, fondamentalmente priva di contenuto informativo. Una tautologia,

in altre parole, ragiona circolarmente attorno agli argomenti o alle definizioni. Un esempio

di affermazione tautologica: “La tautologia è ciò che è tautologico”.

1

5

In simboli avremo che

n

n n

Pr( ) lim

La definizione frequentista è stata anche definita legge empirica del caso.

Proprio perché formulata a posteriori, presenta alcune limitazioni. Quella

più ovvia è che la misura di probabilità nella definizione frequentista presuppone lo svolgimento di un esperimento articolato su un gran numero di

prove. Se un evento non si è ancora manifestato nel corso dell’esperimento,

non se ne può misurare la probabilità: sarebbe infatti necessario ripetere

l’esperimento infinite volte per avere la certezza che tutti gli eventi elementari si siano effettivamente manifestati.

Inoltre, sebbene la definizione frequentista sia largamente diffusa nelle

scienze applicate, non è universale. Per risolvere il problema

dell’universalità sono stati proposti due approcci più consistenti sul piano

matematico, l’impostazione soggettiva e quella assiomatica.

Definizione soggettiva. L’approccio in termini soggettivi appare alla

fine degli anni venti del XX secolo in risposta alle citate lacune logiche

dell’impostazione classica e di quella frequentista.

Partiamo da una premessa generale. Nella vita di tutti i giorni possono

manifestarsi eventi unici, irripetibili, rispetto ai quali un osservatore potrebbe essere chiamato a prendere decisioni, senza conoscerne pienamente

conseguenze e implicazioni. In questi contesti, di incertezza in senso proprio più che di rischio2, le misure classiche e frequentiste di probabilità non

risultano più applicabili.

Sviluppata indipendentemente da Ramsey (1903-1930) e De Finetti

(1906-1985), l’impostazione soggettiva afferma che la probabilità di un evento

è una misura p del grado di fiducia che un individuo attribuisce al verificarsi di

sulla base delle sue opinioni ed informazioni sull’evento e il principio di coerenza.

In realtà De Finetti preferiva utilizzare una definizione più operativa: la

probabilità di un evento , secondo l’opinione di un individuo I, è il prezzo p che I

Dobbiamo a Knight la distinzione tra rischio (measurable uncertainty) e incertezza (unmeasurable uncertainty). Una decisione in condizioni di rischio si realizza quando il decisore ha cognizione di tutti gli stati in cui può manifestarsi un fenomeno ed è in grado di associare una

misura di probabilità a ciascuno stato. Di contro, quando l’agente non dispone di una rappresentazione completa dello spazio degli stati e/o non è in grado di assegnare una misura

di probabilità a ciascuno di essi, si parlerà più propriamente di decisioni in condizioni di incertezza.

2

6

giudica equo pagare per riscuotere un importo unitario nel caso in cui si verifichi.

L’impostazione soggettiva tende a recuperare, in un certo senso, un

concetto di probabilità prossimo al senso comune, quello che, nota

D’Agostini (1999), si ha “prima di andare a scuola” e che si continua a utilizzare inconsciamente dopo, “nonostante quello che si è appreso”. Per i

soggettivisti la probabilità è una misura del grado di fiducia – in inglese degree of belief – che una qualsiasi affermazione sia vera. E poiché quanto più

si crede in un’affermazione, tanto più si è disposti a scommettere su di essa,

si può utilizzare il concetto di scommessa coerente per definire in maniera

operativa la misura di probabilità.

Nella concezione di De Finetti una scommessa è coerente quando non

determina una perdita certa a priori per il banco o per lo scommettitore,

mentre il prezzo pagato si definisce equo se lo scommettitore non muta i

termini della scommessa anche quando scambia il suo ruolo con quello di

banco.

Quindi coerenza significa il rispetto di alcuni criteri di carattere logico.

Con la diretta implicazione che, per quanto in questa impostazione la valutazione sia un atto soggettivo, non è arbitraria. Infatti, se nell’analisi di un

problema le valutazioni di una pluralità di osservatori potrebbero non concordare, quando il set informativo di cui dispone l’osservatore rimane immutato, non deve mutare il suo grado di fiducia circa l’avverarsi di .

Un esempio contribuirà a chiarire i concetti appena esposti. Consideriamo l’evento ‘‘vittoria del pilota X nella gara automobilistica Y”. Ipotizziamo che dietro pagamento di 0 euro un allibratore ve ne promettesse 100

nel caso si verifichi accettereste di partecipare alla scommessa? Sicuramente sì, in quanto l’allibratore vi ha chiesto 0 per partecipare al gioco e

l’evento potrebbe verificarsi. Ipotizziamo adesso che l’allibratore vi chieda di scommettere 10 eurocent. In questo caso accettereste di partecipare?

Quasi certamente la risposta sarebbe ancora affermativa, perché a fronte di

una perdita massima di 10 eurocent la vincita potrebbe essere molto superiore. Ma se per scommettere l’allibratore vi chiedesse 90 euro, accettereste

di partecipare? Verosimilmente no, a meno che il vostro information set non

vi induca a ritenere che la scommessa è comunque vantaggiosa. Dunque

con un prezzo di 10 eurocent partecipate alla scommessa, mentre non partecipate se non a condizioni stringenti quando il prezzo è di 90 euro.

Generalizzando, se uno scommettitore accetta di partecipare al gioco

pagando un prezzo p, accetterà a maggior ragione al prezzo p* p . Di contro, se uno scommettitore non partecipa al gioco al prezzo p, rifiuterà a

maggior ragione al prezzo p * * p . Esisterà quindi un valore soglia di p

che separa la decisione di partecipare alla scommessa da quella di non par-

7

tecipare. Quel valore soglia p è la probabilità soggettiva da voi assegnata a

.

In generale, se un certo evento nell’ambito di una scommessa coerente e ipotizzando che il prezzo sia equo, viene dato “x contro y”, la probabilità soggettiva di risulterà pari a

p( )

y

yx

Per esempio, se un allibratore propone una scommessa “4 contro 1” sul

verificarsi di un certo evento , significa che si impegna, al verificarsi

dell’evento, a riconoscere allo scommettitore un premio pari a 4 più il rimborso del prezzo pagato da quest’ultimo per partecipare al gioco – pari ad 1

– da cui è immediato ottenere p() 1 (1 4) 0,2 .

Definizione assiomatica. Formulata da Kolmogorov (1903-1987), è considerata la definizione più consistente sul piano matematico, in quanto,

come chiarito in precedenza, si fonda su alcuni principi generali di teoria

della misura. In base a tale definizione, data una algebra3 C di sottoinsiemi

A , la misura di probabilità Pr è una funzione che associa ad ogni sottoinsieme

A un numero reale non negativo. In simboli

Pr : A

La funzione di probabilità soddisfa 4 assiomi:

1. Non negatività.

Pr( A) 0

2. Normalizzazione.

Pr() 1

A C

3. Additività finita.

Dati due eventi A e B incompatibili, tali cioè che A B

Pr( A B) Pr( A) Pr( B)

4. Completa additività.

Data una famiglia composta da un’infinità numerabile di eventi

{ Ak } { AK ; k 1,2,...} a due a due incompatibili, tali cioè che

Ai Aj i j

Il lettore interessato può consultare l’Appendice 1 per alcune sintetiche informazioni sulla

nozione di algebra e in generale sulla teoria degli insiemi.

3

8

Pr Ak Pr( Ak )

k 1 k 1

Nell’impostazione assiomatica si adotta una definizione di probabilità

su una algebra C perché si è interessati non soltanto agli eventi elementari, ma anche a sequenze finite o infinite di operazioni di unione, intersezione, differenza, negazione. Gli eventi complessi così definiti appartengono

di nuovo a C, per cui se ne può definire la probabilità. Notare anche che,

per le leggi di De Morgan, data una successione { Ak } C

se Ak C Ak C

k 1

k 1

e quindi anche le probabilità degli eventi intersezione possono essere misurate.

1.3. PROPRIETÀ DELLA MISURA DI PROBABILITÀ

La misura di probabilità gode di alcune proprietà che consentono di

quantificare l’incertezza dell’osservatore non soltanto circa il verificarsi di

eventi elementari, ma anche circa il verificarsi di sottoinsiemi di eventi, cioè

di suddivisioni dello spazio campione . Queste proprietà sussistono indipendentemente dalla definizione adottata di probabilità. Nel caso delle definizioni classiche e frequentistiche, le proprietà sono una conseguenza della formula di calcolo adottata (una frequenza relativa), mentre nelle definizioni soggettivistiche e assiomatiche trovano fondamento in alcuni principi

di natura logica.

Ad ogni modo, nel seguito della trattazione, preferiamo per motivi formali attenerci esclusivamente all’impostazione assiomatica. Dagli assiomi

1‒4 elencati in precedenza derivano tutte le proprietà della probabilità.

Proprietà 1. Probabilità dell’evento negazione.

Pr(A) 1 Pr( A)

A C

Dimostrazione. Poiché A { : A} , questo implica che A A e

A A . In virtù dell’assioma 2 è Pr() 1 , mentre per l’assioma 3 risulta Pr( A A) Pr( A) Pr(A) . Nel complesso avremo che

Pr( A) Pr(A) Pr() Pr(A) 1 Pr( A)

9

Osservando poi che

Pr( ) 1 Pr()

Pr( ) 1 1 0

□

Proprietà 2. Estremi della misura di probabilità

0 Pr( A) 1

A C

Dimostrazione. Poiché in virtù dell’assioma 1 risulta Pr( A) 0 , mentre

per l’assioma 2 è Pr() 1 , allora risulterà anche Pr(A) 0 . Si è poi visto

che Pr(A) 1 Pr( A) . Combinando i risultati precedenti si avrà quindi

Pr(A) 0 1 Pr( A) 0 Pr( A) 1

Combinando questo risultato con l’assioma 1, otteniamo

0 Pr( A) 1

□

Proprietà 3. Additività in una successione finita. Data una famiglia composta da un numero finito di eventi { Ak } { Ak ; k 1,2,...,n} a due a due incompatibili, tali cioè che Ai Aj i j

n

n

Pr Ak Pr( Ak )

k 1 k 1

Dimostrazione. Data una famiglia finita di 3 eventi { A1 , A2 , A3 } C a due

a due incompatibili, risulterà

( A1 A2 ) A3 ( A1 A3 ) ( A2 A3 )

e poiché in virtù dell’assioma 3 Pr( A B) Pr( A) Pr( B) segue che

Pr[( A1 A2 ) A3 ] Pr( A1 A2 ) Pr( A3 )

Pr( A1 ) Pr( A2 ) Pr( A3 )

□

Naturalmente, quanto dimostrato per una successione di tre eventi può

essere esteso ad una qualsiasi successione finita di eventi.

10

Proprietà 4. Teorema delle probabilità totali. Dati due eventi A, B C compatibili, caratterizzati cioè da intersezione non vuota ( A B ), si avrà che

I. Pr( B A) Pr( B) Pr( A B)

II. Pr( A B) Pr( A) Pr( B) Pr( A B)

Dimostrazione. Innanzitutto notiamo che B ( A B) ( B A) . Inoltre si

ha che A B A ( B A) (Fig. 1.1). I due eventi ( A B) e ( B A) sono

incompatibili, per cui ( A B) ( B A) e quindi

Pr( B) Pr( A B) Pr( B A) Pr( B A) Pr( B) Pr( A B)

Figura 1.1 ‒ Rappresentazione di due sottoinsiemi di

eventi compatibili

Essendo poi Pr( A B) Pr( A) Pr( B A) , combinando i due risultati

avremo che

Pr( A B) Pr( A) Pr( B) Pr( A B)

□

Il teorema delle probabilità totali può essere esteso al caso di tre eventi

(Fig. 1.2). Infatti, data una famiglia di tre eventi { A, B, C } a due a due compatibili, si può dimostrare che

Pr( A B C ) Pr( A) Pr( B) Pr(C )

Pr( A B) Pr( A C ) Pr( B C )

Pr( A B C )

11

Figura 1.2 ‒ Rappresentazione di tre sottoinsiemi di

eventi compatibili

Il risultato precedente può infine essere generalizzato. Data una famiglia di n eventi { Ak ; k 1,2,...,n } a due a due compatibili, la probabilità della

loro unione è uguale alla somma delle probabilità degli eventi, meno la

somma delle intersezioni tra coppie di eventi, più la somma delle intersezioni tra triple di eventi, meno la somma delle intersezioni tra quadruple di

eventi, e così via, per giungere alla probabilità dell’intersezione della n-upla

di eventi, con segno positivo se n è dispari, negativo in caso contrario.

Proprietà 5. Probabilità in una relazione di inclusione

Se A B

Pr( A) Pr( B)

Dimostrazione. Ricordando che ( B A )={ : B A } avremo che

( A B) A ( B A) e ( A B) B . Quindi

Pr( B) Pr( A B) Pr( A) Pr( B A) Pr( A)

□

Proprietà 6. Probabilità condizionata. Dati due eventi A,B C si ipotizzi

che B e che non risulti vuota l’intersezione tra i due sottoinsiemi A e B

( A B ). Ipotizziamo di essere interessati all’evento condizionato { A si

verifica essendosi verificato B }, evento che denoteremo come ( A B ). La misura di probabilità dell’evento condizionato è data dalla seguente relazione:

Pr( A B)

Pr( A B)

Pr( B)

Pr( B) 0

12

Dimostrazione. Sia l’evento condizionante B una partizione di eventi

elementari B . Sia C B una algebra costituita da B e dall’evento condizionato ( A B ) coincidente con l’intersezione A B (nel senso che si verifica l’evento condizionato ( A B ) se e solo se si manifesta un evento elementare presente nell’intersezione A B ):

CB A B

B

Associamo ad ogni evento compreso in C B una misura di probabilità

PrB : A B , in cui B assume la funzione di evento certo. Nella parti-

zione B l’evento A B non ha probabilità Pr( A B) , ma una misura di

probabilità PrB ( A B) > Pr( A B) . Ricordando che vale l’identità ( A B ) =

( A B ), possiamo scrivere la seguente relazione:

Pr( A B) : PrB ( A B) Pr(B ) : Pr()

da cui, sostituendo, è agevole mostrare che

Pr( A B) : Pr( A B) Pr( B) : 1

Pr( A B)

Pr( A B)

Pr( B)

□

Naturalmente, se si considera come evento condizionante A, vale anche

il seguente risultato:

Pr( B A)

Pr( A B)

Pr( A)

Pr( A) 0

La principale conseguenza della proprietà appena illustrata è la seguente. Se risolviamo una delle due precedenti relazioni per Pr( A B) , otteniamo la probabilità dell’evento intersezione:

Pr( A B) Pr( B) Pr( A B) Pr( A) Pr( B A)

relazione quest’ultima definita come “principio o postulato della probabilità

composta”.

13

L’evento ( A B ) esprime una revisione nelle aspettative dell’osservatore

circa il manifestarsi di A, che in qualche modo risulta collegato al verificarsi

dell’evento condizionante B, al fine di tenere conto del cambiamento avvenuto nell’information set a seguito del verificarsi di B.

Per esemplificare, ipotizziamo di effettuare un esperimento di estrazione in blocco4 di palline da un’urna contenente 5 palline bianche e 5 nere. Naturalmente, questo esperimento non ha particolare interesse in sé, ma concettualizza situazioni del mondo reale che sono caratterizzate da una complessità ben diversa. Ad ogni modo, assumiamo che alla prima estrazione si

sia ottenuta una pallina di colore nero (evento B) e che questa, conformemente allo schema di estrazione scelto, non sia reintrodotta nell’urna, alterando pertanto la composizione di quest’ultima. Ci domandiamo a quanto

ammonta la probabilità di ottenere nell’estrazione successiva una pallina

bianca (evento A), essendosi verificato l’evento condizionante B nella prima

estrazione. Con la composizione di partenza dell’urna la probabilità di

estrarre nella prima prova una pallina bianca sarebbe stata pari al rapporto

tra il numero delle palline bianche e il totale delle palline contenute

nell’urna, cioè 0,5. Notare che questa probabilità non cambierebbe, nelle

estrazioni successive, se si adottasse uno schema di estrazione con ripetizione, la cui principale caratteristica è quella di lasciare immutata la composizione dell’urna dopo lo svolgimento di ciascuna delle prove. Se viceversa si

adotta uno schema di estrazione in blocco, la composizione dell’urna si altera ad ogni successiva estrazione, influenzando i successivi risultati. Estratta

nella prima prova una pallina nera, infatti, la probabilità di ottenere nella

seconda estrazione una pallina bianca sarà pari a 5 su 9, cioè 0,555.

L’implicazione più diretta di questo semplice esperimento è che il meccanismo di estrazione delle palline dall’urna determina la relazione di dipendenza o l’indipendenza tra eventi.

Più formalmente, tornando al concetto di evento condizionato ( A B ),

va osservato che il verificarsi dell’evento B potrebbe migliorare la conoscenza delle circostanze che determinano il verificarsi dell’evento A, il che in

precedenza ci ha consentito di affermare che PrB ( A B) > Pr( A B) . Ma ciò

non si verifica necessariamente. Può accadere che il manifestarsi di B potrebbe non rappresentare un’informazione rilevante per l’osservatore. È il caso

Si ha estrazione bernoulliana o con ripetizione quando, in un esperimento di estrazione di n

unità da un’urna probabilistica, le unità sono reimmesse nell’urna dopo la registrazione del

risultato e possono essere estratte nuovamente, per cui la composizione dell’urna non si

modifica al susseguirsi delle prove. Si ha viceversa estrazione in blocco o senza ripetizione,

quando le unità estratte non sono reimmesse nell’urna dopo la registrazione del risultato.

Nel secondo caso, il manifestarsi di un certo risultato nello svolgimento della prova i-esima

dipenderà dall’intera sequenza dei risultati che lo hanno preceduto.

4

14

dell’estrazione con ripetizione, in cui Pr( A B) Pr( A) , condizione che ci

consente di affermare che l’evento A è stocasticamente indipendente

dall’evento B.

Nel caso di indipendenza tra eventi, scriveremo pertanto

Pr( B A)

Pr( A B)

Pr( B)

Pr( A)

Pr( A B) Pr( A) Pr( B)

In altri termini, nel caso di indipendenza tra eventi la probabilità dell’evento

intersezione è data dal prodotto delle probabilità associate ai singoli sottoinsiemi

che formano l’intersezione.

Proprietà 7. Probabilità assoluta. È una diretta conseguenza e, in un certo

senso, l’estensione della proprietà precedente ad un certo numero n di

eventi condizionanti.

Figura 1.3 ‒ Rappresentazione di B e degli eventi

condizionanti {Ak}

Sia data una partizione di in n sottoinsiemi { Ak ; k 1,...,n } mutuamente

esclusivi e necessari. Se B è un qualsiasi evento la cui manifestazione è condizionata al verificarsi dell’uno o l’altro degli eventi condizionanti { Ak }, allora potremo scrivere che

n

n

k 1

k 1

Pr( B) Pr( Ak B) Pr( Ak ) Pr( B Ak )

Dimostrazione. Il verificarsi dell’evento B è condizionato al verificarsi

dell’uno o l’altro degli n eventi condizionanti { Ak } (Fig. 1.3).

In simboli avremo quindi che

15

n

B ( A1 B) ( A2 B) ... ( An B) ( Ak B)

k 1

Essendo gli eventi a due a due incompatibili, cioè tali che

( Ai B) ( Aj B) i j , in virtù della Proprietà 3 possiamo affermare

che

n

n

Pr( B) Pr ( Ak B) Pr(Ak B)

k 1

k 1

e ricordando la Proprietà 6 sugli eventi condizionati potremo in ultimo

scrivere che

n

n

k 1

k 1

Pr( B) Pr(Ak B) Pr( Ak ) Pr( B Ak )

□

Il risultato precedente, noto come teorema delle probabilità assolute, riveste

un ruolo fondamentale nella definizione della successiva proprietà.

Proprietà 8. Teorema di Bayes o sulla probabilità delle cause. Formulato da

Thomas Bayes (1702-1761) — anche se pubblicato postumo due anni dopo

la sua morte in Essays towards solving a problem in the doctrine of chances — e

da Laplace ‒ che forse non era al corrente del lavoro di Bayes ‒ nel 1774, è

alla base di innumerevoli applicazioni pratiche e di un particolare approccio statistico, detto appunto bayesiano.

Sia data una partizione di in n sottoinsiemi { Ak ; k 1,...,n } esaustivi e

mutuamente esclusivi. Sia inoltre B un qualsiasi evento la cui manifestazione

è condizionata al verificarsi dell’uno o l’altro degli eventi condizionanti

{ Ak }. Allora, verificatosi l’evento B, la probabilità che Ak sia la causa che

ha determinato il manifestarsi di B è data dalla seguente relazione:

Pr( Ak B)

Pr( Ak ) Pr( B Ak )

n

Pr( Ak ) Pr( B Ak )

k 1

16

Dimostrazione. Dalla Proprietà 6 e, in particolare, dalla definizione di

probabilità condizionata, sappiamo che

Pr( Ak B)

Pr( Ak B)

Pr( B)

Inoltre, applicando al numeratore del precedente rapporto il principio

della probabilità composta, possiamo scrivere che

Pr( Ak B) Pr( Ak ) Pr( B Ak )

Infine, applicando la Proprietà 7 al denominatore del rapporto, avremo

che

n

n

k 1

k 1

Pr( B) Pr( Ak B) Pr( Ak ) Pr( B Ak )

Combinando i tre risultati, potremo pertanto scrivere che

Pr( Ak B)

Pr( Ak ) Pr( B Ak )

n

Pr( Ak ) Pr( B Ak )

Pr( Ak )

k 1

dove

Pr( B Ak )

n

Pr( Ak ) Pr( B Ak )

k 1

□

L’interpretazione del teorema è particolarmente densa di implicazioni.

Consideriamo un esperimento articolato in una singola prova, durante la

quale può avvenire uno e uno solo tra n eventi { Ak ; k 1,2,...,n } e che, verificatosi il generico evento Ak con probabilità Pr( Ak ) , si manifesti un certo

evento ( B Ak ) con probabilità Pr( B Ak ) . Il teorema di Bayes consente di

risalire alla probabilità Pr( Ak B) che, essendosi manifestato B, tale evento

sia stato determinato dall’evento Ak , motivo per cui è indicato come teorema sulla probabilità delle cause.

17

Da notare che la quantità Pr( Ak ) è una probabilità a priori assegnata

dall’osservatore, mentre la quantità Pr( Ak B) è una probabilità a posteriori,

in quanto valutata dopo il manifestarsi di B.

La distinzione tra probabilità a priori e probabilità a posteriori è essenziale per la corretta comprensione del teorema. Nelle parole di Henri Poincaré5 infatti, “... questi problemi sono classificati come probabilità delle cause e sono i più importanti di tutti per le loro applicazioni scientifiche [...] Un effetto potrebbe essere prodotto dalla causa a o dalla causa b. L'effetto è appena stato osservato. Ci domandiamo la probabilità che sia dovuto alla causa a. Questa è una probabilità di causa a posteriori. Ma non la potrei calcolare, se una convenzione più o meno giustificata non mi dicesse in anticipo qual'è la probabilità a priori che la causa

a entri in gioco”.

Un semplice esempio, tratto da D’Agostini (2001), può rendere più chiaro come applicare il teorema. Ipotizziamo che 10 anni fa il mercato automobilistico si ripartisse tra le marche A1, A2 e A3, le cui quote di mercato

ammontavano rispettivamente al 70, al 25 e al 5 per cento del totale. Sappiamo anche che dopo 10 anni sono ancora funzionanti il 6 per cento delle

auto di marca A1, il 22 per cento di quelle di marca A2 e il 75 per cento di

quelle di marca A3. Un nostro amico possiede un'automobile funzionante

acquistata 10 anni fa. Qual'è la probabilità che sia della marca A1?

Un modo di risolvere il problema è considerare il numero N di auto

prodotte 10 anni fa e quello NF 10 di quelle circolanti dopo dieci anni, organizzando le informazioni in nostro possesso nella seguente tabella:

Tabella 1 — Esempio di applicazione del teorema di Bayes

Marca

Quota di mercato

Pr(F 10)

N0

NF 10

A1

A2

A3

0,70

0,25

0,05

0,06

0,22

0,75

0,70 N

0,25 N

0,05 N

0,06 0,70 N

0,22 0,25 N

0,75 0,05 N

Dall’esame della tabella precedente è immediato calcolare che, ipotizzando pari a N il numero di autoveicoli prodotti 10 anni fa, ne circoleranno

funzionanti ancora oggi il 4,2 per cento della marca A1, il 5,5 per cento della

marca A2 e il 3,75 per cento della marca A3.

Henri Poincaré (1854 –1912), matematico, fisico, astronomo e filosofo della scienza, è stato

candidato 12 volte al premio Nobel in fisica. È noto per una serie di risultati nettamente in

anticipo sui tempi, quali la scoperta dell’attrattore strano che è alla base della teoria del caos e

la formulazione della teoria della relatività ristretta.

5

18

Applichiamo il teorema di Bayes:

Pr( A1 F 10 )

Pr( A1 ) Pr( F10 A1 )

3

Pr( Ak ) Pr( F10 Ak )

k 1

0 ,70 0 ,06

0 ,70 0 ,06 0 ,25 0 ,22 0 ,05 0 ,75

0 ,042

0 ,312

0 ,042 0 ,055 0 ,0375

Quindi la probabilità che un automobile funzionante con 10 anni di vita

sia della marca A1 è pari al 31 per cento.

Naturalmente, questo è un modo estremamente semplificato di applicare il teorema di Bayes. Ben più interessante è l’interpretazione adottata da

una particolare scuola statistica, definita appunto bayesiana.

Visto attraverso lenti bayesiane, il teorema fornisce una rappresentazione formalizzata del processo attraverso il quale un osservatore esprime un

grado di fiducia su una congettura relativa un certo fenomeno aleatorio

d’interesse Ak e ne verifica empiricamente la validità attraverso un esperimento. L’esperimento incrementa l’information set dell’osservatore, determinando l’aumento o la diminuzione del grado di fiducia sulla congettura

iniziale. Naturalmente, fondandosi su una valutazione soggettiva del grado

di fiducia, l’interpretazione bayesiana non è completamente riconducibile

al principio di induzione.

Ipotizziamo che un osservatore formuli una congettura su Ak . Non

sempre il generico evento Ak risulta osservabile. Quindi la misura Pr( Ak )

è una probabilità a priori attraverso cui l’osservatore assegna soggettivamente un grado di fiducia alla congettura su Ak prima di verificarne la validità.

La verifica empirica si svolge tramite un esperimento, il cui scopo è

quello di costituire un information set sull’evento Ak . Poiché Ak non è osservabile, la costruzione dell’information set si baserà su un evento osservabile B, in qualche modo collegato ad Ak . Condotto l’esperimento,

l’osservatore assegnerà alla congettura un nuovo grado di fiducia

Pr( Ak B) , configurato come probabilità a posteriori, in quanto ottenuto combinando la probabilità a priori Pr( Ak ) con le evidenze derivanti dalle verifiche svolte.

Nella relazione definitoria del teorema, il rapporto

19

Pr( B Ak )

n

Pr( Ak ) Pr( B Ak )

k 1

è un fattore di scala che misura l’impatto derivante dall’osservazione

dell’evento B sulla probabilità a priori Pr( Ak ) .

Al numeratore figura la verosimiglianza — concetto che, come vedremo

in seguito, svolge un ruolo chiave nell’inferenza statistica — mentre al denominatore figura la probabilità marginale, cioè la probabilità di osservare B

a seguito del manifestarsi dell’uno o dell’altro degli eventi condizionanti

{ Ak } .

È relativamente agevole dimostrare che Pr( Ak B) 1 . Infatti, sempre

con riferimento alla relazione definitoria del teorema, avremo che

Pr( Ak B)

Pr( Ak ) Pr( B Ak )

n

Pr( Ak ) Pr( B Ak )

k 1

Nell’espressione precedente, Pr( Ak B) assume valori inferiori o uguali

all’unità se il denominatore del rapporto risulta maggiore o uguale al numeratore. Ricordando che valgono le identità Pr( Ak ) Pr( B Ak ) Pr( Ak B)

n

e Pr(B) Pr( Ak ) Pr(B Ak ) , la condizione può essere scritta come

k 1

Pr( B) Pr( Ak B)

Il segno di uguaglianza vale a condizione che

Pr( B) Pr( Ak B)

situazione che si verifica quando Pr( B Ak ) 1 , cioè quando al manifestarsi di Ak l’evento B si verifica sempre. In qualunque altro caso la probabilità a posteriori Pr( Ak B) assumerà valori strettamente inferiori all’unità.

20

1.4. OSSERVAZIONI CONCLUSIVE

21

APPENDICE 1. ELEMENTI DI TEORIA DEGLI INSIEMI

L’insieme può essere visto come una collezione di oggetti che presentano

una o più caratteristiche comuni. Nel caso dello spazio campione ,

l’elemento comune agli eventi è quello di essere i risultati ottenibili nel

corso di un esperimento.

Relazioni su insiemi. In matematica, per relazione intendiamo un collegamento tra oggetti.

La prima relazione fondamentale è quella di appartenenza. Diremo che

un evento elementare appartiene ad un sottoinsieme A di eventi elementari (e indicheremo tale relazione come A ) se soddisfa un criterio di

appartenenza specifico (Figura 1.4). Se per esempio A è l’insieme dei numeri naturali minori di 10, il criterio di appartenenza sarà descritto come

A { : numero naturale minore di 10}

{ : N ; 10}

La definizione precedente si legge come “A insieme degli eventi elementari

appartenenti ai numeri naturali minori di dieci”.

Figura 1.4 ‒ Relazione di appartenenza

Definita l’appartenenza è immediato derivare la relazione di non appartenenza. Infatti, fissato l’insieme B dei numeri naturali maggiori o uguali a 10

B { : N; 10}

allora se A B .

22

La seconda relazione fondamentale, riferita a due sottoinsiemi, è quella

di inclusione. Dati due sottoinsiemi A e B, si ha una relazione di inclusione

se tutti gli elementi appartenenti ad uno dei due sottoinsiemi appartengono

anche all’altro. In simboli avremo che

A B A, B

La definizione sarà letta come “A è incluso in B se e solo se, per ogni appartenente ad A, appartiene a B”.

Figura 1.5 ‒ Relazione di inclusione stretta

Parleremo poi di relazione di inclusione stretta (che indicheremo come

A B ) se ogni elemento di A è anche elemento di B, ma esistono alcuni

elementi di B che con certezza non appartengono ad A.

La relazione di inclusione è riflessiva, antisimmetrica e transitiva. Infatti

1.

2.

3.

A A

A BB A A B

A B BC AC

La proprietà di antisimmetria è importante in quanto consente di definire

la relazione di uguaglianza tra due o più sottoinsiemi.

La terza relazione fondamentale è quella di disgiunzione. Dati due sottoinsiemi A e B, diremo che A e B sono disgiunti se non hanno alcun elemento in comune, cioè se la loro intersezione è insieme vuoto.

La relazione di disgiunzione tra sottoinsiemi è simmetrica, nel senso che

se A è disgiunto da B, deve valere anche la relazione opposta, ma non è riflessiva né transitiva. Infatti, se è chiaro che un insieme A non può essere

23

disgiunto da A, cioè da sé stesso, potrebbe non risultare immediato che la

relazione di disgiunzione non è transitiva. Per convincerci della validità

dell’affermazione, tuttavia, basta fare riferimento alla situazione rappresentata nella Figura 1.6.

Figura 1.6 ‒ Relazione di disgiunzione.

Caso di 3 sottoinsiemi

Dall’osservazione del diagramma, appare evidente che A è disgiunto da

B, B è disgiunto da C, ma C non è disgiunto da A. Quindi in generale la relazione di disgiunzione non è transitiva.

Estendiamo la relazione di disgiunzione a famiglie di sottoinsiemi. Una

famiglia di sottoinsiemi { Ak ; k 1,2,...,n } si dirà costituita da insiemi mutuamente disgiunti, o mutuamente esclusivi, se per ogni coppia di indici distinti i

e j, con i j , i corrispondenti sottoinsiemi risultano disgiunti. Nel caso in

cui, infine, lo spazio degli eventi possa essere suddiviso in un certo numero di sottoinsiemi mutuamente esclusivi appartenenti ad una famiglia F,

si dirà che F è una partizione di .

Operazioni su insiemi. In matematica, si definisce operazione una legge

di composizione da uno o più insiemi agli elementi compresi in essi. Si tratta di una definizione alquanto astratta, su cui non è opportuno soffermarci,

e la riportiamo soltanto per uniformità di trattazione. Nel seguito, quindi, ci

affidiamo ad un concetto primitivo di operazione, come confronto tra due o

più sottoinsiemi.

Definiamo innanzitutto l’operazione di unione tra sottoinsiemi. Con riferimento a due sottoinsiemi A, B , l’unione è l’insieme composto dagli

eventi elementari compresi in A o in B o in entrambi. In simboli avremo che

24

A, B

A B { : A B}

La definizione precedente si legge come “dati due sottoinsiemi di eventi

elementari A,B appartenenti allo spazio di eventi , l’evento unione è l’insieme di

eventi elementari che appartengono a A o a B”. Graficamente si avrà che

Figura 1.7 ‒ Operazione di unione

Notare che nel diagramma precedente i due sottoinsiemi presentano

eventi elementari in comune. Se questa situazione non si verifica, parleremo di unione di eventi disgiunti.

La seconda operazione è quella di intersezione tra sottoinsiemi. Con riferimento a due sottoinsiemi A, B , l’intersezione è l’insieme composto dagli eventi elementari compresi in A e in B. In simboli avremo che

A, B

A B { : A B}

La definizione si legge come “dati due sottoinsiemi di eventi elementari A,B

appartenenti allo spazio di eventi , l’evento intersezione è l’insieme di eventi

elementari che appartengono a A e a B”. Graficamente si avrà che

Figura 1.8 ‒ Operazione di intersezione

25

La terza operazione che analizziamo è quella di complemento assoluto, o

negazione. Con riferimento ad un sottoinsieme A , definiamo il complemento assoluto o negazione di A l’insieme degli eventi elementari compresi in

e non appartenenti al sottoinsieme A. In simboli avremo che

A : A

L’evento A quindi si verifica se e solo se non si verifica A. Da un punto di vista grafico, rappresentiamo il complemento assoluto nel modo seguente:

Figura 1.9 ‒ Operazione di negazione

Elenchiamo di seguito alcune implicazioni dell’operazione di complemento assoluto:

1.

2.

3.

4.

5.

(A) A

A A

A A

L’estensione dell’operazione di complemento assoluto è indicata come

complemento relativo o differenza. Con riferimento a due sottoinsiemi

A, B caratterizzati dall’avere uno o più eventi elementari in comune,

tali cioè che A B , il complemento relativo o evento differenza A B è

l’insieme composto dagli eventi elementari compresi in A e non compresi

in B. In simboli avremo che

A, B

A B { : A B}

26

Notare che, diversamente dalle operazioni di unione e intersezione, in

generale l’operazione di complemento relativo non è simmetrica, per cui potremo definire, dati i due sottoinsiemi A e B, un secondo evento differenza

B A , definito come l’insieme composto dagli eventi elementari compresi

in B e non compresi in A. In simboli avremo che

A, B

B A { : B A}

Da un punto di vista grafico possiamo rappresentare gli eventi differenza nel modo seguente:

Figura 1.10 ‒ Operazione di differenza

Naturalmente A B B A A B .

Proprietà delle operazioni su insiemi. Le operazioni su insiemi godono

di alcune o di tutte le proprietà elencate successivamente.

Proprietà commutativa

AB B A

AB B A

Proprietà associativa

A ( B C ) ( A B) C

A ( B C ) ( A B) C

Proprietà distributiva

A ( B C ) ( A B) ( A C )

A ( B C ) ( A B) ( A C )

27

Leggi di De Morgan

( A B) (A) (B)

( A B) (A) (B)

Estensione a più eventi. Data una famiglia composta da un numero finito di eventi { Ak ; k 1,2,...,n }, la loro unione è l’insieme composto dagli

eventi elementari appartenenti a A1 o A2 o … o An, mentre la loro intersezione sarà data dall’insieme composto dagli eventi elementari appartenenti a A1 e A2 e … e An.

In simboli, per l’operazione di unione di n eventi, avremo che

n

Ak { : A1 A2 An }

k 1

mentre per l’operazione di intersezione potremo scrivere che

n

Ak { : A1 A2 An }

k 1

Quanto alle leggi di De Morgan, la loro estensione a n eventi assume la

seguente formulazione:

n

n

k 1

k 1

n

n

k 1

k 1

A k A k

A k A k

Estensione a successioni di eventi. Data la successione di eventi

A1 , A2 , Ak ; k 1, 2, scriveremo che:

Ak { : Ak }

per almeno un k 1,2 ,

Ak { : Ak }

per ogni k 1,2 ,

k 1

k 1

Quanto alle leggi di De Morgan, saranno modificate come segue:

k 1

k 1

k 1

k 1

A k A k

A k A k

28

Classi completamente additive (—algebre). In matematica, una σalgebra o tribù su un insieme di eventi Ω, è una famiglia di sottoinsiemi di Ω

che gode di alcune proprietà di stabilità rispetto a operazioni quali l’unione

numerabile e il passaggio al complementare.

Il concetto di σ-algebra è alla base della teoria della misura, della teoria della probabilità incentrata sull’impostazione assiomatica e di tutte le nozioni di

misurabilità, sia di insiemi, sia di funzioni. Infatti la σ-algebra è un caso particolare di algebra di insiemi, ed è utilizzata ampiamente in analisi matematica, per gli svariati vantaggi che le misure definite su σ-algebre hanno rispetto alle operazioni di passaggio al limite.

Consideriamo uno spazio di eventi e un suo sottoinsieme A. Consideriamo poi una classe C tale che

1. Contenga C

2. Se A C A C . In altri termini, la classe C deve contenere sia

l’evento A, sia la sua negazione A .

3. Data una sequenza finita o infinita A1 , A2 , Ak ; k 1, 2, di

eventi appartenenti a C, anche la loro unione appartiene a C. In simboli avremo che

{ Ak : Ak C} Ak C

k 1

Se valgono le proprietà 1—3, allora C è detta σ-algebra o classe completamente additiva e si indica come C { Ai : Ai } .

Il concetto di σ-algebra è stato introdotto perché condensa e riassume

l’insieme di tutte le operazioni di confronto fra eventi elementari o sottoinsiemi di eventi elementari, con particolare riferimento alle operazioni di

unione, intersezione, differenza. A partire da uno stesso spazio campione

, possono essere costituite più classi di eventi C, ognuna delle quali deve

contenere (proprietà 1) e il non evento (proprietà 2). Quindi la

più piccola classe completamente additiva è formata solo da e :

C { ; } .

Nel caso di insiemi continui definiti su , è impossibile effettuare confronti, per cui preliminarmente vanno fissati intervalli del tipo

( , X ]

[X0 , X1 ]

a partire dai quali è di nuovo possibile costruire la σ-algebra.

29

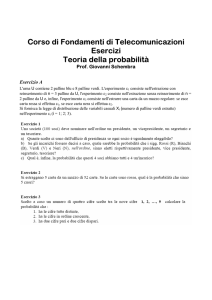

ESERCIZI CAPITOLO 1

Esercizio 1.1. Quanti numeri interi di 3 cifre fra loro diversi possono essere

ottenuti con le cifre {1, 2, 3}?

Soluzione. I numeri interi di 3 cifre sono pari al numero di permutazioni semplici di 3 oggetti tra loro diversi, e cioè 3! = 6.

Esercizio 1.2. Quanti numeri interi di 3 cifre fra loro diversi possono ottenersi con le cifre {1, 2, 3, 4}?

Soluzione. Il numero cercato è pari al numero di disposizioni semplici di 4 oggetti di classe 3, cioè

4!

24 .

4 3 !

Esercizio 1.3. Quante sequenze di tre oggetti fra loro diversi possono ottenersi a partire dal seguente insieme: {A, B, C, D, E}?

Esercizio 1.4. Ipotizziamo di effettuare un esperimento consistente

nell’estrazione di tre palline da un’urna contenente 4 palline bianche e due

nere. Quante sequenze di classe 3 fra loro diverse possono ottenersi come

risultato dell’esperimento?

Esercizio 1.5. Quanti sottoinsiemi di 3 elementi possono ottenersi a partire

dallo spazio degli eventi:

A, B, C, D

Esercizio 1.6. Si supponga di voler permutare nell’ordine (con ripetizione)

10 monete, di cui 5 euro, 3 sterline e 2 dollari. Quante permutazioni possono essere ottenute?

Soluzione. Definiamo “permutazione con ripetizione” di n oggetti, di cui k1 di

tipo 1, k2 di tipo 2,…, ks di tipo s [con is1 ki n ] una loro successione ordinata di classe n. Il numero di permutazioni con ripetizione è dato dalla seguente relazione:

r P k 1 ...k s

n!

k1! k2 !...ks ! k1

n

k2

... ks

30

n

è il coefficiente multinomiale.

dove

k1 ... ks

Applicando la precedente relazione si ottiene che

r P5 ,3 ,2

10 !

2.520

5!3!2!

Esercizio 1.7. Nel gioco del poker, in quanti modi possibili si può presentare

una doppia coppia?

Esercizio 1.8. E un full?

Esercizio 1.9. Quanti numeri di 3 cifre possono ottenersi disponendo con ripetizione i numeri {1,2,3,4}?

Soluzione. Ricordando che, nel caso di disposizioni con ripetizione, sono ammissibili anche sequenze del tipo {1,1,1}, {2,2,1} ecc., il numero complessivo di

ripetizioni sarà dato dalla relazione:

r Dn , k

nk

e quindi, nel problema in esame, avremo r D4 ,3 43 64 .

Esercizio 1.10. Quanti campioni di ampiezza 4 possono ottenersi estraendo

con ripetizione da una popolazione di ampiezza 10?

Esercizio 1.11. Si consideri l’esperimento consistente nel lancio di 4 monete.

Quanti sono i possibili risultati, considerando i due esiti possibili (testa o

croce) di ciascun lancio?

Soluzione. Il numero richiesto è quello delle combinazioni con ripetizione di

due elementi di classe 4, cioè:

r Cn , k

n k 1

k

31

Quindi, nel problema analizzato, il numero di combinazioni con ripetizione sa 2 4 1 5

5!

rà pari a r C 2 ,4

5 . Infatti, lo spazio degli

4 4 4 ! 5 4 !

eventi di classe 4 sarà dato da:

{TTTT,TTTC,TTCC,TCCC, CCCC}

Esercizio 1.12. Dato lo spazio degli eventi 1,2,3 costruire la -algebra

completa dei sottoinsiemi di eventi appartenenti a .

Soluzione. Si avrà che

1 2 3

C

1,2 1,3 2,3

1,2,3

Esercizio 1.13. Dato lo spazio degli eventi {1,2,3} 1) costruire la algebra completa; 2) verificare che se A C A C ; 3) verificare che se

k

k

i 1

i 1

Ai C Ai C .

Soluzioni.

1) Vedi Esercizio 4.12.

2) Scelto arbitrariamente un sottoinsieme di ampiezza 1 o 2 di C, è agevole verificare che:

se A 1,2 C A 3 C

se A 3 C A 1,2 C

3) Scelti arbitrariamente due sottoinsiemi di ampiezza unitaria

A1 1 e A2 3

a) A1 A2 1,3 ( A1 A2 ) 2 C

32

A1 2,3 e A2 1,2

2

b) Ai A1 A2 2,3 1,2 2 C

i 1

c.v.d

Esercizio 1.14. Dato lo spazio degli eventi {bianco, nero , rosso} 1) costruire

la -algebra completa C; 2) verificare che se A C A C ; 3) verificare

k

k

i 1

i 1

che se Ai C Ai C .

Esercizio 1.15. Sia data un’urna probabilistica contenente 8 palline bianche e

2 nere. Si richiede di: 1) costruire lo spazio degli eventi ; 2) costruire la

più piccola -algebra a partire da e 3) costruire la -algebra completa.

Esercizio 1.16. Si consideri l’esperimento consistente nel lancio di due dadi.

Dopo aver elencato tutti i possibili risultati dell’esperimento, si determini:

1) la probabilità di ottenere un punteggio totale pari a 7; 2) la probabilità di

ottenere il punteggio 3 al primo lancio; 3) la probabilità di ottenere 3 al

primo lancio o 7 come somma dei punteggi dei due lanci; 4) la probabilità

di ottenere 3 al primo lancio e 7 come somma dei punteggi dei due lanci.

Esercizio 1.17. Sia data un’urna probabilistica contenente 8 palline bianche e

due nere e si ipotizzi di effettuare un esperimento consistente

nell’estrazione in blocco di due palline dall’urna. Si richiede di: 1) costruire

la -algebra completa su ; 2) calcolare le probabilità dei singoli eventi

elementari BB , BN , NB , NN ; 3) calcolare la probabilità del sottoinsieme

A1 { : bianco alla prima estrazione}

e 4) calcolare la probabilità di ottenere una pallina bianca alla prima estrazione o due palline nere come esito delle due estrazioni.

Esercizio 1.18. Qual è la probabilità di estrarre a caso da un mazzo di carte

da poker: 1) una carta di cuori o una figura; 2) una carta rossa [cuori o quadri] o una carta con punteggio multiplo di 3 [intendendo per J, Q e K = 11,

12 e 13]; 3) una carta pari o una carta di picche.

33

Esercizio 1.19. Un consumatore può acquistare un prodotto della marca X

con probabilità pari a 0,1 e un prodotto della marca Y con probabilità 0,3.

Sapendo che un consumatore ha acquistato uno dei due prodotti, calcolare

la probabilità che si tratti di un prodotto della marca Y.

Esercizio 1.20 In un college, il 25 per cento dei maschi studia matematica,

mentre solo il 10 per cento delle femmine fa altrettanto. Le femmine sono il

60 per cento della popolazione complessiva del collegio. Viene scelto uno

studente a caso. Sapendo che studia matematica, valutare la probabilità che

sia femmina e commentare il risultato ottenuto.

Esercizio 1.21. Si consideri l’esperimento consistente nel lancio di tre dadi. Si

calcoli la probabilità che 1) la somma dei punteggi sia pari a 10; 2) 2 dei 3

dadi presentino lo stesso punteggio; 3) un solo dado presenti il punteggio

6.

Esercizio 1.22. Si consideri l’esperimento consistente nel lancio di n dadi.

Qual è la probabilità di ottenere un dato punteggio – ad esempio il 4 – k

volte nel corso dell’esperimento?

Esercizio 1.23. A quanto ammonta la probabilità di vincere al lotto 1) un

ambo giocando due numeri; 2) un terno giocando tre numeri; 3) una quaterna giocando quattro numeri; 4) una cinquina giocando cinque numeri.