2. CAMPIONAMENTO CASUALE SEMPLICE

2.1

INTRODUZIONE

Sebbene non sia molto diffuso nella pratica delle indagini, il campionamento

casuale semplice rappresenta il naturale punto di partenza per lo studio di tutti gli

altri disegni campionari.

Si consideri una popolazione di N unità dalla quale si debba estrarre un campione di

n unità distinte. Il campionamento casuale semplice è la tecnica che attribuisce la

stessa probabilità di selezione ad ogni insieme di n unità distinte della popolazione.

Consegue dalla precedente definizione che anche ogni singola unità della

popolazione ha la stessa probabilità di entrare a far parte del campione. Vedremo in

seguito che altri disegni di campionamento possiedono questa ultima proprietà, per

la quale vengono detti equiprobabilistici (termine corrispondente alla sigla epsem

usata nella letteratura di lingua inglese da equal probability selection method), ma

in nessuno di essi l'equiprobabilità di estrazione può essere estesa ad una

qualunque n-pla campionaria come avviene nel campionamento casuale semplice.

Un disegno equiprobabilistico dà luogo, in via teorica, ad un campione così detto

autoponderante. All'atto pratico è estremamente difficile, se non impossibile,

realizzare campioni autoponderanti a causa di una serie di ostacoli, in parte dovuti

alla qualità del frame, in parte alle operazioni di raccolta dei dati (problema della

mancata risposta, dell’errore di rilevazione, ecc.).

Nella selezione di un campione casuale è possibile scegliere se ogni unità possa

entrare più di una volta nel campione. Se questa possibilità non è ammessa il

campionamento è detto senza ripetizione, altrimenti con ripetizione. Nella pratica,

l'estrazione con ripetizione viene adottata raramente. E' intuitivo che, fissata la

dimensione del campione, l'osservazione ripetuta di una o più unità rappresenta una

perdita di informazione. E' tuttavia anche evidente che la distinzione tra estrazione

con e senza ripetizione perde gradualmente di importanza all'aumentare della

dimensione della popolazione di rilevazione.

2.1

2.2

PIANO DI CAMPIONAMENTO E PROBABILITÀ DI INCLUSIONE

Per la definizione data nel precedente paragrafo, l’insieme dei possibili campioni di

dimensione prestabilita pari ad n che possono essere selezionati da una popolazione

di N unità ha cardinalità pari a:

⎛N⎞

⎜⎜ ⎟⎟ .

⎝n⎠

Pertanto la probabilità di ciascun possibile campione è pari a :

−1

⎛N⎞

p(s ) = ⎜⎜ ⎟⎟ .

⎝n⎠

Inoltre, ricordando che la probabilità di inclusione semplice può essere ricavata dal

valore atteso delle variabili di appartenenza al campione: E (t i ) e la probabilità di

inclusione congiunta dal valore atteso del loro prodotto: E t i t j , è immediato

( )

verificare che tali probabilità di inclusione sono costanti per ogni unità della

popolazione e rispettivamente pari a:

πi = n N

e

π ij = n(n − 1) N ( N − 1) .

La dimostrazione di questi risultati è riportata in appendice al capitolo

2.3

SELEZIONE DEL CAMPIONE

Per illustrare il procedimento di formazione del campione e quello di stima di una

costante caratteristica della popolazione utilizziamo un semplice esempio [Kalton,

1983]. Supponiamo di disporre di una lista di 1872 studenti universitari ciascuno

contrassegnato da un numero di matricola compreso tra 0001 e 1950. E’ realistico

che il contrassegno più elevato, 1950, sia maggiore del numero degli iscritti, 1872,

in quanto alcuni studenti originariamente nella lista possono essere usciti per vari

2.2

motivi dal corso di studi. Supponiamo ancora che per svolgere l'indagine si debba

estrarre un campione casuale semplice di 250 studenti. Un modo per procedere

all'estrazione consiste nel fare ricorso al così detto modello dell'urna. Ciascun

numero che identifica lo studente è inserito in un contenitore sferico perfettamente

calibrato. I contenitori vengono poi posti dentro un'urna che consenta di

rimescolarli in modo che nessuno abbia possibilità di assumere una posizione

preferenziale o individuabile dentro la stessa e, infine, n tra questi vengono estratti

a caso (con una pesca manuale o meccanica). Se alcuni contenitori, tra quelli

selezionati, contengono numeri corrispondenti a studenti non più iscritti al corso di

studi, si procede ad estrazioni supplementari fino a raggiungere la dimensione programmata del campione, nell'esempio: n = 250 studenti.

Questo metodo è molto semplice ma diventa impraticabile quando la lista supera

certe dimensioni.

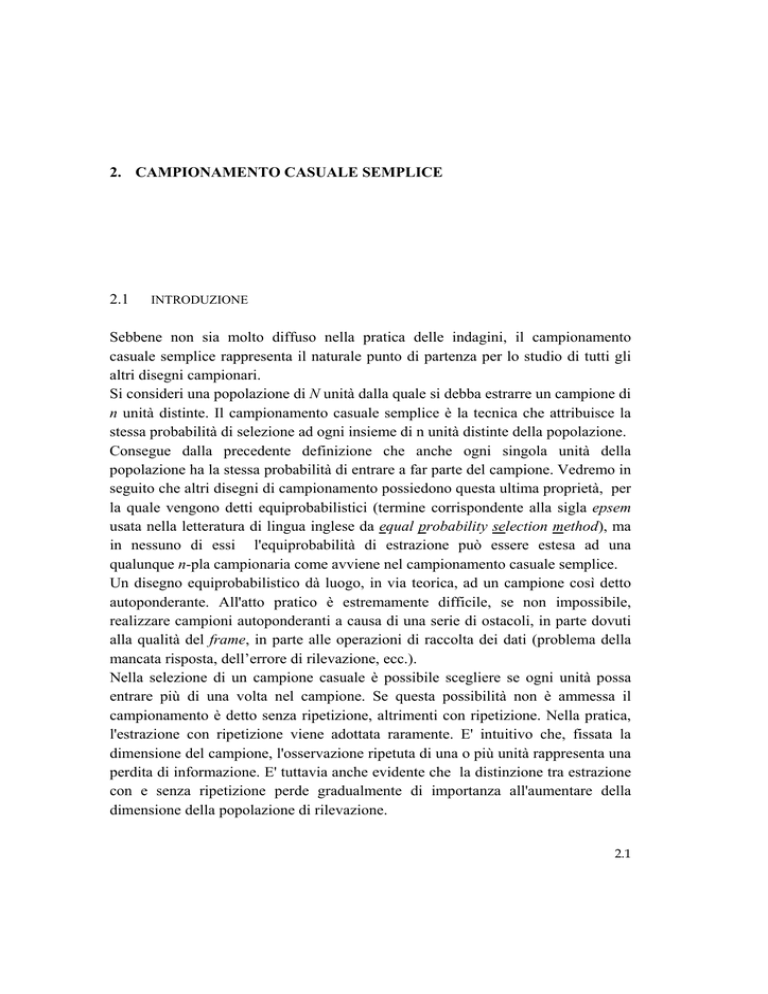

Un metodo alternativo fa uso delle tavole dei numeri casuali. Queste tavole sono

costituite da insiemi di numeri ricavati mediante algoritmi matematici, in modo che

nel lungo andare ogni cifra, ogni coppia di cifre, ogni terna, ecc. abbia la stessa

frequenza di ogni altra. Un estratto della tavola dei numeri casuali prodotta da M.

G. Kendall e Babington Smith [1954] è riportato nella Tab. 1.

Poiché ogni studente è identificato da un numero di quattro cifre, dobbiamo

selezionare casualmente numeri di quattro cifre dalla tavola. Per far questo è

sufficiente individuare casualmente un punto di partenza dal quale procedere

ordinatamente per riga o per colonna.

Per semplicità possiamo partire dall'angolo in alto a sinistra, cioè dall'inizio

naturale della nostra tavola e leggere i numeri in verticale, seguendo le colonne. I

primi due numeri (7766, 7481) non portano ad alcuna selezione. Il primo studente

selezionato corrisponde al numero 0588, a condizione ovviamente che risulti

iscritto al corso di studi. Anche il numero successivo, 0579, corrisponde ad

un'estrazione, dopo di che seguono ben undici numeri (esaurita la prima colonna si

passa alla seconda) che devono essere scartati in quanto superiori a 1950.

L'elevata quantità di numeri scartati deriva naturalmente dal fatto che più dell'80%

dei numeri di quattro cifre sono superiori a 1950. Per rendere il procedimento di

selezione più spedito conviene associare alla lista degli studenti non solo i numeri

compresi tra 1 e 1950 ma anche quelli (di quattro cifre) che si ottengono sommando

a questi opportuni valori costanti maggiori di 1950.

2.3

Tab. 1 - Tavola dei numeri casuali

1

2

3

4

5

6

7

8

9

10

1-4

5-8

9-12

13-16 17-20 21-24 25-28 29-32 33-36 37-40

77 66

74 81

05 88

05 79

79 98

55 09

79 19

28 70

54 44

93 69

88 40

53 71

20 12

76 95

70 98

79 15

16 49

12 06

53 59

31 43

86 61

16 61

10 45

69 00

97 94

11 56

99 08

71 02

34 44

93 93

96 70

59 13

80 22

48 70

55 99

65 88

80 01

34 50

49 93

77 39

78 75

33 02

38 70

60 14

44 04

08 16

56 35

30 16

61 75

72 40

29 77

25 95

94 11

53 11

75 89

96 95

41 42

83 58

19 87

66 32

21 94

92 37

22 02

06 57

69 50

33 17

72 58

39 98

34 93

90 86

12 37

03 18

08 37

06 26

64 03

60 45

20 39

84 01

85 16

65 88

66 11

46 26

74 87

60 31

96 68

81 31

33 53

27 85

18 79

41 19

53 42

37 86

49 04

06 74

17 89

50 46

85 26

17 35

65 94

36 86

Nel nostro caso si possono sommare le costanti 2000, 4000, 6000 e 8000 per

ottenere le serie:

0001

#

1950

2001

#

3950

4001

#

5950

6001

#

7950

8001

#

9950

ciascuna delle quali comprende numeri utili alla selezione degli studenti. Ad

esempio, ripartendo dall'inizio della tavola, troviamo il numero 7766

precedentemente scartato dal quale, togliendo la costante 6000, otteniamo 1766,

cioè un numero compreso nella lista di origine, che dà luogo all'estrazione del

corrispondente studente. Procedendo in questo modo i numeri che si scartano si

riducono a circa il 2,5% di quelli composti da quattro cifre. Così procedendo, può

capitare di incontrare più volte lo stesso numero. Nel qual caso, se l'estrazione è

senza ripetizione, lo si scarta come se fosse fuori della lista.

Il metodo delle tavole casuali è stato alla base dell'estrazione probabilistica fino

all'avvento degli elaboratori elettronici. Al giorno d'oggi quasi tutti i linguaggi

informatici che si usano in campo scientifico contengono routine per la generazione

di numeri casuali. Tali routine permettono di ottenere in tempi brevissimi serie di

numeri casuali che ammettono o meno ripetizioni ed è a queste che lo statistico si

2.4

rivolge per selezionare campioni. Poiché anche le liste delle popolazioni di

selezione sono frequentemente registrate su supporti informatici, l'operazione di

selezione è spesso assistita completamente dall'elaboratore. Occorre pertanto conoscere a fondo le implicazioni probabilistiche dei meccanismi di selezione

automatica per poterne valutare la qualità e l'adeguatezza alle situazioni nelle quali

si vogliono applicare.

2.4

STIMA

Avendo selezionato 250 studenti, supponiamo ora di aver rilevato su ciascuno di

essi alcune variabili per stimare una o più costanti caratteristiche della loro

popolazione di provenienza, ad esempio, il numero medio di ore che uno studente

passa davanti alla televisione e la proporzione di quelli che hanno superato l'esame

di maturità con il massimo dei voti.

Indichiamo il carattere (variabile) quantitativo numero di ore passate davanti alla

televisione con la lettera Y. In seguito useremo la stessa lettera per denotare un

generico carattere quantitativo.

Seguendo una convenzione diffusa nella teoria del campionamento da popolazioni

finite, useremo lettere maiuscole corsive per indicare valori associati alle unità della

popolazione e minuscole corsive per le unità del campione e per le stime. Pertanto,

con Y1, Y2,..,Yi,..YN, denotiamo il numero di ore di televisione per le N unità della

popolazione e con yi1 , yi2 ,..., yin il corrispondente valore per le n unità estratte. La

media della popolazione è data da:

Y =

1

N

N

∑Y

i =1

i

La media delle osservazioni del campione (o media campionaria) da:

y=

1

∑ yi ,

n i∈s

(2.1)

in cui la somma è estesa a tutte le unità della popolazione selezionate nel campione.

2.5

La media campionaria è il tradizionale stimatore della media della popolazione. E’

immediato verificare che la media campionaria corrisponde ad uno stimatore di HT

della media della popolazione.

Viene spontaneo domandarci se y è una buona stima di Y . Essendo il valore di

Y ignoto, non è possibile dare una risposta a questa domanda. In altri termini, non

è possibile valutare una singola stima, cioè un particolare valore ottenuto da un

particolare campione. E' però possibile valutare il procedimento che ha portato alla

formazione di una particolare stima. Il termine stima non dovrebbe essere confuso

con il termine stimatore (nella pratica i due termini sono spesso usati con lo stesso

significato). Infatti, mentre il primo sta ad indicare un particolare valore numerico,

il secondo identifica il procedimento utilizzato per ricavarlo. Lo stimatore possiamo

identificarlo con l'operazione di media delle unità campionarie, la stima con il

risultato che otteniamo in seguito all'applicazione di questa operazione su

determinate osservazioni campionarie.

Le proprietà dello stimatore (media) si ricavano teoricamente ipotizzando di poter

estrarre da una popolazione tutti i possibili campioni distinti di una determinata

dimensione. Calcolata la media su ciascuno di questi, si ricava la sua distribuzione,

che è detta: distribuzione campionaria delle medie. Si è già verificato nel

precedente capitolo che lo stimatore HT del totale Y è uno stimatore corretto. E’

immediato estendere la verifica alla media della popolazione Y , sia in termini

generali, cioè ipotizzando generiche probabilità di inclusione π i , sia considerando

la probabilità di inclusione costante n/N che ogni unità della popolazione ha nel

campionamento casuale semplice. Infatti, poiché la media della popolazione è data

dal rapporto tra il totale e la dimensione della popolazione stessa:

Y =Y N ,

anche lo stimatore di HT della media sarà uguale a quello del totale rapportato alla

dimensione N:

1 N Y

yπ = ∑ i t i

(2.2)

N i =1 π i

2.6

E’ facile verificare che lo stimatore (2.2) è corretto e che sostituendo a πi la

probabilità di inclusione costante n/N si ottiene la media campionaria riporta in

(2.1) che, ovviamente, può essere scritta nella forma:

y ccs =

1 N

∑ Yi ti .

n i =1

(2.3)

Il suffisso ccs, aggiunto al simbolo della media campionaria, sta per:

campionamento casuale semplice. In seguito utilizzeremo analoghi indici per

identificare lo stimatore di HT nel contesto di altri piani di campionamento.

Nonostante la correttezza, la maggior parte, se non la totalità, delle medie

campionarie differirà in più o in meno da quella della popolazione. In altre parole le

medie campionarie avranno una variabilità più o meno elevata intorno al valore

centrale rappresentato, come si è detto, dalla media della popolazione. E' intuitivo

che se questa variabilità è elevata è del pari elevata la probabilità che la media di un

campione casuale risulti anche molto diversa da quella della popolazione. Al

contrario, se la variabilità è piccola la distribuzione campionaria è non solo

centrata ma anche addensata sulla media della popolazione e, di conseguenza, è alta

la probabilità di selezionare casualmente campioni con media prossima a quella

della popolazione. Il grado di addensamento della distribuzione campionaria

intorno alla propria media è una proprietà che si esprime con il termine precisione

e si misura con un indice denominato ‘errore standard’. L'errore standard è la radice

quadrata della varianza della distribuzione campionaria delle medie. Questa varianza non deve essere confusa con quella elementare (cioè degli elementi o unità)

della popolazione, di cui è una funzione. La varianza dello stimatore y ccs è infatti

data da data da:

V ( y ccs ) =

N −nσ2

N −1 n

(2.4)

nella quale :

N

σ 2 = ∑ (Yi − Y ) N

2

i =1

2.7

rappresenta la varianza elementare della popolazione. Tale varianza nella teoria

campionaria viene comunemente definita in modo leggermente diverso, ossia:

N

S 2 = ∑ (Yi − Y ) N − 1

2

(2.5)

i =1

dalla quale si ricava una versione alternativa della (2.4):

S2

N −n S2

= (1 − f )

V ( y ccs ) =

N n

n

(2.6)

nella quale f = n/N è la frazione di campionamento.

E' immediato verificare che sussiste la seguente relazione, che consente di

verificare l'uguaglianza in termini numerici tra la (2.4) e la (2.6):

S 2 = σ 2 N N −1.

L’espressione (2.6) può essere facilmente ricavata dall’espressione dello stimatore

(2.3). Infatti anche per il calcolo della varianza resta valido quanto si è osservato

per il calcolo del valore atteso. La varianza dello stimatore è riferita esclusivamente

alle variabili casuali ti ed in particolare alla loro somma, considerando tutti gli altri

termini come costanti. Pertanto:

⎡1 N

⎤ ⎛ 1 N

⎞

V ( yccs ) = V ⎢ ∑ Yiti ⎥ = ⎜⎜ 2 ∑ Yi2 ⎟⎟ V (ti ) + 2C ti , t j ,

⎢⎣ n i =1 ⎥⎦ ⎝ n i =1 ⎠

(

(

( ))

(2.7)

)

dove C t i , t j è la covarianza tra le possibili coppie di valori ti tj (con i<j).

Tenuto conto che le ti sono variabili bernoulliane con probabilità di successo pari a

n/N, è facile ricavare che:

V (t i ) =

e

2.8

n⎛

n⎞

⎜1 − ⎟

N⎝

N⎠

(

)

C ti , t j = −

n

n⎞

⎛

⎜1 − ⎟ ;

N ( N − 1) ⎝

N⎠

da cui segue che:

1 ⎡N 2

⎢∑ Yi V (t i ) + 2∑i ∑ j <i Yi Y j C t i , t j

n 2 ⎢⎣ i =1

1 ⎡

n⎛

n⎞

= 2 ⎢∑i Yi2 ⎜1 − ⎟ − 2∑i ∑ j <i Yi Y j

N⎝ N⎠

n ⎣

(

V ( y ccs ) =

)⎤⎥

⎥⎦

n

n ⎞⎤

⎛

⎜1 − ⎟⎥.

N ( N − 1) ⎝ N ⎠⎦

Raccogliendo opportunamente a fattor comune, si perviene alla seguente

espressione:

1− f ⎛

2

⎞

2

Yi Y j ⎟

⎜ ∑i Yi −

∑

∑

i

i

<

j

nN ⎝

N −1

⎠

1− f ⎛ N

1

⎞

=

Yi2 −

Y2⎟

⎜

∑

i

nN ⎝ N − 1

N −1 ⎠

V ( y ccs ) =

che con ulteriori semplici passaggi porta a:

V ( y ccs ) =

1− f

(Yi − Y )2 = 1 − f S 2 .

∑

i

n(N − 1)

n

Cioè il risultato anticipato nella (2.6).

L'errore standard della media, ES( y ccs ), è dato dalla radice quadrata della (2.6).

Per convenienza di notazione, la variabilità della stima viene normalmente espressa

in termini di varianza. Quindi diremo che al crescere della varianza diminuisce la

precisione della stima e, viceversa, al diminuire della varianza aumenta la sua

precisione.

La (2.6) mostra che la varianza della media campionaria dipende da tre fattori. Il

primo, (1 − f), detto fattore di correzione per popolazione finita, (cpf), esprime il

contributo nella riduzione della varianza dovuto sia alla dimensione finita della

popolazione che alla selezione senza ripetizione. Per n ≥ 2, infatti il termine è

2.9

minore di 1, ma perde rapidamente di importanza, tendendo ad 1, all'aumentare

della dimensione della popolazione. Il termine è uguale a 1 se l'estrazione è con

ripetizione o se la popolazione non è finita.

Il secondo, n, è la dimensione del campione e il terzo, S2, è la varianza elementare

(per il carattere Y) nella popolazione. Poiché quest'ultima è un dato sul quale non si

ha alcuna influenza e (1 - f) è generalmente trascurabile, il termine dal quale principalmente dipende la varianza della stima è la dimensione campionaria n.

Tornando all'esempio degli studenti, dovrebbe essere chiaro, per le considerazioni

svolte, che se il tempo dedicato alla televisione è approssimativamente uguale per

tutti, la media di ogni campione osservabile sarà vicina a quella della popolazione.

Se, al contrario, le abitudini televisive differiscono notevolmente da uno studente

all'altro, ci sarà un certo rischio di osservare una media campionaria che differisce

molto da quella della popolazione. La varianza della stima ci dà una misura di

questo rischio. Tuttavia, poiché tale varianza dipende da quella non nota, S2, nella

popolazione, sarà necessario ricavare una sua stima dal campione. La stima cui si fa

ricorso è:

s2

(2.8)

v( y ccs ) = (1 − f )

n

nella quale,

s 2 = ∑ ( yi − y ccs )2 (n − 1)

i∈s

è uno stimatore corretto di S2. La verifica della correttezza è lasciata come esercizio

allo studente.

Dalla (2.8) si ricava inoltre la stima dell'errore standard della media:

es( y ccs ) =

(1 − f ) s 2

n

(2.9)

Avendo stimato l'errore standard della media è possibile, sotto certe condizioni,

costruire un intervallo di confidenza centrato su di essa, cioè individuare due valori,

gli estremi dell'intervallo, che hanno una prestabilita probabilità di contenere al loro

2.10

interno la vera media della popolazione. Per esempio l'intervallo di confidenza al

95% per Y è dato da:

y ± 1,96 se( y ccs )

dove il valore 1,96 è tratto dalla tavola della distribuzione normale standardizzata

(il 95% della distribuzione è compreso nell'intervallo i cui estremi sono: -1,96 e

1,96).

Applicando la precedente espressione al campione di 250 studenti, nell'ipotesi che:

y ccs = 2,192 e s2 = 1,008, abbiamo:

250 ⎞ 1,008

⎛

2,192 ± 1,96 ⎜1 −

= 2,192 ± 0,116

⎟

⎝ 1872 ⎠ 250

Possiamo allora affermare che, assumendo sussistano le condizioni di normalità

necessarie per applicare la teoria degli intervalli di stima, abbiamo una probabilità

del 95% che l'intervallo i cui estremi sono 2,076 e 2,3084 comprenda la vera media

della popolazione..

Dal campione di 250 studenti ci eravamo prefissi di stimare anche la proporzione di

quelli che avevano superato la maturità con il massimo dei voti. La proporzione di

unità che nella popolazione detengono un particolare attributo è frequentemente

uno dei parametri di maggiore interesse nelle indagini. I risultati teorici per le

proporzioni derivano direttamente da quelli appena illustrati per le medie,

considerando la proporzioni come una media calcolata su un carattere che possa

assumere solo due valori: 1, ad indicare il possesso di un certo attributo; 0, ad indicarne la mancanza. Pertanto, la proporzione P di unità che hanno un certo attributo

nella popolazione è equivalente alla media Y del carattere stesso e la corrispondente proporzione campionaria p alla media campionaria y o, dato che il

campione è casuale semplice, y ccs .

2

La formula della varianza S dato che Yi può assumere solo valore 0 o 1, può essere

scritta in una forma alternativa rispetto alla (2.5) e lo stesso vale per la sua stima

2

campionaria. In particolare, S = NPQ/(N −1), con Q = (1−P) e s 2 = npq/(n − 1),

con q = (1 − p).

2.11

Pertanto le espressioni della varianza dello stimatore e della sua stima campionaria,

saranno le seguenti:

V ( p ) = (1 − f )

NPQ

(N − 1)n

(2.10)

pq

(n − 1)

(2.11)

e

v( p ) = (1 − f )

A titolo di esempio, supponiamo che nel campione 15 studenti su 250 avessero

superato la maturità con pieni voti. La proporzione stimata è pari a 15/250 = 0,06

(6%). La varianza stimata della proporzione è:

250 ⎞ 0,06 0,94

⎛

v ( p ) = ⎜1 −

= 0,000196

⎟

⎝ 1872 ⎠ 249

e quindi il suo errore standard è:

se( p ) = 0,000196 = 0,014 .

2.5

DETERMINAZIONE DELLA DIMENSIONE CAMPIONARIA

Abbiamo visto nel paragrafo precedente che la frazione di campionamento svolge

un ruolo trascurabile sulla precisione delle stime. Il ruolo preponderante è svolto

dalla dimensione assoluta del campione n. Possiamo allora chiederci quale

dimensione debba avere il campione affinché la precisione delle stime sia pari o

non inferiore ad un prefissato valore. A questa domanda è possibile rispondere ma a

condizione di disporre di informazioni non troppo vaghe sulla varianza elementare

della popolazione relativamente al carattere o ai caratteri di maggiore interesse

nell’indagine.

2.12

Per semplicità, puntiamo l’attenzione sulla stima della media Y della popolazione.

In genere è possibile stabilire a priori l’ordine di grandezza desiderabile del suo

errore standard; spesso si assume per l’errore standard un valore inferiore a quello

che non vorremmo fosse superato nell’indagine. Denotiamo tale errore standard con

V0. Il suo quadrato è dato da:

V02

S2 ⎛

n ⎞ S2

=

,

⎜1 − ⎟ =

n ⎝

N ⎠ n'

nella quale n’ = n/(1−n/N). Se è possibile attribuire un valore ragionevole a S2,

(ricavandolo da dati censuari, da indagini precedenti, da registrazioni di carattere

amministrativo o da indagini pilota ad hoc) la dimensione n’ è data da:

n' =

S2

V02

e il valore di n si ottiene immediatamente dalla relazione:

n=

n'

n'

1+

N

A titolo di esempio, supponiamo di voler stimare la proporzione di studenti

immatricolati all’Ateneo Fiorentino che hanno ottenuto la maturità con il massimo

dei voti. La dimensione della popolazione si aggira sulle 9000 unità; ci

domandiamo quale deve essere la dimensione di un campione casuale semplice che

ci consenta di ottenere uno stimatore della proporzione con un errore standard pari

a 0,01. Quando si vuole stimare una proporzione non è infrequente poter avanzare a

priori delle ragionevoli ipotesi sul suo ordine di grandezza. Nell’esempio, è

ragionevole pensare che tale proporzione sia piuttosto bassa, probabilmente

compresa tra 0,05 e 0,08. La varianza elementare, che possiamo approssimare con

PQ date le dimensioni della popolazione, non è molto variabile in questo intervallo

2.13

2

2

di valori di P. Se P è 0,05, S = 0,0475; se P è 0,08, S = 0,0736. Per cautela

2

possiamo stabilire di prendere il maggiore tra i valori ipotizzati per S . Pertanto:

n' =

PQ

V02

=

0,0736

(0,01)2

= 736

e quindi, poiché la dimensione della popolazione è di circa 9000 unità,

n=

736

≅ 680 ,

736

1+

9000

con una variazione di lieve entità rispetto ad n’ a conferma della scarsa rilevanza

del fattore di correzione, cpf, già in popolazioni di medie dimensioni. Si noti che

con P = 0,05 la dimensione campionaria sarebbe stata di circa 451 unità, cioè circa

il 66% della precedente. A questo proposito si deve osservare che la scelta

cautelativa implica un consistente aumento della dimensione campionaria. E ancora

che quando la proporzione che si deve stimare non è molto piccola, come

nell’esempio, o, il che è equivalente, molto grande, conviene cautelarsi adottando

per P il valore 0,5 che massimizza la varianza PQ.

2.6

CAMPIONAMENTO CASUALE SEMPLICE CON RIPETIZIONE

Pur rivestendo scarsa utilità nella pratica delle indagini, il campionamento casuale

semplice con ripetizione merita qualche cenno nelle sue linee principali soprattutto

per metterne in evidenza le principali differenze rispetto al campionamento senza

ripetizione. Nel campionamento casuale semplice con ripetizione infatti:

(a) è possibile selezionare campioni di dimensione anche superiore a quella

della popolazione;

(b) per popolazioni di dimensione N la cardinalità dell’insieme dei possibili

campioni di dimensione n è maggiore di quella precedentemente vista per

l’estrazione senza ripetizione (cfr. § 2.2)

2.14

Nel determinare la cardinalità dell’insieme S dei possibili campioni si considerano

generalmente le possibili sequenze ordinate di n-ple di unità, data la necessaria

sequenzialità del processo di estrazione. Le unità non possono infatti essere prese in

blocco, ma necessariamente una per volta e reinserite nella popolazione. Le

possibili n-ple sono complessivamente: N n . Di conseguenza, ciascuna ha

probabilità di selezione pari a 1 N n .

Non è possibile parlare di probabilità di inclusione, salvo modificarne la

definizione, dato che un’unità inclusa nel campione alla prima estrazione, può

essere di nuovo estratta nel campione in una successiva estrazione.

Si può e si deve invece parlare di frequenza attesa di inclusione per esprimere il

numero atteso di ricorrenze di ciascuna unità in un campione di dimensione

prestabilita.

Se consideriamo una popolazione di dimensione N e ipotizziamo di selezionare un

campione di n unità:

i) la probabilità di selezione di una generica unità in ogni fase del processo

(estrazione) resta pari a 1/N;

ii) la frequenza attesa di inclusione è pari a n/N.

La frequenza attesa di inclusione, n/N, è solo formalmente uguale alla probabilità di

inclusione nel campionamento casuale semplice senza ripetizione. La differenza

sostanziale è rappresentata dal fatto che la frequenza attesa di inclusione può essere

maggiore di 1, valore che una probabilità non può ovviamente superare.

E’ possibile, come si è già notato, modificare la definizione di probabilità di

inclusione per adattarla al campionamento con ripetizione. Un modo, con

riferimento a quella del primo ordine, è definirla come: “probabilità che una

generica unità entri almeno una volta nel campione durante il processo di

estrazione”. In questa definizione, ed indicandola con π i∗ , per distinguerla

dall’altra, la sua espressione è data da:

π i∗

1⎞

⎛

= 1 − ⎜1 − ⎟

⎝ N⎠

n

Dato che (1 − 1 N )n è la probabilità che un’unità non sia selezionata durante il

processo di formazione del campione.

2.15

Inoltre, la probabilità che, in un campione di dimensione n, un’unità venga

selezionata esattamente r volte è data da:

r

⎛ n ⎞⎛ 1 ⎞ ⎛ N − 1 ⎞

⎜⎜ ⎟⎟⎜ ⎟ ⎜

⎟

⎝ r ⎠⎝ N ⎠ ⎝ N ⎠

n−r

Infine, nella versione modificata che abbiamo appena visto, è ancora possibile

determinare la probabilità di inclusione congiunta, cioè la probabilità che le unità i

e j siano entrambe estratte, almeno una volta, durante il processo di formazione del

campione:

⎛

⎝

π ij∗ = 1 − 2⎜1 −

2.7

n

1⎞

2⎞

⎛

⎟ + ⎜1 − ⎟

N⎠

⎝ N⎠

n

INDICATORE DI RICORRENZA NEL CAMPIONE

Per illustrare, anche se in modo molto sintetico, il procedimento di stima della

media (o del totale) nel campionamento casuale semplice con ripetizione, è utile

introdurre una variabile aleatoria, analoga alla variabile indicatore già introdotta nel

campionamento casuale semplice senza ripetizione, che, in questo caso, dobbiamo

definire come indicatore di ricorrenza di una generica unità nel campione.

Tale variabile che denotiamo con ai, può assumere tutti i valori interi compresi tra 0

e n, ad indicare che l’unità non è stata estratta (ai = 0), è stata estratta una sola volta

(ai = 1), due volte (ai = 2) e così via.

La variabile ai è evidentemente una variabile casuale binomiale con probabilità di

successo 1 N e il suo valore atteso n N corrisponde alla frequenza attesa di

inclusione.

Lo stimatore della media Y , che indichiamo con y ccsr , può essere scritto come

segue:

y ccsr

2.16

1 N

= ∑ Yi ai

n i =1

Ed è immediato verificarne la correttezza dato che E (ai ) = n N .

La sua varianza si ricava facilmente considerando che:

V (ai ) =

1⎞

n⎛

⎜1 − ⎟

N⎝

N⎠

(

)

C ai , a j = −

e

n

N2

Come abbiamo già visto nel paragrafo 2.4:

1 ⎡N 2

⎤

Y V (ai ) + 2∑i ∑ j >i Yi Y j C (ai , a j )⎥

2 ⎢∑ i

n ⎣ i =1

⎦

n⎛

n ⎤

1 ⎡

1⎞

= 2 ⎢∑i Yi 2 ⎜1 − ⎟ − 2∑i ∑ j >i Yi Y j 2 ⎥.

N⎝ N⎠

n ⎣

N ⎦

V ( y ccsr ) =

Da cui:

V ( y ccsr ) =

1 ⎡

1

Y2 −

∑

⎢

i i

nN ⎣

N

∑Y

=

Y2

1 ⎛

⎜⎜ ∑i Yi 2 −

nN ⎝

N

⎞ σ 2 N −1 S 2

⎟⎟ =

=

⋅

N n

⎠ n

i

2

i

−

2

N

∑∑

i

j >i

⎤

Yi Y j ⎥

⎦

Infine uno stimatore corretto della varianza dello stimatore

y

è dato

dall’espressione:

v( y ccsr ) =

s2

⋅

n

E vale la pena di notare che in questo caso s 2 = ∑s ( yi − y ccsr )

2

(n − 1)

è uno

stimatore corretto di σ 2 e non di S 2 .

2.17

2.8

EFFETTO DEL DISEGNO

La strategia di campionamento data dal piano di campionamento casuale semplice

(senza ripetizione) e dallo stimatore di HT è spesso considerata un termine di

confronto con altre strategie alternative, a parità di dimensione campionaria.

Il confronto è spesso effettuato mediante un indice denominato effetto del disegno

(design effect) che denotiamo con Deff 2 . Il Deff 2 (T ) è un rapporto tra la varianza

di uno stimatore T relativo ad una strategia che vogliamo valutare e la varianza del

corrispondente stimatore nella strategia costituita dal campionamento casuale

semplice e dallo stimatore di HT.

A titolo di esempio, possiamo valutare mediante il Deff 2 ( y ccsr ) la strategia,

appena vista, costituita dal campionamento casuale semplice con ripetizione e dallo

stimatore delle media y ccsr .

N −1 S 2

N −1

V ( yccsr )

= N n2 =

Deff 2 ( y ccsr ) =

N −n

V ( y ccs )

N −n S

N n

Il risultato evidenzia che, a parità di dimensione campionaria, il campionamento

casuale semplice senza ripetizione è più efficiente di quello con ripetizione, per un

fattore che tende a diventare trascurabile all’aumentare della dimensione della

popolazione o, comunque, al ridursi della frazione di campionamento.

Prima di concludere, un osservazione che riguarda la simbologia adottata.

L’elevazione al quadrato che compare nel simbolo Deff2 sta ad indicare che l’indice

mette in rapporto tra loro due varianze. E’ possibile valutare una strategia

campionaria anche in termini di errore standard dello stimatore. In questo caso

l’indice viene scritto senza l’elevazione a potenza. Inoltre, l’iniziale maiuscola

denota che l’indice è calcolato su varianze o errori standard reali, ma sappiamo che

in pratica potremo utilizzarlo solo su stime di varianze o di errori standard; in

questo caso l’indice sarà scritto con la lettera minuscola, seguendo la consueta

convenzione introdotta per il carattere di studio Y.

2.18

A.2 - APPENDICE AL CAPITOLO 2

DETERMINAZIONE DELLE PROBABILITÀ DI INCLUSIONE DEL PRIMO E DEL

SECONDO ORDINE

Per definizione, la probabilità di inclusione del primo ordine è:

π i = ∑ p (s )

s ∋i

Ma poiché p(s ) è costante, data la dimensione campionaria, per determinare π i è

necessari semplicemente contare quanti sono i campioni, s, che includono la iesima unità e rapportare questo numero al totale dei campioni selezionabili.

Il numero di campioni che contengono la i-esima unità si ricava facilmente

considerando che oltre alla i-esima il campione può contenere una qualsiasi

combinazione di n − 1 unità scelte dalle N − 1 presenti nella popolazione diverse

dall’unità i. Il loro numero è:

⎛ N − 1⎞

(N − 1)!

⎜⎜

⎟⎟ =

⎝ n − 1 ⎠ (n − 1)!( N − n )!

⎛N⎞

E dividendo per il totale dei possibili campioni ⎜⎜ ⎟⎟ si ottiene, con banali

⎝n⎠

semplificazioni:

⎛ N − 1⎞ ⎛ N ⎞ n

⎟⎟ ⎜⎜ ⎟⎟ = .

π i = ∑ p(s ) = ⎜⎜

−

1

n

s ∋i

⎝

⎠ ⎝n⎠ N

Possiamo ragionare in modo del tutto analogo per ricavare π ij :

⎛ N − 2⎞

⎟⎟

π ij = ∑ p(s ) = ⎜⎜

s ∋i , j

⎝ n−2⎠

⎛ N ⎞ n(n − 1)

⎜⎜ ⎟⎟ =

.

⎝ n ⎠ N ( N − 1)

2.19