I PROCESSI COGNITIVI

Cenni storici

LO STRUTTURALISMO

Nasce con Wundt, fisiologo che costruì il primo laboratorio di psicologia sperimentale a Lipsia. Wundt si era circondato

da abili ricercatori che studiavano la fisiologia degli organi di senso e l’organizzazione del sistema nervoso. Wundt e i

ricercatori pensavano che le percezioni complesse, attraverso le quali abbiamo una rappresentazione del mondo, altro

non fossero che l’elaborazione delle sensazioni elementari date da un’esperienza diretta o immediata. Per capire

queste percezioni complesse si utilizzava un metodo chiamato introspezione, che consiste nel cogliere e riportare i

processi mentale che hanno luogo durante la presentazione di uno stimolo esterno. Era però necessario un periodo di

addestramento che permettesse di riportare le sensazioni elementari conseguenti ad una esperienza immediata e non

le percezioni complesse frutto dell’esperienza passata come il significato o le funzioni degli oggetti (p.e. penna

stilografica nera). Il metodo dell'introspezione doveva portare a scomporre i processi psichici fino a raggiungere la loro

parte più piccola e non ulteriormente scomponibile → <<atomi psichici>> o <<unità psichiche>>. Strutturalismo ed

introspezione non erano destinati a durare a lungo perché si basavano sul resoconto verbale. Un metodo che si basa su

resoconto verbale ha dei limiti i quali:

• non si possono studiare le menti di bambini, malati mentali e animali;

• altre ricerche dimostravano l'importanza dell'attività inconscia (quindi non descrivibile a parole) nei comportamenti

umani;

•l'esperienza della sensazione elementare che una stimolazione sensoriale suscita è del tutto personale.

Per tutti questi motivi lo strutturalismo dovette lasciare il posto ad una nuova corrente di pensiero: il funzionalismo.

IL FUNZIONALISMO

il funzionalismo si sviluppa in America ad opera di William James e John Dewey che, sulla scia della teoria

evoluzionistica di Darwin, sostenevano che il comportamento umano deve essere considerato come un processo di

adattamento dell'organismo all'ambiente. I processi mentali verrebbero messi in atto per aiutare l'organismo a

sopravvivere → <<a cosa servono i processi mentali?>>. I funzionalisti dilatano la gamma di processi mentali studiati

dagli strutturalisti, occupandosi anche della motivazione, del pensiero e dell'apprendimento. Questo stretto legame

che si crea tra comportamento e condizioni ambientali porta la psicologia a studiare il comportamento. In questo clima

nasce dunque il comportamentismo.

IL COMPORTAMENTISMO

John Watson → psicologia come scienza sperimentale → oggetti di studio osservabili in maniera soggettiva. Secondo il

comportamentismo i comportamenti possono essere definiti come l’insieme delle risposte muscolari e ghiandolari di

un individuo. I comportamentisti vedono la mente umana come una scatola nera dentro la quale non possiamo vedere

ciò che succede (→ psicologia della black box). Quindi si può studiare solo ciò che si vede, ovvero il comportamento.

Per i comportamentisti la psicologia deve occuparsi soltanto delle leggi che determinano il comportamento, cioè quali

stimoli provocano le risposte osservabili (→ psicologia dello stimolo-risposta).

Alla fine degli anni ’60 il comportamentismo lascia il posto al cognitivismo. Limitare l'oggetto di studio al

comportamento osservabile e misurabile si dimostrò con il tempo un approccio sterile e fece nascere all'interno degli

stessi psicologi comportamentisti un nuovo movimento che si autodefinì neocomportamentismo. Con esso si inizia ad

ammettere la presenza e l'azione di qualcosa tra lo stimolo e la risposta, che tra la psicologia <S-R>, c’è la psicologia <SO-R>, dove “O” corrisponde a una qualche attività non osservabile messa in atta dall'organismo.

LA PSICOLOGIA DELLA GESTALT

Contemporaneamente in Europa si sviluppava la psicologia della Gestalt (dal tedesco → <<forma organizzata>>). La sua

data di nascita viene convenzionalmente collocata al 1912, quando Wertheimer pubblica il suo esperimento sul

movimento stroboscopico (movimento fenomico apparente indotto da stimoli statici presentati in sequenza). Gli

psicologi che facevano parte di questa scuola davano più importanza alla totalità del fenomeno, piuttosto che alle

singole parti che lo compongono (p.e. un cerchio lo si percepisce come tale sia quando è disegnato con una linea

continua, sia quando è disegnato a spazi intervallati).

Secondo la Gestalt il tutto precede le parti e le parti a loro volta assumono un valore diverso a seconda del <<tutto>>

che vanno a formare (p.e. l'acca formata dalle piccole “s”). Il metodo impiegato dalla psicologia della Gelstalt è quello

fenomenologico: consiste in un'osservazione di tipo bottom-up dei fenomeni, e assume che ciò che percepiamo sia

soltanto ciò che appare durante l'osservazione. I gestaltisti non riconoscono alcuna importanza all’esperienza passata.

IL COGNITIVISMO

Con l'avvento del cognitivismo l'oggetto di studio della psicologia si sposta dal comportamento osservabile ai processi

1

cognitivi divenuti ormai una presenza innegabile per l'elaborazione delle informazioni e per la presa di decisione

finalizzata alla risposta.

I cognitivisti metteranno poi a punto un metodo per misurare la durata (e quindi la complessità) dei processi cognitivi

messi in atto tra il momento della presentazione dello stimolo e il momento dell'emissione, da parte dell'organismo,

della risposta motoria. Ne deriva che: se il tempo di emissione della risposta è breve i processi cognitivi saranno pochi

e semplici; se il tempo di emissione della risposta è lungo i processi cognitivi saranno tanti e complessi. L'affermazione

del cognitivismo è stata anche favorita dalla <<domanda>> militare legata alla seconda guerra mondiale. L'interazione

tra i soldati e le interfacce belliche con le quali dovevano operare, misero in primo piano il problema della human

factors (→ tutti quei punti di forza e quei punti di debolezza che caratterizzano la prestazione umana durante

l'esecuzione) vale a dire la qualità della prestazione non solo in dipendenza di fattori come la paura, la stanchezza, il

caldo, il freddo e la necessità di agire nel minor tempo possibile, ma anche sul tipo di caratteristiche che l'interfaccia

doveva avere.

Metodi di ricerca in psicologia

IL METODO SPERIMENTALE

Il metodo sperimentale (la più diretta emanazione del metodo scientifico) è il metodo che maggiormente garantisce di

comprendere i fenomeni naturali legandoli alle cause che li hanno determinati. Nella sua forma più generale il metodo

sperimentale può essere scomposto in quattro fasi:

• individuazione e descrizione del problema;

• formulazione di un'ipotesi;

• esecuzione dell’esperimento;

• raccolta dei dati ed elaborazione dei risultati.

Nella fase di individuazione e descrizione lo sperimentatore individua il problema di interesse e ne descrive gli aspetti

generali. In pratica questa fase si riferisce all'interrogativo che lo sperimentatore si pone in relazione a un dato

fenomeno (p.e. problema → carenza di sonno causa riduzione della capacità della MBT). Nella seconda fase lo

sperimentazione ipotizza una possibile relazione di causa-effetto tra due variabili. Le variabili sono grandezze o

fenomeni che vengono misurate o manipolate nel corso dell'esperimento. La variabile manipolata (cioè variata in

maniera sistematica) dallo sperimentatore viene definita variabile indipendente mentre la variabili misurata viene

definita variabile dipendente perché appunto dipende dalla manipolazione della variabile indipendente (p.e. ipotesi →

diminuendo le ore di sonno si ha un proporzionale decadimento della capacità della memoria a breve termine). Nella

fase di esecuzione il problema generale e l'ipotesi formulata vengono tradotti in una condizione capace di metterne

alla prova la validità. In pratica si tratta di manipolare la variabile indipendente per osservare e misurare gli effetti che

questa manipolazione causa sulla variabile dipendente (p.e. manipolazione → modificare le ore di sonno di un gruppo

di soggetti privati di 4 ore di sonno e un gruppo privato di 7 ore e verificarne gli effetti su un test di MBT). Nell'ultima

fase l'esperimento deve fornire una misura della variazione della variabile dipendente a seguito della manipolazione

della variabile indipendente e tale variazione deve poter essere raccolta e analizzata (p.e. conferma o falsificazione → il

livello di memoria a breve termine varia a seconda che la privazione di sonno sia di 4 oppure di 7 ore?) e prevede

l'elaborazione dei risultati. Questo particolare passaggio del metodo sperimentale è detto di <<conferma>> o

<<falsificazione>> dell'ipotesi (p.e. sindrome di Edipo, vedi esempio pag. 30).

In generale un esperimento può essere definito come il procedimento attraverso il quale lo scienziato varia in maniera

sistematica uno o più variabili indipendenti e misura i cambiamenti che queste variazioni causano sulla variabile

dipendente.

STUDI DI CORRELAZIONE

Il metodo sperimentale non può essere applicato sempre. Questo perché non sempre abbiamo una variabile

indipendente da manipolare. In questi casi si studia quindi come le due variabili variano insieme. Questi tipi di

esperimenti vengono chiamati esperimenti naturali e vengono eseguiti ogniqualvolta si indagano campi applicativi

dove non è possibile impostare gli esperimenti <<classici>> (p.e. esiste un rapporto di correlazione tra la variabile

<<aver subito un incidente aereo>> e la variabile <<paura di volare>>).

Un rapporto di correlazione (e non di causa-effetto) si verifica quando al variare di una (non a seguito della

manipolazione dello sperimentatore) si osserva anche il variare dell'altra. Il parametro che viene misurato negli studi

di correlazione viene definito coefficiente di correlazione. Il coefficiente di correlazione oltre a misurare l'intensità

della correlazione, cioè la forza di coesione tra due variabili, indica la direzione della correlazione tra le due variabili

espressa in valori che possono oscillare da +1 (correlazione positiva massima tra due variabili) a -1 (correlazione

negativa massima).

Avremo una variabile di correlazione positiva se all’aumentare di una aumenta anche l’altra (p.e. statura e peso

corporeo). Avremo una variabile di correlazione negativa se all’aumentare di una l’altra diminuisce ( es. valore di

un’auto e il numero di chilometri percorsi). Nei casi in cui due variabili siano assolutamente non correlate tra loro, il

coefficiente di correlazione è vicino o uguale allo 0 (p.e. intelligenza e statura di una persona).

2

LA SIGNIFICATIVITÀ E L'INFERENZA STATISTICA

Ogni volta che si studia un certo fenomeno, si formula un'ipotesi di ricerca cioè si fa una specifica inferenza sui risultati

che emergeranno dalla ricerca. Se la ricerca viene condotta applicando il metodo sperimentale, allora l'inferenza o

ipotesi di ricerca sarà che la variazione della variabile dipendente è stata causata dalla manipolazione della variabile

indipendente. Se invece lo studio è di tipo correlazionale allora l'ipotesi formulata sarà che le due variabili oggetto

della ricerca sono in qualche modo correlate tra loro. Ma i risultati dell'esperimento possono essere dovuti al caso e

non alla manipolazione della variabile indipendente. I metodi di inferenza statistica hanno proprio la funzione di

misurare questo possibile errore e calcolano la probabilità che avremmo di ottenere gli stessi risultati attesi dalla

nostra ipotesi anche qualora l'ipotesi di ricerca fosse errata.

Convenzionalmente, in campo psicologico i risultati di una ricerca sono definiti statisticamente significativi quando la

probabilità di sbagliare è inferiore o uguale al 5% (→ significatività statistica). L'assunto generale rimane immutato se

la ricerca di cui ci stiamo occupando misura il coefficiente di correlazione tra due variabili.

I parametri generali sui quali si basano i test di significatività statistica sono fondamentalmente tre:

• l'ampiezza dell’effetto ottenuto (tanto maggiore è la differenza tra i valori della variabile dipendente ottenuti nel

gruppo sperimentale e quello di controllo, tanto più alta sarà la probabilità che i dati risultino statisticamente

significativi);

• il numero dei soggetti che sono stati studiati (più elevato è il campione studiato maggiore sarà la probabilità che una

data differenza risulti statisticamente significativa);

• la distribuzione dei risultati, cioè il livello di variabilità dei dati all'interno di ogni singolo gruppo sperimentale.

I METODI OSSERVATIVI-DESCRITTIVI

Gli studi descrittivi sono quelli in cui non viene ricercata una qualche relazione tra variabili, ma si cerca soltanto di

descrivere un certo fenomeno o un dato comportamento. I metodi osservativi-descrittivi vengono di solito utilizzati

quando i requisiti del metodo sperimentale non possono essere soddisfatti (p.e. il numero di volte che le persone

sedute in una sala d'aspetto di una stazione ferroviaria guardano un cartellone pubblicitario posto sulla parete non

potrà essere osservato in laboratorio, ma soltanto nella stazione ferroviaria stessa).

A fronte di un minor controllo delle variabili avremo però il vantaggio di un comportamento spontaneo eseguito in un

ambiente naturale e in un contesto non inquinato da alcun tipo di intrusione.

In realtà la differenza non consiste nel fatto che lo studio venga svolto in laboratorio o sul campo, ma piuttosto sulla

presenza o meno della variabile indipendente e dipendente in rapporto causale, sulla formulazione di un'ipotesi

falsificabile e sul controllo delle altre variabili in gioco.

IL METODO DELL'INCHIESTA

Il metodo dell'inchiesta viene impiegato per raccogliere vari tipi di informazioni al fine di descrivere un certo

fenomeno, effettuare una certa diagnosi o determinare gli atteggiamenti verso un concetto o un prodotto. Questo

metodo consiste nel chiedere a qualcuno la sua opinione su una determinata cosa, come si comporta in una

determinata situazione, come giudica quel dato profumo, ecc... Occorre però tenere presente il fenomeno

dell'<<accettabilità>> e <<desiderabilità sociale>>, il quale dimostra che le risposte segnate su un questionario

tendono a essere in armonia con i principi e le regole presenti nella società.

L'INTERVISTA

L'intervista consiste nella raccolta di informazioni o dati ottenuti da intervistati tramite un intervistatore.

L'intervistatore può porre una domanda faccia a faccia o telefonicamente. Una generale suddivisione della tipologia di

intervista è tra: strutturata (l'intervista segue uno schema rigido nel porre le domande sia per il contenuto che per la

successione), semistrutturata (l'intervistatore può seguire una traccia generale, ma può decidere di approfondire un

particolare aspetto del tema oggetto dell'intervista) e aperta (l'intervistatore segue soltanto uno schema generale ma

si ritiene libero di variare le domande).

IL QUESTIONARIO

Il questionario ha la caratteristica di essere in forma scritta e quindi chi deve rispondere si trova davanti a domande

per rispondere alle quali non si è sottoposti a una particolare pressione temporale e non si è costretti a interagire con

un interlocutore. Il tipo di domanda più frequente nei questionari è rappresentato dalle domande chiuse (chiarezza

delle risposte e facilità e velocità della decodifica). Gli errori che possono essere commessi nella preparazione di un

questionario sono molti. In primo luogo la lunghezza, l'ambiguità e strutturare le domande in maniera non neutrale.

Sensazione e Percezione

LA SENZAZIONE

Il processo attraverso il quale i diversi tipi di energia fisica vengono tradotti in segnali nervosi è la trasduzione.

3

Attraverso la trasduzione il cambiamento ambientale registrato dall'organo di senso e tradotto in un segnale

bioelettrico viene trasmesso al cervello. È a questo punto che possiamo provare una sensazione del cambiamento

ambientale cui abbiamo assistito. La relazione tra lo stimolo fisico esterno e la sensazione che questo provoca viene

definita relazione psicofisica. Nella loro funzione di registrazione e traduzione degli stimoli esterni i nostri organi di

senso sono però vincolati da alcuni limiti:

✤ il nostro sistema sensoriale è in grado di rilevare solo l’energia a cui è sensibile. Noi siamo continuamente circondati

da stimoli che però non percepiamo perché in nostri organi di senso non li rilevano (ultrasuoni, onde

elettromagnetiche..);

✤ il secondo limite riguarda l’intensità dello stimolo, per poter essere registrato dagli organi di senso lo stimolo deve

essere sufficientemente intenso. Si parla di soglia assoluta, ossia dell’intensità minima che uno stimolo deve avere per

essere colto nel 50% dei casi;

✤ il terzo limite riguarda la capacità di ogni singolo organo di senso di cogliere una variazione di intensità di uno

stimolo. Con soglia differenziale si definisce la differenza di intensità minima che due stimoli devono avere per essere

avvertita nel 50% dei casi.

LEGGE WEBER E LEGGE DI FECHNER

La legge Weber evidenziò che <<la soglia differenziale>> (→JND, just not difference) di ogni stimolo è una frazione

costante dell'intensità dello stimolo iniziale (K=AR/R, K è una costante, AR è la soglia differenziale e R è l'intensità dello

stimolo).

In pratica la legge di Weber dimostra che più grande è uno stimolo (o più luminoso, più forte, più intenso, ecc...)

maggiore sarà la differenza necessaria rispetto a un altro stimolo affinché possa essere rilevata.

Legando il concetto di stimolo a quello di sensazione, alcuni anni più tardi Fechner cercò di verificare di quanto varia la

sensazione (componente psicologica) al variare dell'intensità dello stimolo (componente fisica). Elaborando la legge di

Weber, Fechner poté stabilire che la sensazione è direttamente proporzionale al logaritmo dell'intensità dello stimolo

(S= c log R+C, S è la sensazione, c è la costante di Weber, R è l'intensità dello stimolo e C è una costante di

integrazione). Ciò sta a significare che mentre l'intensità dello stimolo aumenta in maniera geometrica, la sensazione

corrispondente aumenta in progressione aritmetica.

LA PERCEZIONE

La percezione può essere definita come l’elaborazione delle informazioni sensoriali elementari convogliate dagli organi

di senso. Il concetto di elaborazione sta a indicare che la sensazione raccolta dagli organi sensoriali viene codificata,

organizzata, riconosciuta e interpretata. I processi sottostanti le fasi di elaborazione permettono quindi di far emergere

gli oggetti <<strutturati>>.

In un primo stadio hanno luogo i processi visivi primari che svolgono il compito di individuare e descrivere le

caratteristiche fisiche dello stimolo visivo lasciandone però indeterminati il significato, l'uso e la funzione. È proprio

l'analisi delle caratteristiche fisiche che permette di far emergere l'oggetto strutturato.

Dello stadio secondario se ne è occupata principalmente la psicologia cognitiva ed è appunto attraverso i processi

cognitivi che lo stimolo strutturato, attraverso il confronto con le conoscenze depositate in memoria, viene

riconosciuto.

ELABORAZIONE BOTTOM-UP E TOP-DOWN

Le modalità di confronto su cui si basano le principali teorie sulla percezione sono definite bottom-up (elaborazione

dal basso verso l'alto), con cui si intende una modalità di elaborazione <<guidata dai dati>>, cioè un'elaborazione che

parte dalle singole parti dello stimolo, e top-down (dall'alto verso il basso), ossia un'elaborazione <<guidata dai

concetti>>, cioè basata sulle rappresentazioni contenute in memoria.

LE PRINCIPALI TEORIE SULLA PERCEZIONE

La teoria più decisamente a favore del processamento bottom-up è la teoria della percezione diretta (o <<teoria

ecologica>> della percezione) di Gibson. Secondo Gibson ogni stimolo possiede informazioni sensoriali

sufficientemente specifiche da renderne possibile il riconoscimento senza l'intervento dei processi cognitivi superiori

(p.e. la memoria per accedere all'esperienza passata). L'ordine interno, costituito dalla distribuzione spaziale e

temporale dello stimolo, permette una sua diretta <<disponibilità>> al suo riconoscimento.

Gibson ha definito questa disponibilità dello stimolo affordance. L'affordance sarebbe ciò che permette all'osservatore

di estrarre le caratteristiche che definiscono l'uso e le finalità dell'oggetto percepito (p.e. l'interruttore della luce

suggerisce l'azione di premere, la tazza suggerisce di essere di essere afferrata dal manico, ecc...). L'affordance

suggerita dall'oggetto all'osservatore si basa però non soltanto sui fattori fisici posseduti dall'oggetto, ma anche sullo

stato psicologico e fisiologico dell'osservatore (p.e. in uno stato di rabbia un posacenere può assumere l'affordance di

un oggetto pesante da afferrare e lanciare).

4

Una teoria della percezione a favore invece del processamento di tipo top-down è la teoria costruttivista di Bruner e

Rock, secondo la quale, dato che noi non vediamo delle semplici configurazioni ma vediamo oggetti complessi, perché

questo sia possibile è necessaria un'attiva ricerca della migliore interpretazione possibile delle caratteristiche

disponibili. Secondo Gregory tale interpretazione, definita <<controllo delle ipotesi>>, non può avvenire se non

secondo un approccio top-down grazie al quale <<costruiamo>> le nostre percezioni attraverso i nostri processi

cognitivi (p.e. esperimento Pomerantz e Lockhead).

Un'altra teoria della percezione è quella dell'analisi tramite sintesi formulata da Neisser, secondo cui la percezione

sarebbe il risultato di una sequenza di stadi che avrebbe al primo posto la selezione preliminare dello stimolo visivo

tramite un processo preattentivo e automatico in grado di fornire una prima rappresentazione dello stimolo visivo

secondo un processamento di tipo bottom-up. Al secondo livello interverrebbe uno spostamento volontario

dell'attenzione sullo stimolo, basata sulle aspettative e sull'esperienza passata, per poi metterla a confronto con la

rappresentazione preliminare effettuata nello stadio precedente, questo stadio sarebbe guidato da un procedimento di

tipo top-down. Ciò che ha luogo nel terzo e ultimo stadio dipende dal risultato del confronto avvenuto nello stadio

precedente: se il confronto è positivo, allora la rappresentazione mentale dello stimolo ottenuta nel precedente stadio

viene considerata il risultato finale della percezione, se il confronto è negativo, il sistema dovrà ipotizzare nuove

rappresentazioni percettive.

Anche la teoria della percezione di Marr prevede un livello di elaborazione di tipo bottom-up e un livello più avanzato

che si baserebbe invece su processamenti top-down. Per uno stimolo tridimensionale sarebbero necessari tre distinti

stadi per arrivare a una percezione completa:

1. Schema grezzo primario (2D): Semplice abbozzo della scena percettiva. Rilevazione di dati sensoriali.

2. Schema a due dimensioni e mezza: Gli oggetti iniziano ad emergere dalla scena percettiva base degli indizi di

profondità centrati sulla prospettiva dell’osservatore.

Modello tridimensionale: Vero e proprio modello 3D dove possiamo vedere la relazione spaziale tra gli oggetti,

indipendentemente dalla prospettiva dell’osservatore (si sviluppa grazie all’esperienza passata).

COME AVVIENE IL RICONOSCIMENTI DEGLI OGGETTI?

• Teoria della comparazione tra sagome: nella nostra memoria sarebbero archiviate un numero enorme di sagome,

quando ci troviamo di fronte a un oggetto, avrebbe luogo un'analisi di tutte le sagome simili contenute in memoria.

Una volta ritrovata la sagoma uguale alla sagoma esterna avverrebbe il riconoscimento dello stimolo (p.e. codice a

barre sui prodotti del supermercato).

• Teoria dei prototipi: prevede che il confronto avvenga tra lo stimolo esterno ed un prototipo interno che contiene le

caratteristiche più tipiche di un certo insieme di oggetti. Un prototipo è una rappresentazione astratta della

configurazione, è sufficiente che condivida con la configurazione esterna alcune caratteristiche simili.

• Teoria delle caratteristiche (o tratti): il confronto avviene tra alcune caratteristiche possedute dallo stimolo esterno e

alcune caratteristiche possedute in memoria. Gli stimoli visibili vengono riconosciuti comparando le caratteristiche

immagazzinate in memoria. Sulla base del risultato del confronto vengono riconosciuti gli stimoli che contengono il

maggior numero di caratteristiche contenute anche in memoria.

REALTÀ FISICA E REALTÀ PERCETTIVA

Una teoria ingenua della psicologia sosteneva che ciò che noi percepiamo non sarebbe altro che una fotocopia dello

stimolo, cioè della realtà fisica del mondo esterno → realismo ingenuo, ossia, gli stimoli visivi verrebbero percepiti così

come essi sono, generando una completa coincidenza tra <<realtà fisica>> esterna e <<realtà fenomenica>> interna.

Ma non sempre si forma un legame tra queste due realtà, questo perché può succedere che un oggetto ci sia a livello

fisico ma non percettivo, cioè l'oggetto c'è ma noi non lo vediamo. Tale discrepanza viene definita l'assenza

dell’oggetto fenomenico.

Il caso contrario avviene quando uno stimolo c’è a livello percettivo ma non fisico. Tale condizione è l’assenza

dell’oggetto fisico.

Discrepanza fra oggetto fenomenico e oggetto fisico (illusioni ottica → triangolo Kanizsa).

LE LEGGI DELL’ARTICOLAZIONE FIGURA-SFONDO

L'organizzazione di tipo gerarchico del nostro sistema percettivo consente di <<segmentare>> il flusso di informazioni

che provengono dall'ambiente esterno in modo da isolare le singole configurazioni che costituiscono i vari oggetti.

La più generale delle segmentazioni del campo percettivo è quella figura-sfondo. L'articolazione figura-sfondo è un

processo che viene sempre eseguito dalla percezione dato che si può affermare che non può esistere figura senza uno

sfondo.

I PRINCIPI DI ORGANIZZAZIONE PERCETTIVA

5

Il campo percettivo non è né omogeneo (o indifferenziato) né caotico, ma è organizzato secondo unità percettive in

funzione dei cosiddetti principi di organizzazione percettiva della Gestalt.

Come è noto, la psicologia della Gestalt sostiene che la percezione si fondi su principi innati e nega l’importanza o il

ruolo dell’esperienza passata. La capacità di raggruppare stimoli isolati in sottoinsiemi e organizzarli come figura è,

secondo gli psicologi della Gestalt, una tendenza naturale, innata e quindi condivisa da tutti gli osservatori. I principali

principi di organizzazione percettiva proposti dai gestaltisti sono:

• vicinanza: se all'interno di un certo numero di stimoli ve ne sono alcuni vicini tra loro, questi verranno segregati a

formare una figura unica ed organizzata;

• somiglianza: quando in uno stimolo sono racchiusi stimoli simili tra loro, la percezione tenderà ad unificarli formando

un’unica figura;

• chiusura: quando gli elementi tendono a formare una figura chiusa vengono percepiti come un’unità organizzata a sé

stante;

• buona direzione: viene data maggiore importanza e vengono percepite come continue linee le cui traiettorie sono

simili rispetto a linee le cui traiettorie sono opposte.

Attenzione

L'attenzione può essere definita come quel processo che opera una selezione tra tutte le informazioni che in un dato

istante colpiscono i nostri sensi (informazione esterne) e/o i nostri ricordi (informazione interne) consentendo soltanto

ad alcune di accedere ai successivi stadi di elaborazione.

ELABORAZIONE PREATTENTIVA

Molti esperimenti hanno dimostrato che le caratteristiche elementari di uno stimolo, come il colore, la forma o il

movimento, vengono rilevate senza l'intervento dell'attenzione. In questi casi possiamo definire il processamento dello

stimolo come preattentivo. Dato che questo tipo di rilevazione non richiede l'impiego di risorse attentive, ne consegue

che il processamento avviene in maniera molto rapida e non risente del numero di distrattori presenti, cioè del

numero di stimoli simili presenti nel nostro campo percettivo.

Se però ci venisse chiesto di individuare p.e. uno stimolo giallo di forma triangolare, allora il colore e la forma

dovrebbero essere combinati tra loro attraverso un processo di integrazione delle due caratteristiche e questo

richiederebbe l'intervento dell'attenzione focalizzata che funziona analizzando ogni singolo stimolo presente nel

campo percettivo fino a combinare le due caratteristiche che lo definiscono. Il tempo necessario a questo tipo di

processamento attivo-seriale risentirebbe del numero di distrattori presenti e quindi il tempo aumenterebbe con

l'aumentare del numero di stimoli di colore e forma diversi presenti nel campo percettivo.

Gli errori che hanno luogo nella fase di abbinamento delle diverse caratteristiche dello stimolo sono stati definiti

congiunzioni illusorie.

L'elaborazione preattentiva delle singole caratteristiche di una configurazione viene anche definita pop-up. Con pop-up

si intende quel fenomeno in base alla quale le caratteristiche di una configurazione emergono spontaneamente e si

impongono al nostro sistema visivo.

PROCESSI AUTOMATICI E CONTROLLATI

Shneider e Shiffrin ipotizzarono l'esistenza di processi che avvengono sotto il controllo conscio e di processi che invece

non necessitano di alcun controllo.

Questi ultimi, definiti processi automatici, avvengono al di fuori della consapevolezza e non richiedono l'impiego di

risorse attentive. I primi sono invece definiti processi controllati, richiedono l'impiego di risorse attentive, vengono

messi in atto uno dopo l'altro secondo una modalità seriale e, a causa del costante controllo attentivo a cui sono

sottoposti, hanno un tempo di esecuzione più lento.

Attraverso l'esercizio e la pratica alcuni compiti (p.e. guida dell'auto) possono divenire automatizzati. Il processo viene

definito di <<automatizzazione>> o di <<proceduralizzazione>> e può essere messo in atto senza l'intervento

dell'attenzione che può essere impiegata in altri compiti; se però le condizioni ambientali cambiano e il compito

improvvisamente si complica, allora l'attività deve essere riportata sotto il controllo dell'attenzione. Da un punto di

vista generale si può concludere che:

i processi automatizzati richiedono una quantità minima di risorse attentive, avvengono in base a

un'elaborazione in parallelo delle varie operazioni, hanno un tempo di esecuzione rapido;

i processi controllati consumano invece molte risorse attentive, necessitano di un'elaborazione seriale delle

operazioni, vengono eseguiti più lentamente.

ERRORI ATTENTIVI

6

Nella più generale classificazione dell'errore umano proposta da Reason figurano due diversi tipi di errore, i mistakes e

gli slips, che possono essere ricondotti ai processi controllati e a quelli automatizzati. In particolare i mistakes sono gli

errori che si commettono nello scegliere un obiettivo o nell'identificare i mezzi per raggiungerlo e che avvengono

nell'ambito dei processi controllati; gli slips sono invece gli errori che si commettono nel mettere in atto quello che si

intende fare per raggiungere quel dato obiettivo e che quasi sempre avvengono all'interno di processi automatici (il

modo più efficace per evitare di compiere errori di tipo slip è quello di prevedere funzioni obbliganti, forcing functions,

cioè vincoli fisici che ci impediscano di compiere questo tipo di errori).

ATTENZIONE SELETTIVA

Quando ci troviamo di fronte a un numero elevato di stimoli, possiamo concentrare la nostra attenzione su una

specifica zona dello spazio dove si trova l'oggetto a cui siamo interessati. Questa capacità di concentrare l'attenzione in

maniera selettiva ci permette di elaborare in modo efficiente e dettagliato uno stimolo presente nel nostro campo

percettivo. Una possibile spiegazione dell'esistenza dell'attenzione selettiva risiede nella limitatezza delle risorse di cui

il nostro sistema di elaborazione dispone. L'uomo è un elaboratore di informazione a capacità limitata e di

conseguenza l'attenzione selettiva può essere vista come uno strumento per limitare la quantità di informazione che

deve essere elaborata, proteggendo il sistema di elaborazione stesso da sovraccarichi e interferenze (→ principio del

cognitivismo).

Il destino delle informazione irrilevanti dipende in buona misura dal momento in cui avviene la selezione cioè lo stadio

in cui la selezione ha luogo. Per alcuni autori la selezione avverrebbe nei primi stadi (<<selezione precoce>>) che

concernerebbe il processamento preattentivo (senza l'impiego dell'attenzione selettiva il sistema di elaborazione è in

grado di cogliere soltanto elementari caratteristiche fisiche dello stimolo), mentre per gli altri avrebbe luogo a un

livello più centrale (<<selezione tardiva>>).

EFFETTO STROOP

Con effetto Stroop si intende un noto fenomeno descritto per la prima volta da Ridley Stroop più di ottant'anni fa.

Nella sua forma più generale l'effetto viene studiato attraverso la presentazione della parola scritta in diversi colori e si

richiede al soggetto sottoposto di riportare il colore in cui è scritto la parola. Quando il significato della parola esprime

un colore, il confronto tra le due dimensioni dello stimolo può dar luogo a una configurazione <<congruente>> (p.e.

Rosso), oppure <<incongruente>> (p.e. Verde). Il risultato non è ovvio.

Se la selezione messa in atto dall'attenzione selettiva fosse precoce, il sistema attentivo sarebbe in grado di

concentrare le risorse sulla dimensione rilevante ed escludere invece la dimensione irrilevante dell'elaborazione. Ma se

così fosse, allora non emergerebbero delle differenze tra le risorse agli stimoli congruenti e quelle a stimoli

incongruenti.

Nell'elaborazione delle caratteristiche rilevanti, il soggetto focalizza la propria attenzione su quelle particolari

caratteristiche ed è consapevole di prendere in considerazione e analizzare quelle e non altre parti dello stimolo. Nel

caso delle caratteristiche irrilevanti, il soggetto, pur elaborandole, non è consapevole del processo che ha avuto luogo

(le caratteristiche irrilevanti sono state ugualmente elaborate ma non hanno raggiunto il livello di coscienza).

In conclusione, l'effetto Stroop emerge perché i soggetti non riescono a non leggere la parola, non riescono cioè a

limitare il loro compito al processamento della sola caratteristica rilevante (p.e. NON LEGGERE QUESTO MESSAGGIO).

ATTENZIONE SELETTIVA E CECITÀ AL CAMBIAMENTO

Un fenomeno molto legato al tema dell'attenzione selettiva è la cecità al cambiamento o change blindness. La cecità al

cambiamento consiste nell'impossibilità di cogliere in maniera consapevole alcune macroscopiche variazioni di una

scena nel caso in cui la variazione abbia luogo contemporaneamente ad altri elementi visivi di disturbo (p.e. due

immagini in rapida successione separate da un breve intervallo di vuoto-buio, nella seconda immagine c'è un

particolare diverso dalla prima, gli osservatori non sono in grado di rilevare la differenza).

L'effetto della cecità al cambiamento dimostra in maniera piuttosto convincente l'importanza capitale dell'attenzione,

in particolare dell'attenzione focalizzata sulle singole parti della scena per verificarne l'eventuale cambiamento.

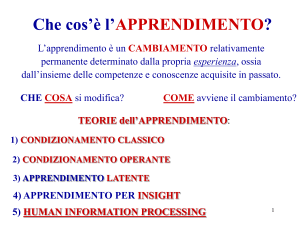

Apprendimento

Nella sua accezione più generale possiamo definire apprendimento tutte quelle modificazioni che un organismo mette

in atto nel corso dell’esistenza per meglio adattarsi all'ambiente esterno. Possiamo dire che ci troviamo in presenza di

apprendimento quando osserviamo un comportamento adattivo successivo a quello messo in atto in concomitanza

della prima esperienza. Da un punto di vista storico l’apprendimento è stato studiato dai comportamentisti.

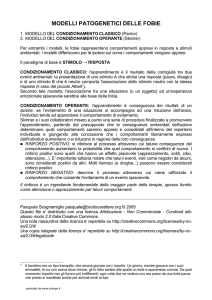

IL CONDIZIONAMENTO CLASSICO

Ivan Pavlov ha svolto una lunga serie di ricerche sulla fisiologia della digestione dimostrando, tra l'altro, come la

presentazione del cibo aumentasse l'attività delle ghiandole salivari. Nel corso delle ricerche emerse un aspetto che

7

portò Pavlov a intuire la relazione che può instaurarsi tra diversi stimoli ambientali e a dimostrare come questa

relazione possa mutare in presenza di determinate condizioni. Pavlov notò che in alcuni casi la salivazione dei cani

sottoposti all'esperimento (misurata tramite una cannula fissata in bocca e collegata a una provetta graduata)

aumentava anche quando non veniva presentato il cibo, ma quando il cane vedeva stimoli (persone, oggetti) che di

solito si accompagnavano al cibo.

Pavlov intuì che nell'animale si era stabilito un riflesso condizionato tra uno stimolo e una risposta appresa e dopo

lunghe e meticolose osservazioni schematizzò la scoperta in tre distinte fasi:

• in un primo momento il cane si trova in presenza di uno stimolo incondizionato-SI (il cibo) che da solo è in grado di

provocare una risposta incondizionata-RI (la salivazione);

• se a questo punto lo stimolo incondizionato-SI viene presentato insieme a uno stimolo neutro-SN (volto del

collaboratore di Pavlov o il camice che indossa) si forma nell'animale un riflesso condizionato che permette, dopo un

certo numero di abbinamenti tra SI e SN, di trasformare lo stimolo neutro-SN in stimolo condizionato-SC;

• quando si ottiene questa trasformazione, alla presenza isolata dell'SC si ha la risposta condizionata-RC (la

salivazione), simile alla risposta incondizionata-RI emessa in precedenza.

Pavlov definì l'insieme di queste sue osservazioni come <<condizionamento classico>> e mise a punto il famoso

esperimento della campanella.

Quindi il condizionamento classico può essere definito come un processo di apprendimento nel quale uno stimolo

inizialmente neutro, dopo ripetuti abbinamenti con un secondo stimolo in grado di produrre naturalmente la risposta,

viene associato a questo, diventando uno stimolo condizionato.

FASI E CARATTERISTICHE DEL CONDIZIONAMENTO CLASSICO

In relazione alle caratteristiche temporali, il condizionamento classico può essere scomposto in due fasi principali e

un'eventuale fase aggiuntiva:

fase di acquisizione, è quella durante la quale lo stimolo incondizionato viene regolarmente

preceduto dallo stimolo neutro (p.e. tutte le volte che il cibo viene preceduto dalla campanella);

fase di estinzione, lo stimolo condizionato ritorna ad essere neutro perdendo la capacità di generare

la risposta condizionata;

fase di riacquisizione, eventuale fase aggiuntiva, si ottiene ristabilendo l'abbinamento tra lo stimolo

condizionato (divenuto neutro) e lo stimolo incondizionato, il tempo per ristabilire il condizionamento è molto

inferiore alla fase di acquisizione.

I risultati ottimali si ottengono quando lo stimolo neutro precede di un brevissimo intervallo di tempo (1-2 secondi) lo

stimolo incondizionato. Questo tipo di relazione temporale tra SN e SI viene definita condizionamento ritardato o

condizionamento in avanti. Di minor efficacia è il condizionamento simultaneo. La velocità di apprendimento diviene

ancora più lenta quando la relazione temporale si inverte ed è SI a precedere di pochi secondi SN, abbinamento

definito condizionamento retrogrado.

GENERALIZZAZIONE E DISCRIMINAZIONE

Una volta instaurato un riflesso tra uno stimolo e una risposta, l'organismo tenderà a mettere in atto lo stesso

comportamento anche in risposta a stimoli simili allo stimolo condizionato.

Naturalmente questa caratteristica del condizionamento classico rappresenta un serio problema per gli effetti del

condizionamento e i ricercatori sono corsi ai ripari mettendo a punto la tecnica dell'addestramento alla

discriminazione

La tecnica consiste nel mettere in atto la fase dell'estinzione limitatamente agli stimoli che sono stati generalizzati. Il

risultato di questa condizione sarà l'estinzione del condizionamento a quegli stimoli, mentre lo stimolo condizionato-SC

continuerà ad essere seguito dallo stimolo incondizionato-SI in modo da consolidare il comportamento. Nel suo

complesso questo procedimento viene definito addestramento alla discriminazione.

Il condizionamento può estendersi anche a stimoli completamente diversi dallo stimolo condizionato a patto che

questi vengano ripetutamente presentati insieme ad esso (p.e. campanella → salivazione; accensione della luce →

campanella → salivazione). Questo nuovo tipo di condizionamento viene definito condizionamento di ordine

superiore.

STIMOLI AVVERSATIVI

Prendendo come esempio uno stimolo fastidioso come un potente soffio d'aria diretto verso la nostra faccia. Uno

stimolo incondizionato-SI avversativo di questo tipo ci provocherà una risposta incondizionata-RI di difesa come

abbassare le palpebre per ripararci gli occhi. Se il soffio di una campanella precede il soffio d'aria in futuro la sola

campanella ci farà abbassare le palpebre per ripararci gli occhi. Ci sono tre aspetti nel caso degli stimoli avversativi che

vanno sottolineati che li differenziano dagli stimoli positivi:

8

• per stabilire un condizionamento tra uno stimolo neutro-SN e uno stimolo incondizionato-SI avversativo può essere

sufficiente un singolo accoppiamento;

• il condizionamento con uno stimolo incondizionato-SI avversativo è molto più resistente all’estinzione (es. cibo

avariato cinese);

• l'importanza che gli stimoli avversativi ricoprono nell’apprendimento umano e in particolare per il condizionamento

di ordine superiore (p.e. aggressione → ladro → vestito da giardiniere → notte → soli → parco).

Come si vede, se lo stimolo incondizionato è negativo, il condizionamento può stabilirsi dopo una sola prova, perdura

nel tempo ed è in grado di generare un condizionamento di ordine superiore (p.e. Watson: bambino → ratto =

rumore/stimolo avversativo → ratto = paura).

IL CONDIZIONAMENTO OPERANTE E LA LEGGE DELL’EFFETTO

Un diverso tipo di condizionamento riguarda quelle azioni e quei comportamenti che mirano a produrre dei

cambiamenti sull'ambiente. Con il termine condizionamento operante si intende quel processo di apprendimento in

cui le conseguenze di una risposta influenzano le probabilità che quella risposta venga nuovamente prodotta in futuro.

Il condizionamento operante studiato e descritto da Skinner affonda le sue radici nella legge dell'effetto di Thorndike,

che nella sua formulazione più generale afferma che un'azione o un comportamento che provoca un effetto positivo

ha più probabilità di ripetersi in futuro, al contrario di un comportamento che abbia come conseguenza un effetto

negativo. Thorndike raggiunse queste conclusioni studiando il comportamento dei gatti all'interno di una <<gabbia

problema>> da lui ideata. L'animale affamato veniva posto in una gabbia con del cibo all'esterno. All'interno della

gabbia vi erano leve, cordicelle, piattaforme con cui il gatto poteva interagire e di cui solo uno dei meccanismi

permetteva di aprire la porta e raggiungere il cibo. Il comportamento dei gatti che, una volta immessi nella gabbia era

apparentemente casuale e privo di precise finalità, può essere definito comportamento <<per prove ed errori>>.

Quando il gatto premeva casualmente la leva giusta ottenendo come effetto l'apertura della porta e la possibilità di

raggiungere il cibo, si creava un legame tra l'azione e l'effetto positivo. Quando il gatto veniva inserito una seconda

volta nella gabbia l'esperienza precedente faceva diminuire significativamente il numero dei comportamenti <<per

prove ed errori>>.

Rispetto agli studi di Thorndike, il condizionamento operante di Skinner presentava alcuni vantaggi.

Nell'apparecchiatura ideata da Skinner era inserita una leva azionando la quale si otteneva un preciso effetto (p.e. la

somministrazione di una piccola quantità di cibo). Questo tipo di legame tra l'azione e il corrispondente effetto ha il

vantaggio che l'animale anche dopo aver effettuato l'azione e aver beneficiato del suo effetto si trova ancora

all'interno della condizione sperimentale e può continuare a ripetere il comportamento che ha appena ottenuto un

risultato positivo. Una seconda innovazione di Skinner fu l'introduzione del concetto di rinforzo, ovvero quel

cambiamento ambientale (positivo per l'organismo) che segue l’esecuzione di un <<comportamento operante>>.

Secondo Skinner la conseguenza positiva di una azione serve da rinforzo per l’organismo e rende più probabile che

quell’organismo ripeta in futuro quell’azione (p.e. gabbia di Skinner. Il ratto riceve un boccone/rinforzo positivo ogni

qual volta tocca la leva giusta).

TIPI E PROGRAMMI DI RINFORZO

Si definisce rinforzo positivo (“+”) qualsiasi effetto positivo che segue immediatamente (fino a 5 secondi) un

comportamento messo in atto da un organismo. Un aspetto particolarmente interessante del condizionamento

operante è la possibilità di aumentare la probabilità di un certo comportamento anche attraverso un rinforzo negativo

(“-”) che invece è rappresentato dalla cessazione di uno stimolo avversativo, doloroso e/o fastidioso, in seguito ad una

azione corretta (p.e. il ratto nella gabbia di Skinner. L'animale viene sottoposto a una scarica elettrica che cesserà

quando sarà toccata la giusta leva). Il rinforzo negativo non va confuso con la punizione che è una conseguenza

negativa a un comportamento per cui diminuisce la probabilità che quel comportamento venga ripetuto.

Per programma di rinforzo si intende la diversa successione tra azione e rinforzo somministrato. Come nel

condizionamento classico, anche in quello operante si può arrivare all’estinzione del comportamento appreso. Questo

avviene grazie alla cessazione del rinforzo.

Viene definito rinforzo costante quando il rinforzo si presenta ogni volta che si manifesta il comportamento e rinforzo

intermittente quando il rinforzo viene presentato soltanto saltuariamente.

I principali tipi di rinforzo intermittente sono quattro:

• rapporto fisso, il rinforzo viene presentato dopo n volte del comportamento da condizionare;

• rapporto variabile, il comportamento deve essere messo in atto un certo numero medio (varia attorno a una media)

di volte prima che venga dato il rinforzo (p.e. roulette);

• intervallo fisso, dopo la risposta rinforzata deve trascorrere un intervallo di tempo fisso;

• intervallo variabile, ogni rinforzo è separato dal successivo da un tempo variabile.

IL MODELLAMENTO

9

Per modellamento si intende quel programma di condizionamento attraverso il quale non si attende che un dato

comportamento insorga spontaneamente, ma si modella il comportamento fino a raggiungere ciò che si vuole

ottenere rinforzando ogni comportamento che si avvicina a quello desiderato (es. addestramento degli animali da

circo).

APPRENDIMENTO E COGNITIVISMO

Mentre i comportamentisti pensano che attraverso diversi tipi di condizionamento si raggiunge un comportamento

automatico, ovvero stimolo-risposta, i cognitivisti pensano che tra la psicologia S-R abbia inizio un processo mentale

responsabile del comportamento messo in atto.

Tolman fu il primo comportamentista ad accettare il concetto di rappresentazione mentale e mise a punto esperimenti

sull'apprendimento di percorsi di labirinti da parte di ratti dimostrando che anche gruppi di ratti che non venivano

<<rinforzati>> per ogni scelta corretta imparavano allo stesso modo del gruppo di ratti che ottenevano regolari rinforzi.

Anche la semplice esplorazione del labirinto permette di apprendere. Tolman concluse che in quella condizione

l'animale si forma una rappresentazione mentale del labirinto definita mappa cognitiva. Il ratto immesso nel labirinto

inizia a esplorarne i vari percorsi e mediante questa attività di esplorazione apprende il percorso corretto. Tolman

definì questo tipo di apprendimento apprendimento latente.

IL VALORE PREDITTIVO DELLO STIMOLO E L'INSIGHT

Secondo Rescorla, il condizionamento classico non può essere considerato un processo meccanico in cui un organismo

forma un'associazione tra due stimoli che si sono presentati insieme. Al contrario un organismo sottoposto a un

condizionamento è un attivo cercatore di informazioni, e per la ricerca si serve dei concetti che già possiede per dare

forma a una rappresentazione del mondo che lo circonda. Un'altra critica mossa all'approccio comportamentista si

riferisce alle condizioni sperimentali troppo rigide all'interno delle quali l'animale non aveva modo di dimostrare

comportamenti creativi e intelligenti.

Con insight si intende un modo di procedere non casuale o per prove ed errori, ma piuttosto una capacità di

ristrutturare in maniera diversa e creativa gli elementi presenti nell'ambiente in modo da risolvere un problema

altrimenti non risolvibile. Anche nel caso dell'insight si deve ipotizzare una rappresentazione interna dell'ambiente

circostante e non un semplice legame tra stimolo e risposta.

APPRENDIMENTO ESPLICITO E IMPLICITO

È possibile distinguere tra due forme di apprendimento e cioè una forma di apprendimento esplicito e una forma di

apprendimento implicito. La prima forma è tipicamente caratterizzata da processi attivi di apprendimento poiché gli

individui attivano delle strategie per lo più consapevoli e volontarie. In questo caso vengono messi in atto dei processi

attivi volti all'individuazione e all'estrazione della struttura di una qualche informazione presentata. L'apprendimento

implicito, invece, è caratterizzato da processi passivi per cui gli individui, quando sono esposti a un'informazione,

acquistano conoscenza da quell'informazione semplicemente in virtù dell'esposizione.

APPRENDIMENTO E STRATEGIE METACOGNITIVE

L'apprendimento di informazioni e la loro organizzazione nelle conoscenze già possedute sono favoriti anche dai

processi metacognitivi o metacognizione.

Con il termine <<metacognizione>> ci si riferisce a processi di pensiero di ordine superiore che svolgono la funzione di

controllo degli altri processi cognitivi coinvolti nell'apprendimento (p.e. pianificare come affrontare un compito in cui è

richiesto apprendimento, il controllo della comprensione e la valutazione dell'approssimazione al completamento di un

compito). La conoscenza di tali processi è intimamente connessa con la conoscenza generale di come gli individui

apprendono ed elaborano l'informazione, ma anche la conoscenza che gli individui hanno dei propri processi di

apprendimento.

Un altro aspetto cruciale nell'utilizzo dei processi metacognitivi è la valutazione della conoscenza relativa alle variabili

di compito inclusa la conoscenza della natura del compito e del tipo di elaborazione che quest'ultimo richiede

all'individuo (p.e. un individuo può essere consapevole di avere bisogno di più tempo per l'apprendimento di alcune

funzioni matematiche rispetto ad una poesia).

La stessa conoscenza può svolgere una funzione metacognitiva ed essere utilizzata strategicamente per programmare

le attività di apprendimento o per raggiungere un certo risultato in un compito.

APPRENDIMENTO SOCIALE

Il più noto tra gli apprendimenti sociali è l'imprinting, una particolare forma di apprendimento studiato

originariamente dagli etologi. L'aspetto più importante dell'imprinting risiede nel fatto che si stabilisce in un intervallo

temporale ben preciso dopo la nascita trascorso il quale questo specifico comportamento non ha più luogo. Il più noto

studioso dell'imprinting è Lorenz, che con i suoi esperimenti ha dimostrato che sostituendo la madre con un qualsiasi

altro oggetto semovente l'imprinting si stabilisce a favore dell'oggetto alternativo. Il tipo di <<legame sociale>> che sta

10

alla base dell'imprinting si basa su meccanismi genetici che prescindono dal semplice legame associativo tra lo stimolo

e la risposta appresa.

Un altro tipo di apprendimento sociale è rappresentato dall'apprendimento osservativo. In generale si può affermare

che due sono i meccanismi sottostanti all'apprendimento osservativo: l'emulazione e l'imitazione. Siamo in presenza di

emulazione quando l'individuo riproduce in maniera stereotipata e meccanica il comportamento di un <<modello>>

senza comprendere lo scopo o l'efficacia di quel comportamento. Si può invece parlare di imitazione quando la

riproduzione del comportamento dell'altro è consapevole ed è finalizzata al raggiungimento dello stesso scopo

perseguito dal <<modello>>. Per condividere uno scopo occorre però comprenderlo e quindi l'imitazione può essere

definita come la capacità di riprodurre ciò che altri intendono fare.

APPRENDIMENTO E TECNOLOGIE COMPLESSE

Come avviene l'apprendimento del funzionamento della rete internet? Si possono ipotizzare due distinti tipi di

apprendimento: uno strumentale, in buona parte procedurale (relativo alla capacità di usare il web), che permette di

apprendere la tecnologia vera e propria, e un apprendimento di tipo dichiarativo relativo alle nozioni apprese tramite

il web (apprendimento di nozioni online).

Non basta comprendere come la tecnologia funziona (conoscenza dichiarativa), ma bisogna anche imparare a usarla

(conoscenza procedurale).

Il web si differenzia da tutti gli altri strumenti multimediali per il fatto che richiede-permette all'utente il controllo sul

materiale presentato. L'utente infatti può individuale, selezionare ed evidenziare le informazioni che vuole apprendere

tra centinaia di altre informazioni potenzialmente raggiungibili.

L'apprendimento per prove ed errori è molto usato nei primi tentativi di operare nel web.

Una volta che si è appresa a modalità di navigazione, però, l'altissimo numero di informazioni disponibili e la

multisensorialità delle modalità di presentazione impone delle scelte che non possono essere attuate per prove ed

errori o per semplice associazione.

Perché vi sia apprendimento occorre che l'acquisizione delle conoscenze tramite web sia sottoposta a un processo

attivo necessario per la selezione, l'elaborazione e l'analisi delle informazioni da apprendere.

Sistemi e processi di memoria

MECCANISMI <<PURI>> DELLA MEMORIA

La memoria può essere definita come la capacità di mantenere le informazioni acquisite dal sistema per più o meno

tempo in modo da poterle avere a disposizione e utilizzare per lo svolgimento dei compiti che si porranno all’individuo.

Lo studioso tedesco Hermann Ebbinghaus sviluppò una serie di tecniche controllate e sottopose se stesso a prove

ripetute in condizioni sperimentali altamente controllate utilizzando materiali neutri per evitare l'influenza della

conoscenza precedentemente acquisita sull'esito delle prove. Tale materiale era costituito da trigrammi senza senso

come ZIK, PAZ, TUV, ecc...

in altri esperimenti Ebbinghaus misurò l'effetto della pratica sull'apprendimento. Con questi esperimenti furono

ottenuti due risultati importanti. Il primo costituisce una conferma dell'ipotesi del tempo totale di apprendimento,

cioè è stato osservato che la quantità di materiale appreso aumenta linearmente con il tempo impiegato

nell'apprendimento. Il secondo risultato riguarda il fatto che la pratica distribuita produce un risultato migliore della

pratica massiva.

Nelle prove di rievocazione libera Ebbinghaus descrisse un altro fenomeno, denominato curva di apprendimento

seriale che si riferisce alla tendenza a ricordare più frequentemente e accuratamente gli item posti all'inizio della lista

(effetto primarietà) rispetto a quelli collocati nella parte centrale (effetto reticenza).

LA COMPLESSITÀ DELLA MEMORIA

Bartlett riteneva che la memoria fosse un processo attivo sia quando le informazioni vengono acquisite, sia quando

devono essere recuperato. Per studiare la memoria utilizzò una particolare tecnica denominata metodo delle

riproduzioni in serie sia in forma grafica sia in forma linguistica (p.e. a un soggetto veniva fatto leggere un testo, per lo

più storie popolari, e di riprodurre quanto si ricordava; lo stesso ad un altro soggetto). Gli studi condotti con questa

procedura e questi materiali permisero a Bartlett di proporre e di descrivere la funzione della nozione di schema,

intesa come struttura che organizza le conoscenze acquisite e guida il nostro comportamento, una sorta di modello che

può essere opportunamente adattato a diverse circostanze. Gli schemi possono influenzare i processi di memoria

favorendo la selezione e l'organizzazione delle informazioni in entrata in una struttura sensata e in tal modo rendendo

più accurata anche la rievocazione.

La memoria, data la sua complessità, può essere valutata in molti modi, principalmente in base alla modalità con cui

viene chiesto ai soggetti di recuperare l'informazione. Ciò può essere effettuato almeno in tre modi e cioè mediante

rievocazione libera che si riferisce a tutte le situazioni in cui il soggetto tenta di ricordare, mediante una ricerca in

memoria, l'informazione richiesta, rievocazione suggerita che si riferisce a una situazione in cui il soggetto tenta di

11

ricordare l'informazione richiesta in presenza di un qualche suggerimento e riconoscimento che costituisce una

modalità di ricordo in cui un soggetto deve dire se un determinato stimolo corrisponde oppure no a uno

precedentemente memorizzato.

L’OBLIO E LE CAUSE DELL’OBLIO

L’oblio può essere definito come l’impossibilità o l’incapacità di recuperare una qualche informazione dalla memoria.

Diverse sono le cause dell'oblio. La prima è il tempo che intercorre tra il momento dell'acquisizione di un'informazione

e il momento in cui tale informazione deve essere recuperata. Il passare del tempo potrebbe essere responsabile del

decadimento della traccia mnestica ovvero di una progressiva erosione dell'informazione che è stata memorizzata.

Un’ipotesi più probabile sulle cause dell’oblio è quella dell’interferenza, proposta da McGeoch e McDonald.

L’interferenza si riferisce all'ipotesi secondo cui le dimenticanze si verificano poiché se due informazioni entrano in

contatto tra loro nella memoria possono rendere meno accurato il ricordo di una delle due (tanto più sono simili tanto

più è forte l'effetto). Si possono osservare due modalità di interferenza: interferenza retroattiva, che fa riferimento

all'effetto interferente del materiale appreso successivamente sul materiale che è stato appreso precedentemente e

che deve essere rievocato; interferenza proattiva, che fa riferimento all'effetto interferente del materiale appreso in

precedenza sul materiale appreso successivamente e che deve essere rievocato.

DAL MAGAZZINO SENSORIALE ALLA MEMORIA A BREVE TERMINE

Molte teorie della memoria fanno riferimento alla metafora del <<sistema di magazzini>> per sottolineare il fatto che

l'informazione, entrando nel sistema cognitivo, passa da un magazzino all'altro per poter essere mantenuta in un

qualche modo come informazione permanente.

Il primo magazzino è deputato alla registrazione dell'informazione sensoriale. Il magazzino si differenzia a seconda

della modalità sensoriale.

Sperling condusse una serie di ricerche volte a esplorare il registro sensoriale nella modalità visiva, che fu denominato

memoria iconica. Sulla base dei suoi esperimenti, Sperling concluse che a) esiste un magazzino in cui l'informazione

visiva persiste per un certo tempo, b) tale magazzino o memoria iconica è molto capiente e c) con il passare del tempo

l'informazione iconica diventa sempre meno leggibile.

Dai registri sensoriali le informazioni vengono trasmesse a un magazzino denominata memoria a breve termine (MBT).

La MBT è un magazzino a capacità limitata e di breve durata.

Miller dimostrò che la MBT poteva mantenere circa 7 item. Baddeley ipotizzò che tale limite può essere superato se si

ricorre alla tecnica del chunking, ovverosia riunendo i singoli item in unità o gruppi di ordine superiore e osservò che il

numero di errori nella ripetizione in sequenza diminuiva in funzione al grado di approssimazione all'inglese delle

stringhe. Ciò dimostra che la capacità dell'MBT dipende dalla natura dell'informazione che deve essere ricordata.

La durata dell'informazione nella MBT e la probabilità che quest'ultima sia trasferita nella memoria permanente

dipende anche dalla possibilità che l'individuo possa reiterare l'informazione (ripeterla a livello subvocalivo). È stato

dimostrato che distraendo i soggetti e impedendo loro di reiterare l'informazione, la rievocazione del materiale

appreso risulta compromessa.

La MBT ha un ruolo centrale nello svolgimento di una molteplicità di compiti differenti, in generale di tutti i compiti

cognitivi coinvolti nel ragionamento, nella soluzione dei problemi, nella comprensione e nell'apprendimento.

La rappresentazione del sistema ideato da Baddeley è denominato memoria di lavoro e consta di due componenti

fondamentali e cioè di un loop articolatorio preposto al mantenimento dell'informazione uditiva e quella basata sul

linguaggio e un taccuino visuospaziale preposto al mantenimento stimoli sotto forma di immagine. Inoltre il sistema

prevede anche un esecutivo centrale, ovvero di un meccanismo che, oltre al controllo dell'intero processo di

elaborazione delle informazioni, regola l'attività dei due magazzini di memoria ed è coinvolto nello svolgimento di una

molteplicità di compiti cognitivi di ordine superiore (p.e. pianificazione di attività, risolvere problemi, prendere

decisioni, ecc...).

STRUTTURA E PROCESSI DELLA MEMORIA A LUNGO TERMINE

La memoria a lungo termine (MLT) è un magazzino in cui le informazioni assunte vengono mantenute in una maniera

permanente. Le informazioni immagazzinate nella memoria a lungo termine possono essere di differente natura.

La memoria fattuale riguarda la descrizione di eventi e oggetti ovvero le conoscenze su <<che cosa sono>> quegli

eventi e quegli oggetti (p.e. un tifone è..., il computer è..., la rosa è..., ecc...); la memoria procedurale riguarda le

procedure alla base sia di ciò che gli individui fanno con oggetti sia di che cosa fare per svolgere certi compiti, fa

riferimento a <<il modo con cui si fanno>>; la memoria semantica si riferisce all'immagazzinamento e al recupero di

conoscenze riguardante le parole e i concetti, le loro proprietà e le relazioni reciproche (fenomeno parola sulla punta

della lingua si verifica quando non ci viene in mente un’informazione ma sappiamo di conoscerla. Noi sappiamo che

l’informazione esiste ma il recupero è momentaneamente bloccato); infine la memoria episodica riguarda

l'immagazzinamento e il recupero di eventi ed episodi temporalmente e spazialmente databili e localizzabili ed esperiti

personalmente.

12

MEMORIA AUTOBIOGRAFICA ED ERRODI DI MEMORIA

Tulvin ha teorizzato una particolare forma di memoria episodica denominata memoria autobiografica, ovvero una

forma particolare di mantenimento di informazioni relative a fatti personali e che consentono di riconoscere familiari,

amici e conoscenti. La memoria autobiografica mantiene anche le informazioni relative a quello che un individuo ha

appreso a scuola.

La memoria autobiografica può anche andare perduta in maniera selettiva, nel senso che possono essere dimenticati

eventi che sono stati esperiti dall’individuo nei primi anni di vita. In questo caso si parla di amnesia infantile. Questo

fenomeno si manifesta per lo più con una perdita di ricordi relativi alle esperienze fatte dagli individui nei primi 5 anni

di vita.

Le memorie autobiografiche possono essere inaccurate in alcuni particolare, ma accurate per quanto riguarda le

conoscenze di base relative agli eventi ricordati e spesso si rivelano delle interpretazioni piuttosto che delle vere e

proprie registrazioni di eventi.

Un fenomeno particolare che si inserisce nella descrizione della memoria autobiografica è il cosiddetto flash di

memoria: ovvero un ricordo ricco e articolato, quasi fotografico, collegato ad eventi sorprendenti (es. torri gemelle).

Luogo, attività, chi ha comunicato, stato d’animo, cosa ho fatto subito dopo rimangono impressi nella memoria.

L'introduzione di informazione fuorvianti prima di un compito di rievocazione può essere responsabile delle cosiddette

false memorie (Kassin e Kiechel): ovvero informazioni che possono contaminare la memoria anche in maniera del

tutto involontaria (es. degli studenti accusati di aver danneggiato un computer).

MEMORIA PROSPETTICA

La memoria retrospettiva si riferisce ai processi riguardanti informazioni relative alle esperienze passate dell'individuo.

La memoria che implica di ricordare ciò che dobbiamo fare, ovvero la realizzazione di intenzioni future riguarda la

memoria prospettica.

Einstein e McDaniel hanno esaminato le differenze tra due tipi di compiti in cui è coinvolta la memoria prospettica. Un

primo tipo sono i compiti basati sul tempo; il secondo tipo di compiti sono quelli basati sugli eventi.

I problemi con la memoria prospettica possono essere di due tipi. Gli individui possono manifestare un deficit quando

si verifica l'incapacità totale a richiamare un'azione che si era stabilito di fare in un preciso momento oppure possono

manifestare errori nell'esecuzione di un'azione. In questo secondo caso l'errore tipico, denominato absent-minded si

manifesta quando è già scattata l'azione o si sta eseguendo l'azione.

AMNESIE

Danno cerebrale, infezione virale, ictus, possono essere cause di un deficit della memoria che nella forma più grave si

presenterà come una sindrome amnesica. Le forme di amnesie conseguenti ad un trauma cranico possono essere di

diverso tipo. Si parla di amnesia postraumatica quando il paziente manifesta difficoltà nel ricordare quanto egli fa in

questo periodo di relativa confusione (disorientamento spazio-temporale, incapacità di ricordare il luogo fisico in cui si

trova, difficoltà a collocare gli eventi su una corretta dimensione temporale, confabulazione); si parla invece di

amnesia retrograda quando il paziente manifesta difficoltà a rievocare eventi che si sono succeduti nel periodo

immediatamente precedente all'evento traumatico (il paziente non riesce a ricordare gli eventi successi prima del

trauma); si parla, infine, di amnesia anterograda quando il paziente manifesta difficoltà a ricordare i fatti relativi al

periodo immediatamente successivo all'evento traumatico e ai nuovi apprendimenti esperiti (difficoltà di memorizzare

fatti correnti e nuovi apprendimenti).

COME MIGLIORERE L'EFFICIENZA DELLA MEMORIA

Gli individui possono aumentare l'efficienza della memoria o ridurre gli effetti dei limiti mnestici facendo ricorso ad

aiuti esterni, ovvero utilizzando strumenti che sono esterni al sistema cognitivo (p.e. post-it, agenda, ecc...) e alle

mnemotecniche.

Tra i cosiddetti aiuti mnestici interni (mnemotecniche), quegli aiuti che si basano sul funzionamento dei processi

cognitivi, Bells ha individuato due grandi categorie: le mnemotecniche per facilitare l'organizzazione delle informazioni

e le mnemotecniche per facilitare la codifica delle informazioni. Fanno parte della prima categoria il metodo dei loci

(individuazione di un percorso familiare e assegnazione ai vari punti o luoghi del percorso l'elemento da ricordare) e la

tecnica delle parole piolo (individuare e apprendere una lista di parole in grado di evocare immagini e associare ad

esse gli elementi da ricordare).

Alle mnemotecniche per facilitare la codifica si riconducono tutte quelle procedure che consentono di generare

rappresentazioni facilmente memorizzabili (p.e. la battaglia di Saratoga → Sara, toga → immagini mentali).

Rappresentazione delle conoscenze

13

Qualsiasi rappresentazione può essere concepita come un simbolo o un segno che <<rappresenta>> un oggetto, un

evento, o un comportamento quando non sono presenti all'osservatore.

Gli stessi oggetti possono trovare una qualche forma di rappresentazione a livello mentale, ovvero come

rappresentazioni analogiche, tipologia di rappresentazioni che consente di riprodurre e mantenere nella mente le

relazioni strutturali e le caratteristiche distintive di ciò che viene rappresentato, proprio come se si trattasse di una

riproduzione fisica. Le rappresentazioni proposizionali, invece, riguardano forme mentali di oggetti esterni

rappresentati in forme simboliche mediante segni arbitrari e descrizioni (linguaggio). Le rappresentazioni

proposizionali sono rappresentazioni astratte degli oggetti ed eventi che rappresentano e perciò non catturano né

contengono le caratteristiche fisiche di ciò che rappresentano.

RAPPRESENTAZIONE DEI SIGNIFICATI

Nella nostra mente sono rappresentati i significati ovvero la conoscenza semantica. Una possibile forma di

rappresentazione dei significati organizzata in modo strutturale è quella proposta da Collins e Quillian. Essi

ipotizzarono che i significati fossero rappresentati in una struttura gerarchica in cui i nodi concettuali fossero inclusi a

diversi livelli e che il recupero dell'informazione semantica corrispondesse alla ricerca all'interno della rete gerarchica

(p.e. il concetto di <<canarino>> è incluso in un concetto più ampio di <<uccello>>, e quest'ultimo è a sua volta incluso

nel più ampio concetto di <<animale>>).

Per dimostrare la validità psicologiche di tale rappresentazione Collins e Quillian hanno ideato un esperimento in cui

veniva chiesto ai partecipanti se fossero vere o false alcuni frasi semplici in cui erano contenute:

relazioni di appartenenza = Il canarino è un animale

presenza di una caratteristica = Il canarino ha le piume

Il tempo richiesto per decidere se la frase fosse vera o falsa sarebbe stato in funzione della <<distanza>> tra il nodo al

quale bisogna accedere e il nodo che contiene l'informazione relativa alla risposta da dare. Se consideriamo le seguenti

domande appartenenti a tre differenti livelli di implicazione:

Un canarino è un canarino? = livello 0

Un canarino è un uccello?= livello 1

Un canarino è un animale?= livello 2

i tempi di reazione per emettere la risposta dovranno essere crescenti a partire dalla risposta più veloce per la

domanda con livello 0 alla risposta più lenta di livello 2. Questo perché la prima domanda contiene una distanza

semantica nulla. La distanza semantica aumenta man mano che la distanza tra i nodi aumenta. Tale fenomeno si può

spiegare con il fatto che il sistema cognitivo per poter emettere la risposta deve prima accedere al nodo concettuale e

poi controllare l’esistenza della caratteristica in esame in quel nodo.

Un'altra modalità di rappresentazione dei significati è quella di Rumelhart e McClelland basata sulle rappresentazioni

distribuite che rappresentano le idee come aggregati di attivazioni distribuita attraverso una certa quantità di nodi e

connessioni. Ciascun nodo può contribuire alla rappresentazione di diversi concetti contemporaneamente. I vari nodi

presentano una molteplicità di connessioni alcune delle quali trasferiscono attivazione attraverso i nodi connessi ai

primi, mentre altre connessioni riducono o inibiscono l'attivazione dei nodi connessi. Questi aggregati operano come

potrebbero operare i neuroni del cervello e costituiscono una simulazione dell'attività neuronale.

RAPPRESENTAZIONE DELLE CONOSCENZE PROCEDURALI

Gli individui dispongono di conoscenze specializzate riguardanti il modo con cui svolgono molte attività. Queste

informazioni rappresentate in forma proposizionale si riferiscono alla conoscenza procedurale. Noi non solo sappiamo

che cosa è una bicicletta e come è fatta, ma sappiamo anche come si usa. Le conoscenze procedurali si riferiscono

tipicamente a come si fanno le cose e a come si utilizzano gli oggetti. Tali conoscenze sono articolate in produzioni

ovvero in strutture preposizionali del tipo se... allora, strutture che mettono in relazione concetti o eventi con un dato

comportamento.

Le conoscenze procedurali sono rappresentate in una forma che consente di eseguire le azioni o i comportamenti in

maniera autonoma. L’idea sviluppata è quella dello script, uno schema che descrive in termini generali come si fa

qualcosa. Lo script corrisponde ad una rappresentazione mentale di una procedura abituale e stereotipata. Lo script è

un canovaccio molte informazioni non sono esplicitate nella rappresentazione schematica, ma devono essere inferite.

IMMAGINI MENTALI

Una delle questioni principali che si pongono gli psicologi è la capacità di riconoscimento degli oggetti e degli eventi.

Le rappresentazioni degli oggetti in entrata non sempre corrispondono alle rappresentazioni degli oggetti posseduta

dagli individui. Per esempio noi possiamo ruotare mentalmente l'immagine di uno stimolo e riconoscerlo ugualmente.

Le immagini mentali sono una fondamentale forma di rappresentazione immagazzinata separatamente rispetto alle

rappresentazioni proposizionali. Le immagini sono generate in un formato analogo alle nostre percezioni e perciò

hanno estensioni e risoluzioni limitate. La teoria di Kosslyn si basa su dati empirici che dimostrano che, quando la

14

gente manipola le rappresentazioni mentali, si comporta in modo tale da replicare l'interazione che generalmente ha

con il mondo reale.

TEORIA DELLA DOPPIA CODIFICA

Paivio ha proposto una teoria della doppia codifica, postulando l'esistenza di due sistemi simbolici indipendenti ma

interconnessi, specializzati per codificare, organizzare, trasformare, immagazzinare e recuperare l'informazione.

I due sistemi di codificano usano due differenti rappresentazione. Il primo tipo di rappresentazione, dette imagens,

costituisce la modalità elettiva di elaborazione delle informazioni non verbali e viene attivata nell'esplorazione di scene

o di generazione immagini mentali (operano in sincrona o parallelo).

Il secondo tipo di rappresentazione, dette logogens, costituisce la modalità privilegiata per l'elaborazione delle

informazioni di tipo linguistico (operano in maniera sequenziale).

La teoria di Paivio prevede che nel sistema vi siano della connessioni referenziali che ci consentono di visualizzare gli

oggetti nominati e di nominare gli oggetti che vediamo.

La teoria della doppia codifica è stata confermata da studi sulla memoria che mostrano come la rievocazione libera di

parole concrete sia migliore di quella di parole astratte.

Gli stimoli possono avere un differente valore di <<immaginbilità>> ovvero la diversa capacità di evocare

un'immagine.

RAPPRESENTAZIONE DEI SIGNIFICATI IN TERMINI DI CONCETTI E CATEGORIE

I concetti costituiscono la conoscenza che permette agli individui di trattare differenti entità come appartenenti alla

medesima categoria e ci consentono di decidere quali comportamenti assumere alla presenza di diverse entità. La

conoscenza contenuta nei concetti ha degli effetti sull'attività percettiva e sulla rappresentazione mentale del mondo

che ci circonda. La variabilità degli stimoli che costituiscono l’ambiente può dare origine ad un certo numero di

categorie. Gli elementi che fanno parte di una categoria difficilmente vengono distinti gli uni dagli altri, questi stessi

elementi si distinguono però da quelli di categorie diverse. Questo utilizzo delle categorie risponde ad un principio di

<<economia cognitiva>> poiché da una parte ci permettono di massimizzare le informazioni in esse contenute e

dall’altra di differenziare ogni categoria dalle altre. Vi sono categorie che sono facili da definire e altre che sono meno

facili se non addirittura difficili da definire. Questo anche se in base al principio di <<struttura del mondo percepito>>

vi sono nel mondo delle combinazioni di caratteristiche che ricorrono più frequentemente di altre.

Gli studi condotti da Rosch hanno permesso di descrivere l’organizzazione dei concetti in base a due dimensioni

principali. La prima, denominata dimensione verticale, si riferisce al grado di inclusione di una categoria (p.e. la

categoria dei veicoli ha un’estensione maggiore delle categorie “automobili” e “ treni” poiché la prima include le