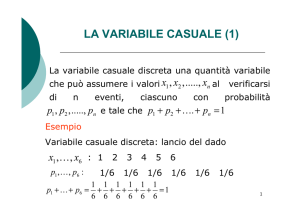

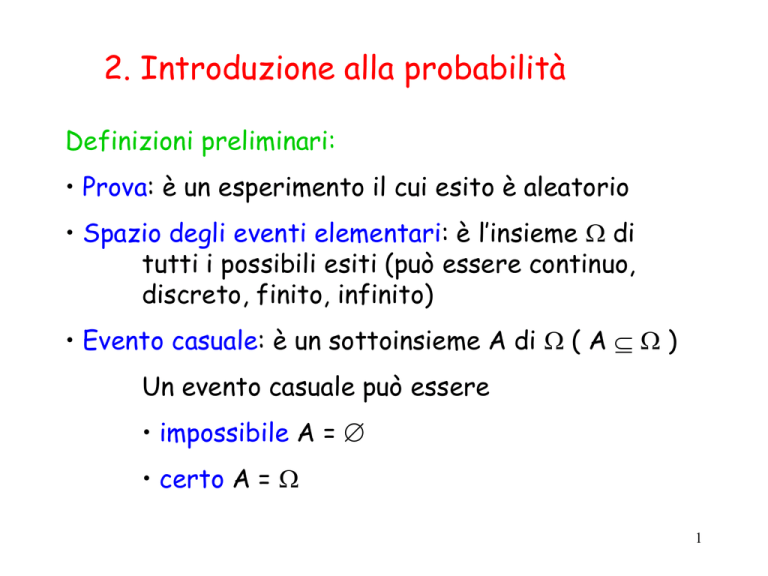

2. Introduzione alla probabilità

Definizioni preliminari:

• Prova: è un esperimento il cui esito è aleatorio

• Spazio degli eventi elementari: è l’insieme di

tutti i possibili esiti (può essere continuo,

discreto, finito, infinito)

• Evento casuale: è un sottoinsieme A di ( A )

Un evento casuale può essere

• impossibile A =

• certo A =

1

Esempi:

1) Prova: estrazione di 2 palline da un’urna di palline

nere e bianche

={bb,bn,nb,nn}

(spazio discreto finito)

Evento casuale: le due palline sono dello stesso

colore A = {bb,nn}

2) Prova: si lancia una moneta fino a che non esce testa

={1,2,3,…} (spazio discreto infinito numerabile)

numero dei lanci necessari

2

4) Prova: lancio di un dado

={1,2,3,4,5,6}

(spazio discreto finito)

Evento casuale: esce un numero pari

A = {2,4,6}

Evento casuale: esce un numero > 6 (impossibile)

Evento casuale: esce un numero <7 (certo)

3) Prova: si arriva ad una coda e si attende il prossimo

arrivo

={t | t 0 } (spazio continuo)

tempi di arrivo

3

Lo spazio degli eventi soddisfa i seguenti assiomi:

1) se A è un evento, il suo complemento (\A) è

anch’esso un evento

2) l’unione di più eventi A1,A2,… è ancora un

evento, ossia

A i Ω

i1

4

Dato uno spazio di EVENTI DISCRETI

= { w1, w2, … , wm},

la probabilità è una funzione

Pr( . ) : [0,1]

che associa ad ogni evento elementare wi ,

i=1, 2, … , m, la sua probabilità Pr(wi).

In particolare, Pr(wi) rappresenta la percentuale

di volte che l’evento elementare può accadere

quando il numero di prove eseguite tende

all’infinito, ossia

Nwi

Pr(ωi ) lim

N N

5

Anche agli eventi casuali (non solo a quelli

elementari) è possibile associare la probabilità di

occorrenza:

N

Pr(A) lim A

N N

Naturalmente, se A = { wl1, wl2, … , wlq} :

q

Pr(A) Pr{wli }

i1

6

La probabilità è caratterizzata dai seguenti assiomi:

1) 0 Pr(A) 1 A

2) Pr() = 1

3) Se A e B sono eventi disgiunti (A B = ), allora

Pr(A B) = Pr(A) + Pr(B)

Se invece A e B non sono disgiunti (A B )

Pr(A B) = Pr(A) + Pr(B) - Pr(A B)

[ Teorema dell’unione di eventi ]

7

Esempi:

1) Prova: estrazione di 2 palline da un’urna di palline

nere e bianche = {bb,bn,nb,nn}

wi

bb

bn

nb

nn

Pr(wi)

1/4

1/4

1/4

1/4

Eventi equiprobabili

Tabella delle probabilità

Evento casuale: le due palline sono dello stesso colore

A = {bb,nn}

Pr(A) = 1/4 + 1/4 = 1/2

8

2) Prova: lancio di una moneta fino a che non esce testa

= {1,2,3,...}

wi

1

2

3

4

:

k

Pr(wi)

1/2

1/4

1/8

1/16

:

1/2k

Primo lancio

Secondo lancio

etc.

T C

TT TC CT CC

9

Probabilità condizionata

Siano dati due eventi casuali A e B e sia Pr(B) > 0.

Definiamo probabilità di A condizionata a B, la

probabilità che si verifichi A essendosi verificato B:

Pr(A B)

Pr(A| B)

Pr(B)

10

Due eventi A e B sono (stocasticamente)

indipendenti se

Pr(A B) = Pr(A) ·Pr(B)

In questo caso risulta

Pr(A| B) = Pr(A) e

Pr(B|A) = Pr(B).

11

Esempio: lancio di un dado = {1,2,3,4,5,6}

Evento casuale A : esce un numero < 4 A = {1,2,3}

Evento casuale B : esce un numero pari B = {2,4,6}

I due eventi non sono stocasticamente indipendenti.

Pr(A) = Pr(B) = 1/2,

A B = {2}

Pr(A B) = 1/6

Pr(A | B) = 1/3 (Suppongo cioè che solo

{2,4,6} si possono verificare, allora 1/3 è la

prob. che si abbia un numero < 4).

12

Teorema della probabilità assoluta

Sia lo spazio degli eventi elementari e sia A1, A2, … ,Ak

una sua partizione, ossia

k

A i Ω

A i A j i j

i1

Sia B . Vale la seguente relazione

k

Pr(B) Pr(A i) Pr(B | A i)

i1

A1

A3

Dimostrazione:

A2

B

A4

B (B A 1) (B A 2 ) (B A k )

k

k

i1

i1

Pr(B) Pr(B A i) Pr(A i) Pr(B | A i)

13

Variabili aleatorie (o casuali) discrete

Ad ogni evento elementare w può essere associato

in modo univoco un numero reale attraverso una

particolare funzione che viene detta variabile

aleatoria (v.a.), ossia

( . ) : X R

Nel seguito indicheremo con X le v.a. e con x i valori

che esse possono assumere.

14

Una variabile aleatoria (o casuale) è completamente

definita dalla coppia (X,) dove X = {x1, … , xn} R e

={x1, … , xn} dove xi = Pr(xi).

Naturalmente

Πx i 1

x iX

Esempio: lancio di 2 monete. Il numero di teste è una

variabile aleatoria.

wi

Pr(wi) xi xi

CC

1/4

0 1/4

CT

1/4

insieme

1 1/2

numerico

TC

1/4

insieme non

numerico

TT

1/4

2

1/4

15

Una variabile aleatoria può essere agevolmente

rappresentata mediante un Istogramma

Esempio: numero di teste nel lancio di 2 monete

Pr(x)

1

3/4

1/2

1/4

-1

0

1

2

3

x

16

Esempio: numero di lanci di una

moneta fino a quando

non esce testa

wi

1

2

Pr(wi)

1/2

1/4

3

4

:

1/8

1/16

:

k

1/2k

Pr(x)

1/2

1/4

0

1

2

3

4

5

6

x

17

La funzione distribuzione cumulativa di

probabilità FX(y) di una v.a. X esprime la

probabilità che X assuma un valore minore o

uguale ad y:

FX(y) = Pr (x y) = x y Pr(x)

Esempio: numero di teste nel lancio di 2 monete

FX(x)

1

3/4

1/2

1/4

-1

1/4

1/2

0

1

2

3

x

18

Valore atteso o media

E[X] μx xPr(x)

xX

Nel caso di probabilità uniformi (ossia in cui

tutte le variabili xi siano equiprobabili) vale

1 m

E[X] μx xi

m i1

dove m= |X|.

Osservazione:

In generale può accadere che E[X] X

19

Varianza

2

Var[X] E[(X - E(X))2 ] σ x (x - μx )2 Pr(x)

xX

x è detta deviazione standard.

È una misura della distribuzione della probabilità

attorno al valore atteso.

Pr(x)

Var[X]=0

1

E[X]

x

20

Esempio: numero di teste nel lancio di 2 monete

wi

CC

CT

TC

TT

Pr(wi) xi xi

1/4

0 1/4

1/4

1 1/2

1/4

1/4

2 1/4

E[X] = 0 ·1/4 + 1 ·1/2 + 2 ·1/4 = 1

Var[X] = (0-1)2 ·1/4 + (1-1) 2 ·1/2 + (2-1) 2 ·1/4

= 1/4 + 1/4 = 1/2

21

Distribuzione uniforme

1

b a 1

Pr(x)

0

x a, a 1, , b

altrimenti

1

E[X] (a b)

2

(b a 1)2 1

Var[X]

12

La probabilità è la stessa in tutti i punti

dell’intervallo.

22

Distribuzione geometrica

p(1 p) x

Pr(x)

0

x N

0<p<1

altrimenti

1

E[X] 1

p

1-p

Var[X] 2

p

N.B.

1

a

1a

x 0

x

1

1

p(1 p) p

1 (1 p)

x 0

x

23

x

0

1

2

3

4

.

.

.

p(1 p) x

(p 0.5)

0.5

0.52 = 0.25

0.53 = 0.125

0.54 = 0.0625

0.55 = 0.03125

.

.

.

24

Distribuzione di Poisson

e - x

x!

Pr(x)

0

x N

R+

altrimenti

E[X]

Var[X]

25

Naturalmente

λ x

eλ

x 0 x!

e λ λ

x!

x 0

x

1

Inoltre è facile verificare che:

x

x

x

λ

λ

λ

μ xp(x) xe λ

xe λ

e λ

x! x 1

x!

xN

x 0

x 1(x 1)!

λ (x 1)

λk

λ

λ

e λ

e λ

e λ λ eλ λ

x 1(x 1)!

k 0 k!

26

x

0

1

2

3

4

5

.

.

.

e - x

x!

0.367

0.367

0.183

0.061

0.015

0.003

.

.

.

( 1)

Pr(x)

1

0 1 2 3 4

x

27

Pr(x)

>1

0 1 2 3 4

x

L’importanza di tale distribuzione deriva dal

fatto che vi sono diverse situazioni in cui la

distribuzione di Poisson appare in modo

naturale.

28

Funzione generatrice di probabilità

PX (z) z xPr(x)

xX

Nel caso in cui X N la funzione generatrice di

probabilità coincide con la z-trasformata della

funzione probabilità.

N.B.

Perché tale definizione abbia senso, la serie deve

naturalmente essere convergente.

29

Se XN possiamo esprimere E[X] e Var[X]

in funzione di

PX (z) z i Pr(i)

i 0

dPX (z)

E[X]

dz z 1

2

dPX (z)

d PX (z)

dPX (z)

Var[X]

2

dz z 1 dz z 1

dz z 1

2

30

Esempio: numero di teste nel lancio di 2 monete

xi xi

0 1/4

1

1/2

2

1/4

1

1

1

z 1 z 2

4

2

4

z2 2z 1

4z2

PX (z) z i Pr(i) z 0

i 0

dPX (z)

z 1

3

1

dz z 1

2z z 1

d2PX (z)

2z 3

5

2

4

dz z 1

2z z 1 2

E[X] 1

5

1

Var[X] 1 1

2

2

31

Esempio: numero di lanci di una moneta fino a che

non esce testa

wi

Pr(wi)

i

i 1

1

1/2

PX (z) z Pr(i) z i (2z) i

2 i1

i 0

i1

2

1/4

3

4

:

k

1/8

1/16

:

N.B. Per i=0 la Pr(i)=0 non 1/20.

Ricordiamo che se |a|< 1,

i

a

1/2k

i 0

PX (z) 1 (2z) 1 (2z)i 1

i1

i

i 0

dPX

2

E[X]

2

2

dz z 1

(2z 1) z 1

1

1a

1

1

1

2z 1

1 (2z)1

32

Variabili aleatorie continue

Fino ad ora abbiamo considerato il caso di variabili

che assumo al più una infinità numerabile di valori.

Vi sono però naturalmente dei casi in cui tali

variabili possono assumere qualunque valore in R (o

in un intervallo di R).

Es. Istante di tempo in cui un certo

dispositivo elettronico smette di funzionare

Molte delle definizioni prima viste sono ancora

valide, quali ad es. quella di evento impossibile,

evento certo, probabilità condizionata, etc.,

alcune vanno tuttavia riformulate.

33

Le v.a. continue sono caratterizzate mediante la

funzione densità di probabilità (x).

(x)

Π(x)dx 1

x

-

x1 x1+dx

(x1)dx = Pr(x[x1, x1+dx])

34

La funzione di distribuzione cumulativa FX(y) esprime

la probabilità che X assuma un valore minore o uguale

ad y:

y

FX (y) Pr(x y) Π(x)dx

-

Chiaramente la funzione FX(x) è una funzione monotona

non decrescente

e FX(+)=1.

35

Valore atteso o media

E[X] μx Π(x)x dx

Varianza

2

2

Var[X] E[(X - E(X)) ] σ x Π(x)(x - μx )2 dx

36

Distribuzione uniforme

(x)

1/(b-a)

x

a

b

E[X]=(a+b)/2

Var[X]=(b-a)2/12

37

Distribuzione esponenziale

(x) = e- x

xR+ {0}

x

E[X]=1/

Var[X]= 1/ 2

38

Distribuzione normale o gaussiana

(x)

Var[X]=2

E[x]=

1

Π(x)

e

σ 2π

x

(x μ)2

2σ 2

39

• Se la distribuzione è normale allora il valore

medio è anche il valore più probabile.

• La somma di v.a. gaussiane indipendenti è ancora

una v.a. gaussiana indipendente la cui media è pari

alla somma delle medie e la cui varianza è pari alla

somma delle varianze.

Una v.a. gaussiana è detta standard se

E[X]=0 e Var[X]=1.

40

Funzione generatrice di probabilità

PX (s) e sxΠ(x)dx L[ (x)]

0

dPX (s)

E[X]

ds s 0

2

dPX (s)

d PX (s)

Var[X]

2

ds s 0 ds s 0

2

41

Esempio: variabile casuale esponenziale negativa

Π(x) λ e λ x

λ

PX (s) L[ e ]

s λ

dPX (s)

λ

1

E[X]

2

ds

λ

(s λ )

d2PX (s)

2λ

1

1

2

Var[X]

E[X]

ds2

(s λ )3 s 0 λ 2 λ 2

λ x

42

![2 [6] Una compagnia di assicurazione ritiene che gli assicurati](http://s1.studylibit.com/store/data/002416903_1-3377a891909164cbe7bb266e8421813f-300x300.png)