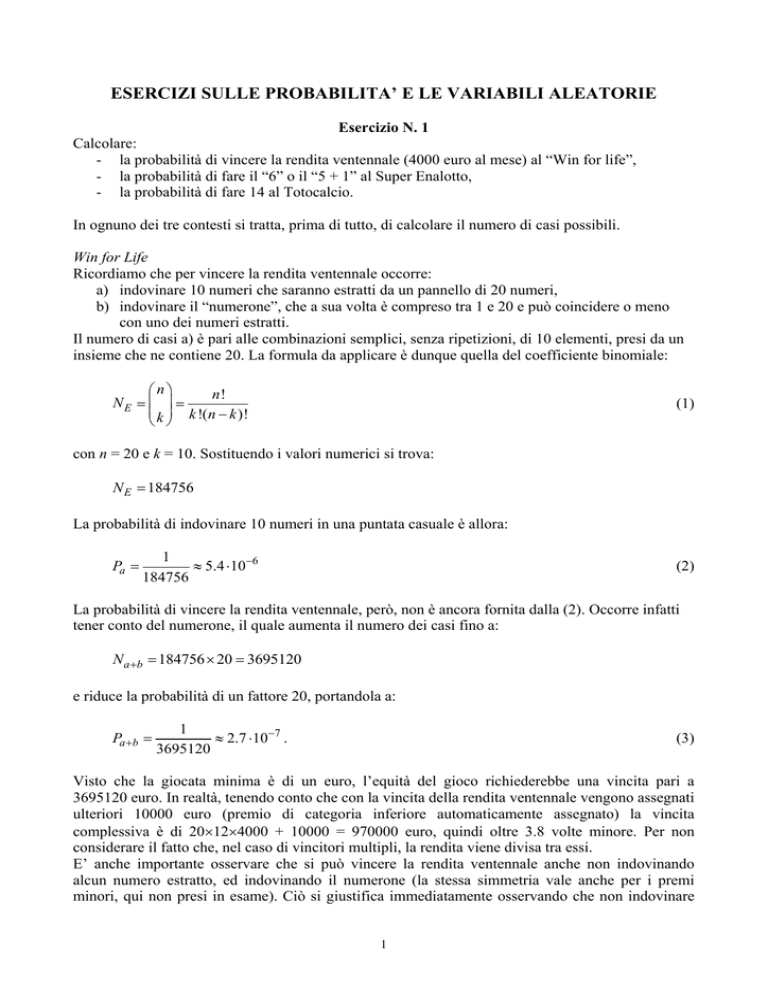

ESERCIZI SULLE PROBABILITA’ E LE VARIABILI ALEATORIE

Esercizio N. 1

Calcolare:

- la probabilità di vincere la rendita ventennale (4000 euro al mese) al “Win for life”,

- la probabilità di fare il “6” o il “5 + 1” al Super Enalotto,

- la probabilità di fare 14 al Totocalcio.

In ognuno dei tre contesti si tratta, prima di tutto, di calcolare il numero di casi possibili.

Win for Life

Ricordiamo che per vincere la rendita ventennale occorre:

a) indovinare 10 numeri che saranno estratti da un pannello di 20 numeri,

b) indovinare il “numerone”, che a sua volta è compreso tra 1 e 20 e può coincidere o meno

con uno dei numeri estratti.

Il numero di casi a) è pari alle combinazioni semplici, senza ripetizioni, di 10 elementi, presi da un

insieme che ne contiene 20. La formula da applicare è dunque quella del coefficiente binomiale:

⎛n⎞

n!

NE = ⎜ ⎟ =

⎜ k ⎟ k !(n − k )!

⎝ ⎠

(1)

con n = 20 e k = 10. Sostituendo i valori numerici si trova:

N E = 184756

La probabilità di indovinare 10 numeri in una puntata casuale è allora:

Pa =

1

≈ 5.4 ⋅10−6

184756

(2)

La probabilità di vincere la rendita ventennale, però, non è ancora fornita dalla (2). Occorre infatti

tener conto del numerone, il quale aumenta il numero dei casi fino a:

N a +b = 184756 × 20 = 3695120

e riduce la probabilità di un fattore 20, portandola a:

Pa +b =

1

≈ 2.7 ⋅10−7 .

3695120

(3)

Visto che la giocata minima è di un euro, l’equità del gioco richiederebbe una vincita pari a

3695120 euro. In realtà, tenendo conto che con la vincita della rendita ventennale vengono assegnati

ulteriori 10000 euro (premio di categoria inferiore automaticamente assegnato) la vincita

complessiva è di 20×12×4000 + 10000 = 970000 euro, quindi oltre 3.8 volte minore. Per non

considerare il fatto che, nel caso di vincitori multipli, la rendita viene divisa tra essi.

E’ anche importante osservare che si può vincere la rendita ventennale anche non indovinando

alcun numero estratto, ed indovinando il numerone (la stessa simmetria vale anche per i premi

minori, qui non presi in esame). Ciò si giustifica immediatamente osservando che non indovinare

1

alcun numero è del tutto equivalente ad indovinare 10 numeri (quelli non estratti). Ne consegue che

la probabilità di fare “0” è uguale alla probabilità di fare “10”.

Super Enalotto

Per il Super Enalotto la sequenza dei 6 numeri vincenti (lasciando da parte il numero jolly) si

ottiene, casualmente, dall’insieme dei 90 numeri in gioco. Ricordiamo che il regolamento del gioco

prevede che i 6 numeri siano tutti diversi tra loro. Di conseguenza, il numero di casi possibili NE è

dato dal numero di combinazioni semplici, senza ripetizioni, di 6 elementi, presi da un insieme che

ne contiene 90. La formula da applicare è dunque ancora la (1) con n = 90 e k = 6. Sostituendo i

valori numerici si trova:

N E = 622614630

La probabilità di vittoria di una giocata singola (6 numeri) è allora pari all’inverso di NE e quindi a:

PE =

1

≈ 1.6 ⋅10−9

622614630

(4)

Da un diverso punto di vista, il valore di NE esprime ovviamente anche il numero di combinazioni

necessarie per avere la certezza di fare 6 punti 1 .

In questo caso, dunque, il gioco sarebbe equo se, a fronte di 1 euro giocato (costo della giocata

minima, che però corrisponde alla scelta di due combinazioni), si avesse la certezza di riceverne,

totalizzando 6 punti, 622614630. Il “giusto” premio, dunque, sarebbe di 311307315 euro. In realtà,

la vincita più alta ad oggi realizzata, il 22 agosto 2009, a Bagnone (MS), è stata di quasi 148 milioni

di euro.

Per quanto concerne il 5 + 1, la probabilità di vincita può essere calcolata come segue.

Sia:

abcdef

la sequenza di 6 numeri giocata dallo scommettitore e

ABCDEF

la sequenza estratta. Ipotizziamo che le due sequenze non coincidano e che dunque la giocata non

abbia prodotto un 6. Chiediamoci preliminarmente quale sia la probabilità del 5 2 .

1

A rigore questa affermazione non è completamente vera. Da regolamento del gioco, esiste infatti la possibilità che la

sestina non venga completata (e dunque premiata). Ciò avviene quando i 5 numeri estratti sulla sesta ruota (Roma) sono

identici a quelli già attribuiti alle ruote precedenti. La probabilità che ciò avvenga è ovviamente pari alla probabilità di

fare cinquina su una data ruota del gioco del lotto (N.B.: giocando 5 numeri) e dunque, ripetendo il ragionamento fatto

1

. Introducendo questa correzione (che tiene dunque conto della probabilità di completare la sestina), la

sopra, vale

90

5

( )

⎡

⎤

⎢

1 ⎥

⎢1 −

⎥ . La correzione non modifica in maniera

90 ⎥

⎢

5 ⎦⎥

⎣⎢

apprezzabile la PE ma, riducendo la probabilità di vincita, mette ulteriormente in evidenza la non equità del gioco in cui

il premio dipende dall’ammontare delle giocate, attuali e precedenti, fatte dagli scommettitori, e non tiene conto

dell’esiguità del valore di PE (come sarebbe invece necessario in un gioco equo).

1

(4) dovrebbe essere sostituita dall’espressione seguente: PE =

90

6

( ) ( )

2

Si realizza un 5 quando uno e uno solo dei numeri estratti assume uno degli 84 valori che non fanno

parte della giocata. D’altro canto, questo numero, che non è stato individuato, può essere uno

qualunque dei 6 estratti. In totale, quindi, si hanno 84×6 casi favorevoli a questo evento, sul totale

dei casi possibili. In definitiva, la probabilità di realizzare un 5 sarà allora:

84 × 6

⎛ 90 ⎞

⎜ ⎟

⎝6⎠

Una volta realizzato il 5, si realizza il 5 + 1 se il numero non uscito coincide con il numero jolly.

Sempre in virtù del regolamento del gioco, il numero jolly può assumere, per ogni estrazione, 84

valori (questo perché non può coincidere con alcuni dei numeri estratti) e dunque la probabilità di

indovinarlo (o, meglio, di averlo indovinato ove si consideri la specifica estrazione), sarà 1/84. Gli

eventi elementari sono ovviamente indipendenti e dunque le relative probabilità (di aver realizzato

un 5 e di indovinare il numero jolly) si moltiplicano.

In definitiva, la probabilità di realizzare un 5 + 1 sarà allora:

84 × 6 1

6

× =

⎛ 90 ⎞ 84 ⎛ 90 ⎞

⎜ ⎟

⎜ ⎟

⎝6⎠

⎝6⎠

sei volte maggiore della probabilità di realizzare un 6.

Totocalcio

In questo caso si hanno 14 risultati, ciascuno suscettibile di assumere 3 valori (1, X, 2). Il numero

dei casi possibili diventa allora

NT = 314 = 4782969

Come si vede, questo numero è circa 130 volte minore del valore di NE calcolato più sopra per il

Super Enalotto. Corrispondentemente, la probabilità di vittoria giocando una singola colonna vale:

PT =

1

≈ 2.09 ⋅10−7

4782969

(5)

ed è quindi più di due ordini di grandezza maggiore della (3). Vincere al Super Enalotto è dunque

assai più complicato che vincere al Totocalcio. In realtà poi, lo squilibrio tra le due situazioni si

accentua se si considera che mentre le sequenze del Super Enalotto sono effettivamente

equiprobabili (almeno dal punto di vista di chi gioca) nel caso del Totocalcio molte delle sequenze

teoricamente possibili vengono in realtà scartate dalla logica e dalle modalità con le quali si

“costruisce” il risultato: ad esempio, non si ha memoria storica, e non v’è motivo per ritenere che

potrà aversi in futuro, di una colonna Totocalcio costituita da tutti segni 2. Resta il fatto che anche

nel caso del Totocalcio il montepremi dipende dall’ammontare delle giocate. Trattandosi di un

gioco che è stato estremamente popolare in passato ma che attualmente è considerato “fuori moda”,

le vincite sono modeste: la più elevata è stata realizzata a Meda (MI) il 13 marzo 2005, ed ha

portato nelle tasche del vincitore 1963484 euro.

2

Anche qui, e in quanto seguirà, trascuriamo per semplicità la probabilità di non completare la sestina.

3

4

Esercizio N. 2

Si consideri l’esperimento che consiste nel lancio simultaneo di due dadi (non truccati). Si definisca

la variabile aleatoria discreta X come la somma dei numeri risultanti dal lancio. Si descrivano le

principali caratteristiche statistiche della variabile X.

Il primo passo consiste nella individuazione del numero e del valore dei possibili risultati

dell’esperimento aleatorio considerato. Visto che ogni dado può produrre 6 uscite diverse, i casi

possibili sono 6×6 = 36 e la variabile X assume valori compresi tra 2 (ambedue i dadi danno valore

1) e 12 (ambedue i dadi danno valore 6). Se, come si è ipotizzato, i dadi non sono truccati ogni

combinazione ha la stessa probabilità di verificarsi. D’altro canto, alcune combinazioni producono

lo stesso risultato; ad esempio, X = 3 si ottiene sia nel caso che il primo dado dia 1 e il secondo 2,

sia nel caso, simmetrico del precedente, che il primo dado dia 2 e il secondo 1. X = 4 può essere il

risultato di un lancio in cui ambedue i dadi assumono il valore 2, o di un lancio in cui il primo dado

fornisce 1 e il secondo 3, oppure ancora di un lancio in cui il primo dado fornisce 3 e il secondo 1.

Questi eventi si escludono vicendevolmente e quindi le loro probabilità possono essere sommate.

Estendendo il ragionamento iniziato più sopra ed indicando con P(i) la probabilità che X = i, si

trova:

1

36

2

P(3) = P(11) =

36

3

P(4) = P(10) =

36

4

P(5) = P(9) =

36

5

P(6) = P(8) =

36

6 1

=

P(7) =

36 6

P(2) = P(12) =

(6)

Si verifica immediatamente che

12

∑ P(i) = 1

(7)

i =2

così come è necessario per la condizione di normalizzazione.

A partire dalle (6), è possibile graficare l’andamento della funzione densità di probabilità fX(x) per

la variabile X. Trattandosi di una variabile discreta, fX(x) è costituita da una sequenza di impulsi

matematici allocati in corrispondenza dei valori possibili per X e di area pari alla corrispondente

probabilità. Il risultato è riportato in Figura 1, dove le delta di Dirac sono state rappresentate con

altezza diversa, proprio a tener conto “visivamente” della diversa area.

La funzione di ripartizione, o distribuzione di probabilità cumulativa, FX(x) rappresenta la

probabilità che X ≤ x. Nel caso, in esame, di variabile discreta si tratta di una funzione a gradini, in

quanto la probabilità si incrementa ogni volta che si incontra un valore possibile. L’andamento

grafico per il caso in esame è riportato in Figura 2.

5

fX(x)

2

3

4

5

6

7

8

9

10

11

12

x

Figura 1

FX(x)

1

0

2

3

4

5

6

7

8

9

10

11

12

x

Figura 2

A questo punto possiamo calcolare il valore medio della variabile X. Ricordando la definizione, si

ottiene direttamente:

12

m X = ∑ i ⋅ P(i ) = 7

(8)

i =2

Questo risultato poteva essere previsto anche semplicemente guardando all’andamento di fX(x), che

è appunto centrata su tale valore.

Infine, possiamo calcolare la varianza che, sempre ricordando la definizione generale, risulta:

12

σ X2 = ∑ ( i − m X ) ⋅ P(i ) = 5.833

2

(9)

i =2

La radice quadrata della (9) fornisce la deviazione standard (o scarto quadratico medio) σX, il cui

valore risulta allora pari a 2.415.

6

Esercizio N. 3

Un esempio significativo di applicazione della teoria delle variabili aleatorie di tipo discreto si

rinviene nel cosiddetto canale binario, di importanza fondamentale nell’ambito delle trasmissioni

numeriche.

Si consideri dunque il caso di una sorgente numerica binaria, che emette i simboli 0 e 1 con

probabilità P0 e P1 rispettivamente. Transitando lungo il canale di trasmissione, ove sono presenti

rumore e altre cause di disturbo, il simbolo trasmesso può essere distorto e, conseguentemente

equivocato in ricezione. Indichiamo con pij (i = 0, 1; j = 0, 1) la probabilità che, trasmesso il

simbolo “i”, in ricezione venga rivelato il simbolo “j”. In un canale ideale sarebbe, evidentemente,

p00 = p11 = 1 e p01 = p10 = 0. Nel canale reale, invece, le probabilità di transizione da un simbolo

all’altro sono in generale diverse da zero, e la situazione è illustrata in Figura 3.

p

‘

P0

00

P0

p 10

p

‘

P1

01

p

P1

11

Figura 3

I simboli 0 e 1 in ricezione sono caratterizzati da probabilità P0’ e P1’, ottenibili come:

P0 ' = P0 p00 + P1 p10

(10)

P1 ' = P0 p01 + P1 p11

In particolare compare, e la sua valutazione è estremamente importante in pratica, una probabilità di

errore

PE = P0 p01 + P1 p10

(11)

che appunto si verifica quando, avendo trasmesso un simbolo, si riceve il simbolo complementare.

Per un canale del tipo illustrato in Figura 3, si assuma: P0 = 0.8, P1 = 0.2, p00 = 0.9, p01 = 0.1, p11 =

0.3, e si determini la probabilità di errore.

Innanzitutto osserviamo che tra i dati assegnati manca il valore di p10, che invece è necessario per la

determinazione della PE. D’altro canto, questo valore può essere immediatamente determinato

utilizzando la condizione di normalizzazione: trasmesso il simbolo 1, in accordo con la Figura 3 non

vi sono alternative al fatto che in ricezione esso venga rivelato come tale o che venga sostituito dal

simbolo 0. Allora deve essere

p10 + p11 = 1

(12)

esattamente come P0 + P1 = 1, e quindi:

7

p10 = 1 − p11 = 0.7

(13)

Tenendo dunque conto dei valori di probabilità che caratterizzano il canale e sostituendo nella (11)

si ottiene:

PE = 0.22

(14)

Nell’esempio numerico, le probabilità a priori dei simboli 0 e 1 sono state assunte diverse tra loro,

come pure diverse erano le probabilità di transizione. Nondimeno, un caso particolare, frequente in

pratica, è costituito dal canale binario simmetrico (BSC = Binary Symmetric Channel). Per esso si

ha:

P0 = P1 = P0 ' = P1 ' =

1

2

p01 = p10 = p

(15)

p00 = p11 = 1 − p

Per questo canale si verifica immediatamente che risulta

PE = p

(16)

8

Esercizio N. 4

Una variabile aleatoria X è descritta da una densità di probabilità gaussiana con valor medio mX = 2

e varianza σX2 = 4. Si determinino:

Pr{X ≤ 6};

1)

Pr{X > 3};

2)

Pr{X ≤ –2};

3)

Pr{2 < X ≤ 3}.

4)

La densità di probabilità della variabile in oggetto è fornita dalla seguente espressione:

f X ( x) =

⎡ ( x − mX )2 ⎤

⎡ ( x − 2) 2 ⎤

1

1

exp ⎢ −

exp

=

⎥

⎢−

⎥

8 ⎥⎦

2πσ X

2σ X2 ⎥⎦ 2 2π

⎢⎣

⎢⎣

(17)

ed il suo andamento grafico è riportato in Figura 4.

0.2

0.15

fX(x)

0.1

0.05

0

-6

-4

-2

0

2

x

4

6

8

Figura 4

A partire dalla densità di probabilità, il calcolo della probabilità che la variabile sia contenuta entro

un dato intervallo (che può essere anche illimitato, superiormente o inferiormente) si riduce,

ovviamente, al calcolo di un integrale. In particolare:

b

b

a

a

Pr {a < X ≤ b} = ∫ f X ( x)dx = ∫

⎡ ( x − mX )2 ⎤

1

exp ⎢ −

⎥ dx

2πσ X

2σ X2 ⎦⎥

⎢⎣

(18)

Si noterà che, a rigore, l’integrale (18) fornisce la Pr{a ≤ X ≤ b}; d’altro canto, essendo X una

variabile aleatoria continua, si ha anche Pr{X = a} = 0 e dunque il fatto di includere nel calcolo

l’estremo inferiore di integrazione è del tutto irrilevante. Analoga osservazione varrà per gli

sviluppi successivi, e non sarà dunque ripetuta.

Ai fini del calcolo, è sempre conveniente introdurre il seguente cambiamento di variabile:

9

x − mX

= y ⇒ dx = 2σ X dy

2σ X

(19)

Con le posizioni (19), la (18) diventa:

b−mX

2σ X

Pr {a < X ≤ b} =

∫

a −mX

2σ X

( )

1

exp − y 2 dy

π

(20)

Si ricordi ora la definizione della funzione errore:

t

erf (t ) =

( )

2

exp − y 2 dy

∫

π0

(21)

che, sostituita nella (20), consente dunque di ricavare

P {a < X ≤ b} =

1 ⎡ ⎛ b − mX

⎢erf ⎜

2 ⎢⎣ ⎜⎝ 2σ X

⎞

⎛ a − mX

⎟⎟ − erf ⎜⎜

⎠

⎝ 2σ X

⎞⎤

⎟⎟ ⎥

⎠ ⎥⎦

(22)

Dalla definizione stessa di funzione errore, osserviamo che risulta:

erf (∞) = 1

erf (−t ) = −erf (t )

(23)

Particolarizzata all’esercizio in esame, la (22) fornisce:

Pr {a < X ≤ b} =

1 ⎡ ⎛b−2⎞

⎛ a − 2 ⎞⎤

− erf ⎜

⎢ erf ⎜

⎟

⎟⎥

2⎣ ⎝2 2 ⎠

⎝ 2 2 ⎠⎦

(24)

A questo punto, le probabilità incognite si determinano valutando numericamente la funzione

errore. In realtà, sono disponibili delle tabelle da cui è possibile leggere, con buona

approssimazione, il valore cercato. Tipicamente, in luogo della funzione errore, queste tabelle

forniscono la funzione errore complementare

erfc(t ) = 1 − erf (t )

(25)

Tabelle per la funzione erfc(⋅) sono state fornite in una dispensa a parte e verranno utilizzate di

seguito per risolvere la parte numerica dell’esercizio.

Scritta in termini di funzione errore complementare la (24) diventa:

Pr {a < X ≤ b} =

1⎡

⎛a−2⎞

⎛ b − 2 ⎞⎤

− erfc ⎜

⎢erfc ⎜

⎟

⎟⎥

2⎣

⎝2 2⎠

⎝ 2 2 ⎠⎦

Procediamo ora al calcolo per i diversi casi proposti:

10

(26)

1) qui si tratta di assumere:

a = –∞

b=6

Dunque

1

⎡erfc ( −∞ ) − erfc (1.41) ⎤⎦

2⎣

(27)

erfc(−∞) = 1 − erf (−∞) = 1 + erf (∞) = 2

(28)

Pr { X ≤ 6} =

Ora

mentre dalle tabelle leggiamo che

erfc(1.41) = 0.0461

(29)

Sostituendo:

Pr { X ≤ 6} = 0.97695

(30)

2) qui si deve porre:

a=3

b=∞

Dunque

Pr { X > 3} =

1

⎡erfc ( 0.35 ) − erfc ( ∞ ) ⎤⎦

2⎣

(31)

Ora

erfc(∞) = 1 − erf (∞) = 0

(32)

mentre dalle tabelle leggiamo che

erfc(0.35) = 0.621

(33)

Sostituendo:

Pr { X > 3} = 0.3105

(34)

3) qui si deve porre:

a = –∞

b = –2

Dunque

Pr { X ≤ −2} =

1

⎡ erfc ( −∞ ) − erfc ( −1.41) ⎤⎦

2⎣

(35)

11

Ora

erfc(−1.41) = 1 − erf (−1.41) = 1 + erf (1.41) = 1 + 1 − erfc(1.41) = 1.9539

ove si è utilizzata la (27).

Sostituendo:

(36)

(37)

Pr { X ≤ −2} = 0.02305

(38)

4) qui si deve porre:

a=2

b=3

Dunque

Pr {2 < X ≤ 3} =

1

⎡erfc ( 0 ) − erfc ( 0.35 ) ⎤⎦

2⎣

(39)

Considerando che

erfc(0) = 1

(40)

e utilizzando la (31) si ricava:

Pr {2 < X ≤ 3} = 0.1895

(41)

12

Esercizio N. 5

Si determinino valor medio e varianza delle variabili aleatorie seguenti tutte di notevole interesse

pratico:

1) gaussiana;

2) uniforme;

3) di Laplace;

4) esponenziale unilatera;

5) di Rayleigh;

6) binomiale;

7) di Poisson.

Le densità di probabilità e le distribuzioni di probabilità cumulativa relative a queste variabili sono

già state introdotte in una dispensa precedente. Per comodità, le densità di probabilità vengono

comunque ripetute di seguito.

1) Gaussiana:

⎡ ( x − μ )2 ⎤

1

exp ⎢ −

⎥

2πσ

2σ 2 ⎥⎦

⎢⎣

f X ( x) =

(42)

2) Uniforme:

⎧ 1

⎪

f X ( x) = ⎨ b − a

⎪0

⎩

a≤ x≤b

(43)

x < a, x > b

3) Di Laplace (o esponenziale bilatera):

f X ( x) =

a

exp ( −a x ) a > 0

2

(44)

4) Esponenziale unilatera:

⎧⎪a ⋅ exp(−ax)

f X ( x) = ⎨

⎪⎩0

x≥0

(45)

x<0

5) Di Rayleigh:

⎧ x

⎛ x2 ⎞

⎪⎪ 2 exp ⎜⎜ − 2 ⎟⎟

f X ( x) = ⎨σ

⎝ 2σ ⎠

⎪

⎪⎩0

x≥0

(46)

x<0

6) Binomiale:

f X ( x) =

⎛n⎞ k

∑ ⎜⎜ ⎟⎟ p (1 − p)n−k δ ( x − k )

k =0 ⎝ k ⎠

n

(47)

13

7) Di Poisson:

f X ( x) =

n

λk

k =0

k!

∑

exp(−λ )δ ( x − k )

(48)

Ciò premesso, il calcolo del valore medio mX e della varianza σX2 per le varie distribuzioni può

essere effettuato applicando direttamente le formule, e vale a dire:

+∞

mX =

∫

x ⋅ f X ( x)dx

(49)

−∞

σ X2

+∞

=

∫ ( x − mX )

2

f X ( x ) dx

(50)

−∞

Per quanto concerne la varianza, in particolare, può essere utile la nota relazione:

σ X2 = X 2 − m 2X

(51)

in cui

+∞

X2 =

∫

x 2 f X ( x)dx

(52)

−∞

è il valore quadratico medio (momento di ordine 2).

Ai fini del calcolo dei momenti, peraltro, e dunque di mX come pure di

X 2 , una procedura

alternativa consiste nell’utilizzo della funzione caratteristica CX(u) per il tramite della relazione:

M j = (−i ) j

d j C (u )

du j u =0

j = 1, 2, ….

(53)

dove Mj è il momento di ordine j.

I risultati sono riassunti in Tabella 1.

La convenienza (o meno) nell’uso della (53) in luogo del calcolo diretto è normalmente

conseguenza della struttura (più o meno complessa) della funzione densità di probabilità, e quindi

dell’integrale che il calcolo diretto chiede di risolvere. In effetti, le funzioni densità di probabilità

proposte dall’esercizio sono piuttosto semplici.

Così, ad esempio, il calcolo del valore medio per la variabile uniforme è immediato, avendosi:

b

m X = ∫ x ⋅ f X ( x)dx =

a

b

1

1 b2 − a 2 a + b

xdx

=

⋅

=

b − a ∫a

b−a

2

2

(54)

come riportato in tabella. Il calcolo basato sulla funzione caratteristica, se non più complicato è

certamente più lungo; ricordando che la funzione caratteristica nel caso di variabile uniforme vale:

14

C X (u ) =

1 exp(iub) − exp(iua )

b−a

iu

(55)

si ha infatti:

mX = (−i )

d ⎡ 1 exp(iub) − exp(iua) ⎤

1 d ⎡ exp(iub) − exp(iua) ⎤

=

=

⎢

⎥

⎢

⎥

du ⎣ b − a

iu

u

⎦ u =0 a − b du ⎣

⎦ u =0

1 ⎡ iub exp(iub) − iua exp(iua) − exp(iub) + exp(iua ) ⎤

=

⎥

a − b ⎢⎣

u2

⎦ u =0

(56)

Sostituendo u = 0, è chiaro che si tratta di una forma indeterminata, del tipo 0/0, risolubile

applicando la regola di L’Hopital. Derivando dunque numeratore e denominatore, la precedente

diventa:

mX =

1 ⎡ ib exp(iub) − b 2u exp(iub) − ia exp(iua) + a 2u exp(iua) − ib exp(iub) + ia exp(iua) ⎤

=

⎢

⎥

a −b ⎣

2u

⎦ u =0

1 ⎡ −b 2 exp(iub) + a 2 exp(iua) ⎤

1 a2 − b2 a + b

=

=

⋅

=

⎢

⎥

a−b ⎣

2

2

2

⎦ u =0 a − b

(57)

Risultato questo coincidente, come atteso, con la (54), ma ottenuto dopo molti più passaggi.

gaussiana

uniforme

di Laplace

esponenziale unilatera

di Rayleigh

binomiale

di Poisson

mX

σX2

μ

σ2

(a + b)/2

0

1/a

(b – a)2/12

2/a2

1/a2

(2 − π/2)σ2

np(1 – p)

σ π/2

np

λ

λ

Tabella 1

D’altro canto se si considera, ad esempio, la variabile binomiale, per il calcolo diretto del valore

medio è necessario un “artificio”. Il calcolo da sviluppare, infatti, è il seguente:

+∞

mX =

∫

−∞

+∞

x ⋅ f X ( x)dx =

∫

n

()

x ∑ n p k (1 − p) n−k δ ( x − k )dx =

k

−∞ k =0

∑ k ( kn ) p k (1 − p)n−k

n

(58)

k =0

avendo applicato, come al solito, la proprietà di campionamento della delta di Dirac. Si procede

come segue:

15

mX =

()

n

n

n!

n(n − 1)!

n p k (1 − p) n−k = k

k

n−k

(1

−

)

=

k

p

p

∑ k

∑ k !(n − k )!

∑ ( k − 1)!(n − k )! p k (1 − p)n−k =

n

k =0

k =1

k =1

( )

( )

n −1

(n − 1)!

p k −1 (1 − p)n −k = np ∑ n − 1 p k −1 (1 − p)n −k = np ∑ n − 1 p h (1 − p)( n−1)−h

k −1

h

k =1 ( k − 1) !( n − k )!

k =1

h =0

n

n

= np ∑

(59)

avendo effettuato, nell’ultimo passaggio, il cambio di variabile nella sommatoria: h = k – 1. In

precedenza, l’estremo inferiore della sommatoria era stato posto a 1 in considerazione del fatto che

il contributo alla somma per k = 0 è nullo.

A questo punto basta osservare che deve essere:

∑ ( n h− 1) p h (1 − p)(n−1)−h = 1 ,

n −1

(60)

h =0

in virtù della condizione di normalizzazione per un esperimento di Bernoulli su n – 1 prove.

Equivalentemente, si può anche ricordare l’espressione del coefficiente binomiale:

( a + b) m =

∑ ( mk )a k bm−k

m

(61)

k =0

che va qui applicato assumendo m = n – 1, a = p e b = 1 – p, ovviamente fornendo lo stesso

risultato. In definitiva si ha dunque, per la variabile binomiale:

m X = np

(62)

così come riportato in Tabella I.

Il calcolo basato sulla funzione caratteristica è molto più diretto. Quest’ultima, nel caso di variabile

binomiale, vale:

[1 − p + p exp(iu )]

n

(63)

e quindi, applicando la (53), si ottiene:

d [1 − p + p exp(iu ) ]

dC (u )

m X = ( −i )

= (−i )

du u =0

du

n

= (−i ) n [1 − p + p exp(iu ) ]

n −1

ip exp(iu )

u =0

=

u =0

= np

ovviamente coincidente con quanto ricavato in precedenza.

16

(64)

Esercizio N. 6

Una variabile aleatoria gaussiana X a valor medio nullo e varianza unitaria viene applicata ad un

circuito raddrizzatore a doppia semionda la cui caratteristica ingresso-uscita vale y = |x|/2.

Determinare la densità di probabilità della variabile aleatoria in uscita Y.

Ripetere il calcolo assumendo un raddrizzatore a semplice semionda in luogo di quello a doppia

semionda.

Si tratta di un tipico problema di trasformazione di variabile aleatoria.

La variabile aleatoria in ingresso X è caratterizzata da una densità di probabilità

f X ( x) =

⎛ x2 ⎞

1

exp ⎜ − ⎟

⎜ 2 ⎟

2π

⎝

⎠

(65)

Nel caso di raddrizzatore a doppia semionda la caratteristica ingresso-uscita è illustrata in Figura 5.

y

0

x

Figura 5

Le formule di trasformazione di variabile aleatoria, che sono note dalla teoria, devono essere

applicate “a tratti”, nelle zone in cui il legame funzionale tra x e y è monotono. Dalla Figura

osserviamo dunque che è necessario distinguere il caso x ≤ 0 e il caso x ≥ 0.

Per x ≤ 0 si ha:

y=−

x

dx

⇒ x = −2 y ⇒

= −2

dy

2

(66)

e quindi 3 :

fY ( y ) =

⎛ 4 y2 ⎞

dx

1

2

exp ⎜ −

exp −2 y 2

⋅ f X ( x) x =−2 y = 2

⎟⎟ =

⎜

dy

2

π

2π

⎝

⎠

(

)

(67)

Per x ≥ 0 si ha invece:

y=

x

dx

⇒ x = 2y ⇒

=2

dy

2

(68)

ma, come in precedenza,

3

In altra dispensa, anziché il prodotto per |dx/dy| si considerava la divisione per |dy/dx|; come accennato nella parte

relativa alle funzioni di n variabili aleatorie, le due procedure sono perfettamente equivalenti (fornendo infatti, come è

facile verificare, lo stesso risultato).

17

fY ( y ) =

⎛ 4 y2 ⎞

dx

1

2

exp ⎜ −

exp −2 y 2

⋅ f X ( x) x=2 y = 2

⎟⎟ =

⎜

dy

π

2π

⎝ 2 ⎠

(

)

(69)

identica alla (67).

Inoltre, visto che tanto i valori di x ≤ 0 quanto i valori di x ≥ 0 producono y ≥ 0, le (67) e (69)

devono essere sommate per ricavare la densità di probabilità risultante della variabile Y. In

definitiva si ha dunque:

⎧ 2

2

⎪

fY ( y ) = ⎨2 π exp −2 y

⎪⎩0

(

)

y≥0

(70)

y<0

La seconda riga della (70) è giustificata dal fatto che non si hanno valori di x che producono y < 0.

Nel caso di raddrizzatore a semplice semionda la caratteristica ingresso-uscita è illustrata in Figura

6.

y

0

x

Figura 6

Nulla cambia, rispetto al caso precedente, per i valori di x ≥ 0 (per i quali dunque continua a valere

la (69)) mentre tutti i valori di x < 0 vengono trasformati in y = 0. Ciò significa che ad y = 0 viene

ad essere associata una probabilità diversa da zero, e in particolare:

Pr {Y = 0} = Pr { X < 0} =

0

∫

0

f X ( x)dx =

−∞

∫

−∞

⎛ x2 ⎞

1

1

exp ⎜ − ⎟ dx =

⎜

⎟

2

2π

⎝ 2 ⎠

(71)

La variabile aleatoria Y in uscita dal raddrizzatore a semplice semionda è quindi una variabile

aleatoria mista, e la sua densità di probabilità si scrive

fY ( y ) =

(

)

2

1

exp −2 y 2 u ( y ) + δ ( y )

2

π

(72)

dove

⎧⎪1

u( y) = ⎨

⎪⎩0

y≥0

(73)

y<0

è la funzione gradino unitario.

18

Esercizio N. 7

Due variabili aleatorie X e Y, tra loro statisticamente indipendenti, sono descritte da due densità di

probabilità uniformi, fX(x) e fY(y), la prima tra 0 e a, la seconda tra –b e 0.

Posto Z = X + Y, si ipotizzi inizialmente che sia a = b, e si calcolino:

1)

la densità di probabilità di Z;

2)

il valore medio e la varianza di Z.

Si ripeta quindi il calcolo assumendo b > a.

Le densità di probabilità di X e Y sono mostrate in Figura 7.

f (x)

fY(y)

X

1/a

1/b

0

a

-b

x

0

y

Figura 7

Nel caso di variabili aleatorie statisticamente indipendenti, è noto che la densità di probabilità della

somma si ottiene come integrale di convoluzione delle densità di probabilità degli addendi; si ha

cioè:

+∞

fZ ( z) =

∫

f X ( z − y ) fY ( y )dy

(74)

−∞

Si tratta quindi di particolarizzare questo risultato all’esercizio in esame.

Nel caso a = b, le densità di probabilità di X e Y si riducono a due funzioni rettangolari di uguale

estensione, seppur diversamente allocate. Il risultato della convoluzione di due funzioni di questo

tipo è ben noto dalla teoria dei segnali, producendo infatti una funzione triangolare. Questa funzione

sarà allocata tra –a e +a, corrispondenti, rispettivamente, a valore minimo e valore massimo di Z, ed

avrà l’andamento illustrato in Figura 8.

Il valore medio e la varianza di Z possono essere determinati a partire dalla fZ(z); nondimeno, risulta

più agevole e significativo il calcolo diretto a partire dalla conoscenza degli indicatori statistici di X

e Y. Si ha infatti:

mZ = Z = X + Y = X + Y = m X + mY

σ Z2 =

( Z − mZ )2

= Z 2 − 2mZ Z + mZ2 = Z 2 − 2mZ Z + mZ2 = ( X + Y ) 2 − mZ2 =

(75)

= X 2 + Y 2 + 2 XY − mZ2

D’altro canto, essendo X e Y statisticamente indipendenti, si ha XY = X Y = m X mY , mentre

mZ2 = (m X + mY ) 2 = m X2 + mY2 + 2m X mY . Sostituendo nella seconda delle (75) otteniamo:

19

σ Z2 = X 2 + Y 2 + 2m X mY − m 2X − mY2 − 2m X mY = σ X2 + σ Y2

(76)

avendo anche utilizzato il risultato (51).

fZ(z)

1/a

-a

0

a

z

Figura 8

In definitiva: il valor medio della somma è uguale alla somma dei valori medi e la varianza della

somma è uguale alla somma delle varianze. Dalla Tabella 1 (dove a e b rappresentano gli estremi

dell’intervallo di definizione della singola densità di probabilità uniforme) ricaviamo

immediatamente (per il caso più generale):

mX =

a

b

, mY = −

2

2

(77)

σ X2 =

2

2

a

b

, σ Y2 =

12

12

per cui, sostituendo:

mZ =

a −b

2

(78)

σ Z2 =

a 2 + b2

12

Nel caso particolare di a = b le (78) forniscono:

mZ = 0

(79)

σ Z2 =

a2

6

Per b > a il risultato della convoluzione non è più un triangolo, ma diventa invece un trapezio così

come illustrato in Figura 9.

20

fZ(z)

1/b

0

-b

a

(a-b)

z

Figura 9

Il tratto costante, in particolare, corrisponde alla zona in cui, eseguendo la convoluzione, la funzione

fX(z – y) è tutta “contenuta” entro la funzione fY(y).

Per valor medio e varianza di Z valgono in questo caso le espressioni generali (78).

21

IL “PARADOSSO DEL COMPLEANNO”

Un risultato del calcolo probabilistico che sembra sorprendente ogni volta che viene enunciato è il

cosiddetto “paradosso del compleanno” (birthday paradox):

“In un insieme di 23 persone, assemblate senza seguire alcun criterio specifico, la probabilità che

almeno due di esse festeggino il compleanno nello stesso giorno è maggiore di 1/2.”

Come verificheremo immediatamente di seguito, questa affermazione può facilmente essere

dimostrata matematicamente. Nondimeno, essa è apparentemente sorprendente quando si considera

che la probabilità che due persone scelte a caso abbiano date di compleanno coincidenti è molto

bassa (1/365 ≈ 0.0027 → 0.27%). Ciò che però si è portati a trascurare è il fatto che, quando la

probabilità viene calcolata in un insieme di persone, il numero di possibilità favorevoli all’evento

cresce rapidamente e ciò incrementa, come ovvio, la probabilità: in un insieme di 23 persone vi

23! 23 ⋅ 22

=

= 253 possibili combinazioni di date e ciascuna di esse è una possibile

sono 23 =

2

21!2!

2

candidata a verificare l’evento di cui si sta stimando la probabilità. E 253 non è un numero

trascurabile.

( )

Come premesso, comunque, il paradosso del compleanno può essere verificato matematicamente.

Ai fini della verifica ipotizziamo che l’anno consti di 365 giorni (escludiamo cioè l’eventualità che

l’anno sia bisestile) ed assumiamo che tutte le date siano ugualmente probabili 4 . Inoltre, nello stesso

senso, escludiamo ovviamente situazioni contingenti particolari, quale la presenza, nel gruppo di

persone considerato, di gemelli.

Indichiamo con P1(p) la probabilità che in un gruppo di p persone ve ne siano almeno due con la

stessa data di compleanno. Il modo più semplice per calcolare P1(p) consiste, in realtà, nella

valutazione del suo complementare: 1 − P1(p) rappresenta la probabilità che, nello stesso gruppo di

p persone, le date di compleanno siano tutte diverse tra loro.

Prese dunque due persone, la probabilità che, indipendentemente dalla data del compleanno della

prima persona, ci sono 364 casi su 365 in cui la seconda compie gli anni in un giorno diverso;

considerata una terza persona, ancora indipendentemente dalla data ci sono 363 casi su 365 in cui

questa terza persona compie gli anni in un giorno diverso da entrambe le precedenti, e così via. La

probabilità che, nel gruppo di p persone, i compleanni cadano in date tutte diverse è quindi:

1 − P1 ( p ) =

364 363

366 − p

364!

365!

⋅

⋅… ⋅

=

=

1

p

−

365 365

365

(365 − p )!365

(365 − p )!365 p

(80)

Dalla (80) è allora immediato ricavare:

P1 ( p ) = 1 −

365!

(81)

(365 − p )!365 p

e calcolando questa espressione per p = 23 si trova:

P1 (23) = 1 −

365!

(365 − p )!365 p

= 0.507

(82)

4

Nella realtà, quest’ultima ipotesi è forse discutibile, nel senso che le statistiche dimostrano che taluni periodi

dell’anno, in funzione della nazione che si considera, sono caratterizzati da tassi di nascita maggiori. Analizzare

particolari distribuzioni, comunque, non aggiunge nulla alle considerazioni che stiamo svolgendo, mentre

complicherebbe la trattazione.

22

che, appunto, verifica la tesi.

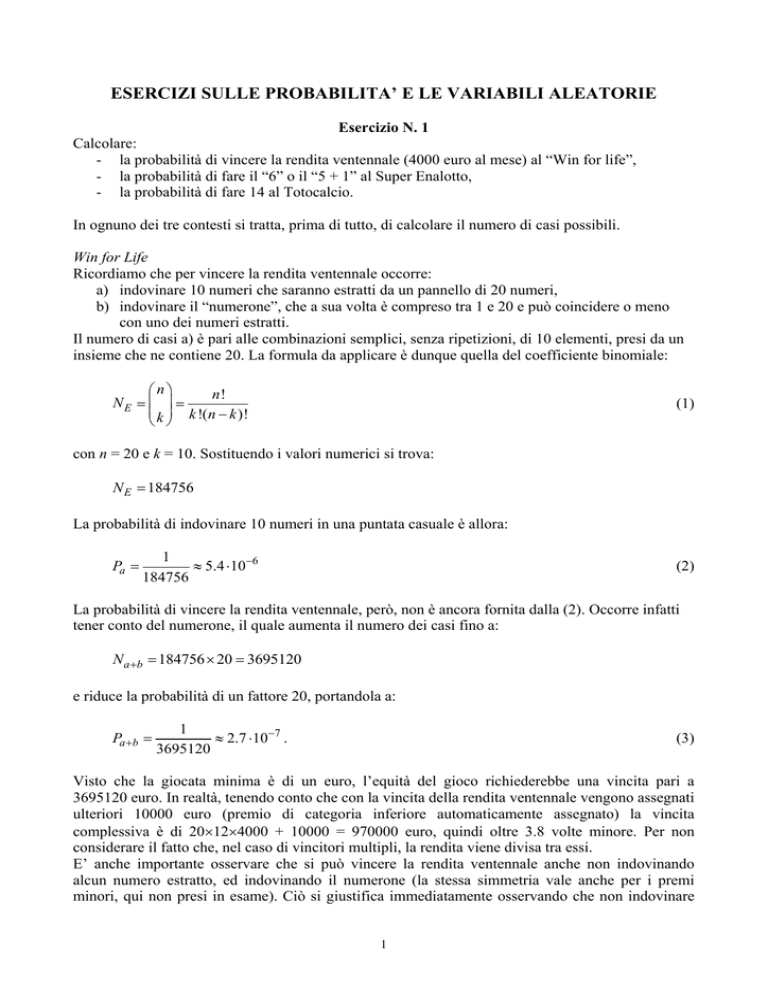

Generalizzando il risultato, la Figura 10 riporta l’andamento di P1(p) al variare di p. Dal grafico si

vede, ad esempio, che la probabilità di avere almeno due compleanni coincidenti in un gruppo di p

= 30 persone è pari circa al 70.63%. Già per p = 57, peraltro, la probabilità è del 99%. Per p = 100,

è quasi certo che si troveranno due persone con compleanni coincidenti. Si deve anche osservare,

benché ovvio, che la (81) va applicata per p ≤ 365. Se p > 365, infatti, è certo che almeno 2 persone

avranno la stessa data di compleanno, e dunque P1(p) = 1. L’aspetto rilevante dell’analisi è che

P1(p) = 1 viene in realtà avvicinato per valori di p significativamente minori del massimo (così

come confermato dalla Fig. 10).

1.0

P1(p)

0.8

0.6

0.4

0.2

0.0

0

10

20

30

40

50

60

70

80

90

100

p

Figura 10

Il paradosso del compleanno può ovviamente essere esteso a contesti diversi e più generali, in

accordo con il seguente enunciato:

“Sia h: D → R una qualunque funzione. Se si scelgono R ≈ 1.17 D elementi a caso, la probabilità

che due di essi diano lo stesso valore della funzione è maggiore di 0.5.”

L’esempio del compleanno è chiaramente un caso particolare di questo enunciato, ove D = 365 è

l’insieme delle date possibili, R = p è l’insieme delle persone le cui date di compleanno vengono

confrontate tra loro, e la funzione h definisce la data di compleanno delle p persone scelte a caso.

Generalizzando la (80), si può ora scrivere:

1⎞ ⎛

2⎞

R −1⎞

⎛ D −1⎞ ⎛ D − 2 ⎞

⎛ D − R +1⎞ ⎛

⎛

1 − P1 ( R, D) = ⎜

⎟⋅⎜

⎟ ⋅… ⋅ ⎜

⎟ = ⎜1 − ⎟ ⋅ ⎜1 − ⎟ ⋅ … ⋅ ⎜1 −

⎟

D

D⎠ ⎝

D⎠

D ⎠

⎝ D ⎠ ⎝ D ⎠

⎝

⎠ ⎝

⎝

(83)

e quindi:

1⎞ ⎛

2⎞

R −1⎞

⎛

⎛

P1 ( R, D) = 1 − ⎜ 1 − ⎟ ⋅ ⎜1 − ⎟ ⋅ … ⋅ ⎜1 −

⎟

D⎠ ⎝

D⎠

D ⎠

⎝

⎝

(84)

Nell’ipotesi di D sufficientemente grande e di R << D la (84) può essere riscritta, utilizzando

l’approssimazione:

23

e− x ≈ 1 − x

(85)

come segue:

P1 ( R, D ) = 1 − e −1/ D ⋅ e −2 / D ⋅ … ⋅ e − ( R −1) / D = 1 − e − (1+ 2 +…+ ( R −1)) / D

(86)

Imponendo P1(R, D) > 0.5 si ha dunque:

e −(1+ 2+…+( R −1)) / D < 0.5 →

R ⋅ ( R − 1)

> ln 2

2D

(87)

e infine:

R > 2 D ln 2 ≈ 1.17 D

(88)

Il passaggio dalla (87) alla (88) ovviamente implica che sia R >> 1.

Il paradosso del compleanno ha significative applicazioni nell’ambito della crittografia e

dell’autenticazione 5 . Esiste anzi una tipologia di attacco da parte degli hacker che, proprio basata

sul paradosso, da esso prende il nome (birthday paradox attack). Da un diverso punto di vista, il

paradosso del compleanno viene ad esempio utilizzato nella criptanalisi per verificare la robustezza

di algoritmi hash per la generazione di firme digitali.

5

Ovviamente queste tematiche saranno oggetto di corsi successivi. Qui vengono solo accennate per ribadire

l’importanza dell’argomento in un contesto attuale e di notevole interesse.

24