Capitolo 3

Valori caratteristici di distribuzioni

3.1

Valori attesi di variabili e vettori aleatori

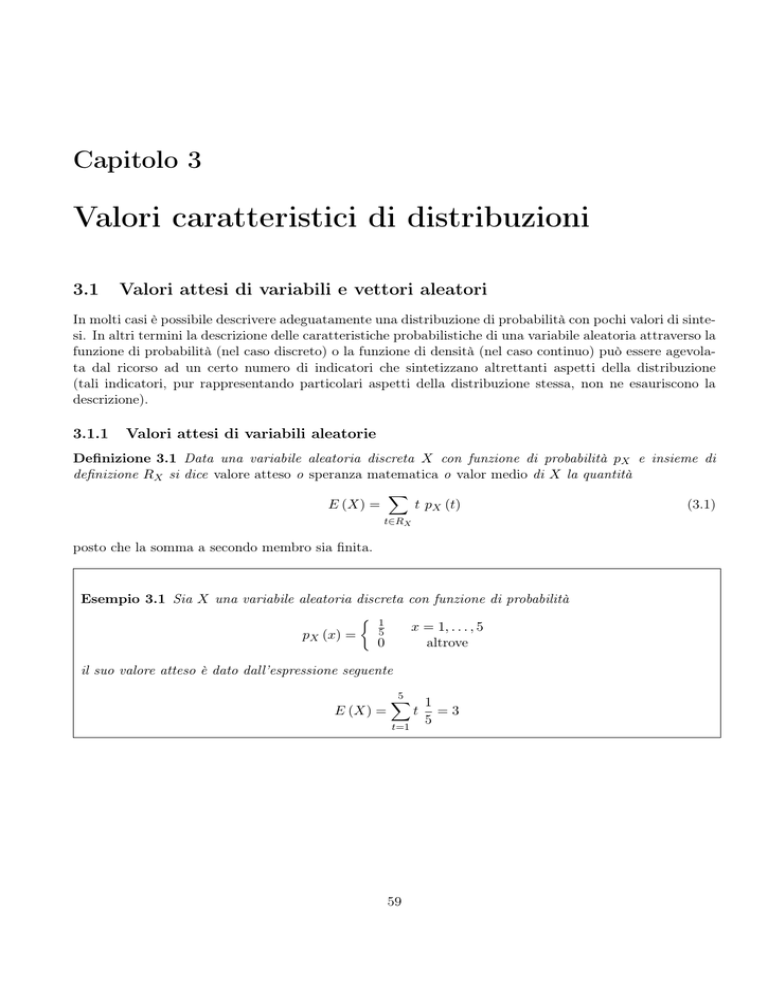

In molti casi è possibile descrivere adeguatamente una distribuzione di probabilità con pochi valori di sintesi. In altri termini la descrizione delle caratteristiche probabilistiche di una variabile aleatoria attraverso la

funzione di probabilità (nel caso discreto) o la funzione di densità (nel caso continuo) può essere agevolata dal ricorso ad un certo numero di indicatori che sintetizzano altrettanti aspetti della distribuzione

(tali indicatori, pur rappresentando particolari aspetti della distribuzione stessa, non ne esauriscono la

descrizione).

3.1.1

Valori attesi di variabili aleatorie

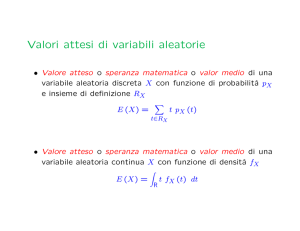

Definizione 3.1 Data una variabile aleatoria discreta X con funzione di probabilità pX e insieme di

definizione RX si dice valore atteso o speranza matematica o valor medio di X la quantità

∑

t pX (t)

(3.1)

E (X) =

t∈RX

posto che la somma a secondo membro sia finita.

Esempio 3.1 Sia X una variabile aleatoria discreta con funzione di probabilità

{ 1

x = 1, . . . , 5

5

pX (x) =

0

altrove

il suo valore atteso è dato dall’espressione seguente

5

∑

1

t =3

E (X) =

5

t=1

59

60

A. Pollice - Appunti di Probabilità

Esempio 3.2 Sia X una variabile aleatoria discreta con funzione di probabilità

pX (−1)

x = −1

pX (0)

x=0

pX (x) =

p (1)

x=1

X

0

altrove

posto che valgano E (X) =

1

6

e pX (0) =

1

2

è possibile determinare pX (−1) e pX (1), infatti

1

∑

1

=

t pX (t)

6

t=−1

= −1 × pX (−1) + 0 ×

1

+ 1 × pX (1)

2

= pX (1) − pX (−1)

inoltre dalla funzione di probabilità si deduce che deve valere pX (1) + pX (−1) = 21 , quindi

pX (1) + pX (−1) =

pX (1) − pX (−1) =

1

2

1

6

⇒

pX (1) =

1

3

pX (−1) =

1

6

Esempio 3.3 Un’urna contiene 10 palline di cui 8 valgono £2000 e 2 valgono £5000. Se ne scelgano a

caso 3 senza reinserimento e si vinca la somma dei valori delle 3 palline estratte. La distribuzione delle

vincite possibili è la seguente:

P (”3 palline da £2000”) = P (£6000) =

(83)

= 0.467

(10

3)

P (”2 palline da £2000 ed 1 da £5000”) = P (£9000) =

(82)(21)

= 0.467

(10

3)

P (”1 pallina da £2000 e 2 da £5000”) = P (£12000) =

(81)(22)

= 0.066

(10

3)

Pertanto il valore atteso della vincità è

£6000 × 0.467 + £9000 × 0.467 + £12000 × 0.066 = £7797

Definizione 3.2 Data una variabile aleatoria continua X con funzione di densità fX si dice valore atteso

o speranza matematica o valor medio di X la quantità

∫

E (X) =

t fX (t) dt

(3.2)

R

posto che l’integrale a secondo membro sia finito.

Cap.3: Valori caratteristici di distribuzioni

61

Esempio 3.4 Se dividiamo casualmente un segmento di lunghezza 5 in due parti ed indichiamo con

X la lunghezza di una delle due parti ottenute (ad esempio quella posta alla nostra sinistra) posiamo

ragionevolmente ritenere che valga

1

0<x<5

5

fX (x) =

0

altrove

In altri termini stiamo supponendo che ciascun punto del segmento abbia la stessa probabilità di essere

selezionato per dividerlo in due, ovvero che la lunghezza X della parte sinistra del segmento abbia distribuzione uniforme su tutto il segmento. In tal caso la lunghezza attesa della parte sinistra del segmento

è data dal risultato seguente (anche giustificabile intuitivamente)

∫

5

E (X) =

5

1

dt = · · · =

5

2

t

0

Esempio 3.5 Sia X una variabile aleatoria continua con funzione di densità continua a tratti

1

0<x<2

8

x

2<x<4

fX (x) =

8

0

altrove

il suo valore atteso è dato da

∫

2

t

E (X) =

0

1

dt +

8

∫

4

t

2

t

31

dt = · · · =

8

12

Allo scopo di unificare la notazione nel caso di variabili aleatorie discrete e continue la definizione di

valore atteso assume talvolta l’espressione seguente

∫

E (X) =

t dFX (t)

(3.3)

R

dove FX indica la funzione di ripartizione (discreta o continua) della variabile aleatoria X. Tale espressione,

che fa riferimento alla teoria dell’integrazione di Lebesgue-Stieltjes, prende la forma rispettivamente della

somma (3.1) o dell’integrale (3.2) nel caso di variabili aleatorie discrete o dotate di densità.

3.1.2

Valori attesi di funzioni di variabili aleatorie

Data una funzione Y = g (X) della variabile aleatoria discreta X il suo valore atteso può essere calcolato

ricavando prima la funzione di probabilità pY della variabile aleatoria Y , quindi applicando la definizione

di valore atteso e la (3.1)

∑

E (Y ) =

t pY (t)

t∈RY

Alternativamente è possibile utilizzare la funzione di probabilità della X senza procedere alla determinazione di quella della Y . La speranza matematica di Y = g (X) è data da

∑

E (Y ) =

g (t) pX (t)

(3.4)

t∈RX

62

A. Pollice - Appunti di Probabilità

Esempio 3.1 (cnt) Siano g1 (X) = X 2 e g2 (X) = (X + 2)2

5

( ) ∑

1

E X2 =

t2 = 11

5

t=1

[

]

E (X + 2)2 =

5

∑

1

= 27

5

(t + 2)2

t=1

Esempio 3.2 (cnt) Posto che non si conosca

( ) il valore di E (X) e che anche in questo caso valga

pX (0) = 12 si può calcolare il valore di E X 2 , infatti

( )

E X2 =

1

∑

t2 pX (t)

t=−1

= (−1)2 pX (−1) + 02 ×

= pX (−1) + pX (1) =

1

+ (1)2 pX (1)

2

1

2

Data una funzione Y = g (X) della variabile aleatoria continua X il suo valore atteso può essere

calcolato ricavando prima la funzione di densità fY della variabile aleatoria Y , quindi applicando la

definizione di valore atteso

∫

E (Y ) =

t fY (t) dt

R

Alternativamente è possibile utilizzare la funzione di densità della X senza procedere alla determinazione

di quella della Y . La speranza matematica di Y = g (X) è data da

∫

E (Y ) =

g (t) fX (t) dt

(3.5)

R

Esempio 3.4 (cnt) La lunghezza attesa della sezione di segmento posta alla nostra destra è data da

∫

5

E (5 − X) =

0

(5 − t)

1

5

dt = · · · =

5

2

analogamente il valore atteso del prodotto delle lunghezze delle due sezioni è dato da

∫ 5

1

25

E [X (5 − X)] =

t (5 − t)

dt = · · · =

5

6

0

Esempio 3.5 (cnt) Tenendo opportunamente conto della funzione di densità continua a tratti della

variabile aleatoria X si ha

∫ 2

∫ 4

( )

1

t

23

E X2 =

t2 dt +

t2 dt = · · · =

8

8

3

0

2

Cap.3: Valori caratteristici di distribuzioni

63

Esempio 3.6 Sia X una variabile aleatoria continua con funzione di densità

0<x<1

2x

fX (x) =

0

altrove

il valore atteso di Y =

√

X è dato da

(√ ) ∫

E (Y ) = E

X =

1√

t 2t dt = · · · =

0

4

5

Si ottiene lo stesso risultato se si individua prima la densità della Y e poi si calcola direttamente il valore

√

atteso. Infatti essendo y = x una trasformazione monotona per 0 < x < 1 si ha

( −1

) dg −1 (y) = 2y 2 |2y| = 4y 3 0 < y < 1

fY (y) = fX g (y) dy quindi

∫

E (Y ) =

1

t 4t3 dt = · · · =

0

4

5

Anche per le funzioni reali di vettori aleatori i valori attesi sono determinabili in modo analogo. Il

valore atteso della funzione reale Y = g (X) di un vettore aleatorio k-dimensionale discreto X con funzione

di probabilità pX1 ···Xk è infatti dato dall’espressione

∑

E (Y ) =

g (t) pX1 ···Xk (t)

(3.6)

t∈RX ⊂Rk

64

A. Pollice - Appunti di Probabilità

Esempio 3.7 Sia (X1 , X2 ) la variabile aleatoria bidimensionale discreta la cui funzione di probabilità è

data da

1

(x1 , x2 ) ∈ {(1, 1) , (2, 2) , (3, 3)}

3

pX1 X2 (x1 , x2 ) =

0

altrove

Si noti che posto Y = X1 si ha

E (X1 ) = 1 ×

1

1

1

+2× +3× =2

3

3

3

e analogamente ponendo Y = X2 si ottiene

E (X2 ) = 1 ×

1

1

1

+2× +3× =2

3

3

3

Il valore atteso di Y = X1 X2 è dato da

E (X1 X2 ) = 1 × 1 ×

1

1

1

14

+2×2× +3×3× =

3

3

3

3

E analogamente

[(

)(

)] (

) (

)

1

2

1

2

1

E X1 −

X2 −

= 1−

× 1−

× +

3

3

3

3

3

) (

)

(

) (

)

(

2

1

1

2

1

26

1

× 2−

× + 3−

× 3−

× =

+ 2−

3

3

3

3

3

3

9

Esempio 2.12 (cnt) Utilizzando la tabella che comprende le distribuzioni marginali (p. 48) è possibile

calcolare E (X1 ) ed E (X2 )

E (X1 ) = 1 ×

2

1

4

+2× =

3

3

3

E (X2 ) = 2 ×

1

2

8

+3× =

3

3

3

Inoltre si ha che per Y = X1 X2

E (X1 X2 ) = 1 × 2 ×

1

1

11

1

+2×2×0+1×3× +2×3× =

3

3

3

3

Analogamente nel caso di un vettore aleatorio k-dimensionale X dotato di densità fX1 ···Xk il valore

atteso di una sua funzione Y = g (X) è dato dall’espressione

∫

E (Y ) =

g (t) fX1 ···Xk (t) dt1 · · · dtk

(3.7)

Rk

Cap.3: Valori caratteristici di distribuzioni

65

Esempio 2.14 (cnt) Si noti che posto Y = X1 si ha

3

E (X1 ) =

8

∫

1∫ 1

0

0

(

)

23

t1 7t21 + t22 dt1 dt2 = · · · =

32

e analogamente ponendo Y = X2 si ottiene

∫ ∫

)

17

3 1 1 ( 2

E (X2 ) =

t2 7t1 + t22 dt1 dt2 = · · · =

8 0 0

32

infine se Y = X1 X2

E (X1 X2 ) =

3

8

∫

1∫ 1

0

0

(

)

3

t1 t2 7t21 + t22 dt1 dt2 = · · · =

8

Esempio 2.15 (cnt) Si noti che posto Y = X1 si ha

∫

1 ∫ t1

t1 t1 t2 dt1 dt2 = · · · =

4

5

t2 t1 t2 dt1 dt2 = · · · =

8

15

E (X1 ) = 8

0

0

e analogamente ponendo Y = X2 si ottiene

∫ 1∫

E (X2 ) = 8

0

infine se Y = X1 X2

t1

0

∫

1 ∫ t1

E (X1 X2 ) = 8

0

3.1.3

t1 t2 t1 t2 dt1 dt2 = · · · =

0

2

3

Proprietà dei valori attesi

I valori attesi di variabili aleatorie godono di alcune proprietà che discendono dalle loro definizioni.

Nell’enunciare queste proprietà si fa riferimento al caso di variabili aleatorie continue unidimensionali.

L’estensione di enunciati e definizioni alle variabili aleatorie discrete e ai vettori aleatori continui e discreti è semplicemente ottenibile sostituendo agli integrali unidimensionali che definiscono i valori attesi

rispettivamente le somme e gli integrali e le somme multidimensionali.

1. Il valore atteso di una costante è uguale alla costante stessa. Se g (X) = c con c costante, si ha

∫

∫

E (c) =

c fX (t) dt = c fX (t) dt = c

(3.8)

R

R

2. Il valore atteso della funzione di una variabile aleatoria moltiplicata per una costante è uguale alla

costante per il valore atteso della funzione della variabile aleatoria. Sia in questo caso g (X) = c h (X)

con c costante ed h funzione di X, si ha

∫

E [c h (X)] =

c h (t) fX (t) dt = c E [h (X)]

(3.9)

R

3. Il valore atteso di una combinazione lineare di due funzioni di una variabile aleatoria è uguale alla

stessa combinazione lineare dei valori attesi delle stesse due funzioni della variabile aleatoria. In

66

A. Pollice - Appunti di Probabilità

questo caso g (X) = c1 h1 (X) + c2 h2 (X) con c1 e c2 costanti ed h1 e h2 funzioni di X, si ha

∫

E [c1 h1 (X) + c2 h2 (X)] =

c1 h1 (t) + c2 h2 (t) fX (t) dt = c1 E [h1 (X)] + c2 E [h2 (X)]

(3.10)

R

4. La proprietà precedente è immediatamente generalizzabile a combinazioni lineari di n > 2 termini

[

E

n

∑

]

ci hi (X) =

i=1

n

∑

ci E [hi (X)]

(3.11)

i=1

5. Il valore atteso del prodotto di due variabili aleatorie è uguale al prodotto dei valori attesi delle

variabili se queste sono indipendenti. Siano X1 ed X2 variabili aleatorie indipendenti rispettivamente

con funzione di densità fX1 ed fX2 , si ha

∫∫

E (X1 X2 ) =

R2

∫∫

t1 t2 fX1 X2 (t1 , t2 ) dt1 dt2

=

t1 t2 fX1 (t1 ) fX2 (t2 ) dt1 dt2

∫

∫

=

t1 fX1 (t1 ) dt1 t2 fX2 (t2 ) dt2 = E (X1 ) E (X2 )

(3.12)

R2

R

R

6. Disuguaglianza di Schwarz-Hölder. Dati due numeri positivi a e b tali che a−1 + b−1 = 1 e due

variabili aleatorie X1 e X2 si ha

[ (

)] 1

b

b

E (|X1 X2 |) ≤ [E (|X1 | )] E |X2 |

a

1

a

(3.13)

L’espressione precedente fornisce come casi particolari la disuguaglianza di Schwarz

( ) ( )

[E (|X1 X2 |)]2 ≤ E X12 E X22

(3.14)

oltre che la seguente disuguaglianza valida per 0 < c < d

(

)1

1

d

(E |X|c ) c ≤ E |X|d

Esempio 3.1 (cnt)

[

]

[

]

E (X + 2)2 = E X 2 + 4X + 4

[ ]

= E X 2 + E [4X] + E [4]

[ ]

= E X 2 + 4E [X] + 4

= 11 + 4 × 3 + 4 = 27

(3.15)

Cap.3: Valori caratteristici di distribuzioni

67

Esempio 3.4 (cnt)

E (5 − X) = 5 − E (X) = 5 −

∫

5

E [X (5 − X)] = 5E (X) −

t2

0

5

5

=

2

2

1

5 1 1

25

dt = 5 × − × × 125 =

5

2 5 3

6

Esempio 3.7 (cnt)

)(

)]

(

)

[(

2

1

2

2

1

X2 −

= E X1 X2 − X2 − X1 +

E X1 −

3

3

3

3

9

1

2

2

= E (X1 X2 ) − E (X2 ) − E (X1 ) +

3

3

9

14 1

2

2

26

− ×2− ×2+ =

3

3

3

9

9

=

Esempi 2.12,14,15 (cnt) In tutti e tre gli esempi poiché E (X1 X2 ) ̸= E (X1 ) E (X2 ) le variabili

aleatorie X1 e X2 non sono indipendenti.

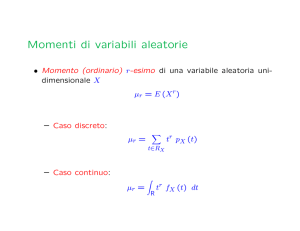

3.2

Momenti di variabili aleatorie

Tra i valori attesi delle funzioni di variabili aleatorie unidimensionali assumono un’importanza particolare

quelli delle potenze con esponente reale non negativo, denominate momenti.

Definizione 3.3 Si dice momento (ordinario) r-esimo di una variabile aleatoria unidimensionale X la

quantità

µr = E (X r )

(3.16)

Naturalmente a seconda che la variabile aleatoria X sia discreta e dotata di funzione di probabilità pX

ovvero continua e dotata di funzione di densità fX il momento r-esimo è rispettivamente dato da

∑

tr pX (t)

(3.17)

µr =

t∈RX

∫

tr fX (t) dt

µr =

(3.18)

R

1. Si osservi che µ1 = E (X) = µ, ossia il momento primo di una variabile aleatoria coincide con il suo

valore atteso.

2. Dalla definizione precedente si deduce immediatamente che il momento secondo gode della proprietà

di essere nullo se e solo se la variabile aleatoria X è uguale a zero con probabilità 1

( )

E X 2 = 0 ⇐⇒ PX (X = 0) = 1

(3.19)

Definizione 3.4 Si dice momento centrale r-esimo di una variabile aleatoria unidimensionale X la quantità

mr = E [(X − E (X))r ]

(3.20)

68

A. Pollice - Appunti di Probabilità

1. I momenti ordinari e i momenti centrali appena definiti corrispondono a valori tipici che caratterizzano le distribuzioni delle variabili aleatorie a cui si riferiscono. La variabile aleatoria X − E (X) è

anche detta scarto dalla media. A causa della proprietà di linearità della media il suo valore atteso

è nullo

m1 = E [X − E (X)] = E (X − µ) = 0

(3.21)

2. Una variabile aleatoria X ha distribuzione simmetrica rispetto al centro di simmetria a se vale

FX (a − x) − PX (X = a − x) = 1 − FX (a + x)

(3.22)

questa condizione nel caso di variabili aleatorie continue dotate di densità diventa

fX (a − x) = fX (a + x)

(3.23)

mentre le variabili aleatorie discrete simmetriche sono tali che i valori che assumono e le loro probabilità si dispongono simmetricamente rispetto ad a. Se una variabile aleatoria X ha distribuzione

simmetrica il suo valore atteso coincide con il centro di simmetria, ovvero µ = a. Inoltre in tal caso

i momenti centrali di ordine dispari sono nulli.

Esempio 2.18 (cnt) Per la densità triangolare vale E (Y1 ) = 0, inoltre poiché per x > 0 si ha che

fY1 (x) = 1 − x = fY1 (−x) allora tale densità è simmetrica e il suo centro di simmetria corrisponde

all’origine degli assi. Di conseguenza i momenti centrali di ordine dispari sono nulli.

[

]

( )

m3 = E (Y1 − E (Y1 ))3 = E Y13

∫

∫

0

3

=

t (1 + t) dt +

−1

1

t3 (1 − t) dt

0

1 1 1 1

= − + + −

4 5 4 5

Definizione 3.5 Il momento centrale secondo è anche

detto varianza

della variabile aleatoria e viene

[

]

2

2

generalmente indicato con m2 = Var (X) = σX = E (X − E (X)) .

La varianza di una variabile aleatoria misura la dispersione della distribuzione di probabilità attorno al

valore medio.

1. Si noti che vale

2

σX

[

]

= E (X − E (X))2

[

]

= E X 2 + (E (X))2 − 2XE (X)

(

= E X

2

)

(3.24)

2

+ (E (X)) − 2E (X) E (X)

= µ2 − µ2

In altri termini la varianza è data dal momento secondo meno il quadrato del momento primo.

Cap.3: Valori caratteristici di distribuzioni

69

2. Si ricava facilmente che vale

[

]

[

]

2

2

Var (aX + b) = E (aX + b − E (aX + b)) = E (aX − aE (X)) = a2 Var (X)

(3.25)

La varianza resta invariata se alla variabile aleatoria si aggiunge una costante b, mentre viene

moltiplicata per a2 se la variabile aleatoria è moltiplicata per a.

3. Si noti che la varianza si annulla se e solo se la variabile aleatoria X assume un unico valore (che

ovviamente coincide con il valor medio µ) con probabilità 1. Dalla proprietà (b) dei momenti ordinari

discende infatti che vale

[

]

E (X − µ)2 = 0 ⇐⇒ PX (X − µ = 0) = 1

(3.26)

4. Per qualsiasi variabile aleatoria vale

[

]

[

]

2

σX

= E (X − µ)2 = min E (X − a)2

a∈R

infatti

(3.27)

[

]

[

]

E (X − a)2 = E (X − µ + µ − a)2

[

]

= E (X − µ)2 + (µ − a)2 + 2 (µ − a) E (X − µ)

2

2

= σX

+ (µ − a)2 ≥ σX

5. Disuguaglianza di Cebicev. Sia X una variabile aleatoria per la quale esistano finiti i momenti primo

e secondo, per qualsiasi a > 0 vale

PX (µ − aσX < X < µ + aσX ) ≥ 1 −

1

a2

(3.28)

Infatti, posto b = aσX la suddetta disuguaglianza implica

PX (|X − µ| < b) ≥ 1 −

2

σX

2

=⇒ σX

≥ b2 PX (|X − µ| ≥ b)

b2

(3.29)

L’ultima disuguaglianza si dimostra nel caso continuo osservando che vale

∫

2

σX =

(t − µ)2 fX (t) dt

∫R

≥

(t − µ)2 fX (t) dt

|X−µ|≥b

∫

2

≥ b

fX (t) dt

|X−µ|≥b

= b PX (|X − µ| ≥ b)

2

Analoghi passaggi portano alla dimostrazione della disuguaglianza nel caso di variabili aleatorie discrete. È importante sottolineare come la disuguaglianza di Cebicev sussiste per qualunque variabile

aleatoria per la quale si conoscano µ e σX senza alcuna assunzione sulla sua distribuzione. Dunque

tale disuguaglianza permette di calcolare il limite inferiore della probabilità di intervalli simmetrici

attorno alla media di una variabile aleatoria di cui si conoscano solo i primi due momenti e non

l’intera distribuzione.

70

A. Pollice - Appunti di Probabilità

Esempio 2.18 (cnt) La varianza della variabile aleatoria continua Y1 con densità triangolare è data

da

[

]

( )

σY21 = E (Y1 − E (Y1 ))2 = E Y12

∫

∫

0

2

=

t (1 + t) dt +

−1

=

1

t2 (1 − t) dt

0

1 1 1 1

1

− + − =

3 4 3 4

6

Definizione 3.6 La radice quadrata della varianza è detta scarto quadratico medio o deviazione standard

√

σX = Var (X)

(3.30)

2 , la trasformazione lineare

1. Si noti che se X è una variabile aleatoria con E (X) = µ e Var (X) = σX

Z=

X −µ

σX

(3.31)

fornisce una variabile aleatoria Z con

E (Z) =

1

E (X − µ) = 0

σX

(3.32)

1

2 Var (X) = 1

σX

(3.33)

Var (Z) =

Tale trasformazione è dunque detta standardizzazione della variabile aleatoria X.

Cap.3: Valori caratteristici di distribuzioni

71

Esempio 3.8 Si calcoli la varianza della somma ottenuta lanciando una coppia di dadi. Siano X1 il

risultato del primo dado ed X2 quello del secondo con rispettivamente pX1 (x1 ) = 61 per x1 = 1, . . . , 6 e

pX2 (x2 ) = 61 per x2 = 1, . . . , 6 e sia Z = X1 + X2

1

z = 2, 12

36

2

z = 3, 11

36

3

z = 4, 10

36

4

z = 5, 9

pZ (z) = PX1 X2 (X1 + X2 = z) =

36

5

z = 6, 8

36

6

z=7

36

0

altrove

E (Z) =

12

∑

tpZ (t) = · · · = 7

t=2

( )

E Z2 =

12

∑

t=2

t2 pZ (t) = · · · =

329

6

( )

35

Var (X1 + X2 ) = Var (Z) = E Z 2 − [E (Z)]2 =

6

Si noti che in generale vale

[

]

m3 = E (Z − E (Z))3

[

]

= E Z 3 − (E (Z))3 + 3Z (E (Z))2 − 3Z 2 E (Z)

( )

( )

= E Z 3 − (E (Z))3 + 3E (Z) (E (Z))2 − 3E Z 2 E (Z)

( )

( )

= E Z 3 + 2 (E (Z))3 − 3E Z 2 E (Z) = µ3 + 2µ3 − 3µ2 µ

( )

Dal calcolo diretto risulta E Z 3 = 931

2 e di conseguenza

m3 =

931

329

+ 2 × 73 − 3 ×

×7=0

2

6

Infatti la funzione di probabilità della variabile aleatoria discreta Z è evidentemente simmetrica attorno

alla media 7.

72

A. Pollice - Appunti di Probabilità

Esempio 3.9 Data la variabile aleatoria continua X con densità

0<x<1

6x (1 − x)

fX (x) =

0

altrove

si voglia determinare la probabilità P (µ − 2σX < X < µ + 2σX ).

∫

1

µ = E (X) =

t 6t (1 − t) dt = · · · =

0

( )

E X2 =

∫

1

t2 6t (1 − t) dt = · · · =

0

2

σX

3

= Var (X) =

−

10

1

2

3

10

( )2

(

)2

1

1

1

√

=

=

2

20

2 5

Quindi

(

PX (µ − 2σX < X < µ + 2σX ) = PX

∫

1

1

1

1

−√ <X< +√

2

2

5

5

0.947

=

)

6t (1 − t) dt = · · · = 0.984

0.053

Per la stessa probabilità, applicando la disuguaglianza di Cebicev, si ha

PX (0.053 < X < 0.947) ≥ 1 −

1

= 0.75

22

Si noti come in questo secondo caso trascurando l’informazione sulla forma della densità della variabile

aleatoria X si perviene a una determinazione molto meno precisa della probabilità dell’intervallo, infatti l’estremo inferiore della probabilità dell’intervallo (0.75) è piuttosto distante dalla probabilità esatta

calcolata precedentemente (0.984).

3.2.1

Mediana di una variabile aleatoria

I momenti descrivono dunque alcuni aspetti delle distribuzioni delle variabili aleatorie. Quando l’integrale

(nel caso continuo) o la somma (nel caso discreto) divergono i momenti non esistono. In questi e in altri

casi in cui il ricorso ai momenti risulta inopportuno vengono utilizzati altri indicatori della posizione e

della forma delle distribuzioni di cui il più importante è la mediana.

Definizione 3.7 Data una variabile aleatoria unidimensionale X si dice mediana della variabile aleatoria

o della sua distribuzione il valore Me (X) tale che

PX (X ≥ Me (X)) ≥

1

2

e

PX (X ≤ Me (X)) ≥

ovvero in termini della funzione di ripartizione

lim FX (Me (X) − h) ≤

h→0+

1

≤ FX (Me (X))

2

1

2

(3.34)

Cap.3: Valori caratteristici di distribuzioni

73

Quando la variabile aleatoria X è continua si ha immediatamente che vale FX (Me (X)) = 12 . Nel caso

discreto la mediana è per definizione quel valore che lascia alla sua sinistra ed alla sua destra una probabilità almeno pari ad 12 .

Esempio 3.10 Le variabili aleatorie X

1

6

1

6

1

6

1

pX (x) =

6

1

6

1

6

0

e Y abbiano funzioni di probabilità rispettivamente

x=1

x=2

x=3

x=4

pY (y) =

x=5

x=6

1

10

y=1

1

10

y=2

1

5

y=3

2

5

1

5

0

y=4

y=5

altrove

altrove

Si nota facilmente che Me (X) non è unica, infatti per 3 ≤ Me (X) ≤ 4 vale la condizione (3.34). Al

contrario Me (Y ) = 4.

Esempio 3.11 Sia X una variabile aleatoria continua con densità esponenziale di parametro 1. La

mediana è ottenuta rsilvendo l’equazione

1

=

2

∫ Me(X)

∫ Me(X)

−∞

fX (t) dt =

e−t dt = 1 − e−Me(X)

0

da cui si ricava Me (X) = log 2.

Per la mediana valgono le due seguenti proprietà:

1. Se Y = g (X) con g funzione non decrescente, allora Me (Y ) = g (Me (X)) .

2. Per qualsiasi variabile aleatoria X vale

E [|X − Me (X)|] = mina∈R E [|X − a|]

3.2.2

(3.35)

Momenti misti

Anche tra i valori attesi delle funzioni di variabili aleatorie bidimensionali assumono un’importanza particolare quelli dei prodotti delle componenti elevate a potenze con esponente reale non negativo, denominate

momenti misti.

Definizione 3.8 Si dice momento misto di ordine r, s di un vettore aleatorio bidimensionale (X1 , X2 ) la

quantità

µr,s = E (X1r X2s )

(3.36)

74

A. Pollice - Appunti di Probabilità

Naturalmente a seconda che la variabile aleatoria X sia discreta e dotata di funzione di probabilità pX1 ,X2

ovvero continua e dotata di funzione di densità fX1 ,X2 il momento misto di ordine r, s è rispettivamente

dato da

∑

µr,s =

tr1 ts2 pX1 ,X2 (t1 , t2 )

(3.37)

(t1 ,t2 )∈RX ⊂R2

∫∫

µr,s =

R2

tr1 ts2 fX1 ,X2 (t1 , t2 ) dt1 dt2

(3.38)

Si noti che ponendo r = 0 si ottiene µ0,s = E (X2s ) e analogamente per s = 0 si ha µr,0 = E (X1r ).

Definizione 3.9 Si dice momento centrale misto di ordine r, s di un vettore aleatorio bidimensionale

(X1 , X2 ) la quantità

mr,s = E [(X1 − E (X1 ))r (X2 − E (X2 ))s ]

(3.39)

Si noti che anche in questo caso ponendo r = 0 si ottiene m0,s = E [(X2 − E (X2 ))s ] e analogamente per

s = 0 si ha mr,0 = E [(X1 − E (X1 ))r ]. Infine ponendo r = s = 1 si ottiene il momento centrale misto di

ordine 1, 1.

Definizione 3.10 Il momento centrale misto di ordine 1, 1 è anche detto covarianza delle variabili aleatorie e viene generalmente indicato con m1,1 = Cov (X1 , X2 ) = σX1 ,X2 = E [(X1 − E (X1 )) (X2 − E (X2 ))].

1. Si noti che vale

σX1 ,X2

= E [(X1 − E (X1 )) (X2 − E (X2 ))]

= E [X1 X2 − X1 E (X2 ) − X2 E (X1 ) + E (X1 ) E (X2 )]

(3.40)

= E (X1 X2 ) − E (X1 ) E (X2 ) − E (X1 ) E (X2 ) + E (X1 ) E (X2 )

= E (X1 X2 ) − E (X1 ) E (X2 )

2. Si ricava facilmente che vale

Cov (aX1 + b, cX2 + d) = E [(aX1 + b − E (aX1 + b)) (cX2 + d − E (cX2 + d))]

= E [(aX1 − E (aX1 )) (cX2 − E (cX2 ))]

(3.41)

= acCov (X1 , X2 )

La covarianza è invariante rispetto a traslazioni delle variabili aleatorie mentre reagisce in modo

proporzionale ai cambiamenti di scala delle stesse.

3. Se X1 e X2 sono due variabili aleatorie indipendenti, allora Cov (X1 , X2 ) = 0. Infatti in tal caso si

ha

Cov (X1 , X2 ) = E (X1 X2 ) − E (X1 ) E (X2 )

= E (X1 ) E (X2 ) − E (X1 ) E (X2 ) = 0

Dunque quando le due variabili aleatorie X1 e X2 sono indipendenti la covarianza si annulla. La

covarianza può, però, anche annullarsi se le due variabili X1 e X2 non sono indipendenti, nel qual

caso X1 e X2 sono dette incorrelate. Se Cov (X1 , X2 ) è positiva, allora X1 e X2 sono dette correlate

positivamente e a valori alti di X1 corrispondono valori alti di X2 nonché a valori bassi di X1

corrispondono valori bassi di X2 . Al contrario X1 e X2 sono dette correlate negativamente se la

covarianza è negativa; in tal caso a valori alti di X1 corrispondono valori bassi di X2 e viceversa.

Cap.3: Valori caratteristici di distribuzioni

75

4. Per due variabili aleatorie qualsiasi X1 e X2 vale

[

]

2

2

σX

=

E

(X

+

X

−

E

(X

+

X

))

1

2

1

2

1 +X2

[

]

= E (X1 − E (X1 ) + X2 − E (X2 ))2

[

]

[

]

= E (X1 − E (X1 ))2 + E (X2 − E (X2 ))2

(3.42)

+2E [(X1 − E (X1 )) (X2 − E (X2 ))]

2

2

= σX

+ σX

+ 2σX1 ,X2

1

2

Inoltre, di conseguenza, la varianza della somma di due variabili aleatorie indipendenti è uguale alla

somma delle varianze delle due variabili aleatorie (risultato generalizzabile alla somma di più di due

variabili aleatorie indipendenti).

Esempio 2.10 (cnt) Dalle funzioni di probabilità marginali calcolo E (X1 ) ed E (X2 )

E (X1 ) = 1 ×

11

1

1

91

+ 2 × + ··· + 6 ×

=

36

4

36

36

E (X2 ) = 2 ×

1

1

1

252

+3×

+ · · · + 12 ×

=

36

18

36

36

mentre dalla funzione di probabilità congiunta della variabile bidimensionale (X1 , X2 ) calcolo

E (X1 X2 ) = 1 × 2 ×

1

2

1

742

+1×3×

+ · · · + 6 × 12 ×

=

36

36

36

36

e complessivamente

Cov (X1 , X2 ) =

742 91 252

105

−

×

=

36

36

36

36

Esempio 2.18 (cnt) Essendo E (Y1 ) = 0 ed

∫

E (Y1 , Y2 ) =

0

1 ∫ 1−t2

−t2

t1 t2 dt2 dt1 = · · · = −

si ha complessivamente

Cov (Y1 , Y2 ) = −

1

1

− 0 × E (Y2 ) = −

12

12

1

12

76

A. Pollice - Appunti di Probabilità

Esempio 3.8 (cnt) Tenendo conto del fatto che evidentemente Cov (X1 , X2 ) = 0, vale Var (X1 + X2 ) =

Var (X1 ) + Var (X2 ) = 2Var (X1 ).

E (X1 ) =

6

∑

tpX1 (t) =

t=1

X12

)

6

∑

) 91

1( 2

1 + 22 + 32 + 42 + 52 + 62 =

6

6

t=1

[ ( )

] 35

Var (X1 + X2 ) = 2Var (X1 ) = 2 E X12 − [E (X1 )]2 =

6

E

(

1

21

(1 + 2 + 3 + 4 + 5 + 6) =

6

6

=

t2 pX1 (t) =

Definizione 3.11 Si dice coefficiente di correlazione la quantità

ρ (X1 , X2 ) =

σX1 ,X2

Cov (X1 , X2 )

=√

σX1 σX2

Var (X1 ) Var (X2 )

1. Dall’applicazione della precedente proprietà 2. della covarianza risulta

(

)

X1 − E (X1 ) X2 − E (X2 )

ρ (X1 , X2 ) = Cov

,

σX 1

σX 2

(3.43)

(3.44)

da cui si vede come il coefficiente di correlazione rappresenta la covarianza tra le variabili X1 e X2

standardizzate.

2. Per trasformazioni lineari delle variabili X1 e X2 vale

ρ (aX1 + b, cX2 + d) = √

acCov (X1 , X2 )

a2 Var (X1 ) c2 Var (X2 )

=√

ac

a2 c2

ρ (X1 , X2 ) = sgn (ac) ρ (X1 , X2 ) (3.45)

Il coefficiente di correlazione è dunque invariante a meno del segno per trasformazioni di scala delle

variabili.

3. Si noti che in generale vale

[Cov (X1 , X2 )]2 = (E [(X1 − E (X1 )) (X2 − E (X2 ))])2

≤ [E |(X1 − E (X1 )) (X2 − E (X2 ))|]2

[

] [

]

≤ E (X1 − E (X1 ))2 E (X2 − E (X2 ))2

= Var (X1 ) Var (X2 )

(3.46)

La prima maggiorazione è banale, mentre la seconda è dovuta alla disuguaglianza di Schwarz. Dalla

(3.46) si ricava che |ρ (X1 , X2 )| ≤ 1.

4. Il coefficiente di correlazione tra una variabile aleatoria X e una sua trasformazione lineare aX + b

vale

ρ (X, aX + b) = √

Cov (X, aX + b)

aCov (X, X)

aVar (X)

=√

=√

= ±1

Var (X) Var (aX + b)

a2 Var (X) Var (X)

a2 Var (X)

(3.47)

In altre parole il coefficiente di correlazione assume valori ±1 quando le due variabili sono legate

da una relazione lineare. Inoltre il valore assoluto del coefficiente di correlazione ρ (X1 , X2 ) è tanto

più vicino all’unità quanto maggiore risulta la concentrazione della distribuzione di probabilità della

variabile aleatoria bidimensionale (X1 , X2 ) attorno a una retta del piano.

Cap.3: Valori caratteristici di distribuzioni

77

( )

( )

Esempio 2.10 (cnt) Ancora dalle funzioni di probabilità marginali calcolo E X12 ed E X22

( )

11

+ 22 ×

E X12 = 12 ×

36

( )

1

E X22 = 22 ×

+ 32 ×

36

1

1

301

+ · · · + 62 ×

=

4

36

36

1

1

1974

2

+ · · · + 12 ×

=

18

36

36

quindi

)

91 2 2555

=

36

362

(

)2

1974

252

7560

−

=

36

36

362

301

−

36

Var (X1 ) =

Var (X2 ) =

(

infine

ρ (X1 , X2 ) = √

Esempio 2.18 (cnt) Essendo Var (Y1 ) =

1

6

∫

105

36

2555

362

×

∼

= 0.86

e

1

(∫

t dt −

t dt

0

0

si ha che

ρ (X1 , X2 ) = √

1

− 12

1

6

)2

1

2

Var (Y2 ) = Var (X2 ) =

3.2.3

7560

362

×

1

12

1

= −

3

( )2

1

1

=

2

12

∼

= −0.71

Valori attesi e momenti condizionati

È possibile applicare la definizione di valore atteso considerando le funzioni di probabilità e di densità

condizionate rispettivamente nel caso di variabili aleatorie doppie discrete e continue.

Definizione 3.12 Data la variabile aleatoria doppia discreta (X1 , X2 ) e la funzione di probabilità condizionata pX1 |X2 il valore atteso condizionato della funzione g (X1 ) dato X2 = x2 è definito dall’espressione

seguente

∑

E (g (X1 ) |x2 ) =

g (t1 ) pX1 |X2 (t1 |x2 )

(3.48)

{t1 ∈R:(t1 ,x2 )∈RX }

Definizione 3.13 Data la variabile aleatoria doppia continua (X1 , X2 ) e la funzione di densità condizionata fX1 |X2 il valore atteso condizionato della funzione g (X1 ) dato X2 = x2 è definito dall’espressione

seguente

∫

E (g (X1 ) |x2 ) =

g (t1 ) fX1 |X2 (t1 |x2 ) dt1

(3.49)

R

78

A. Pollice - Appunti di Probabilità

Esempio 3.12 Si vogliano determinare E (X2 |x1 ) e Var (X2 |x1 ) a partire dalla variabile aleatoria doppia

continua (X1 , X2 ) con funzione di densità

0 < x1 < 1

x1 + x2

0 < x2 < 1

fX1 ,X2 (x1 , x2 ) =

0

altrove

La densità marginale della variabile condizionante risulta

{ ∫1

0 x1 + t2 dt2 = x1 +

fX1 (x1 ) =

0

1

2

0 < x1 < 1

altrove

quindi per un valore 0 < x1 < 1

{

fX2 |X1 (x2 |x1 ) =

da cui

∫

1

E (X2 |x1 ) =

)

(

E X22 |x1 =

0 < x2 < 1

0

altrove

t2

3x1 + 2

x1 + t2

1 dt2 = · · · = 6x + 3

x1 + 2

1

t22

x1 + t 2

4x1 + 3

1 dt2 = · · · = 12x + 6

x1 + 2

1

0

∫

x1 +x2

x1 + 12

1

0

)

(

Var (X2 |x1 ) = E X22 |x1 − (E (X2 |x1 ))2

=

4x1 + 3

−

12x1 + 6

= ··· =

(

3x1 + 2

6x1 + 3

)2

6x1 (x1 − 1) + 1

18 (2x1 + 1)2

Teorema 3.1 Posto E (g (X1 ) |X2 ) = h (X2 ) vale E (h (X2 )) = E (g (X1 )), ovvero

E (E (g (X1 ) |X2 )) = E (g (X1 ))

(3.50)

Infatti nel caso continuo

E (h (X2 )) = E (E (g (X1 ) |X2 ))

∫

E (g (X1 ) |t2 ) fX2 (t2 ) dt2

=

R

∫ ∫

=

R

∫∫

R

=

R2

g (t1 ) fX1 |X2 (t1 |t2 ) dt1 fX2 (t2 ) dt2

g (t1 ) fX1 ,X2 (t1 , t2 ) dt1 dt2 = E (g (X1 ))

In particolare il teorema precedente porta alla seguente uguaglianza

E (X1 ) = E [E (X1 |X2 )]

(3.51)

Cap.3: Valori caratteristici di distribuzioni

79

ed inoltre

( )

Var (X1 ) = E X12 − [E (X1 )]2

[ (

)]

= E E X12 |X2 − {E [E (X1 |X2 )]}2

{

}

[ (

)]

= E E X12 |X2 − E [E (X1 |X2 )]2

{

}

+E [E (X1 |X2 )]2 − {E [E (X1 |X2 )]}2

(3.52)

{ (

}

)

= E E X12 |X2 − [E (X1 |X2 )]2 + Var [E (X1 |X2 )]

= E [Var (X1 |X2 )] + Var [E (X1 |X2 )]

3.2.4

Momenti di vettori aleatori

Nel paragrafo seguente vengono illustrate alcune proprietà relative ai momenti delle variabili aleatorie

multidimensionali.

Definizione 3.14 Il momento primo o valore atteso di un vettore aleatorio k-dimensionale X è dato dal

vettore k-dimensionale dei valori attesi dei suoi elementi

µ = E(X) = (E(X1 ), . . . , E(Xk ))T = (µ1 , . . . , µk )T

(3.53)

Naturalmente la definizione precedente ha senso purché esista finito il valore atteso di ogni componente

del vettore aleatorio X. Seguono le principali proprietà dei valori attesi di vettori aleatori

1. Il valore atteso del trasposto di un vettore aleatorio è uguale al trasposto del valore atteso del vettore

stesso

(

)

E X T = [E (X)]T

(3.54)

2. Linearità. Per X vettore casuale k-dimensionale ed A e b rispettivamente matrice e vettore di costanti

in Rh×k ed Rh vale

E(AX + b) = AE(X) + b

(3.55)

3. Additività. Per X1 e X2 vettori casuali in Rk ed A e B matrici di costanti in Rh×k vale

E(AX1 + BX2 ) = AE(X1 ) + BE(X2 )

(3.56)

Definizione 3.15 La matrice di varianze e covarianze di un vettore aleatorio k-dimensionale X è data

dall’espressione seguente

{

}

(

)

ΣX = Var (X) = E [X − E (X)] [X − E (X)]T = E XX T − E (X) [E (X)]T

(3.57)

La definizione precedente ha senso purché esistano finiti i momenti secondi di ciascun elemento del vettore

aleatorio X. Il perché è facilmente intuibile se si esplicita il significato degli elementi della matrice di

varianze e covarianze

2

σX

σX1 ,X2 · · · σX1 ,Xk

1

2

σX ,X

σX

· · · σX2 ,Xk

2

1

2

ΣX =

(3.58)

..

..

..

.

.

.

.

.

.

2

σXk ,X1 σXk ,X2 · · ·

σX

k

80

A. Pollice - Appunti di Probabilità

{

}

2 = E [X − E (X )]2

Dunque ΣX è una matrice quadrata di ordine k simmetrica e contiene le varianze σX

i

i

1

di ciascuna componente Xi sulla diagonale principale, mentre al di fuori di questa si trovano le covarianze

σX1 ,X2 = E {[Xi − E (Xi )] [Xj − E (Xj )]} tra le possibili coppie di componenti.

Si noti che qualsiasi matrice di varianze e covarianze è sempre semidefinita positiva. Infatti affinché

ΣX sia semidefinita positiva deve valere aT ΣX a ≥ 0 per qualsiasi vettore a ∈ Rk diverso dal vettore nullo:

{

}

{[

]2 }

aT ΣX a = E aT [X − E (X)] [X − E (X)]T a = E aT (X − E (X))

≥0

Definizione 3.16 La matrice di covarianze tra il vettore aleatorio k-dimensionale X e il vettore aleatorio

h-dimensionale Y è data dall’espressione seguente

{

}

(

)

ΣX,Y = Cov (X, Y ) = E [X − E (X)] [Y − E (Y )]T = E XY T − E (X) [E (Y )]T

(3.59)

Come nel caso della matrice di varianze e covarianze

σX1 ,Y1 σX1 ,Y2

σX ,Y σX ,Y

2 1

2 2

ΣX,Y =

..

..

.

.

σXk ,Y1

σXk ,Y2

···

···

..

.

σX1 ,Yh

σX2 ,Yh

..

.

···

σXk ,Yh

(3.60)

Se ne conclude che ΣX,Y è una matrice k×h il cui generico elemento σXi ,Yj = E{(Xi −E(Xi ))(Yj −E(Yj ))}

è la covarianza tra la coppia (Xi , Yj ). Si osservi che Cov (X, X) = Var (X): questa seconda definizione è

quindi più generale.

Teorema 3.2 Se Z = AX + b e K = CY + d, con X ed Y vettori casuali in Rk , A e C matrici di costanti

in Rh×k , b e d vettori di costanti in Rh , vale

Cov (Z, K) = ACov (X, Y ) C T

(3.61)

Infatti

{

}

Cov (Z, K) = E [Z − E (Z)] [K − E (K)]T

{

}

= E [AX + b − E (AX + b)] [CY + d − E (CY + d)]T

{

}

= E [AX + b − AE (X) − b] [CY + d − CE (Y ) − d]T

{

}

= E A [X − E (X)] [Y − E (Y )]T C T = ACov (X, Y ) C T

Da questo risultato generale discendono alcuni importanti casi particolari.

1. X = Y =⇒ Cov (Z, K) = AVar (X) C T

2. Z = K = AX + b =⇒ Var (Z) = AVar (X) AT

3. Z = K = X + b =⇒ Var (Z) = Var (X)

4. Z = K = AX =⇒ Var (Z) = AVar (X) AT

3.3

Funzione caratteristica e funzioni generatrici

Vi sono oltre alle funzioni di ripartizione, alle funzioni di probabilità e di densità e ai momenti ancora altri

strumenti per lo studio delle distribuzioni.

Cap.3: Valori caratteristici di distribuzioni

3.3.1

81

Funzione caratteristica

Tra questi vi è la trasformata complessa della funzione di ripartizione denominata funzione caratteristica

che permette di calcolare i momenti della distribuzione in un modo più agevole di quello diretto: tramite

derivazione piuttosto che tramite integrazione.

Definizione 3.17 Data una variabile aleatoria X con funzione di ripartizione FX si dice funzione caratteristica la funzione definita per u ∈ R dal seguente valore atteso

∫

(

)

ψX (u) = E eiuX =

eiut dFX (t)

(3.62)

R

Dove nell’espressione precedente, che corrisponde alla trasformata di Eulero-Fourier della funzione di

ripartizione, il calcolo del valore atteso è basato sull’integrale di Stieltjes.

Teorema 3.3 La funzione caratteristica esiste sempre finita (l’integrale che la definisce non diverge mai)

per u ∈ Ṙ. Infatti risulta sempre |ψX (u)| ≤ 1

∫

iut

|ψX (u)| = e dFX (t)

∫R

iut e dFX (t)

≤

R

∫

=

|cos ut + i sin ut| dFX (t)

R

∫ √

cos2 ut + sin2 ut dFX (t)

=

∫R

=

dFX (t) = 1

R

Se X è discreta con funzione di probabilità pX e insieme di definizione RX l’espressione (3.62) diventa

∑

(

)

eiut pX (t)

(3.63)

ψX (u) = E eiuX =

t∈RX

mentre se X è continua e dotata di densità fX

(

iuX

ψX (u) = E e

)

∫

eiut fX (t) dt

=

R

(3.64)

82

A. Pollice - Appunti di Probabilità

Esempio 3.13 Sia X una variabile aleatoria continua con funzione di densità uniforme nell’intervallo

(−1, 1)

{ 1

−1 < x < 1

2

fX (x) =

0

altrove

la sua funzione caratteristica è dunque definita dal seguente integrale

1

∫

eiut 1 1 iut

e dt =

2 −1

2iu −1

)

1 ( iu

e − e−iu

2iu

1

(cos u + i sin u − cos u + i sin u)

2iu

sin u

u

ψX (u) =

=

=

=

Si noti che ad ogni funzione di ripartizione corrisponde una funzione caratteristica e viceversa: le

funzioni caratteristiche sono in corrispondenza biunivoca con le funzioni di ripartizione. Dunque la funzione

caratteristica è uno strumento alternativo alla funzione di ripartizione per lo studio delle distribuzioni di

probabilità. In particolare se si è in presenza di una funzione caratteristica di forma nota la biunivocità

della corrispondenza permette di risalire alla distribuzione.

( )

Si può dimostrare che se esistono tutti i momenti E X h per h = 1, 2, . . . e se la serie complessa

1 + iuE (X) −

u2 ( 2 )

(iu)h ( h )

E X + ··· +

E X + ···

2

h!

converge in un intorno non nullo dello 0, allora detta serie coincide con lo sviluppo in serie di Taylor della

funzione caratteristica e si ha

ψX (u) = 1 + iuE (X) −

u2 ( 2 )

(iu)h ( h )

E X + ··· +

E X + ···

2

h!

(3.65)

Questa proprietà stabilisce la corrispondenza tra la funzione caratteristica e la serie completa dei momenti

della variabile aleatoria che pertanto individua le caratteristiche distributive della stessa.

Il teorema seguente permette invece di utilizzare la funzione caratteristica per ricavare i momenti della

variabile aleatoria.

Teorema 3.4 Se la variabile aleatoria X ammette momenti finiti sino all’r-esimo, allora la funzione

caratteristica ψX (u) è derivabile r volte e, per h = 1, . . . , r, vale

( )

h

h

−h d ψX (u) E X = µh = i

h

du

u=0

(3.66)

Infatti per h = 1

dψX (u)

d

=

du

du

∫

∫

iut

e

dFX (t) =

R

mentre per h = 2

d2 ψX (u)

d

=

2

du

du

R

d iut

e dFX (t) =

du

∫

it eiut dFX (t)

R

∫

(it)2 eiut dFX (t)

it eiut dFX (t) =

R

∫

R

Cap.3: Valori caratteristici di distribuzioni

83

quindi in generale per h = 1, . . . , r

dh ψX (u)

=

duh

∫

(it)h eiut dFX (t)

R

Si dimostra che l’integrale precedente è sempre convergente per qualsiasi intero h < r. Infine ponendo

u = 0 si ottiene

∫

dh ψX (u) h

=

i

th dFX (t) = ih µh

duh u=0

R

Esempio 3.14 Sia X la variabile aleatoria che indica il numero di lanci una moneta regolare necessari

affinché esca testa. La funzione di probabilità di X è dunque data da

{ ( 1 )x

x = 1, 2, . . .

2

pX (x) =

0

altrove

La funzione caratteristica è

ψX (u) = lim

n→∞

n

∑

t=1

iut

e

( )t

n ( iu )t

eiu

∑

e

eiu

1

2

=

= lim

=

iu

n→∞

2

2

2 − eiu

1 − e2

t=1

l’espressione precedente è ottenuta come somma infinita della serie geometrica di ragione

1. Il calcolo delle prime due derivate della funzione caratteristica porta a

(

)

(

)

ieiu 2 − eiu − eiu −ieiu

2ieiu

dψX (u)

=

=

du

(2 − eiu )2

(2 − eiu )2

(

)2

(

)(

)

−2eiu 2 − eiu − 2ieiu 2 2 − eiu −ieiu

d2 ψX (u)

2e3iu − 8eiu

=

=

du2

(2 − eiu )4

(2 − eiu )4

Quindi per i primi due momenti di X si ottengono i valori

−1 dψX (u) E (X) = i

=2

du u=0

2

( 2)

−2 d ψX (u) E X =i

=6

du2 u=0

( )

Var (X) = E X 2 − [E (X)]2 = 2

eiu

2

iu con e2 <

84

A. Pollice - Appunti di Probabilità

Esempio 3.15 Sia X una variabile aleatoria continua la cui funzione di densità, detta distribuzione di

Laplace o esponenziale simmetrica di parametro 1, è data da

1

fX (x) = e−|x|

2

−∞<x<∞

La funzione caratteristica è definita dall’integrale

∫

1 ∞ iut −|t|

ψX (u) =

e e dt

2 −∞

∫

∫

1 ∞ iut −t

1 0 iut t

e e dt +

e e dt

=

2 −∞

2 0

0

∞

(

(

1 et(1+iu) 1 e−t(1−iu) =

−

2 1 + iu 2

1 − iu −∞

=

0

1 1

1

1 1

+

=

2 1 + iu 2 1 − iu

1 + u2

Il calcolo delle prime due derivate della funzione caratteristica porta a

(

)−2

dψX (u)

= −2u 1 + u2

du

(

)−2

(

)−3

d2 ψX (u)

= −2 1 + u2

+ 8u2 1 + u2

2

du

Quindi per i primi due momenti di X si ottengono i valori

−1 dψX (u) E (X) = i

=0

du u=0

2

( 2)

−2 d ψX (u) =2

E X =i

2

du

u=0

( )

Var (X) = E X 2 − [E (X)]2 = 2

Cap.3: Valori caratteristici di distribuzioni

85

Esempio 3.13 (cnt) per quanto già visto si ha

dψX (u)

u cos u − sin u

=

du

u2

d2 ψX (u)

du2

=

=

u2 (cos u − u sin u − cos u) − 2u (u cos u − sin u)

u4

2

2 sin u − u sin u − 2u cos u

u3

Dall’applicazione della regola dell’Hôpital per il calcolo del limite della forma indeterminata

lim

u→0

0

0

si ottiene

1

dψX (u)

u cos u − sin u

= lim sin u = 0

= lim

u→0

u→0 2

du

u2

d2 ψX (u)

2 sin u − u2 sin u − 2u cos u

1

1

=

lim

= lim − cos u = −

u→0

u→0

u→0 3

du2

u3

3

Quindi per i primi due momenti di X si ottengono i valori

−1 dψX (u) E (X) = i

=0

du u=0

2

( 2)

1

−2 d ψX (u) E X =i

=

2

du

3

u=0

lim

( )

1

Var (X) = E X 2 − [E (X)]2 =

3

Teorema 3.5 Per a e b reali si ha

ψaX+b (u) = eiub ψX (au)

(3.67)

Infatti per la definizione di funzione caratteristica e per la linearità del valore atteso

[

]

[

]

ψaX+b (u) = E eiu(aX+b) = eiub E eiuaX = eiub ψX (au)

Esempio 3.13 (cnt) Dalla funzione caratteristica della variabile aleatoria X avente densità uniforme

su (−1, 1) si può ottenere facilmente quella della variabile aleatoria Y = 12 (X + 1) che ha densità

uniforme su (0, 1)

u

ψY (u) = ψ 1 X+ 1 (u) = ei 2

2

2

sin u2

u

2

=

iu

) eiu − 1

iu

e 2 ( iu

e 2 − e− 2 =

iu

iu

Teorema 3.6 Se X1 e X2 sono variabili aleatorie stocasticamente indipendenti la funzione caratteristica

della somma X1 + X2 è data dal prodotto delle funzioni caratteristiche di X1 e X2

ψX1 +X2 (u) = ψX1 (u) ψX2 (u)

(3.68)

86

A. Pollice - Appunti di Probabilità

Infatti per la definizione di funzione caratteristica e per la proprietà del valore atteso del prodotto di funzioni

di variabili aleatorie indipendenti si ha

[

]

[

]

[

] [

]

ψX1 +X2 (u) = E eiu(X1 +X2 ) = E eiuX1 eiuX2 = E eiuX1 E eiuX2 = ψX1 (u) ψX2 (u)

Esempio 3.16 Le variabili aleatorie X1 e X2 siano indipendenti e abbiano entrambe densità uniforme

sull’intervallo (0, 1). Allora si ha che

ψX1 (u) = ψX2 (u) =

quindi

(

eiu − 1

iu

ψX1 +X2 (u) =

Si noti inoltre che

)2

=

eiu − 1

iu

)

1 ( iu

2e − e2iu − 1

2

u

[

]

1 − e−iu

ψ−X2 (u) = E e−iuX2 = ψX2 (−u) =

iu

quindi

)

1 (

eiu − 1 1 − e−iu

= 2 2 + e−iu − eiu

iu

iu

u

L’ultima espressione fornisce la funzione caratteristica associata alla densità triangolare.

ψX1 −X2 (u) =

L’enunciato e la dimostrazione dell’ultimo teorema possono essere facilmente estesi alla somma di k > 2

variabili aleatorie mutuamente stocasticamente indipendenti X1 , . . . , Xk

ψX1 +···+Xk (u) = ψX1 (u) · · · ψXk (u) =

k

∏

ψXj (u)

(3.69)

j=1

3.3.2

Funzione generatrice dei momenti

Oltre alla funzione caratteristica vengono utilizzate altre trasformate della funzione di ripartizione. Una

di queste è la trasformata di Laplace che dà luogo alla cosiddetta funzione generatrice dei momenti.

Definizione 3.18 Si dice funzione generatrice dei momenti della variabile aleatoria X con funzione di

ripartizione FX la funzione

∫

( uX )

ϕX (u) = E e

=

eut dFX (t)

(3.70)

R

purché l’integrale sia finito in un intorno dell’origine.

La funzione generatrice dei momenti si distingue dalla funzione caratteristica per la mancanza dell’unità immaginaria. Nonostante la semplificazione che si attua passando dal campo complesso al campo

reale, l’integrale che definisce la trasformata di Laplace pur esistendo sempre può assumere valore infinito

(diversamente dall’integrale che definisce la funzione caratteristica).

Esempio 3.13 (cnt) In questo caso la funzione generatrice dei momenti ha la forma seguente

1

ϕX (u) =

2

1

eu − e−u

eut =

e dt =

2u −1

2u

−1

∫

1

ut

Cap.3: Valori caratteristici di distribuzioni

87

Seguono alcune proprietà analoghe a quelle già enunciate per la funzione caratteristica.

1. Se esistono finiti tutti i momenti della variabile aleatoria X si ha

ϕX (u) = 1 + uE (X) +

2.

u2 ( 2 )

uh ( h )

E X + ··· +

E X + ···

2

h!

(3.71)

( )

dh ϕX (u) h

E X = µh =

duh u=0

(3.72)

ϕaX+b (u) = eub ϕX (au)

(3.73)

3.

4. Per variabili aleatorie X1 , . . . , Xk indipendenti

ϕX1 +···+Xk (u) = ϕX1 (u) · · · ϕXk (u) =

k

∏

j=1

ϕXj (u)

(3.74)

88

A. Pollice - Appunti di Probabilità

Esempio 3.13 (cnt) per l’esempio precedente si ha

(

)

)] ueu + ue−u − eu + e−u

dϕX (u)

1 [ (

= 2 2u eu + e−u − 2 eu − e−u =

du

4u

2u2

d2 ϕX (u)

du2

=

)

( u

)]

1 [ 2( u

u

−u

−u

u

−u

−u

u

−u

2u

e

+

ue

+

e

−

ue

−

e

−

e

−

4u

ue

+

ue

−

e

+

e

4u4

=

u2 eu − u2 e−u − 2ueu − 2ue−u + 2eu − 2e−u

2u3

Dall’applicazione della regola dell’Hôpital per il calcolo del limite della forma indeterminata

dϕX (u) E (X) = µ =

du u=0

ueu + ue−u − eu + e−u

ueu − ue−u

= lim

=

lim

=0

u→0

u→0

2u2

4u

(

E X

2

)

=

=

2

σX

lim

0

0

si ottiene

d2 ϕX (u) =

du2 u2 eu

−

u=0

2

−u

u e −

u→0

2ueu − 2ue−u + 2eu − 2e−u

u2 eu + u2 e−u

1

= lim

=

3

u→0

2u

6u2

3

Inoltre dalla funzione generatrice dei momenti della variabile aleatoria X avente densità uniforme su

(−1, 1) si può ottenere facilmente quella della variabile aleatoria Y = 12 (X + 1) che ha densità uniforme

su (0, 1)

) eu − 1

u

1 u( u

ϕY (u) = ϕ 1 X+ 1 (u) = e 2 e 2 − e− 2 =

2

2

u

u

Esempio 3.16 (cnt) La funzione generatrice dei momenti di X1 + X2 è data da

ϕX1 +X2 (u) =

)

1 u

1

1 (

(e − 1) (eu − 1) = 2 e2u − 1

u

u

u

mentre la funzione generatrice dei momenti della variabile aleatoria X1 − X2 avente densità triangolare

è data da

)

)

1 u

1 ( −u

1 ( u

−u

ϕX1 −X2 (u) = ϕX1 (u) ϕX2 (−u) = −

3.3.3

u

(e − 1)

u

e

−1 =

u2

e +e

−2

Funzione generatrice delle probabilità

Un’altra trasformata della funzione di ripartizione particolarmente utile nel caso di variabili aleatorie

discrete è la trasformata di Dirichlet che dà luogo alla cosiddetta funzione generatrice delle probabilità.

Definizione 3.19 Sia X una variabile aleatoria che assume solo valori interi non negativi con funzione

di probabilità pX e insieme di definizione RX = {x ∈ R : x = 0, 1, 2, . . .}. Per −1 ≤ u ≤ 1 si definisce

funzione generatrice delle probabilità della variabile aleatoria X il seguente valore atteso

∞

( ) ∑

γX (u) = E uX =

ut pX (t)

t=0

(3.75)

Cap.3: Valori caratteristici di distribuzioni

89

Si noti che per u > 0 la funzione caratteristica calcolata nel punto i−1 log u fornisce la funzione generatrice

delle probabilità

( −1

)

(

)

( )

ψX i−1 log u = E ei(i log u)X = E uX = γX (u)

(3.76)

Di conseguenza per la funzione generatrice delle probabilità valgono proprietà analoghe a quelle valide per

la funzione caratteristica.

Inoltre esiste la relazione seguente tra la funzione di probabilità e la funzione generatice delle probabilità

di una variabile aleatoria discreta.

1. Per una variabile aleatoria X con funzione generatrice delle probabilità γX si ha

1 dx γX (u) pX (x) =

x = 0, 1, 2, . . .

x!

dux u=0

Infatti è evidente che

γX (u) = pX (0) + upX (1) + u2 pX (2) + · · ·

d

γX (u) = pX (1) + 2upX (2) + 3u2 pX (3) + · · ·

du

d2

γX (u) = 2pX (2) + 6upX (3) + 12u2 pX (4) + · · ·

du2

da cui si ricava

γX (u)|u=0 = pX (0)

dγX (u) = pX (1)

du u=0

d2 γX (u) = 2pX (2)

du2 u=0

ed in generale

dx γX (u) = x!pX (x)

dux u=0

Esempio 3.14 (cnt) Nel caso in questione si ha

γX (u) =

∞

∑

t=1

u

∑ ( u )t

1

u t =

= 2

2

2

1−

∞

t

t=1

d u pX (1) =

du 2 − u u

2

=

u

2−u

2 − u + u 1

=

=

2 (2 − u) u=0 2

u=0

1

d2 u −3 =

=

4

(2

−

u)

2pX (2) =

2

du 2 − u u=0

2

u=0

in generale

x!pX (x) =

dx u dux 2 − u u=0

(3.77)