CORSO DI LAUREA IN ECONOMIA AZIENDALE

Metodi Statistici per l’impresa (Note didattiche)

Bruno Chiandotto – Fabrizio Cipollini

Capitolo 6

STIMA DEI PARAMETRI

Come indicato nel cap. 2, il calcolo delle probabilità è presupposto essenziale della

teoria della statistica. Proprio sulla base dei concetti del calcolo delle probabilità (cui

faremo costante riferimento) affrontiamo ora l’inferenza statistica. Tuttavia per evitare

l’errato fraintendimento che tale materia sia “pura tecnica”, nell’introduzione che segue

presentiamo l’argomento senza formule: lo scopo è dare un senso al problema, un senso

agli specifici argomenti trattati, un senso ai singoli concetti enunciati. Non tutto sarà

perfettamente chiaro dopo la prima lettura. Per questo si invita lo studente rileggere

l’introduzione dopo aver completato lo studio (perché solo allora ogni affermazione qui

contenuta avrà un senso compiuto) e, soprattutto, ogni volta che avrà la sensazione di

aver “perso il filo”.

1. Introduzione

1.1. Introduzione all’inferenza statistica

In generale, per capire “come si affronta” un certo problema è assolutamente necessario

comprendere prima “dove sta” il problema. Questo è valido a maggior ragione per una

problematica tecnicamente tutt’altro che banale quale l’inferenza statistica. Per questo

motivo si fa precedere la trattazione degli argomenti affrontati (stima puntuale, stima

per intervallo, test delle ipotesi) da alcune considerazioni generali che danno un senso

logico a quanto presentato nel seguito.

Il problema è il seguente e lo schematizziamo per punti.

•

Il punto di partenza è l’analisi di un certo fenomeno d’interesse il cui risultato non

è prevedibile con certezza.

•

Il calcolo delle probabilità indica che dal punto di vista statistico tale fenomeno può

essere rappresentato mediante una variabile casuale, cioè un “oggetto” casuale le

1

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

cui manifestazioni non sono prevedibili in modo certo essendo, appunto, frutto del

caso. Il calcolo delle probabilità dice anche che per identificare una v.c. occorre

esplicitare i valori che questa può assumere e con quale probabilità. Se possiamo

fare questo abbiamo detto tutto della v.c. e quindi del fenomeno che interessa: di più

non è possibile fare.

•

Nella pratica, la probabilità può essere distribuita sui valori che la v.c. può assumere

nei modi più vari. L’obiettivo è conoscere, in modo completo (cioè attraverso la

funzione di massa o la funzione di densità) o parziale (cioè solo attraverso

particolari indici caratteristici) la distribuzione della v.c. considerata. Per

raggiungere questo obiettivo la statistica può seguire diverse vie.

-

Inferenza parametrica. La prima via sfrutta i modelli già preconfezionati e

pronti all’uso che la statistica (servendosi del calcolo delle probabilità) mette a

disposizione proprio per rappresentare certe situazioni tipiche dei fenomeni

reali: il modello di Bernoulli, il modello Binomiale, il modello Ipergeometrico,

il modello di Poisson, il modello Normale, il modello Gamma, ecc. (l’elenco

potrebbe continuare molto a lungo, con modelli anche assai complicati che

possono coinvolgere anche più variabili). Pertanto sulla base delle caratteristiche

del fenomeno in oggetto, di analisi simili, di considerazioni teoriche,

dell’esperienza passata, ecc. si sceglie fra i modelli statistici a disposizione

quello che sembra adattarsi meglio al fenomeno in analisi (oppure se ne inventa

uno nuovo, magari modificando quelli già disponibili). Tale via all’inferenza è

detta inferenza parametrica, nel senso che il modello statistico per l’analisi del

fenomeno è completamente specificato in tutte le sue parti (forma funzionale e

parametri caratteristici) e l’unica inferenza possibile è quella sui parametri

caratteristici del modello.

-

Inferenza non-parametrica. Una via radicalmente opposta a quella indicata

(ma spesso utilizzata in combinazione con la precedente) è quella di non

formulare alcun modello (ad esempio non supporre alcuna forma funzionale per

la distribuzione della v.c.) ma di servirsi di particolari strumenti statistici

particolarmente “flessibili” per arrivare ad una caratterizzazione del problema

studiato esclusivamente sulla base dei dati. Tale via all’inferenza è detta

2

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

inferenza non-parametrica, nel senso che il modello statistico per l’analisi del

fenomeno è completamente non specificato e non ci sono parametri caratteristici

su cui fare inferenza (dato che non c’è nessun modello): sono i dati a guidare in

modo determinante i risultati.

-

Inferenza semi-parametrica. Infine una via intermedia a quelle indicate si ha

quando si specificano certe componenti del modello (ad esempio si suppone che

la v.c. abbia certi indici caratteristici, come media e varianza) ma si lasciano le

altre non specificate (di solito non si specifica la completa forma funzionale

della funzione di massa o di densità). Anche in questo caso esistono strumenti

statistici per poter ottenere dei risultati solo sulle grandezze che interessano

senza dover fare le altre ipotesi. Tale via all’inferenza è detta inferenza semiparametrica, nel senso che il modello statistico per l’analisi del fenomeno è

specificato solo in modo parziale. Come è facile intuire, tale approccio ha

caratteristiche intermedie fra gli altri due, anche se per molti aspetti è più vicino

al primo che al secondo.

Non facendo di norma assunzioni sulla forma funzionale della distribuzione,

l’inferenza non-parametrica e quella semi-parametrica sono spesso raggruppate sotto

la dizione distribution free.

Per quanto riguarda il presente corso ci occuperemo principalmente di inferenza

parametrica e in parte di inferenza semiparametrica. Tuttavia, per semplicità, in

questa introduzione faremo essenzialmente riferimento al caso parametrico.

•

Scelto il modello opportuno per il fenomeno analizzato, tale modello dipende

tipicamente da uno o più parametri incogniti. Solo se si riesce a dare un valore a

tali parametri allora la distribuzione della v.c. considerata è completamente nota e si

è detto tutto del fenomeno analizzato. Tuttavia, in generale di tali parametri si sa

solo che assumono valori in un certo insieme, detto spazio parametrico, ma non di

più. Come fare allora per determinare i parametri? Anzi, più in generale, come

rispondere ai 3 problemi base dell’inferenza statistica sui parametri d’interesse,

ovvero:

1. (Stima puntuale) Come tentare di indovinare il valore dei parametri?

2. (Stima per intervallo) Come determinare, per ciascun parametro d’interesse, un

3

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

intervallo che ne contiene il vero valore “con alta probabilità”?

3. (Test delle ipotesi) Come procedere all’accettazione o al rifiuto di una

particolare ipotesi formulata sui parametri?

•

Per rispondere alle domande di cui sopra occorre sfruttare qualche informazione.

Come informazione di base l’inferenza statistica utilizza un certo insieme di

osservazioni del fenomeno oggetto di studio: tale insieme è detto campione. Quindi:

sulla base dell’informazione del campione si vuol fare inferenza sui parametri del

modello scelto e quindi sulla legge probabilistica alla base del fenomeno analizzato.

La branca dell’inferenza statistica che utilizza come unica informazione per

rispondere alle tre domande di cui sopra le sole osservazioni del campione è detta

statistica classica. In contrapposizione a questa si colloca la statistica bayesiana,

che invece prevede l’utilizzo, oltre all’informazione campionaria, anche di

informazioni a priori che, generalmente, hanno natura soggettiva. Il nome di

statistica bayesiana viene dal fatto di utilizzare il teorema di Bayes come strumento

fondamentale di inferenza.

Per quanto riguarda questo corso ci occuperemo esclusivamente di statistica

classica.

1.2. Introduzione alla stima puntuale

Fin qui la presentazione da un punto di vista generale dell’inferenza statistica, con

accenno ai vari problemi che si possono presentare e ai diversi approcci che si possono

seguire per la risoluzione di tali problemi.

Per rendere il quadro più concreto, occorre evidenziare tre punti fondamentali, che per

maggiore chiarezza interpretiamo principalmente in ottica di stima puntuale:

1. un campione è solo una realizzazione parziale del fenomeno oggetto di analisi;

2. poiché un campione è composto in genere da molte osservazioni del fenomeno, nel

passare dal campione ad una valutazione del o dei parametri occorre un processo di

sintesi delle osservazioni del campione;

3. la scelta del modello può essere sbagliata; in altri termini non è detto che il

modello scelto si adatti bene ai dati analizzati.

Il chiarimento di questi punti consente di evidenziare una serie di aspetti importanti che

4

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

costituiranno oggetto di analisi nelle pagine che seguono.

1. Essendo solo una realizzazione parziale del fenomeno osservato, non è affatto detto

(e anzi è più unico che raro) che dal campione si riesca a determinare il valore esatto

dei parametri: in generale si può solo ricavarne una stima, cioè una valutazione sulla

base delle informazioni a disposizione. Inoltre al cambiare del campione si

ottengono in generale stime diverse.

2. In base alla considerazione precedente, è facile rendersi conto che ogni stima è un

processo di sintesi del campione affetto da errore. Caso per caso occorre scegliere la

sintesi migliore, cioè quella che, a parità di altre condizioni, consente di andare “più

vicino possibile” alla grandezza da stimare. Tuttavia dato che il vero valore di

ciascun parametro non è noto (se si conoscesse non ci sarebbe bisogno di stimarlo)

non è possibile determinare quanto la stima fornita sbaglia rispetto al valore vero del

parametro. Nonostante ciò la statistica ha messo a punto opportuni strumenti per

valutare la bontà delle stime effettuate. Tali strumenti, però, richiedono di far

riferimento non al solo campione estratto ma all’intero universo dei campioni, cioè a

tutti i campioni che sarebbero potuti venire fuori dal modello considerato.

3. Non è affatto detto che il modello scelto sia “ben scelto”; in altri termini può darsi

che quello considerato non sia il modello più adatto per il fenomeno analizzato. La

statistica fornisce allora gli strumenti per testare la bontà del modello scelto, cioè

per decidere, sulla base dei dati del campione, se il modello può essere accettato

oppure deve essere abbandonato in favore di un altro. Questo problema sarà

affrontato nell’ambito del test delle ipotesi di cui al relativo capitolo.

2. La scelta del modello statistico

Il primo passo per l’analisi statistica di un certo fenomeno è, sempre, la scelta del

modello più opportuno per rappresentare il “comportamento probabilistico” del

fenomeno stesso. Detto infatti che questo può essere rappresentato da una v.c., diciamo

X, si tratta di scegliere fra i modelli statistici, quello più adatto per rappresentare la

distribuzione di X.

In realtà la scelta del modello, anche se determinante in funzione nei risultati

dell’analisi, non è prettamente materia statistica, anche se una certa conoscenza della

5

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

materia è assolutamente necessaria. Infatti la scelta del modello è il risultato finale di

considerazioni di varia natura: le caratteristiche del fenomeno in oggetto, analisi simili

(magari con riferimento a quanto presente in letteratura), considerazioni puramente

teoriche, l’esperienza passata con problemi analoghi, ecc. Caso per caso ciascuno degli

aspetti indicati pesa in modo diverso.

Per quanti riguarda questo corso, in linea di massima la scelta del modello sarà

strettamente guidata dal docente, ma non bisogna dimenticare che nella pratica tale

decisione ricade su chi effettua l’analisi. Come aiuto, si forniscono di seguito alcuni

semplici esempi in cui si discute la scelta del modello.

Esempio

Supponiamo di voler analizzare, nell’ambito della popolazione italiana, il gradimento

nei confronti di un provvedimento legislativo di “completa liberalizzazione dell’orario

di apertura dei negozi”.

Se interessa distinguere fra FAVOREVOLI e NON FAVOREVOLI al provvedimento, il

più opportuno sembra essere il modello di Bernoulli. In altri termini se X è la v.c.

“FAVOREVOLE al provvedimento”, allora tale v.c. assumerà valore 1 se un individuo

è favorevole e 0 se non favorevole. In simboli X ~ Be(p) dove p ∈ [0, 1]. Dal punto di

vista statistico, il problema a questo punto è fare inferenza su p.

Esempio

Supponiamo che il “responsabile qualità” di una grossa impresa produttrice di filati di

lana voglia analizzare il numero di difetti presenti nella propria produzione prendendo

come base matasse da 10000 metri.

Fra quelli introdotti (ce ne potrebbero essere tuttavia altri adatti alla situazione indicata),

il modello più opportuno sembra essere la distribuzione di Poisson. Allora assumeremo

che la v.c. X = “numero di difetti in una matassa da 10000 m” ~ Po(λ) dove λ ≥ 0. Dal

punto di vista statistico, il problema a questo punto è fare inferenza su λ.

6

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

Esempio

Supponiamo che un centro di analisi stia studiando la redditività delle piccole imprese

del settore “mobili e arredi” utilizzando l’indice ROE = utile/capitale netto.

Fra quelli introdotti (ma anche in questo caso ce ne potrebbero essere altri adatti), un

modello ragionevole è rappresentato dalla distribuzione Normale. Allora assumeremo

che la v.c. X = “ROE” ~ N(µ, σ2), dove µ ∈ R e σ2 ≥ 0. A questo punto il problema è

fare inferenza sui due parametri µ e σ2.

Esempio

Supponiamo che il responsabile alle vendite di un’impresa del settore moda stia

analizzando il tempo di permanenza in magazzino dei suoi giubbotti in pelle.

Fra quelli introdotti (ma anche in questo caso ce ne potrebbero essere altri adatti), un

modello ragionevole è rappresentato dalla distribuzione Gamma. Allora assumeremo

che la v.c. X = “Tempo di permanenza in magazzino” ~ Ga(α, β), dove α, β > 0. A

questo punto il problema è fare inferenza sui due parametri α e β.

Dagli esempi proposti possiamo trarre il seguente schema riassuntivo. Sia X la v.c.,

discreta o continua, che rappresenta il fenomeno oggetto di analisi. La scelta fra i diversi

modelli presenti in letteratura per rappresentare la distribuzione di X si basa, come detto,

su considerazioni di diversa natura. In ogni caso scegliere un modello significa scegliere

la funzione di massa o di densità di X. Sia quindi

f(x;θ)

la funzione di massa (se discreta) o la funzione di densità (se continua) della v.c. X,

dove θ indica i parametri caratteristici funzione scelta. Si ipotizza che θ ∈ Θ, cioè che i

parametri appartengano ad un certo insieme Θ detto spazio parametrico; lo spazio

parametrico è quindi l’insieme dei valori che i parametri possono assumere. Ad

esempio: nel modello di Bernoulli il parametro è p il cui spazio parametrico è [0, 1]; nel

modello di Poisson il parametro è λ il cui spazio parametrico è [0, +∞); nel modello

Normale i parametri sono µ e σ2 e lo spazio parametrico è il prodotto cartesiano dei

rispettivi spazi parametrici, cioè R × [0, +∞); nel modello Gamma i parametri sono α e

7

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

β e lo spazio parametrico è il prodotto cartesiano dei rispettivi spazi parametrici, cioè (0,

+∞) × (0, +∞).

3. Concetti di base

Con riferimento a quanto detto finora, sia allora X una v.c., discreta o continua, che

rappresenta il fenomeno oggetto di analisi e sia quindi

f(x;θ)

la funzione di massa o di densità della v.c. X, dove θ ∈ Θ indica i parametri caratteristici

funzione scelta.

Per semplicità, nella trattazione che segue ci limiteremo ad analizzare il processo di

inferenza per un parametro alla volta; in altre parole supporremo che θ sia uno scalare e

che lo spazio parametrico Θ sia un sottoinsieme di R (al limite R stesso). Solo quando

utile faremo espliciti richiami al caso multiparametrico.

In generale θ non è noto: l’unica cosa che si conosce è lo spazio parametrico Θ a cui

appartiene. Non essendo noto bisogna cercare di “indovinare” o, più correttamente, di

stimare θ. Per stimare θ si dispone dell’informazione contenuta in un campione di

osservazioni

x = (x1, …, xn)

della v.c. X che rappresenta il fenomeno studiato. La stima puntuale di θ si risolve allora

nella ricerca di una funzione del campione

θ̂ = T(x1, …, xn),

in modo da ottenere un valore θ̂ che sia “più vicino possibile” al parametro incognito θ.

Purtroppo, posto in questi termini il problema di stima puntuale non ha soluzione. Infatti

come è possibile giudicare quanto la stima

θ̂ = T(x1, …, xn)

è vicina al parametro incognito

θ

8

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

se questo, appunto, è incognito? (Com’è possibile giudicare quanto un numero è vicino

ad un altro numero se quest’ultimo non si conosce?)

Per giudicare il processo di stima occorre allora correggere i termini del problema sulla

base di una considerazione fatta in precedenza. Il punto cruciale è il seguente: il

campione a disposizione, x = (x1, …, xn), è solo uno fra i tanti campioni che sarebbero

potuti capitare. Se fosse stato estratto un campione diverso, quasi sicuramente la stima

del parametro sarebbe risultata diversa. Per giudicare la bontà di un processo di stima,

allora, occorre valutarne il comportamento non sulla base del solo campione a

disposizione, ma sulla base di tutti i possibili campioni. In questo modo si ottengono

due vantaggi:

1. è possibile definire il concetto di bontà di un dato procedimento di stima puntuale;

2. è possibile interpretare i risultati ottenuti dal campione a disposizione alla luce del

comportamento di tutti i possibili campioni.

Tornando allora al nostro problema, fra l’assunzione che la v.c. X si distribuisce secondo

una certa funzione di massa o di densità f(x;θ) e il campione x = (x1, …, xn) occorre

inserire alcuni concetti intermedi.

Innanzitutto assumeremo da ora in poi che il campione a disposizione sia un campione

casuale semplice (spesso abbreviato in c.c.s.), cioè un campione le cui osservazioni

sono indipendenti ovvero:

1. o estratte con reimmissione;

2. oppure estratte senza reimmissione da una popolazione di numerosità talmente

elevata da rendere praticamente nulla la probabilità di estrarre la stessa unità

campionaria.

Su questa base, a ciascuna estrazione campionaria i-ma è associata una v.c. Xi che

rappresenta tutti i possibili valori che possono venire fuori da tale estrazione.

Essendo le estrazioni indipendenti, è ovvio che ciascuna Xi sarà distribuita esattamente

come la v.c. dalla quale è stata effettuata l’estrazione, cioè

Xi ∼ f(xi; θ),

con i = 1, …, n.

9

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

Di conseguenza, l’universo dei possibili campioni (di dimensione prefissata n) che

possono essere estratti è rappresentato dalla v.c. multipla

X = (X1, …, Xn)

la cui funzione di massa o funzione di densità è espressa da

f(x1, …, xn; θ) =

n

∏ f(xi; θ),

i=1

dato che le estrazioni sono fra loro indipendenti (si veda cap. 2 sulle v.c. multiple).

In questo contesto il campione

x = (x1, …, xn)

sarà una particolare realizzazione della v.c. multipla

X = (X1, …, Xn).

Altra conseguenza è che con riferimento all’universo dei campioni, cioè alla v.c.

multipla X = (X1, …, Xn), la v.c. sintesi del campione ai fini della stima

T(X1, …, Xn)

sarà anch’essa una v.c., essendo a sua volta funzione di v.c. Per dare risalto a questo

aspetto diamo alcune definizioni.

Definizione 1: Definizione di statistica. Si dice statistica (dall’inglese statistic)

qualunque funzione

T(X1, …, Xn)

del c.c.s. X = (X1, …, Xn) (inteso come campione di v.c.) che non

contiene parametri incogniti. Il valore della statistica calcolato sui dati

campionari x = (x1, …, xn), cioè

T(x1, …, xn),

è detto valore campionario della statistica.

Definizione 2: Definizione di stimatore e di stima. Sia X è una v.c. con funzione di

massa o di densità f(x; θ), dove θ ∈ Θ è un parametro incognito, e sia X

= (X1, …, Xn) un c.c.s. estratto da X. Allora si dice stimatore qualunque

statistica

T(X1, …, Xn)

10

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

utilizzata per stimare θ. Il valore dello stimatore calcolato sui dati

campionari x = (x1, …, xn) al fine di stimare θ, cioè

T(x1, …, xn),

è detto stima.

Definizione 3: Distribuzione campionaria. Sia X una v.c. con funzione di massa o di

densità f(x; θ), dove θ ∈ Θ è un parametro incognito e sia T(X1, …, Xn)

una statistica calcolata sul c.c.s. X = (X1, …, Xn). Allora la distribuzione

della statistica T(X1, …, Xn) (che abbiamo già detto essere una v.c.) è

detta distribuzione campionaria della statistica.

Un commento sulle definizioni introdotte. Una statistica è una qualsiasi funzione T(X1,

…, Xn) del campione, mentre uno stimatore è un caso particolare di statistica quando

quest’ultima è utilizzata per stimare un certo parametro. Essendo funzioni di v.c., sia la

statistica che lo stimatore sono a loro volta v.c. e quindi hanno una certa distribuzione,

detta distribuzione campionaria. La differenza fra stimatore e stima è infine la seguente:

lo stimatore, essendo una funzione delle v.c. X = (X1, …, Xn) è a sua volta una v.c.; la

stima essendo una funzione dei numeri x = (x1, …, xn) è a sua volta un numero.

Ovviamente essendo x = (x1, …, xn) una particolare realizzazione di X = (X1, …, Xn),

anche la stima T(x1, …, xn) sarà una particolare realizzazione dello stimatore T(X1, …,

Xn). La legge di probabilità con cui la v.c. stimatore origina le singole stime è data dalla

distribuzione campionaria dello stimatore.

4. Proprietà di uno stimatore

Riassumiamo alcune considerazioni espresse finora. Data una v.c. X con funzione di

massa o di densità f(x; θ), la stima puntuale del un parametro incognito θ si ottiene

applicando una specifica funzione T(.) ai valori campionari. Tale stima, allora, varierà al

variare del campione secondo la legge di distribuzione f(x; θ) della popolazione cui il

campione si riferisce, ed è necessario fare riferimento a tale distribuzione per riuscire a

giudicare la “bontà” di una qualunque stima θ̂ = T(x1, ...,xn). Infatti, non è possibile

11

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

affermare se un singolo valore numerico, cioè se una particolare stima θ̂ è “buona” o

“cattiva”. Se da una parte è ragionevole ritenere che θ̂ è tanto più “buona” quanto più si

approssima al vero valore del parametro θ, dall’altra parte essendo tale valore incognito,

il confronto non è possibile: risulta, cioè, impossibile valutare la “bontà” di una singola

stima. Pertanto, è improprio parlare di stima “buona” o “cattiva”, si deve parlare invece

di stimatore “buono” o “cattivo”, intendendo, con ciò, fare riferimento al metodo di

stima impiegato le cui proprietà non sono valutabili facendo riferimento ad un singolo

campione ma all’universo di tutti i campioni possibili. Il confronto fra stimatori dovrà,

quindi, essere basato sul confronto tra le corrispondenti distribuzioni campionarie e, più

in particolare, fra particolari indici caratteristici delle distribuzioni campionarie.

Torniamo allora alla problematica generale della stima statistica puntuale. Sia X una

variabile casuale, discreta o continua, con funzione di massa o di densità f(x; θ),

caratterizzata dal parametro incognito θ ∈ Θ. Il problema della ricerca del ”miglior”

stimatore di θ si sostanzia nella individuazione della “migliore” funzione T(.) da

applicare al campione di cui si dispone. Qui di seguito si descrivono le principali

proprietà di uno stimatore. Esempi dei concetti introdotti saranno discussi nella sez. 4.5

e nella sez. 6 relativa ai metodi di stima.

4.1. Sufficienza

Relativamente alle proprietà “ottimali” di uno stimatore si deve, innanzi tutto, tenere

presente che la funzione T(.) opera una compattazione delle informazioni. Risulta,

pertanto ragionevole richiedere ad uno stimatore θ̂ = T(X1, …,Xn) di contenere il

massimo delle informazioni che il campione fornisce in merito al valore del parametro

incognito θ. Questa proprietà è esplicitata dalla definizione di sufficienza.

Definizione 4: Definizione di statistica sufficiente. Sia X una v.c. con funzione di

massa o di densità f(x; θ), dove θ ∈ Θ è un parametro incognito e sia X

= (X1, …, Xn) un c.c.s. estratto da X. Allora una statistica T(X1, …, Xn) è

12

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

sufficiente per θ sse la distribuzione del campione condizionata ad un

qualunque valore assunto dalla statistica T(.), cioè

f(x1, …, xn | T = t),

non dipende da θ.

Tale definizione risulta di interpretazione non immediata: cerchiamo di spiegarla. La

definizione dice che una statistica T è sufficiente per un certo parametro se nella

distribuzione del campione, una volta condizionati al valore della statistica, il parametro

scompare. In altri termini, ricordando l’interpretazione dell’evento condizionante come

“informazione”, T è sufficiente se, una volta calcolata e quindi conosciuta T, nel

campione stesso non rimane più alcuna informazione su θ che infatti scompare nella

distribuzione condizionata: tutto quello che c’era per risalire al parametro è stato

“spremuto” da T.

Il concetto di sufficienza può essere esteso da una statistica ad uno stimatore nel modo

seguente: è sufficiente lo stimatore basato su una statistica sufficiente. In questo caso

allora θ̂ contiene tutte le informazioni su θ contenute nel campione a disposizione.

Appare subito evidente che nei casi in cui esistono stimatori sufficienti, si dovrà

restringere la ricerca del miglior stimatore entro tale classe poiché, al di fuori di essa,

ogni altro stimatore avrebbe come conseguenza una mancata utilizzazione di

informazioni utili contenute nel campione.

Purtroppo la definizione di sufficienza è nella pratica di difficile utilizzazione per due

motivi:

1. la distribuzione condizionata di cui alla definizione spesso è tutt’altro che semplice

da ricavare;

2. la definizione richiede di avere già in testa una statistica T(.) e quindi di verificare se

questa è sufficiente o meno per il parametro; si presta invece poco alla ricerca di

statistiche sufficienti.

Questi due inconvenienti sono tuttavia superati da un importante risultato teorico noto

come criterio di fattorizzazione di Neyman-Fisher.

13

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

Teorema 1:

Criterio di fattorizzazione di Neyman-Fisher. Sia X una v.c. con

funzione di massa o di densità f(x; θ), dove θ ∈ Θ è un parametro

incognito e sia X = (X1, …, Xn) un c.c.s. estratto da X. Allora la statistica

T(X1, …, Xn) è sufficiente per θ sse vale la relazione:

f(x; θ) = g(T(x); θ) h(x)

dove: g(T(x); θ) è una funzione non negativa che dipende dal parametro e

dal campione solo attraverso la funzione T(.); h(x) è una funzione non

negativa degli elementi del campione.

Grazie a questo teorema, per trovare una statistica sufficiente basta riuscire a fattorizzare

la funzione di massa o di densità del campione nel modo indicato: uno dei fattori deve

dipendere solo dal parametro e da una certa statistica (che quindi sarà sufficiente per il

parametro); l’altro deve dipendere solo dal campione.

Tale teorema consente anche di fornire la seguente immagine del concetto di

sufficienza. Supponiamo che X sia effettivamente distribuito secondo la funzione di

massa o di densità f(x; θ) e che T(X) sia sufficiente per θ. In tale situazione supponiamo

poi di assegnare, come informazione per stimare θ, ad uno studente tutto il campione x =

(x1, …, xn) e all’altro (poverino!) la sola statistica T(x). Sembrerebbe questa una

discriminazione del secondo a favore del primo. Ciò è falso: infatti T(x) contiene tutta

l’informazione su θ che c’è nel campione, tanto che anche sapendo solo T(x) è possibile

scrivere la funzione di massa o di densità del campione. Il campione, quindi, non

contiene nient’altro su θ che, appunto, T(x) (paradossalmente è il secondo studente ad

essere avvantaggiato, dato che non deve neanche calcolarsi T(x)!).

Alcune precisazioni importanti.

1. La definizione di sufficienza e il criterio di fattorizzazione possono essere

banalmente estesi al caso in cui θ sia un vettore di parametri e/o T(X) un vettore di

statistiche (le dimensioni dei due vettori non necessariamente coincidono). In tal

caso le statistiche del vettore T(X), prese insieme, sono (congiuntamente) sufficienti

per θ.

14

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

2. Sulla base di quanto detto al punto precedente, l’intero campione X = (X1, …, Xn) è,

chiaramente, sempre sufficiente per θ, qualunque sia il modello scelto. E’ ovvio però

che in tale situazione il concetto di sufficienza è poco interessante per l’assenza di

compattazione delle informazioni fornita da tale statistica. I casi interessanti sono

quelli in cui esistono delle statistiche sufficienti di dimensione minore rispetto

all’intero campione.

3. Il criterio di fattorizzazione evidenzia che la sufficienza è una proprietà intrinseca

del modello. Infatti la funzione di massa o di densità del campione f(x; θ), che è

quella che viene fattorizzata nel teorema, segue direttamente dalla specificazione

della distribuzione della v.c. X data da f(x; θ).

4. Se T(.) è una statistica sufficiente (o un vettore di statistiche sufficienti), si può

facilmente dimostrare che qualsiasi trasformazione biunivoca di tale statistica (o

vettore di statistiche) è anch’essa sufficiente.

5. Nel criterio di fattorizzazione, se in luogo di f(x; θ) si considera il suo logaritmo

naturale lnf(x; θ), la scomposizione di tale funzione in due componenti funziona in

modo analogo, con la differenza che invece di moltiplicarsi si sommano. Infatti

ln f(x; θ) = ln[g(T(x); θ) h(x)] = ln g(T(x); θ) + ln h(x) = g1(T(x); θ) + h1 (x).

Questo significa che T(x) è sufficiente per θ sse ln f(x; θ) può essere scomposto nella

somma di due funzioni g1(T(x); θ) e h1(x), di cui: la prima dipende dal parametro e

dal campione solo attraverso la funzione T(.); la seconda dipende solo dagli elementi

del campione. Questa osservazione sarà utile negli esempi illustrati nella sezione

relativa ai metodi di stima.

4.2. Misure di errore: MSE e MAE

Oltre alla sufficienza, è ragionevole richiedere che le singole stime siano “più vicine

possibile” al parametro incognito da stimare. D’altra parte abbiamo già detto che, per

una serie di ragioni, il confronto deve essere fatto fra la v.c. stimatore θ̂ = T(X1, …, Xn)

e il parametro θ. Gli scostamenti fra lo stimatore θ̂ e il parametro incognito θ, possono

essere espressi dalla differenza in valore assoluto |θˆ – θ | o dalla differenza al quadrato

( θˆ – θ)2. D’altra parte poiché θ̂ è una v.c., anche |θˆ – θ | e ( θˆ – θ)2 lo sono, motivo per

15

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

il quale tali differenze vengono di norma sintetizzate prendendone il valore atteso. Si

ricavano allora le seguenti misure di errore fra stimatore e parametro:

MAE( θˆ ; θ) = E[|θˆ – θ |];

MSE( θˆ ; θ) = E[( θˆ – θ)2].

L’acronimo MAE sta per Mean Absolute Error o errore assoluto medio; l’acronimo

MSE significa invece Mean Squared Error o errore quadratico medio. Come già

evidenziato, tali misure di errore non sono v.c., poiché è stato applicato l’operatore di

valore atteso; è opportuno tuttavia aggiungere che in generale dipendono da θ, dato che

il valore del parametro è incognito. Sulla base di tali misure di errore è ragionevole

definire uno stimatore migliore di un altro, rispetto ad una certa misura di errore, se la

misura di errore del primo è inferiore alla corrispondente misura di errore del secondo

qualunque sia il valore del parametro.

Definizione 5: Definizione di efficienza relativa. Lo stimatore θˆ1 è più efficiente nel

MAE rispetto a θˆ2 se

MAE( θˆ1 ; θ) ≤ MAE( θˆ2 ; θ) per qualunque θ ∈ Θ ;

lo stimatore θˆ1 è più efficiente nel MSE rispetto a θˆ2 se

MSE( θˆ1 ; θ) ≤ MSE( θˆ2 ; θ)

per qualunque θ ∈ Θ .

Seppure importante per stabilire il migliore fra due stimatori dati, all’atto pratico è

auspicabile stimare θ col migliore stimatore possibile in assoluto. E’ allora opportuno

introdurre anche un concetto di efficienza in senso assoluto.

Definizione 6: Definizione di efficienza assoluta. Lo stimatore θˆ * è il più efficiente

nel MAE se per ogni altro stimatore θˆ

MAE( θˆ * ; θ) ≤ MAE( θˆ ; θ)

per qualunque θ ∈ Θ ;

lo stimatore θˆ * è il più efficiente nel MSE se per ogni altro stimatore

θˆ

MSE( θˆ * ; θ) ≤ MSE( θˆ ; θ)

16

per qualunque θ ∈ Θ .

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

Per quanto ragionevole dal punto di vista logico, nella pratica la ricerca dello stimatore

in assoluto più efficiente (nel MAE o nel MSE) si scontra però con un problema non di

poco conto: in genere tale stimatore ottimale non esiste (eccetto in casi particolari un po’

artificiosi)! Questo perché (come è ragionevole fare) nella definizione si richiede che

l’indice di errore sia inferiore per qualunque θ ∈ Θ , mentre la situazione comune è

quella nella quale non esiste uno stimatore che minimizza il MAE o il MSE per

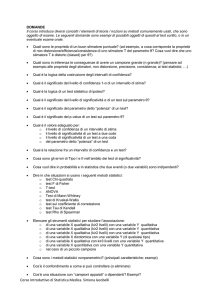

qualunque valore di θ. E’ facile rendersi conto di ciò se si pensa al seguente stimatore di

θ:

T(X1, …, Xn) = 3.

E’ chiaro che un tale stimatore è assolutamente “stupido”: infatti stima il parametro

incognito sempre con 3, ignorando completamente l’informazione contenuta nel

campione. D’altra parte quando θ è effettivamente 3 (o comunque nei dintorni di 3) è

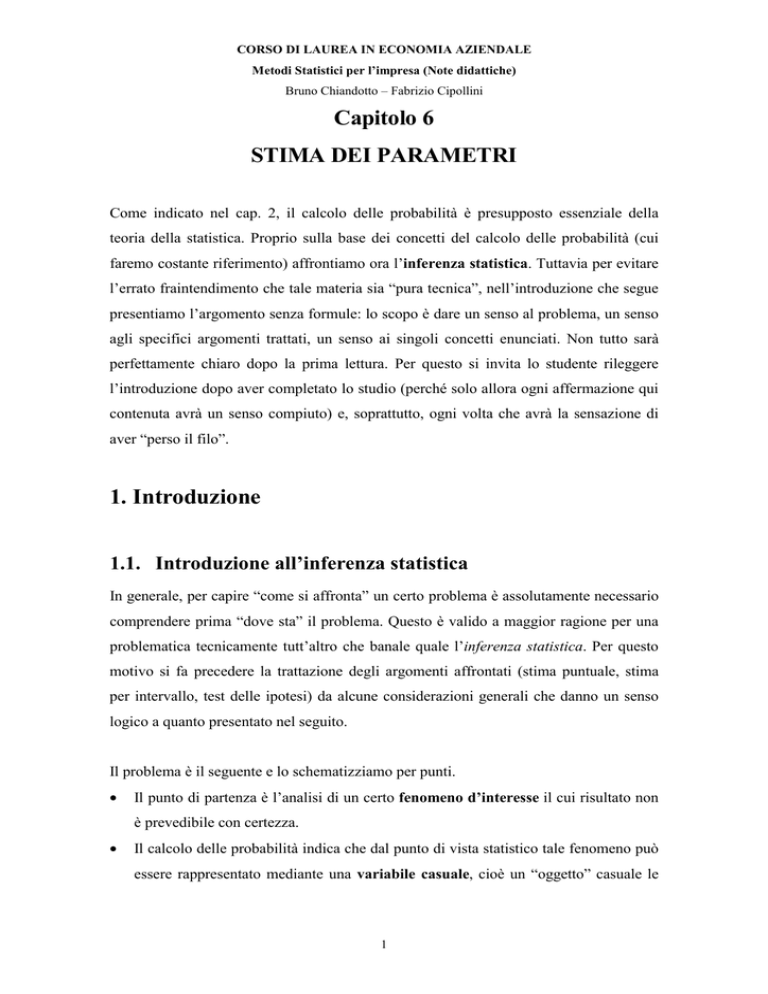

impossibile fare meglio dello stimatore “stupido” indicato (Fig. 1). In generale altri

stimatori avranno un MAE o un MSE più piccolo dello stimatore di cui sopra ma non per

i θ “vicini” a 3. Poiché di stimatori “stupidi” come quello indicato se ne possono

costruire infiniti (uno per ogni valore di θ), da questo ragionamento si evince che in

generale lo stimatore più efficiente in assoluto, nel senso del MAE o del MSE, non

esiste.

In tali situazioni, allora, si dovrà abbandonare l’obiettivo della ricerca dell’ottimo (non

esistendo un ottimo!) per procedere, eventualmente, alla ricerca di un sub-ottimo. Si

può, ad esempio, procedere alla ricerca di uno stimatore puntuale capace di minimizzare

il MAE o il MSE in un insieme ristretto di stimatori (minimo vincolato) essendo

ragionevole ipotizzare l’esistenza di un ottimo in una classe ristretta. Questo aspetto è

approfondito nella seguente sezione.

17

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

8

7

6

5

4

3

2

1

0

-1

-1 0

1

2

3

4

5

6

7

Fig. 1 – Andamento del MSE per tre diversi stimatori di θ > 0: θˆ1 (tratto rosa), θˆ2

(tratto verde), θˆ3 (tratto blu). θˆ1 è più efficiente di θˆ2 ma non di θˆ3 , nonostante

quest’ultimo sia lo “stimatore stupido”.

4.3. Correttezza

Sviluppiamo il ragionamento conclusivo della sezione precedente con riferimento alla

misura di errore MSE. Il MSE, infatti, rispetto al MAE è più facile da trattare dal punto

di vista matematico. Più in particolare il MSE può essere scomposto nel modo seguente:

MSE( θˆ ; θ) = V( θˆ ) + bias( θˆ ; θ)2,

dove V( θˆ ) è la varianza dello stimatore θˆ e bias( θˆ ; θ) = E( θˆ ) – θ è la distorsione

dello stimatore. La scomposizione si ricava facilmente sommando e sottraendo E( θˆ )

nella definizione e poi applicando le proprietà dei valori attesi (si ricorda che θ ed E( θˆ )

sono costanti!) :

MSE( θˆ ; θ) = E[( θˆ – θ)2] = E[( θˆ – E( θˆ ) + E( θˆ ) – θ)2] = E[ ( θˆ – E( θˆ ))2 + (E( θˆ ) – θ)2

+ 2 ( θˆ – E( θˆ ))(E( θˆ ) – θ) ] = E[( θˆ – E( θˆ ))2] + E[(E( θˆ ) – θ)2] + 2 [E( θˆ ) – θ] E[ θˆ –

E( θˆ )] = V( θˆ ) + [E( θˆ ) – θ)2] + 2 [E( θˆ ) – θ] [E( θˆ ) – E( θˆ )] = V( θˆ ) + bias( θˆ ; θ)2 + 0

Tornando al risultato di cui sopra, il MSE di uno stimatore può essere quindi scomposto

18

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

nella somma di due componenti: la varianza dello stimatore, V( θˆ ) e il quadrato della

distorsione, bias( θˆ ; θ)2 = [E( θˆ ) – θ]2. Poiché, come detto, in generale non esiste lo

stimatore con il MSE più piccolo per ogni θ fra tutti gli stimatori, può valere la pena di

limitare la ricerca dello stimatore migliore ad un insieme ristretto di stimatori. In

particolare si può cercare nell’ambito degli stimatori con distorsione pari a 0, per i quali,

si vede facilmente, il MSE è uguale alla varianza dello stimatore.

Definizione 7: Definizione di correttezza. Uno stimatore θ̂ di θ si dice corretto o

non distorto se

E( θ̂ ) = θ

per qualunque θ ∈ Θ .

Da questa definizione segue allora immediatamente che se uno stimatore θ̂ è corretto

relativamente a θ allora:

1. la sua distorsione è 0, cioè bias( θˆ ; θ) = 0 (da questo deriva l’espressione non

distorto);

2. il suo MSE e la sua varianza coincidono, cioè

MSE( θˆ ; θ) = V( θˆ );

pertanto nella classe ristretta degli stimatori corretti lo stimatore più efficiente nel

MSE è lo stimatore di minima varianza. Quest’ultima conclusione provoca spesso

confusione inducendo a concludere che lo stimatore più efficiente è lo stimatore di

minima varianza; si tratta, ovviamente, di una conclusione errata perché

l’affermazione vale solo nell’ambito degli stimatori corretti.

Torniamo ora al problema da cui si è partiti. Si è detto ripetutamente che lo stimatore

più efficiente in assoluto, sia nel senso del MAE che del MSE, di norma non esiste.

Ebbene, è possibile dimostrare che, per certi modelli, esiste invece lo stimatore più

efficiente nel MSE se si limita la ricerca alla classe degli stimatori corretti. Tuttavia

poiché la teoria sottostante è eccessivamente complessa per i fini di questo corso non la

vedremo. Ci limitiamo ad aggiungere tre considerazioni.

19

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

1. La prima è che l’effetto pratico del vincolo di correttezza è, come è ovvio, quello di

eliminare tutti gli stimatori distorti, fra i quali sono compresi anche gli “stimatori

stupidi”.

2. La seconda è che, nell’ambito della teoria relativa alla ricerca del migliore stimatore

corretto, gioca un ruolo fondamentale il concetto di sufficienza visto in precedenza.

3. La terza, a fini pratici più importante, è legata ad un risultato teorico di importanza

fondamentale noto come limite di Cramèr-Rao.

Teorema 2:

Limite di Cramèr-Rao. Sia X una v.c. con funzione di massa o di

densità f(x; θ), dove θ ∈ Θ è un parametro incognito, e supponiamo che

f(x; θ) soddisfi certe condizioni di regolarità. Sia poi X = (X1, …, Xn) un

c.c.s. estratto da X. Allora se θˆ è uno stimatore corretto di θ, la varianza

di θˆ non può essere minore di un certa soglia minima:

V( θˆ ) ≥ 1/I(θ),

dove

ds (θ )

I(θ) = E[s(θ)2] = –E

dθ

è detta informazione di Fisher.

In parole, questo teorema dice che la varianza di uno stimatore corretto non può

scendere sotto il reciproco dell’informazione di Fisher. L’utilità del teorema è la

seguente. Se si prende uno stimatore θˆ e si verifica che è corretto, allora si calcola la

sua varianza V( θˆ ) (che per la correttezza coincide col suo MSE), poi l’informazione di

Fisher I(θ) e quindi il suo reciproco 1/I(θ): se si nota che V( θˆ ) = 1/I(θ) allora è

impossibile fare meglio (fra quelli corretti) dello stimatore considerato, perché sotto

1/I(θ) non si può scendere. E’ ovvio però che con questo criterio, se viene V( θˆ ) > 1/I(θ),

allora non è possibile sapere se esiste un altro stimatore corretto con varianza più

piccola di quello trovato.

Purtroppo un limite di questa teoria è dato dal fatto che per molti modelli non esiste lo

20

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

stimatore più efficiente nel MSE neppure nella classe degli stimatori corretti. Inoltre per

molti modelli risulta perfino impossibile determinare E( θ̂ ) e di conseguenza anche

V( θˆ ) e MSE( θˆ ; θ). E questo rende a sua volta impossibile la ricerca dello stimatore più

efficiente nel MSE di cui si è discusso finora.

4.4. Consistenza

Anche dal punto di vista intuitivo, è facile rendersi conto che al crescere della

dimensione del campione cresce anche la quantità di informazione a disposizione. E’

quindi ragionevole richiedere ad uno stimatore che al crescere della dimensione

campionaria n debba anche crescere la “precisione” dello stimatore nello stimare il

parametro. Questo concetto è precisato dalla proprietà di consistenza. Per esplicitare il

fatto che questa proprietà è legata alla dimensione del campione aggiungiamo l’indice n

allo stimatore, scrivendo θˆn al posto di θˆ .

Definizione 8: Definizione di consistenza debole. Uno stimatore θˆn di θ è

consistente in senso debole se

lim P(|θˆn – θ | < ε) = 1

n→∞

per qualunque θ ∈ Θ e per qualunque ε > 0 piccolo a piacere.

Definizione 9: Definizione di consistenza forte. Uno stimatore θˆn di θ è consistente

in senso forte se

lim MSE( θˆn ; θ) = 0

n→∞

per qualunque θ ∈ Θ.

Relativamente alla consistenza forte, grazie alla scomposizione

MSE( θˆn ; θ) = V( θˆn ) + bias( θˆn ; θ)2

vista in precedenza, è possibile dedurre che, per n → ∞, MSE( θˆn ; θ) tende a 0 sse

tendono a 0 le sue due componenti (entrambe non negative) V( θˆn ) e bias( θˆn ; θ).

21

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

Quindi se la varianza e la distorsione di uno stimatore tendono entrambi a 0 allora lo

stimatore è consistente in senso forte e, viceversa, se lo stimatore è consistente in senso

forte allora la sua varianza e la sua distorsione tendono a 0. Uno stimatore la cui

distorsione tende a 0 è detto asintoticamente corretto, e per esso vale

lim E( θˆn ) = θ

n→∞

per qualunque θ ∈ Θ.

E’ possibile inoltre dimostrare che la consistenza forte implica la consistenza debole.

Questo fatto è una banale conseguenza del teorema di Markov (cap. 2): basta porre nel

teorema indicato, X = θˆn , g(X) = |θˆn – θ |, c = ε:

P(|θˆn – θ | ≥ ε) = P(( θˆn – θ ) 2 ≥ ε2) ≤

[(

E θˆn − θ

ε2

)]= MSE (θˆn ,θ )→ 0,

ε2

da cui P(|θˆn – θ | < ε) = → 1.

Infine un’ultima nota. Per certi aspetti, la consistenza è la proprietà più importante fra

quelle viste. Possiamo argomentare questa affermazione in due sensi. Primo: se uno

stimatore è consistente non è detto che sia buono, ma sicuramente uno stimatore non

consistente è da buttare. Secondo: come affermato alla fine della sez. 4.3, per la maggior

parte dei modelli statistici (fanno eccezione quelli più semplici) è impossibile

determinare valore atteso, varianza e quindi anche MSE degli stimatori considerati. Le

proprietà asintotiche, e in particolare quelle relative alla consistenza, sono invece assai

più facili da ricavare e spesso sono anche le uniche disponibili (si veda al proposito

l’esempio in sez. 5.1.5).

4.5. Un esempio

Proviamo ad illustrare alcuni dei concetti presentati in questa sez. 4 mediante un

esempio. L’esempio è per la verità un po’ artificiale ma può comunque dare un senso a

quanto visto in questa sezione. Esempi più realistici saranno presentati nella sezione che

segue.

22

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

Si considerino 6 palline identiche a meno dei numeri su di esse riportati: {1, 1, 1, 3,

3, 9}. La funzione di massa della v.c. X = “risultato dell’estrazione di una pallina” è

allora data da

x =1

1 / 2

1 / 3

x=3

f(x) =

x=9

1 / 6

0 altrimenti

Per tale v.c. è facile derivare i principali momenti (si veda cap. 2). Il seguente prospetto

riassume il calcolo di µ = E(X) = 3 e σ2 = V(X) = E(X2) – E(X)2 = 17 – 32 = 8.

x

1

3

9

f(x)

x f(x)

1/2

1/2

1/3

1

1/6

3/2

1

3

Tabella 1 – Prospetto di calcolo di E(X) e V(X).

x2 f(x)

1/2

3

27/2

17

Si considerino ora tutti i possibili campioni x = (x1, x2) di dimensione n = 2 che possono

essere estratti con reimmissione dalla v.c. in oggetto. La “lista” di questi campioni

forma l’universo dei campioni che possono essere estratti dalla v.c. X. L’universo dei

campioni può a sua volta essere rappresentato dalla v.c. doppia X = (X1, X2), i cui valori

e la cui distriuzione sono riportati nella seguente tabella (la probabilità di ciascuna

coppia è semplicemente il prodotto delle probabilità dei singoli, dato che le estrazioni

sono indipendenti).

x = (x1, x2) (1,1) (1,3) (1,9) (3,1) (3,3) (3,9) (9,1) (9,3) (9,9) tot

f(x)

1/4

1/6 1/12 1/6

1/9 1/18 1/12 1/18 1/36

1

Tabella 2 – Funzione di massa della v.c. doppia X = (X1, X2).

A questo punto, ogni statistica calcolata su X = (X1, X2) è una v.c. e ha di conseguenza

una sua distribuzione campionaria. Consideriamo ora alcune statistiche e proviamo a

determinarne la distribuzione campionaria.

23

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

•

Media campionaria: X = (X1 + X2)/2 (per la formula generale si veda sez. 5.1)

La seguente tabella riporta, per ogni campione, la relativa media campionaria con la

sua probabilità

x = (x1, x2) (1,1) (1,3) (1,9) (3,1) (3,3) (3,9) (9,1) (9,3) (9,9) tot

f(x)

1/4

x

1

1/6 1/12 1/6

2

5

1/9 1/18 1/12 1/18 1/36

2

3

6

5

6

1

9

Tabella 3 – Prospetto per la costruzione della funzione di massa della media

campionaria.

Da tale tabella si ricava facilmente la funzione di massa della media campionaria,

nella quale si sommano le probabilità relative alle coppie di valori che danno luogo

alla stessa media.

x

1

2

3

5

f( x )

1/4

1/3

1/9

1/6

6

9

tot

1/9 1/36

1

Tabella 4 – Funzione di massa della media campionaria X .

Utilizzando un prospetto di calcolo simile a quello utilizzato per calcolare i

momenti di f(x), si può verificare che E( X ) = 3 e V( X ) = 4 [si invita lo studente a

farlo]. Questo significa che X è uno stimatore corretto di µ e che anche il suo MSE

è 4.

•

Varianza campionaria corretta: S2 = [(X1 – X )2 + (X2 – X )2]/(2 – 1) (per la

formula generale si veda sez. 5.1)

La seguente tabella riporta, per ogni campione, la relativa varianza campionaria

corretta con la sua probabilità

x = (x1, x2) (1,1) (1,3) (1,9) (3,1) (3,3) (3,9) (9,1) (9,3) (9,9) tot

f(x)

1/4

s2

0

1/6 1/12 1/6

2

32

1/9 1/18 1/12 1/18 1/36

2

0

18

32

18

1

0

Tabella 5 – Prospetto per la costruzione della funzione di massa della varianza

campionaria corretta.

24

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

Da tale tabella si ricava facilmente la funzione di massa della varianza campionaria

corretta, nella quale si sommano le probabilità relative alle coppie di valori che

danno luogo alla stessa varianza.

s2

0

f(s2)

2

7/18 1/3

18

32

tot

1/9

1/6

1

Tabella 6 – Funzione di massa della varianza campionaria corretta S2.

Utilizzando un prospetto di calcolo simile a quello utilizzato per calcolare i

momenti di f(x), si può verificare che E(S2) = 8 e V(S2) = 144 [si invita lo studente a

farlo]. Questo significa che S2 è uno stimatore corretto di σ2 e che anche il suo MSE

è 144.

•

Minimo campionario: x(1) = min{X1, X2}

La seguente tabella riporta, per ogni campione, il relativo minimo campionario con

la sua probabilità

x = (x1, x2) (1,1) (1,3) (1,9) (3,1) (3,3) (3,9) (9,1) (9,3) (9,9) tot

f(x)

1/4

x(1)

1

1/6 1/12 1/6

1

1

1/9 1/18 1/12 1/18 1/36

1

3

3

1

3

1

9

Tabella 7 – Prospetto per la costruzione della funzione di massa del minimo

campionario.

Da tale tabella si ricava facilmente la funzione di massa del minimo campionario,

nella quale si sommano le probabilità relative alle coppie di valori che danno luogo

allo stesso minimo.

x(1)

1

f(x(1))

3/4

3

9

2/9 1/36

tot

1

Tabella 8 – Funzione di massa del minimo campionario x(1).

Utilizzando un prospetto di calcolo simile a quello utilizzato per calcolare i

momenti di f(x), si può verificare che E(x(1)) = 1. 6 e V(x(1)) = 2. 2 [si invita lo

25

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

studente a farlo]. Questo significa che x(1) è uno stimatore distorto del minimo della

v.c. X, che è 1, e che MSE(x(1), min) = 2. 2 + (1. 6 – 1)2 = 2. 6 .

•

Massimo campionario: x(2) = max{X1, X2}

La seguente tabella riporta, per ogni campione, il relativo massimo campionario con

la sua probabilità

x = (x1, x2) (1,1) (1,3) (1,9) (3,1) (3,3) (3,9) (9,1) (9,3) (9,9) tot

f(x)

1/4

x(2)

1

1/6 1/12 1/6

3

9

1/9 1/18 1/12 1/18 1/36

3

3

9

9

9

1

9

Tabella 9 – Prospetto per la costruzione della funzione di massa del massimo

campionario.

Da tale tabella si ricava facilmente la funzione di massa del massimo campionario,

nella quale si sommano le probabilità relative alle coppie di valori che danno luogo

allo stesso massimo.

x(2)

1

3

9

tot

f(x(2))

1/4

4/9

11/36

1

Tabella 10 – Funzione di massa del massimo campionario x(2).

Utilizzando un prospetto di calcolo simile a quello utilizzato per calcolare i

momenti di f(x), si può verificare che E(x(2)) = 4. 3 e V(x(2)) = 10. 2 . [si invita lo

studente a farlo]. Questo significa che x(2) è uno stimatore distorto del massimo

della v.c. X, che è 9, e che MSE(x(2), min) = 10. 2 + (4. 3 – 10)2 = 42. 3 .

5. Metodi di stima puntuale

Le proprietà di uno stimatore sono importanti perché specificano quali sono le

caratteristiche desiderabili: uno stimatore con proprietà migliori di un altro è

chiaramente preferibile. D’altra parte le proprietà indicate non dicono molto circa il

problema come fare a trovare uno stimatore (magari anche “buono”). Infatti,

riprendendo alcune considerazioni già fatte:

26

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

•

la ricerca di stimatori sufficienti, seppur importante dal punto di vista della sintesi

delle informazioni, non dice molto circa la capacità dello stimatore di “andare

vicino” al parametro incognito;

•

la ricerca dello stimatore che minimizza il MAE o il MSE per ogni valore del

parametro non ha soluzione;

•

la ricerca dello stimatore che minimizza il MSE nella classe dei soli stimatori

corretti ha soluzione solo in casi relativamente semplici (oltre al fatto di essere assai

complessa);

•

infine le proprietà di correttezza non fanno alcun riferimento al “come fare” per

trovare degli stimatori.

Per questi motivi occorre allora trattare i metodi di stima puntuale proposti in letteratura

verificando se, ed in quali condizioni operative, producono stimatori che soddisfano le

proprietà indicate.

In letteratura sono stati proposti molti metodi di stima, ciascuno adatto in specifici

contesti. Ne ricordiamo i principali:

1. Metodo della massima verosimiglianza

2. Metodo della minima perdita (il caso più importante, ma non l’unico, è il metodo

dei minimi quadrati che vedremo in particolare nell’ambito del modello di

regressione)

3. Metodo dei momenti

4. Metodo degli stimatori analoghi

5. Metodo del minimo Chi-quadrato

6. Metodo della minima distanza

5.1. Massima verosimiglianza

Il metodo di gran lunga più rilevante fra quelli menzionati è metodo della massima

verosimiglianza. La sua importanza è dovuta:

1. alle particolari proprietà di cui godono gli stimatori ottenuti con tale metodo;

2. alla generalità e alla relativa semplicità del metodo dal punto di vista del calcolo (per

poterlo applicare basta che si riesca a calcolare la verosimiglianza);

27

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

3. alla notevole diffusione del metodo, peraltro legata ai due punti precedenti:

possiamo stimare che circa l’85-90% dei modelli sono stimati con tale metodo.

In questa sezione si descrivono le principali caratteristiche del metodo della massima

verosimiglianza. Questa trattazione ci consentirà anche, attraverso gli esempi, di

illustrare concretamente quanto visto nella precedente sez. 4 circa le proprietà degli

stimatori.

5.1.1. Descrizione del metodo

Data una v.c. X, con funzione di massa o di densità, f(x; θ), e un c.c.s. X = (X1, …, Xn)

estratto da X, abbiamo già detto che la distribuzione del campione X = (X1, …, Xn) è data

dalla funzione di massa o di densità

f(x1, …, xn; θ) =

n

∏ f(xi; θ).

i=1

Ovviamente, in quanto funzione di massa o di densità f(x1, …, xn; θ) è una funzione

delle osservazioni del campione x = (x1, …, xn) per un certo θ fissato.

La verosimiglianza L(θ) è la funzione di massa o di densità del campione X = (X1, …,

Xn) vista però come funzione del parametro per fissato il campione, cioè

L(θ) = f(x1, …, xn; θ) =

n

∏ f(xi; θ).

i=1

Pertanto la verosimiglianza coincide in termini formali con la funzione di massa o di

densità del campione; si tratta infatti della stessa espressione interpretata:

1. come funzione degli elementi campionari x = (x1, …, xn) (funzione di massa o di

densità) che variano nell'universo dei campioni per θ fissato;

2. come funzione del parametro θ per un campione x = (x1, …, xn) prefissato.

Nella prima interpretazione (a priori), si fa riferimento all’universo dei campioni e le

variabili che interessano sono, appunto, le variabili casuali campionarie (X1, …, Xn).

Nella seconda interpretazione (a posteriori), le variabili campionarie hanno assunto

particolari determinazioni (x1, …, xn) (il campione) e sono, pertanto, costanti note;

risulta, allora, ragionevole interpretare l’espressione come funzione del parametro (o dei

parametri) θ che, pur essendo una costante, assume la veste di variabile essendo

28

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

incognito il suo valore.

~

Il metodo di stima della massima verosimiglianza consiste nello scegliere il valore θ

che massimizza la funzione L(θ). Se L(θ) è una funzione differenziabile, condizione

necessaria affinché essa abbia un massimo rispetto a θ è che

dL(θ )

= 0.

dθ

D’altra parte fare la derivata di L(θ) comporta, sulla base dell’espressione di cui sopra,

n

fare la derivata del prodotto

∏ f(xi; θ), cosa in generale abbastanza fastidiosa per le

i=1

note caratteristiche della derivazione di un prodotto. Per questo motivo, in genere si

preferisce massimizzare non la verosimiglianza L(θ) ma il logaritmo naturale della

verosimiglianza

l(θ) = ln L(θ) =

n

∑

ln f(xi; θ)

i=1

detto log-verosimiglianza. Essendo il logaritmo naturale una funzione monotona, è

~

garantito che il θ che massimizza la log-verosimiglianza l(θ) è identico a quello che

massimizza la verosimiglianza L(θ).

Di nuovo, se la log-verosimiglianza l(θ) è una funzione differenziabile allora condizione

necessaria affinché abbia un massimo è

s(θ) =

dl (θ )

= 0.

dθ

La derivata prima della log-verosimiglianza s(θ) è spesso indicata col termine score; di

conseguenza, se la log-verosimiglianza è differenziabile allora condizione necessaria

affinché abbia un massimo è che lo score sia 0.

Si nota come l’applicazione del logaritmo ha trasformato un prodotto in una somma,

decisamente più facile da derivare dato che in generale “la derivata di una somma è la

somma delle derivate”; il altre parole lo score è dato in generale da

s(θ) =

dl (θ )

=

dθ

n

∑

i=1

29

d

ln f(xi; θ).

dθ

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

~

Il valore θ che massimizza la verosimiglianza o la log-verosimiglianza è detto stima di

massima verosimiglianza del parametro incognito θ. Se nella soluzione si sostituiscono

alle determinazioni (x1, ..., xn) le corrispondenti variabili casuali (X1, ..., Xn) si ottengono

gli stimatori di massima verosimiglianza.

Ovviamente se la distribuzione della variabile casuale X, è caratterizzata da più

parametri θ1, ..., θk, per trovare il massimo occorrerà uguagliare a 0 ciascuna delle

derivate parziali rispetto ad ogni singolo parametro (lo score è quindi un vettore a k

componenti, una per ogni parametro incognito) e poi ricavare la stima dei parametri

facendo il sistema fra le equazioni ottenute.

Vediamo ora in alcuni esempi semplici come funziona il metodo della massima

verosimiglianza e le caratteristiche degli stimatori ottenuti con tale metodo. [Anche se

ad una prima lettura questo materiale sembra “vasto”, lo schema di ragionamento

seguito è sempre lo stesso e si basa su quanto esposto nelle sezioni precedenti. Si

consiglia lo studente di provare da solo, con carta e penna, a ricostruire il filo logico

degli argomenti presentati].

5.1.2. Esempio X ~ Be(p)

Se si ipotizza che la v.c. X ~ Be(p), allora la log-verosimiglianza è data da

n

l(p) =

∑

n

ln f(xi; p) =

i=1

∑

ln ( p xi q1− xi )

i=1

che dopo alcune semplificazioni diviene

n

l(p) = ln p ∑ xi + ln q (n –

i=1

n

∑

xi).

i=1

Derivando l(p) rispetto a p per ottenere lo score ed uguagliando a 0 si ottiene

1

s(p) =

p

n

∑

i=1

1

xi –

(n –

q

n

∑

xi) = 0.

i=1

Risolvendo tale equazione rispetto a p si ricava dopo alcuni passaggi che la stima di

massima verosimiglianza di p è

30

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

1

~

p =

n

n

∑

xi = x .

i=1

Questo significa che lo stimatore di massima verosimiglianza di p è

1

~

p = X =

n

n

∑

Xi,

i=1

detta media campionaria. Poiché ciascuna Xi è una Be(p), allora essa risulterà 0

n

(INSUCCESSO) o 1 (SUCCESSO); ne consegue che

∑

Xi sarà semplicemente la

i=1

somma degli 1, cioè la somma dei successi nel campione, e X =

1

n

n

∑

Xi sarà

i=1

semplicemente la proporzione di successi nel campione.

Ma quali proprietà ha lo stimatore ottenuto?

•

n

Da come è scritta la log-verosimiglianza si nota subito che

∑

Xi (e qualsiasi altra

i=1

trasformazione biunivoca della stessa) è una statistica sufficiente per p. Di

conseguenza ~

p = X è uno stimatore sufficiente, essendo funzione di tale statistica

sufficiente.

•

In secondo luogo la distribuzione campionaria di ~

p = X può essere ricavata sulla

base di quanto detto nel cap. 2 sulla distribuzione Binomiale [rivedere!]. Infatti: Xi ~

Be(p) ⇒

n

∑

i=1

1

Xi ~ Bi(n, p) ⇒ ~

p = X =

n

n

∑

Xi ~ BiRe(n, p). Dunque ~

p = X si

i=1

distribuisce, esattamente, come una Binomiale con parametri n e p, relativizzata per

il numero di osservazioni del campione. Tale distribuzione per n sufficientemente

grande può essere approssimata con la distribuzione Normale avente la stessa media

(p) e la stessa varianza (pq/n) della Binomiale relativa. In simboli

~

p = X ~ BiRe(n, p) ≈ N(µ = p, σ2 = pq/n).

•

Quanto detto permette di ottenere immediatamente i principali indici caratteristici

della distribuzione campionaria di ~

p = X . Infatti, per le proprietà della Binomiale

relativa (menzionate sopra),

31

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

E( X ) = p,

V( X ) = pq/n.

Su questa base si vede subito che X è uno stimatore corretto di p e che, quindi, il

suo MSE( X ; p) coincide con la varianza dello stimatore.

•

Calcoliamo ora il limite di Cramér-Rao. Ricordando la formula dello score, le

n

∑

proprietà dei valori attesi e il fatto che, essendo

i=1

n

Xi ~ Bi(n, p), E( ∑ Xi) = np,

i=1

allora

ds ( p )

= –E(–p–2

I(p) = –E

dp

n

∑

n

∑

–2

Xi – q (n –

i=1

Xi)) = p–2 n p + q–2 (n – np) =

i=1

n/pq,

da cui

1/I(p) = pq/n

che è identico a V( X ) (vedi sopra). Questo significa che X è in assoluto lo

stimatore migliore di p nella classe degli stimatori corretti.

•

Da quanto detto sopra consegue che X è consistente in senso forte per p, dato che

MSE( X ; p) = pq/n tende a 0 per n → ∞. Poiché la consistenza forte implica quella

debole, X è anche consistente in senso debole per p.

5.1.3. Esempio X ~ Po(λ)

Se si ipotizza che la v.c. X ~ Po(λ) allora la log-verosimiglianza è data da

l(λ) =

n

∑

ln f(xi; λ) =

i=1

n

∑

ln

i=1

λ xi e −λ

xi !

che dopo alcune semplificazioni diviene

n

l(λ) = ln λ ∑ xi – nλ –

i=1

n

∑

ln xi!

i=1

Derivando rispetto a λ per ottenere lo score ed uguagliando a 0 si ottiene

s(λ) =

1

λ

n

∑

xi – n = 0.

i=1

Risolvendo tale equazione rispetto a λ, si ricava che la stima di massima vero-

32

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

simiglianza di λ è

~ 1

λ =

n

n

∑

xi = x .

i=1

Questo significa che lo stimatore di massima verosimiglianza di λ è

~

1

λ = X =

n

n

∑

Xi,

i=1

di nuovo la media campionaria.

Ma quali proprietà ha lo stimatore ottenuto?

•

n

Da come è scritta la log-verosimiglianza si nota subito che

∑

Xi (e qualsiasi altra

i=1

trasformazione biunivoca della stessa) è una statistica sufficiente per λ. Di

~

conseguenza λ = X è uno stimatore sufficiente, essendo funzione di tale statistica

sufficiente.

•

~

In secondo luogo la distribuzione campionaria di λ = X può essere ricavata sulla

base di quanto detto nel cap. 2 sulla distribuzione Poisson [rivedere!]. Infatti: Xi ~

n

~

Po(λ) ⇒ (additività per v.c. Poisson indipendenti) ∑ Xi ~ Po(nλ) ⇒ λ = X =

i=1

1

n

n

∑

~

Xi ~ PoRe(nλ). Dunque λ = X si distribuisce, esattamente, come una

i=1

Poisson con parametro nλ, relativizzata per il numero di osservazioni del campione.

Tale distribuzione per n sufficientemente grande può comunque essere approssimata

con la distribuzione Normale avente la stessa media (λ) e la stessa varianza (λ/n)

della Poisson Relativa. In simboli

~

λ = X ~ PoRe(nλ) ≈ N(µ = λ, σ2 = λ/n).

•

Quanto detto permette di ottenere immediatamente i principali indici caratteristici

~

della distribuzione campionaria di λ = X . Infatti per le proprietà della Poisson

relativa (menzionate sopra)

E( X ) = λ,

V( X ) = λ/n.

33

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

Su questa base si vede subito che X è uno stimatore corretto di λ e che, quindi, il

suo MSE( X ; λ) coincide con la varianza dello stimatore.

•

Calcoliamo ora il limite di Cramér-Rao. Ricordando la formula dello score, le

n

proprietà dei valori attesi e il fatto che, essendo

∑

i=1

n

Xi ~ Po(nλ), E( ∑ Xi) = nλ,

i=1

allora

ds (λ )

–2

I(λ) = –E

= –E(–λ

dλ

n

∑

Xi) = λ–2 n λ = n/λ,

i=1

da cui

1/I(λ) = λ/n

che è identico a V( X ) (vedi sopra). Questo significa che X è in assoluto lo

stimatore migliore di λ nella classe degli stimatori corretti.

•

Da quanto detto sopra consegue che X è consistente in senso forte per λ, dato che

MSE( X ; λ) = λ/n tende a 0 per n → ∞. Poiché la consistenza forte implica quella

debole, X è anche consistente in senso debole per λ.

5.1.4. Esempio X ~ N(µ, σ2)

Se si ipotizza che la v.c. X ~ N(µ, σ2) allora la log-verosimiglianza è data da

l(µ, σ2) =

n

∑

ln f(xi; µ, σ2) =

i=1

n

∑

i=1

1

1 x − µ 2

ln

exp − i

2

2 σ

2πσ

che dopo alcune semplificazioni diviene

l(µ, σ2) = –

1

n

n

ln(2π) – lnσ2 –

2

2

2σ 2

n

∑

(xi – µ)2.

i=1

In questo caso, ovviamente, la log-verosimiglianza dipende da 2 parametri e possiamo

distinguere i seguenti casi.

a) Stima di µ con σ2 nota

Se si vuole stimare µ e si conosce il valore di σ2, allora la log-verosimiglianza dipende

dal solo parametro µ. La formula è identica alla precedente ma conviene esplicitarla:

34

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

l(µ) = –

n

n

1

ln(2π) – lnσ2 –

2

2

2σ 2

n

∑

(xi – µ)2.

i=1

Per ricavare la stima di massima verosimiglianza di µ, si deriva l(µ) rispetto µ per

ottenere lo score e si uguaglia a 0:

s(µ) = –

n

1

2σ 2

∑

2(xi – µ)(–1) = 0,

i=1

che dopo alcune semplificazioni diviene

s(µ) =

1

σ2

n

( ∑ xi – nµ) = 0.

i=1

Risolvendo rispetto a µ si ricava che la stima di massima verosimiglianza di µ è

1

µ~ =

n

n

∑

xi = x .

i=1

Questo significa che lo stimatore di massima verosimiglianza di µ è

1

µ~ = X =

n

n

∑

Xi,

i=1

di nuovo la media campionaria.

Ma quali proprietà ha lo stimatore ottenuto?

•

La distribuzione campionaria di µ~ = X può essere ricavata sulla base di quanto

detto nel cap. 2 sulla distribuzione Normale [rivedere!]. Infatti: Xi ~ N(µ, σ2) ⇒

(proprietà delle combinazioni lineari per v.c. Normali indipendenti con ci = 1/n per i

1

= 1, …, n) µ~ = X =

n

n

∑

Xi ~ N(µ, σ2/n). In breve, allora,

i=1

µ~ = X ~ N(µ, σ2/n).

•

Quanto detto permette di ottenere immediatamente i principali indici caratteristici

della distribuzione campionaria di µ~ = X . Infatti per le proprietà della Normale

(menzionate sopra)

V( X ) = σ2/n.

E( X ) = µ,

35

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

Su questa base si vede subito che X è uno stimatore corretto di µ e che, quindi, il

suo MSE( X ; µ) coincide con la varianza dello stimatore.

•

Calcoliamo ora il limite di Cramér-Rao. Ricordando la formula dello score e le

proprietà dei valori attesi allora

ds (µ )

1

= –E(

I(µ) = –E

(– n)) = n/σ2,

2

σ

dµ

da cui

1/I(µ) = σ2/n

che è identico a V( X ) (vedi sopra). Questo significa che, se σ2 è noto, X è in

assoluto lo stimatore migliore di µ nella classe degli stimatori corretti.

•

Da quanto detto sopra consegue che X è consistente in senso forte per µ, dato che

MSE( X ; µ) = σ2/n tende a 0 per n → +∞. Poiché la consistenza forte implica quella

debole, X è anche consistente in senso debole per µ.

b) Stima di σ2 con µ nota

Se si vuole stimare σ2 e si conosce il valore di µ, allora la log-verosimiglianza dipende

dal solo parametro σ2. La formula è identica alla precedente:

n

n

1

l(σ ) = – ln(2π) – lnσ2 –

2

2

2σ 2

2

n

∑

(xi – µ)2.

i=1

Per ricavare la stima di massima verosimiglianza di σ2, si deriva rispetto σ2 per ottenere

lo score e si uguaglia a 0:

s(σ2) = –

n

2σ

2

+

n

1

2σ

4

∑

(xi – µ)2 = 0.

i=1

Risolvendo rispetto a σ2, si ricava che la stima di massima verosimiglianza di σ2 è

1

σ~ 2 =

n

n

∑

i=1

(xi – µ)2 = s*2* .

Questo significa che lo stimatore di massima verosimiglianza di µ è

1

σ~ 2 = S*2* =

n

detta varianza campionaria con µ nota.

36

n

∑

i=1

(Xi – µ)2,

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

Ma quali proprietà ha lo stimatore ottenuto?

•

La distribuzione campionaria di σ~ 2 = S *2* può essere ricavata sulla base di quanto

detto nel cap. 2 sulla distribuzione Chi-quadrato [rivedere!]. Infatti: Xi ~ N(µ, σ2)

2

Xi − µ

X −µ

2

~ N(0, 1) ⇒ i

⇒

~ χ (1) ⇒ (additività per v.c. Chi-quadrato

σ

σ

2

n

indipendenti)

X −µ

∑ iσ ~ χ2(n). Ma

i =1

nS *2*

σ2

•

2

nS *2*

Xi − µ

=

∑ σ σ 2 , per cui, in breve,

i =1

n

2

n

X −µ

∑ iσ ~ χ2(n).

i =1

=

Quanto detto permette anche di ottenere immediatamente i principali indici

caratteristici della distribuzione campionaria di σ~ 2 = S *2* . Infatti, per le proprietà

della Chi-quadrato,

nS *2*

E 2 = n

σ

nS*2*

V 2 = 2n,

σ

da cui deriva, sfruttando le proprietà dei valori attesi,

E( S *2* ) = σ2

V( S *2* ) = 2σ4/n.

Su questa base si vede subito che σ~ 2 = S *2* è uno stimatore corretto di σ2 e che,

quindi, il suo MSE( S *2* ; σ2) coincide con la varianza dello stimatore.

•

Calcoliamo ora il limite di Cramér-Rao. Ricordando la formula dello score, le

n

2

2

n

Xi − µ

X −µ

2

proprietà dei valori attesi e il fatto che, essendo ∑

~ χ (n), E( ∑ i )

i=1 σ

i=1 σ

= n, allora

( ) = –E(

ds σ 2

I(σ2) = –E

dσ 2

n

2σ

4

–

n

1

2σ

6

∑

(xi – µ)2) = –

i=1

da cui

1/I(σ2) = 2σ4/n

37

n

2σ

4

+

n

σ

4

=

n

2σ 4

,

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

che è identico a V( S *2* ) (vedi sopra). Questo significa che, se µ è noto, S *2* è in

assoluto lo stimatore migliore di σ2 nella classe degli stimatori corretti.

•

Da quanto detto sopra consegue che S *2* è consistente in senso forte per σ2, dato

che MSE( S *2* ; σ2) = 2σ4/n tende a 0 per n → ∞. Poiché la consistenza forte implica

quella debole, S *2* è anche consistente in senso debole per σ2.

c) Stima di µ e σ2 entrambi incogniti

Se si vuole stimare µ e σ2 entrambi incogniti (la cosa più comune nella pratica), allora la

log-verosimiglianza è quella vista all’inizio di questo esempio:

l(µ, σ2) = –

n

n

1

ln(2π) – lnσ2 –

2

2

2σ 2

n

∑

(xi – µ)2.

i=1

Per ricavare la stima di massima verosimiglianza di µ e σ2 occorre derivare rispetto ad

entrambe le variabili, ottenendo (i passaggi sono gli stessi visti in precedenza) le due

componenti del vettore score, ed uguagliarle a 0:

s(µ) =

s(σ2) = –

σ2

n

2σ

n

1

2

+

( ∑ xi – nµ) = 0,

i=1

n

1

2σ

4

∑

(xi – µ)2 = 0.

i=1

Facendo il sistema e risolvendo rispetto ai parametri si ottengono le stime:

1

µ~ = x =

n

n

∑

xi

i=1

1

σ~ 2 =

n

n

∑

i=1

(xi – x )2 = s*2 .

Questo significa che gli stimatori di massima verosimiglianza di µ è di σ2 sono

rispettivamente

1

µ~ = X =

n

n

∑

i=1

Xi

1

σ~ 2 = S*2 =

n

n

∑

(Xi – X )2,

i=1

ovvero, rispettivamente, la media campionaria e la varianza campionaria non

corretta.

Ma quali proprietà hanno gli stimatori ottenuti?

38

B. Chiandotto – F. Cipollini

Versione 2003 – Cap. 6

Metodi statistici per le decisioni d’impresa

•

Da come è scritta la log-verosimiglianza si ricava subito che la coppia di statistiche

n

∑

n

∑ X i2

Xi e

i=1

(e qualsiasi altra trasformazione biunivoca di tale coppia) è

i=1

sufficiente per µ e σ2 (per ottenere tale risultato basta svolgere il quadrato nel

n

termine

∑