Econometria

Sergio Polini

17 maggio 2010

ii

Indice

1 Modello lineare con ipotesi di esogeneità

1.1 Il modello lineare normale . . . . . . . . .

1.2 L’ipotesi di esogeneità . . . . . . . . . . .

1.3 La stima dei parametri . . . . . . . . . . .

1.3.1 Consistenza . . . . . . . . . . . . .

1.3.2 Normalità asintotica . . . . . . . .

1.4 I test di ipotesi . . . . . . . . . . . . . . .

1.5 Un esempio . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

3

5

6

7

7

8

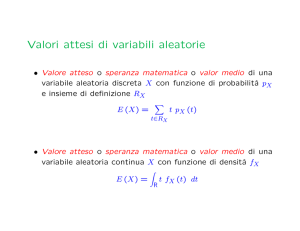

A Richiami di probabilità e di statistica

A.1 Variabili aleatorie multidimensionali . . . . . . . . .

A.2 Aspettativa condizionata . . . . . . . . . . . . . . . .

A.2.1 Legge dell’aspettativa totale (LTE) . . . . . .

A.2.2 Legge della varianza totale (LTV) . . . . . .

A.3 La funzione caratteristica di una variabile aleatoria .

A.4 Successioni di variabili aleatorie . . . . . . . . . . . .

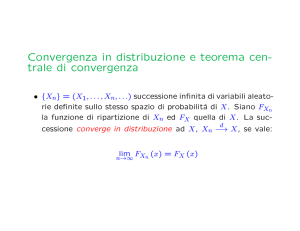

A.4.1 Convergenza in distribuzione e in probabilità

A.4.2 La legge dei grandi numeri . . . . . . . . . .

A.4.3 Il teorema del limite centrale . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

13

13

14

14

15

15

16

16

17

19

iii

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

iv

INDICE

Capitolo 1

Modello lineare con ipotesi di

esogeneità

Si richiamano brevemente le caratteristiche, gli assunti e gli obiettivi del modello lineare

normale, tipico degli studi sperimentali, per mostrare i motivi per cui, in econometria, si

preferisce adottare approcci diversi. Si introducono poi gli assunti dei modelli lineari con

ipotesi di esogeneità e se ne derivano le conseguenze in merito alla stima dei parametri e

ai test di ipotesi.

1.1

Il modello lineare normale

In uno studio sperimentale il ricercatore ha il pieno controllo dell’esperimento:1 sceglie alcuni fattori sperimentali di cui vuole indagare l’effetto su alcune unità sperimentali; a tale

scopo individua diversi trattamenti, corrispondenti a diversi livelli dei fattori sperimentali, che vengono intesi come variabili esplicative, e li somministra alle unità sperimentali

in modo casuale (randomizzazione); osserva quindi i valori di una variabile risposta per

verificare se essi possono essere intesi come effetti delle variabili esplicative, oppure se la

variabilità osservata nella risposta è imputabile solo a fattori accidentali.

Gli n diversi valori della variabile risposta (tanti quante sono le unità sperimentali)

vengono interpretati come realizzazioni di n variabili aleatorie. I risultati dell’esperimento

vengono quindi valutati adottando un modello statistico.

Il modello lineare normale assume la forma:

Y=X β + ε

n,1

n,k k,1

n,1

in cui:

– Y è un vettore di n variabili aleatorie osservabili (la variabile risposta);

– X è una matrice di costanti note; ogni sua colonna contiene i valori di una variabile esplicativa, ogni riga i valori delle diverse variabile esplicative (i livelli dei fattori

sperimentali) come somministrati ad una unità sperimentale;

– β è un vettore di k parametri incogniti e non osservabili;

1

Cfr. Modelli statistici lineari (http://web.mclink.it/MC1166/ModelliStatistici/ModStat.html),

Cap. 1.

1

2

1. Modello lineare con ipotesi di esogeneità

– ε è un vettore di n errori casuali, cioè di variabili aleatorie non osservabili con media

nulla e a due a due indipendenti.

Si assume inoltre che gli errori siano distribuiti normalmente e che abbiano tutti la stessa

varianza (omoschedasticità):

ε ∼ M N (0, σ 2 I)

Se ne ricava che anche Y è una variabile aleatoria multinormale:

(

Y = Xβ + ε

ε ∼ M N (0, σ 2 I)

⇒

Y ∼ M N (Xβ, σ 2 I)

Si tratta di stimare il vettore β dei parametri e di valutare la significatività delle

stime.

La stima dei parametri avviene con il metodo dei minimi quadrati (minimizzazione

della somma dei quadrati degli scarti tra i valori osservati della variabile risposta, y, e i

corrispondenti valori attesi, o valori teorici, Ŷ = Xβ) oppure col metodo della massima

verosimiglianza; entrambi i metodi, nel caso del modello lineare normale, portano allo

stesso risultato. Indicando con b lo stimatore di β:

b = (X0 X)−1 X0 Y

b è uno stimatore corretto; infatti, essendo

E[Y ] = Xβ:

E[b] = (X0X)−1X0E[Y] = (X0X)−1(X0X)β = β

Il modello statistico relativo ad uno studio sperimentale viene espresso preferibilmente

in forma matriciale, in quanto la matrice X contiene le variabili e i rispettivi valori

scelti dal ricercatore e, più in generale, esprime le scelte compiute dal ricercatore nella

pianificazione dell’esperimento.

Si sceglie, inoltre, uno stimatore corretto in quanto uno studio sperimentale è, in linea

di principio, sempre ripetibile nelle stesse condizioni. Informalmente, lo stimatore di un

parametro è corretto se, effettuandone la stima su molti diversi campioni, la media delle

stime coincide col valore “vero” del parametro; si sceglie quindi uno stimatore corretto in

quanto è quello che meglio garantisce che, ripetendo l’esperimento, si ottengano risultati

analoghi.

La situazione è ben diversa negli studi osservazionali, anche in econometria: non si

possono eseguire esperimenti in senso stretto, ma si possono solo osservare valori di alcune

variabili assunte come esplicative (valori osservati, non scelti dal ricercatore), senza la

garanzia di aver osservato tutte le variabili che potrebbero avere effetto sulla variabile

risposta; in generale, inoltre, non è possibile ripetere lo studio a piacimento. Si adottano

quindi approcci diversi. In particolare, negli studi cross-section, i più simili agli studi

sperimentali:2

a) anche la variabili esplicative vengono intese come variabili aleatorie;

2

Negli studi cross-section si osservano i valori di una o più variabili esplicative e di una variabile

risposta su un insieme di unità in uno stesso istante o in uno stesso intervallo di tempo. Si opera quindi

su una matrice di dati che, analogamente a quanto avviene negli studi sperimentali, contiene tante righe

quante sono le unità su cui si sono effettuate le osservazioni, una colonna contenente i valori osservati

della variabile risposta e altre colonne che contengono i valori osservati delle variabili esplicative.

3

L’ipotesi di esogeneità

b) il modello statistico lineare viene espresso preferibilmente, piuttosto che in forma

matriciale, in termini di una ipotesi sulla popolazione:

Y = β1 X1 + β2 X2 + · · · + βk Xk + u

dove Y è la variabile risposta, le Xi sono variabili aleatorie osservabili e u è una variabile

aleatoria non osservabile (unobservable) che comprende in sé non solo l’errore, ma anche

possibili variabili esplicative non considerate; non si assume, quindi, che u abbia una

distribuzione normale;

c) il valore atteso della variabile risposta diventa una aspettativa condizionata alle variabili esplicative: [Y | X1 , . . . , Xk ];

E

d) obiettivo della ricerca diventa la stima dei parametri βj intesi come effetti parziali delle

variabili esplicative sul valore atteso della variabile risposta:

E

∂ [Y | X1 , . . . , Xk ]

= βj

∂Xj

e) i valori osservati vengono intesi come realizzazioni di un campione casuale (con assunzione, quindi, di indipendenza e identica distribuzione);

f) si preferiscono stimatori consistenti:

p

bn → β

in quanto ciò che importa non è tanto la possibilità di ripetere lo studio nelle stesse condizioni (possibilità spesso inesistente), ma di avvicinarsi al valore “vero” dei parametri

aumentando la dimensione n del campione.

In particolare, in un modello lineare con ipotesi di esogeneità si usano i seguenti

assunti:

a) linearità: Y = [ X1 . . . Xk ]0 β + u;

b) esogeneità:

E[u | X1, . . . , Xk ] = 0;

c) norma finita e rango pieno della matrice

variabili esplicative: x = [ X1 . . . Xk ]0 .

E[xx0], dove x indica un vettore k × 1 di

Si può includere infine, anche se non strettamante necessario:

d) omoschedasticità: per ogni i,

1.2

V[ui | Xi1, . . . , Xik ] = σ2.

L’ipotesi di esogeneità

Un modello lineare con ipotesi di esogeneità ha la forma:

Y = β1 X1 + β2 X2 + · · · + βk Xk + u

E[u|X1, . . . , Xk ] = 0

Il modello viene detto lineare perché i parametri βj compaiono tutti con esponente pari

a 1. Rimarrebbe tale se una variabile esplicativa avesse una sua forma funzionale non

lineare; ad esempio, potrebbe aversi X4 = X32 . Il modello può essere espresso anche in

altra forma equivalente:

Y = β0 + β1 X1 + β2 X2 + · · · + βk−1 Xk−1 + u

E[u|X1, . . . , Xk−1] = 0

4

1. Modello lineare con ipotesi di esogeneità

In entrambi i casi vi sono k parametri. Nella seconda forma appare più evidente che

l’equazione descrive una retta in k con intercetta β0 ; ciò comporta che, nella prima

forma, si deve intendere X1 = 1.

L’ipotesi di esogeneità [u | X1 , . . . , Xk ] = 0 fa sì che:

R

E

E[Y |x] = E[xβ + u | x] = E[xβ | x] + E[u | x] = xβ

= β1 X1 + β2 X2 + · · · + βk Xk

Soprattutto, dall’ipotesi di esogeneità discendono due importanti conseguenze:

a)

E[u] = 0; infatti, per la prima legge delle aspettative iterate, o legge dell’aspettativa

totale (LT E, Law of Total Expectation; cfr. Appendice):

E[u] LT=E E E[u | x]

h

i

=

E[0] = 0

b) u è incorrelata con qualsiasi funzione delle variabili esplicative e, in particolare, è

incorrelata con ciascuna Xj ; infatti, per le proprietà dell’aspettativa condizionata (v.

Appendice) e per l’ipotesi di esogeneità:

E[f (x)u | x] = f (x)E[u | x] = 0

in particolare,

E[xu] LT=E E E[xu | x]

h

i

=

E xE[u | x]

h

i

=0

quindi:

E[f (x)u] − E[f (x)]E[u]

h

i

= E E[f (x)u | x] − E[f (x)]E[u] = 0

Cov(f (x), u) =

Per apprezzare l’importanza dell’ipotesi di esogeneità, si può ipotizzare che il modello

“vero” della popolazione sia:

E[u | X1, X2] = 0

Y = β1 X1 + β2 X2 + u

L’effetto parziale di X1 sarebbe, in tal caso:

E

∂

∂

[Y | X1 , X2 ] =

(β1 X1 + β2 X2 ) = β1

∂X1

∂X1

Se però si usasse il modello

Y = β1 X1 + u

e se X1 e X2 fossero correlate, si avrebbe in realtà, per qualche c,

E[Y

| X1 ] = β1 X1 + β2 (cX1 )

quindi

E

∂

[Y | X1 ] = β1 + β2 c

∂X1

dove β1 sarebbe l’effetto diretto, β2 c quello indiretto, di X1 ; β1 non potrebbe quindi essere

considerato l’effetto parziale di X1 . In altri termini, non sarebbe possibile concludere: se

X1 aumenta di una unità, allora Y aumenta di β1 .

In pratica, si cerca di costruire modelli in cui compaiono, oltre alle variabili esplicative

di interesse, anche altre variabili esplicative di controllo, il cui scopo è fare in modo che

il termine u possa sì contenere variabili non osservate, ma solo variabili non correlate con

quelle di interesse.

5

La stima dei parametri

1.3

La stima dei parametri

Il modello della popolazione può essere esposto più sinteticamente nella forma:

Y = x0 β + u

in cui x indica, come sopra, un vettore k × 1 di variabili esplicative.

Assumendo di estrarre un campione casuale dalla popolazione, si avranno n osservazioni del tipo:

Yi = xi0 β + ui

in cui xi0 indica il vettore colonna della i-esima riga di una matrice X contenente tante

righe quante sono le osservazioni e tante colonne quante sono le variabili esplicative.

Premoltiplicando il modello della popolazione per x e calcolando i valori attesi:

E[xY ] = E[xx0β + xu] = βE[xx0] + E[xu] = βE[xx0]

in quanto u e x sono incorrelate (per l’ipotesi di esogeneità). Si ottiene così:

E[xx0]−1E[xY ]

β=

E

E

Per stimare [xx0 ] e [xY ] si può ricorrere al metodo dei momenti, sostituendoli con

le rispettive medie campionarie:

n

b=

n

X

−1

!−1

xi xi0

n

−1

i=1

n

X

=

n

X

n

X

!

xi Yi

=n

i=1

!−1

n

X

xi xi0

!−1

xi xi0

n

−1

n

X

!

xi Yi

i=1

i=1

!

xi Yi

i=1

i=1

Oppure, in forma matriciale,3

b = (X0 X)−1 X0 Y

dove X è la matrice con righe xi , i = 1, . . . , n, e Y è il vettore colonna [ Y1 . . . Yn ]0 .

Poiché Yi = xi0 β + ui , si ha anche:

b = (X0 X)−1 X0 Xβ + (X0 X)−1 X0 u = β + (X0 X)−1 X0 u

=β+

n

X

!−1

xi xi0

i=1

a

Se X = c

e

!

xi ui

i=1

b

a

0

d , allora X X =

b

f

"

3

n

X

#

c

d

e

f

"a

c

e

2

b

a + c2 + e2

d =

ab + cd + ef

f

#

ab + cd + ef

, che è la somma

b 2 + d2 + f 2

di:

x1 x10 =

a a

b

b =

a

Inoltre, se X = c

e

"

b

d

f

#

a2

ab

ab

,

b2

x2 x20 =

c c

d

g

a

0

e Y = h , allora X Y =

b

i

" #

a

ag

x1 Y1 =

g=

,

b

bg

d =

c

d

c2

cd

e

f

cd

,

d2

"g #

x3 x30 =

e e

f

f =

e2

ef

ef

f2

ag + ch + ei

h =

, che è la somma di:

bg + dh + f i

i

c

ch

x2 Y2 =

h=

,

d

dh

e

ei

x3 Y3 =

i=

f

fi

Quindi se X è una matrice n × k e Y è un vettore n × 1, X0 X è la somma di n matrici k × k e X0 Y è la

somma di n vettori k × 1.

6

1. Modello lineare con ipotesi di esogeneità

1.3.1

Consistenza

Lo stimatore b è consistente. Infatti, ponendo Wi = xi ui ,

a) per la legge dell’aspettativa totale,

E[Wi] = E E[Wi | xi]

h

i

E E[xiui | xi]

h

=

i

ma, per l’ipotesi di esogeneità:

E[xiui | xi] = xiE[ui | xi] = 0

E[Wi] = 0

⇒

b) per la legge della varianza totale,

V[Wi] = E V[Wi | xi] + V E[Wi | xi]

ma, poiché per l’ipotesi di esogeneità E[Wi | xi ] = 0,

h

i

h

i

h

i

V[Wi] = E V[Wi | xi] = E V[xiui | xi] = E xiV[ui | xi]xi0

assumendo che V[ui | xi ] sia finita, risulta finita anche V[Wi ]; in particolare, assumendo V[ui | xi ] = σ 2 per ogni i (omoschedasticità) e ricordando l’ipotesi di indipendenza

h

i

h

i

e identica distribuzione (campione casuale):

V[Wi] = E[xiσ2xi0 ] = σ2E[xixi0 ] =id σ2E[xx0] < ∞

c) l’espressione di b in termini di medie campionarie rende evidente che b dipende anche

da n; si può quindi considerare la successione

bn = β + n

−1

n

X

!−1

xi xi0

n

−1

i=1

n

X

!

xi ui

i=1

ora:

–

Pn

0

i=1 xi xi

è in termine n-esimo di una successione di variabili aleatorie assunte iid,

il cui valore atteso è [xx0 ], assunto finito; quindi, per la legge dei grandi numeri:

E

Pn

0

i=1 xi xi

n

–

p

→

E[xx0]

E[Wi] = 0 e V[Wi] < ∞, ma, poiché si assume che le Wi siano iid, si ha anche

E[W ] = E[xu] = 0 e V[W ] = V[xu] < ∞; si può applicare anche qui la legge dei

grandi numeri:

Pn

i=1 xi ui

p

→

E

[xu] = 0

n

ne segue la consistenza di b; infatti, per il lemma di Slutsky (v. Appendice), essendo

l’inversa una funzione continua,

Pn

0

i=1 xi xi

n

e si ha:

p

→

E[xx0]

p

0 −1

p

i=1 xi xi

Pn

⇒

bn → β +

n

E[xx0]−1 · 0 = β

→

E[xx0]−1

7

I test di ipotesi

1.3.2

Normalità asintotica

La successione bn può essere riscritta come segue, portando a sinistra β e moltiplicando

√

entrambi i membri per n:

√

0 −1 Pn x u i=1 xi xi

i=1 i i

Pn

n(bn − β) =

p

√

n

E

n

Si appena vistoPche n−1 ni=1 xi xi0 → [xx0 ].

n

i=1 xi ui

√

, si è visto che [xu] = 0 e che, assumendo omoschedasticiQuanto a

n

tà, [xu] = σ 2 [xx0 ] < ∞. Si può quindi applicare il teorema del limite centrale alla

P

successione ni=1 xi ui :

Pn

i=1 xi ui d

√

→ N (0, [xu])

n

√

n(bn −β) è quindi una trasformazione lineare (una moltiplicazione per una quantità che

tende a [xx0 ], che è una matrice simmetrica) di una successione di v.a. asintoticamente

normali e si ha:

√

d

n(bn − β) → N (0, [xx0 ]−1 σ 2 [xx0 ] [xx0 ]−1 ) = N (0, σ 2 [xx0 ]−1 )

P

V

E

E

V

E

E

E

E

E

Questo consente di dire che, per grandi campioni, b si distribuisce approssimativamente

come una normale con media β e varianza σ 2 [xx0 ]−1 /n:

E

!

σ 2 E[xx0 ]−1

β,

a

b∼N

1.4

n

I test di ipotesi

Una volta stimati i parametri, occorre valutare la loro significatività con test di ipotesi.

La forma più generale dell’ipotesi nulla è:

Rβ −q = 0

r,k k,1

r,1

r,1

dove R è una matrice di restrizioni avente r righe (il numero delle restrizioni) e k colonne

(il numero dei parametri). Ad esempio, se il modello è:

Y = β1 X1 + β2 X2 + β3 X3 + β4 X4 + u

a) per sottoporre a test l’ipotesi nulla

H0 : β2 = β3 = β4 = 0

(tutti i coefficienti nulli tranne il primo, che esprime l’intercetta della retta di regressione in quanto X1 ha tutti gli elementi pari a 1) si usa una matrice R con r = k − 1

righe e k colonne:

β1

0

0

β

0 2 − 0 =

β3

0 1 0

Rβ − q = 0 0 1

0 0 0 1

β4

0

β2

0

0

β3 − 0 = 0

β4

0

0

8

1. Modello lineare con ipotesi di esogeneità

b) se l’ipotesi nulla è

H0 : β2 = β3 , β4 = 5

si usa:

" # "

# " # " #

# β1

0

β2 − β3

0

0

−1 0

β2

=

−

=

−

5

β4

5

0

0 1 β3

"

0 1

0 0

Rβ − q =

β4

Per costruire una statistica test di distribuzione nota, si sostituisce in primo luogo β

con il suo stimatore b e si considera che, essendo b approssimativamente normale per

grandi campioni, Rb − q ne è una trasformazione con distribuzione approssimata:

a

Rb − q ∼ N Rβ − q, RVR0 ,

Quanto a

è di

E

σ2,

[xx0 ].

ne è uno stimatore consistente

s2

Quindi:

2 (n

V̂ = s

−1 Pn x x0 )−1

i=1 i i

n

=s

2

V=

E

σ 2 [xx0 ]−1

n

e0 e

=

, mentre si è visto che

n

n

X

Pn

0

i=1 xi xi

n

lo

!−1

xi xi0

= s2 (X0 X)−1

i=1

Sotto ipotesi nulla si ha:

a

Rb − q ∼ N (0, RV̂R0 )

Si può standardizzare dividendo per la radice quadrata della varianza e definendo così la

variabile:

1

Z = (RV̂R0 )− 2 (Rb − q)

Poiché RV̂R0 è simmetrica, si ha:

1

1

Z2 = Z0 Z = (Rb − q)0 (RV̂R0 )− 2 (RV̂R0 )− 2 (Rb − q)

= (Rb − q)0 (RV̂R0 )−1 (Rb − q)

Si perviene così alla statistica test:

a

T = (Rb − q)0 (RVR0 )−1 (Rb − q) ∼ χ2r

1.5

Un esempio

Si vuole determinare se il salario delle donne è influenzato dalla condizione familiare, in

particolare dall’età e dal numero dei figli. Le relative variabili esplicative sono:

– age: l’età anagrafica in anni;

– kidslt6: il numero dei figli di età minore di 6 anni;

– kidsge6: il numero dei figli di età compresa tra 6 e 18 anni.

Si prendono in considerazione anche altre variabili, che appaiono correlate almeno

all’età anagrafica (variabili di controllo):

– exper: l’anzianità di lavoro;

9

Un esempio

– expersq: il quadrato dell’anzianità di lavoro (si ipotizza che intervengano negli anni

avanzamenti di qualifica, quindi che l’effetto dell’anzianità sul salario non sia lineare);

– educ: il livello di istruzione, misurato con gli anni di frequentazione delle scuole.

Si sceglie il seguente modello per la popolazione:

log(wage) = β0 + β1 exper + β2 expersq + β3 educ + β4 age + β5 kidslt6 + β6 kidsge6 + u

si sceglie cioè di usare come variabile risposta il logaritmo del salario, lwage.

Con R, si tratta di caricare il file women_wage.csv4 e di eseguire una regressione

lineare:

> ww <- read.csv("women_wage.csv")

> reg <- lm(lwage ~ exper+expersq+educ+age+kidslt6+kidsge6, data=ww)

Il comando summary() consente di esaminare i risultati:

> summary(reg)

Call:

lm(formula = lwage ~ exper + expersq + educ + age + kidslt6 +

kidsge6, data = ww)

Residuals:

Min

1Q

-3.08183 -0.30631

Median

0.04606

3Q

0.37161

Max

2.35708

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) -0.4209080 0.3169050 -1.328 0.18484

exper

0.0398190 0.0133930

2.973 0.00312 **

expersq

-0.0007812 0.0004022 -1.942 0.05276 .

educ

0.1078320 0.0144021

7.487 4.16e-13 ***

age

-0.0014653 0.0052925 -0.277 0.78203

kidslt6

-0.0607106 0.0887626 -0.684 0.49437

kidsge6

-0.0145910 0.0278981 -0.523 0.60124

--Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ’ 1

Residual standard error: 0.6682 on 421 degrees of freedom

Multiple R-squared: 0.1582,Adjusted R-squared: 0.1462

F-statistic: 13.19 on 6 and 421 DF, p-value: 1.057e-13

La sezione Coefficients dell’output consente di rilevare che gli unici parametri significativamente diversi da zero sono quelli di exper (β1 ) e di educ (β3 ), un po’ meno

quello di expersq (β2 ), ma soprattutto che i parametri relativi ai fattori familiari non

sembrano affatto significativi. Quanto al modello nel suo complesso, l’ultima riga consente

di rifiutare l’ipotesi nulla secondo la quale tutti i parametri sarebbero pari a zero.

4

Scaricabile da http://web.mclink.it/MC1166/Econometria/women_wage.csv.

10

1. Modello lineare con ipotesi di esogeneità

I test di ipotesi possono essere ricostruiti e generalizzati con una funzione come la

seguente:

> lmtest <- function(reg, R=NULL, q=NULL) {

b <- coef(reg)

V <- vcov(reg)

k <- length(b)

if (is.null(R))

R <- diag(k)[2:k,]

if (is.null(q))

q <- matrix(rep(0,k-1),nrow=k-1)

Rb <- (R %*% b) - q

T <- t(Rb) %*% solve(R %*% V %*% t(R)) %*% Rb

p.value <- pchisq(T, nrow(R), lower.tail=FALSE)

return(list(TestStat = T, pValue = p.value))

}

La funzione lmtest() richiede come primo parametro obbligatorio il risultato di una

chiamata della funzione lm(); vi sono poi due parametri opzionali che consentono di

passare specifici valori per la matrice R e per il vettore q. Il vettore b dei parametri

stimati e la corrispondente matrice V̂ vengono ricavati direttamente dal risultato di lm(),

usando le funzioni coef() e vcov().

Se non vengono passati i parametri opzionali, la funzione costruisce una matrice R e

un vettore q adatti a verificare l’ipotesi nulla “tutti i coefficienti βi nulli tranne il primo”,

elabora la statistica test e calcola il p-value sulla base di una distribuzione χ2r con r gradi

di libertà, dove r è il numero di righe della matrice R (il numero delle restrizioni):

> lmtest(reg)

$TestStat

[,1]

[1,] 79.14383

$pValue

[,1]

[1,] 5.368093e-15

Il valore della statistica test risulta diverso da quello prodotto da summary(reg),

79.14 invece di 13.19, e sembrano diversi anche i p-value. La funzione summary(), in

realtà, calcola il p-value sulla base di una distribuzione Fr,n−k , come richiesto dal modello

lineare normale,5 ma:

a) se W ∼ Fr,s , allora lim rW = Z ∼ χ2r , quindi se la statistica

s→∞

a

T = (Rb − q)0 (RVR0 )−1 (Rb − q) ∼ χ2r

si distribuisce approssimativamente come un χ2r , il rapporto T /r si distribuisce approssimativamente come una Fr,n−k :

T a

∼ Fr,n−k

r

5

Cfr. http://web.mclink.it/MC1166/ModelliStatistici/ModStat.html, Cap. 3.

11

Un esempio

in questo caso, l’ipotesi nulla è:

0 1

0

0

0

0

0 0

0

0

Rβ − q =

0

0

0

1

0

0

0

0

0

0

1

0

0

0

0

0

0

1

0

0

β0

0

0

β1

0

0

β1

β

0

0

0

β 2 0

2

0 β 0 0

0

3

β

−

= − =

3

0 β4 0 0

0

β4

0

0 β5 0 0

β5

0

0

0

0

1

0 1

β6

0

β6

0

0

79.14

;

6

b) dal momento che il test χ2 è esatto, mentre quello F è approssimato, il p-value calcolato

da R, 1.057 × 10−13 , va visto come una ragionevole approssimazione a quello calcolato

su una distribuzione χ26 , 5.37 × 10−15 (si tratta di valori entrambi talmente piccoli da

poter essere considerati nulli).

con r = 6 (6 restrizioni, matrice R di 6 righe) e si ha 13.19 =

Se si passano una matrice R ed un vettore q, la funzione li usa per effettuare il test

specificato. Ad esempio, per sottoporre a test l’ipotesi nulla

H0 : β4 = 0

dove β4 è il coefficiente della variabile age, si procede come segue:

> R <- matrix(c(0,0,0,0,1,0,0), nrow=1)

> q <- 0

> lmtest(reg, R, q)

$TestStat

[,1]

[1,] 0.07664967

$pValue

[,1]

[1,] 0.7818901

R usa una statistica test di distribuzione t con n − k = 421 di libertà, il cui valore

−0.0014653

è il rapporto tra la stima di β4 e il suo standard error:

= −0.2768635,

0.0052925

arrotondato in −0.277. Nel modello con variabili esplicative aleatorie si usa una statistica

test di distribuzione χ21 , approssimata da una F1,421 , che a sua volta è uguale ad una t421

al quadrato:6

(tν )2 = Fi,ν

e infatti il quadrato di −0.2768635 è 0.07665339, molto vicino al valore “vero” della

statistica test, 0.07664967. Conseguentemente, anche il p-value calcolato da R, 0.78203,

è molto vicino a quello “vero”.

Si possono eseguire test su un insieme di coefficienti. Ad esempio, se l’ipotesi nulla è:

H0 : β4 = β5 = β6 = 0

(nulli tutti i coefficienti relativi a fattori familiari), si può procedere come segue:

6

Cfr. Modelli statistici lineari (http://web.mclink.it/MC1166/ModelliStatistici/ModStat.html),

pag. 103.

12

1. Modello lineare con ipotesi di esogeneità

> R <- matrix(c(0,0,0,0,1,0,0,0,0,0,0,0,1,0,0,0,0,0,0,0,1),

+ byrow=TRUE, nrow=3)

> R

[,1] [,2] [,3] [,4] [,5] [,6] [,7]

[1,]

0

0

0

0

1

0

0

[2,]

0

0

0

0

0

1

0

[3,]

0

0

0

0

0

0

1

> q <- matrix(0,nrow=3,ncol=1)

> q

[,1]

[1,]

0

[2,]

0

[3,]

0

> lmtest(reg,R,q)

$TestStat

[,1]

[1,] 0.7110719

$pValue

[,1]

[1,] 0.8705967

e si accetta l’ipotesi nulla.

Si potrebbe anche usare la funzione anova() sul modello già calcolato e su un altro

modello contenente solo le prime tre variabili esplicative:

> reg3 <- lm(lwage ~ exper + expersq + educ, data=ww)

> anova(reg, reg3, test="Chisq")

Analysis of Variance Table

Model 1:

Model 2:

Res.Df

1

421

2

424

lwage ~ exper + expersq + educ + age + kidslt6 + kidsge6

lwage ~ exper + expersq + educ

RSS Df Sum of Sq P(>|Chi|)

187.99

188.31 -3 -0.31751

0.8706

e si otterrebbe lo stesso p-value per l’ipotesi nulla “i due modelli sono equivalenti”.

Appendice A

Richiami di probabilità e di

statistica

A.1

Variabili aleatorie multidimensionali

Dato uno spazio campionario Ω, se ad ogni evento elementare ω ∈ Ω viene associata

una n-upla di numeri reali (X1 (ω), X2 (ω), . . . , Xn (ω)), si ha una variabile aleatoria ndimensionale.

In generale, la funzione di ripartizione di una variabile aleatoria multidimensionale X

è:

FX (x) = P [X1 < x1 , X2 < x2 , . . . , Xn < n]

∀x ∈ n

R

Nel caso di una variabile aleatoria doppia (X, Y ) assolutamente continua:

Z x Z y

FX,Y (x, y) =

−∞ −∞

fX,Y (u, v) du dv

dove fX,Y (x, y) è la funzione di densità della v.a. con funzione di ripartizione F (x, y).

Considerando la sola componente X di una v.a. doppia (X, Y ), la sua funzione di

ripartizione è

Z x

FX (x) = P [X < x] = P [X < x, Y < +∞] =

Z +∞

du

−∞

−∞

fX,Y (u, v) dv

Z x

Poiché in generale, per una v.a. assolutamente continua, FX (x) =

−∞

fX (u) du, le

funzioni di densità marginale delle componenti di (X, Y ) sono

Z +∞

fX (x) =

−∞

Z +∞

fX,Y (x, y) dy

fY (y) =

−∞

fX,Y (x, y) dx

Sempre nel caso di una v.a. doppia (X, Y ), la densità condizionata di X dato l’evento

Y =y è

fX,Y (x, y)

fX|Y (x | y) =

fY (y)

13

14

A. Richiami di probabilità e di statistica

A.2

Aspettativa condizionata

Date due variabili aleatorie assolutamente continue X e Y definite nello stesso spazio

di probabilità, [X | Y ] è anch’essa una variabile aleatoria, detta aspettativa (o media)

condizionata, e assume i valori:

E

E[X | Y

Z +∞

= y] =

−∞

xfX|Y (x | y) dx =

E

Z +∞

fX,Y (x, y)

x

−∞

fY (y)

dx

E

Da notare che, mentre [X | Y ] è una variabile aleatoria, [X | Y = y] è un numero (il

valore atteso di X dato Y = y). In altri termini, [X | Y ] è una variabile aleatoria in

quanto funzione della variabile aleatoria Y .

L’aspettativa condizionata gode delle seguenti proprietà:

E

E[a | Y ] = a;

b) E[aX + bZ | Y ] = aE[X | Y ] + bE[Z | Y ] (linearità);

c) E[X | Y ] ≥ 0 se X ≥ 0;

d) E[X | Y ] = E[X] se X e Y sono indipendenti, infatti in questo caso:

a) se a è una qualsiasi costante,

E[X | Y

= y] =

Z +∞

fX,Y (x, y)

x

−∞

Z +∞

−∞

E[f (Y )X

Z +∞

fX (x)fY (y)

x

−∞

x fX (x)dx =

=

e)

fY (y)

ind

dx =

fY (y)

dx

E[X]

E

E

| Y ] = f (Y ) [X | Y ], in particolare [f (Y ) | Y ] = f (X); infatti, dato

Y = y è dato anche f (y), i valori di f (Y )X sono f (y)x e variano al variare di x:

E[f (Y )X | Y

Z ∞

= y] =

−∞

f (y)xfX|Y (x | y) dx

Z ∞

= f (y)

−∞

E

xfX|Y (x | y) dx = f (y) [X | Y = y]

Sono inoltre particolarmente importanti le leggi delle aspettative iterate, dette anche

legge dell’aspettativa totale e legge della varianza totale.

A.2.1

Legge dell’aspettativa totale (LTE)

La prima legge delle aspettative iterate, detta anche legge dell’aspettativa totale (LTE,

Law of Total Expectation) stabilisce che:

E E[X | Y ]

h

i

=

E[X]

Infatti,

E E[X | Y ]

h

dove

i

E[X | Y

Z +∞

=

−∞

E[X | Y

Z +∞

= y] =

−∞

= y]fY (y) dy

xfX|Y (x | y) dx

15

La funzione caratteristica di una variabile aleatoria

Si ha quindi:

E[X] =

Z

xfX (x) dx

vedendo fX come marginale di una congiunta:

Z

Z

Z Z

=

fX,Y (x, y) dy

=

Z

dx

xfX|Y (x | y)fY (y) dx dy

Z Z

=

x

=

xfX|Y (x | y)dx

E[X | Y

dy

= y]fY (y) dy =

E E[X | Y ]

h

i

Informalmente, la legge dice che il valore atteso totale di X è uguale alla somma dei

valori attesi di X | Y per tutti i diversi possibili valori che Y può assumere, ciascuno

ponderato con la propria probabilità.

A.2.2

Legge della varianza totale (LTV)

La legge della varianza totale (LTV, Law of Total Variance, detta anche seconda legge

delle aspettative iterate) stabilisce che:

V[X] = E V[X | Y ]

h

i

+

V E[X | Y ]

h

i

Infatti:

V[X] = E[X 2] − E[X]2 LT=E E E[X 2 | Y ]

h

i

−

E E[X | Y ]

h

i2

riscrivendo il momento secondo in termini della varianza e del momento primo:

=

per la linearità di

E V[X | Y ] + E[X | Y ]2

h

i

−

E E[X | Y ]

h

E:

E V[X | Y ] + E E[X | Y ]

h

i

h

i

= E V[X | Y ] + V E[X | Y ]

=

A.3

i2

h

i

h

2

i

−

E E[X | Y ]

h

i2 La funzione caratteristica di una variabile aleatoria

Data una variabile aleatoria X con funzione di ripartizione FX (x) = P [X < x], la funzione

caratteristica della v.a. X è una funzione ΦX : → definita da:1

R C

ΦX (t) =

1

E[eitX ] =

Z +∞

−∞

eitx fX (x) dx

La definizione vale solo nel caso Z

la funzione di densità di X esista; in caso contrario, si deve ricorrere

a un integrale di Riemann-Stieltjes:

eitx dFX (x).

Ω

16

A. Richiami di probabilità e di statistica

Esiste una corrispondenza biunivoca tra la funzione caratteristica e la funzione di ripartizione di una qualsiasi variabile aleatoria. La funzione caratteristica presenta, tra altre,

le seguenti proprietà:

a) la f.c. è sempre minore o uguale a 1; è uguale a 1 per t = 0:

|ΦX (t)| ≤ 1

ΦX (0) = 1

b) la sua derivata n-esima in 0 è uguale al momento n-esimo di X moltiplicato per in :

E

dn

(n)

≡ ΦX (0) = in [X n ]

Φ

(t)

X

n

dt

t=0

c) la f.c. di una trasformazione affine di X, Z = aX + b, è

ΦZ (t) =

E[eitZ ] = E[eitaX eitb] = eitbΦX (at)

d) la f.c. di una v.a. degenere C, con P [C = c] = 1, è

ΦC (t) =

E[eitc] = eitc

e) la f.c. di una v.a. normale X ∼ N (µ, σ 2 ) è

ΦX (t) = eµit−

t2 σ 2

2

quindi quella di una normale standard Z ∼ N (0, 1) è

t2

ΦZ (t) = e− 2

A.4

A.4.1

Successioni di variabili aleatorie

Convergenza in distribuzione e in probabilità

Si dice che una successione Xn di variabili aleatorie con funzioni di ripartizione Fn

d

converge in distribuzione alla v.a. X con f.r. F , e si scrive Xn → X, se esiste il limite

lim Fn (x) = F (x)

n→∞

Dal momento che FX (x) = P [X < x], la convergenza in distribuzione comporta che,

al crescere di n, la probabilità che la successione assuma valori minori di x diventa sempre

più simile alla probabilità che X assuma valori minori di x, ma non che Xn e X tendano

ad assumere gli stessi valori.

Si dice invece che una successione Xn di variabili aleatorie converge in probabilità alla

p

variabile aleatoria X, e si scrive Xn → X oppure plim Xn = X, se

∀ε > 0,

lim P [|Xn − X| < ε] = 1

n→∞

oppure, equivalentemente, se

∀ε > 0,

lim P [|Xn − X| > ε] = 0

n→∞

17

Successioni di variabili aleatorie

La convergenza in probabilità riguarda quindi i valori assunti da Xn e X. Se vale, si ha

che all’aumentare di n aumenta sempre più la probabilità che i valori assunti da Xn e

quelli assunti da X differiscano meno di un ε, per quanto piccolo sia ε.2

La convergenza in probabilità implica la convergenza in distribuzione:

p

Xn → X

d

⇒

Xn → X

mentre la convergenza in distribuzione implica quella in probabilità solo nel caso di

convergenza in distribuzione ad una variabile aleatoria degenere:

d

Xn → c

p

⇒

Xn → c

Inoltre:

Teorema di Slutsky. Se Xn e Yn sono due successioni di variabili aleatorie tali che

d

Xn converge in distribuzione ad una variabile aleatoria X, Xn → X, e Yn converge in

p

probabilità ad una costante reale c, Yn → c, allora:

d

– Xn + Yn → X + c;

d

– Xn Yn → cX;

d

– Xn /Yn → X/c, se c 6= 0.

Lemma di Slutsky. Date una successione Xn di variabili aleatorie k-dimensionali e

p

una funzione g : k →

è una funzione continua in X ∈ k , se Xn → X allora

p

g(Xn ) → g(X):

p

p

Xn → X ⇒ g(Xn ) → g(X)

R

A.4.2

R

R

La legge dei grandi numeri

Teorema A.1 (Legge dei grandi numeri, LLN (Law of Large Numbers)). Data una

successione Xn di variabili aleatorie indipendenti e identicamente distribuite, con [X] =

Sn

µ < ∞, indicando con Sn la somma dei primi n termini e con X̄n =

la loro media,

n

si ha:

i

h

p

X¯n → µ

ovvero

∀ε > 0, lim P X̄n − µ < ε = 1

E

n→∞

Dimostrazione. La LLN si dimostra agevolmente nel caso si assuma anche

P

Infatti, la funzione caratteristica di Sn = nj=1 Xj è

E[eitX +itX +···+itX ] = E[eitX eitX

ind

= E[eitX ]E[eitX ] · · · E[eitX ]

id

= E[eitX ]n = ΦX (t)n

ΦSn (t) =

1

n

2

1

2

1

2

V[X] < ∞.

· · · eitXn ]

n

2

Si dice anche che una successione Xn di variabili aleatorie converge quasi certamente alla v.a. X, e si

q.c.

scrive Xn → X, se

P [ lim Xn = X] = 1

n→∞

Se vale la convergenza quasi certa, all’aumentare di n le variabili Xn e X tendono a differire solo per

eventi di probabilità nulla.

18

A. Richiami di probabilità e di statistica

Passando per il logaritmo, log ΦX (t)n = n log ΦX (t). Sviluppando log ΦX (t) secondo

Taylor nell’intorno di 0:

log ΦX (t)

(1)

(2)

(1)

Φ (0)

ΦX (0)ΦX (0) − ΦX (0)2 t2

= log ΦX (0) + X

t+

+ R(t)t3

ΦX (0)

ΦX (0)2

2

t2

= 0 + i [X]t + (i2 [X 2 ] − (i [X])2 ) + R(t)t3

2

2

t

= i [X]t + (− [X 2 ] + [X]2 ) + R(t)t3

2

t2

= i [X]t − [X] + R(t)t3

2

t=0

E

E

E

E

E

E

E

V

Si ha quindi:

E

n

log ΦSn (t) = log ΦX (t) = n i [X]t −

V

t2

[X] + R(t)t3

2

!

Poiché ΦaX (t) = ΦX (at), per X̄n si ha:

t

n

ΦX̄n (t) = Φ 1 Sn (t) = ΦSn

n

t

n

log ΦX̄n (t) = log ΦSn

E

t

= n i [X] −

n

E

a) se

t

V[X] 2n

+R

2

= i [X]t −

Ora:

V

3!

t

t2

t

[X] 2 + R

2n

n

n3

3

t t

n

n2

E[X] = µ = 0,

V

t t3

t2

+R

log ΦXn (t) = − [X]

2n

n n2

lim log ΦXn (t) = 0 ⇒

lim ΦXn (t) = [eitXn ] = 1

n→∞

E

n→∞

Questo vuol dire che la funzione caratteristica di X̄n converge a quella di una variabile

d

aleatorie degenere X = 0, ovvero X̄n → 0, e ciò implica:

X̄n =

E

Sn p

→0=µ

n

b) se [X] = µ 6= 0, ponendo Yn = Xn − µ,

analogo a:

n

X

Yj

j=1

n

=

n

X

Xj − µ

j=1

n

=

n

X

Xj

j=1

n

E[Y ] = E[X] − µ = 0, si perviene in modo

p

− µ = X̄n − µ → 0

⇒

p

X̄n → µ

La LLN dice che, quando l’ampiezza di un campione è sufficientemente elevata, allora,

per quanto piccolo si possa scegliere ε, la probabilità che la media campionaria si trovi

nell’intervallo µ ± ε tende a 1. Ciò non vuol dire che X̄n sia realmente vicino a µ, ma solo

che questo avviene con probabilità molto elevata.

19

Successioni di variabili aleatorie

A.4.3

Il teorema del limite centrale

Teorema A.2 (Teorema del limite centrale, CLT (Central Limit Theorem)). Data una

successione Xn di variabili aleatorie indipendenti e identicamente distribuite, con [X] =

µ < ∞ e [X] = σ 2 < ∞, indicando con Sn la somma dei primi n termini, si ha:

E

V

E

Sn − [Sn ] d

√

→ N (0,

n

Dimostrazione. Sia

V[X])

E[X] = 0, quindi E[Sn] = 0. Sia Un = √Snn . Procedendo come nella

dimostrazione della LLN si ottiene:

ΦUn (t) = ΦSn

t

√

n

nonché:

log ΦUn (t) = log ΦSn

t

√

n

V

√

t2

t3

= n − [X] √ 2 + R(t/ n) √ 3

2( n)

( n)

V

= − [X]

√

t2

t3

+ R(t/ n) 1/2

2

n

quindi:

lim log ΦUn (t) = lim log ΦSn

n→∞

!

n→∞

da cui:

lim ΦUn (t) = e−

t2

t

√

n

=−

V

t2 [X]

2

V[X]

2

Ma questa è la funzione caratteristica di una v.a. normale con media nulla e varianza

[X], quindi:

d

Un → N (0, [X])

V

Se

V

E[Sn] 6= 0, basta sostituire Sn con gli scarti Sn − E[Sn] e si ha:

Sn − E[Sn ] d

√

→ N (0, V[X])

n