3

Forme bilineari e forme sesquilineari

3.1

Definizioni

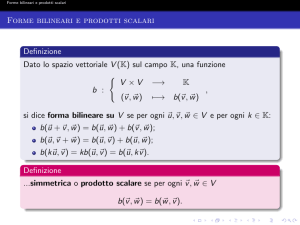

Sia V uno spazio vettoriale su K .

Definizione 3.1 Un’applicazione B : V × V → K si dice bilineare se

1. B(v + w, z) = B(v, z) + B(w, z)

2. B(kv, w) = kB(v, w)

3. B(v, w + z) = B(v, w) + B(v, z)

4. B(v, kw) = kB(v, w)

La forma si dice inoltre simmetrica se B(v, w) = B(w, v) e antisimmetrica ( o

alternante) se B(v, w) = −B(w, v).

Sia V uno spazio vettoriale su C .

Definizione 3.2 Un’applicazione H : V × V → C si dice sesquilineare se

1. H(v + w, z) = H(v, z) + H(w, z)

2. H(kv, w) = kH(v, w)

3. H(v, w + z) = H(v, w) + H(v, z)

4. H(v, kw) = k̄H(v, w)

La forma si dice inoltre hermitiana se H(v, w) = H(w, v) e antihermitiana se

H(v, w) = −H(w, v)

Le proprietà 1 e 2 segnalano che B (H) è lineare nella prima variabile, le

proprietà 3 e 4 segnalano che B è lineare (H antilineare) nella seconda variabile.

Proposizione 3.1 Ogni forma bilineare (sesquilineare) è somma di una forma

simmetrica e una antisimmetrica (hermitiana e antihermitiana).

Dim.

B(v, w) + B(w, v) B(v, w) − B(w, v)

+

(19)

2

2

Il primo addendo è una forma bilineare simmetrica, S(B), il secondo è una forma

bilineare antisimmtrica, A(B).

B(v, w) =

H(v, w) =

H(v, w) + H(w, v) H(v, w) − H(w, v)

+

2

2

(20)

Il primo addendo è una forma hermitiana il secondo è una forma antihermitiana.

35

A ogni forma bilineare B(v, w) si può associare una forma quadratica Q :

V → K, definita da

Q(v) = B(v, v).

Per ogni forma quadratica vale

Q(kv) = k 2 Q(v)

Q(v + w) = Q(v) + Q(w) + B(v, w) + B(w, v).

Se la forma è simmetrica allora

Q(v + w) − Q(v) − Q(w)

.

(21)

2

Molte forme bilineari definiscono la stessa forma quadratica ma fra di loro ve

ne è una sola simmetrica; infatti B e S(B) generano la stessa forma quadratica,

il che garantisce che nell’insieme delle forme bilineari che generano la stessa

forma quadratica ve ne è una simmetrica, e d’altra parte per la (21) questa è

univocamente determinata da Q.

In modo analogo a quanto visto sopra, a una forma sesquilineare H(v, w) si

associa la forma H-quadratica QH : V → C, definita da

B(v, w) =

QH (v) = H(v, v).

Per ogni forma H-quadratica vale

2

QH (kv) = |k| QH (v)

QH (v + w) = QH (v) + QH (w) + H(v, w) + H(w, v),

da cui se la forma H è hermitiana si ha

H(v, w) = ReH(v, w) + iImH(v, w) =

QH (v + iw) − QH (v) − QH (w)

QH (v + w) − QH (v) − QH (w)

+i

.

(22)

2

2

Osserviamo che la forma H-quadratica associata a una forma hermitiana

è reale, nel senso che assume solo valori reali, infatti h(v, v) = h(v, v) ∈ R.

(Analogamente la forma H-quadratica associata a una forma antihermitiana è

immaginaria pura.)

Vi è corrispondenza biunivoca fra le forme hermitiane e le forme H-quadratiche

reali, infatti dalla (20) segue che fra tutte le forme sesquilineari che definiscono

una forma H-quadratica reale ve ne è una hermitiana e d’altra parte una forma

hermitiana che definisce una forma H-quadratica reale QH può essere ricostruita

a partire da QH , per la (22), ed è quindi univocamente determinata.

Esempio 3.1 Sia A ∈ Mnn (K) l’applicazione

B : Kn × Kn

(x, y)

→

K

7→ xt Ay

è una forma bilineare in Kn . La forma B è simmetrica se e solo se A è simmetrica.

36

Definizione 3.3 Una matrice A ∈ Mnn (C) si dice hermitiana se A = Āt .

Esempio 3.2 Sia A ∈ Mnn (C), l’applicazione

H : C n × Cn

(x, y)

→

C

7→ xt Aȳ

è una forma sesquilineare in Cn . La forma H è hermitiana se e solo se A è

hermitiana.

3.2

Matrici associate a forme bilineari e sesquilineari

Sia B : V × V → K una forma bilineare e sia H : V × V → C una forma

sesquilineare; (si intende che nel primo caso V è uno spazio vettoriale su K , nel

secondo uno spazio vettoriale su C .) Sia V = {v1 , . . . , vn } una base di V .

Definiamo

MV (B) := (B(vi , vj ))1 ≤ i ≤ n

MV (H) := (H(vi , vj ))1 ≤ i ≤ n .

1 ≤ j ≤ n

1 ≤ j ≤ n

Siamo in grado, adesso,Pdi rappresentarePin coordinate la forma bilineare

n

n

(sesquilineare). Siano v = i=1 xi vi e w = j=1 yj vj ,

n

n

X

X

B(v, w) = B

xi vi ,

yj vj =

i=1

n

X

xi yj B(vi , vj ) =

i,j=1

n

X

j=1

xi yj MV (B)ij = xt MV (B)y.

i,j=1

t

dove x = (x1 , . . . , xn ) e y = (y1 , . . . , yn )t . Similmente

n

n

X

X

H(v, w) = H

xi vi ,

yj vj =

i=1

n

X

i,j=1

xi ȳj H(vi , vj ) =

n

X

j=1

xi ȳj MV (H)ij = xt MV (H)ȳ.

i,j=1

La rappresentazione in coordinate rispetto alla base V della forma quadratica

Q associata alla forma bilineare B è il seguente polinomio omogeneo di secondo

grado, nelle coordinate x1 , . . . , xn del vettore v:

Q(v) = B(v, v) = xt MV (B)x =

n X

n

X

xi xj B(vi , vj ),

i=1 j=1

e nel caso in cui la forma bilineare B sia la forma bilineare simmetrica associata

alla forma quadratica Q, posso scrivere

37

Q(v) =

n

X

Q(vi )x2i

+2

i=1

n

n

X

X

B(vi , vj )xi xj .

i=1 j=i+1

Per cui, se il polinomio omogeneo di secondo grado

n

X

aii x2i +

n

n

X

X

i=1

aij xi xj

i=1 j=i+1

rappresenta la forma quadratica Q, rispetto la base V, la matrice che rappresenta

la forma bilineare simmetrica24 B associata alla forma quadratica Q, rispetto

la stessa base, è

a11 a212 . . . a21n

a

a

2n

12 a22 . . .

2

2

MV (B) =

.

.

.

... ...

. ...

a1n

a2n

. . . ann

2

2

Nel caso di una forma hermitiana H la rappresentazione in coordinate della

forma H-quadratica associata è data da

QH (v) =

n

n X

X

i=1 j=1

xi xj H(vi , vj ) =

n

X

QH (vi )|xi |2 +2

n

n

X

X

Re(H(vi , vj )xi x̄j ).

i=1 j=i+1

i=1

La matrice associata a una forma bilineare (sesquilineare) dipende dalla base.

Vediamo le relazioni che sussistono fra due matrici associate alla stessa forma

rispetto due basi diverse. Sia V 0 = {v10 , . . . ,P

vn0 } un’altra base P

di V . Nella nuova

n

n

base i vettori v, w si rappresentano v = i=1 x0i vi0 e w = j=1 yj0 vj0 . Dalle

formule di cambiamento di coordinate abbiamo

x = MVV 0 (id)x0

y = MVV 0 (id)y0

Da cui

B(v, w) = xt MV (B)y =

(MVV 0 (id)x0 )t MV (B)MVV 0 (id)y0 =

t

0

x0t MVV

0 (id)MV (B)MVV 0 (id)y

d’altra parte

B(v, w) = x0t MV 0 (B)y0

pertanto

t

0

x0t MV 0 (B)y0 = x0t MVV

0 (id)MV (B)MVV 0 (id)y

che, valendo per ogni x0 e y0 , implica

t

MV 0 (B) = MVV

0 (id)MV (B)MVV 0 (id).

24 in

qualche libro tale forma si chiama forma polare associata alla forma quadratica

38

Analogamente, nel caso sesquilineare, otteniamo

t

MV 0 (H) = MVV

0 (id)MV (H)MVV 0 (id).

Definizione 3.4 Due matrici A, B ∈ Mnn (K) si dicono congruenti se esiste

una matrice M ∈ GLn (K) tale che

A = M t BM.

Definizione 3.5 Due matrici A, B ∈ Mnn (C) si dicono H-congruenti se esiste

una matrice M ∈ GLn (C) tale che

A = M t B M̄ .

Le relazioni di congruenza e H-congruenza sono di equivalenza. Verifica per

esercizio.

Abbiamo dunque provato che

Proposizione 3.2 Le matrici associate alla stessa forma bilineare (sesquilineare) rispetto a due basi diverse sono congruenti (H-congruenti).

La definizione di H-congruenza (3.5) è spesso presentata con la condizione

A = M̄ t BM , che è del tutto equivalente, perché se M soddisfa la condizione

della (3.5), allora M̄ soddisfa la variante su esposta.

Proposizione 3.3 Il rango della matrice associata a una forma bilineare (sesquilineare) non dipende dalla base scelta.

Dim. Moltiplicando una matrice per una matrice invertibile non si altera il

rango e del resto il rango non viene alterato dalle operazioni di trasposizione e

di coniugio di una matrice.

Proposizione 3.4 Il determinante di una matrice associata a una forma hermitiana è reale.

Dim. La matrice associata a una forma hermitiana è una matrice hermitiana,

cioè A = Āt . Da cui

det(A) = det(Āt ) = det(At ) = det(A).

Definizione 3.6 Se il rango di una forma bilineare (o sesquilineare) è minore

della dimesione di V allora la forma si dice degenere.

Proposizione 3.5 Una forma bilineare B è non degenere se e solo se

∀v 6= 0

∃w

B(v, w) 6= 0

(o, equivalentemente, ∀w 6= 0 ∃v B(v, w) 6= 0.

Stessa cosa per una forma sesquilineare H.

39

(23)

Dim. La forma B in coordinate, rispetto a una base V, si rappresenta xt Ay,

dove x e y sono vettori colonna che rappresentano le coordinate di v e w ed

A = MV (B). B è non degenere se e solo se det(A) 6= 0.

• B non degenere ⇒ (23)

Da v 6= 0 segue x 6= 0 e questo implica rk(xt ) = 1; poiché il prodotto per

una matrice invertibile non altera il rango, abbiamo rk(xt A) = 1; quindi

(xt A) non è il vettore riga nullo e avrà una sua componente diversa da

zero. Sia per semplicità la prima componente diversa da zero, allora il

vettore y che ha la prima componente uguale a 1 e tutte le altre nulle è

tale che xtAy 6= 0. Posto w = Vy, abbiamo B(v, w) 6= 0.

• (23) ⇒ B non degenere

Se vale la (23), allora per ogni x 6= 0, esiste y tale che xt Ay 6= 0; pertanto,

per ogni x 6= 0, xt A 6= 0 ed trasponendo per ogni x 6= 0, At x 6= 0 . Il

che significa che il sistema At x = 0 ha solo la soluzione banale e questo è

possibile se e solo se det(A) 6= 0. Dunque B è non degenere.

3.3

Forme bilineari simmetriche e forme hermitiane

Le definizione che seguono vengono enunciate per una forma bilineare simmetrica, ma valgono, sostituendo H a B, anche per una forma hermitiana.

La scelta di una forma bilineare simmetrica B (hermitiana H) permette di

introdurre la nozione di perpendicolarità nello spazio vettoriale V .

Definizione 3.7 Siano v, w ∈ V . v si dice ortogonale a w (si scrive v ⊥ w),

se B(v, w) = 0.

Definizione 3.8 Sia S ⊂ V un sottoinsieme. Si definisce

S ⊥ := {v ∈ V |B(v, w) = 0, ∀w ∈ S}.

É facile verificare che S ⊥ è un sottospazio vettoriale.

Definizione 3.9 Siano U, W, ⊂ V sottospazi. Si dice che U è perpendicolare a

W ( U ⊥ W ) se U ⊂ W ⊥ .

É immediato verificare che U ⊥ W ⇔ W ⊥ U . Il vettore nullo è ortogonale

a ogni vettore dello spazio e se la forma è non degenere esso è l’unico vettore

ortogonale a tutti i vettori di V .

Definizione 3.10 Un vettore v ∈ V si dice isotropo se B(v, v) = Q(v) = 0

(H(v, v) = QH (v) = 0).

40

Il vettore nullo è un vettore isotropo e se la forma è degenere ci sono molti vettori

isotropi, ma anche nel caso di forme bilineari non degeneri possono esistere

vettori isotropi. Per esempio, per

B : C×C

(x, y)

il vettore

1

i

è isotropo. Ed anche per

B : R×R

(x, y)

il vettore

1

0

→ C

7

→

xt y

→

R 0 1

7→ xt

y

1 0

è isotropo.

Definizione 3.11 Sia v non isotropo. Si definisce il coefficiente di Fourier di

w rispetto v, lo scalare

B(w, v)

,

av (w) :=

B(v, v)

analoga definizione per una forma hermitiana H

av (w) :=

H(w, v)

.

H(v, v)

Si ha

B(v, w − av (w)v) = B(v, w) −

B(w, v)

B(v, v) = 0.

B(v, v)

Analogamente per una forma hermitiana

H(v, w − av (w)v) = H(v, w) −

H(w, v)

H(v, v)

H(v, v) = 0.

Da cui, sia nel caso bilineare simmetrico sia nel caso hermitiano, w − av (w)v ∈

{v}⊥ . Poiché , w = av (w)v + (w − av (w)v), e i soli vettori che appartengono

al proprio ortogonale sono i vettori isotropi, possiamo concludere che, se v è un

vettore non isotropo,

V = span{v} ⊕ v⊥ .

(24)

Definizione 3.12 Una base {v1 , . . . , vn } si dice ortogonale se B(vi , vj ) = 0,

(H(vi , vj ) = 0) ogni qual volta i 6= j.

Ne segue che la matrice associata a una forma bilineare (hermitiana) rispetto

una base ortogonale è diagonale.

Prima di provare che esistono basi ortogonali, dimostriamo il seguente

Lemma Ogni forma bilineare B (hermitiana H) non nulla ha almeno un vettore

non isotropo.

41

Dim. Poiché B (H) è non nulla, esistono v, w ∈ V , tali che B(v, w) 6= 0

(H(v, w) 6= 0). Nel caso bilineare simmetrico per la (21) possiamo concludere

che almeno uno fra i tre vettori v, w, v+w, è non isotropo. Nel caso hermitiano

per la (22) possiamo concludere che almeno uno fra i quattro vettori v, w, v+w,

v + iw è non isotropo.

Proposizione 3.6 Sia B (H) una forma bilineare simmetrica (hermitiana).

Esiste una base ortogonale.

Dim. La dimostrazione per induzione non presenta differenze fra il caso simmetrico da quello hermitiano.

Se B è la forma nulla allora ogni base è ortogonale. Se B non è identicamente nulla, procediamo per induzione sulla dimensione di V . Se dim V = 1 la

proposizione è banale.

Assumiamo l’esistenza di una base ortogonale per ogni spazio vettoriale V

di dimensione n − 1. Sia v1 un vettore non isotropo(esiste per il lemma). Per

la (24)

V = span{v1 } ⊕ v1⊥ .

ovviamente B|v1⊥ è ancora bilineare simmetrica. Sia {v2 , . . . , vn } una base ortogonale di v1⊥ ; essa esiste perché dim(v1⊥ ) = n − 1. È facile verificare che

{v1 , v2 , . . . , vn } è una base ortogonnale di V .

Il teorema precedente mostra che per una forma bilineare o hermitiana,

esiste sempre una base rispetto la quale la matrice associata è diagonale. Ci

domandiamo se non sia possibile migliorare ulteriormente il risultato.

Trattiamo prima il caso di una forma B bilineare simmetrica sul campo C.

Proposizione 3.7 Sia B una forma bilineare simmetrica su uno spazio vettoriale complesso V di rango r. Esiste una base V, tale che

Ir 0

MV (B) =

0 0

Dim. Per la proposizione (3.6) sia V 0 = {v10 , . . . , vn0 } una base tale che la

matrice associata MV (B) sia diagonale. Poiché il rango è r, salvo un cambiamento dell’ordine dei vettori della base, posso supporre che i primi r elementi

della diagonale a11 , . . . , arr siano non nulli, mentre tutti gli altri sono 0. Abbiamo dunque che

B(v10 , v10 ) = a11 , . . . , B(vr0 , vr0 ) = arr ,

0

0

B(vr+1

, vr+1

) = 0, . . . , B(vn0 , vn0 ) = 0,

B(vi0 , vj0 ) = 0

42

per i 6= j

Se poniamo

vi =

√1 v0

aii i

vi0

1≤i≤r

r+1≤i≤n

√

dove aii è una delle due radici quadrate di aii , abbiamo che V = {v1 , . . . , vn }

è una base, perché ottenuta da V 0 tramite una matrice invertibile, e che MV (B)

è diagonale con

B(v1 , v1 ) = 1, . . . , B(vr , vr ) = 1, B(vr+1 , vr+1 ) = 0, . . . , B(vn , vn ) = 0.

Poiché sappiamo che il rango è un invariante delle forme bilineari simmetriche, seguendo gli stessi ragionamenti fatti per gli operatori, possiamo concludere

che due forme bilineari simmetriche complesse sono equivalenti, a meno di automorfismi di V, se e solo se hanno lo stesso rango e che quindi il rango classifica

le forme bilineari simmetriche complesse25 .

Poiché due matrici simmetriche complesse, rappresentano la stessa forma

bilineare rispetto basi diverse se e solo se sono congruenti, possimao concludere

che due matrici simmetriche complesse sono congruenti, se e solo se hanno lo

stesso rango.

Nel caso di una forma bilineare simmetrica reale, non possiamo arrivare allo

stesso risultato perché non sempre esiste la radice quadrata di un numero reale.

Abbiamo comunque l’importante

Proposizione 3.8 (Teorema di Sylvester)

Sia B una forma bilineare simmetrica su uno spazio vettoriale reale V di rango

r. Esistono numeri interi p, q, con p + q = r, e una base V, tale che

Ip

0

0

MV (B) = 0 −Iq 0

0

0

0

Inoltre i numeri p, q, non dipendono dalla base, ma solo dalla forma.

Dim. Anche questa volta dalla proposizione (3.6), e salvo un riordinamento

dell’ordine dei vettori, sappiamo che esiste una base V 0 = {v10 , . . . , vn0 } tale che

la matrice associata MV (B) è diagonale, con i primi p termini della diagonale,

a11 , . . . , app , positivi, i secondi q termini, ap+1 p+1 , . . . , arr , negativi e i restanti

nulli. Abbiamo dunque che

B(v10 , v10 ) = a11 , . . . , B(vr0 , vr0 ) = arr ,

0

0

B(vr+1

, vr+1

) = 0, . . . , B(vn0 , vn0 ) = 0,

B(vi0 , vj0 ) = 0

25 ed

anche le forme quadratiche complesse

43

per i 6= j.

Se poniamo

vi =

√1 v0

aii i

√ 1

v0

−aii i

0

vi

1≤i≤p

p+1≤i≤r

r+1≤i≤n

abbiamo che V = {v1 , . . . , vn } è una base, perché ottenuta da V 0 tramite una

matrice invertibile, e che MV (B) è diagonale con

B(v1 , v1 ) = 1, . . . , B(vp , vp ) = 1

B(vp+1 , vp+1 ) = −1, . . . , B(vr , vr ) = −1

B(vr+1 , vr+1 ) = 0, . . . , B(vn , vn ) = 0.

Resta da provare che la coppia p, q non dipende dalla base. Sia pertanto V 00 =

{v100 , . . . , vn00 } un’altra base tale che

B(v100 , v100 ) = 1, . . . , B(vt00 , vt00 ) = 1

00

00

B(vt+1

, vt+1

) = −1, . . . , B(vr00 , vr00 ) = −1

00

00

B(vr+1

, vr+1

) = 0, . . . , B(vn00 , vn00 ) = 0

00

con p 6= t e supponiamo che t < p. Sia U = span{v1 , . . . vp } e W = span{vt+1

, . . . vn00 }.

Dal teorema di Grassmann abbiamo

dim U + dim W = dim(U ∩ W ) + dim(U + W )

p + (n − t) = dim(U ∩ W ) + dim(U + W ) ≤ dim(U ∩ W ) + n

1 ≤ p − t ≤ dim(U ∩ W ).

Per cui esiste un vettore non nullo v ∈ U ∩ W . Poiché v ∈ U ,

v = a1 v1 + . . . + ap vp ,

con a1 , . . . , ap non tutti nulli; e poiché v ∈ W ,

00

v = bt+1 vt+1

+ . . . + bn vn00 .

Dalla prima abbiamo

B(v, v) = a21 B(v1 , v1 ) + . . . + a2p B(vp , vp ) = a21 + . . . + a2p > 0

Mentre dalla seconda

B(v, v) = b2t+1 B(vt+1 , vt+1 ) + . . . + b2n B(vn , vn ) = −b2t+1 − . . . − b2t+r ≤ 0.

questo è assurdo e l’assurdo nasce dall’aver supposto t ≤ p.

44

Nel caso hermitiano abbiamo un teorema perfettamente analogo al teorema

di Sylvester. Anche la dimostrazione è identica, perché gli elementi della diagonale di una matrice hermitiana sono tutti reali.

Definizione 3.13 Si dice segnatura della forma bilineare simmetrica B (o della

forma hermitiana H) la coppia (p, q), corrispondente al numero dei termini

positivi e negativi che si trovano sulla diagonale di una matrice associata a B

(H), rispetto una base ortogonale.

La segnatura è dunque un invariante della forma bilineare simmetrica (hermitiana) e da una parte classifica le forme simmetriche reali (hermitiane) a meno

di automorfismi di V, e dall’altra classifica le matrici simmetriche reali (hermitiane) rispetto la relazione di congruenza (H-congruenza), nel senso che due

matrici sono congruenti (H-congruenti) se e solo se hanno la stessa segnatura.

Più spesso si parla di segnatura di una forma quadratica, riferendosi alla

segnatura della forma bilineare simmetrica associata.

Definizione 3.14 Una forma quadratica (hermitiana) di rango r su uno spazio

vettoriale V di dimensione n prende il seguente nome a seconda della segnatura

(n, 0)

definita positiva

(0, n)

definita negativa

(r, 0) con r < n

semidefinita positiva

(0, r) con r < n

semidefinita negativa

(p, q) con p > 0 e q > 0 indefinita

La ragione dei nomi delle forme quadratiche è dovuta al fatto che una forma

Q è definita positiva se e solo se Q(v) ≥ 0 e Q(v) = 0 ⇔ v = 0.

3.4

Prodotti scalari e prodotti hermitiani

Definizione 3.15 Una forma bilineare simmetrica con forma quadratica associata definita positiva su uno spazio vettoriale reale V si dice un prodotto scalare.

Definizione 3.16 Una forma hermitiana definita positiva su uno spazio vettoriale complesso V si dice un prodotto hermitano.

Supporremo nel seguito sempre definito un prodotto scalare o un prodotto hermitiano, che indicheremo, per ricordarci che è definito positivo, con

< v, w > .

Definizione 3.17 Si dice modulo (o norma) di un vettore v il numero

√

kvk := < v, v >

Proposizione 3.9 (Disuguaglianza di Schwartz)

| < v, w > | ≤ kvkkwk

e vale l’uguaglianza se e solo se v e w sono linearmente dipendenti.

45

Dim. Diamo la dimostrazione nel caso del prodotto hermitiano che presenta

qualche maggiore difficoltà. Se w = 0 il teorema è banale. Per ogni a, b ∈ C,

abbiamo

0 ≤ < av + bw, av + bw >= aākvk2 + bb̄kwk2 + 2Re(ab̄ < v, w >),

(25)

se poniamo a = kwk2 e b = − < v, w >, otteniamo

0 ≤ kwk4 kvk2 + | < v, w > |2 kwk2 + 2Re(−kwk2 | < v, w > |2 ) =

kwk4 kvk2 − | < v, w > |2 kwk2

da cui, dividendo per kwk2 e passando alla radice quadrata, otteniamo la disuguaglianza.

Infine se vale l’uguale ho che

0 =< kwk2 v− < v, w > w, kwk2 v− < v, w > w >

da cui, essendo il prodotto definito positivo, segue che kwk2 v− < v, w > w

è una combinazione lineare nulla non banale di v e w, quindi v e w sono

linearmente dipendenti. Viceversa, se v e w sono uno un multiplo dell’altro,

l’uguaglianza è di immediata verifica.

Dalla disuguaglianza di Schwartz, tanto nel caso reale quanto in quello hermitiano, seguono le seguenti proprietà

1. kvk ≥ 0,

kvk = 0 ⇐⇒ v = 0

2. kkvk = |k|kvk

3. kv + wk ≤ kvk + kwk

La dimostrazione delle prime due è banale, la terza nel caso hermitiano segue

da

kv + wk2 = kvk2 + 2Re < v, w > +kwk2 ≤

kvk2 + 2| < v, w > | + kwk2 ≤

kvk2 + 2kvkkwk + kwk2 =

(kvk + kwk)2 ,

e in maniera simile nel caso reale.

Uno spazio vettoriale dove vi sia una funzione norma, kvk, che soddisfi le tre

proprietà di cui sopra, si dice spazio normato. In uno spazio normato è possibile

definire una funzione distanza d, tramite

d(v, w) := kv − wk;

in effetti d soddisfa le proprietà

46

1. d(v, w) ≥ 0 e d(v, w) = 0 ⇐⇒ v = w

2. d(v, w) = d(w, v)

3. d(v, w) ≤ d(v, z) + d(z, w).

Pertanto, l’introduzione di un prodotto scalare o hermitiano in uno spazio vettoriale arricchisce la sua struttura facendolo diventare anche uno spazio

metrico.

3.5

Operatori ortogonali e unitari

Sia V uno spazio vettoriale di dimensione finita su C (su R) dove sia definita

un prodotto hermitiano (un prodotto scalare) .

Definizione 3.18 Un operatore T : V → V si dice unitario (ortogonale) se

< T (v), T (w) >=< v, w > .

Nelle proposizioni che seguono si faranno le dimostrazioni per il caso unitario,

ottenedosi le dimostrazioni del caso ortogonale in maniera del tutto simile, il

più delle volte , semplicemente omettendo il simbolo del coniugio.

Definizione 3.19 Una matrice A ∈ Mnn (C) si dice unitaria se At Ā = I ( o

equivalentemente AĀt = I)

Proposizione 3.10 Un operatore unitario (ortogonale) gode delle seguenti proprietà

1. conserva il modulo di un vettore

2. conserva la distanza di due vettori

3. trasforma basi ortonormali in basi ortonormali

4. è invertibile

5. la matrice associata all’operatore, rispetto a una base ortonormale, è ortogonale se l’operatore è ortogonale e unitaria se l’operatore è unitario.

Dim. Le proprietà 1), 2) e 3) sono immediata conseguenza della definizione. T

è invertibile perché è iniettivo, infatti T (v) = 0 implica

0 =< T (v), T (v) >=< v, v >

e questo implica v = 0. Infine proviamo l’ultima

Pn proprietà. Sia V = {v1 , . . . , vn }

una base ortonormale di V . Sia T (vi ) = k=1 aki vk , per cui la matrice associata a T , rispetto la base V, è

MV (T ) = (aki ) 1 ≤ k ≤ n .

1 ≤ i ≤ n

47

Abbiamo

δij =< vi , vj >=< T (vi ), T (vj ) >=

n

n

X

X

<

aki vk ,

ahj vh >=

k=1

n

X

k=1

aki

h=1

n

X

āhj < vk , vh >=

h=1

n

X

aki

k=1

n

X

n

X

aki ākj =

k=1

āhj δkh =

h=1

n

X

atik ākj

k=1

dove atik sono gli elementi della matrice trasposta (MV (T ))t ; pertanto

(MV (T ))t (MV (T )) = I,

cioè MV (T ) è una matrice unitaria.

Proposizione 3.11 Se λ è autovalore di un operatore unitario T (ortogonale),

allora |λ| = 1 (λ = ±1).

Dim. Sia v un autovettore relativo all’autovalore λ, abbiamo

< v, v >=< T (v), T (v) >=< λv, λv >= λλ̄ < v, v >,

da cui, essendo v 6= 0, segue la tesi.

Proposizione 3.12 Autovettori relativi a autovalori distinti di un operatore

unitario T (ortogonale) sono ortogonali fra loro

Dim. Siano v e w due autovettori relativi agli autovalori λ e µ, con λ 6= µ.

Abbiamo

< v, w >=< T (v), T (w) >=< λv, µw >= λµ̄ < v, w > .

Da cui, o λµ̄ = 1 o < v, w >= 0. Poiché, per la proposizione precedente,

µµ̄ = 1, non può essere anche λµ̄ = 1, altrimenti λ = µ. Dunque < v, w >= 0.

La seguente proposizione è vera per gli operatori unitari, ma non per gli

operatori ortogonali.

48

Proposizione 3.13 Sia T un operatore unitario. Esiste una base ortonormale

che diagonalizza T .

Dim. Dobbiamo determinare l’esistenza di una base ortonormale di autovettori.

La dimostrazione è per induzione sulla dimensione di V . Se dim V = 1 , il fatto

è banale. Supponiamo di averlo provato per gli spazi vettoriali di dimensione

n − 1 e apprestiamoci a dimostrarlo per gli spazi vettoriali di dimensione n.

Sia λ un autovalore di T ; esso esiste perché siamo sul campo C. Sia v1 un

autovettore unitario, relativo a λ.

Sia w ∈ v1⊥ , abbiamo

0 =< v1 , w >=< T (v1 ), T (w) >=< λv1 , T (w) >= λ < v1 , T (w) >= 0,

da cui, essendo λ 6= 0, segue che < v1 , T (w) >= 0. Dunque T (v1⊥ ) ⊆ v1⊥ .

Naturalmente

T|v1⊥ : v1⊥ → v1⊥

è ancora unitario e opera su uno spazio di dimensione n − 1: Per l’ipotesi

induttiva, esiste una base ortonormale di autovettori per T|v1⊥ , {v2 , . . . , vn }.

Risulta dunque che {v1 , v2 , . . . , vn } è una base ortonormale di autovettori di T .

3.6

Operatori simmetrici, teorema spettrale

Sia V uno spazio vettoriale di dimensione finita su R (su C) dove sia definito

un prodotto scalare (prodotto hermitiano) .

Definizione 3.20 Un operatore T : V → V si dice simmetrico (hermitiano)26

se

< T (v), w >=< v, T (w) >

Proposizione 3.14 La matrice associata a un operatore simmetrico (hermitiano), rispetto a una base ortogonale, è simmetrica (hermitiana).

Dim. Dimostrazione per un operatore

Pn hermitiano. Sia V = {v1 , . . . , vn } una

base ortonormale di V . Sia T (vi ) = k=1 aki vk , per cui la matrice associata a

T , rispetto la base V è

MV (T ) = (aki ) 1 ≤ k ≤ n .

1 ≤ i ≤ n

Abbiamo

< T (vi ), vj >=<

n

X

k=1

aki vk , vj >=

n

X

aki < vk , vj >=

k=1

n

X

aki δkj = aji ,

k=1

26 tali operatori vengono anche chiamati autoaggiunti, infatti si definisce aggiunto di un

operatore T un operatore G tale che

< T (v), w >=< v, G(w) >;

la teoria mostra che per ogni operatore T esiste uno e un solo aggiunto G.

49

similmente

< vi , T (vj ) >=< vi ,

n

X

akj vk >=

k=1

n

X

ākj < vi , vk >=

k=1

n

X

ākj δik = āij .

k=1

Poiché < T (vi ), vj >=< vi , T (vj ) >, abbiamo che aji = āij , da cui MV (T ) =

MV (T )t . Per un operatore simmetrico stessa prova senza il coniugio.

Premettiamo il seguente lemma alla dimostrazione del teorema spettrale.

Lemma Lo spettro di un operatore simmetrico (hermitiano) è totalmente reale;

ovvero il polinomio caratteristico dell’operatore si decompone nel prodotto di n

fattori lineari reali.

Dim. Esprimiamo l’operatore in termini di coordinate rispetto una base ortonormale. Sia V = {v1 , . . . , vn } una base ortonormale di V e sia MV (T ) la

matrice associata. Sia λ un autovalore complesso di MV (T ) e x un corrispondente autovettore27 di Cn . Abbiamo

MV (T )x = λx,

(26)

e, coniugando ambo i membri,

MV (T )x̄ = λ̄x̄.

Utilizzando ora la condizione che, MV (T ) è reale simmetrica nel caso dell’operatore

simmetrico, ovvero che MV (T ) è hermitiana nel caso di un operatore hermitiano,

otteniamo in ogni caso

MV (T )t x̄ = λ̄x̄,

quindi, moltiplicando a sinistra per xt

xt MV (T )t x̄ = xt λ̄x̄,

da cui,posto x = (x1 , . . . , xn ), utilizzando la (26), otteniamo

λ̄

n

X

x̄i xi = λ̄xt x̄ = xt MV (T )t x̄ = (MV (T )x)t x̄ = (λx)t x̄ = λ

i=1

n

X

x̄i xi .

i=1

Pn

Essendo x 6= 0, abbiamo i=1 x̄i xi 6= 0 e quindi λ = λ̄, cioè λ ∈ R. Pertanto

ogni autovalore di MV (T ) complesso è reale e dunque il polinomio caratteristico di MV (T ), che è uguale al polinomio caratteristico di T , si decompone nel

prodotto di fattori lineari reali.

Si osservi che di conseguenza il polinomio caratteristico di un operatore

hermitiano è reale.

27 nel caso T sia un operatore simmetrico, x rappresenta le componenti rispetto la base V,

di un autovettore relativo a λ dell’operatore complessificato TC .

50

Siamo ora in grado di dimostrare il teorema più importante di questo capitolo.

Proposizione 3.15 (Teorema spettrale — versione per gli operatori) Sia T un

operatore simmetrico (o hermitiano). Esiste una base ortonormale che diagonalizza T .

Dim. Dobbiamo determinare l’esistenza di una base ortonormale di autovettori.

La dimostrazione è per induzione sulla dimensione di V . Se dim V = 1 , il fatto

è banale. Supponiamo di aver provato il teorema per gli spazi di dimensione

n − 1 e apprestiamoci a dimostrarlo per gli spazi di dimensione n. Sia λ un

autovalore di T ; esso esiste per il lemma. Sia v1 un suo autovettore unitario.

Sia w ∈ v1⊥ , abbiamo

< v1 , T (w) >=< T (v1 ), w >=< λv1 , w >= λ < v1 , w >= 0.

Pertanto T (v1⊥ ) ⊆ v1⊥ . Naturalmente T|v1⊥ : v1⊥ → v1⊥ è ancora simmetrico

(hermitiano) e opera su uno spazio di dimensione n − 1. Per l’ipotesi induttiva, esiste una base ortonormale di autovettori per T|v1⊥ , {v2 , . . . , vn }. Risulta

dunque che {v1 , v2 , . . . , vn } è una base ortonormale di autovettori di T .

Il teorema spettrale ammette anche diverse letture se lo si esprime in termini

di matrici o in termini di forme bilineari. La versione per le matrici si ottiene

considerando che ogni matrice simmetrica A (hermitiana) definisce un’operatore

simmetrico (hermitiano) T : Rn → Rn (T : Cn → Cn ): l’operatore che mappa

x in Ax.

Proposizione 3.16 (Teorema spettrale — versione per le matrici) Sia A una

matrice simmetrica ( hermitiana). Esiste una matrice M ortogonale (unitaria)

che diagonalizza A, cioè tale che M −1 AM è diagonale.

Se M è ortogonale e M −1 AM è diagonale, allora anche M t AM è diagonale,

quindi la matrice simmetrica A non solo è simile ma è anche congruente a

una matrice diagonale. Se M è hermitiana e M −1 AM è diagonale, abbiamo

che M̄ t AM è diagonale, e ponendo N = M̄ , abbiamo che N t AN̄ è diagonale;

quindi la matrice hermitiana A non solo è simile ma è anche H-congruente a

una matrice diagonale.

Come conseguenza della osservazione precedente otteniamo che se (p, q) è

la segnatura di una matrice simmetrica (hermitiana), allora p rappresenta il

numero degli autovalori positivi e q rappresenta il numero degli autovalori negativi, contati entrambi con la dovuta molteplicità. Dalla stessa osservazione

segue anche la versione del teorema spettrale per le forme bilineari.

Proposizione 3.17 (Teorema spettrale — versione per le forme bilineari) Sia

B una forma bilinerare simmetrica (H una forma hermitiana). Esiste una base

ortonormale che diagonalizza B (H).

51

Quest’ultimo enuciato può essre cosı̀ riletto: se su uno spazio vettoriale V

sono date due forme bilinerai simmetriche (hermitiane) di cui una sia definita

positiva, allora esiste una base che diagonalizza entrambe.

52

![6. Spazi euclidei ed hermitiani 6.1 In [GA] 5.4 abbiamo definito il](http://s1.studylibit.com/store/data/001411348_1-6865080a663f9839123b6698683cc845-300x300.png)