http://www.windizio.altervista.org/appunti/

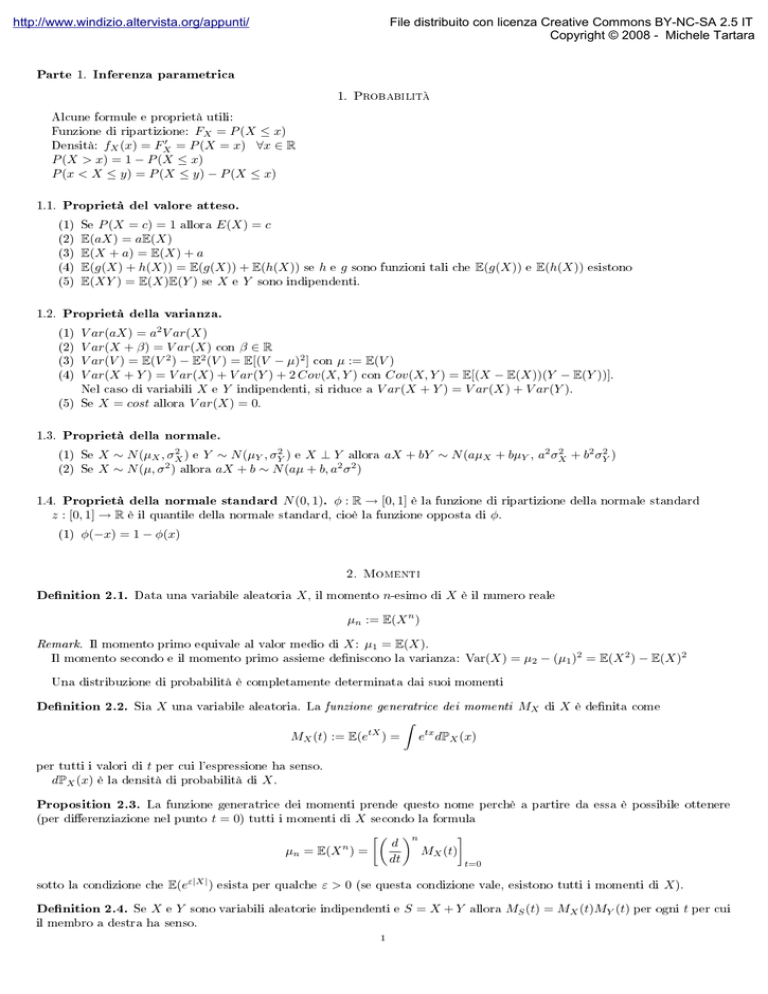

Parte

1.

File distribuito con licenza Creative Commons BY-NC-SA 2.5 IT

Copyright © 2008 - Michele Tartara

Inferenza parametrica

1. Probabilità

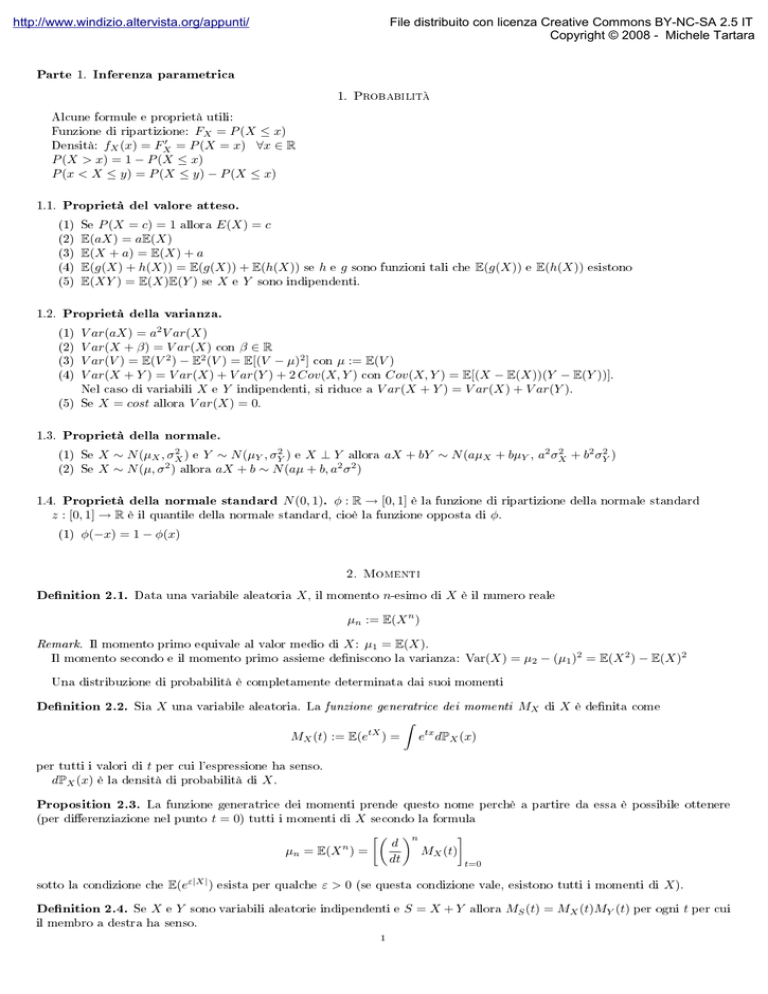

Alcune formule e proprietà utili:

FX = P (X ≤ x)

0

fX (x) = FX

= P (X = x) ∀x ∈ R

P (X > x) = 1 − P (X ≤ x)

P (x < X ≤ y) = P (X ≤ y) − P (X ≤ x)

Funzione di ripartizione:

Densità:

1.1.

Proprietà del valore atteso.

P (X = c) = 1 allora E(X) = c

E(aX) = aE(X)

E(X + a) = E(X) + a

E(g(X) + h(X)) = E(g(X)) + E(h(X)) se h e g sono

E(XY ) = E(X)E(Y ) se X e Y sono indipendenti.

(1) Se

(2)

(3)

(4)

(5)

1.2.

(2)

(3)

(4)

(5)

e

E(h(X))

esistono

V ar(aX) = a2 V ar(X)

V ar(X + β) = V ar(X) con β ∈ R

V ar(V ) = E(V 2 ) − E2 (V ) = E[(V − µ)2 ] con µ := E(V )

V ar(X + Y ) = V ar(X) + V ar(Y ) + 2 Cov(X, Y ) con Cov(X, Y ) = E[(X − E(X))(Y − E(Y ))].

Nel caso di variabili X e Y indipendenti, si riduce a V ar(X + Y ) = V ar(X) + V ar(Y ).

Se X = cost allora V ar(X) = 0.

Proprietà della normale.

(1) Se

(2) Se

1.4.

E(g(X))

Proprietà della varianza.

(1)

1.3.

funzioni tali che

2

2

+ b2 σY2 )

) e Y ∼ N (µY , σY2 ) e X ⊥ Y allora aX + bY ∼ N (aµX + bµY , a2 σX

X ∼ N (µX , σX

2

2 2

X ∼ N (µ, σ ) allora aX + b ∼ N (aµ + b, a σ )

Proprietà della normale standard N (0, 1). φ : R → [0, 1] è la funzione di ripartizione della normale standard

z : [0, 1] → R

(1)

è il quantile della normale standard, cioè la funzione opposta di

φ.

φ(−x) = 1 − φ(x)

2. Momenti

Denition 2.1.

Data una variabile aleatoria

X,

il momento

n-esimo

di

X

è il numero reale

µn := E(X n )

Remark. Il momento primo equivale al valor medio di

X : µ1 = E(X).

Var(X) = µ2 − (µ1 )2 = E(X 2 ) − E(X)2

Il momento secondo e il momento primo assieme deniscono la varianza:

Una distribuzione di probabilità è completamente determinata dai suoi momenti

Denition 2.2.

Sia

X

una variabile aleatoria. La funzione generatrice dei momenti

MX (t) := E(etX ) =

per tutti i valori di

dPX (x)

t

di

X

è denita come

etx dPX (x)

X.

La funzione generatrice dei momenti prende questo nome perchè a partire da essa è possibile ottenere

(per dierenziazione nel punto

t = 0)

tutti i momenti di

n

X

secondo la formula

µn = E(X ) =

sotto la condizione che

E(eε|X| )

Denition 2.4.

e

Se

MX

per cui l'espressione ha senso.

è la densità di probabilità di

Proposition 2.3.

Z

X

Y

esista per qualche

ε>0

d

dt

n

MX (t)

t=0

(se questa condizione vale, esistono tutti i momenti di

sono variabili aleatorie indipendenti e

il membro a destra ha senso.

1

S = X +Y

allora

MS (t) = MX (t)MY (t)

X ).

per ogni

t

per cui

http://www.windizio.altervista.org/appunti/

File distribuito con licenza Creative Commons BY-NC-SA 2.5 IT

Copyright © 2008 - Michele Tartara

2

3. Famiglia delle densità gamma

Denition 3.1.

X ∼ Γ(a, β)

Si dice che una variabile aleatoria

X

ha

densità gamma di parametri a, β

(entrambi > 0) e si scrive

se la funzione di ripartizione della variabile è

(1/β)a −x/β a−1

e

x

1(0,∞) (x)

Γ(a)

f (x, a, β) =

In particolare,

Denition 3.2.

Γ(a)

assume la forma data dalla denizione seguente.

L'integrale gamma

Γ(a)

è

Z

∞

Γ(a) =

e−x xa−1 dx,

a>0

0

Note. La notazione

Proprietà di

Γ(a)

si riferisce all'integrale gamma, mentre

Γ(a, β)

alla densità gamma.

Γ(a):

√

Γ(1) = 1 e Γ(1/2) = π

Derivando per parti Γ(a + 1), si ottiene:Γ(a + 1) = aΓ(a)

Se a è un numero naturale n ≥ 1, allora Γ(n + 1) = n! ∀n ∈ N

(1) Valori particolari:

(2)

(3)

Proposition 3.3. X ∼ Γ(a, β)

ha

funzione generatrice dei momenti

M (t) = E etX =

Si ha inoltre

3.1.

E(X) = aβ , E(X 2 ) = a(a + 1)β 2

Proprietà di Γ(a, β).

Sia

e

1

(1 − βt)a

Var(X) = aβ 2

X ∼ Γ(a, β).

c > 0 e Y = cX allora Y ∼ Γ(a, cβ)

X e Y sono v.a. indipendenti e Y ∼ Γ(c, β) allora X + Y ∼ Γ(a + c, β)

Se c > 0 vale anche l'inverso della precendente, cioè da Y ∼ Γ(c, β) e X + Y ∼ Γ(a + c, β) si può ricavare X ∼ Γ(a, β).

(1) Se

(2) Se

(3)

3.2.

La distribuzione esponenziale.

La densità esponenziale

Exp(β) = Γ(1, β) è un caso particolare della densità gamma.

Assume la seguente forma:

1

x

Exp(β) = exp −

I(0,+∞) (x)

β

β

e la sua FDR è

y

FX (x) = P (X ≤ x) = 1 − e− β

dove

3.3.

β

è il parametro che caratterizza l'esponenziale.

Distribuzione chi quadro.

La densità chi quadro a n gradi di libertà è un sottocaso della distribuzione gamma:

χ2n = Γ( n2 , 2).

Già sappiamo che se

X ∼ N (0, 1)

3.4.

Distribuzione F di Fisher.

m

n

e

gradi di libertà. Se

U

e

V

allora

X 2 ∼ χ21 .

Si dimostra inoltre che, in tal caso,

Si supponga di avere

U

e

V

Pn

i=1

Xi2 ∼ χ2n

variabili aleatorie con distribuzione

χ2

con rispettivamente

sono statisticamente indipendenti, la statistica

U/m

V /n

ha distribuzione F con

m

gradi al numeratore e

fF (x) =

n

Γ

Γ

m

2

gradi al denominatore, la cui densità è

m+n

2

Γ

n

2

m m/2

n

m+n

m

m − 2

x 2 −1 1 + x

n

χ2 ma con picco più alto e più schiacciato lungo l'asse x.

2

Y1 , . . . , Yn ∼ N (µX , σX

) sono indipendenti e S 2 è lo stimatore della

Il suo graco assomiglia a quello di una

Se

2

)

X1 , . . . , Xm ∼ N (µX , σX

e

2

2

SX

/σX

SY2 /σY2

ha distribuzione F con

3.4.1. Proprietà.

m−1

V ∼ Fm,n

gradi di libertà al numeratore e

⇒

1

V

∼ Fn,m

n−1

al denominatore.

varianza, allora

http://www.windizio.altervista.org/appunti/

File distribuito con licenza Creative Commons BY-NC-SA 2.5 IT

Copyright © 2008 - Michele Tartara

3

4. Funzione di verosimiglianza

Denition 4.1.

f (x, θ), θ ∈ Θ,

n variabili aleatorie X1 , . . . , Xn è data dalla funzione

X1 , . . . , Xn è un campione casuale estratto dalla densità

La funzione di verosimiglianza (Likelihood function) di

di densità congiunta di

X1 , . . . , Xn considerata come funzione di θ.

Se

la funzione di verosimiglianza è

θ 7→ Lθ (x1 , . . . , xn ) =

n

Y

f (xj , θ)

j=1

5. Stimatori

Denition 5.1.

κ(θ),

X1 , . . . , Xn i.i.d. ∼ f (x, θ), θ ∈ Θ, e κ(θ) una caratteristica della popolazione. Uno stimatore di

X1 , . . . , Xn è una statistica T = g(X1 , . . . , Xn ) usata per stimare κ(θ). Il valore assunto da uno

detto stima di κ(θ).

Siano

basato sul campione

stimatore

T

di

κ(θ)

è

Uno stimatore, quindi, è una statistica che permette di stimare una quantità a partire dalla sola conoscenza dei campioni.

Denition 5.2.

Si dice distorsione (bias) di uno stimatore il valore atteso dell'errore commesso nella stima

bias(T ) = E(T − θ) = E(T ) − θ

Perciò uno stimatore con bias pari a zero si dice non distorto:

Denition 5.3.

Una statistica

della caratteristica

κ(θ)

T

che ammette media per ogni

θ

in

Θ

è detta stimatore non distorto o corretto (unbiased)

se

Eθ (T ) = κ(θ) ∀θ ∈ Θ

La media campionaria è stimatore non distorto della media teorica. La varianza campionaria è stimatore non distorto

della varianza teorica.

Note 5.4. Combinazioni lineari di stimatori non distorti danno origine a stimatori non distorti.

La qualità di uno stimatore è misurata tramite il suo errore quadratico medio:

Denition 5.5.

Si denisce errore quadratico medio (Mean Square Error) il valore

M SE := E (T − θ)2

1

che, tramite le proprietà del valore atteso e della varianza , si dimostra essere

M SE = V ar(T ) + bias2 (T )

In particolare, se

T

è uno stimatore non distorto, si ha

M SE(T ) = V ar(T )

Denition 5.6.

Si dice consistente in media quadratica uno stimatore

Tn

di

κ(θ) il cui MSE tende a 0 al crescere del numero

di campioni, cioè tale che

lim E[(Tn − κ(θ))2 ] = 0 ∀θ ∈ Θ

n→∞

dove

n

è il numero di campioni.

Dal punto di vista pratico, per vericare la consistenza in media quadratica è conveniente vericare le due seguenti

condizioni:

lim Eθ (Tn ) = κ(θ)

n→∞

lim V arθ (Tn ) = 0

n→∞

Denition 5.7.

Sia

X1 , . . . , Xn

una successione di variabili aleatorie i.i.d. con comune densità

una statistica funzione solo delle

n

σn2 (θ)

se

µn (θ)

e varianza asintotica

osservazioni.

La successione

Tn − µn (θ)

≤z

σn

lim P

n→∞

{Tn }n

f (x, θ)

con

θ∈Θ

e sia

Tn

è asintoticamente gaussiana con media asintotica

= φ(z) ∀z ∈ R

Questa proprietà è utile nel caso di grandi campioni, per poter approssimare lo stimatore

Tn

con una gaussiana.

1E[(T − θ)2 ] = E[T 2 + θ2 − 2T θ] = E[T 2 ] + θ2 − 2θE[T ] + E2 [T ] − E2 [T ] = E[T 2 ] − E2 [T ] + E2 [T ] + θ2 − 2θE[T ] = V ar(T ) − bias2 (T )

|

{z

} |

{z

}

V ar(T )

(E[T ]−θ)2 =bias2 (T )

http://www.windizio.altervista.org/appunti/

File distribuito con licenza Creative Commons BY-NC-SA 2.5 IT

Copyright © 2008 - Michele Tartara

4

5.1.

Stimatori a massima verosimiglianza.

Denition 5.8.

X1 , . . . , Xn un campione casuale con

g(x1 , . . . , xn ) un valore in Θ tale che

Siano

zazione campionaria e

funzione di verosimiglianza

Lθ , θ ∈ Θ, x1 , . . . , xn

una realiz-

Lg(x1 ,...,xn ) (x1 , . . . , xn ) = maxLθ (x1 , . . . , xn )

θ∈Θ

La statistica

θ̂ = g(X1 , . . . , Xn )

è detta stimatore di massima verosimiglianza di

θ.

Per indicare

θ̂

useremo l'acronimo ML

(Maximum Likelihood ) o MLE (Maximum Likelihood Estimator ).

Generalmente, per semplicare alcuni conti, quando si calcola uno stimatore a massima verosimiglianza si preferisce

introdurre il logaritmo di

L.

L

=0

θ̂ : ∂ log

∂θ

caratteristica κ(θ) dipendente

Lo stimatore risulta quindi essere

Lo stimatore di una

dalla quantità

θ

stimata da

θ̂

è dato da

κ(θ̂).

Lo stimatore di massima verosimiglianza di una distribuzione esponenziale è la media campionaria:

θ̂(X1 , . . . , Xn ) = X̄ .

Lo stimatore di massima verosimiglianza di una distribuzione di Poisson è la media campionaria.

5.2.

Stimatori UMVUE.

Denition 5.9.

(1)

(2)

T ∗ che

κ(θ)

Uno stimatore

∗

T è non distorto per

V arθ (T ∗ ) ≤ V arθ (T ) per

ogni

gode delle proprietà

θ

e per ogni stimatore T non distorto e a varianza nita

è detto stimatore non distorto a varianza uniformemente minima (Uniform Miminum Variance Unbiased Estimator), o

stimatore UMVUE.

Remark 5.10. Proprietà degli stimatori UMVUE

Unicità: se lo stimatore UMVUE esiste, è unico.

Simmetria: Sia T ∗ = g(X1 , . . . , Xn ) UMVUE, allora

Pθ g(X1 , . . . , Xn ) = g(Xπ(1) , . . . , Xπ(n) ) = 1 ∀θ ∈ Θ

per ogni permutazione

Nosense:

π

di

{1, . . . , n}.

Lo stimatore UMVUE potrebbe esistere ma essere insensato.

5.2.1. Disuguaglianza di Fréchet-Cramer-Rao. È possibile trovare un conne inferiore (lower bound) della varianza nella

classe di tutti gli stimatori non distorti che sia funzione solo della caratteristica da stimare

mediante la verosimiglianza

Lθ .

κ(θ)

e del modello statistico

È anche possibile costruire uno stimatore che abbia varianza coincidente con esso.

Tale

stimatore sarà lo stimatore UMVUE. Il lower bound e lo stimatore possono essere trovati tramite la disuguaglianza di

Fréchet-Cramer-Rao,

V arθ (T ) ≥

(κ0 (θ))2

nI(θ)

∀θ ∈ Θ

denita dall'omonimo teorema:

Theorem 5.11.

Sia (X1 , . . . , Xn ) un campione aleatorio dalla famiglia di densità

(perchè dovremo derivarlo).

f (x, θ)

κ(θ) la caratteristica da stimare e T = g(X1 , . . . , Xn ) lo stimatore non distorto per

Supponiamo che valgano le seguenti ipotesi (dette di regolarità):

Sia

(1)

(2)

(3)

(4)

Θ intervallo aperto di R

S = {x : f (x, θ) > 0} non dipende da θ

θ7→ f (x, θ) è dierenziabile

in Θ,∀x

∂

Eθ ∂θ

log f (X1 , θ) = 0, ∀θ

(5) Deve essere:

0 < I(θ) < +∞, ∀θ,

con

(6)

κ

S

κ(θ)

θ ∈ Θ ⊂ R

(a varianza nita).

è il supporto)

I(θ) = Eθ

Note 5.12. Se la (4) è vericata, allora

(4)

(NB:

a parametro reale

h

∂

∂θ

I(θ) = V ar

log f (X1 , θ)

∂

∂θ

2 i

log f (X1 , θ) ,

che è detta

perché

informazione di sher

V ar[X] = E[X 2 ] − (E[X])2 ,

ma per la

E[X] = 0.

è dierenziabile in

Θ

e

κ0 (θ) = E T ·

∂

∂θ

log L(θ; X1 , . . . , Xn ) ∀θ ∈ Θ,

Allora:

dove

L

è la funzione di verosimiglianza.

2

V ar(T ) ≥

(κ0 (θ))

, ∀θ ∈ Θ

n · I(θ)

Note 5.13. I modelli Esponenziale, Gaussiano e di Poisson soddisfano le ipotesi di Fréchet-Cramer-Rao.

Denition 5.14.

T ∗ di κ(θ) non distorto

0

(θ))2

V ar(T ∗ ) = (κnI(θ)

.

Uno stimatore

Cramer-Rao è detto eciente e

la cui

varianza raggiunge il conne inferiore

di Fréchet-

http://www.windizio.altervista.org/appunti/

File distribuito con licenza Creative Commons BY-NC-SA 2.5 IT

Copyright © 2008 - Michele Tartara

5

κ(θ) = θ,

Nel caso in cui

allora

V ar(T ∗ ) =

1

nI(θ) .

.

Uno stimatore eciente è anche UMVUE

Condizione necessaria e suciente perchè uno stimatore sia eciente è che

∂

log L(θ, X1 , . . . , Xn ) = a(n, θ)(T − κ(θ))

∂θ

cioè che la derivata in

da stimare e

T

θ

del logaritmo della funzione di verosimiglianza sia una funzione lineare di

stima di

T − κ(θ), con κ(θ) quantità

κ(θ).

6. Media e varianza campionarie

Denition 6.1.

X

Data una serie di variabili aleatorie

X1 , . . . , Xn

è uno stimatore (puntuale) non distorto del valore atteso

Denition 6.2.

S2

σ2 .

µ,

S 2 :=

in quanto

1

n−1

X=

Pn

i=1

Xi

n

.

E(X) = µ

Pn

Pn

(X 2 )−nX̄ 2

j

j=1

2

.

j=1 (Xj − X) =

n−1

P

n

2

E(S 2 ) = σ 2 (perchè E

= (n − 1)σ 2 )

j=1 (Xj − X)

La varianza campionaria è denita come

è uno stimatore (puntuale) della varianza

la media campionaria è denita come

quindi, poichè in

media assume il valore corretto, viene denito stimatore non distorto della varianza.

Distribuzioni di media e varianza campionarie di popolazione gaussiana.

6.1.

Proposition 6.3.

(1)

(2)

(3)

Sia

X1 , . . . , Xn

un campione casuale gaussiano dalla f.d.r.

N (µ, σ 2 ).

Per ogni

µ∈R

e per ogni

σ2 > 0

2

X ∼ N (µ, σn )

2

le statistiche S e X sono

2

2

(n − 1)S /σ ∼ χ2n−1

Questo sarà utile come

(4) La statistica

indipendenti.

statistica

test

√

X−µ

√ (dove

S/ n

S2)

S=

per calcolare gli intervalli di condenza

ha densità t di student con

n−1

per la varianza.

gradi di libertà.

statistica test per la media

X−µ

√ è la media campionaria normalizzata da usare come

S/ n

quando la varianza è incognita, e quindi stimata da S . Conoscendone la distribuzione, possiamo sfruttare le tavole

Questo è utile in quanto

per lavorare con questa statistica.

t di Student.

6.2.

Denition 6.4.

Si dice che

Siano

√Z

Y

k

Z

e

Y

Z ∼ N (0, 1) e Y ∼ χ2k .

Student con k gradi di libertà, cioè tk .

due v.a. indipendenti. Sia

è distribuita secondo una

t

di

Tale distribuzione ha densità:

Γ k+1

1

2

fk (t) = √

t∈R

k+1

k

kπΓ 2 1 + t2 2

k

che è simile ad una gaussiana, ma con code più alte.

Quando

k → +∞,

la distribuzione

t

si avvicina sempre più ad una normale.

7. Intervalli di confidenza

Gli stimatori puntuali non sono particolarmente interessanti in quanto è nulla la probabilità che assumano il vero valore

(incognito) della variabile da stimare. Ad esempio, nel caso della media campionaria (stimatore della media)

Pµ,σ2 (X = c) = 0, ∀c ∈ R, µ ∈ R, σ 2 > 0

Possiamo tuttavia calcolare, a priori e indipendentemente dalla realizzazione campionaria, con un certo grado di ducia

un intervallo all'interno del quale andrà con buona approssimazione a cadere il valore cercato.

Per trovare intervalli di condenza bilateri di livello

γ100%

si usa la seguente formula:

P(a < T < b) = γ

T

dove

è la statistica test opportuna e

a

e

b

sono quantili di tale statistica test.

Tale formula dovrà essere risolta in funzione della quantità per la quale si cerca l'intervallo.

7.1.

con

Per la media.

2

s

Per la media si usa come statistica test

varianza campionaria, se la varianza è incognita.

x̄−µ

√0

σ/ n

∼ N (0, 1)

se la varianza

σ2

è nota, oppure

x̄−µ

√0

s/ n

∼ tn−1 ,

http://www.windizio.altervista.org/appunti/

File distribuito con licenza Creative Commons BY-NC-SA 2.5 IT

Copyright © 2008 - Michele Tartara

6

7.2.

Per la varianza.

• µ

incognita

S 2 (n−1)

σ2

Per trovare un intervallo di condenza si parte dalla quantità aleatoria

a

determinare sono

a

b

e

e

b

2

S (n−1)

σ2

Pµ,σ2 a <

tali che

sono quantili di una f.d.r.

< b = γ.

∼ χ2n−1 .

Ciò che si vuole

χ2n−1 .

Si presentano diversi casi:

(1) [a

= 0]

b = χ2n−1 (γ)

Denition 7.1.

x1 , . . . , x n

Sia

γ ∈ (0, 1) e sia s2

il valore assunto da

livello

in corrispondenza della realizzazione campionaria

di un campione casuale estratto da una popolazione

(dove

S2

χ2n−1 (γ)

γ100%

è il quantile di ordine

per la varianza

σ

2

γ

2

s (n − 1)

, +∞

χ2n−1 (γ)

della f.d.r

µ

, quando

N (µ, σ 2 ).

Allora

χ2n−1 )

è un intervallo di condenza a una coda superiore di

è incognita. Inoltre, la statistica

S 2 (n−1)

è detta limite inferiore di

χ2n−1 (γ)

condenza per la varianza.

(2) [b

= +∞]

a = χ2n−1 (1 − γ)

Denition 7.2.

x1 , . . . , xn di

Sia

γ ∈ (0, 1) e sia s2

il valore assunto da

S2

in corrispondenza della realizzazione campionaria

un campione casuale estratto da una popolazione

2

0,

s (n − 1)

χ2n−1 (1 − γ)

N (µ, σ 2 ).

Allora

γ100% per la varianza

S 2 (n−1)

Inoltre, la statistica 2

è detta limite superiore di condenza per la varianza.

χn−1 (1−γ)

è un intervallo di condenza a una coda inferiore di livello

(3) [0

σ2

quando

µ

è incognita.

< a < b < +∞]

La massa rimanente deve essere distribuita uniformemente a destra e a sinistra dell'intervallo, quindi:

χ2n−1 ( 1−γ

2 )

e

Denition 7.3.

x1 , . . . , x n

Sia

γ ∈ (0, 1) e sia s2

di un campione casuale

S 2 in corrispondenza della realizzazione campionaria

2

estratto dalla f.d.r. N (µ, σ ). Allora

!

s2 (n − 1)

s2 (n − 1)

, 2

χ2n−1 1+γ

χn−1 1−γ

2

2

il valore assunto da

è un intervallo di condenza bilatero per

• µ

a =

1+γ

2

b = χ2n−1 ( 1−γ

2 + γ) = χn−1 ( 2 )

σ2

di livello

γ100%,

quando

µ

è incognita.

nota

Essendo

µ

nota, possiamo stimare

σ2

con la statistica

µ).

S02 n

2

si ottiengono i seguenti intervalli

σ 2 ha densità χn , quindi

S02 :=

Pn

2

j=1 (Xj −µ)

n

(che è lo stimatore di massima

verosimiglianza di

Pn

di condenza per

σ2

di livello

γ100%

quando

2

j=1 (xj−µ )

, +∞ (intervallo di condenza a una coda superiore)

χ2n (γ)

Pn

2

j=1 (xj −µ)

0, χ2 (1−γ)

(intervallo di condenza a una coda inferiore)

n

Pn

P

2

n

2

j=1 (xj −µ)

j=1 (xj −µ)

,

(intervallo di condenza bilatero)

χ2n ( 1+γ

χ2n ( 1−γ

2 )

2 )

8. Intervalli di confidenza per grandi campioni

8.1.

Per la media µ.

Essendo

n

Sia

X1 , . . . , Xn

un campione con

n

grande da una popolazione con media

grande, il campione può essere trattato come una normale

La statistica

X̄−µ

√ , dove

σ/ n

X̄

P

µ

di dimensione

σ

X̄ − µ

√ < z 1+γ

−z 1+γ √ <

2

2

n

σ/ n

'γ

L'intervallo di condenza è quindi

IC =

e varianza

N (µ, σ ).

è la media campionaria, è distribuita come una normale standard

È quindi possibile denire un intervallo di condenza per la media

µ

2

σ

σ

X̄ − z 1+γ √ , X̄ + z 1+γ √

2

2

n

n

γ

N (0, 1).

calcolando

σ2 .

µ

è nota :

http://www.windizio.altervista.org/appunti/

File distribuito con licenza Creative Commons BY-NC-SA 2.5 IT

Copyright © 2008 - Michele Tartara

7

Per una generica caratteristica κ(θ).

8.2.

κ̂ ∼ N κ(θ),

matore di massima verosimiglianza

V ar(κ̂))

colabile come

Supponiamo di dover stimare una caratteristica

(κ0 (θ))2

nI(θ)

di cui abbiamo lo sti-

, con media pari alla caratteristica da stimare e varianza (cal-

che raggiunge il limite inferiore di Fréchet-Cramer-Rao.

∂

log f (X1 , θ))2

I(θ) = E ( ∂θ

κ(θ)

Per

n

κ̂−κ(θ)

grande, r

(κ0 (θ))2

nI(θ)

∼ N (0, 1),

dove

è l'informazione di Fisher.

γ

Un intervallo di condenza di ampiezza

si denisce quindi a partire da

κ̂ − κ(θ)

< q 0 2 < z 1+γ = γ

Pθ −z 1+γ

(κ (θ))

nI(θ)

2

2

ed è

s

κ̂ − z 1+γ

(κ0 (θ̂))2

nI(θ̂)

2

θ

dove tutti i

s

, κ̂ + z 1+γ

(κ0 (θ̂))2

2

!

nI(θ̂)

presenti al denominatore del pivot della equazione precedente possono essere approssimati con l'MLE

perché è dimostrabile che questa sostituzione mantiene l'asintoticità a

θ̂

N (0, 1).

9. Test di ipotesi

Denition 9.1. Una ipotesi H è una aermazione sulla distribuzione F della popolazione.

semplice: se l'ipotesi specica completamente (determina) un'unica distribuzione

composta: altrimenti

Un'ipotesi si denisce

Ciò che ci interessa è una procedura statistica (test) che stabilisca se i dati campionari sono compatibili con l'ipotesi

In tal caso si dice che accetto

Se i dati non sono compatibili con

Denition 9.2.

H,

H.

allora riuto

Una verica di ipotesi è una terna ordinata

(X1 , . . . , Xn ; H0 , H1 ;

{z

} | {z }

|

campione

con

Se

Se

H.

H.

G

|{z}

)

ipotesi regione critica

G ⊆ Rn .

(x1 , . . . , xn ) ∈ G ⇒ riuto l'ipotesi H0 e accetto H1

(x1 , . . . , xn ) ∈ Gc ⇒ non riuto H0 e riuto H1 .

VERO

H0

H1

ACCETTO

H0

H1

OK

Errore di II specie

Errore di I specie

OK

Denition 9.3. (Taglia del test) α := sup Pθ (x ∈ G) con θ ∈ Θ0

α è anche detto livello di signicatività

PH0 (Accetto H1 ) = PH0 (Riuto H0 ).

Denition 9.4.

la probabilità

Il più piccolo valore di

PH0 (Riuto H0 )

del test ed è la probabilità di commettere un errore di I specie, cioè

α per cui, in presenza di x, riuto H0 è detto p-value.

α =

Per calcolare il p-value, si calcola

sotto l'ipotesi che la regione di riuto cominci nel punto indicato dall'attuale realizzazione

campionaria della statistica test.

Quindi:

Se p-value

Se p-value

≤α

≥α

riuto

Analogamente ad

Denition 9.5.

H0

non riuto

di livello di signicatività

H0

α.

di livello di signicatività

α, è possibile denire una funzione β

α.

che rappresenta la probabilità di commettere un errore di II specie:

β := sup Pθ (x ∈ Gc ) con θ ∈ Θ1 .

Cioè, β = PH1 (Riuto H1 )

Allora π = 1 − β(θ) con θ ∈ Θ1 è la funzione di potenza

Sia

Calcolare la potenza di un test sotto l'ipotesi

critica, con

θ

H1 ,

del test.

equivale a calcolare la probabilità dell'appartenenza di T alla regione

determinato dall'ipotesi scelta, riconducendo la scrittura della regione critica a quella di una distribuzione nota,

se ciò è necessario per il calcolo di

P: π(θ ∈ ΘH1 ) = 1−β(θ) = 1−PH1 (Riuto H1 ) = 1−PH1 (Accetto H0 ) = PH1 (Riuto H0 ).

α, è possibile costruire una regione critica tale da massimizzare la potenza del test. Ciò

Data una dimensione pressata di

può essere fatto tramite il Lemma di Neyman-Pearson.

http://www.windizio.altervista.org/appunti/

File distribuito con licenza Creative Commons BY-NC-SA 2.5 IT

Copyright © 2008 - Michele Tartara

8

Denition 9.6. (Lemma di Neyman-Pearson)

Dato un campione (X1 , . . . , Xn ) da f (x, θ) con θ ∈ Θ = {θ0 , θ1 },

=

L(θ

;

x

,

.

.

.

,

x

)

,

L

H0 : θ = θ0 , H1 : θ =

θ

;

L

(x)

0

1

n o 1 (x) = L(θ1 ; x1 , . . . , xn ).

n 1 0

L0 (x)

n

Sia G = G(δ) = (x1 , . . . , xn ) ∈ R :

L1 (x) ≤ δ la regione critica e sia α la sua taglia.

Allora, tra tutte le regioni critiche per vericare H0 contro H1 di taglia α, H è quella con potenza massima.

Una volta impostata la regione critica, per denirla completamente bisogna calcolare

P H0

δ

in modo tale che eettivamente

L0 (x)

L1 (x)

≤ δ = α.

NB: nel fare ciò, tutto ciò che è costante può essere incorporato direttamente dentro a

δ,

rendendo così più semplice la

denizione della regione critica.

H0 e cosa in H1 .

H0 : ciò che ci viene chiesto di vericare. Vericare l'ipotesi che...

H1 : ciò che vogliamo dimostrare. C'è evidenza sperimentale che...?, Possiamo

Remark 9.7. È importante scegliere correttamente cosa va in

In

In

concludere che...?.

10. Test per campioni gaussiani accoppiati indipendenti

Siano

2

X1 , . . . , Xm i.i.d. ∼ N (µX , σX

)

Test F.

2

Y1 , . . . , Yn i.i.d. ∼ N (µX , σX

).

e

2

σX

, σY2 sono incognite e m, n sono grandi.

2

2

2

2

Mira a vericare l'ipotesi H0 : σX = σY contro l'ipotesi H1 : σX 6= σY .

Le varianze, in quanto incognite, devono essere approssimate a partire dai campioni nel seguente modo:

10.1.

Applicabile quando

Pm

2

SX

j=1

=

x2j − m ∗ x̄2

m−1

2

2

j=1 yj − n ∗ ȳ

Pn

SY2 =

dove

x̄, ȳ

L'ipotesi

H0

Fm,n

S2

T = SX2 ∼ Fm−1,n−1 cade nella regione di riuto:

Y

n

α

α o

G = T ≤ Fm−1,n−1

oppure T ≥ Fm−1,n−1 1 −

2

2

di ampiezza α:

α

α Fm−1,n−1

, Fm−1,n−1 1 −

2

2

è riutata quando

cioè nell'itervallo di condenza

dove

n−1

sono le medie dei due campioni.

è la funzione F di Fisher come presente nelle tabelle (attenzione all'ordine dei pedici, alcune tabelle li riportano

al contrario).

Parte

2.

Inferenza non parametrica

Denition 10.1.

La funzione di ripartizione empirica associata al campione

da

F̂n (x) =

F̂n

è una funzione su

R a valori in [0, 1] denita

#{j : Xj ≤ x}

∀x ∈ R

n

11. Media e varianza campionarie

Denition 11.1.

La media di

F̂n

Il momento

r-esimo

F̂n

è

Mr =

1

n

Pn

j=1

Xjr

è uguale alla media campionaria , e, come nel caso parametrico, si ha:

Denition 11.2. E[F̂n ] = M1 =

Quindi

campionario di

1

n

Pn

j=1

Xj

X = M1 .

Nel caso si abbia la distribuzione campionaria è comodo calcolare la media come media pesata:

E[F̂n ] =

n

X

xj dj

j=1

xj è il valore del campione

dj = Fn (xj ) − F (xj − 1).

dove

e

dj

la sua densità, eventualmente ricavabile dalla funzione di ripartizione empirica

F̂n è

Pn

1

Al contrario della media, la varianza di

Denition 11.3.

(Varianza)

V ar[F̂n ] =

n

diversa dalla varianza campionaria, infatti si ha:

j=1 (Xj

− X)2

e

Denition 11.4.

(Varianza campionaria)

S2 =

1

n−1

Pn

j=1 (Xj

n

− X)2 = V ar[F̂n ] n−1

F̂n

come

http://www.windizio.altervista.org/appunti/

File distribuito con licenza Creative Commons BY-NC-SA 2.5 IT

Copyright © 2008 - Michele Tartara

9

V ar(F̂n ) = E[F̂n2 ] − E2 [F̂n ].

con dj denito come sopra.

La varianza è calcolabile anche tramite le normali proprietà di media e varianza, quindi

2

In tal caso, si può calcolare E[F̂n ] come il momento secondo, cioè

E[F̂n2 ]

=

Pn

j=1

2

x dj ,

12. Test di Kolmogorof-Smirnov

Serve a vericare se una funzione F è distribuita secondo una determinata funzione F0 completamente

specicata (cioè con tutti i parametri ssati: ad esempio N (0, 1), Exp(5), ecc) e continua.

Vale per un numero

n

qualsiasi di campioni.

ipotesi nulla

In particolare si controlla l'

H0 : F = F0

contro

Statistica test: Dn :=

Riuto

H0

se

H1 : F 6= F0

|F̂ (x) − F0 (x)|

sup

x∈{n campioni}

Dn > qDn (1 − α)

dove

α

è il livello di signicatività e

qDn

è il quantile della statistica test di Kolmogorof-

Smirnov, cioè riuto se la funzione di ripartizione empirica si discosta più di un massimo sopportabile dalla FDR teorica

F0

(per quanto osservabile con i campioni a nostra disposizione).

NB: essendo

F̂n (x)

discontinua, la dierenza da

F0 (x)

va calcolata sia nell'intorno sinistro, sia nell'intorno destro di ogni

campione, dove essa assumerà valori diversi. Bisognerà quindi calcolare sia

13. Test

χ2

|F̂n (xi ) − F0 (xi )|

sia

|F̂n (xi−1 ) − F0 (xi )|.

di adattamento

Serve a vericare se una serie di dati si adatta ad un determinato modello teorico.

campioni di dimensione n grande, perchè è un test asintotico. Bisogna infatti vericarne

regole empiriche di applicabilità: n ≥ 50 e n · p0i > 5, ∀i ∈ 1, . . . , k

Funziona su dati discreti, oppure su dati continui purchè essi vengano discretizzati tramite suddivisione in classi (il

Può essere usato solo per

le seguenti

test non distingue come la massa si distribuisce all'interno delle classi, ma solo tra le diverse classi).

Si imposta sulle seguenti ipotesi:

H0 : F = F0

contro

H1 : F 6= F0

che possono essere riscritte come:

di

H0 : pi = p0i ∀i = 1, . . . , k contro H1 : pi 6= p0i per qualche i.

dove pi = PF (Xi = ai ) e p0i = PF0 (Xi = ai ), (ai sono le diverse classi),

una certa classe, e p0i è la densità teorica che tale classe dovrebbe avere.

cioè

pi

è la densità osservata in corrispondenza

Per eseguire il test, bisogna calcolare la frequenza assoluta campionaria di ogni

campione che assumono valore

ai ,

cioè il numero di osservazioni del

ai :

Ni = # {j : Xj = ai }

∀i = 1, . . . , k

e misurare lo scostamento fra tali osservazioni e i valori teorici che esse dovrebbero avere (n

· p0i ).

Tale misura viene eettuata mediante la statistica di Pearson:

Qn :=

k

X

(Ni − n p0i )2

i=1

Riutiamo

H0

a livello

α

sse

n p0i

=

k

X

Ni2

−n

np0i

i=1

Qn > χ2k−1 (1 − α), cioè se lo scostamento è troppo grande.

p = 1 − Fχ2k−1 (qn ) dove qn è la realizzazione di Qn .

Il p-value di questo test è calcolabile come:

NB: nel caso la distribuzione teorica non sia completamente specicata e che si debbano stimare a partire dal campione

m

parametri, la regione di riuto sarà:

Qn > χ2k−m−1 (1 − α).

Analogamente, varierà il p-value.

R per l'uso con questo test, il valore ideale è k = n2/5 .

1

esse sia equiprobabile sotto F0 : P (Xi ∈ Ai ) =

k ∀i

Remark 13.1. Se bisogna decidere il numero di classi in cui suddividere

Si sceglieranno poi gli estremi di tali classi in modo che ognuna di

14. Test di indipendenza

Test χ2 di indipendenza.

Serve a vericare se due serie di campioni X e Y sono tra loro indipendenti.

χ2 di indipendenza può essere impostato a partire dalle seguenti ipotesi:

H0 : H(x, y) = F (x) · G(y) ∀x ∈ R ∀y ∈ R cioè X e Y sono indipendenti.

H1 : H(x, y) 6= F (x) · G(y) per almeno un (x, y) ∈ R2 .

Il test lavora discretizzando F in r classi e G in c classi, e contando il numero di coppie tali che il primo elemento è nella

classe Ai e il secondo in Bj , ossia Nij = #(Xk , Yk ) ∈ Ai · Bj , cioè le densità congiunte.

Si calcola poi la probabilità teorica che una coppia ha di appartenere a ogni classe: pi,j = PH (X1 ∈ Ai , Y1 ∈ Bj ), i =

1, . . . , r j = 1, . . . , c

fX (x)·fY (y)

Possiamo anche calcolare, al suo posto, direttamente il numero teorico di elementi di ogni classe, pari a Ei,j =

,

n

dove fx e fY sono le distribuzioni marginali.

14.1.

Il test

http://www.windizio.altervista.org/appunti/

File distribuito con licenza Creative Commons BY-NC-SA 2.5 IT

Copyright © 2008 - Michele Tartara

10

asintotico ed è applicabile solo se valgono le seguenti regole empiriche:

n ≥ 50, nr > 5, nc > 5.

Pr Pc (Nij −Eij )2

P P (Nij )2 Usiamo come statistica test: U :=

=

− n cioè lo scostamento dei valori registrati

i=1

j=1

i

j Eij

Eij

Il test è

dai valori teorici.

Riuto

14.2.

H0

a livello

α

se

Un

è grande, cioè se

Un ≥ χ2(r−1)(c−1) (1 − α).

Test di indipendenza per dati gaussiani.

se il coeciente di correlazione lineare

ρ

Se

(X, Y )

è congiuntamente gaussiana, X,Y sono indipendenti se e solo

è nullo.

Cov(X, Y )

ρ= p

V ar(X) · V ar(Y )

Un valore positivo di

ρ indica concordanza di tipo lineare tra i due campioni, mentre un valore negativo indica discordanza

(quando un campione cresce, l'altro tende a diminuire).

H0 :ρ = 0

H1 :ρ 6= 0.

(indipendenza) contro

Nel caso di campione accoppiato gaussiano con parametri tutti incogniti, uno stimatore di

campionario (o empirico)

ρ è il coeciente

di correlazione

Pn

− X̄)(Yj − Ȳ )

Pn

2

2

j=1 (Yj − Ȳ )

j=1 (Xj − X̄)

R = qP

n

per la quale vale sempre

Theorem 14.1.

Sia

−1 ≤ R ≤ 1

j=1 (Xj

e il seguente

∼ N e ρ = 0. Allora

√

n − 2R

T := √

∼ tn−2 n ≥ 3

1 − R2

(X1 , Y1 ), . . . , (Xn , Yn )

i.i.d.

Tale grandezza è la statistica test che utilizziamo per vericare l'indipendenza dei campioni.

Quindi:

si riuta

H0

nel caso in cui

T ≥ tn−2 (1 − α2 ).

Per

n

grandi,

t

è approssimabile da una gaussiana standard.

È anche possibile impostare i seguenti test, con le relative regioni di riuto:

H0 : ρ ≤ 0

contro

H1 : ρ > 0

con

G = {campioni : T ≥ tn−2 (1 − a)}

contro

H1 : ρ < 0

con

G = {campioni : T ≤ −tn−2 (1 − a)}

e

H0 : ρ ≥ 0

15. Test di omogeneità di Wilcoxon-Mann-Whitney

vericare se due campioni aleatori sono regolati dallo stesso modello,

Un test di omogeneità serve a

hanno la stessa funzione di ripartizione.

Tramite un'opportuna ipotesi alternativa

H1 ,

può essere utilizzato anche per

stocasticamente l'altra (cioè se è più grande).

e

cioè se

determinare se una variabile domina

Siano X e Y le due variabili aleatorie dei cui campioni si vuole vericare l'omogeneità e F

X1 , . . . , Xm i.i.d. ∼ F e Y1 , . . . , Yn i.i.d. ∼ G i due campioni di dati raccolti.

e

G le loro funzioni di ripartizione

L'ipotesi nulla indica omogeneità ed è:

H0 : F (x) = G(x) ∀x ∈ R

L'alternativa può indicare non omogeneità:

H1 : F (x) 6= G(x) per qualche x ∈ R

oppure può indicare che

X

domina stocasticamente

Y:

H1 : F (x) ≤ G(x) ∀x ∈ R

oppure può indicare che

Y

e

F (x) < G(x)

per qualche

x

H1 : F (x) ≥ G(x) ∀x ∈ R

e

F (x) > G(x)

per qualche

x

X

e

Y

domina stocasticamente

X:

Per eseguire il test si riuniscono tutte le osservazioni di

in ordine crescente e si assegna loro un rango

r

= 1)

semplicità che non ci siano ripetizioni nel campione.

Chiamiamo

Chiamiamo

m + n, le si

= m + n). Si

in un unico campione di lunghezza

crescente dalla minore (r

TX la somma dei ranghi delle osservazioni presenti da X : TX =

wa il quantile della f.d.r. di TX (tabulato per m, n ≤ 20).

alla maggiore (r

Pm

i=1

Ri

con

dispongono

assume per

Ri = rango(Xi )

st

Se

X≤Y

mi aspetto che tante

xi

siano più piccole delle

yj ,

quindi

TX

assumerà valori piccoli.

mi aspetto che tante

xi

siano più grandi delle

yj ,

quindi

TX

assumerà valori grandi.

st

Se

X≥Y

Valgono le seguenti regole di signicatività per

Riuto

Riuto

H0 : F (x) = G(x) ∀x

H0 : F (x) = G(x) ∀x

e accetto

e accetto

α:

H1 : F (x) ≥ G(x) ∀x

H1 : F (x) ≤ G(x) ∀x

st

e

F (x) > G(x)

per qualche

x

(ossia

X ≤Y)

st

e

F (x) < G(x)

per qualche

x

(ossia

se

Tx < wα .

X ≥ Y )se Tx > w1−α .

http://www.windizio.altervista.org/appunti/

File distribuito con licenza Creative Commons BY-NC-SA 2.5 IT

Copyright © 2008 - Michele Tartara

11

H0 : F (x) = G(x) ∀x e accetto H1 : F (x) 6= G(x) se Tx < wα/2 oppure TX > w1−α/2 .

TX è distribuita (più o meno come una gaussiana) attorno alla propria media c.

c + (c − wm,n (α)) = 2c − wm,n (α) = m(m + n + 1) − wm,n (α)

Riuto

NB: la statistica

Quindi

wm,n (1 − α) =