Giovanni Salmeri

Piccola

storia della logica

I. Dall’antichità a Leibniz

Roma 1999

Presentazione ................................................................................................ 3

1. L’analitica di Aristotele .............................................................................. 5

1.1. Il tema dell’analitica ............................................................................... 5

1.2. I termini e la proposizione...................................................................... 7

1.3. Le categorie ............................................................................................ 8

1.4. La quantificazione .................................................................................. 9

1.5. Figure e modi del sillogismo................................................................. 10

1.6. La dimostrazione dei sillogismi ............................................................ 12

1.7. Il procedimento scientifico................................................................... 13

1.8. Il procedimento dialettico .................................................................... 16

2. La logica megarico-stoica......................................................................... 19

2.1. Il concetto di logica .............................................................................. 19

2.2. La logica proposizionale ....................................................................... 20

2.3. I discorsi conclusivi ............................................................................... 22

2.4. Gli indimostrabili .................................................................................. 23

2.5. L’antinomia del mentitore.................................................................... 23

3. L’arte combinatoria di Leibniz ................................................................. 25

3.1. La rifondazione della logica.................................................................. 25

3.2. La concezione della verità .................................................................... 26

4. La logica nel Novecento........................................................................... 30

4.1. Georg Cantor (1845-1918) ................................................................... 30

4.1.1. La teoria degli insiemi ............................................................ 30

4.1.2. La gerarchia dei transfiniti...................................................... 32

4.2. Gottlob Frege (1848-1925)................................................................... 34

4.2.1. La fondazione della matematica ............................................ 34

4.2.2. Funzione, senso, significato ................................................... 36

4.2.3. La logica proposizionale ......................................................... 38

4.2.4. La logica dei predicati............................................................. 41

4.3. David Hilbert (1862-1943).................................................................... 44

4.3.1. L’assiomatica.......................................................................... 44

4.3.2. Gli assiomi di Peano ............................................................... 46

4.4. Kurt Gödel (1906-1978)........................................................................ 48

4.4.1. Gödelizzazione e diagonalizzazione ....................................... 48

4.4.2. I due teoremi di limitazione ................................................... 49

4.5. Alan M. Turing (1912-1954) ................................................................. 52

4.5.1. Computabilità e tesi di Church............................................... 52

4.5.2. Il modello di Turing e Post...................................................... 53

4.5.3. Informatica e pensiero artificiale ........................................... 55

2

Presentazione

Le pagine seguenti, che ho riscoperto in un angolo del mio disco rigido,

sono un tentativo di presentare in maniera molto breve gli elementi fondamentali della storia della logica (e quindi dei suoi contenuti e problemi) con un linguaggio accessibile a studenti di scuola media superiore. Per spiegare il carattere di questo testo, credo che la cosa più semplice sia raccontarne la storia.

Comincio da lontano: il mio itinerario scolastico credo che sia stato simile

a quello dei miei coetanei. Nella scuola elementare lo studio dell’aritmetica era

accompagnato da «note di insiemistica» che ruotavano attorno alle collezioni di

giocattoli di Teo e Tea. Da quel che ricordo, tanto per il maestro quanto per noi

scolari rimaneva misterioso quale fosse per comprendere meglio la matematica

l’utilità di quei giochini, e presto li abbandonammo (non ricordo se prima o dopo di aver imparato che i giocattoli che Teo e Tea avevano in comune era un’«intersezione»). Nella scuola media studiai solo buona tradizionale algebra e geometria (forse perché programmi e libri erano differenti, forse perché il professore ne saltava saggiamente qualche capitolo). Ma negli scaffali di casa, complice

la passione di mio padre, trovavo molti libri che presentavano questa materia in

modo originale (per esempio la miniera dei cinque volumi di Enigmi e giochi matematici di Martin Gardner) e così mi convincevo che la matematica poteva essere divertente (e anche la logica, della quale avevo un’idea solo molto vaga).

Nel ginnasio-liceo invece un poco di logica e di teoria degli insiemi le studiai seriamente, ricavandone un’impressione molto positiva: il modo di descrivere fatti

matematici mi appariva più chiaro e preciso.

In quel periodo (gli anni ’80) iniziava a diffondersi l’informatica personale:

il primo computer che ebbi tra le mani fu il minuscolo Radio Shack TSR-80 PC-1

(http://oldcomputers.net/trs80pc1.html), con il quale iniziai i primi esperimenti

di programmazione. E negli stessi anni mio fratello maneggiava l’elettronica digitale, e a casa entravano, come libri preziosi, i databook dei circuiti integrati: fu

così che scoprii che ciò che io chiamavo «congiunzione», «disgiunzione» e «disgiunzione esclusiva» (o magari latineggiando «et», «vel» e «aut») lui lo chiavama AND, OR e XOR. Si cominciava a parlare anche dell’introduzione dell’informatica a scuola, e rimanevo scandalizzato quando sentivo discorsi che ruotavano sempre attorno a macchine da comprare: come se per studiare informatica ci

fosse bisogno di un computer! (Su ciò non ho cambiato idea, peraltro.)

Quando mi iscrissi al corso di laurea in filosofia, fuorviato da un foglio che

lo indicava come «fondamentale», cominciai a frequentare il corso di Propedeutica filosofica. In realtà il professore spiegò subito che l’esame non era obbligatorio, e che lui avrebbe trattato solo di logica formale. Alla terza lezione rimanemmo in due. È uno dei corsi che ricordo con più piacere, faticoso ma estrema3

mente formativo: la soddisfazione di fare cose difficili! Per l’esame, oltre a tutto

ciò che avevamo studiato di teoria (per verificare la quale noi due sopravvissuti

dovemmo sostenere un esame scritto dimostrando una ventina di teoremi), il

programma prevedeva i due volumi de La logica formale di Józef Maria Bocheński, in cui imparai a collegare ciò che avevo studiato con una storia della filosofia che conoscevo sì, ma della quale non avevo mai seriamente esaminato il versante logico.

Subito dopo la laurea tornai al mio liceo per insegnare filosofia e mi portai dietro tutto questo: per esempio l’idea che anche per le scienze «esatte» la

storia (con nomi e volti) fosse importante e potesse anche servire a collegare

meglio le materie tra di loro; o la consapevolezza che filosofia, matematica, logica, informatica fossero cose diverse, ma con molti intrecci; o la convinzione che

la chiarezza nel linguaggio e nel ragionamento è sempre una buona qualità.

Non sempre soddisfatto del libro di testo iniziai a riscrivere alcuni capitoli di storia della filosofia: mi preoccupavo soprattutto di essere preciso, evitando il più

possibile le affermazioni generiche e cercando invece di esporre le argomentazioni, senza le quali la filosofia non esiste. Fu così che mi venne l’idea di scrivere

anche un capitolo di storia della filosofia sulla logica del Novecento. Il mio scopo

era scegliere alcuni temi più importanti, semplificare il discorso in maniera che

fosse accessibile ad uno studente liceale, contemporaneamente dando un’idea

chiara dei concetti centrali e del procedimento effettivo del ragionamento logico.

Ciò che segue è la bozza di quel progetto (composta negli anni ’90), preceduto dalle parti dedicate alla logica di Aristotele, degli stoici e di Leibiniz, estratte dai relativi capitoli più o meno completi che scrissi (e che poi pubblicai nel sito

http://mondodomani.org/mneme/). Dico «bozza», perché il testo sicuramente

avrebbe bisogno di essere riveduto e corretto. Inoltre, considerando l’insieme,

sicuramente è sottostimata la logica medievale, qui ridotta solo a qualche complemento dell’analitica di Aristotele. Ma dopo poco lasciai l’insegnamento al liceo e cominciai a lavorare ad altre cose: una revisione non è dunque mai avvenuta, né sarei in grado di farla ora. Salvo piccole modifiche, ho preferito dunque

lasciare il testo com’era. D’altra parte non so neppure se gli attuali programmi

liceali prevedano quegli agganci che ai miei occhi rendevano sensato il progetto: per esempio ora l’informatica è nominata solo sotto forma di «strumento», e

nelle indicazioni sulla filosofia contemporanea non si cita mai espressamente la

logica. Chissà però se, anche così come sono, queste pagine possano servire a

qualcosa o a qualcuno.

4

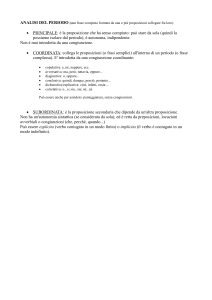

1. L’analitica di Aristotele

1.1. Il tema dell’analitica

Secondo l’ordine tradizionale, si occupa di logica il primo gruppo di opere

di Aristotele (384-323 a.C.): Sulle categorie, Sull’interpretazione, Analitici primi,

Analitici secondi, Topici, Confutazioni sofistiche. Il nome «logica» è però assente

in Aristotele, che usa invece il nome di «analitica». Queste opere furono raccolte da Andronìco di Rodi sotto il titolo di Ὄργανον, cioè «strumento». Così facendo egli suggeriva che l’analitica fosse una tecnica al servizio della filosofia, piuttosto che una sua parte.

Che cosa ritenesse Aristotele stesso va desunto, più che da affermazioni

esplicite, dall’origine di tali indagini, che probabilmente datano dai primi anni di

presenza nell’Accademia di Platone. Qui l’ambiente molto aperto e libero favorì

senza dubbio l’elaborazione di sue posizioni originali, che diedero occasione alla

pubblicazione delle prime opere. Tra essi va classificato anche il Protrettico,

opera (perduta) di esortazione alla filosofia scritta in polemica con Isocrate, che

nella contemporanea Antidosi (353) si faceva sostenitore di una formazione culturale fondamentalmente letteraria. Aristotele vuole invece legare la retorica alla dialettica (l’arte platonica della discussione argomentata), e sul tema comincia anche a tenere corsi all’interno dell’Accademia. È verosimile che l’attività didattica sia accompagnata dalla stesura di trattati ad uso interno, che possono

coincidere in buona parte con le opere giunteci.

L’analitica di Aristotele nasce dunque dal desiderio di rendere più rigorosa la dialettica platonica fino a trasformarla in un metodo descrivibile e chiaramente differenziato dai procedimenti retorici (che vengono sì studiati da Aristotele, ma come rientranti nel campo della tecnica). L’impostazione che permette

questo progresso viene manifestata con esemplare chiarezza già nei Topici,

quello che probabilmente è il suo primo scritto sull’argomento:

5

Il fine che questo trattato si propone è di trovare un metodo con cui poter costruire,

per ogni problema proposto, dei sillogismi. [...] Sillogismo è propriamente un discorso

(λόγος) in cui, posti alcuni elementi, risulta per necessità, a causa degli elementi stabiliti,

qualcosa di differente da essi. Si ha così anzitutto dimostrazione, quando il sillogismo è costituito e deriva da elementi veri e primi. [...] Dialettico è poi il sillogismo che conclude da elementi plausibili (ἔνδοξα). [...] Eristico è infine il sillogismo costituito da elementi che sembrano plausibili, pur non essendolo, e anche quello che all’apparenza deriva da elementi plausibili o presentatisi come tali (Top. I 100 a18-b25).

Insomma, scopo ultimo della logica è individuare le leggi del ragionamento (συλλογισμοί). Una legge logica è quella che mi assicura che una certa connessione di proposizioni è sempre corretta, in virtù della sua semplice forma, a

prescindere dalla verità delle proposizioni che la compongono (per questo oggi

si usa parlare di «logica formale»). Per esempio, il ragionamento «se l’uomo è

un anfibio, allora può vivere nell’acqua» è corretto, anche se la conclusione in

sé è falsa, essendo falsa la premessa. Viceversa, il ragionamento che dalla stessa premessa concludesse che «l’uomo non può vivere nell’acqua», sarebbe

scorretto, benché la conclusione sia vera. Il sillogismo corretto non assicura

quindi che ci siano conclusioni vere, ma assicura che, quando siano poste premesse vere, anche la conclusione sia vera.

Tale nuova impostazione puramente formale, sganciata dai contenuti di

qualsivoglia scienza, spalanca in effetti ad Aristotele un campo di problemi molto grande, studiati con completezza e raffinatezza incomparabilmente superiori

a quelle usate da Platone. Questo è il motivo per cui l’effettiva esecuzione del

compito va molto oltre le originarie intenzioni, mentre viene in parte perso di

vista l’intento di chiarire il procedimento effettivo delle scienze. Ciò è tanto vero

che Aristotele stesso dovrà annotare che non si può imporre in ogni campo del

sapere (per esempio nell’etica) quell’esattezza dimostrativa messa in opera nella teoria del sillogismo.

È da notare che, anche se la definizione dell’analitica sembra richiamare alcuni aspetti della matematica (in particolare della geometria, della quale già all’epoca di Platone era

chiara quella struttura deduttiva che più tardi Euclide formalizzerà), Aristotele non stabilisce

nessun legame tra le due. Ciò si inquadra bene nella sua diffidenza nei confronti della matematica, che nell’Accademia platonica a lui contemporanea aveva preso un posto preponderante, a suo avviso abusivo e ingiustificato: la matematica per Aristotele è al massimo una

delle scienze teoretiche, che esamina la realtà astraendo dalla sua materia e mantenendone

solo gli aspetti quantitativi. L’analitica è invece lo studio preliminare di tutte le leggi del ragionamento, che si applicano a qualsiasi scienza.

6

1.2. I termini e la proposizione

Anzitutto Aristotele si rende conto che la teoria del sillogismo non può essere costruita se non cominciando ad analizzarne le componenti. Bisogna allora

dire che il sillogismo è composto di «proposizioni», e che queste sono costituite

da «termini». È questa una distinzione che avrà una grande fortuna nella storia

della logica e che si può dire mantenuta in buona parte fino ad oggi.

Riguardo ai termini, Aristotele conduce analisi dettagliate sulla struttura

del linguaggio e sulle parti del discorso, fermando la sua attenzione in particolare sul nome (ὄνομα) e sul verbo (ῥῆμα), inaugurando in questo modo anche

l’analisi logica del linguaggio. Il carattere principale che egli riconosce ai termini

è il loro carattere significativo ovvero simbolico: «I suoni della voce sono simboli

delle affezioni che hanno luogo nell’anima, e le lettere scritte sono simboli dei

suoni della voce» (De int. 16 a2). Tuttavia tale rapporto è solo convenzionale:

non c’è nessun rapporto necessario tra il suono ['hippɔs] e il concetto del cavallo, tant’è vero che altre lingue adoperano suoni differenti. Importante è però

notare che, malgrado il rapporto solo convenzionale, il linguaggio esprime tuttavia realmente il pensiero dell’uomo, e in quanto tale può essere il punto di partenza di un’analisi della forma e della struttura del ragionamento.

Entra più decisamente nel campo della logica l’analisi della proposizione.

Essa viene anzitutto definita così:

La proposizione (πρότασις) è un discorso che afferma o che nega qualcosa rispetto a

qualcosa. [...] Chiamo d’altra parte termine (ὅρος) l’elemento cui si riduce la proposizione,

ossia ciò che è predicato e ciò di cui è predicato [cioè il soggetto], con l’aggiunta di essere o

di non essere [cioè della copula] (Anal. pr. I 24 a16-b16).

Come nei termini ciò che conta è il loro significato, così nelle proposizioni

è la loro verità o falsità. Anzitutto per Aristotele è evidente che il vero e il falso

non si trovano nelle cose, ma soltanto nel pensiero dell’uomo: non è questa

mela vera o falsa, ma solo ciò che io penso di essa. Inoltre:

Come nell’anima talvolta sussiste una nozione che prescinde dal vero e dal falso, e talvolta sussiste invece qualcosa cui spetta necessariamente o di essere vero o di essere falso,

così avviene pure per quanto si trova nel suono della voce. In effetti, il falso e il vero consistono nella congiunzione e nella separazione. In sé, i nomi e verbi assomigliano dunque alle nozioni, quando queste non siano congiunte a nulla né separate da nulla. [...] Dichiarativi sono,

però, non tutti i discorsi, ma quelli in cui sussiste un’enunciazione vera oppure falsa. Tale

enunciazione non sussiste certo in tutti: la preghiera, ad esempio, è un discorso, ma non risulta né vera né falsa (De int. 16 a9 - 17 a7).

Ma che cosa significa che una proposizione è vera?

7

Se è vero dire che una cosa è bianca (oppure che non è bianca), essa sarà necessariamente bianca (oppure non sarà bianca), e d’altra parte, se una cosa è bianca (oppure

non è bianca), era vero affermare oppure negare la cosa (De int. 18 a40-b1).

Malgrado l’apparente banalità, questa definizione della verità come corrispondenza tra la proposizione e la realtà eserciterà — condivisa o contestata —

un’influenza decisiva sulla storia della filosofia.

1.3. Le categorie

Un’attenzione particolare è dedicata da Aristotele al verbo «essere» che

realizza la connessione grazie alla quale la proposizione può essere vera o falsa.

Come si è visto, per Aristotele ogni proposizione può infatti assumere fondamentalmente solo le due forme «x è y» oppure «x non è y». Ciò è in effetti vero

almeno per la lingua greca, in cui anche i predicati verbali possono essere sempre riespressi sotto forma di copula e participio (osserva Aristotele: «Infatti non

c’è nessuna differenza tra “l’uomo è vivente” e “l’uomo vive”, né tra “l’uomo è

camminante” o “tagliante” e “l’uomo cammina” o “taglia”, e ugualmente anche

per gli altri casi», Metaph., V.7 1017 a 27-30). Questa era la scoperta che già

aveva fatto Parmenide.

Ciò che però viene continuamente contestato a Parmenide è la pretesa

che «ente» abbia un unico significato. Bisogna invece dire che «l’ente si dice in

molti significati diversi» (τὸ ὄν πολλαχῶς λέγεται, Metaph. IV 1003 a33 e altrove). Quando si considera, come stiamo appunto facendo, il verbo «essere» usato nelle proposizioni, bisogna dire che esso non ha un significato autonomo e

unico, ma assume tutti i possibili significati dei termini che connette. Tali significati vengono classificati in alcuni gruppi principali (otto o dieci secondo i testi),

chiamati «generi delle predicazioni» o in breve «predicazioni» (κατηγορίαι). Ecco il testo più schematico al riguardo:

Delle cose dette secondo nessun collegamento [= termini] ciascuna significa o esistenza o di una quantità o di una qualità o in relazione a qualcosa o in un luogo o in un tempo o

giacere o avere o fare o subire. Ed è esistenza (per fare un caso) ad esempio «uomo», «cavallo»; di una quantità per esempio «di due cùbiti», «di tre cùbiti»; di una qualità per esempio

«bianco», «grammatico»; in relazione a qualcosa per esempio «doppio», «maggiore»; in un

luogo ad esempio «nel liceo», «in piazza»; in un tempo ad esempio «ieri», «un anno fa»; giacere per esempio «è disteso», «siede»; avere per esempio «è calzato», «è armato»; fare per

esempio «tagliare», «bruciare»; subire per esempio «venir tagliato», «venir bruciato» (Categorie, 1.4 1 b 25 — 2 a 4).

La distinzione più netta è tra la prima categoria e tutte le altre. La prima

(in greco ousía, in italiano tradizionalmente reso con sostanza) indica infatti il

soggetto primo, ciò che «esistendo» permette l’attribuzione di altri predicati:

una considerazione questa che svolgerà un ruolo centrale nella Metafisica.

8

All’interno dell’analitica, la teoria delle predicazioni adempie invece ad una funzione solo preliminare: mostrare come la riduzione di tutte le proposizioni alla

forma soggetto-predicato nominale non pregiudica le possibilità espressive ed è

perciò perfettamente accettabile.

Se le categorie abbiano un valore anche ontologico, se indichino cioè non solo i

generi dei predicati ma anche i generi della realtà stessa, è un problema che è stato

molto dibattuto. In linea generale si può notare che l’analisi linguistica è per Aristotele

un punto di partenza costante, ma in numerose occasioni egli mette in guardia da una

meccanica trasposizione dal piano del linguaggio a quello della realtà. Ecco uno dei

passi più significativi:

Dato che non è possibile discutere presentando gli oggetti come tali, e che ci serviamo invece

dei nomi come di simboli che sostituiscono gli oggetti, noi riteniamo allora che i risultati osservabili a

proposito dei nomi si verifichino anche nel campo degli oggetti, come avviene a coloro che fanno calcoli usando dei ciottoli. Eppure le cose non stanno allo stesso modo nei due casi: in effetti, il numero

dei nomi è limitato, mentre gli oggetti sono numericamente infiniti (Confutazioni sofistiche I, 1652 a510).

1.4. La quantificazione

La classificazione delle proposizioni più importante per l’analitica riguarda invece quella che modernamente è chiamata «quantificazione dei predicati»:

La proposizione è dunque un discorso che afferma o nega qualcosa rispetto a qualcosa. Tale discorso, poi, è universale o particolare. [...] Con discorso universale intendo quello

che esprime l’appartenenza ad ogni cosa o a nessuna cosa; con discorso particolare, intendo

quello che esprime l’appartenenza a qualche cosa o la non appartenenza a qualche cosa

(Anal. pr. I 24 a16-20).

«Qualche» va inteso nel senso del moderno quantificatore esistenziale,

cioè «almeno uno», assumendo che la classe individuata dal termine non sia

vuota. Si osservi che Aristotele non cita qui le proposizioni singolari, in cui cioè il

soggetto indica un solo oggetto, né le considera mai esplicitamente nella trattazione dell’analitica. Tale esclusione non conduce però a nessuna grave deficienza teorica, giacché, come è facile mostrare, nella teoria del sillogismo esse risulterebbero formalmente equivalenti a proposizioni universali. In conclusione, si

hanno solo i seguenti quattro modelli di proposizioni (rappresentate dai logici

medioevali con le lettere indicate a sinistra, che sono le prime vocali di affirmo

e nego):

a: ogni x è y

i: qualche x è y

e: nessun x è y

9

o: qualche x non è y

Tra i quattro modelli di proposizioni Aristotele individua dei rapporti che nel

Medioevo vennero rappresentati nel «quadrato logico»:

Le proposizioni contrarie non possono essere contemporaneamente vere; quelle subcontrarie non possono essere contemporaneamente false; delle contraddittorie

la verità dell'una equivale alla falsità dell’altra; le subalterne (i, o) sono sempre vere

quando la subalternante (a, e) è vera.

1.5. Figure e modi del sillogismo

Dopo averne esaminato gli elementi costitutivi, si può infine considerare

il sillogismo in sé. Quale ne sarà la forma generale? Bisogna anzitutto dire che il

sillogismo deve avere due premesse e una conclusione: da una sola premessa

non si potrebbero trarre infatti conclusioni corrette. In generale, dunque, esso

assumerà la forma: «se p e q, allora r», dove le tre lettere p, q, r stanno per tre

diverse proposizioni. Che cosa si può dire dei termini delle proposizioni? Condizione necessaria perché sia possibile trarre una conclusione corretta è che le

due premesse abbiano in comune un termine (detto «medio»), che serva per

così dire da «ponte» per poter connettere gli altri due (detti «estremi»). In sostanza, sono possibili quattro «figure» del sillogismo, differenti solo per l’ordine

dei termini (quello medio è indicato con y, gli estremi con x e z):

1. se ... y ... z e ... x ... y, allora ... x ... z

2. se ... z ... y e ... x ... y, allora ... x ... z

3. se ... y ... z e ... y ... x, allora ... x ... z

4. se ... z ... y e ... y ... x, allora ... x ... z

Ora, secondo ciascuna di queste quattro figure possono essere costruiti

sillogismi connettendo i termini secondo uno dei quattro tipi di proposizione

prima considerati: affermativa universale, affermativa particolare, negativa universale, negativa particolare. Un elementare calcolo combinatorio mostra che in

questo modo è possibile costruire 256 differenti sillogismi (4 figure × 4 prime

premesse × 4 seconde premesse × 4 conclusioni). Ma quali di questi sillogismi

sono validi? quali cioè rappresentano ragionamenti corretti? Questo è il proble10

ma fondamentale dell’analitica. Per riassumere la risposta di Aristotele, useremo la simbologia elaborata nel Medioevo soprattutto da Pietro Ispano (1219

ca.-1277) e ancor oggi celebre. In essa ogni sillogismo è indicato da una parola

mnemonica, in cui le tre vocali indicano nell’ordine la quantità delle premesse e

della conclusione. Ecco dunque la tavola completa dei sillogismi (o «modi») validi:

1ª figura

barbara

darii

celarent

ferio

[barbari]

[celaront]

2ª figura

cesare

camestres

baroco

festino

[cesaro]

[camestrop]

3ª figura

darapti

datisi

disamis

felapton

ferison

bocardo

4ª figura

[bamalip]

[camenes]

[fesapo]

[fresison]

[dimaris]

[camelop]

Tra parentesi quadre sono indicati i sillogismi che Aristotele analizza con

minore dettaglio degli altri. I sillogismi validi sono comunque, dei 256 possibili,

solo ventiquattro. Un esempio per ciascuna delle quattro figure:

1. barbara

2. camestres

3. felapton

4. fresison

se ogni y è z e ogni x è y, allora ogni x è z

se ogni z è y e nessun x è y, allora nessun x è z

se nessun y è z e ogni y è x, allora qualche x non è z

se nessuno z è y e qualche y è x, allora qualche x non è z

A questo punto, ovviamente, è possibile sostituire alle lettere qualsiasi

nome universale: il ragionamento sarà sempre corretto, e, se le premesse saranno vere, si otterrà una conclusione vera (ovvero un «sillogismo dimostrativo»).

Ecco il celeberrimo esempio di un sillogismo barbara: «se ogni uomo è mortale

e ogni ateniese è uomo, allora ogni ateniese è mortale» (spesso quest’esempio

viene citato usando come termine «Socrate» anziché «ateniese»: si tratta di un

anacronismo di quasi due millenni, giacché i termini singolari saranno introdotti

nella sillogistica solo da Guglielmo di Occam [1280-1349]). È opportuno notare

che, a parte l’enunciazione un po’ differente da quella qui usata, anche Aristotele discute i sillogismi in una forma estremamente concisa ed esatta, che diventerà tipica per tutti gli scritti di logica della storia. Ecco per esempio come enuncia il sillogismo barbara: «Se A si predica di ogni B, e se B si predica di ogni Γ, è

necessario che A venga predicato di ogni Γ» (Anal. pr. I 25 b32-35). Ciò che va

soprattutto notato è l’uso delle variabili per indicare i termini. È superfluo dire

che si tratta di una delle scoperte più feconde di tutti i tempi, che ha reso possibile lo sviluppo tanto della logica quanto della matematica: solo tramite esse si

possono infatti formulare in maniera semplice leggi universali, proprio quelle di

cui Aristotele andava alla ricerca nella sua analitica.

11

In una parte successiva della sua opera Aristotele compie un’importante estensione della sillogistica, cui accenniamo soltanto. Si tratta della «sillogistica modale», in

cui, oltre alle semplici affermazioni considerate finora («assertorie») vengono considerate anche quelle che contengono le espressioni «dev’essere» e «può essere». Ai sillogismi prima considerati, in cui entrambe le premesse sono assertorie, se ne aggiungono quindi altre otto classi, secondo le varie combinazioni dei tre tipi di proposizioni.

Dei possibili sillogismi risultanti, Aristotele ne studia esplicitamente non meno di 137,

in pagine che sono tra le più complesse della sua opera e che saranno molto spesso incomprese o fraintese.

1.6. La dimostrazione dei sillogismi

Aristotele non si limita ad individuare quali siano le forme corrette di sillogismo: egli si preoccupa anche di darne una dimostrazione. Riguardo ad essa,

egli è cosciente che essa deve necessariamente fermarsi a premesse indimostrabili, che possano essere accettate per la loro evidenza:

È ignoranza non sapere di quali cose si debba ricercare una dimostrazione e di quali,

invece, non si debba cercare. Infatti, in generale, è impossibile che ci sia dimostrazione di tutto: in tal caso si procederebbe all’infinito, e in questo modo, di conseguenza, non ci sarebbe

affatto dimostrazione (Metaph. IV 1006 a5-9).

Nel caso dei sillogismi, gli sembra che quelli della prima figura possano

svolgere tale compito. Essi costituiscono quindi, nella terminologia odierna, gli

«assiomi» del sistema sillogistico. Agli assiomi bisogna tuttavia aggiungere delle

regole di derivazione. Aristotele individua come sufficienti le seguenti leggi di

sostituzione:

s: nessun x è y = nessun y è x

s: qualche x è y = qualche y è x

p: ogni x è y = qualche y è x

m: se p e q allora r = se q e p allora r

c: se p e q allora r = se non-r e q allora non-p

In tutti e cinque i casi, l’espressione a sinistra deve essere sostituita con

quella a destra. Le prime tre leggi sono regole di «conversione» delle premesse,

la quarta (non esplicitamente enunciata da Aristotele) stabilisce la possibilità

d’invertire le premesse del sillogismo, l’ultima rappresenta la riduzione all’assurdo. Le lettere indicate a fianco sono anche qui i simboli medioevali, che si ritrovano nei nomi dei sillogismi della seconda, terza e quarta figura: quando s o

p seguono una vocale, significa dunque che la proposizione corrispondente va

convertita, quando compare una m le premesse vanno invertite, quando compare all’interno una c che bisogna effettuare la riduzione all’assurdo, eventualmente invertendo prima le premesse. (Tutte le altre consonanti sono sem12

plicemente riempitive.) In questo modo si giungerà alla forma della prima figura

che inizia con la stessa consonante. Per esempio, per dimostrare disamis bisogna: convertire la prima premessa (disamis); convertire la conclusione (disamis); invertire le premesse (disamis); così si ottiene un sillogismo darii (disamis).

Basteranno i successivi sviluppi della logica megarico-stoica per mettere in luce

come nell’analitica di Aristotele sia contenuto solo un piccolo sottoinsieme di leggi logiche (in termini moderni, l’intera sillogistica è solo una porzione del calcolo dei predicati monadici del primo ordine). Ciò nonostante, i meriti di Aristotele sono enormi:

con lui non soltanto viene fondata — partendo quasi dal nulla — la logica formale,

della quale vengono riconosciuti e delimitati chiaramente i compiti, ma viene anche

costruito in maniera pressoché impeccabile un sistema in sé completo, che costituirà

per secoli la base di innumerevoli speculazioni (talvolta acute, talaltra di nessun valore). Questo risultato è tanto più degno di ammirazione quanto più si veda il naufragio

che la logica dovrà subire lungo diversi secoli, soprattutto a partire dal Rinascimento:

affinché in epoca moderna gli scritti di Aristotele possano essere di nuovo correttamente interpretati e discussi, bisognerà aspettare l’opera del polacco Jan Łukasiewicz

(1878-1956).

1.7. Il procedimento scientifico

Negli Analitici secondi Aristotele considera il problema dell’applicazione

dei procedimenti logici alla ricerca scientifica (ἐπιστήμη). Qui non interessa più

solo la validità formale del sillogismo, ma anche la verità delle conclusioni che

esso raggiunge. Ciò spiega la grande attenzione che viene dedicata al problema

dei princìpi della dimostrazione. Come già si è visto su un altro piano, anche nelle scienze è impossibile un regresso all’infinito, e vanno quindi individuati dei

fondamenti indimostrabili:

È necessario che la scienza dimostrativa si costituisca sulla base di premesse vere, prime, immediate, più note della conclusione, anteriori ad essa, e che siano cause di essa: a

questo modo, infatti, pure i princìpi risulteranno propri dell’oggetto provato. In realtà, un sillogismo potrà sussistere anche senza tali premesse, ma una dimostrazione non potrebbe sussistere, poiché allora non produrrebbe scienza (An. post. I.2 71 b20-25).

Le premesse prime di cui si serve la scienza hanno un legame molto stretto con la teoria metafisica della definizione. Detto in breve, i princìpi devono

esprimere ciò che in ciascun àmbito della realtà è più generale e causa di ciò

che è particolare: ma questi sono proprio i caratteri che a diverso livello vengono espressi nella definizione di ciascuna cosa. Ciò è coerente con la ripetuta affermazione (di palese origine platonica) che la scienza si occupa solo dell’universale e necessario e non del singolare e accidentale:

13

Dell’accidente non c’è scienza. Ogni scienza, infatti, riguarda ciò che è sempre o [almeno] per lo più: come sarebbe possibile, altrimenti, imparare o insegnare ad altri? Infatti

ciò che è oggetto di scienza deve potersi determinare come esistente sempre o per lo più: come, per esempio, che l’acqua e miele ai febbricitanti per lo più giova. Altrimenti nemmeno

sarà possibile enumerare i casi in cui ciò non avviene: per esempio nel novilunio, perché anche questo accade o sempre o per lo più, mentre l’accidente non fa così (Metaph. VI 1027

a19-26).

Lo spirito di quest’affermazione è giunto in una buona misura fino alla scienza

moderna, che si preoccupa appunto di formulare leggi universalmente valide. In Aristotele però questo punto di vista è sostenuto in una forma esclusiva: come conseguenza per esempio la storia, trattando di episodi singolari, non può essere una scienza, e viene in ciò paradossalmente superata dalla poesia che tende a considerare situazioni ideali e dunque potenzialmente universali.

La pratica della scienza quindi non coincide con la semplice deduzione da

premesse già date, ma piuttosto consiste in gran parte in altre due operazioni:

la connessione dei princìpi per giungere ad una spiegazione soddisfacente dei

fenomeni, e la scoperta dei princìpi stessi. Riguardo alla prima, nella terminologia dell’analitica ciò significa scoprire del termine «medio», cioè quello che giustifica la connessione dei due estremi che è già data nell’esperienza:

La prontezza deduttiva è una certa abilità di cogliere istantaneamente il medio. Tale

abilità si presenta, ad esempio, nel caso in cui, vedendo che la parte illuminata della luna sta

sempre rivolta verso il sole, qualcuno coglie d’un tratto il perché della cosa, ossia comprende

che ciò si verifica poiché la luna riceve la sua luce dal sole; o nel caso in cui, quando si vede

una persona che parla con un ricco, si comprende che ciò avviene poiché questa persona si

fa prestare del denaro; o anche, nel caso in cui si coglie il perché due persone siano amiche,

comprendendo che ciò deriva dalla loro inimicizia per un medesimo individuo. In tutto questi

casi, infatti, nel vedere gli estremi qualcuno cogli tutti i medi, cioè le cause (An. post. I.34 89

b10-16).

In termini più espliciti, il primo esempio porta al seguente sillogismo: «Se

la luna è un corpo che riceve la luce dal sole e tutti i corpi che ricevono la luce

dal sole hanno la parte illuminata verso il sole, allora la luna ha la parte illuminata verso il sole» (si noti che in questo sillogismo un termine, «la luna», è singolare, contrariamente a quanto viene teorizzato nell’analitica da Aristotele

stesso). Da questa formulazione è chiaro che in assenza del termine medio non

verrebbe detto il perché di un dato fenomeno, ciò che invece costituisce un elemento essenziale della scienza. La correttezza del termine medio è mostrata

dunque da nient’altro che la maggiore o minore capacità di spiegare i fenomeni

in maniera semplice e completa.

Riguardo alla scoperta dei princìpi stessi, Aristotele assegna un ruolo fondamentale all’esperienza. Questa è la celebre discussione in proposito che termina gli Analitici secondi:

14

Ci si può domandare se [...] le facoltà dei princìpi si sviluppino senza sussistere in noi

sin dall’inizio, oppure se esse siano innate, senza che ce ne avvediamo. In verità, se le possedessimo sin dall’inizio, si andrebbe incontro a conseguenze assurde, poiché si dovrebbe concludere che, pur possedendo conoscenze superiori alla dimostrazione, noi non ci accorgiamo

di ciò. D’altra parte, se noi acquistiamo queste facoltà, senza averle possedute in precedenza, come potremmo render noto un qualcosa e come potremmo imparare, quando non si

parta da una conoscenza preesistente? Tutto ciò è infatti impossibile, come dicevamo già a

proposito della dimostrazione. È dunque evidente che non è possibile possedere tali facoltà

sin dall’inizio, e che non è neppur possibile che esse si sviluppino in coloro che sono del tutto

ignoranti e non posseggono alcuna facoltà. Di conseguenza, è necessario che noi siamo in

possesso di una qualche capacità, non però di una capacità tale da essere più pregevole delle

suddette facoltà, quanto ad acutezza.

Pare d’altronde che questa capacità appartenga effettivamente a tutti gli animali. In

effetti, tutti gli animali hanno un’innata capacità discriminante, che viene chiamata sensazione. [...] Dalla sensazione si sviluppa dunque ciò che chiamiamo ricordo, e dal ricordo

spesso rinnovato di un medesimo oggetto si sviluppa poi l’esperienza. [...] In seguito, sulla

base dell’esperienza, ossia dell’intero oggetto universale che si è acquietato nell’anima,

dell’unità al di là della molteplicità, il quale è contenuto come uno e identico in tutti gli oggetti molteplici, si presenta il principio della tecnica e della scienza. [...] Le suddette facoltà

non ci sono dunque immanenti nella loro determinatezza, né provengono in noi da altre facoltà più produttive di conoscenza, ma vengono suscitate piuttosto dalla sensazione. [...]

È dunque evidentemente necessario che noi giungiamo a conoscere gli elementi primi con l’induzione. In effetti, già la sensazione produce a questo modo l’universale. Ora, tra i

possessi che riguardano il pensiero e con i quali cogliamo la verità, alcuni risultano sempre

veraci, altri invece possono accogliere l’errore; tra questi ultimi sono, ad esempio, l’opinione

e il ragionamento, mentre i possessi sempre veri sono la scienza e l’intelligenza, e non sussiste alcun altro genere di conoscenza superiore alla scienza, all’infuori dell’intelligenza. Ciò

posto, e dato che i princìpi risultano più evidenti delle dimostrazioni, e che, d’altro canto,

ogni scienza si presenta congiunta alla ragione discorsiva, in tal caso i princìpi non saranno

oggetto di scienza; e poiché non può sussistere nulla di più verace della scienza, se non l’intelligenza, sarà invece l’intelligenza ad avere come oggetto i princìpi (An. post. II.19 99 b22 —

100 b12).

I due termini «induzione» (ἐπαγωγή) e «intelligenza» (νοῦς) non vanno

quindi contrapposti: il primo indica il procedimento tramite cui grazie all’esperienza viene individuato il carattere essenziale di qualcosa, che costituisce principio della scienza; il secondo la capacità individuale di compiere effettivamente

tale procedimento, che quando è corretto (cosa peraltro sulla quale è facile ingannarsi) assicura una conoscenza più fondamentale di quella «scientifica», la

quale è derivata per dimostrazione.

L’appello all’esperienza mette in luce quell’irriducibile pluralismo che per

Aristotele sussiste nella costruzione della scienza. Sia per quanto riguarda i princìpi, sia per quanto riguarda le dimostrazioni, le diverse scienze si distinguono le

une dalle altre:

15

Risulta evidente che, se viene a mancare qualche senso, necessariamente viene pure

a mancare qualche scienza, che sarà impossibile acquisire, dal momento che noi impariamo

o per induzione o mediante dimostrazione. Orbene, la dimostrazione parte da proposizioni

universali, mentre l’induzione si fonda su proposizioni particolari; non è tuttavia possibile cogliere le proposizioni universali se non attraverso l’induzione, poiché anche le nozioni ottenute per astrazione saranno rese note mediante l’induzione, quando cioè si provi che alcune

determinazioni appartengono ad un singolo genere in quanto tale, sebbene non risultino separabili dagli oggetti della sensazione (An. post. I.18 81 a38-b5).

Non è possibile condurre la dimostrazione passando da un genere all’altro: per esempio, non si può dimostrare una proposizione geometrica mediante l’aritmetica. Tre sono infatti gli elementi costitutivi delle dimostrazioni: in primo luogo ciò che si dimostra, ossia la

conclusione (la quale esprime l’appartenenza di una determinazione per sé ad un qualche genere); in secondo luogo gli assiomi (gli assiomi sono le proposizioni da dove prende le mosse

la dimostrazione); in terzo luogo, il genere sottoposto, le cui affezioni e determinazioni per sé

sono rivelate dalla dimostrazione (An. post. I.7 75 a38-b2).

Qualsiasi giudizio sulla teoria aristotelica della scienza deve necessariamente

prescindere dalle vicende storiche dell’aristotelismo, e in particolare dal fatto che la

scienza moderna si è affermata proprio in polemica verso di esso. È infatti evidente

che molte delle polemiche sollevate lungo la storia nei confronti di Aristotele riguardano in realtà una ripetizione dei risultati da lui raggiunti e non le esigenze di metodo

che egli avanzava. In linea generale va poi osservato che le riflessioni di Aristotele tutto suggeriscono fuorché la presunzione di raggiungere facilmente un’assoluta certezza, priva di possibilità di correzione: «Determinare se la conoscenza sussista o no è difficile. È infatti arduo precisare se la nostra conoscenza parta o no dai princìpi propri di

qualsiasi oggetto, il che costituisce appunto il sapere» (An. post. I.9 76 a26-28).

1.8. Il procedimento dialettico

Accanto al procedimento scientifico, Aristotele conserva anche uno spazio per la «dialettica», che continua ad avere in lui il senso platonico di «tecnica

della discussione». Per questo — come abbiamo visto — il ragionamento dialettico è presentato come quello che «conclude da elementi plausibili (ἔνδοξα)», i

quali a loro volta sono definiti come quelli «che paiono a tutti o alla maggior

parte o ai sapienti» (Top. I 100 b21). Non si intende con ciò dire che la dialettica

è confinata nel campo della probabilità, ma piuttosto che essa prende le mosse

dalle opinioni sostenuti dall’interlocutore (reale o immaginario), per vagliarle e

giudicare se esse siano vere o false. Proprio perché non ha bisogno di punti di

partenza veri e necessari, la dialettica risulta utile sia per affrontare i problemi

che superano l’ambito di una singola scienza, sia per accertare (in concorrenza

con il metodo induttivo) i princìpi di una determinata scienza discutendo le opinioni fino a quel momento espresse. Ciò non toglie che lo spazio della dialettica

pare in Aristotele restringersi man mano che viene sviluppata la tecnica del sillogismo, e la sua opera dedicata al tema (i Topici) è senza dubbio giovanile.

16

Come già in Zenone, il metodo dialettico è essenzialmente quello della

confutazione (in termini moderni dimostrazione per assurdo): quando da

un’opinione si deduce una contraddizione, risulta dimostrata la tesi contraria.

Perché tale metodo possa essere applicato, sono necessari due princìpi: i cosiddetti princìpi di non contraddizione e del terzo escluso. Essi vengono discussi

non nell’Órganon, ma in una sezione presumibilmente giovanile della Metafisica, con la giustificazione che essi riguardano «ciò che è in quanto è», oggetto

proprio della metafisica. Eccone la formulazione:

Lo stesso [attributo] non può contemporaneamente dirsi e non dirsi dello stesso [soggetto] e nello stesso tempo (Metaph. IV 1005 b19-20).

Non è possibile che tra due proposizioni contraddittorie ci sia una via di mezzo, ma è

necessario o affermarne o negarne una sola, qualunque essa sia (Metaph. IV 1011 b23-24).

Il primo di essi viene qualificato da Aristotele «il più forte di tutti i princìpi» e il punto di partenza per qualsiasi dimostrazione (cioè più esattamente:

confutazione). Proprio per questo, ne è impossibile — come sappiamo — una

dimostrazione vera e propria. È possibile però una sorta di dimostrazione indiretta, realizzata confutando l’avversario che lo neghi:

Il punto di partenza consiste nell’esigere che l’avversario [...] dica qualcosa che abbia

un significato per sé e per gli altri; e questo è pur necessario, se egli intende dire qualcosa. Se

non facesse questo, costui non potrebbe in alcun modo discorrere, né con sé stesso né con

altri; se l’avversario concede questo, allora sarà possibile una dimostrazione. [...] Se relativamente ad un medesimo soggetto fossero vere, ad un tempo, tutte le affermazioni contraddittorie, è evidente che tutte quante le cose si ridurrebbero ad una sola. Infatti, saranno la medesima cosa e una nave e una parete e un uomo, se di tutte le cose un determinato predicato si può tanto affermare tanto negare. [...] Infatti, se a qualcuno sembra che un uomo non

sia una nave, è evidente che non è una nave; tuttavia sarà anche una nave, dal momento che

il contraddittorio è vero. Allora tutte le cose saranno confuse insieme (Metaph. IV 1006 a18 1007 b26).

In sostanza: soltanto per il fatto di discutere, usando quindi parole cui attribuisce un significato determinato, l’avversario fa uso del principio di non-contraddizione e quindi ne ammette implicitamente la validità. Questa discussione

è molto importante soprattutto dal punto di vista della semantica (cioè della

teoria del significato).

Tuttavia Aristotele può affermare che il principio è necessario e che ad esso si

riducono tutte le altre leggi logiche solo perché sta pensando alle dimostrazioni per

assurdo; nella sillogistica invece egli ne fa un uso molto limitato, e mostra che è possibile costruire sillogismi validi che tuttavia lo vìolano. Benché Aristotele più tardi notò

la cosa e precisò le sue affermazioni («nessuna dimostrazione assume espressamente

l’assioma secondo cui non è possibile affermare e al tempo stesso negare qualcosa di

un oggetto», Anal. post. I 77 a10-12), il passo della Metafisica trarrà spesso in ingan17

no: ancora Kant (1724-1804) chiamerà il principio di non contraddizione «il sommo

principio di tutti i giudizi analitici» (KrV A 150/B 189).

In modo simile stanno le cose con il principio del terzo escluso, che afferma che non c’è una terza possibilità tra il vero e il falso (tertium non datur), e

che dunque la negazione della negazione è eguale all’affermazione. Anch’esso

non è necessario in senso assoluto: lo stesso Aristotele si rese conto di ciò, e limitò la portata di questo principio nel caso delle proposizioni «future contingenti» (per esempio «domani ci sarà una battaglia navale»), che non sono né

vere né false:

Dal momento che i discorsi sono veri analogamente a come lo sono gli oggetti, è chiaro che a proposito di tutti gli oggetti, costituiti così da accadere indifferentemente in due modi secondo delle possibilità contrarie, anche la contraddizione si comporterà necessariamente in maniera simile. È appunto ciò che avviene riguardo agli oggetti che non sono sempre,

oppure a quelli che non sempre non sono. In tali casi è infatti necessario che una delle due

parti della contraddizione sia vera e l’altra falsa, ma non è tuttavia necessario che una determinata parte sia vera oppure falsa; sussiste piuttosto un’indifferenza tra le due possibilità, e

quand’anche uno dei due casi risulti più vero, la verità e la falsità non saranno tuttavia già decise sin da principio (De int. 9 19a33-39).

Applicare il principio del terzo escluso in questi casi equivarrebbe insomma ad ammettere che tutte le cose avvengono per necessità: «In tal modo, non

occorrerebbe più che noi prendessimo delle decisioni, né che ci sforzassimo laboriosamente» (De int. 9 18b30-31).

Il fatto che tali due princìpi sono indispensabili solo nell’ambito dialettico non

toglie nulla alla loro enorme importanza storica e teorica. Ancora oggi sono utilizzati

come criterio per distinguere i possibili generi di logica proposizionale. Così, le logiche

che assumono tanto il principio di non contraddizione quanto quello del terzo escluso

vengono chiamate «classiche», quelle che assumono solo il primo «intuizionistiche»,

quelle che non assumono né il primo né il secondo «minimalistiche».

18

2. La logica megarico-stoica

2.1. Il concetto di logica

Dopo l’analitica di Aristotele, la filosofia greca può vantare un secondo

grande contributo alla costituzione della logica. Si tratta delle teorie che, sviluppate originariamente dai Megarici e dai «Dialettici» (particolarmente Eubulide

di Mileto, Diodoro Crono e Filone di Megara) furono poi riprese e ordinate dagli

Stoici, in particolare da Crisippo (277-204 a.C). La conoscenza di questo contributo è purtroppo molto frammentario: nessuna opera originale ci è rimasta. Ciò

è un segno chiaro del minore interesse con cui questa forma di logica venne studiata lungo i secoli, fino a venire quasi del tutto dimenticata (salvo poi essere

«reinventata» nell’Ottocento).

I contributi della scuola megarico-stoica sono di due tipi: il primo comprende approfondimenti o chiarimenti di idee già presenti in Aristotele ma in

forma ancora implicita o imprecisa; il secondo vere e proprie novità che compiono una netta estensione rispetto all’analitica aristotelica. Sicuramente più

preciso rispetto ad Aristotele è il concetto stesso di «logica» (questa denominazione venne messa in uso proprio dagli Stoici). Essa viene considerata senza alcun dubbio una parte della filosofia piuttosto che un suo strumento:

[Gli Stoici] rappresentano la filosofia come un animale, paragonando la parte logica

alle ossa e ai nervi, l’etica ai muscoli, la fisica all’anima. O anche come un uovo: la logica è il

guscio, dopo viene l’etica, la parte più interna è la fisica. O anche come un campo fertile, del

quale la siepe di recinzione è la logica, il frutto è l’etica, il terreno o gli alberi la fisica. O infine

ad una città ben costruita e amministrata secondo ragione (SVF II, 38).

Con molta chiarezza viene anche introdotta una distinzione che ad Aristotele era in parte ignota:

19

Gli Stoici dicono che questi tre elementi sono connessi fra di loro: il significato

(σημαινόμενον), il significante (σημαῖνον) e l’evento (τυγχάνον). Il significante è il suono stesso, ad esempio «Dione»; il significato è l’entità manifestata e che apprendiamo in quanto

coesiste con il nostro pensiero, e che gli stranieri non capiscono, sebbene odano il suono;

l’evento è ciò che esiste all’esterno, ad esempio Dione stesso. Di questi, due sono corporei, e

cioè il suono e l’evento, e una è incorporea, e cioè l’entità significata, il senso (λεκτόν), che

[solo] è vero o falso (SVF II, 166 = FL 19.04).

L’oggetto proprio della logica è costituito per gli Stoici solo dai sensi

(λεκτά). La distinzione stabilita tra «eventi» e «sensi» corrisponde sostanzialmente a quella moderna tra «estensione» e «intensione» (chiarita soprattutto

da Gottlob Frege [1848-1925]). Per mostrarne la differenza, prendiamo come

esempio la proposizione «Gli uomini sono mortali». Da un punto di vista estensionale, essa viene interpretata così: «L’insieme degli uomini è incluso nell’insieme dei mortali». Da un punto di vista intensionale viene invece spiegata così: «Il

concetto di uomo comprende il concetto di mortale». Gli Stoici, ritenendo che

la proposizione in sé non abbia alcun corrispondente «reale» (al contrario dei

suoi termini), ma sia solo un λεκτόν, scelsero senza incertezze per la loro logica

un’interpretazione intensionale. (Oggi si ritiene che entrambe le alternative siano lecite, e che in particolare quella che intensionalmente è una logica dei predicati diventi estensionalmente una logica delle classi.)

2.2. La logica proposizionale

Dove la logica stoica supera nettamente l’analitica aristotelica, creando

praticamente un campo nuovo, è nello studio della proposizione (chiamata

ἀξίωμα). Una prima distinzione fondamentale è tra proposizioni semplici e complesse. Semplice è la proposizione che contiene solo un predicato (per esempio

«è giorno»), complessa è quella costituita dal collegamento di più proposizioni

tramite connettivi logici (per esempio «è giorno e piove»). Ovviamente, i connettivi possono unire proposizioni a loro volta complesse. Si osservi che la negazione di una proposizione semplice (per esempio «non è giorno»), che oggi viene classificata tra le proposizioni complesse, era invece considerata semplice

dagli Stoici.

Ora, la loro intuizione fondamentale è che i connettivi logici (non, e, o, se

... allora, ecc.) vanno considerati operatori, simili, per esempio, ai comuni operatori aritmetici (+, –, ×, /). Mentre però questi ultimi operano su valori numerici, i

connettivi logici operano sui valori di verità che le proposizioni possiedono in

quanto λεκτά. Il caso più semplice è quello della negazione logica: quando essa

è applicata ad una proposizione vera genera una proposizione falsa, e viceversa.

Riguardo ai connettivi che collegano due proposizioni bisognerà considerare

quattro casi: due proposizioni entrambe vere, due entrambe false, la prima vera

e la seconda falsa, e viceversa. Definire una connessione logica equivale così a

20

scrivere la sua «tavola di verità», cioè precisare quale sia il valore di verità della

proposizione complessa in corrispondenza dei quattro casi ora detti. Per esempio, una proposizione congiuntiva («è giorno e piove») sarà complessivamente

vera solo quando entrambe le proposizioni congiunte sono vere. In questo modo gli Stoici vennero definite diverse connessioni. Eccone le più importanti, delle quali diamo a sinistra il nome e a destra, sulla stessa riga, la tavola di verità:

proposizione 1

proposizione 2

congiuntiva (... e ...)

disgiuntiva inclusiva (... o ...)

alternativa (o solo ... o solo ...)

condizionale (se ... allora ...)

condizionale doppia (solo se ... allora ...)

vera

vera

vera

vera

falsa

vera

vera

vera

falsa

falsa

vera

vera

falsa

falsa

falsa

vera

falsa

vera

vera

vera

falsa

falsa

falsa

falsa

falsa

falsa

vera

vera

Un paio di osservazioni importanti. La prima riguarda le due differenti disgiunzioni, che né in greco né in italiano sono chiaramente distinte nel linguaggio naturale.

Quella esclusiva (o «alternativa») esclude, appunto, la verità di entrambe le proposizioni disgiunte (per esempio: «partirò lunedì o martedì», ma non i due giorni contemporaneamente); quella inclusiva invece no (per esempio: «se c’è pioggia o neve bisogna guidare con prudenza», e anche se ci sono le due cose contemporaneamente). La

distinzione tra le due è facile in latino, dove l’esclusiva s’indica con aut e l’inclusiva

con vel. Come si vedrà, gli Stoici, contrariamente all’uso moderno, usavano per lo più

la disgiunzione esclusiva.

Una seconda osservazione riguarda la proposizione condizionale (o implicazione). La tavola definisce la cosiddetta «implicazione materiale» o «filoniana», dal nome

del logico megarico Filone. Essa risulta falsa solo nel caso che ad un antecedente vero

segua un conseguente falso, e ciò indipendentemente dal senso delle proposizioni

connesse. Per esempio, tutte e tre queste proposizioni risultano vere: «se 2 è pari, allora è un numero primo», «se la luna è verde, allora il cielo è azzurro», «se Aristotele

è cinese, allora Platone è turco». Tale uso è molto più ampio di quello del linguaggio

naturale, in cui invece una proposizione condizionale viene considerata vera solo

quando in più c’è un nesso reale tra le due proposizioni (come per esempio nei sillogismi aristotelici). Questa è detta «implicazione formale», e di essa due varianti furono

definite da Diodoro Crono e da Crisippo. Il problema era molto dibattuto, al punto che

un bibliotecario di Alessandria del II sec. riferisce: «Anche i corvi gracchiano sui tetti

su quali implicazioni siano corrette» (FL 20.06). La discussione continuerà nel Medioevo, quando Paolo Veneto (1368-1429) elencherà ben dieci significati differenti

dell’implicazione, e arriverà fino ai giorni nostri.

Con la definizione dei connettivi logici viene così iniziata quella che oggi è

chiamata logica proposizionale e che in età moderna venne rifondata da diversi

logici, tra i quali spicca Gottlob Frege. In essa, al contrario della logica dei predicati (di cui la sillogistica aristotelica costituisce una parte), non viene considerata la struttura interna delle proposizioni, ma solo il loro valore di verità. Tramite

21

le tavole è possibile «calcolare» una proposizione comunque complessa, ovviamente una volta che sia noto il valore di verità delle proposizioni semplici.

2.3. I discorsi conclusivi

Questa chiara nozione permise di formulare una distinzione che ad Aristotele era sfuggita: quella tra discorsi conclusivi e proposizioni vere (in linguaggio moderno: tra deduzioni corrette e leggi logiche):

Un discorso (λόγος) è un sistema costituito da premesse e da una conclusione. Le premesse sono le proposizioni accettate per la dimostrazione della conclusione, la conclusione è

la proposizione dimostrata a partire dalle premesse. Prendiamo ad esempio il seguente discorso:

Se è giorno allora c’è luce;

ma è giorno;

dunque c’è luce.

In esso c’è luce è la conclusione, le altre proposizioni sono le premesse (FL 21.01 =

Pyrrh. Hyp. B 135).

Alcuni discorsi sono conclusivi, altri non conclusivi. Sono conclusivi quando la proposizione condizionale che inizia con la congiunzione delle premesse del discorso e finisce con la

conclusione è vera. Ad esempio, il discorso citato è conclusivo, perché è vera la connessione

della congiunzione delle sue premesse con c’è luce, in questa proposizione condizionale: se è

giorno e se è giorno allora c’è luce, allora c’è luce. Non conclusivi sono i discorsi non costruiti

in questo modo (FL 21.02 = Pyrrh. Hyp. B 137).

Più esplicitamente, un discorso conclusivo corrisponde ad una proposizione condizionale sempre vera, qualunque sia il valore di verità delle proposizioni

semplici che la compongono. In generale, oggi viene chiamata legge logica una

proposizione complessa (anche non condizionale) che è vera indipendentemente dai valori di verità delle proposizioni semplici. Per esempio, «p o non p» è

una legge logica. Più chiara che in Aristotele è anche la distinzione tra discorsi

conclusivi e conclusioni vere:

Fra i discorsi conclusivi alcuni sono veri [nella conclusione], altri falsi. Sono veri quando, oltre alla proposizione condizionale costituita dalla congiunzione delle premesse e dalla

conclusione, anche la congiunzione delle premesse, cioè l’antecedente della proposizione

condizionale, è vera (FL 21.07 = Pyrrh. Hyp. B 138).

22

2.4. Gli indimostrabili

Come Aristotele aveva costruito la sua sillogistica a partire dai modi della

prima figura, ritenuti evidenti, così anche gli Stoici stabilirono cinque discorsi

«indimostrabili». Li enumeriamo, indicando con p e q due generiche proposizioni, mentre tra parentesi riportiamo i nomi che saranno assegnati nel Medioevo

e che sono ancor oggi talvolta usati:

1. Se p allora q; ma p; dunque q (modus ponendo ponens).

2. Se p allora q; ma non q; dunque non p (modus tollendo tollens).

3. Non (p e q); ma p; dunque non q (modus ponendo tollens).

4. O solo p o solo q; ma p; dunque non q (modus ponendo tollens).

5. O solo p o solo q; ma non p; dunque q (modus tollendo ponens). (cfr. SVF II, 241)

Le idee sul ruolo di questi princìpi erano molto chiare:

Gli indimostrabili sono quelli di cui gli Stoici dicono che non hanno bisogno di dimostrazione per essere sostenuti. [...] Essi ne immaginano molti, ma ne pongono particolarmente cinque, da cui pare che si possano dedurre tutti gli altri (FL 22.03 = Pyrrh. Hyp. B 156).

Non sapendo quali regole venissero ammesse per dedurre nuovi «discorsi» (a causa della frammentarietà delle fonti), non possiamo giudicare se venne

effettivamente costruita una logica proposizionale completa, in cui cioè tutte le

proposizioni vere siano dimostrabili. Pare certo però che venne almeno chiaramente intuìto il concetto di completezza di un sistema logico. Esso svolgerà un

ruolo fondamentale nella logica contemporanea, quando Kurt Gödel (19061978) riuscirà sorprendentemente a dimostrare che nessun sistema logico che

raggiunga una certa potenza espressiva può essere completo.

Ci si potrebbe domandare quale sia l’utilità di stabilire indimostrabili e regole di

deduzione se — come già detto — l’uso delle tavole è sufficiente per accertare la verità o falsità di qualsiasi proposizione. In realtà, le tavole di verità diventano inutilizzabili appena si esce dal dominio della logica proposizionale e si entra in quello della logica dei termini. Per esempio, i sillogismi di Aristotele non potrebbero essere dimostrati così. Ciò significa che a partire da un certo livello di complessità non esiste più

nessun modo puramente meccanico per dimostrare teoremi.

2.5. L’antinomia del mentitore

Un ulteriore campo dove la logica megarico-stoica diede importanti contributi è nello studio delle cosiddette «antinomie logiche». La più importante è

quella nota come «antinomia del mentitore», formulata per la prima volta dal

megarico Eubulide:

23

Il cretese che afferma che i cretesi mentono sempre, mente o dice la verità?

Lo spunto per questo paradosso sembra essere stato offerto da un esametro del sapiente cretese Epimenide (VI sec. a.C.), testimoniato nel Nuovo Testamento: «I Cretesi sono sempre mentitori, cattive bestie, pigri ghiottoni»

(Κρῆτες ἀεὶ ψευσταί, κακὰ θηρία, γαστέρες ἀργαί [Tit. 1,12]). È evidente che si

giunge in ogni caso ad una contraddizione: se il Cretese dicesse la verità, ciò significherebbe che sta mentendo; se stesse mentendo, ciò significherebbe che

dice la verità. Crisippo scrisse sull’argomento ventotto libri, ma qualcuno fece di

peggio; ecco la lapide di Filita di Cos (340 ca.-285 a.C.): «Viandante, io sono Filita; l’argomento chiamato “il mentitore” e le profonde meditazioni notturne mi

condussero alla morte» (FL 23.08). Sfortunatamente non conosciamo bene le

soluzioni elaborate. Pare che Crisippo sostenesse che l’antinomia del mentitore

non è neanche una proposizione, essendo impossibile stabilire se è vera o falsa.

Questo problema accompagnerà comunque l’intera storia della logica. Paolo Veneto nel Medioevo discuterà ben quindici soluzioni differenti dell’antinomia,

che è rimasta al centro dell’attenzione fino ai tempi moderni.

24

3. L’arte combinatoria di Leibniz

3.1. La rifondazione della logica

Benché le ricerche di Leibniz (1646-1716) nel campo della logica siano in

sé molto importanti, la loro importanza storica è purtroppo molto limitata: egli

infatti non pubblicò praticamente nulla di ciò che scoprì, e si dovette attendere

la fine dell’Ottocento perché ciò che per lui era già cosa nota venisse gradualmente riscoperto. Lo studio della logica è visto da Leibniz in gran parte come alternativa al Discorso sul metodo di Descartes, giudicato troppo vago nei

suoi criteri della «chiarezza e distinzione»:

Vedo che gli uomini del nostro tempo abusano molto di quel famoso principio continuamente ripetuto: qualsiasi cosa percepisco chiaramente e distintamente di qualcosa, è vero, ovvero può essere enunciato di essa. Spesso infatti agli uomini che giudicano frettolosamente sembrano chiare e distinte cosa oscure e confuse. Dunque l’assioma è inutile se non

vengono usati dei criteri del chiaro e del distinto [...] e se non consta la verità delle idee. Del

resto non sono da disprezzare quei criteri di verità degli enunciati che sono le regole della logica comune, che anche i geometri usano, che cioè nulla va ammesso come certo se non è

provato da un’accurata esperienza o da una solida dimostrazione; e solida dimostrazione è

quella che rispetta la forma prescritta dalla logica, non come se fossero necessari i sillogismi

ordinati al modo scolastico [...] , ma almeno in modo che l’argomentazione sia conclusiva in

virtù della forma (come esempio di un’argomentazione nella forma debita potresti dire anche un qualsiasi calcolo legittimo); così né bisogna omettere qualche premessa necessaria, e

tutte le premesse o devono essere già da prima dimostrate, o almeno vanno assunte a mo’

d’ipotesi, nel qual caso anche la conclusione è ipotetica. Coloro che osserveranno attentamente queste norme facilmente si proteggeranno da idee ingannevoli (Meditationes de cognitione, veritate et ideis).

Leibniz non intende però semplicemente riprendere la logica antica e medioevale, ma concepisce l’idea di una sua radicale rifondazione, che viene da lui

25

posta sotto il nome di «arte combinatoria» e che eserciterà una certa influenza

anche sui posteri. In tale denominazione è implicito un netto progresso rispetto

alle idee precedenti in materia:

Chiamo arte combinatoria quella scienza (che si può dire anche in generale caratteristica, o speciosa), in cui si tratta di tutte le forme o formule delle cose, cioè della qualità in

genere, o del simile e dissimile, a, b, c, ecc. (che possono rappresentare quantità o altro), in

quanto dalla loro combinazione nascono via via altre formule; essa si distingue dall’algebra

che concerne le formule applicate alla quantità, ovvero l’eguale e l’ineguale. L’algebra, pertanto, si subordina alla combinatoria, e si serve continuamente delle sue regole, che peraltro

sono di gran lunga più generali, e valgono non solo per l’algebra soltanto, ma anche per l’arte

decifratoria, per vari generi di giochi, per la stessa geometria trattata linearmente al modo

degli antichi, insomma, dovunque entri in gioco la similitudine (SAU, fine).

Leibniz concepisce insomma l’«arte combinatoria» come una scienza

puramente formale, che offre una base universale per tutte le altre. Il modello

di tale scienza è offerto dalla matematica: in essa infatti il linguaggio naturale,

di sua natura soggetto ad ambiguità e fraintendimenti, è abbandonato in favore

di un linguaggio artificiale, che permette di effettuare la deduzione come un

semplice «calcolo» di natura meccanica, cioè tramite la combinazione degli elementi del linguaggio; la stessa cosa deve avvenire nella logica, che dunque assume l’aspetto di una sorta di matematica generalizzata (e che perciò viene chiamata da Leibniz anche «mathesis universalis»). Anche il nome «caratteristica»

allude allo stesso fatto: la logica deve operare su simboli («caratteri») indipendentemente dal loro significato. Quest’idea, benché in parte ispirata dalla lettura di Hobbes e di Lullo, è in realtà di gran lunga più profonda; tra l’altro, essa rispecchia esattamente la concezione di logica che si affermerà nel Novecento, e

che per questi motivi viene spesso chiamata «logica matematica».

3.2. La concezione della verità

Esiste una nozione logica che assume un’importanza fondamentale per

l’intera filosofia di Leibniz. Si tratta del concetto di verità, evidentemente legato

alla comprensione della logica come «arte combinatoria» e dunque puramente

formale. Ecco uno dei numerosi testi in cui Leibniz si pronuncia con chiarezza al

riguardo:

È palese che ogni predicazione vera ha qualche fondamento nella natura delle cose, e

quando una proposizione non è identica, vale a dire quando il predicato non è compreso

espressamente nel soggetto, bisogna che vi sia compreso virtualmente, e questo è ciò che i

filosofi chiamano in-esse, dicendo che il predicato è nel soggetto. Così bisogna che il termine

del soggetto racchiuda sempre quello del predicato, di modo che colui che intendesse perfettamente la nozione del soggetto, giudicherebbe anche che il predicato gli appartiene. [...]

Dio, vedendo la nozione individuale o ecceità di Alessandro [Magno], vi vede in pari tempo il

26

fondamento e la ragione di tutti i predicati che si possono dire di lui con verità, come per

esempio che egli vincerà Dario e Poro, fino a conoscere a priori (e non per esperienza) se è

morto di una morte naturale o avvelenato, il che noi possiamo sapere solo grazie alla storia

(DM 8).

In sintesi: la ragione della verità di una proposizione va trovata sempre e

solo all’interno della proposizione stessa, e cioè nell’inclusione del predicato nel

soggetto; questa inclusione può essere o evidente («il triangolo equilatero è un

triangolo») o soltanto virtuale, nel qual caso è necessaria un’analisi completa

del soggetto per mostrarvi la presenza del predicato, benché quest’analisi alla

mente limitata dell’uomo possa risultare di fatto impossibile. Tutte le proposizioni vere hanno dunque di per sé la loro dimostrazione a priori, cioè

indipendentemente dall’esperienza, anche se la maggior parte vengono conosciute dall’uomo solo a posteriori, e cioè dall’esperienza: che il 1º gennaio del

2000 a Roma faccia un certo tempo di per sé ha la sua dimostrazione a priori, in

séguito cioè ad un’analisi del concetto di atmosfera terrestre; ma di fatto noi lo

verremo a sapere solo quando giungerà quel giorno, dunque per esperienza. Tale concezione di verità non identifica però la realtà con la necessità, come avviene in Spinoza? Leibniz rifiuta esplicitamente questa conseguenza:

Sembra che in questo modo sarà distrutta la differenza tra le verità contingenti e necessarie, che la libertà umana non avrà più alcun luogo, e che una fatalità assoluta regnerà su

tutte le nostre azioni così come su tutti gli altri avvenimenti del mondo. [...] Io dico che la

connessione o conseguenza è di due tipi: una è assolutamente necessaria, e il suo contrario

implica contraddizione, e questa deduzione ha luogo nelle verità eterne, come sono quelle

della geometria; l’altra è necessaria solo ex hypothesi, e per così dire per accidente, ma essa

è contingente in sé, quando il contrario non implica affatto contraddizione. E questa connessione è fondata non sulle idee del tutto pure e sul semplice intelletto di Dio, ma ancora sui

suoi liberi decreti e sulla connessione dell’universo (DM 13).

Si tratta di un punto di estrema importanza nella filosofia di Leibniz, che

dunque va ben chiarito. Le due proposizioni «il triangolo ha gli angoli interni

eguali a due retti» e «Alessandro Magno vince Dario» hanno entrambe il motivo della loro verità in sé stesse, cioè i predicati sono presenti nei rispettivi soggetti. La loro differenza è chiara però quando si esaminano le proposizioni contrarie: «il triangolo non ha gli angoli interni eguali a due retti» e «Alessandro

Magno non vince Dario». La prima è una proposizione certamente falsa, perché

il concetto di «triangolo con gli angoli interni non eguali a due retti» è contraddittorio, come può essere facilmente dimostrato nella geometria euclidea.

Ma il concetto di «Alessandro Magno che non vince Dario» non è in sé contraddittorio: benché nel nostro mondo esso non abbia esistenza, è immaginabile un

mondo diverso in cui Alessandro Magno perda. Le verità necessarie (o di ragione) sono quindi quelle valide in tutti i mondi possibili (e cioè non contraddittori),

le verità contingenti (o di fatto) sono quelle valide nel mondo reale ma non in

27

tutti i mondi possibili. Esse sono dunque necessarie solo sulla base di una premessa (ex hypothesi): dato che questo è il mondo esistente, allora necessariamente Alessandro vince Dario. Ciò si può esprimere anche dicendo che le verità

necessarie sono fondate sull’intelletto di Dio, che pensa tutti i mondi possibili,

mentre quelle contingenti sono fondate sulla volontà di Dio, che ha deciso quale di questi mondi possibili creare, cioè rendere reale.

Da ciò si ricava anche che ci sono in realtà proposizioni contingenti che, contro

la regola generale, non hanno una prova a priori, o perlomeno non nel senso in cui la

posseggono le altre: le proposizioni esistenziali, che affermano se qualcosa esiste o

no. Nel concetto di Alessandro Magno non è compresa la sua esistenza. Ciò avviene —

eccezione dell’eccezione — solo nel caso di Dio, come si vedrà.

Da questa concezione della verità discende la supremazia di due princìpi

logici:

I nostri ragionamenti sono fondati su due grandi princìpi:

il principio di contraddizione, in virtù del quale giudichiamo falso ciò che la includa, e

vero ciò che è opposto al contraddittorio o falso;

e il principio di ragion sufficiente, in virtù del quale consideriamo che nessun fatto potrebbe essere vero, o esistente, nessuna enunciazione vera, senza che vi sia una ragione sufficiente perché sia così e non altrimenti, benché queste ragioni il più delle volte possano non

esserci affatto note.

[...] La ragione sufficiente si deve trovare anche nelle verità contingenti o di fatto, cioè

nella sequenza delle cose distribuite nell’universo delle creature, dove la risoluzione in ragioni particolari potrebbe andare fino ad un dettaglio senza limiti, a causa della varietà immensa delle cose della natura e della divisione dei corpi all’infinito (M 31-32, 36).

I due princìpi sono in gran parte complementari: se infatti il principio di

contraddizione (detto anche «di non contraddizione») afferma che le proposizioni in cui il predicato è incluso nel soggetto sono vere, il principio di ragion sufficiente afferma che nelle proposizioni vere dev’esserci una ragione della loro

verità, e cioè anzitutto l’inclusione del predicato nel soggetto. Leibniz si preoccupa di far notare che questo principio si applica anche alle verità contingenti,

in cui l’analisi del soggetto potrebbe dover andare all’infinito e dunque essere

di fatto impossibile all’uomo (un’idea questa evidentemente ispirata dal calcolo

infinitesimale).

Ciò non significa — come spesso è stato affermato — che il principio di non

contraddizione riguardi solo le verità necessarie e quello di ragion sufficiente solo le

verità contingenti: entrambi riguardano ogni verità. È però vero che il principio di ragion sufficiente ha un’estensione maggiore di quello di non contraddizione, perché si

estende anche alle proposizioni contingenti esistenziali, sebbene mutando leggermente di significato: lì la ragion sufficiente della verità non può consistere certo

nella presenza del predicato nel soggetto. Proprio quest’uso del principio di ragion suf28

ficiente è in grado secondo Leibniz di condurre alla metafisica, che s’interroga sull’esistenza delle cose e sulla sua causa.

29

Giovanni Salmeri

Piccola

storia della logica

II. Il Novecento

Roma 1999

4. La logica nel Novecento

4.1. Georg Cantor (1845-1918)

4.1.1. La teoria degli insiemi

L’opera di Georg Cantor si situa nel complesso di ricerche che vennero

dedicate tra la fine dell’Ottocento e l’inizio del Novecento al problema della fondazione della matematica. Si trattava del tentativo di darle una base assolutamente solida, che non facesse ricorso né a considerazioni psicologiche, né a dati

«intuitivi» come venivano presentati dai neokantiani. Questo nuovo punto di

partenza è offerto secondo Cantor dalla teoria degli insiemi. Eccone i concetti

fondamentali:

Con insieme (Menge) intendiamo ogni riunione I in un tutto di determinati e ben distinti oggetti i della nostra intuizione o del nostro pensiero (che vengono chiamati elementi

di I). In simboli esprimiamo ciò così:

I = {i}.

[...]