G. Giunta, Probabilità, Legge dei Grandi Numeri e Teoremi Fondamentali, 2005.

1

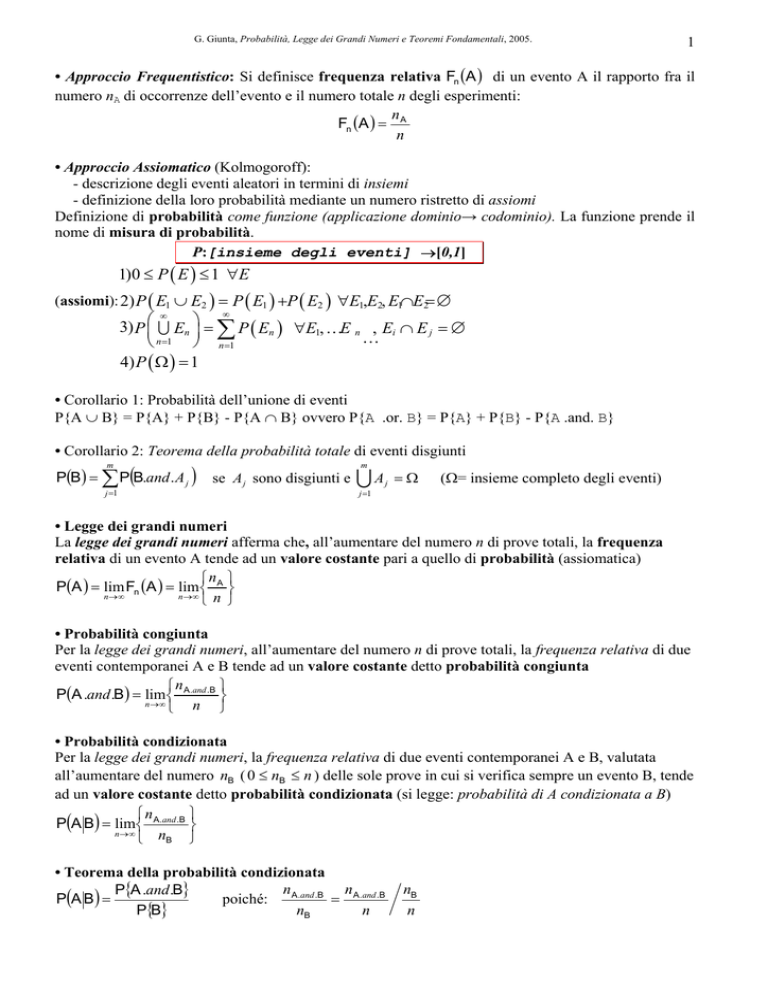

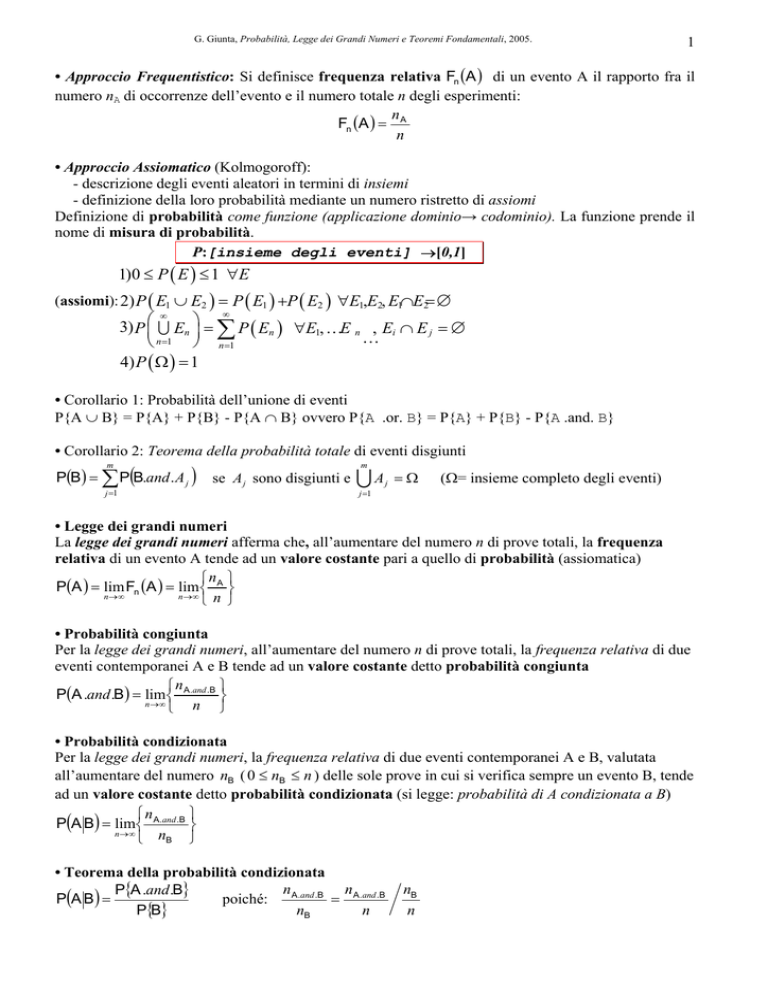

• Approccio Frequentistico: Si definisce frequenza relativa Fn (A ) di un evento A il rapporto fra il

numero nA di occorrenze dell’evento e il numero totale n degli esperimenti:

n

Fn (A ) = A

n

• Approccio Assiomatico (Kolmogoroff):

- descrizione degli eventi aleatori in termini di insiemi

- definizione della loro probabilità mediante un numero ristretto di assiomi

Definizione di probabilità come funzione (applicazione dominio→ codominio). La funzione prende il

nome di misura di probabilità.

P:[insieme degli eventi] →[0,1]

1)0 ≤ P ( E ) ≤ 1 ∀E

(assiomi): 2) P ( E1 ∪ E2 ) = P ( E1 ) +P ( E2 ) ∀E1,E2, E1∩E2= ∅

∞

∞

3) P ⎛⎜ U En ⎞⎟ = ∑ P ( En ) ∀E1, KE n , Ei ∩ E j = ∅

K

⎝ n =1 ⎠ n =1

4) P ( Ω ) = 1

• Corollario 1: Probabilità dell’unione di eventi

P{A ∪ B} = P{A} + P{B} - P{A ∩ B} ovvero P{A .or. B} = P{A} + P{B} - P{A .and. B}

• Corollario 2: Teorema della probabilità totale di eventi disgiunti

P(B ) = ∑ P(B.and . A j )

m

m

j =1

se A j sono disgiunti e

UA

j

=Ω

(Ω= insieme completo degli eventi)

j =1

• Legge dei grandi numeri

La legge dei grandi numeri afferma che, all’aumentare del numero n di prove totali, la frequenza

relativa di un evento A tende ad un valore costante pari a quello di probabilità (assiomatica)

⎧n ⎫

P(A ) = lim Fn (A ) = lim ⎨ A ⎬

n →∞

n →∞

⎩n ⎭

• Probabilità congiunta

Per la legge dei grandi numeri, all’aumentare del numero n di prove totali, la frequenza relativa di due

eventi contemporanei A e B tende ad un valore costante detto probabilità congiunta

⎧n

⎫

P(A .and .B ) = lim ⎨ A .and .B ⎬

n →∞

⎩ n ⎭

• Probabilità condizionata

Per la legge dei grandi numeri, la frequenza relativa di due eventi contemporanei A e B, valutata

all’aumentare del numero nB ( 0 ≤ nB ≤ n ) delle sole prove in cui si verifica sempre un evento B, tende

ad un valore costante detto probabilità condizionata (si legge: probabilità di A condizionata a B)

⎫

⎧n

P(A B) = lim⎨ A.and .B ⎬

n →∞

⎩ nB ⎭

• Teorema della probabilità condizionata

n A .and .B n A.and .B

P{A .and .B}

=

P(A B ) =

poiché:

P{B}

nB

n

nB

n

G. Giunta, Probabilità, Legge dei Grandi Numeri e Teoremi Fondamentali, 2005.

2

• Teorema di Bayes

P(B | A h ) Pr (A h )

P( A h | B ) = m

∑ P(B | A j )Pr (A j )

j =1

poiché: P(A h .and .B ) = P(B | A h )P(A h ) e P(B ) = ∑ P(B | A j )P(A j )

m

j =1

• variabili aleatorie (o variabili casuali o variabili random)

La variabile è una grandezza che, per definizione, può assumere valori diversi (al contrario della

costante). Le variabili aleatorie sono variabili che possono assumere uno dei valori ammissibili con

una data probabilità. In base all’insieme di valori possibili (finito o infinito) si differenziano in:

-) variabili aleatorie discrete, per insiemi finiti, esempio: valore di un bit, faccia di un dado (in latino

alea);

-) variabili aleatorie continue, per insiemi infiniti, esempio: ora effettiva di inizio della lezione, misura

fisica.

• caratterizzazione probabilistica delle variabili aleatorie

Le variabili aleatorie discrete sono caratterizzate statisticamente dalla probabilità (frequenza relativa)

dei vari eventi possibili (esempio P(b=0) e P(b=1) per il bit b).

Un’altra forma equivalente di caratterizzazione probabilistica è la funzione di distribuzione

(cumulativa), che si definisce per variabili aleatorie (X) sia continue che discrete. Essa è una funzione

D X (x) della variabile continua x (invece X può essere continua o discreta) definita come:

D X ( x) = P( X ≤ x)

risultando ovviamente D X (−∞) = 0 e D X (+∞) = 1 .

Le variabili aleatorie continue non possono essere caratterizzate statisticamente dalla probabilità

perché essa è infinitesima (tende a zero). Pertanto, similmente alla misura fisica della massa

(distribuita con continuità nello spazio) ove si è definita la densità di massa, si utilizza il concetto di

densità di probabilità. La densità di probabilità p X (x) di una variabile aleatoria X (X può essere

continua o discreta) si definisce come derivata della funzione di distribuzione cumulativa, ovvero:

d D X ( x)

P( X ≤ x + dx) − P ( X ≤ x)

P ( x ≤ X ≤ x + dx)

p X ( x) =

= lim

= lim

dx − > 0

dx − > 0

dx

dx

dx

Infine, un’altra forma equivalente di caratterizzazione probabilistica è la funzione caratteristica (che si

definisce per una variabile aleatoria x continua o discreta) come trasformata di Fourier della densità

di probabilità p X (x) , ovvero:

+∞

CFX ( f ) =

∫ p X ( x) ⋅ exp[− j ⋅ 2π ⋅ f ⋅ x]⋅ dx

−∞

+∞

Si noti che, per definizione:

∫p

X

( x)dx = CFX (0) = 1

−∞

• indipendenza statistica di variabili aleatorie

Due variabili aleatorie X e Y sono dette statisticamente indipendenti se e solo se:

P( X Y ) = P(Y ) ovvero, equivalentemente P(Y X ) = P(Y ) nel caso discreto;

p X ( x y ) = p X ( x) ovvero, equivalentemente pY ( y x) = pY ( y ) nel caso continuo.

Le definizioni di sopra sono equivalenti per il teorema della probabilità condizionata alla seguente

proprietà di fattorizzazione della probabilità congiunta di variabili aleatorie indipendenti:

P( X .and .Y ) = P( X ) ⋅ P(Y )

nel caso discreto;

p X ,Y ( x.and . y ) = p X ( x ) ⋅ pY ( y ) nel caso continuo.