GEOMETRIA II: SECONDA DISPENSA (PROVVISORIA)

1. T RIANGOLAZIONE E DIAGONALIZZAZIONE SIMULTANEA DI ENDOMORFISMI

Della triangolazione simultanea di due endomorfismi che commutano avevamo parlato soltanto negli esercizi della prima dispensa. A lezione ho invece barato, perché ho dato per scontato che gli autovalori fossero sempre reali. Per mettere le cose a posto,

scrivo ora tutto per bene, compresa l’ortonormalizzazione di Gram-Schmidt complessa.

1.1. Triangolarizzabilità di endomorfismi complessi. Questa parte ci è chiara. Vado velocemente perché ne abbiamo già parlato

abbastanza: se V è uno spazio vettoriale complesso di dimensione finita, e T è un suo endomorfismo lineare, allora gli autovalori

di T si trovano risolvendo l’equazione caratteristica, che si ottiene eguagliando il polinomio caratteristico di T a zero.

Se dim V = n, il polinomio caratteristico di T è un polinomio a coefficienti complessi di grado n. Per il teorema fondamentale

dell’algebra, deve ammettere almeno una radice.

In conclusione

Proposizione 1.1. Sia V uno spazio vettoriale complesso di dimensione finita, e T un suo endomorfismo. Allora T ammette almeno un

autovalore complesso.

Dal momento che ad ogni autovalore corrisponde un autospazio non banale, un’immediata conseguenza è il

Corollario 1.2. Sia V uno spazio vettoriale complesso di dimensione finita, e T un suo endomorfismo. Allora esiste certamente un autovettore

di T : un vettore, cioè, 0 6= v ∈ V tale che T (v) = λv per qualche λ ∈ C.

Una conseguenza meno immediata, ma che abbiamo mostrato per induzione, è la seguente:

Corollario 1.3. Sia V uno spazio vettoriale complesso di dimensione finita, e T un suo endomorfismo. Allora esiste una base di V in cui la

matrice associata a T è triangolare superiore.

1.2. Autospazi di endomorfismi che commutano. In quello che segue S, T sono endomorfismi di uno spazio vettoriale complesso

di dimensione finita. Vi ricordo che, se λ ∈ C, il λ-autospazio di S è il sottospazio

VλS = {v ∈ V |S(v) = λv}.

Proposizione 1.4. Se ST = T S, allora gli autospazi di S sono T -invarianti e viceversa.

Dimostrazione. Mostriamo che, se λ ∈ C, allora T (VλS ) ⊂ VλS . In effetti, v ∈ VλS vuol dire che S(v) = λv. Ma allora

S(T (v)) = T (S(v)) = T (λv) = λT (v),

e quindi anche T (v) è un autovettore di S di autovalore λ. Il viceversa si ottiene scambiando il ruolo di S e T .

La dimostrazione dell’enunciato che segue è anche un’indicazione di come risolvere alcuni esercizi.

Corollario 1.5. Se ST = T S, allora esiste un autovettore simultaneo di S e T : un vettore, cioè, 0 6= v ∈ V tale che S(v) = λv e T (v) = µv

per un’opportuna scelta di λ, µ ∈ C.

Dimostrazione. Sia λ un autovalore di S, e U = VλS l’autospazio corrispondente. Per la proposizione precedente, si ha T (U ) ⊂ U ,

quindi T agisce come endomorfismo di U . Ma allora un autovettore u ∈ U di T , che esiste per il Corollario 1.2, è anche un

autovettore di S, perché appartiene ad U .

La dimostrazione per induzione utilizzata per il Corollario 1.3 si applica parola per parola anche a questo caso più generale.

Corollario 1.6. Se ST = T S, allora esiste una base di V in cui sia la matrice associata ad S che quella associata a T sono triangolari superiori.

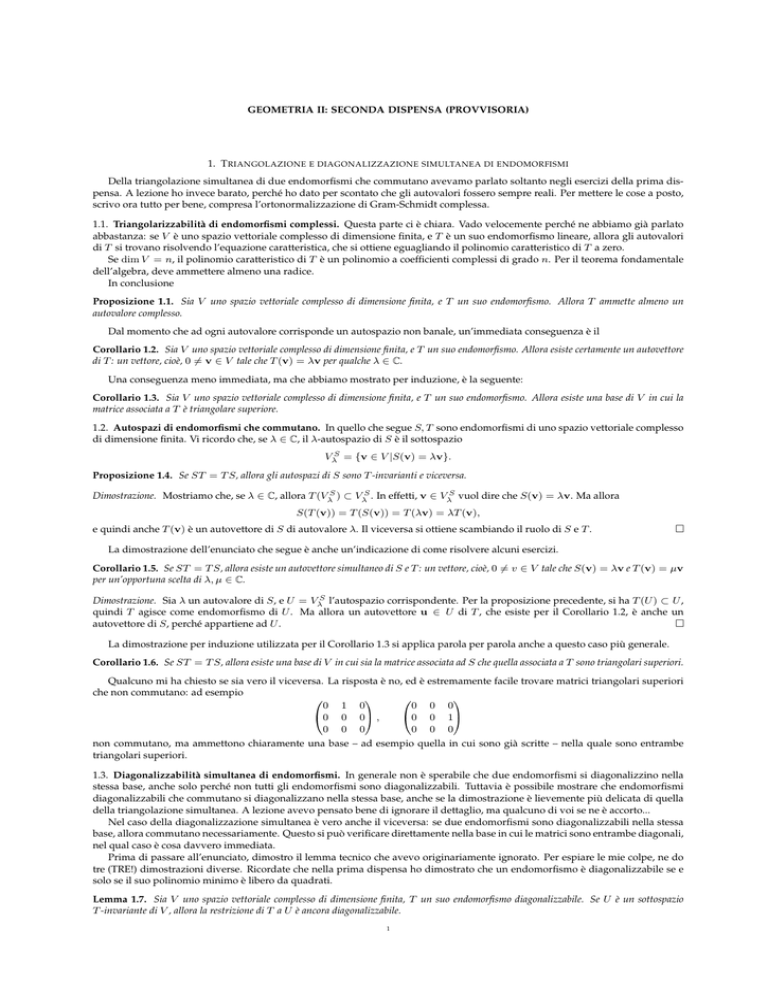

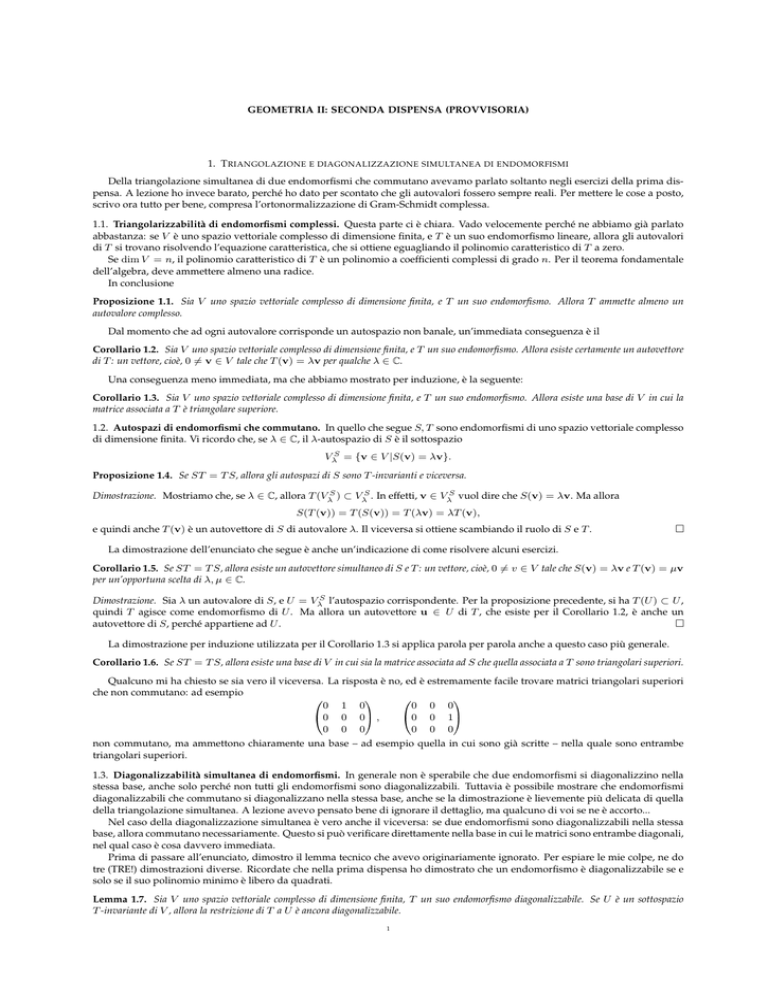

Qualcuno mi ha chiesto se sia vero il viceversa. La risposta è no, ed è estremamente facile trovare matrici triangolari superiori

che non commutano: ad esempio

00 1 01

00 0 01

@0 0 0A , @0 0 1A

0 0 0

0 0 0

non commutano, ma ammettono chiaramente una base – ad esempio quella in cui sono già scritte – nella quale sono entrambe

triangolari superiori.

1.3. Diagonalizzabilità simultanea di endomorfismi. In generale non è sperabile che due endomorfismi si diagonalizzino nella

stessa base, anche solo perché non tutti gli endomorfismi sono diagonalizzabili. Tuttavia è possibile mostrare che endomorfismi

diagonalizzabili che commutano si diagonalizzano nella stessa base, anche se la dimostrazione è lievemente più delicata di quella

della triangolazione simultanea. A lezione avevo pensato bene di ignorare il dettaglio, ma qualcuno di voi se ne è accorto...

Nel caso della diagonalizzazione simultanea è vero anche il viceversa: se due endomorfismi sono diagonalizzabili nella stessa

base, allora commutano necessariamente. Questo si può verificare direttamente nella base in cui le matrici sono entrambe diagonali,

nel qual caso è cosa davvero immediata.

Prima di passare all’enunciato, dimostro il lemma tecnico che avevo originariamente ignorato. Per espiare le mie colpe, ne do

tre (TRE!) dimostrazioni diverse. Ricordate che nella prima dispensa ho dimostrato che un endomorfismo è diagonalizzabile se e

solo se il suo polinomio minimo è libero da quadrati.

Lemma 1.7. Sia V uno spazio vettoriale complesso di dimensione finita, T un suo endomorfismo diagonalizzabile. Se U è un sottospazio

T -invariante di V , allora la restrizione di T a U è ancora diagonalizzabile.

1

2

GEOMETRIA I

Dimostrazione. T è un endomorfismo diagonalizzabile di V , e quindi il suo polinomio minimo è libero da quadrati. Questo vuol

dire che esiste un polinomio p(x) a coefficienti complessi senza radici multiple tale che p(T ) = 0. Ma allora vale anche p(T |U ) = 0.

In effetti, l’azione di T |U su U coincide con quella di T – in fondo ne è la restrizione – quindi se p(T ) fa zero su U , e fa zero su tutto

V in realtà, allora anche p(T |U ) fa zero su tutto U .

Questo mostra che il polinomio p(x), libero da quadrati, annulla T |U . Il polinomio minimo di T |U allora, che non coincide

necessariamente con p(x), deve dividere p(x), ed essere quindi anch’esso libero da quadrati. Ma allora T |U è diagonalizzabile.

[Questa dimostrazione si scriveva in una riga, ma ho deciso di essere sovrabbondante nelle spiegazioni]

Vi avevo promesso tre dimostrazioni, quindi procedo con la seconda: T |U è un endomorfismo di U , e magari non è diagonalizzabile; però sicuramente U si decompone in somma diretta dei suoi antospazi generalizzati U λ . Chiaramente, U λ è contenuto nel

T -autospazio generalizzato V λ . Tuttavia T è diagonalizzabile su V , e quindi l’azione di T su V λ è data dalla moltiplicazione per

λ. Ma allora lo stesso è vero di U λ ⊂ V λ .

La terza dimostrazione è quella che richiede meno idee, ma è in fondo la più complicata. Per mostrare che T |U è diagonalizzabile, devo far vedere che ogni u ∈ U si scrive come somma di autovettori di T contenuti in U . Questo è in sé un po’ difficile, ma

non lo sarebbe se non richiedessimo che gli autovettori appartenessero ad U : in effetti, l’azione di T su tutto V è diagonalizzabile,

quindi V è somma diretta degli autospazi di T , e quindi ogni vettore di V – ed in particolare anche quelli di U – si esprimono

come somma di autovettori di T . Sappiamo quindi che, se u ∈ U , allora è possibile trovare v1 , . . . , vh autovettori di T (relativi ad

autovalori distinti λ1 , . . . , λh tali che

u = v1 + . . . + vh .

L’unica cosa da mostrare è ora che v1 , . . . , vh appartengono tutti ad U .

Dimostrerò, per induzione sul numero h di vettori, che se la somma di autovettori (relativi ad autovalori distinti) v1 , . . . , vh

di T appartiene al sottospazio T -stabile U , allora anche v1 , . . . , vh ∈ U . Se h = 1 l’enunciato è ovvio. Se h > 1, osserviamo che

applicando T si ottiene

T (u) = λ1 v1 + . . . + λh vh ,

e che T (u) ∈ U . Sottraendo l’identità precedente moltiplicata per λh si ottiene

U 3 T (u) − λh u = (λ1 − λh )v1 + . . . + (λh−1 − λh )vh−1 ,

che contiene meno autovettori, e mostra per ipotesi induttiva che (λi − λh )vi ∈ U per i = 1, . . . , h − 1, da cui vi ∈ U . vh ∈ U si

ottiene per differenza.

Proposizione 1.8. Sia V uno spazio vettoriale complesso di dimensione finita, S, T suoi endomorfismi diagonalizzabili tali che ST = T S.

Allora è possibile trovare una base di V in cui sia la matrice associata ad S che quella associata a T siano diagonali.

Dimostrazione. Dobbiamo trovare una base di V composta da autovettori simultanei di S e T . Si può procedere come segue:

sappiamo che V è somma diretta degli autospazi di S. D’altronde ogni autospazio VλS è T -invariante, e quindi l’azione della

restrizione di T a tale autospazio è ancora diagonalizzabile. Esiste quindi una base di VλS che diagonalizza la restrizione di T : si

tratta di una base composta da T -autovettori che sono tutti λ-autovettori di S.

Ma se V è somma diretta degli autospazi di S, scegliendo una base da ciascun autospazio, e mettendo tutti questi vettori

insieme, si ottiene una base di V . Se la base da ciascun autospazio è scelta come illustrato sopra, si ottiene un insieme di vettori che

sono autovettori sia rispetto ad S che rispetto a T .

1.4. Prodotti scalari reali e complessi. Sia V uno spazio vettoriale reale di dimensione finita. Un prodotto scalare su V è un’applicazione bilineare h·|·i che è simmetrica:

hu|vi = hv|ui, per ogni u, v ∈ V ;

e definita positiva:

hv|vi > 0 per ogni 0 6= v ∈ V.

Il numero reale (non negativo) kvk = hv|vi1/2 è detto lunghezza, modulo o norma del vettore v. L’unico vettore di lunghezza

nulla è, per la positività del prodotto scalare, il vettore nullo. Diremo che i vettori u e v formano un angolo 0 ≤ θ ≤ π se

cos θ =

hu|vi

.

kuk · kvk

In particolare u e v si dicono ortogonali se hu|vi = 0. Ricapitolo brevemente, dando le dimostrazioni, alcuni fatti che conosciamo

già dal corso di Geometria 1.

Proposizione 1.9 (Disuguaglianza di Cauchy-Schwartz). Se h·|·i è un prodotto scalare sullo spazio vettoriale reale V , allora:

|hu|vi| ≤ kuk · kvk

Dimostrazione. Per la positività del prodotto scalare, la quantità

hu − αv|u − αvi

è sempre maggiore o uguale a zero. Utilizzando la bilinearità e la simmetria si ha

hu − αv|u − αvi = hu|ui − 2αhu|vi + α2 hv|vi,

e scegliendo α = hu|vi/hv|vi si ottiene

0 ≤ hu − αv|u − αvi = hu|ui −

hu|vi2

,

hv|vi

da cui

hu|vi2 ≤ hu|ui · hv|vi.

ATTENZIONE: questa non è la dimostrazione che era stata data all’inizio del corso di Geometria 1, ma è quella che più facilmente

si generalizza al caso complesso.

Si osservi che la dimostrazione chiarisce quali sono i casi in cui sussista l’uguaglianza: deve essere u = αv, e quindi i due

vettori devono essere paralleli. Nelle stesse ipotesi del risultato appena mostrato, si ha anche:

GEOMETRIA I

3

Corollario 1.10 (Disuguaglianza triangolare). Per ogni scelta di u, v ∈ V si ha:

ku + vk ≤ kuk + kvk.

Dimostrazione. Basta mostrare che ku + vk2 ≤ (kuk + kvk)2 . Questo è però di facile verifica: infatti

ku + vk2 = hu + v|u + vi = hu|ui + 2hu|vi + hv|vi = kuk2 + kvk2 + 2hu|vi,

che per la disuguaglianza di Cauchy-Schwartz è minore o uguale a kuk2 + kvk2 + 2kuk · kvk = (kuk + kvk)2 .

Ogni spazio vettoriale reale dotato di prodotto scalare possiede quindi una naturale struttura di spazio metrico – controllate

sui libri di analisi cosa questo voglia dire esattamente – rispetto alla metrica d(P, Q) = kP − Qk. Nel caso di spazi vettoriali

di dimensione finita, questa metrica è automaticamente completa (le successioni di Cauchy convergono tutte), mentre nel caso di

dimensione infinita le cose sono lievemente più complicate.

Se lo spazio vettoriale che stiamo considerando è complesso, la costruzione va leggermente modificata perché, come ho fatto

vedere a lezione, in questo caso non esistono forme bilineari simmetriche definite positive.

Definizione 1.11. Sia V uno spazio vettoriale complesso. Un prodotto scalare su V è un’applicazione h·|·i : V × V → C che

soddisfa le condizioni seguenti:

•

•

•

•

hu| λ1 v1 + λ2 v2 i = λ1 hu|v1 i + λ2 hu|v2 i per ogni u, v1 , v2 ∈ V ;

hλ1 u1 + λ2 u2 |vi = λ1 hu1 |vi + λ2 hu2 |vi per ogni u1 , u2 , v ∈ V ;

hu|vi = hv|ui per ogni u, v ∈ V ;

hu|ui > 0 per ogni u 6= 0.

[Linearità nel secondo argomento]

[Antilinearità nel primo argomento]

[Hermitianità o Hermiticità]

[Positività]

Le prime due condizioni di linearità prese insieme sono dette condizioni di sesquilinearità. Possiamo quindi dire, in modo conciso, che un prodotto scalare su uno spazio vettoriale complesso è una forma sesquilineare Hermitiana definita positiva. Generalmente,

parlando di forme Hermitiane, si trascura di menzionare la condizione di sesquilinearità, considerandola tuttavia implicitamente

valida.

E’ bene osservare che le quattro proprietà richieste sono intimamente legate l’una all’altra: dalla linearità nel secondo argomento,

insieme all’Hermitianità, segue immediatamente l’antilinearità nel primo argomento. Di nuovo, dall’Hermitianità segue che hu|ui

deve essere necessariamente un numero reale, perché è uguale al proprio complesso coniugato: di conseguenza ha senso imporre

la quarta condizione, perché la relazione d’ordine è ben definita solo tra numeri reali, e non sui numeri complessi.

Anche in questo caso, il numero reale (non negativo) kvk = hv|vi1/2 è detto lunghezza, modulo o norma del vettore v.

La lunghezza di un vettore non nullo è sempre diversa da zero, per la positività del prodotto scalare. I vettori u e v si dicono

ortogonali se hu|vi = 0. In questo caso hv|ui = hu|vi = 0, e quindi la relazione di ortogonalità è simmetrica. La dimostrazione

precedentemente data per la disuguaglianza di Cauchy-Schwartz si adatta con facilità al caso complesso.

Proposizione 1.12 (Disuguaglianza di Cauchy-Schwartz, caso complesso). Se h·|·i è un prodotto scalare sullo spazio vettoriale complesso

V , allora:

|hu|vi| ≤ kuk · kvk

Dimostrazione. Scegliendo α = hv|ui/hv|vi, e ricordando che hv|vi = hv|vi = kvk2 è un numero reale, si ottiene

0 ≤ hu − αv|u − αvi = hu|ui − αhu|vi − αhv|ui + ααhv|vi

hu|vi

hv|uihu|vi

hv|ui

hu|vi −

hv|ui +

hv|vi

hv|vi

hv|vi

hv|vi2

hu|vihv|ui

= kuk2 −

,

kvk2

= kuk2 −

da cui

|hu|vi|2 = hu|vihu|vi = hu|vihv|ui ≤ kuk2 · kvk2 .

ATTENZIONE: la scelta α = hu|vi/hv|vi non funziona! Verificatelo.

La disuguaglianza triangolare si può adesso ricavare come già precedentemente fatto. Anche nel caso di spazi vettoriali complessi dotati di prodotto scalare si ottiene quindi una struttura naturale di spazio metrico, che è sempre completo nel caso di

dimensione finita.

Esempio 1.13. Abbiamo già visto durante il corso di Geometria 1 come sullo spazio vettoriale reale Rn sia possibile definire il

prodotto scalare canonico: se u = (u1 , . . . , un ) e v = (v1 , . . . , vn ), allora

hu|vi = u1 v1 + . . . + un vn .

Alla stessa maniera lo spazio vettoriale complesso Cn possiede il prodotto scalare canonico

hu|vi = u1 v1 + . . . + un vn .

E’ facile verificare (fatelo!) che il prodotto scalare canonico è effettivamente sesquilineare, hermitiano e definito positivo.

Z

Esempio 1.14. La forma bilineare

π

(f |g) =

definisce un prodotto scalare sullo spazio vettoriale (reale)

[−π, π]. Allo stesso modo

f (x)g(x)dx

−π

C 0 ([−π, π]; R)

Z

delle funzioni continue reali definite sull’intervallo

π

(f |g) =

f (x)g(x)dx

−π

definisce un prodotto scalare sullo spazio vettoriale complesso C 0 ([−π, π]; C). Mostrate che gli assiomi di prodotto scalare sono

verificati in entrambi i casi.

4

GEOMETRIA I

Esempio 1.15. Sia V lo spazio vettoriale delle matrici n × n a coefficienti reali. Mostrate che

(A|B) = Tr(At B)

t

definisce su V un prodotto scalare. Allo stesso modo (A|B) = Tr(A B) definisce un prodotto scalare sullo spazio vettoriale delle

matrici n × n a coefficienti complessi. E’ facile verificare che kABk ≤ kAk · kBk.

1.5. Ortonormalizzazione di Gram-Schmidt complessa. Se V è uno spazio vettoriale (reale o complesso) dotato di prodotto

scalare h·|·i, un insieme di vettori {vi } è ortonormale (risp. ortogonale) se hvi |vj i = δij 1 (risp. se è uguale a 0 quando i 6= j).

Lemma 1.16. Se i vettori {vi } sono ortonormali, allora sono automaticamente linearmente indipendenti.

Dimostrazione. Se α1 v1 + . . . + αh vh = 0, allora si ottiene

αi = hvi | α1 v1 + . . . + αh vh i = hvi | 0i = 0,

per ogni i.

E’ naturale pensare di costruire delle basi ortonormali di V , per rendere più semplici i conti che utilizzano il prodotto scalare.

Questo è sempre possibile se V ha dimensione finita, mentre è possibile soltanto nei casi non interessanti se V ha dimensione

infinita. In effetti, si può vedere che se V possiede una base ortonormale rispetto ad un prodotto scalare che induce una struttura

di spazio metrico completo, allora V ha necessariamente dimensione finita.

Esempio 1.17. Se

1

sn (x) = √ sin(nx), n ∈ N;

π

1

c0 (x) = √ ;

2π

1

cn (x) = √ cos(nx), n ∈ N \ {0}

π

allora {sn (x), cn (x), n ∈ N} è un insieme ortonormale di elementi di C 0 ([−π, π]; K), dove K = R oppure C.

In dimensione infinita, si sostituisce al concetto di base ortonormale quello di base di Hilbert, o sistema ortonormale completo: si

tratta di un insieme di vettori linearmente indipendenti attraverso i quali non è possibile ottenere ogni vettore come combinazione

lineare (finita); è tuttavia possibile ottenere ogni vettore come combinazione lineare infinita convergente, cioè come limite convergente

di combinazioni lineari finite. Questo concetto, in qualche modo, è più adatto di quello di base agli spazi vettoriali completi dotati

di prodotto scalare: questi spazi sono detti anche spazi di Hilbert.

Lemma 1.18. Sia V uno spazio vettoriale (reale o complesso) di dimensione finita, dotato di prodotto scalare. Se {v1 , . . . , vh } è un insieme

ortonormale di elementi di V , allora per ogni scelta di v ∈ V

v⊥ = v −

h

X

hvi |vi vi

i=1

è ortogonale a tutti i vi .

Dimostrazione. E’ sufficiente calcolare

hvj |v⊥ i = hvj |v −

X

hvi |vi vi i = hvj |vi −

i

X

hvi |vi · δji = 0.

i

Corollario 1.19. Con le stesse ipotesi, se {v1 , . . . , vh } è un insieme ortonormale di elementi di V , e v non appartiene al sottospazio vettoriale

generato dai vi , allora

{v1 , . . . , vh , vh+1 = v⊥ /kv⊥ k }

è un insieme ortonormale.

Dimostrazione. Il vettore v⊥ è ottenuto da v sottraendo una combinazione lineare di v1 , . . . , vh , pertanto se v non appartiene al

sottospazio vettoriale generato da v1 , . . . , vh , v⊥ non può essere uguale a 0. Allora è sufficiente normalizzarlo a lunghezza uno

per ottenere un sistema ortonormale di h + 1 elementi.

E’ a questo punto chiaro come effettuare il procedimento di ortonormalizzazione su una base (v1 , . . . , vn ) di V : per pura

comodità computazionale, conviene differire le normalizzazioni all’ultimo passo.

• v10 = v1 ;

• v20 = v2 −

0

hv1

|v2 i 0

0 |v0 i v1 ;

hv1

1

• v30 = v3 −

0

hv1

|v3 i 0

0 |v0 i v1

hv1

1

−

0

hv2

|v3 i 0

0 |v0 i v2 ;

hv2

2

• ...

0 =v −

• vn

n

Pn−1 hv |v

i=1

0

i ni 0

v;

hvi0 |vi0 i i

0 ottenuti dividendoli ciascuno per la propria lunghezza.

• Normalizzare tutti i vettori v10 , . . . , vn

La base conclusiva, come già mostrato nella dispensa precedente, è una base ortonormale che induce la stessa bandiera di quella

originaria.

1Per chi non si fosse ancora scontrato con la delta di Kronecker, δ

ij

vale 1 se i = j e 0 altrimenti.

GEOMETRIA I

5

1.6. Forma triangolare in basi ortonormali. Se abbiamo uno spazio vettoriale complesso V di dimensione finita, dotato di prodotto

scalare, e due endomorfismi S, T di V che commutano tra loro – cioè tali che ST = T S – allora possiamo trovare una base che

triangolarizza sia la matrice di S che quella di T .

Il procedimento di ortonormalizzazione di Gram-Schmidt complesso, fatto come descritto sopra, individua una base ortonormale che induce la stessa bandiera, e che pertanto continua a triangolarizzare sia la matrice di S che quella di T . Enunciamo questo

risultato in due maniere diverse:

Proposizione 1.20. Se V è uno spazio vettoriale complesso di dimensione finita dotato di prodotto scalare h·|·i, e S, T sono endomorfismi di

V tali che ST = T S, allora esiste una base di V , ortonormale rispetto a h·|·i in cui le matrici di S e T sono entrambe triangolari superiori.

Lemma 1.21. Sia V uno spazio vettoriale complesso dotato di prodotto scalare h·|·i, e siano B, C due basi ortonormali. Allora la matrice

t

t

M = B [id]C di cambiamento di base è unitaria, cioè tale che M M = M M = id.

Dimostrazione. Sappiamo già dal corso di Geometria 1 che un’inversa sinistra della matrice M è anche destra, quindi è sufficiente

t

mostrare che M M = id: qui M indica la matrice i cui coefficienti sono i complessi coniugati di quelli di M .

Le colonne della matrice M sono le coordinate degli elementi della base B nella base C. Dal momento che entrambe le basi

sono ortonormali, le colonne di M sono una base ortonormale (perché ?) di Cn rispetto al prodotto scalare canonico. Ma allora

t

moltiplicando le righe di M per le colonne di M si calcolano i prodotti scalari canonici tra le colonne della matrice M , ottenendo

1 quando ci si riferisce alla stessa colonna, e 0 quando a colonne diverse. Il risultato del prodotto è precisamente la matrice

identità.

Proposizione 1.22. Date due matrici n × n a coefficienti complessi M, N tali che M N = N M esiste sempre una matrice n × n unitaria U

tale che U −1 M U e U −1 N U siano entrambe triangolari superiori.

Dimostrazione. Siano T, S gli endomorfismi di Cn di matrici M, N rispettivamente, e dotiamo Cn del suo prodotto scalare canonico.

Applicando la Proposizione 1.22 a questa situazione, si ottiene una base ortonormale (in generale diversa da quella canonica) in cui

le matrici sono entrambe triangolari superiori. Ma, come abbiamo visto, la matrice di cambiamento di base tra due basi ortonormali

è necessariamente una matrice unitaria.

2. F ORME BILINEARI

Sia V uno spazio vettoriale su campo K. F : V × V → K è una forma bilineare se è separatamente lineare nei due argomenti.

Le forme bilineari possono essere sommate tra loro

(F1 + F2 )(u, v) = F1 (u, v) + F2 (u, v),

e moltiplicate per elementi di K

(λF )(u, v) = λ(F (u, v)),

ed il risultato è in entrambi i casi una forma bilineare. Pertanto, la famiglia Bil(V, K) delle forme bilineari definite su V possiede

una struttura di spazio vettoriale. Se V ha dimensione finita, e v1 , . . . , vn è una sua base, possiamo associare alla forma bilineare

F la matrice

0 F (v1 , v1 ) F (v1 , v2 ) . . . F (v1 , vn ) 1

B

...

. . . F (v2 , vn ) C

B F (v2. , v1 )

C

[F ] = B

C

..

@ ..

A.

.

F (vn , v1 )

...

. . . F (vn , vn )

E’ immediato verificare (fatelo!) che

0.1

..

C

B

B

0C

B

C

BC

(0, . . . , 0, 1, 0, . . . , 0)[F ] B1C = F (vi , vj )

B

C

B

0C

@A

..

.

se la cifra 1 compare alla i.esima posizione nel primo vettore, e alla j.esima posizione nel secondo vettore.

Proposizione 2.1. Le informazioni contenute nella matrice [F ] sono sufficienti per ricostruire la forma bilineare F . In effetti, se v = α1 v1 +

. . . + αn vn , w = β1 v1 + . . . + βn vn , allora

0 β1 1

B

B β2 C

C

F (v, w) = (α1 α2 . . . αn )[F ] B . C .

@ .. A

βn

In particolare, l’applicazione che associa ad ogni forma bilineare definita su V la corrispondente matrice nella base (v1 , . . . , vn ) è un isomorfismo (lineare) di Bil(V, K) con lo spazio vettoriale delle matrici n × n a coefficienti in K. In particolare, Bil(V, K) ha dimensione

n2 .

Dimostrazione. Dal momento che il prodotto righe per colonne tra matrici distribuisce rispetto alla somma, è immediato verificare

come l’espressione

0 β1 1

B

B β2 C

C

(α1 α2 . . . αn )M B . C

@ .. A

βn

sia bilineare nelle n.uple (α1 . . . αn ) e (β1 . . . βn ) comunque venga scelta la matrice n × n M a coefficienti in K: è quindi bilineare

anche nei vettori u, v dei quali le due n.uple sono le coordinate.

6

GEOMETRIA I

Per verificare l’uguaglianza descritta nell’enunciato, dal momento che entrambi i membri sono espressioni bilineari in u e v, è

sufficiente verificare che le due espressioni coincidono quando u e v appartengono alla base scelta: ma questo è inevitabile, perché

la matrice [F ] è stata costruita proprio per verificare questa proprietà.

Una forma bilineare F è simmetrica (risp. antisimmetrica) se F (u, v) = F (v, u) (risp. F (u, v) = −F (v, u)) per ogni scelta

degli argomenti u, v. Ogni forma bilineare F si può esprimere come somma di una forma bilineare simmetrica FS e di una

antisimmetrica FA , dove:

FS (u, v) =

1

(F (u, v) + F (v, u)) ,

2

FA (u, v) =

1

(F (u, v) − F (v, u)) .

2

2.1. Forme bilineari simmetriche e forme quadratiche. In questo paragrafo parleremo del concetto di forma quadratica definita

su uno spazio vettoriale, e ne analizzeremo il rapporto con le forme bilineari (simmetriche).

Allo stesso modo in cui le applicazioni lineari fornivano operazioni che, espresse in coordinate degli argomenti, risultavano

descritte da polinomi di primo grado senza termine noto, le forme quadratiche sono calcolate da espressioni di secondo grado

omogenee nelle coordinate dell’argomento. Volendo definire questa nozione senza fare ricordo alla scelta di una base dalla quale

ottenere coordinate, è necessario passare attraverso il concetto di forma bilineare.

Definizione 2.2. Sia V uno spazio vettoriale di dimensione finita. Un’applicazione q : V → K è detta forma quadratica se esiste una

forma bilineare F : V × V → K con la proprietà che q(v) = F (v, v).

Anche le forme quadratiche definite su V posseggono le proprietà degli spazi vettoriali. In effetti, la somma di due forme

quadratiche è ancora una forma quadratica, così come amche ogni multiplo di una forma quadratica è esso stesso una forma

quadratica.

Lemma 2.3. Sia q : V → K una forma quadratica. Allora se q(v) = F (v, v) per ogni v ∈ V , si ha anche q(v) = FS (v, v), dove FS è la

parte simmetrica della forma bilineare F . In particolare, se A è una forma bilineare antisimmetrica, si ha A(v, v) = 0 per ogni v ∈ V .

Dimostrazione. Se A è antisimmetrica, allora A(v, v) = −A(v, v) mostra che A(v, v) = 0 per ogni v ∈ V . D’altro canto, se

q(v) = F (v, v), e F = FS + FA con FS simmetrica e FA antisimmetrica, si ha che

q(v) = F (v, v) = (FS + FA )(v, v) = FS (v, v) + FA (v, v) = FS (v, v).

Ogni forma quadratica q può essere quindi indotta da una forma bilineare simmetrica. Un fatto più importante è che tale forma

simmetrica è unica, e può facilmente essere ricavata a partire da q, attraverso l’identità di polarizzazione.

Proposizione 2.4. Sia V uno spazio vettoriale su un campo K di caratteristica diversa da 2,2 q : V → K una forma quadratica. Allora se F è

una forma bilineare simmetrica tale che q(v) = F (v, v), si ha:

F (u, v) =

1

[q(u + v) − q(u) − q(v)] .

2

In particolare, F è unica.

Dimostrazione. Dal momento che q(u + v) = F (u + v, u + v), utilizzando la bilinearità e la simmetria di F si ottiene:

q(u + v) = F (u, u) + F (v, v) + 2F (u, v) = q(u) + q(v) + 2F (u, v).

L’enunciato appena mostrato si può rendere più preciso affermando che lo spazio vettoriale delle forme quadratiche e quello

delle forme bilineari simmetriche definiti sullo stesso spazio vettoriale V sono isomorfi.

L’identità di polarizzazione si può utilizzare per rappresentare, una volta fissata una base (v1 , . . . , vn ) dello spazio vettoriale

V , ogni forma quadratica q su V per mezzo di una matrice simmetrica n×n. Questo si ottiene calcolando per mezzo dell’identità di

polarizzazione l’unica forma bilineare simmetrica che induce q, al fine poi di utilizzare la base per calcolare i coefficienti F (vi , vj )

della matrice simmetrica [F ]. Questo può essere fatto in maniera efficiente quando q è data in coordinate, come mostra il seguente

esempio.

Esempio 2.5. Sia q : Kn → K una forma quadratica, (e1 , . . . , en ) la base canonica di Kn . Se

q(x1 , . . . , xn ) =

X

ai x2i +

i

X

allora la matrice simmetrica che rappresenta q è:

0 a1

B

b12 /2

B

B

@ ...

b1n /2

2Questo vuol dire che 2 6= 0 in K.

bij xi xj ,

i<j

b12 /2

a2

b13 /2

b23 /2

...

...

...

bn−1,n /2

...

1

b1n /2

b2n /2C

C

.. C

. A

an

GEOMETRIA I

7

2.2. Cambiamenti di base. In questo paragrafo vedremo come, scegliendo una base opportuna, la matrice associata ad una forma

bilineare simmetrica (e quindi alla corrispondente forma quadratica) possa mettersi in forma diagonale.

Prima di convincervi di questo fenomeno, ho prima bisogno di trovare un modo di calcolare la matrice associata ad una forma

bilineare F in una base, una volta che sia nota la matrice associata ad F in un’altra base.

Lemma 2.6. Siano M, N matrici n × n. Supponiamo che, per ogni scelta di una matrice 1 × n r e di una matrice n × 1 c si abbia che

rM c = rN c. Allora necessariaemente M = N .

Dimostrazione. Da rM c = rN c segue r(M − N )c = 0. E’ sufficiente quindi mostrare che se rXc = 0, allora X = 0.

Questo è facile: se X non è la matrice nulla, allora esiste almeno una scelta di c per cui Xc 6= 0. Se ora poniamo r = (Xc)t si

ottiene rXc = (Xc)t Xc = kXck2 6= 0.

Corollario 2.7. Sia V uno spazio vettoriale di dimensione finita, B = (v1 , . . . , vn ) una base di V , ed indichiamo con B [v] la colonna, cioè

la matrice n × 1, delle coordinate dell’elemento v nella base B. Allora per ogni forma bilineare F : V × V → K esiste una ed una sola matrice

M tale che F (u, v) = B [u]t M B [v].

Dimostrazione. Abbiamo già visto nel paragrafo precedente che M può essere costruita scegliendo, come coefficiente di riga i e

colonna j, il valore F (ei , ej ). Questo mostra l’esistenza della matrice M . L’unicità segue dal lemma precedente, in quanto due

matrici M, N con la proprietà descritta sopra soddisferebbero rM c = rN c per ogni scelta di colonne di coordinate r t = B [u] e

c = B [v].

Proposizione 2.8. Sia V uno spazio vettoriale di dimensione finita, nel quale abbiamo fissato basi B = (v1 , . . . , vn ) e C = (e1 , . . . , en ),

ed indichiamo con X = C [id]B la matrice di cambiamento di base. Se F : V × V → K è una forma bilineare, e M (risp. N ) è la matrice

associata ad F nella base B (risp. C), allora M = X t N X.

Dimostrazione. Sappiamo che

F (u, v) = ( B [u])t M B [v],

F (u, v) = ( C [u])t N C [v],

e che inoltre

C [u]

= X B [u].

Allora

( B [u])t M B [v] = F (u, v) = ( C [u])t N C [v] = (X B [u])t N (X B [u]) = ( B [u])t (X t N X) B [u],

e quindi M = X t N X per il Lemma 2.6.

2.3. Forme non degeneri ed ortogonali di sottospazi. Una forma bilineare F : V × V → K si dice degenere se esiste 0 6= u ∈ V tale

che F (u, v) = 0 per ogni v ∈ V . L’insieme di tali vettori è detto nucleo della forma bilineare, e si mostra facilmente che costituisce

un sottospazio. F è allora degenere se il suo nucleo contiene elementi non nulli.

Se il nucleo di F si limita al solo vettore nullo, allora F è detta, con scarsa fantasia del mondo scientifico, e manifestazioni di

entusiasmo da parte degli studenti, non degenere. Sono non degeneri molte interessanti forme bilineari, come ad esempio i prodotti

scalari sugli spazi vettoriali reali. Vale quindi la pena di studiarne le proprietà.

Uno degli aspetti che abbiamo studiato durante il corso di Geometria 1 era il fatto che, in uno spazio vettoriale reale V dotato di

prodotto scalare, fosse possibile definire l’ortogonale ad un sottospazio U : questo era il sottospazio U ⊥ composto da tutti i vettori

con prodotto scalare nullo con tutti i vettori di U , e la somma delle dimensioni di U ed U ⊥ coincideva con quella di V .

Era in realtà vero qualcosa di più: contenendo l’intersezione di U ed U ⊥ solamente il vettore nullo, V si decomponeva nella

somma diretta di U ed U ⊥ . Il mio obiettivo è ora quello di vedere fino a che punto queste affermazioni siano generalizzabili al caso

di una forma bilineare non degenere. Ripartiamo con ordine, dalle definizioni.

Definizione 2.9. Sia V uno spazio vettoriale di dimensione finita sul campo K, F : V × V → K una forma bilineare. Allora F è

detta non degerere se, equivalentemente:

• F (u, v) = 0 per ogni v ∈ V implica u = 0,

oppure

• se u 6= 0, esiste allora 0 6= v ∈ V tale che F (u, v) 6= 0.

Per trovare forme bilineari non degeneri non bisogna andare molto lontani.

Proposizione 2.10. Una forma bilineare simmetrica reale definita positiva (o definita negativa) è non degenere.

Dimostrazione. Se u 6= 0, allora F (u, u) è positivo (risp. negativo), e quindi diverso da zero.

Teorema 2.11. Sia V uno spazio vettoriale di dimensione finita su campo K, ed F : V × V → K una forma bilineare. Fissata una base B di

V , sia [F ] la matrice associata ad F nella base B. Allora F è degenere se e solo se det[F ] = 0.

Dimostrazione. Abbiamo già visto come calcolare F a partire dalla sua matrice [F ]: per calcolare F (u, v) è sufficiente moltiplicare

la riga 1 × n di coordinate di u per la matrice [F ] per la colonna n × 1 di coordinate di v. Se il determinante di [F ] è uguale a zero,

è nullo anche il determinante della sua matrice trasposta [F ]t . Ma allora è possibile trovare una matrice n × 1 r tale che [F ]t r = 0.

Questo mostra che

r t [F ]c = ([F ]t r)t c = 0,

per ogni scelta di c, e quindi che F (u, v) = 0 per ogni v ∈ V se u è scelto in modo che le sue coordinate appartengano al nucleo

della matrice [F ]t . Il viceversa è facile.

Quest’ultima dimostrazione è un po’ goffa: è possibile essere più eleganti nei casi reale e complesso adoperando un trucco un

po’ bieco, che permette di sfuttare il seguente fatto:

Teorema 2.12 (di rappresentazione di Riesz). Sia V uno spazio vettoriale reale di dimensione finita, dotato di un prodotto scalare h·|·i.

Allora per ogni forma bilineare F : V × V → R esiste un’unico endomorfismo T di V con la proprietà che F (u, v) = hu|T (v)i. Se B è

una base ortonormale di V rispetto al suo prodotto scalare, allora la matrice associata alla forma bilineare F coincide con la matrice B [T ]B

associata nella base B all’endomorfismo B. In maniera simile, rimane individuato un unico endomorfismo T ∗ tale che F (u, v) = hT (u)|vi

per ogni u, v ∈ V . Nella base ortonormale B, la matrice associata a T ∗ è la trasposta di quella associata a T .

8

GEOMETRIA I

Dimostrazione. Indichiamo con B [u] la colonna n × 1 di coordinate del vettore u ∈ V nella base B. Se B è ortonormale, sappiamo

già che il prodotto scalare tra vettori si riduce al prodotto scalare canonico tra le loro coordinate: hv|wi = ( B [v])t B [w]. Sappiamo

anche che se [F ] è la matrice di F nella base B, allora F (v, w) può essere calcolato eseguendo la moltiplicazione tra matrici

( B [v])t [F ] B [w]. Se T è l’endomorfismo di V che nella base B ha matrice [F ], possiamo allora concludere che

F (u, v) = ( B [v])t [F ] B [w] = ( B [v])t ([F ] B [w]) = ( B [v])t B [T (w)] = hu|T (v)i.

Il ragionamento per

T∗

è totalmente analogo.

Il trucco bieco sta nel fatto che ogni prodotto scalare dà origine ad una diversa rappresentazione della forma bilineare per mezzo

di un endomorfismo. Se siamo interessati alla matrice della forma bilineare F in una base B dello spazio vettoriale V , possiamo

semplicemente IMPORRE che questa base sia ortonormale, ottenere in questo modo un prodotto scalare che la rende ortonormale,

rispetto al quale F sarà rappresentata da un endomorfismo con esattamente la sua matrice. L’enunciato precedente, ad esempio, si

traduce nel seguente modo:

Proposizione 2.13. Sia V uno spazio vettoriale reale di dimensione finita dotato di prodotto scalare, ed F una forma bilineare su V rappresentata dall’endomorfismo T . Allora F è non degenere se e solo se T è invertibile se e solo se T ∗ è invertibile.

Dimostrazione. Che T sia invertibile se e solo se T sia invertibile, segue dal fatto che in una base ortonormale di V hanno matrici

trasposte l’una dell’altra, quindi con lo stesso determinante.

Se F è degenere, allora esiste u tale che F (u, v) = hT ∗ (u)|vi = 0 per ogni v ∈ V . Ma un prodotto scalare è sempre non

degenere, quindi l’unica possibilità è che sia T ∗ (u) = 0. Il viceversa si mostra in maniera simile.

Corollario 2.14. Una formal bilineare F : V × V → R è non degenere se e solo se F (u, v) = 0 per ogni u ∈ V implica v = 0.

Dimostrazione. L’invertibilità di T è equivalente all’invertibilità di T ∗ .

Se U ⊂ V è un sottospazio vettoriale, e F : V × V → R è una forma bilineare, allora possiamo definire l’ortogonale di U rispetto

ad F come segue:

UF⊥ = {v ∈ V |F (u, v) = 0 per ogni u ∈ U }.

Una verifica immediata mostra come UF⊥ sia ancora un sottospazio vettoriale di V .

Proposizione 2.15. Sia V uno spazio vettoriale reale dotato di prodotto scalare, e sia T l’endomorfismo di V che rappresenta la forma bilineare

F : V × V → R. Se U ⊂ V è un sottospazio vettoriale, allora dim UF⊥ + dim T ∗ (U ) = dim V .

Dimostrazione. Ricordiamo che F (u, v) = hT ∗ (u)|vi. Allora v appartiene ad UF⊥ esattamente quando è ortogonale a T ∗ (U )

rispetto al prodotto scalare di V . Quindi UF⊥ coincide con tale ortogonale (T ∗ (U ))⊥ , la cui dimensione è dim V − dim T ∗ (U ). Osservazione 2.16. E’ il caso di osservare che da T ∗ = T o T ∗ = −T segue T ∗ (U ) = T (U ). Questo accade ogni qual volta la forma

F sia simmetrica o antisimmetrica.

Corollario 2.17. Se la forma bilineare F definita su V è non-degenere, e U ⊂ V è un sottospazio vettoriale, si ha sempre

dim U + dim UF⊥ = dim V.

Dimostrazione. Scegliamo un prodotto scalare su V , e rappresentiamo F tramite un endomorfismo T . Dal momento che F è

non-degenere, sia T che T ∗ sono invertibili, e quindi T ∗ (U ) ha la stessa dimensione di U .

Corollario 2.18. Se la restrizione della forma bilineare F ad U ⊂ V è non degenere, allora dim U + dim UF⊥ = dim V. Inoltre U ∩ UF⊥ = 0.

Dimostrazione. Se u ∈ U , allora esiste v ∈ U tale che F (u, v) 6= 0. Questo mostra che 0 6= F (u, v) = hT ∗ (u)|vi e quindi che

T ∗ (u) 6= 0 per ogni u ∈ U . Allora T ∗ è iniettiva su U , e dim U = dim T ∗ (U ). La seconda parte dell’enunciato segue facilmente

dall’osservazione che un elemento u0 ∈ U ∩ UF⊥ è un elemento di U tale che 0 = F (u, u0 ), per ogni u ∈ U , che è in contraddizione

con la non degeneratezza di F |U .

2.4. Il teorema di Sylvester.

Proposizione 2.19. Sia V uno spazio vettoriale di dimensione finita, e F : V × V → K una forma bilineare simmetrica. Allora esiste una

base di V in cui la matrice associata ad F è diagonale.

Dimostrazione. Per induzione sulla dimensione n dello spazio vettoriale V , il caso n = 1 essendo banale. Supponiamo quindi

n > 1. Se la forma F è identicamente nulla, allora la matrice associata è quella identicamente nulla, che è banalmente diagonale.

Supponiamo quindi che F non sia identicamente nulla. Per l’identità di polarizzazione, la forma quadratica associata ad F non

può essere identicamente nulla. Scegliamo allora un elemento u ∈ V tale che F (u, u) 6= 0, ed indichiamo con U il sottospazio –

cioè la retta – che genera in V .

Allora, l’ortogonale UF⊥ di U rispetto ad F è un sottospazio di dimensione n − 1 tale che U ∩ UF⊥ = 0. Questo mostra che

V è somma diretta di U ed UF⊥ , e quindi che per ogni scelta di una base B di UF⊥ , gli elementi di B insieme con u formano una

base B0 di V . Dal momento che la dimensione di UF⊥ è inferiore a quella di V , possiamo scegliere per ipotesi induttiva la base B

in modo che la matrice associata ad F |U ⊥ sia diagonale. E’ facile ora verificare come la matrice associata ad F nella base B0 sia

F

diagonale.

Corollario 2.20. Sia V uno spazio vettoriale reale di dimensione finita, e F : V × V → R una forma bilineare simmetrica. Allora esiste una

base di V in cui la matrice associata ad F è diagonale, e gli elementi sulla diagonale assumono i soli valori ±1, 0.

Dimostrazione. Sia B = (v1 , . . . , vn ) la base in cui, per la Proposizione 2.19, la matrice associata ad F sia diagonale, e definiamo

(

vi0

=

vi

se F (vi , vi ) = 0

p

altrimenti.

vi / F (vi , vi )

0 ) ha la proprietà desiderata.

Allora la matrice associata ad F nella base B0 = (v10 , . . . , vn

Lemma 2.21. Se U, V ⊂ W sono sottospazi vettoriali tali che U ∩ V = 0, allora dim U + dim V ≤ dim W .

GEOMETRIA I

9

Dimostrazione. Segue dalla formula di Grassmann dim U + dim V = dim(U ∩ V ) + dim(U + V ).

Teorema 2.22 (di Sylvester). Sia V uno spazio vettoriale reale di dimensione finita, F : V × V → R una forma bilineare simmetrica, e

siano B, C basi di V in cui le matrici M, N associate ad F siano entrambe diagonali con coefficienti sulla diagonale che assumono i soli valori

1, −1, 0. Allora il numero di 1 (risp. −1, 0) nella matrice M coincide con quello nella matrice N .

−

+

−

0

0

Dimostrazione. A meno di riordinare gli elementi delle due basi, abbiamo B = (u+

1 , . . . , ur , u1 , . . . , us , u1 , . . . , ut ) e C =

−

+

0 ), dove abbiamo indicato i vettori con l’indice +, −, 0 a seconda che l’elemento corrispon, v10 , . . . , vT

, v1− , . . . , vS

(v1+ , . . . , vR

dente sulla diagonale sia rispettivamente 1, −1, 0. Se n = dim V , abbiamo chiaramente r + s + t = R + S + T = n. Fissiamo le

notazioni:

+

U + = hu+

1 , . . . , ur i,

V

+

=

+

i,

hv1+ , . . . , vR

−

0

0

−

U ≤0 = hu−

U − = hu−

1 , . . . , us , u1 , . . . , ut i,

1 , . . . , us i,

−

−

−

−

+

+

0

0

≤0

0

−

0

= hv1 , . . . , vS , v1 , . . . , vT i.

= hv1 , . . . , vR , v1 , . . . , vT i, V = hv1 , . . . , vS i, V

restrizione di F a V + , U + è definita positiva, mentre quella a V ≤0 , U ≤0 è semidefinita negativa.

+

0

0

U ≥0 = hu+

1 , . . . , ur , u1 , . . . , ut i,

V

E’ immediato osservare che la

Inoltre

≥0

dim U + = r, dim U − = s, dim U ≥0 = r + t, dim U ≤0 = s + t,

ed in maniera simile:

dim V + = R, dim V − = S, dim V ≥0 = R + T, dim V ≤0 = S + T.

= 0: infatti se v ∈ U + , allora F (v, v) ≥ 0, mentre da v ∈ V ≤0 segue F (v, v) ≤ 0. Quindi, se v ∈ U + ∩ V ≤0 ,

necessariamente F (v, v) = 0, e v = 0 segue dal fatto che la restrizione di F a U + è definita positiva. Ma allora, per il lemma

precedente, r + S + T ≤ n = R + S + T , da cui r ≤ R. Scambiando il ruolo delle due basi, si ottiene anche R ≤ r, e quindi

r = R. Applicando lo stesso ragionamento alle coppie di sottospazi U − , V ≥0 e V − , U ≥0 si ottiene poi s = S, da cui t = T per

differenza.

Allora U + ∩ V ≤0

Concludiamo traducendo le definizioni di positività, negatività e degenericità di una forma bilineare simmetrica nelle proprietà

della sua forma canonica di Sylvester. Ricordiamo che una forma bilineare simmetrica F : V × V → R è detta semidefinita positiva

(risp. semidefinita negativa) se F (v, v) ≥ 0 per ogni scelta di v ∈ V . Abbiamo già visto quando una forma bilineare simmetrica si

dica non-degenere, o definita positiva (risp. negativa). Allora:

• F è definita positiva (risp. negativa) se e solo se la sua forma di Sylvester ha solo coefficienti 1 (risp. −1) sulla diagonale.

• F è non-degenere se e solo se la sua forma di Sylvester ha solo coefficienti 1 e −1 sulla diagonale.

• F è semidefinita positiva (risp. negativa) se la sua forma di Sylvester ha solo coefficienti 1 e 0 (risp. −1 e 0) sulla diagonale.

2.5. Diagonalizzazione à la Gauss di forme bilineari simmetriche. Siano u, v, w tre vettori (li prenderemo linearmente indipendenti, ma non è necessario) di uno spazio vettoriale V su cui sia definita una forma bilineare simmetrica F : V × V → K, e

supponiamo che F (u, u) 6= 0. E’ facile calcolare (fatelo!) che, se v0 = v − αu, w0 = w − βu:

F (v0 , u) = F (v, u) − αF (u, u), F (w0 , u) = F (w, u) − βF (u, u);

F (v0 , v0 ) = F (v, v) − 2αF (v, u) + α2 F (u, u),

F (w0 , w0 ) = F (w, w) − 2βF (w, u) + β 2 F (u, u);

0

0

F (v , w ) = F (v, w) − αF (u, w) − βF (u, v) + αβF (u, u).

Dalla prima equazione segue che per i valori α = F (v, u)/F (u, u), β = F (w, u)/F (u, u), si ottiene F (v0 , u) = F (w0 , u) = 0.

Meno evidenti, ma assolutamente spettacolari, sono le altre cancellazioni:

F (v0 , v0 ) = F (v, v)−αF (v, u),

F (w0 , w0 ) = F (w, w)−βF (w, u),

F (v0 , w0 ) = F (v, w)−βF (v, u) = F (v, w)−αF (u, w),

che vi invito a verificare.

Questa osservazione permette di giustificare il seguente veloce metodo per diagonalizzare la matrice di una forma bilineare

simmetrica definita su uno spazio vettoriale V di dimensione finita.

Teorema 2.23. Sia V uno spazio vettoriale di dimensione finita sul campo K, F : V × V → K una forma bilineare simmetrica, e B =

(v1 , . . . , vn ) una base di V per la quale F (v1 , v1 ) 6= 0. Definiamo i vettori: vi0 = vi − F (vi , v1 )/F (v1 , v1 )v1 , i = 2, . . . , n.

0 ) è anch’essa una base di V , nella quale F (v , v0 ) = 0 per ogni i = 2, . . . , n; inoltre le righe dalla seconda

Allora C = (v1 , v20 , . . . , vn

1

i

all’n.esima della matrice associata ad F nella base C si ottengono sottraendo alle corrispondenti righe nella matrice associata ad F nella base B

l’unico multiplo della prima riga che renda il primo coefficiente nullo.

Dimostrazione. Segue immediatamente dalle identità mostrate prima, usando u = v1 , v = vi , w = vj , v0 = vi0 , w0 = vj0 .

Può valere la pena di osservare che non è neanche necessario effettuare l’eliminazione di Gauss su tutta la riga, ma soltanto

fino alla diagonale principale: infatti la matrice associata ad una forma bilineare simmetrica è simmetrica, e quindi è sufficiente

calcolare solo la metà inferiore dei coefficienti per conoscere anche la metà superiore. Questa eliminazione à la Gauss simmetrica

è una maniera molto efficiente di ridurre a forma diagonale la matrice associata ad una forma bilineare simmetrica, e di calcolare

quindi gli indici di positività, negatività e nullità di una forma bilineare simmetrica, o equivalentemente quadratica, reale.

2.6. Forme bilineari antisimmetriche reali. Forme simplettiche. La classificazione delle forme bilineari antisimmetriche reali è

addirittura più facile di quella delle forme simmetriche. Vediamo come farla, cominciando con degli esempi.

Esempio 2.24. L’unica forma bilineare antisimmetrica su uno spazio vettoriale di dimensione 1 è quella nulla, che è chiaramente

degenere.

Esempio 2.25. La matrice [F ] di una forma bilineare F antisimmetrica è antisimmetrica. Se F è definita su uno spazio vettoriale di

dimensione 2, la matrice [F ] deve essere necessariamente della forma

0

−α

α

,

0

ed è non-degenere se e solo se α 6= 0. In questo caso, a meno di dividere il secondo vettore della base per α, si può sempre trovare

una base in cui la matrice della forma F è esattamente

0 1

.

−1 0

Lo spazio vettoriale R2 dotato della forma bilineare associata a tale matrice è detto piano simplettico.

10

GEOMETRIA I

Teorema 2.26. Sia V uno spazio vettoriale reale di dimensione finita, F : V × V → R una forma bilineare antisimmetrica.

0 1 Allora esiste una

base di V in cui la matrice associata ad F è diagonale a blocchi, con blocchi sulla diagonale della forma (0) oppure

.

−1 0

In particolare – con linguaggio un po’ forbito – ogni spazio vettoriale dotato di una forma bilineare antisimmetrica non degenere è somma

diretta ortogonale di piani simplettici.

Dimostrazione. Dimostriamo l’enunciato per induzione su n = dim V . Se F è identicamente nulla, la sua matrice è diagonale a

blocchi con tutti blocchi nulli, e non c’è nulla da dimostrare. Se invece F non è identicamente nulla, allora è possibile trovare u, v ∈

V tali che F (u, v) 6= 0. A meno di sostituire v con v/F (u, v) possiamo supporre senza perdere di generalità che F (u, v) = 1.

Allora il piano π generato da u, v è un piano simplettico, poiché per antisimmetria si ha F (u, u) = F (v, v) = 0, F (v, u) =

⊥ ha dimensione n − 2, e V = π ⊕ π ⊥ .

−F (u, v) = −1. Dal momento che la restrizione di F a π è non degenere, avremo che πF

F

⊥.

Basta allora applicare l’ipotesi induttiva alla restrizione di F al sottospazio πF

Ricordate che a lezione ho fatto le cose un po’ alla rovescia: ho prima mostrato la classificazione nel caso non-degenere, ed ho

poi fatto vedere che il caso degenere differisce solo per la presenza di un blocco identicamente nullo.

3. I L TEOREMA SPETTRALE

3.1. Il teorema spettrale per endomorfismi reali autoaggiunti.

3.2. Il teorema spettrale per endomorfismi complessi normali.

D IPARTIMENTO DI M ATEMATICA , U NIVERSITÀ DEGLI STUDI DI R OMA – “L A S APIENZA”

E-mail address: [email protected]