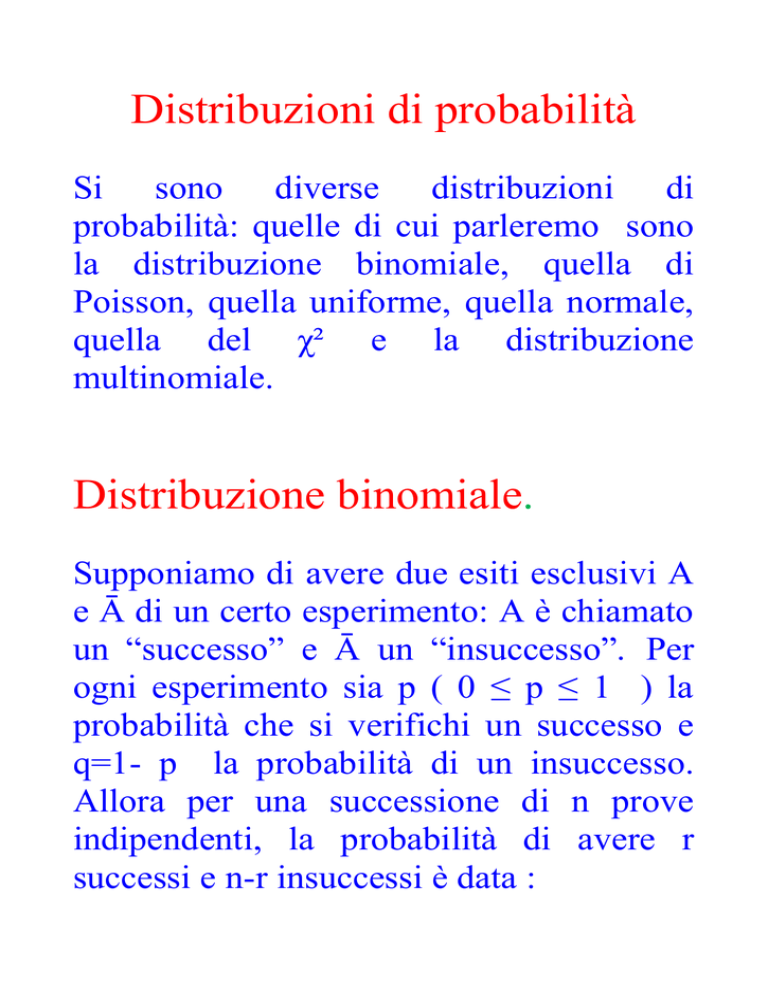

Distribuzioni di probabilità

Si sono diverse distribuzioni di

probabilità: quelle di cui parleremo sono

la distribuzione binomiale, quella di

Poisson, quella uniforme, quella normale,

quella del χ² e la distribuzione

multinomiale.

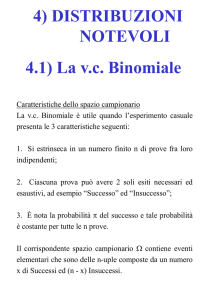

Distribuzione binomiale.

Supponiamo di avere due esiti esclusivi A

e Ā di un certo esperimento: A è chiamato

un “successo” e Ā un “insuccesso”. Per

ogni esperimento sia p ( 0 ≤ p ≤ 1 ) la

probabilità che si verifichi un successo e

q=1- p la probabilità di un insuccesso.

Allora per una successione di n prove

indipendenti, la probabilità di avere r

successi e n-r insuccessi è data :

(

)

( ) pr ( 1-p)n-r

dove il coefficiente binomiale

( )= ( )

tiene conto che non è importante l’ordine

con cui si verificano gli r successi. Questa

distribuzione si dice anche di Bernoulli,

dal nome dello scienziato svizzero Jakob

Bernoulli.

Si può dimostrare ( vedi “Severi”) che μ=

E(r) = np e che la varianza V(r) =np(1-p).

Il grafico che segue mostra l’andamento di

una binomiale per diversi valori di p e di

n: all’aumentare di n tende ad una

distribuzione normale.

Distribuzione di Poisson

In una distribuzione binomiale può

capitare che p sia molto piccola ed n molto

grande, ma che il valore atteso μ = np

possa essere finito e diverso da zero.

Nel caso limite che p tenda a zero ed n

tenda all’infinito con μ finito e diverso da

zero, si dimostra che la binomiale può

essere scritta come

(

)

con r=1,2,….

che costituisce la distribuzione scoperta da

Siméon_Denis Poisson.

Un tipico caso in cui si applica questa

distribuzione è quella degli eventi rari.

Si può dimostrare che E(r) = μ e che la

varianza vale ancora μ.

La prossima figura illustra la distribuzione

di Poisson per diversi valori di p: anche

essa tende ad una distribuzione normale al

crescere di μ.

Distribuzione uniforme

Immaginiamo di avere una variabile

continua x che abbia p.d.f. costante

sull’intero intervallo in cui essa sia

definita. Allora

( )=

con a ≤x ≤ b fornisce una p.d.f. costante.

Si può vedere che

( )

(

)

( )

(

)

( )

dove F(x) è la funzione di distribuzione

cumulativa.

La prossima figura illustra f(x) e F(x).

Distribuzione normale ( o di

Gauss )

Questa distribuzione deriva da una

binomiale quando n tende all’infinito. Fu

trovata inizialmente da Abraham de

Moivre e da Pierre-Simon de Laplace;

deve il suo nome anche a Gauss in quanto

egli l’ha applicata agli errori di misura. La

p.d.f. normale ad una dimensione ha la

forma generale :

(

)

(

)

√

con - ∞ ≤ x ≤ ∞

Si può dimostrare che E(x) = μ e che V(x)

= σ2.

Quindi i parametri μ e σ2 che compaiono

nella distribuzione hanno il solito

significato di valore medio e varianza

della distribuzione.

La distribuzione normale è simmetrica

intorno a μ e quindi la mediana coincide

con μ.

Inoltre ha la sua moda ( ossia il suo

massimo) per x = μ.

Si può vedere inoltre che ad una distanza ±

σ da μ si hanno due punti di flesso.

La figura successiva illustra differenti

distribuzioni normali aventi la stessa

media.

La distribuzione normale N(μ, σ2 ) può

essere trasformata in una forma più

conveniente mediante l’introduzione della

variabile ridotta z = (x-μ)/σ.

Questo dà origine alla p.d.f. normale

N(0,1) = 1/√2π exp( -1/2 z2 )

con z compreso fra -∞ e +∞.

Questa forma di p.d.f. è più semplice da

tabellare perché dipende dalla sola

variabile z.

La distribuzione cumulativa G(z) gode

della proprietà che G(-z) = 1 – G(z). La

successiva figura illustra N(0,1) e la sua

funzione di distribuzione cumulativa.

La funzione di distribuzione cumulativa

standard G(z) è usata per determinare il

contenuto di probabilità di un dato

intervallo per un valore distribuito

normalmente e viceversa per determinare

un intervallo corrispondente ad una certa

probabilità.

Sia x una variabile casuale distribuita

secondo N(μ, σ2 ). Vogliamo determinare

la probabilità che x cada entro un certo

intervallo [a,b].

Ora P( a ≤ x ≤ b) = P( x ≤ b) – P( x ≤ a),

che è equivalente a scrivere che

P( a ≤ x ≤ b) = G[(b-μ)/σ] - G[(a-μ)/σ].

Usando le opportune tavole si trova che :

P( = 2 G(1) -1 = 0,6827

P( = 2 G(2) -1 = 0,9545

)

)

P( = 2 G(3) -1 = 0,9973

)

La prossima figura mostra N(μ, σ2 ) con le

varie zone che corrispondono a scarti da μ

pari a 1 σ, 2 σ e 3 σ.

È interessante sapere che la media

aritmetica di un campione di dimensione n

, estratto da una popolazione normale, si

distribuisce normalmente con media μ e

varianza σ2/n .

È interessante sapere inoltre che (n-1) s2/

2

2

σ si distribuisce come un χ con n-1 gradi

di libertà, come vedremo in seguito.

Concludiamo con l’enunciare il

teorema del Limite Centrale

dovuto sempre a Laplace.

Se x1, x2, … x N sono un insieme di N

variabili casuali indipendenti, ognuno

aventi media della popolazione μi e

varianza finita , allora la variabile

∑

∑

√∑

ha, come distribuzione limite, una

distribuzione normale, centrata su zero e

varianza pari ad 1.

In particolare la media aritmetica di n

misure xi della stessa grandezza fisica x

nelle stesse condizioni tende ad una

distribuzione normale con media µ e

varianza σ² per n

anche se la

distribuzione di x non è normale: la cosa

importante è che la varianza sia finita.

Il motivo per cui in laboratorio è

consigliabile effettuare misure ripetute è

proprio legato al Teorema del Limite

Centrale.

La distribuzione del χ

2

Consideriamo una grandezza x, che si

distribuisca secondo una distribuzione

normale, centrata

intorno a X con

varianza σ². Introduciamo il concetto di

variabile standard z definendola come z =

(x-X)/σ.

Si può dimostrare che z si distribuisce

secondo una distribuzione normale,

centrata sullo zero e con varianza pari ad

1.

Consideriamo ora ν variabili standard zi.

2

Possiamo definire allora la grandezza χ

come la somma dei quadrati di ν variabili

standard:

Il parametro ν viene chiamato numero di

gradi di libertà.

Si può ricavare la funzione di

distribuzione fν(χ2), tale che fν(χ2) d χ2 dia

la probabilità di trovare un valore del chi

quadro compreso fra χ2 e χ2+d χ2:

dove C è un fattore di normalizzazione.

Si può vedere che

C= (2½ν Γ(½ν))-1

dove Γ è la funzione Gamma di Eulero,

che le seguenti proprietà :

Γ(x+1) = x Γ(x)

Γ(½) = √π

Γ(1) = 1

A questo punto è possibile ricavare la

probabilità P(χ2 > χ20 ), ossia la probabilità

di trovare un valore di χ2 maggiore di uno

fissato χ20 .

e quindi ottenere il valore atteso e la

varianza del chi quadro :

In alcune situazioni è più opportuno

usare il cosiddetto chi quadro ridotto,

definito come rapporto fra il chi quadro e

il numero di gradi di libertà. Si ha in tal

caso

La tabella A.16 del Severi mostra i valori

del

χ2 ridotto ordinati per righe,

individuate dai valori di ν e per colonne

individuate dai valori di P(χ2/

χ20/ν ).

La tabella D del Taylor illustra i valori di

P(χ2/

χ20/ν ) in funzione di ν e di

χ20/ν.

Nella figura seguente sono riportati gli

andamenti della funzione di distribuzione

fν(χ2)=f(u,ν) al variare di χ2 per diversi

valori di ν.

In particolare si nota che f1 (χ2) , essendo

proporzionale a exp(-χ2/2)/√χ2, diverge per

χ2 tendente a zero.

Inoltre si nota che f2(χ2), essendo

proporzionale a

exp(- χ2/2 ) , ha

l'andamento

di

un

esponenziale

decrescente.

Per ν maggiore di due, la funzione vale

zero per χ2 uguale a zero, manifesta un

massimo per un valore del χ2 pari a ν-2 e

poi decresce con una coda, più o meno

2

lunga, verso lo zero al divergere di χ .

Come si vede, la funzione non è

simmetrica, ma tende, al crescere di ν ad

una distribuzione normale di pari valore

atteso e varianza. Nella pratica questo

limite si ritiene raggiunto per ν pari a circa

30.

È opportuno rimarcare infine che , quando

viene usato ai fini di test di ipotesi, il χ2

sperimentale χ20 deve essere tale che

P(χ2 > χ20 ) ≥ 0.05 ( ossia l'area sottesa

dalla funzione di distribuzione fra χ20 e ∞

deve essere maggiore od uguale al 5 per

cento ), affinché l'ipotesi non sia rigettata.

Talora questo taglio del 5 per cento viene

portato al 10 per cento. Il motivo di questo

taglio è dovuto al desiderio di ridurre la

possibilità

di accettare per buona

un'ipotesi falsa a costo di perdere

un'ipotesi buona ma avente bassa

probabilità di verificarsi.

Ancora la binomiale e il

Teorema di Bernoulli

Talora ( come nel caso in cui si vuole

valutare l’efficienza di un rivelatore ) si è

interessati alla quantità φ=r/n, il numero

relativo di successi in n prove, ossia alla

frequenza relativa dei successi. In tal caso

( ) = E(r) = p

V( ) = ( )² V(r) =

(

)

Usando la diseguaglianza di BienayméČebičev si può dimostrare che

P[ (│ -p│≥ ε ] ≤

(

)

che costituisce il Teorema di Bernoulli,

secondo il quale la probabilità che la

frequenza relativa e p differiscano di una

quantità maggiore od uguale a ε tende a

zero al tendere di n a ∞.

Questo teorema è importante perché

afferma che asintoticamente l’approccio

classico e l’approccio frequentistico sono

consistenti fra di loro.

Una

generalizzazione

della

binomiale : la multinomiale.

Immaginiamo di avere n eventi

indipendenti classificati in k categorie. Sia

pi la probabilità di avere un successo nella

i-ma categoria: la somma di tutte le pi

vale chiaramente 1. La probabilità di avere

r1, r2, …rk successi nelle categorie 1,2,..k è

data da

(

dove

)

sta per l’insieme di r1…, rk e

per

l’insieme di p1,…pk. I valori di ri non sono

indipendenti poiché la loro somma deve

valere n.

Si può dimostrare che, per ogni categoria,

:

E(ri) = npi

V(ri) = npi (1-pi )

Cov(ri, rj) = -npi pj

Un

esempio

di

multinomiale

è

l’istogramma, in cui suddividiamo n

eventi in k canali, contenenti ognuno ni

eventi.

Supponiamo adesso di sapere, a meno di

eventuali parametri da determinare, la

probabilità pi di avere un evento nell’i-mo

canale. Quindi il valore atteso fi della

frequenza degli eventi nell’i-mo canale

sarà npi e la condizione di normalizzazione

∑

= 1 implica che ∑

=∑

=

n.

Se vogliamo verificare che il modello

teorico, che fornisce le pi , sia corretto

potremmo costruire una grandezza tipo χ²,

andando a considerare la somma degli

scarti al quadrato di ogni ni da npi, diviso

per la varianza

npi (1-pi )

tenendo in conto

normalizzazione.

∑

la

condizione

(

)

(

)

di

Questo problema può essere affrontato in

maniera più semplice. Infatti si può

dimostrare che si tiene conto della

normalizzazione se si scrive un χ² che ha

al denominatore non la varianza di una

binomiale ma la varianza di una

poissoniana.

Si tratta della famosa formula

∑

(

)

già usata per verificare la bontà del piano

di riferimento usato con lo sferometro.

Principio di massima

verosimiglianza per grandezze

gaussiane : giustificazione della

media aritmetica come migliore

stima del valore atteso della

popolazione ( vedi Taylor, §5.6 )

e media pesata ( vedi Taylor,

§7.2)

Osservazione : una volta ottenuto il valore

della media pesata X, bisogna controllare

l’ipotesi di partenza, ossia quella che

stiamo pesando n misure xi della stessa

grandezza fisica ottenute in esperimenti

differenti ( e quindi con diverse σ ).

Se l’ipotesi è corretta allora la quantità

∑

(

)

²

si distribuisce come un χ² non n-1 gradi di

libertà.

Un valore troppo elevato del χ² segnala

che almeno uno dei valori delle xi è

incompatibile con tutti gli altri.