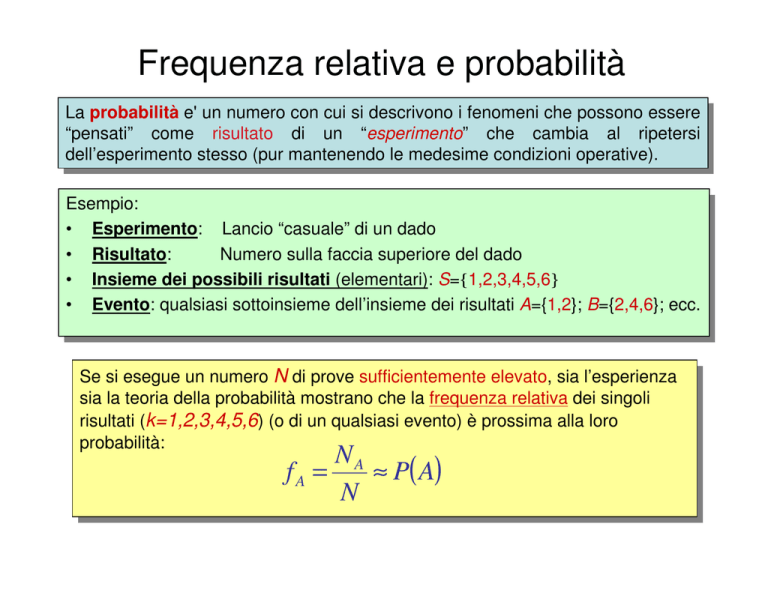

Frequenza relativa e probabilità

La

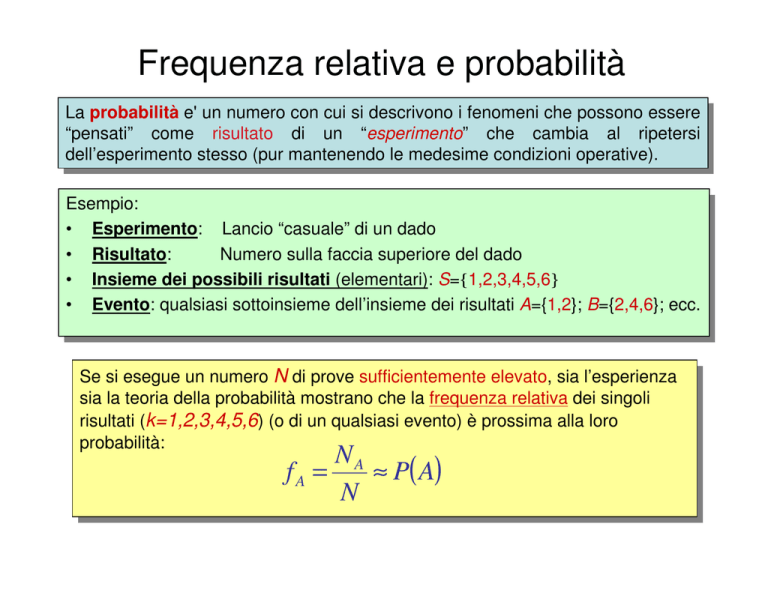

Laprobabilità

probabilitàe'e'un

unnumero

numerocon

concui

cuisisidescrivono

descrivonoi ifenomeni

fenomeniche

chepossono

possonoessere

essere

“pensati”

come

risultato

di

un

“esperimento”

che

cambia

al

ripetersi

“pensati” come risultato di un “esperimento” che cambia al ripetersi

dell’esperimento

dell’esperimentostesso

stesso(pur

(purmantenendo

mantenendolelemedesime

medesimecondizioni

condizionioperative).

operative).

Esempio:

Esempio:

•• Esperimento:

Esperimento: Lancio

Lancio“casuale”

“casuale”didiun

undado

dado

•• Risultato:

Numero

Risultato:

Numerosulla

sullafaccia

facciasuperiore

superioredel

deldado

dado

•• Insieme

Insiemedei

deipossibili

possibilirisultati

risultati(elementari):

(elementari):S={1,2,3,4,5,6}

S={1,2,3,4,5,6}

•• Evento:

Evento:qualsiasi

qualsiasisottoinsieme

sottoinsiemedell’insieme

dell’insiemedei

deirisultati

risultatiA={1,2};

A={1,2};B={2,4,6};

B={2,4,6};ecc.

ecc.

Se

Sesisiesegue

esegueun

unnumero

numeroNNdidiprove

provesufficientemente

sufficientementeelevato,

elevato,sia

sial’esperienza

l’esperienza

sia

sialalateoria

teoriadella

dellaprobabilità

probabilitàmostrano

mostranoche

chelalafrequenza

frequenzarelativa

relativadei

deisingoli

singoli

risultati

risultati(k=1,2,3,4,5,6

(k=1,2,3,4,5,6))(o

(odidiun

unqualsiasi

qualsiasievento)

evento)èèprossima

prossimaalla

allaloro

loro

probabilità:

probabilità:

NA

fA =

≈ P( A)

N

Frequenza relativa e probabilità

NA

fA =

≈ P( A)

N

0 ≤ fA ≤1

0 ≤ P( A) ≤ 1

fS = 1

P(S ) = 1

f AUB = f A + f B − f AIB

P( A U B) = P( A) + P(B) − P( A I B)

f A+ B = f A + f B − f AB

P( A + B) = P( A) + P(B) − P( AB)

Variabile casuale

x

numero reale associato ad un evento

Funzione di distribuzione

Densità di probabilità

Fx (a) = P( x ≤ a)

P(a ≤ x ≤ a + da) d

px (a) =

= Fx (a)

da

da

Variabile casuale continua

••Le

continue

Levariabili

variabilicasuali

casualisono

sono

continuequando

quandopossono

possonoassumere

assumereun

uninsieme

insieme

x

continuo

continuodidivalori

valori(e

(equindi

quindii ipossibili

possibilirisultati

risultatisono

sonoininnumero

numeroinfinito).

infinito).

••Esempio:

Esempio:v.c.

v.c.Uniforme

Uniforme0-1.

0-1.Assume

Assumecon

conlalastessa

stessaprobabilità

probabilitàun

unqualsi

qualsivalore

valorereale

reale

valore

compreso

tra

0

e

1

valore compreso tra 0 e 1

Funzione di distribuzione

Fx (a) = P( x ≤ a) = a

Densità di probabilità

d

px (a) = Fx (a) = 1

da

Variabile casuale discreta

••Le

discrete

Levariabili

variabilicasuali

casualisono

sono

discretequando

quandopossono

possonoassumere

assumereun

uninsieme

insieme

x

discreto

discretodidivalori

valori(e

(equindi

quindii ipossibili

possibilirisultati

risultatisono

sonoininnumero

numerofinito).

finito).

••Esempio:

Esempio:v.c.

v.c.Legata

Legataalalnumero

numerosulla

sullafaccia

facciasuperiore

superioredel

deldado.

dado.

Funzione di distribuzione

1

1

1

Fx (a) = P( x ≤ a) = u(a −1) + u(a − 2) + ... + u(a − 6)

6

6

6

Densità di probabilità

d

1

1

1

px (a) = Fx (a) = δ (a −1) + δ (a − 6) + ... + δ (a − 6)

da

6

6

6

Uso della densità di probabilità

Dalla

Dalladensità

densitàdidiprobabilità

probabilitàp(a)

p(a)èèfacile

facilecalcolare

calcolarelalaprobabilità

probabilitàche

chelalavariabile

variabile

casuale

casualexxassuma

assumaun

unvalore

valorecompreso

compresoininun

unintervallo

intervalloaa11, ,aa22. .Basta

Bastasommare!

sommare!sisi

ottiene

ottienel’area

l’areasottesa

sottesadalla

dalladdp

ddpnell’intervallo

nell’intervallod’interesse.

d’interesse.

a2

P(a1 < x ≤ a2 ) = ∫ px (a)da

0.5

0.4

a1

Si noti che

0.3

∞

P(− ∞ < x < ∞) = ∫ px (a)da = 1

0.2

−∞

0.1

Dunque

Dunquel’area

l’areasottesa

sottesadalla

dalladdp

ddpdidiuna

una

qualunque

qualunquevariabile

variabilecasuale

casualeèèunitaria.

unitaria.

0

-5

-4

-3

-2

-1

a1

0

1

2

a2

3

4

5

Variabili casuali continue

•Il

•Ilconcetto

concettodidifrequenza

frequenzarelativa

relativaviene

viene

recuperato

recuperatoapprossimando

approssimandol’insieme

l’insieme

continuo

continuodidivalori

valoricon

conun

unnumero

numerofinito

finitodidi

intervallini

intervallinididimisura

misura(discretizzazione).

(discretizzazione).

2

1.5

•Ad

•Adesempio,

esempio,se

selalav.c.

v.c.può

puòvariare

variarecon

con

continuità

continuitàtra

tra00ee11gradi,

gradi,non

non

commettiamo

commettiamoun

ungrosso

grossoerrore

errore

approssimando

approssimandol’intervallo

l’intervallocontinuo

continuocon

con20

20

intervallini

intervallinicontigui

contiguilarghi

larghi0.05.

0.05.

1

0.5

0

-0.5

-1

0

200

400

600

800

1000

1200

1400

1600

1800

2000

•La

•Lavariabile

variabilecasuale

casualeèèdiventata

diventatadiscreta

discreta

(ci

(cisono

sono20

20possibili

possibilirisultati

risultati

dell’esperimento)

dell’esperimento)eepossiamo

possiamo

approssimare

approssimarelalaprobabilità

probabilitàcome

comelimite

limite

della

dellafrequenza

frequenzarelativa

relativaper

perNNelevato.

elevato.

Istogramma dei risultati di una V.C. uniforme

x=rand(1,1000);

hist(x,20)

70

60

50

40

30

20

10

0

0

0.1

0.2

0.3

0.4

0.5

0.6

0.7

0.8

0.9

1

All'aumentare del numero di prove, l'istogramma

tende alla frequenza relativa moltiplicata per il

numero di prove.

x=rand(1,1000000);

hist(x,20)

4

6

x 10

5

4

3

2

1

0

0

0.1

0.2

0.3

0.4

0.5

0.6

0.7

0.8

0.9

1

All'aumentare del numero di prove e del numero di

intervalli, l'istogramma diviso per il numero di prove

e per la dimensione degli intervalli tende alla

densita' di probabilita'

x=rand(1,1000000);

[X,N]=hist(x,20);

bar(N,X/1000000*20)

1.4

1.2

1

0.8

0.6

0.4

0.2

0

0

0.1

0.2

0.3

0.4

0.5

0.6

0.7

0.8

0.9

1

All'aumentare del numero di prove, l'istogramma

tende alla frequenza relativa moltiplicata per il

numero di prove.

x=randn(1,1000000);

hist(x,101)

4

4

V.C. gaussiana

x 10

3.5

3

2.5

2

1.5

1

0.5

0

-5

-4

-3

-2

-1

0

1

2

3

4

5

All'aumentare del numero di prove e del numero di

intervalli, l'istogramma diviso per il numero di prove

e per la dimensione degli intervalli tende alla

densita' di probabilita'

x=randn(1,1000000);

[X,N]=hist(x,101);

dx=(N(2)-N(1));

bar(N,X/1000000/dx)

V.C. gaussiana

0.4

0.35

0.3

0.25

0.2

0.15

0.1

0.05

0

-5

-4

-3

-2

-1

0

1

2

3

4

5

Valor medio di una variabile casuale

IlIlvalor

valormedio

mediom

mxx, ,detto

dettoanche

anchevalore

valoreatteso

attesoEE[x]

[x]oomomento

momento(statistico)

(statistico)didiordine

ordine

uno,

uno,didiuna

unavariabile

variabilecasuale

casualexx èèdefinito

definitocome

comesegue.

segue.

∞

m x = E [x ] =

∫ a ⋅ p (a) ⋅ da

x

−∞

Il valor medio di una variabile casuale è l’ascissa del “baricentro” dell’area

sottesa dalla densità di probabilità.

p(a)

p(a)

mX

a

mX

a

Il valor medio della somma di 2 variabili casuali è la somma dei valori medi

Valore quadratico medio e varianza

IlIlvalor

EE[x[x22],],detto

statistica o momento

∞anche

valorquadratico

quadraticomedio

medio

detto

anchepotenza

2

2potenza statistica o momento

2

σ X 2,

=2,E

− mvariabile

− mx ) ⋅ fxx

aè):⋅: da =

didi( X

una

(statistico)

X ) = ∫ (acasuale

X (è

(statistico)didiordine

ordine

una

variabile

casuale

[

[ ]

]

−∞

2

[ ]

E[x2 ] = ∫ a2 ⋅ px(a)⋅ da

−∞

[ ]

= E X 2 − 2 ⋅ mX ⋅ E[ X ] + m2X = E X ∞− 2 ⋅ mX ⋅ mX + m2X = E X 2 − m2X

2

La

Lavarianza

varianzaσσxx2 (detta

(dettaanche

anchemomento

momentocentrale

centraledidiordine

ordine2)

2)didiuna

unavariabile

variabile

casuale

casualexxèèililvalore

valorequadratico

quadraticomedio

mediodella

delladifferenza

differenzatra

traxxeeililsuo

suovalor

valormedio

mediommx

x

σ x2 = E[( x − mx )2 ] = E[x2 ] − mx 2

La

Laradice

radicequadrata

quadratadella

dellavarianza

varianzaèèdetta

dettadeviazione

deviazionestandard

standard(o

(oscarto

scartoquadratico

quadratico

medio)

medio)della

dellavariabile

variabilecasuale

casualexx

σ x = σ x2

x=rand(1,1000000);

z=rand(1,1000000);

b=1/2*x+1/2*z;

[B,N]=hist(a,21);

bar(N,B/1000000*21)

La d.d.p. della somma di 2 v.c. indipendenti è data

dalla convoluzione delle 2 d.d.p.

2

1.8

1.6

1.4

1.2

1

0.8

0.6

0.4

0.2

0

0

0.1

0.2

0.3

0.4

0.5

0.6

0.7

0.8

0.9

1

Introduzione ai processi casuali

Il rumore termico

Un classico e importante esempio utile a introdurre il concetto di processo

casuale e’ rappresentato dalla debole tensione elettrica v1(t) esistente ai

capi di un resistore. Questa tensione, variabile nel tempo, e’ causata dal

movimento caotico degli elettroni dovuto ad una temperatura del materiale

superiore allo zero assoluto.

Se si misura la tensione v1(t) si ottiene, secondo quanto detto in

precedenza, un segnale deterministico.

v1(t)

t

Introduzione ai processi casuali (2)

Se si prende un secondo resistore identico al primo e posto alla stessa

temperatura e si esegue la misura della tensione elettrica ai suoi capi, si otterra’ di

nuovo un segnale deterministico v2(t), con caratteristiche simili ma diverso dal

precedente dato che gli elettroni si muovono in modo diverso.

v2(t)

t

v1(t)

t

Introduzione ai processi casuali (3)

Se il nostro scopo e’ determinare l’effetto del rumore termico del resistore su

un’apparecchiatura elettronica, non e’ di nessuna utilità conoscere

deterministicamente il comportamento della tensione v1(t) ai capi del primo

resistore se poi il resistore effettivamente montato nell’apparecchiatura e’ il

secondo.

E’ utile invece riuscire a descrivere quelle che sono le caratteristiche della

tensione di rumore comuni a tutti i resistori dello stesso tipo e a quella

temperatura.

In questo modo, qualsiasi sia il resistore (di quel valore e a quella

temperatura) montata nell’apparecchiatura, potremo dire, per esempio, con

quale probabilità si presenteranno certi valori di tensione o quale sarà il

valore atteso della potenza di rumore.

Si abbandona dunque il concetto di certezza (proprio dei segnali

deterministici) per passare a quello dell’incertezza, descritto dalla teoria della

probabilità, proprio dei processi casuali.

Introduzione ai processi casuali (4)

Un processo casuale e’:

l’insieme di tutti i segnali deterministici (detti le realizzazioni del processo)

generati da altrettante sorgenti uguali, ma indipendenti tra loro.

ESEMPIO

Dimendsione Temporale

Dimensione d'INSIEME

Introduzione ai processi casuali (5)

Per ogni tempo t si ottiene una variabile casuale che viene descritta

attraverso la sua ddp

Dimendsione Temporale

Dimensione d'INSIEME

t

Introduzione ai processi casuali (6)

Per ogni coppia di tempi t1 e t2 si ottiengono 2 variabili casuali che

viengono descritte attraverso la loro ddp congiunta

Dimendsione Temporale

Dimensione d'INSIEME

t1

t2

ESEMPIO

x(t ) = cos(2π 0.1t + ϑ )

ϑ

V.C. Unif.

0 - 2π

Dimensione Temporale

1

0

-1

0

10

20

30

40

50

60

70

80

90

100

0

10

20

30

40

50

60

70

80

90

100

0

10

20

30

40

50

60

70

80

90

100

0

10

20

30

40

50

60

70

80

90

100

0

10

20

30

40

50

60

70

80

90

100

0

10

20

30

40

50

60

70

80

90

100

0

10

20

30

40

50

60

70

80

90

100

0

10

20

30

40

50

60

70

80

90

100

0

10

20

30

40

50

60

70

80

90

100

0

10

20

30

40

50

60

70

80

90

100

Dimensione d'INSIEME

1

0

-1

1

0

-1

1

0

-1

1

0

-1

1

0

-1

1

0

-1

1

0

-1

1

0

-1

1

0

-1

ESEMPIO

x(t ) = cos(2π 0.1t + ϑ )

ϑ

V.C. Unif.

0 - 2π

1

0.8

0.6

0.4

0.2

0

-0.2

-0.4

-0.6

-0.8

-1

0

10

20

30

40

50

60

70

80

90

100

ESEMPIO

x(t ) = cos(2π 0.1t + ϑ )

ϑ

V.C. Unif.

0 - 2π

4

7

x 10

6

N=1000000;

fi=rand(1,N)*2*pi;

x=cos(fi);

hist(x,100)

5

4

3

2

1

0

-1

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

1

ESEMPIO

x(t ) = cos(2π 0.1t + ϑ )

N=1000000;

fi=rand(1,N)*2*pi;

x=cos(fi);

[X,M]=hist(x,100);

bar(M,X/N*50)

p x (a ) =

ϑ

V.C. Unif.

0 - 2π

1

π 1− a2

3.5

3

2.5

2

1.5

1

0.5

0

-1

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

1

x=randn(1,200);

5

0

-5

0

5

20

40

60

80

100

120

140

160

180

200

20

40

60

80

100

120

140

160

180

200

20

40

60

80

100

120

140

160

180

200

0

-5

0

5

0

-5

0

Lo "scatterplot" di 2 v.c. è una visualizzazione

indicativa della densita' di probabilità congiunta

x=randn(1,10000);

y=randn(1,10000);

plot(x,y,'.')

axis('square')

4

3

V.C. gaussiane

indipendenti

2

1

y

0

-1

-2

-3

-4

-4

-3

-2

-1

x

0

1

2

3

4

L'istogramma dei risultati di 2 V.C. Gaussiane indipendenti con valor medio nullo e

e varianza unitaria

x=randn(1,10000);

y=randn(1,10000);

Fxy=hist3([x' y'],{-5:0.1:5 -5:0.1:5});

imagesc((-5:0.1:5),(-5:0.1:5),Fxy)

colorbar

-5

-4

20

-3

-2

15

-1

0

10

1

2

5

3

4

5

-5

0

5

0

All'aumentare del numero di prove, l'istogramma tende alla frequenza relativa

moltiplicata per il numero di prove.

x=randn(1,1e7);

y=randn(1,1e7);

Fxy=hist3([x' y'],{-5:0.1:5 -5:0.1:5});

imagesc((-5:0.1:5),(-5:0.1:5),Fxy)

colorbar

16000

-5

-4

14000

-3

12000

-2

10000

-1

0

8000

1

6000

2

4000

3

2000

4

5

-5

0

5

0

All'aumentare del numero di prove e del numero di intervalli, l'istogramma diviso per

il numero di prove e per la dimensione degli intervalli tende alla densita' di

probabilita' congiunta.

x=randn(1,1e7);

y=randn(1,1e7);

Fxy=hist3([x' y'],{-5:0.1:5 -5:0.1:5});

Pxy=Fxy/1e7/(0.1*0.1);

imagesc((-5:0.1:5),(-5:0.1:5),Pxy)

colorbar

-5

0.15

-4

-3

-2

0.1

-1

0

1

0.05

2

3

4

5

-5

0

5

0

La densità condizionata si ottiene leggendo la congiunta in un particolare valore di x

(es: x=0.5) e dividendo il risultato per la somma dei valori letti moltiplicata per la

dimensione dell'intervallo (0.1 nel nostro esempio):

x=0.5;

n=(x+5)/0.1;

Py=Pxy(:,n)/sum(Pxy(:,n)*0.1);

plot((-5:0.1:5),Py)

-5

0.15

-4

-3

-2

0.4

0.1

-1

0.35

0

1

0.3

0.05

2

3

0.25

4

5

-5

0.2

0.15

0.1

0.05

0

-5

0

5

0

5

0

X(n+1)=0.955*x(n)+0.3*randn(1,1);

5

0

-5

0

5

20

40

60

80

100

120

140

160

180

200

20

40

60

80

100

120

140

160

180

200

20

40

60

80

100

120

140

160

180

200

0

-5

0

5

0

-5

0

x=randn(1,10000);

y=randn(1,10000);

a=x;

b=0.955*x+0.3*y;

plot(a,b,'.')

axis('square')

3

2

V.C. gaussiane

correlate

1

b

0

-1

-2

-3

-3

-2

-1

0

a

1

2

3

L'istogramma dei risultati di 2 V.C. Gaussiane correlate

x=randn(1,10000);

y=randn(1,10000);

a=x;

b=0.955*x+0.3*y;

Fab=hist3([a' b'],{-5:0.1:5 -5:0.1:5});

imagesc((-5:0.1:5),(-5:0.1:5),Fab) -5

colorbar

60

-4

50

-3

-2

40

-1

0

30

1

20

2

3

10

4

5

-5

0

5

0

All'aumentare del numero di prove, l'istogramma tende alla frequenza relativa

moltiplicata per il numero di prove.

x=randn(1,1e7);

y=randn(1,1e7);

a=x;

b=0.955*x+0.3*y;

Fab=hist3([a' b'],{-5:0.1:5 -5:0.1:5});

imagesc((-5:0.1:5),(-5:0.1:5),Fab)

colorbar

x 10

-5

5

-4

4.5

-3

4

-2

3.5

-1

3

0

2.5

1

2

2

1.5

3

1

4

0.5

5

-5

0

5

0

4

All'aumentare del numero di prove e del numero di intervalli, l'istogramma diviso per

il numero di prove e per la dimensione degli intervalli tende alla densita' di

probabilita' congiunta.

x=randn(1,1e7);

y=randn(1,1e7);

a=x;

b=0.955*x+0.3*y;

Fab=hist3([a' b'],{-5:0.1:5 -5:0.1:5});

Pab=Fab/1e7/(0.1*0.1);

imagesc((-5:0.1:5),(-5:0.1:5),Pab)

colorbar

-5

0.5

-4

0.45

-3

0.4

-2

0.35

-1

0.3

0

0.25

1

0.2

2

0.15

3

0.1

4

0.05

5

-5

0

5

0

La densità condizionata si ottiene leggendo la congiunta in un particolare valore di x

(es: x=1) e dividendo il risultato per la somma dei valori letti moltiplicata per la

dimensione dell'intervallo (0.1 nel nostro esempio):

x=1;

n=(x+5)/0.1;

Pb=Pab(:,n)/sum(Pab(:,n)*0.1);

plot((-5:0.1:5),Pb)

-5

0.5

-4

0.45

-3

0.4

1.4

-2

0.35

-1

1.2

0.3

0

0.25

1

1

0.8

0.15

3

0.1

4

0.05

5

-5

0.6

0.4

0.2

0

-5

0

5

0.2

2

0

5

0

X(n+1)= - 0.955*x(n)+0.3*randn(1,1);

5

0

-5

0

2

20

40

60

80

100

120

140

160

180

200

20

40

60

80

100

120

140

160

180

200

20

40

60

80

100

120

140

160

180

200

0

-2

0

5

0

-5

0

x=randn(1,10000);

y=randn(1,10000);

a=x;

b=-0.955*x+0.3*y;

plot(a,b,'.')

axis('square')

4

3

V.C. gaussiane

correlate

2

1

b

0

-1

-2

-3

-4

-5

-4

-2

0

a

2

4

Predizione MMSE (Minimum Mean Square Error)

La predizione del futuro dato il presente che minimizza l'errore quadratico

medio è data dal valor medio del futuro condizionato al presente, cioè dal

valo medio della densità di probabilità condizionata:

( )

xˆ (t 2 ) = E x t 2

x(t1 ) = a

La predizione MMSE coincide con la più semplice predizione lineare nel

caso di processi casuali gaussiani :

xˆ (t 2 ) = ρ x (t 2 − t1 )x(t1 )

Tuttavia la predizione MMSE coincide con la predizione lineare in molti altri

processi casuali.

ESEMPIO x(t ) = cos(2π 0.01t + ϑ )

p x (a ) =

V.C. Unif.

0 - 2π

mx = 0

1

π 1− a

ϑ

1

σ =

2

2

x

2

3.5

3

2.5

2

1.5

1

0.5

0

-1

-0.8

-0.6

-0.4

-0.2

0

0.2

0.4

0.6

0.8

1

ESEMPIO x(t ) = cos(2π 0.01t + ϑ )

ϑ

V.C. Unif.

1

Rx (τ ) = cos(2π 0.01τ )

2

ρ x (τ ) =

ρ x (τ ) = 0

C x (τ )

σ

2

x

= cos(2π 0.01τ )

quando τ = 25 + k ⋅ 50

0 - 2π

x(t1 ) = cos(2π 0.01t1 + φ )

x(t ) = cos(2π 0.01t + ϑ )

φ = ±acos( x(t1 )) − 2π 0.01t1

1

x(t1 )

B

A

0.8

0.6

0.4

0.2

0

-0.2

-0.4

-0.6

-0.8

-1

0

20

t1

40

60

80

100

120

140

160

180

200

x A (t ) = cos[2π 0.01(t − t1 ) + acos( x(t1 ))]

xB (t ) = cos[2π 0.01(t − t1 ) − acos( x(t1 ))]

1

x(t1 )

B

A

0.8

0.6

0.4

0.2

0

-0.2

-0.4

-0.6

-0.8

-1

0

20

t1

40

60

80

100

120

140

160

180

200

x A (t 2 ) = cos[2π 0.01(t 2 − t1 ) + acos( x(t1 ))]

xB (t 2 ) = cos[2π 0.01(t 2 − t1 ) − acos(x(t1 ))]

1

x(t1 )

B

A

0.8

0.6

0.4

0.2

0

-0.2

-0.4

-0.6

-0.8

-1

0

20

t1

40

t2

60

80

100

120

140

160

180

200

x A (t 2 ) = cos[2π 0.01(t 2 − t1 ) + acos( x(t1 ))]

xB (t 2 ) = cos[2π 0.01(t 2 − t1 ) − acos(x(t1 ))]

p x (t 2 )

1

2

x A (t 2 )

x (t1 )

(a )

1

2

xB (t 2 )

a

[

[

]

]

x A (t 2 ) = cos π + acos( x(t1 ))

2

xB (t 2 ) = cos π − acos( x(t1 ))

2

1

t 2 − t1 =

= 25

4 ⋅ 0.01

1

x(t1 )

B

A

0.8

0.6

0.4

0.2

0

-0.2

-0.4

-0.6

-0.8

-1

0

20

t1

40

t2

60

80

100

120

140

160

180

200

[

[

]

]

x A (t 2 ) = cos π + acos( x(t1 ))

2

xB (t 2 ) = cos π − acos( x(t1 ))

2

p x (t 2 )

1

2

x A (t 2 )

x (t1 )

(a )

1

2

xB (t 2 )

a

x A (t 2 ) = cos[2π 0.01(t 2 − t1 ) + acos( x(t1 ))]

xB (t 2 ) = cos[2π 0.01(t 2 − t1 ) − acos(x(t1 ))]

x A (t 2 ) + xB (t 2 )

(

)

x

t

2

xˆ (t 2 ) = E

=

=

x(t1 )

2

p x (t 2 )

= cos[2π 0.01(t 2 − t1 )]cos[acos( x(t1 ))] =

= ρ x (t 2 − t1 ) ⋅ x(t1 )

1

2

x A (t 2 )

x (t1 )

(a )

1

2

xB (t 2 )

a