Gennaio-Marzo 2012 n. 1

Anno XXVI

Quaderni di Minimondo

Rivista culturale Braille

Periodico trimestrale

Fascicolo I

Direzione Redazione Amministrazione

Biblioteca Italiana per i Ciechi

20900 Monza - Casella postale 285

c.c.p. 853200 - tel. 039/28.32.71

e-mail: [email protected]

Dir. Resp. Pietro Piscitelli

Comitato di redazione:

Massimiliano Cattani,

Antonietta Fiore,

Luigia Ricciardone,

Pietro Piscitelli (Responsabile)

Copia in omaggio

Stampato in Braille a cura della

Biblioteca Italiana per i Ciechi

«Regina Margherita» onlus

via G. Ferrari, 5/a

20900 Monza

Sommario

Valerio Castronovo:

Le nuove sfide della democrazia

(«Prometeo» n. 111/10)

Gérald Bronner:

Internet e false credenze

(«Psicologia contemporanea» n. 230/12)

Giuseppe O. Longo:

Sarà l'uomo a provocare la sesta estinzione

di massa

(«Vita e Pensiero» n. 2/11)

Darin L. Wolfe:

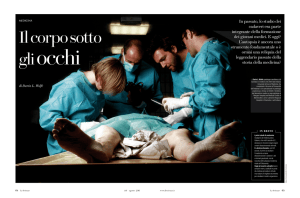

Il corpo sotto gli occhi

(«Le Scienze» n. 516/11)

Silvano Petrosino:

Da Lady Gaga a Steve Jobs. Idoli, idoletti e

oggetti affini

(«Vita e Pensiero» n. 6/11)

Marina D'Amato:

Telefantasie

(«Psicologia contemporanea» n. 225/11)

Alessandro Cerri:

I tristi diavoli del blues

(«Prometeo» n. 116/11)

Giuseppe Ivan Lantos:

A spasso con il commissario Maigret

(«Meridiani» n. 204/12)

Le nuove sfide della democrazia

- I problemi cruciali che l'Occidente si

trova oggi ad affrontare. Nel corso del primo decennio del nuovo

millennio ci si è resi conto di quanto fossero

infondate certe previsioni diffusesi,

all'indomani dell'Ottantanove, che davano per

scontato il tramonto, dopo quello avvenuto

nell'Est comunista, di altre dittature di

colore analogo o di matrici diverse. Così non

è stato. Anche se in alcuni punti le frontiere

della democrazia si sono ampliate, è rimasta

pur sempre consistente l'area dei regimi

totalitari, autoritari o militari, nonostante

alcuni di essi abbiano formalmente le parvenze

di governi democratici per quanto c'è scritto

nelle loro pandette costituzionali o per la

periodica chiamata alle urne dei loro

cittadini.

D'altra parte, se in alcuni casi come in

Iran (che è il più eclatante) la dittatura

degli ayatollah ha mostrato ancor più il suo

volto feroce e repressivo, non è che nel resto

dei paesi sotto il tallone di regimi

autocratici il pugno di ferro degli uomini,

delle caste o dei partiti unici al potere sia,

a seconda delle evenienze, meno pesante e

risoluto qualora ci si trovi alle prese con

qualche forma di opposizione che possa dar

ombra.

Sta di fatto che, al di là dell'area in cui

la democrazia aveva forti radici da molto

tempo o si è sviluppata nel corso del secondo

dopoguerra (che corrisponde sostanzialmente a

quella del mondo occidentale euroatlantico con

alcune propaggini in Asia, nell'America

centro-meridionale e in Australia), è ancora

vasto l'arcipelago dei paesi dove seguitano a

dominare tirannidi personali, monarchie

assolute, dittature o governi cosiddetti

«forti», di differente stampo politico e

ideologico. In pratica, a fare la conta dei

paesi soggetti in un modo o nell'altro a

regimi dove non esistono o vengono

sistematicamente conculcate libertà politiche

e individuali, diritti civili e garanzie

costituzionali, o ridotte al silenzio e

all'irrilevanza le minoranze, è dato

constatare come essi ammontino a quasi un

centinaio, sparsi dovunque, dall'Europa

all'Oceania. Oltretutto, si tratta di paesi

che per lo più spendono in media, rispetto

alla loro popolazione, più soldi in armamenti.

Se l'Africa sub-sahariana è quella che

annovera più dittature o regimi a un passo dal

divenirlo (per via di limitazioni al

multipartitismo, controlli del governo sul

sistema giudiziario, vincoli e discriminazioni

civili di vario genere a scapito dei diritti

umani), il Sud-est asiatico e l'area del

Pacifico non sono pressoché da meno, e così

pure quelle del Medio Oriente e del Nord

Africa. Ma pure in Europa e nelle contrade

contigue dell'Asia settentrionale sono almeno

una decina i paesi, appartenenti in passato

all'impero sovietico, dove esistono regimi

semidittatoriali o il cui assetto potrebbe

assumere connotazioni del genere. E se le

Americhe a sud del Messico sono le aree del

pianeta dove negli ultimi anni sono scomparsi

di più regimi autoritari o di marca militare,

Cuba seguita ad essere, a oltre mezzo secolo

di distanza dalla rivoluzione castrista (che

spodestò la dittatura di Fulgencio Batista),

un paese in cui Stato e partito coincidono, la

dissidenza è duramente contrastata, e il

passaggio di consegne nel 2008 dal «lìder

màximo» Fidel Castro al fratello Raúl non si è

tradotto per il momento in alcun concreto

mutamento di scenario. Nel frattempo s'è

inasprito il regime personale nazionalpopulista di Chàvez in Venezuela; e, se si è

assistito nel 2009 a un colpo di stato di

destra in Honduras, si è registrato un ritorno

di fiamma in Nicaragua del movimento

sandinista-marxista di Daniel Ortega e il

consolidamento al potere in Bolivia del

cosiddetto «Lenin indio», Evo Morales.

Che i paesi caduti sotto il tallone di

dittature o soggetti a regimi autoritari

possano affrancarsi da questo stato di cose,

appare oggi un'impresa più difficile di quanto

non si pensasse sino a qualche tempo addietro.

L'assunto sostenuto dai neoconservatori

americani, per cui la democrazia avrebbe

potuto o dovuto essere esportata anche con

l'uso della forza, è risultato un paradigma

dottrinario altrettanto incongruo che

disastroso alla luce di quanto è accaduto con

l'avventura anglo-americana in Iraq. Ma non ha

mostrato di reggere alla prova dei fatti

neppure la tesi secondo cui lo sviluppo

economico avrebbe contribuito, come una sorta

di campo magnetico, a una progressiva

transizione verso la democrazia. Se così

fosse, la Cina, che ha conosciuto negli ultimi

anni una crescita poderosa, non sarebbe

rimasta un «pianeta rosso». D'altro canto,

essa non è l'unico paese al mondo in cui il

passaggio dall'arretratezza economica

all'industrializzazione e alla diffusione dei

consumi, non ha dato luogo a sostanziali

cambiamenti nell'assetto politico in senso

democratico.

Non per questo, beninteso, si deve

considerare come permanente e inalterabile la

situazione dei paesi soggetti a un regime

autoritario. Si tratta di tener conto, assai

più di quanto in genere non si pensi,

dell'importanza che possono avere altri

elementi di carattere propulsivo, come quelli

di ordine culturale. Che, del resto, hanno

esercitato un ruolo preminente nell'evoluzione

politica e sociale dell'Occidente, come

attestano le sue vicende storiche. Grazie allo

sviluppo delle conoscenze e alla diffusione

del sapere, i paesi europei e l'America non

solo hanno conseguito il successo economico,

ma posto anche le fondamenta di ordinamenti

costituzionali segnati dall'affermazione delle

libertà e dei diritti politici e dal

consolidamento in progresso di tempo di

sistemi liberal-democratici con robuste

tendenze riformiste sul versante economico e

sociale.

Ma se per l'avvento di ordinamenti

democratici là dove oggi non esistono ancora o

appaiono troppo fragili e instabili per

consolidarsi, è essenziale che maturino

dall'interno nuovi fattori e stimoli di

carattere culturale, non per questo le

democrazie dell'Occidente sono esentate da

qualsiasi genere d'iniziativa. Esse devono

seguitare a denunciare recisamente qualsiasi

violazione dei diritti umani; impegnarsi per

la riduzione degli armamenti dandone per prime

l'esempio, assecondare la massima circolazione

di opinioni e informazioni, sollecitando

perciò il libero accesso ai mass media, e

solidarizzare con i movimenti d'opposizione ai

governi autoritari. D'altra parte, a giudicare

dalle vaste manifestazioni di piazza avvenute

in Iran contro il regime, non è detto che le

generazioni più giovani siano disposte, nei

paesi soggetti a regimi autocratici, ad

accettarli supinamente o a subirli sia pur

«obtorto collo».

Quanto è avvenuto dagli anni Novanta del

secolo scorso in poi ha segnato il tramonto di

quello che era stato definito, con riferimento

alle traiettorie dell'Occidente nel secondo

dopoguerra, come un «secolo

socialdemocratico». Non già perché avessero

assunto in questo periodo un ruolo da

protagonisti i partiti di marca socialista (la

cui presenza, del resto, non si estendeva agli

Stati Uniti e a vari altri paesi

extraeuropei). Ma perché il tratto distintivo

del processo di sviluppo manifestatosi in

Occidente consisteva, soprattutto, in una

serie di riforme che avevano aggiunto ai

diritti e alle libertà politiche tradizionali

i principi dell'uguaglianza sociale e

dell'equità distributiva. Tanto da dar luogo a

una sorta di «rivoluzione silenziosa»,

contrassegnata dagli sviluppi in senso

progressista della democrazia liberale,

dall'estensione dell'interventismo pubblico e

dalla diffusione del benessere economico, da

un miglioramento generalizzato del tenore di

vita delle masse popolari.

Ci si chiede oggi che il capitalismo

globale, la rivoluzione informatica e il

ridimensionamento dei poteri degli Stati

nazionali hanno modificato lo scenario in

termini sempre più tangibili, se possa

ricrearsi nell'ambito delle società

democratiche dell'Occidente quella sorta di

«circolo virtuoso» che in passato era

scaturito dall'intreccio fra democrazia

politica e ampliamento dei diritti civili, fra

crescita delle risorse e un più alto grado di

equità e coesione sociale.

Negli ultimi tempi si è assistito infatti a

una sempre più intensa finanziarizzazione

dell'economia, a una maggiore flessibilità del

mercato del lavoro, e quindi al declino di un

regime di piena occupazione e di rapporti di

lavoro a tempo indeterminato, nonché a un

restringimento delle prerogative e della sfera

d'intervento dei singoli Stati nazionali. Di

conseguenza, mentre l'industria non ha più

quel ruolo di assoluta centralità nel sistema

economico che rivestiva in passato, e così

pure la classe operaia, s'è indebolito il

potere contrattuale delle organizzazioni

sindacali; si sono dilatate le dimensioni e le

propaggini del settore terziario, è aumentata

sempre più la schiera dei lavoratori autonomi,

e sono comparse nuove sacche di povertà o di

precarietà e di emarginazione.

In questo nuovo contesto è evidente come sia

venuto riaffacciandosi il problema, tanto

dibattuto da sempre, se sia possibile

un'effettiva coesistenza fra capitalismo e

democrazia, fra le varianti e le dinamiche

dell'uno e le stimmate intrinseche e le

proiezioni dell'altra.

Sappiamo che il tasso d'innovazione è la

ragion d'essere e la forza propulsiva del

capitalismo, ma anche che la disoccupazione è

il maggior pericolo per la stabilità del

sistema. E sappiamo che la democrazia non può

considerarsi tale da corrispondere ai suoi

principi effettivi senza un'economia di

mercato competitiva ma orientata al

conseguimento di un maggior grado di benessere

collettivo, e perciò a un'equa ripartizione

della ricchezza prodotta e a fini di utilità

collettiva.

Negli ultimi tempi la crisi economica

provocata da un'overdose di finanza senza

adeguate regole ha riportato in auge

l'interventismo pubblico per salvare il

salvabile, per sottrarre una parte consistente

del sistema bancario dal pericolo di un

disastro, per cercare di sanare altri

sconquassi e riavviare il motore

dell'economia. Ma questi e altri provvedimenti

avrebbero effetti contingenti qualora non

venissero introdotte nell'ambito del mondo

finanziario severe regole etiche e norme

concrete in modo da ricondurlo a funzioni

complementari allo sviluppo degli investimenti

produttivi e, quindi, da impedire che certi

potentati si avventurino nuovamente in

operazioni puramente speculative e predatorie,

sganciate dall'economia reale. Inoltre, a poco

servirebbe l'esistenza di tante organizzazioni

internazionali attive da tempo se esse non

giungessero a coordinare le loro politiche per

garantire uno sviluppo omogeneo ed

equilibrato, senza cortocircuiti, senza derive

finanziarie e rigurgiti protezionistici, e

s'impegnassero anche in modo da assicurare il

progresso civile e la salvaguardia

dell'ambiente.

Non si tratta, con questo, di reinventare il

capitalismo, come da varie parti si tende a

dire, bensì di riportarlo su linee direttrici

che siano coerenti con un processo di sviluppo

sostenibile, in grado di accrescere

opportunità di lavoro, livelli d'istruzione e

qualità della vita. D'altronde, la proprietà

privata e l'economia di mercato sono

altrettanti requisiti e ingredienti della

democrazia. Il problema sta, quindi, in

politiche riformiste che valgano a ridurre le

diseguaglianze sociali e ad assicurare a tutti

i cittadini uguali capacità di influenza nella

gestione della cosa pubblica.

Se la crisi economica ha rivelato in pieno a

qual punto fosse giunta la forza e l'influenza

di alcuni dei principali gruppi e lobby della

finanza, nella distorsione non solo del

mercato ma anche nel condizionamento di vari

settori dell'amministrazione pubblica, non è

che unicamente loro siano arrivati ad avere un

ruolo così incisivo e rimarchevole.

Altre oligarchie, a livello nazionale e

internazionale, dalle grandi corporation, ai

titolari delle principali catene di massmedia, ai più autorevoli consessi del mondo

professionale continuano, sia pur in diversa

misura, a incidere nell'ambito delle

democrazie, sugli equilibri politici e

sociali. Perciò, non da oggi, si sono

moltiplicate le voci di quanti ritengono che

in Occidente la democrazia sia andata

corrodendosi o che comunque sia malata. Anche

perché si è indebolita o non conta più come

una volta quella sorta di intercapedine fra le

istituzioni politiche e la società civile

rappresentata dai grandi partiti di massa, con

la loro capacità di mobilitazione popolare, di

attivazione del dibattito e del confronto

delle idee, di sostegno alle cause di

interesse collettivo, con la loro dialettica e

alternanza nell'esercizio delle responsabilità

di governo.

Ma se tutto questo è avvenuto, è perché vi

hanno contribuito soprattutto due fenomeni

pressoché concomitanti: da un lato, le «onde

lunghe» prodotte dal crollo del comunismo, dei

regimi del «socialismo reale», per cui i paesi

occidentali non si trovano più sulla

difensiva, e, dall'altro, il progressivo

sfrangiamento del ceto medio, di quello che

era divenuto man mano il fulcro delle società

industriali avanzate.

L'esistenza di formazioni politiche

organizzate sulla base sia di determinate

concezioni ideologiche e culturali sia di

strutture capillari e articolate a livello

territoriale, erano in Europa il portato e

l'espressione di una stagione, come quella

prolungatasi dal secondo dopoguerra sino

all'Ottantanove, segnata da forti linee di

contrapposizione o di demarcazione fra due

differenti schieramenti. Pertanto, quando esse

sono venute meno, quel che era rimasto in vita

dei precedenti partiti di massa e dei loro

apparati s'è ridotto di peso e di statura, si

è frantumato in vari spezzoni più minuscoli o

si è trasformato in nuove entità e compagini

politiche. Non è con questo, ovviamente, che

siano scomparse la destra e la sinistra, ma

esse hanno assunto nuove insegne e comunque

delle connotazioni tali da non riprodurre le

stesse sembianze e le medesime istanze e

affiliazioni d'un tempo.

D'altra parte, s'è sdrucito negli ultimi

anni quella sorta di tessuto connettivo della

democrazia liberale composto dal ceto medio,

che aveva finito col divenire in progresso di

tempo il principale serbatoio elettorale dei

partiti di centro e di centro-sinistra, in

Germania e in Francia come in Gran Bretagna e

in Spagna. Ancora all'inizio del nuovo secolo

si parlava del ceto medio come di una classe

sociale destinata tanto a ispessirsi che ad

allargarsi al punto da costituire una «società

dei due terzi» con all'infuori un'élite a

reddito particolarmente elevato e una frangia

di gente alle soglie della povertà. Da allora,

invece, il ceto medio s'è andato

disarticolando e frammentando, in quanto è

cresciuta al suo interno la forbice fra alcuni

strati più abbienti o titolari di determinate

occupazioni più stabili, e gran parte delle

altre sue componenti, in quanto in condizioni

più disagiate o addette ad attività non

garantite.

Ma questo fenomeno e la crescente influenza

dei gruppi più eminenti dell'establishment non

comportano inevitabilmente il declino della

democrazia liberale o una sorta di «postdemocrazia», come è stata definita da alcuni

analisti. Le società occidentali hanno pur

sempre in sé gli anticorpi per contrastare il

pericolo di derive e regressioni oligarchiche,

di un sopravvento di consorterie corporative e

di ristretti clan e gruppi di interesse.

Purché la classe politica non si limiti a

declinare i principi e i valori del sistema

democratico secondo vecchi rituali e schemi

autoreferenziali.

C'è chi sostiene che si sarebbe ormai chiuso

un ciclo, che in Occidente la democrazia si

sia atrofizzata. La tradizionale divisione dei

poteri non sarebbe più in grado di regolare il

funzionamento delle istituzioni, le

rappresentanze parlamentari non avrebbero più

effettivi poteri di scelta e decisione, la

latitanza dalle urne e il disincanto di una

parte dell'elettorato sarebbero destinate a

crescere, la videodipendenza avrebbe preso il

posto della partecipazione alla vita pubblica

nella massa dei cittadini. Non da ultimo, si

chiama in causa, a riprova dell'esistenza di

un ulteriore fattore deformante e corrosivo

della democrazia, il populismo, quale forma di

legittimazione popolare passiva e strumento di

manipolazione del consenso dall'alto.

Ma se le cose stessero effettivamente a

questo modo, non rimarrebbe altro che

rassegnarsi a un desolante quanto sterile

pessimismo.

Non è, con questo, che si debbano chiudere

gli occhi sui rischi che corre altrimenti la

democrazia nei paesi che se ne fregiano, quale

loro conquista storica, e se ne proclamano

alfieri per eccellenza. Tuttavia non si può

pensare che ormai ci sia ben poco da fare,

come se una parabola declinante della

democrazia fosse qualcosa di ineludibile.

Governi e parlamenti, forze politiche e

sociali hanno pur sempre la possibilità di

stabilire determinate regole e gli strumenti

per far valere le proprie decisioni. Certo,

quelle che la democrazia occidentale deve

affrontare sono sfide ardue e complesse. Si

tratta infatti di bloccare l'invadenza di

lobby smodate e prevaricatrici, e ridare

vigore e fiducia al ceto medio, essenziale per

la stabilità delle istituzioni pubbliche,

definire nuove scale di priorità e promuovere

culture della ricerca e dell'innovazione per

competere nel mercato globale, modificare i

congegni del Welfare per serbarlo in vita e

renderlo più efficiente (e quindi alzare l'età

pensionabile e non solo tutelare chi ha perso

il lavoro ma anche aiutare chi non riesce a

trovarlo), rilanciare una partecipazione

attiva dei cittadini alla vita pubblica

attraverso nuove forme di aggregazione e

mobilitazione.

Tra i pericoli che incombono sulle

democrazie si è indicato, in particolare, dal

campo della sinistra, quello di una deriva

populista, consistente nella propagazione di

virus xenofobi e localistici. Va detto

tuttavia che il populismo di per sé non ha una

precisa colorazione politica né un corollario

unilateralista. In diverse circostanze il

populismo è stato declinato dai progressisti

in funzione di un coinvolgimento dei ceti

sociali più deboli e in nome del loro diritto

di cittadinanza; e oggi è stato uno degli

ingredienti del successo di Barack Obama negli

Stati Uniti. A ogni modo, se in vari paesi

europei il populismo sta assumendo colorazioni

politiche di estrema destra e scioviniste, lo

si deve soprattutto al fatto che le élite

politiche non hanno saputo prendere le misure

adeguate per gestire i mutamenti radicali di

scenario e di prospettiva avvenuti negli

ultimi anni finendo così per scaricare sulla

gente comune i problemi causati dalla

globalizzazione economica, dalla perdita

d'identità nazionale e dalle immigrazioni di

massa dal Sud del mondo.

Se la competizione sempre più serrata

imposta dal capitalismo globale e il

ridimensionamento del Welfare, dovuto alla

crisi fiscale dello Stato, hanno diffuso una

vasta ondata di apprensione e di malessere,

l'irruzione nei paesi euro-occidentali di una

fiumana di gente proveniente da varie parti

dell'universo, rischia di divenire una mina

vagante ad alto potenziale. Affinché non

finisca prima o poi per deflagrare, non basta

infatti che le autorità governative e le

amministrazioni locali assicurino a quanti

hanno le carte in regola, per stabilirsi nel

paese in cui intendono risiedere e svolgere il

proprio lavoro, la possibilità di usufruire

delle stesse condizioni e opportunità che

valgono per gli autoctoni. Né basta che

vengano posti freni efficaci all'immigrazione

clandestina, a quella avulsa da accordi

bilaterali con i paesi di provenienza o che

non ha a che fare con la ricerca di un rifugio

per motivi di persecuzione politica, come

sancito dal diritto internazionale.

È necessario che gli immigrati riconoscano a

tutti gli effetti i principi fondamentali e le

norme dei paesi d'arrivo e quindi vi diano

concreto riscontro nei loro comportamenti.

Ciò non significa, naturalmente, alcuna

rinuncia alla propria credenza religiosa e

alla propria identità, e tantomeno ai propri

orientamenti politici e sociali. Ma comporta

l'allineamento, senza ambiguità e ipocrisie,

ai principi istituzionali e alle leggi dello

Stato alla pari di tutti gli altri cittadini.

Solo così è possibile conciliare le diversità

e porre le basi di una reale convivenza in

un'incipiente società multietnica quale sta

profilandosi anche in Europa. Del resto, non è

che negli Stati Uniti il «melting pot» sia

avvenuto in modo diverso. Ciò che ha

contribuito a unire gli americani è infatti

l'adesione ai principi sanciti dalla

Costituzione, per quanto riguarda sia i

diritti e i doveri dei singoli cittadini, sia

la laicità delle istituzioni, e quindi la

rigorosa separazione fra autorità civili e

quelle religiose, nonché il riconoscimento

della piena sovranità dello Stato.

Il problema di un'effettiva integrazione di

quanti si sono stanziati nei paesi

dell'Occidente europeo, e seguitano a

giungervi, si è andato imponendo soprattutto

per gli immigrati musulmani, rispetto a quelli

di altre fedi religiose come l'induismo e il

buddismo. Sia perché essi sono divenuti negli

ultimi decenni la componente di gran lunga

maggioritaria degli extracomunitari

trapiantatisi in Europa, tra quelli che vi

risiedevano da tempo e quelli che vi sono

sbarcati di recente, fra quelli concentrati

nelle aree metropolitane e quelli disseminati

nei piccoli centri: tant'è che, secondo stime

attendibili, la popolazione musulmana nella

Ue, più che raddoppiata nell'ultimo

trentennio, raddoppierebbe di nuovo entro il

2020 se continuasse di questo passo, per poi

costituire entro il 2050 un quinto della

popolazione complessiva. Sia perché i

musulmani tendono, più di altri gruppi di

immigrati, a trapiantare tali e quali certe

ataviche prescrizioni religiose, nonché i

costumi e gli abiti mentali prevalenti nei

loro paesi d'appartenenza. Ed è questo il

fatto che desta più motivi di preoccupazione

tra gli europei.

S'è così diffuso il timore che l'Europa

finisca col trasformarsi in una sorta di

«Eurabia» (stando al termine coniato nel 2003,

prim'ancora che dai «neocon», dalla stampa

americana «liberal»). Che è quanto prevede

pure Bernard Lewis, uno dei massimi esperti

del mondo arabo, secondo il quale il Vecchio

Continente potrebbe tramutarsi, se non in un

prossimo futuro, entro la fine del secolo, in

una specie di «Euroislam».

Ciò non significa, beninteso, che l'Europa

debba chiudersi come in una fortezza, protetta

da una muraglia insormontabile, contro le

ondate migratorie provenienti dalle regioni

dove è dominante la religione islamica.

Rimane il fatto che l'integrazione degli

immigrati di fede musulmana costituisce una

questione quanto mai complessa, ben più

difficile rispetto a quella posta

dall'insediamento di altri nuclei

extraeuropei. E che quindi vada affrontata in

termini realistici e appropriati, tenendo in

debito conto due dati di fatto: il primo dei

quali è che numerosi immigrati islamici sono

originari di paesi dove sono cresciuti avendo

per precipuo riferimento le norme più rigide

della Shari'a; il secondo è che, per alcuni

imam delle moschee europee, quel che vale,

rispetto alle «leggi fatte dagli uomini», e a

maggior ragione nei riguardi di quelle degli

Stati secolari ospitanti, è pur sempre e deve

continuare a essere la «legge creata da

Allah».

Ci si domanda perciò, con riferimento a

queste due circostanze, se e fino a qual punto

determinate norme religiose e consuetudini di

matrice islamica siano compatibili con le

leggi e le istituzioni del mondo occidentale.

Se infatti uno Stato democratico deve

consentire a ciascuno di esprimere liberamente

le proprie convinzioni, dall'altro deve far

valere pur sempre determinati principi

fondamentali di rilevanza pubblica a cui tutti

sono tenuti a uniformarsi.

Senonché, nel caso degli immigrati di fede

musulmana, ci sono di mezzo diaframmi di non

poco conto, tradizioni e convenzioni sociali

che confliggono con le leggi dei paesi

occidentali: come la concezione della famiglia

e dei rapporti matrimoniali (per via tanto

della legittimazione della poligamia che della

giurisdizione assoluta del marito

sull'educazione dei figli e la gestione dei

beni famigliari); la posizione di globale

inferiorità civile della donna (soggetta a un

codice che sancisce il principio del tutore,

sia padre o fratello, a cui chiedere il

permesso se vuole sposarsi, oltre al divieto

di convolare a nozze con un non musulmano); la

pratica della mutilazione genitale femminile

che, ancorché non sia più seguita da molti,

non viene considerata per sé deplorevole; le

modalità dell'istruzione pubblica che si

vorrebbero basate sulla separazione fra maschi

e femmine nelle aule scolastiche, quando non

su un diverso grado di apprendimento.

È vero che non tutti gli immigrati musulmani

la pensano a questo modo o seguono in pratica

i precetti coranici più ortodossi e

totalizzanti. Ed è un fatto che molti di loro,

soprattutto quelli residenti da tempo in

Europa, hanno assunto laicamente le regole del

vivere comune.

Ma negli ultimi tempi, con la crescita degli

immigrati dai paesi islamici, è andata

ispessendosi anche la schiera degli imam e

degli ulema portati a ribadire anche fuori del

loro contesto originario il primato vincolante

della loro parola quale fondamento e fattore

di legittimazione sia del sistema giuridico e

sociale che delle istituzioni pubbliche. E

nell'ambito delle comunità musulmane si è

registrata negli ultimi anni, a cominciare

dalle leve più giovani, una tendenza non più

ad acquisire i valori etico-politici e i

modelli di riferimento laici occidentali bensì

a contrastarli recisamente, sino ad

abbracciare gli orientamenti più radicali

dell'islamismo come un'affermazione orgogliosa

della propria identità di fronte a sé e agli

altri.

È pur vero che, a detta di alcuni

osservatori, il multiculturalismo non

determina di per sé inevitabilmente una

«tribalizzazione» della società, e quindi la

diffusione di forme di separatezza e

segregazione tali da escludere categoricamente

qualsiasi reale rapporto di ibridazione e

interazione con il mondo circostante. Ma la

proliferazione di tante monadi monolitiche e

incomunicanti è quanto in pratica avviene

nella realtà. E quali pericoli, e conseguenze

negative, ciò finisce per innescare, lo hanno

sottolineato Giovanni Sartori e altri

osservatori abituati a valutare le cose senza

paraocchi fuorvianti. Il rifiuto pervicace, da

parte dei gruppi islamici più radicali, dei

principi dello Stato laico e liberale finisce

infatti per determinare tensioni laceranti e

destabilizzanti dell'ordinamento statuale.

Ha osservato perciò la scrittrice algerina

Assia Djebar: «Oggi la vera sfida, la vera

possibilità di avere un Islam nella modernità

e nella democrazia, si gioca in Europa». A suo

avviso, i musulmani europei dovrebbero

«prendere in mano la situazione», assumersi un

compito importante su due fronti: «discutere

tra di loro [...] e farsi interlocutori dei

loro Paesi d'origine». Esiste, d'altra parte,

tra gli immigrati islamici, una forte corrente

riformista, una sorta di «maggioranza

silenziosa», in grado di farsi valere se saprà

conciliare la propria fede religiosa con la

propria autonomia e libertà individuale. Del

resto, il filosofo iraniano Ramin Jahanglegoo

osserva come la cosa più importante in una

religione non è tanto quello che si crede, ma

quello che si fa con ciò che si crede.

Incontrarsi e discutere, per capire e farsi

capire. A questo riguardo si attribuisce un

ruolo importante ai leader delle istituzioni

ecclesiali. In effetti, la loro voce e la loro

opera risultano essenziali per promuovere un

clima favorevole allo sviluppo fra le varie

comunità di rapporti improntati a uno spirito

di reciproco rispetto e comprensione. Al di là

del versante teologico e dottrinale, esistono

infatti determinati valori etici condivisi in

linea di principio dalle diverse fedi

religiose, come il ripudio dei pregiudizi

razziali, il rifiuto dell'utilitarismo e

dell'egoismo individualistico, la compassione

e la solidarietà operosa verso gli umili e i

più deboli.

Ma se è dato sperare che il dialogo

interreligioso possa rivestire un ruolo

importante, nell'instaurare un clima di

reciproca fiducia e armonia fra comunità di

fede diversa, è un fatto tuttavia che in

Occidente spetti soprattutto alle istituzioni

pubbliche assolvere due precipui compiti. Il

primo dei quali è di neutralizzare le pulsioni

viscerali, fondamentaliste e teocratiche, di

alcune nomenclature islamiche più radicali. Il

secondo è di promuovere un'efficace azione

culturale, attraverso adeguate politiche

educative e scolastiche, che valga ad

accreditare e diffondere negli immigrati

islamici i principi basati sul primato

dell'individuo, sulla libertà di coscienza e

d'espressione, nonché sulla tolleranza e sulla

separazione fra religione e politica.

Sta di fatto che le democrazie occidentali

si trovano oggi ad affrontare quest'altra

impresa decisiva per la loro identità

collettiva e il loro futuro. Poiché è

essenziale a tal fine che quanti vengono a far

parte della loro società rispettino e facciano

proprie quelle norme fondamentali del regime

democratico e dell'ordinamento civile e

giuridico che costituiscono altrettante

architravi di un sistema aperto e pluralista.

Che è anche, nello stesso tempo, la leva più

efficace per scongiurare, al proprio interno,

la diffusione e la sedimentazione sia di

astiosi pregiudizi xenofobi sia di un clima

diffuso di smarrimento.

Valerio Castronovo

(«Prometeo» n. 111/10)

Internet e false credenze

- Quando cerchiamo informazioni in Internet

cadiamo spesso nell'errore di selezionare solo

quelle che confermano le nostre credenze. Come

accade? Internet, come tutte le grandi innovazioni

tecnologiche, suscita timori e speranze. In un

attimo ci permette di sapere qual è la

popolazione dell'Armenia o che tempo fa in

Australia; allo stesso tempo, però, molti sono

preoccupati dal fatto che in rete corra ogni

genere di informazioni sbagliate che ci

allontanano da una rappresentazione

ragionevole della realtà.

Data la diffusione planetaria del web, dato

che secondo stime attendibili dall'inizio del

nuovo millennio è entrata in circolazione una

quantità di informazioni cinque volte maggiore

di quelle diffuse da quando Gutenberg ha

inventato la stampa e data infine la nostra

tendenza a utilizzare sempre di più questo

strumento per cercare informazioni, è

legittimo chiedersi quale influenza esso possa

avere sulla diffusione di idee dubbie,

specialmente nel contesto delle società

democratiche.

Internet rappresenta anzitutto una

formidabile rivoluzione del mercato cognitivo,

cioè di quello spazio virtuale dove si

incontrano idee, conoscenze e credenze che

possono essere in concorrenza fra loro (si

veda Bronner, 2003). Ci potremmo aspettare

quindi che la diffusione generalizzata e a

basso prezzo dell'informazione favorisca la

diffusione del sapere e l'educazione delle

masse. Questa speranza di democratizzazione

della conoscenza è indubbiamente fondata,

almeno in parte, ma tradisce anche una certa

ingenuità nella rappresentazione del rapporto

che la nostra psiche normalmente intrattiene

con la ricerca di informazioni.

L'errore di conferma in azione

Abbastanza spesso succede, infatti, che la

nostra mente, nella ricerca di informazioni,

vada cercando dati che confermino la

rappresentazione che si è già costruita. Sotto

questo profilo Internet rappresenta lo

strumento perfetto: con un dispendio minimo di

tempo e di energia, ci propone una massa

enorme di informazioni, qualunque sia la

nostra inclinazione personale. La conseguenza

meno visibile, e tuttavia più decisiva, di

questo fatto è di predisporre le condizioni

ottimali perché l'errore di conferma

(confirmation bias) possa esercitare appieno

la sua efficacia nel distoglierci dalla

verità. Di tutte le tentazioni inferenziali

che affliggono la logica ordinaria, l'errore

di conferma è senza dubbio quello più

determinante al fine dei processi che

perpetuano le false credenze. Gli esperimenti

di Peter Cathcart Wason mettono in evidenza la

presa che questa distorsione esercita sulla

nostra mente. Ai soggetti viene presentato un

gioco apparentemente molto facile, con quattro

carte. Nell'esempio qui proposto sul retro

della carta contrassegnata con il numero 1 si

trova la lettera E; sul retro della carta

numero 2 si trova la lettera K; al numero 3 è

associato il 4; alla numero 4 è associato il

7.

Lo sperimentatore spiega che sul fronte si

possono trovare alternativamente due lettere,

E o K, e sul retro due cifre, 4 o 7. Il

problema è quali due carte si devono girare

per verificare l'affermazione seguente: «Se

una carta ha su un lato una vocale, sull'altro

ha una cifra pari».

La soluzione giusta è girare le carte 1 e 4,

ma la stragrande maggioranza dei soggetti

sceglie di girare le carte 1 e 3. Così

facendo, considerano il caso che conferma la

regola, anziché quello che la confuta. Sembra

infatti naturale andare a vedere se la terza

carta conferma l'enunciato, presentando sul

retro una vocale. In realtà, anche se sul

retro ci fosse una consonante la regola non

sarebbe contraddetta. La sola carta, a parte

la prima, che permette di verificarne la

validità è la quarta: se sul retro trovassimo

una vocale, sarebbe dimostrato che l'enunciato

è falso.

Questo meccanismo ci fornisce una

spiegazione semplice, ma molto efficace, per

capire la longevità delle credenze. È facile,

infatti, trovare dati che non sono

incompatibili con un enunciato dubbio, ma

questo tipo di dimostrazione non ha alcun

valore se non si tiene conto di quelli che lo

contraddicono.

Benché non esprima una razionalità

obiettiva, tuttavia, questo tropismo per le

conferme ci facilita in un certo senso

l'esistenza. Il processo di confutazione è

indubbiamente più efficace se lo scopo è la

ricerca della verità, riducendo la probabilità

di accettare come vere ipotesi false, ma esige

un investimento di tempo che può apparire

assurdo quando si tratta solo di prendere una

decisione soddisfacente. Come notano molti

autori, si sceglie spesso un'inferenza

soddisfacente anziché quella ottimale, cedendo

a quella che Fiske e Taylor (1984) chiamano

«avarizia cognitiva». Il fatto è che la

ricerca metodica di conoscenze fondate produce

un risultato cognitivo superiore, in confronto

a quelle proposizioni appena «soddisfacenti»

che sono le credenze condivise, ma implica un

dispendio di forze e di tempo molto maggiore.

La probabilità di adottare cognizioni ben

dimostrate risente della facilità con la quale

si incontrano credenze tutt'altro che

garantite.

Una volta accettata un'idea, si tende

generalmente a perseverare nella credenza,

tanto più facilmente quanto più la diffusione

ampia e non selettiva di informazioni rende

probabile la scoperta di «dati» che la

confermino. Personalmente non credo affatto

che Internet riprogrammi il nostro cervello,

come afferma Nicholas Carr nel suo saggio

Internet ci rende stupidi?, ma trovo del tutto

accettabile pensare che una persona a caccia

di informazioni in Internet dipenda in parte

dal modo in cui le organizza un motore di

ricerca. Quello rivelato dal web non è un modo

nuovo di pensare, ma al contrario un modo

arcaico, segnato dall'errore di conferma.

Qualcuno crede che gli attentati dell'11

settembre siano stati fomentati dalla CIA? In

pochi istanti, qualunque motore di ricerca gli

fornirà centinaia di pagine che gli permettono

di confermare quella sua credenza. Consultare

fonti d'informazione che non adottino quella

che è la sua rappresentazione del mondo può

sembrare una perdita di tempo.

Se teniamo conto di questo meccanismo di

ricerca selettiva dell'informazione, è chiaro

che la diffusione non selettiva di ogni sorta

di materiali sembra fatta apposta per

amplificare l'errore di conferma e quindi

perpetuare l'impero delle credenze, il che

rappresenta un notevole paradosso nella nostra

era informatica. Ma c'è un altro aspetto, che

finora i vari commentatori della cultura

Internet non sembrano aver colto fino in

fondo: abbiamo a che fare con un mercato

cognitivo ipersensibile alla strutturazione

dell'offerta e quindi alle motivazioni di chi

la produce. È questo uno dei fattori

principali che strutturano la concorrenza sul

mercato della conoscenza.

I «credenti» dominano il mercato cognitivo

Cosa rischia d'incontrare in rete, a

proposito di un tema vettore di credenze, un

internauta senza idee preconcette, se per

farsi un'opinione si affida a Google? Ho

cercato di simulare il modo in cui un utente

medio può accedere su Internet all'offerta

cognitiva relativa a vari soggetti:

l'astrologia, il mostro di Loch Ness, i crop

circles (agroglifi o cerchi nel grano), la

psicocinesi (qui mi limito a riassumere certi

risultati, ma per lo studio completo e il

metodo si veda Bronner, 2011). Mi è sembrato

interessante condurre la verifica su questi

temi, in quanto l'ortodossia scientifica

contesta la fondatezza delle credenze cui si

ispirano. Non è nemmeno il caso di porsi qui

la questione della verità o falsità degli

enunciati (chissà, un giorno si potrebbe

scoprire che esiste davvero un dinosauro in un

lago scozzese): ci basti osservare la

concorrenza fra risposte che si richiamano

all'ortodossia scientifica e altre che ne

divergono (indicate come «credenze» per

semplificare). Internet è un posto

d'osservazione interessante per valutare la

visibilità di tesi dubbie.

I risultati sono chiarissimi. Se si tiene

conto solo dei siti che sostengono tesi

favorevoli o sfavorevoli alle varie credenze,

fra le prime 30 voci proposte da Google si

trova in media oltre l'80% di siti che

sostengono la credenza in questione.

Come si spiega questa situazione?

Emerge chiaramente che Internet è, come già

accennato, un mercato cognitivo estremamente

sensibile all'offerta, e questa dipende dalla

motivazione di chi la produce. Altrettanto

chiaro è che i credenti sono generalmente più

motivati dei non credenti, quindi più disposti

a dedicare tempo alla difesa delle proprie

convinzioni. La credenza infatti è parte

integrante dell'identità personale del

credente: mentre questo si darà da fare per

trovare informazioni che gli forniscano pezze

d'appoggio, il non credente si accontenta di

rifiutare un enunciato, senza bisogno di altra

giustificazione che la sua palese fragilità.

Questo fatto si tocca con mano nei forum in

rete, dove talvolta credenti e non credenti si

contrappongono. Nell'insieme dei 23 forum che

ho esaminato (relativi alle quattro credenze

considerate), ho potuto contare 211

interventi, 83 a favore della credenza, 45

contrari e 83 neutri. Quello che colpisce

nella lettura di questi testi è che gli

scettici si limitano a messaggi ironici, senza

argomentare, mentre i sostenitori della

credenza portano argomenti, certo non

conclusivi (citazioni copia e incolla, link,

ecc.), ma comunque espongono per esteso il

loro punto di vista. Fra gli interventi a

favore, infatti, il 36% è corredato di un

link, un documento o un'argomentazione

articolata, contro il 10% degli interventi

scettici. Il mondo scientifico in generale non

ha molto interesse, né accademico né

personale, a intervenire in questo tipo di

dibattito, con la conseguenza paradossale che

i credenti, su ogni genere di argomento, hanno

finito per instaurare un monopolio nel mercato

cognitivo della rete, monopolio che non si

limita a Internet ma contagia anche i media

tradizionali, ormai estremamente sensibili

alle fonti d'informazione eterodosse.

Riassumendo, non credo si possa dire che

Internet ci renda più stupidi o più

intelligenti, ma il suo stesso funzionamento

facilita certe disposizioni rischiose della

nostra mente e organizza l'informazione in

maniera non sempre favorevole ad un sapere

rispettoso dei canoni scientifici. In altre

parole, la libera concorrenza delle idee non

sempre favorisce il pensiero più metodico e

razionale.

Gérald Bronner

(«Psicologia contemporanea» n. 230/12)

Sarà l'uomo a provocare la sesta estinzione di

massa?

- La scomparsa delle specie ha scandito

l'intera storia evolutiva. Oggi qualcosa del

genere accade ancora, ma non a causa di

meteoriti o grandi catastrofi, bensì per lo

più a seguito delle attività «antropiche». Il

dilemma del futuro che ci aspetta. Chi percorra le calli di Venezia o ne

navighi i rii si rende conto del degrado di

palazzi, ponti e monumenti, sui quali

l'inquinamento e le intemperie lasciano tracce

che con il tempo si trasformano in ingiurie e

ferite. Nel corso della storia sono nati e poi

morti imperi, nazioni e città: abbattuti dalle

invasioni, sommersi dalla sabbia, devastati

dai terremoti, allagati dagli oceani, arsi

dagli incendi. Ammiriamo le rovine di Machu

Picchu, le piramidi d'Egitto, le necropoli

etrusche, Pompei, i templi della Magna Grecia:

ma davanti alla lenta rovina di Venezia

avvertiamo un senso di ribellione e di

sconforto, perché si svolge sotto i nostri

occhi.

Da oltre quattro miliardi di anni la Terra

subisce sconvolgimenti e devastazioni. Appena

formate dalla spinta orogenetica, le montagne

cominciano a sfaldarsi, i continenti si

separano e tornano a riunirsi, le isole

emergono per poi scomparire di nuovo tra i

flutti degli oceani, i ghiacciai invadono le

pianure e poi si ritirano. Questa tormentata

storia geologica è inscritta sulla superficie

rugosa del nostro pianeta, sul fondo dei mari,

nei giacimenti stratificati di rocce e di

conchiglie e di ossa pietrificate. Di tutto

ciò siamo consapevoli: sappiamo bene che

montagne, laghi, coste e acrocori sono stati e

sono sottoposti a un continuo travaglio

costruttivo e distruttivo. Ma un conto è

sapere, un conto è vedere: quando l'indefesso

lavorio della natura si palesa davanti a noi,

ne siamo turbati e spaventati. Qualche anno fa

risonò un grido di allarme per lo sfaldarsi

delle nostre Dolomiti, uno dei più suggestivi

monumenti naturali del pianeta: ma le Dolomiti

hanno cominciato a sgretolarsi appena emerse

dai mari del Permiano, oltre 200 milioni di

anni fa. È la nostra visione ravvicinata che

c'impedisce di vedere le cose in prospettiva

geologica: fenomeni comunissimi, sempre

avvenuti nel lungo buio del tempo preumano,

oggi ci appaiono straordinari solo perché vi

assistiamo. Inoltre, lo sgomento che proviamo

di fronte alle inesorabili leggi

dell'entropia, del disordine e del degrado,

non deve farci dimenticare che spesso siamo

proprio noi a contribuire ai processi

degenerativi: le montagne sono solcate da

strade carrozzabili che consentono alle

automobili di inerpicarsi fino ad alta quota,

le foreste sono abbattute a ritmi forsennati

per sfruttarne il legno e ricavare spazio alle

coltivazioni, i mari sono solcati da pescatori

armati di una tecnologia che non lascia scampo

alle prede, cumuli di rifiuti più o meno

tossici e pericolosi invadono ogni angolo

dell'unico pianeta che abbiamo, e anche lo

spazio intorno alla Terra è gremito di

migliaia di oggetti piccoli e grandi che

abbiamo lanciato nel corso di mezzo secolo.

Questo discorso può essere declinato anche

in chiave biologica: la vita, comparsa

grossomodo tre miliardi di anni fa, si è

rapidamente diffusa ed è esplosa in una

varietà stupefacente di forme, ordini, specie.

Ma i periodi di grande fioritura sono stati

interrotti da calamitosi eventi recessivi, le

cosiddette estinzioni di massa. Se ne contano

cinque:

1. Nell'Ordoviciano superiore (circa 440

milioni di anni fa);

2. Nel tardo Devoniano (circa 370 milioni di

anni fa);

3. Nel passaggio dal Permiano al Triassico

(circa 250 milioni di anni fa), la più

disastrosa, in cui scomparvero il 96% delle

specie marine e il 50% di tutte le specie

animali esistenti;

4. Nel passaggio dal Triassico al Giurassico

(circa 180 milioni di anni fa);

5. Nel passaggio dal Cretaceo al Terziario

(circa 65 milioni di anni fa), nella quale

scomparvero, tra l'altro, i dinosauri.

Anche se le estinzioni di massa sono

impressionanti per le loro dimensioni, il

fenomeno della scomparsa delle specie si

riscontra lungo tutta la storia evolutiva,

tanto che più del 90% degli organismi mai

vissuti sono ora estinti. Se si esaminano

questi eventi adottando una visione oggettiva

e spassionata, non si può non convenire che

essi rientrano nell'avvicendamento naturale

tra la vita e la morte: la morte,

dell'individuo e della specie, è necessaria

alla comparsa di nuova vita, anzi allo stesso

mantenimento della vita. E in effetti dopo

ogni grande estinzione si è avuta una

straordinaria fioritura di nuove forme. I

dinosauri si affermarono dopo la terza

estinzione e i mammiferi conobbero il loro

trionfo dopo la quinta estinzione, che portò

alla scomparsa dei dinosauri.

Oggi assistiamo a quella che molti chiamano

la sesta estinzione di massa, segnata dalla

rapida scomparsa di un numero impressionante

di specie: ne siamo testimoni diretti, come

siamo testimoni del declino di Venezia. E,

come nel caso di Venezia, questa rapida

decadenza ci preoccupa e ci addolora. Ma oggi

il quadro è diverso: l'estinzione non è

causata come in passato da eruzioni vulcaniche

o dalla caduta di grandi meteoriti, bensì,

soprattutto, dalle attività antropiche.

Negli ultimi tempi, una crescente

consapevolezza della responsabilità umana

nell'ambito dei processi globali ha sostituito

la beata incoscienza di un passato non troppo

lontano. Ma quali sono i risultati di questa

consapevolezza? Il mese di aprile 2008 fu

proclamato «mese della Terra» e il pianeta fu

celebrato come un'arcaica divinità, riesumando

forme di venerazione tribali tipiche delle

popolazioni primitive. Tuttavia, questa acuita

sensibilità non è riuscita finora a tradursi

in azioni efficaci di contrasto alle attività

umane più invasive e inquinanti, che secondo

molti specialisti sono una delle cause

predominanti dell'estinzione di massa, del

riscaldamento globale e in genere degli

squilibri planetari. In assenza di

provvedimenti adeguati, la consapevolezza non

può che tradursi in angoscia.

Nei confronti di questi problemi, noi umani

tendiamo ad adottare un punto di vista

antropocentrico e a ricondurre alla nostra

specie e al momento attuale tutti gli eventi

che interessano il pianeta, dandone una

valutazione positiva o negativa con

riferimento solo a noi stessi. Ma il sistema

del quale facciamo parte è molto più vasto e

se gli equilibri planetari sono sconvolti

oltre misura, ciò può portare alla scomparsa

(non della vita ma) di molte specie viventi,

tra cui la nostra.

Si deve quindi operare una vera e propria

rivoluzione concettuale, che consiste nel

reinserire l'uomo nel grande quadro della

natura vivente. È una questione sistemica,

come ha sottolineato con forza, tra gli altri,

Gregory Bateson in tutte le sue opere e in

particolare in quelle dedicate all'ecologia

della mente. L'operazione auspicata di

reimmissione dell'uomo nel sistema complessivo

si è tradotta di recente nel cosiddetto

principio di precauzione, che consiste in

sostanza nell'astenersi da ogni intervento

umano che presenti una qualche probabilità di

danno significativo, anche se non accertata e

tantomeno quantificata.

Sorge tuttavia un problema: per quanto in

apparenza molto ragionevole, nella sua forma

più radicale il principio di precauzione è

paralizzante, perché ogni intervento umano,

anche il mancato intervento, presenta rischi

potenziali; e in generale è impossibile

dimostrare che una qualunque azione non

comporti rischi. In altre parole, se si

considera il sistema nel suo complesso, il

tentativo di salvaguardare un sottosistema può

ripercuotersi negativamente su un altro

sottosistema. Per esempio una riduzione rapida

e cospicua delle immissioni di gas serra

nell'atmosfera, di per sé benefica sotto il

profilo della qualità dell'aria e

presumibilmente anche del riscaldamento

globale, provocherebbe una vasta crisi

economica che avrebbe ripercussioni disastrose

sugli strati meno abbienti della popolazione

mondiale e in particolare sui Paesi in via di

sviluppo.

Il dilemma è evidentissimo nel caso della

Cina: l'aumento della produzione industriale

comporta costi altissimi in termini

ambientali, ma un suo ridimensionamento

porterebbe a una crisi economica di

proporzioni inimmaginabili. In sostanza è la

complessità insormontabile del sistema globale

a impedirci di applicare il principio di

precauzione nella sua forma estrema. Sono

invece accettabili forme attenuate del

principio, che predicano l'astensione da

quelle attività che presentano rischi

potenziali, anche se non accertati, purché la

rinuncia non comporti un aumento intollerabile

di rischi o di costi in altri settori del

sistema.

Si tratta di una sorta di conflitto di

interessi: coltivare un campo petrolifero al

largo di una costa incontaminata dove le

balene vengono a riprodursi, con il rischio di

inquinare il mare e sterminare pesci e

cetacei, oppure rinunciare al petrolio e

preservare lo stato integro del luogo?

L'interrogativo riguarda, per esempio, le

trivellazioni marine lungo le coste dell'isola

russa di Sakhalin, in Estremo Oriente, e si

traduce nel conflitto tra l'alimentazione

delle automobili da una parte e l'equilibrio

dell'ecosistema e il nutrimento della

popolazione locale dall'altra.

Certo, si può argomentare che siccome l'uomo

fa parte della natura, tutte le sue azioni

sono naturali, quindi anche quelle che portano

all'eliminazione di altre specie, eliminazione

che la natura, con la sua tipica «crudeltà»,

ha praticato per centinaia di milioni di anni

e continua a praticare senza nessuno scrupolo.

Tuttavia l'uomo è anche un essere razionale, e

non può limitarsi ad agire guardando solo il

profitto immediato e adottando la legge del

più forte.

Un atteggiamento più saggio consiste nel

considerare non solo gli interessi di questa

generazione, anzi dei suoi rappresentanti più

avanzati, ma nel tener conto delle componenti

più deboli della specie umana e delle

generazioni future. In effetti questa forma di

altruismo verrebbe a coincidere con una sorta

di «egoismo di specie», se con questa

locuzione s'intende un atteggiamento che

favorisca il mantenimento a lungo termine

dell'equilibrio dinamico del sistema Terra e

quindi della nostra sopravvivenza. La specie

che distrugge l'ambiente distrugge sé stessa

(è nota la metafora del boscaiolo incauto che

sega il ramo su cui sta seduto), anche se

nell'immediato questa distruzione, che si

traduce in uno sfruttamento intensivo delle

risorse, è fonte di prosperità e di benessere

materiale. Ma come decidere quali azioni sono

benefiche e quali negative per l'equilibrio

sistemico? Data l'insuperabile complessità del

reale, le nostre capacità di previsione sono

molto limitate: dobbiamo rassegnarci

all'incertezza e al rischio, ma non dobbiamo

rinunciare all'impegno etico.

Giuseppe O. Longo

(«Vita e Pensiero» n. 2/11)

Il corpo sotto gli occhi

- In passato, lo studio dei cadaveri era

parte integrante della formazione dei giovani

medici. E oggi? L'autopsia è ancora uno

strumento fondamentale o è ormai una reliquia

del leggendario passato della storia della

medicina? In un grigio mattino di novembre, durante il

mio internato in patologia, mi trovavo

nell'obitorio dell'Indiana University

Hospital, con la sola compagnia del piacevole

ronzio delle luci fluorescenti e del gocciolio

di un rubinetto. Una donna deceduta da poco

giaceva sul tavolo metallico. Indossava ancora

gli orecchini e la vera nuziale. Dal suo corpo

fuoriuscivano alcuni tubi di plastica, gli

ultimi dolorosi segni dell'intervento medico.

Con un senso di timore e di eccitazione mi

apprestai a compiere l'antico rituale

dell'autopsia. Sebbene da studente avessi già

avuto occasione di osservare il decesso di

alcuni pazienti, da quando avevo dissezionato

un cadavere durante il primo anno di medicina

non mi era più capitato di trovarmi da solo in

una sala settoria, in compagnia di un

cadavere. Divenni conscio del mio respiro,

degli sbuffi di aria calda che increspavano la

mascherina chirurgica e del martellare del mio

cuore mentre il ritmo aumentava. Sebbene il

corpo che avevo di fronte fosse privo di

emozioni e inerte come qualsiasi altro oggetto

inanimato nella stanza, percepivo la vita che

questa donna aveva vissuto, da giovane moglie,

figlia, forse sorella o madre. Mi sforzavo di

abbandonare la mia innata avversione per la

morte, accettandone il carattere definitivo e

separando la persona dal corpo che rimaneva.

Concentrandomi sul mio compito effettuai il

normale esame esterno, che per il patologo

equivale al tradizionale esame fisico eseguito

dal medico di famiglia, da un internista o da

un chirurgo. Mentre stavo preparando il

bisturi, scoprii una prominente protuberanza

delle dimensioni di un pompelmo nel punto in

cui la spalla si inserisce nella parte

superiore del torace. Tenendo ben ferma la

mano premetti la lama contro la pelle

incidendo l'epidermide e il tessuto molle

profondo fino a quando il bisturi toccò

l'osso. La pelle era rimasta sufficientemente

elastica per essere penetrata dalla mia lama,

e riuscii a completare velocemente la serie di

tagli necessari a creare un'incisione a Y sul

torace e sull'addome. Esaminai i tessuti della

cavità toracica, i quali rivelarono una massa

carnosa di tessuto bianco disorganizzato che

si estendeva dall'interno del seno fino ai

muscoli scheletrici sottostanti e alle costole

con una presa implacabile.

Questa era la natura del cancro, che

illustrava perfettamente l'etimologia della

parola, da karcinos, granchio. Il nome fu

coniato dal grande medico greco Ippocrate, e

si basava sulla tendenza dei tumori maligni

infiltranti a diffondersi in proiezioni

stellate, simili a dita, che ricordano le

zampe e le chele di un granchio. La parola

autopsia, che deriva dal greco e significa

«vedere con i propri occhi», ben esprimeva la

mia esperienza in quell'obitorio, mentre

imparavo a capire la natura dei tumori maligni

direttamente con i miei occhi, una capacità

che avrei coltivato per il resto della mia

carriera di patologo. Fu un episodio avvilente

osservare una così personale, palese e

avanzata manifestazione di malattia in una

donna che aveva la mia stessa età. Mi sentii

onorato di essere l'unico a posare gli occhi e

le mani sulla realtà della patologia che aveva

condotto alla morte questa donna. Provai anche

un legame spirituale con i medici del passato

che fecero un enorme balzo in avanti, passando

dalla semplice osservazione della superficie

di un corpo all'osservazione di ciò che era

racchiuso al suo interno.

Una simile scoperta rappresenta la forma più

pura della medicina, quando una condizione

clinica può essere direttamente collegata ai

sintomi fisici osservati. E sebbene le

caratteristiche grossolane e microscopiche del

cancro e di altre malattie abbiano avuto,

probabilmente, nel corso degli anni un aspetto

simile negli esseri umani, i modi in cui

scopriamo e interpretiamo le loro cause sono

cambiati drasticamente.

Una prognosi incerta

L'autopsia è stata e rimane lo strumento

migliore per giungere a una valutazione delle

malattie e dei traumi che comunemente

affliggono gli individui e le popolazioni.

Tuttavia questo esame sta progressivamente

perdendo il suo ruolo di procedura medica

principale. Osservando le onnipresenti

descrizioni di autopsie nelle serie

televisive, si potrebbe dedurre che gli

obitori straripano di casi in attesa di essere

risolti. Di fatto, mentre l'elevato numero di

omicidi, suicidi e incidenti tiene occupato

l'ufficio del coroner e del medico legale, il

patologo ospedaliero ha sperimentato negli

ultimi cinquant'anni un'enorme diminuzione

delle autopsie. Il tasso di autopsie negli

anni precedenti al 1950 si attestava su valori

costanti superiori al 50 per cento; negli anni

successivi, la percentuale di esami autoptici

per i decessi ospedalieri ha subito un brusco

calo fino a raggiungere attualmente valori

stimati intorno al 6 per cento. E questo

nonostante i risultati autoptici rivelino un

sorprendente tasso di errore nelle diagnosi

pre mortem e l'autopsia rappresenti, di fatto,

il principale strumento per determinare quel

tasso di errore.

Nel 40 per cento dei casi l'esame autoptico

rivela una diagnosi principale non scoperta in

precedenza, un valore che è rimasto costante

per i 60 anni in cui sono state registrate

queste correlazioni clinico-patologiche.

Questa statistica è in certa misura

fuorviante, in quanto i casi selezionati per

l'esame autoptico sono, in genere, quelli con

la maggiore incertezza diagnostica. Comunque,

analisi di regressione multipla su decenni di

dati disponibili presentati in numerose

pubblicazioni da parte di Kaveh Shojania

all'Università di Ottawa e da altri colleghi

hanno incluso periodi di studio, tassi di

autopsie, nazioni e diversi casi per

dimostrare che il tasso di errore diagnostico

continua a preoccupare i medici in modo

significativo. La probabilità che l'autopsia

evidenzi un errore di classe I, in cui

l'errata diagnosi può aver influenzato la

sopravvivenza del paziente, è del 10,2 per

cento. La probabilità di errori di maggiore

rilievo, diagnosi mancate che probabilmente

non hanno influito sul risultato, è risultata

del 25,6 per cento. Si stima che 35.000

pazienti che muoiono negli ospedali degli

Stati Uniti ogni anno potrebbero sopravvivere

se queste condizioni cliniche nascoste

venissero alla luce prima.

L'incompetenza diagnostica non è

necessariamente l'unico colpevole. Alcune

discrepanze fra le diagnosi cliniche e quelle

effettuate in sala settoria vanno attribuite

ai limiti della tecnologia diagnostica, e alle

inevitabili sfide costituite da pazienti

affetti da problemi medici multipli, da

sintomatologie atipiche della malattia o da

una patologia che può essere clinicamente

nascosta. Eppure, l'ampiezza delle statistiche

sugli errori suggerisce chiaramente quanto

l'esame autoptico sia importante ai fini del

monitoraggio e del miglioramento dei

risultati. Oltre a confermare e a correggere

le diagnosi cliniche, l'autopsia consente di

stabilire le cause del decesso, permette di

scoprire nuove e mutate patologie, consente di

valutare nuovi test diagnostici, tecniche

chirurgiche, dispositivi e farmaci. Inoltre dà

la possibilità di investigare su rischi

ambientali e occupazionali, consente di creare

precise statistiche vitali e permette di

valutare la qualità degli interventi medici.

Infine ha un valore fondamentale nella

formazione dei medici e, soprattutto, continua

ad ampliare i confini della conoscenza medica.

L'esame autoptico è un'arte antica. Ha un

futuro incerto, e un emozionante passato.

Gli inizi

La curiosità nei confronti dei fenomeni

naturali ha sempre alimentato gli sforzi

scientifici. A uno a uno, i grandi misteri

della vita sono stati illuminati da menti

avide di sapere, che spesso procedevano

controcorrente contestando i dogmi dell'epoca.

Le scienze mediche non hanno fatto eccezione,

come dimostrato dalla coesistenza di opposte

correnti di pensiero che ipotizzavano, per

esempio, l'attività di demoni e spiriti come

causa di malattia, proprio mentre stavano

emergendo spiegazioni più laiche e moderne.

La prima e predominante teoria sulle

malattie nell'antica Grecia, così come in

India e in Tibet, si basava sul concetto dei

quattro umori associati ai quattro elementi terra, aria, fuoco e acqua - che a loro volta

configurano la personalità umana. La teoria

degli umori postulava che tutti gli acciacchi

umani avessero origine da squilibri a carico

di questi elementi interni, che si manifestano

con apatia, perdite di sangue, bile gialla e

bile nera. Per esempio, a un individuo

sofferente di depressione veniva diagnosticato

un eccesso di bile nera (il termine melancolia

è formato dalle parole greche «nero» e

«bile»). Questa scuola di pensiero era

preminente all'epoca dei grandi medici greci

come Erofilo, il primo anatomista sistematico,

Ippocrate, il cui corpus medico rigettava le

spiegazioni soprannaturali della malattia, ed

Erasistrato, seguace di Erofilo e uno degli

ultimi di quell'epoca a dissezionare corpi

umani.

Il ruolo degli umori venne articolato in

modo assai eloquente da Galeno di Pergamo

(129-200 d.C.). La grande opera di Galeno

sulla cura, De methodo medendi, assieme agli

altri suoi trattati, fu il primo grande

scritto sulla medicina, e servì come guida

universale alle malattie umane per più di un

millennio. Durante l'epoca di Galeno e dei

discepoli che seguirono, la dissezione del

corpo umano non era approvata, e veniva

violentemente condannata. Di conseguenza,

Galeno formò la maggior parte delle sue

conoscenze di anatomia umana dissezionando

animali, incluse le bertucce, una specie di

scimmie presenti soprattutto in Nord Africa.

Galeno suppose - in modo ragionevole ma

pericolosamente imperfetto - che la struttura

interna di questi animali fosse abbastanza

simile a quella degli esseri umani, tanto da

essere sufficiente per capire l'anatomia

umana. Gli insegnamenti di Galeno rimasero in

auge in Europa e in Grecia fino al XVI secolo,

e alcune antiche scuole mediche, come quelle

ayurvedica e tibetana, esercitano ancora la

guarigione metafisica e la diagnostica basata

sugli umori che hanno avuto origine dalle

stesse radici, combinate con tecniche

terapeutiche e farmacologiche altamente

sofisticate. In effetti, quando i governanti

tibetani tennero due importanti conferenze

mediche nell'VIII e nell'XI secolo, riunendo

moltissimi medici - e traduttori - provenienti

da India, Persia, Nepal, Grecia, Cina e da

altri paesi per condividere le proprie

conoscenze, fu proprio la medicina di Galeno

quella che usarono come base per il loro

sistema medico integrato.

L'approccio galenico generalmente accettato

cambiò drasticamente nel 1530, quando Andrea

Vesalio, medico e anatomista italiano che

esercitava a Padova, ipotizzò che le

supposizioni di Galeno sulle somiglianze fra

l'anatomia animale e quella umana - senza

contare i suoi errori di osservazione stavano impedendo di capire più a fondo il

corpo umano. Vesalio giunse alla conclusione

che, per conoscere e caratterizzare le

malattie umane, fosse essenziale nient'altro

che l'accurata dissezione dei corpi umani.

Nel 1539 un giudice padovano che condivideva

un certo interesse per il lavoro svolto da

Vesalio concesse ai medici il diritto di

dissezionare i corpi dei criminali

giustiziati, fornendo in questo modo una fonte

fondamentale - sebbene discussa - di

conoscenza anatomica: un corpo umano appena

deceduto. Girava voce che un giudice

accomodante avrebbe organizzato le esecuzioni

per favorire l'anatomista padovano. Il lavoro

di Vesalio fu essenziale per espandere

l'ampiezza del sapere medico, e segnò la

nascita di una nuova era nella scienza

anatomica. Allo stesso modo in cui aumentò il

numero dei criminali giustiziati e delle loro

autopsie, crebbe anche la conoscenza anatomica

globale di Vesalio. Le sue indagini

culminarono nel 1543, con la pubblicazione del

De Humani Corporis Fabrica. Sulla struttura e

la funzione del corpo umano. Le sue scoperte

furono così complete e dettagliate che oggi

Vesalio è conosciuto come il padre

dell'anatomia umana.

Con la pubblicazione della sua opera si aprì

la via verso una reale comprensione della

struttura interna e delle funzioni del corpo

umano. Da raccolta sparsa di superstizioni e

rimedi fidati, la medicina occidentale si

trasformò in una disciplina basata sulla

logica e sull'osservazione, e un'altra area

della natura che in precedenza era rimasta

avvolta nel mistero venne liberata e

assimilata nella biblioteca collettiva della

conoscenza umana.

Il commercio dei corpi

Il patrimonio di informazioni provenienti

dalla dissezione dei corpi umani fu alimentato

e nutrito, e le scuole mediche finirono per

incoraggiare l'uso dei cadaveri a scopo

didattico. Il problema era dato semplicemente

dalla scarsità di corpi a disposizione: il

numero dei criminali giustiziati era di gran

lunga inferiore al numero dei cadaveri

necessari per i grossolani corsi di anatomia

delle scuole mediche. Di conseguenza, la

richiesta di corpi crebbe a dismisura e, come

spesso accade quando qualcosa scarseggia, il

prezzo salì ed ebbero inizio loschi affari.

Fra le novità introdotte dallo stesso Vesalio

va annoverato l'oscuro traffico di corpi

ignobilmente acquistati per un nobile scopo.

Come riporta Charles O'Malley nell'autorevole

biografia di Vesalio:

«Come un autentico studioso, Vesalio

raccomandò di fare ricorso alle fonti, in

questo caso i corpi umani, e se i corpi non

fossero stati facilmente accessibili lo

studente veniva incoraggiato a parole o, nella

Fabrica, attraverso insegnamenti aneddotici, a

procurarseli da sé. È significativo che,

dovunque Vesalio si recasse a tenere seminari,

ne conseguisse un'ondata di corpi scippati; i

vari aneddoti presenti nella Fabrica non danno

indicazioni sulla provenienza...»

Quando le pratiche e le conoscenze di

Vesalio si diffusero su larga scala, il

bisogno di cadaveri si tramutò nel cosiddetto

«commercio dei corpi», e trafugare salme dai

cimiteri divenne pratica comune. Per salme

decedute da poco e parti anatomiche varie

venivano offerti prezzi più alti di quelli

richiesti per cadaveri in diverso stato di

decomposizione. Tutto ciò indusse alcuni

imprenditori a partecipare a questo macabro

commercio. Famiglie preoccupate furono spinte

a prendere ulteriori precauzioni per

proteggere i loro cari dagli «uomini della

resurrezione», come venivano chiamati,

seppellendo i corpi in bare rinforzate che

venivano sigillate, e assumendo guardie per

impedire che le tombe venissero violate.

Numerose scuole mediche svilupparono una

politica del «non chiedere, non dire» quanto

all'acquisizione da parte degli studenti di

materiale umano per la dissezione. Se uno

studente si presentava in classe con un corpo,

questo veniva usato per la dissezione senza

che nessuno facesse domande. Questa abitudine

stimolò nuovamente la domanda di corpi come

pure la competizione fra i ladri di cadaveri.

Ma mentre molti pagavano ingenti somme di

denaro per acquisire corpi, arti e cervelli

dalle tombe, c'era chi accompagnava le persone

verso una morte prematura, in modo da poterne

vendere la salma. I due più famigerati ladri

di cadaveri, William Burke e William Hare,

fecero una breve carriera assassinando

numerosi cittadini e consegnando corpi ancora

caldi, evitandosi così il fastidio di esumare

i cadaveri dal terreno e fornendo materiale

fresco ai prezzi più elevati. Burke e Hare

entrarono in commercio quando un inquilino

della pensione di Hare morì per cause

naturali. I due portarono il corpo

all'università di Edimburgo, dove furono

ricompensati con 7 sterline e 10 scellini,

grosso modo un migliaio di euro al tasso di

inflazione attuale.

I due affrontarono allora il problema del

rifornimento, dando inizio a una mattanza che

fece 16 vittime in 12 mesi. Dopo la cattura, a

Hare venne concessa l'immunità per la sua

testimonianza contro Burke, con grande rabbia

del popolino che fu in certa misura ammansito

solo quando Burke venne impiccato e, in

seguito, dissezionato pubblicamente.

La protesta relativa alle pratiche di

sottrazione di cadaveri produsse, in

Inghilterra, l'Anatomy Act del 1832, che

affrontava, secondo la rivista «Lancet», «il

sistema di traffico fra resurrezionisti e

anatomisti, della cui esistenza l'esecutivo

aveva così a lungo sofferto». L'Anatomy Act

ampliava il pool di cadaveri legalmente

disponibili includendovi i senzatetto che

nessuno reclamava, molti dei quali furono

agevolmente recuperati da prigioni e ospizi.

Alla fine, con la comparsa dell'Anatomy Act e

una nuova detrazione per la donazione di corpi

da parte di privati cittadini, il mercato dei

rapitori di cadaveri giunse a termine.

La nascita dell'autopsia medica

Avevo appena ultimato la tradizionale

incisione a Y della mia prima autopsia quando

il patologo di turno entrò in sala,

apparentemente ignaro della mia mancanza di

esperienza. «Vai avanti e fai una Rokitansky»,

disse con tono monocorde. Dal momento che non

avevo la più pallida idea di che cosa fosse la

Rokitansky, immaginai che si stesse riferendo

alla rimozione e all'esame degli organi

interni. Il patologo scrutò attentamente ogni

mia incisione e guidò la mia mano con

suggerimenti esperti. Trascorsi più di un'ora

tagliando i tessuti molli, incidendo fra le

costole e manipolando organi in questo e

quell'altro modo, con tagli precisi e mirati.

Con le maniche completamente inzuppate di

sangue e la fronte imperlata di sudore,

completai la prima autopsia della mia

carriera. Avevo fatto la Rokitansky al mio

primo cadavere.

Il medico tedesco Karl von Rokitansky (18041878) fu uno dei primi a proporre l'uso

dell'anatomia patologica e degli studi

autoptici per l'apprendimento della medicina

clinica. In qualità di direttore dell'Istituto

di patologia del primo ospedale d'Europa,