Università degli Studi di Bari

Dipartimento di Scienze Economiche e Metodi Matematici

Corso di Econometria

Corsi di Laurea Magistrale in

Economia degli Intermediari e dei Mercati Finanziari

8 CFU

Statistica per le per le Decisioni Finanziarie ed Attuariali

6 CFU

Economia e Management

6 CFU

1

Orario Lezioni

mercoledì

11:30 – 14:30

giovedì

12:30 – 14:30

costituiscono parte integrante del corso le esercitazioni sull’uso di Gretl.

Orario ricevimento

martedì 11.30-13.00

[email protected]

Comunicazioni

Pagina web docente

2

Programma (8 CFU)

•

•

•

•

•

•

•

•

Il Modello Lineare Classico di Regressione

Regressione Multipla

Funzioni di regressione non lineari

Valutazione degli studi di regressione

Regressione con dati panel

Regressione con variabili strumentali

Regressione con variabile dipendente binaria

Regressioni con serie storiche

Libro di testo

Stock J.H. e Watson M.W. Introduzione all’Econometria, Pearson Education Italia

3

Obiettivi del corso

Introduzione all’analisi empirica dei dati economici. La teoria

economica suggerisce relazioni molto interessanti che hanno

un’interpretazione di natura politica.

• Quali sono le variabili che possono influenzare i cicli

economici?

Tuttavia molto spesso la grandezza degli effetti CAUSALI è

ignorata:

• Qual è l’effetto della produttività del lavoro sulla crescita?

• Da che variabili dipende il rendimento di un titolo?

4

L’econometria serve a rispondere a queste domande e a…

1. sottoporre a verifica empirica le teorie economiche

2. prevedere i valori futuri delle variabili economiche

3. adattare dei modelli economici/matematici ai dati del

mondo reale

4. formulare raccomandazioni di “policy” quantitative

5

Alcune domande empiriche:

1.

ridurre la dimensione delle classi migliora il livello di

istruzione nella scuola elementare? nel senso comune

orientativamente si, ma bisogna quantificare

2.

qual è il rendimento di un titolo di studio come la laurea?

bisogna tenere costanti le altre caratteristiche dei richiedenti

3.

effetti della tassazione: di quanto riduce il consumo del bene

tassato?

4.

di quanto aumenta il rendimento di un titolo se aumenta il

rendimento del mercato?

6

Esempio di stima

L’econometria utilizza metodi statistici e matematici per l’analisi

di dati economici con il fine di dare riscontro empirico alle teorie

economiche.

Modelli economici = rappresentazione schematizzata della realtà di

un fenomeno economico

Esempio

Teoria del consumo di Keynes

Funzione implicita ⇒ Consumo = f(Reddito)

7

Dati economici (serie storica)

Consumo Reddito

1971Q1

6.420

6.629

1971Q2

6.433

6.635

1971Q3

6.443

6.642

1971Q4

6.456

6.662

1972Q1

6.473

6.676

1972Q2

6.475

6.695

1972Q3

6.50

6.699

1972Q4

6.499

6.715

1973Q1

6.529

6.735

1973Q2

6.535

6.753

1973Q3

6.535

6.751

1973Q4

6.554

6.770

8

19

72

19 Q1

73

19 Q2

74

19 Q3

75

19 Q4

77

19 Q1

78

19 Q2

79

19 Q3

80

19 Q4

82

19 Q1

83

19 Q2

84

19 Q3

85

19 Q4

87

19 Q1

88

19 Q2

89

19 Q3

90

19 Q4

92

19 Q1

93

19 Q2

94

19 Q3

95

19 Q4

97

19 Q1

98

Q

2

Proponiamo una rappresentazione grafica al fine di cogliere

l’andamento di questi dati nel tempo.

7.4

7.2

7

6.8

6.6

6.4

6.2

6

9

Diagramma a nuvola- scatter plot

7.1

7

6.9

Consumo

6.8

6.7

6.6

6.5

6.4

6.3

6.5

6.6

6.7

6.8

6.9

7

7.1

7.2

7.3

Reddito

10

Funzione esplicita (lineare) ⇒ C = α + βR

7.1

7

6.9

Consumo

6.8

6.7

6.6

6.5

6.4

6.3

6.5

6.6

6.7

6.8

6.9

7

7.1

7.2

7.3

Reddito

11

1.

C = α + βR +ε ; α=0.6; β=0.9; C = 0.6 + 0.9R

è solo un’ approssimazione della realtà.

(α + βR) parte deterministica , (ε) parte stocastica

Qual è il significato di α=0,6; β=0.9 ?

↓

Inferenza …

2.

bisogna tenere conto di altre variabili?

3.

etc..

12

Tipi di dati:

1. Dati sperimentali: provengono da esperimenti disegnati

per valutare l’effetto di un trattamento o un’azione di

politica economica;

2. Dati sezionali (cross-section): dati che si riferiscono ad

entità diverse (lavoratori, consumatori, unità governative,

paesi etc.) osservate solo una volta nel tempo.

3. Serie storiche (time series): dati che si riferiscono ad una

singola entità (individuo, impresa, paese) osservati più

volte nel tempo - quelli dell’esempio precedente - .

13

4. Dati longitudinali (panel): dati che riguardano più entità

ognuna delle quali è osservata in due o più periodi

14

Riassunto su Probabilità e Statistica

Problema empirico: grandezza della classe e output dell’istruzione

• Domanda politica: qual è l’effetto di ridurre la grandezza delle

classi di uno studente per classe? e di 8 studenti?

• Qual è la misura corretta per l’output (variabile dipendente)?

o Soddisfazione dei genitori

o Sviluppo personale degli studenti

o Guadagno e/o benessere futuro degli alunni

o Performance (voto) nei test

15

Che cosa ci dicono i dati sulla relazione fra grandezza della classe e

i voti?

Variabili considerate

• Voti ottenuti in 5a (Stanford-9 achievement test, combina

matematica e lettura), media dei distretti (tipo PISA)

• Rapporto fra studenti ed insegnanti Student Teacher Ratio (STR)

= numero di studenti nel distretto scolastico diviso per in numero

di insegnanti

16

17

Come possiamo iniziare a capire se numericamente i distretti con basso

STR ottengono voti più alti?

Tre possibili strategie:

1. confrontare numericamente le medie dei voti ottenuti nei

distretti con basso STR con quelli con alto STR (stima)

2. test di ipotesi sulle medie dei test nei due tipi di distretto (test di

ipotesi)

3. stimare un intervallo di confidenza per la differenza delle medie

dei voti, alto vs basso STR. (intervallo di confidenza)

18

Analisi dei dati iniziale:

Confronto fra i distretti con classi piccole, STR< 20, e classi grandi,

STR>=20.

Grandezza della classe

Voto medio stimato

Deviazione standard

(Y )

stimata (sY)

Classi Piccole STR< 20

657.4

19.4

238

Classi Grandi STR ≥ 20

650.0

17.9

182

n

19

Procedura d’analisi:

1. Stimiamo ∆ = differenza fra le medie dei gruppi

2. Testiamo l’ipotesi che ∆ = 0

3. costruiamo un intervallo di confidenza per ∆

2. e 3. sono alternative che conducono allo stesso risultato

20

1. Stima

Y

small

−Y

Ysmall =

large

1

nsmall

= 657.4 – 650.0 = 7.4

n small

∑Y

i

1

Y =

1

nl arg e

nl arg e

∑Y

i

1

Domanda: Questa differenza può essere considerata grande?

• La deviazione standard fra i distretti è di 19.1 (vedi tabella)

• La differenza fra il 60° e il 75° percentile dei voti è

667.6-659.4=8.2

• È una differenza abbastanza grande per aprire un dibattito su una

eventuale riforma della scuola.

21

2. Test d’ipotesi

Test di differenze fra medie: calcoliamo la statistica t

t=

Ys − Yl

ss2 sl2

+

ns nl

=

Ys − Yl

SE(Ys − Yl )

Ricordate?

dove SE(Ys − Yl ) è lo standard error di (Ys −Yl ) e lo standard error è la stima

della deviazione standard.

22

Utilizzando il nostro campione

Grandezza delle classi

Y

sY

N

Piccole

657.4

19.4

238

Grandi

650.0

17.9

182

657.4 − 650.0

7.4

t=

=

= 4.05

19.42 17.92 1.83

+

238 182

|t|>1.96 rifiutiamo (al livello di significatività del 5%) l’ipotesi nulla

che le due medie sono uguali

23

3. Intervallo di confidenza

Un intervallo di confidenza al 95% per la differenza fra le medie è

Y s − Y l ± 1.96 × SE(Ys − Yl ) = 7.4± 1.96 ×1.83 = (3.8. - 11.0)

Due conclusioni equivalenti:

1.

l’intervallo di confidenza al 95% per ∆ non include lo 0;

2.

l’ipotesi che ∆=0 è rifiutata al 5%

24

Dovreste già conoscere tutto questo ma: quali sono i presupposti che

giustificano questo procedimento?

1.

Stima: perché stimiamo ∆ utilizzando Y s − Y l ?

2. Test: che cos’è in realtà lo standard error di Y s − Y l? perché

rifiutiamo ∆ = 0 se |t|>1.96 ?

3. Intervallo di confidenza: cos’è in realtà l’intervallo di

confidenza?

25

Nozioni di probabilità per inferenza statistica

1. stima

2. test

3. intervalli di confidenza

Popolazione

• gruppo o collettivo di entità di interesse

• nel nostro esempio “tutti i possibili” distretti scolastici. “Tutti i

possibili” significa tutte le possibili circostanze che conducono

a valori specifici di STR e voti

• in genere si pensa alla popolazione come infinitamente grande;

il nostro compito è di fare inferenza utilizzando un campione

estratto da una grande popolazione

Variabile casuale

• indicatore numerico sintetico di un risultato casuale

• nel nostro esempio, il valore numerico della media distrettuale dei

risultati dei test (o gli STR distrettuali), una volta scelto l’anno e il

distretto da campionare

Distribuzione di probabilità di Y

• la probabilità con cui i diversi valori di Y si ripetono nella

popolazione, es. Pr[Y=650] per Y discreta

• le probabilità con cui un insiemi di questi valori si ripete, es.

Pr[Y<=650] per Y continua

Momenti di una distribuzione di probabilità

media = valore atteso

= E(Y)

1 n

= Y = ∑ Yi

n 1

= µY

varianza = E(Y- E(Y))2 = E(Y-µY)2

= σY2

= misura dell’ampiezza della distribuzione (distanza dalla

media) al quadrato

2

σ

deviazione standard = Y = σY

Distribuzione condizionata

La distribuzione di Y, dati i valori di un’altra variabile casuale, es. la

distribuzione dei voti dato che STR < 20

Momenti di una distribuzione di probabilità

media condizionata = media della distribuzione condizionata

= E(Y|X=x)

varianza condizionata = varianza della distribuzione condizionata

es. E(voti|STR>20) la media dei voti per i distretti con le classi più

grandi, i.e. E(voti) = 654.2 mentre E(voti|STR>20) = 650.0

La differenza delle medie è la differenza fra le medie di due

distribuzioni condizionate

∆ = E(voti|STR<20) - (voti|STR>=20)

altri esempi di medie condizionate:

• salari delle donne lavoratrici (Y=salari, X=genere)

• tasso di mortalità ad un anno per coloro a cui è stato dato un

trattamento sperimentale (Y=vivo/morto, X=trattato, non trattato)

La media condizionata è un nuovo termine per un concetto già noto

come media di gruppo

Inferenza su medie, medie condizionate, e differenze fra medie

condizionate

Vorremmo conoscere ∆ (differenza fra i voti, differenza fra i salari

delle donne e degli uomini, effetto di un trattamento sperimentale).

Abbiamo dunque bisogno di dati che ci permettano di fare inferenza

statistica su ∆, 2 possibilità:

• dati sperimentali

• dati osservati

Campionamento casuale semplice

scegliamo un individuo (distretto, entità) casualmente dalla

popolazione

Casualità e dati

• Prima di raccogliere i dati, il valore di Y è casuale perché

l’individuo selezionato è causale

• quando l’individuo è stato selezionato e il valore di Y è osservato,

allora Y è solo un numero – non più casuale

• Il campione di dati è (Y1, Y2, … Yn) dove Yi è il valore di Y per

l’individuo/distretto/entità i-esimo/a del campione

Implicazioni di un campionamento casuale semplice

Poiché gli individui #1 e #2 sono selezionati casualmente il valore

Y1 non fornisce alcuna informazione su Y2. In questo senso si dice

che:

• Y1 e Y2 sono indipendentemente distribuite

• Y1 e Y2 provengono dalla stessa distribuzione e cioè sono

identicamente distribuite

↓

Una conseguenza del campionamento casuale è che Y1 e Y2 sono

indipendentemente ed identicamente distribuite (i.i.d.)

Più in generale, sotto un campionamento casuale semplice si dice

che {Yi}, i=1,2,…,n sono i.i.d.

Nozioni di probabilità per inferenza statistica

1. stima

2. test

3. intervalli di confidenza

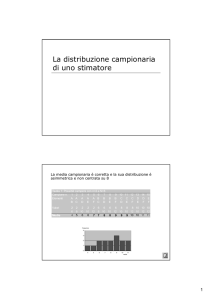

Y è uno stimatore “naturale” della media ma quali sono le proprietà di

questo stimatore? altri esempi potrebbero essere Y1 la prima

osservazione o una media ponderata con pesi diversi per diverse

osservazioni o la mediana della distribuzione di Yi .

Si può dimostrare che Y è il miglior stimatore della media guardando

alle sue proprietà

NB proprietà/caratteristiche di uno stimatore => media e varianza

Per rispondere a queste domande dobbiamo caratterizzare la

distribuzione campionaria di Y

• gli individui del campione sono distribuiti casualmente

• dunque i valori di (Y1, Y2, … Yn) sono casuali

• dunque le funzioni di (Y1, Y2, … Yn), come Y , sono casuali (se

estraiamo un altro campione avremmo valori diversi)

• la distribuzione di Y su tutti i possibili campioni diversi di

grandezza n è chiamata distribuzione campionaria di Y

• la media e la varianza di Y sono media e varianza della sua

distribuzione campionaria, E( Y ) e Var( Y )

• per calcolare Var( Y ) abbiamo bisogno della covarianza (vedi

par 2.3)

La covarianza fra X e Z è

cov(X,Z)=E[(X-E(X)) (Z-E(Z))]= σXZ

• La covarianza è una misura di associazione lineare fra X e Z

• cov(X,Z) > 0 (<0). C’è una relazione positiva (negativa) fra X e Z.

• Se X e Z sono indipendentemente e identicamente distribuite

allora cov(X,Z)=0 (ma non viceversa!!!)

la covarianza di una variabile casuale con se stessa è la sua varianza

cov(X,X)=E[(X-E(X)) (X-E(X))]= σ2X

Digressione:

Il coefficiente di correlazione è definito in termini della varianza

corr ( X , Z ) =

cov( X , Z )

σ XZ

=

= rXZ

var( X ) var( Z ) σ X σ Z

• -1 ≤ corr(X,Z) ≤ 1

• corr(X,Z) = 1 associazione lineare positiva perfetta

• corr(X,Z) = - 1 associazione lineare negativa perfetta

• corr(X,Z) = 0 non c’è associazione lineare

Ora siamo i grado di valutare le proprietà dello stimatore Y

La media e la varianza della distribuzione campionaria di Y

- Media

1 n

1 n

1 n

nµY

E (Y ) = E ( ∑ Yi ) = ∑ E (Yi ) = ∑ µY =

= µY

n i =1

n i =1

n i =1

n

NB il valore atteso di una costante è uguale alla costante stessa

- Varianza

n

1 n

1

Var(Y ) = Var( ∑ Yi ) = 2 Var ∑ Yi

n i =1

n

i =1

1 n

1 n n

= 2 ∑Var(Yi ) + 2 ∑ ∑ cov(Yi , Y j )

n i =1

n i =1 j =1, j ≠i

n 2 σ Y2

= 2 σY =

n

n

NB la varianza di una costante è uguale alla costante al quadrato +

cov(Yi,Yj)=0 + vedi fine par 2.3 media e varianza di somme di due

variabili casuali

Implicazioni:

• Y è uno stimatore corretto di µY , cioè E( Y )=µY

• var( Y ) è inversamente proporzionale a n

• l’ampiezza (distanza dalla media) della distribuzione

campionaria è proporzionale a 1/√n

• dunque l’incertezza campionaria che deriva dal fatto di fare

inferenza su µY usando Y proporzionalmente a 1/√n

Cosa dire dell’intera distribuzione di Y oltre che della media e

varianza? In generale è molto difficile estrarre la distribuzione

campionaria di Y , è complicato perché essa dipende dalla

distribuzione di Y. Tuttavia si nota che al crescere di n la distribuzione

di Y si concentra attorno a µY e dunque l’incertezza campionaria

diminuisce.

Uno stimatore è consistente se la probabilità che esso cada all’interno

di un intervallo che comprende i veri valori della popolazione tende a 1

quanto più la grandezza campionaria cresce.

La legge dei grandi numeri

se (Y1, Y2, … Yn) sono i.i.d. e σ Y2 < ∞ allora Y è uno stimatore

consistente di µY cioè Pr[ | Y - µY| < ε]→1 come n→∞ che può essere

scritto come Y → µY

( Y converge in probabilità verso µY)

Teorema del limite centrale

se (Y1, Y2, … Yn) sono i.i.d. e σ Y2 < ∞ => quando n è grande la

distribuzione di Y è ben approssimata da una distribuzione normale:

σY2

N µ ,

•Y~

n

(Y

− µY )

;

• σY / n

n (Y − µ Y )

σY

~ N(0,1)

• l’approssimazione migliora se n cresce

normale standardizzata

Y − E (Y )

Distribuzione di

var(Y )

Sommario per (Y1, Y2, … Yn) assumendo che sono i.i.d. e σ Y2 < ∞

• la distribuzione campionaria esatta di Y ha media µY e varianza

σY2

n

• a parte media e varianza, l’esatta distribuzione di Y è complicata e

dipende dalla distribuzione di Y

p

→ µY (legge dei grandi numeri)

•Y

Y − E (Y )

•

var(Y ) si distribuisce approssimativamente N(0,1) (teorema

del limite centrale)

Perché usiamo Y per stimare µY ?

• correttezza

E( Y ) = µY

p

→ µY

Y

• consistenza

• Y ha la varianza minore fra tutti gli altri stimatori lineari di µY

(teorema di Gauss-Markov che non abbiamo dimostrato)

Nozioni di probabilità per inferenza statistica

1. stima

2. test

3. test d’ipotesi

4. intervalli di confidenza

Il test d’ipotesi (per le medie) ci aiuta a prendere una decisione: o è

vera l’ipotesi nulla o lo è qualche altra ipotesi alternativa?

H0 : E(Y) = µY,0 vs H1 : E(Y) > µY,0 (ad una coda)

H0 : E(Y) = µY,0 vs H1 : E(Y) < µY,0 (ad una coda)

H0 : E(Y) = µY,0 vs H1 : E(Y) ≠ µY,0 (ad due coda)

p-valore: assumendo che la H0 è vera, il p-valore è probabilità di

ottenere una statistica che sia tanto sfavorevole all’H0 almeno quanto

quella calcolata per mezzo del campione.

p-valore = PrHo[| Y - µY,0|>| Yatt - µY,0|]

dove

Yatt

è il valore di

Y

attualmente osservato (non casuale).

Probabilità di ottenere un valore di Y che, sotto H0, sia diverso da µY,0

almeno quanto lo è Y .

p-valore è l’area nelle code della distribuzione di Y , sotto H0,

corrispondente ai valori esterni all’intervallo | Y att - µY,0|.

Se il p-valore è elevato allora il valore Y è coerente con l’ipotesi

nulla.

att

att

se n è grande possiamo utilizzare l’approssimazione alla normale

dunque

Y − µY

Yatt − µY

PrHo

>

p-value =

σY / n

σ Y / n

≈ probabilità sotto le code destra

e sinistra di una N(0,1)

livello di significatività di un test è la probabilità specificata a priori di

rifiutare non correttamente H0, quando H0 è vera.

Stima della varianza di Y

n

1

2

sY2 =

(

Y

−

Y

)

∑

i

n −1 i=1

di fatto se (Y1, Y2, … Yn) sono i.i.d. e

p

E(Y 4 ) < ∞ , sY2

→

σY2

• la legge dei grandi numeri si applica perché anche sY2 è una media

campionaria, vedi appendice 3.3

• si assume che E(Y 4 ) < ∞ perché la media non è di Yi ma del suo

quadrato, vedi appendice 3.3

Il p-value con sY2 al posto di σY2 è

Y − µY ,0 Yatt − µY ,0

PrH 0

>

sY / n

sY / n

= PrH 0 [ t > tatt ]

≈ probabilità sotto le

code destra e sinistra di una normale

dove

(

Y −µ )

t=

Y ,0

sY / n è la statistica t che già conosciamo

Il p-value e il livello di significatività

con un livello di significatività già specificato a priori (es 5%)

• rifiutiamo se |t|≥1.96

• allo stesso modo rifiutiamo se p≤0.05

• il p-value è a volte chiamato livello di significatività marginale

La distribuzione t-student

se Y è una normale N(µY,σY2) allora da statistica t ha una

distribuzione t-student con gradi di libertà n

per n grandi (n>30) la distribuzione t e la N(0,1) sono molto simili

In questo corso utilizzeremo principalmente questa approssimazione

Nozioni di probabilità per inferenza statistica

5. stima

6. test

7. test d’ipotesi

8. intervalli di confidenza

un intervallo di confidenza al 95% può sempre essere costruito come

un insieme di valori di µY non rifiutati da un test di ipotesi con un

livello di significatività del 5%

(

Y − µY )

Y − µY

≤ 1 . 96 = µ Y : − 1 . 96 ≤

≤ 1 . 96 =

µY :

sY / n

sY / n

sY

sY

, Y + 1 . 96

µ Y ∈ Y − 1 . 96

n

n

il concetto dell’intervallo di confidenza si basa sui risultati visti prima

che presuppongono n grande e dunque che Y sia approssimativamente

p

σY2

normalmente distribuito e che sY2 →

Sommario

Assumendo

1. un campionamento casuale e che (Y1, Y2, … Yn) sono i.i.d.

2. 0 < E(Y4) < ∞

possiamo sviluppato per n grande:

• teoria dello stimatore (distribuzione campionaria di Y )

• teoria del test d’ipotesi (statistica t e p-value)

• teoria dell’intervallo di confidenza (costruita invertendo la

statistica t)

Le assunzioni 1. e 2. sono plausibili in pratica? SI !

Domanda di natura politica:

qual’è l’effetto di ridurre STR di uno studente a classe?

Fino ad ora abbiamo esaminato ∆ = differenza fra le medie, anche se ∆

non risponde propriamente alla nostra domanda.

∆ voti

Saremmo piuttosto interessati a conoscere il valore di ∆ STR che è la

pendenza della retta che mette in relazione i voti con STR

…in qualche modo dobbiamo stimare questa pendenza..

Obiettivo principale del corso:

utilizzare metodi statistici ed econometrici per quantificare gli effetti

causali:

idealmente dovremmo fare uso di dati sperimentali ma nella maggior

parte dei casi faremo riferimento a dati osservati

i principali problemi dei dati osservati sono:

• effetti che confondo le nostre conclusioni (fattori omessi)

• causalità simultanea (STR→ voti o voti→ STR ?)

• correlazione non implica causalità

In questo corso

1. imparerete i metodi di stima degli effetti causali usando dati

osservati;

2. imparerete qualche metodo che può essere utilizzato per qualche

altro scopo, es prevedere serie storiche;

3. vi concentrerete sulle applicazioni empiriche al fine di

comprendere il “perché” di questi metodi;

4. imparerete a fare la vostra analisi empirica e a comprendere

quella che hanno fatto altri;

Tavole della distribuzione t-student

Degrees of Freedom

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

40

60

120

∞

Probability, p

0.1 0.05 0.01 0.001

6.31 12.71 63.66 636.62

2.92

4.3 9.93

31.6

2.35 3.18 5.84 12.92

2.13 2.78

4.6

8.61

2.02 2.57 4.03

6.87

1.94 2.45 3.71

5.96

1.89 2.37

3.5

5.41

1.86 2.31 3.36

5.04

1.83 2.26 3.25

4.78

1.81 2.23 3.17

4.59

1.8

2.2 3.11

4.44

1.78 2.18 3.06

4.32

1.77 2.16 3.01

4.22

1.76 2.14 2.98

4.14

1.75 2.13 2.95

4.07

1.75 2.12 2.92

4.02

1.74 2.11

2.9

3.97

1.73

2.1 2.88

3.92

1.73 2.09 2.86

3.88

1.72 2.09 2.85

3.85

1.72 2.08 2.83

3.82

1.72 2.07 2.82

3.79

1.71 2.07 2.82

3.77

1.71 2.06

2.8

3.75

1.71 2.06 2.79

3.73

1.71 2.06 2.78

3.71

1.7 2.05 2.77

3.69

1.7 2.05 2.76

3.67

1.7 2.05 2.76

3.66

1.7 2.04 2.75

3.65

1.68 2.02

2.7

3.55

1.67

2 2.66

3.46

1.66 1.98 2.62

3.37

1.65 1.96 2.58

3.29