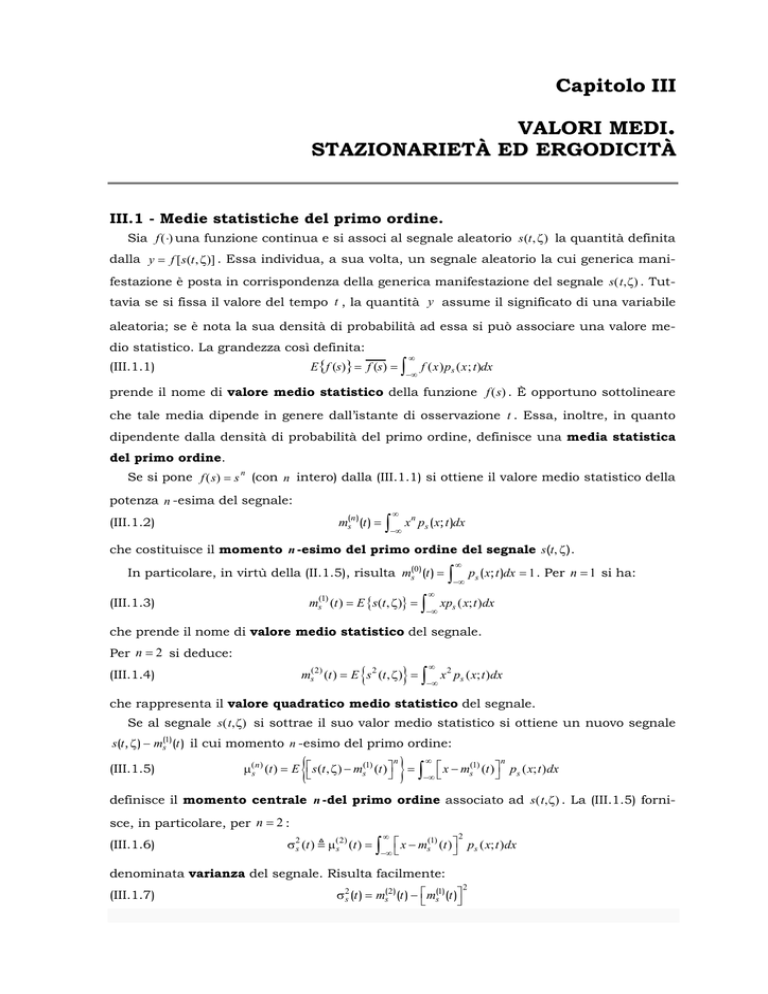

Capitolo III

VALORI MEDI.

STAZIONARIETÀ ED ERGODICITÀ

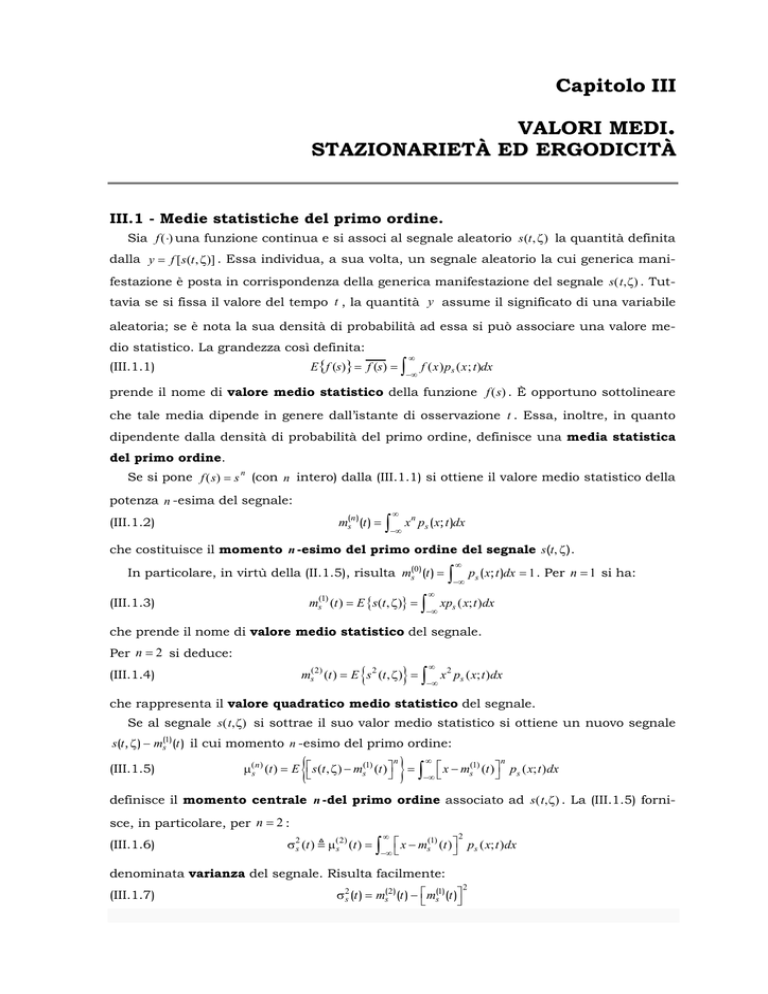

III.1 - Medie statistiche del primo ordine.

Sia f (⋅) una funzione continua e si associ al segnale aleatorio s (t , ζ ) la quantità definita

dalla y = f [ s (t , ζ )] . Essa individua, a sua volta, un segnale aleatorio la cui generica manifestazione è posta in corrispondenza della generica manifestazione del segnale s(t,ζ) . Tuttavia se si fissa il valore del tempo t , la quantità y assume il significato di una variabile

aleatoria; se è nota la sua densità di probabilità ad essa si può associare una valore medio statistico. La grandezza così definita:

E{f (s)} = f (s) = ∫

(III.1.1)

∞

−∞

f (x)ps (x; t)dx

prende il nome di valore medio statistico della funzione f (s) . È opportuno sottolineare

che tale media dipende in genere dall’istante di osservazione t . Essa, inoltre, in quanto

dipendente dalla densità di probabilità del primo ordine, definisce una media statistica

del primo ordine.

Se si pone f (s) = s n (con n intero) dalla (III.1.1) si ottiene il valore medio statistico della

potenza n -esima del segnale:

ms(n )(t ) =

(III.1.2)

∞

∫−∞ x

n

ps ( x; t )dx

che costituisce il momento n -esimo del primo ordine del segnale s(t, ζ) .

In particolare, in virtù della (II.1.5), risulta ms(0 ) (t ) =

ms(1) (t ) = E {s(t , ζ )} =

(III.1.3)

∞

∫−∞ ps ( x; t )dx = 1 . Per n = 1 si ha:

∞

∫−∞ xps ( x; t )dx

che prende il nome di valore medio statistico del segnale.

Per n = 2 si deduce:

{

} ∫

ms(2) (t ) = E s 2 (t , ζ ) =

(III.1.4)

∞

−∞

x 2 ps ( x; t )dx

che rappresenta il valore quadratico medio statistico del segnale.

Se al segnale s(t,ζ) si sottrae il suo valor medio statistico si ottiene un nuovo segnale

s(t, ζ ) − m(s1) (t ) il cui momento n -esimo del primo ordine:

(III.1.5)

{

μ(sn ) (t ) = E ⎡⎣ s (t , ζ ) − ms(1) (t ) ⎤⎦

n

}

=

∞

∫−∞ ⎡⎣ x − ms

(1)

n

(t ) ⎤⎦ ps ( x; t )dx

definisce il momento centrale n -del primo ordine associato ad s(t,ζ) . La (III.1.5) fornisce, in particolare, per n = 2 :

(III.1.6)

σ 2s (t )

μ (2)

s (t ) =

∞

∫−∞ ⎡⎣ x − ms

(1)

2

(t ) ⎤⎦ ps ( x; t )dx

denominata varianza del segnale. Risulta facilmente:

(III.1.7)

σ 2s (t ) = ms( 2 ) (t ) − ⎡⎣ ms(1) (t )⎤⎦

2

-26-

G. Mamola: Fondamenti di Comunicazioni Elettriche

III.2 – Medie statistiche del secondo ordine.

Più in generale dato un segnale s = s(t,ζ) , fissata la n -upla t1,…,tn , può essere individuato un vettore s di variabili aleatorie le cui componenti sono rispettivamente:

s1 = s(t1 , ζ),…, sn = s(tn , ζ) . Alla grandezza x = f (s) dove f (s) denota una funzione definita in

uno spazio n -dimensionale, è possibile associare la media statistica x ponendo:

E { f ( s )} = f ( s ) = ∫

(III.2.1)

n

f ( x ) ps1s2 …sn ( x; t ) dx

dove ps1 s2 … sn (x; t ) indica la densità di probabilità di ordine n del segnale.

In particolare, considerando solo due istanti di tempo t1, t2 la precedente si riduce alla:

E { f ( s1 , s2 )} = f ( s1 , s2 ) = ∫∫

(III.2.2)

2

f ( x1 , x2 ) ps1s2 ( x1 , x2 ; t1 , t2 )dx1dx2

Se si pone f ( s1 , s2 ) = s1p s2q dalla (III.2.2) si ottiene il momento (p + q) -esimo del secondo

ordine del segnale:

{

} ∫∫

ms( p ,q ) (t1 , t2 ) = s1p s2q = E s1p s2q =

(III.2.3)

2

x1p x2q ps1s2 ( x1 , x2 ; t1 , t2 )dx1dx2

In particolare, per p = q = 0 si ottiene ms(0,0) (t1 , t2 ) = 1 e per p = q = 1 fornisce la media

ms(1,1) (t1 , t2 ) detta funzione di autocorrelazione del segnale:

Rs (t1 , t2 ) = ∫∫

(III.2.3)

2

x1 x2 ps1s2 ( x1 , x2 ; t1 , t2 )dx1dx2

Molto spesso è conveniente esprimere la funzione di autocorrelazione in funzione

dell’istante t1 e della differenza t2 − t1 . Ponendo allora t = t1 e τ = t2 − t1 nella (III.2.3), la

funzione di autocorrelazione diventa:

Rs (t , τ) = ∫∫

(III.2.4)

2

x1 x2 ps1s2 ( x1 , x2 ; t , t + τ)dx1dx2

Si possono anche definire dei momenti centrali (p + q) -esimi del secondo ordine:

p

(III.2.5)

q

μ(s p ,q ) (t1 , t2 ) = ⎡⎣ s1 − ms(1) (t1 ) ⎤⎦ ⎡⎣ s2 − ms(1) (t2 ) ⎤⎦ =

=

∞

∫∫ ∫−∞ ⎡⎣ x1 − m1s

(1)

2

p

q

(t1 ) ⎤⎦ ⎡⎣ x2 − ms(1) (t2 ) ⎤⎦ ps1s2 ( x1 , x2 ; t1 , t2 )dx1dx2

in particolare il momento centrale μ(s1,1) prende il nome di autocovarianza denotata con

σ s (t1 ,t2 ) e risulta:

σ s (t1 , t2 ) = Rs (t1 , t2 ) − E {s1} E {s2 }

(III.2.6)

I momenti centrali

μ(s2,0 )

e

μ(s0,2 )

individuano la varianza del segnale calcolata negli i-

stanti t1 e t2 rispettivamente:

μ(2,0)

(t1 ) = σ 2s (t1 ) = ⎡⎣ s1 − ms(1) (t1 ) ⎤⎦

s

(III.2.7)

2

μ(0,2)

(t2 ) = σ2s (t2 ) = ⎡⎣ s2 − ms(1) (t2 ) ⎤⎦

s

2

Anche nel caso di due segnali aleatori distinti x (t) e y(t) , si può definire il valore medio

statistico della funzione f ( x1 , y2 ) mediante la:

(III.2.8)

E { f ( x1 , y2 )} = f ( x1 , y2 ) = ∫∫

2

f ( x, y ) px1 y2 ( x, y; t1 , t2 ) dxdy

essendo rispettivamente x1 e y1 le variabili aleatorie x(t1 , ζ) e y(t2 , ζ) e dove p x1 y2 (x, y; t1 , t2 )

denota la densità di probabilità congiunta dei due segnali.

Il momento incrociato ( p + q) -esimo è allora definito dalla:

(III.2.9)

{

}

E x1p y2q = x1p y2q =

∫∫

2

x p y q px1 y2 ( x, y; t1 , t2 )dxdy

Qualora i segnali siano statisticamente indipendenti risulta evidentemente:

Cap. III – Valori medi. Stazionarietà ed ergodicità

{

-27-

} { } { }

E x1p y2q = E x1p ⋅ E y2q

(III.2.10)

cioè il valore medio del binomio x1p y q2 si ottiene dal prodotto dei valori medi delle quantità

p

q

x1 e y2 .

Se si pone nella (III.2.9) p = q = 1 si ha:

Rxy (t1 , t2 ) = ∫∫

(III.2.11)

2

xypx1 y2 ( x, y; t1 , t2 ) dxdy

che costituisce la funzione di correlazione incrociata o di mutua correlazione associata ai due segnali.

Se si pone nella precedente t = t1 e τ = t2 − t1 si ha

Rxy (t , τ) = ∫∫

(III.2.12)

2

xypx1 y2 ( x, y; t , t + τ)dxdy

e cioè la funzione di mutua correlazione è espressa in funzione dell’istante iniziale t e

della differenza τ .

I momenti centrali ( p + q) -esimi incrociati, sono definiti come segue:

(III.2.13)

( x1 − x1 ) p ( y2 − y2 )q = E {( x1 − x1 ) p ( y2 − y2 )q } =

=

p

q

∫∫ ( x − x1 ) ( y − y2 ) px y ( x, y; t1 , t2 )dxdy

2

1 2

Ponendo p = q = 1 si ha:

(III.2.14)

E {( x1 − x1 )( y2 − y2 )} =

σ xy (t1 , t2 )

= ∫∫

2

( x − x1 )( y − y2 ) px y

1 2

( x, y; t1 , t2 )dxdy

che è la funzione di covarianza incrociata o di mutua covarianza. Si ottiene facilmente:

(III.2.15)

σ xy (t1 , t2 ) = Rxy (t1 , t2 ) − E { x1} ⋅ E { y2 }

Se i segnali sono statisticamente indipendenti risulta Rxy (t1 , t2 ) = E { x1} ⋅ E { y2 } , quindi:

σ xy (t1 , t 2 ) = 0

(III.2.16)

III.3 – Segnali aleatori deterministici.

Una classe particolare di segnali aleatori è costituita dai cosiddetti segnali aleatori deterministici. In essi l’evoluzione della generica manifestazione per t ≥ τ può essere dedotta dalla conoscenza del segnale in t < τ . In generale un segnale di questo tipo è rappresentato da una funzione s (t , v ) in cui v è un n -vettore composto da n variabili aleatorie

definite su uno stesso esperimento casuale caratterizzate da una densità di probabilità

congiunta pv (v1 , v2 ,… , vn ; t1 , t2 ,… , tn ) .

In questo caso il valore medio statistico diventa:

(III.3.1)

il valore quadratico medio:

(III.3.2)

∞

E {s (t , v )} = s (t , v ) =

∫−∞ s(t , v ) pv (v; t )dv

{

∫−∞ s

}

E s 2 (t , v ) = s 2 (t , v ) =

∞

2

(t , v ) pv (v; t )dv

e la funzione di autocorrelazione:

(III.3.3)

Rs (t1 , t2 ) =

∞

∫−∞ s(t1 , v )s(t2 , v ) pv (v; t )dv

-28-

G. Mamola: Fondamenti di Comunicazioni Elettriche

Esempio

Si consideri il segnale

s (t , ϕ) = cos(2πf 0 t + ϕ)

dove ϕ è una variabile aleatoria definita in

[ 0, 2π ) e caratterizzata dalla densità di probabilità

pϕ (ϕ) .

Il valore medio del segnale vale:

∫

π/2

{ } ∫

π/2

E {s} =

il valore quadratico medio:

E s2 =

−π / 2

−π / 2

cos(2πf 0 t + ϕ) pϕ (ϕ) d ϕ

cos 2 (2πf0 t + ϕ) pϕ (ϕ)d ϕ

e la funzione di autocorrelazione:

Rs (t1 , t2 ) =

π/2

∫−π / 2 cos(2πf0t1 + ϕ) cos(2πf0 t2 + ϕ) pϕ (ϕ)d ϕ

Se ϕ è uniformemente distribuita in [ 0, 2π ) le precedenti diventano:

1

∫

2π

{ } = 2π ∫

2π

E {s} =

E s

2

2π

1

0

cos(2πf0 t + ϕ) d ϕ = 0

0

Rs (t1 , t2 ) =

1

∫

cos (2πf0 t + ϕ) d ϕ =

2

1

π/2

2π ∫−π / 2

1 + cos(4πf0 t + 2ϕ)

2π

2

1

cos(2πf 0 t1 + ϕ) cos(2πf0 t2 + ϕ) d ϕ =

2π 0

2π

1

= cos(2πf 0 (t2 − t1 )

2

2π

∫0

dϕ =

1

2

cos(2πf0 (t2 − t1 ) + cos(2πf 0 (t1 + t2 + 2ϕ)

2

dϕ =

III.4 - Stazionarietà.

Un segnale aleatorio s( t) si dice stazionario in senso stretto se le sue funzioni di

probabilità, di qualsiasi ordine dipendono esclusivamente dalla posizione relativa degli

istanti in cui il segnale viene osservato. Cioè se risulta:

ps1…sn ( x1 , x2 , …, xn ; t1 , t2 , …, tn ) =

(III.4.1)

= ps1…sn ( x1 , x2 , …, xn ; t1 + T , t2 + T ,… , tn + T )

∀n ∈ N , ∀T ∈

Se la precedente vale solo n ≤ k , il segnale si dice stazionario all’ordine k .

La condizione (III.4.1) comporta che la densità di probabilità di ordine n dipenda dalle

differenze τ ij = t i − t j fra gli istanti di osservazione.

In particolare per n = 2 si ha:

ps1 ,s 2 (x1 , x2 ; t1 ,t2 ) = ps1 ,s2 ) (x1 , x 2 ; τ)

(III.4.2)

essendo τ = t2 − t1 , mentre la densità di probabilità del primo ordine deve risultare indipendente dal tempo:

(III.4.3)

ps (x;t ) ≡ ps (x)

Si noti che dal momento che la densità di probabilità di ordine n − 1 può essere dedotta da quella di ordine n la stazionarietà all’ordine k comporta quella agli ordini inferiori,

ma non il viceversa.

Una classe importante di segnali è costituita dai segnali stazionari in senso lato. Un

segnale si dice stazionario in senso lato se risulta:

E {s (t , ζ )} = cost

(III.4.4)

E {s (t1 , ζ ) s (t2 , ζ )} = Rs (t2 − t1 )

cioè se il suo valore medio è indipendente dal tempo e se la sua l’autocorrelazione dipende solo dalla differenza fra gli istanti t2 e t1.

Cap. III – Valori medi. Stazionarietà ed ergodicità

{

-29-

}

È evidente che, essendo Rs (0) = E s 2 (t , ζ ) la stazionarietà in senso lato implica che anche il valore quadratico medio non dipende da t .

È opportuno infine osservare che un segnale stazionario in senso stretto lo è anche in

senso lato, ma non viceversa giacché, ad esempio, l’invarianza temporale del momento

del secondo ordine non implica necessariamente quella della corrispondente densità di

probabilità.

III.5 - Medie temporali ed ergodicità.

Le considerazioni sin qui svolte mostrano come è possibile ottenere delle informazioni

su un segnale aleatorio a partire dall’insieme delle sue manifestazioni note che siano le

sue funzioni di probabilità.

In molti casi si hanno a disposizione alcune manifestazioni del segnale (se non una

sola) dalle quali possono dedursi solo quelle informazioni che si ottengono utilizzando le

cosiddette medie temporali.

Se s (t , ζ ) denota la generica manifestazione di un segnale aleatorio, la quantità

≺ f [ s (t , ζ )] = lim

(III.5.1)

1

T →∞ 2T

T

∫−T f [s(t )]dt

se esiste, costituisce la media temporale della funzione f (s) associata alla manifestazione s (t , ζ ) del segnale.

Dalla (III.5.1) possono in particolare dedursi il valore medio temporale:

≺ s (t , ζ ) = lim

(III.5.2)

1

T →∞ 2T

T

∫−T s(t , ζ)dt

e il valore quadratico medio temporale:

(III.5.3)

≺ s 2 (t , ζ ) = lim

1

T →∞ 2T

T

∫−T s

2

(t , ζ ) dt

che esprime la potenza media specifica associata alla manifestazione s (t , ζ ) .

Più in generale si può definire una media temporale associata alla funzione

f [ s (t1 + t , ζ ), s (t2 + t , ζ ), … , s (tn + t , ζ ) ] mediante la:

(III.5.4)

≺ f [ s (t1 + t , ζ ), s(t2 + t , ζ ), …, s(tn + t , ζ )] =

= lim

1

T →∞ 2T

T

∫−T f [s(t1 + t , ζ), s(t2 + t , ζ),…, s(tn + t , ζ)]dt

Dalla (III.5.4) in particolare, ponendo f [ s (t1 + λ, ζ ), s (t2 + λ, ζ ) ] = s (t1 + λ, ζ ) s (t2 + λ , ζ ) si ha:

(III.5.5)

≺ s (t1 + λ, ζ ) s (t2 + λ, ζ ) = lim

1

T →∞ 2T

T

∫−T s(t1 + λ, ζ)s(t2 + λ, ζ)d λ

che, ponendo t = t1 + λ e τ = (t2 + λ ) − (t1 + λ) costituisce l’espressione della funzione di autocorrelazione in media temporale del segnale s (t , ζ ) . Risulta:

(III.5.6)

γ s ( τ, ζ ) = lim

1

T →∞ 2T

T

∫−T s(t , ζ)s(t + τ, ζ)dt

È da notare che, in ogni caso, le medie temporali, fornite dalla (III.5.1) o dalla (III.5.4),

definiscono altrettante variabili aleatorie, dato che esse dipendono dalla manifestazione

del segnale. È quindi possibile calcolare un loro valore medio statistico come segue:

-30-

G. Mamola: Fondamenti di Comunicazioni Elettriche

E {≺ f [ s (t , ζ ) ]

(III.5.7)

}=E

{

lim 1

T →∞ 2T

= lim

1

T →∞ 2T

∫−T f [s(t , ζ)]dt} =

T

T

∫−T E { f [s(t , ζ)]} dt =≺ E { f [s(t , ζ)]}

In maniera analoga, partendo dalla (III.5.4) si perviene alla:

E {∼ f [ s (t1 + t , ζ ), s (t2 + t , ζ ), …, s (tn + t , ζ )] } =

(III.5.8)

=≺ E { f [ s (t1 + t , ζ ), s (t2 + t , ζ ), …, s (tn + t , ζ )]}

Le (III.5.7) e (III.5.8) stanno a significare che le operazioni di media temporale e media

statistica possono essere tra loro permutate.

Le medie temporali, di per sè, non permettono di ottenere delle informazioni di natura

statistica del segnale. Tuttavia esiste una particolare classe di segnali per i quali ogni

proprietà statistica può essere determinata a partire da una qualsiasi manifestazione. In

altri termini, qualsiasi operazione di media effettuata nel tempo su una generica manifestazione conduce agli stessi risultati se si effettua l’operazione analoga sulla base

dell’insieme delle manifestazioni. Un segnale di tale tipo si dice ergodico.

Normalmente si è interessati ad un particolare parametro del segnale (valore medio,

valore quadratico medio o autocorrelazione). Di conseguenza l’ergodicità è formulata limitatamente al parametro in considerazione in quanto se un segnale aleatorio è ergodico

rispetto a certi parametri può non esserlo per altri.

In particolare un segnale si dice ergodico in media quando risulta ≺ s (t , ζ ) = E{s (t , ζ )} e

cioè:

(III.5.9)

1

T →∞ 2T

lim

∞

T

∫−T s(t , ζ)dt = ∫−∞ xps ( x; t )dx

si dice ergodico in funzione di autocorrelazione se ≺ s (t , ζ ) s (t + τ, ζ ) = E{s (t , ζ ) s (t + τ, ζ )} e

cioè:

(III.5.10)

1

T →∞ 2T

lim

∞

T

∞

∫−T s(t , ζ) s(t + τ, )dt = ∫−∞ ∫−∞ x1 x2 ps s ( x1 , x2 ; t , t + τ)dx1dx2

1 2

Affinché la condizione di ergodicità si verifichi, occorre innanzi tutto che le medie temporali non dipendano dalla particolare manifestazione; inoltre è necessario che le medie

statistiche a secondo membro delle (III.5.9) non dipendano da t e quelle definite dalla

(III.5.10) dipendano solo da τ . Ciò comporta che perchè un segnale aleatorio sia ergodico

è necessario che sia stazionario almeno in senso lato.

Poiché ponendo nella (III.5.10) τ = 0 si ottiene:

(III.5.11)

1

T →∞ 2T

lim

T

∫−T s

2

(t , ζ )dt = ∫

essendo lim ps1s2 ( x1 , x2 ; t , t + τ) = ps1 ( x1 ; t )δ( x2 − x1 )

τ→0

∞

−∞

1

x 2 pS ( x; t ) dx

la condizione di ergodicità rispetto al valo-

re quadratico medio discende da quelle dell’autocorrelazione.

1 Si tengano presenti le (II.2.17) e (II.2.18) del Cap. II.