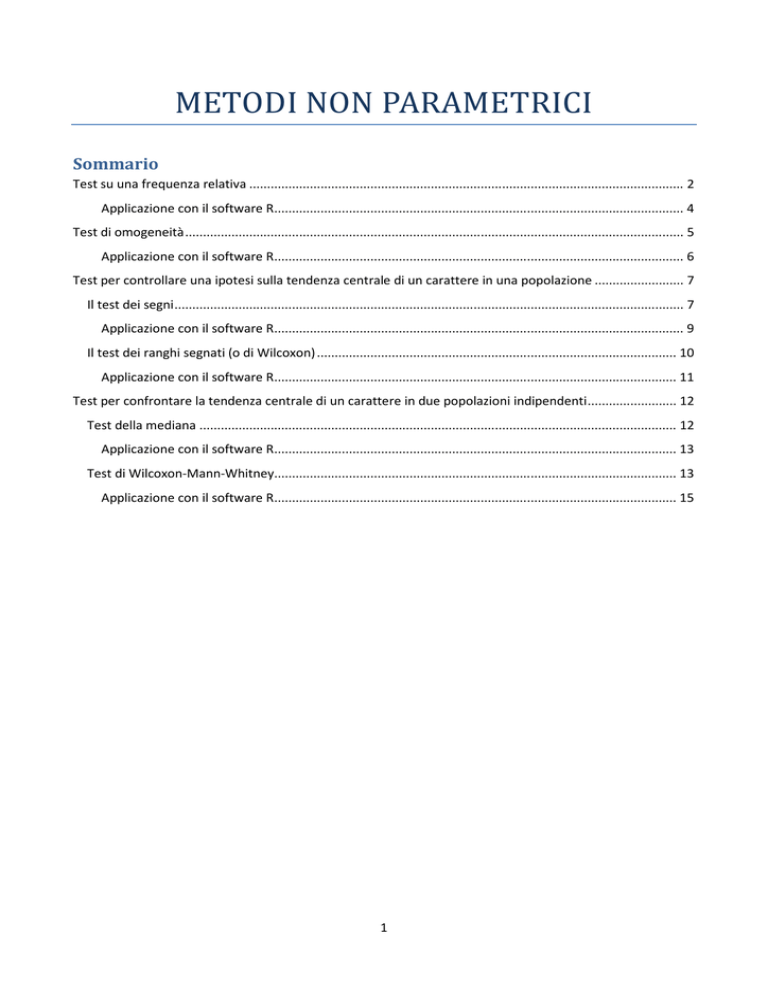

METODI NON PARAMETRICI

Sommario

Test su una frequenza relativa .......................................................................................................................... 2

Applicazione con il software R................................................................................................................... 4

Test di omogeneità ............................................................................................................................................ 5

Applicazione con il software R................................................................................................................... 6

Test per controllare una ipotesi sulla tendenza centrale di un carattere in una popolazione ......................... 7

Il test dei segni ............................................................................................................................................... 7

Applicazione con il software R................................................................................................................... 9

Il test dei ranghi segnati (o di Wilcoxon) ..................................................................................................... 10

Applicazione con il software R................................................................................................................. 11

Test per confrontare la tendenza centrale di un carattere in due popolazioni indipendenti ......................... 12

Test della mediana ...................................................................................................................................... 12

Applicazione con il software R................................................................................................................. 13

Test di Wilcoxon-Mann-Whitney................................................................................................................. 13

Applicazione con il software R................................................................................................................. 15

1

METODI NON PARAMETRICI

Sia X la variabile su cui si vuole fare inferenza a partire da un campione C.

I metodi di inferenza parametrici si basano sulla specificazione di un modello distributivo per la variabile su

cui si vuole fare inferenza; in particolare, tali metodi richiedono che sia nota la forma distributiva della

popolazione di riferimento per trovare la forma distributiva della statistica test campionaria (ad esempio il

test t per la media, che richiede la normalità).

I metodi di inferenza non parametrici (o distribution free methods) invece non sono vincolati dalla

specificazione di un modello distributivo parametrico e sono validi a prescindere dalla numerosità n del

campione.

Test su una frequenza relativa1

Supponiamo di voler fare inferenza su una particolare caratteristica di una popolazione virtualmente

infinita (es. pazienti sofferenti di emicrania). Ciò a cui si è interessati è la probabilità p che il farmaco A sia

preferito al farmaco B. L’ipotesi nulla è dunque H0: p=0.5 e supponiamo di aver osservato il dato empirico

f=8/10. Il test che viene adoperato è il test binomiale.

In generale, dati un campione C di numerosità n, composto dai risultati di n prove di Bernoulli e verificato

che:

1. ogni prova ammette solo due possibili esiti, classificabili come successo S e come insuccesso I;

2. la probabilità di successo resta costante da prova a prova (eg. la popolazione considerata è

omogenea al suo interno rispetto alla caratteristica d’interesse);

3. le n prove sono fra loro indipendenti (eg. la popolazione è virtualmente non finita)

Sulla base della frequenza relativa di successo f osservata nel campione, l’obiettivo è quello di sottoporre a

controllo un’ipotesi sull’incognita probabilità di successo H0: p=p*.

•

•

•

Per l’assunzione 1, la variabile aleatoria associata all’i-esima unità statistica è così definita:

1 successo 0 insuccesso

Per l’assunzione 2, 1 e 0 1 , .

Dalle assunzioni 2 e 3:

~ , Il dato osservato f=0.8 è una realizzazione di ! 1

∑%

$&' #$

Non esiste l’alternativa parametrica a questo test.

2

) !~ , .

(

Ciò che caratterizza la veridicità di H0 è la distribuzione della frequenza relativa sotto H0. Occorre valutare se

ciò che si è osservato abbia una probabilità di verificarsi sufficientemente grande da giudicare vera (o

meno) H0.

Il p-value è la probabilità di osservare sotto H0 esiti uguali o più estremi a quello osservato. Nell’esempio

considerato

! * 0.8 |./ ! 0.8 |./ 0 ! 0.9 |./ 0 ! 1 |./ 10

10

10

2 3 0.55 · 0.57 0 2 3 0.58 · 0.5 0 2 3 0.5/ · 0.5/

8

9

10

0.099

Se il test è bilaterale e si vuole valutare ad un livello di significatività 9 0.05, si ha 0.099 : 0.025 9/2;

per cui non si ha sufficiente evidenza empirica tale da confutare l’ipotesi nulla.

Comportamento asintotico

Per ) ∞, si ha che )> ~?@, 1 A, e quindi

!)> ~? B,

Il p-value:

1 C

p‐value ! * I | ./ dato che

O

N

! M

M

M

P 1 *

!|./ ~? BM ,

M 1 M C

I M

R S * TU M 1 M Q

Il test Z non è altro che la versione asintotica del test binomiale.

Il problema affrontato poteva esser risolto anche in un altro modo, sotto forma di distribuzione di

frequenza:

Osservato

0

1 I

1

I

Atteso

0

1 M 1

M

Per testare l’ipotesi nulla si può confrontare la distribuzione empirica con quella teorica impiegando il test

χ2. Le uniche assunzioni del test χ2 sono che n deve essere sufficientemente elevato e le frequenze teoriche

devono essere ≥5.

Riassumendo: Per testare una frequenza relativa si possono utilizzare:

•

•

Test BINOMIALE: qualunque sia il valore di n

Test NORMALE: per n sufficientemente elevato

3

•

Test CHI-QUADRATO: equivalente al test normale, impiegabile per n sufficientemente grande e

solo con frequenze teoriche ≥5.

Applicazione con il software R

In una popolazione, l’allele maggiormente diffuso viene indicato come selvatico o wild-type; gli alleli

alternativi sono invece detti mutanti.

Un genetista, impegnato nello studio di una determinata caratteristica, prende in esame una progenie di 9

individui. I fenotipi osservati nel collettivo sono 8 di tipo wild e 1 di tipo mutante; lo studioso, però, si

aspettava un rapporto di 3:1 tra i due fenotipi e quindi si domanda se la differenza tra il fenotipo osservato

e quello atteso sia o meno significativa.

Indicando come ‘successo’ il fenotipo mutante, si ha il seguente sistema di ipotesi:

./ : 1⁄4 0.25

. : Y 1⁄4

La frequenza osservata f =1/9

In R il test binomiale si ottiene con la funzione binom.test:

>?binom.test

binom.test(x, n, p = 0.5,

alternative = c("two.sided", "less", "greater"),

conf.level = 0.95)

Tale funzione richiede come argomenti il numero x di successi, le n prove, la probabilità dell’ipotesi nulla (di

default uguale a 0.5), il tipo di test (se a due code o a una coda) e il livello di confidenza.

Tornando all’esempio considerato:

> binom.test(1,9,p=0.25,alternative="two.sided")

Exact binomial test

data: 1 and 9

number of successes = 1, number of trials = 9, p-value = 0.4661

alternative hypothesis: true probability of success is not equal to 0.25

95 percent confidence interval:

0.002809137 0.482496515

sample estimates:

probability of success

0.1111111

Il p-value è uguale a 0.4661, e dunque non si rifiuta l’ipotesi nulla, l’esito sperimentale è compatibile con un

teorico rapporto 3:1 tra i due fenotipi.

Si assuma ora che il genetista abbia osservato 90 casi (invece di 9), di cui 80 con fenotipo wild e 10 con

fenotipo mutante. Vediamo quindi cosa succede al test binomiale per n grande:

> binom.test(10,90,p=0.25,alternative="two.sided")

Exact binomial test

data: 10 and 90

number of successes = 10, number of trials = 90, p-value = 0.001429

alternative hypothesis: true probability of success is not equal to 0.25

95 percent confidence interval:

0.0545856 0.1948586

sample estimates:

4

probability of success

0.1111111

Il p-value è ora uguale a 0.001429 dunque l’ipotesi alternativa non è rifiutata: o si è verificato un evento

raro o il rapporto tra i due fenotipi è significativamente diverso da 3:1.

Si può infine andare a valutare l’eventuale differenza tra il p-value del test binomiale e il p-value ottenibile

dal test normale Z:

> Z<-(10/90-1/4)/sqrt(0.25*0.75/90)

> Z

[1] -3.042903

> pnorm(Z)

[1] 0.001171539

I due valori sono leggermente diversi, ma conducono alla stessa conclusione riguardo il sistema di ipotesi.

Dato però che il test binomiale è esatto, mentre quello normale fornisce un valore del p-value

approssimato, è sempre preferibile usare il test binomiale anche per campioni grandi.

Test di omogeneità

Il test di omogeneità si utilizza per confrontare 2 o più distribuzioni uni variate e per stabilire se siano tra

loro significativamente diverse. Per capire l’impiego del test si consideri il seguente esempio:

In due campioni di telespettatori, rispettivamente composti da 175 maschi e 230 femmine, le percentuali di

coloro che hanno dichiarato di apprezzare una trasmissione sportiva in onda la domenica pomeriggio sono

risultate pari a 81% per i maschi e a 77% per le femmine. Ci si chiede se il gradimento sia diverso nei due

sessi.

C1

Soddisfatti

142

Insoddisfatti 33

175

C2

177

53

230

L’ipotesi da testare è dunque:

319

86

./ : 7 ma la probabilità è incognita e occorre stimarla. Per farlo si possono

mettere insieme i due campioni che, sotto l’ipotesi nulla, sono omogenei:

I ̂ %

%''

\ '] %[' [' %[] []

[' \[]

Dato che ̂ '[

'' \'] ['

\

[]

'[

le frequenze attese sotto ./ :

è possibile costruire una tavola analoga che conterrà

Soddisfatti

Insoddisfatti

C1

7

/

C2

7

77

/7

/

7/

C1

C2

/

/

/

/

/ 0 /7 Soddisfatti

/ ·

/7 ·

·

/

/

/

/

/

7/

Insoddisfatti / · ^1 _ /7 · ^1 _

/ 0 /7 ^1 _ · ^1 _·

7/

/

/7

5

Confrontando le due tavole, quella della distribuzione empirica e quella della distribuzione teorica, si

possono calcolare le statistiche χ2 per i due campioni

∑7

∑7

]

χ2 calcolato con riferimento al campione 1

]

χ2 calcolato con riferimento al campione 2

M

@$' `$'

A

M

$'

M

@$] `$]

A

M

$]

Sommando queste due statistiche si ottiene:

∑7

7

c ∑ a

]

M

@$' `$'

A

M

$'

bd ./ : 7 Sotto ./ , se n è sufficientemente elevato e con frequenza teorica ≥5, ciascuna somma per ogni campione si

distribuisce come un χ2(1). Siccome i due campioni sono indipendenti per ipotesi, anche i χ2 dei due

campioni sono indipendenti; per la proprietà di riproducibilità rispetto alla somma, la somma di variabili χ2

indipendenti è ancora una variabile χ2 con gradi di libertà pari alla somma degli stessi.

La nuova statistica test dunque si distribuirebbe come un χ2(2), ma siccome i gradi di libertà diminuiscono

con l’introduzione di parametri stimati nella formula (e si è stimato il valore di ), i gradi di libertà sono in

realtà 2-1=1.

Questo test è detto test di omogeneità o χ2 di omogeneità, e serve per confrontare due o più distribuzioni

uni variate.

Nel particolare caso di distribuzioni 2×2, si ha una forma semplificata del test:

χ7 77 7 7 7

/ /7 / 7/

È possibile dimostrare che il test χ2 è perfettamente uguale al quadrato del test normale per il confronto di

due frequenze relative, χ2(1)=Z2.

Applicazione con il software R

In R il test di omogeneità si ottiene con la funzione chisq.test:

>?chisq.test

chisq.test(x, y = NULL, correct = TRUE,

p = rep(1/length(x), length(x)), rescale.p = FALSE,

simulate.p.value = FALSE, B = 2000)

Tale funzione richiede come argomento la matrice dei dati e un valore logico per indicare la correzione per

la continuità. Vediamo di seguito il caricamento dei dati e la costruzione della distribuzione doppia con l’uso

del comando table:

> dati<-read.table("c:\\temp\\soddisfazione.txt",header=TRUE)

> Y<-table(dati)

> Y

6

Sesso

Giudizio

Insoddisf

Soddisf

F

M

53

33

177 142

> chisq.test(Y,correct=FALSE)

Pearson's Chi-squared test

data:

Y

X-squared = 1.0414, df = 1, p-value = 0.3075

Il p-value indica che non è possibile rifiutare l’ipotesi nulla, per cui le due distribuzioni possono considerarsi

significativamente omogenee.

Test per controllare una ipotesi sulla tendenza centrale di un carattere in

una popolazione

Un istituto di credito vuole aprire una nuova filiale in un quartiere periferico di una grande città, ma lo farà

solo se il reddito mediano delle famiglie della zona è superiore ai 50 milioni. Per verificarlo esamina il

reddito di un campione di 50 famiglie ottenendo i seguenti risultati (in milioni):

48

51

63

80

45

50

61

88

42

36

52

64

56

59

54

I dati suggeriscono l’apertura di una nuova filiale? La mediana del campione è 54, occorre però controllare

se la mediana in popolazione sia significativamente maggiore di 50:

H0: me=50

H1: me>50

Dato un campione costituito da n osservazioni, x1, x2,…, xn, e verificato che

1. le variabili aleatorie xi sono tra loro stocasticamente indipendenti

2. le variabili aleatorie xi hanno la medesima mediana θ:

1

f g : g ,

2

1, … , L’obiettivo è quello di testare l’ipotesi ./ : g g M ; a tale scopo, si considerino due strumenti:

•

•

il test dei segni

il test dei ranghi segnati (o test di Wilcoxon)

Il test dei segni

Il test dei segni è uno dei test più antichi e non lavora sui valori di X ma sui corrispondenti segni delle

differenze dalla mediana.

Definiamo le variabili aleatorie ψi come

7

1

ψ j

0

se g M : 0

se g M f 0

1, 2, … . , Si costruiscono quindi n variabili aleatorie che indicano se le osservazioni sono maggiori o minori della

mediana. Per costruzione siamo costretti a tralasciare le unità statistiche che portano un valore del

carattere uguale a g M (di conseguenza n rischia di ridursi).

Caratteristiche:

•

•

•

•

Le variabili sono indipendenti per ipotesi. Di conseguenza, anche le ψ sono indipendenti

ψ ~k!@ : g M A

Se ./ è vera, cioè se g g M, allora le variabili aleatorie ψ ~k! ^ _ , per 1, … , Se si considera la variabile ψ ∑mn ψ |./ ~ ^, 7_

7

Dunque sotto l’ipotesi nulla, la distribuzione di probabilità delle osservazioni è nota; la statistica test che si

andrà ad utilizzare è proprio ψ, che non fa altro che contare il numero di segni positivi.

Il test viene quindi ricondotto ad un semplice test su una frequenza relativa (test binomiale), perché è come

dire che la probabilità dei segni positivi è uguale a 0.5:

./ : 0.5

Tornando all’esempio di partenza:

n=14 (una osservazione si toglie perché uguale a g M 50)

ψ=10 (n. di osservazioni >50)

Data l’ipotesi nulla sopra indicata, si procede a calcolare il p-value

o * 10 |./ o 10 | 0.5 0 o 11 | 0.5 0 p 0 o 14 | 0.5

14

14

2 3 0.5/ 0.5q 0 p 0 2 3 0.5q 0.5/

10

14

0.5

q

q

2

s/

14

3 0.09

r

P-value=0.09 > 0.01=α → L’ipotesi ./ non viene rifiutata, la presenza di 10 valori superiori alla soglia g M in

un campione di 14 unità statistiche rientra negli effetti dell’errore di campionamento.

Comportamento asintotico

Sfruttando la convergenza della distribuzione binomiale alla normale per grandi campioni:

∑ o 7

Pq

|./ ~)> ?0,1

Il test dei segni sfrutta solo una minima parte delle informazioni contenute nei dati, in quanto tiene conto

solo della posizione sotto/sopra rispetto a g M ma non tiene conto della differenza, di quanto sia “lontana”

un’osservazione in termine di posizione nella graduatoria ordinata.

8

Applicazione con il software R

Vediamo come risolvere l’esempio precedente (dati sui redditi di 15 famiglie in base ai quali la banca deve

decidere se aprire una nuova filiale) con l’ausilio del software R.

L’ipotesi nulla è che il reddito mediano dei residenti nella zona sia 50. L’ipotesi alternativa è che esso sia

maggiore di 50. Le due ipotesi si possono riformulare in termini di probabilità di osservare un’osservazione

maggiore di 50, cioè probabilità di osservare un “segno” positivo (chiamiamo tale probabilità p+):

H0: p+ = 1/2

H1: p+ > 1/2

Si inseriscono dunque i dati in R (tralasciando l’unità che porta il valore 50):

> x<-c(48,51,63,80,45,61,88,42,36,52,54,56,59,54)

e si ricava per ciascuna osservazione l’informazione sul fatto che essa sia o meno maggiore di 50:

> segno.pos<-x-50>0

> segno.pos

[1] FALSE

[12] TRUE

TRUE

TRUE

TRUE FALSE

TRUE

TRUE FALSE FALSE

TRUE

TRUE

TRUE TRUE

Si costruisce dunque la distribuzione di frequenza:

> y<-table(segno.pos)

> y

segno.pos

FALSE

TRUE

4

10

e si applica infine il test binomiale

> binom.test(10,14,p=0.5,alternative="g")

Exact binomial test

data:

10 and 14

number of successes = 10, number of trials = 14, p-value = 0.08978

alternative hypothesis: true probability of success is greater than 0.5

95 percent confidence interval:

0.4599946 1.0000000

9

sample estimates:

probability of success

0.7142857

Il test dei ranghi segnati (o di Wilcoxon)

Date n osservazioni X1, X2, …,Xn di un carattere continuo X e sia verificato che:

1. le variabili aleatorie Xi siano fra loro stocasticamente indipendenti

2. le variabili aleatorie Xi si distribuiscano simmetricamente attorno alla comune mediana θ.

Anche in questo caso, l’ipotesi nulla da controllare è

./ : g g M

Al fine di comprendere la costruzione e l’impiego del test si consideri il seguente esempio:

Sono date n=8 osservazioni di un carattere quantitativo continuo, con distribuzione simmetrica attorno alla

propria mediana θ:

187

224

241

297

385

472

505

646

La statistica tu è la somma dei ranghi corrispondenti a segni positivi (→ranghi SEGNATI), mentre t è la

somma dei ranghi corrispondenti a segni negativi.

Se g M : g ci si aspetterebbe che tu > t ; le due statistiche sono legate dalla relazione

tu 0 t quindi ragionare in termini di tu o t è la stessa cosa.

0 1

2

Se invece g M f g ci si aspetterebbe che tu <t , e se infine g M g ci si aspetterebbe che tu v t .

Wilcoxon pensò quindi di utilizzare tu come statistica test per decidere le sorti di ./ . I valori riportati nelle

tavole però si riferiscono al più piccolo valore fra t e tu :

tU min@t , tu A

e indicano il massimo valore che, in un campione di n unità statistiche, tale quantità può assumere per

portare al rifiuto di ./ .

Comportamento asintotico

È possibile dimostrare che il valore atteso e la varianza della statistica test tu sotto H0 sono:

xytu |./ z 0 1

4

{|!ytu |./ z 10

0 12 0 1

24

Per grandi campioni, il teorema centrale del limite secondo la versione di Liapurov (in cui le variabili sono

indipendenti ma non identicamente distribuite) assicura la convergenza della statistica test alla

distribuzione normale:

0 1 0 12 0 1

tu |./ ~)> ? B

,

C

4

24

0 1

4

P 0 12 0 1

24

tu }} ./ ~)> ?0 ,1

Applicazione con il software R

Vediamo ora come risolvere l’esempio precedente (dati fittizi) con l’ausilio del software R.

Per prima cosa si procede con l’inserimento dei dati

> x<-c(646,241,472,385,297,505,224,187)

Il test di Wilcoxon è implementato nella funzione wilcox.test:

> ?wilcox.test

wilcox.test(x, y = NULL,

alternative = c("two.sided", "less", "greater"),

mu = 0, paired = FALSE, exact = NULL, correct = TRUE,

conf.int = FALSE, conf.level = 0.95, ...)

La funzione prende come argomenti il vettore x dei dati, l’ipotesi nulla sulla mediana mu e la specificazione

della tipologia di ipotesi alternativa. In questo caso vogliamo valutare la coda di sinistra, e quindi il sistema

d’ipotesi :

./ : g 430

. : g f 430

In R

> wilcox.test(x,mu=430,alternative="l")

Wilcoxon signed rank test

data:

x

V = 11, p-value = 0.1914

alternative hypothesis: true location is less than 430

Dato il valore del p-value uguale a 0.1914>0.05=α, l’ipotesi nulla non viene rifiutata.

Il valore V della statistica coincide con la somma dei ranghi corrispondenti a segni positivi.

11

Test per confrontare la tendenza centrale di un carattere in due

popolazioni indipendenti

Per confrontare le tendenze centrali in due campioni indipendenti il test che si utilizza in ambito

parametrico è il test t di Student:

' \] `7 r r7

u P

1

1

0

7

7 1 0 77 7 1

u

0 7 2

Tale statistica test ha però alla base due assunzioni molto forti:

•

•

omoschedasticità

~? in entrambe le popolazioni: ~? , 7 ~?7 , 7 , con 7

Vediamo nel seguito quali possono essere le alternative non parametriche al test t.

Si considerino due collettivi

e

7 tali che:

Test della mediana

•

•

•

: realizzazione di variabili aleatorie , 7 , … , ' indipendenti e con la stessa mediana g

7 : realizzazione di 7 variabili aleatorie 7 , 77 , … , 7] indipendenti e con la stessa mediana g7

Le variabili dei due campioni sono tra loro indipendenti (eg. non appaiati )

7 ,

L’ipotesi da saggiare è ./ : g g7 g

1, … , 1, … , 7

Se l’ipotesi nulla è vera, i due campioni provengono da 2 popolazioni omogenee rispetto alla tendenza

centrale (i.e. la mediana).

Per stimare g si possono quindi mettere insieme i due campioni, ordinarli e individuare quindi la mediana.

Se l’ipotesi da testare è vera ci si aspetta che in ciascuno dei due campioni circa la metà delle osservazioni

sarà superiore (o inferiore) alla mediana stimata. Se l’ipotesi invece non è vera ci si aspetta una

preponderanza di osservazioni superiore (o inferiore) alla mediana complessiva stimata.

Di seguito viene rappresentata la situazione in forma tabellare

: g

f g

7

/

7

7

77

/7

/

7/

Per costruzione

'[

][

7 perché g è la mediana delle osservazioni.

Ciò che occorre controllare è che

']

[]

''

['

non sia significativamente diverso da

e che entrambi non siano significativamente diversi da 7 .

L’ipotesi da testare diventa dunque: ./ : 7 7 , dove @ : gA e 7 @7 : gA .

Messa in questo modo, ./ è riconducibile ad un test per il confronto tra due proporzioni; per n

sufficientemente grande si può utilizzare il test 7 di omogeneità.

12

Applicazione con il software R

Si consideri il dataset scolarita_freq.txt contenente il grado di scolarità (I,II,III,IV) delle madri di

alcuni alunni e la frequenza delle loro visite volontarie a scuola, utilizzata come misura dell’interesse al

rendimento dei rispettivi figli.

Per valutare la significatività di questa relazione si utilizza il test della mediana, costruendo la tavola 2x4 e

calcolando il test 7 di omogeneità.

x<-read.table(“c:\\temp\\scolarita_freq.txt”,header=TRUE)

La mediana del numero di visite si ottiene:

> mediana.tot<-median(x[,1])

> mediana.tot

[1] 2.5

Costruiamo la distribuzione doppia delle frequenze osservate con il comando table:

> y<-table(x[,1]<2.5,x[,2])

> y

I II III IV

FALSE 5

4

7

6

TRUE

7

6

4

5

Applichiamo ora il test 7 di omogeneità

> chisq.test(y)

Pearson's Chi-squared test

data:

y

X-squared = 1.2951, df = 3, p-value = 0.7303

Non ci sono elementi sufficienti a rifiutare l’ipotesi nulla e quindi per sostenere che ci sia una relazione

significativa tra il grado di scolarità della madre e la frequenza di visite alla scuola.

Test di Wilcoxon-Mann-Whitney

Quando il carattere X è continuo, il test della mediana comporta una perdita di informazioni. Per questo

motivo, in quei casi è possibile utilizzare un test alternativo: il test di Wilcoxon-Mann-Whitney.

Tale test ha però delle assunzioni più restrittive rispetto al test della mediana. Per capire la sua costruzione

ed il suo impiego partiamo da un esempio.

13

Esempio. Si è misurata la diffusione di acqua contenente trizio attraverso un tessuto della placenta in due

collettivi di donne: il primo è costituito da 10 gestanti al termine della gravidanza, mentre il secondo è

costituito da 5 donne esaminate dai 3 ai 6 mesi dopo l’interruzione di gravidanza. I dati:

7

0.80 0.83 1.89 1.04 1.45 1.38 1.91 1.64 0.73 1.46

1.15 0.88 0.90 0.74 1.21

Il modello alla base del test è di tipo location shift, cioè una situazione in cui il fattore che distingue i due

campioni comporta unicamente una traslazione (qualora questo fattore esista) di X nel passare da una

popolazione all’altra, senza alterare la forma distributiva della variabile.

Tale modello, oltre a presupporre che le variabili hanno la stessa mediana così pure le 7 variabili,

richiede che:

1, … , siano IID, F(∙)

7 1, … , 7 siano IID, G(∙)

L’ipotesi da testare è:

./ : r,

. : ∆, dove ∆ è il location shift, ∆ 0

Se H0 è vera F(X)=G(X), i due campioni provengono dalla medesima popolazione (nel caso del test della

mediana le due popolazioni erano omogenee rispetto alla mediana ma comunque distinte).

Mettendo insieme i due campioni

•

•

Se H0 è vera ci si aspetta di trovare lo stesso “miscuglio” di ranghi alti e bassi

Se H0 è falsa, in un campione si avrà una prevalenza di ranghi alti (o bassi)

Tornando all’esempio, assegniamo i ranghi alle osservazioni:

X1

0.80

0.83

1.89

1.04

1.45

1.38

1.91

1.64

0.73

1.46

Ri

3

4

14

7

11

10

15

13

1

12

X2

1.15

0.88

0.90

0.74

1.21

Si considerino le due quantità

t somma dei ranghi del primo campione

t 0 t7 Ri

8

5

6

2

9

t7 somma dei ranghi del secondo campione

0 7 0 7 0 1

2

somma dei primi nn1 0n2 numeri naturali

14

In analogia con quanto visto per un solo campione, la statistica test è rappresentata dalla più piccola fra S1 e

S2. Spesso le tavole sono riferite alle statistiche di Mann-Whitney U1 e U2, che sono delle semplici

trasformazioni monotone di S1 e S2. Si ha infatti infatti:

t 0 1

2

e

7 t7 7 7 0 1

2

e quindi la statistica test da utilizzare per un test a due code è: U min , 7 .

Applicazione con il software R

Vediamo ora come risolvere l’esempio precedente (misura della presenza di trizio tra donne la cui

gravidanza è giunta al termine e tra le donne che si trovano dai 3 ai 6 mesi dall’interruzione di gravidanza)

con l’ausilio del software R.

Per prima cosa si procede con il caricamento dei dati:

> x<-read.table("c:\\temp\\gravidanza.txt",header=TRUE)

> x

VAR00001 VAR00002

1

0.80

at_term

2

0.83

at_term

3

1.89

at_term

4

1.04

at_term

5

1.45

at_term

6

1.38

at_term

7

1.91

at_term

8

1.64

at_term

9

0.73

at_term

10

1.46

at_term

11

1.15

3-6_mon

12

0.88

3-6_mon

13

0.90

3-6_mon

14

0.74

3-6_mon

15

1.21

3-6_mon

Il test di Wilcoxon-Mann-Whitney si ottiene con la funzione wilcox.test:

> ?wilcox.test

wilcox.test(x, y = NULL,

alternative = c("two.sided", "less", "greater"),

15

mu = 0, paired = FALSE, exact = NULL, correct = TRUE,

conf.int = FALSE, conf.level = 0.95, ...)

Tale funzione richiede come argomenti i dati dei due collettivi x e y, e il tipo di ipotesi alternativa. Volendo

specificare un test a una coda di tipo “greater”:

> wilcox.test(x[1:10,1],x[11:15,1],alternative="g")

Wilcoxon rank sum test

data: x[1:10, 1] and x[11:15, 1]

W = 35, p-value = 0.1272

alternative hypothesis: true location shift is greater than 0

La statistica test W prodotta dal software coincide con il valore di , la somma dei ranghi nel primo

campione diminuita di

' ' \

.

7

Il p-value è più grande del livello di significatività α fissato e dunque l’ipotesi nulla non può essere rifiutata.

16