SPETTRO DI POTENZA DI UN PROCESSO STOCASTICO

I segnali aleatori vengono comunemente denominati processi stocastici. Per un processo stocastico

non è definibile, e dunque calcolabile, la trasformata di Fourier. La ragione di ciò è qualitativamente

evidente: la trasformata di Fourier presuppone la conoscenza (se non in forma analitica esplicita,

almeno in termini di sequenza numerica) dell’andamento del segnale. Questo è sempre possibile,

fermi restando i limiti di applicabilità della trasformata, per un segnale determinato, la cui

evoluzione temporale è nota ed univocamente assegnata, mentre non è possibile per un processo

stocastico, la cui evoluzione temporale può solo essere descritta statisticamente.

Quanto sopra osservato, comunque, non implica che per un processo stocastico non sia

individuabile una descrizione in frequenza; semplicemente non si tratterà della trasformata di

Fourier del segnale ma di un’altra funzione, che chiameremo “spettro di potenza del processo”, e la

cui utilizzazione pratica, ad esempio ai fini della valutazione della banda occupata, avrà molte

similitudini con quella della classica trasformata.

Per introdurre appropriatamente il concetto di spettro di potenza (o “densità spettrale di potenza”) di

un processo stocastico, è preliminarmente opportuno ricordare alcune definizioni e proprietà di

validità generale.

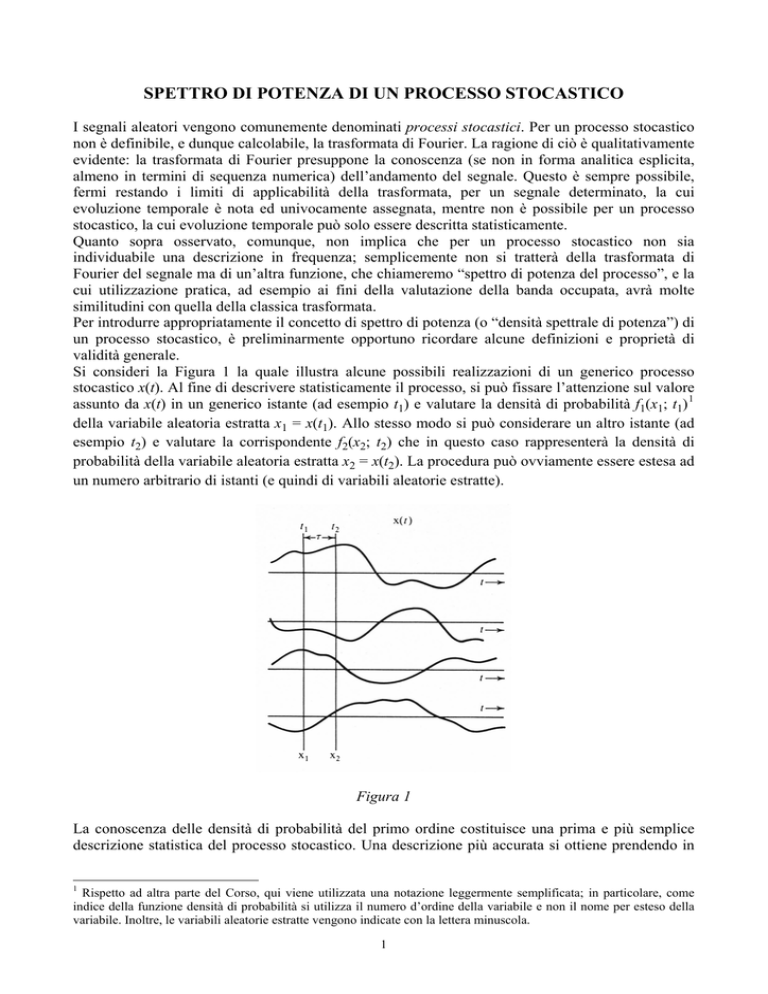

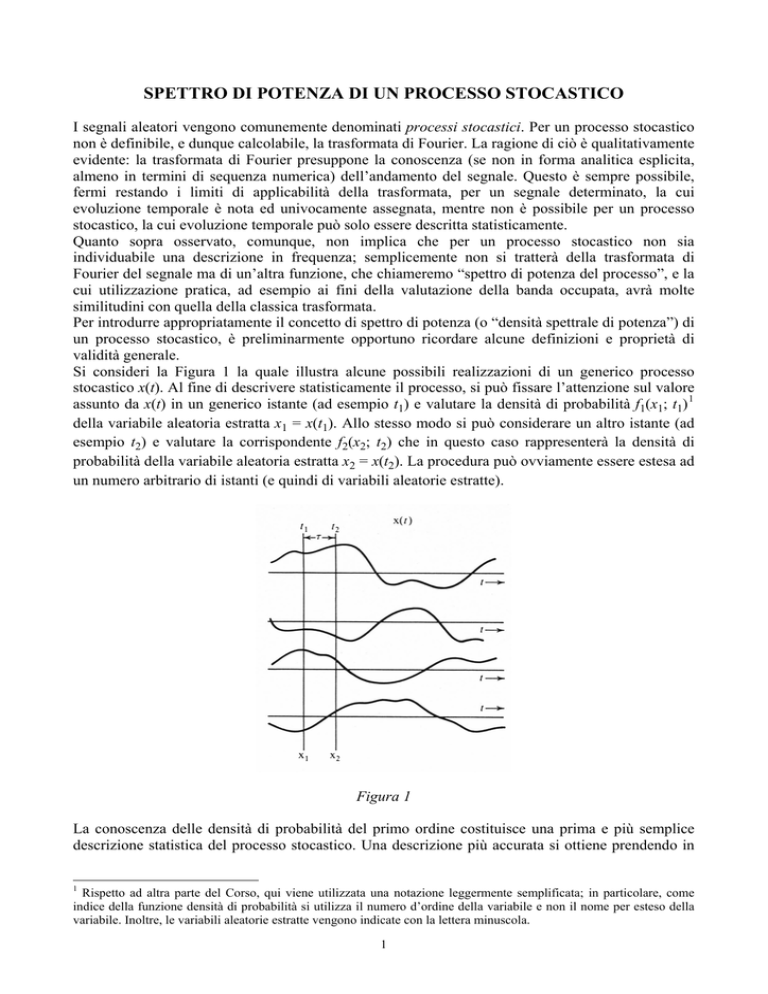

Si consideri la Figura 1 la quale illustra alcune possibili realizzazioni di un generico processo

stocastico x(t). Al fine di descrivere statisticamente il processo, si può fissare l’attenzione sul valore

assunto da x(t) in un generico istante (ad esempio t1) e valutare la densità di probabilità f1(x1; t1) 1

della variabile aleatoria estratta x1 = x(t1). Allo stesso modo si può considerare un altro istante (ad

esempio t2) e valutare la corrispondente f2(x2; t2) che in questo caso rappresenterà la densità di

probabilità della variabile aleatoria estratta x2 = x(t2). La procedura può ovviamente essere estesa ad

un numero arbitrario di istanti (e quindi di variabili aleatorie estratte).

Figura 1

La conoscenza delle densità di probabilità del primo ordine costituisce una prima e più semplice

descrizione statistica del processo stocastico. Una descrizione più accurata si ottiene prendendo in

1

Rispetto ad altra parte del Corso, qui viene utilizzata una notazione leggermente semplificata; in particolare, come

indice della funzione densità di probabilità si utilizza il numero d’ordine della variabile e non il nome per esteso della

variabile. Inoltre, le variabili aleatorie estratte vengono indicate con la lettera minuscola.

1

esame, contemporaneamente, due istanti generici (ad esempio t1 e t2) e valutando la densità di

probabilità congiunta f12(x1, x2; t1, t2). Anche in questo caso, può essere in tal modo costruito un

numero arbitrario di funzioni densità di probabilità del secondo ordine (vale a dire: densità di

probabilità congiunte di due variabili aleatorie estratte dal processo).

Come si avrà modo di verificare nel seguito, la conoscenza di f12(x1, x2; t1, t2) costituisce una

descrizione sufficientemente dettagliata per la soluzione della maggior parte dei problemi.

Nondimeno, si può rendere il metodo sempre più completo considerando 3, 4, 5, …, n istanti di

tempo, e valutando la corrispondente densità di probabilità di ordine n, vale a dire f12…n(x1, x2, …,

xn; t1, t2,…, tn).

Per le variabili aleatorie estratte dal processo sono ovviamente calcolabili le medie d’insieme (vale

a dire: momenti e momenti centrali delle singole variabili aleatorie estratte, nonché momenti e

momenti centrali congiunti) in accordo con le definizioni più generali. Così il valore medio di x1

sarà dato da:

+∞

x1 =

∫

x1 f1 ( x1; t1 )dx1

(1)

−∞

Analogamente, il momento congiunto di ordine (1, 1) delle variabili x1 e x2 si otterrà come:

+∞ +∞

x1 x2 =

∫ ∫

x1x2 f12 ( x1, x2 ; t1 , t2 )dx1dx2

(2)

−∞ −∞

Il momento congiunto di ordine (1, 1), che rappresenta la correlazione tra le variabili aleatorie

estratte x1 e x2; prende anche il nome di autocorrelazione statistica del processo e si indica con R(t1,

t2).

Si noti che nelle definizioni delle densità di probabilità, e delle medie d’insieme (1) e (2), le

variabili aleatorie sono le xi mentre il tempo svolge il ruolo di parametro.

In generale, le densità di probabilità del primo ordine sono diverse al variare dell’istante ti

considerato e le densità di ordine superiore dipendono singolarmente dagli istanti ti, tj, …, tk.

Processi stocastici con queste caratteristiche sono però di interesse solo in particolari applicazioni.

Più frequentemente, si può ritenere vera la circostanza che una traslazione arbitraria dell’origine dei

tempi dell’intero processo non ne modifichi le caratteristiche statistiche; con riferimento alle

definizioni precedenti, ciò comporta che:

1) la densità del primo ordine è indipendente da t, ed è quindi la stessa per ogni possibile variabile

aleatoria estratta;

2) la densità del secondo ordine dipende solo dalla differenza τ = t2 – t1;

3) la densità di probabilità di ordine n dipende solo dagli n – 1 parametri τi = ti+1 – ti, per i = 1, 2,

…, n – 1.

Un processo di questo tipo si dice stazionario in senso stretto e, per esso, le densità di probabilità

del primo e del secondo ordine si scrivono f(x) e f12(x1, x2; τ), rispettivamente.

Accanto alla stazionarietà in senso stretto si può definire anche la stazionarietà in senso lato; gode

di tale proprietà un processo il cui valore medio (1) è indipendente da t e la cui autocorrelazione

statistica (2) dipende dalla sola differenza τ = t2 – t1. La stazionarietà in senso stretto implica,

ovviamente, la stazionarietà in senso lato, mentre non è vero il viceversa.

2

La proprietà di stazionarietà è propedeutica ad un altro fondamentale concetto: quello di ergodicità.

In un processo ergodico ogni realizzazione 2 è tipica del processo nel senso che la sua osservazione

per un tempo sufficientemente lungo consente di estrarre tutte le proprietà del processo.

Per comprendere il senso di questa affermazione si pensi alla procedura che consente di ricavare, ad

esempio sperimentalmente, la densità di probabilità del primo ordine del processo. Si può pensare di

osservare un numero sufficientemente elevato (pari a N) di realizzazioni del processo: fissando

l’attenzione sull’istante t1, così come mostrato in Figura 2, si registrano i valori delle ampiezze

assunte dal processo e si riportano i valori ottenuti in un istogramma. A partire da un’assegnata

discretizzazione dei valori di x1, l’istogramma fornisce quindi la frequenza relativa con la quale

sono stati registrati i valori appartenenti a distinti intervalli della discretizzazione. Normalizzato al

numero di osservazioni effettuate, l’istogramma fornisce quindi una stima f1*(x1; t1) della densità di

probabilità f1(x1; t1). L’accuratezza della stima può essere arbitrariamente migliorata aumentando il

livello della risoluzione orizzontale (vale a dire, riducendo l’estensione degli intervalli) ed

assumendo un valore di N via via più elevato.

Figura 2

Supponiamo ora di considerare, in luogo di N distinte realizzazioni del processo, un’unica

realizzazione (ad esempio x(1)(t)) e di ripetere la costruzione dell’istogramma questa volta a partire

da N “spezzoni” della realizzazione considerata, ciascuno di durata Δt e con inizio in istanti ϑi

2

Alcuni testi usano il termine “manifestazione” anziché “realizzazione” del processo.

3

equispaziati di Δϑ. La procedura è illustrata in Figura 3: gli spezzoni vengono allineati in modo da

far coincidere l’origine dei tempi e accanto alla realizzazione di partenza x(1)(t) se ne considerano

altre N – 1, indicate con x’(i)(t) (i = 2, 3, …, N) e tali che x’(i)(t) = x(1)[t + (i – 1) Δϑ]. Come detto, la

stima della densità di probabilità può essere ora ricavata a partire dalle x(1)(t), x’(2)(t), …, x’(N)(t); se

il risultato che in tal modo si ottiene è identico a quello ottenuto in precedenza, qualunque sia la

realizzazione x(1)(t) considerata, il processo x(t) si dice ergodico nella densità di probabilità del

primo ordine.

Figura 3

In modo analogo l’istogramma può essere utilizzato per stimare la densità di probabilità del secondo

ordine o una qualunque media di insieme (valore medio, autocorrelazione statistica, …); se la

generica proprietà del processo può essere ricavata, nel senso precisato, dall’osservazione di una

sua unica realizzazione, il processo si dirà ergodico nella corrispondente proprietà. Un processo

ergodico in tutte le sue densità di probabilità (di ordine qualsiasi) si dirà, genericamente, ergodico.

Se le considerazioni qualitative precedenti fossero state formalizzate in termini rigorosamente

analitici, ci saremmo resi conto che l’ergodicità presuppone la stazionarietà; in altre parole, non può

essere ergodico un processo che non è stazionario. Ci si domanda allora se, e quali, processi reali

possono essere considerati ergodici.

Un esempio tipico che si considera ai fini della comprensione è quello di una persona che parla

davanti a un microfono, ed il processo stocastico consiste nell’andamento temporale della tensione

ai capi del microfono stesso. A rigore, la proprietà di stazionarietà dovrebbe essere verificata su un

intervallo temporale arbitrariamente esteso; in altre parole, ciò significa che la sorgente dovrebbe

rimanere “identica a sé stessa” (dal punto di vista delle proprietà statistiche) per un tempo illimitato.

E’ chiaro che nessuna sorgente reale (e men che meno il parlatore davanti al microfono) può essere

esaminata per un tempo infinito; sarà allora sufficiente che la proprietà di stazionarietà risulti

verificata per il tempo, più o meno lungo, di osservazione.

Ciò posto, è noto che la struttura della voce umana è diversa da parlatore a parlatore, in funzione

dell’età, del sesso, della nazionalità, ecc., e questo si riflette in una diversa struttura probabilistica

dei segnali aleatori emessi. Su queste basi, sembra impossibile che l’osservazione di un’unica

realizzazione consenta di individuare le caratteristiche statistiche dell’intero processo che dunque,

viene da concludere, non sarà ergodico.

Tuttavia, in molti casi, si può supporre che il parlatore non sia una generica persona, ma una di

caratteristiche fonetiche precisate (una sorta di “parlatore medio”) per il quale dunque le

caratteristiche delle varie realizzazioni siano effettivamente identiche tra loro. Da un diverso punto

4

di vista, si può dire che la maggior parte dei processi reali non sono “intrinsecamente” ergodici ma

possono essere “separati” in (ovvero “ridotti” a) processi più semplici e singolarmente ergodici. Se

il numero di sottoinsiemi che contengono la totalità delle realizzazioni è finito questa riduzione ha

significato operativo e consente di studiare in maniera efficace tutte le situazioni di pratico

interesse. D’altro canto, si dimostra che in un processo stazionario riducibile vi è coincidenza tra

media d’insieme e corrispondenti valori medi temporali valutati per ciascuna sorgente ridotta e

mediati probabilisticamente rispetto alle probabilità di ciascuna sorgente ridotta.

Quest’ultima proprietà introduce, indirettamente, il vantaggio che si ha nel considerare sorgenti

ergodiche rispetto a sorgenti che non lo sono.

Accanto alle medie statistiche (1) e (2) è sempre possibile, per un processo stocastico, considerare

anche le medie temporali; arrestandoci alle medie del primo e del secondo ordine, il valore medio

temporale di una generica realizzazione del processo x(t) è definito come:

____

Δt / 2

1

∫ x(t )dt

Δt →∞ Δt

−Δt / 2

x(t ) = lim

(3)

mentre la sua autocorrelazione temporale vale 3 :

Δt / 2

_____

1

R(τ ) = lim

∫ x(t ) x(t + τ )dt

Δt →∞ Δt

−Δt / 2

(4)

La generica realizzazione del processo, una volta specificata (vale a dire, misurata o registrata), può

essere riguardata come un particolare segnale determinato a potenza finita. Per esso si può dunque

definire una densità spettrale di potenza (o, semplicemente, spettro di potenza) p(ω) che, in accordo

con quanto visto a suo tempo sui segnali determinati, sarà data da:

p(ω ) = lim

Δt →∞

X Δ (ω )

2

(5)

Δt

dove XΔ(ω) è la trasformata di Fourier del segnale che si ottiene considerando x(t) entro un

intervallo, centrato nell’origine e di estensione Δt. In generale, peraltro, la (5) fornisce un

andamento diverso a seconda della particolare realizzazione considerata.

Nel caso di processo ergodico, invece, si dimostra il seguente fondamentale risultato: le medie

d’insieme (vale a dire le medie statistiche) coincidono con le medie temporali e possono essere

calcolate a partire da un’unica, e generica, realizzazione del processo.

Così, se il processo è ergodico almeno nel suo valor medio la (3) coincide con la (1) e fornisce lo

stesso risultato qualunque sia la realizzazione considerata. Analogamente, se il processo è ergodico

nella sua autocorrelazione statistica tutte le realizzazioni del processo hanno la stessa funzione di

autocorrelazione (4) e quest’ultima coincide con il momento congiunto di ordine (1, 1) delle

variabili aleatorie estratte x1 e x2, a distanza τ, fornito dalla (2).

L’importanza pratica di queste proprietà è notevolissima: in primo luogo si ribadisce la possibilità

di caratterizzare il processo dall’osservazione di un’unica realizzazione; inoltre, le quantità di

interesse possono essere calcolate utilizzando indifferentemente i parametri statistici o quelli

temporali, in funzione di ciò che si conosce o che è più opportuno valutare.

Nella parte relativa ai segnali determinati l’autocorrelazione di un segnale s(t) era stata indicata con Rs(τ). Qui, per

evitare confusione, si è preferito utilizzare una notazione più esplicita, introducendo la sopralineatura, come per il

valore medio temporale.

3

5

Per ultimo, si può enunciare il seguente fondamentale risultato, la cui dimostrazione è ovvia alla

luce delle considerazioni precedenti e che va sotto il nome di teorema di Wiener-Khintchine: se il

processo x(t) è stazionario ed ergodico, almeno nella sua autocorrelazione, lo spettro di potenza del

processo ad esso associato risulta la trasformata di Fourier della sua autocorrelazione statistica R(τ).

Come esempio di applicazione del teorema si può considerare il caso, importante in pratica, di un

segnale binario completamente causale. Per esso si trova che la funzione di autocorrelazione

statistica vale 4 :

⎧ τ

⎪1 −

R (τ ) = ⎨ T

⎪

⎩0

τ ≤T

(6)

τ >T

essendo T il tempo di simbolo. Visto che tale processo è stazionario e può essere considerato

ergodico, la trasformata di Fourier della (6) fornisce lo spettro di potenza che sarà 5 :

⎛ ωT ⎞

sin 2 ⎜

⎟

⎝ 2 ⎠

p (ω ) = T

2

⎛ ωT ⎞

⎜

⎟

⎝ 2 ⎠

(7)

Sempre in virtù dell’ergodicità, e delle proprietà ad essa associate, si può osservare che la potenza

del processo stocastico coincide con il momento di ordine 2 (valore quadratico medio) della

generica variabile aleatoria estratta. Visto che le medie d’insieme coincidono con le medie

temporali, si ha infatti:

Δt / 2

_____

1

2

P = lim

x

t

dt

=

R (0) = R(0) = x12

(

)

Δt →∞ Δt ∫

− Δt / 2

(8)

ove l’ultimo membro della (8) dà lo stesso risultato qualunque sia l’istante t1 considerato. D’altro

canto, dallo conoscenza dello spettro p(ω), ora associato univocamente al processo ergodico, è

possibile, come già si faceva per i segnali determinati, definire la banda (vale a dire l’occupazione

spettrale del segnale) come l’intervallo di frequenze, centrato sul valore massimo, che contiene una

percentuale prefissata della potenza complessiva. Ciò in ragione del fatto che facendo passare il

segnale attraverso un filtro con banda passante pari a tale intervallo, se la percentuale di potenza è

stata scelta appropriatamente la distorsione subita dal segnale sarà minima.

Così, ad esempio, per semplice integrazione numerica si trova che il 95% della potenza complessiva

del segnale binario completamente casuale, il cui spettro di potenza è fornito dalla (7), è contenuto

nell’intervallo [–B, B] con B ≈ 1.5/T.

Infine giova ricordare che, come già nel transito di un segnale di potenza determinato attraverso un

sistema lineare, anche lo spettro di potenza di un processo stocastico ergodico viene alterato in

ragione del modulo al quadrato della funzione di trasferimento H(ω) del sistema che attraversa.

Indicando con y(t) il processo in uscita e con x(t) il processo in ingresso si ha cioè:

4

Il segnale binario completamente casuale è discusso in dettaglio in un’altra dispensa.

Si tratta della trasformata di una funzione triangolare, che è già stata calcolata nella parte relativa ai segnali

determinati.

5

6

2

p y (ω ) = H (ω ) p x (ω )

(9)

Questa relazione è estremamente utile nelle applicazioni.

7

TEOREMA DI WIENER-KHINTCHINE GENERALIZZATO

Benché l’ipotesi di stazionarietà (semplice da verificare) e in subordine quella di ergodicità (più

difficile da verificare) siano spesso soddisfatte entro i limiti della “ragionevolezza” per la specifica

applicazione 6 , possono esservi situazioni, pure di pratico interesse, in cui ciò non è vero. Per questa

classe di segnali, dei quali risultano validi esponenti, come si vedrà successivamente, i segnali in

modulazione, sembrerebbe allora venir meno lo strumento operativo per il calcolo dello spettro di

potenza (e, con esso, la possibilità di ricavare la rappresentazione in frequenza del processo

stocastico).

In realtà, si definisce il seguente Teorema di Wiener-Khintchine generalizzato:

•

se per ogni valore finito di τ e per ogni intervallo A di estensione pari a |τ| la funzione di

autocorrelazione del segnale aleatorio x(t) soddisfa la condizione:

∫R

X

(t + τ, t )dt < ∞

(10)

A

allora la densità spettrale di potenza di x(t) è la trasformata di Fourier della funzione RX(t + τ,

t) mediata rispetto a t; in formule, indicando con SX(f) la densità spettrale di potenza, si ha:

T /2

⎡

⎤

1

S X ( f ) = F ⎢ lim

R X (t + τ, t )dt ⎥

⎢T →∞ T

⎥

−T / 2

⎣

⎦

∫

(11)

dove F[⋅] sta ad indicare la trasformata di Fourier.

La dimostrazione del teorema è omessa per semplicità.

6

Come si è detto in precedenza, la stazionarietà deve essere verificata all’interno dell’intervallo di osservazione del

processo; mentre, per quanto concerne l’ergodicità, è spesso conveniente suddividere le realizzazioni in classi,

considerando cioè sorgenti ridotte che, singolarmente, possono essere considerate ergodiche.

8

SEGNALI CICLOSTAZIONARI

Un importante esempio di applicazione del teorema di Wiener-Khintchine generalizzato si ha con i

segnali ciclostazionari.

Si definisce ciclostazionario un segnale aleatorio x(t) il cui valore medio E[x(t)] e la cui funzione di

autocorrelazione RX(t + τ, t) sono funzioni periodiche di periodo (comune) T0; risultano, cioè,

verificate le condizioni 7 :

E[ x(t + T0 )] = E[ x(t )] ,

(12)

R X (t + τ + T0 , t + T0 ) = R X (t + τ, t ) .

(13)

Perché un processo ciclostazionario verifichi le ipotesi del teorema di Wiener-Khintchine

generalizzato è sufficiente che risulti:

T0

∫R

X

(t + τ, t )dt < ∞ .

(14)

0

Se dunque la (14) è verificata, la densità spettrale di potenza del processo vale:

⎡ _______ ⎤

S X ( f ) = F ⎢ R X (τ) ⎥

⎣

⎦

(15)

essendo

_______

1

R X (τ) =

T0

T0 / 2

∫R

X

(t + τ, t )dt .

(16)

−T0 / 2

Un esempio molto significativo di segnale ciclostazionario è costituito dal segnale in modulazione

di ampiezza con portante sinusoidale 8 :

y (t ) = x(t ) cos(2πf 0 t )

(17)

con x(t) (segnale modulante) per ipotesi stazionario ed ergodico nella sua funzione di

autocorrelazione RX(τ) = E[x(t)x(t + τ)].

Per il segnale modulato y(t) si ha:

E[ y (t )] = E[ x(t ) cos(2πf 0 t )] = E[ x(t )] cos(2πf 0 t ) ,

(18)

in quanto il cos(2πf0t) è un segnale determinato, mentre:

7

In questo paragrafo il valore medio statistico viene indicato usando il simbolo E[⋅] (Expectation).

A rigore, quello considerato è un segnale BLD-PS (Banda Laterale Doppia – Portante Soppressa), in cui la portante

non viene trasmessa, che necessita di un ricevitore coerente. Peraltro, considerazioni analoghe possono essere ripetute

anche per gli altri formati di modulazione (ad esempio, la modulazione di ampiezza convenzionale, con trasmissione

della portante).

8

9

RY (t + τ , t ) = E [ x(t + τ ) cos(2π f 0 (t + τ )) x(t ) cos(2π f0t )] =

= E [ x(t + τ ) x(t ) ] [ cos(2π f 0 (t + τ )) cos(2π f 0t ) ] =

(19)

1

⎡1

⎤

= RX (τ ) ⎢ cos(2π f 0τ ) + cos(4π f 0t + 2π f 0τ ) ⎥

2

⎣2

⎦

avendo applicato note formule di trigonometria.

Sia il valore medio che la funzione di autocorrelazione di y(t) sono funzioni di t periodiche, con

periodo comune T0 = 1/f0 9 . Di conseguenza, si applicano le (15)-(16). In particolare, la (16)

fornisce:

_______

1

RY (τ ) =

T0

=

T0 / 2

T /2

RX (τ ) 0

R

t

+

t

dt

=

(

τ

,

)

∫ Y

∫ [cos(2π f0τ ) + cos(4π f0t + 2π f0τ )] dt =

T

2

0

−T / 2

−T / 2

0

0

T0 / 2

RX (τ )

R (τ )

cos(2π f 0τ ) + X

cos(4π f 0t + 2π f 0τ )dt

2

2T0 −T∫ / 2

. (20)

0

D’altro il secondo contributo è nullo, avendosi infatti 10 :

T0 / 2

∫

cos(4π f 0t + 2π f 0τ )dt =

−T0 / 2

=

=

=

1

4π f 0

1

4π f 0

1

4π f 0

1

4π f 0

T /2

0 /2

sin(4π f 0t + 2π f 0τ ) −0T

=

[sin(2π f0T0 + 2π f0τ ) + sin(2π f0T0 − 2π f0τ )] =

(21)

[sin(2π + 2π f0τ ) + sin(2π − 2π f0τ )] =

[sin(2π f0τ ) − sin(2π f0τ )] = 0

Si resta dunque con:

_______

RY (τ ) =

RX (τ )

cos(2π f 0τ ) .

2

(22)

e, applicando la (15), si ottiene:

SY ( f ) =

1

[S X ( f − f 0 ) + S X ( f + f 0 )]

4

(23)

9

In realtà, la funzione di autocorrelazione è periodica con periodo 1/(2f0) ma, come già si è osservato, ciò che conta è il

periodo “comune” ad ambedue le funzioni. Inoltre, nel caso specifico della modulazione, si impone E[x(t)] = 0, e questo

comporta E[y(t)] = 0. Peraltro, ciò non ha alcuna implicazione sulle affermazioni fatte nel testo, configurandosi come

un caso particolare in cui v’è necessità di verificare la sola periodicità della funzione di autocorrelazione.

10

Sulla base della nota precedente riguardo al periodo della funzione di autocorrelazione, questo calcolo è perfino

superfluo.

10

dove SX(f) è lo spettro di potenza del processo x(t). Ne concludiamo che lo spettro di potenza del

segnale modulato y(t) si ottiene per traslazione alla frequenza f0 (e, simmetricamente, alla frequenza

−f0, per quanto concerne il contenuto alle frequenze negative) dello spettro di potenza del segnale

modulante x(t).

11