Stime di massima verosimiglianza per un modello di regressione lineare normale.

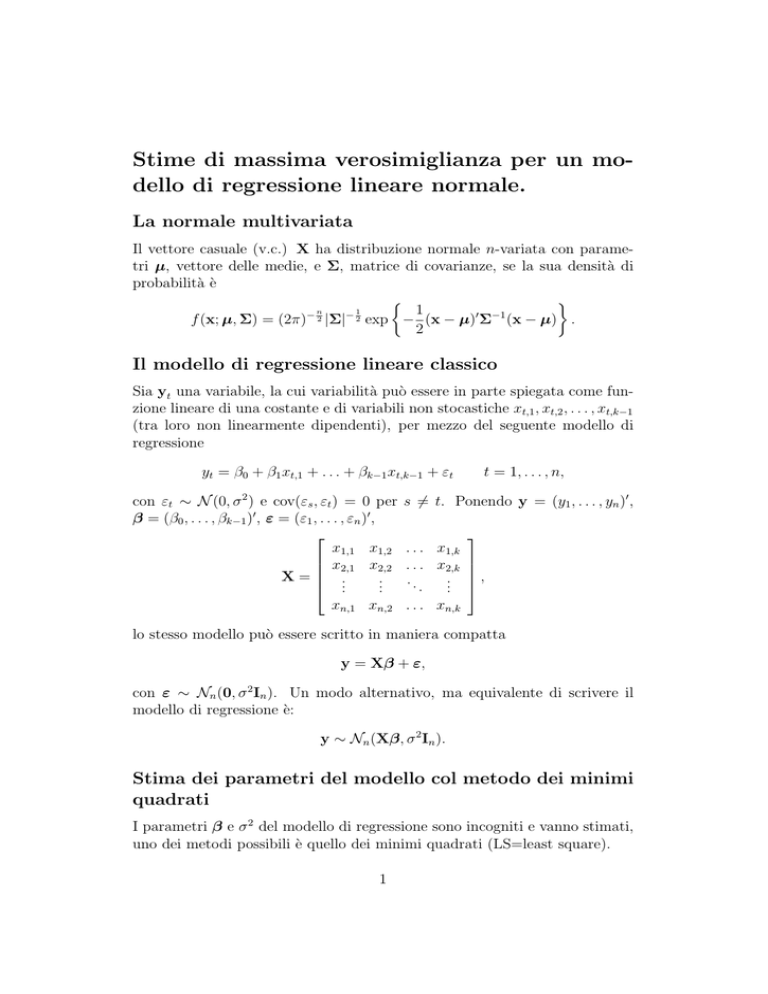

La normale multivariata

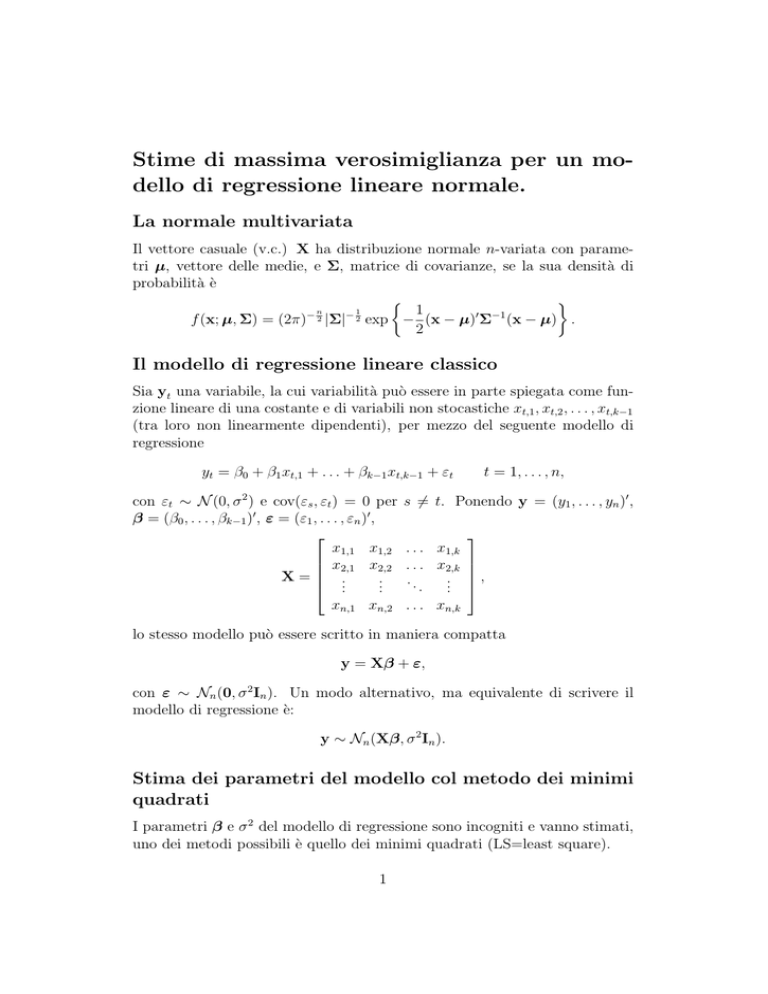

Il vettore casuale (v.c.) X ha distribuzione normale n-variata con parametri µ, vettore delle medie, e Σ, matrice di covarianze, se la sua densità di

probabilità è

1

1

−1

−

0

−n

f (x; µ, Σ) = (2π) 2 |Σ| 2 exp − (x − µ) Σ (x − µ) .

2

Il modello di regressione lineare classico

Sia yt una variabile, la cui variabilità può essere in parte spiegata come funzione lineare di una costante e di variabili non stocastiche xt,1 , xt,2 , . . . , xt,k−1

(tra loro non linearmente dipendenti), per mezzo del seguente modello di

regressione

yt = β0 + β1 xt,1 + . . . + βk−1 xt,k−1 + εt

con εt ∼ N (0, σ 2 ) e cov(εs , εt ) = 0 per

β = (β0 , . . . , βk−1 )0 , ε = (ε1 , . . . , εn )0 ,

x1,1 x1,2

x2,1 x2,2

X = ..

..

.

.

xn,1 xn,2

t = 1, . . . , n,

s 6= t. Ponendo y = (y1 , . . . , yn )0 ,

. . . x1,k

. . . x2,k

..

...

.

. . . xn,k

,

lo stesso modello può essere scritto in maniera compatta

y = Xβ + ε,

con ε ∼ Nn (0, σ 2 In ). Un modo alternativo, ma equivalente di scrivere il

modello di regressione è:

y ∼ Nn (Xβ, σ 2 In ).

Stima dei parametri del modello col metodo dei minimi

quadrati

I parametri β e σ 2 del modello di regressione sono incogniti e vanno stimati,

uno dei metodi possibili è quello dei minimi quadrati (LS=least square).

1

Gli stimatori LS dei parametri β del modello sono i valori che soddisfano a

n

X

(yt − β0 − β1 xt,1 − . . . − βk−1 xt,k−1 )2 = min,

t=1

che in forma matriciale può essere riscritta

(y − Xβ)0 (y − Xβ) = min .

Eseguendo i prodotti si ottiene

y0 y − β 0 X0 y − y0 Xβ + β 0 X0 Xβ =

= y0 y − 2y0 Xβ + β 0 X0 Xβ,

dove il secondo ed il terzo addendo della prima riga sono uguali essendo scalari

(il trasposto di uno scalare è uguale allo scalare stesso). Ora, per trovare il

minimo non resta che derivare rispetto a β e porre le derivate uguali a zero

(e verificare che la matrice delle derivate seconde sia definita positiva).

∂ 0

(y y − 2y0 Xβ + β 0 X0 Xβ) = 0

∂β

−2X0 y + 2X0 Xβ = 0

β̂ LS = (X0 X)−1 X0 y.

Per esercizio

• Si calcoli la matrice delle derivate seconde e si mostri che tale matrice

è definita positiva.

• Si mostri che lo stimatore è corretto, cioè che E(β LS ) = β.

• Si mostri che la matrice di covarianza dello stimatore è: E[(β LS −

β)(β LS − β)0 ] = σ 2 (X0 X)−1 .

Essendo β̂ LS esprimibile come combinazione lineare di variabili casuali

normali, è a sua volta normale:

β̂ LS ∼ Nk (β, σ 2 (X0 X)−1 ).

Si può mostrare che

(y − Xβ)0 (y − Xβ)

s =

n−k

2

2

è uno stimatore corretto di σ 2 , la cui distriuzione è

(n − k)s2

∼ χ2n−k .

2

σ

Si chiami cij , il generico elemento della matrice (X0 X)−1 ; dalla teoria della

normale segue che

p

(n − k)σ 2

β̂LSi − βi

β̂LSi − βi

√

p

·

∼ tn−k ,

= √ 2

2

σ cii

s cii

(n − k)s2

con cui si può costruire un test t per verificare l’ipotesi H0 : βi = 0.

Stima di massima verosimiglianza dei parametri del modello

Un metodo alternativo per stimare β e σ 2 nel modello di regressione è

la massima verosimiglianza (ML=maximum likelihood), che gode di buone proprietà statistiche (specie per grandi campioni). Visto che il modello di

regressione può essere espresso con

y ∼ Nn (Xβ, σ 2 In ),

è possibile scrivere la densità di probabilità di y, e quindi la funzione di

verosimiglianza dei parametri β e σ 2 come segue:

1

0

2

2

2 −n/2

L(β, σ ; y) = f (y; β, σ ) = (2πσ )

exp − 2 (y − Xβ) (y − Xβ) .

2σ

La stima di massima verosimiglianza dei parametri è la combinazione di

valori per β e σ 2 che rende massima la funzione di verosimiglianza, cioè è quel

valore dei parametri che rende il campione estratto il più probabile possibile,

quando il modello lineare gaussiano è corretto.

In genere è più agevole cercare il massimo della trasformata logaritmica della

funzione di verosimiglianza, che ha la proprietà di non alterare il valore dei

parametri nei punti stazionari della funzione L(.)1 :

n

1

n

l(β, σ 2 ) = log L(β, σ 2 ) = − log(2π) − log(σ 2 ) − 2 (y − Xβ)0 (y − Xβ).

2

2

2σ

Ponendo le derivate prime uguali a zero si ottiene:

∂l

n

1

= − 2 + 4 (y − Xβ)0 (y − Xβ) = 0

2

∂σ

2σ

2σ

∂l

1

= − 2 [2X0 Xβ − 2X0 y] = 0

∂β

2σ

1

Infatti porre

∂L(θ)

∂θ

uguale a zero, equivale a porre

3

1 ∂l(θ)

L(θ) ∂θ

nullo, con l(θ) = log L(θ).

da cui risulta

1

(y − Xβ)0 (y − Xβ)

n

= (X0 X)−1 X0 y

2

σ̂M

L =

β̂ M L

In questo caso particolare (regressione lineare gaussiana) lo stimatore di β

M L coincide con lo stimatore LS (=least square=minimi quadrati) e quindi

β̂ M L ∼ N (β, σ 2 (X0 X)−1 ).

Proprietà del generico stimatore di massima

verosimiglianza

Sia θ̂ lo stimatore di massima verosimiglianza di θ 0 , e l(θ) la funzione di

log-verosimiglianza che θ̂ massimizza. Sotto condizioni di regolarità (generalmente rispettate nei comuni problemi di stima), lo stimatore θ̂ è

1. Consistente: limn→∞ Pr(|θ̂ − θ 0 | < ε) = 1.

√

2. Asintoticamente normale: n(θ̂ − θ 0 ) ∼a N (0, I−1 (θ 0 )) con

" #

2 0

∂l

∂ l

∂l

I(θ 0 ) = E

= −E

,

∂θ θ0 ∂θ θ0

∂θ∂θ 0 θ0

matrice di informazione di Fisher.

3. Asintoticamente efficiente: infatti per n → ∞ non esiste alcuno

stimatore più efficiente (a varianza più piccola) di θ̂.

4