Università degli studi di Siena

Dipartimento di ingegneria dell’informazione e scienze matematiche

Dispense del corso di

Teoria dei Giochi e Giochi Evolutivi

Parte 2 - Teoria dei Giochi Evolutivi

Dario Madeo, Chiara Mocenni

Marzo 2016

Indice

1 Introduzione

2

2 Stabilità Evolutiva

3

2.1

Strategie Evolutivamente Stabili (ESS) . . . . . . . . . . . . . . . . . . . . .

4

2.2

Equilibri di Nash puri e strategie pure evolutivamente stabili in giochi simmetrici a due giocatori . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7

3 Dalla teoria dei giochi alla replicator dynamics

3.1

La replicator dynamics . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8

8

3.1.1

Invarianza nella trasformazione dei payoff . . . . . . . . . . . . . . . .

11

3.1.2

La soluzione indotta . . . . . . . . . . . . . . . . . . . . . . . . . . .

11

3.2

Replicator dynamics e evoluzione biologica . . . . . . . . . . . . . . . . . . .

12

3.3

Classificazione dei giochi evolutivi 2x2 . . . . . . . . . . . . . . . . . . . . .

15

3.4

Stati stazionari della replicator equation ed equilibri di Nash . . . . . . . . .

17

3.4.1

Stati stazionari e ∆N E . . . . . . . . . . . . . . . . . . . . . . . . . .

18

3.4.2

Stati Lyapunov stabili e ∆N E . . . . . . . . . . . . . . . . . . . . . .

19

Sintesi dei concetti base ed esercizi . . . . . . . . . . . . . . . . . . . . . . .

21

3.5

4 Applicazione dei giochi evolutivi all’ecologia

1

23

Capitolo 1

Introduzione

La teoria dei giochi classica si occupa di interazioni che avvengono una sola volta tra giocatori

perfettamente razionali, che conoscono tutti i dettagli del gioco. Nella teoria dei giochi

evolutiva, invece, il gioco si ripete continuamente nel tempo ed avviene tra giocatori, scelti

casualmente, in una popolazione sufficientemente vasta. Tali giocatori sono programmati per

agire in un determinato modo, ovvero utilizzando una strategia del gioco, e hanno la capacità

di replicarsi con un certo tasso riproduttivo. I figli scelgono le stesse strategie dei genitori.

La dinamica dei replicator assume che gli individui possono adottare solamente strategie

pure, cioè quelle appartenenti all’insieme delle strategie del gioco. In generale, un processo

evolutivo combina due elementi di base: un meccanismo di mutazione, che introduce elementi

di differenziazione tra le strategie, e un meccanismo di selezione che favorisce alcune strategie

rispetto ad altre. Nella sua formulazione la dinamica di replicator viene formalizzata come

un sistema di equazioni differenziali ordinarie, mentre la robustezza contro le mutazioni è

indirettamente governata da i criteri di stabilità dinamica. Analogamente a quanto accade

nella teoria dei giochi calssica, anche nel caso evolutivo è possibile avere strategie miste.

Una strategia mista x può essere interpretata come uno stato della popolazione, dove ogni

componente xi rappresenta lo share di individui della popolazione che sono programmati ad

adottare la corrispondente strategia pura i. Continueremo ad interpretare il payoff come

il vantaggio di un individuo, misurato come tasso di riproduzione. La cosa interessante in

questi modelli è che le variazioni dello stato della popolazione modificano anche i payoff e

il vantaggio delle strategie pure. Come detto sopra queste dinamiche sono modellate come

un sistema di equazioni differenziali ordinarie non lineare e adattabile a descrivere molti

fenomeni reali.

Un concetto molto importante che ci introduce ai giochi evolutivi è quello delle strategie

evolutivamente stabili, che vengono discusse nel prossimo paragrafo.

2

Capitolo 2

Stabilità Evolutiva

In questo paragrafo viene illustrato il concetto di strategia evolutivamente stabile (ESS). Una

strategia si dice ESS se è robusta rispetto a pressioni evolutive da parte di altre strategie. Si

consideri una popolazione di individui indistinti e programmati a giocare una determinata

strategia pura o mista (strategia prevalente) nell’ambito di una serie ripetuta di giochi a due

giocatori scelti a caso nella popolazione. Supponiamo dunque di inserire nella popolazione

un piccolo numero di individui che giocano un’altra strategia pura o mista. La strategia

prevalente viene detta ESS se per ogni strategia mutante esiste una barriera di invasione

tale che il numero di individui che gioca la strategia mutante rimane al di sotto di questa

barriera in quanto la strategia prevalente fornisce sempre un payoff più alto.

Questo approccio dunque considera interazioni simmetriche tra coppie di individui appartenenti ad una popolazione infinita. Inoltre, il concetto di strategia evolutiva si basa sulla

connessione che esiste tra i payoffs di un gioco e la diffusione di una determinata strategia

in una popolazione. In particolare, i payoffs del gioco rappresentano il guadagno in termini di fitness biologica o di capacità riproduttiva derivante dall’interazione in questione.

Le strategia ESS generalizzano l’evoluzione biologica in senso darwiniano, cioè l’idea della

sopravvivenza di coloro che utilizzano strategie che forniscono una fitness più alta delle altre

possibili, e in cui la fitness stessa dipende dal comportamento (dalle strategie) degli altri

individui della popolazione.

Analogamente all’equilibrio di Nash, la stabilità evolutiva non spiega come la popolazione è

arrivata ad adottare tale strategia.

Il concetto di ESS può essere utilizzato anche per spiegare la robustezza del comportamento

umano in un’ampia gamma di situazioni, come l’ambito sociale ed economico. In tal senso, la stabilità evolutiva richiede che un piccolo gruppo di individui che tenta di utilizzare

una strategia alternativa ottiene un risultato peggiore di coloro che adottano la strategia

prevalente, i quali dunque non hanno motivo di cambiare il proprio comportamento. Una

3

strategia ESS in questo contesto viene chiamata convenzione.

2.1

Strategie Evolutivamente Stabili (ESS)

Supponiamo che gli individui della popolazione abbiano a disposizione m strategie pure,

s1 , . . . , sm , e che siano in grado di giocare anche strategie miste (x1 , . . . , xm ), dove xi rappresenta la probabilità di giocare la strategia pura si . L’insieme delle strategie del gioco

appartiene al simplesso

(

)

m

X

m

Sm = x = (x1 , . . . , xm ) ∈ R : xi ≥ 0,

xi = 1 .

i=1

• Gli angoli del simplesso sono le strategie pure rappresentate dai vettori unitari e1 , . . . , em ,

• L’interno del simplesso è costituito solo da strategie completamente miste, cioè in cui

xi > 0 per ogni i,

• I bordi del simplesso sono costituiti da strategie per cui esiste almeno una componente

xi = 0 delle strategie del gioco.

Consideriamo il gioco a due giocatori, in cui πij rappresenta il payoff ottenuto dal primo

giocatore quando gioca la strategia pura Si contro il secondo giocatore che usa la strategia

pura Sj . La matrice A = (aij ) è la matrice di payoff del gioco. Uno stratega Si ottiene un

payoff

X

(Ay)i =

aij yj

j

contro uno stratega y = (y1 , . . . , ym ). Il payoff ottenuto da uno stratega x = (x1 , . . . , xm )

ottiene un payoff

X

xT Ay =

aij xi yj .

ij

L’insieme delle best responses β(y) è l’insieme delle strategie per cui xT Ay è massimo.

Un equilibrio di Nash nel contento dei giochi simmetrici a due giocatori è una strategia che

rappresenta la miglior risposta a se stessa, cioè y è un equilibrio di Nash se

xT Ay ≤ yT Ay,

per ogni x 6= y. L’equilibrio di Nash è stretto se

xT Ay < yT Ay.

4

Gli equilibri di Nash stretti sono strategie pure.

Supponiamo adesso che nella popolazione vi siano una strategia prevalente x̂ ed una strategia divergente x che viene giocata con una probabilità . La strategia mista giocata nella

popolazione sarà dunque x + (1 − )x̂. La strategia x̂ si dice evolutivamente stabile se per

ogni strategia divergente x si ha che la disuguaglianza

xT A(x + (1 − )x̂) < x̂T A(x + (1 − )x̂)

è verificata per ogni > 0 inferiore ad un valore ¯(x) > 0, detto barriera di invasione.

Possiamo riscrivere questa disuguaglianza come

(1 − )(x̂T Ax̂ − xT Ax̂) + (x̂T Ax − xT Ax) > 0.

Facendo tendere a 0, abbiamo che la strategia x̂ è evolutivamente stabile se sono verificate

le due condizioni seguenti:

a Condizione di equilibrio

x̂T Ax̂ ≥ xT Ax̂, per ogni x ∈ S;

b Condizione di stabilità

se x 6= x̂ e x̂T Ax̂ = xT Ax̂, allora x̂T Ax > xT Ax.

La strategia x̂ è una best response a se stessa, ma questo fatto da solo non è sufficiente a

garantire la non invadibilità da parte di un’altra strategia, infatti nel caso dell’uguaglianza

esiste una best response alternativa x. Va allora verificato che x̂ fornisce un payoff maggiore

se giocata contro x di quanto ottenuto giocando x stessa.

Se una strategia è un equilibrio di Nash stretto allora è ESS. Se una strategia è ESS, allora

è un equilibrio di Nash.

Si dimostra il seguente teorema.

Teorema. Una strategia x̂ ∈ S è ESS sse

x̂T Ay > yT Ay

per ogni y 6= x̂ in qualche intorno di x̂ in S.

Da ciò segue che se vi è una strategia ESS nell’interno del simplesso S, allora questa è unica.

Infatti la disuguaglianza del teorema precedente deve valere per ogni altra strategia. Dunque, se vi sono ESS multiple, esse devono appartenere alla frontiera di S.

5

Esercizio 1. Trovare tutti gli equilibri di Nash di un gioco con due giocatori e due strategie.

Quali sono stretti?

Esercizio 2. Verificare che nel gioco Falchi e Colombe, descritto dalla matrice di payoff:

A=

G−C

2

0

G

G

2

(2.1)

l’unica strategia ESS è x∗ = G/C.

Esercizio 3. Verificare che nel gioco descritto dalla matrice di payoff

0 6 −4

A = −3 0 5

−1 3 0

(2.2)

la strategia mista x = (1/3, 1/3, 1/3) non è ESS. Sol. La strategia pura e1 è ESS.

Esercizio 4. Verificare la presenza di strategie pure e degli equilibri di Nash (misti e puri)

nel gioco descritto dalla matrice di payoff:

1 0 0

A = 0 1 0 .

(2.3)

0 0 1

Sol. Nel gioco vi sono 3 ESS (e1 , e2 , e3 ) e un NE misto.

Esercizio 5. Verificare la presenza di strategie pure e degli equilibri di Nash (misti e puri)

nel gioco descritto dalla matrice di payoff:

0

1 −1

1 .

A = −1 0

(2.4)

1 −1 0

Sol. Nel gioco non vi sono ESS e vi è un NE misto (1/3, 1/3, 1/3).

Esercizio 6. Dimostrare, applicando la definizione, la condizione di ESS per una strategia

pura in un gioco generico a due giocatori e due strategie.

6

2.2

Equilibri di Nash puri e strategie pure evolutivamente stabili in giochi simmetrici a due giocatori

NE e ESS puri in giochi a 2 strategie

Nel gioco evolutivo a 2 strategie, descritto dalla matrice dei payoff

A=

a b

c d

,

valgono le seguenti proprietà.

• La strategia s1 è un equilibrio di Nash stretto se a > c;

• La strategia s1 è un equilibrio di Nash se a ≥ c;

• La strategia s2 è un equilibrio di Nash stretto se d > b;

• La strategia s2 è un equilibrio di Nash se d ≥ b.

La strategia pura s1 si dice evolutivamente stabile se a > c, oppure a = c e b > d.

Sotto queste condizioni la selezione si oppone all’invasione di s2 su s1 .

Nel caso più generale di n strategie pure, sia π(ei , ej ) il payoff della strategia ei rispetto a ej .

NE e ESS puri in giochi a m strategie

i Una strategia ek è un equilibrio di Nash stretto se π(ek , ek ) > π(ei , ek ), ∀i 6= k;

ii Una strategia ek è un equilibrio di Nash se π(ek , ek ) ≥ π(ei , ek ), ∀i 6= k.

iii Una strategia ek è evolutivamente stabile se π(ek , ek ) > π(ei , ek ), ∀i 6= k, oppure

π(ek , ek ) = π(ei , ek ) e π(ek , ei ) > π(ei , ei ) ∀i 6= k.

7

Capitolo 3

Dalla teoria dei giochi alla replicator

dynamics

3.1

La replicator dynamics

Si supponga di disporre di una popolazione di n giocatori (n sufficientemente grande), ognuno dei quali possiede la stessa matrice di payoff A ∈ Rm×m . Ad ogni istante di tempo, coppie

di giocatori si sfidano, adottando determinate strategie ed ottenendo un determinato payoff;

riprendendo i concetti visti finora, la sfida avviene dunque tra due giocatori, dove il primo

ha matrice di payoff pari ad A, mentre il secondo ha matrice B = AT .

Le strategie a disposizione di ogni giocatore sono uguali e sono esattamente n. Un giocatore

decide di usare una certa strategia secondo uno schema precostituito non necessariamente

valido da un punto di vista ”razionale”. All’istante iniziale di tempo, diciamo t = 0, sono

note le percentuali di soggetti presenti nella popolazione che adottano, secondo il loro schema

precostituito, una certa strategia. In particolare xi (0) indica la percentuale di popolazione

che adotterà nel prossimo scontro la strategia i-esima. In particolare si ha che:

xi (0) ∈ [0, 1] ∀i = 1...m ∧

m

X

xi (0) = 1.

i=1

Per chiarire meglio cosa succederà negli istanti successivi a t = 0, si supponga all’istante t di

chiedere a tutti i giocatori di scrivere la loro prossima strategia su un foglietto. Si prendono

poi tutti i nomi dei giocatori e si inseriscono in un’urna; in maniera casuale ne vengono

estratti due per volta, ed essi si sfideranno utilizzando la strategia che avevano segnato sul

8

loro foglietto. La probabilità di estrarre un giocatore che adotta la strategia i è pari a xi (t),

mentre quella di estrarre un giocatore con strategia j è xj (t). In tal caso, entrambi otterranno

un payoff pari a aij . Se ci si sofferma sulla prima estrazione, dopo aver scoperto che il primo

giocatore è di tipo i, si potrebbe voler sapere quale sarà il payoff medio che potrà ottenere

contro l’avversario che ancora non è stato estratto e di cui quindi ancora non si conosce la

strategia. In particolare si ha che:

pi (t) =

m

X

aij xj (t)

j=1

dove pi (t) è il payoff medio che si voleva calcolare. Sfruttando il precedente risultato, si può

inoltre calcolare il payoff medio della partita a priori, cioè senza conoscere l’esito di nessuna

delle due estrazioni. Esso in particolare è:

φ(t) =

m

X

pi (t)xi (t) =

i=1

m X

m

X

aij xi (t)xj (t)

i=1 j=1

La differenza tra queste equazioni e quelle introdotte in precedenza è che il meccanismo

appena descritto costituisce una diversa ma comunque valida interpretazione del concetto di

strategie miste. Si noti che in tale contesto, si utilizza solo il vettore delle strategie miste

x. Difatti il procedimento di sfide successive descritto finora avviene sempre tra soggetti

uguali (= stessa matrice di payoff), che si differenziano solo per la strategia usata ad un

certo istante; viene quindi a cadere la netta distinzione tra giocatore 1 e 2 (e quindi x ed y)

poichè in questo contesto ognuno è un pò l’avversario di se stesso!

La dinamica del sistema appena descritto prevede l’evoluzione temporale del vettore delle

strategie miste, secondo regole che prevedono l’apprendimento da parte della popolazione

di quali siano le strategie migliori da adottare. Le seguenti equazioni differenziali ordinarie

sono costruite appositamente per descrivere questo tipo di fenomeno:

ẋi (t) = xi (t)[pi (t) − φ(t)] ∀i = 1...m

(3.1)

Tali equazioni prendono il nome di replicator dynamics a tempo continuo. Per il

loro importante legame con la teoria dei giochi, tali equazioni sono utilizzate in molteplici

contesti ed inoltre, esistono svariate varianti, sviluppate per contesti diversi e più complessi.

Di notevole importanza sono le replicator dynamics a tempo discreto:

9

xi (k + 1) = xi (k)

pi (k)

∀i = 1...m

φ(k)

(3.2)

La costruzione di tale equazioni alle differenze è del tutto analoga al caso (3.1), dove però

si suppone che le sfide tra i vari giocatori avvengano in istanti ben precisi e non in continuazione. Le equazioni (3.1) sono molto importanti perchè, oltre a spiegare taluni fenomeni

specifici, esse possono essere anche usate come un’ottima discretizzazione delle equazioni

a tempo continuo (3.1) e sono quindi ideali per la simulazione (si tenga presente che con

un computer simulare l’evoluzione di un sistema di equazioni differenziali a tempo continua

significa discretizzarle ed ottenere quindi un equazione alle differenze). Si ha inoltre che le

proprietà dinamiche (equilibri, stabilità, ecc...) delle due famiglie di equazioni sono le stesse.

Come detto sopra, andremo a considerare una popolazione vasta di individui, ognuno dei

quali sarà programmato da una strategia pura i ∈ K, in un gioco simmetrico a due giocatori

con strategie miste nel simplesso ∆ e funzione di payoff π. Sia qi (t) ≥ 0 il numero di

individui, al tempo t, programmati dalla strategia pura i ∈ K, dove quest’ultima viene

interpretata

P come un comportamento geneticamente programmato. Rappresenteremo con

q(t) = i∈K qi (t) > 0 il totale della popolazione. Lo stato della popolazione viene definito

dal vettore x(t) = (x1 (t), ..., xk (t)) dove ogni componente xi (t) rappresenta lo share, ovvero

il numero di individui programmato per la strategia pura i al tempo t, rispetto al totale

della popolazione; infatti xi (t) = qi (t)/q(t). Avremo che xi (t) ∈ ∆ in altre parole lo stato

della popolazione coincide con le strategie miste del gioco. Il payoff atteso per ogni strategia

pura i, quando la popolazione appartiene ad uno stato x ∈ ∆, verrà indicato da π(ei , x). Il

payoff misura il processo riproduttivo di un individuo, nel nostro caso questo processo sarà

del tutto asessuato. Sia:

k

X

π(x, x) =

xi π(ei , x)

(3.3)

i=1

la media dei payoff della popolazione, ovvero il payoff di un individuo casuale, che corrisponde

al payoff che guadagnerebbe la strategia mista x giocando contro se stessa.

Supponiamo che il payoff misuri il vantaggio di un individuo, misurato con il numero di

prole per ogni unità di tempo, ed inoltre che ogni prole erediti la strategia del genitore. Se

la riproduzione si ripete continuamente nel tempo, allora il tasso di nascita ad ogni tempo t

di individui programmati per la strategia pura i corrisponde a: β + π(ei , x(t)), dove β ≥ 0 è

il vantaggio degli individui della popolazione, indipendentemente dal risultato del gioco. Sia

δ ≥ 0 il tasso di mortalità che è lo stesso per ogni individuo. Rappresenteremo con il punto

la derivata rispetto al tempo, e ometteremo la dipendenza esplicita dal tempo. La dinamica

della popolazione può essere descritta come segue corrisponde a:

q̇ = [β + π(ei , x) − δ]qi

10

(3.4)

ed il corrispondente dinamico per lo share della popolazione xi :

ẋi = [π(ei , x) − π(x, x)]xi

(3.5)

Il tasso di crescita ẋi /xi è rappresentato dalla differenza tra il payoff, ovvero il vantaggio

effettivo utilizzando la strategia pura ei , ed il payoff medio della popolazione. L’equazione (2.3) ci fornisce la replicator dynamics. Utilizzando la linearità del payoff π potremo

trascrivere l’equazione come segue:

ẋi = π(ei − x, x)xi

(3.6)

dove il tasso di crescita coincide con π(ei − x, x) = α. Otterremo cosı̀ una funzione di

replicazione ẋi = αxi dove α è un valore in funzione dello stato della popolazione x e della

strategia pura ei adottata. La funzione di replicator mette in evidenza il ruolo di selezione,

che dipenderà dal valore di α, ovvero se α > 0 otterremo un aumento dello share della

popolazione con strategia pura i, ed invece con α < 0 la diminuzione. Il rapporto tra lo

share di due popolazioni xi > 0 e xj > 0, cresce (decresce) nel tempo se la strategia i vince

un payoff maggiore (minore) rispetto la strategia j, e verrà rappresentato da:

d xi

ẋi

xi x˙j

xi

=

−

= [π(ei , x) − π(ej , x)]

(3.7)

dt xj

xj

xj xj

xj

3.1.1

Invarianza nella trasformazione dei payoff

La dinamica replicator è invariante rispetto alle trasformazioni affini positive del payoff. La

funzione π viene sostituita da π̄ = λπ + µ con λ numero reale positivo e µ un numero reale,

trasformando l’equazione in:

ẋi = π̄(ei − x, x)xi = λπ(ei − x, x)xi

(3.8)

L’effetto di questa trasformazione del payoff è quindi equivalente alla variazione temporale

del fattore λ > 0 nella dinamica dei replicator (2.4). In particolare, tutte le soluzioni sono le

stesse per entrambe le dinamiche, solamente la velocità con la quale lo stato della popolazione

si muove lungo queste orbite è differente secondo il fattore λ. Le trasformazioni locali dei

payoff non hanno effetti sulla dinamica dei replicator, infatti sommando la costante ν ∈ R

alla j-esima colonna della matrice A il payoff π(ei , x) per ogni strategia i è modificata in

π̄(ei , x) = π(ei , x) + νxj mentre π̄(x, x) = π(x, x) + νxj , che non apporta modifiche alla

dinamica di replicator.

3.1.2

La soluzione indotta

Il lato destro della dinamica di replicator, definisce un campo vettoriale ϕ : Rk → Rk dove

ϕi (x) = π(ei − x, x)xi

11

(3.9)

Poiché il campo vettoriale è polinomiale nello share della popolazione, il sistema di equazioni

differenziali (2.4) ha un’unica soluzione per ogni stato iniziale xo ∈ Rk , per il teorema di

esistenza e unicità della soluzione delle equazioni differenziali ordinarie. Inoltre, il simplesso

∆ ⊂ Rk è invariante rispetto queste dinamiche. La soluzione della (2.4) è contenuta in delta

per ogni condizione iniziale anch’essa appartenete a ∆. Intuitivamente questo è ovvio poiché

sulla (2.4)

gli share della popolazione rimane necessariamente uguale a

P la somma di tuttiP

uno, ( i∈K xi = 1) quindi

i∈K ẋi = 0 e lo share della popolazione non possono mai

essere negativi. Più precisamente, il sistema di equazioni differenziali (2.4) definisce una

mappatura di soluzioni continue ξ : R × ∆ → ∆ che per ogni stato iniziale x0 ∈ ∆ e per

ogni tempo t ∈ R assegna uno stato della popolazione ξ(t, xo ) ∈ ∆. Poiché il simplesso

∆ è invariante rispetto alle dinamiche, lo sarà anche il suo interno e la sua frontiera. In

altre parole se una strategia pura, è presente nella popolazione in qualche istante t, allora

essa sarà sempre presente ad ogni istante di tempo, viceversa non comparirà se non è stata

presente nel passato. Certamente questo non preclude che la traiettoria di una soluzione

interna converga verso la frontiera del simplesso per t → ∞.

3.2

Replicator dynamics e evoluzione biologica

La teoria dei giochi evolutivi si ispira ai meccanismi di selezione ed evoluzione delle specie

in un contesto biologico. Per introdurre tale teoria, supponiamo di avere una popolazione di

individui che presentano due diversi fenotipi, A e B. Siano, x(t) e y(t) l’abbondanza relativa

(frequenza) dei fenotipi A e B al tempo t. Dunque x(t) + y(t) = 1. Le equazioni che regolano

la dinamica della frequenza dei due fenotipi sono:

ẋ = x(a − φ)

ẏ = y(b − φ),

dove φ = ax + by. Sostituendo y = 1 − x abbiamo l’equazione che descrive l’evoluzione del

fenotipo A:

ẋ = x(1 − x)(a − b),

mentre l’evoluzione del fenotipo B è data da y(t) = 1 − x(t).

Se a 6= b, tale equazione presenta due equilibri, x = 0 e x = 1. Se a > b, allora x(t) → 1 e

y(t) → 0, mentre, se b > a avviene il contrario. Nel primo caso l’equilibrio x = 1 è stabile e

il fenotipo A è dominante, mentre nel secondo caso è stabile l’equilibrio x = 0 e il fenotipo

B risulta dominante.

L’analisi può essere estesa a n fenotipi, dove xi (t), i = 1, . . . , n è la frequenza del fenotipo i.

La struttura della popolazione è dunque x = (xP

la fitness di

1 , x2 , . . . , xn ). Se pi rappresenta

Pn

n

ogni fenotipo, avremo che la fitness media φ = i=1 xi pi , dove inoltre i=1 xi = 1.

12

La dinamica selettiva è data dall’equazione

ẋi = xi (pi − φ),

i = 1, . . . , n.

(3.10)

In accordo con quanto visto nel caso di due fenotipi, la frequenza del fenotipo i aumenta se

la sua fitness è maggiore della fitness media della popolazione.

P

P

Si vede facilmente che ni=1 ẋi = 0. L’insieme dei punti tali che ni=1 xi = 1 viene chiamato

simplesso. L’interno del simplesso è tale che xi > 0, ∀i, mentre il bordo è l’insieme dei punti

tali che xi = 0 per almeno un i. Nei vertici tutti i fenotipi hanno frequenza nulla, tranne

uno per cui xi = 1.

L’equazione (3.10) ha un unico punto di equilibrio che si trova su un vertice: partendo da una

qualunque posizione (condizione iniziale) si giunge verso il vertice in cui tutti gli individui

della poplazione appartengono al fenotipo con fitness maggiore.

Supponiamo adesso che la fitness relativa degli individui non sia costante ma dipenda dalla

frequenza stessa dei fenotipi. Supponiamo inoltre che coppie casuali di individui della popolazione interagiscano attraverso un gioco in cui ciascun individuo ha una strategia fissa.

Il payoff del fenotipo corrisponde alla somma dei payoff ottenuti dai singoli individui del

fenotipo e ne rappresenta la fitness. Il successo del gioco diventa un successo riproduttivo. Infatti, le strategie vincenti si riproducono più velocemente e quelle perdenti vengono

sopraffatte (selezione naturale).

Questa classe di modelli è stata largamente utilizzata per spiegare numerose decisioni strategiche del comportamento umano, in quanto il gioco prevede una interazione strategica tra

individui che cercano di massimizzare il proprio payoff.

Siano xA la frequenza del fenotipo A e xB la frequenza del fenotipo B, dunque la struttura

della popolazione è descritta dal vettore x = (xA , xB ). Se pA (x) e pB (x) rappresentano le

fitness dei due fenotipi l’equazione della dinamica è la seguente:

ẋA = xA (pA (x) − φ)

ẋB = xB (pB (x − φ),

dove φ = xA pA (x) + xB pB (x) e xA + xB = 1.

Se poniamo xa = x e xB = 1 − x otteniamo la seguente equazione:

ẋ = x(1 − x) [pA (x) − pB (x)]

13

(3.11)

Gli equilibri di questa equazione sono x = 0, x = 1 e tutti i valori x∗ per cui pA (x∗ ) = pB (x∗ ).

Si presentano tre casi.

1. pA (x) > pB (x). La popolazione tende ad una situazione in cui tutti gli individui sono

del fenotipo A, infatti la frequenza di A aumenta nel tempo. L’equilibrio x = 1 è

stabile.

2. pA (x) < pB (x). La popolazione tende ad una situazione in cui tutti gli individui sono

del fenotipo B, infatti la frequenza di B aumenta nel tempo. L’equilibrio x = 0 è

stabile.

3. pA (x) = pB (x). Si verificano due casi:

3a La tangente alla curva pA = pB nel punto di equilibrio ha coefficiente angolare

positivo. In questo caso il punto di equilibrio è instabile e la popolazione evolverà

verso uno degli altri due (x = 1, o x = 0).

3b La tangente alla curva pA = pB nel punto di equilibrio ha coefficiente angolare

negativo. In questo caso il punto di equilibrio è stabile e la popolazione evolverà

verso di esso. La stabilità degli altri due equilibri dovrà variare di conseguenza.

Nella teoria dei giochi evolutivi si assume che ogni individuo scelga di comportarsi come

uno dei fenotipi della popolazione in base ad un principio di massimizzazione del proprio

payoff (cioè usa la strategia del fenotipo che ritene vincente). In questo caso, tutti i giocatori

hanno la stessa matrice di payoff e la loro scelta consiste nello scegliere di seguire la strategia

evolutiva A o B. Il payoff corrisponde, come già detto, alla fitness.

Sia

a b

c d

la matrice dei payoff relativa alle strategie A e B, dove i payoff della strategia A sono

riportati nella prima riga e quelli della strategia B nella seconda. Dunque la matrice si legge

nel seguente modo: A guadagna a se gioca contro A e guadagna b se gioca contro B. B

guadagna c se gioca contro A e guadagna d se gioca contro B.

Adesso xA rappresenta la frequenza dei giocatori che scelgono A e xB la frequenza dei

giocatori che scelgono B. I payoff (o fitness) di A e B sono:

pA = axA + bxB

pB = cxA + dxB .

14

Dunque la probabilità che ha ogni giocatore di interagire con A è xA e con B è xB , in accordo

con l’ipotesi che due giocatori si incontrino e giochino casualmente.

Se supponiamo che le fitness siano lineari, sostituendo nell’equazione (3.2) si ottiene l’equazione:

ẋ = x(1 − x) [(a − b − c + d)x + b − d] .

3.3

(3.12)

Classificazione dei giochi evolutivi 2x2

Poiché la dinamica replicator è invariante rispetto a cambiamenti locali del payoff, possiamo

supporre, senza perdere di generalità, che la matrice dei payoff abbia la seguente forma:

a1 0

A=

(3.13)

0 a2

dove a1 a2 6= 0. La dinamica replicator in questo caso sarà rappresentata da:

x˙1 = [a1 x1 − a2 x2 ]x1 x2

(3.14)

con x˙2 = −x˙1 . Considerando la classificazione fatta per i giochi non cooperativi nel primo

capitolo, avremo le quattro categorie che verranno, anche in questo caso, classificate in base

ai valori di a1 e a2 . Ponendo l’equazione in un’unica incognita ed utilizzando l’uguaglianza

x1 = 1 − x2 otterremo:

x˙1 = x1 (1 − x1 )[(a1 + a2 )x1 − a2 ]

(3.15)

Rinominando [(a1 + a2 )x1 − a2 ] = F (x1 ). Otterremo stati stazionari (x˙1 = 0) per i seguenti

valori di x1 :

a2

(3.16)

x1 = 0;

x1 = 1;

x1 =

a1 + a2

Poniamo l’ultimo stato stazionario x1 = x∗ . Dovremo verificare che x∗ appartenga al simplesso, ciò viene fatto in accordo con la classificazione riportata nel capitolo 1.

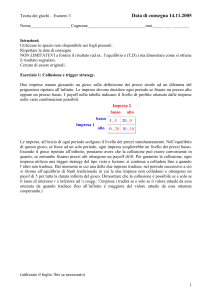

La prima categoria è costituita da giochi in cui a1 < 0 e a2 > 0, in questo caso x∗ non

appartiene al simplesso ed inoltre lo share della popolazione x1 decresce. Dunque la seconda

strategia pura e2 è dominante rispetto alla prima. Potremo visualizzare graficamente questo

risultato nella figura 3.1. Un gioco di questo tipo è il Dilemma del prigioniero, dove a1 = −1

e a2 = 3, la dinamica di replicator in questo caso corrisponde a:

x˙1 = (2x1 − 3)(1 − x1 )x1

15

(3.17)

Figura 3.1: Rappresentazione grafica della prima categoria, nella quale la strategia e2 è

dominante e quindi lo share della popolazione che adotta la prima strategia tende a zero.

La seconda categoria è costituita da giochi in cui a1 a2 > 0. In questo caso otteniamo

un cambio di segno per x1 quando a1 x1 = a2 x2 , questo avviene precisamente nel valore

2

, in questo caso il valore

dell’equilibrio di Nash in strategie miste, ovvero x1 = x∗ = a1a+a

2

∗

di x appartiene al simplesso. Come possiamo osservare dal grafico riportato in figura 3.2,

lo stato stazionario repulsivo. In questo caso lo share della popolazione x1 decresce verso 0

per valori iniziali x01 < x∗ mentre cresce verso 1 per valori iniziali x01 > x∗ . Questo tipo di

dinamica prende il nome di bistabilità. I giochi di questo tipo sono detti di coordinamento,

e l’equazione replicator diventa:

x˙1 = (2x1 − 3)(1 − x1 )x1

(3.18)

La terza categoria è costituita da giochi in cui a1 < 0 e a2 < 0. Anche in questo caso x∗ ,

che corrisponde al valore dell’equilibrio di Nash in strategie miste, appartiene al simplesso,

ed è il valore per il quale la derivata ẋ1 cambia di segno, passando da valori positivi a valori

negativi. Come possiamo osservare dal grafico riportato in figura 3.3 lo stato stazionario

attrattivo. Per valori iniziali minori di x∗ lo share tende a x∗ stesso, per valori maggiori,

invece, decresce verso x∗ . Questo tipo di dinamica prende il nome di coesistenza. Un gioco

di questo tipo è il gioco Falchi e Colombe, dove a1 = −1 e a2 = −2 e l’equazione replicator

in questo caso è:

x˙1 = (2 − 3x1 )(1 − x1 )x1

(3.19)

La quarta categoria, come notato nella teoria dei giochi non cooperativi, è un caso simmetrico

rispetto alla prima categoria. Appartengono a questa categoria i giochi in cui a1 > 0 e

a2 < 0. In questo caso x∗ non appartiene al simplesso, e lo share della popolazione x1 tende

a 1, rendendo dominante la strategia pura e1 . Questo risultato è riportato graficamente nella

figura 3.4.

16

Figura 3.2: Rappresentazione grafica della seconda categoria, in cui lo stato stazionario x∗ è

repulsivo

Figura 3.3: Rappresentazione grafica della terza categoria, in cui lo stato stazionario x∗ è

attrattivo

3.4

Stati stazionari della replicator equation ed equilibri di Nash

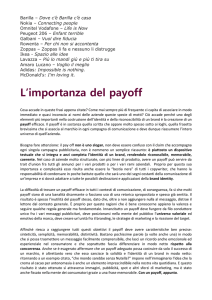

Per i giochi finiti e simmetrici a due giocatori, sia ∆N E ⊂ ∆ il sottoinsieme non vuoto

di strategie che sono in equilibrio di Nash con se stesse. Questa definizione risulta essere

17

Figura 3.4: Rappresentazione grafica della quarta categoria, in cui la strategia e1 è dominante, quindi lo share della popolazione che adotta la prima strategia i, cresce verso

uno

utile per l’analisi dinamica, in quanto una strategia x apparterrà a ∆N E se e solo se tutte

le strategie pure a cui x assegna probabilità positiva ottengono il massimo payoff che può

essere ottenuto contro x. Formalmente:

∆N E = {x ∈ ∆ : π(ei , x) = max π(z, x) ∀i ∈ C(x)}

z∈∆

(3.20)

Andremo ad analizzare la relazione tra questo insieme e l’insieme degli stati stazionari della

equazione replicator.

3.4.1

Stati stazionari e ∆N E

Per definizione, uno stato di popolazione x è stazionario nella (2.4) se e solo se il prodotto

π(ei − x, x)xi è uguale a zero per ogni strategia pura i ∈ K, o equivalentemente, se e solo se

tutte le strategie pure i guadagnano precisamente lo stesso payoff contro la strategia mista

x. Sia ∆0 ⊂ ∆ l’insieme degli stati stazionari della (2.4):

∆0 = {x ∈ ∆ : π(ei , x) = π(x, x) ∀i ∈ C(x)}

(3.21)

La condizione di stazionarietà è banalmente soddisfatta da ogni vertice del simplesso x = ei ,

dal momento che in tale stato x, tutti gli individui utilizzano la stessa strategia pura i e

guadagnano lo stesso payoff. Da qui l’insieme finito {e1 , ..., ek } di vertici è un sottoinsieme

di ∆0 . Un confronto tra la (2.15) e la (2.16) rivela subito che anche l’insieme non vuoto e

18

chiuso ∆N E è un sottoinsieme di ∆0 : se tutte le strategie pure nel supporto della strategia x

guadagnano lo stesso payoff massimo contro x, allora tutti guadagnano il payoff medio della

popolazione.

k

X

X

π(x, x) =

π(ej , x)xj =

π(ej , x)xj

(3.22)

j=1

j∈C(x)

Potremo visualizzare graficamente ciò che è stato appena enunciato tramite la figura 3.5.

Otteniamo lo stesso risultato per gli stati interni della popolazione x: Se x ∈ int(∆) è

Figura 3.5: Relazione tra i punti stazionari delle equazioni di replicator e gli equilibri di

Nash del gioco

stazionario nella (2.4), allora π(ei , x) = π(x, x) per ogni strategia pura i nel gioco, quindi ogni

strategia pura è una best reply per le strategie miste x e conseguentemente x ∈ ∆N E . Sia ora

∆00 (non necessariamente non vuoto) l’insieme di stati stazionari interni ∆00 = ∆0 ∩ int(∆).

Abbiamo appena evidenziato che ∆00 ⊂ ∆N E . Dal momento che tutti gli equilibri di Nash

sono stazionari otteniamo ∆00 = ∆N E ∩ int(∆), inoltre l’insieme ∆00 è necessariamente

convesso, infatti ogni combinazione lineare di stati stazionari è sempre uno stato stazionario.

3.4.2

Stati Lyapunov stabili e ∆N E

Gli stati stazionari che non sono equilibri di Nash, non soddisfano il criterio di stabilità

di Lyapunov (stabilità debole). La ragione per la quale uno stato della popolazione x non

appartenente a ∆N E è instabile, è semplicemente che esistono alcune strategie pure i che

non vengono utilizzate (xi = 0), ma che otterrebbero un payoff maggiore contro x rispetto

alle strategie pure utilizzate nello stato x. Quindi, se un parte arbitrariamente piccola della

19

popolazione iniziasse a utilizzare tale strategia redditizia i, gli individui individui di questo

gruppo guadagnerebbero un payoff maggiore, il che porterebbe lo stato della popolazione a

lasciare x. Tale risultato è dovuto alla Bomze.

Proposizione 3.4.1 Se x ∈ ∆ è Lyapunov stabile nella (2.14), allora x ∈ ∆N E .

Dim. Supponiamo che x ∈ ∆0 e che x ∈

/ ∆N E . Allora tutte le strategie pure nel supporto

C(x) hanno lo stesso payoff non ottimale contro x. Quindi esistono i ∈

/ C(x) tali che

π(ei − x, x) > 0. Dalla continuità di π, esiste un δ > 0 ed un intorno U di x tale che

π(ei −y, y) ≥ δ per ogni y ∈ U ∩∆. Cosı̀ ξi (t, x0 ) aumenta inizialmente in modo esponenziale

da ogni x0 ∈ U ≥ int(∆), e anche xi = 0, quindi x non è Lyapunov stabile.

Potremo visualizzare graficamente le relazioni appena enunciate tra stati stazionari, equilibri

di Nash e stati stazionari Lyapunov stabili tramite la figura 3.6.

Figura 3.6: Relazione tra gli equilibri di Nash e la stabilità dei punti stazionari delle equazioni

di replicator

Come ultima osservazione facciamo notare che tutti gli individui nella popolazione conoscono

la distribuzione delle strategie pure della popolazione durante il trascorrere del tempo, e

cercano di massimizzare il payoff ottenuto contro questa distribuzione. Inoltre se uno stato

è il limite di una soluzione del sistema di equazioni differenziali ordinarie, allora tale stato

è necessariamente stazionario. In particolare, se accade che la traiettoria di una soluzione

della dinamica di replicator converge a qualche stato interno della popolazione, allora questo

20

stato limite appartiene a ∆00 e quindi anche a ∆N E . La seguente proposizione estende questo

risultato agli stati limite che si trovano nel bordo del simplesso (Nachbar 1990):

Proposizione 3.4.2 Se x0 ∈ int(∆) e ξ(t, x0 )t→∞ → x, allora x ∈ ∆N E

Dim. Supponiamo che x0 ∈ int(∆), ξ(t, x0 )t→∞ → x ma x ∈

/ ∆N E . Allora esistono alcune

strategie i ∈ K tali che π(ei − x, x) = per alcuni > 0. Dato che ξ(t, x0 ) → x e che

π è continua, esistono alcuni T ∈ R tali che π(ei − ξ(t, x0 ), ξ(t, x0 )) > /2 ∀t ∈ T . Dalla

(2.14) ẋi = xi /2 ∀t ∈ T , e quindi ξ(t, x0 ) > ξ(T, x0 ) exp((t − T )/2) ∀t ≥ T , implica che

ξi (t, x0 ) → ∞ (da ξ(T, x0 ) > 0), una contraddice l’ipotesi. Quindi x ∈ ∆N E .

Questo risultato potrebbe essere riformulato come segue: Uno stato x ∈ ∆ potrebbe essere

chiamato raggiungibile se esiste qualche stato interno a partire dal quale la soluzione converge

a x e inoltre, ogni stato raggiungibile x ∈ ∆ appartiene al sottoinsieme ∆N E .

3.5

Sintesi dei concetti base ed esercizi

1. Teorema. Se x∗ ∈ SN è un NE del gioco descritto dalla matrice di payoff A, allora x∗ è

uno stato stazionario della RE (cioè x˙∗ = 0). Inoltre, se x∗ è Lyapunov stabile, allora

è un NE del gioco.

2. Teorema. Se x∗ ∈ SN è un ESS del gioco con matrice di payoff A, allora è uno stato

stazionario asintoticamente stabile della RE.

Un esempio di stato stazionario asintoticamente stabile ma non ESS è rappresentato

dall’equilibrio interno al simplesso S3 presente nel gioco descritto dalla matrice 2.2.

Infatti nel gioco vi sono anche altre strategie ESS nel bordo.

Studiare la dinamica del gioco Falchi e Colombe generalizzato, descritto dalla matrice

di payoff (dove C > G):

A=

G−C

2

G

0

G

2

G(G+C)

2C

G(G−C)

2C

G(C−G)

2C

G(C−G)

2C

G(C−G)

2C

.

(3.23)

Sol. La strategia e3 non può essere invasa da e1 o e2 perché è ESS.

Studiare la dinamica del gioco descritto dalla matrice di payoff:

0 10 1

A = 10 0 1 .

1 1 1

21

(3.24)

Sol. La strategia e3 è stabile contro l’invasione di e1 o e2 separatamente, ma non da

una combinazione delle due.

Studiare la dinamica del gioco ”morra cinese” generalizzato:

0 −a2 b3

0 −a3 ,

A = b1

−a1 b2

0

(3.25)

sapendo che l’equilibrio misto (1/3, 1/3, 1/3) è stabile asintoticamente sse a1 a2 a3 <

b1 b2 b3 ed è instabile se a1 a2 a3 > b1 b2 b3 .

3. Studiare la dinamica del gioco a due strategie descritto dalla matrice di payoff:

A=

a b

c d

.

(3.26)

Verificare che in questo caso gli stati stazionari della RE coincidono con gli equilibri di

Nash e sono asintoticamente stabili sse corrispondono a strategie miste ESS. Inoltre,

strategie pure dominanti sono NE, mentre strategie pure dominate non lo sono. Nel

caso della bistabilità, entrambe le strategie pure sono equilibri di Nash. Infine, nel caso

della coesistenza, nessuna strategia pura è un equilibrio di Nash.

22

Capitolo 4

Applicazione dei giochi evolutivi

all’ecologia

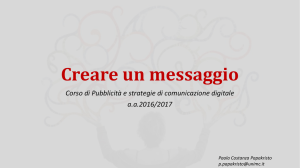

L’interdipendenza delle diverse specie può essere meravigliosamente complessa. Darwin analizzò durante il suo lavoro come le piante e gli animali, e la più remota scala della natura,

sono tenuti insieme da una rete di relazioni complesse. Questa auto-regolamentazione delle

frequenze di popolazione è stato un tema dominante dell’ecologia matematica. La storia

delle comunità ecologiche è raccontata in termini di invasioni ed estinzioni. Per gli ecologisti, stabilità significa che le specie che compongono l’ecosistema persistono. Sopravvivenza,

non equilibrio, è quello che conta. I modelli più comuni per la dinamica delle popolazioni

negli ecosistemi vengono descritti dalle equazioni Lotka-Volterra ed i modelli più comuni per

le dinamiche delle frequenze delle strategie, le equazioni replicator, sono matematicamente

equivalenti. In ambito ecologico analizzeremo il modello predatore preda descritto da equazioni di Lotka-Volterra. Gli ecologisti indagano sull’interazione tra le specie e su quali siano

i cambiamenti che quest’ultime subiscono nel tempo. L’approccio matematico fondamentale per l’ecologia è data dall’equazione di Lotka-Volterra. Negli anni successivi alla prima

guerra mondiale, la quantità di pesci predatori nell’Adriatico è risultato notevolmente più

elevato rispetto agli anni precedenti. Le ostilità tra l’Austria e l’Italia avevano apportato

grandi modifiche, ma perché questo favoriva più i predatori che le prede? Quando fu posta

questa domanda a Volterra egli denotò con x la densità dei pesci preda, mentre con y quella

dei predatori e trovò un’equazione differenziale che rappresentava l’incremento della densità

dei predatori. Volterra assunse che il tasso di crescita della popolazione preda, in assenza

di predatori, è dato da una certa costante, che diminuisce linearmente come la densità dei

predatori y. Questo porta a xẋ = a − by e a, b > 0. In assenza di prede, il pesce predatore

avrebbe dovuto estinguersi, il che significa un tasso negativo di crescita; ma questo tasso

riprende con la densità x delle prede, quindi yẏ = −c + dx con c, d > 0. Ottenendo quindi:

ẋ = x(a − by),

ẏ = y(−c + dx).

23

(4.1)

Elenchiamo adesso gli stati stazionari:

i)x(t) = y(t) = 0

ii)x(t) = 0 y(t) = y(0)e−ct (∀y(0) > 0)

iii)y(t) = 0 x(t) = x(0)eat (∀x(0) > 0)

Ciò significa che se la densità dei predatori o prede è zero ad un certo dato tempo t, allora

è sempre zero. In assenza di prede, i predatori si estinguono, quindi y(t) converge a 0, per

t → +∞. In assenza di predatori, ci troviamo dinanzi ad una crescita esponenziale della

popolazione prede x(t) → +∞. Quest’ultima caratteristica è assurda, e si ha la volontà di

modificarla nei modelli successivi. Queste tre soluzione i), ii), iii) costituiscono tre orbite,

rispettivamente i) l’origine, ii) l’asse x positivo e iii) l’asse y positivo. Insieme costituiscono

il confine di:

2

= {(x, y) ∈ R2 : x ≥ 0, y ≥ 0}

(4.2)

R+

Dal momento che le densità della popolazione devono essere non negative, andremo a con2

della (3.4). Questo insieme è invariante, nel senso che ogni

siderare solo la restrizione a R+

soluzione che inizia in esso vi rimane per tutto il tempo. Infatti, come abbiamo visto, il

2

bordo di R+

è invariante poiché nessuna orbita può attraversarne un’altra per l’unicità della

2

soluzione, l’interno di R+

, definito come:

2

int(R+

) = {(x, y) ∈ R2 : x > 0, y > 0}

(4.3)

2

è anch’esso invariante. Esiste un unico punto stazionario nell’int(R+

), tale punto è identificato da F = (x̄, ȳ), tale che x̄(a − bȳ) = 0 e ȳ(−c + dx̄) = 0, dato che ȳ > 0 e x̄ > 0, questo

implica:

a

c

ȳ =

(4.4)

x̄ =

d

b

I segni di ẏ e ẋ dipendo dalla relazione dei due valori e dei corrispettivi valori stazionari,

quindi se x è maggiore o minore di x̄, e se y è maggiore o meno di ȳ. La figura 4.1 permette

una visualizzazione grafica dell’andamento dello share delle due popolazioni al variare della

relazione che sussiste tra i valori iniziali e i relativi stati stazionari. É interessante chiedersi la

relazione che sussiste tra le equazioni replicator analizzate nel secondo capitolo e le equazioni

di Lotka-Volterra. Le equazioni della (3.4) sono riscrivibili con un sistema analogo alle equazioni replicator. L’equazione replicator in n variabili, x1 , ..., xn è equivalente a l’equazione

Lotka-Volterra in n − 1 variabili y1 , ..., yn−1 .

Teorema 4.0.1 Esiste una mappa differenziabile ed invertibile da Ŝn = {x ∈ Sn : xn > 0}

n−1

in R+

che mappa le orbite dell’equazione replicator

ẋi = xi ((Ax)i − x · Ax)

(4.5)

nelle orbite delle equazioni Lotka-Volterra di equazione:

ẏ = yi (ri +

n−1

X

a0ij yj )

j=1

24

∀i = 1, ..., n − 1

(4.6)

Figura 4.1: Rappresentazione grafica che permette di visualizzare l’andamento dello share

delle due popolazioni.

dove ri = ain − ann e a0ij = aij − anj

Nel nostro modello, il caso specifico delle (3.4) si nota che il numero delle variabili nell’equazione Lotka-Volterra corrisponde a due, il che ci riconduce ad un’equazione replicator a tre

variabili, dove il valore di ri corrisponderà a ai3 − a33 mentre a0ij corrisponderà a aij − a3j .

Considerando yn = 1 e analizzando la trasformazione y 7→ x definita da:

yi

xi = Pn

j=1

i = 1, ..., n

yj

25

(4.7)

n

che mappa {y ∈ R+

: yn = 1} in Ŝn , mentre l’inversa x 7→ y definita come:

yi =

yi

xi

=

yn

xn

i = 1, ..., n

(4.8)

Adesso consideriamo l’equazione di replicator (3.8) in n variabili, assumendo che l’ultima

riga della matrice A = (aij ), n × n, sia nulla. L’equazione diventa quindi:

ẏ =

d xi

x1

=

((Ax)i − (Ax)n )

dt xn

xn

(4.9)

Dato che (Ax)n = 0 otterremo il seguente risultato:

ẏi = yi (

n

X

n

X

aij xj ) = yi (

aij yj )xn

j=1

(4.10)

j=1

Tramite un cambiamento di velocità, potremo eliminare il temine xn . Da yn = 1 otterremo

quindi:

n−1

X

ẏi = yi (ain +

aij yj )

(4.11)

j=1

o con ri = ain l’equazione (3.9) di Lotka-Volterra, il passaggio opposto dalla (3.9) alla (3.8)

è analogo.

26

Bibliografia

• J. Hofbauer and K. Sigmund, Evolutionary games and population dynamics, Cambridge University Press, 1998.

• D. Madeo and C. Mocenni, Game Interactions and dynamics on networked populations,

IEEE Trans. on Autom. Control, vol. 60, n. 7, pp. 1801-1810, 2015.

• J. Maynard Smith, Evolution and the Theory of Games, Cambridge University Press,

Cambridge. 1982.

• J. Nash, Equilibrium points in n-person games, Proc. Nat. Acad. Sci. USA vol. 36,

no. 1, pp. 48-49, 1950. sity Press, 1994.

• M.A. Nowak, Evolutionary Dynamics: Exploring the Equations of Life, Belknap Press

of Harvard University Press, 2006.

• M.J. Osborne, An Introduction to Game Theory, Oxford University Press, 2003.

• J.W. Weibull, Evolutionary Game Theory, MIT Press, 1995.

• J. von Neumann and O. Morgenstern, Theory of games and economic behavior, Princeton University

• C. Brezzi, Teoria dei Giochi: Modelli e Applicazioni in un Contesto Evolutivo, Tesi di

Laura Triennale in Matematica, Università di Siena, 2014.

27