Elaborazione digitale delle immagini

Dal Dizionario: rappresentazione, imitazione di un oggetto o di

una cosa; descrizione grafica o visiva di oggetti o cose;

qualcosa introdotto o rappresentare qualcos’altro.

Es.: foto di Piazza di Spagna e’ la rappresentazione di un luogo

ottenuta mediante una macchina fotografica. L’immagine

contiene l’informazione dell’oggetto che rappresenta. Tale

informazione viene riprodotta dalla fotografia in modo che

l’occhio umano e il cervello possano visualizzare l’oggetto.

Tipi di immagini: fotografie, disegni, documenti, dipinti,

immagini televisive, ologrammi (immagini formate con

dispositivi ottici come lenti, prismi ect.)

Elaborazione digitale delle immagini

Immagini digitali: funzioni f(x,y) che misurano l’intensità

luminosa nei punti di coordinate (x,y) dell’immagine stessa.

Nota1: in seguito si farà riferimento alle immagini in un

contesto di ottica non coerente (l’informazione e’ contenuta

nell’intensità luminosa del campo e.m.=intensità luminosa. Non

si utilizza l’informazione di fase)

Nota2: si farà una trattazione su singola lunghezza d’onda

(come l’occhio percepisce le variazioni d'intensità per una

lunghezza d’onda, omettendo la percezione del colore).

Elaborazione digitale delle immagini

Sono temi di image processing and understanding:

•compressione immagini (image coding)

•analisi di immagini (image analysis)

•riconoscimento di forme (pattern recognition)

•trattamento del segnale video (video processing)

Elaborazione digitale delle immagini

Esempio: robotica per l’automazione delle produzioni

industriali meccaniche ed elettromeccaniche

Scena con

oggetti

Unità di

acquisizione

(Sensori meccanici,

termici, telecamera)

Unità di

elaborazione

decisione e

controllo

(Riconoscimento e inseguimento

degli oggetti)

Unità di

attuazione

Operazione

sugli

oggetti

Elaborazione digitale delle immagini

Vantaggi dell’elaborazione digitale

Precisione:

•ingrandimento fotografico analogico produce una

degradazione dell’immagine

•si può modificare la luminosità di un’immagine con un

circuito analogico, ma il risultato e’ affetto da rumore

introdotto dal circuito stesso.

Flessibilità: permette di ottenere le più svariate combinazioni e

variazioni dei parametri senza dover ricorrere ad apparati

diversi per ciascuna operazione

Alternative: elaborazione ottica

Componenti di un sistema di elaborazione immagini

Modello dell’immagine (1/3)

Una immagine monocromatica e reale può essere caratterizzata

come la distribuzione spaziale di energia radiante prodotta da

una sorgente luminosa tramite una funzione spazio-temporale

reale, non negativa, finita e limitata (rispetto alle variabili

spaziali e temporali).

L'immagine effettivamente percepita (da un osservatore umano)

o acquisita (mediante un trasduttore) è la funzione modificata

dalla risposta dell'osservatore e/o del trasduttore, tipicamente

secondo una media temporale.

Modello dell’immagine (2/3)

L'immagine può quindi essere caratterizzata, d’accordo con

l’intuizione, come una distribuzione bidimensionale di intensità:

f= f (x,y,t)

Più precisamente, in alcuni testi la f è detta irradianza o illuminanza,

ed è definita come:

dΦ

E=

dA

Φ è un flusso luminoso (grandezza “fisiologica”) la cui unità è il Lumen (Lm);

A indica l’area (m).

L’irradianza si misura pertanto nella unità fotometrica lumen/m2 (Lux) a cui

corrisponde un parametro fisico di intensità espresso in W/m2.

Modello dell’immagine (3/3)

Altre grandezze correlate con la radiazione luminosa sono:

• Energia radiante Q [W · s = Joule] alla quale corrisponde

l’energia luminosa [Lm · s]

• Potenza [W] Φ = dQ/dt alla quale corrisponde il flusso luminoso

misurato in Lumen [Lm]

•Intensità radiante I = dΦ/dΩ [W · sr-1] alla quale corrisponde

l’intensità luminosa [Lm/sr = candela]

Acquisizione dell’immagine

• E’ il processo di rivelazione e registrazione che

"ferma" l'immagine su un supporto adatto agli usi

successivi.

• Tecnologie principali: fotochimiche (es. pellicola

fotografica) e optoelettroniche (es. telecamera +

dispositivo di memoria).

• L'acquisizione di una immagine digitale deve

produrre come risultato una immagine numerica su un

supporto accessibile da parte di un dispositivo di

calcolo.

Fasi dell’acquisizione (1/2)

• Scansione

• Trasduzione o rivelazione

• Campionamento

• Quantizzazione

• Scrittura (memorizzazione)

Fasi dell’acquisizione (2/2)

Richiami sul sistema visivo umano (1/9)

Ricettori sulla superficie della retina: coni (sensibilità ai colori, zona centrale

del campo visivo, alta risoluzione), bastoncelli (poco sensibili ai colori,

modesta risoluzione, zona estesa del campo visivo). La loro distribuzione è

radialmente simmetrica rispetto al punto centrale della fovea.

Richiami sul sistema visivo umano (2/9)

.– Supponiamo che la fovea sia un quadrato di 1.5 mm x 1.5 mm.

Poiché la densità dei coni in questa regione è di circa 150,000 per mm2, la fovea

può essere considerata come un array quadrato di circa 337,000 fotosensori.

– La tecnologia odierna consente sicuramente di realizzare chip di sensori di

dimensioni maggiori e con maggior numero di elementi sensibili (pixel

dell’immagine).

– La qualità della visione umana non è quindi dovuta ai sensori, ma

principalmente all’integrazione dell’intelligenza e dell’esperienza che gli esseri

umani usano per completare il processo di percezione visiva.

Elaborazione digitale delle immagini

Struttura dell’occhio

Fotoricettori contenuti dalla retina

Coni:

preposti alla visione diurna o fotopica;

si hanno tre tipi di coni con diverse risposte spettrali grazie hai

quali si ha la visione dei colori

producono una visione più nitida perche’ essendo più sottili

assicurano una più elevata risoluzione spaziale

singolarmente collegati ciascuno a una propria terminazione

nervosa

massima concentrazione dei coni è sulla fovea

Elaborazione digitale delle immagini

Struttura dell’occhio

Fotoricettori contenuti dalla retina

Bastoncelli:

preposti alla visione notturna o scotopica;

molto più sensibili dei coni allo stimolo luminoso

sono connessi a gruppi a un singolo nervo

danno una indefinibile tinta tra il grigio scuro il verde e il blu

massima concentrazione nelle zone periferiche della retina (di

notte posso vedere gli oggetti fissandoli con la coda dell’occhio

anziché direttamente

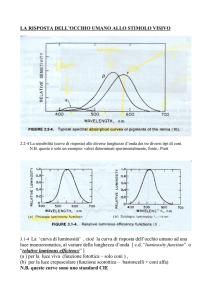

Richiami sul sistema visivo umano (3/9)

Il sistema visivo umano risponde

alla radiazione elettromagnetica nel

campo del visibile, tra 360 nm e

800 nm circa (anche se la sensibilità

dell’occhio è molto ridotta tra 360

nm e 410 nm circa e tra 720 nm e

800 nm circa).

L’energia luminosa è assorbita dalla pigmentazione

fotosensibile dei ricettori. Nei coni, questa pigmentazione è di

tre tipi, il che rende i coni sensibili a differenti gamme spettrali

e quindi rende possibile la percezione del colore.

Richiami sul sistema visivo umano (4/9)

La gamma dei livelli di intensità ai quali l’occhio può adattarsi è enorme

dell’ordine di 1010 (100dB), dalla soglia scotopica (visione “quasi

monocromatica” dei bastoncelli con occhi adattati al buio) al limite

dell’abbagliamento. Una dinamica così elevata è ottenuta anche tramite

l’iride, che riduce automaticamente “l’apertura relativa” dell’occhio: è

identico al diaframma degli obiettivi fotografici.

La luminosità soggettiva (cioè la luminosità percepita dal sistema visivo

umano) è una funzione logaritmica dell’intensità della luce incidente

sull’occhio.

E’ importante notare che l’occhio non funziona simultaneamente sulla

intera gamma dei livelli. Piuttosto, il sistema passa attraverso una serie di

livelli di adattamento alla intensità della luce

Richiami sul sistema visivo umano (5/9)

Richiami sul sistema visivo umano (6/9)

Se per esempio l’occhio si trova, in certe condizioni

ambientali, al livello di adattamento Ba, la gamma dei livelli

che esso può discriminare è soltanto quello indicato dalla

curva corta, che ha Bb come limite sotto il quale nessuno

stimolo produce una sensazione diversa dal nero

La porzione tratteggiata indica che a livelli superiori a Ba

in realtà l’occhio si sposta su un livello di adattamento

superiore

E’ molto importante la capacità dell’occhio di discriminare tra

variazioni della luminosità, ai diversi livelli di adattamento

Una grandezza utile, in termini quantitativi, è il cosiddetto

rapporto di Weber

Log ∆I/I

Sistema visivo umano: Il rapporto di Weber (7/9)

Log I

Sistema visivo umano: Il rapporto di Weber (8/9)

Si tratta del rapporto dI/I, essendo dI la variazione di

luminosità e I la luminosità: un piccolo valore di dI/I significa

che una piccola variazione percentuale dell’intensità è

discriminabile (quindi una buona capacità di discriminazione

delle variazioni)

Viceversa, alti valori del rapporto di Weber indicano la necessità

di forti variazioni di luminosità, affinché le variazioni stesse

siano avvertibili

Come il grafico mostra, la capacità di discriminazione

migliora al crescere del livello di illuminazione

Sistema visivo umano: percezione dell’intensità (9/9)

La luminosità percepita non è soltanto funzione

dell’intensità: un fenomeno tipico è quello del contrasto

simultaneo: il contesto contribuisce alla determinazione

della luminosità di una regione.

I quadrati hanno la stessa intensità, ma quello su sfondo scuro

appare più chiaro di quello su sfondo chiaro. Appaiono uguali

solo quando sono a contatto.

Natura ondulatoria della luce (1/2)

Natura ondulatoria della luce (2/2)

n1

c =λ⋅ f

n2>n1

c

ni =

vi

n1

vi = λi ⋅ f

Intensità delle immagini (1/2)

üL’irradianza di una scena (da ora in poi chiamata intensità, come d’uso in

Image Processing) può essere rappresentata mediante il prodotto di due

termini, l’illuminazione i(x,y) e la riflettanza r(x,y):

üL’immagine è costituita da una componente dovuta alla luce proveniente

dalla sorgente di illuminazione che è modulata e da una componente dovuta

alla luce riflessa dagli oggetti presenti nella scena.

üLa componente di illuminazione è responsabile delle variazioni lente di

luminosità (basse frequenze spaziali), mentre la componente di riflettanza

dà luogo alle variazioni brusche di luminosità, spesso in corrispondenza ai

contorni o bordi degli oggetti (alte frequenze spaziali)

Intensità delle immagini (2/2)

üL’effettiva natura di i(x,y) è determinata dalla sorgente luminosa,

mentre r(x,y) dipende dalle caratteristiche degli oggetti presenti nella

scena, e varia tra 0 (assorbimento totale) e 1 (riflessione completa)

üI limiti di cui sopra sono ovviamente teorici, valori reali (tipici) sono

i seguenti:

Sorgente luminosa

Chiaro di luna

Interno (ambiente di lavoro, almeno)

Cielo nuvoloso

Luce solare

Oggetto

Velluto nero

Grigio di riferimento (cartoncino Kodak)

Parete bianca a calce

Argento e altri metalli chiari

Neve fresca

i (candele)

0.01

100

1000

9000

r

0.01

0.18

0.80

0.90

0.93

Intensità delle immagini e scala di grigi

üSi può pertanto assumere che Lmin<f(x,y)<Lmax, dove valori

ragionevoli per Lmin e Lmax sono:

Lmin≅0.005 cd Lmax ≅200 cd(interni)

Lmax ≅ 10000 cd (esterni)

üPer una immagine monocromatica, l’intervallo [LMin, LMax]

prende il nome di scala dei grigi, mentre l’intensità f(x,y) è detta

anche livello di grigio dell’immagine nel punto di coordinate (x,y)

üIn pratica si usa una scala dei grigi convenzionalmente

compresa in [0,L-1], in cui 0 corrisponde al nero e L-1

rappresenta il bianco, nella quale si considerano L livelli discreti

di grigio per tenere conto del carattere digitale della f dopo la

quantizzazione dell’intensità.

Immagine come matrice di pixel(1/2)

üTenendo conto anche del campionamento spaziale che rende

discreti gli intervalli di variazione delle due dimensioni

dell’immagine, x e y, e assumendo che l’immagine continua sia

approssimata mediante M x N campioni equispaziati lungo x e y,

con:

Immagine come matrice di pixel(2/2)

üUn'immagine digitale monocromatica pertanto è una matrice f(x,y) di

valori discreti di intensità luminosa (livelli di grigio)

ü Essa è costituita da M*N pixel (picture elements)ciascuno dei quali ha un

valore appartenente all'intervallo [0, L-1] essendo L i livelli possibili di

intensità (o di grigio)

ü Si ha tipicamente L = 2b, dove b è il numero di bit usato per codificare

ciascun pixel (profondità del pixel)

ü Per esempio, con 8 bit si ha la possibilità di rappresentare un numero di

livelli (256) tale da consentire una discriminazione dei grigi accettabile nella

maggior parte delle applicazioni, in quanto abbastanza prossima a quella

dell'occhio umano

ü Una immagine monocromatica tipica (1024 x 768 x 8) occupa pertanto

circa 6 Mbit di memoria; con “tre” piani di colore si arriva a circa 18 Mbit,

tali valori comportano spesso necessità di “compressione” dell’immagine.

La dinamica dell’immagine (1/3)

ü Si è fatta l’ipotesi implicita di una quantizzazione lineare per

la produzione degli L livelli discreti di grigio a partire dalla

intensità luminosa

ü La risposta del sistema visivo umano, tuttavia, non è lineare,

bensì logaritmica: l’occhio può discriminare un numero enorme

di livelli di luminosità, ben maggiore dei 256 precedentemente

ipotizzati.

ü Pertanto una immagine digitalizzata ha spesso una dinamica

molto meno ampia di quella del sistema visivo umano, o in altri

termini c’è l’esigenza, per immagini di qualità, di usare più di 8

bit.

La dinamica dell’immagine (2/3)

ü Le limitazioni di dinamica sono evidenti quando la

scena è ad elevato contrasto: se il sensore è lineare, le

parti scure risulteranno sottoesposte (ripresa effettuata

con obiettivo poco aperto), oppure le parti chiare

risulteranno sovraesposte (obiettivo molto aperto):

La dinamica dell’immagine (3/3)

ü Una soluzione più generale al problema delle scene

caratterizzate da una dinamica troppo ampia è adottata nelle

videocamere, in cui la grandezza quantizzata non è direttamente

l’intensità, ma una sua funzione esponenziale.

ü Se g è il livello di grigio e f l’intensità, si ha cioè:

g=f γ

con

γ <1

ü Questa correzione permette di approssimare la caratteristica

logaritmica del sistema visivo umano

üIl valore γ che meglio realizza questa condizione è (tipicamente)

0,4.

Risoluzione spaziale e

pixel (1/6)

ü Ogni pixel rappresenta l’intensità

nella corrispondente posizione della

griglia di campionamento

ü Un pixel rappresenta in realtà non

soltanto un punto dell’immagine, ma

piuttosto una regione rettangolare

coincidente con una cella della griglia

üIl valore associato al pixel

rappresenta pertanto la intensità media

della cella

Risoluzione spaziale e pixel (2/6)

Risoluzione spaziale e pixel (3/6)

ü Se si fanno variare le dimensioni dei pixel, le dimensioni

dell’immagine restano invariate al variare della risoluzione

üSe la dimensione dei pixel resta invariata, la variazione di

risoluzione provoca invece una variazione delle dimensioni

dell’immagine

üCon pixel di grande dimensione, non solo la risoluzione

spaziale è scadente, ma appaiono ben visibili le discontinuità

di grigio al confine tra i pixel

Risoluzione spaziale e pixel (4/6)

Risoluzione spaziale e pixel (5/6)

ü Man mano che le dimensioni dei pixel si riduce, l’effetto

diventa meno visibile, fino al punto che si ha l’impressione di

un’immagine continua, quando la dimensione dei pixel

diventa più piccola della risoluzione spaziale del sistema

visivo umano

üSiccome quest’ultima dipende dalla distanza e dalle altre

condizioni di osservazione, in generale non è definibile a

priori il numero di pixel necessari a garantire una buona

qualità dell’immagine

üSicuramente la dimensione dei pixel deve essere piccola in

relazione alla scala degli oggetti rappresentati nell’immagine.

Risoluzione spaziale e pixel (6/6)

Effetti del numero di livelli di quantizzazione (1/3)

Effetti del numero di livelli di quantizzazione (2/3)

Effetti del numero di livelli di quantizzazione (3/3)