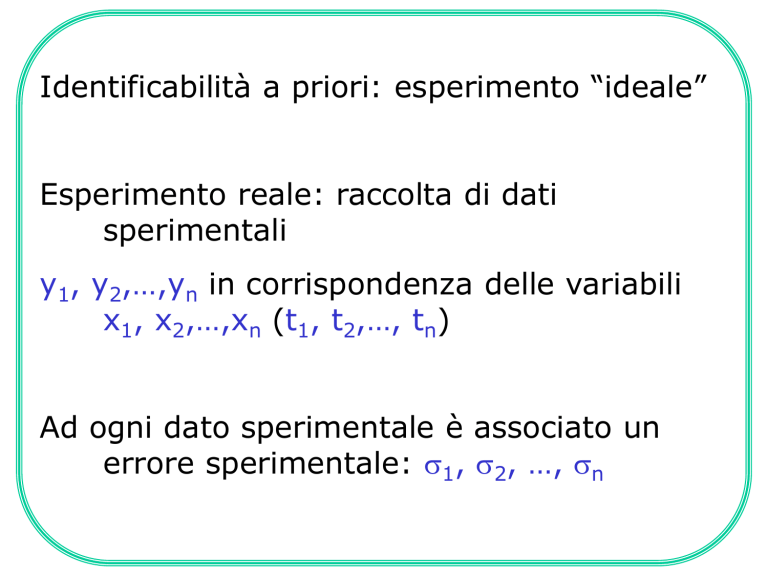

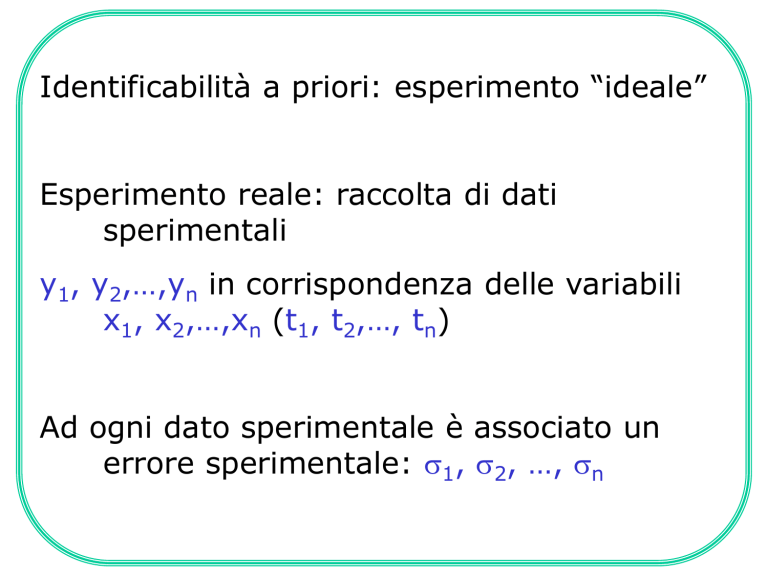

Identificabilità a priori: esperimento “ideale”

Esperimento reale: raccolta di dati

sperimentali

y1, y2,…,yn in corrispondenza delle variabili

x1, x2,…,xn (t1, t2,…, tn)

Ad ogni dato sperimentale è associato un

errore sperimentale: 1, 2, …, n

In corrispondenza delle variabili x1, x2,…,xn

(t1, t2,…, tn) il modello fornisce le sue

previsioni:

fi=f(ti,p1,p2,…,pp)

Confronto tra misure e previsioni del

modello:

errori di misura

errori nel segnale di input

errori nella struttura del modello

STIMATORI

n

:R R

p

Unbiasedness:

la funzione di distribuzione probabilità dei

vettori p è distribuita simmetricamente intorno al valore vero p0

Varianza minima:

tra tutti i possibili stimatori unbiased,

deve avere varianza minima:

2 p 2 p

p R p

Efficienza:

uno stimatore efficiente è quello che raggiunge il

valore più basso della covarianza (limite inferiore di Cramer-Rao).

Consistenza:

Al tendere all’infinito della dimensione del

campione (del numero di misure effettuate) la stima tende al valore

vero p0:

lim Z t1 , , Z tn p0

n

METODO DEI MINIMI QUADRATI

T

1

Ce R e

e= differenza tra valore misurato e

previsione del modello

R = matrice di covarianza degli errori

di misura.

HP: MODELLO LINEARE NEI PARAMETRI

Questo stimatore verifica le condizioni richieste sopra (in

particolare, la varianza minima, che non è invece verificata se non

c’è la matrice di covarianza). Nel caso in cui gli errori di misura

sono bianchi (cioè, non correlati) la matrice di covarianza è

diagonale. Se inoltre gli errori di misura sono gaussiani, allora le

stime sui parametri ricavate con questo stimatore sono distribuite

normalmente con media e deviazione standard come ricavate dal

fit. E’ quindi possibile fare tutta una serie di considerazioni di tipo

statistico riguardanti la bontà del fit e gli intervalli di confidenza.

METODO DEI MINIMI QUADRATI

2

n

y i f t i , p1 , , pp

SSWR

i 1

i

Squared sums of the weighted residuals (objective function)

y ji f j t ji , p1 , , pp

SSWR

ji

j 1 i 1

m

n

SSWR

2

pk

2

y ji f j t ji , p1 , , pp

fj t ji, p1, , pp 0

2

ji

pk

j 1 i 1

m

n

k 1p

METODO DEI MINIMI QUADRATI

modello lineare nei parametri

f j t, p1, , pp

fj t, p1, , pp

pk

pk

p

z jh t ph

h 1

p

z jh t ph z jk t

h 1

p

y

z jh t ji ph

m n ji

z t 0

h 1

2

jk ji

2

ji

j 1 i 1

k 1p

METODO DEI MINIMI QUADRATI

Modello non lineare nei parametri

In questo caso, la funzione da minimizzare non è più

quadratica nei parametri incogniti, e quindi quando si

considerano le derivate per la minimizzazione non si ha più

un sistema di equazioni lineari del prim’ordine in p: soluzioni

possibili utilizzando procedure iterative.

PROCEDURA PIU’ COMUNE:

Algoritmo di LevenbergMarquardt

Metodo delle approssimazioni

quadratiche

Metodo della massima pendenza

(steepest descent)

ALGORITMO DI LEVENBERG-MARQUARDT

Metodo delle approssimazioni quadratiche

Approssimazione della funzione obiettivo in un intorno di un

dato set di valore del vettore dei parametri p

SSWRp p SSWR p 2 b p p A p

n

dove b è un

yi f ti , p1, , pp f ti , p1, , pp

1 SSWR

bk

vettore p2

2 pk

pk

i

i 1

dimensionale

legato al

1 2SSWR

akl

gradiente

2 pk pl

della

funzione

f ti , p1, , pp f ti , p1, , pp

obiettivo, e A

n

pk

pl

1

una matrice

2

2

di dimensioni

f ti , p1, , pp

i 1 i

yi f ti , p1, , pp

pxp

p p

k

l

ALGORITMO DI LEVENBERG-MARQUARDT

Metodo delle approssimazioni quadratiche

Si valutano i valori dei componenti di A e b in

corrispondenza di un determinato valore pj del vettore dei

parametri, e si calcola poi

pj+1=pj+A-1b

Metodo della steepest descent

In questo caso l’incremento in ogni iterazione si calcola

pj+1=pj+c·b

ove c è una opportuna costante.

Il primo metodo più efficace vicino al minimo, il secondo

metodo più efficace lontano dal minimo.

METODO DELLA MASSIMA VEROSIMIGLIANZA

Questo metodo richiede in anticipo una conoscenza di qual è

la distribuzione di probabilità attesa per i risultati delle

misure.

Al processo di raccolta dei dati sperimentali va associata una

FUNZIONE DI DISTRIBUZIONE DI PROBABILITA’, che sarà in

qualche modo dipendente dai parametri del modello: L(y,

p).

Dato un set di misure y1, y2,…, yn, viene quindi ricercato il

valore dei parametri che rendono massima la probabilità di

ottenere quei valori misurati:

ln Ly1, y2 , , yn , p 0

p

Lo stimatore ML possiede tutte le proprietà asintotiche

richieste nel caso in cui le misure sono statisticamente

indipendenti, ma questo non è garantito nel caso di numero

piccolo di misure.

METODO DELLA MASSIMA VEROSIMIGLIANZA

Nel caso in cui la funzione di probabilità è gaussiana, allora

la funzione da massimizzare risulta la seguente:

1

y f T R 1 y f

1

L

2n

R

e

2

essendo R la matrice di covarianza degli errori, che nel caso

siano tutti indipendenti è diagonale e quindi:

L

n

1

2 e

i 1

1 yi f ti ,p1 ,p2 ,,pp

2

i2

2

i

I due metodi coincidono, e quindi anche nel caso di modelli

non lineari valgono le proprietà asintotiche dello stimatore

ML.

DISTRIBUZIONE DEL CHI-QUADRATO

Si consideri una serie di misure (x1,…,xn) rappresentative di una

popolazione con valore vero μ e con varianza σ. Si definisce chiquadrato:

2

n

xi

i 1

2

Funzione di distribuzione di probabilità per ν gradi di libertà

f

,

1

2

22

2

1

2

2 2 1

e 2

0

2

ove:

Γ(x+1) = xΓ(x);

Γ(1) = 1

Γ(1/2) =

All'aumentare dei gradi di libertà, la distribuzione del chi-quadrato

tende alla distribuzione normale.

DISTRIBUZIONE DEL CHI-QUADRATO

0.5

n

n

n

n

n

n

0.4

f(u,)

0.3

=

=

=

=

=

=

1

2

3

4

5

10

0.2

0.1

0.0

0

5

10

15

u

20

25

DISTRIBUZIONE DEL CHI-QUADRATO

SI DIMOSTRA CHE, SE LE OSSERVABILI SONO

DISTRIBUITE NORMALMENTE, IL VALORE MINIMO

ASSUNTO DA SSWR E' DISTRIBUITO COME UNA

VARIABILE χ2 CON (n-p) GRADI DI LIBERTA’

POSSIBILITA' DI VALUTARE IN MANIERA

STATISTICA LA BONTA' DEL FIT.

DISTRIBUZIONE DEL CHI-QUADRATO

SI DIMOSTRA CHE, SE LE OSSERVABILI SONO

DISTRIBUITE NORMALMENTE, IL VALORE MINIMO

ASSUNTO DA SSWR E' DISTRIBUITO COME UNA

VARIABILE χ2 CON (n-p) GRADI DI LIBERTA’

POSSIBILITA' DI VALUTARE IN MANIERA

STATISTICA LA BONTA' DEL FIT.

Nel caso dell'analisi compartimentale, sono stati sviluppati degli

indicatori appositi che permettono di avere informazioni sulla bontà

del fit, ma che in particolare sono utili per confrontare tra loro

strutture compartimentali "concorrenti":

AIC (Akaike Information Criterion): uMIN + 2n

SC (Schwarz Criterion): uMIN + n·ln(N)

Criterio di convergenza

Come varia il peso associato ad un dato

sperimentale a seconda delle opzioni scelte

ERRORE ESPRESSO COME

SD=d

Dati

ASSO

LUTO

RELA

TIVO

1

2

d

1

2

d

FSD=f

Modello

1

2

d

1

2

d

Dati

1

2

f y

1

2

f y

Modello

1

2

f s

1

2

f s

Modello di varianza

In ogni iterazione, il programma cerca valori dei

parametri che risultano in una diminuzione del

valore della funzione obiettivo. Se, per ogni

parametro, la differenza tra il valore assunto

dal p nella i-esima iterazione e quello assunto

nella iterazione precedente verifica la

relazione:

pi pi1 p U pL

allora si considera soddisfatto il criterio di

convergenza.

y i f x i , p

RESIDUI: s _ wres

i

2

y

f

x

,

p

CHIQUADRO: 2 i i

i

i

Iniettato

Residuo

0.147

-0.735

0.365

0.965

-0.335

0.653

0.039

-0.286

-1.876

1.090

0.476

1.882

Ingerito

Chiquadro

0.022

0.540

0.133

0.931

0.112

0.426

1.52e-3

0.082

3.519

1.188

0.227

3.542

10.724

Residuo

0.202

-0.356

0.622

0.114

0.246

0.160

0.517

0.101

-0.233

-1.436

0.494

-0.748

Chiquadro

0.041

0.127

0.387

0.013

0.061

0.026

0.267

0.010

0.054

2.062

0.244

0.560

3.851

14.575

CHI QUADRO

Chiquadro calcolato: 14.575

Numero di gradi di libertà:

numero di dati sperimentali

meno numero di parametri determinati: 24-7 =

Chiquadro ridotto: 0.857

Probabilità: 62.88 %

(0.8: 70%; 1.0: 45%)

17