Calcolo delle probabilità per le

scuole superiori

Laboratorio

Convegno "Il piacere di insegnare - il

piacere di imparare la matematica"

Alberto Gandolfi

[email protected]

Appunti completi disponibili su

http://bb.math.unifi.it/~gandolfi/didindex.html

Eventi casuali

• Il calcolo delle probabilità e la statistica costituiscono quella parte

della matematica e, più in generale, della scienza che si occupa di

fenomeni casuali.

Partiamo da due problemi.

• Problema 1: lanciando 1000 volte una moneta, quale sarebbe la

vostra reazione di fronte a 510 teste? E a

492, 459, 423, 397, 354, 299, 212, 154, 22?

• Problema 2: cercando la porta vincente tra 3, ne scegliamo una e

poi ci viene mostrata una porta non vincente tra le altre: conviene

cambiare la nostra scelta? O preferiremmo che la porta fosse aperta

prima di fare la scelta?

Probabilità

In questi problemi non si riesce a determinare con certezza

l'esito tra varie possibili alternative.

Due cause possibili:

- mancanza di informazioni

- l'indeterminatezza connaturata.

Ma non ci interessa: per l'indeterminatezza chiameremo tali

eventi "casuali".

Per fare comunque previsioni introduciamo una nuova

quantità: la probabilità.

Caratteristiche della probabilità

- Non importa la sua vera natura: basta che sia misurabile

ed utile in casi interessanti.

- Si determina attraverso processi logici.

- E' un numero puro e si esprime in genere in frazioni di

100 (tipo 30%) o con un numero in [0,1].

Quest'ultimo metodo è conveniente per le moltiplicazioni: il 3% del 40% è

l'1,2%, facilmente ottenibile da 0,03x0,40=0,12.

Interpretazioni della probabilità

• Esistono varie scuole su come definire la

probabilità:

• - Frequentista

• - Soggettiva

• - Bayesiana

• - Convenzionalismo

Obiettivi didattici

nell'insegnamento della probabilità:

• deduzione logica di una teoria da alcune ipotesi

• fornitura di alcuni elementi per l'interpretazione del

mondo reale, inclusi giochi, dati, sondaggi

• esemplificazione dell’uso di alcuni strumenti matematici

presentati nel corso

Prima formalizzazione

• Iniziamo da una formulazione elementare,

che può rimanere l’unica se si intende

esporre una parte limitata della teoria.

• Con qualche esempio si vede la naturalezza dell’uso

della terminologia insiemistica per descrivere le

probabilità:

- Tutte le realizzazioni possibili sono un insieme S

- Un evento è un sottoinsieme di S

- La probabilità è una funzione P sui sottoinsiemi di S

Probabilità uniformi

Alcune proprietà elementari

da derivare (o far derivare) rigorosamente

Calcolo combinatorio

Probabilità finite

• Per poter fare modelli di situazioni più

generali si considerano casi in cui

probabilità non sono tutte uguali.

• Si prendono come punti di partenza le prime tre

proprietà dimostrate nel caso uniforme:

Costruzione delle probabilità finite

• La teoria è molto elementare e tutti gli

esempi di spazi di probabilità finiti si

costruiscono come segue:

Probabilità dell’unione di eventi

• Talvolta è utile dedurre la probabilità da

quella di eventi più semplici.

Probabilità del complemento

• Nello stesso spirito di prima:

Indipendenza

Due direzioni dell’indipendenza

L’indipendenza naturalmente è utile quando

si usa senza verificarla. Questo pone

qualche problema di consistenza con

definizione precedente.

Per i corsi elementari accontentiamoci di

dire che omettiamo la verifica.

Indipendenza dei complementi

• Un risultato elementare che verifica che la

teoria si sta sviluppando coerentemente

riguarda l’indipendenza dei complementi:

Riepilogo primi calcoli delle

probabilità

Distribuzione di Bernoulli

• Con i metodi appena riassunti si ricava la

distribuzione di Bernoulli o Binomiale (n,p):

k

Prob k succ su 2k prove

10

0,176197

20

0,125371

30

0,102578

40

0,088928

50

0,079589

60

0,072685

70

0,067313

80

0,06298

90

0,059388

100

0,056348

110

0,053732

120

0,05145

130

0,049435

10

0,176197

100

0,056348

1000

0,017839

10000

0,005642

100000

0,001784

1000000

0,000564

10000000

0,000178

1E+08

5,64E-05

1E+09

1,78E-05

Foglio di calcolo

• Usando le funzioni di

un foglio elettronico di

calcolo si possono

calcolare alcune

probabilità. Ad

esempio il valore

della distribuzione

Binomiale(n, p). Qui

di fianco i valori di

p(k,2k,1/2).

1E+10

#NUM!

1E+11

#NUM!

1E+12

#NUM!

Osservazioni sulle monete

• Anche il numero di teste che ci aspettiamo

(n/2 su n) ha probabilità che tende a 0.

Quindi queste espressioni non servono

per il problema 1.

• E’ chiaro però che la probabilità di un

numero di successi minore o uguale a k

può non tendere a 0.

Riprenderemo la questione quando avremo più strumenti.

Interpretazioni della probabilità

• Vediamo i progressi fatti: sui problemi

(1) sappiamo scrivere le varie probabilità

(2) nessun progresso

Come interpretare le probabilità?

-

A priori ci si aspetta che specifici eventi di probabilità piccola

non si realizzino

-

A posteriori: si sarà realizzato qualche evento di probabilità

piccola, ma non era prevedibile quale.

Probabilità condizionate

• Talvolta interessa la probabilità di un

evento sapendo che un altro si è

realizzato.

Anche in questo caso ci sono due direzioni: a volte si ricava

P(A|B) dalla situazione concreta e lo si usa per ottenere uno

degli altri termini.

Probabilità totali o composte

Dimostrazione del teorema

Il problema del premio dietro alla

porta

•

Finalmente abbiamo gli strumenti per rispondere al problema 2:

Formula di Bayes

Formula di Bayes e probabilità condizionate sono usate ampiamente

nei calcoli di genetica.

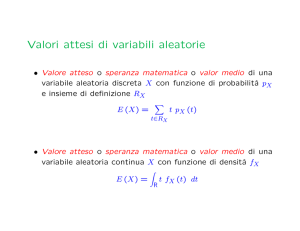

Variabili aleatorie

• Una funzione X definita su un insieme S su cui sia

definita una probabilità P è detta variabile aleatoria

• La sua distribuzione è l’insieme dei valori x che assume

e delle relative probabilità P(X=x).

Valore atteso

• Con qualche esempio si vede che il valore

atteso o valor medio emerge sia come risultato

medio dopo molte prove che come valutazione

equa di un esperimento aleatorio.

Significato del valore atteso

Linearità del valore atteso

• Il valore atteso è lineare.

• Questa dimostrazione si può cominciare ad omettere.

Indipendenza di variabili aleatorie

La verifica che questa definizione generalizza l’indipendenza di

eventi è un po’ laboriosa dovendo considerare sottofamiglie di

eventi e si omette.

Misure della deviazione dal valor

medio

• Per valutare quanto in media una variabile

aleatoria si discosta dal suo valore atteso

si introduce la deviazione standard SD:

• per valutare la quale il primo passo è la

varianza:

Additività della varianza

• Sorprendentemente, la varianza è additiva

per variabili aleatorie indipendenti.

•

(volendo si può presentare agli studenti una dimostrazione)

Deviazione standard per il numero

di teste

Per cui per n lanci di una moneta, essendo p=1/2, la deviazione

standard è

½

Questo suggerisce già qualcosa sul problema delle monete, ma prima

di completare l’analisi introduciamo le variabili continue.

Variabili continue

• Finora si sono viste variabili aleatorie con

un numero finito di valori. Vari esempi

suggeriscono che a volte è utile

considerare variabili che assumono valori

sul continuo.

• Ad esempio se si spezza un bastoncino a

caso o si considera l’orario di un arrivo.

Densità delle variabili continue

• Le variabili aleatorie continue sono ben

descritte prendendo una densità di

probabilità f, analoga alla densità di

massa, che soddisfa:

• La probabilità poi si calcola con gli integrali

Esempi di variabili continue

Valore atteso di variabili continue

Funzione di distribuzione

• Un altro modo per descrivere una variabile

aleatoria è la funzione di distribuzione.

Non è un metodo intuitivo, ma talvolta è

molto utile:

Simulazione di una variabile

uniforme

Simulazione di variabili continue

Analisi di dati

• Per analizzare dati casuali (che interpretiamo come

realizzazioni di variabili aleatorie) si utilizzano le stesse

quantità calcolate però sui dati, e quindi dette empiriche:

indicate nei fogli di calcolo con funzioni tipo MEDIA,

DEV ST, VAR

•

Il valor medio empirico è anche detto media empirica e può essere a sua volta

pensato come funzione delle variabili aleatorie.

Convergenza della media empirica

Teorema centrale del limite

• Con qualche calcolo questo risultato permette di

stimare molto accuratamente la probabilità che

la somma di variabili indipendenti disti più di una

data costante dal valore atteso.

Illustrazione grafica del TCL

• Ci sono molti siti in cui si può vedere come

la distribuzione della somma di variabili

indipendenti converge ad una normale.

• Per le variabili Bernoulli si veda per

esempio

http://cnx.org/content/m11198/latest/

Stima della deviazione dal valore

atteso

Stima della deviazione della media

empirica dal valore atteso

• Abbiamo visto che la media empirica approssima il valore atteso,

ma il TCL permette di dare una stima più accurata:

• Questa osservazione si usa nei problemi di misura fornendo una

stima di quanto la media empirica delle misurazioni disti dalla

misura “vera”.

Variabili congiunte

• Spesso si considerano più variabili

aleatorie allo stesso momento. Queste

possono essere non essere indipendenti,

e quindi occorre una trattazione delle

distribuzioni congiunte.

• In un corso di scuola superiore conviene

però limitarsi ad un caso semplice: una

misura del grado di dipendenza di due

variabili aleatorie.

Correlazione

• Date due variabili aleatorie X ed Y si

introduce la covarianza:

• E poi la misura adimensionale della

dipendenza, detta correlazione:

Proprietà della correlazione

• La correlazione soddisfa:

• Quando r=1 oppure r=-1 c’è dipendenza

lineare tra X ed Y. Quando X ed Y sono

indipendenti r=0. Per cui r misura la

dipendenza di X ed Y

Correlazione empirica

• I fogli di calcolo forniscono di solito una

funzione, a volte indicata con

CORRELAZIONE che calcola questo

valore sui dati.

Test: un modello per pesi ed

altezze