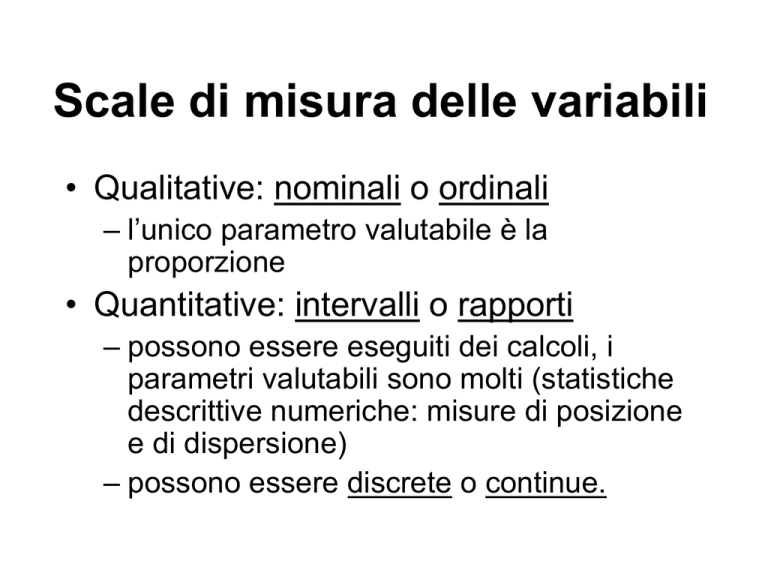

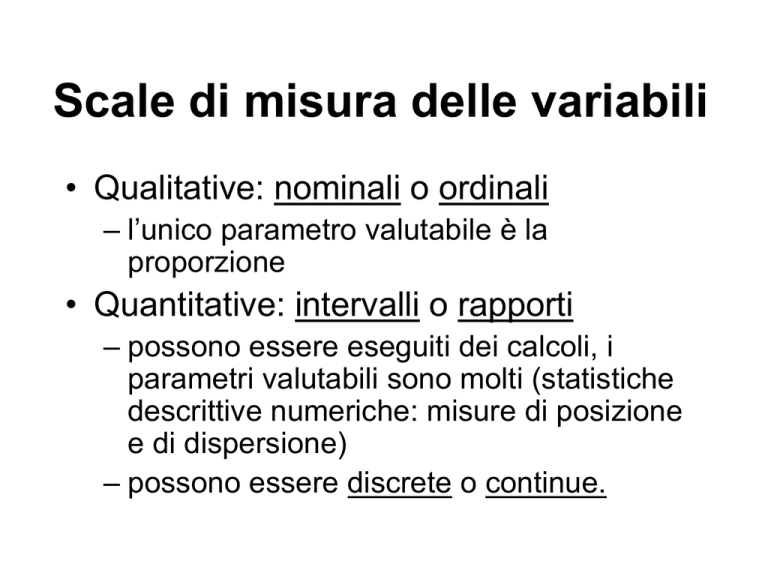

Scale di misura delle variabili

• Qualitative: nominali o ordinali

– l’unico parametro valutabile è la

proporzione

• Quantitative: intervalli o rapporti

– possono essere eseguiti dei calcoli, i

parametri valutabili sono molti (statistiche

descrittive numeriche: misure di posizione

e di dispersione)

– possono essere discrete o continue.

Richiami di statistica descrittiva

Descrivere e sintetizzare i dati osservati attraverso

grafici (es. distribuzioni di frequenza), indici di

posizione e dispersione

• Dati univariati

• Dati bivariati

• Dati multivariati

Indici di posizione

Indicano la tendenza centrale di un insieme di dati

Media aritmetica

1 n

x xi

n i 1

Proprietà della media aritmetica:

la sommatoria degli scarti di ogni dato dalla media (momento di 1° ordine) è nulla.

x x 0

n

i

i 1

n

( x1 x) ( x2 x) .. ( xn x) xi n x 0

i 1

la sommatoria del quadrato degli scarti (momento di 2° ordine) è minima

(ovvero non esiste alcun altro punto che sostituito alla media dia un valore inferiore

x x

n

i 1

2

i

min

Indici di posizione

media aritmetica

Se i dati sono espressi come frequenze:

n

fx

x

f

i 1

i i

media aritmetica ponderata

i

Se i dati sono espressi come proporzioni:

n

x pi xi

i 1

Indici di posizione

Mediana: divide la serie ordinata in due parti di uguale numerosità

Moda: è il valore della classe a cui corrisponde la maggiore frequenza.

Media armonica: è il reciproco della media dei reciproci, idonea a

mediare rapporti tra 2 variabili.

Media geometrica: è la radice ennesima del prodotto di n dati.

Idonea per mediare tassi.

Indici di tendenza centrale resistenti

Trimmed mean: media aritmetica nella quale non

vengono considerate le code della distribuzione (es.

il 5% dei dati)

M-estimators (Maximum likelihood estimators):

media aritmetica pesata con peso funzione della

distanza dal valore centrale. Si differenziano per la

funzione di assegnazione dei pesi.

Indici di dispersione

Quantili: misure di posizione non centrale. Sono valori che dividono

la serie ordinata in un certo numero di parti di uguale numerosità.

Percentili: dividono la serie ordinata in 100 parti uguali. Il p-esimo

percentile di una distribuzione è quel valore con p% dei valori inferiori

ad esso. In statistica inferenziale sono interessanti il 1, 2.5, 5, 95,

97.5 e 99 esimo percentile

Quartili dividono la serie ordinata in 4 parti uguali. Sono il 25 esimo, il

50 esimo (è la mediana) e il 75 esimo percentile

L’intervallo tra il 25 esimo e il 75 esimo percentile si chiama distanza

interquartile.

Decili: dividono la serie ordinata in 10 parti uguali. Sono il 10, 20 30

…80, 90 percentile.

Indici di dispersione

Campo di variazione (Range): Xmax - Xmin

Scarti dalla media

Devianza (Sum of Squares)

SS

x

n

i

i 1

x

2

Varianza (o Quadrato Medio o Mean Square)

n

2

x

i 1

i

x

n

2

s

2

i 1

n 1

n

n

Se i dati sono in frequenze:

Se i dati sono in proporzioni:

2

2

i 1

n

i 1

i

x

f i xi

2

fi

pi xi

2

2

Indici di dispersione

Deviazione standard (standard deviation)

n

xi

i 1

n

x

n

2

s

Coefficiente di variazione (CV)

s

CV 100

x

i 1

i

x

n 1

2

Indici di dispersione

Teorema di Tchebysheff: indipendentemente dalla distribuzione,

fissata una costante K, l’intervallo

x Ks

contiene almeno

[1-(1/K2)] dati. (s è la dev.standard)

Es.

K = 2 l’intervallo contiene almeno il 75% dei dati

K = 3 l’intervallo contiene almeno l’ 89% dei dati

Approssimativamente, se una distribuzione è simmetrica e a

campana:

l’intervallo

xs

l’intervallo

x 2s

x 3s

l’intervallo

contiene il 68% dei dati

contiene il 95% dei dati

contiene quasi il 100% dei dati

Indici di forma

x

n

Asimetria (Skewness)

x

i

i 1

3

n

negativa

Curtosi (Kurtosis)

platicurtica

3

positiva

x

n

i 1

i

x

n

4

4

3

leptocurtica

Cambio di scala dei dati

Se trasformo una variabile:

X a bY

a = cambio di origine

b = cambio di scala

La media e la varianza vengono trasformate nel modo seguente:

x a by

sx2 b2 s y2

Aggiungere una costante ai dati non ha effetto sulla loro varianza

Analisi esplorativa dei dati

Tra i più comuni strumenti grafici (oltre ai bar charts e histograms)

della EDA sono i diagrammi stem and leaf e box plot

diagramma stem and leaf

2.2 , 2.2, 3.1, 3.1, 3,3, 3,4, 4.2, 4,6, 4,7, 4.8, 5 5.1

Si considerano le prime 2 cifre significative ( in questo caso l’intero

numero). la prima cifra costituisce lo stem, la seconda le leaf.

2

22

3

1134

4

2678

5

01

si ottiene una specie di distribuzione di frequenza

Stem-and-Leaf Plot

Frequency

Stem &

7,00

2

13,00

3

14,00

4

7,00

5

9,00

6

1,00

7

,00

8

3,00

9

2,00

10

8,00 Extremes

Stem width:

Each leaf:

.

.

.

.

.

.

.

.

.

Leaf

0224688

0022444466668

00002244466888

0244688

000224446

6

444

26

(>=10,8)

1,0

1 case(s)

Box plot

50

17

Outlayer (>3*diff int)

40

Outlayer (<3*diff int)

30

16

1,5 * diff. interquartile

20

3° quartile

10

mediana

1° quartile

0

-10

N=

17

VAR00001

La mediana e il box indicano asimmetria nella parte centrale della

distribuzione, i bracci presenza di “code”

Inferenza statistica

Popolazione e campione

POPOLAZIONE: insieme di tutte le manifestazioni

relative a un certo fenomeno. Può essere finita o

infinita. In genere ci si occupa di popolazioni molto

grandi.

CAMPIONE: sottoinsieme della popolazione. Se

estratto casualmente rappresenta la popolazione in

esame.

Obiettivi dell’inferenza statistica

1. Test delle ipotesi

2. Stima dei parametri della popolazione

POPOLAZIONE descritta da

PARAMETRI

Campionamento

Inferenza

CAMPIONE -> funzione campionaria ->

STIME

Probabilità: definizioni

Spazio campione: insieme di tutti i possibili risultati o

realizzazioni ottenibili.

Realizzazione (outcome): risultato specifico ottenuto.

Evento: combinazione di realizzazioni, che ha caratteristiche

specifiche di interesse.

Esempi

spazio campione del lancio di un dado: 1, 2, 3, 4, 5, 6

spazio campione del lancio di 2 dadi:

(1,1),

(1,2),

(1,3),

(1,4),

(1,5),

(1,6),

(2,1),

(2,2),

(2,3),

(2,4),

(2,5),

(2,6),

(3,1),

(3,2),

(3,3),

(3,4),

(3,5),

(3,6),

(4,1),

(4,2),

(4,3),

(4,4),

(4,5),

(4,6),

(5,1),

(5,2),

(5,3),

(5,4),

(5,5),

(5,6),

(6,1),

(6,2),

(6,3),

(6,4),

(6,5),

(6,6),

Probabilità: definizioni

La probabilità di un evento A è indicata da P(A) ed è sempre

compresa tra 0 e 1

Se due eventi si escludono l’un l’altro, sono detti mutualmente

esclusivi.

La somma delle probabilità di tutti gli eventi mutualmente esclusivi

deve essere = 1

Il complemento di un evento è il non verificarsi di tale evento.

Il complemento di A è indicato con Ā

P(Ā) = 1 - P(A)

Due eventi A e B sono detti indipendenti se la probabilità che si

verifichi A non è influenzata dal fatto che si sia verificato B o viceversa.

Regole per combinare le probabilità

Per combinare le probabilità di più eventi valgono le seguenti

regole

Se due eventi sono indipendenti, la probabilità che entrambi si

verifichino è:

P(A and B)= P(A)P(B)

La probabilità che si verifichi almeno uno dei due eventi è:

P(A or B)= P(A)+P(B)

Se i due eventi non sono mutualmente esclusivi:

P(A or B)= P(A)+P(B) - P(A and B)

Distribuzioni di probabilità

Variabile casuale: numero che viene assegnato a ciascuna

realizzazione di un esperimento

Distribuzione di probabilità: probabilità associate a ciascun valore

della variabile casuale

La variabile casuale può essere discreta o continua

1. Distribuzioni di probabilità discrete (di VC discrete)

2.

Distribuzioni di probabilità continue (di VC continue)

La distribuzione di probabilità è la distribuzione teorica della

popolazione, i cui parametri si intendono indagare

La media di una distribuzione di probabilità è detta valore atteso della

variabile casuale

Distribuzioni di probabilità della somma di

due dadi da gioco ERRORE NEL

GRAFICO DATI TRUCCATI!

0.18

0.16

0.14

0.12

0.1

NORMALI

0.08

TRUCCATI

0.06

0.04

0.02

0

2

3

4

5

6

7

8

9 10 11 12 13 14 15 16

Distribuzioni di probabilità discrete

p(y)

0.18

0 p(y) 1

0.16

p(y) = 1

0.14

0.12

Valore medio (valore atteso):

0.1

0.08

= y p(y)

0.06

Varianza:

0.04

2= (y- )2p(y)

0.02

0

2

3

4

5

6

7

8

9 10 11 12

y

1

Distribuzioni di probabilità continue

y

y

x

a

b

x

Sono descritte da funzioni. Di queste ci interessa solo l’integrale

L’area sottesa dalla curva è = 1

y ( x )dx 1

L’area sottesa dalla curva tra due valori (es. a-b) è la probabilità

che la variabile casuale assuma valori compresi tra a e b

1

Distribuzioni di probabilità di interesse

Distribuzione binomiale

Distribuzione normale

Distribuzione del t di Student

Distribuzione di F di Fisher

Distribuzione del 2

Distribuzione di Poisson

Distribuzione del Q

Distribuzione binomiale negativa

Distrib Gamma, beta, Cauchy, Gumbel,

Weibull, Log-normale ecc…

Popolazione binomiale

Il caso più semplice di popolazione con variabili

qualitative è la popolazione binomiale. Viene detta

binomiale perché sono contemplate solo due possibilità,

due possibili realizzazioni.

Vengono quindi analizzate le proporzioni delle due

realizzazioni contemplate, dove:

p è la proporzione di individui che presentano una certa

caratteristica

(1-p) è la proporzione di individui che non la presentano.

Distribuzione binomiale

Convenzionalmente ad una delle due realizzazioni

possibili viene assegnata l’etichetta di “successo” e viene

indicata con 1. L’altra (“insuccesso”) viene indicata con 0.

Si indicano:

P(1) = p

P(0) = q = (1 - p)

La distribuzione binomiale descrive la distribuzione di

una variabile casuale Y che è il numero di successi in un

campione di numerosità n, composto cioè da n

realizzazioni indipendenti dell’evento elementare.

Distribuzione binomiale

La variabile casuale Y (numero di successi in un

campione di numerosità n) è una variabile discreta che

ha possibili realizzazioni:

0, 1, 2, …, n

Si tratta in sostanza di associare una probabilità a

ciascuna di queste realizzazioni.

La formula è la seguente:

n!

p( y )

p y (1 p) ( n y )

y!(n y )!

Dove y è una delle possibili realizzazioni di Y

Origine distribuzione binomiale

n!

p( y )

p y (1 p) ( n y )

y!(n y )!

Ho un sacco con 40 palline bianche e 60 nere. L’evento “successo” è

dato dalla estrazione di una pallina bianca. Estraggo, con reimmissione,

5 palline. Quale probabilità di estrarre 2 palline bianche?

p=0.4

q=0.6

n=5

y=2

- Se i successi sono 2, gli insuccessi saranno 5-2=3

- Poiché le realizzazioni sono indipendenti:

P = 0.4*0.4*0.6*0.6*0.6 = 0.420.63=0.03456

cioè: p2q3 = p2(1-p)3 = py(1-p)(n-y)

Questa è la probabilità di una sola possibile sequenza di estrazioni con

2 successi. (prime 2 estrazioni successo, ultime 3 insuccesso)

Origine distribuzione binomiale

Non avendo definito la sequenza di successi ed insuccessi a priori,

per avere la probabilità di ottenere 2 successi in 5 realizzazioni devo

considerare tutte le possibili combinazioni delle possibili estrazioni con

2 successi e applicare la regola additiva delle probabilità.

1

2

3

4

5

6

7

8

9

10

1

1

1

1

0

0

0

0

0

0

1

0

0

0

1

1

1

0

0

0

0

1

0

0

1

0

0

1

1

0

0

0

1

0

0

1

0

1

0

1

0

0

0

1

0

0

1

0

1

1

Il numero delle combinazioni possibili si può ottenere dal calcolo combinatorio:

n!

5!

5 4 3 2 1

10

y!(n y)! 2!(5 2)! 2 1(3 2 1)

Quindi la probabilità di estrarre due palline bianche estraendone 5 da una

popolazione con p=0,4 è:

p(2) = 10 x 0.03456 = 0.3456

Campione di numerosità 3 da popolazione con

p=0.5

p =

q= 1- p

0.5

d1

0

1

0

0

1

1

0

1

d2

0

0

1

0

1

0

1

1

0.4

0.35

0.3

0.25

0.2

0.15

0.1

0.05

0

d3

0

0

0

1

0

1

1

1

0 successi

1

n succ

0

1

1

1

2

2

2

3

1 successo

2

0.5

P

q*q*q

p*q*q

q*p*q

q*q*p

p*p*q

p*q*p

q*p*p

p*p*p

2 successi

3

Probab.

0.125

0.125

0.125

0.125

0.125

0.125

0.125

0.125

3 successi

4

0.125

}

0.375

}

0.375

0.125

Campione di numerosità 3 da popolazione con

p=0.1

p =

q= 1-

0.1

d1

0

1

0

0

1

1

0

1

d2

0

0

1

0

1

0

1

1

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

d3

0

0

0

1

0

1

1

1

0 successi

1

p

n succ

0

1

1

1

2

2

2

3

1 successo

2

0.9

P

q*q*q

p*q*q

q*p*q

q*q*p

p*p*q

p*q*p

q*p*p

p*p*p

2 successi

3

Probab.

0.729

0.081

0.081

0.081

0.009

0.009

0.009

0.001

3 successi

4

0.729

}

}

0.243

0.027

0.001

Caratteristiche della distribuzione binomiale

n!

p( y )

p y (1 p) ( n y )

y!(n y )!

Dove y è una delle possibili realizzazioni di Y

È descritta da un solo parametro: p

Se i dati sono espressi come frequenze:

Valore medio (valore atteso): =np

Varianza: 2= np(1-p)

Distribuzione normale

Tra le varie distribuzioni di probabilità, una ha ruolo fondamentale in

statistica: la distribuzione normale o Gaussiana

1

y

e

2

1 x 2

2

Tra le proprietà della Gaussiana ricordiamo:

La variabile x (variabile casuale) può avere valore da - a +

E’ completamente definita da 2 parametri (media e varianza –

ovvero dev. St.) e viene sinteticamente indicata con N(; )

E’ simmetrica intorno alla media ed è a forma di campana

Ha il massimo in x= e 2 flessi in

Distribuzione normale

0,6

N(6;2)

N(6;3,5)

N(8;0,5)

N(11;1)

0,5

0,4

0,3

0,2

0,1

0

0

5

10

15

Esistono infinite curve normali (per ogni possibile media & dev. st.)

Le probabilità (superfici sottese) sono in relazione alle distanze dalla

media misurata in numero di deviazioni standard

la normale standardizzata

Tra le curve normali, si fa spesso riferimento alla cosiddetta

“Normale standardizzata” che è N(0;1) e quindi ha:

media = 0

deviazione standard = 1

Tutte le normali possono essere ricondotte alla normale

standardizzata, sottraendo a ogni dato la media e dividendo per la

deviazione standard.

La distribuzione normale standardizzata si chiama distribuzione di Z

z

x

la normale standardizzata

Data una normale qualsiasi e un punto x, l’area compresa tra

il punto x e + è la stessa di quella compresa tra il

corrispondente z e +

L’integrale della normale N(, ) tra x e + è calcolabile, ma con

notevole difficoltà; l’integrale di z è invece tabulato.

(l’integrale della normale N(, ) tra x e + ci dà la probabilità che

un’unità sperimentale abbia un valore superiore a x)

Distribuzione binomiale -> normale

all’aumentare della numerosità campionaria la distribuzione

binomiale tende alla normale.

0,6

p=0,7

0,5

n=2

0,4

n=3

n=5

0,3

n=10

n=20

0,2

n=30

0,1

30

28

26

24

22

20

18

16

14

12

10

8

6

4

2

0

0

L’approssimazione è accettabile quando np5 e n(1-p)5

Stimatori

Uno stimatore è una statistica ottenuta da un campione che

stima un parametro della popolazione.

Gli stimatori si indicano con lettera latina

I parametri della popolazione si indicano con lettera greca

Media

x stimatore di

Varianza s 2 stimatore di 2

Dev. St.

s stimatore di

Lo strumento per valutare l’attendibilità di uno stimatore si

basa sullo studio della probabilità

Stimatori e distribuzioni campionarie

Proprietà di uno stimatore

Non distorsione (accuratezza): la media di tutti i possibili

valori dello stimatore è uguale al valore del parametro

della popolazione.

Consistenza: all’aumentare della dimensione del

campione lo stimatore tende al valore del parametro

Efficienza (precisione): è più efficiente, tra tutti gli

stimatori non distorti, quello che ha minore varianza

campionaria

Stimatori di media e varianza

Il miglior stimatore della media di una popolazione è

la media del campione.

Il miglior stimatore della varianza di una popolazione

è:

n

2

s2

x

i 1

i

x

n 1

Se si divide per n invece che per n-1 lo stimatore è

distorto

Non vi sono stimatori non distorti della deviazione

standard, è per questo che si usa molto la varianza.

un universo:

media =

dev.st=

varianza=

2

3

5

6

4

1,6

2,5

Possibili campioni di numerosità 2 ottenibili

per estrazione casuale con reimmissione:

Campioni

x1

x2

2

2

2

3

2

5

2

6

3

2

3

3

3

5

3

6

5

2

5

3

5

5

5

6

6

2

6

3

6

5

6

6

medie stimatori

Varianze stimatori

Dev. St stimatori

media var (/n)

2

0,00

2,5

0,25

3,5

2,25

4

4,00

2,5

0,25

3

0,00

4

1,00

4,5

2,25

3,5

2,25

4

1,00

5

0,00

5,5

0,25

4

4,00

4,5

2,25

5,5

0,25

6

0,00

Statistiche

var (/(n-1) dev st (/n) dev st (/(n-1)

0,00

0,00

0,00

0,50

0,50

0,71

4,50

1,50

2,12

8,00

2,00

2,83

0,50

0,50

0,71

0,00

0,00

0,00

2,00

1,00

1,41

4,50

1,50

2,12

4,50

1,50

2,12

2,00

1,00

1,41

0,00

0,00

0,00

0,50

0,50

0,71

8,00

2,00

2,83

4,50

1,50

2,12

0,50

0,50

0,71

0,00

0,00

0,00

4

1,25

2,50

0,88

1,24

1,25

1,118

1,844

1,358

7,375

2,716

0,484

0,696

0,969

0,984

Teorema del limite centrale

Una variabile che derivi dalla somma di altre tende a essere

distribuita normalmente. Tante più variabili concorrono alla

somma tanto più l’approssimazione è buona

Le medie campionarie, anche se i campioni sono tratti

da popolazioni con distribuzioni diverse dalla normale,

tendono ad essere distribuite normalmente.

L’approssimazione è tanto maggiore quanto maggiore è

la numerosità campionaria

Distribuzione campionaria delle medie

la distribuzione campionaria della media di un

campione di numerosità n estratto casualmente da una

popolazione di media e varianza 2 ha:

media = (stimatore non distorto)

varianza =

2

n

deviazione standard =

n

Inoltre, per il teorema del limite centrale, se n

(numerosità del campione) è sufficiente, la distribuzione

delle medie campionarie è normale

Errore standard della media

La deviazione standard della distribuzione delle

medie campionarie, più piccola di di un fattore

1

n , si chiama errore standard o deviazione

standard della media o errore di campionamento

della media.

Errore standard:

Errore percentuale:

x

e%

n

x

x

100

Distribuzione campionaria di

una proporzione

La distribuzione binomiale (popolazione) descrive la probabilità

di Y (numero di successi) in un campione di numerosità n.

Se ci si riferisce alle proporzioni di successi, è caratterizzata da:

Media (valore atteso): =p

Varianza: 2= p(1-p)

L’estrazione di un campione casuale di numerosità n fornirà una

proporzione campionaria di successi.

La proporzione di successi del campione, se n è sufficiente, è

una variabile casuale con distribuzione approssimativamente

normale e:

Media = p

Varianza = p(1-p)/n

La distribuzione del t di Student

x

t

s

Ve ne sono infinite, in funzione della dimensione campionaria.

In altri termini l’unico parametro della distribuzione sono i GL di s.

Per n= la distribuzione del t diviene quella di z.

Nella distribuzione delle medie campionarie:

x

t

sx

con:

s

sx

n

La distribuzione del t di Student

E’ simmetrica, più appiattita della normale (è tanto più platicurtica tanto

più piccola è la dimensione campionaria).

E’ tabulata per il n° di gradi di libertà (n-1) con cui si stima la

deviazione standard

n= 2

n= 5

normale n-> inf.

-5

-3

-1

1

3

5

La distribuzione F

Serve a descrivere la distribuzione del rapporto di due stime

della varianza.

Dati due campioni indipendenti, estratti da popolazioni con

distribuzione normale e varianze 21 22

2

1

s

F

s

2

2

2

1

2

2

È una variabile casuale con la distribuzione F

La distribuzione F ha due parametri: 1 e 2 che sono i gradi di

libertà con cui sono calcolate le varianze stimate s2.

Si indica con F(1, 2)

La distribuzione F

Definita solo per valori non negativi

Asimmetrica

Per ogni combinazione di gradi di libertà esiste una

distribuzione

Bisogna scegliere quale varianza mettere a numeratore.

Per convenzione si mette sempre la varianza più

grande.

Se 21= 22

2

1

2

2

s

F

s

Distribuzione del X2

E’ data dalla sommatoria di n variabili indipendenti z2.

n

2

1

( x )2

2

E’ sempre positiva.

E’ composta da n quote additive a ciascuna delle

quali compete 1 grado di libertà (GL).

I GL sono quindi dati dal numero di variabili z2

sommate.

Per 1 GL, X2=z2

Distribuzione del X2

Può essere usata per descrivere la distribuzione della

varianza campionaria.

Infatti:

Ovvero:

(n 1) s 2

2

2

(

x

x

)

2

Ha la distribuzione di X2 con (n-1) GL.