Metodi Statistici e Probabilistici per l’Ingegneria

MODELLI PROBABILISTICI

Corso di Laurea in Ingegneria Civile

Facoltà di Ingegneria, Università di Padova

Docente: Dott. L. Corain

E-mail: [email protected]

Home page: www.gest.unipd.it/~livio/Corso_Civile.html

MODELLO PROBABILISTICI

1

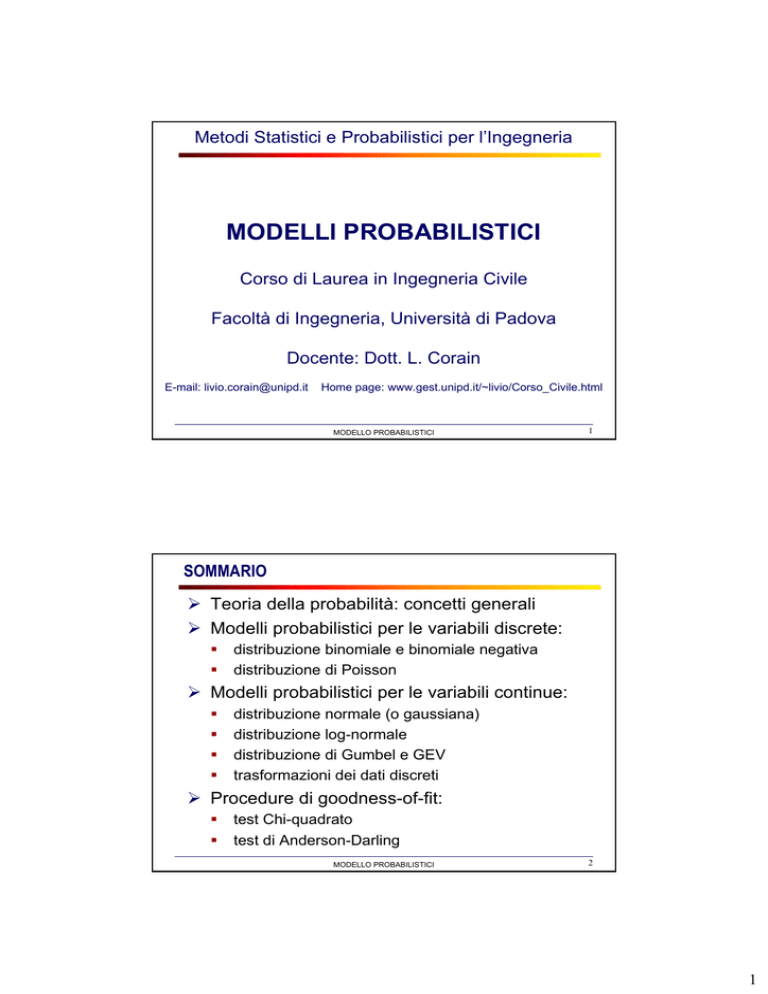

SOMMARIO

¾ Teoria della probabilità: concetti generali

¾ Modelli probabilistici per le variabili discrete:

distribuzione binomiale e binomiale negativa

distribuzione di Poisson

¾ Modelli probabilistici per le variabili continue:

distribuzione normale (o gaussiana)

distribuzione log-normale

distribuzione di Gumbel e GEV

trasformazioni dei dati discreti

¾ Procedure di goodness-of-fit:

test Chi-quadrato

test di Anderson-Darling

MODELLO PROBABILISTICI

2

1

TEORIA DELLA PROBABILITÀ: CONCETTI GENERALI

La probabilità può essere definita come un numero che

esprime la possibilità, il grado di verosimiglianza con cui un

evento è destinato a verificarsi.

Si parla così della probabilità di pescare una carta nera da

un mazzo di carte, della probabilità che in un campione

d’aria siano presenti 10 particelle di amianto per unità di

volume o della probabilità che un processo produttivo

realizzi prodotti rispondenti ai requisiti (di legge, di progetto,

di contratto, ecc.).

La probabilità è una proporzione o frazione che varia tra i

valori 0 e 1, estremi inclusi. Associamo il valore zero a un

evento che non ha nessuna possibilità di verificarsi (evento

impossibile) e il valore uno a un evento che si verificherà

sicuramente (evento certo). Tra due estremi, si collocano

eventi più o meno probabili.

MODELLO PROBABILISTICI

3

TEORIA DELLA PROBABILITÀ: CONCETTI GENERALI

In teoria della probabilità, una variabile casuale (o variabile

aleatoria – v.a.) può essere pensata come il risultato

numerico di un esperimento quando questo non è

prevedibile con certezza (ossia non è deterministico).

Ad una variabile casuale X si associa la sua distribuzione,

o legge di probabilità PX, che assegna ad ogni sottoinsieme

dell'insieme dei possibili valori di X (eventi) la probabilità che

la variabile casuale X assuma valore in esso. Le variabili casuali si dividono principalmente in due grandi classi:

discrete, se l'insieme dei possibili valori (o supporto di X)

è finito o numerabile;

continue, se l'insieme dei possibili valori è l’insieme dei

numeri reali.

MODELLO PROBABILISTICI

4

2

TEORIA DELLA PROBABILITÀ: CONCETTI GENERALI

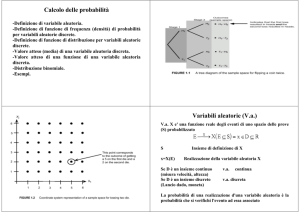

Per caratterizzare una variabile casuale X, dobbiamo

specificarne la sua distribuzione, o legge di probabilità PX,

che può essere, in base al tipo di variabile casuale, di due

tipi:

funzione di probabilità: p(x) = P(X=x), se la variabile

aleatoria è discreta;

funzione di densità di probabilità: f(x), tale per cui

P(X ∈ A) = ∫A f(x) dx, se la variabile aleatoria è continua.

Le due funzioni p(x) e f(x) dipenderanno da uno o più

parametri (p, µ, σ, ecc.). Fissati i valori dei parametri, è

possibile calcolare la probabilità di eventi di interesse,

ovvero che la variabile X assume dei valori specifici.

Si noti che nelle applicazioni reali i parametri sono

ovviamente ignoti e non osservabili, ma possono essere

stimati attraverso una procedura di inferenziale di stima.

MODELLO PROBABILISTICI

5

TEORIA DELLA PROBABILITÀ: CONCETTI GENERALI

La media µ di una distribuzione di probabilità si dice valore

medio (o valore atteso) della variabile aleatoria.

Il valore atteso di una variabile aleatoria discreta è una

media ponderata delle modalità (valori) assunte dalla

variabile, dove i coefficienti di ponderazione sono

rappresentati dalle probabilità associate a ciascuna modalità

Valore atteso di una variabile aleatoria discreta

N

µ = E ( X ) = ∑ X i P( X i )

i =1

dove Xi = i-esima modalità della variabile aleatoria X

P(Xi) = probabilità associata alla modalità Xi

MODELLO PROBABILISTICI

6

3

TEORIA DELLA PROBABILITÀ: CONCETTI GENERALI

La varianza σ2 di una variabile aleatoria discreta è definita

come la media ponderata dei quadrati delle differenze tra

ciascuna modalità e il valore atteso della variabile, dove i

coefficienti di ponderazione sono rappresentati dalle

probabilità associate a ciascuna modalità.

Varianza di una variabile aleatoria discreta

N

σ = ∑ [ X i − E ( X )]2 P( X i )

2

i =1

dove Xi = i-esima modalità della variabile aleatoria X

P(Xi) = probabilità associata alla modalità Xi

Lo scarto quadratico medio σ di una variabile aleatoria

discreta è dato dalla radice quadrata della varianza: σ=√σ2

MODELLO PROBABILISTICI

7

TEORIA DELLA PROBABILITÀ: CONCETTI GENERALI

La media (o valore atteso) µ e la varianza σ2 (e la deviazione

standard σ) di una v.a. X sono i parametri di maggiore

interesse della distribuzione di probabilità di X, in quanto

essi esprimono rispettivamente la tendenza centrale e la

variabilità della v.a. X.

Nel caso la v.a. X sia continua, per il calcolo di µ e la

varianza σ2, l’operatore sommatoria va sostituito con

l’integrale:

La probabilità che la v.a. assuma valori minori od uguali ad

un valore specificato, viene detta funzione di ripartizione:

FX = P (X ≤ x).

MODELLO PROBABILISTICI

8

4

LA DISTRIBUZIONE BINOMIALE

Tra i modelli probabilistici discreti più utilizzati vi è la

distribuzione binomiale, caratterizzata da 4 proprietà:

Si considera un numero prefissato di n osservazioni.

Ciascuna osservazione può essere classificata in due

categorie incompatibili ed esaustive, chiamate per

convenzione successo e insuccesso

La probabilità di ottenere un successo, p, è costante per

ogni osservazione, così come la probabilità che si

verifichi un insuccesso, q = (1 – p).

Il risultato di un’osservazione, successo o insuccesso, è

indipendente dal risultato di qualsiasi altra.

La funzione di probabilità della distribuzione binomiale è

definita dall’espressione:

MODELLO PROBABILISTICI

9

LA DISTRIBUZIONE BINOMIALE

Media e varianza della distribuzione binomiale sono

rispettivamente µ = np e σ2 = npq = np(1-p).

Una distribuzione binomiale può essere simmetrica o

asimmetrica in base ai valori assunti dai parametri. Per

qualsiasi valore di n, la distribuzione è simmetrica se p=0.5

e asimmetrica per valori di p diversi da 0.5. L’asimmetria

diminuisce all’avvicinarsi di p a 0.5 e all’aumentare del

numero di osservazioni n.

MODELLO PROBABILISTICI

10

5

LA DISTRIBUZIONE BINOMIALE

La distribuzione binomiale è utilizzata come modello

quando una specifica caratteristica in un campione può

essere riconosciuta (ad esempio la presenza di elementi

difettosi in un lotto).

La distribuzione binomiale è spesso usata come base per

l'elaborazione di schemi di campionamento in accettazione

materia prime e altri materiali.

In tali schemi, q è definito come la probabilità che un

generico campione non sia difettoso (ad esempio, che non

vi siano contaminanti), mentre p è la probabilità che il

campione sia difettoso (ad esempio, vi è almeno un

elemento contaminante) e dove n rappresenta il numero di

totale campioni esaminati.

MODELLO PROBABILISTICI

11

LA DISTRIBUZIONE DI POISSON

In molte applicazioni si è interessati a contare il numero di

volte in cui si osserva la realizzazione di un evento

(contaminazione, incidente, rottura, ecc.) in una certa area

di opportunità.

Un’area di opportunità è un intervallo continuo quale un

tempo, una lunghezza, una superficie, un volume o in

generale un’area nella quale un certo evento può verificarsi

più volte.

Un esempio può essere quello di dello studio degli infortuni

nei cantieri edili: se il numero di medio di incidenti mortali

nel settore edile è pari a 2 incidenti alla settimana, qual è la

probabilità che in due settimane ci siano più di 5 incidenti?

(evento: P(X > 5))?

MODELLO PROBABILISTICI

12

6

LA DISTRIBUZIONE DI POISSON

Per poter utilizzare la distribuzione di Poisson come

modello probabilistico per un problema ingegneristico,

alcune condizioni devono essere soddisfatte:

Il numero di singoli eventi per unità di campionamento

(x) deve essere ben al di sotto del numero max possibile

che potrebbe verificarsi (x→∝);

La probabilità che si verifichi un evento in una

determinata frazione dell’unità di campionamento deve

essere allo stesso tempo costante e molto piccola;

Il verificarsi di un singolo evento in una qualsiasi frazione

dell’unità di campionamento deve né aumentare né

diminuire la probabilità che un altro evento si verifichi;

La dimensione dell’area di opportunità del campione

deve essere piccola rispetto a quella di tutta la

popolazione.

MODELLO PROBABILISTICI

13

LA DISTRIBUZIONE DI POISSON

La funzione di probabilità della distribuzione di Poisson, il

suo valore atteso e la sua varianza, sono definite dalle

seguenti espressioni:

MODELLO PROBABILISTICI

14

7

DISTRIBUZIONE POISSON

MODELLO PROBABILISTICI

15

LA DISTRIBUZIONE BINOMIALE NEGATIVA

Se la seconda e la terza condizione per l'uso della

distribuzione di Poisson non sono soddisfatte, la varianza

della popolazione di solito è maggiore della media (µ < σ2 ).

Tra i vari modelli probabilistici disponibili, la distribuzione

binomiale negativa

è spesso il miglior

modello per

descrivere la distribuzione delle frequenze ottenute.

La distribuzione binomiale negativa è ampiamente usata per

modellare dati di conteggio degli incidenti automobilistici,

che spesso presentano bassi valori medi campionari e

campioni di piccole dimensioni.

La distribuzione binomiale negativa, che descrive il numero

di fallimenti prima del x-esimo successo, quando n è il

numero intero, è definita dall’espressione:

MODELLO PROBABILISTICI

16

8

LA DISTRIBUZIONE BINOMIALE NEGATIVA

Un metodo molto semplice per ottenere un valore

approssimativo per il k può essere ottenuta riordinando

l'equazione per la varianza di una binomiale negativa:

Per ottenere stime più affidabili è opportuno utilizzare il

metodo di stima della massima verosimiglianza.

Il metodo della massima verosimiglianza è implementato dal

software statistico R (non Minitab), tuttavia esiste la

possibilità di effettuare i calcoli usando degli applet presenti

sul web:

http://www.wessa.net/rwasp_fitdistrnegbin.wasp#output

MODELLO PROBABILISTICI

17

MODELLI PROBABILISTICI PER VARIABILI CONTINUE

z

z

z

z

Una funzione di densità di probabilità continua è un

modello che definisce analiticamente come si

distribuiscono i valori assunti da una variabile aleatoria

continua.

Quando si dispone di un’espressione matematica adatta

alla rappresentazione di un fenomeno continuo, siamo in

grado di calcolare la probabilità che la variabile aleatoria

assuma valori compresi in intervalli (gli intervalli sono gli

eventi di interesse, per una v.a. continua).

Tuttavia, si noti che la probabilità che la variabile

aleatoria continua assuma un particolare valore è pari a

zero.

I modelli continui hanno importanti applicazioni in

ingegneria, scienze fisiche e naturale e scienze sociali.

MODELLO PROBABILISTICI

18

9

MODELLI PROBABILISTICI PER VARIABILI CONTINUE

z

Alcuni tipici fenomeni continui sono gli aspetti

dimensionali dei campioni/prelievi (volume, peso, ecc.) o

il tempo che intercorre fra il verificarsi di due eventi di

interesse (ad esempio un incidente).

z

La figura rappresenta graficamente tre funzioni di

densità di probabilità: normale, uniforme ed

esponenziale.

MODELLO PROBABILISTICI

19

DISTRIBUZIONE NORMALE O GAUSSIANA

La distribuzione normale (o distribuzione Gaussiana) è

la distribuzione continua più utilizzata in statistica.

La distribuzione normale è importante in statistica per tre

motivi fondamentali:

1. Diversi fenomeni continui sembrano seguire, almeno

approssimativamente, una distribuzione normale.

2. La distribuzione normale può essere utilizzata per

approssimare numerose distribuzioni di probabilità

discrete.

3. La distribuzione normale è alla base dell’inferenza

statistica classica in virtù del teorema del limite

centrale.

MODELLO PROBABILISTICI

20

10

DISTRIBUZIONE NORMALE O GAUSSIANA

La distribuzione

caratteristiche:

normale

ha

alcune

importanti

La distribuzione normale ha una forma campanulare e

simmetrica.

Le sue misure di posizione centrale (valore atteso,

mediana) coincidono.

Il suo range interquartile è pari a 1.33 volte lo scarto

quadratico medio, cioè copre un intervallo compreso

tra µ – 2/3σ e µ + 2/3σ.

La variabile aleatoria con distribuzione

assume valori compresi tra -∞ e + ∞.

MODELLO PROBABILISTICI

normale

21

DISTRIBUZIONE NORMALE O GAUSSIANA

MODELLO PROBABILISTICI

22

11

DISTRIBUZIONE NORMALE O GAUSSIANA

Notiamo che, essendo e e π delle costanti matematiche, le

probabilità di una distribuzione normale dipendono soltanto

dai valori assunti dai due parametri µ e σ.

Specificando particolari combinazioni di µ e σ, otteniamo

differenti distribuzioni di probabilità normali.

MODELLO PROBABILISTICI

23

DISTRIBUZIONE NORMALE O GAUSSIANA

Poiché esiste un numero infinito di combinazioni dei

parametri µ e σ, per poter rispondere a quesiti relativi a

una qualsiasi distribuzione normale avremmo bisogno di

in numero infinito di tavole.

Introduciamo ora una formula di trasformazione delle

osservazioni, chiamata standardizzazione, che consente

appunto di trasformare una generica variabile aleatoria

normale in una variabile aleatoria normale standardizzata.

La standardizzazione

Z=

X −µ

σ

Z è la variabile ottenuta sottraendo ad X il suo valore atteso

µ e rapportando il risultato allo scarto quadratico medio, σ.

MODELLO PROBABILISTICI

24

12

DISTRIBUZIONE LOG-NORMALE

In probabilità la distribuzione lognormale, o log-normale, è

la distribuzione di probabilità di una variabile aleatoria X il

cui logaritmo logX segue una distribuzione normale. La

funzione di densità di probabilità della

distribuzione log-normale è data da

Così come la distribuzione normale può fornire

un'approssimazione per la somma di "molte" variabili

aleatorie IID X1,...,Xn (teorema del limite centrale), la

distribuzione log-normale, se le Xi sono positive, può

fornire un'approssimazione per il loro prodotto.

Nell’ambito dell’ingegneria Civile vi sono molti fenomeni

che possono essere ben interpretati dalla distribuzione

log-normale, tra questi la dissipazione delle piogge, la

dispersione dell’amianto, così come anche la resistenza

allo snervamento dell’acciaio è tipicamente modellata in

modo log-normale.

MODELLO PROBABILISTICI

25

DISTRIBUZIONE LOG-NORMALE

MODELLO PROBABILISTICI

26

13

DISTRIBUZIONE DI GUMBEL E GEV

La distribuzione Gumbel viene utilizzata per modellare la

distribuzione del massimo (o il minimo) numero di

campioni, che possono essere estratti da distribuzioni

diverse.

Per esempio potremmo utilizzarla per rappresentare la

distribuzione del livello massimo di un fiume in un

particolare anno, se avessimo a disposizione l'elenco dei

valori massimi degli ultimi anni.

La distribuzione Gumbel risulta utile nel predire la

probabilità di accadimento di eventi estremi quali terremoti

di grande intensità, alluvioni o altri disastri naturali.

La potenziale applicabilità della distribuzione Gumbel per

rappresentare la distribuzione dei massimi si riferisce alla

teoria dei valori estremi che ci suggerisce che essa può

essere di aiuto quando la distribuzione sottostante ai dati

campionari è di tipo normale o esponenziale.

27

MODELLO PROBABILISTICI

DISTRIBUZIONE DI GUMBEL E GEV

La distribuzione di Gumbel può essere vista come un caso

particolare di distribuzione GEV − Generalized Extreme

Value (dei valori estremi generalizzata, anche conosciuta

come distribuzione Fisher-Tippett). La distribuzione è

anche nota come log-Weibull e distribuzione doppio

esponenziale (che viene talvolta usata per riferirsi alla

distribuzione di Laplace).

La funzione di densità f e di ripartizione F (densità

cumulata), dipendenti dai due parametri µ (location) e β

(scale) della distribuzione di Gumbel sono

f =

dove

MODELLO PROBABILISTICI

;

28

14

DISTRIBUZIONE DI GUMBEL E GEV

MODELLO PROBABILISTICI

29

DISTRIBUZIONE DI GUMBEL E GEV

In idrologia, quindi, la distribuzione di Gumbel è utilizzata

per analizzare variabili come valori massimi mensili e

annuali delle piogge giornaliere e volumi di portata dei

fiumi.

Gumbel ha dimostrato che il valore massimo in un

campione di una variabile casuale che segue una

distribuzione esponenziale si avvicina sempre più alla

distribuzione di Gumbel al crescere della dimensione del

campione.

Gumbel ha anche dimostrato che lo stimatore r/(n+1) per

la probabilità di un evento - dove r è il numero di rango del

valore osservato nella serie di dati e n è il numero totale di

osservazioni - è uno stimatore corretto della probabilità

cumulata della moda della distribuzione. Pertanto, questo

stimatore è spesso usato come plotting position del

probability plot.

MODELLO PROBABILISTICI

30

15

DISTRIBUZIONE DI GUMBEL E GEV

In probabilità e statistica, distribuzione dei valori estremi

(GEV) è una famiglia di distribuzioni di probabilità

continue sviluppata all'interno della teoria dei valori

estremi che include le famiglie Gumbel, Fréchet e Weibull,

note anche come distribuzione dei valori estremi di tipo I,

II e III.

Dal teorema dei valori estremi la distribuzione GEV è la

distribuzione limite dei massimi, normalizzati in modo

opportuno, di una sequenza variabili aleatorie IID

(indipendenti e identicamente distribuite).

Per questo motivo, la distribuzione GEV è usato come

approssimazione per modellare i massimi di lunghe (finite)

sequenze di variabili aleatorie.

MODELLO PROBABILISTICI

31

DISTRIBUZIONE DI GUMBEL E GEV

La funzione di densità f e di ripartizione F (densità

cumulata), dipendenti dai tre parametri µ ∈ R — location,

σ > 0 — scale, ξ ∈ R — shape, della distribuzione GEV

sono:

Il parametro di forma ξ

governa il comportamento

della coda della

distribuzione. Le subfamiglie definite da ξ→0,

ξ> 0 e ξ <0 corrispondono,

rispettivamente, alle

famiglie Gumbel, Fréchet

e Weibull, le cui funzioni di

distribuzione cumulativa

sono riportate a destra.

MODELLO PROBABILISTICI

32

16

TRASFORMAZIONI DEI DATI DISCRETI

Non sempre la distribuzione normale si presta ad essere

un modello appropriato per variabili di natura discreta e di

interesse ingegneristico. Questa spesso è però una

condizione importante perché i metodi inferenziali

parametrici sono basati sull’assunzione di normalità (tra

questo, i test ANOVA e t-test per la significatività delle

differenze). Per superare questo problematica, possono

essere prese in considerazione delle trasformazioni dei dati

discreti dette

'normalizzanti‘,

ovvero tali da

rendere la

trasformazione

approssimativamente normale.

MODELLO PROBABILISTICI

33

PROCEDURE DI GOODNESS-OF-FIT

Una volta assunta una funzione p(x) e f(x) adeguata a

rappresentare un problema reale (discreto o continuo), e

disponendo di stime plausibili per i suoi parametri, è

possibile calcolare la probabilità di un qualsiasi evento di

interesse.

Tuttavia, dal momento che la vera legge di probabilità PX di

un fenomeno X rappresenta una caratteristica ignota e non

osservabile della popolazione (come per altro lo sono i

anche i suoi parametri), risulta di interesse valutare la bontà

di adattamento (goodness of fit) di uno specifico modello

probabilistico rispetto ad un campione di dati osservati.

Più propriamente, un test statistico di goodness of fit

consente di prendere una decisione in merito all’ipotesi che

il vero modello della popolazione sia o meno uno prespecificato modello probabilistico.

MODELLO PROBABILISTICI

34

17

TEST CHI-QUADRATO

z

Per verifica l’ipotesi nulla secondo cui legge di

probabilità PX di un fenomeno X è uguale a P0,

H0: PX = P0

contro l’alternativa

H1: PX ≠ P0

si può considerare la statistica χ2

Statistica test χ2 per il confronto tra leggi di probabilità:

∑

χ =

2

tutte le celle

z

( f0 − fe )

2

fe

La statistica χ2 si ottiene calcolando per ogni cella di una

tabella di contingenza la differenza al quadrato fra la

frequenza osservata (f0) e quella attesa (fe), divisa per fe,

e sommando quindi il risultato ottenuto per ogni cella.

35

MODELLO PROBABILISTICI

TEST CHI-QUADRATO

Fissato α, l’ipotesi nulla dovrà essere rifiutata se il valore

osservato della statistica χ2 è maggiore del valore critico χ2U

di una distribuzione χ2 con (r-1) gradi di libertà.

Field

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

No. bacteria

19

12

7

11

9

9

7

7

9

13

18

13

10

12

12

Conteggio di No. bacteria

No. bacteria

Totale

4-5

6

6-7

11

8-9

12

10-11

18

12-13

12

14-15

11

16-17

11

18-19

11

20-21

3

22-23

3

24-26

2

Totale complessivo

100

Num. medio di batteri

12.69

X

4

6

8

10

12

14

16

18

20

22

24

26

28

Fr_att_Poiss

0.5

2.6

8.4

16.4

21.8

20.9

15.1

8.5

3.8

1.4

0.4

0.1

0.0

Fr_oss

0

6

11

12

18

12

11

11

11

3

0

3

2

Chi-Sq.Stat. =

DF =

alpha =

Crit. value =

MODELLO PROBABILISTICI

(Att-Oss)^2/Att

0.5

4.3

0.8

1.2

0.7

3.8

1.1

0.8

13.4

1.8

0.4

73.0

122.9

101.728

12

0.05

18.74

36

18

TEST CHI-QUADRATO

Conteggio dei batteri: frequenze osservate vs distribuzione di Poisson

22

20

Fr_oss

Fr_att

18

Frequenza

16

14

12

10

8

6

4

2

0

1

2

3

4

5

6

7

8

9

10

11

12

13

Numero di batteri

Chi-Sq. Stat. = 101.728

DF =

12

alpha =

0.05

Crit. value =

18.74

37

MODELLO PROBABILISTICI

TEST CHI-QUADRATO

Conteggio dei batteri: frequenze osservate vs distribuzione binomiale negativa

22

20

Fr_oss

Fr_att

18

Frequenza

16

14

12

10

8

6

4

2

0

1

2

3

4

5

6

7

8

9

10

11

12

13

Numero di batteri

Chi-Sq. Stat. =

DF =

alpha =

Crit. value =

14.5

12

0.05

18.74

MODELLO PROBABILISTICI

38

19

TEST DI ANDERSON-DARLING

La statistica di Anderson-Darling (A2) misura l'area il modello

previsto (in base alla distribuzione scelta) e la funzione di

ripartizione empirica. Più precisamente, la statistica

Anderson-Darling è una distanza al quadrato che avrà un

peso maggiore nelle code della distribuzione.

Valori bassi della statistica Anderson-Darling indicano che la

distribuzione ipotizzata si adatta bene i dati.

La statistica A2 può essere applicata sia a modelli discreti sia

continui, ma tradizionalmente viene applicata a variabili

continue.

La statistica test Anderson-Darling A2 è definita come

A2 = – n – S, dove

S=∑ni=1((2*i – 1)/n)*[ln(F(Y(i)) + ln(1 – F(Y(N+1-i))]

F è la funzione di distribuzione cumulativa della distribuzione

specificata

39

MODELLO PROBABILISTICI

TEST DI ANDERSON-DARLING

Summary for Counts

Anderson-Darling Normality Test

A-Squared

P-Value <

Mean

StDev

Variance

Skewness

Kurtosis

N

0

750000

1500000

2250000

Minimum

1st Quartile

Median

3rd Quartile

Maximum

3000000

5.08

0.005

731462

719651

5.17897E+11

1.99001

4.14066

80

26303

270721

519110

971676

3467369

Probability Plot of Counts

95% Confidence Interval for Mean

9 5 % C onfidence Inter vals

571312

Mean

Normal - 95% CI

891612

95% Confidence Interval for Median

369663

Median

300000

400000

500000

600000

700000

800000

900000

99.9

99

95% Confidence Interval for StDev

622824

852407

95

90

Lognormal - 95% CI

Loc

Scale

N

AD

P-Value

99

95

Percent

90

80

70

60

50

40

30

20

13.05

1.037

80

0.518

0.183

Percent

Probability Plot of Counts

99.9

Mean

731462

StDev

719651

N

80

AD

5.081

P-Value <0.005

640945

80

70

60

50

40

30

20

10

5

1

0.1

-2000000

-1000000

0

1000000

2000000

3000000

4000000

Counts

10

5

1

0.1

10000

100000

1000000

Counts

10000000

MODELLO PROBABILISTICI

40

20

TEST DI ANDERSON-DARLING

Summary for Peso

Anderson-Darling Normality Test

A-Squared

P-Value <

0.96

0.98

1.00

1.02

1.04

1.06

1.08

1.77

0.005

Mean

StDev

Variance

Skewness

Kurtosis

N

0.98302

0.02868

0.00082

1.61433

3.20499

50

Minimum

1st Quartile

Median

3rd Quartile

Maximum

0.94500

0.96275

0.97700

0.99425

1.08500

Probability Plot of Peso

Lognormal - 95% CI

99

Loc

-0.01753

Scale

0.02857

N

50

AD

1.592

P-Value

<0.005

95% Confidence Interval for Mean

9 5 % C onfidence Inter vals

0.97487

Mean

90

95% Confidence Interval for Median

0.970

0.975

0.980

0.985

0.98500

95% Confidence Interval for StDev

0.990

0 02396

0 03574

Probability Plot of Peso

Normal - 95% CI

80

Percent

0.96867

Median

70

60

50

40

30

20

99

Mean

0.9830

StDev

0.02868

N

50

AD

1.768

P-Value <0.005

95

90

80

Percent

95

0.99117

10

5

1

0.90

70

0.95

1.00

Peso

1.05

1.10

60

50

40

30

20

10

5

1

0.90

0.95

1.00

Peso

1.05

1.10

MODELLO PROBABILISTICI

41

21