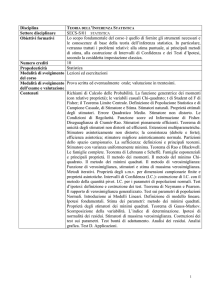

Ciclo di seminari in STATISTICA e APPLICAZIONI per le Scuole di

Dottorato in Ingegneria Civile, Ingegneria Industriale, Ingegneria

dell’Informazione

Coordinatori: Prof.ri Pasquale Erto e Roberta Siciliano

Novembre 2013– Gennaio 2014

Metodi di Stima e Test Statistici

Antonio D’Ambrosio, Ph.D.

Assistant Professor,

Dept. Of Industrial Engineering, Naples University Federico II

STAD Research Group

http://www.stad.unina.it

Outline

• Statistiche campionarie e distribuzioni campionarie

– Statistica, stimatore, statistica-test

– Proprietà degli stimatori

• Metodi di stima

–

–

–

–

–

Metodo dei Momenti

Metodo dei Minimi Quadrati

Metodo della Massima Verosimiglianza

Stima puntuale per intervalli

Inferenza computazionale (moderna)

• Bootstrap

• Jacknife

• Cross-validation

• Ensemble Methods

• Test delle ipotesi statistiche

– Logica e caratteristiche fondamentali dei test

– Test Parametrici e non parametrici

Sono già noti i concetti di…

• Statistica descrittiva;

• Probabilità;

• Variabili casuali.

Premessa

Un’industria che produce pompe idrauliche utilizza guarnizioni in materiale

plastico che vengono usate nel raccordo degli elementi meccanici. Le

guarnizioni vengono fornite da un’industria chimica con un contratto di

forniture periodiche di 5000 guarnizioni alla volta.

L’industria acquirente ha l’esigenza di valutare la qualità dei pezzi forniti per

ogni fornitura.

Il tempo (e il costo) di collaudo delle guarnizioni rende inverosimile

procedere all’esame di tutti i pezzi forniti, visto che le guarnizioni devono

essere fatte funzionare sotto pressione elevata e per un certo periodo di

tempo.

Si procede, così, all’esame di un numero limitato di guarnizioni, ad esempio

50, e dall’esame di soli questi pezzi si vuol valutare la frazione di pezzi

difettosi dell’intera partita ed eventualmente respingere la fornitura.

Premessa (Cont’d…)

Si può considerare la partita di 5000 guarnizioni come la popolazione

oggetto di indagine in cui ogni pezzo rappresenta un «soggetto» (o unità

statistica) del quale siamo interessati alla sua conformità o meno alle

specifiche tecniche.

Le 50 guarnizioni che vengono effettivamente controllate sono il campione,

attraverso l’analisi del quale si vuole valutare la frazione di elementi

conformi nell’intera popolazione.

Ovviamente le rilevazioni sugli elementi del campione sono di interesse

nella misura in cui esse forniscono informazione sulle caratteristiche della

popolazione.

Per poter estendere le caratteristiche del campione alla popolazione, è

necessario che questo debba riprodurre, per quanto possibile, le

caratteristiche della popolazione, cioè deve essere rappresentativo della

stessa.

Premessa (Cont’d…)

Affinché un campione sia rappresentativo bisogna scegliere gli elementi che

lo compongono in modo tale che l’inclusione sia indipendente dalle

caratteristiche che si vogliono esaminare.

Un modo che assicura l’indipendenza richiesta è quello di scegliere gli

elementi del campione in modo casuale, quindi per definizione in modo

indipendente dalla caratteristica oggetto di studio.

Si può pensare di istituire un esperimento casuale ausiliario per selezionare

i soggetti da includere nel campione, idealizzandolo (ad esempio) nella

estrazione di tante palline da un’urna che contiene tanti elementi quanti

sono gli elementi della popolazione.

L’estrazione può avvenire con ripetizione o senza ripetizione.

La probabilità di estrazione potrebbe non essere uguale per tutti se, ad

esempio, si assegnano probabilità di estrazione diverse a palline diverse,

oppure se si predispongono più urne…

Premessa (Cont’d…)

L’esempio dell’industria può essere comparato ad una situazione in cui in

un’urna ci sono 5000 palline (la popolazione di guarnizioni) di cui una

proporzione incognita è rappresentata da palline nere (i pezzi difettosi).

Supponiamo che l’estrazione delle 50 palline dia luogo al risultato che 4 di

esse siano nere.

La proporzione 4/50 è un criterio ragionevole per dare un valore a , ma ad

esempio, se si fossero estratte 100 palline di cui 8 difettose, la proporzione

sarebbe rimasta immutata. Le domande a cui cerchiamo di dare una risposta

sono:

• Cosa sarebbe cambiato se avessimo scelto di estrarre 100 palline?

• Ci sono altri metodi di scegliere ragionevolmente ?

• Quanto è accurata la valutazione del risultato?

• Che informazione abbiamo su altri plausibili valori di ?

Premessa (Cont’d…)

L’esperimento in questione ci consente di individuare la v.c. che ha generato

il fenomeno nella popolazione

50

=4 =

1−

4

Nel grafico si è lasciata

variare l’incognita nel

range dei possibili valori

che nella realtà può

assumere.

Il massimo valore che la

figura assume si trova in

corrispondenza di

= 4/50.

Se avessimo optato per

un valore alternativo di

pari a 6/50, quale tra

le alternative sarebbe

stata più verosimile?

Premessa (Cont’d…)

Nel grafico si è assunto di avere estratto un campione di numerosità 100. Si è poi diviso il

risultato di ogni valore di ottenuto per il suo massimo, al fine di rendere sovrapponibili le

due figure. Il massimo valore che la figura assume si trova in corrispondenza di = 4/50.

Quale delle due situazioni fornisce maggiore informazione?

Premessa (Cont’d…)

Si può individuare un intervallo di valori sufficientemente plausibili per che tenga conto del

fatto che vi è comunque un grado di imprecisione intrinseco nel risultato dell’estrazione

campionaria?

Campione Casuale

Indichiamo con X la popolazione, la quale è caratterizzata dalla v.c. X. La

conoscenza della popolazione X coincide strettamente con la funzione di

ripartizione

; della v.c. X.

Dalla popolazione X viene estratto un sottoinsieme di n unità statistiche. La

procedura di selezione (assimilabile ad una prova nel senso del calcolo delle

probabilità) genera una n-pla di v.c. ( , , … , )la cui determinazione

numerica specifica una n-pla di numeri reali ( , , … , ) detto campione

osservato. Di conseguenza, ogni è la realizzazione della v.c. che prende

il nome di v.c. della i-ma estrazione. E’ da notare, inoltre, che ogni

proviene dalla stessa v.c. ∼ ( ; ).

Le v.c. sono quindi componenti della v.c. n-pla

indipendenti e identicamente distribuite.

=(

,

,…,

)

Campione Casuale e Campione Osservato

Una successione di v.c. ( , , … , ) ottenute con una procedura di

estrazione da ∼ ( ; ) è detta campione casuale se le v.c. , = 1, … ,

sono indipendenti e identicamente distribuite.

Il campione osservato è la n-pla di numeri reali ( ,

costituiscono le realizzazioni del campione casuale.

,…,

) che

La distribuzione congiunta del campione casuale è, pertanto,

( ; ) = ( ; ) ( ; )… (

; )=

!

( ; )

Statistica, Stimatore, Statistica-test

Si definisce statistica (campionaria) " = "( , , … , ) qualunque funzione nota

e a valori reali del campione casuale indipendente da quantità incognite. Essendo

funzione di variabili casuali, la statistica stessa è una variabile casuale.

Il valore della statistica " calcolata sul campione casuale # = "( , … ,

il nome di statistica calcolata.

), prende

Nell’ambito della teoria della stima, la statistica è chiamata stimatore mentre la

statistica calcolata è detta stima;

Nell’ambito della teoria della prova delle ipotesi, la statistica viene detta statisticatest.

La distribuzione di probabilità della statistica prende il nome di distribuzione

campionaria della statistica (stimatore) " .

Distribuzioni campionarie (intro)

Per semplicità, consideriamo lo schema di campionamento casuale semplice,

che corrisponde allo schema di estrazione con reinserimento.

Indichiamo con N la numerosità della popolazione, mentre indichiamo con n

la numerosità campionaria.

L’universo campionario (cioè l’insieme di tutti i possibili campioni di ampiezza

n che possono essere estratti da una popolazione di cardinalità N) è pari a

$ =%

Per curiosità, nel caso di caso di campionamento senza reimmissione, esso è

pari a

$ =

%

%!

=

! (% − )!

Distribuzioni campionarie (esempio)

Supponiamo di avere una popolazione di 4 macchinari (A, B, C, D) preposti

alla misurazione del tempo di reazione di una cellula fotoelettrica allo

spostamento d’aria. Supponiamo che, nel corso di una giornata, commettono

errori di misurazione rispettivamente pari a 1, 2, 3 e 4 millisecondi.

La media degli errori di tali macchinari è pari a 2,5, mentre la varianza è pari

a 1,25.

Supponiamo di essere interessati alla stima della media degli errori dei

macchinari.

Supponendo di estrarre un campione di n=2 macchinari, è possibile estrarre

un massimo di 4 = 16 possibili campioni differenti.

Distribuzioni campionarie (esempio)

Si ottengono i seguenti risultati:

n.b.

= 2,5;

)*+ = 0,625;

,-

=

, .

= 0,625

Distribuzioni campionarie (esempio)

Immaginiamo di estrarre tutti i campioni di numerosità 3

Si ottengono i seguenti risultati:

n.b.

= 2,5;

)*+ = 0,4167;

,0

=

, .

0

= 0,4167

Distribuzioni campionarie

Per qualsiasi v.c. che possiede varianza finita, la statistica media campionaria

ha valor medio pari al valor medio della popolazione e varianza pari alla

varianza della popolazione diviso per la numerosità campionaria.

Se X è una v.c. Normale, allora anche la v.c. media campionaria è una v.c.

Normale.

Distribuzioni campionarie notevoli:

differenza tra medie

Sia ( , , … , ) un campione casuale proveniente da

43

allora ∼ %(1, 5 ).

Sia ( , , … , 6 ) un campione casuale proveniente da

3 ∼ %(17 , 48).

9

∼ %(1, 2 ),

∼ %(17 , 27 ), allora

Se i due campioni sono indipendenti, allora è noto che per qualunque

443

3

combinazione lineare (* + ; ) ∼ %((*1 + ;17 ), (*

+ ; 8)).

5

9

La v.c. differenza tra medie campionarie 3 − 3 sarà anch’essa normale, con

la conseguenza che la corrispondente v.c. standardizzata si distribuisce come

una v.c. normale standardizzata:

3− 3

∼ %(0,1)

< =

,-

+

,86

Distribuzioni campionarie notevoli:

varianza campionaria

Sia ( , , … , ) un campione casuale proveniente da ∼ %(1, 2 ),

(?@ AB)supponiamo che allora 1 sia nota. Sia V = ∑ !

la varianza.

C

=D

2

!

?@ AB

,

=D

!

?@ ABE?3A?3

,

=D

!

?@ A?3

,

G con n gdl.

Poiché

F

,-

+

?3AB

,

G con 1 gdl, poiché

?3AB

,

=

?3AB

,/

si decompone nella somma di 2 v.c. di cui una è una v.c. G

teorema di Fisher e Cochran segue che ∑ !

J

H@ IH

4

∼G

A

Se Q, Q1 2 Q2 sono forme quadratiche tali che Q=Q1+Q2, e se K ∼ G L e

K1 ∼ G L , allora K2 ∼ G L0 con g3=g1-g2 con q1 e q2 indipendenti.

, per il

Distribuzioni campionarie notevoli

Questo significa che ( − 1)4M- ∼ G

-

A

A fini inferenziali (per i test statistici) dai risultati precedenti risulta che:

3−1

<

"=

=

∼# A

N /

G A

−1

3− 3

6( E6A )

∼ # E6A

"=

E6

( − 1)N + O − 1 S7

2? G A /( − 1)

N?

=

∼

=

N7 27 G 6A /(O − 1)

A ,6A

Proprietà degli stimatori: introduzione

La conoscenza della distribuzione campionaria dello stimatore è necessaria sia

per valutare la bontà di una particolare procedura di stima, sia per

confrontare tra loro stimatori alternativi.

- Quali sono i criteri per stabilire se uno stimatore è un «buon» stimatore?

- Proprietà per «piccoli campioni»

- Proprietà per «grandi» campioni

- Quali sono i metodi di costruzione degli stimatori?

- Metodi «classici» (parametrici)

- Metodi «moderni» (computazionali)

Proprietà degli stimatori: Correttezza

Uno stimatore T si dice corretto per

se

Q " =

Evidentemente, se Q " ≠ lo stimatore si dice distorto, e la distorsione è

definita dalla grandezza ; " = Q " − .

La v.c. media campionaria è uno stimatore corretto poiché Q 3 = 1.

La v.c. varianza campionaria è uno stimatore distorto poiché

Q N = 2 (1 − )

Poiché la distorsione è nota, è agevole provvedere alla correzione della

statistica calcolando la varianza campionaria corretta in questo modo

1

D

−1

!

− ̅

Proprietà degli stimatori: Efficienza

L’Errore Quadratico Medio di uno stimatore T si definisce come

TNQ = Q " −

E si decompone nella somma della varianza dello stimatore e del quadrato

della sua distorsione:

TNQ = Q " − Q "

=Q "−Q "

Varianza

+ Q " −

+ Q " −

=

Distorsione

Se uno stimatore è corretto, l’errore quadratico medio coincide con la

varianza.

Proprietà degli stimatori: Efficienza

Per confrontare due stimatori T1 e T2 per si può misurare l’efficienza relativa di T1

rispetto a T2 rapportando i rispettivi Errori Quadratici Medi.

U

TNQV

"1, "2 =

TNQV

Se eff(T1,T2)<1, allora lo stimatore T1 è efficiente relativamente a T2

Supponiamo che uno stimatore T sia corretto: esiste un limite inferiore alla sua

varianza?

Si può dimostrare (Disuguaglianza di Cramér & Rao) che

C*+ " ≥ X

A

Dove X A è l’informazione di Fisher (vedi oltre)

Se esiste uno stimatore corretto per che raggiunge il limite di Cramér e Rao, allora

esso è unico.

Proprietà asintotiche degli stimatori

Uno stimatore T si dice asintoticamente corretto se

lim Q(") =

→]

Uno stimatore T si dice coerente (o consistente) in media quadratica se

lim TNQ(") = 0

→]

La coerenza in media quadratica implica la correttezza asintotica.

Uno stimatore T si dice coerente (o consistente) in probabilità se, ∀_ > 0

lim

→]

"−

<_ =1

La coerenza in media quadratica implica la coerenza in probabilità (ma non è

vero il contrario).

Proprietà asintotiche degli stimatori

Uno stimatore T si dice coerente (o consistente) quasi certamente se

( lim " − ) = 1

→]

Uno stimatore T si dice asintoticamente efficiente se

lim C*+ " = X

→]

A

Uno stimatore T si dice asintoticamente normale se lim

→]

" − Q(")

C*+(")

≤ # = Φ(#)

Metodi di costruzione degli stimatori:

Metodo dei momenti

I momenti di ordine r si definiscono come i valori medi delle potenze resime della v.c. X

1d = Q

d

=

e

]

A]

]

D

d

!

d

g

f

Metodi di costruzione degli stimatori:

Metodo dei momenti

Sia ∼

; un v.c. che possieda momenti Q d = 1d , + = 1,2, … , O

Se si indicano con Td i momenti campionari generati dal campione casuale

, ,…,

, il metodo dei momenti consiste nel risolvere rispetto a il

sistema delle prime m equazioni

1d

= Td , + = 1,2, … , O

Il metodo dei momenti fornisce stimatori che godono di proprietà

asintotiche (sono coerenti, asintoticamente corretti e asintoticamente

normali).

Non sempre fornisce stimatori efficienti.

Metodi di costruzione degli stimatori:

Metodo dei minimi quadrati

Sia

, ,…,

un campione casuale proveniente da ∼

; . Se

ognuna delle v.c. componenti il campione casuale può essere interpretata

come la somma di una componente deterministica e di una quantità stocastica

+_

=h

Allora si può utilizzare il metodo di stima dei minimi quadrati.

La parte deterministica h

è formata da funzioni note e a valori reali del

parametro , mentre le v.c. _ hanno valore atteso nullo, varianza costante e

sono incorrelate tra loro.

Il metodo dei minimi quadrati deriva la stima del parametro (o del vettore

vettore di parametri) in modo tale che

i

=D

!

−h

=O Metodi di costruzione degli stimatori:

Metodo dei minimi quadrati

La soluzione di minimo si ottiene derivando iN

l’equazione ij

=0

D

!

(

−h

rispetto a

e risolvendo

kh

)

=0

k( )

Al variare dei campioni, tale soluzione genera una funzione delle v.c.

campionarie che definisce lo stimatore dei minimi quadrati per .

Nell’ambito di stimatori lineari (vedi seminario sulla regressione lineare), si

può dimostrare che detti stimatori sono BLUE (Best Linear Unbiased

Estimators).

Gli stimatori dei minimi quadrati sono asintoticamente normali e coerenti. Per

l’applicazione di tale metodo non è necessario conoscere la distribuzione di

probabilità della v.c. che genera il campione.

Metodi di costruzione degli stimatori:

Metodo della massima verosimiglianza

Sia

, ,…,

un campione casuale proveniente da ∼

; .

Abbiamo già visto che ( ; ) = ( ; ) ( ; ) … ( ; ) = ∏ ! ( ; )

è la funzione di densità congiunta del campione casuale. Essa, prima di

estrarre il campione, e il parametro (o il vettore di parametri) fisso, esprime

la probabilità di estrarre proprio quel campione casuale

Supponendo che il campione sia stato estratto, supponendo che sia

incognito, la quantità ℒ( ; ) = ( ; ) ( ; ) … ( ; ) = ∏ ! ( ; )

prende il nome di funzione di verosimiglianza, ed è funzione del solo

parametro .

Essa esprime la plausibilità di ottenere quel campione casuale le cui

determinazioni numeriche si sono effettivamente realizzate. Se ℒ( ; ) >

ℒ( ; ), allora è maggiormente verosimile che il parametro caratterizzante la

v.c. nella popolazione sia e non .

Metodi di costruzione degli stimatori:

Metodo della massima verosimiglianza

Spesso si preferisce lavorare con il logaritmo della funzione di verosimiglianza,

C = nohℒ( ; ) = D

!

noh ( ; )

Si definisce la funzione score la derivata della funzione di verosimiglianza

rispetto al parametro

knohℒ( ; )

j

C =

k

Se valgono alcune condizioni di regolarità sulla funzione di verosimiglianza

(esistenza per ogni x delle derivate fino al terzo ordine, valore atteso del

quadrato della funzione score finito), allora si ha che

Q C j = 0; C*+ C j = Q C j

= −Q C jj = X( )

Metodi di costruzione degli stimatori:

Metodo della massima verosimiglianza

La grandezzaX( ) prende il nome di informazione (attesa) di Fisher. Questa

grandezza può essere interpretata come un indice della rapidità di caduta

della funzione di (log)verosimiglianza intorno al suo punto di massimo, e di

conseguenza del grado relativo di preferenza che la verosimiglianza assegna al

valore di corrispondente al suo massimo rispetto a valori alternativi.

Il metodo di stima della massima verosimiglianza propone come stima per

il valore #( , , … , ) per il quale la funzione di verosimiglianza è massima.

La soluzione della funzione score corrisponde quindi alla stima di massima

verosimiglianza. Al variare del campione essa descrive una v.c. che

rappresenta lo stimatore di massima verosimiglianza.

Metodo della massima

verosimiglianza: proprietà

Sotto le condizioni di regolarità, gli stimatori di massima verosimiglianza

possiedono tutte le proprietà considerate ottimali.

- Invarianza: se T è lo stimatore di massima verosimiglianza per e se

p=f

è una funzione biunivoca di , allora f " è lo stimatore di

massima verosimiglianza per f

- Coerenza: gli stimatori di massima verosimiglianza sono coerenti e

asintoticamente corretti

- BAN: per gli stimatori di massima verosimiglianza vale che

q

" → %( , X A ). Quindi sono stimatori BAN (Best Asintotically Normal)

- Se esiste uno stimatore T non distorto e efficiente per , e se T* è la

soluzione di massima verosimiglianza di C′( ), allora " ≡ " ∗

- Se esiste uno stimatore efficiente per , allora lo stimatore di massima

verosimiglianza coincide con esso ed è quindi efficiente per ogni n finito. Se

non esiste uno stimatore efficiente per , allora lo stimatore di massima

verosimiglianza è comunque asintoticamente efficiente.

Stima per intervalli

Per quanto accurata sia la stima e per quanto sia affidabile lo stimatore, a volte

è preferibile accompagnare il risultato numerico derivato dal campione con una

misura di affidabilità circa la sua collocazione più probabile.

Sia

, ,…,

un campione casuale proveniente da ∼

; . Si

definisce variabile casuale pivot una v.c. )( ; ) che è funzione sia del

campione che del parametro incognito (quindi, non è una statistica), ma la cui

distribuzione di probabilità è indipendente da parametri incogniti.

Se esiste una v.c. pivot per , e se la funzione che definisce la stessa è

invertibile, allora si può scrivere che

)u ≤ ) ; ≤ Cv = () A )u ,

≤ ≤ ) A )v , ) = 1 − w

Si può definire allora un intervallo casuale con coefficiente di confidenza 1 − w,

i cui limiti sono ) A )u , e ) A )v ,

Sia

,

Stima per intervalli: v.c. pivot

,…,

un campione casuale proveniente da

∼ % 1; 2 .

HIy

Poiché sappiamo che Z = 4/

∼z({, ), allora Z è una v.c. pivot perché la sua

5

distribuzione di probabilità non dipende da 1.

J

HIy

∼~ 5I• . Allora T è una v.c. pivot

Se 2 è incognita, sappiamo che T = }/

5

perché la sua distribuzione di probabilità non dipende da 1.

J

E così è vero per tutte le distribuzioni notevoli che abbiamo incontrato prima.

In genere,

Se esiste uno stimatore di massima verosimiglianza T per un parametro di

posizione (come la media), allora la v.c. T- è una v.c. pivot. Se è un

parametro di scala (come la varianza), allora la v.c. T/ è una v.c. pivot.

Sia

,

Stima per intervalli: v.c. pivot

,…,

Poiché < =

?3A€

,/

un campione casuale proveniente da

∼ %(0,1) allora si può dire che

3−

2/

Da cui Xƒ

< •(‚/

A‚

)

=1−w

= 3 ∓ •(‚/ ) 2/

∼%

;2 .

Stima per intervalli

Prima dell’estrazione del campione, si potrebbe parlare di probabilità che il

parametro incognito nella popolazione sia incluso tra i limiti inferiore e

superiore dell’intervallo casuale;

Dopo che il campione è stato estratto, la probabilità che il parametro incognito

ricada all’interno dei limiti inferiore e superiore vale 1 se l’affermazione è vera

e 0 altrimenti.

Si parla quindi di intervalli di confidenza, con grado di confidenza pari a 1 − w,

perché ripetendo l’esperimento un numero elevato di volte i limiti

dell’intervallo casuale conterranno il parametro incognito in una frazione pari a

1 − w %.

Stima per intervalli

Da una popolazione generata da una normale con media pari a 120.92 e varianza

pari a 49 si sono estratti 100 campioni casuali di ampiezza 40. Si riportano 100

intervalli di confidenza al 95%

Stima per intervalli

Da una popolazione generata da una normale con media pari a 120.92 e varianza

pari a 49 si sono estratti 100 campioni casuali di ampiezza 40. Si riportano 100

intervalli di confidenza al 99%

Stima per intervalli

Da una popolazione generata da una normale con media pari a 120.92 e varianza

pari a 49 si sono estratti 100 campioni casuali di ampiezza 40. Si riportano 100

intervalli di confidenza al 90%

Stima per intervalli

La stima per intervalli in questo modo è possibile se si suppone che la v.c. che

governa il fenomeno oggetto di studio nella popolazione sia Normale.

Se ciò non dovesse essere verificato, e si ha conoscenza del momento

secondo, si può ricorrere alla disuguaglianza di Tchebycheff

3−1 ≤ _ ≥ 1−

2 /

_

Alternativamente si può ricorrere ad intervalli di confidenza non parametrici,

(ad es. Bootstrap, vedi oltre).

Metodi di stima computazionali

Ai metodi di stima «moderni» si può far ricorso in situazioni diverse:

- Le condizioni di regolarità possono non essere soddisfatte, o la condizione di

massimo può essere raggiunta solo per via numerica. In questo caso si

utilizzano metodi di ottimizzazione numerica, quali ad esempio:

- Il metodo Newton_Raphson (molto utilizzato per problemi di stima dei parametri nei

modelli lineari generalizzati);

- Il metodo Tri-section (metodo molto semplice, ma anche poco efficiente);

- Il metodo dello scoring (simile al metodo Newton-Raphson, ma che sfrutta le proprietà

statistiche della funzione di verosimiglianza);

- Algoritmi di «Majorizing», come l’algoritmo SMACOF (metodo iterativo per la

minimizzazione di funzioni di perdita –come nel caso dei minimi quadrati- molto

utilizzato in statistica multivariata per problemi di multidimensional scaling);

- Algoritmi di Alternating Least Squares (metodi iterativi per la minimizzazione di funzioni

di perdita, molto utilizzati per problemi di regressione non lineare).

- ….

Metodi di stima computazionali

Ai metodi di stima «moderni» si può far ricorso in situazioni diverse:

- Si può avere una conoscenza solo approssimata o addirittura inesistente

della v.c. che ha generato il campione.

-

Si può avere l’esigenza di rendere maggiormente «robuste» le stime che

ottengono.

- Si può avere l’esigenza di pervenire a stime intervallari senza avere alcuna

idea della distribuzione di probabilità nella popolazione

- Bootstrap

- Jacknife

- Cross-validation

- Ensemble methods (Bagging, Boosting, Random Forest,…)

Bootstrap

Tecnica che fa parte della famiglia dei metodi di ricampionamento.

Dal campione osservato si estraggono B campioni casuali con ripetizione della

stessa numerosità del campione osservato.

Per ciascuno di tali campioni si calcolano le grandezze (stime) di interesse,

ottenendone così una successione.

Il bootstrap viene maggiormente utilizzato per:

• Stimare la distorsione;

• Stimare la varianza;

• Generare intervalli di confidenza, generalmente con il metodo del

percentile.

Bootstrap: toy example 1

Si è generato un «campione casuale» da una v.c. normale di dimensione 100.

Immaginiamo che esso sia la nostra popolazione e valutiamo la distorsione con

il metodo bootstrap.

Abbiamo (nella popolazione) 1 = 9,9439 e 2 = 8,3158.

Generiamo 10000 campioni bootstrap e valutiamo la correttezza degli stimatori

media e varianza campionaria (esempio eseguito con MatLab).

Abbiamo che Q 3‰ − 1 = −0,00001, Q N‰ − 2 = −0,0831588

Lo stimatore media campionaria (come è noto) è corretto, mentre lo

stimatore media campionaria è (come altrettanto noto) distorto.

Sappiamo anche che la distorsione è pari a −

,-

Dai dati della nostra «popolazione» abbiamo che

.

—,0 .—

{{

= 0,083158

Bootstrap: toy example 2

Dal dataset «auto-mpg» (UCI machine learning repository) stimiamo la retta dei

minimi quadrati (vedi seminario su regressione lineare). Si vuole spiegare il

consumo delle automobili espresso in miglia per galloni a partire da una serie

di caratteristiche delle auto. Si riportano sia gli intervalli di confidenza (95%) sui

coefficienti sia gli stessi calcolati con 10000 ripetizioni boostrap (percentile CI)

Beta CI_lower CI_upper

intercept

-17,955 -27,150 -8,759

cylinders

-0,490 -1,121

0,142

displacement 0,024

0,009

0,039

horsepower -0,018 -0,045

0,009

weight

-0,007 -0,008 -0,005

acceleration

0,079 -0,114

0,272

model year

0,777

0,675

0,879

origin_EU

2,630

1,516

3,744

origin_JAP

2,853

1,766

3,940

Boot_CI Boot_CI

Boot_Beta lower upper

intercept

-17,746 -27,583 -7,859

cylinders

-0,492 -1,079 0,130

displacement

0,024 0,007 0,041

horsepower

-0,018 -0,047 0,009

weight

-0,007 -0,008 -0,005

acceleration

0,075 -0,170 0,319

model year

0,776 0,672 0,881

origin_EU

2,631 1,338 3,906

origin_JAP

2,858 1,812 3,926

Jackknife

Tecnica che fa parte della famiglia dei metodi di ricampionamento.

Dal campione osservato di numerosità n si estraggono tutti i possibili n

campioni di numerosità n-1 ottenuti eliminando a turno dal campione la i-ma

unità.

Si procede in maniera analoga al metodo bootstrap.

Il metodo jackknife viene maggiormente utilizzato per la costruzione di

intervalli di confidenza.

Metodi Ensemble

Tecniche che fanno parte della famiglia dei metodi di ricampionamento,

principalmente per modelli di regressione (parametrica e non parametrica) e di

classificazione supervisionata (vedi seminari su regressione non parametrica e

sullo statistical learning).

Un ensemble è una aggregazione di classificatori con lo scopo di combinare in

qualche modo le decisioni individuali di ciascuno di questi per classificare

nuove osservazioni.

La particolarità del BAGGING (Bootstrap Aggregating) consiste nell’utilizzare il

Bootstrap come metodo di ricampionamento; questo significa che la

probabilità di essere estratto, per ciascun individuo, è costante in ogni prova e

uguale per tutti. La stima finale è quindi l’aggregazione della risposta dei

modelli di regressione o di classificazione attraverso la media o utilizzando

«majority rules».

Metodi Ensemble

0.2

test error single tree

test error Bagging

0.18

0.16

0.14

test error

0.12

0.1

0.08

0.06

0.04

0.02

0

0

5

10

15

20

25

30

Bootstrap replications

35

40

45

50

Metodi Ensemble

BOOSTING

L’IDEA:

Addestrare l’algoritmo di apprendimento (weak learner) su un data set e

costringerlo ad imparare dai propri errori a classificare in modo corretto.

Weak learner:

Classificatore almeno moderatamente accurato (le sue previsioni devono

essere almeno leggermente migliori rispetto ad una scelta totalmente casuale).

Si ricampiona dal set di dati in modo che le osservazioni malclassificate (o con

valori maggiori della funzione di perdita) hanno maggiore probabilità di essere

estratte, forzando il weak learner ad addestrarsi sugli errori commessi per

poterli correggere.

La stima finale è l’aggregazione della risposta ponderata dei modelli di

regressione o di classificazione attraverso medie ponderate o a utilizzando

«majority rules».

Metodi Ensemble

Cross-Validation

CROSS-VALIDATION

Molto simile concettualmente al Jackknife nella sua forma più estrema (leaveone-out cross-validation).

L’idea:

Dividere il set di dati di numerosità n in V sottocampioni di numerosità n/ V (in

genere si pone V=10).

Si procede effettuando V analisi (escludendo di volta in volta il subset di dati

corrispondente alla frazione n/ V), testando il modello solo sulla parte restante

del modello.

Metodo molto utilizzato nei metodi di regressione e classificazione non

parametrici (alberi di classificazione e regressione, criterio di scelta dei

parametri di penalizzazione nelle p-splines) e anche nei metodi di regressione

parametrica (ridge regression, procedure di optimal scaling)

Cross-Validation

Albero di classificazione validato via cross-validation. Funzione di goodness:

˜? rank correlaztion coefficient.

Cross-Validation

Cross-validation applicata al criterio di selezione della penalità per l’utilizzo delle psplines

Test delle ipotesi statistiche

Si può derivare un test delle ipotesi supponendo nota la distribuzione

di probabilità di una v.c. X, quindi l’inferenza si riferisce ai soli parametri

che la specificano (Test Parametrici)

Si può derivare un test senza fare assunzioni stringenti sulla forma

analistca della distribuzione di probabilità della v.c. X (ma qualche

assunzione minimale va fatta: unimodale? continua? simmetrica?

Possiede momento r-mo finito?). L’inferenza riguarda quindi sia la

forma che i parametri (Test non parametrici, o distribution free).

Test delle ipotesi statistiche

Un test è una regola istituita sullo spazio campionario mediante la

quale, in funzione del campione osservato, si decide se rifiutare o meno

una ipotesi ™{ riferita alla popolazione.

Un’ipotesi statistica è una affermazione che specifica completamente

(ipotesi semplice) o parzialmente (ipotesi composita) la distribuzione

di probabilità di una v.c. X.

∼ % 10,9 ; ∼ o 0,5 ; ∼ šf 1,6 ; … ipotesi semplici. Quando sono vere la

conoscenza di X è completa

∼ % 5, 2 ; ∼ o ; ∼ šf 1, % ; … ipotesi composite. Quando sono vere non

consentono di pervenire alla conoscenza di un’unica v.c. ben definita.

Test delle ipotesi statistiche

Si intende per ipotesi nulla (™{ ) l’ipotesi preesistente rispetto

all’esperimento campionario. E’ l’ipotesi che sussiste fino a prova

contraria.

L’ipotesi alternativa (™ ) è l’ipotesi complementare rispetto a ™{ .

E’ importante precisare subito che, qualora non fosse vera ™{ , non è

detto che sia vera ™ .

™{ e ™ sono esaustive e disgiunte: vale l’una o vale l’altra.

Test delle ipotesi statistiche

Il test è una regola basata sullo spazio campionario che si concretizza in

una funzione definita sull’insieme di tutti i possibili campioni generati

da X. Per alcuni valori

, ,…,

∈ œ{ per cui ∉ ž{ , (ž{ ⊂ Ω )

la regola imporrà di rigettare ™{ ,mentre per altri valori

, ,…,

∉ œ{ per cui ∈ ž{ la regola imporrà di non rigettare

™{ .

œ{ è detta regione critica (RC) per ™{ . La regione complementare è

detta regione di accettazione.

Poiché se l’ipotesi riguarda il parametro le informazioni riguardo ad

esso possono essere sintetizzate senza danno attraverso gli stimatori, la

regola decisionale definita tramite il campione casuale su œ{ si traduce

in una nuova regola fondata sullo stimatore (o statistica) " sulla base

di ƒ{

, ,…,

∈ œ{ ⇔ " ∈ ƒ{

Struttura probabilistica di un test

In teoria, prima di prendere una decisione, sono possibili le seguenti 4

situazioni

¦§ è vera

¦§ è falsa

Si rigetta ™{

Errore 1 (di prima specie)

Si rigetta ™{

Decisione Giusta 2

Non si rigetta ™{

Non si rigetta ™{

Decisione Giusta 1

Errore 2 (di seconda specie)

Dopo aver deciso se rigettare o meno ™{ , si può solo aver preso la

decisione giusta o aver commesso un errore.

w = E1 = Pr(rigettare ™{ |™{ è vera) = Pr(" ∈ ƒ{ |™{ )

¤ = E2 = Pr(non rigettare ™{ |™{ è falsa) = Pr(" ∉ ƒ{ |™ )

¥ = 1 − ¤ = Pr(rigettare ™{ |™{ è falsa) = Pr " ∈ ƒ{ ™

(decisione giusta 2, nota come POTENZA DEL TEST)

1 − w = Pr(non rigettare ™{ |™{ è vera) = Pr(" ∉ ƒ{ |™{ )(decisione giusta 1)

Struttura probabilistica di un test

Sarebbe auspicabile richiedere che la RC sia tale che sia w che ¤ siano

ragionevolmente piccole.

A parità di numerosità campionaria, non è possibile far tendere a zero

entrambe le probabilità di errore.

¤

1

1

w

Si potrebbe fissare w e scegliere la RC che minimizza ¤;

Si potrebbe fissare ¤ e scegliere la RC che minimizza w;

Si opta per la prima soluzione, poiché si ritiene più grave commettere

l’errore di prima specie (è più rischioso modificare a torto la realtà piuttosto che

persistere nella medesima situazione laddove non fosse più vera)

Struttura probabilistica di un test

Si definisce regione critica ottimale di ampiezza ¨ (RCO(w)) una RC per

™{ tale che Pr " ∈ ƒ{ ™{ = w e che, per qualsiasi altra RC ©j§ di

eguale ampiezza risulti:

¤ ƒ{ = Pr " ∉ ƒ{ ™ < Pr " ∉ ƒ{j ™ = ¤ ƒ{j .

E’ quindi ottimale la regione critica che, a parità di tutte quelle di

ampiezza w, possiede la più elevata potenza del test

¥ ª{ > ¥(ƒ{j )

Un buon test è quello con la potenza più elevata a parità di probabilità

di commettere l’errore di prima specie. Come si costruiscono le RCO(w)?

Lemma di Neyman Pearson

Sia X = ( , , … , ) un campione casuale generato da ∼ ( ; ).

Si vuole verificare ™{ : = { contro ™ : = . Sia i( ; ) la funzione

di verosimiglianza di X. La œƒ-(w) per ™{ contro ™ è quella regione ƒ{

che soddisfa:

dove i = i

i

*) ≥ ª; ;)Pr(X ∈ ƒ{ ™{ = w

i{

;

ei{ = i

{;

.

a) Implica che ƒ{ viene costruita in modo tale che l’ipotesi alternativa

deve risultare c volte più verosimile

b) Implica che la costante c è determinata in modo che la probabilità di

commettere l’errore di prima specie sia pari a w

Test di significatività

Si utilizza solo ™{ e ci si chiede se i dati sostengono tale affermazione.

L’ipotesi alternativa non è mai specificata.

Ci si basa sul p-value: g = Pr(" > #|™{ ), definito cioè come probabilità

che, se è vera ™{ , lo stimatore " assuma un valore almeno estremo

come la stima # osservata.

Non è possibile calcolare la potenza del test

Test uniformemente più potente

La potenza del test è definita come ¥ = Pr(" ∈ ƒ{ | = ). Se si

prende in considerazione qualsiasi valore di ∈ Ω( ), si definisce

funzione potenza

¥

= Pr " ∈ ƒ{

, ∀ ∈ Ω ,

w = sup ¥( )

€∈¯°

Sia ƒ{ una RC di ampiezza w. Un test si dice uniformemente più potente

šT ‚ se

≥ ¥ ∗ ∀ ∉ ž{

¥

dove ¥ ∗

è la funzione potenza di qualsiasi altro test di eguale

ampiezza.

Test LRT

Il test del rapporto di verosimiglianza (LRT) si basa sul rapporto tra la

verosimiglianza massimizzata sotto ™{ e la verosimiglianza massimizzata

senza alcun vincolo.

Sia X =

, ,…,

un campione casuale generato da ∼ ( ; ).

Si vuole verificare ™{ : ∈ ž{ contro ™ : ∉ ž{ . Si costruisce il

rapporto

max i( ; )

€∈¯°

=

±

max i( ; )

€∈³(€)

La RC è costruita in modo che sia

Pr ±

≤ ª‚ ™{ = w.

ƒ{ = { : ±

≤ ª‚ } è una RC costruita con il metodo LRT

Test LRT

Se è applicabile il Lemma di Neyman-Pearson, il LRT produce œƒ-(w)

coincidenti.

Sotto opportune condizioni di regolarità, se è vera ™{ allora

−2 log ±

q

→ G(L)

dove g è il numero di dimensioni dello spazio parametrico sotto ™{

(teorema di Wilks)

Test asintotici: Score test

Sia X =

, ,…,

un campione casuale generato da ∼ ( ; ·).

Si vuole verificare ™{ : · ∈ ·§ contro ™ : · ∉ ·§ . Sia C j (·) il vettore

degli score rispetto ai parametri:

k log i ·;

j

C · =

k

Si può dimostrare che

N

=

Cj

·§

k log i ·;

,

k

V

X ·§

A

k log i ·;

,…,

k 6

Cj

V

q

·§ → G(6)

Lo score test, rispetto al LRT, necessita solo del calcolo delle derivate

della funzione di verosimiglianza per · = ·§

Asintoticamente LRT e score test sono equivalenti

Test asintotici: test di Wald

Sia X =

, ,…,

un campione casuale generato da ∼ ( ; ·).

Si vuole verificare ™{ : · ∈ ·§ contro ™ : · ∉ ·§ . Si può dimostrare che

¸

= ¹º − ·§

VX

q

¹º ¹º − ·§ → G(6)

Asintoticamente LRT e score test e test di Wald sono equivalenti

LRT, Score test e test di Wald

When → ∞ the

three test statistics

have equivalent

properties.

For small the

Likelihood ratio

statistic is more

reliable than the

Wald statistic.

71

Principali test parametrici:

Test sul valore medio, varianza nota:

™ : 1 > 1{ œƒ- w 3 ≥ 1{ + •‚ 2/√

™ : 1 < 1{ œƒ- w 3 ≤ 1{ − •‚ 2/√

™{ : 1 = 1{ 3 ≥ 1{ + •‚/ 2/√

™ : 1 ≠ 1{ œƒ- w ½

3 ≤ 1{ − •‚/ 2/√

Test sul valore medio, varianza ignota:

™ : 1 > 1{ œƒ- w 3 ≥ 1{ + #(‚,L) ¾/√

™ : 1 < 1{ œƒ- w 3 ≤ 1{ − #(‚,L) ¾/√

™{ : 1 = 1{ 3 ≥ 1{ + #(‚/ ,L) ¾/√

™ : 1 ≠ 1{ œƒ- w ½

3 ≤ 1{ − #(‚/ ,L) ¾/√

Principali test parametrici:

Test sulla varianza, media ignota:

™{ : 2 = 2{

™ : 2 > 2{ œƒ- w N ≥ G(‚,L) 2{ /( − 1)

™ : 2 < 2{ œƒ- w N ≤ G(

A‚,L) 2{ /(

N ≥ G(‚/

™ : 2 ≠ 2{ œƒ- w ½

N ≤ G(

,L) 2{ /(

A‚/ ,L) 2{ /(

− 1)

− 1)

− 1)

Test sulla differenza tra medie, varianze ignote (note), campioni

indipendenti…

Test sulla differenza tra medie, varianze ignote (note), campioni

dipendenti (appaiati)…

Test sul rapporto tra varianze…

…and so on

Principali test non parametrici:

Test dei segni

Test di Wicoxon

Test di Mann e Whitney

Goodness of fit tests (test chi quadrato, test di Kolmogorov-Smirnov,

test di Jarque-Bera,…)

And so on

Letture consigliate

• Azzalini, A. Inferenza statistica, Springer, 2008

• Casella, G., Berger, R. Statistical inference, Brooks/Cole Pub. Co., 1990

• Erto, P. Probabilità e statistica per le scienze e l'ingegneria, McGraw-Hill,

2008

• Hastie, T., Tibshirani, R., Friedman, J.H. The elements of statistical learning,

Springer, 2009

• Landenna, G., Marasini, D., Ferrari, P. Teoria della Stima, Il Mulino 1997

• Landenna, G., Marasini, D., Ferrari, P. La verifica di ipotesi statistiche, Il

Mulino 1998

• Lindgren B., W. Statistical theory, Chapman & Hall, 1993

• Piccolo, D. Statistica, Il Mulino, 1998.

• Rice, J. Mathematical Statistics and Data Analysis, Duxbury, 2007

• …