Variabili aleatorie e test statistici Versione 2.0 (10 dicembre 2010) Corso di Laurea in Scienze e Tecnologie Agrarie – Facoltà di Scienze e Tecnologie Libera Università degli Studi di Bolzano – A.A. 2010/11 – Prof. Paolo Coletti Introduzione Questa dispensa contiene solo la parte sulle distribuzioni continue e sui test statistici per il corso di Matematica e Statistica. La dispensa è in continuo aggiornamento, attenzione alla data e alla versione. Indice

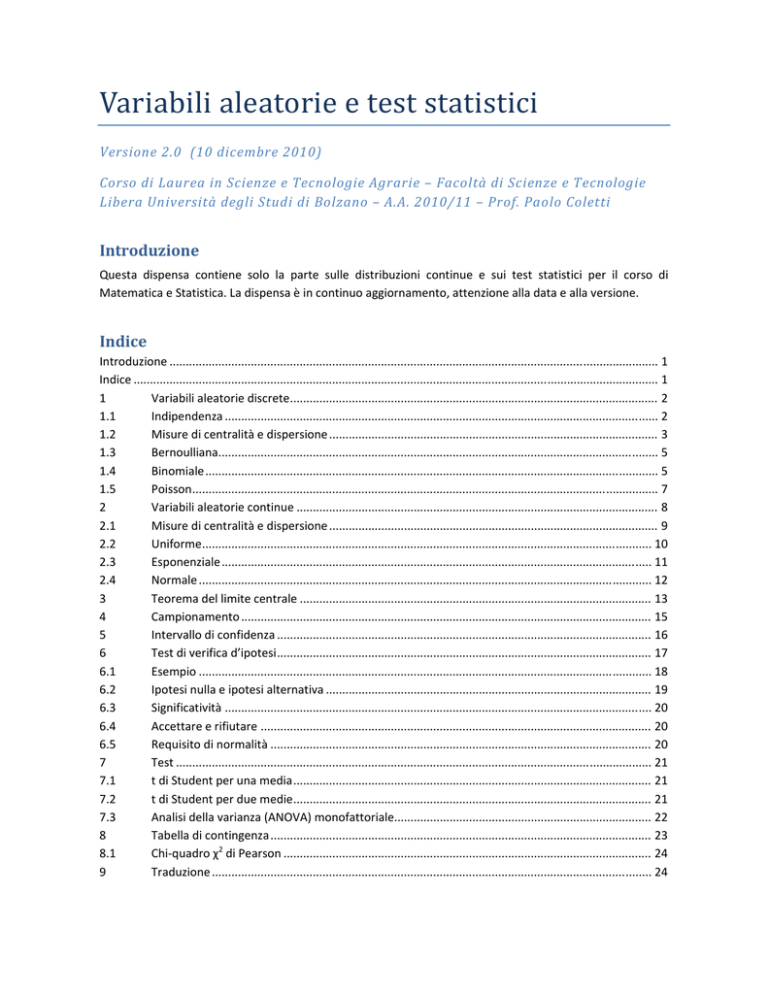

Introduzione ...................................................................................................................................................... 1 Indice ................................................................................................................................................................. 1 1 Variabili aleatorie discrete ................................................................................................................. 2 1.1 Indipendenza ..................................................................................................................................... 2 1.2 Misure di centralità e dispersione ..................................................................................................... 3 1.3 Bernoulliana ....................................................................................................................................... 5 1.4 Binomiale ........................................................................................................................................... 5 1.5 Poisson ............................................................................................................................................... 7 2 Variabili aleatorie continue ............................................................................................................... 8 2.1 Misure di centralità e dispersione ..................................................................................................... 9 2.2 Uniforme .......................................................................................................................................... 10 2.3 Esponenziale .................................................................................................................................... 11 2.4 Normale ........................................................................................................................................... 12 3 Teorema del limite centrale ............................................................................................................ 13 4 Campionamento .............................................................................................................................. 15 5 Intervallo di confidenza ................................................................................................................... 16 6 Test di verifica d’ipotesi ................................................................................................................... 17 6.1 Esempio ........................................................................................................................................... 18 6.2 Ipotesi nulla e ipotesi alternativa .................................................................................................... 19 6.3 Significatività ................................................................................................................................... 20 6.4 Accettare e rifiutare ........................................................................................................................ 20 6.5 Requisito di normalità ..................................................................................................................... 20 7 Test .................................................................................................................................................. 21 7.1 t di Student per una media .............................................................................................................. 21 7.2 t di Student per due medie .............................................................................................................. 21 7.3 Analisi della varianza (ANOVA) monofattoriale............................................................................... 22 8 Tabella di contingenza ..................................................................................................................... 23 8.1 Chi‐quadro χ2 di Pearson ................................................................................................................. 24 9 Traduzione ....................................................................................................................................... 24 Variabili aleatorie e test statistici Prof. Paolo Coletti 1 Variabili aleatorie discrete Le variabili utilizzate comunemente in matematica possono assumere un solo valore, anche se spesso questo valore resta incognito oppure è da determinare risolvendo delle equazioni. Le variabili aleatorie invece possono assumere un insieme di valori, ognuno con la propria probabilità. Esse si indicano in questo modo: dove è la probabilità del risultato , la probabilità del risultato , ecc. Soltanto quando un evento associato alla variabile aleatoria si verifica potremo quale risultato assume la variabile, ed a questo punto la variabile smette di essere una variabile aleatoria e diventa una variabile non aleatoria. Ad esempio, un lancio di dado può essere rappresentato, prima del lancio, dalla variabile aleatoria lancio di dado

1

1

2

1

3

1

4

1

5

1

6

1

6

6

6 6

6

6

I requisiti che una variabile aleatoria discreta deve soddisfare, per far sì che uno e solo uno dei risultati si verificherà, sono: 1. ogni probabilità deve essere compresa tra 0 e 1 2. la somma delle probabilità deve essere 1 1.1 Indipendenza Due variabili aleatorie si dicono indipendenti quando la probabilità che si verifichi una coppia di risultati è data esattamente dal prodotto delle probabilità dei singoli risultati. In termini matematici e P

per ogni possibile risultato e . Se anche una delle coppie ·P

P

di risultati non soddisfa questa relazione, allora le variabili aleatorie non sono indipendenti. Viceversa, per essere indipendenti tutte le possibili coppie di risultati devono soddisfare questa relazione. Il concetto di indipendenza tra variabili aleatorie indica che le due variabili non hanno nulla a che fare l’una con l’altra e non hanno modo di influenzare reciprocamente i risultati. Ad esempio, considerando le variabili aleatorie lancio di dado e lancio di moneta (indicando con 1 il risultato testa e con 2 il risultato croce) queste due variabili evidentemente non possono influenzarsi i risultati. Difatti, ad esempio, la probabilità di ottenere 3 con il dado e testa con la moneta è proprio 1/12, esattamente 1/6 ∙ 1/2. Facendo il calcolo con tutte le altre coppie otteniamo lo stesso risultato. Considerando invece le variabili aleatorie lancio di dado e quadrato del lancio precedente, queste due variabili sono palesemente dipendenti in quanto la seconda variabile è determinata unicamente dalla prima. Infatti Versione 2.0 (10‐dic‐10) Pag. 2 di 25 Variabili aleatorie e test statistici lancio di dado

1

1

2

1

3

1

4

1

5

1

6

1

Prof. Paolo Coletti 6

1

1

6

4

1

6 quadrato di lancio di dado

9

1

6

16

1

6

25

1

1

6

6

6 6

6

36

6

6

e P lancio di dado 2 e quadrato stesso lancio di dado 25

0, dato che è impossibile ottenere 2 con il lancio e 25 con il quadrato del lancio! Invece P lancio di dado 2 · P quadrato stesso lancio di dado 25

1/6 · 1/6 1/36. I due risultati non sono uguali, quindi le due variabili non sono indipendenti. Non è necessario verificare altre coppie, in quanto basta una coppia che non soddisfa la relazione per mostrare che le due variabili non sono indipendenti. Per fornire un altro esempio costruiamo la variabile che indica la somma di due lanci di dado. Questa variabile è fatta in questo modo somma

di due

lanci di

dado 1

1

1

1

1

1

1

36 2

2 1 36 2

3 1 36 2

4 1 36 2

5 1 36 2

6 1 36 2

1

1

1

2

1

3

1

4

1

5

1

6

1

36

3

36

3

36

3

36

3

36

3

36

3

somma di due

lanci di e, riassumendo i valori uguali, dado 1 1 36 4

2 1 36 4

3 1 36 4

4 1 36 4

5 1 36 4

6 1 36 4

2 1 36

3 2 36

4 3 36

5 4 36

6 5 36

7 6 36

1

2

3

4

5

6

8

5

9

4

10

3

11

2

12

1

1

36 5

1

36 5

1

36 5

1

36 5

1

36 5

1

36 5

1

36 6

2 1 36 6

3 1 36 6

4 1 36 6

5 1 36 6

6 1 36 6

1

1

1

2

1

3

1

4

1

5

1

6

1

36

36

36 36

36

36

36

36

36 36

36

dove la probabilità è sempre 1/36 = 1/6 ∙ 1/6 dato che i due lanci non hanno modo di influenzarsi a vicenda. Se ora consideriamo invece come X la variabile somma e come Y la variabile primo lancio, Y influenza evidentemente X, dato che metà della somma è determinata proprio dal primo dado. Infatti, facciamo il calcolo della probabilità di ottenere X=4 e Y=1, cioè P somma 4 e lancio primo dado 1 . La probabilità che il primo dado dia 1 è 1/6 e, a questo punto, la probabilità di ottenere una somma uguale a 4 condizionata dal fatto che il primo dado ha fatto 1 è 1/6, dato che l’unico risultato possibile per il secondo lancio è 3. Quindi la probabilità della coppia è 1/36. Mentre P somma 4 · P lancio primo dado 1

3/36 · 1/6 1/72 che è diverso da 1/36. 1.2 Misure di centralità e dispersione 1.2.1

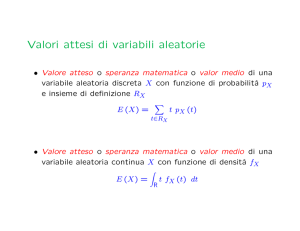

Valore atteso Il valore atteso di una variabile aleatoria X è Versione 2.0 (10‐dic‐10) Pag. 3 di 25 Variabili aleatorie e test statistici E

Prof. Paolo Coletti ·

dove xj sono i valori della variabile aleatoria e pj sono le relative probabilità. Il valore atteso ci dà una misura del punto centrale della variabile aleatoria, considerando i possibili valori e la probabilità di avvenire. Dalla definizione si capisce che intuitivamente il valore atteso è l’analogo della media di un insieme di dati. Calcolando il valore atteso del lancio di dado otteniamo 1

1

1

1

1

1

2·

3·

4·

5·

6·

3,5 6

6

6

6

6

6

e da qui possiamo notare che il valore atteso non coincide necessariamente con uno dei valori della variabile aleatoria ma può anche essere un numero che in realtà non avviene mai. E lancio di dado

1·

Il valore atteso ha delle interessanti proprietà: 1. E

E

E , cioè se sommiamo due variabili aleatorie (ottenendo una terza variabile aleatoria X+Y), il valore atteso della somma è la somma dei due valori attesi di partenza; 2. E ·

· E , cioè se moltiplichiamo una variabile aleatoria per una costante (ottenendo così un’altra variabile aleatoria cY), il valore atteso è quello di partenza moltiplicato per la costante; 3. E

, cioè se calcoliamo il valore atteso di una costante (che è in pratica una variabile aleatoria con un solo valore possibile) otteniamo esattamente la costante; 4. E

E

, cioè se aggiungiamo una costante ad una variabile aleatoria il valore atteso aumenta di una costante. Ad esempio, se consideriamo la variabile aleatoria “doppio di lancio di un dado”, che ha i seguenti valori doppio di lancio di dado

2·

2

1

4

1

6

1

8

1

10

1

12

1

6

6

6 6

6

6

Il suo valore atteso è 1

1

1

1

1

1

4

6

8

10

12

6

6

6

6

6

6

che è esattamente il doppio del valore atteso 2 · E lancio di dado

2 · 3,5 7. E doppio di lancio di dado

1.2.2

2

7 Mediana Un’altra misura di centralità che tiene maggiormente conto della distribuzione di probabilità e meno dei valori è la mediana. Questo valore è definito come quel valore per cui il 50% delle probabilità restano a sinistra e il 50% delle probabilità restano a destra. Nel caso del lancio di dado la mediana può essere 3,5, in quanto i valori a sinistra (1, 2 e 3) hanno una probabilità di 3/6, cioè del 50%, e quelli a destra (4,5 e 6) hanno una probabilità di 3/6, cioè del 50%. Però anche 3,1 è una possibile mediana, e anche 3,999. Pertanto la mediana di una variabile aleatoria discreta potrebbe non essere unica. Versione 2.0 (10‐dic‐10) Pag. 4 di 25 Variabili aleatorie e test statistici 1.2.3

Prof. Paolo Coletti Varianza e deviazione standard La varianza è una misura di dispersione, cioè ci dà un’idea di quanto dispersi sono i valori possibili della variabile aleatoria. Essa è calcolata così: Var

E

·

Quindi, per calcolare la varianza abbiamo bisogno del valore atteso. Ad esempio, nel caso del lancio di dado, Var lancio di dado

1

3,5

1

1

6 3,5 ·

6

6

La varianza ha delle interessanti proprietà: 5

3,5

1. Var

2. Var

3. Var

·

Var

Var

· Var

·

·

1

2

6

1

· 2,5

6

3,5

·

1,5

1

6

3

0,5

3,5

0,5

·

1

6

4

1,5

3,5

2,5

·

1

6

2,916 soltanto quando le variabili X e Y sono indipendenti; ; 0; 4. Var

Var

. Inoltre notiamo che la varianza, essendo una somma di quadrati moltiplicati per probabilità, che sono sempre positive, ha sempre un valore maggiore di 0. L’unico caso in cui vale esattamente 0 è quando la variabile aleatoria ha un solo valore, cioè è costante. Definiamo la deviazione standard come la radice quadrata della varianza Var

. 1.3 Bernoulliana La variabile aleatoria di Bernoulli è una semplice variabile aleatoria discreta con due valori: 1

0

bernoulliana

1

dove p è un parametro con valore tra 0 e 1. Pertanto la variabile di Bernoulli è non è una singola variabile aleatoria, ma un’intera famiglia di variabile aleatorie. Ad esempio, il lancio di una moneta può essere rappresentato, indicando con 1 testa e con 0 croce, tramite una variabile di Bernoulli con p=0,5: lancio di una moneta

1 testa

0 croce

50%

50%

Il valore atteso di una bernoulliana è facile da calcolare E Bernoulli

1·

0· 1

. La varianza ·

0

· 1

1 2

1

. è Var Bernoulli

1

Per quanto riguarda la mediana, se p=0,5 allora qualunque valore tra 0 e 1 è una possibile mediana, mentre se p≠0,5 la mediana non esiste in quanto automaticamente uno dei due valori possiede una probabilità superiore al 50% e pertanto è impossibile trovare un valore che abbia a sinistra 50% di probabilità e a destra 50% di probabilità. 1.4 Binomiale Se sommiamo due variabili bernoulliane indipendenti e con lo stesso parametro p=0,3 otteniamo: Versione 2.0 (10‐dic‐10) Pag. 5 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti 0

1

0

1

somma di due bernoulliane con parametro 0,3

0

0

1

1

0,7 · 0,7

0,3 · 0,7

0,7 · 0,3

0,3 · 0,3

0

1

2

0,49

0,42 0,09

dove le probabilità sono date dal prodotto delle probabilità dato che le due variabili sono indipendenti. Sommandone tre, otteniamo: somma di tre bernoulliane con parametro 0,3

0

1

0

1

0

1

0

1

0

0

1

1

0

0

1

1

0

0

0

0

1

1

1

1

0,7 · 0,7 · 0,7

0,3 · 0,7 · 0,7

0,7 · 0,3 · 0,7

0,3 · 0,3 · 0,7

0,7 · 0,7 · 0,3

0,3 · 0,7 · 0,3

0,7 · 0,3 · 0,3

0,3 · 0,3 · 0,3

0

1

2

3

0,343

0,441

0,189

0,027

Vediamo che la variabile risultante ha valori che vanno da 0, quando non abbiamo mai ottenuto un valore 1, a N, quando abbiamo sempre ottenuto il valore 1 in tutte le variabili bernoulliane considerate. La variabile aleatoria binomiale è definita come la somma di N variabili casuali bernoulliane, indipendenti e tutte con lo stesso parametro p. È importante sottolineare che le variabili bernoulliane sommate devono avere tutte lo stesso parametro p e devono essere indipendenti. Si può dimostrare che in generale la variabile binomiale è 0

1

B

;

0

1

1

0

1

1

1

1

1

1

1

Quindi la probabilità per il valore k della variabile binomiale è data esattamente dal coefficiente binomiale 1

moltiplicato per . La variabile aleatoria binomiale è una variabile a due parametri, in quanto cambia al variare dei parametri N e p, che devono essere N un numero intero maggiore1 di 1 mentre p un numero tra 0 e 1. Il valore atteso della variabile binomiale è facile da calcolare usando la proprietà 1 a pagina 4: E B

;

E Bernoulli

E Bernoulli

E Bernoulli

Dato che le variabili sono indipendenti, possiamo usare la proprietà 1 a pagina 5 per calcolare la varianza: Var B

;

Var Bernoulli

Var Bernoulli

1

1

1

Var Bernoulli

1

La mediana invece è difficile da calcolare nel caso generale e potrebbe non esistere per molti parametri N e p. Un esempio di una possibile applicazione della distribuzione binomiale è il seguente. Sappiamo che la probabilità che una mela sia marcia è dell’1%; se una cassa di mele contiene 200 mele, quali sono le probabilità di trovare zero mele marce, non più di 5 mele marce e non più di 10 mele marce? 1

Se N è 1, allora la variabile binomiale è una variabile di Bernoulli. Versione 2.0 (10‐dic‐10) Pag. 6 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti Considerando la variabile bernoulliana mela con valore 1 corrispondente a marcia e 0 corrispondente a buona, la distribuzione di mele marce nella cassa è una variabile binomiale B(200;0,01) e quindi: P B 200; 0,01

200

0,01 0,99

0

0

1 · 1 · 0,13398

13,398% P B 200; 0,01

5

P B 200; 0,01

0

P B 200; 0,01

1

P B 200; 0,01

2

P B 200; 0,01

3

P B 200; 0,01

4

P B 200; 0,01

5

200

200

200

0,01 0,99

0,01 0,99

0,01 0,99

0

1

2

200

200

200

0,01 0,99

0,01 0,99

0,01 0,99

3

5

4

0,13398 0,27067 0,27203 0,18136 0,09022 0,03572 98,398% Come è evidente, calcolare i valori di una binomiale è un procedimento lungo e pertanto è consigliabile utilizzare la funzione Excel BINOMDIST(k;N;p;FALSE) per calcolare la probabilità di un singolo valore e la funzione Excel BINOMDIST(k;N;p;TRUE) per calcolare la probabilità cumulata, cioè la somma delle probabilità da 0 a k. Difatti per calcolare P B 200; 0,01

10 utilizziamo BINOMDIST(10;200;0,01;TRUE) e otteniamo direttamente 99,999%. 1.5 Poisson Quando dobbiamo studiare un evento che ha una distribuzione binomiale ma non è noto il valore di N ma abbiamo la certezza che sia un valore grande, allora ricorriamo alla variabile aleatoria di Poisson. 0

Poisson

1

0!

0

1

1!

!

!

Come notiamo dalla definizione, la variabile di Poisson non ha un numero limitato di valori possibili ma può teoricamente assumere qualunque numero intero da 0 in poi come valore. Essa ha un parametro µ che deve essere un numero, anche non intero, positivo. Considerando un intervallo di tempo o di quantità, il parametro µ rappresenta quante volte solitamente osserviamo il fenomeno in quell’intervallo. Ad esempio, considerando un albero di mele con un numero indeterminato di mele e sapendo che solitamente su ogni albero ci sono 7 mele marce, la probabilità che le mele marce siano esattamente 4 è 7

2401

0,0009119 9,1226% 24

4!

Anche per la variabile di Poisson esiste la funzione Excel POISSON(k;µ;FALSE) e, per la probabilità cumulata, POISSON(k;µ;TRUE). P Poisson 7

4

Il valore atteso e la varianza della variabile di Poisson sono difficili da calcolare e sono entrambi uguali a µ. La mediana dipende molto dal parametro µ e non esiste una formula generale, e addirittura in alcuni casi non esiste. Versione 2.0 (10‐dic‐10) Pag. 7 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti 2 Variabili aleatorie continue La variabile aleatoria continua, detta anche distribuzione, è un’estensione della variabile aleatoria discreta nel caso in cui i valori oltre ad essere infiniti sono anche densi, cioè comprendano interi intervalli di numeri non necessariamente interi. La variabili aleatorie continue sono definite tramite una funzione di densità f(x) che ha le seguenti proprietà: 1. f(x) ≥ 0 2.

d

1 3. P

d Quindi, prendendo una funzione f(x) sempre positiva, come da richiesta 1 f(x)

d

la proprietà 3 di pagina 8 ci dice che la probabilità di ottenere un valore compreso da 1 e 3 è l’area sotto questa curva compresa tra 1 e 3, dato che l’integrale rappresenta l’area sotto la curva. La proprietà 2 inoltre ci garantisce che prendendo tutti i possibili valori tra –∞ e +∞ la probabilità è esattamente uguale a 100%, come deve intuitivamente essere. Facendo un’analogia con le variabili aleatorie discrete, la proprietà 1 coincide con la 1 di pagina 2 (ogni probabilità deve essere compresa tra 0 e 1), mentre la 2 è l’analogo della proprietà 2 di pagina 2 (la somma delle probabilità deve essere 1). Qualora desiderassimo calcolare la probabilità che la variabile aleatoria continua assuma esattamente un singolo valore c, in virtù della proprietà 3 tale probabilità sarebbe P

d

0 che è nullo dato che è l’integrale di una zona con base di lunghezza 0. Quindi per le variabili aleatorie continue non ha senso parlare di un singolo valore, dato che i valori possibili sono così tanti che la probabilità che esca un singolo valore predeterminato è nulla. Viceversa, parleremo sempre di probabilità di intervalli. Ad esempio, considerando la seguente funzione 0

0

0

0

√3 √3

è facile dimostrare che è una funzione di densità. Difatti la funzione è 0 fuori dall’intervallo [0; √3 mentre è sempre positiva all’interno e quindi la proprietà 1 è soddisfatta. Inoltre l’integrale tra –∞ e +∞ si riduce all’integrale tra 0 e √3 essendo la funzione nulla al di fuori dell’intervallo. Quindi Versione 2.0 (10‐dic‐10) Pag. 8 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti √

√

d

√3

3

3

0

1 f(x)

2,5

2

1,5

1

0,5

0

‐0,5

0

0,5

1

1,5

2

2.1 Misure di centralità e dispersione 2.1.1

Valore atteso Il valore atteso di una variabile aleatoria continua X è dato dalla formula E

·

d Esattamente come per le variabili aleatorie discrete esso indica un punto, che non è necessariamente un valore, che si trova al centro della distribuzione di valori e di probabilità. Nell’esempio precedente, E

2.1.2

·

√

d

·

√

√

d

d

√3

4

4

0

3

4

1,0817 Mediana La mediana di una variabile aleatoria continua X è definita esattamente come la mediana di una variabile aleatoria discreta: quel valore per cui metà della probabilità sta a sinistra e metà a destra, cioè mediana

d 50% e d 50% mediana

Nell’esempio precedente, mediana

mediana

mediana

d

d

3

mediana

3

0

mediana

3

0,50 e, risolvendo l’equazione, otteniamo mediana

2.1.3

1,50 mediana

1,5

1,1447 Varianza La varianza di una variabile aleatoria continua X è data dalla formula Var

Versione 2.0 (10‐dic‐10) E

·

d Pag. 9 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti Esattamente come per le variabili aleatorie discrete esso ci dà un’idea di quanto dispersi siano i valori di X e anch’essa richiede la conoscenza del valore atteso per poter essere calcolata. Nell’esempio precedente, Var

·

1,0817

√

√

d

1,0817

·

1,0817

√

d

2,1634

1,248

4

2,3401

1,170075

1,170075

d

2,1634

√

5

·

1,170075

√3

5

3

2,1634

d

√3

4

1,170075

√3

3

0

0,077975 Anche per le variabili aleatorie continue la deviazione standard è definita come la radice quadrata della varianza. 2.2 Uniforme La variabile aleatoria uniforme è l’analogo continuo del lancio di un dado. Essa è definita dalla funzione di densità 0

1

0

f(x)

1

a

b

dove a e b sono due parametri, che possono assumere qualunque valore purché a<b. Il valore atteso della distribuzione uniforme è facile da calcolare, dato che la sua densità E U

;

·

d

·

1

è costante: 1

d

2

2

2

2

Il valore atteso della distribuzione uniforme è quindi il punto di mezzo tra i due valori estremi. La varianza Versione 2.0 (10‐dic‐10) Pag. 10 di 25 Variabili aleatorie e test statistici Var U

;

·

2

Prof. Paolo Coletti d

·

2

1

·

2

1

d

1

d

3

1

2

2

2

3

3

3

3

2

2

2

4

4

1

1

2

1

3

1

2

1

2

2

1

4

2

4

4

2

4

4

2

4

4

3

1

12

4

12

2

12

12

Notiamo che la varianza è sempre positiva in quanto a<b e ovviamente aumenta quando a e b sono molto distanti. La mediana invece è chiaramente , valore che divide l’area sotto f(x) in due parti perfettamente uguali ognuna pari a 0,5. In generale, per tutte le variabili aleatorie continue simmetriche la mediana coincide con il valore atteso. 2.3 Esponenziale La variabile aleatoria esponenziale è l’analogo continuo della variabile aleatoria di Poisson. Essa è definita dalla funzione di densità 0

0

0

f(x)

λ dove λ è un parametro che può assumere qualunque valore positivo. Versione 2.0 (10‐dic‐10) Pag. 11 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti Il valore atteso2 è varianza3 della distribuzione esponenziale sono più complessi da calcolare e sono pari a 1/λ e 1/λ2. 2.4 Normale La distribuzione normale, detta anche gaussiana, è l’analogo continuo della binomiale. Essa è definita dalla funzione di densità 1

√2

f(x)

σ

µ

dove µ è un parametro che può assumere qualunque valore e rappresenta il punto di massimo della funzione di densità, mentre σ2 è un altro parametro che può assumere qualunque valore positivo e la sua radice quadrata rappresenta quanto larga è la distribuzione. Quindi mentre µ indica dove è posizionata la distribuzione sull’asse dei valori x, σ2 ci indica quanto larga è la distribuzione. Chiaramente, dovendo essere l’intera area sotto la curva sempre uguale a 1, se σ2 è grande sarà larga ma schiacciata, mentre se σ2 è piccolo sarà stretta ma molto più alta. 2

E (esponenziale(λ )) =

+∞

+∞

+∞

+∞

+∞

per parti ⎡

e − λx ⎤

e − λx

−λx

− λx

xf

(

x

)

d

x

x

e

d

x

x

e

d

x

x

−

λ

λ

λ

λ

=

=

=

⎢ −λ ⎥

∫−∞

∫0

∫0

∫0 − λ dx =

⎦0

⎣

+∞

+∞

⎛ lim

⎡ e − λx ⎤

e − λx

e −λ 0 ⎞

1⎞ 1

⎛

⎟⎟ + ∫ e −λx dx = λ (0 − 0 ) + ⎢

= λ ⎜⎜

x

−0

⎥ = 0 + ⎜0 + λ ⎟ = λ λ

λ

λ

x

→

+∞

−

−

−

⎝

⎠

⎝

⎠ 0

⎣

⎦0

3

Var(esponenziale(λ ) ) =

per parti

= λ ⎡(x − λ1 )

⎢⎣

per parti

=

=

1

λ2

2 e − λx

−λ

+∞

+∞

+∞

+∞

−∞

0

0

2

2

2 − λx

−λs

∫ (x − λ1 ) f ( x)ds = ∫ (x − λ1 ) λe dx = λ ∫ (x − λ1 ) e dx =

+∞

⎤ − λ 2(x − 1 ) e−λx dx = λ ⎛⎜ lim (x − 1 )2

λ −λ

λ

∫0

⎥⎦ 0

⎝ x→+∞

e − λx

e0

−

−λ

−λ3

+∞

+∞

⎡(x − 1 ) e−λx ⎤ − 2 e−λx dx = 1 + 2⎛⎜ lim (x − 1 ) e−λx

2

+

λ −λ ⎥

λ −λ

∫0 −λ

⎢⎣

⎦0

λ2

λ2 ⎝ x→+∞

1

+2

1

λ2

−

+∞

⎞⎟ + 2 (x − 1 )e −λs dx =

∫0 λ

⎠

+∞

⎞⎟ + 2 e −λx dx =

−λ2 ⎠

λ ∫0

e0

+∞

+

2 ⎡ e -λx ⎤

3

2

1

= 2− 2 = 2 ⎢

⎥

λ ⎣ - λ ⎦0

λ λ λ

Versione 2.0 (10‐dic‐10) Pag. 12 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti f(x)

f(x)

1

0,2

0,8

0,6

0,4

0,2

0

‐3

‐2

‐1

0

0

1

2

3

4

Distribuzione normale con µ=1 e σ2=2. ‐3

5

‐2

‐1

0

1

2

3

4

5

Distribuzione normale con µ=1 e σ2=0,4. Il valore atteso è varianza della distribuzione esponenziale sono molto complicati da calcolare e sono proprio uguali a µ e σ2. Essendo la distribuzione perfettamente simmetrica, la mediana coincide con il valore atteso µ. Per calcolare i valori della funzione di densità esiste in Excel la funzione NORMDIST(x;µ;σ2;FALSE), mentre per conoscere i valori dell’area tra –∞ e x, dato che l’integrale è impossibile da calcolare analiticamente, c’è la funzione NORMDIST(x;µ;σ2;TRUE). Ad esempio, se dobbiamo calcolare la probabilità di ottenere da una distribuzione normale con µ=2 e σ2=3 un valore inferiore a 1, P(N(2;3)<1) = area sotto f(x) tra –∞ e 1 = NORMDIST(1;2;3;TRUE) ≈ 36,9441%. Se invece vogliamo calcolare la probabilità di ottenere, dalla medesima distribuzione, un valore compreso tra 4 e 7, P(4<N(2;3)<7) = area sotto f(x) tra 4 e 7 = (area sotto f(x) tra –∞ e 7) – (area sotto f(x) tra –∞ e 4) = = NORMDIST(7;2;3;TRUE) – NORMDIST(4;2;3;TRUE) ≈ 95,221% – 74,751% = 20,47% La distribuzione normale è la più importante distribuzione in statistica in quanto in natura moltissime variabili aleatorie seguono questa distribuzione. In particolare, quando si effettua una misura il valore ottenuto è una variabile aleatoria con µ pari al valore vero della misura e σ2 che dipende da quanto preciso è lo strumento di misura: strumenti molto precisi hanno σ2 molto piccolo e quindi tutti i valori misurati saranno vicini al valore vero µ, mentre strumenti grossolani hanno σ2 grande e quindi i valori misurati sono molto sparpagliati anche abbastanza lontano da µ. 3 Teorema del limite centrale Il teorema del limite centrale dice che la media di N variabili aleatorie identiche e indipendenti si distribuisce, al crescere di N, approssimativamente secondo una distribuzione normale con µ pari al valore atteso delle variabili aleatorie (che è lo stesso dato che sono identiche) e σ2 pari alla varianza delle variabili aleatorie divisa per N. Ad esempio, prendendo come variabile aleatoria il lancio di un dado a 6 facce, otteniamo per N=1, 2, 3, 4,5 le seguenti distribuzioni di probabilità: Versione 2.0 (10‐dic‐10) Pag. 13 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti lancio di 1 dado

media del lancio di 2 dadi

20%

20%

15%

15%

10%

10%

5%

5%

0%

0%

1

2

3

4

5

6

1 1,5 2 2,5 3 3,5 4 4,5 5 5,5 6

media del lancio di 3 dadi

media del lancio di 4 dadi

14%

12%

10%

8%

6%

4%

2%

0%

12%

10%

8%

6%

4%

2%

0%

normale con µ=3,5 e σ2=2,917/5

media del lancio di 5 dadi

10%

8%

6%

4%

2%

1,00

1,400

1,800

2,200

2,600

3,00

3,400

3,800

4,200

4,600

5,00

5,400

5,800

0%

1

2

3

4

5

6

Come possiamo vedere già con N=5 la distribuzione somiglia molto ad una normale con µ=3,5 che è esattamente il valore atteso del lancio di un dado. L’approssimazione con una normale pertanto migliora tanto più N aumenta; se la distribuzione di partenza è abbastanza regolare già con N=10 l’approssimazione è molto buona, mentre per distribuzioni irregolari è opportuno aspettare almeno fino a N=30 per avere una buona approssimazione normale. Versione 2.0 (10‐dic‐10) Pag. 14 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti normale con µ=3,5 e σ2=2,917/10

1

2

3

4

normale con µ=3,5 e σ2=2,917/50

5

1

6

2

3

4

5

6

La varianza, che misura la larghezza della distribuzione, diminuisce sempre di più in quanto è approssimativamente pari a 2,917/ . Se consideriamo la seguente variabile aleatoria – / √

, notiamo che è esattamente la media considerata prima ma a cui abbiamo sottratto il proprio valore atteso e divisa per la propria deviazione standard / √ . Pertanto anch’essa si distribuisce normalmente, ma stavolta con parametri µ=0 e σ2=1. 4 4 Campionamento Una ricerca statistica può analizzare i dati di una popolazione o di un campione. La popolazione è l’insieme di tutti gli oggetti per i quali vogliamo ricavare relazioni tra le variabili analizzate. In questo caso i dati sono completi e la ricerca statistica si limita a descrivere la situazione senza porsi nessun altro obiettivo e senza necessitare di test statistici. Se invece i dati sono disponibili solo su un campione, un sottoinsieme della popolazione, allora la statistica si pone il problema di chiedersi se le relazioni individuate sul campione siano estensibili a tutta la popolazione oppure se queste relazioni siano presenti solo per una scelta particolare dal campione. Pertanto la scelta del campione riveste nelle ricerche statistiche un’importanza notevole. Molte tecniche statistiche permettono di estendere i risultati ottenuti sul campione a tutta la popolazione a patto che il campione sia un campione casuale, cioè un campione i cui membri siano estratti dalla popolazione completamente a caso senza alcuna scelta arbitraria. Lavorare con un campione del genere purtroppo presenta notevoli problemi, dato che non sempre è facile effettuare una selezione perfettamente casuale. 4

Possiamo dimostrare facilmente che il nuovo valore atteso, che per una distribuzione normale corrisponde al parametro µ, è 0 utilizzando le proprietà del valore atteso 2, E(c⋅X)=c⋅E(X), e 4, E(X+c)=E(X)+c, di pagina 4: E

– E

– / √

E

– / √

– / √

/ √

0. Possiamo anche dimostrare nello stesso modo che la varianza, che per una distribuzione normale corrisponde al parametro σ2, è 1 usando le proprietà della varianza 2, Var(c⋅X)=c2⋅Var(X), e 4, Var(X+c)=Var(X), di pagina 5: Var

– V

/ √

Versione 2.0 (10‐dic‐10) – V

/ / / / 1. Pag. 15 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti Una strategia molto usata per costruire un campione che si comporta come un campione casuale è il campionamento stratificato. In questo campionamento il campione viene scelto in modo da rispettare le proporzioni di alcune variabili significative nella popolazione; ad esempio, se vogliamo analizzare una popolazione di alberi avremmo cura di selezionare un campione di alberi che riflettano la distribuzione di altezza, d’età, d’illuminazione e di caratteristiche del terreno che sono presenti nell’intera popolazione di alberi. In questo modo il campione rispecchia perfettamente la popolazione, per lo meno per quanto riguarda le variabili prese in considerazione. Ovviamente queste variabili vanno scelte con cura, bilanciando il loro numero dato che un numero troppo basso non crea un campione ben stratificato mentre un numero di variabili eccessivo rende molto difficile creare il campione. Un altro aspetto del campionamento riguarda il numero di soggetti da inserire nel campione. Ovviamente più grande è il campione e meglio riuscirà a descrivere la popolazione, tenendo però in considerazione che è sempre preferibile una buona qualità tramite una scelta casuale oppure una stratificazione ben fatta, ad una grande quantità. 5 Intervallo di confidenza Consideriamo una variabile aleatoria della quale però ignoriamo la distribuzione e abbiamo a disposizione soltanto un campione casuale di dati. Vogliamo stimare il valore atteso, cioè trovare un valore che si avvicina al valore atteso esatto. Per fare ciò utilizziamo ovviamente la media aritmetica dei dati che abbiamo a disposizione dato che è l’oggetto che più naturalmente si avvicina al valore atteso. Quindi se i nostri dati sono: 7, 8, 9, 9, 9, 10, 11, 15, 15, 16, la nostra stima del valore atteso è 10,9. Su quanto sia attendibile questa stima al momento però non abbiamo alcuna informazione, considerando soprattutto che con pochi dati potrebbe il valore atteso della popolazione potrebbe essere molto diverso. Introduciamo quindi il concetto di intervallo di confidenza, che è un intervallo, centrato sulla nostra stima, all’interno del quale il valore atteso si trova con una certa probabilità. Purtroppo è impossibile ottenere un intervallo all’interno del quale il valore atteso si trova con certezza, e quindi ad ogni intervallo di confidenza associamo la probabilità che il valore atteso si trovi effettivamente all’interno. Solitamente la probabilità che si utilizza è del 90%, 95% o del 99%. Supponiamo a questo punto che la popolazione di partenza sia distribuita normalmente (perché, ad esempio, si tratta di una misura naturale o di qualche altro fenomeno che sappiamo essere distribuito normalmente) o che i nostri dati siano in numero sufficientemente grande5 da poter applicare il teorema del limite centrale e sostenere che la media aritmetica dei dati sia distribuita normalmente. Pertanto possiamo utilizzare il teorema del limite centrale (capitolo 3 a pagina 13) e sapere che – 90% 5% ‐3

‐2

‐1

0

2

si distribuisce come una normale N(0;1). 5%

1

/ √

A questo punto andiamo a guardare l’area che copre il 90% centrale della distribuzione, usando la funzione Excel NORMINV(5%;0;1) e 3

5

Una buona regola empirica ci suggerisce almeno 30 dati. Versione 2.0 (10‐dic‐10) Pag. 16 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti NORMINV(95%;0;1), e troviamo i valore di –1,64 e +1,64 come estremi. Pertanto possiamo affermare che: P

P

media – valore atteso

1,64

1,64 · deviazione standard

deviazione standard⁄ √

media – valore atteso

√

1,64 · deviazione standard

P media 1,64

90% 1,64 · deviazione standard

√

1,64 · deviazione standard

90% valore atteso media

90% √

√

Abbiamo quindi ottenuto l’intervallo di confidenza al 90% per il valore atteso che è media

,

·

√

; media ,

·

√

. All’interno di questo intervallo al 90% si troverà il valore esatto del valore atteso. Se vogliamo ottenere l’intervallo di confidenza al 95% e al 99% basta studiare l’area che copre il 95% o il 99% e trovare di conseguenza, al posto di 1,64, i numeri 1,96 e 2,58. Per calcolare questi intervallo di confidenza come si può notare abbiamo bisogno della deviazione standard. Qualora anch’essa non sia nota possiamo stimare anch’essa usando la deviazione standard del campione media . Chiaramente a questo punto il ragionamento precedente non vale più6 ma si può dimostrare che per un campione sufficientemente grande l’intervallo di confidenza resta quello indicato precedentemente. 6 Test di verifica d’ipotesi I test di verifica d’ipotesi, chiamati anche test statistici, sono degli strumenti della statistica inferenziale per verificare con quale probabilità i risultati ottenuti sul campione possono essere estesi a tutta la popolazione. Le caratteristiche di ogni test di verifica d’ipotesi sono: •

un campione, su cui abbiamo i dati, e una popolazione, su cui vogliamo estendere i risultati ricavati dai dati; •

l’ipotesi nulla e la sua contraddittoria ipotesi alternativa; •

i requisiti, condizioni necessarie affinché il test funzioni. Tra i requisiti c’è sempre, anche se non lo indicheremo mai, che i dati provengano da un campione casuale o quantomeno di un campione ben stratificato per quanto riguarda tutte le variabili che possono influenzare il risultato; •

la funzione calcolata sui dati, detta semplicemente statistica, il cui valore è il risultato del test; •

tramite la statistica otteniamo la significatività del test (detta anche p‐value), in base alla quale potremmo decidere se accettare o rifiutare l’ipotesi nulla. Nei programmi di statistica la significatività appare automaticamente durante il calcolo della statistica. 6

Infatti a questo punto invece della distribuzione normale dovremmo, finché il campione è piccolo, utilizzare una distribuzione t di Student, come vedremo nel paragrafo 7.1 a pagina 21. Versione 2.0 (10‐dic‐10) Pag. 17 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti 6.1 Esempio Per illustrare tutti gli elementi di un test di verifica di ipotesi utilizziamo un esempio molto semplice e in seguito spiegheremo ed analizzeremo, uno ad uno, i passi effettuati. Supponiamo di voler stimare il diametro medio delle mele prodotte dal nostro campo. Formuliamo innanzitutto l’ipotesi che la media sia 70 mm e l’ipotesi alternativa è che la media sia diversa da 70 mm. Scriviamo queste ipotesi come - H0: media = 70 - H1: media ≠ 70 A questo punto prendiamo un campione casuale di 100 mele7. Calcoliamo la media di queste 100 mele e otteniamo 72,4. Confrontiamo questo risultato con il 70 ipotizzato e vediamo che scarta di +2,4. A questo punto ci chiediamo se la differenza di +2,4 sia dovuta semplicemente ad una fluttuazione casuale per una scelta poco fortunata del campione oppure sia dovuta al fatto che la media del diametro delle mele della popolazione non è 70 ma presumibilmente di più. Ovviamente non prendiamo una decisione basandoci su una stima personale, ma ricorriamo in modo più scientifico ad un test di verifica di ipotesi. Prendiamo in considerazione come statistica questa funzione: media del campione − media ipotizzata

deviazione standard del campione / n

dove la media ipotizzata è evidentemente 70 e n è 100. È importante vedere cosa succede al variare dell’osservazione sul campione: se troviamo un valore per la media sul campione di esattamente 70 la statistica sarà nulla. Pertanto un valore nullo della statistica è da considerarsi un’ottima conferma della nostra ipotesi. Viceversa, se la media calcolata sul campione è molto più grande di 70, pessimo segnale per la nostra ipotesi H0, la statistica viene largamente positiva. Anche se la media campionaria è molto più piccola di 70, altro pessimo segnale per la nostra ipotesi H0, la statistica viene largamente negativa. Quindi, considerando che nel nostro caso la deviazione standard è 17,13 e quindi la statistica è +1,40, possiamo riassumere la situazione con un grafico: H0 probabilmente falsa

H0 probabilmente vera

0 H0 probabilmente falsa

+1,40

A seconda di quanto il valore della statistica si discosta dallo 0 l’ipotesi H0 sarà confermata dai dati o smentita. A questo punto resta sempre la domanda se +1,40 sia un valore troppo grande o troppo piccolo. Per scoprirlo, cerchiamo di calcolare quale sia la probabilità di ottenere un risultato ancora peggiore8 di quello ottenuto, cioè un risultato superiore a 1,4 oppure inferiore a –1,4. Sfruttiamo il teorema del limite centrale che ci garantisce che, se n è abbastanza grande, la nostra statistica si distribuisce con una 7

I dati che utilizziamo sono: 50; 52; 54; 56; 58; 60; 62; 60; 66; 68; 70; 72; 74; 76; 60; 60; 82; 84; 86; 88; 90; 92; 94; 96; 98; 100; 102; 104; 40; 108; 110; 112; 114; 40; 40; 40; 60; 62; 64; 66; 68; 70; 72; 74; 76; 78; 80; 82; 84; 86; 88; 90; 92; 94; 96; 98; 100; 40; 42; 44; 46; 48; 50; 52; 54; 56; 58; 60; 62; 64; 66; 68; 70; 72; 74; 76; 78; 80; 70; 72; 74; 70; 72; 74; 70; 72; 74; 70; 72; 74; 70; 72; 74; 70; 72; 74; 70; 72; 74; 70. 8

Con il termine “peggiore” intendiamo peggiore per la conferma di H0, quindi più lontano dallo 0. Versione 2.0 (10‐dic‐10) Pag. 18 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti distribuzione normale con µ=0 e σ2=1 e quindi riusciamo a calcolare la probabilità di ottenere valori inferiori a –1,4 o superiori a +1,4. Questa probabilità è chiamata significatività o p‐value, ed è indicata in figura. ‐3

‐2

‐1,4

‐1

0

1

+1,4

2

3

Qualora questa significatività risulti alta, vuol dire che, prendendo un altro campione, possiamo ottenere per caso un valore ben peggiore di quello ottenuto e quindi che il valore ottenuto può essere considerato vicino a 0, cosa che propende a favore dell’ipotesi nulla. Se invece questa significatività fosse bassa, significa che, prendendo un altro campione, possiamo ottenere per caso un risultato simile o peggiore solo in pochissimi casi e che quindi il nostro risultato è effettivamente molto distante da 0, cosa che propende a favore dell’ipotesi alternativa. In questo caso la significatività è del 16%9, che viene considerata un valore grande dato che la soglia scelta nelle ricerche statistiche è tipicamente del 5%. 6.2 Ipotesi nulla e ipotesi alternativa Il cuore di un test statistico è l’ipotesi nulla H0, che rappresenta l’informazione che vogliamo cercare di estendere dal campione alla popolazione. È importante che l’ipotesi nulla ci fornisca delle precise informazioni aggiuntive, perché queste informazioni vengono successivamente utilizzate dalla statistica per poter essere calcolata sui dati del campione. Ipotesi nulle formulate in versione negativa solitamente invece non forniscono informazioni utilizzabili. Ad esempio, ipotesi nulle accettabili sono “media = 70” oppure “distribuzione è uniforme” o ancora “le due variabili sono indipendenti”. Al contrario, non sono accettabili le ipotesi “media ≠ 35” oppure “distribuzione non è uniforme” dato che queste ipotesi non ci stanno dicendo nulla di utilizzabile. Anche l’ipotesi “le due variabili sono indipendenti” ci fornisce un’informazione facilmente utilizzabile per la successiva statistica, mentre “le due variabili sono dipendenti” non ci fornisce informazioni in quanto non ci dice come sono dipendenti. Nel test di esempio precedente, formulando l’ipotesi nulla “media = 70” siamo poi riusciti a calcolare la differenza tra la media osservata di 72,4 e quella ipotizzata di 70. Se invece avessimo formulato un’ipotesi “media ≠ 70” non avremmo potuto concludere nulla con il 72,4 osservato perché non avremmo saputo con che valore confrontarlo. 9

Può essere calcolata, ad esempio, usando la funzione di Microsoft Excel inglese NORMDIST(‐1,4;0;1;TRUE) che fornisce l’area della zona a sinistra pari all’8%. L’area della zona a destra è ovviamente identica. Versione 2.0 (10‐dic‐10) Pag. 19 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti Accanto all’ipotesi nulla si scrive l’ipotesi alternativa H1, che è il contrario logico dell’ipotesi nulla e, ovviamente, è di tipo negativo. È anche possibile formulare un’ipotesi nulla del tipo “media ≤ 70” con ipotesi alternativa “media > 70”, ed in questo caso il test si chiama test ad una coda perché, pur essendo svolto in modo identico, durante il calcolo della significatività nella distribuzione della statistica si considera solamente una coda. 6.3 Significatività La probabilità di ottenere, sotto l’ipotesi che H0 sia vera, estraendo un altro campione casuale, un risultato uguale o peggiore10 è chiamata significatività oppure p‐value. Questa si calcola calcolando il valore della statistica sui dati e calcolando le aree esterne, quelle lontane dallo 0, della distribuzione della statistica. Utilizzando un programma statistico la significatività viene fornita direttamente dal programma stesso. Chiaramente una significatività alta mostra che, quando H0 è vera, è molto probabile ottenere un valore così distante da 0 e quindi accetteremo l’ipotesi nulla; viceversa una significatività bassa mostra che, anche se H0 fosse vera, sarebbe difficile ottenere un risultato così lontano da 0 e quindi rifiuteremo l’ipotesi nulla. 6.4 Accettare e rifiutare Giunti alla fine del test statistico, si osserva se la significatività è sopra o sotto una soglia decisa dal ricercatore: •

se la significatività è sopra la soglia, l’ipotesi nulla viene accettata; •

se la significatività è sotto la soglia, l’ipotesi nulla viene rifiutata. Il valore numerico di questa soglia dipende solitamente dall’ambito scientifico in cui si sta effettuando la ricerca e varia da 1% a 10%. Nel resto di questa dispensa useremo il valore tipico del 5%. La scelta di una soglia così bassa fa sì che accettare l’ipotesi nulla non significa che essa sia vera. Difatti, accettare l’ipotesi nulla vuol semplicemente dire che un valore così distante da 0 può essere considerato possibile. Viceversa, rifiutare un’ipotesi nulla con una soglia del 5% significa che molto probabilmente essa è effettivamente falsa. Altro effetto da sottolineare è legato alla numerosità del campione. Quando i dati sono pochissimi è abbastanza probabile ottenere qualunque valore della statistica e quindi otterremo spesso significatività molto alte e saremo portati ad accettare molto di più. Quindi, soprattutto nei casi con pochi dati, accettare l’ipotesi nulla significa semplicemente che non abbiamo abbastanza dati per smentirla. 6.5 Requisito di normalità Tra i requisiti del test figura spesso la richiesta che i dati siano distribuiti normalmente. Per verificarlo, solitamente disponiamo di vari metodi: •

se i dati non sono misure singole ma ottenute tramite media di molti altri dati, allora il teorema del limite centrale ci garantisce che sono distribuiti normalmente; •

se i dati provengono da misure di fenomeni naturali, molto spesso sono distribuiti normalmente; •

se l’istogramma dei dati del campione presenta una forma normale, possiamo ipotizzare che anche la popolazione da cui provengono i dati sia distribuita normalmente; 10

Con il termine “peggiore” intendiamo peggiore per la conferma di H0. Versione 2.0 (10‐dic‐10) Pag. 20 di 25 Variabili aleatorie e test statistici •

Prof. Paolo Coletti esistono test statistici specifici (ad esempio il test Kolmogorov‐Smirnov) che permettono di dedurre, osservando i dati del campione, se i dati della popolazione sono distribuiti normalmente. 7 Test 7.1 t di Student per una media H0: media = m Statistica: media del campione − m

deviazione standard del campione / N

Distribuzione: la statistica si distribuisce secondo la distribuzione t di Student con N‐1 gradi di libertà.11 William “Student” Gosset

(1886‐1937) Ad esempio, vogliamo verificare se la media d’età di una popolazione è uguale o superiore a 32 prendendo un campione di 10 soggetti con valori 25; 26; 27; 28; 29; 30; 31; 30; 33; 34. - H0: media = 32 - H1: media ≠ 32 La media del campione è 29,3 e la deviazione standard 2,91. La statistica quindi vale –2,94. La significatività viene dell’1,7%12 e quindi H0 è rifiutata13, pertanto possiamo affermare che la media non è 32. Come si può facilmente notare confrontando questo paragrafo con il capitolo 5 a pagina 16, il test t di Student per una media coincide in tutto e per tutto con l’intervallo di confidenza della media. Difatti, quando i gradi di libertà sono grandi, la distribuzione t di Student diventa proprio la distribuzione normale. 7.2 t di Student per due medie Requisiti: due popolazioni A e B, la variabile è distribuita normalmente sulle popolazioni H0: media della popolazione A = media della popolazione B Statistica: . Questa statistica vale 0 se le medie dei due media campione A − media campione B

(N A − 1) varianza A

+ (N B − 1) varianza B ⎛ 1

⎞

+ 1 ⎟

⎜

N

N

N −2

A

B

⎝

⎠

campioni A e B sono uguali. Distribuzione: la statistica si distribuisce come una distribuzione t di Student con N‐2 gradi di libertà. 11

Come abbiamo visto in precedenza, nel caso di N molto grande si distribuisce come una distribuzione normale con µ=0 e σ2=1. 12

La significatività può essere calcolata: • dopo aver calcolato la statistica usando la funzione di Microsoft Excel inglese TDIST(2,94;9;2) che fornisce la somma delle aree delle due code a sinistra di ‐2,94 e a destra di +2,94. Attenzione: per questo test, la funzione TTEST non può essere utilizzata. 13

Questo 1,7% significa che estraendo 10 dati a caso da una distribuzione normale con media pari a 32, abbiamo solo l’1% di possibilità di trovare dei dati peggiori. Versione 2.0 (10‐dic‐10) Pag. 21 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti Ad esempio, vogliamo verificare - H0: media altezza maschi = media altezza femmine - H1: media altezza maschi ≠ media altezza femmine Prendiamo un campione di 10 maschi (180; 175; 160; 180; 175; 165; 185; 180; 185; 190) e 8 femmine (170; 175; 160; 160; 175; 165; 165; 180). Supponiamo che la distribuzione dell’altezza di maschi e femmine sia una distribuzione normale con la medesima varianza. La media dei maschi del campione è 177,5 e quella delle femmine è 168,75. Il valore della statistica è +2,18 a cui corrisponde una significatività del 4,4% e quindi rifiutiamo14. 7.3 Analisi della varianza (ANOVA) monofattoriale Requisiti: tre o più popolazioni, la variabile è distribuita normalmente sulle popolazioni H0: la media di tutte le popolazioni è uguale Statistica: una funzione che è 0 quando le medie campionarie sono tutte uguali. Distribuzione: la statistica si distribuisce secondo la distribuzione F di Fisher con primo gradi di libertà pari a numero di popolazioni –1 e secondo grado di libertà pari a N – numero di popolazioni. Questa distribuzione ha solo valori positivi, quindi la coda da considerare è sempre a destra. Ad esempio, supponiamo di avere altezze dei giovani (180; 170; 150; 160; 170), degli adulti (170; 160; 165) e degli anziani (155; 160; 160; 165; 175; 165) e vogliamo verificare - H0: media altezza giovani = media altezza adulti = media altezza anziani - H1: almeno una media è diversa dalle altre Analizzando i dati otteniamo una media di 166 per i giovani, 165 per gli adulti e 163,3 per gli anziani. Calcolando la statistica sul nostro campione otteniamo +0,14 che corrisponde ad una significatività15 dell’87% e pertanto accettiamo. Quindi non abbiamo abbastanza dati per sostenere che le tre media siano diverse. L’ANOVA si può anche fare nel caso in cui le categorie siano soltanto 2, ed in questo caso fornisce lo stesso risultato del t‐test per due medie. 14

La significatività può essere calcolata: • usando uno dei test t (Zweistichproben t‐Test) dell’Analisi dei Dati in Excel, scegliendo tra varianze note (in questo caso le varianze delle popolazioni vanno indicate esplicitamente), uguale e non nota, diverse e non nota (in questi ultimi due casi le varianze delle popolazioni vengono stimate, direttamente da Excel, prendendo le varianze del campione), che fornisce direttamente statistica e significatività; • usando la funzione Microsoft Excel TTEST fornisce direttamente la significatività partendo dai dati, scegliendo come type=2 se supponiamo le varianze uguali e type=3 se le supponiamo diverse (in entrambi i casi le varianze delle popolazioni vengono stimate, direttamente da Excel, prendendo le varianze del campione); • calcolando la statistica e usando la funzione di Microsoft Excel inglese TDIST(2,18;16;2) che fornisce la somma delle aree delle due code a sinistra di ‐2,18 e a destra di +2,18. 15

La significatività può essere calcolata: • usando l’ANOVA monofattoriale (ANOVA: Einfaktorielle Varianzanalyse) dell’Analisi dei Dati in Excel che fornisce direttamente la statistica e la significatività partendo dai dati; • calcolando la statistica e usando la funzione di Microsoft Excel inglese FDIST(0,14;2;11) che fornisce l’area della coda a destra di 0,14. Attenzione: per questo test la funzione FTEST non può essere utilizzata. Versione 2.0 (10‐dic‐10) Pag. 22 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti 8 Tabella di contingenza Quando bisogna confrontare due variabili categoriali, per osservare se appartenere ad una categoria di una variabile influenza la categoria dell’altra variabile, ricorriamo alla tabella di contingenza. Questa tabella è ha le categorie di una variabile lungo le righe e quelle dell’altra lungo le colonne e contiene, per ogni incrocio, la frequenza assoluta di soggetti che fanno parte di quelle due categorie. L’ultima riga e l’ultima colonna contengono i totali della riga e della colonna. Ad esempio, prendendo un campione di alberi di un campo e considerando le variabili età (giovane, maturo, vecchio) e malattia (malato, sano), la tabella di contingenza risulta essere così: frequenze giovane maturo vecchio totale

malato 10 20 10 40 sano 40 50 20 110 totale 50 70 30 150 Da questa tabella sembrerebbe, ad un’osservazione superficiale della riga dei malati, che gli alberi giovani malati e vecchi malati siano gli stessi e che questi siano inferiori ai maturi malati. Ma, osservando la riga dei sani, notiamo che gli alberi vecchi sani sono molto meno degli alberi giovani e di quelli adulti. Difatti nella riga del totale vediamo che il basso numero dei vecchi malati è dovuto al basso numero degli alberi vecchi in generale presenti nel campione (30 contro 50 giovani e 70 maturi). Quindi un’osservazione dei numeri presenti in tabella può facilmente ingannare e pertanto solitamente indichiamo anche le percentuali per riga e le percentuali per colonna. percentuali per riga percentuali per colonna giovane maturo vecchio totale

giovane maturo vecchio totale

malato 25% 50% 25% 100% malato

20% 29% 33% 27% sano 36% 45% 19% 100% sano 80% 71% 67% 73% totale 33% 47% 20% totale 100% 100% 100% La scelta di quali percentuali indicare dipende da ciò che vogliamo mostrare. Se vogliamo vedere come la malattia è diffusa per fasce d’età allora utilizzeremo le percentuali per colonna: da questa tabella vediamo che la percentuale di malati sale dal 20% dei giovani al 29% degli alberi maturi fino al 33% dei quelli vecchi e che la percentuale media di malati è 27%. Se invece vogliamo mostrare come sono suddivisi in età gli alberi malati e gli alberi sani, dalla tabella con le percentuali per riga osserviamo che il 25% dei malati sono alberi giovani, il 50% dei malati è maturo e il 25% dei malati è un albero vecchio. Sulla tabella di contingenza a due variabili possiamo verificare se le due variabili sono indipendenti, cioè se la distribuzione della variabile A all’interno delle categorie della variabile B sia la stessa, tenendo ovviamente conto del fatto che le numerosità delle categorie possono non essere la stessa. Tornando al nostro esempio, verifichiamo se la distribuzione della malattia sia uniforme sull’età, tenendo ovviamente conto del fatto che nel nostro campione il numero degli alberi maturi è in totale maggiore di quelli dei vecchi e il numero dei sani è in totale maggiore di quello dei malati. Cioè non verifichiamo se la tabella sia statisticamente simile a questa Versione 2.0 (10‐dic‐10) Pag. 23 di 25 Variabili aleatorie e test statistici Prof. Paolo Coletti giovane maturo vecchio

malato

25 25 25 sano 25 25 25 perché ovviamente non potrà mai esserlo, dato che non abbiamo 50 vecchi nel campione né 75 malati. Bensì verifichiamo se la tabella sia statisticamente simile a giovane maturo vecchio

malato

13,3 18,7 8 sano 36,7 51,3 22 I numeri in questa tabella sono dette frequenze teoriche e sono i valori che dovremmo trovare se la distribuzione per malattia fosse totalmente indipendente da quella per età. Questi valori sono calcolati utilizzando i totali per riga e per colonna con la formula ·

. 8.1 Chi­quadro χ2 di Pearson Requisiti: due variabili categoriali con n e m categorie, frequenze teoriche ≥ 5 H0: le due variabili sono indipendenti ,

Statistica: ,

, che è 0 quando le frequenze teoriche e effettive sono uguali. Distribuzione: la statistica si distribuisce come distribuzione chi‐quadro con (numero di categorie variabile A –1)·(numero di categorie variabile B –1) gradi di libertà. Questa distribuzione ha solo valori positivi, quindi consideriamo solo la coda di destra. Karl Pearson

(1857-1936)

Nell’esempio precedente, volendo verificare -

H0: malattia ed età sono indipendenti H1: malattia ed età sono dipendenti Calcolando la statistica viene 1,95. I gradi di libertà sono 1·2, cioè 2. La significatività16 nel caso di 2 gradi di libertà è 37,8% e quindi accettiamo. 9 Traduzione Diamo in questa tabella la traduzione dei termini più utilizzati nel libro in italiano, tedesco e inglese americano, che è la lingua dalla quale molti termini provengono. Italiano accettare Deutsch beibehalten

English accept 16

La significatività può essere calcolata, una volta costruita la tabella delle frequenze teoriche: • utilizzando la funzione di Microsoft Excel inglese CHITEST, che fornisce direttamente la significatività partendo dai dati e dalla tabella delle frequenze teoriche, che bisogna purtroppo costruire manualmente; • calcolando la statistica e usando la funzione di Microsoft Excel inglese CHIDIST(1,95;2) che fornisce, dopo aver calcolato il valore della statistica, l’area della coda a destra di 1,95. Versione 2.0 (10‐dic‐10) Pag. 24 di 25 Variabili aleatorie e test statistici analisi della varianza campionamento campionamento casuale campionamento stratificato campione campione casuale chi quadro correlazione lineare diagramma a barre diagramma a barre impilato diagramma a scatola / box plot diagramma a torta / diagramma circolare distribuzione distribuzione normale distribuzione uniforme F di Fisher frequenza intervallo di confidenza ipotesi alternativa ipotesi nulla istogramma media media pesata mediana moda p‐value popolazione probabilità quartile regressione lineare regressione logistica regressione multilineare regressione non lineare residuo rifiutare deviazione standard scatter plot / diagramma a dispersione significatività t di Student tabella di contingenza test test del chi quadro variabile dipendente variabile indipendente varianza Varianzanalyse

Auswahlverfahren

Zufallsauswahlverfahren

stratifiziertes Auswahlverfahren

Stichprobe

Zufallsstichprobe

Chi‐Quadrat

Korrelation

Säulendiagramm

gestapeltes Säulendiagramm

Boxplot

Kreisdiagramm

Verteilung

Normalverteilung

Gleichverteilung

Fisher‐F

Häufigkeit

Konfidenzintervall / Vertrauensbereich

Alternativhypothese

Nullhypothese

Histogramm

Mittelwert

gewichtetes Mittel

Zentralwert / Median

Modalwert

p‐Wert

Grundgesamtheit

Wahrscheinlichkeit

Quartil

lineare Regression

logistische Regression

multiple Regression

Residue

ablehnen

Standardabweichung

Streudiagramm

Signifikanz

Studentsche t

Kontingenztafeln

Test

Chi‐Quadrat‐Test

abhängige Variable

unabhängige Variable

Varianz

Prof. Paolo Coletti ANOVA sampling random sampling stratified sampling sample random sample chi square linear correlation bar plot stacked bar plot box plot pie chart distribution normal distribution uniform distribution Fisher’s F frequency confidence interval alternative hypothesis

null hypothesis histogram average / mean weighted average median mode p‐value population probability quartile linear regression logistic regression multilinear regression

non linear regression residual reject standard deviation scatter plot significance Student’s t contingency table / cross table

test

chi square test dependent variable independent variable

variance Versione 2.0 (10‐dic‐10) Pag. 25 di 25