DISEGUAGLIANZA DI CEBICEV (per intervalli simmetrici centrati nella media)

Come è noto la varianza è un indice di dispersione che dice quanto i dati siano concentrati intorno

alla media. Maggiore è la varianza e maggiore sarà l’ampiezza della “campana” che rappresenta la

densità di probabilità (sempre che la curva abbia la forma di una campana, naturalmente!)

Detto più in generale tanto più grande è la varianza, tanto più la curva della densità sarà appiattita.

Un buon modo per valutare quanto è appiattita la curva è quello di misurare l’intervallo centrato

nella media in cui calcolare l’integrale della densità in modo che esso sia pari ad un preciso valore.

Ad esempio possiamo vedere quanto ampio deve essere l’intervallo di integrazione affinchè il suo

valore sia pari a 0.95.

Orbene, tanto più grande è la varianza quanto più ampio dovrà essere tale intervallo.

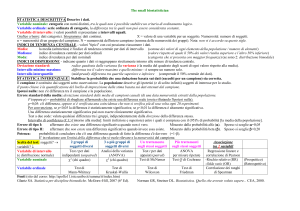

Data una qualsiasi varibile aleatoria, con l’unica richiesta che sia dotata di media e varianza finite, il

teorema di Cebicev fornisce proprio un preciso legame tra varianza, ampiezza dell’intervallo e

probabilità che la v.a. cada in quell’intervallo.

Leggiamo insieme la formula:

P ( X − µ < kσ ) ≥ 1 −

1

2

k

la probabilità che la v.a. disti dalla media per meno di un multiplo k della deviazione standard tende

a 1 col crescere di k.

Per k=1 la formula non ci dice praticamente nulla: che la probabilità (che X cada in un intervallo

simmetrico centrato nella media e di raggio pari alla deviazione standard) sia positiva o al più nulla,

lo sanno tutti.

Ma se k assume valori maggiori di 1 (generalmente si usano i primi interi k=2 e k=3) allora la

formula acquista significatività.

Ad esempio per k=3 scopriamo che una qualsiasi v.a. cade sempre nell’intervallo centrato nella

media di raggio pari al triplo della deviazione standard con probabilità pari o superiore all’89%.

In altri termini non importa che tipo di distribuzione abbiamo davanti al naso. Notevole o meno che

sia, almeno il 90% circa dei valori (e quindi dei dati in caso di campionamento) deve distare dalla

media per meno di 3 volte sigma. (infatti questa proprietà viene detta anche 3-sigma).

Ecco l’importanza della diseguaglianza: se la distribuzione è incognita ma noi ne conosciamo media

e varianza allora possiamo fare delle stime sulla probabilità che la v.a. assuma certi valori a patto

che non siano troppo distanti dalla media.

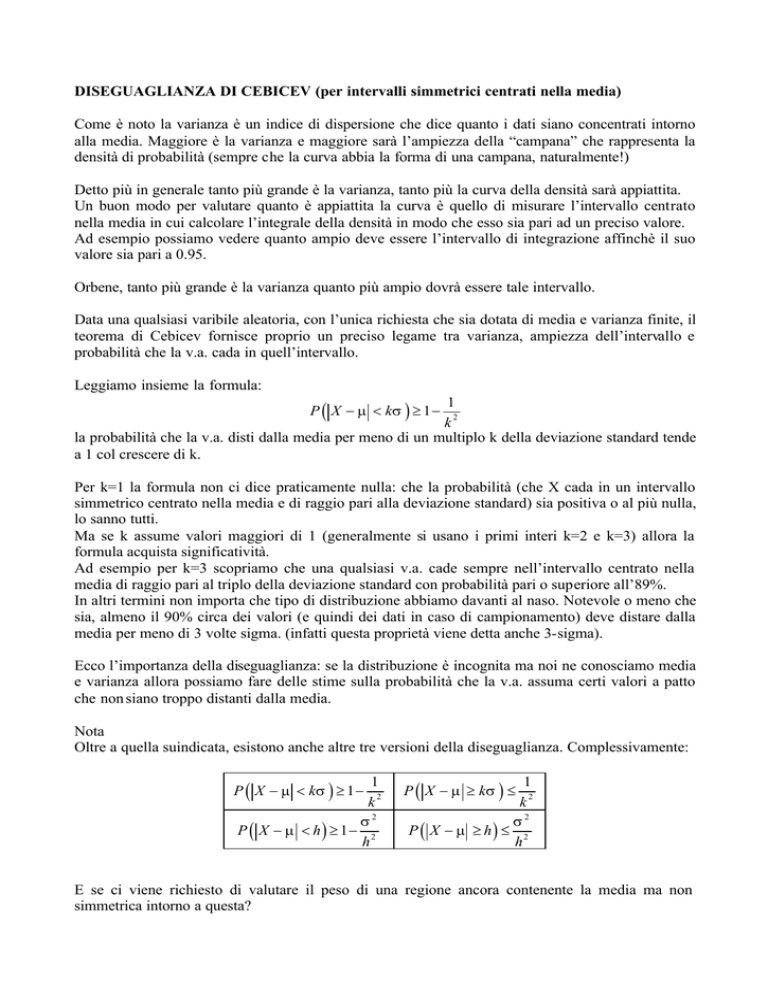

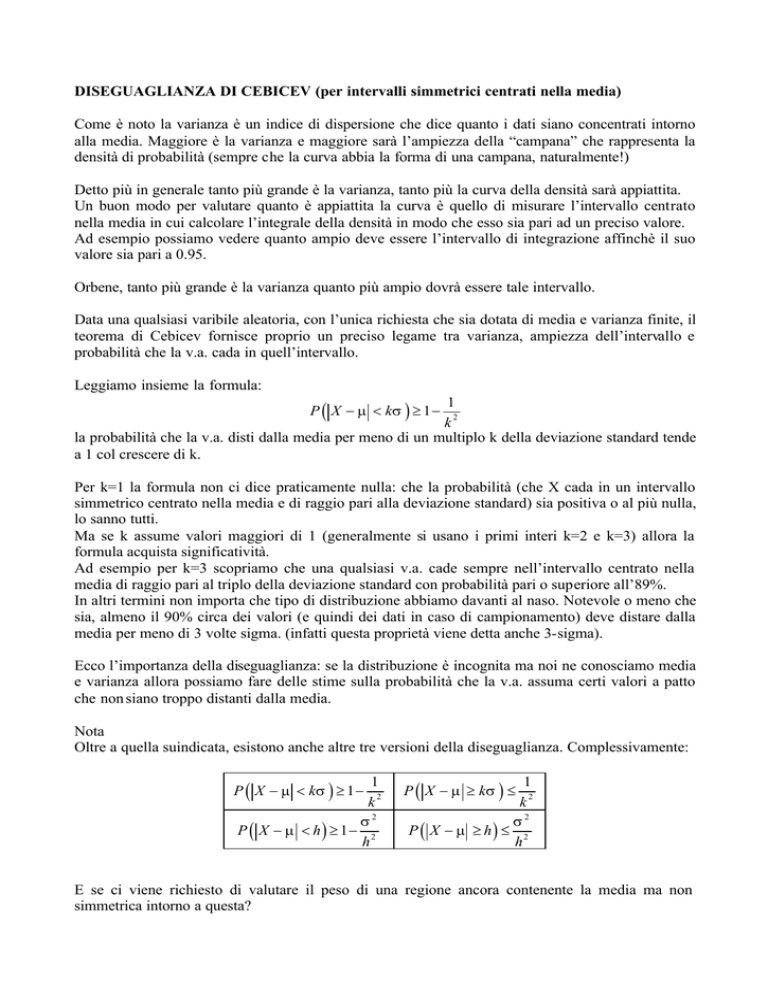

Nota

Oltre a quella suindicata, esistono anche altre tre versioni della diseguaglianza. Complessivamente:

P ( X − µ < kσ ) ≥ 1 −

1

2

k

σ2

P ( X − µ < h) ≥ 1− 2

h

P ( X − µ ≥ kσ ) ≤

1

2

k

σ2

P ( X − µ ≥ h) ≤ 2

h

E se ci viene richiesto di valutare il peso di una regione ancora contenente la media ma non

simmetrica intorno a questa?

DISEGUAGLIANZA DI CEBICEV (per intervalli non simmetrici)

Non avendo altre informazioni a disposizione, la diseguaglianza di Cebicev può ancora venirci in

aiuto e vediamo come.

Supponiamo di dover valutare il peso della regione

( a, b )

µ

b

a

contenente la media. Sia A = ( a, b ) l’intervallo associato a questa

regione. Sia inoltre hˆ = min ( b − µ , µ − a ) il più piccolo tra i due segmenti in cui la media divide

l’intervallo A .

Chiamiamo B = µ − hˆ, µ + hˆ = x ∈ ¡ :| x − µ |< hˆ l’intervallo centrato nella media avente

(

) {

}

semiampiezza ĥ .

Evidentemente, poichè A ⊇ B , avremo che P ( A) ≥ P ( B ) .

Sfruttando la diseguaglianza di Cebicev possiamo quindi concludere che:

σ2

P ( A) ≥ P ( B ) = P | X − µ |< hˆ ≥ 1 − 2

hˆ

arrivando così a dare comunque una limitazione inferiore al peso richiesto.

(

)

Analogamente, se la regione il cui peso dobbiamo valutare è quella esterna all’intervallo ( a, b ) cioè

è A = { x ∈ ¡ : x ∉ ( a , b )} , avremo A ⊆ B e quindi:

(

)

σ

P ( A) ≤ P ( B ) = P | X − µ | ≥ hˆ ≤ 2 .

hˆ

2