CENNI SULLE VARIABILI ALEATORIE ............................................................................................................................. 2

1 INTRODUZIONE ALLA TEORIA DELLE PROBABILITÀ ................................................................................................................... 2

2 APPROFONDIMENTO SULLA TEORIA DELLE PROBABILITÀ ......................................................................................................... 3

2.1 Teorema della probabilità dell’evento complementare ................................................................................................... 3

2.2 Teorema della probabilità totale ..................................................................................................................................... 3

2.3 Fenomeno aleatorio condizionato ................................................................................................................................... 3

2.4 Indipendenza Statistica.................................................................................................................................................... 4

2.5 Teorema di Bayes ............................................................................................................................................................ 4

3 DEFINIZIONE DI VARIABILE ALEATORIA .................................................................................................................................... 5

3.1 Funzione distribuzione..................................................................................................................................................... 5

3.2 Funzione densità di probabilità....................................................................................................................................... 6

4 APPROFONDIMENTI CON ESEMPI SULLE VARIABILI ALEATORIE ................................................................................................. 7

4.1 Variabili aleatorie discrete.............................................................................................................................................. 7

4.2 Variabili aleatorie continue.......................................................................................................................................... 10

1

Cenni sulle variabili aleatorie

1 Introduzione alla teoria delle probabilità

la teoria della probabilità si occupa dei valori medi di fenomeni di massa che avvengono simultaneamente

o successivamente nel tempo: emissioni di elettroni, chiamate telefoniche, rilevamenti radar, controllo

della qualità di un prodotto, guasti in un impianto, meccanica statistica, indici di natalità e di mortalità,

ereditarietà.

Alcuni esempi di fenomeni aleatori di interesse specifico nelle telecomunicazioni sono:

• Errori introdotti dal canale di comunicazione sul messaggio trasmesso,

• Numero e tipo di chiamate simultaneamente attive alla centrale di commutazione,

• Errori di misura negli strumenti di acquisizione.

E’ stato osservato che in questi e altri campi certi valori medi si approssimano a un valore costante,

allorché il numero delle osservazioni aumenta. Per di più, questo valore limite si mantiene invariato,

anche se le medie vengono valutate su una qualunque successione parziale, definita prima che

l’esperimento venga compiuto. Così, se ripetendo più volte il lancio di una moneta, la percentuale degli

esiti “testa” si avvicina al 50% (valore medio), questo stesso valore si otterrebbe se si considerasse, ad

esempio, un lancio ogni quattro.

Un fenomeno aleatorio può essere caratterizzato secondo gli elementi descritti in tabella

Esperimento

Prova

Determinazione

Evento

Descrizione delle modalità di attuazione di un fenomeno

aleatorio

Esecuzione di un esperimento

Valore che può essere assunto da una grandezza fisica a

seguito di una prova

L’evento si verifica se il risultato soddisfa certi requisiti.

La teoria si propone di descrivere e di predire tali valori medi e a questo proposito si associa a un certo

evento la sua probabilità.

Nell’osservazione dei fenomeni aleatori, all’aumentare del numero delle osservazioni alcune grandezze

tendono a valori costanti. Questo consente di definire la probabilità di un evento A tramite il rapporto fra

il numero nA di occorrenze dell’evento e il numero totale n degli esperimenti effettuati:

nA

n→∞ n

Pr ( A) = lim

Pr(A) è un numero reale positivo sempre compreso tra 0 e 1.

Gli eventi aleatori si definiscono in termini di insiemi e sono caratterizzati delle probabilità ad essi

associati. Ad ognuno dei risultati si associa con una corrispondenza biunivoca un punto nell’insieme

(spazio) dei risultati Ω. Dato un evento E ad esso corrisponde l’insieme E dei punti di Ω corrispondenti ai

risultati favorevoli all’evento E. All’evento certo, cui sono favorevoli tutti i risultati possibili, corrisponde

l’intero insieme Ω e quindi la probabilità 1. Agli eventi si applicano le classiche operazioni tra insiemi, di

cui alcuni esempi sono in tabella.

2

Operazione d’insieme

Complementazione

A = {ω ω ∈ Ω,ω ∉A}

Unione

A ∪ B = {ω ω ∈ Ω,

Operazione sugli eventi

Evento “non-A”, che si verifica quando

non si verifica A

Evento “A o B”, che si verifica quando si

verifica almeno uno dei due eventi A o B.

ω ∈ A "o " ω ∈ B}

Intersezione

A ∩ B = {ω ω ∈ Ω,

Evento “A e B”, che si verifica quando si

verificano ambedue gli eventi A e B.

ω ∈ A " e" ω ∈ B}

La probabilità Pr può essere definita come una funzione che fa corrispondere ad un dato insieme in Ω un

valore reale compreso tra 0 e 1:

Pr : F→ [0 , 1]

La probabilità gode delle seguenti proprietà (assiomi):

1) Pr(E) ≥ 0, ∀ E ⊂ Ω

2) Pr(∪n En) = ΣnPr(En) ∀ E1 , …, En ⊂ Ω, Ei ∩ Ej = ∅

3) Pr(Ω) = 1

2 Approfondimento sulla teoria delle probabilità

Questa sezione contiene una rassegna dei principali risultati sulla teoria della probabilità che possono

essere utili per uno studio approfondito sui fenomeni aleatori e sulle loro applicazioni nel campo delle

telecomunicazioni.

2.1 Teorema della probabilità dell’evento complementare

Dato un evento ammissibile E con Probabilità Pr(E), la probabilità dell’evento complementare Pr(non-E)

è pari a

Pr(non-E) = 1 – Pr(E)

2.2 Teorema della probabilità totale

Dati due eventi ammissibili A e B, non necessariamente mutuamente escludentisi (⇒ A∪B ≠∅), con

probabilità Pr(A), Pr(B), l’evento (A o B) è ammissibile, e la sua probabilità vale:

Pr(A ∪ B) = Pr(A)+ Pr(B) – Pr(A ∩ B)

2.3 Fenomeno aleatorio condizionato

Dato un fenomeno aleatorio descritto dallo spazio Ω ed un evento ammissibile Γ (cioè Pr(Γ)>0), si dice

fenomeno aleatorio condizionato all’evento Γ il fenomeno aleatorio ottenuto da quello di partenza

scartando i casi in cui l’evento Γ non si verifica. Rispetto al fenomeno aleatorio condizionato, il generico

evento E è rappresentato dall’insieme E ∩ Γ. Pertanto si definisce la probabilità condizionata di un evento

E rispetto a Γ il rapporto seguente:

3

Pr (E | Γ ) =

Pr (E ∩ Γ )

Pr (Γ )

2.4 Indipendenza Statistica

In generale, sapere che si è verificato l’evento Γ modifica la conoscenza circa il contemporaneo verificarsi

dell’evento E. Infatti:

Pr ( E Γ) ≠ Pr ( E )

Se la conoscenza che si sia verificato Γ non porta alcuna conoscenza riguardo ad E, i due eventi si dicono

statisticamente indipendenti. In particolare un evento E si dice statisticamente indipendente dall’evento Γ

se e solo se

Pr ( E Γ) = Pr ( E )

Se l’evento E è statisticamente indipendente dall’evento Γ risulta:

Pr ( E ∩ Γ ) = Pr (Γ ) Pr ( E )

2.5 Teorema di Bayes

Si consideri un fenomeno aleatorio complesso, cui siano associati due fenomeni aleatori semplici

interconnessi fra loro, di cui solo uno direttamente osservabile. Si consideri ad esempio un sistema di

trasmissione in cui il canale introduce un errore di trasmissione. Un primo fenomeno aleatorio è costituito

dall’emissione da parte della sorgente S di una sequenza di bit {ak = 0 o 1}. Il secondo fenomeno aleatorio

(interconnesso al primo) è costituito dalla ricezione da parte del destinatario D di una sequenza di simboli

{bk = 0 o 1} che, a causa degli errori introdotti dal canale, non coincide necessariamente con {ak}.

Le conoscenze a priori sulla sorgente si traducono sulla conoscenza delle probabilità con cui la sorgente

emette i simboli {ak}:

p0 = Pr(ak = 0)

p1 = Pr(ak = 1) = 1 - p0

Le conoscenze a priori sui meccanismi fisici di trasmissione nel canale si traducono sulla conoscenza

delle probabilità dei simboli ricevuti {bk} condizionate ai simboli emessi {ak}:

Pr(bk = 0 | ak = 0)

Pr(bk = 0 | ak = 1)

Pr(bk = 1 | ak = 0)

Pr(bk = 1 | ak = 1)

Il teorema di Bayes risponde alla domanda: se il simbolo ricevuto è bk = 1, qual è la probabilità che il

simbolo emesso sia stato ak = 1 ? ovvero, come si calcolano le seguenti probabilità a partire dalle Pr(ak) e

dalle Pr(bk | ak)

Pr(ak = 0 | bk = 0)

Pr(ak = 0 | bk = 1)

Pr(ak = 1 | bk = 0)

4

Pr(ak = 1 | bk = 1)

Enunciato del teorema di Bayes: Sia dato un processo aleatorio con spazio Ω, si consideri una partizione

completa {Γ1,...Γm} di Ω, (ovvero ∪j Γj = Ω con Γi ∩ Γj = ∅, i ≠ j), che corrisponde ad una serie completa

di eventi mutuamente escludentisi Γi ed un evento ammissibile E. Note le probabilità Pr(Γi), i = 1,…m, e

le probabilità condizionate Pr(E | Γi), i = 1,…m, la probabilità condizionata dell’evento Γh h = 1,…m

rispetto all’evento E, è data da:

Pr (Γh | E ) =

Pr (E | Γh )Pr (Γh )

∑ Pr (E | Γ )Pr (Γ )

m

j

j =1

j

3 Definizione di variabile aleatoria

Dato un esperimento aleatorio che è caratterizzato dallo spazio dei risultati Ω, abbiamo definito la

probabilità associata ad eventi e cioè sottoinsiemi di risultati che appartengono a Ω. La variabile aleatoria

mappa i singoli esiti del processo in valori reali. In particolare, vale la seguente definizione di variabile

aleatoria: dato uno spazio di probabilità caratterizzato dallo spazio dei risultati Ω e dalla probabilità P

associata ai suoi sottoinsiemi, si definisce variabile aleatoria X(ω) una qualsiasi funzione X : Ω→ R tale

che per ogni punto ξ di R l’insieme A corrispondente, A = {ω ∈ Ω, ω | − ∞ < X (ω ) ≤ ξ }, rappresenti un

evento ammissibile.

Una variabile aleatoria X(ω) si dice discreta se esiste un insieme S = {xi} finito o infinito numerabile tale

che ∑ P(ω | X (ω ) = xi ) = 1 (condizione di normalizzazione). Una variabile aleatoria si dice continua

xi ∈S

quando i valori che può assumere sono continui; in questo caso la precedente condizione di

normalizzazione vale in forma integrale.

3.1 Funzione distribuzione

La funzione distribuzione associata alla variabile aleatoria X, FX(x), è definita come la probabilità che la

variabile aleatoria X sia minore o uguale a x:

FX ( x ) =∆ Pr{X ≤ x}

Nella precedente notazione il simbolo maiuscolo (cioè X) indica la variabile aleatoria, mentre il

corrispondente simbolo minuscolo (cioè x) indica una “manifestazione” (e cioè un possibile valore) della

variabile aleatoria.

La funzione distribuzione FX(x) gode delle seguenti proprietà:

Non-negativa

Non-decrescente

FX ( x ) ≥ 0

FX ( x + ∆x ) ≥ FX ( x ), ∀ ∆x > 0

Continua da destra

5

lim FX ( x + ∆x ) = FX ( x ), ∆x > 0

∆x → 0

Tende a 0 al tendere a -∞ dell’argomento

lim FX ( x + ∆x ) = 0

∆x → −∞

Tende a 1 al tendere a +∞ dell’argomento

lim FX ( x + ∆x ) = 1

∆x → +∞

La probabilità di un evento ammissibile A, cui tramite la X corrisponde un insieme A(X) di R, può essere

calcolata tramite l’integrale:

Pr ( A) =

∫ dF (x )

A( X )

X

3.2 Funzione densità di probabilità

La funzione densità di probabilità della variabile aleatoria X, fX(x), è definita come la derivata della

funzione distribuzione rispetto a x:

f X (x ) =

dFX ( x )

dx

Due variabili aleatorie X1, X2 sono statisticamente indipendenti se e solo se è verificata la condizione

seguente per le funzioni densità:

f X 1 X 2 ( x1 , x2 ) = f X 1 ( x1 ) ⋅ f X 2 ( x2 )

o (equivalentemente) per le funzioni distribuzione:

FX 1 X 2 ( x1 , x2 ) = FX 1 ( x1 ) ⋅ FX 2 ( x2 )

Il valore medio di una variabile aleatoria X è definito dal seguente operatore:

E [x ] = ∫ xf X (x )dx

,

dove l’integrale viene fatto su tutto lo spazio di variabilità di X

X

Il valore quadratico medio è ottenuto applicando l’operatore E[.] alla variabile X2:

[ ]

E x 2 = ∫ x 2 f X ( x )dx

,

dove l’integrale viene fatto su tutto lo spazio di variabilità di X

X

La varianza della variabile aleatoria X, σ2, si ottiene come segue:

( )

σ 2 = E x 2 − [E ( x )] 2

6

4 Approfondimenti con esempi sulle variabili aleatorie

Questa sezione ha lo scopo di fornire una rassegna molto dettagliata delle caratteristiche delle variabili

aleatorie più comunemente usate nel campo delle comunicazioni.

Le variabili aleatorie possono essere di tipo continuo e discreto. La distinzione si fa in base all’insieme di

valori che la variabile può assumere. Se la variabile aleatoria può assumere solo un insieme finito di

valori si dice variabile aleatoria discreta. Pertanto mentre le variabili aleatorie sono contraddistinte dalle

relative funzioni densità (o le funzioni distribuzione di probabilità), le variabili aleatorie discrete sono

contraddistinte dai valori puntuali delle probabilità.

Di seguito sono dettagliate le caratteristiche dei tipi più comuni di variabili aleatorie. Alcune di queste

variabili possono essere particolarmente utili per caratterizzare, ad esempio, il canale di comunicazione e

le caratteristiche del traffico.

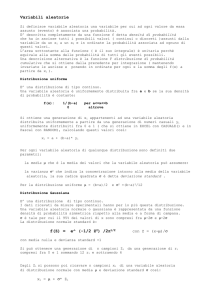

4.1 Variabili aleatorie discrete

La distribuzione binomiale

Riferendoci ad un esperimento aleatorio, si ha dato evento A che ad ogni prova dell’esperimento si

verifica con probabilità p. Supponendo che l’esito dell’esperimento sia indipendente da prova a prova,

allora la probabilità che su N prove ripetute dell’esperimento, l’evento A sia stato soddisfatto X = k volte è

data dalla formula seguente (distribuzione di probabilità binomiale):

N

N −k

P rob {X = k } = p k (1 − p )

k

, k ∈ [0, 1, ..., N ]

N

N!

dove =

è il coefficiente binomiale.

k k!(N − k )!

Il valore medio di questa distribuzione è E[X] = np; la varianza vale Var[X] = np(1 - p).

Un esempio di distribuzione di probabilità binomiale è mostrato in Fig. 1.

7

0.25

Probabilità

0.2

0.15

0.1

0.05

0

0

2

4

6

8

10

x

12

14

16

18

20

Fig. 1: Distribuzione di probabilità binomiale per N = 20 e p = 0.2.

La distribuzione geometrica

Sia dato un esperimento aleatorio, in base al quale si definisce l’evento A che ad ogni prova si verifica con

probabilità p. Supponendo che l’esito dell’esperimento sia indipendente da prova a prova, il numero di

prove che occorre eseguire per aver verificato l’evento A è X = k secondo la seguente distribuzione di

probabilità geometrica:

P rob {X = k } = p (1 − p )

k −1

, k ∈ [1, 2, ...]

Il valore medio di questa distribuzione è E[X] = 1/p; la varianza vale Var[X] = (1 - p)/p2.

Un esempio di andamento della distribuzione geometrica è indicato nella Fig. 2.

8

0.2

0.18

0.16

Probabilità

0.14

0.12

0.1

0.08

0.06

0.04

0.02

0

0

5

10

15

20

25

x

Fig. 2: Distribuzione di probabilità geometrica per p = 0.2.

La distribuzione di Poisson

Una variabile aleatoria discreta X ha distribuzione di Poisson quando la probabilità che si verifichi

l’evento X = k per k = 0, 1, 2, … soddisfa la seguente formula:

ρ k −ρ

P rob {X = k } =

e

, k ∈ [0, 1, ...]

k!

dove ρ è un parametro (adimensionale) reale positivo; la distribuzione ha andamento decrescente con k,

ma al crescere di ρ divengono maggiormente significativi i valori con k più elevato.

Il valore medio di questa distribuzione è E[X] = ρ; la varianza vale Var[X] = ρ.

Un esempio che illustra l’andamento della distribuzione di Poisson è indicato in Fig. 3.

9

0.3

0.25

Probabilità

0.2

0.15

0.1

0.05

0

0

2

4

6

8

10

12

14

16

18

20

x

Fig. 3: Distribuzione di probabilità di Poisson per ρ = 2.

4.2 Variabili aleatorie continue

Distribuzione esponenziale

Una variabile aleatoria con distribuzione di esponenziale ha la seguente funzione densità:

f X (x ) =

1 − λx

e , x ∈ [0 , + ∞ )

λ

Il valore medio di questa distribuzione è E[X] = 1/λ (λ prende il nome di tasso e ha le dimensioni del

reciproco di x); la varianza vale Var[X] = 1/λ2.

5

4.5

4

Funzione densità

3.5

3

2.5

2

1.5

1

0.5

0

0

10

20

30

40

50

60

70

80

90

100

x

Fig. 4: Funzione densità di probabilità per un tasso λ = 0.2.

10

La distribuzione gaussiana

Una variabile aleatoria con distribuzione gaussiana con valore medio µ e varianza σ2 è caratterizzata dalla

seguente funzione densità:

f X (x ) =

1

2πσ

2

e

−

( x −µ )2

2 σ2

, x ∈ (− ∞ , + ∞ )

σ è la deviazione standard.

La funzione densità di una variabile aleatoria x gaussiana con valore medio µ = 0 e varianza σ2 = 1 è

rappresentata in Fig. 1.

0.4

0.35

Funzione densità

0.3

0.25

0.2

0.15

0.1

0.05

0

-10

-8

-6

-4

-2

0

2

4

6

8

10

x

Fig. 5: Funzione densità di probabilità per una variabile aleatoria gaussiana con valore medio nullo e

varianza unitaria.

La funzione distribuzione FX(x) associata alla densità gaussiana è ovviamente data dalla seguente

formula: FX (x ) =

x

∫ f (x ) dx . Tale integrale non può essere espresso in forma chiusa. Si introduce allora la

X

−∞

+∞

y2

2

x

1

x 1

= erfc

. Riferendoci ad una variabile aleatoria

1 − erf

2

2π x

2 2

2

gaussiana con valore medio nullo e varianza unitaria, allora la sua distribuzione FX(x) può essere ottenuta

come 1 – Q(x).

funzione Q( x ) =

1

∫e

−

dy =

La distribuzione gaussiana ha un’interessante proprietà che va sotto il nome di teorema del limite

centrale: la somma di n variabili aleatorie continue identicamente distribuite e statisticamente

11

indipendenti tende ad una variabile aleatoria gaussiana se n (questo vale qualsiasi sia la funzione densità

delle variabili aleatorie che si sommano).

La distribuzione lognormale

Una variabile aleatoria X è detta avere una distribuzione lognormale con parametri µ e σ, se ln(X) ha

distribuzione normale con valore medio µ e deviazione standard σ. Equivalentemente X = exp(Y), dove Y

ha distribuzione gaussiana con valore medio µ e deviazione standard σ.

E’ possibile dimostrare che questa variabile aleatoria ha la seguente funzione densità:

f X (x ) =

1

x 2πσ 2

e

−

(ln( x ) −µ )2

2σ2

, x ∈ (0 , + ∞ )

Il valore medio di questa distribuzione è E[X] = exp(µ + σ2/2); la varianza vale Var[X] = exp(2µ + 2σ2)exp(2µ + σ2). Un esempio di distribuzione lognormale è dato in Fig. 6 per µ = 0 e σ = 0.2.

10

Funzione densità

10

10

10

10

10

10

50

0

-50

-100

-150

-200

-250

0

10

20

30

40

50

60

70

80

90

100

x

Fig. 6: Funzione densità di probabilità per una variabile aleatoria lognormale con per µ = 0 e σ = 0.2.

La distribuzione lognormale serve per modellare la statistica del prodotto di un numero elevato di

variabili indipendenti ed indipendentemente distribuite (teorema del limite centrale per il prodotto).

Distribuzione di Rayleigh

Una variabile aleatoria X con distribuzione di Rayleigh ha la seguente funzione densità:

f X (x ) =

x

1 − 2σ2

e

, x ∈ [0 , + ∞ )

2σ 2

12

Il valore medio di questa distribuzione è E[X] =

la varianza vale Var[X] = (2 – π/2)σ2.

2 σ Γ(3 / 2 ) , dove Γ(x) indica la funzione Gamma di x;

Se X e Y sono due variabili aleatorie indipendenti con distribuzione gaussiana, valore medio nullo e

varianza σ2, allora la variabile Z = X2 + Y2 è distribuita secondo Rayleigh come indicato in precedenza.

Invece Z2 ha distribuzione chi-quadro centrale con due gradi di libertà.

Distribuzione di Rice

Una variabile aleatoria X con distribuzione di Rice ha la seguente funzione densità:

x −

f X (x ) = 2 e

σ

x2 +s2

σ2

xs

I 0 2 , x ∈ [0 , + ∞ )

σ

dove I0(x) rappresenta la funzione di Bessel modificata del primo tipo di ordine 0 e s è il parametro di

non-centralità.

Se X e Y sono due variabili aleatorie indipendenti con distribuzione gaussiana, valori medi µ1 e µ2

(rispettivamente) e stessa varianza σ2, allora la variabile Z = X2 + Y2 è distribuita secondo Rice come

indicato in precedenza, dove s2 = µ12 + µ22. Invece Z2 ha distribuzione chi-quadro non-centrale centrale

con parametro di non-centralità s.

13