Richiami di inferenza statistica

Strumenti quantitativi per la

gestione

Emanuele Taufer

Inferenza statistica

Inferenza statistica: insieme di tecniche che si

utilizzano per ottenere informazioni su una (o più)

caratteristiche (o parametri) su una data popolazione

sulla base di dati campionari.

Alcuni aspetti formali:

Popolazione: un insieme di N unità (persone,

imprese, Stati) che siamo interessati ad

analizzare. Indichiamo con

U = {x , x , … , x } l’insieme delle

modalità della caratteristica che siamo

interessati ad analizzare (sesso, altezza,

reddito, addetti, PIL, etc.) misurate su ogni

unità della popolazione.

1

2

N

Campione: un sottoinsieme di dimensione n, (

n << N ) delle unità della popolazione

selezionate con criteri probabilistici. Poichè a

priori non sappiamo quali unità faranno parte

del campione, le corrispondenti modalità sono

delle variabili casuali. Indichiamole con

C = {X 1 , X 2 , … , X n }

Parametri e statistiche

Parametri: caratteristiche della popolazione.

Tipicamente la media (μ), la varianza (σ ),

etc.. Di solito si usano lettere dall’alfabeto

greco per indicare i parametri della

popolazione.

2

Statistiche: caratteristiche del campione.

Tipicamente la media,

n

1

X̄ =

n

∑ Xi ,

i=1

la varianza (corretta),

S

2

1

=

n − 1

n

2

∑(Xi − X̄) .

i=1

Poiché il valore delle statistiche cambia con il

campione selezionato, a priori, ossia prima

della selezione del campione, sono delle

variabili casuali.

Esempi

stimare l’età (o l’altezza) media della

popolazione residente in Italia

stimare la percentuale di consumatori di una

certa regione che acquista abitualmente un

certo tipo di prodotto

prevedere (con un dato margine di errore)

l’esito delle elezioni

verificare se una certa campagna pubblicitaria

ha portato ad un aumento delle vendite

Tecniche di inferenza

Le principali tecniche di inferenza statistica sono:

Stima: quando interessa individuare il valore di una

certa caratteristica. Si distingue in:

puntuale

intervallare

Verifica delle ipotesi (o test): quando i dati

campionari sono utilizzati per verificare una certa

ipotesi su un parametro della popolazione.

Stima

Si consideri il caso in cui siamo interessati a

determinare un valore numerico (la stima)

sufficientemente preciso per la media μ di una certa

popolazione.

Dato un campione, proveniente dalla popolazione di

interesse, sembra naturale utilizzare X̄ come

indicatore del valore di μ

Terminologia

Stimatore: la regola per effettuare la stima (calcola la

media). Lo stimatore è una variabile casuale poichè

definito a priori su tutti i possibili risultati campionari.

Stima: il valore dello stimatore ottenuto dal campione.

Un valore numerico.

Esistono diversi metodi di stima che permettono di

ottenere delle buone regole di stima per problemi

anche molto complessi.

Precisione delle stime

Per valutare la precisione delle regole di stima è

opportuno ragionare a priori su tutti i possibili

risultati campionari.

Idealmente questo si può fare agevolmente se si

conosce la distribuzione di probabilità dello stimatore

adottato. Poichè nella pratica questo non sempre è

possibile, si utilizzano alcuni indicatori di sintesi.

Indichiamo con T uno stimatore per il generico

parametro θ.

1. Il valore atteso, ossia la media calcolata su tutti i

possibili risultati campionari. Se

E(T ) = θ

∀θ

si dice che lo stimatore è non distorto o corretto

poiché il suo valore atteso coincide con il

parametro che si vuole stimare. In caso

contrario la quantità

E(T ) − θ ≠ 0

è definita bias o distorsione.

La media campionaria è uno stimatore corretto per

la media della popolazione μ poiché

E(X̄ ) = μ

, ∀μ

2. Una indicatore della dispersione dello

stimatore, lo MSE (mean squared error), misura

la distanza quadratica media dello stimatore dal

parametro.

2

M SE(T ) = E(T − θ)

2

= V ar(T ) + (E(T ) − θ)

Bias

Nel caso della media, poiché è corretta per μ,

2

M SE(X̄ ) = V ar(X̄ ) = σ /n

dove σ indica la varianza della popolazione

campionata.

2

2

Intervalli di confidenza (IC)

Un IC di livello (1 − α) per il parametro θ è un

intervallo casuale (dipende dal campione) che include

il vero valore di θ con probabilità (1 − α) .

Anche per gli IC esiste una distinzione analoga a

quella fra stimatore e stima:

A priori, prima di selezionare il campione, la

procedura di costruzione fornisce un IC che

includerà il vero valore del parametro con

probabilità (1 − α) .

A posteriori, l’intervallo determinato dai dati

non è più casuale e conterrà oppure no il

vero valore del parametro. Questo non è, di

solito, noto. La procedura di costruzione ci dà

un certo grado di confidenza, pari a (1 − α) ,

ma nulla di più.

Tipicamente α è piccolo per avere gradi di

confidenza elevati. Ad esempio α = 0, 05 o

α = 0.01 .

Esempio

Esempio: IC per la media μ

Un IC di livello (1 − α) per la media di una

popolazione μ è dato da

S

X̄ ± zα/2

√n

L’IC è esatto se la popolazione campionata è

normale, è approssimato (per il teorema

limite centrale) in altri casi

−−

2

S = √S

è il percentile (1 − α/2) per la distribuzione

normale standard.

zα/2

Esempio: se α = 0.05 allora z

0.025

= 1.96

.

Verifica delle ipotesi

Nella teoria dei test i risultati campionari sono usati

per decidere tra due ipotesi in competizione

H0

- ipotesi nulla

H1

- ipotesi alternativa

Esempio

Il prezzo medio di una stanza in hotel 4S a

Londra è 150 Euro (H )

0

Possibili alternative (H

1)

il prezzo medio è > 150 - unilaterale

il prezzo medio è < 150 - unilaterale

il prezzo medio è ≠ 150 - bilaterale

Errori nella decisione

α = P (Rifiutare erroneamente H0 )

β = P (Accettare erroneamente H0 )

Esempio 1

Regole di decisione

Esiste trade-off tra α e β e non è possibile

minimizzarli contemporaneamente.

Poiché H è l’ipotesi fondamentale, la

decisione è di rifiutare H (e quindi accettare

H ) quando la probabilità dell’errore di prima

specie, α, molto piccola.

0

0

1

Tipicamente si richiede che α < 0.05 .

In generale la decisione è presa osservando il

valore assunto da una certa statistica

campionaria, definita, in questo caso, statistica

test

Le statistiche test sono diverse a seconda del

problema considerato ed esistono metodi

statistici per determinare regole ottimali.

Un esempio intuitivo

Abbiamo un campione di n unità da una distribuzione

normale a media μ e varianza σ (nota). Vogliamo

verificare il set di ipotesi: H : μ = 0 contro

H : μ ≠ 0.

2

0

0

Poichè X̄ è stimatore per μ sembra ragionevole

confrontarne il valore con quello indicato nell’ipotesi

nulla e rifiutare se questo è molto minore o molto

maggiore di 0 .

Per quantificare quel “molto maggiore” o “molto

minore”, conviene di solito misurare le distanze in

termini di deviazioni standard, ossia procediamo a

standardizzare X̄ :

Z =

(X̄ − 0)√n

σ

Si noti che la standardizzazione usa il valore di μ

specificato dall’ipotesi nulla. Ossia si fanno i calcoli

ipotizzando che questa sia effettivamente vera.

Ad esempio, se |Z| = 1, si trova ad una deviazione

standard dall’ipotesi nulla; se |Z| = 4 si trova a 4

deviazioni standard dall’ipotesi nulla.

Per decidere è necessario sapere quale distanza

assicura ci assicura che la probabilità dell’errore di

prima specie α sia piccola, diciamo < 0.05.

Riassumendo:

La statistica test è: Z

La regola di decisione è: rifiuta se |Z| supera

un valore soglia che renda la probabilità

dell’errore di prima specie α < 0.05 .

In altre parole, dobbiamo individuare un valore z ( il

valore soglia) per il quale

P (|Z| > z|H0

è vera) = α

Se dai dati osserviamo il valore z della statistica

test, il valore soglia z è superato se

oss

P (|Z| > zoss |H0

è vera) < α

è definito p -value ed è

tipicamente fornito dai software per la decisione.

P (|Z| > zoss |H0 )

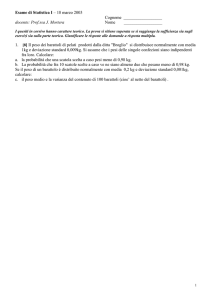

Esempio

Il prezzo medio di una stanza in hotel 4S a

Londra è 150 Euro (H )

0

Il prezzo medio è ≠ 150

(H 1 )

In termini di parametri possiamo scrivere

H : μ = 150 contro H : μ ≠ 150

0

1

Supponiamo per semplicità che la popolazione

sia normale con varianza σ = 2500

2

Un campione casuale di 25 unità fornisce un

prezzo medio (X̄ ) pari a 180 Euro.

la statisitca test è

−

−

(180 − 150)√25

z =

−

−

−

−

√2500

= 3

che si colloca a tre deviazioni standard dalla

media

il p -value associato è 0.0027.