CORSO DI LAUREA IN ECONOMIA AZIENDALE

Metodi Statistici per le decisioni d’impresa (Note didattiche)

Bruno Chiandotto

2

CALCOLO DELLE PROBABILITA’

Il calcolo delle probabilità, nato nel contesto dei giochi d’azzardo si è sviluppato

teoricamente fino ad assumere un ruolo particolarmente rilevante nell’analisi dei

fenomeni collettivi diventando, come già sottolineato in precedenza, presupposto

essenziale della teoria delle decisioni e della statistica. La teoria delle probabilità è una

disciplina matematica astratta e altamente formalizzata pur conservando il suo originale

e rilevante contenuto empirico; per questa sua particolare natura l’esposizione,

necessariamente sommaria, dei suoi contenuti risulta facilitata dall’introduzione di

definizioni esplicite relative agli aspetti e concetti che ne costituiscono il corpo.

Definizione 1: Si dice esperimento casuale, ogni operazione o attività (fenomeno) il

cui risultato (la cui manifestazione) non può essere previsto con certezza.

Risulta chiaro che il termine esperimento va qui inteso in senso lato,

comprendendo in esso, sia il caso del lancio di un dado, sia il caso dell'estrazione di una

pallina da un'urna, sia il caso della rilevazione dei pesi dei coscritti alla leva, sia quello

dell’esito di una operazione chirurgica, sia il caso della sperimentazione di un nuovo

farmaco, sia quello del controllo dei pezzi prodotti da un certo macchinario ecc.

Definizione 2: Si dice spazio campionario di un esperimento casuale, l'insieme Ω di

tutti i possibili risultati, esaustivi e mutualmente escludentesi,

dell'esperimento stesso.

Se l'esperimento consiste nell'estrazione di una pallina da un'urna che ne contiene

n identiche a meno del numero progressivo, da 1 a n, sopra impresso, lo spazio

campionario resta definito da

Ω = (ω 1 , ω 2 ,..., ω i ,..., ω n )

dove ω i (i=1, 2,...,n) sta ad indicare il punto camponario costituito dalla estrazione della

1

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

pallina contrassegnata con il numero i .

Se l'esperimento si svolge attraverso il controllo dei pezzi prodotti da un certo

macchinario avendo come finalità l'accertamento della bontà o difettosità del pezzo

prodotto, lo spazio campionario Ω sarà composto dai soli due elementi (punti

campionari) ω 1 e ω 2 , dove ω 1 rappresenta il pezzo difettoso ed ω 2 il pezzo non

difettoso.

Definizione 3:

Se lo spazio campionario è costituito da un numero finito o da

un’infinità numerabile di punti campionari, si dice evento ogni

sottoinsieme E dello spazio campionario Ω. Se lo spazio campionario

è costituito d un’infinità non numerabile di punti, non tutti i possibili

sottoinsiemi di Ω sono eventi; in questa sede verranno, comunque,

considerati soltanto i cosidetti sottoinsiemi ammissibili di Ω, cioè i

sottoinsiemi che hanno natura di eventi.

Ogni evento sarà pertanto costituito da un insieme di punti campionari. Se, ad

esempio, si fa riferimento al caso dell'estrazione di una pallina da un'urna che ne

contiene n, si può pensare di suddividere l'intero spazio campionario in due sottospazi

Ω 1 ed Ω 2 contenenti, rispettivamente, i punti campionari: a) presentarsi di una pallina

contrassegnata da un numero dispari; b) presentarsi di una pallina contrassegnata con un

numero pari.

L'evento

E = ( ω : ω i per i pari o dispari) =

(ω , ω

1

2

,..., ω i ,..., ω n ) = Ω

coincide con l'intero spazio e rappresenta l'evento certo; l'evento cioè che certamente si

realizzerà in quanto effettuando l'estrazione è certo che si presenterà una pallina o

contrassegnata con un numero dispari o contrassegnata con un numero pari.

L'evento

E = ( ω : ω i per i pari e dispari)

2

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

è un evento che non contiene punti campionari; infatti ogni pallina è contrassegnata o da

un numero dispari o da un numero pari e non esiste pallina contrassegnata da un

numero che è dispari e pari allo stesso tempo.

L'evento così definito viene detto evento impossibile (si tratta dell'evento che non

si potrà mai realizzare) e denotato con il simbolo ø.

Gli eventi

Ei = (ωi) , per i = 1,2,…,n, vengono detti eventi elementari in

quanto costituiti da un solo punto campionario.

Sugli eventi si può introdurre un'algebra, cioè un insieme di operazioni che

soddisfano certe proprietà e che generano, come risultato delle operazioni stesse, ancora

degli eventi, cioè elementi che appartengono all’insieme B sui quali è stata introdotta

l’algebra e si parla di sistema chiuso rispetto alle operazioni introdotte. Se il sistema è

chiuso rispetto ad un numero finito di operazioni, si parla di algebra di Boole o, più

semplicemente, di algebra o campo, se il sistema è chiuso rispetto ad un’infità

numerabile di operazioni, si parla di algebra di Boole completa o, più semplicemente, di

σ-algebra o σ-campo.

Il lettore a conoscenza dei rudimenti della teoria degli insiemi noterà come quanto

esposto in queste note, riguardo agli eventi, non rappresenta alcunchè di nuovo o di

diverso rispetto al già conosciuto; in effetti gli eventi possono essere interpretati come

insiemi, o meglio, come sottoinsiemi di un insieme dato rappresentato dallo spazio

campionario Ω. Si ha così che l'evento certo Ω (coincidente con l'intero spazio

campionario) non rappresenta altro che l'insieme universale, mentre l'evento impossibile

ø corrisponderà all'insieme vuoto.

Le operazioni proprie della teoria degli insiemi sono quella di prodotto o

intersezione (∩), quella di somma o unione (∪), quella di complementazione o

negazione E e quella di differenza (-); si tratta delle stesse operazioni che, oltre al

concetto di inclusione, verranno qui considerate in quanto costituenti parte essenziale

dell'algebra degli eventi.

3

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Si dice che un evento E1 è incluso nell'evento E2, e si scrive E1 ⊆ E2 se ogni

punto campionario appartenente ad E1 appartiene anche ad E2. Due eventi E1 ed E2

sono, quindi, uguali se e solo se (sse) contemporaneamente

E1 ⊆ E2

ed

E1 ⊇ E2

in questo caso i due eventi saranno costituiti dagli stessi punti campionari.

Si definisce come negazione (complementazione nella teoria degli insiemi) di un

evento E, e si scrive E , l'evento che si realizza quando non si realizza E. L'evento E

sarà pertanto, costituito da tutti i punti campionari di Ω che non appartengono ad E.

Nella figura sottostante vengono proposti graficamente (facendo ricorso ai

cosidetti diagrammi di Venn) il concetto di evento incluso e di evento negato.

Ω

E1

E2

E2

Fig. 4 - Diagrammi di Venn per l’inclusione e la negazione dove il quadrato rappresenta

l’intero spazio campionario Ω e E1 ⊂ E2 .

Sugli eventi vengono definite le due ulteriori operazioni di intersezione (o

prodotto) tra eventi e quello di unione (o somma) di eventi.

L'intersezione tra due eventi E1 ed E2 è l'evento E3 = E 1 ∩ E2, che resta definito

dai punti campionari che appartengono sia ad E1 sia ad E2.

L'unione tra due eventi E1 ed E2 è l'evento E4 = E1 ∪ E2 che resta definito da

tutti i punti campionari che appartengono ad E1 o ad E2 o ad entrambi gli eventi E1 ed

E2 .

4

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

La rappresentazione grafica tramite i diagrammi di Venn delle due operazioni

(intersezione ed unione) è riportata nella figura sottostante

Ω

Ω

E3

E1

E2

E4

Fig. 5 - Diagrammi di Venn per l’intersezione e l’unione dove il tratteggio vuole

evidenziare rispettivamente, l’evento E3 , nella prima figura e l’evento E4

nella seconda figura.

Si definisce, infine, come differenza fra due eventi E1 ed E1 l'evento

E5 = E1- E2 che risulta costituito dai punti campionari che appartengono ad E1 ma non a

E2.

Si noti che una volta introdotte le operazioni di negazione ed intersezione

(operazioni base dell’algebra di Boole) si potrebbe fare a meno d'introdurre le due ulteriori operazioni di unione e di differenza non essendo queste ultime operazioni

concettualmente nuove; infatti:

E 1 ∪ E 2 = (E1 ∩ E 2 )

E1 − E 2 = (E1 ∩ E 2 )

La relazione E1 ∪ E 2 = (E1 ∩ E 2 ) e la relazione duale E 1 ∩ E 2 = (E1 ∪ E 2 )

vengono usualmente dette leggi di de Morgan.

L'introduzione di queste due ultime operazioni è giustificata dalla semplificazione,

sia formale sia operativa, che esse comportano.

5

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Due eventi E1 e E2 si dicono incompatibili se la loro intersezione da luogo

all'evento impossibile

E1 ∩ E2 = ø

si tratta di eventi che non hanno elementi (punti campionari) comuni.

A questo punto risulta facile verificare le relazioni seguenti, dove il simbolo

⇒ rappresenta

la

relazione

di

implicazione

necessariamente - è implicata - la seconda relazione):

E1 ⊂ E2 => E1 ∩ E2 = E1

E1 ⊂ E2 => E1 ∪ E2 = E2

φ =Ω

Ω=ø

ø⊂E⊂Ω

E∩ø=ø

E∩Ω=E

E∪ø=E

E∪Ω=Ω

E∩ E =ø

E∪ E =Ω

E1 ⊂ (E1 ∪ E2)

(E1 ∩ E2) ⊂ E1

E2 ⊂ (E1 ∪ E2)

(E1 ∩ E2) ⊂ E2

6

(dalla

prima

relazione

deriva

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Un ulteriore e rilevante concetto è quello di condizionamento degli eventi.

L'evento E1/E2 (e si legge l'evento E1 condizionato dall'evento E2 o, più

semplicemente, l'evento E1 dato E2) va analizzato presupponendo già verificato l'evento

condizionante E2. Il condizionamento degli eventi si risolve, praticamente, in una sorta

di ridefinizione dello spazio campionario che da Ω si trasforma nell'evento

condizionante, o, ancora meglio, è l'evento condizionante che assume la natura di spazio

campionario di riferimento.

Ω

E1

E2

Fig. 6 - Ridefinizione degli spazi per eventi condizionati

Se si considera l'evento condizionato E1/E2 non solo E2 si trasforma in Ω ma

anche l'evento E1 si trasforma nell'evento E1 ∩ E2, in quanto, sapendo che l'evento E2

si è verificato perdono di rilevanza tutti i punti campionari che pur appartenendo ad E1

non appartengono ad E2.

Le operazioni di unione e di intersezione possono, naturalmente, essere applicate

anche a k (>2) eventi. l'intersezione fra k eventi E1,E2,….,Ek fornisce come risultato

l'evento E

k

E = E 1 ∩ E 2 ∩...∩ E k = E i

i =1

che contiene tutti i punti campionari ω i comuni ai k eventi E1,E2,….,Ek; mentre, l'unione

tra gli stessi k eventi dà come risultato l'evento E

k

E = E1 ∪ E2 ∪ ... Ek =

7

Ei

i=1

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

che contiene tutti i punti campionari ω i che appartengono ad almeno uno degli eventi

Ei.

Le operazioni di unione e di intersezione soddisfano la proprietà associativa e

quella distributiva

E1 ∩ E2 ∩ E3 = (E1 ∩ E2) ∩ E3 = E1 ∩ (E2 ∩ E3)

E1 ∪ E2 ∪ E3 = (E1 ∪ E2) ∪ E3 = E1 ∪ (E2 ∪ E3)

E1 ∩ (E2 ∪ E3) = (E1 ∩ E2) ∪ (E1 ∩ E3)

E1 ∪ (E2 ∩ E3) = (E1 ∪ E2) ∩ (E1 ∪ E3)

Le due ultime proprietà (distributive) per k eventi danno

k

E ∩ (E1 ∪ E2 ∪...∪ Ek) = E ∩ ( Ei) =

i=1

k

E ∪ (E1 ∩ E2 ∩...∩ Ek) = E ∪ ( Ei ) =

i=1

k

(E ∩ Ei)

i=1

k

i=1

(E ∪ Ei)

Relativamente agli esperimenti casuali più semplici non s'incontrano, usualmente,

difficoltà nell'individuazione e nella successiva enumerazione dei punti campionari che

ne costituiscono i possibili risultati. In esperimenti più complessi possono risultare di

notevole ausilio alcune formule combinatorie (richiamate sinteticamente in appendice al

capitolo) che facilitano notevolmente l'enumerazione dei punti campionari, cioè l'esatta

definizione dello spazio campionario.

Definizione 4: Si dice probabilità di un evento, la funzione a

valori reali P(E),

definita sulla classe dei sottoinsiemi ammissibili (eventi) dello spazio

campionario che soddisfa specifiche proprietà.

I concetti (primitivi) prova o esperimento casuale, evento e probabilità introdotti

sono legati fra loro dalla seguente frase: "l'esperimento genera l'evento con una certa

8

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

probabilità". Dove, naturalmente, la probabilità va intesa come misura applicata agli

eventi quando viene condotto un esperimento casuale.

I tre concetti primitivi sono posti a base della definizione assiomatica di

probabilità. Si tratta di una definizione che non ha sollevato obiezioni sostanziali da

parte degli studiosi dopo la sua formulazione da parte di Kolmogorov. Si tratta infatti di

una definizione che si preoccupa di precisare e chiarire soltanto i contenuti sintattici sui

quali è più facile trovare l'accordo. Ma se da un lato il cosidetto approccio assiomaticoformale alla probabilità presenta indubbi vantaggi, sia in termini di accettabilità che di

sviluppo della teoria, dall'altro lato il considerare i soli aspetti formali esclude ogni

operatività della definizione stessa in quanto non consente la derivazione numerica della

probabilità nei singoli casi concreti.

Quando si vuol far ricorso alla probabilità per risolvere problemi reali si dovrà,

quindi, fare necessariamente ricorso ad altre definizioni nelle quali l'aspetto semantico

viene privilegiato.

Prima di trattare della definizione assiomatica di probabilità conviene, pertanto,

introdurre altre definizioni. Tra le innumerevoli definizioni proposte in letteratura, in

questa sede se ne presentano soltanto tre: la definizione classica, quella frequentista o

statistica e la definizione soggettiva. Si tratta delle tre definizioni non assiomatiche

della probabilità più note ed alle quali si fa più spesso riferimento in pratica; tutte e tre

le definizioni soddisfano ai postulati posti a base della definizione assiomatica di

probabilità.

Definizione classica (a priori) della probabilità

La probabilità P(E) di un evento E è data dal rapporto tra il numero n E dei casi

favorevoli al verificarsi dell'evento e il numero n dei casi possibili, purchè tutti i casi

siano egualmente possibili

P( E ) =

n E numero dei casi favorevoli

=

n

numero dei casi possibili

Alla definizione classica di probabilità sono state rivolte critiche di varia natura.

La prima critica è di ordine logico e riguarda la circolarità della definizione: affermare

9

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

che tutti i casi sono ugualmente possibili significa dire che sono ugualmente probabili

(non si può definire un concetto utilizzando lo stesso concetto).

Altre due critiche riguardano l’operatività della definizione; una volta superato lo

scoglio logico, non sono affatto rare le situazioni reali nelle queli non è possibile

procedere all’enumerazione dei casi favorevoli e dei casi possibili, inoltre, anche nelle

situazioni in cui si può effettuare una tale enumerazione, non è infrequente la

circostanza in cui non tutti i casi sono ugualmente possibili.

Per superare gli inconvenienti operativi cui si andrebbe incontro se si volesse far

ricorso alla definizione classica di probabilità quando le situazioni non lo consentono, è

stata introdotta una diversa definizione di probabilità.

Definizione frequentista o statistica (a posteriori) della probabilità

La probabilità di un evento ripetibile E è data dal rapporto tra il numero n E delle

volte in cui l'evento si è verificato ed il numero delle prove (effettuate tutte nelle stesse

condizioni) quando il numero delle prove stesse tende ad infinito

P(E) = lim

n→∞

nE

n

La probabilità secondo questa definizione può essere, pertanto, intesa come una

sorta di idealizzazione della frequenza relativa che verrà introdotta nel contesto della

statistica descrittiva. Taluni autori ritengono, infatti, che probabilità e frequenza relativa

non siano altro che l'aspetto teorico e quello empirico di uno stesso concetto ed

interpretano la frequenza relativa di un evento come misura approssimata (per n finito)

della probabilità.

Anche alla definizione frequentista sono state rivolte critiche di varia natura quale

quella relativa al limite irraggiungibile (+∞) imposto al numero delle prove, ma ad una

tale critica si risponde accettando la frequenza relativa di un numero finito (ma

sufficientemente elevato) di prove come misura approssimata della probabilità. Molto

più problematica è la risposta alla critica relativa alla ripetibilità delle prove

(esperimento) in situazioni invariate e, soprattutto, quella che fa riferimento alle

situazioni reali, e non sono affatto infrequenti, nelle quali non è possibile procedere

all’effettuazione di alcuna prova.

10

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Una definizione che supera le critiche, sia di ordine logico che operativo, rivolte

alla definizione classica e alla definizione frequentista di probabilità è la definizione

sotto riportata.

Definizione soggettiva della probabilità

La probabilità P(E) di un evento E viene definita come il grado di fiducia che un

individuo razionale attribuisce al verificarsi di un evento. La misura (soggettiva) di

probabilità si deriva ponendo l'individuo (razionale) di fronte ad un'operazione di

scommessa chiedendo quanto è disposto a puntare per ricevere 1 nel caso in cui l'evento

in questione si realizzi. Si deve sottolieare che questa affermazione vale solo nel caso di

individui con funzione di utilità lineare; ma sulla funzione di utilità si avrà modo di

tornare nelle pagine successive.

Anche alla definizione soggettiva di probabilità sono state rivolte critiche. La

prima riguarda proprio la soggettività insita nella stessa definizione, la seconda è

relativa alla difficoltà di traduzione in un valore numerico significativo del grado di

fiducia.

Alla prima critica si risponde osservando che qualunque probabilità deve essere

intesa in senso condizionato, cioè condizionatamente allo stato di informazione

dell’individuo (razionale); pertanto, anche se apparentemente due individui diversi

attribuiscono una diversa misura di probabilità ad uno stesso evento, gli stessi individui

si riferiscono a due diversi eventi essendo diverso lo stato di informazione su cui basano

l’esplicitazione del proprio grado di fiducia.

Alla seconda critica si risponde che, nonostante alcune difficoltà operative, alla

misura di probabilità si perviene, come già sottolineato, attraverso l’attivazione di un

processo relativamente semplice (almeno sul piano concettuale) che è quello di porre

l’individuo di fronte ad una operazione di scommessa.

Le tre definizioni introdotte, cui si può far ricorso per addivenire ad una

valutazione numerica della probabilità, non sono necessarie per lo sviluppo del calcolo

delle probabilità bastando a tal fine la definizione assiomatica, ed a questa definizione

si farà riferimento negli sviluppi teorici che seguono. Alle tre definizioni non

assiomatiche si farà, di volta in volta, riferimento nelle esemplificazioni delle

argomentazioni teoriche.

11

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Definizione assiomatica di probabilità

Gli assiomi o postulati di base del Calcolo delle probabilità sono sei: il primo

riguarda il concetto primitivo di evento, gli altri cinque il concetto primitivo di

probabilità.

Assioma 1 - Gli eventi formano un’algebra di Boole completa.

Assioma 2 - La misura di probabilità di un evento P(E) è unica.

Assioma 3 - La misura della probabilità di un evento è sempre non negativa

P(E) ≥ 0

Assioma 4 - La probabilità dell’evento certo è uguale a 1

P(Ω) = 1

Assioma 5 - Se due eventi E1 ed E2 sono incompatibili, cioè se la loro intersezione è

l’evento impossibile, allora la probabilità della loro unione è uguale alla

somma delle probabilità dei singoli eventi (principio delle probabilità

totali per eventi incompatibili)

P(E1 ∪ E2) = P(E1) + P(E2)

per E1 ∩ E2 = ∅

Assioma 6 - La probabilità dell’evento condizionato E1/E2 è pari alla probabilità

dell’intersezione dei due eventi rapportata alla probabilità dell’evento

condizionante supposta maggiore di 0

P(E1/E2) =

P(E1 ∩ E 2 )

P(E 2 )

per P(E2) > 0

L’ultima relazione può essere riscritta (principio delle probabilità composte)

come:

P(E1 ∩ E2) = P(E2) • P(E1/E2) = P(E1∩E2) = P(E1) • P(E2/E1)

Avendo definito la probabilità come funzione da applicare agli eventi dove, come

precisato, l'evento è un qualunque sottoinsieme dello spazio campionario Ω, cioè un

elemento dell’insieme B (Algebra di Boole completa costruita su Ω), risulta facile

dimostrare le relazioni d uguaglianza (teoremi) seguenti:

12

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

P( E) = 1 − P(E)

P(E) ≤ 1

P(ø) = 0

E1 ⊂ E2 => P(E1) < P(E2)

P(E1 ∪ E2) = P(E1) + P(E2) - P(E1 ∩ E2)

L'ultima relazione, detta anche (impropriamente) principio delle probabilità totali, per

k eventi diventa

k

k

k +1

P E i = Σ P(E i ) − Σi Σ jP(E i ∩ E j ) + Σi Σ j Σ h P(E i ∩ E j ∩ E h ) + + (− 1) E i

i =1

i =1

e si riduce al postulato delle probabilità totali

k

P Ei =

i =1

k

∑ P(E )

i =1

i

quando i k eventi Ei sono tra loro incompatibili.

La probabilità per eventi condizionati o, più semplicemente, la probabilità

condizionata P(E1/E2) soddisfa ai primi cinque assiomi; infatti gli eventi condizionati

formano un’algebra di Boole, inoltre

P(E1/E) ≥ 0

P(E/E) = 1

P(E1 ∪ E2 ∪ .../E) = P(E1/E) + P(E2/E) +....

se gli eventi E1, E2,... sono incompatibili.

Inoltre

E1 ⊂ E2 => P(E1/E) ≤ P(E2/E)

P( E 1 /E) = 1 - P(E1/E)

13

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

P(E1 ∪ E2/E) = P(E1/E) + P(E2/E) - P(E1 ∩ E2/E)

Il principio delle probabilità composte; può riguardare anche un numero qualsiasi di eventi E1, E2, E3,..., si avrà allora

P(E1 ∩ E2 ∩ E3 ∩...) = P(E1).P(E2/E1).P(E3/E1 ∩ E2) ...

Si consideri una partizione dello spazio campionario Ω in k eventi

E1, E2, ... , Ei, ... , Ek; i k eventi sono necessari ed incompatibili, tali cioè da rispettare

k

E

le condizioni Ei ∩ Ej = ø per i ≠ j = 1, 2, ...,k e

i =1

i

= Ω. Se E è un evento

appartenente ad Ω si ha

k

k

E = E ∩ Ω = E ∩ ( Ei ) =

i =1

(E ∩ Ei)

i=1

e, per l'incompatibilità degli eventi Ei, anche

k

P(E) = P [ (E ∩ Ei)] =

i =1

k

∑

i =1

P(E ∩ Ei)

Inoltre, valendo le relazioni

P(E ∩ Ej) = P(Ej)P(E/ Ej) = P(Ej ∩ E) = P(E) P(Ej /E)

si avrà

P(Ej /E) =

=

P(E j )P(E / E j )

P(E)

P(E j )P(E/E j )

k

∑ P(E )P(E/E )

i

i

i =1

che viene detta formula di Bayes ed assume una rilevanza particolare quando i k eventi

Ei possono essere interpretati come possibili “cause” dell'evento E. In tale contesto,

14

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

P(Ej /E) viene detta probabilità a posteriori della causa Ej; mentre, P(Ej) rappresenta la

probabilità a priori della stessa causa e P(E/ Ej) è detta probabilità probativa o

verosimiglianza dell'evento E.

Ω

E1

E3

E4

E2

E

E5

Fig. 7 - Partizione dello spazio campionario Ω in cinque eventi E1, E2, E3, E4 ed E5

possibili cause dell’evento E

La formula di Bayes esprime in maniera molto semplice il processo di

apprendimento dall'esperienza in contesti non deterministici.

Della realtà si possiede una conoscenza probabilistica, che viene espressa in

termini di probabilità (a priori) P(Ej), queste probabilità si trasformano, al verificarsi

dell'evento E (acquisizione di ulteriori informazioni), nelle probabilità (a posteriori) P(Ej

/E).

Le probabilità condizionate si usano, quindi, per riassegnare le probabilità agli

eventi una volta che siano state acquisite ulteriori informazioni relative ad una

realizzazione parziale di un esperimento casuale.

Sapendo che si è realizzato un certo evento E1, non è detto che questo modifichi

necessariamente la probabilità di realizzarsi di un altro evento E2, può accadere cioè che

P(E2 / E1) = P(E2)

in tal caso si avrà anche (principio delle probabilità composte per eventi

indipendenti)

P(E2 ∩ E1) = P(E2) P(E1)

ed i due eventi E1 ed E2 si dicono indipendenti statisticamente (o indipendenti

stocasticamente, o indipendenti in probabilità).

15

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Più in generale, k eventi E1, E2, ... , Ek si dicono statisticamente (o stocasticamente o

probabilisticamente) indipendenti se

P(E i1 ∩ E i2 ∩ ... ∩ E i k ) = P(Ei1 ) ⋅ P(Ei2 ) ⋅ ...⋅ P(Eik )

per ogni sottoinsieme di eventi Ei1 ,˘ E i2 ,˘ ˘ , ˘ E is per s = 2, 3, 4, ... ,k . Ad esempio i

tre eventi E1, E2 ed E3 sono statisticamente indipendenti se valgono le relazioni

P(E1 ∩ E2) = P(E1) • P(E2)

P(E1∩ E3) = P(E1) • P(E3)

P(E2∩ E3) = P(E2) • P(E3)

P(E1∩ E2∩ E3) = P(E1) • P(E2) • P(E3)

Si deve sottolineare in proposito che le prime tre relazioni (indipendenze doppie)

non implicano la quarta (indipendenza tripla). Così come la quarta relazione non implica

le prime tre.

Prima di procedere all'introduzione di ulteriori concetti, conviene precisare ancora

una volta il ruolo che, in qualunque contesto di ricerca, viene svolto dalla statistica e

quello svolto dal calcolo delle probabilità.

Il calcolo delle probabilità si occupa dello studio degli esperimenti casuali, della

coerenza delle probabilità assunte dai vari eventi, della costruzione

di modelli

probabilistici su esperimenti casuali e sulle loro implicazioni. Mentre la statistica si

preoccupa di accertare se le effettive osservazioni, relative ad un determinato

esperimento o a una serie di esperimenti casuali, sono coerenti con il modello probabilistico assunto. Nella statistica, naturalmente, le osservazioni e le eventuali conoscenze a

priori sul fenomeno oggetto d'indagine possono essere utilizzate per la costruzione di un

modello probabilistico rappresentativo del fenomeno cui le osservazioni e le conoscenze

a priori si riferiscono.

L'uso delle conoscenze a priori nella statistica induttiva caratterizza la cosidetta

inferenza statistica bayesiana; che si distingue dalla inferenza statistica classica

proprio perchè questa ultima, basata sul presupposto della riproducibilità delle

esperienze, prefigura l'utilizzo delle sole informazioni campionarie.

16

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Se con Ip si indica l'insieme delle informazioni a priori, si può proporre una

rappresentazione schematica completa (cfr. Fig.8) di quanto si è andato dicendo fino a

questo momento dopo aver aggiunto, a completamento del quadro delineato, che il calcolo delle probabilità si occupa anche dello studio dell'universo o spazio dei campioni;

spazio questo costituito dall'insieme di tutti i possibili campioni estraibili da una

determinata popolazione.

F

f1(.)

.

.

fi(.)

.

P

R

SPAZIO o UNIVERSO

dei Campioni

DEDUZIONE

Calcolo

delle

Probabilità

t1(.)

.

ti(.)

.

tk(.)

C

Ip

Rc

R

INDUZIONE

Inferenza

Statistica

CLASSICA

BAYESIANA

Fig.8 - Rappresentazione grafica del processo di induzione statistica (classica e

bayesiana)

Dopo la sommaria indicazione delle operazioni proprie del calcolo delle

probabilità e dopo aver precisato che la tripletta (Ω, B, P(.)) [dove: Ω è lo spazio

campionario (cioè l’insieme di tutti i punti campionari ω1 , ω 2 ,... possibili risultati di un

esperimento casuale), B è l’algebra di Boole completa costruita su Ω e P(.) è una

funzione definita su B che gode di particolari proprietà], viene detta spazio di

probabilità o spazio probabilistico, si può procedere all'introduzione di due ulteriori

concetti che possono essere ritenuti fondamentali nello sviluppo sia del calcolo delle

probabilità sia della statistica. Il primo concetto è quello di "variabile casuale", il secondo è quello di "funzione di distribuzione".

17

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Definizione 5: Si dice variabile casuale, una funzione X (.) a valori reali definita sullo

spazio campionario Ω; cioè ogni funzione che, soddisfacendo ad

opportune condizioni (tali da preservare la struttura di B), associa ad

ogni punto dello spazio campionario un numero reale.

In termini più rigorosi, la funzione univoca X( ω ) definita su Ω è una variabile

casuale (o variabile stocastica, o variabile aleatoria o numero aleatorio) se vale la

relazione A = {ω ∈ Ω / X(ω ) ≤ x} ∈ B cioè se l’insieme A, costituito da tutti gli eventi

elementari ω per i quali il valore assunto dalla funzione X( ω ) è minore od uguale ad

un numero reale qualsiasi x , è un elemento di B, cioè un evento appartenente

all’algebra.

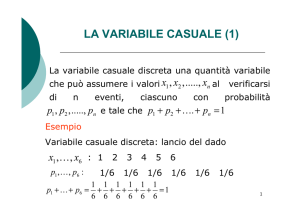

Le variabili casuali si distinguono in:

a) discrete, se il rango della funzione è costituito da un numero finito o da un'infinità

numerabile di numeri reali;

b) continue, se il rango della funzione è costituito da un insieme continuo (e quindi non

numerabile) di numeri reali.

Definizione 6: Si dice funzione di distribuzione (o funzione di ripartizione, o

funzione delle probabilità cumulate) della variabile casuale X, la

funzione F(x) definita dalla relazione

F(x) = P (X ≤ x)

dove: x rappresenta un numero reale qualunque; P (X ≤ x) misura la

probabilità con cui la variabile casuale X può assumere un valore

inferiore od uguale al numero reale x.

La funzione di distribuzione non rappresenta altro che la probabilità dell’evento A

definito in precedenza; infatti, P(A) = P[ω ∈ Ω / X(ω ) ≤ x] = P[X(ω ) ≤ x] = P( X ≤ x) .

18

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Se con x1, x2,...,xk, si indicano le possibili determinazioni distinte, ordinate in

modo crescente, di una certa variabile casuale discreta X e con p1, p2,...,pk, le

probabilità rispettive, si avrà

i

F(xi) = P(X ≤ xi) =

dove

∑

j =1

i

P(X = xj) =

∑

j =1

pj

pj = P(X = xj)

La funzione f(xi) che deriva dalla relazione f(xi) = F(xi) - F(xi-1) viene detta

funzione di massa di probabilità e, ovviamente, fornisce la probabilità che l’entità

variabile X ha di assumere la specifica determinazione xi ; infatti

F(xi) - F(xi-1) = P (X ≤ xi) - P (X ≤ xi-1) = P(X = xi)

per i = 1, 2, ... , k .

Nel caso in cui la variabile X sia continua, e la F(x) sia una funzione

assolutamente continua (si supporrà, da ora in poi e per tutte le F(x),

che tale

condizione sia soddisfatta), esisterà la derivata

f(x) =

d F( x)

dx

Si ricorda in proposito che le funzioni assolutamente continue sono funzioni

continue e derivabili (quasi ovunque).

La funzione f(x) così definita viene detta funzione di densità di probabilità o più

semplicemente funzione di densità. Si avrà quindi anche

∫

X

−∞

f(y) dy = F(x).

Evidentemente, f(x) dx = dF(x), rappresenta la probabilità con cui una variabile casuale

continua X assume valori all'interno dell'intervallino infinitesimo x − x+dx.

Va rilevato che le funzioni di distribuzione, e quindi le corrispondenti

(corrispondenza biunivoca) funzioni di massa di probabilità, nel discreto, di densità di

probabilità, nel continuo, che identificano completamente le variabili casuali cui si

riferiscono, sono caratterizzate da specifici valori (entità di riferimento) dette parametri. Per evidenziare tale fatto, si usa la notazione

19

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

F(x; θ1;θ2,...,θµ) ; f(x; θ1;θ2,...,θµ)

dove i simboli θ1;θ2,...,θµ indicano i parametri caratteristici della funzione (modello

probabilistico).

Ripercorrendo il processo che ha portato alla definizione della funzione di

distribuzione, della funzione di massa e di densità di probabilità, risulta immediata

l’individuazione delle proprietà che tali funzioni soddisfano.

Si supponga che la variabile casuale discreta X possa assumere le determinazioni

x1, x2,..., xi, ... , xk, (dove: xi< xi+1 e k può anche tendere al valore +∞) e che la variabile

casuale continua X risulti definita nell’intervallo dell’asse reale ab(dove:

a < b, a può tendere al valore -∞ e b tendere al valore +∞), allora la funzione di

distribuzione F(x):

1.

assume valori nell’intervallo unitario

0 ≤ F(x) ≤ 1

2.

il limite sinistro assume valore zero

lim F(x) = 0

x→−∞

3.

il limite destro assume valore uno

lim F(x) = 1

x→+∞

4.

è monotona non decrescente

5.

è continua a destra nel caso discreto (i punti di discontinuità si collocano in

corrispondenza dei valori x1, x2,..., assunti dalla variabile) è assolutamente

continua (continua e derivabile quasi ovunque) nel caso continuo.

La funzione di massa di probabilità f(xi) , essendo una probabilità gode delle

proprietà già considerate relativamente a tale entità, inoltre

k

∑ f (x ) = 1

i =1

i

.

La funzione di densità f(x) soddisfa le condizioni

f(x) ≥ 0

20

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

b

∫ f ( x)dx = 1

a

Da quanto è stato detto, risulta che una variabile casuale rimane individuata

completamente dalla sua funzione di distribuzione (o di massa o di densità di

probabilità) e che essa rappresenta una formalizzazione astratta (modello) dell'insieme

delle possibili manifestazioni di un certo fenomeno avente natura aleatoria.

Per particolari esigenze scientifiche ed operative si può essere interessati

all’effettuazione di una rappresentazione sintetica delle manifestazioni di un certo

fenomeno mediante indici caratteristici. Può, cioè, risultare conveniente, o sufficiente,

descrivere una variabile casuale con degli indici caratteristici, anzichè procedere ad

una sua rappresentazione completa mediante la funzione di distribuzione, la funzione di

massa o la funzione di densità di probabilità.

Un modo di pervenire alla sintesi di una variabile casuale X è quello di procedere

al calcolo del valore atteso E(.) di particolari trasformazioni Y = g(X) della variabile

casuale stessa. In questa sede si considerano solo le trasformazioni che portano alla

definizione di una nuova variabile casuale; se, ad es., X è una v.c. continua con funzione

di densità f(x), anche Y =g(X) è una variabile casuale, discreta o continua, la cui

funzione di densità f(y) o di massa di probabilità f(yi) potrà essere derivata attraverso

appropriate trasformazioni della funzione di densità f(x).

Definizione 7: Si definisce valore atteso di una trasformazione g(X) di una variabile

casuale X , con funzione di distribuzione F(x) , la quantità definita dalla

relazione

k

E [g (X )] = ∑ g (xi ) f (xi )

nel discreto

E [g (X )] = ∫ g (x ) f (x )dx

nel continuo

i 01

dove f (xi ) è la funzione di massa di probabilità della variabile casuale discreta X che

assume il valore xi con probabilità f (xi ), per i = 1, 2, ..., k ; mentre f (x ) è la funzione

di densità di probabilità della variabile casuale continua X , definita nell’intervallo ab.

Si può osservare come l’operatore valore atteso non richieda la derivazione della

funzione di densità o di massa di probabilità della variabile casuale trasformata Y =

21

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

g(X) e goda della proprietà di linearità; infatti, per qualunque variabile X, con funzione

f(xi) nel discreto, f(x) nel continuo, date due costanti a , b e due trasformazioni g1(X) e

g2(X) ancora variabili casuali

[

]

[

E{ag 1 ( X) + bg 2 ( X)} = a E g 1 ( X) + b E g 2 ( X)

]

come si può verificare facilmente osservando le relazioni sotto riportate

k

[

]

k

k

i =1

i =1

E{ag 1 ( X) + bg 2 ( X)} = ∑ ag 1 ( x i ) + bg 2 ( x i ) f ( x i ) =

i =1

[

]

[

= a ∑ g 1 ( x i ) f ( x i ) + b ∑ g 2 ( x i ) f ( x i ) = a E g 1 ( X) + b E g 2 ( X)

]

nel discreto e

b

[

] [

]

E ag 1 ( X) + bg 2 ( X) = ∫ ag 1 ( x) + bg 2 ( x) f ( x)dx =

a

b

b

a

a

[

]

[

= a ∫ g 1 ( x)f ( x)dx + b ∫ g 2 ( x)f ( x)dx = a E g 1 ( X) + b E g 2 ( X)

]

nel continuo.

Ponendo g(X) = Xr per r = 0, 1, 2 , ... si ha

k r

∑ x i f ( x i ) nel discreto

µ r = E[g( X)] = E ( X r ) = i =1

b

x r f ( x)dx nel continuo

∫a

che viene detto momento r-esimo rispetto all’origine o momento di ordine r rispetto

all’origine. Da rilevare che il momento di ordine 0

k

∑ f ( x i ) = 1 nel discreto

µ 0 = E ( X 0 ) = i =1

b

f ( x)dx = 1 nel continuo

∫

a

è assolutamente non significativo risultando, almeno nelle condizioni qui prefigurate,

sempre uguale ad uno per qualunque variabile casuale.

Particolare rilevanza assume il momento di ordine uno.

22

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

k

∑ x i f ( x i ) nel discreto

µ = µ 1 = E[g( X)] = E( X) = i =1

b

xf ( x)dx nel continuo

∫

a

che viene detto anche media aritmetica della variabile casuale ed è l’indice sintetico

(indice caratteristico) più utilizzato per mettere in evidenza quanto c’è di tipico nella

variabile casuale. Altri momenti di un certo rilievo sono il momento secondo µ 2 , il

momento terzo µ 3 ed il momento quarto µ 4 che evidenziano, come si avrà modo di

sottolineare nelle righe successive, la loro rilevanza in contesti diversi di sintesi delle

variabili casuali.

Ponendo g(X) = ( X − µ ) r , per r = 0, 1, ... , dove µ = µ 1 = E( X) è il momento

primo rispetto all’origine (media aritmetica) della variabile casuale X , si avrà

k

r

∑ ( x i − µ) f ( x i ) nel discreto

r

µ r = E[g (X)] = E[(X − µ) ] = i =1

b

( x − µ) r f ( x )dx nel continuo

∫

a

che viene detto momento centrale r-esimo o momento di ordine r rispetto alla media

(aritmetica).

Oltre al momento di ordine zero, non presenta alcuna rilevanza anche il momento

di ordine uno; infatti

µ 1 = E[g( X)] = E[( X − µ )] = E( X) − E(µ ) = µ − µ = 0

dove non si è più proceduto, essendo fatto ormai acquisito, alla esplicitazione del valore

atteso in termini di sommatoria o di integrale.

La trasformazione g(X) = ( X − µ) si risolve con una traslazione dell’origine nel

punto medio. La variabile casuale trasformata si indica usualmente con il simbolo

S x = ( X − µ ) e viene detta variabile casuale scarto. Qualunque variabile casuale scarto

ha, pertanto, il momento primo sempre uguale a zero; cioè la media aritmetica di una

qualunque variabile casuale scarto è uguale a zero.

Il momento centrale di ordine due

µ 2 = E[g( X)] = E[( X − µ ) 2 ] =

= E( X 2 + µ 2 − 2µX) = E( X 2 ) + E(µ 2 ) − 2µE( X) =

23

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

= µ 2 + µ 2 − 2µ 2 = µ 2 − µ 2 = σ 2

viene denominato varianza ed assume una rilevanza tutta particolare in quanto è

l’indice più utilizzato per sintetizzare la variabilità di una variabile casuale. Da

sottolineare che il momento centrale di ordine due µ 2 , cioè la varianza σ 2 , è uguale al

momento secondo rispetto all’origine (µ 2 ) meno il quadrato del momento primo

rispetto all’origine (µ 2 ) .

Essendo la media (aritmetica) e la varianza gli indici caratteristici più utilizzati

per sintetizzare in un solo valore, rispettivamente, la tipicità e la variabilità di una

variabile casuale, si incontrano spesso situazioni in cui interessa valutare l’effetto sulla

media e sulla varianza di particolari trasformazioni di variabili casuali. Interessa, ad

esempio, in molti contesti di ricerca procedere ad una trasformazione lineare

(cambiamento del sistema di riferimento che si risolve nella traslazione dell’origine e

nel cambiamento dell’unità di misura con cui è espressa la variabile) della variabile X

Y = a + bX

Se con µ x e σ 2x si indicano rispettivamente la media e la varianza della variabile

casuale X , la media e la varianza della variabile casuale trasformata Y risultano dalla

relazione

µ y = E(Y) = E(a + bX) = a + bµ x

cioè, la media di una trasformazione lineare di una variabile casuale è uguale alla

trasformazione lineare della media della variabile casuale originaria.

σ 2y = E[(Y − µ y ) 2 ] = E[(a + bX − a − bµ x ) 2 ] =

[

]

[

]

= E ( bX − bµ x ) 2 = b 2 E ( X − µ x ) 2 = b 2 σ 2x

cioè, la varianza di una trasformazione lineare di una variabile casuale è pari alla

varianza della variabile casuale originaria moltiplicata per il quadrato del coefficiente

angolare della trasformazione.

X − µ

Ponendo g(X) =

σ

r

24

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

dove: µ è il momento primo (media aritmetica) della variabile casuale X e σ la radice

quadrata positiva della sua varianza σ 2 , si ha

k x i − µ r

f ( x i ) nel discreto

X − µ r ∑

σ

i =1

per r = 1, 2, ...

=

µ r = E[g (X)] = E

r

b x − µ

σ

f ( x )dx nelcontinuo

∫a σ

che viene detto momento standardizzato r-esimo o momento standardizzato di ordine r .

La trasformazione (lineare), standardizzazione

Zx =

X−µ

µ 1

=− + X

σ

σ σ

è particolarmente rilevante in quanto oltre a procedere alla traslazione nel punto medio

si utilizza come nuova unità di misura il valore assunto dall’indice caratteristico di

variabilità σ che prende il nome di scostamento quadratico medio.

(

)

(

)

Oltre ai momenti standardizzati di ordine zero µ 0 = 1 e di ordine uno µ 1 = 0

anche il momento standardizzato di ordine due è del tutto irrilevante; infatti

[

]

X − µ 2

1

1

2

µ 2 = E

= 2 E ( X − µ) = 2 ⋅ σ 2 = 1

σ

σ σ

cioè, per qualunque variabile casuale il secondo momento standardizzato è uguale a uno.

Particolare rilevanza assumono, invece, il momento terzo standardizzato

[

X − µ 3 E ( X − µ )

µ 3 = E

=

σ3

σ

3

]= µ

σ

3

3

= γ1

che misura la simmetria (rispetto al valore centrale) delle distribuzioni, ed il momento

quarto standardizzato

[

X − µ 4 E ( X − µ )

µ 4 = E

=

σ4

σ

4

]= µ

σ

4

4

= γ2

che misura la curtosi (appiattimento rispetto alla distribuzione normale che verrà

analizzata nelle pagine successive) della distribuzione.

25

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Sui due indici di simmetria ( γ 1 ) e di curtosi ( γ 2 ) si avrà modo di tornare

successivamente, dopo aver parlato della variabile casuale normale, mentre risulta

conveniente definire altri due indici caratteristici molto usati per sintetizzare gli aspetti

di tipicità delle variabili casuali.

Il primo indice caratteristico che si considera è la moda di una variabile casuale.

Si definisce come moda ( M o ) di una distribuzione il valore della modalità cui

corrisponde la probabilità (nel caso discreto) o la densità di probabilità (nel caso

continuo) più elevata.

Quando il massimo non è unico si parla di distribuzioni plurimodali; concetto

questo che può essere esteso anche a situazioni in cui si considerano non solo il

massimo assoluto (della probabilità o della densità di probabilità) ma anche i massimi

relativi (massimi locali).

Il secondo indice caratteristico che serve ad evidenziare la tipicità delle variabili

casuali è la mediana. Si definisce come mediana ( M e ) di una variabile casuale

continua il valore centrale della distribuzione stessa; cioè il valore della modalità

rispetto a quale si registra una probabilità pari a 0,50 di valori inferiori e pari a 0,50 di

valori superiori.

Si può aver interesse alla individuazione di altri valori (segnaletici) particolari. Se

la variabile casuale è continua, il valore che è preceduto dal 25% dei casi e seguito dal

75% dei casi (Q1 ) e quello preceduto dal 75% dei casi e seguito dal 25% dei casi (Q 3 ) .

I valori Q1 e Q 3 vengono detti, rispettivamente, primo e terzo quartile; ovviamente il

secondo quartile Q 2 è uguale alla Mediana. In generale il p-esimo quantile, con 0 < p <

1 ,è il valore, usualmente indicato con Qx(p), che soddisfa la relazione P[ X ≤ Qx(p) ] =

p.

Per le variabili casuali continue è possibile operare la suddivisione con una

proporzione esatta p di casi a sinistra ed una proporzione (1-p) esatta di casi a destra

di Qx(p) mentre ciò non è sempre possibile per le variabili casuali discrete. Infatti, per

le variabili casuali discrete la massa di probabilità del punto x = Qx(p) può essere

diversa da zero, pertanto, la proporzione di valori a sinistra di Qx(p) può essere ≤ p e la

proporzione di valori a destra di Qx(p) può essere ≤ (1-p) . Può accadere, cioè, che non

esista alcun valore x per il quale F(x) = p, il quantile viene comunque facilmente

individuato in corrispondenza del valore Qx(p) nel quale si riscontra il salto della

26

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

funzione di distribuzione (da un valore inferiore a p ad un valore superiore a p ).

Inoltre, sempre per le variabili casuali discrete può accadere che la relazione F(x) = p

valga per un intervallo di valori di x , in questo caso il quantile si ottiene calcolando la

semisomma degli estremi dell’intervallo.

Variabili casuali di uso più frequente.

Alcuni modelli probabilistici (tipi specifici di variabili casuali) si sono dimostrati

particolarmente utili in vari campi della ricerca applicata. Tra questi, ne vengono

presentati alcuni, tra quelli più comunemente usati, facendo riferimento al tipo di

distribuzione ad essi associata.

DISTRIBUZIONI DISCRETE

Distribuzione binomiale

La distribuzione binomiale si usa quando si è interessati al numero delle volte con

cui un certo evento E si presenta in n ripetizioni indipendenti di un esperimento casuale.

Se con P(E) = p si indica la probabilità che ha l'evento di presentarsi in una

singola prova, 1 - p = q rappresenterà la probabilità contraria, cioè la probabilità del non

verificarsi dell'evento.

Si consideri ora la variabile casuale X ( = numero delle volte in cui l'evento E si

presenta nelle n prove). Per n = 1 si avrà che la variabile casuale X, detta variabile

casuale di Bernoulli, potrà assumere unicamente i due valori 0 e 1, con probabilità

rispettive

P (X = 0) = q = 1 - p , P (X = 1) = p

La corrispondente funzione di massa assume i valori f(0) = q e f(1) = p, e può

essere espressa dalla formula

f(x) = f(x;p) = px q1-x

27

per x = 0, 1

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Per n qualsiasi, si avrà che la variabile casuale X potrà assumere i valori 0, 1, 2,...,n, si

tratta cioè di una funzione che associa ad ogni possibile successione di successi ed

insuccessi in n prove indipendenti, il numero x di successi che nelle n prove stesse si

sono verificati. La probabilità di x successi P(X = x) = f(x), cioè la funzione di massa di

probabilità è data da

n

f(x) = f(x;n,p) = p x q n − x

x

n

dove rappresenta il numero di permutazioni con ripetizione di n oggetti di cui x e

x

(n-x) sono uguali tra loro che coincide con il numero delle combinazioni di n oggetti x

a x, cioè

n

n!

=

x x !( n − x)!

L'interpretazione della formula della funzione di massa di probabilità della

variabile casuale binomiale è immediata: la probabilità di una specifica successione di x

successi e (n-x) insuccessi indipendenti è pari a (principio delle probabilità composte

per eventi indipendenti)

p ⋅ p p p

x volte

q ⋅ q q = p x q n − x ;

( n − x ) volte

non essendo interessati all'ordine di presentazione dei successi, ma solo al loro numero,

tali probabilità dovranno essere sommate (principio delle probabilità totali per eventi

incompatibili) tante volte quante sono le permutazioni di n oggetti di cui x ed

(n-x) sono uguali tra loro.

Il nome di variabile casuale binomiale deriva dal fatto che i valori della funzione

f(x) rappresentano i termini dello sviluppo del binomio di Newton. Ovviamente la

28

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

somma delle probabilità relative a tutti i possibili valori assunti dalla variabile casuale

binomiale (come per qualunque variabile discreta) è uguale ad uno; infatti

n

n

∑ x p

x =0

x

q n − x = (p + q ) n = 1n = 1

La media e la varianza della distribuzione binomiale sono date rispettivamente

dalle uguaglianze

n

n

n

µ = ∑ x f ( x; n, p) = ∑ x p x q n − x = np

x

x=0

x=0

n

n

n

σ 2 = ∑ ( x − µ ) 2 f ( x; n, p) = ∑ ( x − np) 2 p x q n − x = npq

x

x=0

x=0

Esempio 1.

Assumendo che la probabilità di nascita di un maschio o una femmina sia uguale,

cioè p = 1-p = 0,5, si vuol determinare la probabilità che in una famiglia con quattro

figli vi sia: a) Almeno un maschio, b) almeno un maschio ed una femmina.

a) - Poichè si ha

4

1

P (0 maschi) = 0 ,5 0 0 ,5 4 =

16

0

1

4

P (1 maschio) = 0,51 0,53 =

4

1

3

4

P (2 maschi) = 0,5 2 0,5 2 =

8

2

1

4

P (3 maschi) = 0,53 0,51 =

4

3

29

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

1

4

P (4 maschi) = 0,5 4 0,5 0 =

16

4

la probabilità che nella famiglia vi sia almeno un maschio sarà fornita dall'espressione

P (almeno un maschio) = P (1 maschio) + P (2 maschi) + P (3 maschi) + P (4 maschi) =

1 3 1 1 15

+ + +

=

4 8 4 16 16

Una soluzione più rapida si ottiene se si considera l'evento contrario (nessun maschio) a

quello che interessa (almeno un maschio), si determina poi la probabilità del suo

verificarsi che sottratta alla unità fornisce il risultato; si avrà

P ( almeno un maschio ) = 1 - P ( nessun maschio) =

1 15

4

= − 0,5 0 0,5 4 = 1 −

=

16 16

0

b) - Per rispondere al quesito si può seguire la seconda via sopra indicata; si avrà

P ( almeno un maschio ed una femmina ) =

= 1 - P ( nessun maschio ) - P (nessuna femmina) =

1−

1

1 14 7

−

=

=

16 16 16 8

Esempio 2

In una serie di esperimenti su cavie è stata riscontrata una mortalità del 60%.

Volendo predisporre un ulteriore esperimento in modo tale che, con una probabilità

superiore all'80%, almeno due animali sopravvivano, si chiede quale dovrà essere il

numero minimo di cavie da sottoporre ad esperimento. In altri termini si dovrà ricercare

30

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

il più piccolo n (numero di cavie da sottoporre ad esperimento) capace di soddisfare la

disuguaglianza.

P (X ≥ 2) > 0,80

dove X sta per il numero di cavie che sopravvivono all'esperimento.

Nella distribuzione binomiale per p = 0,4 (probabilità di successo; e nel caso

specifico successo significa cavia sopravvissuta) ed n = 7, si ha

7

7

P(X ≥ 2) = 1 − P(X = 0) − P(X = 1) = 1 − 0,40 0 0,60 7 − 0,401 0,60 6 = 0,84

0

1

Per p = 0,4 ed n = 6, si ha

6

6

P(X ≥ 2) = 1 − P(X = 0) − P(X = 1) = 1 − 0,40 0 0,60 6 − 0,401 0,60 = 0,77

0

1

Il numero minimo di cavie da sottoporre ad esperimento dovrà quindi essere pari a 7.

Distribuzione ipergeometrica

Per

introdurre

la

distribuzione

ipergeometrica

conviene

riprendere

in

considerazione la distribuzione binomiale proponendo un'interpretazione che si rifà al

linguaggio dell'estrazione casuale da un'urna.

Si consideri un'urna contenente N palline, di cui K siano bianche e N - K nere. La

probabilità di estrarre pallina bianca in una prova sarà p =

K .

N

Se si effettuano n estrazioni con ripetizione (cioè con reinserimento della pallina

nell’urna) la probabilità di ottenere esattamente x palline bianche, nelle n prove, è data

da

31

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

n K

K

P ( X = x ) = f ( x) = 1 −

N

x N

x

n−x

n

= p x q n− x

x

Quanto detto mostra come l'estrazione con ripetizione (campionamento

bernoulliano) conduce alla distribuzione binomiale. Si ammetta ora di effettuare le n

estrazioni, senza rimettere ogni volta la pallina estratta nell'urna (campionamento

esaustivo o campionamento senza ripetizione); in questa situazione la probabilità di

estrarre esattamente x palline bianche è data da

K N − K

x n − x

f ( x ) = f ( x; n , K , N ) =

N

n

per max [ 0,n - (N - K) ] ≤ x ≤ min [n, K]

Infatti, se n > K, X potrà assumere al massimo il valore K, inoltre se

n > N - K, il valore minimo che X può assumere sarà pari a n - (N - K).

Naturalmente

n

∑

x=0

K N − K

n

x n − x

f ( x; n, K, N ) = ∑

=1

N

x=0

n

La media e la varianza, della distribuzione che ha la funzione di massa sopra

indicata e che viene detta ipergeometrica, sono date rispettivamente da

K N − K

n

n

x n − x

K

µ = ∑ x f ( x; b, K, N ) = ∑ x

= n ⋅ = np

N

N

x=0

x=0

n

32

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

K N − K

nk x n − x N − n K

K

N−n

2

2

n ⋅ 1 − = npq

σ = ∑ ( x − µ) f ( x; n , K , N ) = ∑ x −

=

N

N −1

N

N

N −1

N

x =0

x =0

n

n

Il fattore

2

n

N−n

(≤ 1) viene usualmente detto fattore di correzione per il

N −1

campionamento senza ripetizione.

Distribuzione di Poisson

La distribuzione che ha la funzione di massa di probabilità

f ( x) = f ( x; λ ) =

λx e − λ

x!

per x = 0, 1, ...

(dove e è la costante di Nepero e λ un numero reale positivo) è detta distribuzione di

Poisson. Naturalmente la somma delle probabilità, per questa particolare variabile

casuale discreta che può assumere l'infinità (numerabile) di valori diversi 0, 1, 2,...

pari ad 1

∞

λx e − λ

=1

x!

x=0

∞

∑ f ( x; λ ) = ∑

x=0

Si dimostra che

λx e − λ

µ = ∑ xf ( x; λ ) = ∑ x

=λ

x!

x=0

x=0

∞

∞

∞

∞

x=0

x=0

σ = ∑ ( x − µ ) 2 f ( x; λ ) = ∑ ( x − λ ) 2

2

33

λx e − λ

=λ

x!

,è

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Dalle uguaglianze sopra riportate risulta che il parametro, caratterizzante la

distribuzione di Poisson, coincide con la media e la varianza della variabile casuale ad

esso associata.

La distribuzione di Poisson ha importanti applicazioni anche perchè essa

rappresenta una conveniente approssimazione della distribuzione binomiale nel caso in

cui il numero delle prove n sia abbastanza elevato e le probabilità che l'evento si

presenti in una singola prova sia sufficientemente prossima allo 0.

Alcune

considerazioni

sull'applicazione

delle

distribuzioni:

binomiale,

ipergeometrica e di Poisson.

La distribuzione binomiale può essere considerata un'eccellente modello

probabilistico per molte situazioni sperimentali. Infatti, tale distribuzione può servire

per studiare ad es. l'atteggiamento dei cittadini nei confronti di un determinato

provvedimento legislativo (favorevoli o contrari alla elezione diretta del Presidente della

Repubblica), per analizzare la produzione di un determinato macchinario (pezzi regolari

e pezzi difettosi) ecc. Serve cioè, in generale, nello studio di tutti quei fenomeni che

possono essere caratterizzati da un evento che può realizzarsi o meno: "successo" o

"insuccesso"; dove, successo vuol dire estrazione di pallina bianca, essere favorevole

alla elezione diretta del Presidente, pezzo regolare, ecc., mentre insuccesso vuol dire

estrazione di pallina nera, essere contrari alla elezione diretta, pezzo difettoso, ecc.

La distribuzione ipergeometrica ha lo stesso campo di applicabilità della

distribuzione binomiale, e dovrà essere ad essa sostituita tutte le volte che gli eventi

relativi alle singole prove non possono essere considerati indipendenti.

L'esperienza mostra che l'applicazione della distribuzione di Poisson in svariati

campi dell'analisi conduce a dei risultati piuttosto soddisfacenti. Si consideri ad es. il

numero delle particelle emesse da una sostanza radioattiva in un certo intervallo di

tempo e si indichi tale numero con X, si potrà accertare che, per un conveniente valore

di λ, la variabile casuale X ha una distribuzione di probabilità approssimativamente

poissoniana. Si pensi ancora al numero di difetti riscontrabili in un manufatto, al numero

delle chiamate telefoniche in un certo intervallo di tempo, al numero degli arrivi, sempre

34

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

in un determinato intervallo di tempo, a un casello autostradale o a uno sportello

bancario. In tutti questi casi si può pensare ad un processo di generazione di numeri

casuali (difetti, chiamate, ecc.) in un determinato intervallo temporale o spaziale,

approssimativamente poissoniano.

Altre distribuzioni discrete frequentemente usate sono: la distribuzione

geometrica e la distribuzione binomiale negativa.

35

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

DISTRIBUZIONI CONTINUE

Distribuzione normale.

La distribuzione normale, o gaussiana, o degli errori accidentali, può essere

considerata la più importante tra le distribuzioni continue, soprattutto per le seguenti

ragioni:

a) una vasta serie di esperimenti casuali ha associata una variabile casuale la cui

distribuzione è approssimativamente normale;

b) alcune variabili casuali che non sono distribuite normalmente, possono essere rese

tali mediante trasformazioni relativamente semplici;

c) alcune distribuzioni relativamente complicate, possono essere approssimate

sufficientemente bene dalla distribuzione normale;

d) alcune variabili casuali, che sono alla base di procedure per la verifica di ipotesi

statistiche o per la determinazione di intervalli di stima, o sono distribuite

normalmente o derivano da tale distribuzione.

Si deve, comunque, sottolineare che in passato si è esagerato sull'importanza, pure

notevolissima, della distribuzione normale. Un tale fatto è derivato soprattutto dal ruolo

fondamentale che la distribuzione ha giocato nella "teoria degli errori accidentali" e

che ha spinto diversi studiosi a ritenere che essa potesse riguardare praticamente tutti i

fenomeni naturali. In realtà, la giustificazione teorica del ruolo importantissimo che

svolge la distribuzione normale nella ricerca scientifica risiede soprattutto nel “teorema

del limite centrale” o “teorema centrale del limite”; di questo teorema si tratterà in

seguito.

La funzione di densità di probabilità della distribuzione normale è

f ( x ) = f ( x; µ ,σ 2 ) =

1

2πσ 2

e

1 x−µ

−

2 σ

Ovviamente

36

2

per -∞ ≤ x ≤ +∞

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

∫

+∞

−∞

f (x; µ; σ2 )dx = 1

Si controlla facilmente che la distribuzione normale è simmetrica e che ha il

massimo nel punto x =µ. Si dimostra inoltre che i due parametri caratteristici µ e σ2

corrispondono proprio alla media (momento primo rispetto all’origine) e alla varianza

(momento secondo rispetto alla media) della distribuzione.

÷∞

µ = ∫ x f ( x; µ ,σ 2 )dx

−∞

σ2 =

∫

+∞

−∞

( x − µ) 2 f ( x; µ, σ 2 )dx

Il momento terzo ed il momento quarto standardizzati (indice di simmetria e

indice di curtosi) sono dati rispettivamente, da:

3

x −µ

2

γ1 = µ 3 = ∫

f ( x; µ, σ )dx = 0

−∞

σ

+∞

4

x −µ

2

γ2 = µ4 = ∫

f ( x; µ, σ )dx = 3

−∞

σ

+∞

Ovviamente, essendo la distribuzione normale simmetrica, l’indice γ1 assume

valore zero. L’indice assume, invece, valore negativo in caso di asimmetria a sinistra,

valore positivo in caso di asimmetria a destra, della distribuzione (cfr. Fig. 9).

Mentre l’asimmetria è definita in termini assoluti, la curtosi è concetto relativo;

infatti, si può affermare che una distribuzione è platicurtica o leptocurtica solo se si fa

riferimento alla distribuzione normale. Essendo per quest’ultima distribuzione il valore

assunto dall’indice di curtosi pari a tre, si dirà platicurtica la distribuzione con valore

dell’indice γ2 inferiore a tre, leptocurtica la distribuzione con valore dell’indice γ2

maggiore di tre (cfr. Fig. 9).

37

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Asimmetria positiva

γ1 > 0

Asimmetria negativa

γ1 < 0

µ Me Mo

Mo Me µ

Distribuzione leptocurtica

γ2 > 3

Distribuzione normale

γ2 = 3

Distribuzione platicurtica

γ2 < 3

Fig. 9 - Forma delle distribuzioni

La funzione di distribuzione della variabile casuale normale è:

F(x) = P(X ≤ x) =

∫

1

x

−∞

2 πσ 2

e

−

1

2σ2

(y − µ ) 2

Ricorrendo alla variabile casuale standardizzata Z =

F(z) = P(Z ≤ z) =

1

2π

∫

z

−∞

e

1

− y2

2

dy

x−µ

si ha

σ

dy

i cui valori sono stati tabulati.

Si ricorda che tutte le variabili casuali espresse in forma standardizzata hanno

valore medio nullo e varianza pari ad 1.

Tenendo presente che

b − µ

a − µ X − µ b − µ

a−µ

F( b) − F(a ) = P(a < X ≤ b) = P

<

≤

= P

<Z≤

σ

σ

σ

σ

σ

Se si pone a = µ - σ e b = µ + σ si avrà, utilizzando le tavole della distribuzione normale

38

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

standardizzata, che

P (µ - σ< X ≤ µ + σ) = P(-1 < Z ≤ 1) ≈ 0,68

per a = µ - 2σ e b = µ + 2σ si ha

P (µ - 2σ < X ≤ µ + 2σ) = P(-2 < Z ≤ 2) ≈ 0,955

Per a = µ - 3σ e b = µ + 3σ si ha

P (µ - 3σ < X ≤ µ + 3σ) = P(-3 < Z ≤ 3) ≈ 0,997

Le relazioni sopra scritte

portano a concludere che per qualunque variabile

casuale normale:

- circa i due terzi dei valori, sono contenuti nell'intervallo (µ - σ)(µ + σ);

- circa il 95% dei valori, sono contenuti nell'intervallo (µ - 2σ)(µ + 2σ);

- circa il 99,7% dei valori (praticamente tutti), sono contenuti nell'intervallo

(µ - 3σ)(µ + 3σ).

Ragionando in termini analoghi si ottiene

P (µ - 1,96σ < X ≤ µ + 1,96σ) = 0,95

P (µ - 2,58σ < X ≤ µ + 2,58 ) = 0,99

P (µ - 3,29σ < X ≤ µ + 3,29σ) = 0,999

Si dimostra che, per n sufficientemente grande, la distribuzione binomiale, la cui

funzione di massa di probabilità è, come già detto pari a

n

f ( x; n, p) = p x q n − x

x

può essere approssimata abbastanza bene dalla distribuzione normale con valore medio

µ = np e con varianza σ2 = npq; cioè, dalla distribuzione normale con funzione di

densità di probabilità

39

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

1

( x − np ) 2

−

1

2 npq

e

2 πnpq

f ( x) =

Esempio 3.

Sia X una variabile casuale normale di media µ = -2 e varianza σ2 = 0,25; si vuol

determinare il valore della costante c in modo da soddisfare le relazioni:

a)

P (X ≥ c) = 0,2;

c)

P (-c ≤ X ≤ c) = 0,95; d)

b)

P (-c ≤ X ≤ -1) = 0,5;

P (-2-c ≤ X ≤ -2+c) = 0,9.

Utilizzando la tavola, in cui sono riportati i valori della funzione di distribuzione

della variabile casuale normale standardizzata, si ottengono i seguenti risultati:

c + 2

c + 2

c + 2

X − µ c − µ

a ) − P ( X ≥ c) = P

≥

= P Z ≥

= 1 − P Z <

= 1 − F

= 0,2 ⇔

σ

0,5

0,5

0,5

σ

c + 2

c+2

⇔ P Z ≤

= 0 ,842 ⇔ c = 1,579

= 0 ,8 ⇔

0 ,5

0 ,5

− c + 2

− c + 2 X − µ −1+ 2

−c+2

b) − P (−c ≤ X ≤ −1) = P

≤

≤

≤ Z ≤ 2 = P(Z ≤ 2 ) − P Z <

= P

=

0,5

0,5

σ

0,5

0,5

2−c

2−c

2−c

= F ( 2 ) − F

= − 0,057 ⇒ c = 2,0285

= 0 ,5 ⇔ F

= 0, 4772 ⇒

0,5

0,5

0 ,5

c + 2

− c + 2

− c + 2 X − µ c + 2

−c+2

c ) − P ( −c ≤ X ≤ c ) = P

≤

≤

≤Z≤

= P

= 2 P Z <

− 0,5 =

0,5

0,5

0,5

σ

0,5

0,5

c+2

c+ 2

2+ c

= 2 F

= 1,96 ⇒ c = − 1,02

− 1 = 0,95 ⇔ F

= 0,975 ⇒

0 ,5

0 ,5

0 ,5

c

c

−c X−µ

−c

d ) − P ( −2 − c ≤ X ≤ − 2 + c ) = P

≤

≤

≤Z≤

= P

= P ( Z ≤ 2c) − P ( Z < 2c ) =

0,5

0,5

σ

0,5

0,5

= F( 2 c ) − F ( − 2 c ) = 0,9 ⇒ 2 c = 1,645 ⇒ c = 0,823

Esempio 4.

Si supponga che le lamine d'acciaio prodotte da una certa industria debbano avere

un determinato spessore e che la produzione subisca delle piccole variazioni (in termini

40

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

di spessore) aventi carattere accidentale. Il fenomeno, spessore delle lamine d'acciaio

prodotte,

può

essere

convenientemente

rappresentato

mediante

un

modello

probabilistico di tipo normale. Sia X la variabile casuale normale che interessa e si

ammetta di conoscere la sua media µ = 10 mm. e la sua varianza σ2 = 0,0004. Si vuol

determinare la percentuale attesa di lamine difettose supposto che:

a) Siano difettose le lamine con spessore inferiore a 9,97 mm.;

b) siano difettose le lamine con spessore superiore a 10,05 mm.;

c) siano difettose le lamine che si discostano dalla media per più di |0,03| mm.

Si chiede inoltre:

d) Quale valore dovrebbe assumere la costante c affinchè la percentuale attesa di

lamine che si discosta da 10 mm. per una quantità non superiore a c sia pari a 0,05;

e) come varierebbe la percentuale attesa di cui al punto d) e,relativamente al

valore della costante |c| trovato, nel caso in cui si avesse µ = 10,01.

Usando la tavola della distribuzione normale si ottengono i seguenti risultati:

9,97 − 10

= F( −1,5) ≈ 0,067

a) - P( X < 9,97) = F

0,02

10,05 − 10

≈ 0,006

b) - P(X > 10,05) = 1 − p(X ≤ 10,05) = 1 − F

0,02

c) - P (X < 9,97) + P (X > 10,03) = 1 - P (9,97 ≤ X ≤ 10,03) = 1 - P (X ≤ 10,03)

10,03 − 10

9,97 − 10

+ F

+ P (X < 9,97) = 1 - F

0,02 = 0,13

0,02

d) - Per quanto detto nel testo e visto nell'esempio precedente, si ottiene

immediatamente

c = 1,96; σ = 1,96 . 0,02 = 0,039

e) - P (X < 10-0,039) + P (X > 10 + 0,039) = 1 - P (9,961 ≤ X ≤ 10,039) =

10,039 − 10,01

9,961 − 10,01

+ F

= 0,08

= 1 - F

0,02

0,02

41

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Distribuzione χ2 (di Pizzetti-Pearson).

Se Z è una variabile casuale normale standardizzata, cioè una variabile casuale

normale con media uguale a zero e varianza uguale ad uno, la variabile casuale X = Z2

,definita nell’intervallo 0+∞ , è una variabile del tipo χ2 (chi quadro) con un grado

di libertà. In generale, se X1, X2,...,Xn sono variabili casuali normali standardizzate

(cioè con valor medio nullo e varianza unitaria) indipendenti (in probabilità o

stocasticamente indipendenti), la somma dei loro quadrati X = X12 + X22 + ...+Xn2 dà

luogo ad una variabile casuale, generalmente indicata con il simbolo χ 2n , che ha la

funzione di densità di probabilità pari a

f ( x) = f ( x; n) =

2

n/2

1

x ( n / 2 ) −1 e − x / 2

Γ ( n / 2)

per x ≥ 0

dove il parametro caratteristico n è un intero positivo e rappresenta i gradi di libertà

della distribuzione χ2;

Γ(n/2) è la c.d. funzione gamma, definita in generale dall'integrale

+∞

Γ(λ ) = ∫ e − x x λ −1 dx

0

per λ>0

Si dimostra facilmente la relazione Γ(n ) = (n - 1)!

1

e quindi Γ (n / 2) = (n/2 - 1)! e Γ = π

2

La curva della distribuzione χ2 è monotona per n = 1 e n = 2; per n > 2 ha un

massimo nel punto x = n - 2.

Il valor medio e la varianza della distribuzione χ 2 sono rispettivamente

∞

µ = ∫ x f ( x; n )

0

dx=n

42

B. Chiandotto

Metodi Statistici per l’impresa

∞

σ 2 = ∫ ( x − µ) 2 f ( x; n )

0

Versione 00 - Cap. 2

dx = 2n

Si dimostra che la variabile casuale χ2 standardizzata tende, al crescere di n, alla

distribuzione normale (con media zero e varianza unitaria), ne deriva quindi una

possibilità di approssimazione della v.c. χ2 mediante la v.c. normale per n

sufficientemente elevato. Si dimostra inoltre che la somma di k variabili casuali del tipo

χ2, stocasticamente indipendenti e con gradi di libertà rispettivamente pari a

k

n1, n2, ...,nk, è ancora una variabile casuale

χ2

con g =

∑n

i =1

i

gradi di libertà (proprietà

addittiva del χ2).

Esempio 5

Sia X una variabile casuale del tipo χ2

con 5 gradi di libertà. Si vogliono

determinare le costanti c, c1 e c2 in modo che sia:

a) P (X ≤ c) = 0,10

b) P (X > c) = 0,05

c) P (c1 < X ≤ c2) = 0,95 per c1 < c2

Utilizzando le tavole della distribuzione χ2 si avrà

a) - P (X ≤ c) = F(c) = 0,10 => c = 1,61

b) - P (X > c) = 1 - p (X ≤ c) = 1 - F(c) = 0,05 => c = 11,1

c) - In relazione a questo quesito, va detto che esistono infinite coppie di valori (c1, c2)

capaci di soddisfare la condizione posta, si potrebbe ad esempio suddividere la

probabilità 0,05 in modo da avere un livello pari a 0,01 alla sinistra di c1 ed un

intervallo 0,04 alla destra di c2, oppure 0,02 a sinistra di c1 e 0,03 a destra di c2

ecc.;usualmente, a meno che non vi siano particolari ragioni per specificare altrimenti, si

suddivide la probabilità in parti uguali, così facendo si avrà

43

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

P (X ≤ c1) = F(c1) = 0,025 => c1 = 0,831

P (X > c2) = 1 - P (X ≤ c2) = 0,025 => c2 = 12,8

da cui

P (c1 < X ≤ c2) = P (0,831 < X ≤ 12,8) = 0,95

Distribuzione t (di Student)

La c.d. distribuzione t è stata introdotta dal chimico W.S. Gosset nel 1908 sotto lo

pseudonimo di "Student".

La distribuzione t è relativa alla variabile casuale

X=

Z

Y/n

dove:

a) n è un intero positivo che rappresenta il numero dei gradi di libertà della

distribuzione t;

b) Z è una variabile casuale normale standardizzata;

c) Y è una variabile casuale χ2 con n gradi di libertà;

d) Z e Y sono variabili stocasticamente indipendenti.

La distribuzione t ha funzione di densità di probabilità

44

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

n + 1

Γ

1

2

f ( x ) = f ( x; n ) =

n +1

n

Γ nπ x 2 2

1 +

2

n

per − ∞ ≤ x ≤ +∞

è simmetrica ed ha un massimo nel punto t = 0. La media µ = 0 per n ≥2 , mentre non

esiste per n = 1; la varianza non esiste per n = 1,2 mentre per n ≥ 3 la varianza è data

da σ2 ==

n

n−2

Al crescere di n la distribuzione t tende alla distribuzione normale standardizzata;

un buona approssimazione si ottiene anche per n relativamente piccolo ( n > 30 ).

Esempio 6.

Sia X una variabile casuale del tipo t di Student con 9 gradi di libertà. Si vogliono

determinare i valori della costante c che soddisfano le relazoini: a) P(X > c) = 0,05;

b) P(X < c) = 0,05; c)P(-k < X ≤ k) = 0,99; d) P(0 < X ≤ c) = 0,475.

Utilizzando le tavole della distribuzione t

e ricordando la simmetria di tale

distribuzione, si ottiene

a)- P (X > c) = 1 - P (X ≤ c) = 1 - F(c) = 0,05 => c = 1,83

b)- P (X ≤ c) = F(c) = 0,05 => c = -1,83

c)- P (-c < X ≤ c) = P (X < c) - P (X ≤ c) = F(c) - F(-c) = F(c) - [ 1 - F(c) ] =

0,99 => c = 3,25

d)- P (0 < X ≤ c) = P (X ≤ c) - P (X ≤ 0) = F(c) - 0,5 = 0,475 => c = 2,26

45

B. Chiandotto

Metodi Statistici per l’impresa

Versione 00 - Cap. 2

Distribuzione F (di Fisher- Snedecor).

La distribuzione F è relativa alla variabile

X=

V / n1

Y / n2

dove V e Y sono due variabili casuali del tipo χ2, con gradi di libertà rispettivamente

pari a n1 e n2, distribuite indipendentemente. Si noti che l'ordine dei gradi di libertà n1 e

n2 è fondamentale, infatti si verifica facilmente che le due variabili casuali

Fn1 , n2 e

Fn−21, n1 hanno la stessa distribuzione.

La funzione di densità di probabilità di una variabile casuale X di tipo F, con n1 e

n2 gradi di libertà, risulta essere

n 1 + n 2 n1 / 2 n2 / 2

Γ

n n2

2 1

x ( n 1 / 2 ) −1

f ( x) = f ( x; n 1 , n 2 ) =

( n 1 x + n 2 ) ( n1 + n 2 )/ 2

n1 n 2

Γ Γ

2 2

per 0 ≤ x ≤ +∞

La media e la varianza sono date da.

2n 22 (n1 + n − 2)

n2

2

;σ =

µ=

n2 −1

n1 (n 2 − 2) 2 (n 2 − 4)

Esempio 7.

Sia X una variabile casuale del tipo F con n1 = 7 e n2 = 10 gradi di libertà. Si