Computazione per l’interazione naturale:

fondamenti probabilistici

Corso di Interazione Naturale Prof. Giuseppe Boccignone

Dipartimento di Informatica

Università di Milano

[email protected]

boccignone.di.unimi.it/IN_2016.html

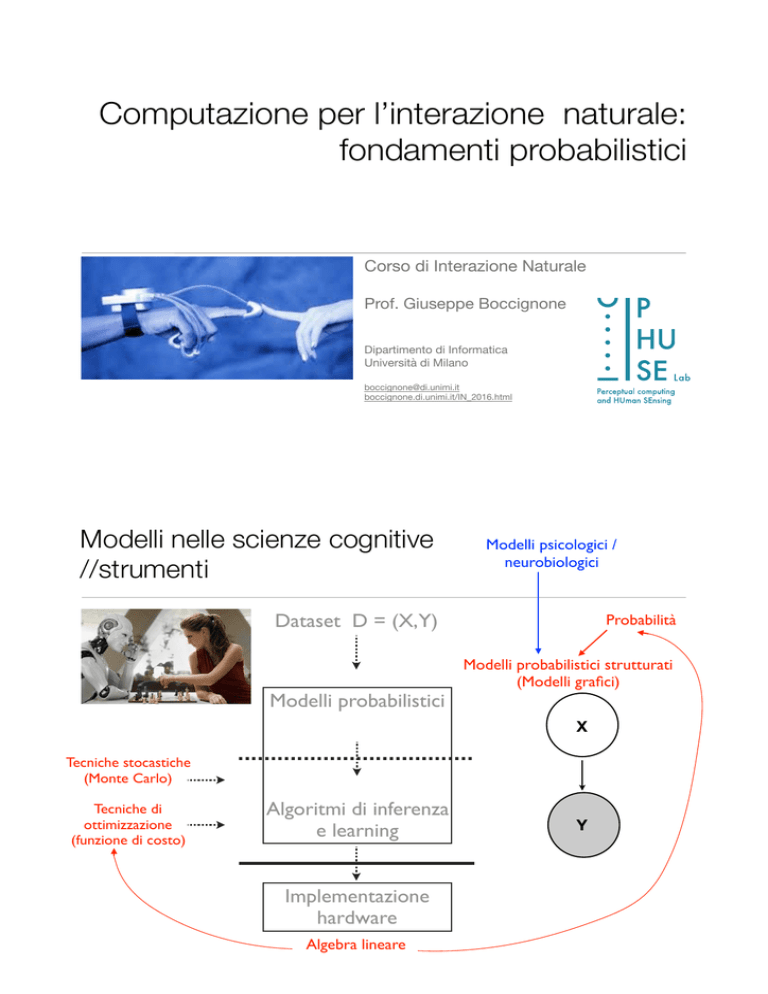

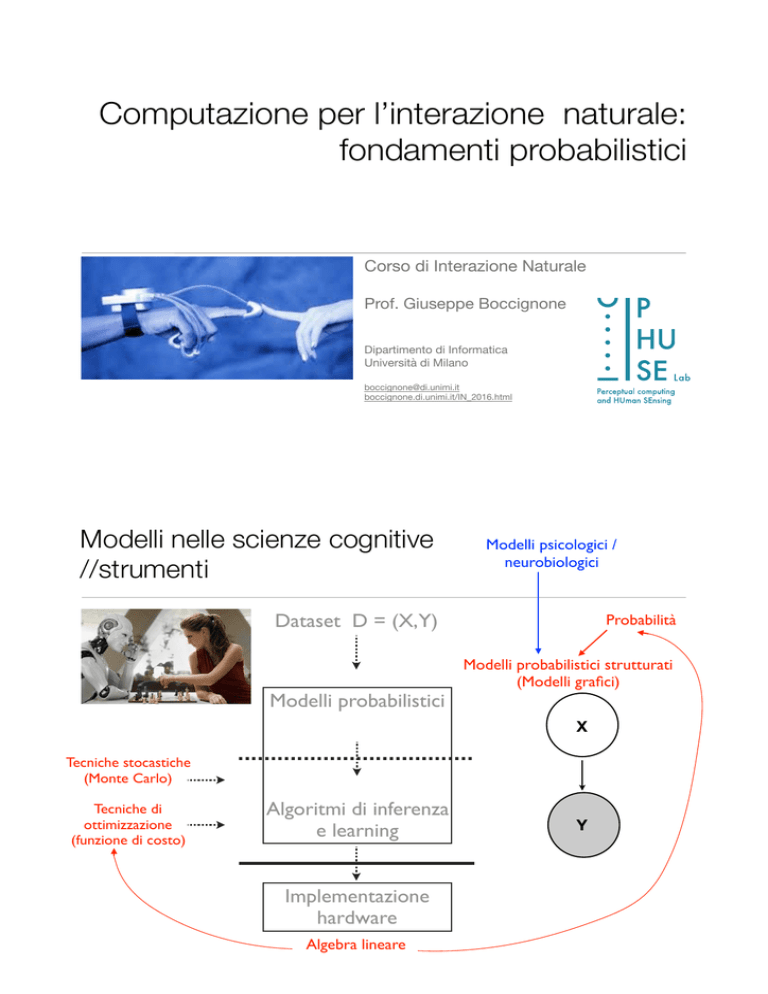

Modelli nelle scienze cognitive

//strumenti

Modelli psicologici /

neurobiologici

Dataset D = (X,Y)

Modelli probabilistici

Probabilità

Modelli probabilistici strutturati

(Modelli grafici)

X

Tecniche stocastiche

(Monte Carlo)

Tecniche di

ottimizzazione

(funzione di costo)

Algoritmi di inferenza

e learning

Implementazione

hardware

Algebra lineare

Y

Perchè introdurre elementi aleatori

//Esempio: Regressione lineare con rumore

• La generazione dei punti da un processo reale puo’ avvenire con maggiore o

minor precisione

• I punti reali non vengono generati sulla curva ideale ma con delle deviazioni /

disturbi

come definiamo la precisione?

Perchè introdurre elementi aleatori

//Esempio: Regressione lineare con rumore

• Assumiamo una generazione di punti con un processo rumoroso

come definiamo la precisione?

Perchè introdurre elementi aleatori

//Esempio: Regressione lineare con rumore

• Assumiamo una generazione di punti con un processo rumoroso

possiamo definire la precisione

(e.g., inverso della varianza)

Probabilità

//assiomi:definizione formale

• L’insieme dei possibili valori osservati (risultati dell’osservazione di un

processo casuale) definisce uno spazio campione è un insieme di valori dallo spazio campione. La classe F

• Un evento A ⊆

dei possibili eventi soddisfa le proprietà seguenti:

• Su F è definita una misura di probabilità P : F → IR, che soddisfa le proprietà

seguenti:

S¼

fsjV1 < s <description

V2 g:

(1.4) is given

The

mathematical

of the random experiment

• Sample space

In most situations, we•areEvents

not interested in the occurrence of specific outcomes,

but rather in certain characteristics

of the outcomes. For example, in the voltage

• Probability

measurement experiment we might be interested if the voltage is positive or less

set of all

possible

outcomes

is called

space

than some desired value V. The

To handle

such

situations

it is useful

tosample

introduce

theand it is gi

S.

For

example,

in

the

experiment

of

a

coin-tossing

we

cannot pr

concept of an event.

“head,” or “tail” will appear; but we know that all possible ou

“heads,” or “tails,” shortly abbreviated as H and T, respectively. T

space for this random experiment is:

Probabilità

//lo spazio campione

Sample space

S ¼ fH; Tg:

s1=

s2=

Each element in S is called a sample point, si. Each outcome is r

corresponding sample point. For example, the sample points in (1.1

s1 ¼ H;

s2 ¼ T:

When rolling a die, the outcomes correspond to the numbers

Consequently, the sample set in this experiment is:

S ¼ f1; 2; 3; 4; 5; 6g:

Fig. 1.1 Sample spaces for coin tossing and die rolling. (a) Coin tossing. (b) Die rolling

G.J. Dolecek, Random Signals and Processes Primer with MATLAB,

DOI 10.1007/978-1-4614-2386-7_1, # Springer Science+Business Media New

S

V1

V2

Fig. 1.2 Example of continuous space

Probabilità condizionata e indipendenza

• Sia B un evento a probabilità non nulla (P(B) > 0). La probabilità condizionata

di un evento A dato B è definita come

• Se P(A∩B) = P(A)P(B), e quindi P(A | B) = P(A), allora i due eventi sono detti

indipendenti.

Variabili aleatorie

Chapter 1

to Sample Space and Prob

è una funzione

• Una variabile casuale (o random)Introduction

• Se, dato

può assumere soltanto valori interi, allora

X è una variabile casuale discreta, altrimenti viene detta continua.

2

1

Introduction to Sample Space and Probability

We assume here that coins and dice are fair and have no memory, i.e., each

outcome is equally likely on each toss, regardless of the results of previous tosses.

It is helpful to give a geometric representation of events using a Venn diagram.

This is a diagram in which

space Space

is presented

a closed-plane figure

1.1sample

Sample

and using

Events

and sample points using the corresponding dots. The sample spaces (1.1) and (1.3)

are shown in Fig. 1.1a, b, respectively.

Probability theory is the mathematical analysis of random experi

The sample sets (1.1) and (1.3) are discrete and finite. The sample set can also be

p. 11]. An experiment is a procedure we perform that produces

discrete and infinite. If the elements of the sample set are continuous (i.e., not

outcome [MIL04, p. 8].

countable) thus the sample set S is continuous. For example, in an experiment

An experiment is considered random if the result of the experim

which measures voltage over time T, the sample set (Fig. 1.2) is:

determined exactly. Although the particular outcome of the exp

known in advance, let us suppose that all possible outcomes are kn

S¼

fsjV1 < s <description

V2 g:

(1.4) is given

The

mathematical

of the random experiment

• Sample space

In most situations, we•areEvents

not interested in the occurrence of specific outcomes,

but rather in certain characteristics

of the outcomes. For example, in the voltage

• Probability

measurement experiment we might be interested if the voltage is positive or less

set of all

possible

outcomes

is called

space

than some desired value V. The

To handle

such

situations

it is useful

tosample

introduce

theand it is gi

S.

For

example,

in

the

experiment

of

a

coin-tossing

we

cannot pr

concept of an event.

“head,” or “tail” will appear; but we know that all possible ou

“heads,” or “tails,” shortly abbreviated as H and T, respectively. T

space for this random experiment is:

Variabili aleatorie

//esempio: V.A. discreta

Sample space

S ¼ fH; Tg:

s1=

s2=

Each element in S is called a sample point, si. Each outcome is r

corresponding sample point. For example, the sample points in (1.1

s1 ¼ H;

s2 ¼ T:

When rolling a die, the outcomes correspond to the numbers

Consequently, the sample set in this experiment is:

S ¼ f1; 2; 3; 4; 5; 6g:

Variabile aleatoria

Fig. 1.1 Sample spaces for coin tossing and die rolling. (a) Coin tossing. (b)XDie rolling

X

(discreta)

G.J. Dolecek, Random Signals and Processes

Primer with MATLAB,

DOI 10.1007/978-1-4614-2386-7_1, # Springer Science+Business Media New

x1= 0

S

x2=1

V1

Fig. 1.2 Example of continuous space

x

V2

Realizzazioni

x

della v.a. X

Variabili aleatorie

• Una variabile casuale (o random) è una funzione

può assumere soltanto valori interi, allora X è una

• Se, dato

variabile casuale discreta, altrimenti viene detta continua.

• Una distribuzione (cumulativa) di probabilità è una funzione • tale che FX(x) = P(X ≤ x). Per tale funzione valgono le seguenti

Distribuzione di probabilità

//discreta

• Se X può assumere un insieme finito di possibili valori, è possibile definire la

distribuzione (di massa) di probabilità • tale che pX(x) = P(X = x). Valgono:

Densità di probabilità

//continua

• Se X è continua e FX è derivabile ovunque, possiamo definire la densità di

probabilità

• Dalla definizione di derivata:

• Altre proprietà

Valore atteso

• X variabile casuale discreta con distribuzione pX(x), g :

generica

funzione, allora g(X) è variabile casuale e possiamo definire il suo valore atteso

come:

• X variabile casuale continua

Valore atteso: proprietà

Varianza

• La varianza di una variabile casuale X

• Vale allora:

• Inoltre

Distribuzioni utili

Distribuzioni discrete

//Bernoulli

• Probabilità che, data una moneta

con probabilità di “testa” uguale a

p, un suo lancio abbia “testa”

come esito.

=

• Media

• Varianza

Distribuzioni discrete

//Binomiale

• probabilità che, data una moneta

con probabilità di “testa” uguale a

p, n suoi lanci indipendenti diano

x volte “testa” come esito.

• Media

n=10,

p=0.25

• Varianza

Distribuzioni discrete

//Poisson

• probabilità che, dato un evento

che può avvenire in media

lambda volte per unità di tempo,

l’evento compaia x volte nell’unità

di tempo.

• Media

• Varianza

lambda = 2;

x = poissrnd(lambda,1,1000);

hist(x)

Distribuzioni continue

//Uniforme

• probabilità costante tra a e b, 0

altrove.

• Media

• Varianza

Distribuzioni continue

//Esponenziale

• probabilità che l’intervallo tra due

eventi successivi in un processo

di Poisson con parametro

abbia lunghezza x

• Media

• Varianza

Distribuzioni continue

//Normale o Gaussiana

• Media

• Varianza

Distribuzioni continue

//Normale o Gaussiana

• Media

• Varianza

>>

>>

>>

>>

>>

mu=0;

sigma=2;

x=-10:0.1:10;

y = normpdf(x,mu,sigma);

plot(x,y)

Distribuzioni continue

//Normale o Gaussiana

• Media

>>

>>

>>

>>

• Varianza

mu=0;

sigma=2;

x = normrnd(mu,sigma,1,100000);

hist(x)

Distribuzioni continue

//Beta

• Usata come a priori sul parametro della

Binomiale

• dove

è la funzione Gamma

• Media

• Varianza

Distribuzione Beta

in funzione degli iperparametri a,b

Distribuzioni continue

//Distribuzioni coniugate

• Quando moltiplichiamo una distribuzione con la sua coniugata il risultato ha

la forma della coniugata

una$costante

una$nuova$Beta

Distribuzioni continue

//Distribuzioni coniugate

• Quando moltiplichiamo una distribuzione con la sua coniugata il risultato ha

la forma della coniugata

una$costante

una$nuova$Beta

Distribuzioni continue

//Gamma

• Usata come a priori sulla varianza della

Normale o sulla Poisson

• dove

è la funzione Gamma

• Media

• Varianza

Distribuzione Gamma

in funzione degli iperparametri a,b

Estensione a due variabili casuali

//distribuzioni cumulative congiunte e marginali

• Date due variabili casuali continue X, Y , la distribuzione di probabilità

cumulativa congiunta è definita come

• Valgono le seguenti

• Data la distribuzione cumulativa di probabilità congiunta FXY (x, y) le

distribuzioni cumulative marginali di probabilità FX e FY sono definite come

Estensione a due variabili casuali

//distribuzioni di probabilità congiunte e marginali

• Date due variabili casuali discrete X, Y • valgono le seguenti

• Data la distribuzione di probabilità pXY (x, y) le distribuzioni marginali di

probabilità pX e pY sono definite come

Estensione a due variabili casuali

//distribuzioni di probabilità congiunte e marginali

Estensione a due variabili casuali

//distribuzioni di probabilità congiunte e marginali

continua

discreta

discreta e continua

Estensione a due variabili casuali

//densità di probabilità congiunte e marginali

• Se FXY (x, y) è dovunque derivabile rispetto sia a x che a y, allora la densità di

probabilità congiunta è definita come

• vale

• Data la densità di probabilità cumulativa fXY (x, y) le densità marginali di

probabilità fX e fY sono definite come

Estensione a due variabili casuali

//probabilità condizionate

• Date due variabili casuali X, Y discrete , la probabilità condizionata di X

rispetto a Y è definita come

• X, Y continue

Estensione a due variabili casuali

//probabilità condizionate

Estensione a due variabili casuali

//Teorema di Bayes

• X, Y discrete

• X, Y continue

Estensione a due variabili casuali

//Teorema di Bayes

Likelihood$–$propensione$ad$

osservare$un$certo$valore$x$

dato$un$valore$y

Posterior$–$cosa$

sappiamo$di$y$dopo$aver$

osservato$x

Prior$–$cosa$sappiamo$di$$

y$prima$di$osservare$x

Evidence$–una$costante$di$

normalizzazione$

Estensione a due variabili casuali

//Teorema di Bayes e coniugate

• Quando moltiplichiamo una distribuzione con la sua coniugata il risultato ha

la forma della coniugata

una$costante

una$nuova$Beta

Estensione a due variabili casuali

//Teorema di Bayes e coniugate

• Utilizziamo le coniugate e Bayes per il learning dei parametri

Likelihood$–$Bernoulli

Posterior$–$è$una$nuova

Prior$–$uso$la$coniugata

Evidence$–$è$la$costante$di$

normalizzazione$

Estensione a due variabili casuali

//indipendenza

• Due variabili casuali sono indipendenti se

• ovvero

Estensione a due variabili casuali

//indipendenza

estrae la slice e normalizza

Estensione a due variabili casuali

//valore atteso

• Date due variabili casuali X, Y discrete e una funzione

il valore atteso di g è

• X, Y continue

• Valgono le seguenti

Estensione a due variabili casuali

//covarianze

• Date due variabili casuali X, Y , la loro covarianza è definita

• come nel caso della varianza:

• Valgono inoltre:

Estensione a n variabili casuali

• Date n variabili causali X1,X2, . . . ,Xn

• valgono

• Per ogni Xi è definita la marginale

Estensione a n variabili casuali

//caso discreto

• Date n variabili casuali discrete, la distribuzione di probabilità congiunta

• per la quale valgono:

• La distribuzione di probabilità marginale è

Estensione a n variabili casuali

//caso discreto: la distribuzione categorica

Descrive$una$situazione$dove$vi$sono$sono$K$possibili$risultati$y=1… y=k.$

(e.g.,$il$lancio$di$un$dado$con$k=6)$

Prende$$K$parametri$$$$$$$$$$$$$$$$$$$$$$$$$$con$

A$volte$viene$detta$$Multinoulli,$perché$è$una$generalizzazione$

della$Bernoulli

La$v.a.$può$essere$pensata$come$un$

vettore$di$indicatori$dove$solo$il$ksimo$

elemento$è$diverso$da$zero,$e.g.$$

e4$=$[0,0,0,1,0]

Estensione a n variabili casuali

//caso continuo

• Se la F è derivabile, la densità di probabilità congiunta è definita

• quindi

• La densità marginale di probabilità è

Estensione a n variabili casuali

//regola del prodotto

• Dalla definizione di probabilità condizionate:

Estensione a n variabili casuali

//valore atteso

• Date una distribuzione f(x1, x2, . . . , xn) e una funzione

Estensione a n variabili casuali

//covarianza

• Dato un insieme X1,X2, . . . ,Xn di variabili casuali, è possibile definire il

vettore aleatorio

• Anche una funzione

è rappresentabile come vettore

Estensione a n variabili casuali

//covarianza

• Dato il vettore

che, per ogni coppia i, j

• ovvero:

la sua matrice di covarianza è la matrice n x n tale

Estensione a n variabili casuali

//covarianza

•

è matrice simmetrica:

• per definizione di covarianza •

è definita positiva:

• per qualunque vettore z:

• ma

Estensione a n variabili casuali

//il caso Gaussiano

• Un vettore aleatorio

e matrice di covarianza

ha una distribuzione normale di media

di dimensione n x n

forma quadratica di x

Estensione a n variabili casuali

//il caso Gaussiano

Estensione a n variabili casuali

//il caso Gaussiano

• I contorni di densità costante sono determinati dalla matrice di covarianza

• Per esempio in 2D

Forma generale

Forma diagonale

(allineata con gli assi)

Forma isotropa

(matrice identità)

Estensione a n variabili casuali

//il caso Gaussiano

Distribuzione Normale multivariata:

//il caso diagonale

• Consideriamo il caso della matrice di covarianza diagonale

• allora • ovvero

Distribuzione multivariata =

prodotto di n distribuzioni

gaussiane univariate, ognuna

relativa ad una coordinata xi

Distribuzione Normale multivariata:

//il caso diagonale

cov diagonale

=

indipendenza

Distribuzione Normale multivariata:

//decomposizione della covarianza

Nel$sistema$di$riferimento$verde:

Relazione$fra$i$due$SR:

Sostituendo:

Conclusione

Posso$decomporre$la$matrice$di$

covarianza$in$una$matrice$di$rotazione$

e$una$diagonale

Distribuzione Normale multivariata:

//medie e covarianze

• Valgono le seguenti come nel caso univariato

Distribuzione Normale multivariata:

//somma di variabili gaussiane indipendenti

• Siano • La somma

è ancora distribuita normalmente

• Si noti che la distribuzione di z = x + y è cosa diversa dalla somma delle

distribuzioni di x e y (che in generale non è gaussiana).

Distribuzione Normale multivariata:

//congiunta, marginale e condizionata di v.a.g.

• Sia

con

• La distribuzione di x è la congiunta

Distribuzione Normale multivariata:

//congiunta, marginale e condizionata di v.a.g.

• La distribuzione di x è la congiunta Gaussiana

• Marginali Gaussiane:

• Condizionate Gaussiane:

Distribuzione Normale multivariata:

//congiunta, marginale e condizionata di v.a.g.

allora

Distribuzione Normale multivariata:

//congiunta, marginale e condizionata di v.a.g.

se

allora

Distribuzione Normale multivariata:

//congiunta, marginale e condizionata di v.a.g.

se

allora

Nel$caso$sferico$/$diagonale,$x1$and$x2$sono$indipendenti$

e$le$distribuzioni$condizionate$sono$tutte$uguali

Distribuzione Normale multivariata:

//congiunta, marginale e condizionata di v.a.g.

Trasformazione$di$variabili:

Distribuzione Normale multivariata:

//formula di Bayes

• Siano

• La probabilità a posteriori vale:

• Inoltre:

Distribuzione coniugata sui parametri della Gauss.

//Normal Inverse Wishart

(dispersion)

(ave.$Covar)

(disper$of$means)

(ave.$of$means)

esempi$$

campionati

Computer$vision:$models,$learning$and$inference.$$©2011$Simon$J.D.$Prince

Distribuzione categorica e coniugata di Dirichlet

Descrive$una$situazione$dove$vi$sono$sono$K$possibili$risultati$y=1… y=k.$

(e.g.,$il$lancio$di$un$dado$con$k=6)$

Prende$$K$parametri$$$$$$$$$$$$$$$$$$$$$$$$$$con$

A$volte$viene$detta$$Multinoulli,$perché$è$una$generalizzazione$

della$Bernoulli

La$v.a.$può$essere$pensata$come$un$

vettore$di$indicatori$dove$solo$il$ksimo$

elemento$è$diverso$da$zero,$e.g.$$

e4$=$[0,0,0,1,0]

Distribuzione categorica e coniugata di Dirichlet

Definita$su$K$valori$$$$$$$$$$$$$$$$$$$$$$$$$$con

k$$parametri$$$$$αk>0