caricato da

gabriella.caroti

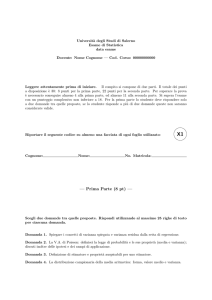

Statistica: Campionamento e Inferenza nella Revisione Contabile

Corso di Laurea Magistrale in Economia e Professioni

Statistica per l’analisi dei dati

Prima parte: il campionamento nella

revisione contabile

Dispensa 2

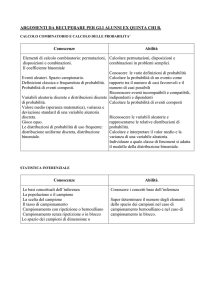

Argomenti: elementi di inferenza statistica

Prof. Giorgio Tassinari

a.a. 2011-12

II -

inferenza statistica

In generale dobbiamo affrontare problemi in cui, sulla base della conoscenza

di alcuni elementi della popolazione, si vogliono trarre conclusioni su tutta la

popolazione da cui questi elementi provengono

Avendo però osservato solo alcuni elementi della popolazione

le conclusioni che possiamo trarre sull’intera popolazione sono

caratterizzate da incertezza.

Per popolazione intendiamo l’insieme

delle unità statistiche a cui vogliamo

riferire le nostre conclusioni

popolazioni concettuali (infinite)

popolazioni reali (finite)

le fatture emesse da una azienda nell’anno contabile costituiscono una popolazione finita

tutte le possibili uscite T o C in successivi lanci di una moneta sono una popolazione infinita

II -

2

Il procedimento logico-induttivo attraverso cui si arriva, sulla base di

un campione, a trarre conclusioni sull’intera popolazione è detto

inferenza statistica.

Oggetto dell’inferenza sono alcune misure di sintesi della distribuzione di

uno o più caratteri nella popolazione (medie, varianze, proporzioni,…)

popolazione

?

parametri

, 2 , , ,

stime

verifica di ipotesi

distribuzioni campionarie

teoria della probabilità

campione

statistiche

x , s 2 , p, r , b

II -

3

Data quindi una popolazione P, un criterio di campionamento C e la numerosità

campionaria n, è possibile definire l’insieme di tutti i possibili campioni

S(P,C,n).

Se indichiamo con P(c) la probabilità di ogni campione c, appartenete ad S, di

essere estratto, la coppia {S,P(c)} è detta piano di campionamento.

Consideriamo un piano di campionamento casuale semplice con ripetizione:

una volta estratte le n unità campionarie ed osservata la caratteristica di

interesse avremo la n-upla (x1,x2,…,xn), ovvero il campione osservato.

Questa n-upla è uno dei possibili elementi dello spazio campionario S.

Al variare della n-upla in S viene generata una v.c. campionaria (X1,X2,…,Xn)

II -

4

La v.c. n-upla campionaria (X1,X2,…,Xn) è una variabile n-dimensionale a

componenti i.i.d. (indipendenti ed identicamente distribuite).

Questo significa che la v.c. Xj (j=1,…n), generata dalla j-esima estrazione,

ha la stessa distribuzione di probabilità della caratteristica X nella popolazione.

(x1,x2,…,xn) -> (X1,X2,…,Xn)

Dato che la v.c. n-upla campionaria (X1,X2,…,Xn) è a componenti i.i.d.,

allora la sua funzione di probabilità congiunta è data da:

P(X1=x1,X2=x2,…,Xn=xn)=P(X1=x1)P(X2=x2)…P(Xn=xn)

Questa rappresenta la probabilità di avere

osservato il campione (x1,x2,…,xn)

II -

5

Consideriamo ad esempio il numero di impiegati per ufficio in una azienda.

N. impiegati

Frequenza relativa

1

2

3

4

0.15

0.30

0.45

0.10

Totale

1.00

Se estraiamo un campione casuale di n=5 uffici, la variabile numero di impiegati potrà

assumere valori da 1 a 4, con probabilità pari alla frequenza relativa associata ad ogni singolo

valore. Ciò significa che le 5 v.c. generate dalle 5 estrazioni avranno distribuzione di probabilità

uguale fra loro ed uguale a quella della caratteristica in esame.

Ad esempio, la prima unità estratta avrà:

P(X1=1)=0.15, P(X1=2)=0.30, P(X1=3)=0.45, P(X1=4)=0.10

Supponiamo di avere estratto un campione con n=5 che ha fornito i seguenti valori:

(x1=1,x2=3, x3=2, x4=1, x5=4)

La probabilità associata al campione osservato è:

P(x1=1,x2=3, x3=2, x4=1, x5=4)=P(x1=1)P(x2=3)P(x3=2)P(x4=1)P(x5=4)=

0.15*0.45*0.30*0.15*0.10=0.000303

II -

6

Indichiamo con θ un parametro della popolazione, ovvero una sua costante

caratteristica (nel caso di popolazioni finite una media, varianza,…)

Noto θ, la distribuzione di probabilità della v.c. n-upla campionaria (X1,X2,…,Xn) ci

consente di assegnare una probabilità a qualsiasi campione osservato (x1,x2,…,xn)

[problema diretto].

In realtà quello ci interessa è il problema inverso (o induttivo).

Non conosciamo il valore di un parametro θ della popolazione, e lo si

vuole “valutare” per mezzo del campione osservato (x1,x2,…,xn).

I metodi che permettono di risolvere il problema inverso sono detti di

inferenza statistica

Ad esempio, se il parametro θ a cui siamo interessati è la media μ del numero di impiegati per

ufficio dell’azienda sotto esame, ed abbiamo osservato il campione (x1=1,x2=3, x3=2, x4=1, x5=4)

avremo:

1

x (1 3 2 1 4) 2.2

( 2.5)

5

II -

7

Inferenza statistica

Stima dei parametri

Verifica di ipotesi

stima puntuale

stima per intervallo

Dato lo spazio parametrico Θ, ovvero l’insieme

di tutti i valori che può assumere il parametro

incognito θ, e dato lo spazio campionario S, la

stima dei parametri consente, in base al

campione osservato, di un valore (stima

puntuale) o un insieme di valori (stima per

intervallo) al valore incognito θ.

S

(x1,x2,…,xn)

La verifica di ipotesi consente di fare una

congettura, un’affermazione su θ, detta

ipotesi, e di decidere, sulla base del

campione, se essa può essere accettata.

Si tratta cioè di dividere lo spazio

campionario in due sottoinsiemi: il

sottoinsieme A dei campioni che porta ad

accettare l’ipotesi, ed il sottoinsieme

complementare R che invece porta al rifiuto

dell’ipotesi.

S

Θ

Θ

ω

R

A

S

(x1,x2,…,xn)

Θ

ω

dove ω rappresenta il sottoinsieme dello

spazio parametrico cui appartiene θ

II -

8

Statistiche campionarie e distribuzioni campionarie

Ogni processo di inferenza statistica è caratterizzato da una componente di

incertezza, i dati x sono infatti interpretati come realizzazione di un vettore

casuale X.

Se si ripete l’esperimento, nelle medesime condizioni, si ottengono dei dati x0, generalmente

diversi da x.

L’inferenza viene eseguita cercando di estrarre tutta l’informazione possibile

contenuta nel campione, per fare una valutazione dell’intera popolazione rispetto

al fenomeno studiato. Pertanto, si fa uso di opportune funzioni dei valori

campionari (somma, media aritmetica, differenza tra massimo e minimo e così

via) che permettano di effettuare questa valutazione.

Queste funzioni vengono dette statistiche campionarie.

Si definisce statistica (campionaria) ogni trasformata T = t(X1, … ,Xn), che

sintetizza opportunamente il campione casuale X = (X1,…,Xn).

Formalmente si tratta di funzioni

t ( X1 ,..., X j ,..., X n ) : S

che associano a ogni n-pla ( x1 ,..., x j ,..., xn ) un singolo numero reale (ad esempio la

media campionaria, la varianza campionaria,…)

II -

9

Una statistica campionaria è essa stessa una variabile casuale:

o

è funzione della v.c. ( X1 ,..., X j ,..., X n )

o

assume, in generale, valori diversi a seconda del campione estratto

o

ha una propria distribuzione di probabilità che dipende dalla distribuzione della

v.c. ( X1 ,..., X j ,..., X n )

o

la probabilità che la statistica campionaria assuma un certo valore è pari alla

probabilità complessiva di tutti i campioni (dello spazio campionario) per i quali

si ottiene tale valore

T t ( X1 ,..., X j ,..., X n ) è una variabile casuale o, in generale, un vettore casuale con una

determinata distribuzione di probabilità, chiamata distribuzione campionaria.

Una statistica campionaria, utilizzata per stimare un generico parametro θ

viene detta stimatore di θ

Ad esempio la media campionaria x è uno stimatore di

II - 10

I parametri che si debbono stimare, o rispetto ai quali verificare ipotesi,

rappresentano delle misure di sintesi della popolazione, cioè funzioni della

distribuzione del carattere nella stessa popolazione (medie, varianze, proporzioni)

E’ abbastanza ragionevole pensare di stimare (in modo puntuale) un parametro

incognito θ applicando, ai dati campionari, la stessa sintesi che θ opera sulla

popolazione.

Questo modo di procedere viene denominato “plug in principle” e si basa

sull’idea di stimare funzioni dei dati in popolazione (parametri) applicando le

stesse funzioni ai dati campionari (es.: stimare la media di pop. con la media

campionaria, la varianza di pop. con la varianza campionaria, ecc. …)

Tuttavia, non sempre è possibile usare tale metodo e, comunque, non è detto

che tale metodo produca una “buona” stima del parametro.

Esistono altri metodi per individuare gli stimatori (dei minimi quadrati, della

massima verosimiglianza, dei momenti, ecc.)

II - 11

Definizione: si chiama stimatore del parametro θ ogni

statistica T t ( X1 ,..., X j ,..., X n ) utilizzata per stimare θ.

Il valore t t ( x1 ,..., x j ,..., xn ) che lo stimatore T assume in un

campione osservato si chiama stima.

In realtà viene osservato un singolo campione e, poiché non è nota la popolazione,

non è possibile dire se la stima ottenuta in base al campione osservato è “buona”

o no (così come non si poteva decidere se il campione era rappresentativo)

Al fine di decidere se lo stimatore rappresenta una proposta ragionevole oppure no

per stimare il parametro è necessario considerare la distribuzione dello stimatore

nello spazio dei campioni

II - 12

Data una popolazione di 100 documenti, in cui la percentuale di errore è del 20%,

supponiamo di estrarre un campione di 3 documenti, e di verificare quanti di essi sono errati

Campione

s

Valore assunto dalla

statistica camp. P̂

(0,0,0)

0

(0,0,1)

Pr(s)

distribuzione di probabilità di

(distribuzione campionaria)

Pr( Pˆ )

(1-θ)3

P̂

1/3

θ(1-θ)2

0

(1-θ)3

(0,1,0)

1/3

θ(1-θ)2

1/3

3xθ(1-θ)2 = 0.384

(1,0,0)

1/3

θ(1-θ)2

2/3

3xθ2(1-θ) = 0.096

(0,1,1)

2/3

θ2(1-θ)

1

θ3

(1,0,1)

2/3

θ2(1-θ)

Totale

1

(1,1,0)

2/3

θ2(1-θ)

(1,1,1)

1

= 0.512

= 0.008

θ3

Supponiamo di osservare tre documenti e di ottenere (1,0,1).

Secondo il “plug in principle” proponiamo la proporzione campionaria

ˆ 2 3 0.667

come stima di θ. p

Se invece avessimo osservato un campione (0,0,1), avremmo avuto p

ˆ 1 3 0.333

il che avrebbe portato a conclusioni diverse.

II - 13

Distribuzione della media campionaria

Se si indica con x1, x2, …, xn l’insieme dei valori rilevati in un campione di

ampiezza n, la media aritmetica campionaria si ottiene sommando le osservazioni

e dividendole per n:

n

x

x

j

j 1

n

Se calcoliamo la media campionaria per tutti i possibili campioni dello spazio

campionario U avremo la distribuzione della media campionaria.

I parametri che ci consentono una “descrizione” di questa distribuzione sono:

- il valore atteso E ( x )

- la varianza

V (x )

II - 14

Si consideri una popolazione finita, costituita da N = 4 elementi, e avente la seguente

distribuzione

xi

f(xi)

1

2

3

4

0.25

0.25

0.25

0.25

1 2 3 4

2.5

4

1

1

1

1

2 1 22 32 42 (2.5) 2 1.25

4

4

4

4

Consideriamo tutti i possibili campioni di dimensione n = 2 estraibili da questa popolazione;

se il campionamento avviene con reimmissione, i campioni di ampiezza 2 sono 42 = 16

Si tratta di disposizioni con ripetizione per cui

Universo campionario

Campioni

Medie

Campioni

U N ,n N n

Medie

(1,1)

1

(3,1)

2

(1,2)

1.5

(3,2)

2.5

(1,3)

2

(3,3)

3

(1,4)

2.5

(3,4)

3.5

(2,1)

1.5

(4,1)

2.5

(2,2)

2

(4,2)

3

(2,3)

2.5

(4,3)

3.5

(2,4)

3

(4,4)

4

Distribuzione delle medie campionarie

xi

f ( xi )

1

1.5

2

2.5

3

3.5

4

1/16

2/16

3/16

4/16

3/16

2/16

1/16

II - 15

Distribuzione della popolazione

Distribuzione della media campionaria

la distribuzione della media

campionaria ha una forma a

campana, simile a una

distribuzione normale,

anche se la popolazione ha

la distribuzione uniforme

0.3

0.25

0.2

0.15

0.1

0.05

0

1

2

3

4

1

1.5

2

2.5

media della distribuzione della media campionaria:

3

3.5

E(x ) 1

4

1

2

3

4

3

1

1.5 2 2.5 3 4 2.5

16

16

16

16

16

16

varianza della distribuzione della media campionaria:

V (x ) 1

1

2

3

4

3

2

1

(1.5) 2 (2) 2 (2.5) 2 (3) 2 (3.5) 2 (4) 2 (2.5) 2 0.625

16

16

16

16

16

16

16

II - 16

Il valore atteso della distribuzione della media campionaria è, indipendentemente

dalla forma distributiva di X, equivalente al valore atteso μ della popolazione:

n

xj

j 1

E( X ) E

n

n

E(x )

j

j 1

n

n

n

La varianza non è uguale alla varianza della popolazione, tuttavia vale la relazione

V (X )

2

n

1.25

0.625

2

infatti

n

xj

j 1

V (X ) V

n

n

V ( x )

j

j 1

n

n 2 2

2

n

n

II - 17

Se il campionamento, nell’esempio precedente, viene fatto senza reimmissione, i

campioni estraibili da questa popolazione finita costituita da 4 elementi sono soltanto 6,

Si tratta di combinazioni semplici per cui

Universo campionario

Campioni

U N ,n

Medie

(1,2)

1.5

(1,3)

2

(1,4)

2.5

(2,3)

2.5

(2,4)

3

(3,4)

3.5

N

N!

n !( N n)! n

Distribuzione delle medie campionarie

1.5

2

2.5

3

3.5

xi

f ( xi )

1/6

1/6

2/6

1/6

1/6

1

1

2

1

1

E ( X ) 1.5 2 2.5 3 3.5 2.5

6

6

6

6

6

V ( x ) (1.5) 2

1

1

2

1

1

5

(2) 2 (2.5) 2 (3) 2 (3.5) 2 (2.5) 2

0.417

6

6

6

6

6

12

II - 18

In generale, se estraiamo un campione casuale di ampiezza n da una popolazione

con media μ e varianza σ2, allora la distribuzione della media campionaria ha

media:

E( X )

Per campioni estratti da popolazioni infinite o se il campionamento è effettuato con

reimmissione, la varianza della media campionaria è:

V (X )

2

n

Per campioni estratti senza reimmissione da popolazione finita, la varianza della

media campionaria è:

2

V (X )

Lo scarto quadratico medio

S(X )

N n

n N 1

n

è detto errore standard della media, e rappresenta una misura della variabilità delle

medie dei campioni di ampiezza n estratti da una popolazione con varianza σ2

N n

N 1

viene detto fattore correttivo per la popolazione finita, e tende ad 1 più la

dimensione del campione è piccola rispetto alla dimensione della popolazione

II - 19

Per quanto riguarda la forma funzionale della distribuzione si può inoltre affermare

che se la popolazione segue un modello normale (con media μ e varianza σ2)

anche la distribuzione campionaria della media campionaria segue a sua volta una

variabile aleatoria normale con la media e varianza indicate in precedenza

Più in generale, data una popolazione con media μ e varianza σ2, se

da essa si estraggono campioni di dimensione n, allora la variabile:

Z

X

n

è una v.c. la cui distribuzione tende ad una distribuzione normale

standardizzata per n->∞ (Teorema del limite centrale)

Qualunque sia la distribuzione della popolazione, si può quindi affermare

che la distribuzione della media campionaria è approssimativamente

normale con media μ e varianza σ2/√n, per n sufficientemente grande.

II - 20

Schema riassuntivo distribuzione della media campionaria

1. Campionamento da una popolazione distribuita normalmente con media μ e

varianza σ2

E( X )

V (X )

2

n

la distribuzione della media campionaria è normale

2. Campionamento da una popolazione non distribuita normalmente con media μ

e varianza σ2

E( X )

V (X )

V (X )

2

n

se

n

0.05

N

2 N n

n N 1

la distribuzione della media campionaria è approssimativamente normale,

per n abbastanza grande

II - 21

Distribuzione della media campionaria (varianza σ2 incognita)

Quanto visto in precedenza richiede la conoscenza della varianza σ2 della

popolazione.

Nel caso che il numero n degli elementi del campione sia grande (grande

campione), se σ2 non è nota, si sostituisce a σ2 la varianza s2 del campione.

Se invece l’ampiezza n del campione è piccola (piccolo campione), si hanno dei

risultati solo se il campione proviene da una popolazione normale.

Sia data una popolazione normale avente media μ, e da essa si

estraggano campioni casuali di ampiezza n; indicando con X la

media campionaria e con S lo scarto quadratico medio campionario,

la variabile:

X

T

S

n

è una variabile aleatoria avente la distribuzione t di Student con

grado di libertà ν = n − 1

II - 22

Proprietà principali della t di Student:

•

è simmetrica rispetto all’asse x = 0

•

la densità ha una forma a campana simile a quella della normale ma le sue code

sono più “pesanti”;

•

è caratterizzata dai gradi di libertà (g) , definiti (nel contesto che consideriamo)

come dimensione del campione (n) meno il numero delle ipotesi che si avanzano

(nel caso della distribuzione della media, una sola, quindi g = n -1);

•

al crescere di g la t assomiglia sempre più ad una Normale e, per g≥30 ne è

praticamente indistinguibile.

E (t ) 0

n

n2

N (0,1)

V (t )

t

n

Esistono tavole statistiche anche per la distribuzione t di Student.

In queste tavole si hanno i valori di h corrispondenti all’espressione:

Pr(t ≥ h) = α

II - 23

Distribuzione

t di Student

Ad esempio:

gdl=9 α=0.05:

t0.05=1.833

Se gdl=9, trovare il valore di tα tale

che la somma dell’area a destra di tα

e dell’area a sinistra di −tα vale α =

0.05

Area totale delle due code = α = 0.05

area a destra di tα (una coda) =

α/2 = 0.025.

tα = t0.025 = 2.262

II - 24

In sintesi, la distribuzione della media campionaria potrà essere:

Grandi campioni

σ2

Nota

Popolazione

distribuita secondo

una N(μ,σ2)

X

N (0,1)

n

Non

nota

X

S

n

Piccoli campioni

Distribuzione non

nota o diversa dalla

Normale

X n

N (0,1)

n

n

N (0,1)

X n

N (0,1)

S

n

Popolazione

distribuita secondo

una N(μ,σ2)

X

N (0,1)

n

X

S

n

n

tn 1

Distribuzione non

nota o diversa dalla

Normale

La distribuzione

della media

campionaria dipende

distribuzione di X

nella popolazione

La distribuzione

della media

campionaria dipende

distribuzione di X

nella popolazione

II - 25

Distribuzione campionaria del numero di successi e della proporzione

Se un campione casuale di n elementi è estratto da una popolazione suddivisibile in

due classi mutuamente escludentisi (E e Ē) caratterizzata dalla probabilità p’ del

verificarsi dell’evento E, allora la distribuzione campionaria del numero di successi

è descritta dalla

distribuzione binomiale

nel caso di campionamento con

ripetizione

distribuzione ipergeometrica

nel caso di campionamento senza

ripetizione

La distribuzione campionaria del numero di successi X, nel caso di estrazione con

ripetizione, essendo binomiale, avrà valore atteso e varianza pari a:

n

E ( X ) E x j np '

j 1

n

n

V ( X ) V x j V ( x j ) np '(1 p ')

j 1 j 1

mentre nel caso di campionamento senza ripetizione avremo la stessa media, e

varianza:

N n

V ( X ) np '(1 p ')

N 1

II - 26

Se invece consideriamo la proporzione di successi (eventi E) in un campione di

n elementi, avremo il parametri campionario X/n, direttamente legato alla v.c. X

numero di successi.

La distribuzione campionaria di P=X/n sarà descritta da:

distribuzione binomiale

con:

np '

p'

n

np '(1 p ') p '(1 p ')

V ( P)

n2

n

E ( P)

distribuzione ipergeometrica

con:

nel caso di campionamento con

ripetizione

nel caso di campionamento senza

ripetizione

E ( P) p '

V ( P)

p '(1 p ') N n

n

N 1

II - 27

In base al teorema del limite centrale avremo inoltre che:

La variabile X numero di successi tende, al

crescere di n, alla distribuzione normale

n

X

N (np ', np '(1 p '))

per cui la probabilità di avere valori di X inferiori ad un certo x sarà:

x np '

P( X x) P Z

np

'(1

p

')

La variabile P proporzione di successi tende,

al crescere di n, alla distribuzione normale

n

P

N ( p ',

p '(1 p ')

)

n

per cui la probabilità di avere valori di P inferiori ad un certo p sarà:

P( P p ) P Z

p p'

p '(1 p ')

n

II - 28

Stima puntuale

Proprietà degli stimatori

Uno stimatore T t ( X1 ,..., X j ,..., X n ) è uno strumento che consente di ottenere

delle stime, ovvero dei valori che possano “validamente” approssimare il valore

di un parametro θ della popolazione.

In genere è possibile calcolare più di uno stimatore per uno stesso campione,

ognuno dei quali fornisce potenziali stime per il parametro θ e la scelta dello

stimatore è basata sull’analisi della sua distribuzione di probabilità e di alcune

proprietà auspicabili.

correttezza

efficienza

consistenza

sufficienza

II - 29

Correttezza

T è uno stimatore corretto di θ se il suo valore atteso è uguale al

valore del parametro incognito:

E(T) = θ

Siccome non siamo in grado di sapere se la stima ottenuta in base ad un

singolo campione osservato sia buona, si richiede che lo stimatore che la

produce sia corretto, ovvero che la stima sia almeno basata su una regola

buona “in media”.

La distorsione di uno stimatore T è definita da: B(T ) = E (T ) - θ

II - 30

Efficienza

Accanto al valore atteso di uno stimatore è utile considerare anche la sua

varianza.

V (T ) = E [T - E(T )]2 = E[T -θ]2

La varianza di uno stimatore fornisce una misura sintetica di quanto i valori

della stima che osserviamo nei singoli campioni “distano” dal valore vero del

parametro che costituisce la loro media.

Dati due stimatori corretti per il parametro θ:

f ( X1 ,..., X i ,..., X n )

g ( X1,..., X i ,..., X n )

Diremo che f è più efficiente di g se:

V f ( X1 ,..., X i ,..., X n ) V g ( X1,..., X i ,..., X n )

II - 31

La correttezza di uno stimatore è importante perché indica che lo stimatore T

ha una distribuzione centrata sul parametro θ.

D’altra parte, il valore atteso di T è tanto più rappresentativo quanto più la sua

varianza è piccola.

Tuttavia, poiché la varianza di T misura la dispersione attorno al suo valore

atteso, se E(T ) ≠ θ (stimatore distorto) è necessario usare un diverso criterio

di valutazione della variabilità:

MSE(T) = E(T–θ)2 = Var(T) + B2(T)

detto errore quadratico medio (mean square error)

Per stimatori corretti l’MSE coincide con la varianza

Diremo che f è più efficiente di g se:

MSE ( g )

1

MSE ( f )

Uno stimatore T si dice consistente (in senso forte) per

il parametro θ se il suo errore quadratico medio tende

a zero al crescere di n

lim MSE (T ) 0

n

II - 32

Stima della media della popolazione

Si consideri una popolazione X, con media μ e varianza σ2.

n

Lo stimatore media campionaria

X

x

j

è stimatore corretto, infatti:

j 1

n

n

n

n

1

1

1

E( X ) E n x j n E( x j )n n1n

j 1

j 1

j 1

n x

j

j 1

La varianza della media campionaria è: V X V

n

pertanto è uno stimatore consistente, poiché:

n

V (x j )

n 2 2

j 1

2

2

n

n

n

lim MSE ( X ) lim

n

n

2

n

0

Se la popolazione è distribuita normalmente con N(μ,σ2) allora anche la media

campionaria si distribuisce come una Normale

2

X N ,

n

II - 33

Stima della proporzione della popolazione

Si consideri una popolazione X distribuita come una Bernoulli con parametro π.

n

La proporzione campionaria

no di [ x j 1]

ˆ

P

n

x

j

j 1

n

è stimatore corretto della proporzione π, infatti:

La varianza della proporzione campionaria è:

pertanto è uno stimatore consistente, poiché:

E ( Pˆ )

(1 )

V ( Pˆ )

n

(1 )

lim MSE ( Pˆ ) lim

0

n

n

n

II - 34

Stima della varianza della popolazione

Si consideri una popolazione X, con media μ e varianza σ2.

n

2

Se utilizziamo lo stimatore “naturale” della varianza campionaria: s

n1 2

il suo valore atteso è: E(s2 )

2

n

x

j 1

j

x

2

n

n 1 2 1 2

B(V ) E (V ) 2

1

n

n

Non si tratta di un difetto grave, la distorsione infatti decresce

rapidamente al crescere di n, tuttavia spesso si utilizza un’apposito

stimatore

La distorsione dipende essenzialmente dal valore di n:

Si definisce varianza campionaria corretta lo stimatore:

S2 è uno stimatore corretto infatti:

e consistente per σ2:

1 n

2

S

x

x

j

n 1 j 1

2

E (S 2 ) 2

lim MSE (S 2 ) 0

n

II - 35

Stima intervallare

Per mezzo della stima puntuale, sulla base di un campione

osservato s S, si ottiene una stima t del parametro θ,

ossia un singolo valore, che, tuttavia, può differire in modo

rilevante da θ stesso.

Per rappresentare l’incertezza legata alla stima, è opportuno

accompagnare la stima puntuale con una misura di variabilità

dello stimatore nello spazio dei campioni.

stima intervallare

La stima intervallare consiste nel calcolare, sulla base dei dati di un

campione, un intervallo di valori [c1,c2 ] per cui sia possibile dire che il

valore del parametro cada al suo interno, con un livello di “fiducia (o

confidenza)” pari a 1-α (assegnato).

II - 36

In generale sia X una v.c. con f(x,θ) dipendente da θ ignoto,

considerato un campione di numerosità n che fornisce i valori

(X1,…,Xj,…,Xn), se C1 e C2 sono due v.c. funzione di (X1,…,Xj,…,Xn) ,

tali che W=C2-C1 è indipendente da θ e che: P[C1≤θ≤C2]=1-α,

esse determinano un intervallo di confidenza del parametro θ avente

coefficiente di confidenza pari a 1-α.

Se per tale intervallo si afferma che al suo interno è compreso l'ignoto

parametro θ, tale affermazione gode di un grado di fiducia pari ad 1-α.

Per costruire un intervallo di confidenza fissiamo una regola [C1(X1,…Xn); C2(X1,…,Xn)]

in base a cui calcoleremo l'intervallo, in funzione del campione (X1,…,Xn).

Un volta estratto un campione (x1,…, xn), si calcolano gli estremi dell'intervallo come

[C1(x1,…,xn) ;C2(x1,…,xn)].

•

A priori possiamo dire che la probabilità di estrarre un campione tale da fornire

un intervallo che includa θ è (1-α).

•

A posteriori, confidiamo di aver estratto uno dei campioni che forniscono un

intervallo che include θ.

II - 37

Per costruire IC un metodo è quello della quantità pivotale o ausiliaria.

Una quantità pivot è una funzione dei dati campionari e del parametro

incognito θ da stimare, la cui distribuzione nello spazio dei campioni S è

completamente nota e non dipende da nessun altro parametro incognito.

Se ad esempio vogliamo stimare la media μ in popolazione di un carattere X, tale che

X~N(μ,σ2)

Sappiamo che:

Z

X

/n

2

con σ noto

N (0,1)

Z è una quantità pivot in quanto:

• è funzione dei dati campionari (attraverso la media campionaria) e del parametro

incognito μ,

• è di distribuzione nota nello spazio dei campioni (è N(0,1))

• non dipende da nessun altro parametro incognito (abbiamo supposto σ noto)

II - 38

Inversione di una quantità pivot

Essendo nota la distribuzione della QP, allora per ogni α fissato, 0< α <1,

esisteranno due valori q1 e q2 dipendenti da α, tali che

Pr q1 QP q2 1

Nel caso precedente della media, fissato un livello di probabilità 1-α , è possibile

determinare due valori z2 e z1 tali che:

X

Pr z1

z2 1

n

X

Pr z /2

z /2 1

n

Pr X z /2

X z /2

1

n

n

II - 39

Abbiamo quindi uno stimatore intervallare definito dall’intervallo:

C1 X z /2

n

C2 X z /2

n

che ha probabilità 1-α di contenere il valore incognito μ.

Ad esempio se α=0.05

P X 1.96

X 1.96

0.95

n

n

La stima intervallare, calcolata sul campione, è invece definita da:

c1 x z /2

n

c2 x z /2

n

e consente di affermare che questo intervallo conterrà μ con un livello di “fiducia”

(o “confidenza”) pari a 1-α (non è più corretto parlare di “probabilità…)

II - 40

Si parla di “confidenza” e non di probabilità perché inizialmente si considera:

X

Pr z /2

z /2 1

n

Pr z /2

X z /2

1

n

n

questo consente di affermare che la probabilità di estrarre un campione la cui

media sia distante da μ meno di zα/2σ/√n è pari a 0,95.

Risolvendo la disequazione rispetto a μ, si ottiene:

Pr X z /2

X z /2

1

n

n

Il cui significato è: se consideriamo per ciascun campione dello spazio campionario

S l’intervallo di estremi X z /2 ( / n ) allora la frazione 1-α di tutti gli intervalli

associati ai campioni di S hanno estremi tali da contenere il valore incognito μ.

II - 41

0.014

0.012

0.01

0.008

0.006

0.004

0.002

0

0

50

100

150

Estratto quindi un campione

effettivo si potrà calcolare il

parametro campionario e

determinare gli estremi

dell’intervallo. Tuttavia non si può

dire che con probabilità 1-α (ad

esempio del 95%) il parametro

incognito è compreso in questo

intervallo, in quanto

Pr X z /2

X z /2

1

n

n

esprime una proprietà che

riguarda lo spazio campionario e

non il singolo campione osservato.

Ma, dato che a priori la probabilità di ottenere un campione a cui è associato un

intervallo che contiene il parametro incognito è del 95%, si ha “fiducia” che

l’intervallo effettivamente determinato sia un intervallo valido.

II - 42

La lunghezza di un intervallo di confidenza con grado di fiducia (1−α)⋅100% è

2z /2

n

e dipende quindi da tre fattori:

1. n: al crescere dell’ampiezza del campione, la lunghezza dell’intervallo diminuisce,

quindi la stima è più precisa;

2. α: al crescere del grado di fiducia richiesto, la lunghezza dell’intervallo aumenta,

quindi la stima è meno precisa;

3. σ: al crescere della deviazione standard, che riflette la variabilità del campione, la

lunghezza dell’intervallo aumenta.

II - 43

Stima intervallare di una media

◊ Varianza della popolazione nota

Dato un campione di dimensione n estratto da una

popolazione con media μ e varianza σ², avremo che,

per il teorema del limite centrale:

x

P z / 2

z / 2 1

n

dove z /2 è l'ascissa che lascia α/2% dei casi della normale standardizzata alla

sua sinistra, mentre z/ 2 è l'ascissa che lascia la medesima percentuale di casi

alla sua destra.

Per mezzo di una semplice trasformazione matematica avremo che la formula

precedente diviene:

P x z / 2

x z / 2

1

n

n

Potremo cioè dire che la media della popolazione è compresa nell'intervallo:

x z /2

x z /2

n

n

,x z /2

n

nel caso di campionamento con ripetizione

N-n

, x z /2

N-1

n

N-n

N-1

nel caso di campionamento senza ripetizione

con un grado di affidabilità dell'1-α%.

II - 44

◊ Varianza della popolazione ignota

In questo caso, se la numerosità del campione è sufficientemente grande (n≥30),

i limiti dell'intervallo potranno essere calcolati esattamente con le stesse modalità

del caso in cui la varianza della popolazione sia nota, utilizzando come stima della

varianza della popolazione la varianza calcolata sui dati campionari che

indicheremo con s²:

n

s2

(x

i

x)

i 1

n 1

n

2

per cui

s

(x

i

x )2

i 1

n 1

avremo quindi gli intervalli:

s

s

x

z

,x

z

/2

/2

n

n

s

x

z

/2

n

nel caso di campionamento con ripetizione

N-n

s

, x z /2

N-1

n

N-n

N-1

nel caso di campionamento senza ripetizione

II - 45

Se invece la numerosità del campione è inferiore a 30 unità non potremo più

assumere la distribuzione normale come distribuzione limite; in particolare

avremo che:

x

s

n

si distribuisce secondo una t-Student

Gli intervalli saranno perciò:

s

s

x

t

,x

t

/2

/2

n

n

s

x t /2

n

nel caso di campionamento con ripetizione

N-n

s

, x t /2

N-1

n

N-n

N-1

nel caso di campionamento senza ripetizione

II - 46

Stima intervallare di una proporzione

Abbiamo già avuto modo di notare come il parametro proporzione possa essere

considerato come una media P X

n

Pertanto potremo costruire intervalli di confidenza seguendo una formula del

tutto analoga a quella della media. Quindi se π è la proporzione della popolazione

da stimare e p è la proporzione calcolata sulla base delle osservazioni

campionarie, avremo gli intervalli per π:

p z /2

p(1 p)

, p z /2

n

p(1 p)

n

p z /2

p(1 p) N n

, p z /2

n

N 1

nel caso di campionamento con ripetizione

p(1 p) N n

n

N 1

nel caso di campionamento senza ripetizione

L'approssimazione che si compie nel sostituire π con p per il calcolo della

varianza è pari a quella che si ha quando si sostituisce σ con s, ed introduce una

fonte di errore trascurabile per campioni sufficientemente grandi.

II - 47

Normalmente si scelgono valori di probabilità: α=0.10, α=0.05, α=0.02,

α=0.01 (i più utilizzati sono α=0.05 e α=0.01).

Sulla base della tavola della normale

standardizzata è possibile ricavare i

valori di zα/2 per i valori di α sopra

indicati

α=0.10

α=0.05

α=0.02

α=0.01

»

»

»

»

z0.050=1.64

z0.025=1.96

z0.010=2.33

z0.005=2.58

II - 48

Esempio 1

Si vuole stimare l’importo medio μ delle 2000 fatture emesse da un’azienda in un certo

esercizio e si costruisce un campione di 100 fatture. L’importo medio risulta pari a 450 euro,

e lo scarto campionario corretto è pari a 65 euro. L’intervallo di stima al 95% (cioè con una

probabilità di errore pari a 0,05) sarà dato da:

caso di campionamento con ripetizione

s

s

65

65

,x z /2

, 450 1.96

x z /2

450 1.96

450 12.74, 450 12.74 437.26, 462.74

n

n

100

100

caso di campionamento senza ripetizione

x z /2

n

N-n

, x z /2

N-1

n

N-n

65

450 1.96

N-1

100

2000 100

65

, 450 1.96

2000 1

100

2000 100

2000 1

450 1.96 6.5 0.9749, 450 1.96 6.5 0.9749 450 12.42, 450 12.42 437.58, 462.42

Se ad esempio il campione fosse n=50, sempre

con (1-α)%=95%, avremo rispettivamente:

Se invece il campione fosse sempre n=100, ma

con (1-α)%=99%, avremo rispettivamente:

(431.98, 468.02)

campionamento con ripetizione

(433.23, 466.77)

(432.21, 467.79)

campionamento senza ripetizione

(433.65, 466.35)

II - 49

Se invece il campione fosse di numerosità n=25 avremo:

Tavola della distribuzione t di Student

s

s

,x t /2

x t /2

n

n

65

65

450

2.064

,

450

2.064

25

25

450 26.8, 450 26.8

423.2, 476.8

s N-n

s N-n

, x t /2

x t /2

=

N-1

N-1

n

n

65 2000 25

65

, 450 2.064

450 2.064

25 2000 1

25

450 26.67, 450 26.67

2000 25

2000 1

423.3, 476.7

II - 50

Esempio 2

Date 5000 fatture emesse da un’azienda in un certo esercizio, si vuole stimare la

proporzione π delle fatture contenenti errori formali e si costruisce un campione di 150

fatture, delle quali 9 contengono errori formali. Si vuole costruire un intervallo al 95%

per la proporzione π.

La proporzione campionaria è:

p

9

0.06

150

caso di campionamento con ripetizione

p(1 p)

p(1 p)

0.06(1 0.06)

0.06(1 0.06)

p

z

,

p

z

0.06

1.96

,

0.06

1.96

/2

/2

n

n

150

150

0.06 1.96 0.0194, 0.06 1.96 0.0194 0.06 0.038, 0.06 0.038 0.022, 0.098

caso di campionamento senza ripetizione

p z /2

p (1 p ) N n

, p z /2

n

N 1

p (1 p ) N n

n

N 1

0.06(1 0.06) 5000 150

0.06(1 0.06) 5000 150

, 0.06 1.96

0.06 1.96

150

5000

1

150

5000

1

0.06 1.96 0.0191, 0.06 1.96 0.0191 0.06 0.037, 0.06 0.037 0.023, 0.097

II - 51

Esempio 3

Consideriamo nuovamente di volere stimare l’importo medio μ delle 2000 fatture emesse da

un’azienda in un certo esercizio, e di ipotizzare che lo scarto quadratico medio sia pari a 65

euro. Quale dovrà essere la numerosità del campione affinché possiamo essere “confidenti” al

95% che l’errore compiuto nella stima non superi i 10 euro (ipotizzando un campionamento

con ripetizione)?

x

z

,x

z

/2

/2

n

n

1.96

65

10

n

n 1.96

z /2

n

65

n (1.96 6.5) 2 n 162.31

10

Il campione dovrà quindi essere n=163

II - 52

Se dall’osservazione del campione di 163 fatture si ottenesse una media per fattura di 450

euro, avremo il seguente intervallo di confidenza al 95%:

s

s

65

65

x

z

,x

z

450

1.96

,

450

1.96

/2

/2

450 9.98, 450 9.98 440.02, 459.98

n

n

163

163

II - 53

Verifica delle ipotesi

Per ipotesi statistica intendiamo un'assunzione riguardante generalmente un

parametro o una distribuzione di una popolazione.

La verifica o controllo di ipotesi consiste nello stabilire se l'assunzione fatta

si possa considerare esatta o meno, sulla base delle osservazioni campionarie.

Un test per provare un'ipotesi è un criterio per accettare o respingere l'ipotesi

fatta sulla popolazione in base alle risultanze di un campione estratto da

questa popolazione.

L'ipotesi che viene formulata sul valore che un parametro può assumere, e che

si vuole provare per mezzo del test, è detta ipotesi nulla H0, mentre viene

indicata con H1 l'ipotesi alternativa, che è l'ipotesi sul valore che lo stesso

parametro può assumere in alternativa a quello definito nell'ipotesi nulla.

II - 54

Le ipotesi possono essere:

semplici:

se definiscono un punto nello spazio dei parametri

H0: θ=a H1: θ =b

composte:

se definiscono delle regioni H0: θ=a H1: θ≠a;

H0: θ=a H1: θ>a

H0 : θ = a

H1 : θ = b

Ipotesi semplice

H1 : θ < a

Ipotesi composta monodirezionale

H1 : θ > a

Ipotesi composta monodirezionale

H1 : θ ≠ a

Ipotesi composta bidirezionale

II - 55

Nella verifica di ipotesi si segue la seguente procedura:

1. definizione dell'ipotesi nulla

2. assunzione della distribuzione del parametro campionario

3. decisione del grado di rischio che si è disposti a correre

4. decisione sulla numerosità del campione

5. definizione, in base ai punti precedenti, della regione critica o di rifiuto R

6. estrazione del campione, calcolo del parametro, controllo con la regione

critica, accettazione o rifiuto dell'ipotesi nulla.

Nel compiere questa decisione si possono commettere due tipi di errore:

1. rifiutare l'ipotesi nulla H0 quando in realtà è vera (errore di I tipo)

2. accettare l'ipotesi nulla H0 quando in realtà è falsa (errore di II tipo)

II - 56

La possibilità di commettere uno di questi errori dipende dal fatto che la prova

di ipotesi, essendo di carattere inferenziale, viene effettuata in condizioni di

informazione limitata, cioè per mezzo di un campione. Questo significa che,

sulla base delle informazioni prodotte da un sottoinsieme della popolazione,

non potremo mai essere sicuri che l'affermazione fatta nei riguardi della

popolazione sia corretta (la certezza l'avremmo solamente osservando l'intera

popolazione).

Ai due tipi di errore sono associate le probabilità e α e β.

In particolare se S f ( X1 , X2 ,....., Xn ) è la funzione test, definiamo

1. P S R / 0 la probabilità di rifiutare H0 quando in realtà è vera

(probabilità errore di I tipo)

2. P S A / 1 la probabilità che la statistica S cada nella regione

di accettazione A, quando l'ipotesi nulla è falsa.

Il valore di probabilità α è detto livello di significatività, e corrisponde alla

dimensione della regione critica.

II - 57

Riassumendo potremo avere:

ipotesi

decisioni

H0 vera

H0 falsa

respingere H0

errore I tipo prob=α

decisione corretta

prob=1-β

accettare H0

decisione corretta

prob=1-α

errore II tipo prob=β

Esiste una relazione tra α e β, tale per cui se diminuiamo la probabilità di avere

un errore di I specie α, aumenterà la probabilità di commettere un errore di

seconda specie β.

II - 58

Se consideriamo ad esempio le ipotesi:

H0 : X 67

H1 : X 68

avremo un'area in cui saremo portati ad accettare H0 , (intervallo A,B). Entro tale intervallo

sarà però possibile commettere un errore di II specie.

E' chiaro se vogliamo ridurre la probabilità β, dovremo aumentare α.

II - 59

La procedura di verifica di ipotesi può quindi essere sintetizzata come segue, nel

caso in cui siano prefissati α ed n:

1. definizione dell'ipotesi nulla

2. assunzione della distribuzione del parametro campionario

3. determinazione della numerosità campionaria n

4.

5.

6.

7.

definizione di α: livello di significatività

identificazione della regione critica

estrazione del campione, calcolo del parametro,

controllo con la regione critica, e quindi accettazione o rifiuto dell'ipotesi nulla

8. controllo di β (detta curva operativa caratteristica OC) o di 1- β, detta

funzione di potenza, in relazione a prefissate ipotesi alternative

se β o 1- β sono adeguate alle necessità proprie dell'analisi, confermare la

decisione

se β o 1- β sono inadeguate modificare α o n e ripetere il test.

La curva operativa caratteristica è un grafico indicante la probabilità di errore di II tipo sotto

diverse ipotesi alternative. Questi grafici forniscono indicazioni riguardo a quanto un test

permette di minimizzare l'errore di II specie; indicano in altri termini la potenza di un test

nell'evitare di prendere decisioni errate.

II - 60

Se invece di fissare a priori i valori di α e n, si vuole mantenere controllata la

probabilità di errore di II tipo, potremo sviluppare un test in cui α e β sono dati,

ed, in base a questi, si determina la numerosità n del campione da osservare, tale

da soddisfare i livelli di probabilità richiesti. In questo caso il processo di verifica

di ipotesi sarà:

1. definizione dell'ipotesi nulla

2. assunzione della distribuzione del parametro campionario

3. definizione di α: livello di significatività, e di β

4. calcolo della numerosità n del campione

5. identificazione della regione critica

6. estrazione del campione, calcolo del parametro,

7. controllo con la regione critica, e quindi accettazione o rifiuto dell'ipotesi

nulla

II - 61

Controllo di ipotesi sulla media di una popolazione

σ

nota

Test bilaterale

1. stabilire le ipotesi H0 : a;

H1 : a

2. stabilire il parametro campionario da utilizzare:

3. decidere il livello di significatività α

z

x

n

4. stabilire la numerosità campionaria n

5. stabilire i limiti critici di z in base ad α ed n

6. estrarre il campione e calcolare il valore di z per il campione e controllare

la sua posizione nei confronti dei valori dei limiti critici

7. decidere se accettare o rifiutare l'ipotesi nulla

8. individuare, se necessario, la curva operativa caratteristica

II - 62

Data la produzione di una macchina che produce componenti meccanici per i quali è previsto

un diametro di 67mm, con una deviazione standard di 3mm, decidere, sulla base di un

campione di 25 unità se la produzione rispetta le specifiche, con un livello di significatività

del 5%.

H0 : 67

H1 : 67

per =5%=0.05 avremo che i valori limite di z saranno 1.96; graficamente il test sarà:

Supponiamo di estrarre il campione e di ottenere x 68

Calcoliamo

z

68 - 67

1

1.67

3

0.6

25

Il valore di z ricade all'interno dell'intervallo fissato come regione di accettazione:

si è quindi portati ad accettare l'ipotesi nulla.

II - 63

Vediamo di determinare la curva operativa caratteristica.

Si ipotizza che alcune ipotesi alternative siano vere;

consideriamo ad esempio vera l'ipotesi μ=68; β sarà la probabilità di avere campioni con

media che ricade nell'intervallo di accettazione costruito con μ=67, quando in realtà μ=68.

I limiti di accettazione per μ=67 saranno:

z / 2

65. 82

3

67 1. 96

68. 18

n

25

E' sufficiente calcolare i valori di z per i due limiti: z1

65. 82 68

3. 63

3

25

z2

68. 18 68

0. 30

3

25

e determinare la probabilità di avere

valori campionari entro questi due limiti,

se è vero che μ=68:

Utilizzando la tavola della normale

standardizzata avremo β=0.6172.

II - 64

Ripetendo questo calcolo per diverse alternative avremo:

z1

z2

β

1- β

68.5

-4.47

-0.53

0.29

0.71

68.0

-3.63

0.30

0.62

0.38

67.5

-2.80

1.13

0.87

0.13

67.0

-1.96

1.96

0.95

0.05

66.5

-1.13

2.80

0.87

0.13

66.0

-0.30

3.63

0.62

0.38

65.5

0.53

4.47

0.29

0.71

μ

1

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

68.5

Funzione di potenza

probabilità

probabilità

Curva operativa caratteristica

68

67.5

67

66.5

66

65.5

1

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

68.5

68

67.5

67

66.5

66

II - 65

65.5

Per diminuire β, fissato a, si dovrà modificare la numerosità campionaria n; quindi per avere

valori di 1- β più bassi dovremo aumentare n. Se consideriamo ad esempio n=100 avremo che

i limiti saranno 66.41 e 67.59, per cui i valori di probabilità saranno:

z1

z2

β

1- β

68.5

-6.97

-3.04

0.00

1.00

68.0

-5.30

-1.37

0.09

0.91

67.5

-3.63

0.30

0.62

0.38

67.0

-1.96

1.96

0.95

0.05

66.5

-0.30

3.63

0.62

0.38

66.0

1.37

5.30

0.09

0.91

65.5

3.04

6.97

0.00

1.00

μ

Graficamente avremo quindi, confrontando

le due curve delle funzioni di potenza:

Funzione di potenza

1

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

68.5

n=100

n=25

68

67.5

67

66.5

66

65.5

II - 66

Test unilaterale

E' il caso in cui si applica il test per la media ad una sola coda per

accettare l'ipotesi:

H0 : a

H1 : a

oppure

H0 : a

H1 : a

Si applicherà evidentemente lo stesso procedimento utilizzato nel caso di test

bilaterali, però il limite della regione di rifiuto sarà determinato in modo che si

trovi da un lato solo della distribuzione del parametro campionario media.

H : 64. 3

Supponiamo di volere verificare l’ipotesi: H0: 64. 3

1

utilizzando un campione n=25, e

sapendo che σ=2, con un livello di

significatività α=0.05.

Per α=0.05, il limite di

accettazione sarà z=-1.645

II - 67

per cui il limite della regione di rifiuto sarà:

z

2

64. 3 1. 645

63. 64

n

25

Si rifiuterà quindi l'ipotesi nulla se la media calcolata sul campione di 25 prove

sarà inferiore a 63.64, oppure se il valore di z calcolato sempre nel campione

sarà inferiore a -1.645.

In questo caso la curva operativa caratteristica sarà:

valori medi

limite regione di

rifiuto

z

63. 64

2

25

curva operativa

caratteristica

63.64

Pr z

2

25

62.5

2.85

0.0020

63.0

1.60

0.0548

63.5

0.35

0.3632

64.3

-1.645

0.9500

65.0

-3.40

0.9997

II - 68

β esprime quindi la probabilità di avere valori medi campionari superiori a

63.64 quando la media della popolazione è diversa da 64.3:

0.014

0.014

0.012

0.012

0.01

0.01

0.008

0.008

0.006

0.006

0.004

0.004

0.002

0.002

0

0

0

0

50

50

100

100

150

150

II - 69

Controllo di ipotesi sulla media di una popolazione

σ

ignota

In questo caso si dovrà utilizzare la distribuzione del parametro

campionario t-Student:

x

t

s

n

con s

(x

i

x )2

n 1

con n-1 gradi di libertà, purché la popolazione di provenienza possa

essere considerata normale.

II - 70

Esempio test bilaterale: supponiamo di volere effettuare il test per:

H0 : 0 65

H1 : 1 65

Ipotizziamo di avere osservato un campione con n=12 che fornisce i seguenti

valori: 55, 62,54,58,65,64,60,62,59,67,62,61; e di volere avere un livello di

significatività del 5%.

Avremo quindi una distribuzione t con (n-1)=(12-1)=11 gradi di libertà da cui

otterremo:

t 2. 20

t 2. 20

2

2

in base al campione avremo inoltre: x 60. 75

s 3. 84

potremo quindi calcolare il valore di t nel campione:

t

60. 75 65

3. 83

3. 84

12

per cui rifiuteremo l'ipotesi nulla.

II - 71

Esempio test unilaterale: data una miscela chimica in cui debbono essere

presenti almeno 64.3 parti di un additivo, si vuole verificare con 25 prove se la

produzione garatisce tale tipo di composizione della miscela al livello del 5%. Il

campione di 25 prove ha presentato:

x 63. 64 e s 2

In questo caso i gradi di libertà saranno (25-1)=24, per cui la soglia del valore

t sarà -1.711.

Il valore del t campionario è invece:

t

63. 64 64. 3

1. 65

2

25

per cui potremo accettare l'ipotesi nulla

II - 72

Conclusioni relative alla verifica di ipotesi sulla media

carattere distribuito in modo normale

Se

0

, sistemi di ipotesi del tipo H 0 : 0 H1 : 0

0

σ2 non noto si testano per mezzo della statistica: t

σ2 noto si testano per mezzo della statistica:

X 0

Z

2

S n

X 0

n

2

Se n è grande (di solito si assume n≥30) allora la differenza

tra t e Z è piccola e possiamo dire che, approssimativamente:

tn1 t di Student con n 1 gdl

N (0,1)

X 0

2

N (0,1)

S n

carattere distribuito NON in modo normale

Se n è abbastanza elevato, è possibile richiamare il teorema del Limite Centrale per

cui, sotto H0, la statistica test

X 0 n

2

N (0,1)

S n

II - 73

Controllo di ipotesi sulla proporzione di una popolazione

Quando si deve sottoporre a test l’ipotesi che la proporzione della popolazione

assuma un determinato valore p0 si conta il numero X di volte in cui la

caratteristica osservata si presenta nel campione di ampiezza n e si calcola la

proporzione campionaria: si osserva cioè il numero di successi in n prove (o

proporzione di successi).

Si ha quindi a che fare con la distribuzione binomiale e si effettua

un test di ipotesi sul parametro p di una popolazione binomiale.

Quando la numerosità n del campione è sufficientemente grande,

Bin(n,p) ~ N(np,np(1-p))

per cui il test di ipotesi sulla proporzione può essere basato sulla

distribuzione normale.

Per sottoporre a test l’ipotesi H0: p=p0 (o in modo analogo p ≤ p0 o p ≥ p0) si utilizza:

Z

X np0

np0 (1 po )

che si distribuisce come una normale standardizzata per n sufficientemente grande.

II - 74

Potremo quindi procedere nel modo già illustrato per i test per la media nel

caso dei grandi campioni.

test

Ipotesi nulla H0

Ipot. Altern. H1

Liv. Signif. α

Valori critici

Regione rifiuto

una coda

p ≤ p0

p > p0

0.01

2.326

Z > 2.326

0.05

1.645

Z > 1.645

0.01

-2.326

Z < -2.326

0.05

-1.645

Z < -1.645

0.01

-2.576 e 2.576

Z < -2.576

Z > 2.576

0.05

-1.96 e 1.96

Z < -1.96

Z > 1.96

una coda

due code

p ≥ p0

p = p0

p < p0

p ≠ p0

II - 75

Si effettuano 500 lanci di una moneta, e si ottiene testa 267 volte.

Decidere se la moneta è truccata con un livello di significatività del 5%

Ripetere il calcolo nel caso in cui si ottenga testa 280 volte

Si assume come ipotesi nulla:

H0 : p = 0.5

e come ipotesi alternativa:

H1: p ≠ 0.5.

Si effettua un test a due code con α=0.05, per cui la regione di rifiuto sarà definita dai valori:

Z<-1.96 e Z>1.96

Abbiamo n=500, x=267, p0=0.5

Z

267 500 0.5

1.52

500 0.5 (1 0.5)

Z=1.52 cade pertanto nella regione di accettazione, quindi l’ipotesi nulla non può essere

rifiutata, potremo quindi ritenere che la moneta non è truccata.

Nel caso in cui si ottenga 280 volte testa,

avremo: n=500, x=280, p0=0.5

Z

280 500 0.5

2.68

500 0.5 (1 0.5)

In questo caso Z cade nella regione di rifiuto, saremo quindi portati a rifiutare l’ipotesi nulla,

ritenendo pertanto che la moneta sia truccata, con un livello di significatività del 5%

II - 76

Nell’effettuare una verifica su alcune procedure di controllo interno si ritiene che almeno il

95% della documentazione debba essere conforme alle procedure previste.

L’esame di un campione di 200 documenti rivela che in 18 di loro sono riscontrabili delle

irregolarità.

Sottoponiamo a test la percentuale di conformità richiesta, al livello di significatività α=0.01.

Si assume come ipotesi nulla:

e come ipotesi alternativa:

H0 : p ≥ 0.95

H1: p < 0.95.

Si effettua un test a una coda e si ha: n=200

Z

200-x=18

x=182

p0=0.95

182 200 0.95

2.60

200 0.95 (1 0.95)

Per il livello di significatività α=0.01 la regione di rifiuto è data dai valori Z<−2.326.

Il valore cade nella regione di rifiuto, perciò si rifiuta l’ipotesi nulla, al livello di

significatività dell’1%, concludendo che la percentuale di documenti conformi è inferiore al 95%.

II - 77