119.8

11-04-2011

13:56

Pagina 1

FrancoAngeli

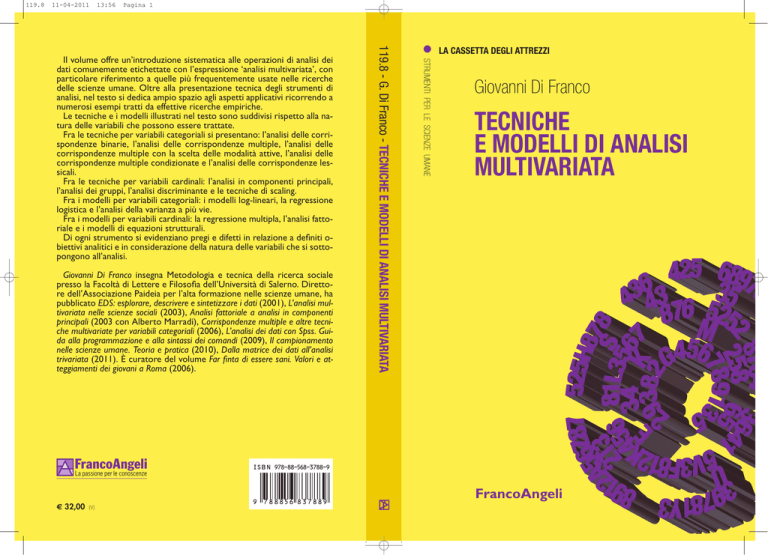

LA CASSETTA DEGLI ATTREZZI

STRUMENTI PER LE SCIENZE UMANE

Giovanni Di Franco insegna Metodologia e tecnica della ricerca sociale

presso la Facoltà di Lettere e Filosofia dell’Università di Salerno. Direttore dell’Associazione Paideia per l’alta formazione nelle scienze umane, ha

pubblicato EDS: esplorare, descrivere e sintetizzare i dati (2001), L’analisi multivariata nelle scienze sociali (2003), Analisi fattoriale a analisi in componenti

principali (2003 con Alberto Marradi), Corrispondenze multiple e altre tecniche multivariate per variabili categoriali (2006), L’analisi dei dati con Spss. Guida alla programmazione e alla sintassi dei comandi (2009), Il campionamento

nelle scienze umane. Teoria e pratica (2010), Dalla matrice dei dati all’analisi

trivariata (2011). È curatore del volume Far finta di essere sani. Valori e atteggiamenti dei giovani a Roma (2006).

119.8 - G. Di Franco - TECNICHE E MODELLI DI ANALISI MULTIVARIATA

Il volume offre un’introduzione sistematica alle operazioni di analisi dei

dati comunemente etichettate con l’espressione ‘analisi multivariata’, con

particolare riferimento a quelle più frequentemente usate nelle ricerche

delle scienze umane. Oltre alla presentazione tecnica degli strumenti di

analisi, nel testo si dedica ampio spazio agli aspetti applicativi ricorrendo a

numerosi esempi tratti da effettive ricerche empiriche.

Le tecniche e i modelli illustrati nel testo sono suddivisi rispetto alla natura delle variabili che possono essere trattate.

Fra le tecniche per variabili categoriali si presentano: l’analisi delle corrispondenze binarie, l’analisi delle corrispondenze multiple, l’analisi delle

corrispondenze multiple con la scelta delle modalità attive, l’analisi delle

corrispondenze multiple condizionate e l’analisi delle corrispondenze lessicali.

Fra le tecniche per variabili cardinali: l’analisi in componenti principali,

l’analisi dei gruppi, l’analisi discriminante e le tecniche di scaling.

Fra i modelli per variabili categoriali: i modelli log-lineari, la regressione

logistica e l’analisi della varianza a più vie.

Fra i modelli per variabili cardinali: la regressione multipla, l’analisi fattoriale e i modelli di equazioni strutturali.

Di ogni strumento si evidenziano pregi e difetti in relazione a definiti obiettivi analitici e in considerazione della natura delle variabili che si sottopongono all’analisi.

Giovanni Di Franco

TECNICHE

E MODELLI DI ANALISI

MULTIVARIATA

I S B N 978-88-568-3788-9

La passione per le conoscenze

€ 32,00

(V)

9

788856 837889

FrancoAngeli

La cassetta degli attrezzi. Strumenti per le scienze umane

Direttore

Giovanni Di Franco, Università di Salerno

Comitato editoriale

Elena Battaglini, Ires-Cgil

Sara Bentivegna, Università di Roma

Alberto Marradi, Università di Firenze

Federica Pintaldi, Istat

Luciana Quattrociocchi, Istat

Marta Simoni, Iref-Acli

La collana, rivolta a ricercatori accademici e professionisti, studiosi, studenti, e operatori del variegato mondo della ricerca empirica nelle scienze umane, si colloca sul versante dell’alta divulgazione e intende offrire strumenti

di riflessione e di intervento per la ricerca.

Obiettivo è consolidare le discipline umane presentando gli strumenti di ricerca empirica, sia di raccolta sia di analisi dei dati, in modo intellegibile e

metodologicamente critico così da consentirne l’applicazione proficua rispetto a definiti obiettivi cognitivi.

I testi sono scritti da professionisti della ricerca che, attingendo alla personale esperienza maturata in anni di attività, offrono ai lettori strumenti concettuali e tecnici immediatamente applicabili nella propria attività di ricerca.

Tutti i volumi pubblicati sono sottoposti a referaggio.

I lettori che desiderano informarsi sui libri e le riviste da noi pubblicati

possono consultare il nostro sito Internet: www.francoangeli.it e iscriversi nella home page

al servizio “informazioni” per ricevere via e-mail le segnalazioni delle novità

o scrivere, inviando il loro indirizzo, a: “FrancoAngeli, viale Monza 106, 20127 Milano”.

Giovanni Di Franco

TECNICHE

E MODELLI DI ANALISI

MULTIVARIATA

La cassetta degli attrezzi

Strumenti per le scienze umane/8

FrancoAngeli

Progetto grafico di copertina di Maria Teresa Pizzetti

Copyright © 2011 by FrancoAngeli s.r.l., Milano, Italy

L’opera, comprese tutte le sue parti, è tutelata dalla legge sul diritto d’autore. L’Utente nel momento in

cui effettua il download dell’opera accetta tutte le condizioni della licenza d’uso dell’opera previste e

comunicate sul sito www.francoangeli.it.

119. La cassetta degli attrezzi. Strumenti per le scienze umane

Volumi pubblicati:

1. Giovanni Di Franco, L’analisi dei dati con SPSS. Guida alla programmazione e alla sintassi dei comandi

2. Silvia Cataldi, Come si analizzano i focus group

3. Federica Pintaldi, Come si analizzano i dati territoriali

4. Giovanni Di Franco, Il campionamento nelle scienze umane: dalla

teoria alla pratica

5. Lucia Coppola, NVivo un programma per l’analisi qualitativa

6. Simone Gabbriellini, Simulare meccanismi sociali con NetLogo

una introduzione

7. Giovanni Di Franco, Dalla matrice dei dati all’analisi trivariata.

Introduzione all’analisi dei dati

8. Giovanni Di Franco, Tecniche e modelli di analisi multivariata

9. Federica Pintaldi, Come si interpretano gli indici internazionali

Guida per ricercatori, giornalisti e politici

Volumi in preparazione:

Alberto Marradi, Come evitare gli errori tipici in un questionario

Indice

pag.

9

2. Progettare l’analisi multivariata dei dati

2.1 Definizione e funzioni dell’analisi multivariata

2.2 Le fasi dell’analisi multivariata

2.3 Il linguaggio dell’analisi multivariata

2.4 Natura delle variabili, tecniche e modelli compatibili

2.5 Cosa leggere per saperne di più

»

»

»

»

13

13

20

23

»

»

28

33

3. Le tecniche per variabili categoriali

3.1 Analisi delle corrispondenze binarie

3.2 Analisi delle corrispondenze multiple

3.3 Analisi delle corrispondenze con scelta delle

modalità attive

3.4 Analisi delle corrispondenze condizionate

3.5 Analisi delle corrispondenze lessicali

3.6 Cosa leggere per saperne di più

»

»

»

35

36

52

»

»

81

87

92

103

4. Le tecniche per variabili cardinali

4.1 Analisi in componenti principali

4.2 Analisi dei gruppi

4.3 Analisi discriminante

4.4 Tecniche di scaling multidimensionale

4.5 Cosa leggere per saperne di più

»

»

»

»

»

»

105

105

147

178

196

200

1. Introduzione

7

5. I modelli per variabili categoriali

5.1 Modelli log-lineari

5.2 Regressione logistica

5.3 Analisi della varianza a più vie

5.4 Cosa leggere per saperne di più

»

»

»

»

»

203

203

241

248

261

6. I modelli per variabili cardinali

6.1 Regressione multipla lineare

6.2 Analisi fattoriale

6.3 Modelli di equazioni strutturali

6.4 Cosa leggere per saperne di più

»

»

»

»

»

263

263

283

291

302

8

1. Introduzione

Le basi di una buona analisi dei dati si gettano nel momento in cui

si progetta una ricerca su un determinato oggetto, fenomeno o problema sociale, si formulano le ipotesi, si definisce il significato dei

concetti rilevanti per l’indagine, si delinea la rappresentazione, in

termini di procedimenti di operativizzazione, del o dei fenomeni che

si intendono studiare, sia in termini spaziali e temporali che in termini di indicatori e variabili che dovranno essere rilevate su una determinata unità di analisi, e così via.

Considerare l’analisi dei dati come la fase terminale del percorso

di ricerca, eventualmente, da appaltare a qualche specialista o mago

del computer al quale si chiede soltanto di applicare, che sia possibile

o no non importa, qualche sofisticata tecnica di analisi multivariata

non può produrre risultati rilevanti, e, spesso, produce solo nonsense.

A volte, per illustrare l’uso delle tecniche e dei modelli di analisi

multivariata dei dati, si ricorre alla seguente analogia: usare le tecniche di analisi multivariata equivale a guidare una macchina; non

occorre sapere come funziona il motore per essere degli ottimi automobilisti. L’analogia è sbagliata in quanto il vero problema è quello

di sapere effettuare la scelta più appropriata rispetto agli obiettivi

prefissati: usare senza consapevolezza le tecniche e i modelli di analisi multivariata è come salire su un’automobile senza sapere quale

strada si vuole percorrere e dove si vuole andare. In altri termini, il

primo principio da non evadere mai è quello dell’indissolubilità fra

teoria e ricerca, fra metodo e tecniche di ricerca.

La tendenza ad attribuire capacità taumaturgiche, “oggettive” e

“scientifiche” a tecniche e a modelli di analisi statistica multivariata è

9

inversamente proporzionale al grado di conoscenza e di comprensione che di queste hanno i ricercatori che ne fanno un uso acritico e

disinvolto. Paradossalmente, per le scienze umane, si può affermare

che tanto meglio si conosce uno specifico modello di analisi dei dati,

ovvero i suoi assunti e i vincoli che esso impone sui dati presenti

nella matrice, e tanto meno si è portati ad utilizzarlo. Dare conto del

paradosso appena esposto è in buona sostanza l’obiettivo del presente

lavoro.

Lo sviluppo dei programmi di elaborazione statistica, che tendono

ad essere di sempre più facile gestione, associato alla diffusione di

massa dei personal computer, permette anche al più inesperto studente l’illusione autogratificante del dominio di tecniche e modelli complessi di analisi dei dati usando un software adatto. In realtà il vantaggio del calcolo elettronico è solo quello di aver reso possibile

l’applicazione dei modelli e delle tecniche di analisi multivariata dei

dati a matrici di grandi dimensioni per cui, anche se una buona parte

di questi modelli e tecniche sono disponibili da molti anni (in diversi

casi anche da più di un secolo), il loro concreto uso nella ricerca è

reso possibile solo dai calcolatori elettronici che sono in grado di

effettuare in pochi minuti miliardi di operazioni matematiche le

quali, se dovessero essere fatte a mano, richiederebbero molti mesi o

anni di lavoro a valenti matematici.

In questo senso, si deve ad Alberto Marradi (1985) un primo grido

d’allarme. Nella presentazione di un numero monografico della

Rassegna Italiana di Sociologia dal titolo Strumenti concettuali per la

raccolta e l’analisi dei dati, egli infatti affermava: “Già la precedente

rivoluzione dei calcolatori (che produsse contemporaneamente lo

hardware capace di gestire i grandi files delle scienze sociali, e un

software più abbordabile da utenti sociologi anziché informatici) aveva provocato un abbassamento del livello qualitativo medio delle ricerche – a giudizio non degli esponenti di un umanesimo di élite, ma

di protagonisti di quella stessa rivoluzione, come Norman Nie, il

creatore del linguaggio SPSS. Migliaia di aspiranti ricercatori, infarinati alla bell’è meglio da scuole estive di tecniche statistiche, hanno

correlato e fattor’analizzato tutto ciò che capitava loro a tiro, producendo tonnellate di nonsense, di cui non pochi quintali hanno trovato

la via della pubblicazione” (1985, 136).

10

A nostro avviso, oggi, uno studente o un ricercatore di scienze umane che intenda avvalersi di questi strumenti di analisi dei dati si

deve porre due ordini di problemi tra loro interconnessi; il primo è

relativo alla comprensione degli strumenti concettuali che stanno a

monte delle suddette tecniche e modelli, e il secondo – ovviamente

dipendente dal primo – è il riuscire a discriminare tra la ormai vasta

offerta nei diversi programmi informatici di analisi statistica dei dati

che, solo apparentemente, offrono le stesse procedure, quello o quelli

che offrono i maggiori vantaggi in riferimento agli obiettivi e alle

necessità di una particolare elaborazione.

Naturalmente, non è necessario comprendere tutte le fasi o tutti i

passaggi degli algoritmi matematici dei singoli strumenti; ma non si

possono ignorare gli assunti e i vincoli che questi presuppongono nei

dati.

Parallelamente allo sviluppo attuale dell’informatica, che prevede

l’utilizzo del computer da parte di utenti totalmente privi di alfabetizzazione informatica, anche i programmi informatici di analisi dei dati

oggi disponibili permettono al più inesperto utente l’esecuzione di

procedimenti di analisi dei dati molto complessi senza assumere da

parte dello stesso un benché minimo controllo delle procedure e, nel

peggiore dei casi, senza richiedergli l’onere di effettuare alcuna scelta

tra le molte possibili. In ambedue i casi non si devono confondere

questi vantaggi o venderli come “oggettività” o come “verità scientifica”, dimenticando i rischi e le distorsioni che questi mezzi statistico-informatici comportano, soprattutto se nel loro utilizzo non vi

è un controllo concettuale delle procedure e una giusta dose di buon

senso. In particolare l’utilizzo di tali procedimenti di analisi prevede

che l’utente sappia, quanto meno, valutare i risultati forniti dal

calcolatore. Questo, spesso, significa saper navigare in un mare di

cifre e di coefficienti statistici nel quale si rischia di rimanere

sommersi. Non a caso, la migliore prova di quanto stiamo affermando è la sensazione di sgomento che gli utenti inesperti provano

quando il computer fornisce i risultati delle procedure di analisi che

rimangono incomprensibili. Allora si tocca con mano la distanza che

separa l’uso di un programma di analisi dei dati e la competenza

metodologica che l’utente deve possedere per sfruttare al meglio le

11

possibilità della semplificazione procedurale offerta dai programmi

informatici.

Il presente volume è complementare ai testi L’analisi dei dati con

SPSS. Guida alla programmazione e alla sintassi dei comandi, e

Dalla matrice dei dati all’analisi trivariata editi nella stessa collana.

Diamo per scontato che gli argomenti dei due volumi siano conosciuti dai lettori di questo testo nel quale si illustreranno solo le più

usate tecniche e modelli di analisi multivariata dei dati trattandole ad

un livello da utente informato. Queste verranno introdotte direttamente nella loro cornice informatica, ossia saranno trattate in relazione alla loro effettiva disponibilità nei packages più diffusi presso i ricercatori delle scienze umane, non trascurando però di fare

riferimento ai fondamenti statistico-matematici che implicano e cercando di evidenziarne pregi e difetti in relazione a specifici obiettivi

cognitivi.

Un consapevole apprendimento delle possibilità di uso di questi

strumenti è possibile solo attraverso un esercizio pratico. Per esercitarsi praticamente nell’analisi dei dati, oltre alle necessarie conoscenze di base di metodologia e di statistica, occorre disporre di un

file di dati, di un personal computer, di un adeguato software informatico e una certa dose di buon senso che non faccia dimenticare che

riuscire a risolvere i problemi di una esercitazione e/o di una simulazione di analisi dei dati è solo una piccola parte del bagaglio di

esperienza che occorre per riuscire a percorrere un intero iter di

ricerca empirica.

Se ripercorriamo a ritroso il consueto ordine secondo il quale si

rende conto di un procedimento di ricerca, possiamo affermare che

una buona analisi dei dati dipende dall’aver costruito una buona

matrice dei dati, che significa aver definito precisamente l’unità di

analisi dalla quale si sono individuati i casi su cui si sono raccolti i

dati e aver progettato bene le variabili; ciò implica che la rilevazione

dei dati sia stata effettuata in maniera pertinente ed efficace rispetto

alla formulazioni delle ipotesi e degli obiettivi esplicitati e definiti

nel disegno della ricerca rispetto al quale l’intero iter di ricerca comincia e, con andamento circolare e iterativo, finisce e riparte.

12

2. Progettare l’analisi multivariata dei dati

Prima di presentare le tecniche e i modelli di analisi dei dati,

riteniamo sia utile delineare un quadro generale di riferimento che

permetta di definire con chiarezza il ruolo dell’analisi dei dati nella

ricerca delle scienze umane.

A tale fine presentiamo alcuni problemi di carattere metodologico

visti in stretta connessione con le procedure di analisi dei dati. Le

possibili opzioni in merito a tali problemi sono determinanti per

progettare correttamente l’analisi multivariata dei dati in relazione

agli obiettivi cognitivi presenti nel disegno della ricerca.

2.1 Definizione e funzioni dell’analisi multivariata

Possiamo definire l’analisi multivariata dei dati come un insieme

di operazioni finalizzate al raggiungimento di almeno uno dei seguenti obiettivi:

1. l’esplorazione del fenomeno oggetto di studio;

2. la descrizione del fenomeno oggetto di studio;

3. la sintesi e la classificazione delle informazioni che riguardano l’oggetto di studio;

4. la spiegazione, l’interpretazione e la specificazione delle relazioni tra le variabili che sono, in via ipotetica, ritenute rilevanti in connessione con il fenomeno oggetto di studio;

5. la previsione di stati futuri che riguardano il fenomeno oggetto di studio.

13

In questo testo i termini di spiegazione, interpretazione e specificazione

vengono usati in senso lazarsfeldiano, ovvero come esiti possibili di un

procedimento di analisi multivariata teso a svelare, procedendo attraverso

controlli con terze variabili, i rapporti di causa-effetto tra due variabili di cui

una è assunta, in ipotesi, come dipendente dall’altra.

L’ordine con il quale abbiamo elencato gli obiettivi perseguibili

non è casuale: essi sono disposti in modo ascendente rispetto: a) al

livello di complessità (dalla relativamente semplice esplorazione alla

più complessa previsione); b) al grado di desiderabilità, nel senso che

un’indagine empirica dovrebbe garantire il raggiungimento di tutti i

cinque obiettivi.

L’eventuale mancato conseguimento degli obiettivi dipende dal

livello di conoscenze teoriche, dal tipo di ipotesi di ricerca che si è in

grado di formulare e dalle esperienze empiriche consolidate in merito

all’oggetto d’indagine.

Un’indagine progettata con finalità prevalentemente descrittivoesplorative avrà ipotesi di ricerca non formalizzate o implicite – in

particolare, uno studio descrittivo-esplorativo di un fenomeno sociale

richiede quanto meno la selezione, teoricamente fondata, di quali

aspetti e caratteristiche del fenomeno oggetto di studio debbano essere prese in considerazione – ed i conseguenti obiettivi dell’elaborazione dei dati saranno l’esplorazione, la descrizione e la sintesi

delle informazioni raccolte.

Se invece l’indagine è di tipo prevalentemente esplicativo, saremo

in grado di formulare ipotesi più complesse ed articolate e l’analisi

dei dati sarà volta a controllare la plausibilità delle relazioni costruite,

la loro forza e la loro generalizzabilità. La possibilità di spingere gli

obiettivi dell’analisi dei dati dalla più semplice esplorazione-descrizione verso la spiegazione-previsione delle relazioni tra un insieme di

variabili dipende dal ricorso ad una teoria da parte di chi effettua la

ricerca: se si dispone di una teoria sufficientemente formalizzata e

ricca si potrà, in sede di analisi dei dati, controllare le ipotesi di ricerca che possiamo derivarne. Se, al contrario, non disponiamo di

una teoria sufficientemente formalizzata in base alla quale specificare

l’oggetto d’indagine allora gli obiettivi dell’analisi dei dati dovranno

limitarsi alla descrizione e alla sintesi delle informazioni raccolte fi-

14

nalizzandole ad una futura messa a punto e ampliamento della teoria

di riferimento.

Il livello di sviluppo teorico non è il solo problema di cui si deve

tenere conto nell’analisi dei dati. Ci sono infatti ulteriori problemi

che vanno considerati, e sono nell’ordine: a) la natura non sperimentale di quasi tutte le ricerche delle scienze umane; b) la natura

delle variabili, che impone una serie di vincoli alle elaborazioni che

su di esse si possono effettuare.

Alcune discipline fisico-naturali sono caratterizzabili come sperimentali in quanto generalmente il loro strumento di indagine è l’esperimento controllato in laboratorio, nel quale il ricercatore ha la

possibilità, schematizzando e semplificando, di:

1. isolare le variabili che gli interessano, ovvero estrapolarle da

qualsiasi altra variabile fonte di disturbo;

2. manipolare la variabile che assume come indipendente facendola variare a suo piacimento;

3. osservare e misurare, con strumenti di solito molto precisi, le

variazioni che la variabile dipendente subisce per effetto delle

variazioni prodotte nella variabile indipendente.

Nelle scienze umane un simile procedimento di esperimento controllato in laboratorio è del tutto inapplicabile per ragioni che sono

ovvie: non è possibile né il controllo-manipolazione della variabile

indipendente, né l’isolamento delle variabili sottoposte ad esperimento da tutte le altre che si dovrebbero tenere sotto controllo per evitare influenze-perturbazioni sulle variabili sperimentali.

Inoltre, si è di fronte alla necessità di aumentare le osservazioni.

Mentre in fisica un atomo di idrogeno è dello stesso tipo di tutto

l’idrogeno che c’è in natura, un individuo inteso sociologicamente,

non è affatto rappresentativo di tutta l’umanità, ma neanche della sua

nazione, o della sua città o del suo quartiere di residenza. Chiarita la

necessità da parte delle scienze umane di raccogliere informazioni su

molti esemplari concreti dell’unità di analisi adottata, si può provare

ad applicare un procedimento di tipo quasi-sperimentale costruendo

due gruppi di individui che sono ritenuti uguali rispetto a tutte le

variabili che interessano nell’esperimento, detti l’uno gruppo sperimentale e l’altro gruppo di controllo, e facendo agire la variabile

indipendente solo sul primo gruppo. Se dopo l’esperimento il gruppo

15

sperimentale differisce significativamente dal gruppo di controllo, si

conclude che l’effetto della variazione intervenuta sia determinato

dallo stimolo sperimentale.

Ricorrendo ad un disegno quasi-sperimentale, tuttavia, non si risolvono i dubbi legati al controllo delle variabili estranee all’esperimento, che rimandano all’assunto che i due gruppi siano in tutto e

per tutto uguali, e che l’effetto della variabile indipendente sia inequivoco e unico nei risultati registrati nel gruppo sperimentale.

Un esempio di quasi-esperimento in sociologia, riportato in molti manuali

di metodologia, teso a controllare il rapporto tra le condizioni di lavoro e la

produttività degli operai in un’industria elettrica portò alla scoperta del cosiddetto ‘effetto Hawthorne’ da parte del sociologo Elton Mayo. L’effetto Hawthorne consiste nella reazione dei soggetti sottoposti ad un esperimento: gli

operai, siano essi parte del gruppo sperimentale o del gruppo di controllo,

aumentavano la loro produttività indipendentemente dalla condizioni più o

meno favorevoli del luogo di lavoro perché erano consapevoli di essere

osservati dai ricercatori e di essere sottoposti ad un esperimento. Evidentemente, la definizione della situazione effettuata dagli individui coinvolti

comporta notevoli difficoltà nell’approntare disegni quasi-sperimentali quando si ha a che fare con esseri umani.

Per le suddette difficoltà le ricerche quasi-sperimentali non sono

molto diffuse in sociologia mentre sono frequentemente applicate in

ricerche di psicologia e psicologia sociale, dove l’assunto di uniformità del genere umano è evidentemente ritenuto più sostenibile.

Se il metodo sperimentale, sia nella sua versione hard (quella tipica delle scienze fisico-naturali sperimentali) che nella sua versione

soft (quella applicata in psicologia), non è quasi mai convenientemente applicabile nelle indagini sociologiche, cosa rimane da fare?

Una parziale risposta a questo quesito è stata formulata da John

Stuart Mill (1843), che non ritenendo possibile l’applicazione del

metodo sperimentale alle scienze umane non rinunciò alla possibilità

di usare i procedimenti logici delle scienze naturali nel campo della

ricerca sociale. Non è questa la sede per sviluppare considerazioni di

tipo logico-epistemologico sui limiti del contributo milliano; ci preme solo sottolineare che tra i cinque canoni di indagine suggeriti da

Mill (il metodo delle concordanze, delle differenze, delle concordanze congiunto alle differenze, dei residui e delle variazioni conco16

mitanti), che in vario modo propongono una logica di tipo sperimentale, il metodo delle variazioni concomitanti, a partire dalla classica

indagine di Durkheim sul suicidio (1897), è quello che più si adatta

alle esigenze e ai problemi delle ricerche sociologiche.

Possiamo allora definire le procedure di analisi dei dati proprie

della ricerca nelle scienze umane con il termine proposto da Nagel di

“investigazione controllata”.

Tranne casi particolari nei quali la rilevazione dei dati viene effettuata in modo esaustivo (e quindi riguarda l’intera popolazione di

riferimento), nella maggior parte delle ricerche sociologiche si ha a

che fare con rilevazioni campionarie che costituiscono una valida

alternativa, in termini di tempi e di costi finanziari, se non addirittura

l’unica scelta possibile per effettuare una ricerca. Naturalmente, l’interesse cognitivo dell’indagine rimane ancorato alla possibilità di

estendere i risultati ottenuti nel campione all’intera popolazione di

riferimento; ciò è reso possibile, per campioni di tipo probabilistico,

attraverso il ricorso a quella branca della statistica che si denomina

statistica inferenziale (Di Franco 2010).

L’ultimo problema da considerare riguarda infine la natura delle

variabili. Anche in questo caso il dibattito metodologico è molto ampio e qui non può che essere accennato a grandi linee considerandone le ricadute che attengono, in maniera particolare, l’analisi dei

dati.

Le informazioni che interessano in una indagine sono operativamente raccolte attraverso una scelta di indicatori che possiamo

intendere come concetti di proprietà che vengono trasformati in

variabili da una definizione operativa. Definire operativamente un

concetto di proprietà significa quindi fissare un insieme di regole che

consentono di rilevare concretamente per ogni caso il suo stato sulla

proprietà in considerazione.

Nelle ricerche delle scienze umane le proprietà che solitamente si

rilevano si possono classificare in continue o discrete come mostrato

in tabella 2.1.

Una proprietà si definisce discreta se i suoi stati variano per incrementi

finiti, ad esempio il numero dei figli di una coppia di coniugi, il numero di

volte che una persona si reca in chiesa in una settimana, etc.; continua se i

17

suoi stati, almeno teoricamente, variano per intervalli infinitesimi, ad esempio le misure fisiche come il tempo, lo spazio, etc. Evidentemente una

proprietà continua per essere misurata deve essere resa discreta individuando una unità di misura convenzionale e costruendo uno strumento di

misura che esprima i diversi stati rilevati con un numero finito di suoi multipli

e sottomultipli.

A loro volta le variabili che ne derivano si possono distinguere in cardinali e categoriali (una variabile si definisce cardinale, in senso stretto,

quando è esprimibile con una unità di misura convenzionale, che può essere, specie nel caso di proprietà di tipo psico-attitudinali, anche sottintesa,

come avviene nella costruzione delle scale Thurstone con la tecnica degli

intervalli che appaiono uguali; in ogni caso il continuum che rappresenta il

campo di variazione della proprietà viene diviso in intervalli uguali, o supposti tali, a partire da un punto arbitrario detto anche ‘zero convenzionale’.

Un caso particolare è rappresentato da quelle proprietà i cui stati sono

rilevabili non con una unità di misura, ma con una unità di conto, ad esempio, il numero dei figli, l’ammontare dei depositi bancari posseduti da una

famiglia non si rilevano misurando, ma attraverso il conteggio; in questo

caso il valore zero rappresenta l’assenza della proprietà, ma dal punto di

vista dell’analisi dei dati questa differenza viene superata dalle operazioni di

standardizzazione delle variabili, comunque necessarie per rendere comparabili variabili rilevate con diverse unità di misura o di conto, che permettono

di esprimere gli stati sulle proprietà in unità di scarto-tipo dalla media che

viene posta a zero.

Quando una proprietà non è rilevabile né con una unità di misura, né

con una unità di conto, allora si dice categoriale. In questi casi la definizione

operativa appropriata per rilevare gli stati sulle proprietà è la classificazione

semplice, ossia che non prevede alcun ordine fra le classi individuate, o

ordinata, che al contrario instaura fra le classi individuate un qualsiasi tipo

di ordinamento. A partire dalla celebre classificazione di Stevens (1946), il

termine ‘misurazione’ è stato eccessivamente esteso, riferendolo a qualsiasi procedura che permetta di attribuire dei numeri a degli oggetti o eventi

seguendo determinate regole.

Tabella 2.1 – Tipi di proprietà e operazioni di rilevazione connesse

Tipo Proprietà

Continua

Discreta

Cardinali

misurazione

conteggio

Categoriali

classificazione ordinata

classificazione ordinata o non ordinata

Ai fini dell’analisi multivariata occorre sottolineare che le operazioni eseguibili sulle variabili dipendono dalla loro natura: se le variabili sono cardinali (frutto di misurazione o di conteggio) possiamo

18

applicare tutte le procedure statistiche compatibili con questo livello

(dal calcolo della media, allo scarto tipo, alla standardizzazione delle

variabili, al coefficiente di correlazione lineare, alla regressione,

etc.); se le variabili sono categoriali si devono applicare altri strumenti statistici (frequenze semplici, frequenze relative, moda, mediana, differenza interquartilica, etc.).

In realtà, per non rinunciare all’applicazione di strumenti statistici

considerati più potenti (come la correlazione e la regressione lineare,

etc.) si è sempre tentato di rendere cardinali anche le variabili categoriali ricorrendo a diversi escamotages, che in taluni casi violano

pesantemente i canoni della correttezza metodologica.

Tra i diversi sistemi escogitati per trattare come cardinali delle variabili

categoriali ricordiamo la creazione di dummy variables o variabili booleane

trasformando una variabile categoriale con un numero k di modalità in k-1

variabili binarie dove si registra la presenza/assenza del carattere preso in

considerazione.

Ad esempio, se la variabile da trasformare è il genere con due modalità

(1 = maschio e 2 = femmina) basterà definire una sola dummy variable –

etichettata ‘mascolinità’ – che assumerà valore 0 nel caso della modalità

femmina e valore 1 nel caso della modalità maschio.

Un altro modo di trattare come cardinali le variabili categoriali consiste

nel calcolare i logaritmi delle frequenze relative, come avviene nei modelli

log-lineari.

Fortunatamente, oggi disponiamo di molti strumenti di analisi

multivariata applicabili alle variabili categoriali, come vedremo più

avanti.

Alberto Marradi (1993), considerando la natura delle variabili in

relazione alle operazioni di analisi dei dati, sottolinea come in sede di

analisi multivariata la distinzione tra le variabili tende a diventare

dicotomica, mentre per i livelli di analisi monovariata e bivariata essa

è più articolata come mostrato nel quadro sinottico riportato in

tabella 2.2.

19