Statistica di base

Introduzione

Ok eccoci qua a studiare Statistica di base

Cos’è la statistica?

La statistica si occupa di derivare da un insieme di dati delle conclusioni La parte che si occupa di

raccogliere e rappresnetare i dati è la statistica descrittiva,mentre quella addetta alla loro analisi e alla

“predizione probabilistica” dei risultati è detta inferenza statistica. Se Raccogliamo dei dati su un

determinato evento o proprietà, vogliamo di solito poter intuire un probabile risultato. Affinche questo

risultato sia però veritiero, occorre che i dati raccolti non siano influenzati da fattori non presi in esame. Ad

esempio se volessimo sapere chi vince le elezioni e facciamo il sondaggio su una piccola parte per stabilire

all’incirca come vota la popolazione, non potremmo scegliere le persone per il sondaggio solo in una

regione appertamente schierata(cosa che tra l’altro spesso fanno xD) perche falseremo il risultato non

avendo preso in considerazione un campione causale. Difatti bisogna sempre far si che il campionamento

dei soggetti che si usano per una qualsiasi raccolta dati statistici siano casuali, pena risultati poco veritieri.

Termini usati in statistica sono:

Popolazione

o insieme spesso troppo grande per un esame esaustivo, su cui vogliamo fare delle ipostesi

statistiche

Campione

o Sottoinsieme della popolazione scelto a caso per avere dei dati su cui inferire(inferire

significa “dedurre”) un risultato

Il termine statistica deriva dal fatto che

all’inizio era stata usata per derivare da

numero di morti, eta delle morti etc etc il

numero di persone residenti nelle citta e

le speranze di vita(utili i banchieri).

STATISTICA DESCRITTIVA

La statistica descrittiva si occupa di come i dati devono essere rappresntati per poter essere facilmente

studiati(su cui cioè si possa inferire facilmente), attraverso grafici e rappresntazioni che mettano in risalto le

proprietà.

Se i valori raccolti durante l’analisi sono un numero non troppo alto(ad esempio si sono raccolti i dati

inerenti una serie di voti dal 18 al 30 ad un esame, con un rangedi valori raccolti di 30-18 = 12 valori

massimi) si può usare un diagramma che esponga le frequenze dei dati(quante volte sono stati raccolti),

oppure una tabella, che però mette meno in risalto le proprietà. Ecco i grafi (e la tabella) per farci un idea,

inerenti una raccolta di stipendi all’interno di un’azienda.

Come vedete è facile inferire dati come il minimo stipendio, quante persone prendono la cifra massima,

quale stipendio è quello più frequente e anche la ditribuzione delle ricchezze aziendali(si vede infatti che la

distribuzione è a forma di campana, quindi è ragionevole pensare che quelli con stipendio basso

probabilmente salgono in fretta ad avere uno stipendio medio, e poi rallentano per quello più alto, poiche

altrimenti ci sarebbe più probabilemente stata uan distribuzione equa, ovvero una linea dritta e orizzontale

approssivativamente nel diagramma 2.3 qui sopra).

Volendo possiamo trasfromare le frequenze sopra in frequenze relative(ovvero calcolare quale percentuale

del totale dei dati occupano) ottenendo per i dati di prima una tabella così:

Le frequenze relative sono comode sia nei grafi sopra visti, in cui però non cambia nulla ai fini grafici(il grafo

è uguale, in pratica abbiamo solo diviso ogni colonna del grafico per il numero totale degli elementi), sia nei

grafi percentualistici, come quelli a torta, come il seguente:

A volte però l’assunzione che i valori da analizzare siano pochi non è vera xD e lì? Ci spariamo :D

No vabbe ho un idea migliore, prendiamo i dati e li dividiamo in “Classi”. Esattamente come nell’idea di una

classe di una scuola, essa contiene un determinato intervallo di dati. Prendiamo per definizione da qui in

poi che le classi contengano il valore piu piccolo dell’intervallo di dati che descrivono e non quello più

grande(per cui se diciamo che una classe contiene il numero di bambini con un età da 20 a 21 anni

includeremo i bambini che hanno 20 anni ma non quelli con 21). Di solito i dati vengono divisi in 5/10 Classi

per poter ottenere un risultato studiabile, ma si può scegliere diversamente.

Un Esempio di Rappresnetazione in classi:

Questi dati possono essere poi rappresentati in grafi, con un istogramma a barre, usato per convenzione

perchè lascia intendere che si sta parlando di un intervallo approssimato(anche qui si può lavorare sia su

frequenze assolute che relative, ovvero percentuali)

Utile anche se un pò meno immediata è la rappresntazione con un Ogiva, un grafo che invece che far

vedere quanti dati sono presenti per un valore indica quanti dati sono minori di quel valore

Per ogni valore T sull’asse X nell’esempio precedente,possiamo capire quanti valori minori di T sono stati

raccolti. Ad esempio se prendiamo T = 900 ci accorgiamo che pressapoco il 40% dei dati raccolti (la scala

nell’esempio rappresnta le percentuali tra 0 e 1 nell’asse Y, e a 900 vale 0.4) è minore di 900. Visto che si

riferisce alla vita di una lampadina, ciò significa che il 40% delle lampadine schiatta prima dei 900 giornid i

accensione xD

Come Curiosità Utile ecco un modo per organizzare dati in tabella in maniera sintatica.

Il diagramma stem/leaf.

In questo tipo di rappresntazione tabellare, una parte significativa del dato raccolto(detta stem) viene usata

come classe e poi vengono scritte le varie leafs ommettendo lo stem. Nella tabella precedente ad esempio

per capirci XD hanno raccolto le temperature medie nelle città americane e visto che i valori erano del tipo

“70.0” hanno preso le decine come stem e hanno scritte tutti i valori rimasti separati da virgole(le leafs) in

maniera molto piu sintetica. Inoltre Anche da questa rappresntazione di possono inferire deduzioni, come

ad esempio che le città arrivano al massimo a 50 gradi farenheit e sono rare quelle che hanno temperature

superiori, visto che come si vede sono solo 2(cosa poco deducibile da una tabella disordinata XD)

LE_STATISTICHE_DEI_DATI

Per Orientarci su una mole di dati raccolti veramente enorme dobbiamo in qualche maniera ottenere

informazioni che prescindono i grafici. Definiamo quindi alcune operazioni utili allo scopo.

La media classica(qui detta Media Campionaria) è definita matematicamente cosi:

Si può facilemente verificare che calcolare la media su una serie di dati molto grande in questo modo è

difficile e rompiscatole XD però se si riesce a scrivere tutti i dati Xi raccolti in questa forma

ovvero i dati sono descrivibili in un equazione con A e B costanti,

allora la media calcolata sui valori Y ottenuti dall’equazione, è uguale a

.

Si prenda ad esempio i seguenti dati:

Li possiamo descrievere con un equazione del tipo Y = X – 280 e otterremmo i seguenti valori:

la cui media è facile da calcolare ed è

A questo punto sapendo che

è uguale a X – 280 verrà che 6/10 + 280 = 280.6 che è la media cercata :D

Nel caso avessimo a disposizione frequenze, è evidente che ogni basta calcolare la frequenza relativa e

usarla come peso per i singoli dati.

se avessimo 2 stipendi uno da 10000 euro al mese con una frequenza di 5 e uno da 3000 con una frequenza

di 30 per fare una media basta (5* 10000 + 30 * 3000)/ 35 che poi matematicamente se passiamo alle

frequenze relative (5/35) * 10000 + (30/35) * 3000

Che in formula standardizzata viene

A volte però non ci interessa una media campionaria, ma una mediana, ovvero il valore che sta

precisamente a meta tra il massimo e il minimo valore registrato, senza pesi.

Per trovarlo si ordinano i valori dal piu piccolo al piu grande, poi se il numero N dei dati raccolti è dispari si

prende il valore nella posizione (N+1)/2 altrimenti si rende il valore che sta nella posizione indicata dalla

media tra N/2 e (N+1)/2

Riporto un breve passo sull’Utilità della Mediana e della Media:

Confrontando gli stacchi dalle due medie dei due casi si vede che nel primo caso(l’ambiente sterile) c’è uno

stacco maggiore che nel secondo(l’ambiente normale). Si intuisce facilmente quindi che c’è un vantaggio

per alcuni topi nell’ambiente sterile. Ma il fatto che le due mediane siano simili, ci porta a pensare che

questo vantaggio non sia comune a tutti i topi ma dipenda da cause specifiche del singolo topo, non legate

all’esperimento.In pratica significa che qualche topo ha delle condizioni tali non note che lo favoriscono

nell’ambiente sterile, ma gli altri topi non ne traggono il minimo beneficio XD. Per andare oltre nel concetto

di mediana, esistono anche divisioni extra in egual maniera, come ad esempio i Quartili e i Decili(divisioni in

4 classi e 10 ripettivamente), ottenute dividendo in parti uguali usando gli stessi principi della mediana,c he

consentono altre deduzioni, come ad esempio quanto è andato bene un esame(se uno studente avesse un

voto superiore all’terzo quartile significa che tale studente ha preso un voto maggiore del 75% del resto

della classe, ovvero è tra i migliori). Ps se non vi è chiaro l’esempio dei topi, pensate piu in grande coi

numeri. Se mettiamo 1000 topi e in entrambi i casi muiono tutti in un giorno e uno non muore e campa

1000 giorni in ambiente sterile, è lecito dire che l’ambiente sterile fa bene? XD La media direbbe di si, la

mediana ci direbbe che non cambia nulla XD Se ne dedurrebbe che qualcosa succede iin ambiente sterile

per alcuni topi, ma non certo che fa bene sempre xD

Definiamo poi Moda il valore con la frequenza più alta, e nel caso di più frequenze piu alte, le chiameremo

valori modali. Ad esempio potrebbero essere valori modali 4 gradi centigradi e 40 gradi centigradi

nell’ambito delle temperature medie di una città. Significherebbe che 4 e 40 sono i valori registrati piu

spesso durante le misurazioni(e che il numero di misurazioni dei due valori è ovviamente uguale) e che il

nostro termometro è rotto ahahah XD

Un esempio di uso della moda è l’ambiente didattico. Non è Auspicabile che due punteggi molto distaccati

siano valori modali, è probabile che il metodo di insegnamento non sia molto efficace in tutti i casi in

questo caso. E’ Auspicabile che la moda sia un punteggio alto invece.

Parliamo ora di Varianza:

La varianza non è altro che una stima della concentrazione dei dati attorno alla media campionaria. Piu è

alto tale valore e più i dati NON sono concentrati attorno alla media.Si utilizza una funzione quadratica

perche è piu comoda che usare il modulo(necessario se si volesse considerare una distanza in valore

assoluto,cosa che viene a gratis nel caso di un quadrato)

Si calcola con questa formula

Come si capisce facilemente si tratta della somma delle distanze dei valori della media campionaria da

quelli campionati. Questo ci da una stima di quanto si discostano i dati dalla media. Il motivo per cui si

divide per n-1 è dovuto a ragionamenti legati al calcolo matematico e non ce ne cureremo.

Per Calcolarla piu velocemente si può usare anche la seguente formula per seplificare laparte superiore,

frutto di riduzioni matematiche, che immagino potrete intuire facilmente e riflette un secondo è quasi

banale che è vera XD

Inoltre da tenere a mente che sommare una costante a ciascuno dei dati non fa cambiare la varianza, per

ovvie ragioni, mentre moltiplicarli per una costante fa venire la varianza moltiplicata per il quadrato di

quella costante

MATEMATICA PER PICCINI:

Le equazioni di secondo grado hanno la seguente formula di risoluzione una volta portate in forma

normale.

La radice Quadrata della Varianza è detta Deviazione Standard Campionaria, e indica di quanto si

discostano i valori in media dalla media xD(che giroooo di paroleeeee XD). In pratica il valore utile sara

questo, la varianza è usata per avere una stima al quadrato senza dover gestire il segno negatvo della

distanza e semplificare i calcoli in moltissimi casi :D

Definiamo Percentile K-esimo un valore X che è maggiore del K percento dei dati e minore del restante

(100 – K) percento. Se ce n’è piu di uno il percentile K-esimo è la media di questi valori trovati. E’ evidnete

che i Quartili definiscono 4 percentili nei punti di divisione. E’ Altrettanto ovvio che il 50-esimo percentile

non è altro che la Mediana! :D

Definiamo di rimando in ultimo il Box Plot, che è un grafo per mostrare la divisione in quartili dei

dati.Eccone un esempio:

Il rettangolo dal primo quartili al terzo(30-34) è detto scarto interquartile.

la lunghezza della riga dal primo valore all’ultimo è detta Campo di Variazione o Range

In genere più è alto lo scarto interquartile piu i dati sono dispersi(aumento della deviazione standard).

Concludiamo questa sezione con una discussione sui dati bivariati.Un Dato Bivariato è un campo che ha due

valori misurati invece che uno. Ad esempio se stiamo facendo una statistica sul numero di battiti del cuore

al minuto e vogliamo sapere come varia in base agli anni di istruzione delle persone campionate, otterremo

per ogni dato campionato delle coppie di valori del tipo (frequenza cardiaca,anni di studio).

Per Renderci meglio conto di un eventuale correlazione è sempre bene vederlo graficamente

E per farlo usiamo il diagramma di dispersione:

Questo diagramma ha un punto in ogni intersezione di valori che forma una coppia-valore.Leggerlo al

momento è complesso ma poi capiremo cosa cercare e tutto diventerà chiaro.

Definiamo il coefficiente di correlazione campionaria la seguente variabile:

Con r che ha le seguenti prorpietà:

Il coefficiente di correlazione R è utile perche ci da una stima quanto i due dati siano correlati.

In pratica se R è uguale a 0, i dati non c’azzeccano un cavolo XD e nel diagramma di dispersione sono tutti

belli sparsi,mentre nel caso di R > 0 i valori tendono a essere correlati positivamente(cioè se cresce uno

cresce pure l’altro), fino a R = 1 che è la correlazione massima.Nel caso di R < 0 i valori sono invece correlati

negativamente(se uno cresce l’altro decresce) fino a R = -1 che come per R = 1 significa correlazione

massima, ovvero che se uno dei due valori cambia l’altro cambia linearmente in maniera analoga(a seconda

del segno di R)

Un valore R = 1 nel diagramma di dispersione risulterebbe con tutti i punti allineati su una linea retta con m

= 1 e q = 0(una retta a 45 gradi passante per l’origine) mentre un valore completamente negativo li

allineerebbe in una retta perpendicolare a quella sopra descritta XD Adesso arrivano le figure cosi capite eh

xD

Come potete vedere sopra piu i valori sono vicini al valore 1 piu i punti si allineano in un modo(retta per il

centro e m=1) mentre per valori negativi si allineano in un altro(perpendicolari alla retta precedente con m

= -1 ). Ora sapete che cercare.

Nel caso di prima della frequenza cardiaca e gli anni di istruzione, si nota che R dovrebbe essere

negativo(dalla forma) indicando una correlazione negativa tra anni di istruzione e frequenza del cuore, che

sta a significare che chi studia ha il cuore che batte piu lento(che in teoria è un bene XD)

NOTARE BENEEEEEEEEEEEEEEEEEEEEEEEEEEEEEEEEEEEEE (>.<)

Qui non si parla di causa effetto ma di correlazione i risultati inferiti da questa ricerca non sono che chi

va a scuola ha il cuore che batte piu lento per il fatto di essere andato a scuola, ma che statisticamente chi

va a scuola scatena na serie di eventi che lo portano ad avere con piu probabilita un cuore piu lento(un

esempio: la scuola magari da diritto a sconti per le palestre e la gente ne fa piu uso). Spesso infatti le

correlazioni non sono dirette,ma arrivano da terze parti.Ad esempio potremmo ottenere da una ricerca che

chi legge molto vive piu a lungo, ma non è che se vi mettete a leggere campate 100 anni, magari è solo il

fatto che se fate quello, non vi abbuffate di schifezze dolci :D

Probabilita

Nel campo della statistica rientra a pieno diritto anche lo studio della probabilità, perchè difatti l’inferenza

statistica è del tutto una semplice ipotesi probabilistica(di solito si arriva dire che una evento è

statisticamente molto probabile.La statistica non è una scienza che dà risultati esatti).

Cominciamo col definire che in che modo vogliamo definire la probabilità. Prendiamo un insieme di possibili

risultati previsti da un esperimento, che chiameremo spazio degli eventi, e ci definiamo sopra dei

sottoinsiemi che chiameremo eventi. Questi insiemi possono essere disgiunti (tipo il lancio di un dado) o

congiunti (la coppia generata dal lancio di due dadi insieme). Ad esempio mettiamo che voglio lanciare due

dadi e vedere se esce un 2. Questo è un evento definito da un insieme congiunto.

mettiamo che un bambino ad esempio prenda i dadi e faccia uscire solo una queste 4 coppie:

(1,2)(2,3)(4,3)(1,5)

Queste 4 coppie sono lo spazio degli eventi.

In queso caso ogni coppia ha la stessa probabilità di uscire, ma se cerco un 2 ci sono lo 2 coppie che ne

hanno uno.

Ma se sapessi che uno dei due dadi è un 3? Allora la coppia che ha un 2 associato con un 3 è una, mentre il

nuovo spazio degli eventi diventerebbe (2,3)(4,3) e quindi avrei una possibilita su 2 elementi dello spazio

degli eventi = 1/2 :)

Qua dò un pò di definizioni che dovrebbero essere banali, quindi mi soffermo solo sul significato

probabilistico della cosa :D

Defininiamo P(E) come la probabilita tra 0(non avviene mai) e 1(avviene sempre) di un evento E.

1) P(E1 Λ E2) è la probabilità che E1 e E2 si verifichino entrambi( E1 e E2 ).

2) P(E1 V E2) è al probabilità che si verifichi almeno uno dei due Eventi(E1 o E2 )

Il simbolo di insieme vuoto si usa per indicare che probabilita in AND(la prima qui sopra numerata) o in

OR(la seconda) non si può mai verificare. Nel caso dell’AND si parla di eventi mutualemnte esclusi(chissa

perche??).

Per ogni Evento E definiamo l’evento NOT(E) come il complementare, che si verifichera solo se non si

verifica E

Ricordando un pò di algebra lineare, qua nella figura(sono solo un pò di proprietà utili e le notissime leggi di

De Morgan) introduciamo anche i diagrammi di Venn

Il diagramma di Venn sono usati per rappresntare una situazione di eventi. Il quadrato è lo spazio degli

eventi, i cerchi corrispondono a degli eventi e le loro intersezioni a risultati dove gli eventi si sono entrambi

verificati.Ad esempio il secondo schema in figura indica che si p verificati tutti e due gli eventi (cerchi) presi

in considerazione(area colorata in nero rappresenta il verificarsi di un evento )

Definiamo ora due Assiomi banali ma che dobbiamo citare per forza XD al solito mi dilungo poco perche li

dovreste gia sapere xD E è un evento e S è lo spazio degli eventi

La probabilita P(S)è da intendersi in senso insiemistico: Se lanciamo un dado, la probabilità P(S) equivale a

dire “esce un numero tra (1,2,3,4,5,6)” il che è banalemnete sempre verificato

Questo terzo assioma merita però spiegazione:

Per ogni E1,E2,E3,....,En mutualmente esclusivi(cioè se se ne verifica uno non si verifica nessuno degli altri)

vale:

In pratica ci dice che la probabilita che si verifichi uno degli eventi in questione è uguale alla somma delle

probabilità di ogniuno di questi singoli eventi. Essendo Mutualmente esclusivi, la cosa risulta abbastanza

banale, perche verrebbe P(0 + E + 0 + 0 ) = P(0) + P(E) + P(0) + P(0) nel singolo caso.

Altre probabilità note:

con E e F due eventi qualasiasi

Vediamo ora il caso aprticolare di spazi con eventi equiprobabili. Se uno spazio ha tutti gli eventi interni

equiprobabili(tipo un dado non truccato xD) allora la possibilita che un evento(o una combinazione di

eventi, come nel caso di piu dadi ad esempio) si verifichi è data da (grandezza della combinazione di

eventi)/(cardinalità di S). Questo principio vale solo per spazi di grandezza finita(altrimenti sarebbe un pò

difficile capire qual’è la probabilita che uno di quelli si verifichi XD).

Per chi non ricordasse il coeffieciente binomiale è quello scritto cosi:

E indica il numero di insiemi di r elementi su un insieme di grandezza n.

Alcune caratteristiche del coefficente binomiale sono:

Può tornare molto comodo sapere calcolarlo in talune situazione probabilistiche :D

Parliamo ora di roba un pò piu seria

Come si fa a capire la probabilità di un evento, dopo che se ne è verificato già un’altro? Semplice si usa la

cosidetta probabilita condizionata.La probabilità condizionata è la probabilita che si verifichi un evento a

fronte del fatto che se ne è verificato già uno.In formule:

Se si è verificato F, qual’è la probabilita che si verifichi E??

La formula deriva dal fatto che la probabilità che si verifichi E se si è verificato F è limitata da F stesso.

Vediamola in senso insiemistico. Mettiamo che l’evento E(tiriamo fuori da un sacchetto prima due lettere

dell’alfabeto senza rinserilre dentro, poi ne estraiamo solo una) sia composto dagli elementi (x) di un

insieme che contiene tutte le lettere delll’alfabeto. F può essere composto ad esempio da (z) e (a) (con la

medesima descrizione). Se è uscito F significa che abbiamo estratto dal sacchetto (z) e (a). Sapendo questo

e dandolo per certo per ipotesi, ci troveremo con un sacchetto in cui mancano 2 lettere per vedere se si

verifica E quindi la probabilita di E scende da 1/21 a 1/19(stiamo estraendo la seconda volta, quindi un

solo numero ) La probabilita che si verifichino E e F insieme è di 1/21 * 1/20 * 1/19 (perchè ho 21

possibili scelte nel primo caso, 20 nel secondo, e 19 nel terzo di estrarre i valori, (z),(a),(x)). Ma noi

sappiamo che (a) e (z) sono gia usciti. Se divisiamo per la probabilita che escano (a) e (z) (ovvero P(F) )

otteniamo proprio 1/19

A volte i due eventi sono slegati tra loro, ovvero le rispettive probabilità non si influenzano tra loro(se si

verifica un evento E la probabilita che si verifichi un evento F non cambia, come nel caso di lanciare una

moneta piu volte. Se è già uscita testa, la probabilita che esca croce al prossimo lancio non varia ). In quel

caso si parla di eventi indipendenti(altrimenti dipendenti).La formula per provare l’indipendenza degli

eventi è la seguente:

Cioè se la probabilita che si verifichino insieme i due eventi è uguale al prodotto della probabilta che si

verifichino separati, significa che non c’era nulla in comune tra le loro probabilità.Questo ci dà una formula

per risolvere alcuni problemi. Se sappiamo che E e F sono indipendenti, possiamo calcolare il risultato

usando la motiplicazione come AND.

Definiamo ora(lo so rompo con tutte ste definizioni ma purtroppo cosi è la cosa xD) la fattorizzazione XD

Partiamo dal definire F come un insieme di eventi mutuamente esclusivi che ricoprono S(lo spazio). In

pratica F contiene tutti i possibili casi di un evento su S(con l’aggiunta che siano mutualmente esclusivi,

quindi disgiunti)

Questa formula detta di fattorizzazione. Ci dice che la probabilita che si verifichi un Evento E in un simile

spazio e con una simile divisione è data dalla somma delle probabilita che si verifichi al passo i, E con

l’evento F-iesimo.è evidente che se tutti gli eventi F sono mutualmente esclusivi, E è contenuto in uno o più

degli eventi F(tipo E è “esce un 2” e Fi è “Esce un 2”) e che la somma delle probabilita che si verifichino gli

eventi F dopo E è 1. Quindi si intuisce facilemente che la probabilità che si verifichi E(esce un 2) è uguale

alla probabilità che esca E e un altro numero qualsiasi(che è uno).Si va delineando il concetto di

moltiplicazione per AND e somma per OR, che valgono solo in certe circostanze delineate(per le altre ci

sono formule che ci riconducono). Ad esempio per gli eventi indipendenti. “Esce un 2” e “esce un 4” in AND

avranno probabilità P(“Esce un 2”) * P(“Esce un 4”), in Or saranno sommate

Da questa otteniamo la formula di Bayes,che, assumendo che E si sia già verificato, ci dice come varia Fj

associata tenendo conto di questo, ed è cosi composta:

Ok vediamo un esempio sulla fattorizzazione e la formual di Bayes e capiamo perche funziona cosi:

La formula vuole una serie di eventi mutuamente esclusivi su cui poi si verifica un evento dipendente. In

teoria il suo utilizzo è quello di capire come aumenta o diminuisce la probabilita dell’evento “padre” se se

ne verifica uno “figlio”.

Un esempio buono potrebbe essere cercare un programma alla TV che a un certo punto dovrebbe mostrare

dei dinosauri. Ogni canale ha una certa probabilità di avere quel programma in diretta detta Fi.Lo spazio

sara ricoperto da eventi Fi ( Fi = i è il canale che trasmette i dinosauri) non equiprobabili e sappiamo che

uno lo sta trasmettendo. Ora mettiamo che abbiamo trovato il programma al canale X secondo noi (evento

E), ma che non siamo sicuri che il canale sia quello(perchè magari non è ancora la parte sui dinosauri...).

come cambia la probabilita che il canale X sia quello giusto??

Applichiamo Bayes

Probabilita che abbiamo trovato il canale giusto dopo che abbiamo riconosciuto il programma =

P(Fj | E) = P(E | Fj) * P(Fj)

DIVISO

Sommatoria per i di: P(E |Fi) * P(Fi)

Tradotto in linguaggio umano suonerebbe:

Probabilita che si verifichi (“J è il canale giusto” se per l’evento E j è il canale giusto) =

Probabilità (“j è il canale giusto per E” se per F j è il canale giusto) * la probabilità che j sia il canale giusto

per F

DIVISO

Sommatoria per i: Probabilità (“i è il canale giusto per E” se per F i è il canale giusto) * la probabilità che i sia

il canale giusto.

Ad esempio potremmo ottenere questo: se 2 canali hanno il 90% e il 10% di prossibilità di essere quelli

giusti, e abbiamo riconosciuto il programma con una probabilita del 50% su quello da 10%, avremmo:

P = (50% del 10%) * 10% / Sommatoria di: (0 + 0 + 0 + (50% del 10%) * 10% + (50% del 90%) * 90%)

P = 50% (ottenuto da 10/2 * 10) / 50% + 45% * 90% = 50% / (50% + 4050%) = 50% / 4100% = 0,01 su 1 = 1

su 100. Considerando le stime direi che ci siamo :P

Avremmo ottenuto facendo i conti quale probabilità ci sarebbe che se abbiamo riconosciuto il programma,

a guardarlo vediamo davvero dei dinosuri,in patica 1 – il nostro tasso di idiozia XD XD XD XD ahahhaa

Utile no?

Variabili Aleatorie

Una variabile aleatoria è una variabile probabilistica che indica una qualche forma di “riassunto” di risultati

o parti di risultati di eventi probabilistici. Se volessimo rappresentare la probabilita che esca una somma

pari a 3 da un lancio di due dadi, potremmo scrivere:

ovvero X è la variabile aleatoria e = 3 è l’evento che

rappresenta, in questo caso l’insieme di tutti gli eventi “tiro di due dadi e ottengo (a,b)” che hanno 3 come

somma a+b. In pratica scrivere

È volerci chiedere quant’è la probabilità che tirando 2 dadi ottengo come somma un 3(la somma è una

variabile aleatoria.)

Il concetto di aleatorio sta ad indicare che in realtà stiamo considerando solo un aspetto degli eventi che si

verificano(la somma nel caso dei dadi) ingorando per quanto è possibile gli altri risultati(ad esempio

potremmo lanciare due volte lo stesso dado e vedere la somma. Il risultato i P(X = 3) rimarrebbe invariato,

ma ignoriamo eventi tipo quale valore sia uscito prima dei due ad esempio, perche non ce ne frega na sega

xD, anche se ovviamente essa costituisce una parte della soluzione, visto che dobbiamo sapere cos’è uscito

per fare una somma ).

Definiamo funzione indicatrice dell’evento E una variabile aleatoria I tale che I è uguale a uno se l’evento si

verifica e 0 altrimenti. Un esempio! Se cerchiamo una funzione indicatrice ad indicare l’evento E(“X è

maggiore di zero”) in un tiro di un dado a 3 faccie(0,1,2) la sua funzione indicatrice sarebbe:

Definiamo funzione di ripartizione una variabile aleatoria che comprende un intervallo di valori.

In formula:

Che risulta valida se è non decrescente, continua a destra e tendente a 1 a + infinito e a 0 a –infinito e

ovviamente con F(x) positivi in ogni punto

Definiamo funzione di massa la seguente

Che ci dice la probabilita che si verifichi uno degli eventi nella variabile aleatoria specificata.

come si potra intuire se la variabile aleatoria in esame comprende una serie di eventi che forma una

copertura di S almeno numerabile(un insieme e numerabile se è in corrispondenza biunivoca coi naturali XD

per chi non se lo ricorda ) allora vale:

Una variabile aleatoria non numerabile(quindi in corrisponde coi reali) si definisce continua se vale:

con B ogni insieme dei numeri reali possibile

Questa formula sopra definisce il concetto di densità di una variabile aleatoria(la funzione f(x) ). In pratica

ci dice la probabilita che una variabile aleatoria appartenga a un insieme B è pari all’integrale della densita

della funzione(ricordando il concetto di variabile aleatoria, essa è costituita da sottoinsiemi di eventi che ci

interessa analizzare, che sono di solito accorpament di dati piu grezzi e “meno interessanti”, come ad

esempio nel caso del lancio dei dadi, in cui volevamo sapere solo la somma).

Partendo dal pressupposto di quanto visto finora possiamo dire che una variabile aleatoria non numerabile

è continua se:

Ponendo B = [a,b] ovvero all’insiem dei numeri reali tra a e b,otteniamo che

E mettendo che a = b

Ovvero la probabilita che una variabile aleatoria continua prenda precisamente il valore a(che è un valore

qualunque dell’intervallo) è zero!

Quindi la densita ci dà un indicazione di quanto è probabile che un evento cada nella variabile aleatoria

MOLTO VICINO ad a!

Sviluppando i calcoli si otterrà che :

Ovvero che la densita è la derivata della funzione di ripartizione il che spiega anche quello zero di

prima!!! Quanto varia una fnzione tra un punto e se stesso? Zero ovviamente Ricordare che la derivata

geometricamente è l’M della retta che passa per 2 punti vicini all’infinito della funzione derivata ovvero

l’inclinazione della retta che va da a a b.

Quando conosciamo la funzione di massa o quella di densita di una variabile aleatoria DISCRETA, sappiamo

calcolare la probabilita di ogni singolo evento che dipenda unicamente da queste variabili aleatorie e si

dice che conosciamo la legge o la distrbuzione della variabile aleatoria considerata

Definiamo ora la probabilita di eventi dipendenti da piu variabili aleatorie.

E si denota con

la funzione che associa a due variabili aleatorie la loro probabilità.

Tecnicamente sapendo questa funzione F siamo in grado di sapere la funzione di ripartizione sia di X che di

Y. Infatti se una delle due tende a Infinito(x o y tendono a infinito quindi),allora la probabilita che l’evento

combinato si verifichi(visto che quello che tende a infinito si verifica, almeno per il senso di limite, SEMPRE)

dipende unicamente dall’altra.

Non è però vero che se sappiamo le due funzioni di ripartizione di X e Y sappiamo anche quella di

F(X,Y)...perche? se ci pensiamo anche solo logicamente, ci si accorgerà che se sappiamo qual’è la

probabilita che a un tiro di dado esca 1 e qual’è che esca 2, non sappiamo dire qual’è che escano due valori

minori di 3 XD

SE E DICO SE lo spazio studiato è discreto(enumerabile e finito) si puo usare il precdente risultato per

ottenere un simpatico aiuto. Avevamo detto che bastava mettere a limite tendente a infinito una variabile

per ottenere la probabilità dell’altra. Se lo spazio è discreto, la cosa diventa semplicemente porre una

variabile come il valore massimo(che nel primo caso era infinito, qui invece è calcolabile). In formule:

Se vogliamo calcolare la formula di distribuzione di Xi basta porre Y al massimo(in modo da essere sempre

uguale o minore, per come è costruita la definizione). Per trovare il massimo basta sommare per la

componente Xi tutti i valori Yj con j variabile. In questo modo stiamo dicendo, se Xi è un valore e Y è sempre

vera...allora...!!Se ci pensate è anche logico. Difatti se scegliessimo un Xi fisso,la somma di tutte le

probabilita Yj degli eventi che possono scaturire da questa scelta è sicuro uguale a 1(perch sommandoli

tutti si sommano sia quelli andati bene che quelli male di risultati e quindi li prendiamo sicuro tutti xD,

alternativamente parlando, vedendola sotto profilo probabilistico, stiamol prendendo tutto lo spazio degli

eventi di Y, e quindi rimane solo X a influenzare le probabilità :P )

Due variabili a questo punto si dicono congiuntamente continue se per ogni valore di x e y vale

Ovvero se la funzione di densità è continua su tutti valori di un intervallo/insieme

Quella della formula precdente è detta densita congiunta di X e Y.

Le singole densita (dette marginali perche in effetti quando le si calcola si finisce su uno dei margini,

dovendo imporre una delle due variabili a infinito o al valore massimo come visto prima) si calcolano alla

maniera usuale:

Dove il primo integrale è la densità nel senso stretto(essendo l’area della zona di spazio descritta dalla

funione nell’intervallo).

Accenniamo rapidamente alle distribuzioni condizionali:

Se poniamo p(X;Y) come

Avremo la possibilità di capire come varia una distribuzione rispetto all’altra. Lo studio di queste

condizionalità sarà limitato a casi discreti e raramente a casi continui.

Vediamo ora il concetto di valore atteso:

Ovvero la somma dei valori che può assumere x pesati con al probabilita che vengano assunti da X.

E’ evidente che se X è una funzione indicatrice(1 se si verifica e 0 altrimenti) allora

Come appare evidente(se X assume solo valori uno e zero, è evidente che solo quelli che si verificano

vengono presi in considerazione ed esclusi quelli che non si verificano, dunque logicamente è vera la

precdente).

Ne segue anche che

Fermi tutti cos’è un momento n-esimo? In pratica è il valore atteso calcolato elevando al grado n la

variabile aleatoria.Poi vedremo la sua utilità!

Per calcolare il valore atteso della somma di variabili aleatorie si può usare la seguente formula che non

dimostreremo:

ma si può estendere questo concetto alla somma di tutte le variabili che si vuole

Calcoliamo la varianza di una variabile aleatoria ora:

o anche:

La varianza è il momento secondo di X in pratica tra poco vedremo i “momenti” e capirete :P

Il che si ricava dalle 3 equazioni sopra notando che E[X^2 + µ^2 - 2*X *µ ] che per il fatto che il valore atteso

della somma di variabili aleatorie è il valore atteso sommato delle due singole variabili, diventa

E[X^2] – 2*µ*E[X] + µ^2 (è cosi anche tenendo conto della definizione di valore atteso).

Ora ricordando che µ è la media(ovvero il valore atteso di X :P) diventa

E[X^2] – 2*µ^2 + µ^2 = E[X^2] – µ^2 e da qui per la stessa motivazione:

E aggiungiamo:

Vabbe non c’è nulla di nuovo...

Vediamo la varianza di due variabili aleatorie

E si può calcolare anche come

E vale

E agiungiamo carne al fuoco. Se le due variabili sono indipendenti(non si influenzano a vicenda)

e la covarianza diventa Zero.

Ma perchè abbiamo visto la covarianza? Perche esattamente come per il coefficiente di correlazione tra

due eventi, si può anche qui verificare la correlazione tra due variabili aleatorie:

Ma passiamo a qualcosa di serio:

Da cu si ricava

Perchè è importante?

A che serve la funzione generatrice(nota ai più come trasfromata di Laplace)?

Beh ha alcune importanti proprietà, prima fra tutte che se poniamo t=0, la derivata di tale funzione

è

“Derivata di funzione generatrice di X con t=0” = E[X]

cosa comoda per calcolare il valore atteso di una funzione :P

Più in generale si può calcolare con la sopracitata tecnica ogni grado del valore atteso:

“Derivata n-esima della funzione generatrice di X con t = 0” = E [X^n] , per ogni n ∈ N.

Cosa che tra l’altro ci consente di calcolare spesso e volentieri anche la Varianza di X.

Difatti potremmo trovare E[X^2] – E[X]^2 con due derivate..

Vedremo più avanti che la funzione generatrice dei momenti sarà molto importante per determinare e

capire le distribuzioni di alcune importanti funzioni :P

LEGGE DEBOLE DEI GRANDI NUMERI:

vediamo alcune proposizioni vere che ci porteranno a un grande risultato:

La seconda ci dice in pratica che se lo scarto tra media e i valori di X è più grande di r > 0 allora la sua

probabilità è minore della varianza / r al quadrato

Da queste arriviamo a poter dire:

Che ci dice che se ripetiamo un esperiemento molte volte, la probabilità che la media dei risultati si discosti

dal valore atteso di Xi = u tende a 0(la probabilita che la differenza tra media dei campioni e media calcolata

tende ad essere più piccola di ogni numero > 0), ovvero che al crescere dei tentativi la media dei campioni

tende a P(E[X]). In pratica ci sta confermando che ripetendo un esperimento 100 volte il valore più

probabile che otterrò è quello indicato dal valore atteso(alias media).

Le distribuzioni

Distribuzione bernoulliana:

Descrive uno spazio degli eventi in cui si hanno solo due risultati, successo o fallimento.

La legge che lo governa è la seguente:

P(X = 0) = 1- p

P(X = 1) = p

Sfruttando quello che sappiamo sulla funzione generatrice calcoliamo E[X] e VAR[X]

E[X] = derivata prima di funzione generatrice di X =derivata di E[e^(t*x)] in t = 0.

E[X] = E[X * e^(T*X)] (ovvero la derivata di quanto sopra)

E[X] = Sommatoria tra 0 e 1 per x di p(x) * X * e^(T*X)

E[X] = p(X = 0)* X * e^(T*X) + p(X = 1) * X * e^(T*X)

E[X] = (1-p) * 0 * e^T*0 + p * 1 * e^(T*1)

E[X] = 0 + p * e^t che visto che stiamo calcolandola cosa per T=0

E[X] = p

Grandissimo! Abbiamo appena calcolato la nostra prima E[X] usando la trasformata di Laplace alias

funzione generatrice :P

la varianza è la derivata seconda, ovvero

VAR[X] = E[X^2 * E^(T*X)] che è la derivata seconda presupponendo come variabile di integrazione T.

A conti svolti risulta

VAR[X] = (1-p) * p

Distribuzione binomiale:

Una distribuzione binomiale risponde all’esigenza di descrivere una situazione di n esperimento in cui si

registrano tot successi.

La legge che descrive questa situzione è la seguente:

Ora:

Essendo tale legge una generalizzazione a n casi di una bernoulliana, possiamo dedurre il suo valore atteso

da questa considerazione:

E[X] = n * p ovvero n volte il valore atteso delle singole bernoulliane che compongono la distribuzione

E ancora

VAR[X] = n * p * (1-p)

Ovvero n volte la varianza delle singole bernoulliane.

Questo si evince dalla legge stessa. Riflettiamo. La probabilità di X di essere uguale a “i” è data dalla

quantità di elementi che soddisfano la richiesta (n su i difatti è il numero di sottoinsieme di i successi su un

insieme di n esperimenti), diviso il numero totale di possibili sottoinsiemi. Ma abbiamo già visto in

precedenza che si può, invece di dividere, moltiplicare per il valore compreso tra 0 e 1 delle probabilità che

si verifichi una di quelle configurazioni. Per verificarsi una di quelle configurazioni deve essere vero che

sono usciti “i” risultati positivi(da cui p^i ) ma anche che gli altri sono tutti negativi(da cui (1-p)^(n-i) )

Trucchetto per chi se lo vuole ricordare:

P(X = k+1) = (p * (n-k)) /((1-p) * (k+1))

Con questa definizione ricorsiva si può calcolare ogni elemento della distribuzione binomiale, partendo dal

precedente

Distribuzione di Poisson:

Una distribuzione di poisson indica eventi meno evidenti delle due sopra.

Ad esempio questa distribuzione descrive bene il numero di successi con una piccola probabilità “p” in un

grande numero n di esperimenti. Lambda in quel caso vale n*p. Come esempio è :P

Per questa distribuzione E[X] e VAR[X] sono entrambe uguali a lamda.

Come nota per il calcolo il rapporto tra il valore precedente e successivo della distribuzione vale

il che è perfetto per calcolare tutta al distribuzione molto rapidamente ricorsivamente

DISTRIBUZIONI UNIFORMI:

E’ Facile intuire che E[X] di una simile distribuzione è il punto medio tra A e B.

La varianza invece è data da VAR[X] = ((b-a)^2) / 12

DISTRIBUZIONE NORMALE O GAUSSIANA:

Questa legge è importantissima perchè si notò in vari studi fatti nel passato, che porteranno al teorema del

limite centrale, che molti fenomeni casuali seguono pressapoco una distribuzione gaussiana. Il teorema del

limite centrale concretizzerà questa teoria affermando che se prendiamo una serie di variabili aleatorie con

stessa distribuzione, causali e indipendenti, queste tendono a una distribuzione Gaussiana. In pratica La

gaussiana è la distribuzione a cui tende un fenomeno casuale al limite.

La media e la varianza sono insiti nella definizione :P sono labda e la o^2 della definizione rispettivamente.

Definiamo normale standard una distribuzione gaussiana di parametri N(0,1)

Da notare che se a una Gaussiana tolgo la media e divido per la radice della varianza, ottengo una

distribuzione gaussiana standard. Questo è utile perchè ci porta a dire che la funzione di ripartizione per

gaussiana si può esprimere anche come:

il che significa che la probabilità che X sia minore di B è la stessa che una normale standard assuma un

valore minore di b- media / radice di varianza :P

DISTRIBUZIONE ESPONENZIALE:

E’ usata per descrivere il tempo che passerà priam che si verifichi un evento casuale tipo “tra quanto si

verifichera il prossimo terremoto?”

E[X] = 1/lambda

VAR[X] = 1/(lambda^2)

La cosa piu notevole della funzione esponenziale è che non ha memoria. Ovvero ad ogni istante non

considera che l’evento ha dei “precedenti” ma solo quello che sta per succedere. Per fare un esempio: se

ad oggi non c’è stato un terremoto ancora, questo non aumenta o diminuisce la probabilita che da adesso

in poi ci sia o no un terremoto a breve

Il che si traduce in una cosa del genere:

Se ho una macchina e questa macchina ha fatto 10000 km, e la sua distribuzione della vita è esponenziale,

la probabilità che farà altri 20000 km non è influenzata dal fatto che ne ha già fatti 10000, ma viene

calcolata dal punto attuale, ovvero è la probabilità che ne fara altri 20000 come se fosse appena uscita

dalla fabbrica. In pratica se fosse vero, la prob che una macchina fa piu di 20000 km dalla vendita è la stessa

che ne faccia 20000 da usata :P

Delle altre Distribuzioni ricordiamo:

Definiamo ora un campione aleatorio, come una serie di variabili aleatorie, tutte con stessa distribuzione.

Definiamo la media campionaria di un campione di variabili aleatorie indipendenti con valore atteso A e

varianza B come:

Calcolando E[Media Campionaria] e VAR[Media Campionaria] si ottiene:

E[Media Campionaria] = A

VAR[Media Campionaria] = B / n

Questo HA UNA GRANDE VALENZA: infatti ci dice che al crescere del numero della variabili la varianza

rispetto alla media diminuisce, e la distribuzione tende sempre allo stesso valore A,confermando la legge

debole dei grandi numeri(se lo scarto diminuisce i valori diventano sempre piu simili alla media :P ).

In pratica che piu esperimenti rendono piu preciso il risultato. Ma anche ad altro!

Da qui si arriva alla definizione di Teorema del limite centrale!

Questo teorema è molto importante perche ci permette di poter approssimare ogni somma di grandi

quantità di variaili aleatorie come una gaussiana o con qualche aggiustamento ad una distribuzione

normale standard gaussiana, mentre la differenza tra le varianze si evince dallo studio sulle funzioni

generatici ma è solo per mettervi il pepe sotto il naso se avevate qualche dubbio e ve lo voleste togliere

Ma torniamo a parlare della media campionaria. Notiamo che a differenza della semplice somma la media

campionaria presenata una divisione per n, il che spiega la differenza tra il valore atteso della Media

campionaria e quello del limite centrale (si sottrae il valore ultimo delle somme che producono la media,

non la media stessa ) .Il denominatore è ovviamente lo scarto medio (la radice della varianza)

Dal teorema del limite centrale si può calcolare la distribuzione della media campionaria:

Difatti questa soddisfa tutti i requisiti del teorema e dunque la sua distribuzione è approsimativamente

gaussiana. Il suo valore atteso l’abbiamo calcolato prima :P insieme alla sua varianza

Una buoan regola empirica ci dice che per essere n “grande” deve essere almeno 30 quindi da tale valore

in poi la approssimazione diventa buona

La varianza campionaria è definita come solito:

Piu che altro ci potrebbe interessare il valore atteso di S^2 perche è il valore atteso della varianza

campionaria, ovvero il valore a cui tenderà la varianza :P

E[S^2] = o^2 ovvero la varianza delle singole variabilia aleatore coinvolte a meno di una divisione per n-1

invece che per n che dipende da cause matematiche che non sono parte del corso .

Da uno studio piu profondo che qui non faremo si può dimostrare che queste due distribuzioni appena viste

sulla media campionaria, si evince che esse sono indipendenti . Tendenzialemente per fortuna le

incotnrreremo poco :P

LA STIMA

Ok eccoci a parlare di roba seria :P

Mettiamo che non sappiamo alcuni dati di una serie di variabili aleatorie. Sarebbe carino poter fare

inferenza su di esse anche se siamo all’oscuro di certi dettagli, come ad esempio quanto vale il lamda di una

serie di variabili di poisson. Vedremo che è possibile stabilire un valore di massima verosimiglianza, ovvero

un valore di una determinata variabile A che non conosciamo(nell’esempio appena fatto delle variabili di

poisson sarebbe proprio il lamda), in modo tale da poter dedurre cmq alcune cose importanti.

A volte oltre al valore di massima verosimiglianza, che è il valore per cui si MASSIMIZZA la funzione di

ditribuzione, ovvero il valore che ha la probabilità piu grand edi uscire, ci interessa anche studiare il suo

intorno, detto intervallo di verosmiglianza o di confidenza. Ogni intervallo di confidenza ha associato a sua

volta un LIVELLO di confidenza. In pratica per capirci, il valore di massima verosmiglianza è il valore con la

probabilità piu alta di uscire, l’intervallo di verosimiglianza invece è,dato un livello di verosimiglianza che è

una percentuale, che ne sò tipo del 95%, quell’intervallo per cui ladistribuzione cade con probabilità pari al

livello. Prendendo un livello del 95% come esempio di prima, l’intervallo di confidenza o verosimiglianza è

quell’intevallo nell’intorno del valore di massima verosiglianza(di solito è dato da

ValoreMaxVerosimiglianza +- un qualcosa, ovvero è un intorno simmetrico) in cui la distribuzione cade al

95% Il valore di massima verosimiglianza determinato si chiama stima.

Come abbiamo detto per estrarre una stima per una distribuzione di variabili aleatorie, dovremmo cercare

dove è massima tale distribuzione. Come abbiamo già visto in precedenza la media campionaria è il punto

dove la probabilità è max per le gaussiane Una proprietà utile della ricerca delle stime è che se facciamo

il logaritmo di una distribuzione il suo punto di massimo non cambia, il che potrebbe tornare utile se

stessimo cercando punti di massimo di funzioni elevate a quadrati e resto

Ora: vediamo un semplice calcolo per capire come funziona il giochetto(dopo lasceremo solo formule):

la stima del valore massimo di una funzione è mera matematica e si può sfruttare il logaritmo per darsi un

aiutino: incollo ad esempio la massimizzazione di una gaussiana di cui non si sa il lamda:

Notare che la funzione di likehood è la funzione di distribuzione generica delle variabili coinvolte

massimizzata per un valore che viene indicato dopo una sbarra nella dichiarazione(che è la vera incognita,

non sono le variabili aleatorie).

Questo ci dice che la distribuzione di varie variabili di poisson è massima quando lamda è uguale a

Per le normali gli stimatori di media e varianza sono rispettivamente:

Notare che la varianza non coincide con la varianza campionaria(per motivazioni matematiche di cui non ci

sbatte na sega, anche se si capisce che qui si sta cercando una sorta di media di varianze :P ) che valeva

Ma per n grandi, la differenza è trascurabile

Ora vediamo il ragionamento dietro il calcolo di un intervallo di confidenza:

Mettiamo di avere tot gaussiane di parametri noti N(U,O) e che vogliamo sapere,visto che sappiamo qual’è

il valore piu probabile di tutti ovvero

per quanto detto sopra,qual’è l’intervallo in (

ho una probabilità del TOT % di cadere se provassi a fare l’esperimento.

-K;

+ K) in cui

Prendiamo una percentuale del 95% e vediamo che intervallo attorno alla media campionaria dovrei

prendere:

Sappiamo che

Per quanto detto in precedenza. Abbiamo posto

semplificano). Difatti:

in

perchè i dati sono tutti noti e i calcoli si

Questo perchè nella tabella della distribuzione normale standard(che possiamo sostituire a

facile identificare un intervallo in cui la somma delle probabilità sia 0.95.

vediamola insieme

)è

La gaussiana è centrata sullo 0, perciò basta fare 0.95 / 2 = 0.475 e ci si accorge che tale valore si ha a 1.96.

Ora visto che la gauassiana normale standar è simmetrica rispetto all’asse y, avremo

Ovvero che visto che z sopra indica l’area sottesa dalla densità di probabilità della normale standard la

somma dell’area(la probabilità, perchè quell’area come intuirete è il calcolo per quell’intervallo della

funzione di ripartizione, ovvero dell’integrale della funzione di densità di probabilità ) a destra è a sinistra

sara 0.475 a destra dello 0 e altrettanto a sinistra per cui 0.95.

Perciò la probabilità che la N(0,1) normale standard sia compresa in quell’intervallo è del 95%.

Ora spostiamo i valori costanti della media e della varianza U e O nell’equazione precdente e otteniamo:

Che ci conferma che la probabilità che la media si trovi in quell’intervallo è del 95%

Prima di darci in pasto altre formule ricavate nello stesso modo, voglio parlare degli intervallo unilaterali.

Quello appena calcolato è un intervallo bilaterale, in quanto “prevede” che la media sia in un certo

intervallo con una erta percentuale. Ma se volessimo vedere con una certa percentuale quando la media è

superiore al valore di massima verosimiglianza? Beh è facile:

Qual’è l’interavallo unilaterale(ovvero solo a destra o sinistra della media) destro che la probabilità che i

valori assunti da una serie di test su gaussiane cadano vicino al loro punto di massima verosimiglianza al

95%?

Notando che possiamo ridurre le gaussiane alla forma normale possiamo dedurre l’intervallo unilaterallo

unilateral cosi(Z è un normale standard N(0,1)):

Infatti Notiamo che 1.645 è il punto in cui la funzione nel lato destro assume il valore 0.45, e visto che

tutta la parte negativa vale 0.5 in probabilità, la loro probabilità congiunta se consideriamo Z < 1.645 vale

prorpio 0.95 e quindi esso costituisce un intervallo unilaterale destro selo cercavamo bilaterale

avremmo tagliato un pezzo della parte negativa, perche avremmo allargargato l’intervallo positivo e

questo spiega perche 1.645 è piu piccolo di 1.96 nonostante a pensarci potevamo pensare che sarebbe

stato piu grande il nostro errore è che pensavamo all’intervallo unilaterale come “solo positivo”

Denotiamo Z di alfa mezzi come il valore nel punto alfa/2 di Z che è la nomenclatura classica di Z = N(0,1)

:D

Questa tabella riporta gli intervallid i confidenza noti:

In realtà solo la gausiana e la bernoulliana hanno un utilità per noi :P

La bernoulliana deriva dalle seguenti considerazioni:

E i suoi intervalli sono

Con la stessa tecnica delle gaussiane(ovvero equiparare a una gauassiana standard, cercare un valore

adatto e poi sviluppare l’equazione)

.

Errori di prima e seconda specie

Immaginiamo di voler inferire su una distribuzione di cui conosciamo la distribuzione dipendente da un

parametro “r” , Un errore di prima specie in questo senso, è un errore che noi facciamo sul fatto che

arriviamo a definire falsa una inferenza che invece è vera.Un errore di seconda specie è il contrario, ovvero

pensare che è vera una inferenza falsa

Definiamo “Ipotesi nulla” l’ipotesi su cui andiamo a inferire

Definiamo come “alfa” il livello di significatività, ovvero la probabilita che non si verifichi un errore di prima

specie, o “1-Alfa” la probabilità che si verifichi un tale errore

La regione in cui l’errore di prima specie ha una probabilità maggiore del livello di significatività scelto(e

quindi si ha un errore) è detto “regione critica”, se non ricade in questa regione avremo trovato la regione

di distribuzione in cui ci aspettiamo che il valore ricada con la probabilità di esattezza richiesta.

Se il parametro alfa è 0.95 in pratica stiamo affermando che vogliamo una regione l’ipotesi sia vera con

una tolleranza del 5%.

Che significa? Vabbe la parte sulla robustezza dei dati è abbastanza autoesplicativa(un tes è robusto se

anche sbagliando quale assunzione si comporta bene, ovvero non presenta grosse variazioni, con i dati

inferiti, dalla realta ),

La tabella sotto ci da le formule risolutive per dimostrare l’Ipotesi H0, che accade al contrario dell’ipotesi

H1(la sua negata). Per capire gli altri campi, ragioniamoci sopra:

Ovvero il livello di significatiovità del test è uguale alla probabilità di errori di prima specie(un 5% di errore

di solito è una buona scelta) che è uguale alla probabilita che la differenza tra media campionaria e la

media delel singole variabili sia maggiore di una costante. Ora.. chiaramente il problema è trovare quella

“c” Chiaramente la sua risoluzione dipende da cosa stiamo cercando(potrebbero esserci errori unilaterali

o bilaterlai(ovvero un intorno o una parte dell’intorno, come nella stima)).

La “statistica dei test” nella tabella si riferisce quindi alla traformazione che dobbiamo applicare per

ottenere la normale standard del test Come nella stima di massima verosimiglianza le normali si

riducono nella forma standard in quella maniera.

Ora.. Si rifiuta se Xts in modulo è maggiore di z di alfa / 2. Questo deriva da questo risultato che intuisce

facilemnte come si è ottenuto (nel caso di ipotesi nulla di uguaglianza), perché il ragionamento è lo stesso

della stima:

Se quindi prendiamo la statistica della riga della tabella tabella e la poniamo > z di alfa mezzi della tabella

stessa (nella sezione “rifiuta se”) otteniamo il rifiuto o l’accettazione cercata. Z di alfa mezzi è il valore di

alfa mezzi di Z che è la nomenclatura classica di N(0,1) come già detto :D

L’ultimo campo è detto P-DEI-DATI e ci indica un punto, se la statistica avesse prodotto un valore t

assumendo H0 vera, entro cui possiamo accettare, altrimenti rifiutiamo.

In pratica possiamo, se sappiamo i dati degli esperimenti, calcolare il valore della statistica e da questo(che

chiameremo “t”) calcolare la probabilità P-DEI-DATI, che lo so suona molto na cosa alla KENSHIRO XD, con Z

che è la normale standard. Se questa probabilità di accettazione è inferiore a lambda si accetta sennò si

rifiuta. Forte il P-DEI-DATI!!! Quello in tabella è calcolato dalle osservazioni sulla regione critica della

statistica associata, quindi esatto e preciso, ma a volte si procede osservando i valori, calcolando il p-deidati(che è la probabilità dei dati stessi) e si vede quanto discordano da quanto ci aspettiamo. In questo

modo fissiamo un livello di singificatività dinamico in pratica terra terra osserviamo i dati e diciamo

“vabbe mi sembrano abbastanza congruenti” cosi a partito preso XD da quanto i piacciono i risultati dei test

XD mentre ragionando analiticamente come in tabella avremmo potuto dire “vabbe si discostano al

massimo del 5% di errore da quanto mi aspettavo quindi accetto”

Parliamo un secondo della funzione di potenza:

B(u) che a conti fatti vale

dove il simbolo

sta per funzione di ripartizione di N(0,1)

La funzione B(u) deriva a sua volta da:

Ovviamente 1 – B(u) è la probabilita di non fare un errore di seconda specie,mentre B(u) rappresenta

prorpio la probabilita di non commettere errori di prima specie Vedendo come è ricavata B(u) ci si

accorge che si sfrutta il fatto che

risultato )

si possa ridurre a Z (e difatti poi fa una sostituzione per ricavare il

proseguiamo con la tabella di quando la varaianza non è nota:

Nel caso di una distribuzione binomiale di n variabili bernoulliane invece troviamo che la statistica è uguale

a:

dove K è dato da:

In alternativa si può usare la probabilità p-dei-dati, data da:

O anche approssimare a una gaussiana usando il teorema del limite centrale per n grande

Nel caso si cerchi un uguaglianza nel numero di successi(una cosa del tipo “il numero di successi è k”) allora

bisogna che la statistica sia vera per valori:

ovvero la probabilita che i dati assumano valore

maggiore e minore

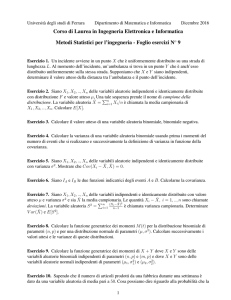

Note apprese dagli esercizi:

I.

II.

III.

La somma di due normali standard è N(0,2)

Se dobbiamo calcolare la distribuzione congiunta di due variabili aleatorie che sono distribuite

uniformemente all’interno di un’area delimitata, si ragiona cosi:

si parte dal fatto che il doppio integrale(per x e y) da – infinito a piu infinito è uguale a 1(per

definizione di densità).

Poi si porta fuori la costante c dall’integrale, cioè

ps: segue dal fatto che l’integrazione di f(x,y) deve essere una costante, visto che la distribuzione è

uniforme :P Poichè l’integrale doppio di ogni elemnto dell’area è prorpio l’area in questione, la

formula diventa:

c* area della regione interessata = 1

Visto che di solito è facile capire l’area della regione interessata, la cosa diventa abbastanza facile

da qui :P

La distribuzione media campionaria ha u = media dei dati e varianza V = o^2/n