Capitolo 7

Esempi di distribuzioni teoriche

In questo capitolo presentiamo alcune funzioni teoriche che rappresentano

densità di probabilità di variabili casuali unidimensionali (continue e discrete)

che hanno importanza per la fisica.

7.1

La distribuzione uniforme

Il caso più semplice, dal punto di vista teorico, è quello di una variabile

casuale x continua che possa assumere solo valori compresi in un intervallo

finito avente estremi costanti prefissati, [a, b]; e ivi con probabilità uguale per

ogni punto1 .

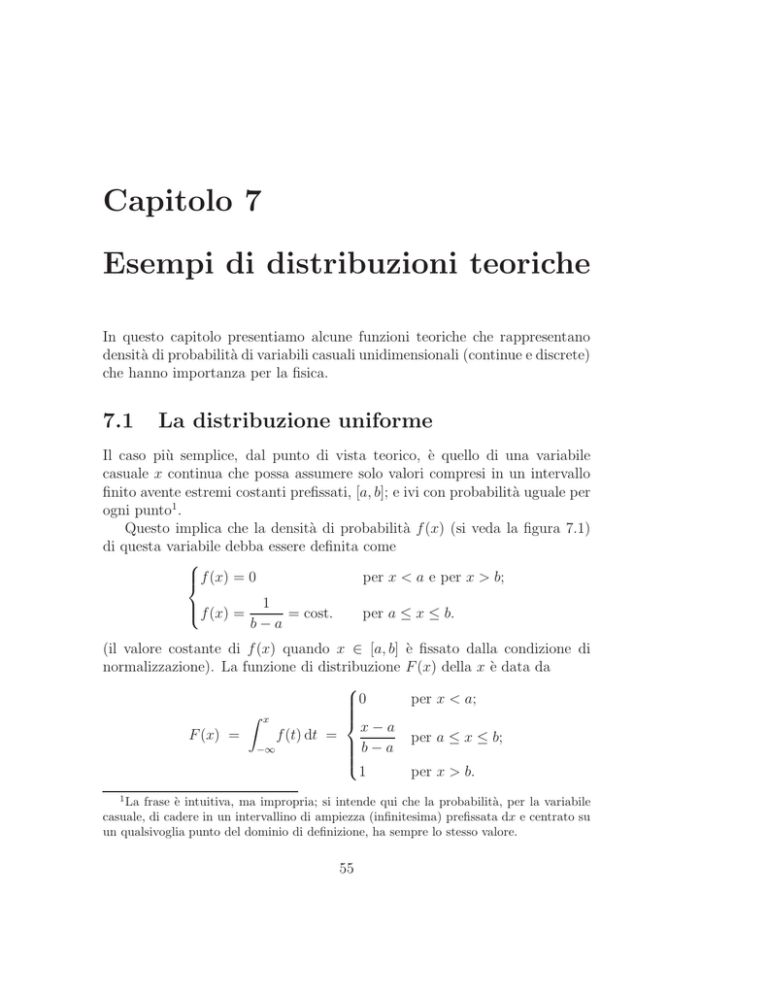

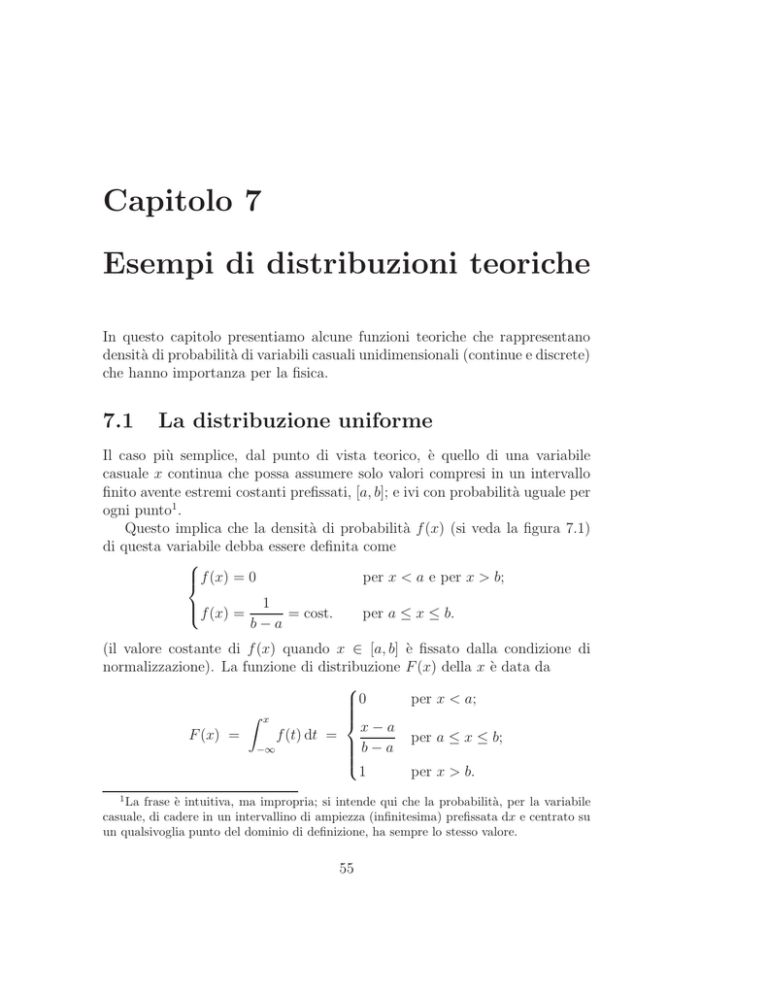

Questo implica che la densità di probabilità f (x) (si veda la figura 7.1)

di questa variabile debba essere definita come

per x < a e per x > b;

f (x) = 0

f (x) =

1

= cost.

b−a

per a ≤ x ≤ b.

(il valore costante di f (x) quando x ∈ [a, b]

normalizzazione). La funzione di distribuzione

0

Z x

x−a

F (x) =

f (t) dt =

b−a

−∞

1

1

è fissato dalla condizione di

F (x) della x è data da

per x < a;

per a ≤ x ≤ b;

per x > b.

La frase è intuitiva, ma impropria; si intende qui che la probabilità, per la variabile

casuale, di cadere in un intervallino di ampiezza (infinitesima) prefissata dx e centrato su

un qualsivoglia punto del dominio di definizione, ha sempre lo stesso valore.

55

56

CAPITOLO 7. ESEMPI DI DISTRIBUZIONI TEORICHE

Figura 7.1: Distribuzione uniforme definita nell’intervallo [a, b]. Pannello superiore: Funzione di densità di probabilità f (x); pannello inferiore: Funzione

di distribuzione cumulativa F (x).

I valori di aspettazione e della varianza della variabile casuale x, come si può

facilmente calcolare, valgono

a+b

E(x) = 2

2

Var(x) = (b − a)

12

(7.1)

Per vedere una prima applicazione pratica della distribuzione uniforme,

supponiamo di misurare una grandezza fisica usando uno strumento digitale: ad esempio una bilancia con sensibilità inversa di 1 grammo. Se, per

semplicità, escludiamo la presenza di errori sistematici, il fatto che il display

digitale indichi (ad esempio) 10 grammi significa solo che la massa dell’oggetto pesato è maggiore o uguale a questo valore e minore di 11 grammi2 ; e tutti

2

La maggior parte degli strumenti digitali tronca il valore mostrato e si comporta

7.2. LA DISTRIBUZIONE BINOMIALE

57

i valori interni a questo intervallo ci appaiono inoltre come ugualmente plausibili. Per questo motivo, viste le (7.1), in casi di questo genere

√ si attribuisce

all’oggetto pesato una massa di 10.5 g con un errore di 1/ 12 ≈ 0.3 g.

7.2

La distribuzione binomiale

Consideriamo un evento casuale ripetibile E, avente probabilità costante p

di verificarsi; indichiamo con q = 1 − p la probabilità del non verificarsi di E

(cioè la probabilità dell’evento complementare E ). Vogliamo ora determinare

la probabilità P (x; N) che in N prove ripetute E si verifichi esattamente x

volte (deve necessariamente risultare 0 ≤ x ≤ N).

L’evento casuale costituito dal presentarsi di E per x volte (e quindi dal

presentarsi di E per le restanti N − x) è un evento complesso che può verificarsi in diverse maniere, corrispondenti a tutte le diverse possibili sequenze

di successi e fallimenti; queste sono ovviamente mutuamente esclusive, ed in

numero pari a quello delle possibili combinazioni di N oggetti a x a x, che

vale

N!

N

N

.

=

Cx =

x! (N − x)!

x

Essendo poi ognuna delle prove statisticamente indipendente dalle altre

(infatti la probabilità di E non cambia di prova in prova), ognuna delle

possibili sequenze di x successi ed N − x fallimenti ha una probabilità di

presentarsi che vale px q N −x ; in definitiva

P (x; N) =

N!

px q N −x .

x! (N − x)!

(7.2)

Questa distribuzione di probabilità P (x; N) per una variabile casuale

discreta x si chiama distribuzione binomiale o di Bernoulli ; vogliamo ora

determinarne alcune costanti caratteristiche.

Verifichiamo per prima cosa che vale la condizione di normalizzazione:

sfruttando la formula per lo sviluppo delle potenze del binomio, risulta

N

X

x=0

P (x; N) =

N

X

x=0

N!

px q N −x = (p + q)N ≡ 1 .

x! (N − x)!

Vogliamo ora calcolare il valore di aspettazione della variabile x (ossia il

numero di successi attesi, in media, in N prove). A tale scopo introduciamo

appunto in questo modo; altri invece arrotondano il risultato e, se questo fosse il caso,

vorrebbe dire che la massa dell’oggetto pesato è maggiore o uguale a 9.5 g e minore di

10.5 g.

58

CAPITOLO 7. ESEMPI DI DISTRIBUZIONI TEORICHE

una variabile casuale y, definita come il numero di volte in cui E si è verificato

in una di tali prove. Ovviamente y può assumere i due soli valori 1 (con

probabilità p) e 0 (con probabilità q); il suo valore di aspettazione è perciò

dato da

E(y) = 1 · p + 0 · q = p ;

e, osservando che anche y 2 può assumere i due soli valori 1 e 0, sempre con

le probabilità rispettive p e q,

E y2

= 1·p+0·q = p

e quindi la varianza della y esiste e vale

2

Var(y) = E y 2 − E(y) = p − p2 = p (1 − p) = pq .

(7.3)

Il numero totale x di successi nelle N prove è legato ai valori yi della y in

ognuna di esse dalla

x=

N

X

yi

i=1

e risulta quindi, per speranza matematica e varianza della distribuzione

binomiale,

E(x) = E

N

X

i=1

2

Var(x) = σx = Var

yi

!

N

X

i=1

yi

=

N

X

E (yi ) = Np

i=1

!

=

N

X

Var (yi) = Npq .

i=1

L’andamento della distribuzione di probabilità binomiale è illustrato in

Fig. 7.2, per alcune combinazioni dei parametri (n, p). In generale la distribuzione è assimmetrica, tranne che per p = q = 0.5. Inoltre se p = q = 0.5

con n è pari essa è unimodale, mentre è bimodale per n dispari. Infine, come

è evidente dal pannello con (n = 100, p = 0.5) di Fig. 7.2 e dalla figura 7.3,

la forma della distribuzione binomiale è molto simile a quella di una curva

di Gauss (discussa nella sezione 7.3). Si può in effetti dimostrare che quando

N tende all’infinito la distribuzione di probabilità dei possibili valori tende

7.2. LA DISTRIBUZIONE BINOMIALE

59

Figura 7.2:

Andamento della distribuzione binomiale per diverse

combinazioni dei parametri n e p.

60

CAPITOLO 7. ESEMPI DI DISTRIBUZIONI TEORICHE

0.15

N = 50, p = 0.2

N = 50, p = 0.5

0.1

0.05

0

0

10

20

30

40

50

Figura 7.3: La distribuzione binomiale, per un numero di prove N = 50 e

due differenti valori della probabilità p.

61

7.2. LA DISTRIBUZIONE BINOMIALE

ad una distribuzione normale avente la stessa media Np e la stessa varianza

Npq. In pratica, quando il numero di prove N è elevato e la probabilità

p non è troppo vicina ai valori estremi 0 ed 1, la distribuzione binomiale è

bene approssimata da una distribuzione normale; in generale si ritiene che

l’approssimazione sia accettabile quando entrambi i prodotti Np e Nq hanno

valore non inferiore a 5.

7.2.1

Applicazione: decadimenti radioattivi

Se la probabilità Λt per un singolo nucleo instabile di decadere in un intervallo di tempo t è costante, la probabilità di avere un numero prefissato di

decadimenti nel tempo t in un insieme di N nuclei è data dalla distribuzione

binomiale; in particolare, il numero medio di decadimenti in N nuclei e nel

tempo t è NΛt .

Se si ammette poi che Λt sia proporzionale al tempo3 t, indicando con

λ la probabilità di decadimento nell’unità di tempo avremo Λt = λt; in un

tempo infinitesimo dt, il numero di atomi N(t) presente al tempo t varia

mediamente di

dN = −N λ dt .

Separando le variabili ed integrando, il numero medio di atomi presenti

al tempo t, dopo il decadimento di una parte di quelli N0 presenti all’istante

iniziale t = 0, è dato dalla

N(t) = N0 e−λt

(7.4)

ed il numero medio di decadimenti dalla

N0 − N(t) = N0 1 − e−λt

.

La vita media τ di una sostanza radioattiva si può definire come il tempo

necessario perché il numero originario di nuclei si riduca mediamente di un

fattore 1/e; quindi τ = 1/λ, e la (7.4) si può riscrivere

t

N(t) = N0 e− τ .

3

(7.5)

Questa ipotesi può evidentemente essere soddisfatta solo in prima approssimazione:

basta pensare al fatto che Λt deve raggiungere l’unità solo dopo un tempo infinito. In

particolare, la probabilità per un nucleo di decadere in un tempo 2t vale Λ2t = Λt +

(1 − Λt ) · Λt = 2Λt − Λt 2 ; e l’ipotesi fatta è in effetti valida solo se Λt è infinitesimo, o (in

pratica) se l’osservazione riguarda un lasso di tempo trascurabile rispetto alla vita media.

62

CAPITOLO 7. ESEMPI DI DISTRIBUZIONI TEORICHE

7.3

La distribuzione di Gauss

La distribuzione normale (o distribuzione di Gauss) è una delle più importanti distribuzioni di variabili casuali continue, in quanto è, o la base di partenza

per le altre funzioni di distribuzione (vedasi la Chi Quadrato, la t di Student)

o la funzione alla quale altre possono essere approssimate in certe situazioni

limite (vedasi la binomiale e la poissoniana e il teorema del limite centrale).

In particolare, si dimostra che la distribuzione di Gauss rappresenta il

limite asintotico della binomiale quando il parametro n → +∞. Un aspetto

chiave per il passaggio dalla distribuzione discreta binomiale a quella continua

di Gauss risiede nell’utilizzo della formula di Stirling per riscrivere i termini

fattoriali in forma asintotica:

√

lim n! = nn e−n 2πn

n→∞

7.3.1

La funzione di Gauss: generalità

Possiamo generalizzare i risultati per una qualunque variabile casuale x di

tipo normale. La distribuzione normale è una funzione di densità di probabilità di tipo continuo che dipende da due parametri µ e σ (con la condizione

σ > 0), definita come:

f (x) ≡ N(x; µ, σ) =

1

√

σ 2π

1

−

e 2

x−µ

σ

2

.

in cui il parametro µ coincide con il valore di aspettazione della variabile

stessa (E(x) = µ), e il parametro σ è il valore di aspettazione della variabile

errore.

L’andamento della funzione normale è quello delineato nella figura 7.4:

quando√x = µ si ha un punto di massimo, nel quale la funzione ha il valore

yb = (σ 2π)−1 ≈ 0.4/σ. La larghezza a metà altezza 4 è pari all’ampiezza

√

dell’intervallo che separa i due punti x1 √

ed x2 di ascissa µ ± σ 2 ln 2 e di

ordinata y1 = y2 = yb/2: e vale quindi 2σ 2 ln 2 ≈ 2.35σ.

Nel caso particolare di una variabile normale con valore medio µ = 0 e

varianza σ 2 = 1 (variabile normale standardizzata).

Vale il seguente importante teorema:

4

In genere indicata con la sigla FWHM, acronimo di full width at half maximum; è un

parametro usato nella pratica astronomica per la caratterizzazione delle righe spettrali, il

cui profilo è spesso approssimato dalla funzione di Gauss.

63

7.4. LA DISTRIBUZIONE DI POISSON

Figura 7.4: La funzione di Gauss per quattro combinazioni dei parametri

(µ, σ). La linea in verde (σ = 1) si riferisce alla variabile casuale normale

standardizzata.

Teorema: combinazioni lineari di variabili casuali normali e

tutte statisticamente indipendenti tra loro sono ancora distribuite

secondo la legge normale.

Siano N variabili normali xk (con k = 1, . . . , N), e siano µk e σk 2 i loro valori

di aspettazione e le loro varianze rispettivamente; consideriamo poi la nuova

variabile casuale y definita dalla

y=

N

X

ak xk ,

k=1

dove le ak sono coefficienti costanti). Il valore di aspettazione della variabile

y è dato da:

µ=

N

X

k=1

7.4

ak µk

e

2

σ =

N

X

ak 2 σk 2 .

k=1

La distribuzione di Poisson

La distribuzione di Poisson è detta pure legge degli eventi rari, in quanto è

un caso limite della variabile casuale binomiale quando la probabilità p di

64

CAPITOLO 7. ESEMPI DI DISTRIBUZIONI TEORICHE

un evento è molto bassa (p → 0) e contemporaneamente la grandezza del

campione n è molto alta (n → ∞), ovvero quando un evento è raro, ma il

numero di eventi che si verificano in media (λ = np) è comunque finito.

Per ricavare l’espressione delle distribuzione di Poisson riferiamoci all’esempio del decadimento radioattivo di un nucleo e consideriamo come evento la ricezione della particella di decadimento. Assumiamo che tale evento

avvenga rispettando le seguenti ipotesi:

1. La probabilità del verificarsi dell’evento E in un intervallo di tempo5

molto piccolo (al limite infinitesimo) dt è proporzionale alla durata di

tale intervallo;

2. Il verificarsi o meno dell’evento in un certo intervallo temporale è

indipendente dal verificarsi o meno dell’evento prima o dopo di esso;

3. La probabilità che più di un evento si verifichi in un tempo infinitesimo

dt è infinitesima di ordine superiore rispetto a dt.

Vogliamo ora ricavare la probabilità P (x; t) che in un intervallo di tempo

finito, di durata t, si verifichi esattamente un numero prefissato x di eventi

E. Usando questa simbologia, la prima ipotesi fatta sul processo casuale in

esame si scrive

P (1; dt) = λ dt

=⇒

P (0; dt) = 1 − λ dt

e, viste le altre ipotesi ed applicando in conseguenza i teoremi delle probabilità totali e composte, la probabilità di avere x eventi in un intervallo di

tempo lungo t + dt è data, a meno di infinitesimi di ordine superiore, da

P (x; t + dt) = P (x − 1; t) · P (1; dt) + P (x; t) · P (0; dt)

= P (x − 1; t) λ dt + P (x; t) (1 − λ dt)

cioè

P (x; t + dt) − P (x; t)

d

≡

P (x; t) = −λ P (x; t) + λ P (x − 1; t) .

dt

dt

5

Sebbene ci si riferisca, per esemplificare le nostre considerazioni, ad un processo temporale (e si faccia poi l’esempio del numero di decadimenti in un intervallo costante di

tempo per una sostanza radioattiva come quello di una variabile casuale che segue la distribuzione di Poisson), gli stessi ragionamenti naturalmente si applicano anche a fenomeni

fisici riferiti ad intervalli di differente natura, per esempio di spazio.

Cosı̀ anche il numero di urti per unità di lunghezza delle molecole dei gas segue la

distribuzione di Poisson (se si ammette che la probabilità di un urto nel percorrere un

intervallo infinitesimo di spazio sia proporzionale alla sua lunghezza, ed analogamente per

le altre ipotesi).

65

7.4. LA DISTRIBUZIONE DI POISSON

Ora, quando x = 0, essendo chiaramente nulla la probabilità di avere un

numero negativo di eventi E in un tempo qualsiasi, risulta in particolare

d

P (0; t) = −λ P (0; t)

dt

da cui

P (0; t) = e−λt

(la costante di integrazione si determina imponendo che P (0; 0) = 1). Da questa relazione si può ricavare P (1; t) e, con una serie di integrazioni successive,

P (x; t): risulta

(λt)x −λt

P (x; t) =

e

.

(7.6)

x!

In questa espressione x è l’unica variabile casuale, e t funge da parametro:

se introduciamo la nuova grandezza µ = λt, possiamo scrivere

P (x; µ) =

µx −µ

e

.

x!

(7.7)

Questa distribuzione di probabilità per una variabile casuale (discreta) x

prende il nome di distribuzione di Poisson. Più esattamente, la probabilità

di avere precisamente x decadimenti radioattivi nel tempo t è data dalla

distribuzione binomiale; la distribuzione di Poisson è una approssimazione

alla distribuzione binomiale che si può ritenere valida qualora si considerino

eventi casuali di probabilità estremamente piccola, e che ci è possibile vedere

solo perché si compiono osservazioni su un numero molto elevato di essi: in

formula, quando

p2 ≪ p

e

p ≪ Np ≪ N

(7.8)

(eventi rari su larga base statistica).

Anche se la distribuzione di Poisson è, come nel caso dei decadimenti radioattivi, una approssimazione di quella binomiale, si preferisce però

sempre usarla nella pratica al posto di quest’ultima quando le (7.8) siano

approssimativamente verificate: infatti se N è grande i fattoriali e le potenze

presenti nella (7.2) rendono generalmente l’espressione difficile da calcolare.

Verifichiamo ora la condizione di normalizzazione:

+∞

X

x=0

P (x) = e

−µ

+∞ x

X

µ

x=0

x!

= e−µ eµ ≡ 1

66

CAPITOLO 7. ESEMPI DI DISTRIBUZIONI TEORICHE

0.3

µ=2

µ = 25

µ = 50

0.2

0.1

0

0

10

20

30

40

50

60

70

80

Figura 7.5: La distribuzione di Poisson, per tre diversi valori del parametro

µ.

67

7.4. LA DISTRIBUZIONE DI POISSON

(riconoscendo nella sommatoria l’espressione di uno sviluppo in serie di McLaurin della funzione esponenziale). Calcoliamo poi il valore di aspettazione di

x:

+∞

X

µx −µ

E(x) =

x

e

x!

x=0

+∞

X

µx −µ

=

x

e

x!

x=1

= µ e−µ

= µe

−µ

+∞

X

µx−1

(x − 1)!

x=1

+∞ y

X

µ

y=0

y!

= µ e−µ eµ

=µ .

Nei passaggi si è prima osservato che il primo termine della sommatoria

(x = 0) è nullo, e si è poi introdotta la nuova variabile y = x − 1. Troviamo

ora il valore di aspettazione di x2 : con passaggi analoghi, si ottiene

2

E(x ) =

+∞

X

x2

x=0

=µ

+∞

X

µx −µ

e

x!

x

x=1

µx−1 −µ

e

(x − 1)!

+∞

X

µx−1 −µ

=µ

(x − 1) + 1

e

(x

−

1)!

x=1

" +∞

#

+∞ y

X µy

X

µ

=µ

y

e−µ +

e−µ

y!

y!

y=0

y=0

" +∞

#

+∞

X

X

=µ

y P (y) +

P (y)

y=0

= µ (µ + 1)

y=0

68

CAPITOLO 7. ESEMPI DI DISTRIBUZIONI TEORICHE

e la varianza di x risulta allora anch’essa data da

2

Var(x) = E x2 − E(x) = µ (µ + 1) − µ2 = µ .

Anche la distribuzione di Poisson, come si vede dai grafici di figura 7.5,

è bene approssimata da una distribuzione normale quando µ è abbastanza

elevato; questo non deve stupire, visto lo stretto legame che esiste tra la

distribuzione di Poisson e quella di Bernoulli — il cui limite per grandi N è

appunto la funzione di Gauss. Anche la distribuzione di Poisson, per grandi

µ, tende a quella normale.

In genere si ritiene che, per valori medi µ & 8, si possa ritenere soddisfacente l’approssimazione normale alla distribuzione di Poisson.

Chiudiamo questa sezione sottolineando che la distribuzione poissoniana

si applica alle cosiddette misure di conteggio, ovvero allo studio di fenomeni

intrinsecamenti discreti e soggetti a fluttuazioni (nello spazio o nel tempo), di

cui siamo interessati al numero di occorrenze, indipendentemente dall’ordine.

Un tipico esempio in ambito astronomico è dato dal conteggio di fotoni provenienti da una sorgente celeste per mezzo di rivelatori CCD (charge-coupleddevice). In questo caso il numero di fotoni totali è enorme, mentre è bassa

la probabilità di incidenza sul singolo elemento (pixel) del CCD. Dunque se

n è il numero di fotoni conteggiati da un certo pixel (convenzionalmente si

parla di segnale S = n), l’indeterminazione sul conteggio

(convenzionalmente

√

si parla di rumore N - dall’inglese noise) è N√= n, per cui il parametro

“rapporto segnale-rumore”, è dato da S/N = n.