Fisica

Introduzione

La massa è una misura della resistenza di un corpo a variare il suo stato di moto. Nel SI, la sua unità di misura è il

chilogrammo (kg), definito come la massa di un cilindro di lega platino-iridio conservato all’Ufficio Internazionale di

Pesi e Misure di Sèvres, in Francia.

La lunghezza è una grandezza fondamentale, misurata nel SI in metri (m), unità di misura definita nel 1983 come la

distanza percorsa dalla luce nel vuoto durante il tempo di 1/299792458 secondi.

Il tempo è un’altra grandezza fondamentale, misurata nel SI in secondi (s), definito nel 1967 come 9192631770 volte il

periodo di oscillazione della radiazione dell’atomo di cesio (Cs).

Ogni unità di misura possiede multipli e sottomultipli ed è inoltre convertibile in altre unità di misura, purché l’analisi

dimensionale lo consenta. Es. 1 miglio = 1609 m = 1.609 km.

Metodo usato dal testo Jewett & Serway: 15.0 𝑖𝑛 = (15.0 𝑖𝑛) (

2.54 𝑐𝑚

1 𝑖𝑛

) = 38.1 𝑐𝑚

N.B. Il rapporto fra parentesi è uguale ad 1! Le unità di misura sono poste in modo da elidersi e dare l’unità di misura

desiderata.

Sistemi di coordinate

La collocazione spaziale degli eventi è rappresentata in fisica tramite coordinate geometriche: un punto su di una linea

retta è rappresentabile da una sola coordinata, un punto in un piano è individuato da due coordinate, un punto nello

spazio da tre coordinate.

Il sistema di coordinate usato consiste di un’origine (fissa), detta O, un insieme di assi o direzioni, ciascuno con scala di

misura e nome appropriati ed istruzioni che ci dicano come etichettare un punto dello spazio rispetto all’origine ed agli

assi. Il sistema di coordinate generalmente adoperato è quello cartesiano:

y

(x, y)

O

x

Vettori e Scalari

Le grandezze fisiche possono essere suddivise in due categorie: scalari e vettori. Gli scalari sono completamente

specificati da un numero (positivo o negativo) seguito da un’unità di misura. Un vettore, invece, necessita di

informazioni diverse per essere completamente specificato: intensità (o modulo), direzione e verso. Esempi di

grandezze scalari sono il tempo o la massa, esempi di vettori sono gli spostamenti, la forza, la velocità.

Proprietà dei Vettori

⃗⃗ sono per definizione uguali se hanno le stesse unità di misura, lo stesso

Uguaglianza di due vettori: due vettori 𝐴⃗ e 𝐵

⃗⃗ solo se 𝐴 = 𝐵 ed 𝐴⃗ e 𝐵

⃗⃗ sono concordi. Questa proprietà

modulo e puntano nella stessa direzione e verso. Cioè, 𝐴⃗ = 𝐵

permette di traslare un vettore parallelamente a se stesso, senza alterarlo.

Addizione: due o più vettori possono essere sommati solo se hanno tutti la stessa unità di misura (come per gli scalari);

inoltre, si disegnano i vettori l’uno adiacente all’altro (cioè il secondo a partire dalla punta del primo, e così via) ed il

vettore somma risultante sarà un vettore che congiunge l’inizio della freccia del primo vettore con la punta della

⃗⃗ = 𝐵

⃗⃗ + 𝐴⃗) e di quella associativa

freccia dell’ultimo. La somma di vettori gode della proprietà commutativa (𝐴⃗ + 𝐵

⃗⃗ + 𝐶⃗) = (𝐴⃗ + 𝐵

⃗⃗) + 𝐶⃗].

[𝐴⃗ + (𝐵

Opposto di un vettore: l’opposto del vettore 𝐴⃗ è definito come il vettore che ha stesso modulo e direzione di 𝐴⃗ ma verso

opposto. La somma di un vettore con il suo opposto dà zero come vettore somma. Cioè, 𝐴⃗ + (−𝐴⃗) = 0.

⃗⃗ equivale alla somma del vettore 𝐴⃗ con l’opposto del vettore 𝐵

⃗⃗. Cioè, 𝐴⃗ −

Sottrazione di vettori: la sottrazione 𝐴⃗ − 𝐵

⃗⃗ = 𝐴⃗ + (−𝐵

⃗⃗).

𝐵

Moltiplicazione di un vettore per uno scalare:se un vettore 𝐴⃗ viene moltiplicato per una quantità scalare positiva s, il

prodotto 𝑠𝐴⃗ è un vettore che ha la stessa direzione e lo stesso verso di 𝐴⃗, ma modulo uguale al prodotto sA. Se s è,

invece, una grandezza negativa,il vettore 𝑠𝐴⃗ sarà diretto nel verso opposto ad 𝐴⃗.

⃗⃗ possono essere moltiplicati in due diversi modi: tramite il prodotto

Moltiplicazione di due vettori: due vettori 𝐴⃗ e 𝐵

scalare (che origina una grandezza scalare) e tramite il prodotto vettoriale (che origina una grandezza vettoriale). Nel

⃗⃗ = 𝐴𝐵 𝑐𝑜𝑠 𝜗, dove 𝜗 è l’angolo compreso fra i due vettori 𝐴⃗ e 𝐵

⃗⃗. Nel secondo caso,

primo caso, il prodotto scalare 𝐴⃗ ∙ 𝐵

⃗⃗ è uguale ad un vettore che ha modulo uguale ad 𝐴𝐵 𝑠𝑖𝑛 𝜗.

invece, il prodotto vettoriale 𝐴⃗ × 𝐵

Moto in una dimensione

Dall’esperienza quotidiana sappiamo che il moto rappresenta il cambiamento continuo della posizione di un oggetto. Il

moto di un oggetto attraverso lo spazio (traslazione) può essere accompagnato dalla rotazione e dalla vibrazione

dell’oggetto; è spesso possibile, tuttavia, semplificare le cose, trascurando rotazione e moti interni dell’oggetto in

movimento, almeno inizialmente. Il risultato è un modello semplificato che chiamiamo modello del punto materiale, in

cui qualsiasi oggetto è approssimato ad un punto materiale che si muove in uno spazio delimitato da assi cartesiani.

La velocità scalare media è una grandezza che trascura le variazioni di velocità che può avere un punto in movimento

ed approssima la velocità sempre costante durante lo spostamento. Essa si calcola come 𝑣𝑚𝑒𝑑 ≡

𝑑

∆𝑡

, dove d è la

distanza percorsa in un intervallo di tempo ∆𝑡 e ∆𝑡 è l’intervallo di tempo stesso. È, appunto, uno scalare e non

necessita, pertanto, di alcuna direzione o verso.

La velocità media è, invece, un vettore, definito come il rapporto fra lo spostamento ∆𝑥 e l’intervallo di tempo ∆𝑡 in cui

avviene questo spostamento (𝑣𝑥,𝑚𝑒𝑑 ≡

∆𝑥

∆𝑡

=

𝑥1 −𝑥0

𝑡1 −𝑡0

). N.B. Il pedice x indica lo spostamento lungo l’asse x.

ATTENZIONE: il modulo della velocità media NON è uguale alla velocità scalare media! Es. una particella si muove

dall’origine fino a 𝑥 = 10𝑚 per poi tornare indietro in un intervallo di tempo complessivo ∆𝑡 = 4.0𝑠. Il modulo della

velocità media sarà 0 (perché il punto di inizio 𝑥0 coincide con il punto di fine 𝑥1 ), ma la velocità scalare media sarà

𝑣𝑚𝑒𝑑 =

20𝑚

4.0𝑠

= 5.0 𝑚⁄𝑠.

La velocità media, essendo il rapporto fra lo spostamento e l’intervallo di tempo, non ci fornisce alcuna informazione

sul moto, ma solo sul risultato del moto: essa è, infatti, indipendente dal cammino seguito dal punto materiale e

dipende soltanto dalle sue coordinate iniziali e finali.

Infine, è da notare che la velocità media può avere segno positivo o negativo, a seconda del segno dello spostamento

(l’intervallo di tempo è sempre positivo). Se 𝑥1 > 𝑥0 , la velocità media è positiva, cioè è nella direzione delle x positive.

Se, invece, 𝑥1 < 𝑥0 , la velocità media è negativa, cioè è nella direzione delle x negative.

La velocità istantanea è, invece, la velocità (vettoriale) di una particella ad un qualsiasi istante di tempo ed è uguale al

valore limite del rapporto ∆𝑥 ⁄∆𝑡 quando ∆𝑡 tende a zero1. Con la terminologia dell’analisi matematica, questo limite si

chiama derivata di x rispetto a t. Quindi 𝑣𝑥 ≡ 𝑙𝑖𝑚

∆𝑥

∆𝑡→0 ∆𝑡

=

𝑑𝑥

𝑑𝑡

. Il termine generico Velocità è adoperato per riferirsi alla

Velocità Istantanea.

Esiste anche una velocità scalare istantanea, che non è altro che il modulo del vettore Velocità Istantanea e non

necessita di ulteriori chiarimenti.

Quando la velocità varia nel tempo, si dice che la particella è accelerata. Se una particella in moto lungo l’asse x ha

velocità 𝑣𝑥𝑖 all’istante 𝑡𝑖 e velocità 𝑣𝑥𝑓 all’istante 𝑡𝑓 , l’accelerazione media 𝑎𝑥,𝑚𝑒𝑑 nell’intervallo di tempo ∆𝑡 = 𝑡𝑓 − 𝑡𝑖

è definita come il rapporto ∆𝑣𝑥 ⁄∆𝑡 in cui ∆𝑣𝑥 = 𝑣𝑥1 − 𝑣𝑥0 è la variazione di velocità nell’intervallo di tempo. Quindi,

𝑎𝑥,𝑚𝑒𝑑 ≡

𝑣𝑥1 −𝑣𝑥0

𝑡1 −𝑡0

=

∆𝑣𝑥

∆𝑡

. L’accelerazione è una misura della velocità scalare di variazione della velocità, ma è una

grandezza vettoriale.

Se il valore dell’accelerazione media è diverso in diversi intervalli di tempo, è utile definire l’accelerazione istantanea

come il limite dell’accelerazione media quando ∆𝑡 tende a zero, analogamente alla velocità istantanea. Quindi, 𝑎𝑥 ≡

𝑙𝑖𝑚

∆𝑣𝑥

∆𝑡→0 ∆𝑡

=

𝑑𝑣𝑥

𝑑𝑡

. Cioè, l’accelerazione istantanea è uguale alla derivata della velocità rispetto al tempo, che per

definizione è la pendenza del grafico velocità-tempo. Quando l’accelerazione e la velocità sono nello stesso verso,

l’oggetto sta aumentando il modulo della velocità in quel verso; se, invece, l’accelerazione e la velocità hanno verso

discorde, la velocità scalare dell’oggetto sta diminuendo nel tempo.

Se l’accelerazione di una particella varia nel tempo, descrivere il moto di tale particella può essere complicato. Se,

invece, l’accelerazione è costante, possiamo utilizzare un modello molto pratico, appunto quello della particella

sottoposta ad accelerazione costante. In questo caso, l’accelerazione media relativa a qualsiasi intervallo di tempo è

uguale all’accelerazione istantanea in ogni istante di tempo contenuto nell’intervallo. Se consideriamo, per

convenienza, 𝑡0 = 0 e 𝑡1 = 𝑡, possiamo esprimere la velocità 𝑣𝑥 = 𝑣𝑥0 + 𝑎𝑥 𝑡. Questa espressione ci permette di

prevedere la velocità ad ogni istante t se la velocità iniziale e l’accelerazione (costante) sono note. Per conoscere,

invece, la posizione della particella, sapendo velocità (iniziale e finale) ed istante di tempo, utilizziamo l’equazione 𝑥 =

1

𝑥0 + (𝑣𝑥0 + 𝑣𝑥 )𝑡. Possiamo inoltre arrivare alla posizione anche conoscendo l’accelerazione (costante) invece della

2

1

velocità finale: 𝑥 = 𝑥0 + 𝑣𝑥0 𝑡 + 𝑎𝑥 𝑡 2 . Infine, esiste anche una formula per la velocità in funzione della posizione:

2

𝑣𝑥 2 = 𝑣𝑥0 2 + 2𝑎𝑥 (𝑥 − 𝑥0 ).

Queste equazioni sono utilizzabili anche per un corpo in caduta libera: l’accelerazione 𝑎⃗ diventerà però l’accelerazione

di gravità 𝑔⃗ = 9.80 𝑚⁄𝑠 2 = 980 𝑐𝑚⁄𝑠 2 = 32 𝑓𝑡⁄𝑠 2 . La direzione del vettore 𝑔⃗ è diretta in basso verso il centro della

Terra.

1

Lo spostamento ∆𝑥 tende a zero quando ∆𝑡 tende a zero, ma il rapporto ∆𝑥 ⁄∆𝑡 tende al valore della vera pendenza

della retta tangente alla curva x in funzione di t.

Moto in due dimensioni

Il moto di una particella lungo una retta è completamente determinato se è nota la sua posizione in funzione del

tempo. Nel piano xy, invece, la posizione della particella sarà espressa da un vettore posizione 𝑟⃗, tracciato a partire

dall’origine del sistema di riferimento alla posizione della particella. Quindi, ∆𝑟⃗ ≡ ⃗⃗⃗⃗

𝑟1 − ⃗⃗⃗⃗.

𝑟0

La velocità media 𝑣⃗𝑚𝑒𝑑 della particella nell’intervallo di tempo ∆𝑡 è il rapporto fra lo spostamento e l’intervallo di

tempo stesso. Cioè, 𝑣⃗𝑚𝑒𝑑 ≡

∆𝑟⃗

∆𝑡

. Poiché lo spostamento è una grandezza vettoriale, anche la velocità media è un

vettore, diretto lungo ∆𝑟⃗. Come quella unidimensionale, anche questa velocità media è indipendente dal percorso e

dipende soltanto dalle coordinate iniziali e da quelle finali.

La velocità istantanea 𝑣⃗ è, invece, il limite della velocità media ∆𝑟⃗⁄∆𝑡 allorquando ∆𝑡 tende a 0. Ovvero, in simboli,

𝑣⃗ ≡ 𝑙𝑖𝑚

∆𝑟⃗

∆𝑡→0 ∆𝑡

=

𝑑𝑟⃗

𝑑𝑡

. La direzione del vettore velocità istantanea in ogni punto della traiettoria è quella della retta

tangente alla traiettoria in quel punto e nel verso del moto. Il modulo della velocità istantanea è la velocità scalare.

Se la velocità cambia (anche solo in direzione), il vettore velocità istantanea cambia da 𝑣⃗0 al tempo 𝑡0 a 𝑣⃗1 al tempo

𝑡1 . L’accelerazione media 𝑎⃗𝑚𝑒𝑑 è definita come il rapporto della variazione della velocità istantanea ∆𝑣⃗ in un intervallo

di tempo ∆𝑡 e l’intervallo di tempo stesso. In simboli, 𝑎⃗𝑚𝑒𝑑 ≡

𝑣⃗⃗1 −𝑣⃗⃗0

𝑡1 −𝑡0

=

∆𝑣⃗⃗

∆𝑡

. L’accelerazione media è una grandezza

vettoriale (poiché la velocità istantanea è un vettore) diretta lungo ∆𝑣⃗.

L’accelerazione istantanea 𝑎⃗ è, infine, il valore limite del rapporto ∆𝑣⃗⁄∆𝑡, allorché ∆𝑡 tende a zero, cioè la derivata del

vettore velocità rispetto al tempo: 𝑎⃗ ≡ 𝑙𝑖𝑚

∆𝑣⃗⃗

∆𝑡→0 ∆𝑡

=

𝑑𝑣

𝑑𝑡

.

Consideriamo ora il moto in due dimensioni in cui modulo e direzione dell’accelerazione rimangono costanti; esso può

essere descritto conoscendo il suo vettore posizione 𝑟⃗ in ogni istante. Nel piano xy, il vettore posizione si può scrivere

come 𝑟⃗ = 𝑥𝑖̂ + 𝑦𝑗̂, dove x, y ed 𝑟⃗ variano nel tempo al muoversi della particella. Anche il vettore velocità può essere

espresso in termini simili: 𝑣⃗ = 𝑣𝑥 𝑖̂ + 𝑣𝑦 𝑗̂. Assumendo il vettore accelerazione 𝑎⃗ costante, anche le sue componenti 𝑎𝑥

ed 𝑎𝑦 lo sono. Pertanto, possiamo applicare le equazioni della cinematica unidimensionale anche in questo caso,

1

modificandole opportunamente. Otteniamo, così, le seguenti equazioni: 𝑣⃗ = 𝑣⃗0 + 𝑎⃗𝑡 ed 𝑟⃗ = 𝑟⃗0 + 𝑣⃗0 𝑡 + 𝑎⃗𝑡 2 . In altre

2

parole, il moto di due dimensioni con accelerazione costante è equivalente a due moti indipendenti nelle direzioni x ed

y aventi accelerazioni 𝑎𝑥 ed 𝑎𝑦 costanti, giacché il moto nella direzione x non influenza quello nella direzione y e

viceversa.

Il moto di un proiettile, sparato su un suolo piano dall’origine a 𝑡 = 0 con una componente 𝑣𝑦 positiva è un moto in

due dimensioni. Vi sono due punti nel moto interessanti da analizzare: il picco massimo, di coordinate cartesiane (R/2,

h) ed il punto di atterraggio, di coordinate (R,0). La distanza R è detta gittata del proiettile ed h è la sua altezza

massima. A causa della simmetria della traiettoria, il proiettile raggiunge la sua massima altezza h quando la sua

posizione x è la metà della gittata R. Si possono determinare R ed h in funzione di 𝑣0 , 𝜗0 e g. L’altezza massima sarà

determinata dall’equazione ℎ =

𝑣0 2 𝑠𝑖𝑛 𝜗0

2𝑔

, da cui si evince che per aumentare l’altezza massima si può agire in due

modi: imprimere una maggiore velocità iniziale 𝑣0 oppure spararlo ad un angolo 𝜗0 maggiore (oppure andare in un

posto con una minore accelerazione di gravità, come sulla Luna!). La gittata R, cioè la distanza orizzontale percorsa in

un tempo doppio di quello necessario a raggiungere il punto più alto, è, invece, calcolabile con l’equazione 𝑅 =

𝑣0 2 𝑠𝑖𝑛 2𝜗0 𝑐𝑜𝑠 𝜗0

𝑔

=

𝑣0 2 𝑠𝑖𝑛 2𝜗0

𝑔

, da cui si evince che per aumentare la gittata si può agire in due modi: imprimere una

velocità iniziale maggiore oppure andare in un posto con una minore accelerazione di gravità (come sulla Luna!).

Se il percorso è circolare e la velocità è (di modulo) costante, si parla di moto circolare uniforme; la particella che si

muove con questo moto ha comunque un’accelerazione, anche se la velocità non cambia di modulo, dal momento che

la velocità cambia in ogni istante, per rimanere tangente alla traiettoria. Questo tipo di accelerazione si chiama

accelerazione centripeta ed il suo modulo è dato da 𝑎𝑐 =

𝑣2

𝑟

, dove r è il raggio della circonferenza. L’accelerazione

centripeta è diretta verso il centro della circonferenza. In molte situazioni, è conveniente descrivere il moto di una

particella che si muove con velocità costante di modulo lungo una circonferenza di raggio r in funzione del periodo T,

definito come il tempo necessario per una rivoluzione completa: nel tempo T, la particella si muove su un percorso di

2𝜋𝑟, uguale alla lunghezza della traiettoria circolare. Quindi, poiché il modulo della velocità è uguale alla lunghezza

della circonferenza diviso per il periodo, ossia 𝑣 = 2𝜋𝑟 ⁄𝑇, segue che il periodo sarà definito dall’equazione 𝑇 =

2𝜋𝑟

𝑣

.

Nel caso in cui, invece, la velocità di una particella, lungo un percorso curvo, vari di modulo e di direzione, la velocità

della particella sarà sempre tangente al percorso e l’accelerazione sarà individuata dalla somma vettoriale 𝑎⃗ = 𝑎⃗𝑟 +

𝑎⃗𝑡 , dove 𝑎⃗𝑟 è la cosiddetta accelerazione radiale (dovuta alla variazione della direzione del vettore velocità ed il cui

modulo è uguale a −𝑎𝑐 ), mentre 𝑎⃗𝑡 è l’accelerazione tangenziale (dovuta alla variazione del modulo del vettore

velocità ed il cui modulo è uguale a

𝑎𝑟

𝑑|𝑣⃗⃗|

𝑑𝑡

).

𝑎⃗

𝑎𝑡

Le Leggi del Moto

Ciascuno di noi ha una comprensione elementare del concetto di forza, tratta dall’esperienza quotidiana; dal punto di

vista fisico, si distingue fra forze di contatto, che rappresentano il risultato di un contatto fisico fra due oggetti, e campi

di forze, che non necessitano di contatto e possono agire attraverso lo spazio vuoto. La distinzione fra i due non è così

netta come sembrerebbe, dal momento che le forze di contatto sembrano in realtà dovute a campi di forze a livello

atomico. Sperimentalmente, le forze si comportano come vettori, per cui è conveniente adoperare la regola della

somma fra vettori per ottenere la forza risultante su un corpo.

La prima legge di Newton, talvolta detta principio di inerzia, definisce un insieme speciale di sistemi di riferimento

chiamati riferimenti inerziali. La legge può essere espressa come: “Se un corpo non interagisce con altri corpi, è

possibile individuare un sistema di riferimento nel quale esso abbia accelerazione nulla.” Un tale sistema di riferimento

è chiamato sistema di riferimento inerziale. Un qualsiasi sistema di riferimento che si muova con velocità costante

relativa ad un sistema di riferimento inerziale è esso stesso un sistema di riferimento inerziale (es. una nave che si

muove con velocità costante rispetto alla Terra è inerziale per i suoi occupanti; la Terra stessa, che si muove con

velocità costante rispetto al Sole, è inerziale per i suoi abitanti). La Terra, che si muove, oltre che intorno al Sole, anche

intorno al proprio asse, è approssimabile ad un sistema inerziale perché le velocità dei suoi due moti sono del tutto

trascurabili se confrontate con l’accelerazione di gravità g. Consideriamo, quindi, inerziale qualsiasi sistema in moto

solidale a quello della Terra.

Un enunciato più pratico della legge di Newton è il seguente: in assenza di forze esterne, quando visto da un sistema

inerziale, un oggetto in quiete rimarrà in quiete ed un oggetto in moto persevererà nel suo stato di moto rettilineo

uniforme. In termini ulteriormente semplificati, quando su un corpo non agisce alcuna forza, la sua accelerazione è

zero.

La tendenza di un corpo a resistere alle variazioni della sua velocità è detta inerzia; una misura di questa tendenza è la

massa (detta per l’appunto massa inerziale), proprietà intrinseca ai corpi la cui unità di misura nel SI è il kilogrammo (è

una grandezza scalare). Maggiore è la massa di un oggetto, minore sarà l’accelerazione che assumerà se è sottoposto

ad una determinata forza. Poiché sperimentalmente la forza (risultante) agente su di un oggetto è proporzionale

all’accelerazione prodotta (𝐹 ∝ 𝑎), chiamiamo il fattore di proporzionalità massa. Attenzione: questa massa è

concettualmente differente dalla massa inerziale, tuttavia esse si identificano a livello numerico, per cui possiamo

ritenerle una stessa grandezza.

La massa non deve essere confusa con il peso, che è il modulo della forza gravitazionale 𝐹⃗𝑔 (la forza esercitata

sull’oggetto dal pianeta su cui risiede), proporzionale sì alla massa del corpo, ma anche all’accelerazione di gravità

(𝐹⃗𝑔 = 𝑝⃗ = 𝑚𝑔⃗). Pertanto, il peso è una grandezza vettoriale, mentre la massa è uno scalare.

La seconda legge di Newton afferma che l’accelerazione di un oggetto è direttamente proporzionale alla forza

risultante agente su di esso ed inversamente proporzionale alla sua massa: 𝑎⃗ ∝

∑ 𝐹⃗

𝑚

, dove ∑ 𝐹⃗ è la forza risultante,

ovvero la somma vettoriale di tutte le forze agenti sull’oggetto di massa m. In forma matematica, ∑ 𝐹⃗ = 𝑚𝑎⃗,

espressione equivalente alle tre equazioni componenti ∑ 𝐹𝑥 = 𝑚𝑎𝑥 , ∑ 𝐹𝑦 = 𝑚𝑎𝑦 ed ∑ 𝐹𝑧 = 𝑚𝑎𝑧 .

L’unità di misura della forza nel SI è il Newton (N), definito come la forza che agendo su una massa di 1 kg produce

un’accelerazione di 1 𝑚⁄𝑠 2 .

La terza legge di Newton (detta anche Principio di Azione e Reazione), infine, afferma che se due corpi interagiscono,

la forza 𝐹⃗12 esercitata dal corpo 1 sul corpo 2 è uguale in modulo, ma di verso opposto, alla forza 𝐹⃗21 esercitata dal

corpo 2 sul corpo 1. Ovvero, le forze si presentano sempre in coppia. Es. la Terra esercita su un oggetto, come un

monitor di computer fermo su di un tavolo, una forza 𝐹⃗𝑇𝑚 diretta verso il basso, mentre il monitor esercita una forza di

reazione sulla Terra𝐹⃗𝑚𝑇 = −𝐹⃗𝑇𝑚 . Il monitor non accelera perché esso è sostenuto dal tavolo, che esercita sul monitor

una forza verso l’alto 𝑛⃗⃗ = 𝐹⃗𝑡𝑚 , chiamata forza normale. Dalla seconda legge di Newton si evince che, poiché il monitor

ha accelerazione nulla, ma massa non nulla, la risultante delle forze deve essere nulla: ∑ 𝐹⃗ = 𝑛⃗⃗ − 𝑚𝑔⃗ = 0, da cui 𝑛 =

𝑚𝑔. La forza normale bilancia la forza gravitazionale sul monitor, quindi la forza risultante è zero.

Le Forze

Quando un corpo è in movimento su una superficie scabra o attraverso un mezzo viscoso (come l’acqua, ma anche

l’aria), c’è una resistenza al moto, dovuta all’interazione del corpo con ciò che lo circonda. Chiamiamo tale resistenza

forza di attrito. Se applichiamo ad un oggetto una forza piccola, esso rimane fermo finché non si raggiunge una certa

soglia: questa soglia è rappresentata dalla forza che bilancia la forza d’attrito statico 𝑓⃗𝑠 , che impedisce all’oggetto di

muoversi. Quando l’oggetto comincia a muoversi, la forza esercitata 𝐹⃗ ha superato la forza d’attrito statico massima

𝑓⃗𝑠,𝑚𝑎𝑥 . Quando l’oggetto è in movimento, la forza di attrito diventa minore di 𝑓⃗𝑠,𝑚𝑎𝑥 e prende il nome di forza d’attrito

dinamico 𝑓⃗𝑑 . L’accelerazione è prodotta ora non dalla forza 𝐹⃗ , bensì dalla forza netta 𝐹⃗ − 𝑓⃗𝑑 . Se riduciamo l’intensità

di 𝐹⃗ fino ad eguagliarla in modulo ad 𝑓⃗𝑑 , l’accelerazione diventa zero e l’oggetto si muoverà con velocità costante. Se

la forza applicata viene rimossa, la forza di attrito fornirà un’accelerazione nel verso opposto (cioè una decelerazione),

fermando il corpo.

Il modulo della forza di attrito statico fra due qualsiasi superfici a contatto può assumere valori dati da 𝑓𝑠 ≤ 𝜇𝑠 𝑛, dove

𝜇𝑠 è una costante adimensionale che rappresenta il coefficiente di attrito statico ed n è il modulo della forza normale.

La disuguaglianza ha valore fino al momento in cui il corpo è sul punto di iniziare a scivolare (in cui 𝑓𝑠 = 𝑓𝑠,𝑚𝑎𝑥 ≡ 𝜇𝑠 𝑛),

situazione detta di moto imminente.

Il modulo della forza di attrito dinamico agente fra due superfici è, invece, uguale ad 𝑓𝑑 = 𝜇𝑑 𝑛, dove 𝜇𝑑 è il

coefficiente di attrito dinamico, indipendente (almeno per i nostri scopi) dalla velocità relativa delle superfici. In

generale, comunque, 𝜇𝑑 è minore di 𝜇𝑠 .

La direzione della forza d’attrito è opposta al moto reale (attrito cinetico) o al moto imminente (moto statico)

dell’oggetto, relativamente alla superficie con la quale è a contatto.

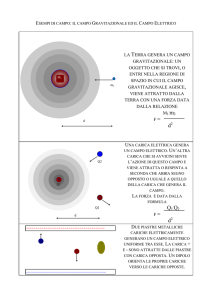

La forza gravitazionale è la forza di attrazione reciproca fra due corpi qualsiasi nell’Universo. Sebbene essa sia

estremamente intensa fra corpi macroscopici, è la più debole di tutte le forze fondamentali. La legge di gravitazione

universale di Newton afferma che ogni particella nell’Universo attrae ogni altra particella con una forza direttamente

proporzionale al prodotto delle due masse ed inversamente proporzionale al quadrato della distanza. In simboli, 𝐹𝑔 =

𝐺

𝑚1 𝑚2

𝑟2

, dove G è la costante di gravitazione universale, corrispondente a 6.67 × 10−11 𝑁 ∙ 𝑚2 ⁄𝑘𝑔2 .

La forza elettromagnetica è la forza che lega atomi e molecole in composti che formano la materia ordinaria ed è

molto più intensa della forza gravitazionale. In realtà, tutte le forze che agiscono a livello macroscopico (eccetto quella

gravitazionale) sono manifestazioni della forza elettromagnetica (forze di contatto, forze di tensione, forze di attrito,

ecc.). La forza elettromagnetica prevede l’interazione fra due tipi di particelle, quelle con carica positiva e quelle con

carica negative: cariche di segno opposto si attraggono, cariche dello stesso segno di respingono (diversamente dalla

forza gravitazionale, che è sempre di tipo attrattivo). Il modulo della forza elettrostatica (cioè della forza

elettromagnetica fra due particelle cariche a riposo) è direttamente proporzionale alle cariche ed inversamente

proporzionale al quadrato della distanza fra le cariche. In simboli, la cosiddetta legge di Coulomb si scrive come 𝐹𝑒 =

𝑘𝑒

𝑞1 𝑞2

𝑟2

, dove 𝑘𝑒 è detta costante di Coulomb ed è uguale a 8.99 × 109 𝑁 ∙ 𝑚2 ⁄𝐶 2 .

Esistono, inoltre, altre due forze fondamentali: una è la cosiddetta forza forte, forza di attrazione fra quark (particelle

che compongono elettroni e protoni), che supera la forza elettrostatica, per esempio nel tenere insieme protoni e

neutroni all’interno dei nuclei degli atomi; l’altra è detta forza debole, una forza a corto raggio che tende a produrre

instabilità in certi nuclei. Nel tentativo di unificare i tipi di forze, nel 1967 è stato proposto (e poi confermato

sperimentalmente nel 1984) che la forza elettromagnetica e la forza debole siano un’unicum, denominato oggi forza

elettrodebole. L’obiettivo è unificare tutte e quattro le forze in una singola superforza, con leggi uniche valide per tutti i

fenomeni fisici.

Energia e Trasferimento di Energia

L’energia è presente nell’Universo in molteplici forme. Ogni processo fisico nell’Universo coinvolge l’energia e

trasferimenti o trasformazioni di energia. Essa, pur essendo concettualmente così importante, è ben difficile da

definire, poiché non rappresenta una variabile “concreta” quale può essere la massa o la forza. Utilizziamo, quindi, due

concetti strettamente legati fra loro, quello di lavoro e quello di energia.

Innanzitutto, è bene definire il concetto di sistema come modello di semplificazione in cui concentriamo la nostra

attenzione su una piccola regione dell’Universo, ignorando i dettagli al di fuori di esso. Il contorno del sistema è

un’immaginaria superficie (spesso ma non necessariamente coincidente con una superficie fisica), che divide l’Universo

fra il sistema e l’ambiente circostante al sistema.

Se un sistema compie uno spostamento sotto l’azione di una forza costante, quella forza ha compiuto un lavoro sul

sistema. Questo lavoro si calcola come 𝐿 ≡ 𝐹∆𝑟 𝑐𝑜𝑠 𝜗, che non è altro che il prodotto scalare del modulo della forza

per il modulo dello spostamento. Si noti che per trovare il lavoro svolto non abbiamo bisogno di conoscere la durata

dello spostamento o la sua velocità o accelerazione. Il lavoro è, quindi, una grandezza scalare, misurata nel SI in 𝑁 ∙ 𝑚

o J (Joule). Dalla formula si nota che il lavoro è zero se sono nulli: la forza, lo spostamento oppure il coseno dell’angolo

compreso, il che accade quando l’angolo è di 90°, cioè quando la forza è perpendicolare allo spostamento. Se, invece,

la forza è parallela alla direzione (e ha lo stesso verso) dello spostamento (e quindi 𝜗 = 0 e 𝑐𝑜𝑠 𝜗 = 1), il lavoro

diventa uguale a 𝐹∆𝑟.

Nel caso di una forza variabile, quindi non costante, basta applicare la formula di cui sopra per spostamenti

infinitesimali (tendenti a zero) in cui la forza può ritenersi costante e sommare tutti questi piccoli lavori (di numero

tendente ad infinito): il valore totale tenderà ad un valore finito, ovvero l’area sottesa dalla curva forza-spostamento.

𝑥

In formula, 𝐿 = ∫𝑥 𝐹𝑥 𝑑𝑥 , cioè il lavoro svolto da 𝐹𝑥 durante lo spostamento da 𝑥0 ad 𝑥 è uguale all’integrale definito

0

(da 𝑥0 ad 𝑥) di 𝐹𝑥 in 𝑑𝑥. Se sul sistema agiscono più forze, il lavoro totale svolto sul sistema sarà il lavoro compiuto

dalla forza risultante.

Un sistema fisico costituito da un blocco, su una superficie orizzontale liscia, collegato ad una molla. Se la molla è

allungata o compressa di un tratto ∆𝑥 (a partire dalla sua posizione di equilibrio 𝑥0 = 0), essa eserciterà sul blocco una

forza data da 𝑓𝑚 = −𝑘𝑥, dove 𝑘 è una costante propria di ogni specifica molla, detta costante elastica della molla.

Questa legge è nota come legge di Hooke e risulta accurata purché lo spostamento non sia molto grande. E dunque il

𝑥

1

1

0

2

2

lavoro compiuto dalla molla sarà uguale a 𝐿𝑚 = ∫𝑥 (−𝑘𝑥)𝑑𝑥 = 𝑘𝑥02 − 𝑘𝑥 2 , da cui si nota che il lavoro sarà nullo

per qualsiasi moto i cui punti estremi coincidono (𝑥0 = 𝑥).

Un oggetto su cui è applicata una forza (che quindi compie un lavoro), che provoca uno spostamento, e quindi modifica

la sua velocità in modulo, avrà una certa energia cinetica. Il teorema delle forze vive (o teorema dell’energia cinetica)

dice, appunto, che: “quando è svolto lavoro su un sistema e la sola variazione nel sistema è il modulo della sua

velocità, il lavoro compiuto dalla forza risultante è uguale alla variazione dell’energia cinetica del sistema”. In formula,

1

𝐿 = 𝐸𝑘 = 𝑚𝑣 2 .

2

Va fatta una precisazione sui tipi di sistema: se un sistema è sottoposto a varie forze esterne, che ne causano una

variazione dell’energia cinetica, esso è un sistema non isolato. In tale sistema, il lavoro è inquadrato come un mezzo di

trasferimento di energia fra il sistema e l’ambiente. Tuttavia, esso non è l’unico: altri mezzi di trasferimento di energia

sono le onde meccaniche (propagazione in aria o in un altro mezzo), il calore (per mezzo di urti microscopici), la

trasmissione elettrica (per mezzo della corrente elettrica), la radiazione elettromagnetica, il trasferimento di materia.

Una nozione basilare è il principio di conservazione dell’energia: l’energia non si crea né si distrugge. Quando, infatti,

un sistema “perde” energia, vuol dire che essa ha attraversato il contorno ed è stata trasferita all’ambiente;

ugualmente, quando un sistema “acquista” energia, vuol dire che l’ambiente ne ha ceduto una quantità equivalente.

Oltre alla quantità di energia trasferita al sistema, è interessante conoscere anche la rapidità con cui essa viene

trasmessa. Si usa quindi il concetto di potenza. La potenza media è uguale al rapporto fra il lavoro svolto da una forza

esterna in un intervallo di tempo e l’intervallo di tempo stesso. In simboli, 𝑊𝑚𝑒𝑑 ≡

𝐿

∆𝑡

. La potenza istantanea, a un

particolare istante di tempo t, è il valore limite della potenza media quando ∆𝑡 tende a zero: 𝑊 ≡ 𝑙𝑖𝑚

𝐿

∆𝑡→0 ∆𝑡

=

𝑑𝐿

𝑑𝑡

generale, però, la potenza è definita non solo per il lavoro, ma per ogni tipo di trasferimento di energia, come 𝑊 =

. In

𝑑𝐸

𝑑𝑡

,

ovvero la rapidità con cui l’energia attraversa il contorno del sistema. L’unità di misura della potenza nel SI è il 𝑊

(Watt) o 𝐽⁄𝑠 . Un’altra unità, in uso nel sistema convenzionale USA, è il cavallo vapore (hp), corrispondente a 746 W. In

funzione del Watt si definisce una nuova unità di energia, il chilowatt-ora (kWh), corrispondente all’energia trasferita

in un’ora al tasso costante di 1 kW. ATTENZIONE: il kWh è un’unità di energia, NON di potenza!

Energia Potenziale

Immaginiamo un sistema costituito da un libro e dalla Terra, che interagiscono tramite la forza gravitazionale.

Sollevando (lentamente) il libro di una quota ∆𝑦 = 𝑦𝑏 − 𝑦𝑎 , faremo certamente un certo lavoro sul sistema. Tuttavia,

poiché il libro era fermo all’inizio e resta fermo anche dopo lo spostamento, la sua energia cinetica non cambia. Ma ci

deve essere un’altra forma di energia immagazzinata, dal momento che rilasciando il libro, esso cade al suolo,

acquisendo una certa velocità. Mentre il libro era sollevato, esso possedeva la potenziale capacità di acquisire energia

cinetica, donatagli dal sollevamento iniziale. Questo meccanismo di immagazzinamento è, quindi, chiamato energia

potenziale (nello specifico, energia potenziale gravitazionale). Matematicamente, l’energia potenziale gravitazionale

si esprime con la relazione 𝑈𝑔 ≡ 𝑚𝑔ℎ, dove m è la massa dell’oggetto, g è l’accelerazione di gravità ed h è lo

spostamento in senso verticale. Ebbene, il lavoro compiuto dalla forza che ha sollevato l’oggetto è uguale alla

variazione dell’energia potenziale: 𝐿 = ∆𝑈𝑔 = 𝑈𝑔 − 𝑈𝑔0 , dove, poiché il libro era inizialmente a terra, 𝑈𝑔0 era uguale a

zero, per cui 𝐿 = 𝑈𝑔 . L’energia potenziale gravitazionale dipende solamente dall’altezza che raggiunge l’oggetto e non

cambia se esso viene sollevato verticalmente o trascinato su di un piano inclinato.

Possiamo definire anche l’energia potenziale elastica come l’energia immagazzinata nella molla deformata (che sia

1

compressa o allungata): 𝑈𝑚 ≡ 𝑘𝑥 2 . Poiché 𝑥 2 è sempre una quantità positiva, l’energia potenziale elastica, per una

2

molla deformata, è sempre una quantità positiva.

La somma dell’energia potenziale e dell’energia cinetica di un sistema si chiama energia meccanica totale del sistema.

La legge della conservazione dell’energia meccanica afferma, appunto, che l’energia meccanica di un sistema isolato

non cambia: se aumenta l’energia cinetica, diminuirà quella potenziale e viceversa. In simboli, 𝐸𝑚 = 𝐸𝑘 + 𝑈 = 𝐸𝑚0 =

𝐸𝑘0 + 𝑈0 . Quest’equazione è vera soltanto se non c’è attrito fra le parti del sistema.

La forza di gravità è un esempio di una categoria di forze per le quali l’energia meccanica di un sistema si conserva.

Queste sono chiamate forze conservative. L’altra possibilità di immagazzinare energia in un sistema oltre quella

cinetica e potenziale è l’energia interna; quindi, una forza conservativa è una forza tra i membri di un sistema che non

causa trasformazioni di energia meccanica in energia interna dentro il sistema. Il lavoro svolto da una forza

conservativa ha una particolare proprietà: è indipendente dalla traiettoria seguita dai componenti del sistema e

dipende soltanto dalla configurazione iniziale e finale del sistema. Da questo segue che, quando un componente del

sistema si muove lungo un percorso chiuso, il lavoro svolto dalla forza conservativa è zero.

Una forza non-conservativa, invece, è una forza fra i componenti di un sistema che causa dentro il sistema

trasformazioni di energia meccanica in energia interna. Un comune esempio è la forza d’attrito, che causa il

riscaldamento dell’oggetto e della superficie su cui scorre. Per forze non conservative, inoltre, il lavoro dipende dalla

traiettoria seguita e non è nulla su un percorso chiuso.

Indipendentemente dal fatto che le forze agenti siano conservative o non-conservative, l’energia totale di un sistema

isolato (cinetica, potenziale ed interna) si conserva. Mai alcuna violazione di questo principio di conservazione critico è

stata osservata: se consideriamo, infatti, l’Universo come un sistema isolato, questa affermazione dichiara che nel

nostro Universo esiste una quantità fissa di energia e che tutti i processi all’interno dell’Universo rappresentano

trasformazioni di energia da un tipo ad un altro.

La formula per l’energia potenziale gravitazionale 𝑈𝑔 = 𝑚𝑔ℎ è valida per oggetti posti in prossimità della superficie

terrestre; tuttavia, esiste una formula più generale indipendente dalla distanza di separazione fra l’oggetto e la Terra.

Tale formula è la seguente: 𝑈𝑔 = −𝐺

𝑚1 𝑚2

𝑟

, dove r è la distanza fra i centri dei due oggetti. Anche la forza

elettrostatica fra due particelle, che ha un’espressione simile alla legge di gravitazione universale di Newton, consente

di ricavare una formula che esprima l’energia potenziale elettrica: 𝑈𝑒 = 𝑘𝑒

𝑞1 𝑞2

𝑟

. La differenza maggiore, oltre alla

presenza delle cariche al posto delle masse e la differente costante in uso, è la mancanza del segno negativo. Questo è

dovuto al fatto che il segno è automaticamente fornito dai segni delle cariche: se sono concordi, l’energia potenziale

elettrica sarà positiva (poiché la forza è repulsiva), se invece sono discordi, l’energia potenziale sarà negativa (e la

forza attrattiva).

Urti e Quantità di Moto

Per descrivere un oggetto in moto, si può far ricorso al concetto di quantità di moto (o momento lineare), la cui

somma per le particelle in un sistema isolato si conserva. Essa è il prodotto della massa della particella per la velocità a

cui si muove. In simboli, 𝑝⃗ ≡ 𝑚𝑣⃗. La quantità di moto è, dunque, un vettore, dal momento che è il prodotto di un

vettore per uno scalare. La sua direzione e verso sono gli stessi della velocità. Nel SI si misura in 𝑘𝑔 ∙ 𝑚⁄𝑠 . Per un corpo

che si muova nello spazio tridimensionale, l’equazione può essere scomposta in 𝑝𝑥 = 𝑚𝑣𝑥 , 𝑝𝑦 = 𝑚𝑣𝑦 e 𝑝𝑧 = 𝑚𝑣𝑧 .

Applicando la Seconda Legge di Newton alla quantità di moto, otteniamo che la forza risultante agente su una

particella avente quantità di moto 𝑝⃗ è uguale alla variazione nel tempo di detta quantità di moto. In formula, ∑ 𝐹⃗ =

𝑑𝑝⃗

𝑑𝑡

=

𝑑(𝑚𝑣⃗⃗)

𝑑𝑡

=𝑚

𝑑𝑣⃗⃗

𝑑𝑡

= 𝑚𝑎⃗ (se la massa della particella è costante).

In un sistema isolato, le componenti del moto nelle direzioni x, y e z si conservano indipendentemente. Questo

risultato, noto come principio di conservazione della quantità di moto, può essere riassunto come “la quantità di

moto totale di un sistema isolato è costante”; questo principio è valido indipendentemente dalla natura delle forze

considerate, anche, cioè, se le forze non sono conservative.

Come detto prima, se la forza risultante è uguale alla variazione della quantità di moto nell’unità di tempo, allora la

quantità di moto sarà uguale al prodotto della forza (risultante) per l’intervallo di tempo entro cui essa agisce.

𝑡

L’integrazione di questa espressione ci porta alla formula ∆𝑝⃗ = 𝑝⃗ − ⃗⃗⃗⃗⃗

𝑝0 = ∫𝑡 ∑ 𝐹⃗ 𝑑𝑡. L’integrale della forza rispetto

0

all’intervallo di tempo durante il quale essa agisce si chiama impulso della forza ed è un vettore avente stessa

direzione e verso della quantità di moto (e stesse dimensioni).

Il cosiddetto teorema dell’impulso afferma che l’impulso totale di una forza risultante ∑ 𝐹⃗ su una particella eguaglia la

variazione della quantità di moto della particella. In simboli, 𝐼⃗ = ∆𝑝⃗. Useremo spesso un’approssimazione sull’impulso:

assumeremo che l’intervallo di tempo sia breve e che una delle forze che contribuiscono alla forza risultante superi di

molto le altre per intensità; con questa approssimazione, possiamo trascurare gli effetti delle altre forze senza

problemi.

La legge di conservazione della quantità di moto può essere utilizzata per descrivere ciò che avviene negli urti fra due

oggetti. Useremo l’approssimazione dell’impulso, assumendo che le forze dovute all’urto siano molto più intense di

tutte le forze esterne presenti. L’urto può essere macroscopicamente inteso come il risultato di un contatto fra due

oggetti, ma questa definizione mal si applica agli urti microscopici, dal momento che due particelle con la stessa carica

(per esempio, un protone ed una particella alfa, entrambi carichi positivamente) si respingono senza che avvenga alcun

contatto: l’urto, tuttavia, è avvenuto.

L’urto si definisce urto anelastico quando l’energia cinetica non si conserva (anche se la quantità di moto si conserva).

Per esempio, l’urto di una palla di gomma contro un tavolo è anelastico, poiché parte dell’energia cinetica della palla si

trasforma in energia interna con la deformazione. Gli urti anelastici sono utilizzati in medicina per la rilevazione della

pressione intraoculare: una macchina detta tonometro invia uno sbuffo di aria contro la superficie esterna dell’occhio e

misura la velocità con cui essa viene riflessa. A pressione normale, molta energia cinetica viene dissipata (poiché

l’occhio è morbido) e la velocità è bassa. A pressioni più alte (patologiche), l’occhio è rigido e dissipa poca energia

cinetica, con il risultato di riflettere l’aria a velocità maggiore. Quando due oggetti che si urtano rimangono uniti l’uno

all’altro (quindi viene dissipata TUTTA l’energia cinetica), l’urto è detto perfettamente anelastico. È quanto accade

quando, per esempio, un meteorite cade sulla Terra e vi rimane sepolto.

Un urto elastico, invece, è un urto in cui l’energia cinetica si conserva (così come la quantità di moto): nel mondo

macroscopico, gli urti sono elastici solo approssimativamente, poiché parte dell’energia cinetica è sempre dispersa

sotto forma di calore o suono (come in una partita a biliardo). A livello atomico e subatomico, invece, si possono avere

delle vere e proprie collisioni elastiche. Ad ogni modo, è bene convenire che elasticità ed anelasticità degli urti sono

condizioni limite: nella realtà avvengono sempre casi intermedi.

Moto Rotazionale

Quando un corpo esteso, come una ruota, ruota intorno al proprio asse, il moto non può essere analizzato

considerando il corpo come una particella, in quanto ad ogni istante le differenti parti del corpo si muovono con

velocità differenti ed in direzioni differenti. Possiamo, comunque, analizzare il moto considerando il corpo esteso come

composto da un insieme di particelle in moto.

Per indicare la posizione di un corpo rotante (posizione rotazionale o posizione angolare), possiamo utilizzare la sua

orientazione (cioè l’angolo) relativa a una qualche direzione fissa di riferimento. Quando un corpo ruota, una sua

particella situata sul punto P descriverà un arco di lunghezza s sul percorso circolare di raggio r; la sua posizione

𝑠

angolare sarà uguale a 𝜗 = . ATTENZIONE: l’angolo 𝜗 è il rapporto fra un arco ed un raggio, pertanto è un numero

𝑟

puro. Gli attribuiamo, tuttavia, l’unità di misura artificiale di radiante (rad), definito come “l’angolo sotteso da un arco

di lunghezza uguale al raggio”. Poiché la lunghezza della circonferenza è 2𝜋𝑟, 360° corrispondono ad un angolo di 2𝜋

rad. Per convertire, quindi, un angolo espresso in gradi in un angolo in radianti, usiamo la formula 𝜗(𝑟𝑎𝑑) =

𝜋

𝜋

𝜋

3

4

6

𝜋

180°

𝜗(𝑑𝑒𝑔)

(es. 60° = ; 45° = ; 30° = ).

La velocità angolare media si definisce come il rapporto dello spostamento angolare del corpo rigido e l’intervallo di

tempo ∆𝑡 entro cui avviene lo spostamento: 𝜔𝑚𝑒𝑑 ≡

𝜗−𝜗0

𝑡−𝑡0

=

∆𝜗

∆𝑡

.

Analogamente alla velocità lineare, la velocità angolare istantanea è definita come il limite, per ∆𝑡 tendente a zero,

del rapporto ∆𝜗⁄∆𝑡: 𝜔 ≡ 𝑙𝑖𝑚

∆𝜗

∆𝑡→0 ∆𝑡

=

𝑑𝜗

𝑑𝑡

. L’unità di misura è il 𝑟𝑎𝑑 ⁄𝑠 oppure il 𝑠 −1 (essendo il radiante una grandezza

adimensionale).

Se la velocità angolare istantanea di una particella varia dal valore 𝜔0 ad 𝜔 nell’intervallo di tempo ∆𝑡, la particella ha

un’accelerazione angolare. L’accelerazione angolare media 𝛼𝑚𝑒𝑑 di una particella in moto lungo una traiettoria

circolare è definita dal rapporto fra la variazione di velocità angolare e l’intervallo di tempo: 𝛼𝑚𝑒𝑑 ≡

𝜔−𝜔0

𝑡−𝑡0

=

∆𝜔

∆𝑡

.

In analogia con l’accelerazione lineare, l’accelerazione angolare istantanea è definita come il limite, per ∆𝑡 tendente a

zero, del rapporto ∆𝜔⁄∆𝑡: 𝛼 ≡ 𝑙𝑖𝑚

∆𝜔

∆𝑡→0 ∆𝑡

=

𝑑𝜔

𝑑𝑡

. L’accelerazione angolare si misura in 𝑟𝑎𝑑 ⁄𝑠 2 oppure in 𝑠 −2 .

Quando un corpo rigido ruota attorno ad un asse fisso, ogni particella del corpo ruota attorno a quest’asse dello stesso

angolo, in un dato intervallo di tempo, ed ha la stessa velocità angolare e la stessa accelerazione angolare.

Le leggi del moto traslazionale unidimensionale possono essere applicate anche al moto rotazionale, sostituendo

l’accelerazione angolare all’accelerazione, la velocità angolare alla velocità e la posizione angolare alla posizione: 𝜔 =

1

1

2

2

𝜔0 + 𝛼𝑡, 𝜗 = 𝜗0 + 𝜔0 𝑡 + 𝛼𝑡 2, 𝜔2 = 𝜔0 2 + 2𝛼(𝜗 − 𝜗0 ) e 𝜗 = 𝜗0 + (𝜔0 + 𝜔)𝑡.

Poiché, quando un corpo rigido ruota intorno ad un asse fisso, ogni sua particella percorre una circonferenza, esiste

anche una velocità traslazionale sempre tangente alla traiettoria, detta velocità tangenziale, il cui modulo è dato, per

definizione, da 𝑑𝑠 ⁄𝑑𝑡, dove s è lo spazio percorso dalla particella lungo la circonferenza, ovvero 𝑠 = 𝑟𝜗; poiché r è

costante, si ha: 𝑣 =

𝑑𝑠

𝑑𝑡

=𝑟

𝑑𝜗

𝑑𝑡

= 𝑟𝜔, cioè il modulo delle velocità tangenziale della particella è uguale al prodotto della

distanza della particella dall’asse di rotazione per la velocità angolare della particella stessa.

Possiamo calcolare anche un’accelerazione tangenziale, uguale alla variazione della velocità tangenziale nel tempo,

come 𝑎𝑡 =

𝑑𝑣

𝑑𝑡

=𝑟

𝑑𝜔

𝑑𝑡

= 𝑟𝛼, cioè la componente tangenziale dell’accelerazione traslazionale della particella sottoposta

al moto circolare è uguale al prodotto della distanza della particella dall’asse di rotazione per l’accelerazione angolare.

Come abbiamo visto in precedenza, una particella in moto in una traiettoria circolare è sottoposta ad un’accelerazione

centripeta, o radiale, di modulo 𝑣 2 ⁄𝑟 , diretta verso il centro di rotazione. Poiché 𝑣 = 𝑟𝜔, possiamo esprimere

l’accelerazione centripeta della particella in funzione della velocità angolare, come 𝑎𝑐 =

𝑣2

𝑟

= 𝑟𝜔2 . L’accelerazione

traslazionale totale della particella è 𝑎⃗ = 𝑎⃗𝑡 + 𝑎⃗𝑟 , quindi il suo modulo sarà 𝑎 = √𝑎𝑡 2 + 𝑎𝑟 2 = √𝑟 2 𝛼 2 + 𝑟 2 𝜔 2 =

𝑟√𝛼 2 + 𝜔 4 .

Assimilando un corpo rigido ad un insieme di particelle ed assumendo che esso ruoti attorno ad un asse fisso con

velocità angolare 𝜔, possiamo dire che ciascuna particella è in moto, cosicché ha una certa energia cinetica,

determinata dalla massa e dalla velocità tangenziale. Sia 𝑚𝑖 la massa dell’i-esima particella e 𝑣𝑖 la sua velocità,

1

l’energia cinetica di questa particella sarà uguale a 𝐸𝑘𝑖 = 𝑚𝑖 𝑣𝑖 2 . Possiamo, quindi, esprimere l’energia cinetica totale

2

1

del corpo come la somma delle energie cinetiche delle singole particelle. Cioè, 𝐸𝑘(𝑇𝑂𝑇) = ∑𝑖 𝐸𝑘𝑖 = ∑𝑖 𝑚𝑖 𝑣𝑖 2 =

2

1

2

1

∑𝑖 𝑚𝑖 𝑟𝑖 2 𝜔2 = (∑𝑖 𝑚𝑖 𝑟𝑖 2 )𝜔2 , dove abbiamo messo in evidenza 𝜔2 perché è uguale per tutte le particelle. La

2

grandezza in parentesi è chiamata momento d’inerzia del corpo rigido: 𝐼 = ∑𝑖 𝑚𝑖 𝑟𝑖 2 . Possiamo, quindi, esprimere

1

l’energia cinetica del corpo rigido che ruota attorno all’asse, cioè l’energia cinetica rotazionale, come 𝐸𝑘(𝑇𝑂𝑇) = 𝐼𝜔2 .

2

Quando su un corpo rigido imperniato su un certo asse si esercita una forza risultante e la retta d’azione (cioè la linea

immaginaria co-lineare al vettore forza ed estesa all’infinito nei due versi) della forza non passa attraverso il perno, il

corpo tende a ruotare attorno a quest’asse. La tendenza di una forza a far ruotare un corpo attorno a un certo asse si

misura con una grandezza (vettoriale) chiamata momento della forza (o momento meccanico). Esso è l’analogo nel

moto rotazionale della forza che causa le variazioni nel moto traslazionale, poiché è la causa delle variazioni nel moto

rotatorio. La forza applicata 𝐹⃗ che agisce formando un angolo 𝜑 rispetto al vettore posizione 𝑟⃗ che localizza il punto di

applicazione della forza, ha un momento di modulo 𝜏 ≡ 𝑟𝐹 𝑠𝑖𝑛 𝜑. La grandezza 𝑟 𝑠𝑖𝑛 𝜑, indicata con d, è chiamata

braccio del momento (o braccio della forza) e rappresenta la distanza fra l’asse di rotazione e la retta d’azione di 𝐹⃗ .

Quindi, possiamo definire il momento della forza come 𝜏 = 𝐹(𝑟 𝑠𝑖𝑛 𝜑) = 𝐹𝑑, oppure come prodotto vettoriale di 𝑟⃗ ed

𝐹⃗ , cioè 𝜏⃗ ≡ 𝑟⃗ × 𝐹⃗ ≡ 𝑟𝐹 𝑠𝑖𝑛 𝜑. Il momento di una forza non deve essere confuso con la forza: esso dipende dalla forza,

ma anche da dove essa è applicata. Inoltre, esso ha le dimensioni di una forza per una lunghezza e si misura in 𝑁 ∙ 𝑚.

Alla luce del moto rotazionale, perché un corpo sia in equilibrio sono necessarie due condizioni: la risultante delle forze

esterne agenti sul corpo deve essere uguale a zero: in simboli, ∑ 𝐹⃗ = 0 (condizione di equilibrio traslazionale); inoltre,

anche la risultante dei momenti delle forze esterne deve essere uguale a zero (rispetto a qualsiasi asse): in simboli,

∑ 𝜏⃗ = 0 (condizione di equilibrio rotazionale). Le due equazioni vettoriali sono equivalenti a sei equazioni scalari: tre

derivanti dalla prima e tre dalla seconda. Limitando, però, il campo di interesse (ovvero considerando le forze tutte

giacenti nel piano xy), bastano tre equazioni per definire l’equilibrio statico: ∑ 𝐹𝑥 = 0, ∑ 𝐹𝑦 = 0 e ∑ 𝜏𝑧 = 0.

Possiamo ricavare un analogo rotazionale della Seconda Legge di Newton, ovvero: ∑ 𝜏 = 𝐼𝛼, cioè il momento

risultante delle forze agenti su un corpo rigido è proporzionale alla sua accelerazione angolare, e la costante di

proporzionalità è il momento d’inerzia.

Il momento della quantità di moto è chiamato momento angolare ed è uguale al prodotto vettoriale del vettore

posizione 𝑟⃗ e del vettore quantità di moto 𝑝⃗. In simboli, 𝐿⃗⃗ ≡ 𝑟⃗ × 𝑝⃗. Poiché 𝑝⃗ = 𝑚𝑣⃗, il modulo di 𝐿⃗⃗ è dato da 𝐿 =

𝑚𝑣𝑟 𝑠𝑖𝑛 𝜑, dove 𝜑 è l’angolo compreso fra 𝑟⃗ e 𝑝⃗. Ne segue che L è zero quando 𝑟⃗ è parallelo a 𝑝⃗. D’altra parte, quando

𝑟⃗ è perpendicolare a 𝑝⃗, L assumerà il suo valore massimo 𝑚𝑣𝑟. Sulla base del momento angolare, possiamo affermare

che il momento di una forza non è altro che la variazione nel tempo del momento angolare della particella: in simboli,

𝜏⃗ =

⃗⃗

𝑑𝐿

𝑑𝑡

(analogo rotazionale della formula 𝐹⃗ =

𝑑𝑝⃗

𝑑𝑡

). Come, inoltre, la quantità di moto totale di un sistema di particelle

rimane costante quando la risultante delle forze esterne agenti sul sistema è nulla, così il momento angolare totale di

un sistema resta costante se il momento risultante delle forze esterne agenti sul sistema è nullo.

Moto Oscillatorio

Nel caso del moto oscillatorio, il modello sperimentale di uso corrente è quello di un oggetto di massa m attaccato ad

una molla orizzontale. Se la molla non è deformata, l’oggetto rimane fermo (su una superficie priva di attrito) nella sua

posizione di equilibrio, definita come 𝑥 = 0. Se l’oggetto è tirato di lato nella posizione 𝑥, e poi rilasciato, esso oscillerà

avanti e indietro fra le posizioni 𝑥 e – 𝑥. Per eliminare gli effetti della dimensione dell’oggetto, si usa il modello del

punto materiale. Quando una particella è soggetta ad una forza di richiamo lineare (data dalla legge di Hooke 𝐹 =

−𝑘𝑥), il moto che essa segue è un particolare tipo di moto oscillatorio detto moto armonico semplice. Un sistema

sottoposto a tale moto si chiama oscillatore armonico semplice. Se 𝐹 = −𝑘𝑥, allora – 𝑘𝑥 = 𝑚𝑎, da cui segue che 𝑎 =

−

𝑘

𝑚

𝑥, ovvero l’accelerazione di una particella in moto armonico semplice è proporzionale allo spostamento della

particella dalla sua posizione di equilibrio ed è in verso opposto. La particella completa un intero ciclo del suo moto

quando ritorna alla sua posizione iniziale, passando ancora per 𝑥 = 0 con la sua velocità massima.

Il periodo T del moto è definito come il tempo necessario alla particella per compiere un ciclo completo;

matematicamente, 𝑇 =

2𝜋

𝜔

𝑚

, dove 𝜔 è la frequenza angolare (misurata in radianti/s): 𝜔 = 2𝜋√ , dove m è la massa

𝑘

della particella e k la costante elastica della molla. In funzione del periodo, la frequenza angolare può anche essere

calcolata come 𝜔 =

2𝜋

𝑇

.

Il reciproco del periodo di chiama frequenza f del moto e rappresenta il numero di oscillazioni che la particella compie

nell’unità di tempo. L’unità di misura della frequenza è l’Hertz (Hz), equivalente al 𝑠 −1 . In formula, 𝑓 =

1

𝑇

=

𝜔

2𝜋

. In

funzione della frequenza, la frequenza angolare può essere espressa come 𝜔 = 2𝜋𝑓.

Se un oggetto attaccato ad una molla scivola su una superficie priva di attrito, possiamo considerare la combinazione

molla-oggetto come un sistema isolato ed applicarvi le relative leggi. Pertanto, l’energia meccanica del sistema è pari

1

ad 𝐸𝑚 = 𝑘𝐴2 , dove k è la costante elastica della molla ed A è l’ampiezza del moto (ovvero lo spostamento massimo).

2

Il pendolo semplice è un altro sistema meccanico che si muove di moto periodico. Esso consiste di un punto materiale

di massa m sospeso ad un filo (di massa trascurabile) di lunghezza L, la cui estremità superiore è fissata. Un pendolo

reale, purché la dimensione dell’oggetto sia piccola rispetto alla lunghezza del filo, può essere assimilato ad un pendolo

semplice. Quando il pendolo è tirato lateralmente e poi rilasciato, esso oscilla intorno al punto più basso, la posizione

di equilibrio. Poiché il moto è dovuto alla forza di gravità 𝑚𝑔⃗, possiamo calcolare delle formule valide per piccoli angoli

𝑔

(minori di 10°). In particolare, la frequenza angolare è uguale a 𝜔 = √ (dove g è il modulo dell’accelerazione di

𝐿

gravità ed L la lunghezza del filo). Il periodo, di conseguenza, è pari a 𝑇 =

2𝜋

𝜔

𝐿

= 2𝜋√ . Si dimostra, quindi, che per

𝑔

piccole oscillazioni il periodo e la frequenza angolare di un pendolo semplice dipendono soltanto dalla lunghezza del

filo e non dalla massa dell’oggetto, per cui sperimentalmente si troverà che tutti i pendoli semplici di uguale lunghezza

oscillano con lo stesso periodo (purché g sia costante).

Onde Meccaniche

Le onde meccaniche (ad es. le onde acustiche o l’ondulazione dell’acqua dovuta ad un sasso gettatovi) sono onde la cui

perturbazione si propaga attraverso un mezzo, come l’aria o l’acqua. Esse si distinguono dalle onde elettromagnetiche

(ad es. le onde luminose o le onde radio) che, invece, non necessitano di un mezzo per propagarsi.

La propagazione di una perturbazione è un trasferimento di energia senza trasferimento di materia; tutte le onde

trasportano energia, ma la quantità di energia trasmessa differisce da caso a caso, così come il meccanismo

responsabile del trasferimento. Tutte le onde meccaniche richiedono una sorgente di perturbazione, un mezzo che

possa essere perturbato e un meccanismo fisico per cui le particelle del mezzo possano influenzarsi (cioè che consenta

la propagazione della perturbazione). Le onde possono essere trasversali o longitudinali: nel primo caso, le particelle

del mezzo perturbato si muovono perpendicolarmente alla velocità dell’onda; nel secondo, invece, esse subiscono uno

spostamento parallelo alla direzione del moto dell’onda (è questo il caso delle onde sonore).

Partendo da un esempio di una corda con un’estremità fissata, cui diamo un impulso all’altra estremità, possiamo

verificare come lo scuotimento continuo generi un’onda continua, detta onda sinusoidale, per la forma che essa

assume. Il punto di massimo spostamento positivo della corda si chiama cresta, mentre il punto più basso è detto

avvallamento. La cresta e l’avvallamento si muovono con l’onda, per cui un particolare punto della corda alternerà la

sua posizione fra una cresta ed un avvallamento.

Per descrivere un’onda sinusoidale, si fa riferimento a tre caratteristiche fisiche: la lunghezza d’onda, la frequenza e la

velocità. La lunghezza d’onda è la distanza minima fra due punti che si comportano identicamente (ad es. due creste o

due avvallamenti adiacenti) e si indica con il simbolo λ. La frequenza f delle onde sinusoidali è identica alla frequenza

del moto armonico semplice ed è, quindi, l’inverso del periodo T, definito come il tempo necessario affinché un

elementino del mezzo effettui un’oscillazione completa. La velocità d’onda v è la velocità con cui le onde si propagano

in uno specifico mezzo e dipende, pertanto, dalle sue caratteristiche. Un altro parametro importante è l’ampiezza

dell’onda A, che corrisponde al massimo spostamento della particella del mezzo dalla sua posizione d’equilibrio.

Velocità, lunghezza d’onda, frequenza e periodo sono legati dalla relazione 𝑣 =

identica a quella del moto armonico semplice, cioè: 𝜔 ≡

2𝜋

𝑇

𝜆

𝑇

= 𝜆𝑓. La frequenza angolare è

= 2𝜋𝑓.

Quando un impulso che si propaga raggiunge una discontinuità, una parte o tutto l’impulso verrà riflesso. La parte non

riflessa si dice che viene trasmessa attraverso la discontinuità. Nell’esempio della corda fissata ad un’estremità al

muro, quando l’impulso raggiunge l’estremità fissa, poiché la superficie è rigida, nessuna parte dell’impulso è

trasmessa ed esso è totalmente riflesso. Si noti che l’impulso riflesso ha esattamente la stessa ampiezza dell’impulso in

arrivo, ma è invertito.

Se due o più onde che si propagano si muovono in un mezzo e si combinano in un dato punto, lo spostamento

risultante del mezzo in quel punto è la somma degli spostamenti delle singole onde (principio di sovrapposizione). Non

tutte le onde obbediscono, però, a questo principio: quelle che lo fanno sono dette onde lineari ed hanno un’ampiezza

piccola rispetto alla lunghezza d’onda. La combinazione di onde diverse nella stessa regione di spazio è detta

interferenza (ma essa non è un effetto permanente, esiste soltanto fintanto che le onde condividono la stessa regione

di spazio). Se le onde sono “in fase”, cioè i picchi e gli zeri delle singole onde si presentano sempre nella stessa

posizione, esse interferiscono “costruttivamente”, generando, cioè, un’onda risultante che ha un’ampiezza pari alla

somma delle singole ampiezze. Se, invece, le onde sono “fuori fase”, ovvero ad un picco dell’una corrisponde una valle

dell’altra, i loro spostamenti si annullano in ogni punto e l’onda risultante ha ampiezza zero ovunque: esse

interferiscono “distruttivamente”. Esistono, infine, casi intermedi.

Statica dei Fluidi

La materia viene abitualmente considerata in uno dei tre stati: solido, liquido o gassoso. Un solido ha forma e volume

definiti, un liquido ha un volume definito, ma assume la forma del recipiente che lo contiene ed un gas non ha né forma

né volume definiti. Un insieme di molecole sistemate in modo casuale e tenute insieme da deboli forze di coesione e da

forze esercitate dalle pareti del contenitore si chiama fluido. Questa definizione risulta comprendere sia i liquidi sia i

gas.

Se applichiamo una forza non perpendicolare sulla superficie di un oggetto solido, esso subirà una distorsione. Nel

nostro modello semplificato, i fluidi non sono viscosi (non hanno, cioè, attrito fra strati adiacenti) e non sostengono,

pertanto, questo tipo do forze (dette forze di taglio): l’unico tipo di forza applicabile è, quindi, quella perpendicolare

alla superficie. La forza che un fluido esercita su una superficie trae origine dall’urto delle molecole del fluido con la

superficie: ciascuna collisione produce una forza sulla superficie. Ogni secondo, avviene un numero enorme di queste

forze, che danno luogo ad una forza macroscopica che si distribuisce uniformemente su tutta l’area della superficie.

Questa forza è in relazione con una grandezza chiamata pressione. La pressione (che è uno scalare!) è misurata come

𝐹

la forza esercitata dal fluido sulla superficie dello strumento di misura. In simboli, 𝑝 ≡ . La sua unità di misura è il

𝐴

𝑁⁄𝑚2 , anche detto Pascal (Pa). Attenzione a non confondere forza e pressione: oltre al fatto che la prima è un vettore,

mentre la seconda è uno scalare, esse possono anche avere valori molto diversi fra loro. Es. un ago ipodermico esercita

una grandissima pressione (tale da perforare la cute) in virtù di una piccola forza, ma applicata in un’ancor più piccola

superficie. All’opposto, le racchette usate per camminare sulla neve distribuiscono una grande forza (la forza-peso) su

una grande superficie, generando una pressione minore, tale da non far sprofondare la persona.

L’atmosfera esercita una pressione sulla superficie della Terra e su tutti gli oggetti sulla superficie. Tale pressione,

detta pressione atmosferica, è uguale a 𝑝0 = 1.00 𝑎𝑡𝑚 ≈ 1.013 × 105 𝑃𝑎.

Come ben sanno i subacquei, la pressione nel mare o in un lago aumenta quando il sub nuota verso il fondo.

Analogamente, la pressione atmosferica decresce con l’altitudine. Questo fenomeno è descritto dalla seguente

equazione, che indica come la pressione esercitata su un immaginario cilindro di liquido vari linearmente con la

profondità: 𝑝 = 𝑝0 + 𝜌𝑔ℎ, dove 𝑝0 è la pressione atmosferica, 𝜌 è la densità del fluido, g è l’accelerazione di gravità ed

h è la profondità (o l’altitudine). La pressione è, perciò, la stessa in tutti i punti che hanno la stessa profondità,

indipendentemente dalla forma del recipiente.

Sulla base dell’equazione di cui sopra, ogni aumento della pressione alla superficie deve essere trasmesso in tutti i

punti del liquido. Questa legge, scoperta dal francese Blaise Pascal e perciò detta legge di Pascal, enuncia quanto

segue: una variazione di pressione applicata ad un fluido chiuso è trasmessa integralmente in ogni punto del fluido ed

alle pareti del contenitore. La legge di Pascal è il principio della pressa idraulica, ma anche del tubetto di dentifricio.

La forza di galleggiamento è una forza (o spinta) verso l’alto che si esercita su un oggetto circondato da un fluido,

relativa al sostegno parziale offerto dall’acqua a qualsiasi oggetto che vi si trovi immerso. Secondo il principio di

Archimede, “ogni oggetto immerso parzialmente o totalmente in un fluido subisce una spinta verso l’alto la cui

intensità è uguale al peso del fluido spostato dall’oggetto”. In simboli, 𝐵 = 𝜌𝑓 𝑔𝑉, dove 𝜌𝑓 è la densità del fluido, NON

del corpo. Perciò, la spinta che agisce su un cubo d’acciaio è la stessa che agisce su di un cubo di fluido delle stesse

dimensioni.

Nel caso di un oggetto completamente immerso, il volume del liquido spostato è lo stesso dell’oggetto (𝑉 = 𝑉0 ). Se la

densità dell’oggetto è minore di quella del fluido, la forza risultante è positiva e l’oggetto accelera verso l’alto. Al

contrario, se il corpo ha densità maggiore di quella del liquido, la forza risultante è negativa e l’oggetto affonda.

Nel caso di un oggetto in equilibrio statico, che galleggi sulla superficie di un fluido (cioè che sia solo parzialmente

immerso), il volume del fluido spostato è solo una frazione del volume totale dell’oggetto, giacché il volume del fluido

spostato è uguale al volume al di sotto della superficie del fluido. Poiché l’oggetto è in equilibrio, la spinta di Archimede

è equilibrata dalla forza di gravità. In simboli, 𝐵 = 𝑀𝑔 → 𝜌𝑓 𝑔𝑉 = 𝜌0 𝑔𝑉0 →

𝜌0

𝜌𝑓

=

𝑉

𝑉0

, cioè la frazione di volume

dell’oggetto al di sotto della superficie del fluido è uguale al rapporto fra la densità dell’oggetto e quella del fluido.

Dinamica dei Fluidi

La dinamica dei fluidi è lo studio dei fluidi in movimento; invece di affrontare lo studio del moto di ciascuna particella

del fluido in funzione del tempo, si descrivono le proprietà del fluido nel suo insieme.

In un fluido in moto, si possono caratterizzare due tipi di flusso: il flusso è detto stazionario o laminare quando i

cammini seguiti da ciascuna particella del fluido non si intersecano fra di loro. In queste condizioni, la velocità del

flusso in ogni punto rimane costante nel tempo. Per velocità superiori ad un valore critico, il flusso del fluido diventa

turbolento. Il flusso turbolento è un flusso irregolare caratterizzato da alcune regioni simili a piccoli vortici.

La viscosità è il grado di attrito interno nel flusso di un fluido, associato alla resistenza tra due strati adiacenti di liquido

in moto relativo. Nel nostro modello semplificato di fluidi ideali, il fluido è considerato non viscoso, oltre che

incomprimibile e dotato di flusso stazionario ed irrotazionale (cioè il momento angolare del fluido è nullo in ogni

punto).

Il cammino seguito da una particella di fluido in un flusso stazionario è chiamato linea di corrente. La velocità di una

particella del fluido risulta sempre tangente in ogni punto alla linea di corrente. Due linee di corrente non possono mai

intersecarsi, altrimenti non sarebbe un flusso stazionario.

Considerando un fluido che si muova in una conduttura di sezione variabile, l’equazione di continuità dei fluidi indica

che il prodotto dell’area del tubo per la velocità del fluido (chiamato anche portata Q) in tutti i punti del tubo è

costante. In simboli, 𝐴1 𝑣1 = 𝐴2 𝑣2 (o 𝑄 = 𝑐𝑜𝑠𝑡). Perciò, la velocità del fluido è maggiore dove il tubo è più stretto e

minore dove è più ampio.

Quando un fluido si muove in una regione in cui la sua altezza al di sopra della superficie terrestre o la sua velocità

cambia, la pressione del fluido varia con questo cambiamento. Questa relazione è stata scoperta dal fisico svizzero

1

Daniel Bernoulli nel 1738. L’equazione di Bernoulli, applicata al caso di un fluido ideale, recita: 𝑝 + 𝜌𝑣 2 + 𝜌𝑔ℎ =

2

𝑐𝑜𝑠𝑡, ovvero che la somma di pressione, energia cinetica per unità di volume ed energia potenziale gravitazionale per

unità di volume del fluido è costante in tutti i punti di una linea di corrente. Applicazioni del teorema di Bernoulli sono

restringimenti (stenosi, aterosclerosi) e dilatazioni (aneurismi, ectasie) dei vasi sanguigni.

Termologia e Termodinamica

La termodinamica si occupa dei concetti relativi al trasferimento di energia fra un sistema e l’ambiente circostante e le

conseguenti variazioni di temperatura o variazioni di stato. Il concetto di temperatura è connesso alla percezione di

caldo o freddo che un oggetto produce al tatto; tuttavia, la nostra pelle è sensibile alla rapidità di energia trasferita

(cioè la potenza), non alla quantità dell’energia o alla temperatura.

Immaginando due oggetti posti in un contenitore isolato in modo da formare un sistema isolato, se gli oggetti sono a

temperature diverse, dell’energia può essere scambiata fra di essi per mezzo di calore (o di radiazione

elettromagnetica). Oggetti che possono scambiare energia fra di loro in questo modo si dicono in contatto termico.

Alla fine, le temperature dei due oggetti diventeranno uguali, raggiungendo, cioè, l’equilibrio termico, ovvero la

situazione in cui due oggetti in contatto termico cessano di avere qualunque scambio di energia mediante calore.

Sulla base di queste definizioni basilari, possiamo enunciare il principio zero della termodinamica come segue: se gli

oggetti A e B sono separatamente in equilibrio termico con un terzo oggetto C, allora A e B sono in equilibrio termico

fra loro. Possiamo riferirci alla temperatura come alla proprietà che determina se un oggetto è in equilibrio termico

con altri oggetti oppure no: due oggetti in equilibrio termico fra di loro sono alla stessa temperatura.

I termometri sono dispositivi usati per misurare la temperatura, in base ad una qualche proprietà che varia al variare

della temperatura: il volume di un liquido, la pressione di un gas (mantenuto a volume costante), il colore di un oggetto

caldo, la resistenza elettrica di un conduttore, la lunghezza di un solido. Il termometro di uso comune consiste di una

massa liquida (mercurio o alcool) che si dilata in un capillare di vetro quando la sua temperatura aumenta. Poiché la

sezione del capillare è uniforme, la variazione varia linearmente con la sua lunghezza nel tubo. Il termometro può

essere tarato ponendolo in contatto con una temperatura costante ed associandovi una scala.

Una delle scale in uso è la scala centigrada o scala Celsius, che pone ai due estremi il punto di congelamento

dell’acqua (chiamato 0°C) ed il punto di ebollizione dell’acqua (chiamato 100°C). La distanza fra di essi viene divisa in

100 segmenti uguali, ciascuno dei quali indica una variazione di temperatura di un grado Celsius.

Un’altra scala, più accurata e con il vantaggio di presentare solo temperature positive, è la scala Kelvin o della

temperatura assoluta. Il limite inferiore di questa scala (0 K) corrisponde a -273,15°C, chiamato zero assoluto, la

temperatura più bassa raggiungibile in natura. L’ampiezza di un grado nella scala Kelvin è identica all’ampiezza di un

grado nella scala Celsius, per cui la conversione dall’una all’altra scala è facile: 𝑇𝐶 = 𝑇 − 273.15.

Un’altra scala, in uso nei paesi di lingua e cultura anglosassone, è la scala Fahrenheit, la cui unità (il grado Fahrenhait)

5

è uguale a di un kelvin (e di un Celsius). In questa scala, lo zero centigrado corrisponde a 32°F e il punto di ebollizione

9

9

dell’acqua è a 212°F. La conversione fra le due scale si effettua tramite la relazione 𝑇𝐹 = 𝑇𝐶 + 32°𝐹.

5

Nei termometri a liquido si utilizza una delle proprietà dell’energia termica: quella di dilatare oggetti solidi e liquidi. La

dilatazione termica complessiva di un oggetto è la conseguenza della variazione della distanza media di separazione

tra gli atomi o le molecole che lo costituiscono. Se la dilatazione termica di un oggetto è sufficientemente piccola

confrontata con le sue dimensioni iniziali, allora la variazione di ogni dimensione è approssimativamente dipendente

dalla prima potenza della variazione di temperatura.

Per un oggetto di lunghezza iniziale 𝐿𝑖 , che aumenta di una quantità ∆𝐿 per una variazione di temperatura ∆𝑇, la

variazione della lunghezza è uguale a ∆𝐿 = 𝛼𝐿𝑖 ∆𝑇, dove 𝛼 è una costante di proporzionalità propria di un determinato

materiale, chiamata coefficiente medio di dilatazione lineare (espressa in (℃)−1 ).

L’aumento di superficie di un oggetto dovuto alla variazione di temperatura è, invece, uguale a ∆𝐴 = 𝛾𝐴𝑖 ∆𝑇, dove 𝛾 è

il coefficiente medio di dilatazione quadratica (o superficiale), dato da 𝛾 = 2𝛼.

Infine, la variazione di volume di un oggetto dovuto alla variazione di temperatura è uguale a ∆𝑉 = 𝛽𝑉𝑖 ∆𝑇, dove 𝛽 è il

coefficiente medio di dilatazione cubica (o volumica), dato da 𝛽 = 3𝛼.

Introduciamo un modello semplificato per descrivere i gas: il modello dei gas perfetti. Un gas perfetto (o ideale) è un

insieme di atomi o molecole che si muovono di moto caotico (anche detto “browninao”), che hanno dimensioni così

piccole da occupare una frazione trascurabile del volume del loro contenitore e che interagiscono, fra di loro e con le

superfici del contenitore, per mezzo di urti elastici; inoltre, tra essi non si esercitano forze (di attrazione o repulsione) a

lunga distanza. Un gas reale è assimilabile ad un gas perfetto a temperature lontane dalla temperatura di liquefazione

e/o a bassa pressione. La maggior parte dei gas, a temperatura ambiente ed a pressione atmosferica, si comporta

approssimativamente come un gas perfetto.

La quantità di gas in un dato volume viene espressa comunemente in termini di numero di moli. Una mole di una

qualunque sostanza è quella massa di sostanza che contiene un numero di Avogadro (𝑁𝐴 = 6.022 × 1023 ) di molecole.

𝑚

Il numero di moli n presente in un campione è legato alla sua massa dalla relazione 𝑛 = , dove M è la massa molare

𝑀

della sostanza, espressa in 𝑔⁄𝑚𝑜𝑙 .

Si supponga che un gas sia contenuto in un recipiente cilindrico il cui volume possa essere variato per mezzo di un

pistone mobile. Assumeremo che il cilindro non abbia perdite e che il numero di moli del gas rimanga costante. Per un

sistema di questo tipo, gli esperimenti forniscono le seguenti informazioni:

-

Legge di Boyle-Mariotte: quando il gas viene tenuto a temperatura costante, la sua pressione è inversamente

proporzionale al volume. In formula, 𝑝 × 𝑉 = 𝑐𝑜𝑠𝑡 (per 𝑇 = 𝑐𝑜𝑠𝑡);

Legge di Charles (o prima legge di Gay-Lussac): quando la pressione del gas è tenuta costante, il volume è

direttamente proporzionale alla temperatura. In formula,

-

𝑉

𝑇

= 𝑐𝑜𝑠𝑡 (per 𝑝 = 𝑐𝑜𝑠𝑡);

Legge di Gay-Lussac (o seconda legge di Gay-Lussac): quando il volume del gas è tenuto costante, la

pressione è direttamente proporzionale alla temperatura. In formula,

𝑝

𝑇

= 𝑐𝑜𝑠𝑡 (per 𝑉 = 𝑐𝑜𝑠𝑡).

Le tre leggi possono essere riassunte nell’equazione di stato dei gas perfetti: 𝑝𝑉 = 𝑛𝑅𝑇, dove p è la pressione, V è il

volume, n è il numero di moli, T è la temperatura assoluta ed R è una costante di proporzionalità chiamata costante

universale dei gas e uguale ad 8.314 𝐽⁄𝑚𝑜𝑙 ∙ 𝐾 (oppure a 0.082 𝐿 ∙ 𝑎𝑡𝑚⁄𝐾 ∙ 𝑚𝑜𝑙 ). La legge può essere riscritta

utilizzando il numero di molecole N invece del numero di moli n; in questo caso, prende la forma di 𝑝𝑉 =

𝑁𝑘𝐵 𝑇, dove 𝑘𝐵 è la costante di Boltzmann, uguale ad

𝑅

𝑁𝐴

𝑁

𝑁𝐴

𝑅𝑇 =

= 1.38 × 10−23 𝐽⁄𝐾 .

Il modello strutturale del gas perfetto costituisce la teoria cinetica dei gas, basata sui seguenti assunti: 1) Il numero di

molecole del gas è grande e la distanza media di separazione fra di esse è grande se confrontata con le loro

dimensioni; 2) Le molecole obbediscono alle leggi del moto di Newton, ma nell’insieme il loto moto è isotropico

(ovvero, ogni molecola si può muovere in qualsiasi direzione a qualsiasi velocità); 3) Le molecole interagiscono con urti

elastici esclusivamente mediante forze che hanno effetto a breve distanza; 4) Le molecole interagiscono con urti

elastici con le pareti; 5) Il gas considerato è una sostanza pura (ovvero, tutte le molecole sono identiche).

È necessario fornire una distinzione fra energia interna e calore, prima di procedere con le leggi della termodinamica.

L’energia interna è l’energia associata con le componenti microscopiche (atomi e molecole) di un sistema, viste da un

sistema di riferimento a riposo rispetto al sistema. Essa è associata al moto traslazionale degli atomi di un gas

perfetto: più alta è la temperatura del gas, più è alta la sua energia cinetica e più è alta la sua energia interna.

Il calore, invece, è un meccanismo col quale l’energia è trasferita fra un sistema ed il suo ambiente circostante a causa

di una differenza di temperatura fra essi. Esso è anche la quantità di calore Q trasferita in questo modo. Non ha senso,

quindi, usare il termine calore in condizioni di equilibrio: si parlerà, più propriamente, della temperatura del sistema.

Unità di misura del calore sono la caloria ed il joule: una caloria (cal) è la quantità di calore necessaria per innalzare di

un grado la temperatura di 1g di acqua (precisamente da 14.5℃ a 15.5℃); un suo multiplo è la chilocaloria (kcal o

Cal). Poiché, però, il calore è un sistema di trasferimento di energia come il lavoro, si è pensato di utilizzare l’unità di

misura del lavoro, il Joule (J), anche per il calore. La conversione è effettuata per mezzo della corrispondenza esatta

1 𝑐𝑎𝑙 ≡ 4.186 𝐽 (da cui consegue che 1 𝐶𝑎𝑙 ≡ 4186 𝐽).

Dalla definizione originaria di caloria, abbiamo visto che per aumentare la temperatura di un chilogrammo di acqua di

un grado occorrono 4186 joule; ma la quantità di calore necessaria per aumentare di un grado la temperatura di un

chilogrammo di una sostanza qualsiasi dipende dalla sostanza. Introduciamo, quindi, il concetto di calore specifico,

inteso come la quantità di calore necessaria per aumentare la temperatura di un kg di sostanza di un grado Celsius (o

Kelvin, è equivalente). In simboli, 𝑐 ≡

𝑄

𝑚∆𝑡

; la sua unità di misura è 𝐽⁄𝑘𝑔 ∙ ℃.

Da questa definizione, possiamo calcolare la quantità di calore come 𝑄 = 𝑚𝑐∆𝑡. La quantità 𝑚𝑐, data dal prodotto del

calore specifico della sostanza (per unità di massa) per la sua massa è chiamata capacità termica ed è, in ultima

analisi, il rapporto fra la quantità di calore fornita ad una sostanza e l’aumento di temperatura derivatone. In formula,

𝑚𝑐 =

𝑄

∆𝑡

.

Quando dell’energia viene trasferita tra una sostanza ed il suo ambiente circostante, generalmente la sostanza subisce

un aumento di temperatura. Vi sono, tuttavia, situazioni in cui un trasferimento di energia non corrisponde ad un

aumento di temperatura: ciò accade ogni volta che le caratteristiche fisiche della sostanza mutano: ogni volta, cioè,

che avviene un passaggio di stato. L’energia trasferita necessaria per il cambiamento di fase di una data massa m di

una sostanza pura è uguale a 𝑄 = ±𝑚𝐿, dove L è chiamato calore latente della sostanza e dipende sia dalle proprietà

della sostanza sia dalla natura del cambiamento di fase. Il segno appropriato è scelto in base alle convenzioni sui segni

ed in base alla direzione del flusso di energia. Il calore latente di fusione, in particolare, è l’energia necessaria per

rompere tutti i legami intermolecolari in un chilogrammo di una sostanza, in modo da convertire la fase solida in fase

liquida. Il calore latente di vaporizzazione, invece, è l’energia che si deve fornire ad un chilogrammo di una sostanza

per rompere tutti i legami del liquido per formare un gas. Il secondo è generalmente maggiore del primo, in virtù della

differente forza dei legami in fase solida e liquida.